JP5958041B2 - 表情演奏リファレンスデータ生成装置、演奏評価装置、カラオケ装置及び装置 - Google Patents

表情演奏リファレンスデータ生成装置、演奏評価装置、カラオケ装置及び装置 Download PDFInfo

- Publication number

- JP5958041B2 JP5958041B2 JP2012094853A JP2012094853A JP5958041B2 JP 5958041 B2 JP5958041 B2 JP 5958041B2 JP 2012094853 A JP2012094853 A JP 2012094853A JP 2012094853 A JP2012094853 A JP 2012094853A JP 5958041 B2 JP5958041 B2 JP 5958041B2

- Authority

- JP

- Japan

- Prior art keywords

- performance

- facial expression

- data

- pitch

- evaluation

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

- 238000011156 evaluation Methods 0.000 title claims description 109

- 230000014509 gene expression Effects 0.000 title claims description 53

- 230000008921 facial expression Effects 0.000 claims description 147

- 230000005236 sound signal Effects 0.000 claims description 19

- 238000000034 method Methods 0.000 description 39

- 230000008569 process Effects 0.000 description 22

- 239000008186 active pharmaceutical agent Substances 0.000 description 21

- 230000001755 vocal effect Effects 0.000 description 19

- 238000012854 evaluation process Methods 0.000 description 17

- 235000014196 Magnolia kobus Nutrition 0.000 description 10

- 240000005378 Magnolia kobus Species 0.000 description 10

- 241000238876 Acari Species 0.000 description 9

- 230000005540 biological transmission Effects 0.000 description 6

- 238000004891 communication Methods 0.000 description 6

- 238000010586 diagram Methods 0.000 description 6

- 238000001514 detection method Methods 0.000 description 4

- 230000035945 sensitivity Effects 0.000 description 4

- 230000003111 delayed effect Effects 0.000 description 2

- 230000000694 effects Effects 0.000 description 2

- 238000005516 engineering process Methods 0.000 description 2

- 230000001815 facial effect Effects 0.000 description 2

- 230000004044 response Effects 0.000 description 2

- 241001070941 Castanea Species 0.000 description 1

- 235000014036 Castanea Nutrition 0.000 description 1

- 238000009825 accumulation Methods 0.000 description 1

- 230000008859 change Effects 0.000 description 1

- 230000001934 delay Effects 0.000 description 1

- 235000013601 eggs Nutrition 0.000 description 1

- 230000007704 transition Effects 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10K—SOUND-PRODUCING DEVICES; METHODS OR DEVICES FOR PROTECTING AGAINST, OR FOR DAMPING, NOISE OR OTHER ACOUSTIC WAVES IN GENERAL; ACOUSTICS NOT OTHERWISE PROVIDED FOR

- G10K15/00—Acoustics not otherwise provided for

- G10K15/04—Sound-producing devices

-

- G—PHYSICS

- G09—EDUCATION; CRYPTOGRAPHY; DISPLAY; ADVERTISING; SEALS

- G09B—EDUCATIONAL OR DEMONSTRATION APPLIANCES; APPLIANCES FOR TEACHING, OR COMMUNICATING WITH, THE BLIND, DEAF OR MUTE; MODELS; PLANETARIA; GLOBES; MAPS; DIAGRAMS

- G09B15/00—Teaching music

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10H—ELECTROPHONIC MUSICAL INSTRUMENTS; INSTRUMENTS IN WHICH THE TONES ARE GENERATED BY ELECTROMECHANICAL MEANS OR ELECTRONIC GENERATORS, OR IN WHICH THE TONES ARE SYNTHESISED FROM A DATA STORE

- G10H1/00—Details of electrophonic musical instruments

- G10H1/36—Accompaniment arrangements

- G10H1/361—Recording/reproducing of accompaniment for use with an external source, e.g. karaoke systems

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L25/00—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00

- G10L25/48—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00 specially adapted for particular use

- G10L25/51—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00 specially adapted for particular use for comparison or discrimination

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L25/00—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00

- G10L25/90—Pitch determination of speech signals

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10H—ELECTROPHONIC MUSICAL INSTRUMENTS; INSTRUMENTS IN WHICH THE TONES ARE GENERATED BY ELECTROMECHANICAL MEANS OR ELECTRONIC GENERATORS, OR IN WHICH THE TONES ARE SYNTHESISED FROM A DATA STORE

- G10H2210/00—Aspects or methods of musical processing having intrinsic musical character, i.e. involving musical theory or musical parameters or relying on musical knowledge, as applied in electrophonic musical tools or instruments

- G10H2210/031—Musical analysis, i.e. isolation, extraction or identification of musical elements or musical parameters from a raw acoustic signal or from an encoded audio signal

- G10H2210/091—Musical analysis, i.e. isolation, extraction or identification of musical elements or musical parameters from a raw acoustic signal or from an encoded audio signal for performance evaluation, i.e. judging, grading or scoring the musical qualities or faithfulness of a performance, e.g. with respect to pitch, tempo or other timings of a reference performance

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10H—ELECTROPHONIC MUSICAL INSTRUMENTS; INSTRUMENTS IN WHICH THE TONES ARE GENERATED BY ELECTROMECHANICAL MEANS OR ELECTRONIC GENERATORS, OR IN WHICH THE TONES ARE SYNTHESISED FROM A DATA STORE

- G10H2220/00—Input/output interfacing specifically adapted for electrophonic musical tools or instruments

- G10H2220/155—User input interfaces for electrophonic musical instruments

- G10H2220/441—Image sensing, i.e. capturing images or optical patterns for musical purposes or musical control purposes

- G10H2220/455—Camera input, e.g. analyzing pictures from a video camera and using the analysis results as control data

Landscapes

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Physics & Mathematics (AREA)

- Acoustics & Sound (AREA)

- Computational Linguistics (AREA)

- Educational Technology (AREA)

- General Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- Educational Administration (AREA)

- Signal Processing (AREA)

- Health & Medical Sciences (AREA)

- Audiology, Speech & Language Pathology (AREA)

- Human Computer Interaction (AREA)

- Business, Economics & Management (AREA)

- Auxiliary Devices For Music (AREA)

- Reverberation, Karaoke And Other Acoustics (AREA)

- Electrophonic Musical Instruments (AREA)

Description

また、本発明は、楽曲に含まれるノートまたはノート群の発音開始時刻を基準とする時間軸上において当該発音開始時刻から当該楽曲の演奏中に行われるべき表情演奏が実際に行なわれる時刻までの時間差と当該時間差に応じて動的に変化する評価点との関係を当該表情演奏ごとに示す表情演奏リファレンスデータを取得する表情演奏リファレンスデータ取得手段と、演奏者による前記楽曲の演奏音から当該演奏音のピッチまたは音量を示すピッチ音量データを生成するピッチ音量データ生成手段と、前記ピッチ音量データ生成手段により生成された前記ピッチ音量データにより示されるピッチまたは音量の少なくとも一方の特性が、前記楽曲における前記表情演奏リファレンスデータにより示される所定時間範囲内において前記表情演奏リファレンスデータにより行われるべきであるとされる表情演奏の特性を示す場合、当該表情演奏の出現時刻に応じた前記評価点を用いて評価を行う演奏評価手段と、を備える演奏評価装置を提供する。

図1は、本発明の一実施形態である歌唱評価システム1の構成を示す図である。この歌唱評価システム1は、カラオケ装置10−m(m=1、2…M:Mはカラオケ装置の総数)とサーバ装置30とを有する。カラオケ装置10−mは、各カラオケ店に一台または複数台ずつ設置される。サーバ装置30は、システム運営センタ内に設置される。カラオケ装置10−mとサーバ装置30はネットワーク90に接続され、互いに各種データの送受

信が可能である。

a1.タメ

これは、歌唱曲内の特定の音の歌いだしを故意に遅らせる表情歌唱である。図2に示すように、この歌唱が行われた場合、歌唱音の前の音のものから当該音のものへと音のピッチが変化する時刻が楽譜(模範的な歌唱)における両音に対応する2つのノート(音符)の遷移時刻よりも僅かな時間だけ遅れる。

b2.ビブラート

これは、歌唱曲内の特定の音を見かけのピッチを保ちつつ細かく震わせる表情歌唱である。図3に示すように、この歌唱が行われた場合、歌唱音のピッチは楽譜におけるその音に対応するノートの高さを跨いで周期的に変化する。

c1.コブシ

これは、歌唱曲内の特定の音の声色を発音の途中でうなるように変化させる表情歌唱である。図4に示すように、この歌唱が行われた場合、歌唱音のピッチは楽譜におけるその音に対応するノートの途中で一過的に上昇する。

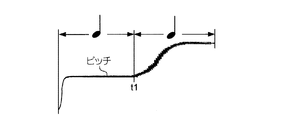

d1.シャクリ

これは、歌唱曲内の特定の音を本来の高さよりも低い声で発音してから本来の高さに近づけていく歌唱手法である。図5に示すように、この歌唱が行われた場合、歌唱音の発音開始時刻におけるピッチは楽譜におけるその音に対応するノートの高さよりも低くなる。そして、この歌唱音のピッチは発音開始後に緩やかに上昇してノートの高さとほぼ同じ高さに達する。

e1.フォール

これは、歌唱曲内の特定の音を本来の高さよりも高い声で発音してから本来の高さに近づけていく歌唱手法である。図6に示すように、この歌唱が行われた場合、歌唱音の発音始時刻におけるピッチは楽譜におけるその音に対応するノートの高さよりも高くなる。そして、この歌唱音のピッチは発音開始後に緩やかに下降してノートの高さとほぼ同じ高さに達する。

ク20に記憶されたプログラムを実行する。このCPU17の動作の詳細は後述する。ROM19には、IPL(Initial Program Loader)などが記憶されている。ハードディスク20には、各種歌唱曲の曲データMD−n(n=1〜N)(Nは、歌唱曲の種類の総数)、リファレンスデータベースDBRK、及び歌唱評価プログラムVPGが記憶されている。各歌唱曲の曲データMD−nは、歌唱曲の伴奏内容、歌唱曲の歌詞、及び歌唱曲の模範的な歌唱内容をSMF(Standard MIDI File)形式で記録したデータである。

a2.標準評価機能

これは、ボーカルアダプタ16の出力信号SL及びSPが示すピッチ及び音量と模範歌唱リファレンストラックTRNR内の各イベントEV(i)ON及びEV(i)OFFにより決ま

る各ノートNT(i)の模範ピッチPCHREF及び模範音量LVREFとを比較し、この比較の結果に基づいて歌唱の巧拙を評価する機能である。

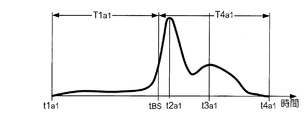

b2.表情歌唱評価機能

これは、ボーカルアダプタ16の出力信号SPが示すピッチ波形に表情歌唱の特徴波形が出現する度に、表情歌唱の対象となったノートNT(i)の発音開始時刻を基準点tBSとする時間軸上における表情歌唱の特徴波形の出現時刻を求め、この出現時刻と対応する評価点VSR(t)をリファレンスデータベースDBRK内における該当の表情歌唱リファレンスデータDDの各評価点VSR(t)の中から選択し、この評価点VSR(t)に基づいて歌唱の巧拙を評価する機能である。

c2.評価結果提示機能

これは、a2による評価の評価結果及びb2による評価の評価結果から得点を算出し、この得点をコメントメッセージとともに表示部14に表示させる機能である。

に接続された装置との間でデータを送受信する。CPU37は、RAM38をワークエリアとして利用しつつ、ROM39やハードディスク40に記憶された各種プログラムを実行する。このCPU37の動作の詳細は後述する。ROM39にはIPLなどが記憶されている。

a3.蓄積機能

これは、カラオケ装置10−mから各歌唱曲の歌唱サンプルデータDSを1曲分ずつ取得し、取得した歌唱サンプルデータDSを歌唱サンプルデータベースDBSに蓄積する機能である。

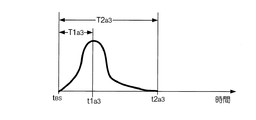

b3.書き換え機能

これは、歌唱サンプルデータベースDBSに蓄積された歌唱サンプルデータDSの各々について、当該歌唱サンプルデータDSが示す波形内から表情歌唱の特徴波形を探索し、この探索結果から表情歌唱の対象となったノートNT(i)の発音開始時刻を基準点tBSとする時間軸上の各時刻tとそれらの時刻tにおける表情歌唱の出現数Numとの関係を示す統計データを生成し、リファレンスデータベースDBR内の表情歌唱リファレンスデータDDにおける各時刻tと対応する評価点VSR(t)を統計データの内容に基づいて書き換える機能である。

c3.送信機能

これは、書き換え機能により書き換えた表情歌唱リファレンスデータDDをカラオケ装置10−mからの要求に応じてカラオケ装置10−mに送信する機能である。

この処理では、CPU17は、シーケンサ21からイベントEV(i)ONが供給されてから次のイベントEV(i)OFFが供給されるまでの時間をi番目のノートNT(i)に相当する音の発音時間TNT(i)とする。CPU17は、発音時間TNT(i)の間のボーカルアダプタ16の出力信号SPが示すピッチとイベントEV(i)ONのノートナンバを変換した模範ピッチPCHREFとの差PCHDEF、及びその間の信号SPが示す音量とイベントEV(i)ONのベロシティを変換した模範音量LVREFとの差LVDEFを求め、この差PCHDEF及び差LVDEFが所定範囲に収まる場合にノートNT(i)の歌唱が合格であると判定する。CPU17は、利用者による歌唱の開始から終了までの間に亘ってこのノート判定を行い、歌唱の終了時点における全ノートTN(i)の数を合格と判定したノートNT(i)の数で除算した値に100を乗じた値を基本得点SRBASEとする。

チ波形内に、タメ、ビブラート、コブシ、シャクリ、フォールのいずれかの表情歌唱の特徴波形が出現した否かを判定する。ここで、タメの特徴波形の判定手法の詳細は特許文献2を、ビブラートの特徴波形の判定手法の詳細は特許文献3を、コブシの特徴波形の判定手法の詳細は特許文献4を、シャクリの特徴波形の判定手法の詳細は特許文献5を、フォールの特徴波形の判定手法の詳細は特許文献6を参照されたい。CPU17は、利用者による歌唱の開始から終了までの間に亘ってこの特徴波形判定を行い、歌唱の終了時点における表情歌唱の出現数に所定の係数を乗じた値を加算点SRADDとする。そして、この処理では、基本得点SRBASEと加算点SRADDの合計を標準得点SRNORとする。

この処理では、CPU17は、音源イベントEV(i)ONの出力から次のイベントEV(i)OFFの出力までの時間をi番目のノートNT(i)に相当する音の発音時間TNT(i)とする。そして、CPU17は、発音時間TNT(i)の間のボーカルアダプタ16の出力信号SPが示すピッチ波形内に表情歌唱の特徴波形が出現した場合には、発音時間TNT(i)内における表情歌唱の出現時刻と出現した表情歌唱の種類を求める。CPU17は、そのように特定した表情歌唱の種類と出現時刻とを示す表情歌唱出現データを生成する。

を探索し、この探索結果を示す表情歌唱出現データ(タメが出現したノートNT(i)の発音開始時刻を基準点tBSとする時間軸上の各時刻tを示すデータ)を生成する。続いて、CPU37はタメに関し生成した表情歌唱出現データに基づき、ノートNT(i)の発音開始時刻を基準点tBSとする時間軸上の各時刻tとそれらの時刻tにおける表情歌唱「タメ」の出現数Numとの関係を示す統計データを生成し、表情歌唱リファレンスデータDDa1における各時刻tと対応する評価点VSR(t)をこの統計データの内容に基づいて書き換える。

サンプルデータDSが示すピッチ波形内からシャクリの特徴波形を探索し、この探索結果を示す表情歌唱出現データ(シャクリが出現したノートNT(i)の発音開始時刻を基準点tBSとする時間軸上の各時刻tを示すデータ)を生成する。続いて、CPU37はシャクリに関し生成した表情歌唱出現データに基づき、ノートNT(i)の発音開始時刻を基準点tBSとする時間軸上の各時刻tとそれらの時刻tにおける表情歌唱の出現数Numとの関係を示す統計データを生成し、表情歌唱リファレンスデータDDa4における各時刻tと対応する評価点VSR(t)をこの統計データの内容に基づいて書き換える。

第1に、本実施形態の表情付け歌唱評価処理では、ボーカルアダプタ16の出力信号の波形に表情歌唱の特徴波形が出現する度に、表情歌唱の対象となったノートNT(i)の発音開始時刻を基準点とする時間軸上における表情歌唱の特徴波形の出現時刻を求め、この出現時刻と対応する評価点VSR(t)を歌唱リファレンスデータDD内の各評価点VSR(t)の中から選択し、この選択した評価点VSR(t)に基づいて歌唱の巧拙を評価する。よって、本実施形態によると、利用者が表情歌唱を行ったとしても、そのタイミ

ングが適切でなければ良好な評価が得られないことになる。従って、本実施形態によると、人の感性によるものにより近い評価結果を提示することができる。

(1)上記実施形態では、CPU17は、タメ、ビブラート、コブシ、シャクリ、フォールの5種類の表情歌唱をボーカルアダプタ16の出力信号SPから検出した。しかし、この5種類以外の表情歌唱を検出してもよい。たとえば、抑揚をつけた歌唱を検出してもよい。

情歌唱の検出処理は行わずカラオケ装置10から送信されてくる表情歌唱出現データに基づき表情歌唱リファレンスデータDDの更新処理が行われる構成が採用されてもよい。

が不要な場合は、シーケンサ21および表示部14による画像信号の出力処理は行われなくてもよい。

Claims (10)

- 任意数の任意の演奏者による楽曲の演奏音の各々に関し、当該演奏音のピッチまたは音量を示すピッチ音量データを取得するピッチ音量データ取得手段と、

前記ピッチ音量データ取得手段により取得されたピッチ音量データにより示されるピッチまたは音量の少なくとも一方の特性が、前記楽曲における任意のタイミングにおいて予め定められた1以上の表情演奏の特性のうちの一の特性を示す場合、当該表情演奏と、前記楽曲に含まれるノートまたはノート群の発音開始時刻を基準とする当該タイミングとの対を示す表情演奏出現データを生成する表情演奏出現データ生成手段と、

前記表情演奏出現データ生成手段により生成された任意数の表情演奏出現データに基づき、前記楽曲に含まれるノートまたはノート群の各々に関し、当該ノートまたはノート群の発音開始時刻を基準とする時間軸上のいずれのタイミングでいずれの表情演奏がいずれの頻度で出現しているかを特定し、当該特定した情報を用いて前記発音開始時刻を基準とする前記時間軸上の各時刻と当該時刻においてそれぞれ当該楽曲の演奏中に行われるべき表情演奏が行なわれた場合の評価点との各対で示す表情演奏リファレンスデータを生成する表情演奏リファレンスデータ生成手段と、

を備える表情演奏リファレンスデータ生成装置。 - 楽曲に含まれるノートまたはノート群の発音開始時刻を基準とする時間軸上において当該発音開始時刻から当該楽曲の演奏中に行われるべき表情演奏が実際に行なわれる時刻までの時間差と当該時間差に応じて動的に変化する評価点との関係を当該表情演奏ごとに示す表情演奏リファレンスデータを取得する表情演奏リファレンスデータ取得手段と、

演奏者による前記楽曲の演奏音から当該演奏音のピッチまたは音量を示すピッチ音量データを生成するピッチ音量データ生成手段と、

前記ピッチ音量データ生成手段により生成された前記ピッチ音量データにより示されるピッチまたは音量の少なくとも一方の特性が、前記楽曲における前記表情演奏リファレンスデータにより示される所定時間範囲内において前記表情演奏リファレンスデータにより行われるべきであるとされる表情演奏の特性を示す場合、当該表情演奏の出現時刻に応じた前記評価点を用いて評価を行う演奏評価手段と、

を備える演奏評価装置。 - 任意数の任意の演奏者による楽曲の演奏音の各々に関し、当該演奏音のピッチまたは音量を示すピッチ音量データを取得するピッチ音量データ取得手段と、

前記ピッチ音量データ取得手段により取得されたピッチ音量データにより示されるピッチまたは音量の少なくとも一方の特性が、前記楽曲における任意のタイミングにおいて予め定められた1以上の表情演奏の特性のうちの一の特性を示す場合、当該表情演奏と、前記楽曲に含まれるノートまたはノート群の発音開始時刻を基準とする当該タイミングとの対を示す表情演奏出現データを生成する表情演奏出現データ生成手段と、

前記表情演奏出現データ生成手段により生成された任意数の表情演奏出現データに基づき、前記楽曲に含まれるノートまたはノート群の各々に関し、当該ノートまたはノート群の発音開始時刻を基準とする時間軸上のいずれのタイミングでいずれの表情演奏がいずれの頻度で出現しているかを特定し、当該特定した情報を用いて前記発音開始時刻を基準とする前記時間軸上の各時刻と当該時刻においてそれぞれ当該楽曲の演奏中に行われるべき表情演奏が行なわれた場合の評価点との各対で示す前記表情演奏リファレンスデータを生成する表情演奏リファレンスデータ生成手段と、

を備え、

前記表情演奏リファレンスデータ取得手段は、前記表情演奏リファレンスデータ生成手段によって生成された前記表情演奏リファレンスデータを取得する

請求項2に記載の演奏評価装置。 - 前記楽曲の模範となるピッチまたは音量を示す模範演奏リファレンスデータを取得する模範演奏リファレンスデータ取得手段

を備え、

前記演奏評価手段は、前記ピッチ音量データ生成手段により生成されたピッチ音量データにより示されるピッチと、前記模範演奏リファレンスデータにより示されるピッチとの比較の結果に基づき前記演奏者による前記楽曲の演奏に対する評価を行う

請求項2または3に記載の演奏評価装置。 - 前記演奏評価手段は、

前記ピッチ音量データ生成手段により生成されたピッチ音量データにより示されるピッチまたは音量と、前記模範演奏リファレンスデータにより示されるピッチまたは音量との比較の結果に基づき、前記演奏者による前記楽曲の演奏に関する第1の得点を求めると共に、

前記ピッチ音量データ生成手段により生成されたピッチ音量データにより示されるピッチまたは音量と、前記表情演奏リファレンスデータにより示されるピッチまたは音量との比較の結果に基づき、前記演奏者による前記楽曲の演奏に対する第2の得点を求め、

前記第1の得点および前記第2の得点に基づき、前記楽曲の演奏に対する演奏評価を行うことを特徴とする

請求項4に記載の演奏評価装置。 - 前記楽曲の模範となるピッチを示す模範演奏リファレンスデータを取得する模範演奏リファレンスデータ取得手段

を備え、

前記演奏評価手段は、前記ピッチ音量データ生成手段により生成されたピッチ音量データにより示されるピッチと、前記模範演奏リファレンスデータにより示されるピッチとの比較の結果に基づき前記演奏者による前記楽曲の演奏に対する評価を行い、

前記ピッチ音量データ取得手段により取得されるピッチ音量データは、前記演奏評価手段により前記模範演奏リファレンスデータを用いて行われた評価の結果、または前記演奏評価手段と同様の手段を備える他機により前記模範演奏リファレンスデータと同様のデータを用いて行われた評価の結果を示す演奏評価データを伴い、

前記表情演奏リファレンスデータ生成手段は、前記ピッチ音量データ取得手段により取得されるピッチ音量データのうち所定の条件を満たす演奏評価データを伴うピッチ音量データを用いて前記表情演奏出現データ生成手段により生成された表情演奏出現データに基づき、前記表情演奏リファレンスデータを生成する

請求項3に記載の演奏評価装置。 - 請求項2乃至6のいずれか1項に記載の演奏評価装置と、

楽曲の伴奏を指示する伴奏データを取得する伴奏データ取得手段と、

前記伴奏データの指示に従い伴奏の楽音を示す音信号を出力する音信号出力手段と、

を備える

カラオケ装置。 - 前記楽曲は歌唱曲であり、

前記歌唱曲の歌詞を示す歌詞データを取得する歌詞データ取得手段と、

前記歌詞データにより示される歌詞であって、前記音信号出力手段により現在出力されている音信号が示す伴奏とともに歌唱されるべき歌詞を示す画像信号を出力する画像信号出力手段と、

を備える請求項7に記載のカラオケ装置。 - 前記楽曲は楽器により演奏される楽曲であり、

前記楽曲の楽譜を示す楽譜データを取得する楽譜データ取得手段と、

前記楽譜データにより示される楽譜であって、前記音信号出力手段により現在出力されている音信号が示す伴奏とともに行われるべき演奏を指示する楽譜を示す画像信号を出力する画像信号出力手段と、

を備える請求項7に記載のカラオケ装置。 - 任意数の任意の演奏者による楽曲の演奏音の各々に関し、前記楽曲に含まれるノートまたはノート群の発音開始時刻を基準とする一のタイミングにおいて一の表情演奏が出現したことを示す表情演奏出現データを取得する表情演奏出現データ取得手段と、

前記表情演奏出現データ取得手段により取得された任意数の表情演奏出現データに基づき、前記楽曲に含まれるノートまたはノート群の各々に関し、当該ノートまたはノート群の発音開始時刻を基準とする時間軸上のいずれのタイミングでいずれの表情演奏がいずれの頻度で出現しているかを特定し、当該特定した情報を用いて前記発音開始時刻を基準とする前記時間軸上の各時刻と当該時刻においてそれぞれ当該楽曲の演奏中に行われるべき表情演奏が行なわれた場合の評価点との各対で示す表情演奏リファレンスデータを生成する表情演奏リファレンスデータ生成手段と、

前記表情演奏リファレンスデータ生成手段により生成された表情演奏リファレンスデータを演奏評価装置に送信する送信手段と、

を備える装置。

Priority Applications (5)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2012094853A JP5958041B2 (ja) | 2012-04-18 | 2012-04-18 | 表情演奏リファレンスデータ生成装置、演奏評価装置、カラオケ装置及び装置 |

| PCT/JP2013/061488 WO2013157602A1 (ja) | 2012-04-18 | 2013-04-18 | 演奏評価装置、カラオケ装置及びサーバ装置 |

| KR1020147025532A KR101666535B1 (ko) | 2012-04-18 | 2013-04-18 | 연주 평가 장치, 노래방 장치 및 서버 장치 |

| TW102113839A TWI497484B (zh) | 2012-04-18 | 2013-04-18 | Performance evaluation device, karaoke device, server device, performance evaluation system, performance evaluation method and program |

| CN201380015347.7A CN104170006B (zh) | 2012-04-18 | 2013-04-18 | 演奏评价装置、卡拉ok装置及服务器装置 |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2012094853A JP5958041B2 (ja) | 2012-04-18 | 2012-04-18 | 表情演奏リファレンスデータ生成装置、演奏評価装置、カラオケ装置及び装置 |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2013222140A JP2013222140A (ja) | 2013-10-28 |

| JP2013222140A5 JP2013222140A5 (ja) | 2015-06-18 |

| JP5958041B2 true JP5958041B2 (ja) | 2016-07-27 |

Family

ID=49383554

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2012094853A Expired - Fee Related JP5958041B2 (ja) | 2012-04-18 | 2012-04-18 | 表情演奏リファレンスデータ生成装置、演奏評価装置、カラオケ装置及び装置 |

Country Status (5)

| Country | Link |

|---|---|

| JP (1) | JP5958041B2 (ja) |

| KR (1) | KR101666535B1 (ja) |

| CN (1) | CN104170006B (ja) |

| TW (1) | TWI497484B (ja) |

| WO (1) | WO2013157602A1 (ja) |

Families Citing this family (24)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR101459324B1 (ko) * | 2013-08-28 | 2014-11-07 | 이성호 | 음원 평가방법 및 이를 이용한 음원의 평가장치 |

| JP6428066B2 (ja) * | 2014-09-05 | 2018-11-28 | オムロン株式会社 | 採点装置及び採点方法 |

| JP6352164B2 (ja) * | 2014-11-28 | 2018-07-04 | 株式会社第一興商 | 聴取者評価を考慮したカラオケ採点システム |

| CN104392731A (zh) * | 2014-11-30 | 2015-03-04 | 陆俊 | 一种练习唱歌的方法和系统 |

| CN104485090B (zh) * | 2014-12-12 | 2020-01-17 | 上海斐讯数据通信技术有限公司 | 乐谱生成方法及装置、移动终端 |

| JP5715296B1 (ja) * | 2014-12-16 | 2015-05-07 | 行秘 大田 | 替え歌通信カラオケサーバ及び替え歌通信カラオケシステム |

| US10380657B2 (en) * | 2015-03-04 | 2019-08-13 | International Business Machines Corporation | Rapid cognitive mobile application review |

| JP6113231B2 (ja) * | 2015-07-15 | 2017-04-12 | 株式会社バンダイ | 歌唱力評価装置及び記憶装置 |

| JP6701864B2 (ja) * | 2016-03-25 | 2020-05-27 | ヤマハ株式会社 | 音評価装置および音評価方法 |

| JP6614356B2 (ja) * | 2016-07-22 | 2019-12-04 | ヤマハ株式会社 | 演奏解析方法、自動演奏方法および自動演奏システム |

| JP6776788B2 (ja) * | 2016-10-11 | 2020-10-28 | ヤマハ株式会社 | 演奏制御方法、演奏制御装置およびプログラム |

| CN108665747A (zh) * | 2017-04-01 | 2018-10-16 | 上海伍韵钢琴有限公司 | 一种在线钢琴陪练系统及使用方法 |

| JP6867900B2 (ja) * | 2017-07-03 | 2021-05-12 | 株式会社第一興商 | カラオケ装置 |

| JP6708180B2 (ja) * | 2017-07-25 | 2020-06-10 | ヤマハ株式会社 | 演奏解析方法、演奏解析装置およびプログラム |

| CN108694384A (zh) * | 2018-05-14 | 2018-10-23 | 芜湖岭上信息科技有限公司 | 一种基于图像和声音的观众满意度调查装置和方法 |

| CN109903778B (zh) * | 2019-01-08 | 2020-09-25 | 北京雷石天地电子技术有限公司 | 实时演唱评分的方法与系统 |

| CN109887524A (zh) * | 2019-01-17 | 2019-06-14 | 深圳壹账通智能科技有限公司 | 一种演唱评分方法、装置、计算机设备及存储介质 |

| JP7232654B2 (ja) * | 2019-01-31 | 2023-03-03 | 株式会社第一興商 | カラオケ装置 |

| JP7232653B2 (ja) * | 2019-01-31 | 2023-03-03 | 株式会社第一興商 | カラオケ装置 |

| JP7169243B2 (ja) * | 2019-03-29 | 2022-11-10 | 株式会社第一興商 | カラオケ装置 |

| CN110120216B (zh) * | 2019-04-29 | 2021-11-12 | 北京小唱科技有限公司 | 用于演唱评价的音频数据处理方法及装置 |

| CN110083772A (zh) * | 2019-04-29 | 2019-08-02 | 北京小唱科技有限公司 | 基于演唱技巧的歌手推荐方法及装置 |

| JP7533568B2 (ja) * | 2020-03-04 | 2024-08-14 | ヤマハ株式会社 | 演奏データに対する観衆の評価を推論する方法、情報処理システム、及びプログラム |

| CN112037609B (zh) * | 2020-08-26 | 2022-10-11 | 怀化学院 | 一种基于物联网的音乐教学装置 |

Family Cites Families (22)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2915773B2 (ja) * | 1993-12-25 | 1999-07-05 | 日本コロムビア株式会社 | カラオケ装置 |

| JP3299890B2 (ja) * | 1996-08-06 | 2002-07-08 | ヤマハ株式会社 | カラオケ採点装置 |

| JP3293745B2 (ja) * | 1996-08-30 | 2002-06-17 | ヤマハ株式会社 | カラオケ装置 |

| JP3690224B2 (ja) * | 2000-01-13 | 2005-08-31 | ヤマハ株式会社 | 携帯電話機および携帯電話システム |

| CN1380642A (zh) * | 2001-04-11 | 2002-11-20 | 华邦电子股份有限公司 | 跟唱学习评分装置及方法 |

| JP2003058155A (ja) * | 2001-08-13 | 2003-02-28 | Casio Comput Co Ltd | 演奏教習装置及び演奏教習処理のプログラム |

| JP4222915B2 (ja) * | 2003-09-30 | 2009-02-12 | ヤマハ株式会社 | 歌唱音声評価装置、カラオケ採点装置及びこれらのプログラム |

| JP4163584B2 (ja) | 2003-09-30 | 2008-10-08 | ヤマハ株式会社 | カラオケ装置 |

| JP4209751B2 (ja) * | 2003-09-30 | 2009-01-14 | ヤマハ株式会社 | カラオケ装置 |

| JP4204941B2 (ja) | 2003-09-30 | 2009-01-07 | ヤマハ株式会社 | カラオケ装置 |

| JP2005241848A (ja) * | 2004-02-25 | 2005-09-08 | Daiichikosho Co Ltd | 通信カラオケシステムにおける投稿作品編集式の模範ボーカル提供装置 |

| TWI232430B (en) * | 2004-03-19 | 2005-05-11 | Sunplus Technology Co Ltd | Automatic grading method and device for audio source |

| JP2007256617A (ja) * | 2006-03-23 | 2007-10-04 | Yamaha Corp | 楽曲練習装置および楽曲練習システム |

| JP2007271977A (ja) * | 2006-03-31 | 2007-10-18 | Yamaha Corp | 評価基準判定装置、制御方法及びプログラム |

| JP2008015388A (ja) * | 2006-07-10 | 2008-01-24 | Dds:Kk | 歌唱力評価方法及びカラオケ装置 |

| JP2008026622A (ja) * | 2006-07-21 | 2008-02-07 | Yamaha Corp | 評価装置 |

| JP2008139426A (ja) * | 2006-11-30 | 2008-06-19 | Yamaha Corp | 評価用データのデータ構造、カラオケ装置及び記録媒体 |

| JP4865607B2 (ja) | 2007-03-13 | 2012-02-01 | ヤマハ株式会社 | カラオケ装置、歌唱評価方法およびプログラム |

| JP4910854B2 (ja) | 2007-04-17 | 2012-04-04 | ヤマハ株式会社 | こぶし検出装置、こぶし検出方法及びプログラム |

| JP2007334364A (ja) * | 2007-08-06 | 2007-12-27 | Yamaha Corp | カラオケ装置 |

| TWI394141B (zh) * | 2009-03-04 | 2013-04-21 | Wen Hsin Lin | Karaoke song accompaniment automatic scoring method |

| JP5244738B2 (ja) * | 2009-08-24 | 2013-07-24 | 株式会社エクシング | 歌唱評価装置、歌唱評価方法及びコンピュータプログラム |

-

2012

- 2012-04-18 JP JP2012094853A patent/JP5958041B2/ja not_active Expired - Fee Related

-

2013

- 2013-04-18 KR KR1020147025532A patent/KR101666535B1/ko active IP Right Grant

- 2013-04-18 TW TW102113839A patent/TWI497484B/zh not_active IP Right Cessation

- 2013-04-18 CN CN201380015347.7A patent/CN104170006B/zh not_active Expired - Fee Related

- 2013-04-18 WO PCT/JP2013/061488 patent/WO2013157602A1/ja active Application Filing

Also Published As

| Publication number | Publication date |

|---|---|

| CN104170006B (zh) | 2017-05-17 |

| JP2013222140A (ja) | 2013-10-28 |

| WO2013157602A1 (ja) | 2013-10-24 |

| CN104170006A (zh) | 2014-11-26 |

| TWI497484B (zh) | 2015-08-21 |

| KR20140124843A (ko) | 2014-10-27 |

| TW201407602A (zh) | 2014-02-16 |

| KR101666535B1 (ko) | 2016-10-14 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP5958041B2 (ja) | 表情演奏リファレンスデータ生成装置、演奏評価装置、カラオケ装置及び装置 | |

| JP2009104097A (ja) | 採点装置及びプログラム | |

| JP4163584B2 (ja) | カラオケ装置 | |

| JP6288197B2 (ja) | 評価装置及びプログラム | |

| JP5428459B2 (ja) | 歌唱評価装置 | |

| JP6102076B2 (ja) | 評価装置 | |

| JP6944357B2 (ja) | 通信カラオケシステム | |

| JP4491743B2 (ja) | カラオケ装置 | |

| JP5994343B2 (ja) | 演奏評価装置及びカラオケ装置 | |

| JP3879524B2 (ja) | 波形生成方法、演奏データ処理方法および波形選択装置 | |

| JP6219750B2 (ja) | 歌唱対戦カラオケシステム | |

| JP6073618B2 (ja) | カラオケ装置 | |

| JP6365483B2 (ja) | カラオケ装置,カラオケシステム,及びプログラム | |

| JP4182782B2 (ja) | カラオケ装置 | |

| JP2015060203A (ja) | 演奏データとオーディオデータの同期装置、方法、およびプログラム | |

| JP2007140163A (ja) | カラオケ装置およびカラオケ装置用プログラム | |

| JP6011506B2 (ja) | 情報処理装置,データ生成方法,及びプログラム | |

| JP2004184506A (ja) | カラオケ装置及びプログラム | |

| JP2007233078A (ja) | 評価装置、制御方法及びプログラム | |

| JP6514868B2 (ja) | カラオケ装置及びカラオケ採点システム | |

| JP5551983B2 (ja) | カラオケ演奏制御システム | |

| JP2015106061A (ja) | カラオケ装置 | |

| JP2014071137A (ja) | 楽器音出力装置 | |

| KR20110005653A (ko) | 데이터 집배 시스템, 통신 노래방 시스템 | |

| JP2012013920A (ja) | カラオケ演奏制御システム |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20150220 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20150422 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20160216 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20160414 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20160524 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20160606 |

|

| R151 | Written notification of patent or utility model registration |

Ref document number: 5958041 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R151 |

|

| LAPS | Cancellation because of no payment of annual fees |