JP2016033729A - 周囲環境認識装置 - Google Patents

周囲環境認識装置 Download PDFInfo

- Publication number

- JP2016033729A JP2016033729A JP2014156165A JP2014156165A JP2016033729A JP 2016033729 A JP2016033729 A JP 2016033729A JP 2014156165 A JP2014156165 A JP 2014156165A JP 2014156165 A JP2014156165 A JP 2014156165A JP 2016033729 A JP2016033729 A JP 2016033729A

- Authority

- JP

- Japan

- Prior art keywords

- sensing

- lens

- detection

- vehicle

- image

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

- 238000003745 diagnosis Methods 0.000 claims abstract description 20

- 238000001514 detection method Methods 0.000 claims description 160

- XLYOFNOQVPJJNP-UHFFFAOYSA-N water Substances O XLYOFNOQVPJJNP-UHFFFAOYSA-N 0.000 claims description 74

- 238000012545 processing Methods 0.000 claims description 18

- 230000007423 decrease Effects 0.000 claims description 10

- 238000003384 imaging method Methods 0.000 abstract description 10

- 238000011109 contamination Methods 0.000 abstract description 7

- 238000010586 diagram Methods 0.000 description 20

- 238000000034 method Methods 0.000 description 18

- 238000006243 chemical reaction Methods 0.000 description 16

- 230000015556 catabolic process Effects 0.000 description 6

- 230000008859 change Effects 0.000 description 6

- 238000006731 degradation reaction Methods 0.000 description 6

- 239000000284 extract Substances 0.000 description 6

- 230000003449 preventive effect Effects 0.000 description 6

- 238000003708 edge detection Methods 0.000 description 3

- 230000000694 effects Effects 0.000 description 3

- 230000006872 improvement Effects 0.000 description 3

- 230000007774 longterm Effects 0.000 description 3

- 101150072448 thrB gene Proteins 0.000 description 3

- 239000000463 material Substances 0.000 description 2

- 241000238631 Hexapoda Species 0.000 description 1

- 206010068829 Overconfidence Diseases 0.000 description 1

- 230000002159 abnormal effect Effects 0.000 description 1

- 238000013459 approach Methods 0.000 description 1

- 230000037237 body shape Effects 0.000 description 1

- 238000004140 cleaning Methods 0.000 description 1

- 239000003086 colorant Substances 0.000 description 1

- 238000010276 construction Methods 0.000 description 1

- 239000000428 dust Substances 0.000 description 1

- 239000011521 glass Substances 0.000 description 1

- 230000009191 jumping Effects 0.000 description 1

- 238000012423 maintenance Methods 0.000 description 1

- 230000007246 mechanism Effects 0.000 description 1

- 230000003287 optical effect Effects 0.000 description 1

- 239000005304 optical glass Substances 0.000 description 1

- 230000002265 prevention Effects 0.000 description 1

- 230000008569 process Effects 0.000 description 1

- 238000011084 recovery Methods 0.000 description 1

- 238000004092 self-diagnosis Methods 0.000 description 1

- 239000000126 substance Substances 0.000 description 1

- 230000001629 suppression Effects 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

- G08G1/16—Anti-collision systems

- G08G1/165—Anti-collision systems for passive traffic, e.g. including static obstacles, trees

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60Q—ARRANGEMENT OF SIGNALLING OR LIGHTING DEVICES, THE MOUNTING OR SUPPORTING THEREOF OR CIRCUITS THEREFOR, FOR VEHICLES IN GENERAL

- B60Q5/00—Arrangement or adaptation of acoustic signal devices

- B60Q5/005—Arrangement or adaptation of acoustic signal devices automatically actuated

- B60Q5/006—Arrangement or adaptation of acoustic signal devices automatically actuated indicating risk of collision between vehicles or with pedestrians

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60R—VEHICLES, VEHICLE FITTINGS, OR VEHICLE PARTS, NOT OTHERWISE PROVIDED FOR

- B60R1/00—Optical viewing arrangements; Real-time viewing arrangements for drivers or passengers using optical image capturing systems, e.g. cameras or video systems specially adapted for use in or on vehicles

- B60R1/20—Real-time viewing arrangements for drivers or passengers using optical image capturing systems, e.g. cameras or video systems specially adapted for use in or on vehicles

- B60R1/22—Real-time viewing arrangements for drivers or passengers using optical image capturing systems, e.g. cameras or video systems specially adapted for use in or on vehicles for viewing an area outside the vehicle, e.g. the exterior of the vehicle

- B60R1/23—Real-time viewing arrangements for drivers or passengers using optical image capturing systems, e.g. cameras or video systems specially adapted for use in or on vehicles for viewing an area outside the vehicle, e.g. the exterior of the vehicle with a predetermined field of view

- B60R1/24—Real-time viewing arrangements for drivers or passengers using optical image capturing systems, e.g. cameras or video systems specially adapted for use in or on vehicles for viewing an area outside the vehicle, e.g. the exterior of the vehicle with a predetermined field of view in front of the vehicle

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60W—CONJOINT CONTROL OF VEHICLE SUB-UNITS OF DIFFERENT TYPE OR DIFFERENT FUNCTION; CONTROL SYSTEMS SPECIALLY ADAPTED FOR HYBRID VEHICLES; ROAD VEHICLE DRIVE CONTROL SYSTEMS FOR PURPOSES NOT RELATED TO THE CONTROL OF A PARTICULAR SUB-UNIT

- B60W50/00—Details of control systems for road vehicle drive control not related to the control of a particular sub-unit, e.g. process diagnostic or vehicle driver interfaces

- B60W50/08—Interaction between the driver and the control system

- B60W50/14—Means for informing the driver, warning the driver or prompting a driver intervention

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V20/00—Scenes; Scene-specific elements

- G06V20/50—Context or environment of the image

- G06V20/56—Context or environment of the image exterior to a vehicle by using sensors mounted on the vehicle

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

- G08G1/16—Anti-collision systems

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

- G08G1/16—Anti-collision systems

- G08G1/166—Anti-collision systems for active traffic, e.g. moving vehicles, pedestrians, bikes

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

- G08G1/16—Anti-collision systems

- G08G1/168—Driving aids for parking, e.g. acoustic or visual feedback on parking space

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60R—VEHICLES, VEHICLE FITTINGS, OR VEHICLE PARTS, NOT OTHERWISE PROVIDED FOR

- B60R2300/00—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle

- B60R2300/20—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle characterised by the type of display used

- B60R2300/205—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle characterised by the type of display used using a head-up display

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60R—VEHICLES, VEHICLE FITTINGS, OR VEHICLE PARTS, NOT OTHERWISE PROVIDED FOR

- B60R2300/00—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle

- B60R2300/30—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle characterised by the type of image processing

- B60R2300/307—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle characterised by the type of image processing virtually distinguishing relevant parts of a scene from the background of the scene

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60R—VEHICLES, VEHICLE FITTINGS, OR VEHICLE PARTS, NOT OTHERWISE PROVIDED FOR

- B60R2300/00—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle

- B60R2300/60—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle characterised by monitoring and displaying vehicle exterior scenes from a transformed perspective

- B60R2300/607—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle characterised by monitoring and displaying vehicle exterior scenes from a transformed perspective from a bird's eye viewpoint

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60R—VEHICLES, VEHICLE FITTINGS, OR VEHICLE PARTS, NOT OTHERWISE PROVIDED FOR

- B60R2300/00—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle

- B60R2300/80—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle characterised by the intended use of the viewing arrangement

- B60R2300/8033—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle characterised by the intended use of the viewing arrangement for pedestrian protection

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60R—VEHICLES, VEHICLE FITTINGS, OR VEHICLE PARTS, NOT OTHERWISE PROVIDED FOR

- B60R2300/00—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle

- B60R2300/80—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle characterised by the intended use of the viewing arrangement

- B60R2300/8093—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle characterised by the intended use of the viewing arrangement for obstacle warning

Landscapes

- Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Multimedia (AREA)

- Mechanical Engineering (AREA)

- Automation & Control Theory (AREA)

- Signal Processing (AREA)

- Theoretical Computer Science (AREA)

- Acoustics & Sound (AREA)

- Human Computer Interaction (AREA)

- Transportation (AREA)

- Traffic Control Systems (AREA)

- Image Processing (AREA)

- Image Analysis (AREA)

Abstract

【課題】レンズの汚れ状態に応じて変化するセンシング可能範囲をユーザに提示する周囲環境認識装置を提供すること。【解決手段】本発明は、画像を取得する撮像部100と、画像から認識対象物を認識するアプリケーションを実行するアプリ実行部400と、画像に基づいてカメラのレンズ状態を診断するレンズ状態診断部200と、アプリケーションを実行した場合にレンズ状態診断部で診断したレンズ状態によって認識対象物をセンシングすることが可能なセンシング可能範囲と、認識対象物をセンシング不可能なセンシング不可能範囲を判断するセンシング範囲判断部300と、センシング範囲判断部のセンシング可能範囲を報知する報知制御部500を有することを特徴としている。【選択図】図1

Description

本発明は、カメラで撮像した画像に基づいて周囲の環境を認識する周囲環境認識装置に関する。

車両に設置されたカメラで周囲を撮像した画像から周囲環境を認識するアプリケーションの製品化が増加傾向にある。その中で、車室外にカメラが設置されている場合に、カメラのレンズが正常に認識できる状態となっているかどうかを判定する技術がある(特許文献1)。特許文献1の技術は、カメラのレンズに付着した異物等を検出し、その領域の割合が閾値を超えると、周囲環境を認識するアプリケーションを停止して、アプリケーションが停止したことをユーザに報知するものである。また、車両走行時の画像から背景が動くにも関わらず、変化しない不動領域を検出し、この不動領域を除いた領域のみで物体検出する技術も、従来から種々存在する。

しかしながら、認識対象物を認識可能な範囲がどのように変化したかをユーザに提示するものはない。従来のように、レンズ汚れ時に、アプリケーションを停止するだけ、あるいは、不動領域を除いた領域のみで物体検出するだけでは、ユーザがアプリを過信して、周囲環境への注意が疎かになるおそれもある。

本発明は、上記の点に鑑みてなされたものであり、その目的とするところは、レンズの汚れ状態に応じて変化するセンシング可能範囲をユーザに提示する周囲環境認識装置を提供することである。

上記課題を解決する本発明の周囲環境認識装置は、カメラで外部環境を撮像した画像に基づいて周囲環境を認識する周囲環境認識装置であって、前記画像を取得する画像取得部と、前記画像から認識対象物を認識するアプリケーションを実行するアプリ実行部と、前記画像に基づいて前記カメラのレンズ状態を診断するレンズ状態診断部と、前記アプリケーションを実行した場合に前記レンズ状態診断部で診断したレンズ状態によって前記認識対象物をセンシングすることが可能なセンシング可能範囲と、前記認識対象物をセンシング不可能なセンシング不可能範囲を判断するセンシング範囲判断部と、該センシング範囲判断部のセンシング可能範囲とセンシング不可能範囲との少なくとも一方を報知する報知制御部を有することを特徴としている。

本発明によれば、レンズ汚れに起因した現状の画像認識アプリケーションの性能低下状況をユーザに報知することによって、ユーザのカメラ認識機能への過信を抑制し、ユーザに対してレンズ汚れ時には周囲環境により注意して運転することを促すことができる。なお、上記した以外の課題、構成及び効果は、以下の実施形態の説明により明らかにされる。

次に、本発明の周囲環境認識装置が適用される実施形態について図面を用いて以下に説明する。なお、以下の実施例では、本発明の周囲環境認識装置を自動車などの車両に搭載される車載用環境認識装置に適用した場合を例に説明するが、車載用に限定されるものではなく、建築機器、ロボット、監視カメラ、農業機器などにも適用することができる。

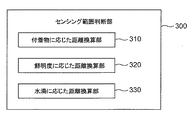

図1は、周囲環境認識装置の内部機能を説明するブロック図である。

本実施の形態における車載用の周囲環境認識装置10は、車両の外部を撮像する車載カメラと、車載カメラで撮像した画像に基づいて外部の環境を認識する認識装置を有しているが、車載カメラ自体は周囲環境認識装置の必須の構成要素ではなく、車載カメラ等で撮像した外部の画像を取得することができる構成であればよい。

本実施の形態における車載用の周囲環境認識装置10は、車両の外部を撮像する車載カメラと、車載カメラで撮像した画像に基づいて外部の環境を認識する認識装置を有しているが、車載カメラ自体は周囲環境認識装置の必須の構成要素ではなく、車載カメラ等で撮像した外部の画像を取得することができる構成であればよい。

周囲環境認識装置10は、図1に示すように、撮像部100と、レンズ状態診断部200と、センシング範囲判断部300と、アプリ実行部400と、報知制御部500を有している。

撮像部100は、例えば車体の前後左右に取り付けられた車載カメラ101(図6を参照)によって撮像された車両周囲の画像を取得する(画像取得部)。アプリ実行部400は、撮像部100が取得した画像から対象物を認識して、歩行者検知や車両検知などの各種のアプリケーション(以下、アプリ)を実行する。

レンズ状態診断部200は、撮像部100で取得した画像に基づいて車載カメラ101のレンズの状態を診断する。車載カメラ101は、CMOS等の撮像素子と、撮像素子の前に配置される光学系のレンズを有している。なお、本実施形態におけるレンズは、ピントを調整する度付のレンズのみに限定されるものではなく、一般的に撮像素子の前方に配置される光学系のガラス(例えば汚れ防止用のフィルタレンズや偏光レンズなど)も含まれる。

レンズ状態診断部200は、レンズの付着物や白濁、水滴等による汚れを診断する。車載カメラ101は、例えば車外に配置されている場合、泥やゴミ、虫などの付着物がレンズに付着し、あるいは塵埃や水垢などによって磨りガラスのように白く白濁し、また、水滴自体が付着して、レンズが汚れるおそれがある。車載カメラ101のレンズが汚れると、画像に撮像されている背景の一部または全部が隠れたり、鮮明度が低くなってぼやけたり、背景が歪むなどして対象物の認識が困難となるおそれがある。

センシング範囲判断部300は、レンズ状態診断部200で診断したレンズ状態に基づいて認識対象物を認識可能なセンシング可能範囲を判断する。センシング可能範囲は、レンズに対する付着物の付着位置、大きさなどの汚れ度合いに応じて変化するが、それだけではなく、アプリ実行部400で実行されるアプリに応じても変化する。例えば、レンズの汚れ度合い及び対象物までの距離が同じ場合であっても、アプリの認識対象物が車両などのように比較的大きいものの方が、歩行者などのように比較的小さいものよりも、センシング可能範囲が広くなる。

報知制御部500は、センシング可能範囲判断部300からの情報に基づいて、センシング可能範囲とセンシング不可能範囲の少なくとも一方をユーザに報知する制御を行う。報知制御部500は、例えば車載モニタや警報装置からユーザにセンシング可能範囲を表示したり、警報音やメッセージ等を流すことでユーザにセンシング可能範囲の変化を報知し、また、車両制御装置が車両制御に用いることができるように、センシング可能範囲に応じて車両制御装置に情報を提供することができる。

図6は、車両のシステム構成の一例であって、車載カメラシステムの全体構成を説明する概略図である。周囲環境認識装置10は、車載カメラ101の画像処理を行う画像処理装置2の内部機能と、画像処理装置からの処理結果に基づいて運転者への報知や車両制御を行う車両制御装置3の内部機能とを用いて構成されている。画像処理装置2は、例えば、レンズ状態診断部200と、センシング可能範囲判断部300、アプリ部400を備えており、車両制御装置3は、報知制御部500を備えている。

車両1は、複数の車載カメラ101、例えば車両1の前方を撮像する前方カメラ101a、後方を撮像する後部カメラ101b、左側方を撮像する左側部カメラ101c、右側方を撮像する右側部カメラ101dの4台の車載カメラ101を有しており、車両1の周囲を全周に亘って連続して撮像できるようになっている。なお、車載カメラ101は、複数に限定されるものではなく、単一のものであってもよく、また、全周に亘って撮像するものに限定されず、前方のみや後方のみを撮像するものであってもよい。

左右の車載カメラ101は、サイドミラーに装着されたカメラでもよく、また、サイドミラーの代わりに設置されたカメラでもよい。報知制御部500は、ユーザとのインタフェースであり、これは画像処理装置2とは別のハードウェア上に実装されている。報知制御部500は、アプリ実行部400において実行された結果を利用して、予防安全機能や利便性機能を実現する制御を実施する。

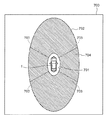

図7は、車載モニタに表示される画面の一例を示す図である。

システムが正常動作中で所定のアプリが実行中の場合に、アプリのセンシング可能範囲を、自車(車両1)の上から見たような距離空間のまま、車載モニタ700に提示する俯瞰表示方法が従来から存在する。

システムが正常動作中で所定のアプリが実行中の場合に、アプリのセンシング可能範囲を、自車(車両1)の上から見たような距離空間のまま、車載モニタ700に提示する俯瞰表示方法が従来から存在する。

所定のアプリにより車両1に最も近い対象物をセンシング可能(認識可能)な最小センシングライン701は、車両1の周囲を囲む小楕円で示され、同じアプリにより車両1から最も遠い対象物をセンシング可能(認識可能)な最大センシングライン702は、大楕円で示されている。最小センシングライン701と最大センシングライン702との間がセンシング範囲704となり、レンズに汚れがない通常状態の場合には、センシング範囲704全体がセンシング可能範囲となる。なお、図中に破線で示される符号703は、互いに隣り合う車載カメラの撮像範囲が重複する部分を示す。

センシング範囲704は、実行されるアプリに応じて設定される。例えばアプリの対象物が車両1のように比較的大きい場合には最大センシングライン702と最小センシングライン701はそれぞれ大きくなり、対象物が歩行者など比較的小さい場合には最大センシングライン702と最小センシングライン701はそれぞれ小さくなる。

車載カメラ101のレンズに汚れ等がある場合、たとえセンシング範囲704内であったとしても、その汚れ等によって隠れている背景部分については認識対象物の検知が困難となり、アプリは所期の性能を発揮できない性能低下状態となるおそれがある。本発明の周囲環境認識装置では、アプリが性能低下状態となっていることをユーザに伝えるために報知する制御を行う。

報知方法として、例えば車載モニタ等にセンシング範囲704からセンシング可能範囲とセンシング不可能範囲を視覚的に表示し、性能低下状態をユーザに明確に伝えることができる。この表示方法は、車両1からの検知可能な距離が把握しやすく、性能低下によるセンシング能力の低下の程度もわかりやすく提示することができる。また、車室内のメータパネル等に設けられたLEDを点灯させたり、警告音や振動などにより合わせてユーザにアプリの動作が性能低下状態であることを伝えてもよい。

図8は、車載モニタに表示される画面の一例を示す図である。車載モニタ801には、車両前部の車載カメラ101で撮像した画像802と、その画像802に重畳してセンシング可能領域803とセンシング不可能領域804とが表示されている。画像802には、車両1の前方の道路Rと、走行車線を示す左右の白線WLが撮像されている。このような表示により、ドライバー(運転者)に対して車載カメラ101(図6を参照)のレンズ状態を見せながら、レンズ状態に応じたセンシング可能領域803を伝えることができる。そして、例えば、「この程度の汚れの場合には遠方が見えなくなるので拭いた方がよい」など、レンズ状態とセンシング可能領域803を同時に見せることができるため、ドライバーに車載カメラ101のセンシング能力をわかりやすく伝えることができる。

図9は、車両のフロントガラスに表示される画像の一例を示す図である。

ここでは、車内からみたフロントガラス901越しの風景に、ヘッドアップディスプレイ(HUD)を利用して、現実世界に重畳して見せている。現実世界の路面上にセンシング可能領域803やセンシング不可能領域804を重畳して見せることで、実際の車載カメラ101のセンシング可能領域やセンシングの距離を視覚的に把握しやすくできる。ただし、フロントガラス901への投影型のヘッドアップディスプレイは、ドライバー(運転者)の視界を遮ることからフロントガラス901全面への表示は困難である。このため、図9に示すようにフロントガラス901の下側を利用した路面への重畳表示か、フロントガラス901の上側を利用した空中への重畳表示によりセンシング可能領域803等を現実世界に提示してもよい。

ここでは、車内からみたフロントガラス901越しの風景に、ヘッドアップディスプレイ(HUD)を利用して、現実世界に重畳して見せている。現実世界の路面上にセンシング可能領域803やセンシング不可能領域804を重畳して見せることで、実際の車載カメラ101のセンシング可能領域やセンシングの距離を視覚的に把握しやすくできる。ただし、フロントガラス901への投影型のヘッドアップディスプレイは、ドライバー(運転者)の視界を遮ることからフロントガラス901全面への表示は困難である。このため、図9に示すようにフロントガラス901の下側を利用した路面への重畳表示か、フロントガラス901の上側を利用した空中への重畳表示によりセンシング可能領域803等を現実世界に提示してもよい。

次に、図1に示される、レンズ状態診断部200、センシング可能範囲判断部300、アプリ実行部400、報知制御部500でそれぞれ実行される内容について順番に説明する。

図2は、レンズ状態診断部200の内部機能を説明するブロック図である。レンズ状態診断部200は、付着物検知部210と、鮮明度検知部220と、水滴検知部230を備えており、撮像部100で取得された画像に基づいて車載カメラ101のレンズに付着したそれぞれの汚れ状態を種別に応じて診断する。

図10は、レンズに付着した付着物の検知方法を説明する図であり、図10(a)は、車載カメラ101で前方を撮像した画像1001を示し、図10(b)、(c)は、付着物を検知する方法を説明する図である。

図10(a)に示すように、画像1001にはレンズに複数の付着物1002が付着して汚れている。付着物検知部210は、レンズに付着した付着物、例えば泥のように背景の様子を遮る付着物1002を検知する。泥のような付着物1002はレンズに付着すると背景が見えづらく、周囲と比較して輝度が低い状態が継続される。したがって、輝度変化が小さな領域を検出することによって付着物1002を検知できる。

まず、付着物検知部210は、画像1001の画像領域を、図10(b)に示されるように複数のブロックA(x,y)に分割する。次に、画像1001の各画素の輝度を検出して、各ブロックA(x,y)ごとにそのブロックA(x,y)に含まれる各画素の輝度の総和It(x,y)を算出する。そして、現フレームの撮影画像について算出したIt(x,y)と前フレームの撮影画像について同様に算出したIt−1(x,y)との差ΔI(x,y)を各ブロックA(x,y)ごとに算出する。そして、この差ΔI(x,y)が周囲のブロックと比較して小さいブロックA(x,y)を検出して、そのブロックA(x,y)に対応するスコアSA(x,y)を所定値、たとえば、「1」だけ増加させる。

付着物検知部210は、画像1001中の全画素について上述の判定を行った後、各ブロックA(x,y)のスコアSA(x,y)を初期化してからの経過時間tAを取得する。そして、各ブロックA(x,y)のスコアSA(x,y)を、その経過時間tAで除して、スコアSA(x,y)の時間平均SA(x,y)/tAを算出する。付着物検知部210は、全ブロックA(x,y)の時間平均SA(x,y)/tAの総和を算出して、それを撮影画像中の全ブロック数で除してスコア平均SA_aveを算出する。

車載カメラ101のレンズに泥などの汚れ1002が継続的に付着していると、順次に撮像されたフレームごとにスコア平均SA_aveが増加する。換言すると、スコア平均SA_aveが大きい場合、長時間レンズに泥などが付着している確率が高い。時間平均SA(x,y)/tAが所定の閾値を超えたかどうかを判定し、閾値を超えた領域は泥が付着し、背景が見えない領域であると判定する。閾値を超えた領域の大きさに応じた各アプリのセンシング可能範囲の計算に利用される。また、スコア平均SA_aveを利用して、各アプリの動作が可能かどうかの最終判定を実施する。図10(c)は、スコア例を示したものであり、全ブロックをスコアに応じた色の濃淡で示している。そして、スコアが所定の閾値以上の場合には、付着物で背景が見えない領域1012と判定する。

次に、図11を用いて鮮明度検知部220の動作について説明する。図11は、レンズの鮮明度を検知する方法を説明する図である。鮮明度検知部220は、レンズが鮮明な状態であるのか不鮮明な状態であるか鮮明度の指標としてレンズ状態を検知する。レンズが不鮮明な状態とは、例えば、レンズの表面が汚れによって白く濁り、コントラストが低くなって対象物の輪郭等がぼやけたようになることであり、その程度は鮮明度によって示される。

鮮明度検知部220は、図11(a)に示されるように、画像1001に地平線が写り込む予定の位置に左上検知領域BG_L(Background Left)と上検知領域BG_T(Background Top)と右上検知領域BG_R(Background Right)とを設定する。上検知領域BG_Tは、路面に互いに平行に設けられた2本のレーンマークWLが遠方で交わる消失点と地平線が含まれるような位置に設定される。左上検知領域BG_Lは上検知領域BG_Tよりも左側に設定され、右上検知領域BG_Rは上検知領域BG_Tよりも右側に設定される。それぞれ画像上に必ずエッジが含まれるように、地平線を含む領域に設定する。また、画像1001中にレーンマークWLが写る予定の位置に左下検知領域RD_L(Road Left)と右下検知領域RD_R(Road Right)とを設定する。

鮮明度検知部220は、左上検知領域BG_Lと上検知領域BG_Tと右上検知領域BG_Rと左下検知領域RD_Lと右下検知領域RD_Rのそれぞれの領域内の画素に対して、エッジ検出処理を行う。左上検知領域BG_Lと上検知領域BG_Tと右上検知領域BG_Rに対するエッジ検出では、地平線などのエッジが必ず検出される。また、左下検知領域RD_Lと右下検知領域RD_Rとに対するエッジ検出では、レーンマークWLなどのエッジが検出される。

鮮明度検知部220は、各検知領域BG_L,BG_T,BG_R,RD_L,RD_Rに含まれる各画素についてそれぞれエッジ強度を算出する。そして、鮮明度検知部220は、各検知領域BG_L,BG_T,BG_R,RD_L,RD_Rごとにエッジ強度の平均値Blaveを算出して、この平均値Blaveを元に鮮明の程度を判定する。図11(b)に示すように、エッジ強度が強いほどクリアなレンズで鮮明だと判定し、エッジ強度が弱いほど白濁して不鮮明なレンズと判定する鮮明度を設定する。

算出した平均値Blaveを基に標準鮮明度を下回った場合に、アプリの認識性能に影響を及ぼすと判定し、各領域の鮮明度の平均値を使ってアプリの性能低下度合いを、アプリごとに判定する。最低鮮明度α2を下回った場合には、アプリの認識が困難であることを各アプリごとに判定する。

図12は、レンズに付着した水滴の検知方法を説明する図である。

図2の水滴検知部230では、撮像画面上で図12(a)に示すような周囲画素との輝度比較を実施することで、水滴特徴量を抽出する。水滴検知部230は、その着目点から上方向、右上方向、右下方向、左上方向、左下方向に、それぞれ所定距離(たとえば、3pix)離れた画素を内部参照点Piに設定して、それらの5方向に更に所定距離(たとえば、更に3pix)離れた画素を外部参照点Poに設定する。次に、水滴検知部230は、各内部参照点Piと各外部参照点Poのそれぞれについて、輝度を比較する。

図2の水滴検知部230では、撮像画面上で図12(a)に示すような周囲画素との輝度比較を実施することで、水滴特徴量を抽出する。水滴検知部230は、その着目点から上方向、右上方向、右下方向、左上方向、左下方向に、それぞれ所定距離(たとえば、3pix)離れた画素を内部参照点Piに設定して、それらの5方向に更に所定距離(たとえば、更に3pix)離れた画素を外部参照点Poに設定する。次に、水滴検知部230は、各内部参照点Piと各外部参照点Poのそれぞれについて、輝度を比較する。

水滴1202の縁より内側付近は、外側よりもレンズ効果で明るい可能性が高い。そこで、水滴検知部230は、5方向の各々について、水滴1202の縁の内側に設置された内部参照点Piの輝度が外部参照点Poの輝度よりも高いか否かを判定する。換言すると、水滴検知部230は、着目点が水滴1202の中心部であるか否かを判定する。水滴検知部230は、各方向の内部参照点Piの輝度が同方向の外部参照点Poの輝度よりも高い場合、その着目点が属する図12(b)に示す領域のB(x,y)のスコアSB(x,y)を所定値、たとえば、「1」だけ増加させる。B(x,y)のスコアは、所定時間tB時間の瞬間値を保存し、tB時間以上経過した過去のスコアについては、破棄されるものとする。

水滴検知部230は、撮影画像中の全画素について上述の判定を行った後、各ブロックB(x,y)のスコアSB(x,y)を、その経過時間tBの総和を求めTbで除算することにより、時間平均スコアSB(x,y)を算出して、それを撮影画像中の全ブロック数で除してスコア平均SB_aveを算出する。分割領域のSB(x,y)ごとに特定の閾値ThrBを、どの程度、超えているかどうかを判定し、スコア化し、図12(c)に示すような閾値を超えている分割領域とそのスコアをマップ上に示し、このマップ上のスコアの総計SB2を算出する。

車載カメラ101のレンズに水滴が継続的に付着していると、フレームごとにスコア平均SB_aveが増加する。換言すると、スコア平均SB_aveが大きい場合、そのレンズ位置に水滴が付着している確率が高い。水滴検知部230は、このスコア平均SB_aveを、利用してレンズ上での水滴付着の多さを判定する。レンズ上での水滴付着量の多さがSB2に値し、この値を利用してシステム全体のフェール判定を実施する。各ロジックごとの判定には、別途、水滴占有率により、その最大検知距離の判定に利用する。

レンズ汚れによる認識アプリケーションの性能低下の判定には、水滴付着量の多さと、スコア平均SB_aveの両方を利用する。そして、どのようにセンシング可能範囲を計算するか考える。図12(c)は、スコア例を示したものであり、全ブロックをスコアに応じた色の濃淡で示している。そして、スコアが所定の閾値以上の場合には、水滴により背景が見えない領域と判定する。

図3は、センシング範囲判断部の内部機能を説明する図である。センシング範囲判断部300は、付着物に応じた距離換算部310と、鮮明度に応じた距離換算部320と、水滴に応じた距離換算部330を備えており、レンズ状態診断部200における診断結果を利用してセンシング可能範囲を判断する処理を行う。付着物に応じた距離換算部310では、付着物検知部210の検知結果を利用して各アプリの検知が保証可能なセンシング可能範囲を換算する。鮮明度に応じた距離換算部320では、鮮明度検知部220の検知結果を利用して各アプリの検知が保証可能なセンシング可能範囲を換算する。水滴に応じた距離換算部330では、水滴検知部230の検知結果を利用して各アプリの検知が保証可能なセンシング可能範囲を換算する。

付着物に応じた距離換算部310は、付着物検知部210の検知結果に応じてセンシング可能範囲を計算する。付着物検知部210の結果を利用して、時間平均SA(x,y)/tAが所定の閾値を超えたかどうかを判定し、閾値を超えた領域は泥が付着し、背景が見えない領域であると判定する。例えば、図13−1(a)に示すように、画像1301上の左上に泥等の付着物1302が付着した場合、付着物1302の領域に対応する領域の時間平均SA(x,y)/tAが所定の閾値を超えたとする。これにより、図13−1(b)に色が濃い領域1303として示すように、付着物1302が付着したことによって背景が見えない領域を画像上で選定する。

次に、この場合のセンシング可能範囲を、それぞれのアプリ別に定義する。ここで重要となるのが、各アプリによって認識対象物の大きさが異なる点である。まず、例題としてわかりやすい歩行者検知のアプリの場合を例に説明する。

<歩行者検知の場合>

図13−2(a)、(b)に示すように、付着物1302によって背景が見えないとされる領域部分に、歩行者Pが重なる場合を想定する。画像上では、奥行き方向の距離に応じて歩行者Pの大きさが異なって見える。歩行者Pが遠方にいるほど、付着物1302が歩行者Pを遮るパーセンテージ(率)が高まるために、遠方、およびフロント魚眼カメラの左方向で検知を保証することが困難になる。この例では、歩行者が自車両から6.0m離れており、歩行者のほとんどの部分が付着物1302の陰に隠れてしまっており、歩行者の大きさの40%未満しか見えていないので、アプリ実行部400の歩行者検知部430は、歩行者を認識できない。一方、図13−2(b)に示すように、歩行者が自車両から1.0m離れている場合には、歩行者の大きさの40%以上が見えているので、歩行者検知部430は歩行者を認識できる。奥行き距離Zごとにこの処理を実施する。

図13−2(a)、(b)に示すように、付着物1302によって背景が見えないとされる領域部分に、歩行者Pが重なる場合を想定する。画像上では、奥行き方向の距離に応じて歩行者Pの大きさが異なって見える。歩行者Pが遠方にいるほど、付着物1302が歩行者Pを遮るパーセンテージ(率)が高まるために、遠方、およびフロント魚眼カメラの左方向で検知を保証することが困難になる。この例では、歩行者が自車両から6.0m離れており、歩行者のほとんどの部分が付着物1302の陰に隠れてしまっており、歩行者の大きさの40%未満しか見えていないので、アプリ実行部400の歩行者検知部430は、歩行者を認識できない。一方、図13−2(b)に示すように、歩行者が自車両から1.0m離れている場合には、歩行者の大きさの40%以上が見えているので、歩行者検知部430は歩行者を認識できる。奥行き距離Zごとにこの処理を実施する。

歩行者は、身長1.8mの標準的な体型を想定し、これを1mから5mの奥行き距離Z別に、画像1301上で歩行者Pがどの程度の大きさに見えるかを計算する。この奥行き別の歩行者Pの形状と、泥などの付着物1302によって背景が見えない領域部分を比較し、最大、歩行者Pの何パーセントを付着物1302が隠す可能性があるかどうかを計算する。例えば、歩行者Pが最大30%以上見えなくなる可能性がある奥行きと、カメラ101からの視野角度θを計算する。

図13−3(a)、(b)は、歩行者を認識(センシング)することが不可能なセンシング不可能範囲1331と、認識可能なセンシング可能範囲1332とを車載モニタなどの表示部1330に表示した状態の一例をそれぞれ示している。センシング範囲判断部300は、アプリを実行した場合にレンズ状態診断部200で診断したレンズ状態によって歩行者をセンシングすることが可能なセンシング可能範囲と、センシング不可能なセンシング不可能範囲を判断する。図13−3(a)に示す例では、付着物の大きさや形状に応じて距離換算された所定距離705よりも遠方の歩行者は見えないと判断してセンシング不可能範囲1331を設定している。所定距離705は、付着物の大きさが大きくなるほど車両1に接近し、付着物の大きさが小さくなるほど車両1から離れるように設定される。センシング不可能範囲1331の横幅を決定するθは、付着物の大きさに応じて設定されている。そして、図13−3(b)の例では、車両1の前部に取り付けられた車載カメラ101aに付着物が付着しており、遠方は付着物の影になって見えない可能性が高いので、車両前部の車載カメラ101で撮像される画像の所定距離705より遠方全てを使用不可に設定している。

<車両検知の場合>

車両検知は、歩行者検知の考え方と同様であり、認識対象物である車両Mの大きさを幅1.8m奥行き4.7mと定義する。そして、歩行者Pと異なる部分は、検知対象の車両Mの向きをレーン認識もしくは、自車両の進行方向と同じと定義する部分である。例えば図14−1(a)に示すように、レーンWLに沿って走る先行車両Mが、左上の付着物1302に重なる場合を奥行き別に調査する。歩行者Pと比較して車両Mは大きいので、歩行者Pよりも遠方まで検出することが可能である。ここでは、車体の40%以上が隠れた場合に、検知の保証が困難と判定している。車両Mは、歩行者Pと比較して剛体であり、人工物であるため、歩行者Pと比較して見えないパーセンテージ(比率)が高くなっても検知の保証が可能である。例えば、図14−2(a)、(b)に示すように、車両Mが遠方にいるほど、付着物1302が車両Mを遮るパーセンテージが高まるために、遠方、およびフロント魚眼カメラの前方向で検知を保証することが困難になる。

車両検知は、歩行者検知の考え方と同様であり、認識対象物である車両Mの大きさを幅1.8m奥行き4.7mと定義する。そして、歩行者Pと異なる部分は、検知対象の車両Mの向きをレーン認識もしくは、自車両の進行方向と同じと定義する部分である。例えば図14−1(a)に示すように、レーンWLに沿って走る先行車両Mが、左上の付着物1302に重なる場合を奥行き別に調査する。歩行者Pと比較して車両Mは大きいので、歩行者Pよりも遠方まで検出することが可能である。ここでは、車体の40%以上が隠れた場合に、検知の保証が困難と判定している。車両Mは、歩行者Pと比較して剛体であり、人工物であるため、歩行者Pと比較して見えないパーセンテージ(比率)が高くなっても検知の保証が可能である。例えば、図14−2(a)、(b)に示すように、車両Mが遠方にいるほど、付着物1302が車両Mを遮るパーセンテージが高まるために、遠方、およびフロント魚眼カメラの前方向で検知を保証することが困難になる。

<レーン認識の場合>

レーン認識は、その基本の考え方としては歩行者検知や車両検知同様である。異なるのは認識対象物に決まった大きさがないことである。しかし、重要な考え方は、レーンWLを認識する場合にそもそも遠方10mから近傍50cmを認識対処としており、その中で奥行き何mから何mまでが見えないかどうかということである。画面上の汚れ領域を、カメラ幾何を利用して路面上のどの範囲を隠すかどうかを判定する。

レーン認識は、その基本の考え方としては歩行者検知や車両検知同様である。異なるのは認識対象物に決まった大きさがないことである。しかし、重要な考え方は、レーンWLを認識する場合にそもそも遠方10mから近傍50cmを認識対処としており、その中で奥行き何mから何mまでが見えないかどうかということである。画面上の汚れ領域を、カメラ幾何を利用して路面上のどの範囲を隠すかどうかを判定する。

白線(レーンWL)の場合には、遠方の左側が見えないことが、平行性を利用した右側の認識性能に影響するため、左側5mより遠方が見えないと判定された場合には、右側も同等の性能として、白線の遠方が認識できないと判定する。実際の画像処理でも、5m遠方部分を除外して画像処理することで、誤検知を低減してもよい。または、汚れ領域のみをセンシング領域から外してもよい。検知保証可能範囲を提示するとともに、検知保証領域が狭くなるにつれて低下するレーン認識の横位置、ヨー角、曲率の精度を考慮して、制御に利用可能か、制御には利用できないが警報に利用できるレベルなのか、まったく利用できないのかを同時に判定する。

<駐車枠検知の場合>

駐車枠は、白線と同様に路面に存在するが、白線と異なり対象物の大まかなサイズは既知とみなすことができる。当然場所によって駐車枠の大きさに若干の差異はあるものの例えば幅2.2m、奥行き5mの大きさであると駐車枠を定義し、この領域の枠内部の何パーセントを隠す可能性があるかを計算する。実際には、枠線のみが重要で枠内部だけが泥で汚れていても検知可能であるが、車両が動いて見えなくなればアプリとしては性能保証できないことに変わりはないため、枠内部の何パーセントが泥で見えなくなる可能性があるかを計算し、30%を超える場合には、動作保証不可とする。これも奥行き別に実施する。また、駐車枠を利用したアプリでは、車を旋回させながら駐車支援に利用することが多い、このためフロントカメラの左奥7m以降だけが30%を超える泥が付着していたとしても、アプリが性能保証できる範囲は、フロントカメラでは7mより近傍だけと定義する。

駐車枠は、白線と同様に路面に存在するが、白線と異なり対象物の大まかなサイズは既知とみなすことができる。当然場所によって駐車枠の大きさに若干の差異はあるものの例えば幅2.2m、奥行き5mの大きさであると駐車枠を定義し、この領域の枠内部の何パーセントを隠す可能性があるかを計算する。実際には、枠線のみが重要で枠内部だけが泥で汚れていても検知可能であるが、車両が動いて見えなくなればアプリとしては性能保証できないことに変わりはないため、枠内部の何パーセントが泥で見えなくなる可能性があるかを計算し、30%を超える場合には、動作保証不可とする。これも奥行き別に実施する。また、駐車枠を利用したアプリでは、車を旋回させながら駐車支援に利用することが多い、このためフロントカメラの左奥7m以降だけが30%を超える泥が付着していたとしても、アプリが性能保証できる範囲は、フロントカメラでは7mより近傍だけと定義する。

<障害物検知>

障害物検知の場合には、車両周囲に存在する立体物全てを検知対象とするため、検知対象物体の大きさを定義することができない。このため障害物検知では、立体物の足元が路面上に存在することを特定することができない場合を、障害物検知の性能保証できないと定義する。このため基本的な考え方は、泥検知領域にあるサイズの路面領域が映っていると仮定した場合に、自車両からどの範囲では遮蔽率が高まって見えないかを距離変換することで、障害物検知の性能保証範囲を決定する。例えば図15(a)に示すように、レンズに付着物1302が付着することによって、上方向の矢印が見えなくなっている領域が存在する場合に、図15(b)に示すように、付着物で背景が見えない領域、すなわちセンシング不可能範囲1303であると判定できる。

障害物検知の場合には、車両周囲に存在する立体物全てを検知対象とするため、検知対象物体の大きさを定義することができない。このため障害物検知では、立体物の足元が路面上に存在することを特定することができない場合を、障害物検知の性能保証できないと定義する。このため基本的な考え方は、泥検知領域にあるサイズの路面領域が映っていると仮定した場合に、自車両からどの範囲では遮蔽率が高まって見えないかを距離変換することで、障害物検知の性能保証範囲を決定する。例えば図15(a)に示すように、レンズに付着物1302が付着することによって、上方向の矢印が見えなくなっている領域が存在する場合に、図15(b)に示すように、付着物で背景が見えない領域、すなわちセンシング不可能範囲1303であると判定できる。

このように立体物の検知対象の大まかな3次元サイズが仮定できる車両検知や歩行者検知では、検知対象である仮定サイズの立体物を想定し、3次元位置を路面上での奥行き方向と、それに直交する横方向に変化させた場合それぞれにおいて画像上でどの程度の汚れで立体物が遮蔽されるかのパーセンテージを算出する。付着物によって遮られるパーセンテージが、閾値を超えた場合には、認識不可能な3次元位置であると判断し、閾値を超えない範囲であれば、認識可能であると判断する。

このように付着物の状態と図16に示すようなアプリ別の対象物の耐久遮蔽率を計算することで、検知対象の検知率が低下する場所を、自車両を中心とした3次元的なエリアとして推定する。ただし、障害物検知のように、物体サイズに定義が無い場合は、足元位置にある一定サイズを仮定し、この領域が見えるかどうかの判定で代用してもよい。

図16は、アプリの認識対象物の標準サイズと耐久遮蔽率を示した表である。ここで、耐久遮蔽率とは、画像上で付着物の大きさが認識対象物の大きさよりもどれくらいのパーセンテージで小さい場合に認識対象物として認識できるかを定義したものである。例えば車両検知では付着物が車両の50%以下の大きさである場合に車両を認識でき、歩行者検知では、付着物が歩行者の40%以下の大きさである場合に車両を認識できるように設定されている。このように画像的にも、3次元的なエリアとしてもカメラのセンシング可能範囲を推定することで、カメラのレンズ状態に応じて変化するセンシング可能範囲をユーザにわかりやすく伝えることを可能とする。

<鮮明度に応じた距離換算部320について>

図3に示す鮮明度に応じた距離換算部320では、鮮明度検知部220の結果、鮮明度の平均値Blaveに基づいて保証検知距離を計算する。まず、各アプリ別に認識対象物体を最大検知距離まで認識するために必要なエッジ強度を得るための必要なレンズ鮮明度の標準鮮明度α1を設定する。図18(a)は、各アプリのエッジ強度と最大検知距離との関係を説明する図である。そして、鮮明度が標準鮮明度α1以上を示している場合には、各アプリは最大検知距離までセンシング動作を保証可能であるが、これが、標準鮮明度α1を下回るにつれて最大検知距離から保証検知距離が短くなる。鮮明度に応じた距離換算部320は、鮮明度が標準鮮明度α1から低下するに応じて保証検知距離を短くする。

図3に示す鮮明度に応じた距離換算部320では、鮮明度検知部220の結果、鮮明度の平均値Blaveに基づいて保証検知距離を計算する。まず、各アプリ別に認識対象物体を最大検知距離まで認識するために必要なエッジ強度を得るための必要なレンズ鮮明度の標準鮮明度α1を設定する。図18(a)は、各アプリのエッジ強度と最大検知距離との関係を説明する図である。そして、鮮明度が標準鮮明度α1以上を示している場合には、各アプリは最大検知距離までセンシング動作を保証可能であるが、これが、標準鮮明度α1を下回るにつれて最大検知距離から保証検知距離が短くなる。鮮明度に応じた距離換算部320は、鮮明度が標準鮮明度α1から低下するに応じて保証検知距離を短くする。

図18(b)は、検知距離と鮮明度との関係を示すグラフであり、鮮明度Blaveが標準鮮明度α1と最低鮮明度α2の中間に存在する場合に、アプリの保証検知距離が変化することを示している。

それぞれのアプリの設定は、図18(a)の表に示すように、各アプリの最大検知距離が存在し、この最大検知距離での範囲を保証する場合には、各アプリごとに設定された標準鮮明度α1以上を鮮明度の平均値Blaveが示す必要がある。鮮明度の平均値Blaveが標準鮮明度α1から低下するにつれて保証検知距離が低下し、対象アプリの最低鮮明度α2に達したところで検知が不可であることを示す。

例えばアプリが車両検知の場合、標準鮮明度0.4のときに最大検知距離10mとなり、最低鮮明度が0.15のときに最小検知距離0mになる。そして、アプリが歩行者検知の場合、標準鮮明度0.5のときに最大検知距離5mとなり、最低鮮明度が0.2のときに最小検知距離0mになる。

図17は、センシング範囲判断部300が鮮明度に応じてセンシング可能範囲を判断する方法を説明する図であり、図17(a)は、鮮明度が低い状態が車載モニタに表示されている例を示しており、図17(b)は、歩行者を認識(センシング)することが不可能なセンシング不可能範囲1331と、認識可能なセンシング可能範囲1332とを車載モニタなどの表示部1330に表示した状態の一例を示している。

例えば図17(a)に示すように、白濁のために鮮明度が低い場合には、図17(b)に示すように、車両前部の車載カメラ101で撮像される画像の所定距離705より遠方全てを使用不可と定義する。所定距離705は、最低鮮明度に近くなるほど車両1に接近し、標準鮮明度に近くなるほど車両1から離れるように設定される。

例えば図17(a)に示すように、白濁のために鮮明度が低い場合には、図17(b)に示すように、車両前部の車載カメラ101で撮像される画像の所定距離705より遠方全てを使用不可と定義する。所定距離705は、最低鮮明度に近くなるほど車両1に接近し、標準鮮明度に近くなるほど車両1から離れるように設定される。

<水滴に応じた距離換算部330について>

図3に示す水滴に応じた距離換算部330では、水滴検知部230の結果に基づいて、各アプリ別にセンシング可能範囲を計算する。水滴検知の結果のSB(x,y)と閾値ThrBに基づいて、各アプリの処理領域内にあり、かつSB(x,y)が閾値ThrBを超えた場合の面積を算出する。これは各アプリの処理領域内で水滴がどれだけの量を付着しているかを示す数値となるため、アプリの処理領域内中の水滴付着面積を処理領域の面積で割ることで、水滴占有率を各アプリごとに求める。

図3に示す水滴に応じた距離換算部330では、水滴検知部230の結果に基づいて、各アプリ別にセンシング可能範囲を計算する。水滴検知の結果のSB(x,y)と閾値ThrBに基づいて、各アプリの処理領域内にあり、かつSB(x,y)が閾値ThrBを超えた場合の面積を算出する。これは各アプリの処理領域内で水滴がどれだけの量を付着しているかを示す数値となるため、アプリの処理領域内中の水滴付着面積を処理領域の面積で割ることで、水滴占有率を各アプリごとに求める。

この水滴占有率を利用して、最大検知距離を決定する。図19(a)に示すように、水滴1902の場合、そのレンズ状態が素早く変化する可能性が高い。例えば、降ってくる雨による影響や、路面上の水分を巻き上げたことにより更なる水滴が付着して、レンズ状態が変化する場合、また、反対に走行中の風や、カメラ起動中の発熱により水滴が減少していくなどレンズ状態は常に変化しうる可能性が高い状態である。このため、現在の水滴の位置により視野が妨げられている箇所1903を視野外や検知不可の領域と判断するのはなく、現在の水滴付着量から、ここしばらくの間のレンズ状態では、遠方や小さな物体の位置を正しく判定することができないため、検知距離を短く設定することで、レンズ状態に応じ動作を保証する。

各アプリ別に、処理エリアが異なるため、水滴に応じた距離換算部330では、この処理領域を考慮した水滴占有率から保証検知距離を算出する。更に、水滴占有率の値から、アプリの最大検知距離をそのまま保証できる水滴占有率を図20(a)に示す耐久水滴占有率とする。更に、アプリの動作自体ができずに検知を保証できなくなる水滴占有率を限界水滴占有率として定める。限界水滴占有率の状態は、すなわち保証検知距離が0mの状態を示し、耐久水滴占有率から限界水滴占有率の間で保証検知距離が、図20(b)に示すように、線形に低下するような仕組みとする。

水滴付着時には、背景の映像が見えづらくなるが、レンズ上の水滴付着量が多いほど画像認識ロジックにとって誤検知や不検知が生じやすい要因となる。このため、レンズに付着した水滴のうち、特に認識対象物を認識するために画像処理する範囲内の水滴付着量を求めることで、各アプリ別に誤検知や不検知の影響が出る度合いとして換算して利用する。例えば、レーン認識の処理領域内の水滴占有率が高い場合には、画像上でレーンが存在すると予想した領域には水滴が大量に付着しており、レーンが適切に認識できない可能性がある。そこで、特に水滴の歪みの影響を受けやすい遠方の検知は、水滴占有率が少し上がった段階で保証対象外とし、水滴占有率が上がるに応じて近傍の距離も徐々に保証対象外としている。

例えば実行中のアプリが車両検知の場合、水滴占有率が耐久水滴占有率35%以下までが最大検知距離10mを保証でき、限界水滴占有率60%よりも大きいときに最小検知距離0mになる。そして、アプリが歩行者検知の場合、水滴占有率が耐久水滴占有率30%のときに最大検知距離5mを保証でき、限界水滴占有率が50%よりも大きいときに最小検知距離0mになる。

図4は、アプリ実行部400の内部機能を説明するブロック図である。

アプリ実行部400は、例えばレーン認識部410、車両検知部420、歩行者検知部430、駐車枠検知部440、障害物検知部450を備えており、予め設定された条件に基づいてそれぞれ実行される。

アプリ実行部400は、例えばレーン認識部410、車両検知部420、歩行者検知部430、駐車枠検知部440、障害物検知部450を備えており、予め設定された条件に基づいてそれぞれ実行される。

アプリ実行部400は、車載カメラ101で撮像された画像を入力として利用し、予防安全や利便性を高めるために画像認識を利用する各種アプリを実行する。

レーン認識部410は、例えば、車線逸脱の警報や防止、車線維持支援、カーブ手前減速などに利用されるレーン認識を実行する。レーン認識部410では、画像上から白線WLの特徴量を抽出し、この特徴量の直線性や曲線性を評価することで、自車両が車線内のどの横位置に存在するか、また車線に対する傾きを示すヨー角、走行車線の曲率等を推定する。そして、推定した車両横位置や、ヨー角、曲率に応じて、自車両が車線から逸脱しそうな場合に、ドライバーにその危険性を伝える警報を鳴らす、もしくは、車線逸脱しそうな場合に、その逸脱を防ぐために自車線に戻す制御を実施する。ただし、車両の制御を実施する際には、車線の認識性能自体が安定的で横位置、ヨー角が精度良く求められていることが条件となる。更に、遠方まで高精度に車線を抽出できている場合には、曲率の推定精度も高く、カーブ中の制御などにも利用可能であり、より滑らかにカーブに沿って走行するためのアシストを実施してもよい。

車両検知部420は、先行車の背面の画像上で四角い形状を特徴量として抽出し、車両候補を抽出する。この候補に対して、背景と異なり自車速で画面上を移動していく静止物体でないことを確認する。また、候補領域に対してパターンマッチングをかけることで、候補の絞り込みに用いても良い。このように車両候補を絞り込み、自車両に対する相対位置を推定することで、自車両と接触、衝突の恐れがあるかなどを判定し、警報対象となるか、もしくは制御対象となるかの判定を実施する。先行車追従のようなアプリケーションとして利用する場合には、先行車両の相対距離に応じて自車速度を制御することで、先行車に衝突しないように自動追従する。

歩行者検知部430は、歩行者の頭部形状もしくは脚部形状などを基にした、特徴量を抽出することで歩行者候補を絞り込む。更に、自車両の移動にともなう静止物の背景の動きと比較して、その歩行者候補の移動が衝突方向に向かっているかなどを判定基準として、移動中の歩行者検知を実施する。パターンマッチングを利用することで、静止歩行者をも対象としても良い。このように歩行者を検知することで、走行中の飛びだしに対する警報や制御が可能となる。また、道路走行中でなくとも駐車所や交差点などといった低速領域でも非常に役に立つアプリケーションとなる。

駐車枠検知部440は、たとえば、時速20km以下のような低速時に、白線認識と同様に、白線の特徴量を抽出する。次に、画面上に存在するあらゆる傾きの直線をハフ変換により抽出する。更に、単なる白線の直線を見つけるのではなく、ドライバーに駐車を促す駐車枠かどうかの判定を実施する。左右枠の幅が車両1を止められる程度の幅であること、更に駐車した場合に車両1の後方もしくは前方にくる車止めブロック、もしくは前後の白線などを検出することで駐車可能領域かどうかを検出する。広い駐車場で駐車枠が遠方まで見えるような場所のときは、複数の枠候補からユーザに駐車枠を選択させることもできるが、近傍の駐車枠のみしか見えないような場合のときには、近くの駐車スペースまで近寄らないと認識できない。また、基本的に車両1の駐車制御に利用させるため、認識が不安定な場合には、制御できないことをユーザに報知する。

障害物検知部450は、画像上で特徴的な点を抽出する。物体の角などで構成される画像上で固有の特徴を持つ特徴点は、次のフレームにおいても、画像上の変化が小さい場合に、同一の特徴を持つ特徴点である、と対応付けをすることができる。この2フレーム間もしくはマルチフレーム間で対応がとれた特徴点を利用して3次元復元を実施する。この時に、自車両との衝突の恐れがあるような障害物を検出する。

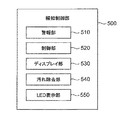

図5は、報知制御部500の内部機能を説明するブロック図である。

報知制御部500は、例えば警報部510、制御部520、ディスプレイ部530、汚れ除去部540、LED表示部550等を備えている。

報知制御部500は、例えば警報部510、制御部520、ディスプレイ部530、汚れ除去部540、LED表示部550等を備えている。

報知制御部500は、センシング範囲判断部300の判断結果を受けて、その情報をユーザに伝えるインタフェース部分をになう。例えばアプリが必要としているセンシング範囲内においてセンシング不可能範囲がなく、全てがセンシング可能範囲となっているときのような正常状態では、緑色のLEDを点灯表示させ、抑制モード中は緑色のLEDを点滅させる。そして、雨天中などの一時的で、早期復帰の可能性があるシステムギブアップ状態ではオレンジ色のLEDを点灯表示させ、レンズに泥や白濁のような長期的な汚れが付着している可能性が高く、ユーザがレンズを拭かなければ、復帰の可能性が低いようなシステムギブアップ状態の場合には赤色のLEDを点灯させる、などのように、ユーザへ現状の予防安全アプリケーションの動作状況とともに、現在のシステムのレンズ汚れによる異常状態をユーザに警告できるようなシステム構成とする。なお、システムギブアップ状態とは、レンズ表面の付着物によって画像認識に適切な撮像が難しいと判断した場合に、予防安全のために認識対象物を認識するアプリケーションを停止する状態を示す。また、認識自体は停止しなくともCAN出力を停止、もしくは、CAN出力は出たままの状態であっても最終出力となる警報や車両制御、画面への表示などにおいて、認識対象物の認識結果をユーザへ伝えないような状態を示す。システムギブアップ状態は、認識対象物の認識結果を提示しない代わりに、ユーザに認識システムがギブアップ状態であることを表示したり、音声などで伝えてもよい。

他にも、予防安全のアプリケーションが、一時的にシステムギブアップ状態に移行する際には、ユーザへ予防安全アプリケーションの停止を警告するディスプレイ表示や、ドライバーの運転を阻害しないように音声で案内する等、レーン認識、車両検知などのアプリケーションが停止状態に移行することをユーザに伝える機能があっても良い。また、復帰時には同様に、復帰したことをユーザに伝える表示や、音声案内があっても良い。また、長期的な汚れが付着したと判断された場合に、レンズ状態は改善したが、道路構造物トラッキング部による視認性の改善が確認されないような状況では、長期ギブアップ時には赤点灯であった表示を、オレンジ色に変更し、レンズの改善を伝えるようにしても良い。ただし、実際には、背景や光源環境の影響を受けただけの可能性もある。また、特に赤色のLEDが点灯するような水滴付着以外の長期的に付着した汚れと判定された場合には、停車時、もしくは発進前などにレンズを拭くようにユーザへ指示を促しても良い。

レンズ状態診断部200で診断されたレンズ状態とセンシング範囲判断部300で判断されたセンシング可能範囲とに基づいた各アプリの動作状況をユーザに伝えることで、ユーザが知らない間に予防安全機能が停止していたということが無いようにする。

これは車線認識が作動していることを期待しているにも関わらず、車線逸脱しても警報がならなかったというようなクレームがなきよう、また、システムの故障などを疑われないように現状のシステム状況をユーザへ告知することで、改善したい場合の対処方法、レンズを拭く、レンズ洗浄用のハードウェアを手動で動作させるなどの改善方法をユーザに伝える意味合いがある。

レンズ汚れによるシステムギブアップ状態において、ユーザによるレンズ表面の汚れ除去などをしなければ状況改善しづらいような状況では、これをユーザへ報知することで、改善を促すとともに、現在のアプリケーションが動いてないことをユーザに報告する。

図21は、認識対象物に応じたセンシング可能範囲を比較する図である。

前方の車載カメラ101に付着している付着物の大きさ及び位置が同じで、各アプリの認識対象物が車両、歩行者、障害物の3種類の場合、認識対象物の大きさが個々に異なるのでセンシング範囲も互いに異なっている。例えば、認識対象物が車両の場合、最小センシング範囲2101の車両前方の長さLa2と、最大センシング範囲2102の車両前方の長さLa1は、歩行者の最小センシング範囲2111の車両前方の長さLp2と、最大センシング範囲2112の車両前方の長さLp1よりも長く、障害物の最小センシング範囲2121の車両前方の長さLm2と、最大センシング範囲2122の車両前方の長さLm1は、歩行者の最小センシング範囲2111の車両前方の長さLp2と、最大センシング範囲2112の車両前方の長さLp1よりも小さくなる。一方、付着物によって背景が隠される角度θは、各アプリの間でもほぼ同じとなるが、認識対象物の大きさに応じて補正がされる。

前方の車載カメラ101に付着している付着物の大きさ及び位置が同じで、各アプリの認識対象物が車両、歩行者、障害物の3種類の場合、認識対象物の大きさが個々に異なるのでセンシング範囲も互いに異なっている。例えば、認識対象物が車両の場合、最小センシング範囲2101の車両前方の長さLa2と、最大センシング範囲2102の車両前方の長さLa1は、歩行者の最小センシング範囲2111の車両前方の長さLp2と、最大センシング範囲2112の車両前方の長さLp1よりも長く、障害物の最小センシング範囲2121の車両前方の長さLm2と、最大センシング範囲2122の車両前方の長さLm1は、歩行者の最小センシング範囲2111の車両前方の長さLp2と、最大センシング範囲2112の車両前方の長さLp1よりも小さくなる。一方、付着物によって背景が隠される角度θは、各アプリの間でもほぼ同じとなるが、認識対象物の大きさに応じて補正がされる。

上記した本発明の周囲環境認識装置1によれば、車載カメラ101のレンズ汚れに応じたセンシング可能範囲をユーザに示すことができ、ユーザは、アプリの認識対象物を認識可能な範囲を知ることができる。したがって、ユーザがアプリを過信して周囲環境への注意が疎かになるのを防ぎ、より注意して運転することを促すことができる。

以上、本発明の実施形態について詳述したが、本発明は、前記の実施形態に限定されるものではなく、特許請求の範囲に記載された本発明の精神を逸脱しない範囲で、種々の設計変更を行うことができるものである。例えば、前記した実施の形態は本発明を分かりやすく説明するために詳細に説明したものであり、必ずしも説明した全ての構成を備えるものに限定されるものではない。また、ある実施形態の構成の一部を他の実施形態の構成に置き換えることが可能であり、また、ある実施形態の構成に他の実施形態の構成を加えることも可能である。さらに、各実施形態の構成の一部について、他の構成の追加・削除・置換をすることが可能である。

10 周囲環境認識装置

100 撮像部

200 自己診断部

210 付着物検知部

220 鮮明度検知部

230 水滴検知部

300 センシング範囲判断部

310 付着物に応じた距離換算部

320 鮮明度に応じた距離換算部

330 水滴付着に応じた距離換算部

400 アプリ実行部

410 レーン認識部

420 車両検知部

430 歩行者検知部

440 駐車枠検知部

450 障害物検知部

500 報知制御部

510 警報部

520 制御部

530 ディスプレイ部

540 汚れ除去部

550 LED表示部

100 撮像部

200 自己診断部

210 付着物検知部

220 鮮明度検知部

230 水滴検知部

300 センシング範囲判断部

310 付着物に応じた距離換算部

320 鮮明度に応じた距離換算部

330 水滴付着に応じた距離換算部

400 アプリ実行部

410 レーン認識部

420 車両検知部

430 歩行者検知部

440 駐車枠検知部

450 障害物検知部

500 報知制御部

510 警報部

520 制御部

530 ディスプレイ部

540 汚れ除去部

550 LED表示部

Claims (6)

- カメラで外部環境を撮像した画像に基づいて周囲環境を認識する周囲環境認識装置であって、

前記画像を取得する画像取得部と、

前記画像から認識対象物を認識するアプリケーションを実行するアプリ実行部と、

前記画像に基づいて前記カメラのレンズ状態を診断するレンズ状態診断部と、

前記アプリケーションを実行した場合に前記レンズ状態診断部で診断したレンズ状態によって前記認識対象物をセンシングすることが可能なセンシング可能範囲と、前記認識対象物をセンシング不可能なセンシング不可能範囲を判断するセンシング範囲判断部と、

該センシング範囲判断部のセンシング可能範囲とセンシング不可能範囲との少なくとも一方を報知する報知部と、

を有することを特徴とする周囲環境認識装置。 - 複数のアプリケーションを備え、

前記センシング範囲判断部は、各アプリケーションが認識する認識対象物に応じて前記センシング可能範囲をそれぞれ判断することを特徴とする請求項1に記載の周囲環境認識装置。 - 前記レンズ状態診断部は、前記レンズに付着した付着物を検知する付着物検知部と、前記レンズの鮮明度を検知する鮮明度検知部と、前記レンズに付着した水滴を検知する水滴検知部の少なくとも一つを備え、

該検知結果に基づいて前記レンズ状態の診断を行うことを特徴とする請求項2に記載の周囲環境認識装置。 - 前記付着物検知部は、前記付着物が前記画像内を占める付着物領域を算出し、

前記センシング範囲判断部は、予め定義されている前記アプリケーションの認識対象物の標準サイズを用いて、前記付着物領域が前記標準サイズの認識対象物を遮蔽する割合を算出し、予め設定された耐久遮蔽率に基づいて前記認識対象物を検知可能な保証検知距離を換算することを特徴とする請求項3に記載の周囲環境認識装置。 - 前記鮮明度検知部は、前記画像に写り込む地平線を含む複数の領域の各エッジを検出し、該各エッジのエッジ強度に基づいて鮮明度を設定し、

前記センシング範囲判断部は、前記鮮明度が低下するに応じて前記認識対象物を検知可能な保証検知距離を短くすることを特徴とする請求項3に記載の周囲環境認識装置。 - 前記水滴検知部は、検知された水滴エリアを利用して、認識アプリ別に各処理領域内の水滴占有率を算出し、この水滴占有率に応じて認識アプリ別に保証検知距離を変更することを特徴とする請求項3に記載の周囲環境認識装置。

Priority Applications (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2014156165A JP2016033729A (ja) | 2014-07-31 | 2014-07-31 | 周囲環境認識装置 |

| PCT/JP2015/068618 WO2016017340A1 (ja) | 2014-07-31 | 2015-06-29 | 周囲環境認識装置 |

| US15/322,839 US20170140227A1 (en) | 2014-07-31 | 2015-06-29 | Surrounding environment recognition device |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2014156165A JP2016033729A (ja) | 2014-07-31 | 2014-07-31 | 周囲環境認識装置 |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2016033729A true JP2016033729A (ja) | 2016-03-10 |

| JP2016033729A5 JP2016033729A5 (ja) | 2017-06-15 |

Family

ID=55217245

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2014156165A Pending JP2016033729A (ja) | 2014-07-31 | 2014-07-31 | 周囲環境認識装置 |

Country Status (3)

| Country | Link |

|---|---|

| US (1) | US20170140227A1 (ja) |

| JP (1) | JP2016033729A (ja) |

| WO (1) | WO2016017340A1 (ja) |

Cited By (9)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2016146135A (ja) * | 2015-02-09 | 2016-08-12 | 株式会社デンソー | 車両用表示制御装置及び車両用表示制御方法 |

| JP2017159884A (ja) * | 2016-03-10 | 2017-09-14 | パナソニック インテレクチュアル プロパティ コーポレーション オブ アメリカPanasonic Intellectual Property Corporation of America | 運転制御装置、運転制御方法及び運転制御プログラム |

| JP2018071994A (ja) * | 2016-10-24 | 2018-05-10 | 株式会社デンソーテン | 付着物検出装置および付着物検出方法 |

| JP2018142756A (ja) * | 2017-02-24 | 2018-09-13 | 京セラ株式会社 | カメラ装置、検出装置、検出システムおよび移動体 |

| JP2019032619A (ja) * | 2017-08-04 | 2019-02-28 | パナソニックIpマネジメント株式会社 | 汚れ検出装置、カメラ、コンピュータプログラムおよび記録媒体 |

| JP2019128797A (ja) * | 2018-01-24 | 2019-08-01 | 株式会社デンソーテン | 付着物検出装置および付着物検出方法 |

| JP2019128798A (ja) * | 2018-01-24 | 2019-08-01 | 株式会社デンソーテン | 付着物検出装置および付着物検出方法 |

| JP2020050119A (ja) * | 2018-09-27 | 2020-04-02 | アイシン精機株式会社 | 付着物検出装置 |

| WO2020100540A1 (ja) * | 2018-11-15 | 2020-05-22 | ソニー株式会社 | 情報処理装置、情報処理システム、および情報処理方法、並びにプログラム |

Families Citing this family (18)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP6520668B2 (ja) * | 2015-02-09 | 2019-05-29 | 株式会社デンソー | 車両用表示制御装置及び車両用表示ユニット |

| JP6661883B2 (ja) * | 2015-02-09 | 2020-03-11 | 株式会社デンソー | 車両用表示制御装置及び車両用表示制御方法 |

| EP3106562A1 (en) * | 2015-06-19 | 2016-12-21 | TF-Technologies A/S | Correction unit |

| JP6556563B2 (ja) * | 2015-08-31 | 2019-08-07 | 株式会社東芝 | 検出装置、検出方法、検出プログラムおよび情報処理システム |

| EP3276079B1 (en) * | 2016-07-26 | 2021-07-14 | Caterpillar Paving Products Inc. | Control system for a road paver |

| US10654422B2 (en) | 2016-08-29 | 2020-05-19 | Razmik Karabed | View friendly monitor systems |

| US20180060685A1 (en) * | 2016-08-29 | 2018-03-01 | Razmik Karabed | View friendly monitor systems |

| JP6930120B2 (ja) * | 2017-02-02 | 2021-09-01 | 株式会社リコー | 表示装置、移動体装置及び表示方法。 |

| KR102356259B1 (ko) * | 2017-03-03 | 2022-01-27 | 삼성전자 주식회사 | 전자 장치 및 전자 장치 제어 방법 |

| US10810773B2 (en) * | 2017-06-14 | 2020-10-20 | Dell Products, L.P. | Headset display control based upon a user's pupil state |

| JP6854890B2 (ja) * | 2017-06-27 | 2021-04-07 | 本田技研工業株式会社 | 通知システムおよびその制御方法、車両、並びにプログラム |

| JP6772113B2 (ja) * | 2017-08-02 | 2020-10-21 | クラリオン株式会社 | 付着物検出装置、および、それを備えた車両システム |

| CN111385411B (zh) * | 2018-12-28 | 2022-04-22 | Jvc建伍株式会社 | 通知控制装置、通知控制方法以及存储介质 |

| JP7251425B2 (ja) * | 2019-09-20 | 2023-04-04 | 株式会社デンソーテン | 付着物検出装置および付着物検出方法 |

| CN111026300B (zh) * | 2019-11-19 | 2021-04-02 | 维沃移动通信有限公司 | 一种屏幕显示方法及电子设备 |

| US11388354B2 (en) | 2019-12-06 | 2022-07-12 | Razmik Karabed | Backup-camera-system-based, on-demand video player |

| JP7077356B2 (ja) | 2020-04-21 | 2022-05-30 | 住友重機械工業株式会社 | 作業機械用周辺監視システム |

| CN113011316B (zh) * | 2021-03-16 | 2023-05-30 | 北京百度网讯科技有限公司 | 一种镜头状态的检测方法、装置、电子设备和介质 |

Citations (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2003259358A (ja) * | 2002-03-06 | 2003-09-12 | Nissan Motor Co Ltd | カメラの汚れ検出装置およびカメラの汚れ検出方法 |

| JP2008197863A (ja) * | 2007-02-13 | 2008-08-28 | Hitachi Ltd | 車載用走行環境認識装置 |

| JP2014013455A (ja) * | 2012-07-03 | 2014-01-23 | Clarion Co Ltd | 車線逸脱警報装置 |

| JP2014030188A (ja) * | 2012-07-03 | 2014-02-13 | Clarion Co Ltd | レンズ付着物検知装置、レンズ付着物検知方法、および、車両システム |

Family Cites Families (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP3655541B2 (ja) * | 2000-09-18 | 2005-06-02 | トヨタ自動車株式会社 | レーン検出装置 |

| JP2012038048A (ja) * | 2010-08-06 | 2012-02-23 | Alpine Electronics Inc | 車両用障害物検出装置 |

-

2014

- 2014-07-31 JP JP2014156165A patent/JP2016033729A/ja active Pending

-

2015

- 2015-06-29 WO PCT/JP2015/068618 patent/WO2016017340A1/ja active Application Filing

- 2015-06-29 US US15/322,839 patent/US20170140227A1/en not_active Abandoned

Patent Citations (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2003259358A (ja) * | 2002-03-06 | 2003-09-12 | Nissan Motor Co Ltd | カメラの汚れ検出装置およびカメラの汚れ検出方法 |

| JP2008197863A (ja) * | 2007-02-13 | 2008-08-28 | Hitachi Ltd | 車載用走行環境認識装置 |

| JP2014013455A (ja) * | 2012-07-03 | 2014-01-23 | Clarion Co Ltd | 車線逸脱警報装置 |

| JP2014030188A (ja) * | 2012-07-03 | 2014-02-13 | Clarion Co Ltd | レンズ付着物検知装置、レンズ付着物検知方法、および、車両システム |

Cited By (12)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2016146135A (ja) * | 2015-02-09 | 2016-08-12 | 株式会社デンソー | 車両用表示制御装置及び車両用表示制御方法 |

| WO2016129233A1 (ja) * | 2015-02-09 | 2016-08-18 | 株式会社デンソー | 車両用表示制御装置及び車両用表示制御方法 |

| JP2017159884A (ja) * | 2016-03-10 | 2017-09-14 | パナソニック インテレクチュアル プロパティ コーポレーション オブ アメリカPanasonic Intellectual Property Corporation of America | 運転制御装置、運転制御方法及び運転制御プログラム |

| JP2018071994A (ja) * | 2016-10-24 | 2018-05-10 | 株式会社デンソーテン | 付着物検出装置および付着物検出方法 |

| JP2018142756A (ja) * | 2017-02-24 | 2018-09-13 | 京セラ株式会社 | カメラ装置、検出装置、検出システムおよび移動体 |

| JP2019032619A (ja) * | 2017-08-04 | 2019-02-28 | パナソニックIpマネジメント株式会社 | 汚れ検出装置、カメラ、コンピュータプログラムおよび記録媒体 |

| JP2019128797A (ja) * | 2018-01-24 | 2019-08-01 | 株式会社デンソーテン | 付着物検出装置および付着物検出方法 |

| JP2019128798A (ja) * | 2018-01-24 | 2019-08-01 | 株式会社デンソーテン | 付着物検出装置および付着物検出方法 |

| JP7059649B2 (ja) | 2018-01-24 | 2022-04-26 | 株式会社デンソーテン | 付着物検出装置および付着物検出方法 |

| JP2020050119A (ja) * | 2018-09-27 | 2020-04-02 | アイシン精機株式会社 | 付着物検出装置 |

| JP7200572B2 (ja) | 2018-09-27 | 2023-01-10 | 株式会社アイシン | 付着物検出装置 |

| WO2020100540A1 (ja) * | 2018-11-15 | 2020-05-22 | ソニー株式会社 | 情報処理装置、情報処理システム、および情報処理方法、並びにプログラム |

Also Published As

| Publication number | Publication date |

|---|---|

| US20170140227A1 (en) | 2017-05-18 |

| WO2016017340A1 (ja) | 2016-02-04 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| WO2016017340A1 (ja) | 周囲環境認識装置 | |

| JP5022609B2 (ja) | 撮像環境認識装置 | |

| JP6246014B2 (ja) | 外界認識システム、車両、及びカメラの汚れ検出方法 | |

| JP6174975B2 (ja) | 周囲環境認識装置 | |

| JP6126094B2 (ja) | 車載用画像認識装置 | |

| US9616856B2 (en) | Lens cleaning apparatus | |

| JP6117634B2 (ja) | レンズ付着物検知装置、レンズ付着物検知方法、および、車両システム | |

| JP5981322B2 (ja) | 車載画像処理装置 | |

| JP5887219B2 (ja) | 車線逸脱警報装置 | |

| CN106489174B (zh) | 通过相机系统跟踪车辆的方法、相机系统以及机动车辆 | |

| CN102779430B (zh) | 基于视觉的夜间后碰撞警告系统、控制器及其操作方法 | |

| US9965690B2 (en) | On-vehicle control device | |

| US9296336B2 (en) | Image display device and image display method | |

| JP5902049B2 (ja) | レンズ白濁状態診断装置 | |

| US8660737B2 (en) | Vehicle handling assistant apparatus | |

| JP2015139128A (ja) | 車両用周辺監視装置 | |

| US20150179074A1 (en) | Vehicle vision system with cross traffic detection | |

| JP5749405B2 (ja) | 車両のフロントガラス上の雨滴を検出するための方法およびカメラアセンブリ | |

| JP2013146029A (ja) | 車両周辺監視装置 | |

| JP2004348645A (ja) | 赤外線画像認識装置、及び赤外線画像認識装置を用いた警報装置 | |

| EP3373196A1 (en) | Device for determining a region of dirt on a vehicle windscreen | |

| Takemura et al. | Development of Lens Condition Diagnosis for Lane Departure Warning by Using Outside Camera | |

| CN110954920B (zh) | 附着物检测装置 | |

| WO2011107115A1 (en) | Method and device of raindrop detection on a windscreen | |

| TWM451611U (zh) | 夜間障礙物偵測系統 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20170426 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20170426 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20180306 |

|

| A02 | Decision of refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A02 Effective date: 20180918 |