WO2018173739A1 - プロジェクターおよびプロジェクターの制御方法 - Google Patents

プロジェクターおよびプロジェクターの制御方法 Download PDFInfo

- Publication number

- WO2018173739A1 WO2018173739A1 PCT/JP2018/008526 JP2018008526W WO2018173739A1 WO 2018173739 A1 WO2018173739 A1 WO 2018173739A1 JP 2018008526 W JP2018008526 W JP 2018008526W WO 2018173739 A1 WO2018173739 A1 WO 2018173739A1

- Authority

- WO

- WIPO (PCT)

- Prior art keywords

- projection

- unit

- image

- projector

- captured image

- Prior art date

Links

Images

Classifications

-

- G—PHYSICS

- G03—PHOTOGRAPHY; CINEMATOGRAPHY; ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ELECTROGRAPHY; HOLOGRAPHY

- G03B—APPARATUS OR ARRANGEMENTS FOR TAKING PHOTOGRAPHS OR FOR PROJECTING OR VIEWING THEM; APPARATUS OR ARRANGEMENTS EMPLOYING ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ACCESSORIES THEREFOR

- G03B17/00—Details of cameras or camera bodies; Accessories therefor

- G03B17/48—Details of cameras or camera bodies; Accessories therefor adapted for combination with other photographic or optical apparatus

- G03B17/54—Details of cameras or camera bodies; Accessories therefor adapted for combination with other photographic or optical apparatus with projector

-

- G—PHYSICS

- G03—PHOTOGRAPHY; CINEMATOGRAPHY; ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ELECTROGRAPHY; HOLOGRAPHY

- G03B—APPARATUS OR ARRANGEMENTS FOR TAKING PHOTOGRAPHS OR FOR PROJECTING OR VIEWING THEM; APPARATUS OR ARRANGEMENTS EMPLOYING ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ACCESSORIES THEREFOR

- G03B21/00—Projectors or projection-type viewers; Accessories therefor

- G03B21/14—Details

- G03B21/142—Adjusting of projection optics

-

- G—PHYSICS

- G03—PHOTOGRAPHY; CINEMATOGRAPHY; ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ELECTROGRAPHY; HOLOGRAPHY

- G03B—APPARATUS OR ARRANGEMENTS FOR TAKING PHOTOGRAPHS OR FOR PROJECTING OR VIEWING THEM; APPARATUS OR ARRANGEMENTS EMPLOYING ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ACCESSORIES THEREFOR

- G03B21/00—Projectors or projection-type viewers; Accessories therefor

- G03B21/14—Details

- G03B21/147—Optical correction of image distortions, e.g. keystone

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N9/00—Details of colour television systems

- H04N9/12—Picture reproducers

- H04N9/31—Projection devices for colour picture display, e.g. using electronic spatial light modulators [ESLM]

- H04N9/3179—Video signal processing therefor

- H04N9/3185—Geometric adjustment, e.g. keystone or convergence

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N9/00—Details of colour television systems

- H04N9/12—Picture reproducers

- H04N9/31—Projection devices for colour picture display, e.g. using electronic spatial light modulators [ESLM]

- H04N9/3191—Testing thereof

- H04N9/3194—Testing thereof including sensor feedback

-

- G—PHYSICS

- G03—PHOTOGRAPHY; CINEMATOGRAPHY; ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ELECTROGRAPHY; HOLOGRAPHY

- G03B—APPARATUS OR ARRANGEMENTS FOR TAKING PHOTOGRAPHS OR FOR PROJECTING OR VIEWING THEM; APPARATUS OR ARRANGEMENTS EMPLOYING ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ACCESSORIES THEREFOR

- G03B21/00—Projectors or projection-type viewers; Accessories therefor

- G03B21/14—Details

- G03B21/145—Housing details, e.g. position adjustments thereof

-

- G—PHYSICS

- G03—PHOTOGRAPHY; CINEMATOGRAPHY; ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ELECTROGRAPHY; HOLOGRAPHY

- G03B—APPARATUS OR ARRANGEMENTS FOR TAKING PHOTOGRAPHS OR FOR PROJECTING OR VIEWING THEM; APPARATUS OR ARRANGEMENTS EMPLOYING ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ACCESSORIES THEREFOR

- G03B5/00—Adjustment of optical system relative to image or object surface other than for focusing

- G03B5/02—Lateral adjustment of lens

Definitions

- the present invention relates to a projector and a projector control method.

- Patent Document 1 describes a projector that corrects trapezoidal distortion of a projected image. Upon receiving an instruction transmitted in response to a remote control operation by a user, the projector described in Patent Literature 1 detects a frame of the screen serving as a projection surface, and trapezoidal distortion so that the projected image fits in the frame (projection area). Perform correction.

- This invention is made in view of the situation mentioned above, and makes it a solution subject to provide the technique which can reduce the user's effort for projecting a projection image on the projection area

- An aspect of the projector includes a projection unit that projects a projection image on a projection surface, an imaging unit that captures the projection surface and generates a captured image, and the projection surface that is disposed on the projection surface based on the captured image. And a detection unit that detects a position of the detachable object that is attached and an adjustment unit that adjusts a projection position of the projection image on the projection surface based on the position of the object.

- the projection position can be automatically adjusted according to the position of the detachable object arranged on the projection surface. For this reason, it becomes possible to reduce a user's effort for projecting a projection image on the projection area of a projection surface.

- the detection unit further detects the movement of the object on the captured image based on the captured image

- the adjustment unit detects the object on the captured image. It is desirable to adjust the projection position when movement is detected.

- the position of the projector or the projection surface is shifted, the relative positional relationship between the projector and the projection surface changes, and the projection position of the projection image is shifted on the projection surface. Further, when the relative positional relationship between the projector and the projection surface changes, the object moves on the captured image.

- the projection position is adjusted when the movement of the object on the captured image is detected. For this reason, according to this aspect, when the projection position is shifted on the projection surface, the projection position can be automatically adjusted.

- the detection unit detects positions of a plurality of detachable objects arranged on the projection surface

- the adjustment unit is configured to detect the projection image based on the positions of the plurality of objects. It is desirable to determine a projection range and adjust the projection position so that the projection image is projected within the projection range. According to this aspect, it becomes possible to project a projection image in the projection range determined based on the positions of a plurality of objects.

- the adjustment unit adjusts the projection position by controlling driving of a position changing unit that changes the projection position. According to this aspect, it is possible to adjust the projection position using the position changing unit.

- the position changing unit changes the projection position by changing a projection direction of the projection image. According to this aspect, it is possible to adjust the projection position by changing the projection direction of the projection image.

- the projection unit includes a projection lens, and a lens shift unit that shifts the projection lens in a direction intersecting the optical axis of the projection lens, and the position changing unit includes A lens shift unit is desirable. According to this aspect, it is possible to adjust the projection position using the lens shift unit.

- the position changing unit changes the projection position by shifting the projection unit.

- the projection position can be adjusted by shifting the projection unit.

- the position changing unit changes the projection position by rotating the projection unit.

- the projection position can be adjusted by rotating the projection unit.

- the projection unit preferably includes a zoom lens and a lens driving unit that changes a zoom state of the zoom lens, and the position changing unit is preferably the lens driving unit. According to this aspect, it is possible to adjust the projection position by changing the zoom state of the zoom lens.

- the adjustment unit adjusts the projection position by adjusting image information indicating the projection image. According to this aspect, it is possible to adjust the projection position by adjusting the image information.

- the object is preferably a retroreflective member.

- the light reflected by the retroreflective member is reflected in the direction of the incident light.

- the imaging part provided with the projection part in the projector becomes easy to receive this reflected light.

- the object is easily displayed on the captured image, and the position of the object is easily detected.

- One aspect of the projector control method includes a step of projecting a projection image onto a projection surface, a step of capturing the projection surface to generate a captured image, and the projection surface based on the captured image.

- the method includes a step of detecting a position of an object arranged detachably, and a step of adjusting a projection position of the projection image on the projection surface based on the position of the object. According to this aspect, it becomes possible to reduce a user's effort for projecting a projection image on the projection area of a projection surface.

- FIG. 1 is a diagram schematically illustrating a projector 1.

- FIG. 2 is a diagram illustrating an example of an imaging unit.

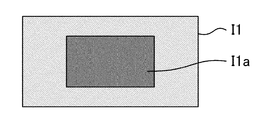

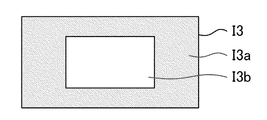

- FIG. It is the figure which showed the installation guide image I1. It is the figure which showed the pattern 12 for position detection. It is the figure which showed the 1st pattern I3. It is the figure which showed the 2nd pattern I4. It is the figure which showed the 3rd pattern I5. It is a flowchart for demonstrating the operation

- FIG. It is the figure which showed the further another example by which the projection image was projected on the projection area

- FIG. It is a flowchart for demonstrating a tracking process. It is the figure which showed the condition when the projection surface 5 rotated. It is the figure which showed the captured image when the projection surface 5 rotated. It is the flowchart which showed the operation

- FIG. 1 is a diagram showing a projector 1 according to a first embodiment to which the present invention is applied.

- the projector 1 is supported by a support device 3 installed on the ceiling 2.

- the support device 3 may be installed not on the ceiling 2 but on a wall or the like.

- FIG. 2 is a diagram illustrating an example of the support device 3.

- the support device 3 includes a base part 31, a first arm part 32, a second arm part 33, a holding part 34, an arm driving part 35, and a rotation driving part 36.

- the base portion 31 is fixed to the ceiling 2 and supports the first arm portion 32.

- the second arm portion 33 is configured to be slidable in the direction of arrow E (the optical axis direction of the projection image of the projector 1) with respect to the first arm portion 32.

- the first arm portion 32 is provided with an arm driving portion 35 that adjusts the sliding amount of the second arm portion 33. Driving by the arm driving unit 35 is controlled by the projector 1.

- the arm drive unit 35 is an example of a position change unit that changes the projection position of the projection image of the projector 1 by shifting the projector 1 (particularly, the projection unit 104).

- the second arm unit 33 supports a holding unit 34 that holds the projector 1.

- the holding portion 34 is configured to be rotatable in the direction of arrow F with the shaft 34a as a rotation axis.

- the second arm portion 33 is provided with a rotation driving portion 36 that adjusts the rotation amount of the holding portion 34.

- the driving by the rotation driving unit 36 is controlled by the projector 1.

- the rotation driving unit 36 is an example of a position changing unit that changes the projection position by changing the projection direction of the projection image of the projector 1.

- the rotation drive unit 36 is an example of a position changing unit that changes the projection position of the projection image of the projector 1 by rotating the projector 1 (in particular, the projection unit 104).

- the projector 1 can adjust the attitude of the projector 1 by controlling the drive of the arm drive unit 35 and the rotation drive unit 36 of the support device 3.

- the projector 1 receives image information from a PC (personal computer) 4 and projects a projection image corresponding to the image information from the projection unit 104 onto the projection surface 5.

- the projection surface 5 is, for example, a projection surface of a magnet screen.

- the magnet screen has a projection surface and a magnet surface that face each other.

- a projection image is projected from the projector 1 onto the projection surface of the magnet screen with the magnet surface attached to a blackboard or the like.

- the projection surface 5 is not limited to the projection surface of the magnet screen, and may be a white board, for example, and can be changed as appropriate.

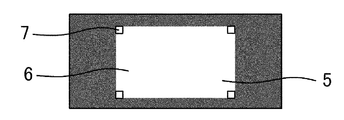

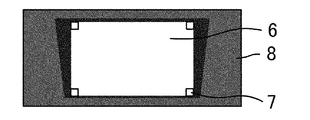

- the user arranges the object 7 on the projection surface 5 to set the projection area 6 on which the user wants to project a projection image on the projection surface 5.

- a rectangular projection area 6 is set by four objects 7. Specifically, the object 7 is arranged at each of the four vertices A to D of the projection area 6.

- the object 7 is detachable from the projection surface 5.

- a retroreflective member provided with a magnet is used as the object 7.

- the object 7 is not limited to the retroreflective member provided with a magnet, and can be changed as appropriate.

- the projector 1 captures the projection surface 5 on which the object 7 is arranged with the image capturing unit 108 and generates a captured image.

- the projector 1 detects the position of the object 7 arranged on the projection surface 5 based on the captured image.

- the projector 1 determines the projection area 6 based on the position of the object 7 and projects a projection image on the projection area 6.

- the projector 1 when the projector 1 repeatedly generates captured images and detects the movement of the object 7 on the captured image (for example, when the projector 1, the projection surface 5, or the object 7 is moved), the movement of the object 7 is performed.

- the projection area 6 is determined based on the later position, and a projection image is projected onto the projection area 6.

- the projector 1 controls both or one of the arm driving unit 35 and the rotation driving unit 36 of the support device 3 to determine the position of the projector 1 relative to the projection surface 5.

- a method of projecting a projected image on the projection area 6 by changing the posture is mentioned.

- the projector 1 performs trapezoidal distortion correction on the projection image so that the projection image is projected onto the projection region 6.

- FIG. 3 is a diagram schematically showing the projector 1.

- the projector 1 includes an operation unit 101, an image processing unit 102, a light valve driving unit 103, a projection unit 104, a light source driving unit 105, a lens driving unit 106, a lens shift unit 107, an imaging unit 108, A storage unit 109, a control unit 110, and a bus 111 are included.

- the image processing unit 102 includes an image composition unit 102a and a trapezoidal distortion correction unit 102b.

- the projection unit 104 includes a light source 11, three liquid crystal light valves 12 (12 R, 12 G, and 12 B) that are examples of a light modulation device, and a projection optical system 13.

- the projection optical system 13 includes a zoom lens 13a and a projection lens 13b.

- optical axis of the zoom lens 13a coincides with the optical axis of the projection lens 13b.

- optical axis 13c the optical axis of the zoom lens 13a and the optical axis of the projection lens 13b are indicated by “optical axis 13c”.

- the operation unit 101 is, for example, various operation buttons, operation keys, or a touch panel.

- the operation unit 101 receives a user's input operation.

- the operation unit 101 may be a remote controller or the like that transmits information according to an input operation wirelessly or by wire.

- the projector 1 includes a receiving unit that receives information transmitted by the remote controller.

- the remote controller includes various operation buttons, operation keys, or a touch panel that receives an input operation.

- the image processing unit 102 performs image processing on the image information to generate an image signal.

- the image processing unit 102 performs image processing on image information (hereinafter also referred to as “received image information”) received from the PC 4 (see FIG. 1) to generate an image signal.

- image information hereinafter also referred to as “received image information”

- the image composition unit 102a composes a plurality of pieces of image information or outputs a single piece of image information. Specifically, the image composition unit 102a synthesizes or outputs image information written in an image memory (hereinafter also referred to as “layer”). The layer may or may not be built in the image composition unit 102a.

- the image composition unit 102a includes two layers, specifically, a first layer and a second layer.

- received image information is written in the first layer.

- the second layer for example, installation guide image information indicating an image for guiding the installation of the projector 1 (hereinafter referred to as “installation guide image”), position detection pattern information indicating a pattern for detecting the position of the object 7 (Image information) and matrix generation pattern information (image information) indicating a pattern for generating a projective transformation matrix are alternatively written.

- the first to third pattern information is used as the matrix generation pattern information.

- the projective transformation matrix will be described later.

- the image composition unit 102a When the image information is written in the first layer and the image information is not written in the second layer, the image composition unit 102a outputs the image information written in the first layer. When the image information is not written in the first layer and the image information is written in the second layer, the image composition unit 102a outputs the image information written in the second layer. When image information is written in both the first layer and the second layer, the image composition unit 102a combines the image information written in the first layer and the image information written in the second layer. Composite image information is generated, and composite image information (image information) is output.

- the trapezoidal distortion correction unit 102b performs trapezoidal distortion correction on the image information output from the image synthesis unit 102a to generate an image signal.

- the trapezoidal distortion correcting unit 102b generates an image signal corresponding to the image information output from the image combining unit 102a when the keystone distortion correction is not performed on the image information output from the image combining unit 102a.

- the light valve driving unit 103 drives the liquid crystal light valve 12 (12R, 12G, 12B) based on the image signal.

- Projection unit 104 projects a projection image on projection surface 5.

- the liquid crystal light valve 12 modulates the light emitted from the light source 11 to form projection image light (projection image), and this projection image light is enlarged and projected from the projection optical system 13.

- the light source 11 is a xenon lamp, an ultra-high pressure mercury lamp, an LED (Light Emitting Diode), or a laser light source.

- the light emitted from the light source 11 is reduced in variation in luminance distribution by an integrator optical system (not shown), and then red (R), green (G), which are the three primary colors of light by a color separation optical system (not shown), It is separated into blue (B) color light components.

- the color light components of R, G, and B are incident on the liquid crystal light valves 12R, 12G, and 12B, respectively.

- the liquid crystal light valve 12 is composed of a liquid crystal panel in which liquid crystal is sealed between a pair of transparent substrates.

- the liquid crystal light valve 12 is formed with a rectangular pixel region 12a composed of a plurality of pixels 12p arranged in a matrix.

- a driving voltage can be applied to the liquid crystal for each pixel 12p.

- each pixel 12p is set to a light transmittance corresponding to the image signal. For this reason, the light emitted from the light source 11 is modulated by transmitting through the pixel region 12a, and an image corresponding to the image signal is formed for each color light.

- the image of each color is synthesized for each pixel 12p by a color synthesis optical system (not shown), and projection image light (projection image) that is color image light (color image) is generated.

- projection image projection image

- color image color image

- the projected image light is enlarged and projected onto the projection surface 5 by the projection optical system 13.

- the light source driving unit 105 drives the light source 11.

- the light source driving unit 105 causes the light source 11 to emit light when the operation unit 101 receives a power-on operation.

- the lens driving unit 106 changes the zoom state of the zoom lens 13a. Specifically, the lens driving unit 106 changes the zoom state of the zoom lens 13a by moving the zoom lens 13a in the direction G along the optical axis 13c.

- the lens driving unit 106 is an example of a position changing unit.

- the lens shift unit 107 can shift the projection optical system 13, more specifically, the projection lens 13b, in a direction H (for example, a direction orthogonal to the optical axis 13c) intersecting the optical axis 13c.

- the lens shift unit 107 can further shift the projection lens 13b in a direction perpendicular to both the optical axis 13c and the direction H.

- the lens shift unit 107 is an example of a position changing unit that changes the projection position by changing the projection direction of the projection image.

- the imaging unit 108 captures the projection surface 5 and generates a captured image.

- FIG. 4 is a diagram illustrating an example of the imaging unit 108.

- the imaging unit 108 is a camera that includes an optical system 21 such as a lens and an imaging element 22 that converts light collected by the optical system 21 into an electrical signal.

- the imaging element 22 is, for example, a CCD (Charge Coupled Device) image sensor or a CMOS (Complementary Metal Oxide Semiconductor) image sensor.

- the imaging unit 108 repeatedly captures the projection surface 5 and generates captured images in time series.

- the storage unit 109 is a computer-readable recording medium.

- the storage unit 109 stores a program that defines the operation of the projector 1 and various information (for example, image information used in the image composition unit 102a).

- the image information used in the image composition unit 102a is, for example, installation guide image information, position detection pattern image information, and first to third pattern information. Note that these pieces of information are not limited to the configuration stored in advance in the storage unit 109, and may be generated each time by a program.

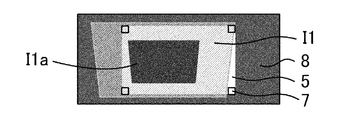

- FIG. 5 shows the installation guide image I1 according to the installation guide image information.

- guide information for guiding the installation of the projector 1 to the user is shown.

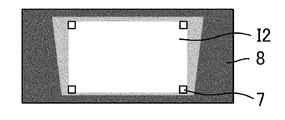

- FIG. 6 is a diagram showing a position detection pattern I2 corresponding to the position detection pattern image information.

- the position detection pattern I2 is used to detect the object 7 arranged on the projection surface 5.

- the position detection pattern image is, for example, a white image as a whole.

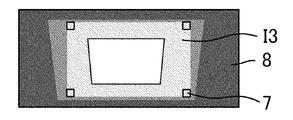

- FIG. 7 shows the first pattern I3 corresponding to the first pattern information.

- the white rectangular pattern I3b is superimposed on the black background I3a.

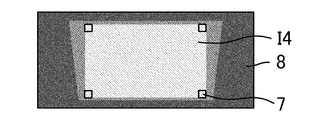

- FIG. 8 is a diagram illustrating a second pattern I4 corresponding to the second pattern information.

- the second pattern I4 is a black image as a whole.

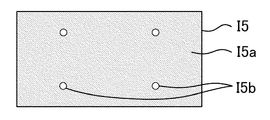

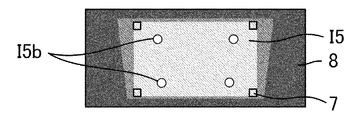

- FIG. 9 is a diagram showing a third pattern I5 corresponding to the third pattern information.

- white dots I5b are superimposed at the same positions as the positions of the four vertices of the rectangular pattern I3b shown in FIG.

- the first pattern I3, the second pattern I4, and the third pattern I5 are used to generate a projective transformation matrix.

- the projective transformation matrix is a matrix for projectively transforming an image in the liquid crystal light valve 12 into a captured image. That is, the projective transformation matrix is information that associates a position between the projection image projected by the projection unit 104 and the captured image obtained by capturing the projection image.

- control unit 110 is a computer such as a CPU (Central Processing Unit).

- the control unit 110 reads and executes a program stored in the storage unit 109 to thereby execute a projection control unit 41, an imaging control unit 42, a position detection unit 43, an adjustment unit 44, a conversion matrix generation unit 45, and the like. Is realized.

- the projection control unit 41 controls the light source driving unit 105 to control the projection image projected by the projection unit 104.

- the imaging control unit 42 controls imaging by the imaging unit 108.

- the position detection unit 43 detects the position of the object 7 arranged on the projection surface 5 based on the captured image. Further, the position detection unit 43 detects the movement of the object 7 on the captured image based on the captured image.

- the position detection unit 43 is an example of a detection unit.

- the adjustment unit 44 adjusts the projection position of the projection image on the projection surface 5 based on the position of the object 7. For example, when the movement of the object 7 is detected, the adjustment unit 44 adjusts the projection position of the projection image on the projection surface 5 based on the position after the movement of the object 7.

- the adjustment unit 44 controls the operation of the trapezoidal distortion correction unit 102b, the lens driving unit 106, the lens shift unit 107, the arm driving unit 35 (see FIG. 2), or the rotation driving unit 36 (see FIG. 2) to control the projection surface. 5 adjusts the projection position of the projected image. For example, the adjustment unit 44 adjusts the projection amount by adjusting the image information by adjusting the correction amount in the trapezoidal distortion correction unit 102b.

- the transformation matrix generation unit 45 generates a projective transformation matrix.

- the transformation matrix generation unit 45 stores the projective transformation matrix in the storage unit 109.

- FIG. 10 is a flowchart for explaining an operation associated with power-on.

- the projection surface 5 such as a magnet screen

- the user sets a plurality of objects 7 (in this embodiment, 4 Two objects 7) are arranged on the projection surface 5 (see FIG. 12).

- the user operates the operation unit (for example, a remote controller) 101 of the projector 1 supported by the support device 3 to turn on the power of the projector 1.

- the projection control unit 41 controls the light source driving unit 105 to turn on the light source 11.

- the user operates the operation unit 101 to input a correction start instruction to start automatic adjustment of the projection position.

- the adjustment unit 44 reads the installation guide image information from the storage unit 109, writes the installation guide image information to the second layer, and further sets the correction amount in the trapezoidal distortion correction unit 102b to zero.

- the image processing unit 102 generates an image signal corresponding to the installation guide image information

- the projection unit 104 projects the installation guide image I1 (see FIG. 5) on the projection surface 5 according to the image signal. (Step S1).

- FIG. 13 is a diagram showing a projection example of the installation guide image I1.

- the guide information shown in the area I1a is “adjust the position of the projector or the like so that the object enters the blue part”. Is used. The guide information is changed as appropriate.

- trapezoidal distortion occurs in the installation guide image I ⁇ b> 1.

- FIG. 14 is a diagram illustrating a state in which manual adjustment has been completed.

- step S2 the adjustment unit 44 starts projection of each pattern and detection of each pattern in order to automatically adjust the projection position.

- the adjustment unit 44 reads the position detection pattern information from the storage unit 109 and writes the position detection pattern information to the second layer. Thereby, the image processing unit 102 generates an image signal corresponding to the position detection pattern information, and the projection unit 104 converts the position detection pattern I2 (see FIG. 6) into the projection surface 5 according to the image signal. (Step S3).

- FIG. 15 is a diagram showing a projection example of the position detection pattern I2.

- the position detection pattern I2 is used to detect light reflected by the object 7.

- a white image is used as the position detection pattern I2 in order to easily detect the reflected light from the object 7.

- the imaging control unit 42 causes the imaging unit 108 to capture the projection surface 5 and generate a captured image (step S4). At this time, the imaging control unit 42 performs exposure control so that the captured image is generated with appropriate brightness.

- the position detection unit 43 analyzes the captured image and detects the position of the object 7 on the captured image (step S5).

- step S5 the following processing is executed. Since the object 7 has a retroreflective member, the brightness of the object 7 is higher than that of the surrounding area on the captured image. For this reason, the position detection unit 43 first detects an area having a higher brightness than the surrounding area on the captured image as an “area where the object 7 exists”. Subsequently, the position detection unit 43 detects, for each object 7, the barycentric position (the barycentric coordinate) of the “region where the object 7 exists” as the “position of the object 7”.

- the object 7 preferably has a shape and reflection characteristics (for example, a characteristic such that the object 7 has a circular shape in plan view and has a higher reflectance as it is closer to the position of the center of gravity). .

- the position of the object 7 is not limited to the position of the center of gravity of the object 7 and can be changed as appropriate.

- the vertex of the object 7 may be used as the position of the object 7.

- the object 7 has a thick three-dimensional shape (such as a sphere or a rectangular parallelepiped)

- the position of the object 7 may be obtained in consideration of an offset amount corresponding to the thickness.

- step S5 the transformation matrix generation unit 45 reads the first pattern information from the storage unit 109 and writes the first pattern information to the second layer. Thereby, the image processing unit 102 generates an image signal corresponding to the first pattern information, and the projection unit 104 projects the first pattern I3 (see FIG. 7) onto the projection surface 5 according to the image signal.

- Step S6 the transformation matrix generation unit 45 reads the first pattern information from the storage unit 109 and writes the first pattern information to the second layer.

- the image processing unit 102 generates an image signal corresponding to the first pattern information

- the projection unit 104 projects the first pattern I3 (see FIG. 7) onto the projection surface 5 according to the image signal.

- FIG. 16 is a diagram illustrating a projection example of the first pattern I3.

- the imaging control unit 42 causes the imaging unit 108 to image the projection surface 5 to generate a first captured image (step S7). Subsequently, the imaging unit 108 outputs the first captured image to the conversion matrix generation unit 45.

- FIG. 17 is a diagram illustrating a projection example of the second pattern I4.

- the imaging control unit 42 causes the imaging unit 108 to image the projection surface 5 to generate a second captured image (step S9). Subsequently, the imaging unit 108 outputs the second captured image to the conversion matrix generation unit 45.

- the conversion matrix generation unit 45 detects the rectangular pattern I3b by taking the difference between the first captured image and the second captured image. Subsequently, the transformation matrix generation unit 45 detects the positions of the four vertices of the rectangular pattern I3b on the captured image (step S10).

- FIG. 18 is a diagram illustrating a projection example of the third pattern I5.

- the imaging control unit 42 causes the imaging unit 108 to image the projection surface 5 to generate a third captured image (step S12). Subsequently, the imaging unit 108 outputs the third captured image to the conversion matrix generation unit 45.

- the transformation matrix generation unit 45 uses the positions of the four vertices detected in step S10 as the search start position of the dot I5b, and “a region where the dot I5b exists” for each dot I5b. Is detected. Subsequently, the conversion matrix generation unit 45 detects, for each dot I5b, the centroid position (centroid coordinates) of the “region where the dot I5b exists” as the “position of the dot I5b” (step S13).

- the transformation matrix generation unit 45 detects the center of gravity of the dots that can be detected with high accuracy based on the vertices of the rectangular pattern that is easy to detect, and thus quickly identifies a predetermined position with high accuracy. be able to.

- the transformation matrix generation unit 45 calculates a projective transformation matrix based on the positional relationship between the barycentric coordinates of the four dots I5b specified by the third pattern information and the barycentric coordinates of the four dots I5b in the captured image. Calculate (step S14). Subsequently, the transformation matrix generation unit 45 stores the projective transformation matrix in the storage unit 109. Note that, when the position accuracy is not so high, the projective transformation matrix may be calculated based on the positions of the four vertices of the rectangular pattern I3b without using the third pattern I5 (dot I5b). In the third pattern I5, a cross mark or the like may be arranged instead of the dot I5b, and the projective transformation matrix may be calculated based on the position of this intersection.

- the position detection unit 43 calculates an inverse matrix of the projective transformation matrix, and converts the position of the object 7 on the captured image into a position on the liquid crystal light valve 12 using this matrix.

- the adjustment unit 44 uses a quadrangular area (an area corresponding to the projection area 6 in the liquid crystal light valve 12) whose apex is the position of the four objects 7 on the liquid crystal light valve 12 as a projection range of the projection image. decide.

- the adjustment unit 44 calculates a trapezoidal distortion correction amount for accommodating the projection image within the projection range of the projection image (step S15).

- the adjustment unit 44 sets the trapezoidal distortion correction amount calculated in step S15 in the trapezoidal distortion correction unit 102b.

- the trapezoidal distortion correction unit 102b executes trapezoidal distortion correction on the output (image information) of the image composition unit 102a based on the trapezoidal distortion correction amount (step S16). For this reason, for example, as shown in FIG. 19, a projection image (for example, an image corresponding to the received image information) is projected onto the projection area 6 specified by the position of the object 7.

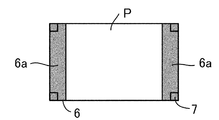

- the adjustment unit 44 may calculate a trapezoidal distortion correction amount for storing the projection image in the projection area while maintaining the aspect ratio of the projection image based on the image information. For example, as shown in FIG. 20, the adjustment unit 44 has a trapezoidal shape so that the entire projection image P is within the projection region 6 and the region 6 a of the projection region 6 where the projection image P does not exist is displayed in black. A distortion correction amount is calculated. In this case, it is possible to suppress the disturbance of the aspect ratio of the projection image P.

- the adjustment unit 44 may calculate the trapezoidal distortion correction amount so that the projection image P is projected on the entire projection region 6 while maintaining the aspect ratio of the projection image P as shown in FIG. .

- the adjustment unit 44 makes the vertical length of the projection image P and the vertical length of the projection area 6 match, or the horizontal length of the projection image P and the horizontal length of the projection area 6 match.

- the trapezoidal distortion correction amount is calculated.

- the size of the projection image P can be increased while suppressing the disturbance of the aspect ratio of the projection image P. It should be noted that it is desirable that the mode of projection image P in FIGS. 19 to 21 can be selected by the user through a menu operation or the like before or after the start of automatic adjustment of the projection position.

- FIG. 22 is a flowchart for explaining the tracking process.

- the same processes as those shown in FIG. 10 are denoted by the same reference numerals.

- processes different from the processes shown in FIG. 10 will be mainly described.

- the tracking process illustrated in FIG. 22 is periodically performed.

- the period (frequency) of the tracking process for example, the user may be able to determine a desired period by menu operation or the like from among hourly, daily, weekly, or monthly units.

- the position detection unit 43 detects the object 7 from the captured image generated by the imaging unit 108 and compares the position of the object 7 detected in the current tracking process with the position of the object 7 detected in the previous tracking process. Then, it is determined whether or not the object 7 has moved (step S21). In the first tracking process after the tracking mode is turned on, since the previous captured image does not exist, the position detection unit 43 determines that the object 7 has not moved. Alternatively, when the tracking mode is turned on, the process shown in FIG. 10 may be executed and the initial position of the object 7 may be stored. In step S21, the following processing is executed.

- the position of each of the four objects 7 on the captured image is moved by moving the magnet screen (projection surface 5), moving the projector 1, or moving the position of the object 7 on the projection surface 5.

- the position detection unit 43 determines that the object 7 has moved. Note that the threshold for determining the movement of the object 7 may be a different threshold depending on the position of the object 7.

- the position detection unit 43 determines that there is no movement of the object 7. For this reason, for example, even if the object 7 moves within a range of a predetermined threshold value or less on the captured image due to vibration of the projection surface 5 or the like, the position detection unit 43 does not move the object 7 substantially. Judge that there is no. Further, for example, a person crosses between the object 7 and the projector 1, and due to the influence, some objects 7 cannot be detected, or only the movement amount of some objects 7 exceeds a predetermined threshold. In addition, the position detection unit 43 determines that the object 7 has not substantially moved.

- the position detection unit 43 may determine that the object 7 has moved when the amount of movement of the object 7 exceeds a predetermined threshold continuously for a predetermined number of times. In this way, for example, when the position of the object 7 moves on the captured image due to temporary vibration, it can be determined that the object 7 has not moved substantially. Further, the position detection unit 43 may determine whether or not the object 7 has moved on the captured image by another method (for example, a combination of the methods described above). For example, when the movement of the positions of at least two objects 7 exceeds a predetermined threshold, the position detection unit 43 may determine that the object 7 has moved.

- step S21: NO If the position detection unit 43 does not detect the movement of the object 7 (step S21: NO), the current tracking process ends.

- step S21 when the position detection unit 43 detects the movement of the object 7 (step S21: YES), first, processing for generating a projective transformation matrix is executed (steps S6 to S14).

- the adjustment unit 44 determines whether or not the position of the object 7 is within the projectable region (step S22). Specifically, the adjustment unit 44 first estimates the position of the pixel area 12a (projectable area) of the liquid crystal light valve 12 on the captured image based on the newly generated projective transformation matrix. Subsequently, when the position of the object 7 is included in the pixel area 12a (projectable area) in the captured image, the adjustment unit 44 determines that the position of the object 7 is within the projectable area. On the other hand, when the position of the object 7 is not included in the pixel area 12a (projectable area) in the captured image, the adjustment unit 44 determines that the position of the object 7 is outside the projectable area.

- steps S15 and S16 are executed, and a projection image is projected onto the projection region 6.

- the adjustment unit 44 drives at least one of the lens driving unit 106, the lens shift unit 107, the arm driving unit 35, and the rotation driving unit 36 in accordance with the movement of the object 7 on the captured image, so that the projector The positional relationship between 1 and the projection surface 5 is changed (step S23).

- the adjustment unit 44 causes the projection lens 13b to move in an amount corresponding to the movement amount in a direction corresponding to the movement.

- the lens shift unit 107 is driven.

- the adjustment unit 44 is narrowed by an amount corresponding to the increase in the interval between the objects 7 on the captured image. As described above (to increase the distance between the projector 1 and the object 7), both or one of the arm driving unit 35 and the lens driving unit 106 is driven.

- the adjustment unit 44 increases the interval between the objects 7 on the captured image. Then, both or one of the arm driving unit 35 and the lens driving unit 106 is driven. For example, when the interval between the objects 7 on the captured image is narrowed, the adjustment unit 44 increases the distance between the objects 7 on the captured image by a predetermined amount (projector 1 and object 7). The arm driving unit 35 and / or the lens driving unit 106 are driven so that the distance of the lens driving unit 35 is shortened.

- the adjustment unit 44 drives the rotation driving unit 36 so that the distance between the object 7a and the object 7d is shortened and the distance between the object 7b and the object 7c is increased in the captured image 9.

- steps S3 to S5 are executed, and then the process returns to step S22.

- the projection position can be automatically adjusted according to the position of the detachable object 7 arranged on the projection surface 5. Even if the positional relationship between the projector 1 and the projection surface 5 changes, the projection position can be automatically adjusted to the projection area. For this reason, it becomes possible to reduce a user's effort.

- the position detection unit 43 may detect the amount of movement of the object 7 on the captured image.

- the adjustment unit 44 moves the lens drive unit 106, the lens shift unit 107, and the arm drive unit so that the projection unit 104 moves by an amount corresponding to the movement amount of the object 7 on the captured image.

- At least one of 35 and the rotation drive unit 36 may be driven.

- the trapezoidal distortion correction is performed using the projective transformation matrix, but the arm is used until the positional relationship between the position of the object 7 and the four vertices of the projection image becomes a predetermined positional relationship based on the captured image. You may perform control which drives the drive part 35 and the rotation drive part 36 little by little.

- the configuration including the lens driving unit 106 that changes the zoom state of the zoom lens 13a and the lens shift unit 107 that shifts the projection lens 13b as the position changing unit is exemplified.

- the position may be changed.

- the image processing unit 102 forms a image in a range smaller than the pixel area 12a of the liquid crystal light valve 12, and the digital zoom that reduces the image, or the digital shift that moves the image reduced by the digital zoom in the pixel area 12a. May be performed.

- the resolution decreases when digital zoom is used it is desirable to lower the priority of adjustment using digital zoom.

- the configuration in which the projector 1 is slid in the optical axis direction (front-rear direction) by the arm driving unit 35 as the position changing unit is exemplified. Further, it may be configured to be able to slide in a plurality of directions among the front-rear direction, the left-right direction, and the vertical direction. Further, in the above embodiment, the configuration in which the projector 1 is horizontally rotated by the rotation driving unit 36 as the position changing unit is exemplified. However, a configuration in which vertical tilt or horizontal roll rotation is possible, horizontal rotation, vertical It is good also as a structure which can be rotated among a tilt and a horizontal roll.

- the rotation drive unit 36 includes a mechanism capable of horizontal rotation, vertical tilt and horizontal roll rotation, the horizontal roll is adjusted after the horizontal rotation and vertical tilt are adjusted to make the projection image rectangular. It is desirable to make adjustments.

- the adjustment unit 44 may adjust the projection position by combining a plurality of position change units, or may perform adjustment using only one position change unit.

- the adjustment unit 44 rotates the three axes of the projector 1 in accordance with the measured inclination by providing a measurement unit that can measure the inclination of the projector 1 with respect to the projection surface 5 using a technique such as triangulation. You may make it the structure which adjusts.

- the number of objects 7 may be greater than four.

- the object 7 is used to specify the projection area and is used to detect movement on the captured image.

- the object used for specifying the projection area and the object used for detecting movement on the captured image may be different.

- each object in the captured image Can be identified.

- the number of objects used for detecting movement on the captured image is not limited to four and can be changed as appropriate.

- the number of objects used for specifying the projection area is not limited to four, and may be two or more. For example, when the number of objects used for specifying the projection area is 2, these two objects are installed at diagonal positions of the rectangular projection area.

- the object 7 has a reflection characteristic different from the reflection characteristic of the projection surface 5. Further, if the reflection characteristics of the object 7 can be changed by switching the reflection surface itself or switching the optical filter, the object 7 can be easily detected on various projection surfaces 5. In this case, if the object 7 includes means for receiving a control signal by wireless communication or infrared communication and means for changing the reflection characteristic based on the received control signal, the user can obtain the reflection characteristic by operating the remote controller. Can be changed. Further, the projector 1 may transmit a control signal based on the image captured by the imaging unit 108 to the object 7 so that the reflection characteristics are automatically switched.

- FIG. 25 is a flowchart showing an operation example when the tracking process shown in FIG. 22 is performed instead of the manual adjustment.

- FIG. 25 the same processes as those shown in FIG. 22 are denoted by the same reference numerals.

- the image composition unit 102a may use the image information stored in the storage unit 109 instead of the received image information.

- All or part of the elements realized by the control unit 110 executing the program may be realized by hardware by an electronic circuit such as an FPGA (field programmable gate array) or an ASIC (Application Specific IC). It may be realized by cooperation of software and hardware.

- an electronic circuit such as an FPGA (field programmable gate array) or an ASIC (Application Specific IC). It may be realized by cooperation of software and hardware.

- a liquid crystal light valve is used as the light modulation device, but the light modulation device is not limited to the liquid crystal light valve and can be changed as appropriate.

- the light modulation device is composed of a system combining one liquid crystal panel and a color wheel, a system using three digital mirror devices (DMD), and a system combining one digital mirror device and a color wheel. It may be.

- DMD digital mirror devices

- a configuration capable of modulating the light emitted from the light source can be employed as the light modulation device.

Landscapes

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Signal Processing (AREA)

- Optics & Photonics (AREA)

- Geometry (AREA)

- Projection Apparatus (AREA)

- Transforming Electric Information Into Light Information (AREA)

- Controls And Circuits For Display Device (AREA)

Abstract

投射面の投射領域に投射画像を投射させるための使用者の手間を低減できる技術を提供する。 プロジェクターは、投射画像を投射面に投射する投射部と、投射面を撮像して撮像画像を生成する撮像部と、撮像画像に基づいて、投射面に配置された着脱自在のオブジェクトの位置を検出する検出部と、オブジェクトの位置に基づいて、投射面における投射画像の投射位置を調整する調整部と、を有する。

Description

本発明は、プロジェクターおよびプロジェクターの制御方法に関する。

特許文献1には、投射画像の台形歪を補正するプロジェクターが記載されている。特許文献1に記載のプロジェクターは、使用者によるリモコン操作に応じて送信される指示を受信すると、投射面となるスクリーンの枠を検出し、投射画像が枠(投射領域)に収まるように台形歪補正を実行する。

ところで、投射面に着脱自在に配置されるオブジェクト(例えば、マグネット付き部材)を使って、投射面に投射画像の投射領域を設定することが考えられる。

この場合、特許文献1に記載のプロジェクターの使用者は、オブジェクトを使って投射面に投射領域を設定するごとにリモコンを操作する必要があり、手間がかかってしまう。また、投射面とプロジェクターとの位置関係が変化した場合にも、使用者はリモコンを操作する必要があり、手間がかかってしまう。

この場合、特許文献1に記載のプロジェクターの使用者は、オブジェクトを使って投射面に投射領域を設定するごとにリモコンを操作する必要があり、手間がかかってしまう。また、投射面とプロジェクターとの位置関係が変化した場合にも、使用者はリモコンを操作する必要があり、手間がかかってしまう。

本発明は上述した事情に鑑みてなされたものであり、投射面の投射領域に投射画像を投射させるための使用者の手間を低減できる技術を提供することを解決課題とする。

本発明に係るプロジェクターの一態様は、投射画像を投射面に投射する投射部と、前記投射面を撮像して撮像画像を生成する撮像部と、前記撮像画像に基づいて、前記投射面に配置された着脱自在のオブジェクトの位置を検出する検出部と、前記オブジェクトの位置に基づいて、前記投射面における前記投射画像の投射位置を調整する調整部と、を有することを特徴とする。

この態様によれば、投射面に配置された着脱自在のオブジェクトの位置に応じて投射位置を自動的に調整することが可能になる。このため、投射面の投射領域に投射画像を投射させるための使用者の手間を低減することが可能になる。

この態様によれば、投射面に配置された着脱自在のオブジェクトの位置に応じて投射位置を自動的に調整することが可能になる。このため、投射面の投射領域に投射画像を投射させるための使用者の手間を低減することが可能になる。

上述したプロジェクターの一態様において、前記検出部は、さらに、前記撮像画像に基づいて、前記撮像画像上での前記オブジェクトの移動を検出し、前記調整部は、前記撮像画像上での前記オブジェクトの移動が検出された場合に、前記投射位置を調整することが望ましい。

プロジェクターまたは投射面の位置がずれると、プロジェクターと投射面との相対的な位置関係が変化して、投射面において投射画像の投射位置がずれる。また、プロジェクターと投射面との相対的な位置関係が変化すると、撮像画像上でオブジェクトが移動する。

この態様によれば、撮像画像上でのオブジェクトの移動が検出された場合に、投射位置が調整される。このため、この態様によれば、投射面において投射位置がずれた場合に、投射位置を自動的に調整することが可能になる。

プロジェクターまたは投射面の位置がずれると、プロジェクターと投射面との相対的な位置関係が変化して、投射面において投射画像の投射位置がずれる。また、プロジェクターと投射面との相対的な位置関係が変化すると、撮像画像上でオブジェクトが移動する。

この態様によれば、撮像画像上でのオブジェクトの移動が検出された場合に、投射位置が調整される。このため、この態様によれば、投射面において投射位置がずれた場合に、投射位置を自動的に調整することが可能になる。

上述したプロジェクターの一態様において、前記検出部は、前記投射面に配置された着脱自在の複数のオブジェクトの位置を検出し、前記調整部は、前記複数のオブジェクトの位置に基づいて前記投射画像の投射範囲を決定し、前記投射画像が前記投射範囲内に投射されるように前記投射位置を調整することが望ましい。この態様によれば、複数のオブジェクトの位置に基づいて決定された投射範囲に、投射画像を投射することが可能になる。

上述したプロジェクターの一態様において、前記調整部は、前記投射位置を変更する位置変更部の駆動を制御することによって前記投射位置を調整することが望ましい。この態様によれば、位置変更部を用いて投射位置を調整することが可能になる。

上述したプロジェクターの一態様において、前記位置変更部は、前記投射画像の投射方向を変更することによって前記投射位置を変更することが望ましい。この態様によれば、投射画像の投射方向を変更して投射位置を調整することが可能になる。

上述したプロジェクターの一態様において、前記投射部は、投射レンズと、前記投射レンズを前記投射レンズの光軸と交差する方向にシフトするレンズシフト部と、を有し、前記位置変更部は、前記レンズシフト部であることが望ましい。この態様によれば、レンズシフト部を用いて投射位置を調整することが可能になる。

上述したプロジェクターの一態様において、前記位置変更部は、前記投射部をシフトすることによって前記投射位置を変更することが望ましい。この態様によれば、投射部をシフトして投射位置を調整することが可能になる。

上述したプロジェクターの一態様において、前記位置変更部は、前記投射部を回転させることによって前記投射位置を変更することが望ましい。この態様によれば、投射部を回転して投射位置を調整することが可能になる。

上述したプロジェクターの一態様において、前記投射部は、ズームレンズと、前記ズームレンズのズーム状態を変更するレンズ駆動部と、を有し、前記位置変更部は、前記レンズ駆動部であることが望ましい。この態様によれば、ズームレンズのズーム状態を変更して投射位置を調整することが可能になる。

上述したプロジェクターの一態様において、前記調整部は、前記投射画像を示す画像情報を調整することによって前記投射位置を調整することが望ましい。この態様によれば、画像情報を調整して投射位置を調整することが可能になる。

上述したプロジェクターの一態様において、前記オブジェクトは、再帰性反射部材であることが望ましい。再帰性反射部材で反射された光は、入射した光の方向に反射される。このため、プロジェクターに投射部と共に設けられた撮像部は、この反射光を受光しやすくなる。このため、この態様によれば、撮像画像にオブジェクトが表示されやすくなり、オブジェクトの位置を検出しやすくなる。

本発明に係るプロジェクターの制御方法の一態様は、投射画像を投射面に投射するステップと、前記投射面を撮像して撮像画像を生成するステップと、前記撮像画像に基づいて、前記投射面に着脱自在に配置されたオブジェクトの位置を検出するステップと、前記オブジェクトの位置に基づいて、前記投射面における前記投射画像の投射位置を調整するステップと、を有することを特徴する。

この態様によれば、投射面の投射領域に投射画像を投射させるための使用者の手間を低減することが可能になる。

この態様によれば、投射面の投射領域に投射画像を投射させるための使用者の手間を低減することが可能になる。

以下、図面を参照しながら本発明に係る実施の形態を説明する。なお、図面において各部の寸法および縮尺は実際のものと適宜異なる。また、以下に記載する実施の形態は、本発明の好適な具体例である。このため、本実施形態には、技術的に好ましい種々の限定が付されている。しかしながら、本発明の範囲は、以下の説明において特に本発明を限定する旨の記載がない限り、これらの形態に限られるものではない。

<第1実施形態>

図1は、本発明を適用した第1実施形態に係るプロジェクター1を示した図である。プロジェクター1は、天井2に設置された支持装置3によって支持されている。なお、支持装置3は、天井2ではなく、壁等に設置されてもよい。

図1は、本発明を適用した第1実施形態に係るプロジェクター1を示した図である。プロジェクター1は、天井2に設置された支持装置3によって支持されている。なお、支持装置3は、天井2ではなく、壁等に設置されてもよい。

図2は、支持装置3の一例を示した図である。支持装置3は、ベース部31と、第1アーム部32と、第2アーム部33と、保持部34と、アーム駆動部35と、回転駆動部36と、を含む。

ベース部31は、天井2に固定され、第1アーム部32を支持する。第2アーム部33は、第1アーム部32に対して矢印E方向(プロジェクター1の投射画像の光軸方向)にスライド可能に構成されている。第1アーム部32には、第2アーム部33のスライド量を調整するアーム駆動部35が設けられている。アーム駆動部35による駆動は、プロジェクター1によって制御される。アーム駆動部35は、プロジェクター1(特には、投射部104)をシフトすることによってプロジェクター1の投射画像の投射位置を変更する位置変更部の一例である。第2アーム部33は、プロジェクター1を保持する保持部34を支持する。保持部34は、軸34aを回転軸として矢印F方向に回転可能に構成されている。第2アーム部33には、保持部34の回転量を調整する回転駆動部36が設けられている。回転駆動部36による駆動は、プロジェクター1によって制御される。回転駆動部36は、プロジェクター1の投射画像の投射方向を変更することによって投射位置を変更する位置変更部の一例である。さらに言えば、回転駆動部36は、プロジェクター1(特には、投射部104)を回転させることによってプロジェクター1の投射画像の投射位置を変更する位置変更部の一例である。

ベース部31は、天井2に固定され、第1アーム部32を支持する。第2アーム部33は、第1アーム部32に対して矢印E方向(プロジェクター1の投射画像の光軸方向)にスライド可能に構成されている。第1アーム部32には、第2アーム部33のスライド量を調整するアーム駆動部35が設けられている。アーム駆動部35による駆動は、プロジェクター1によって制御される。アーム駆動部35は、プロジェクター1(特には、投射部104)をシフトすることによってプロジェクター1の投射画像の投射位置を変更する位置変更部の一例である。第2アーム部33は、プロジェクター1を保持する保持部34を支持する。保持部34は、軸34aを回転軸として矢印F方向に回転可能に構成されている。第2アーム部33には、保持部34の回転量を調整する回転駆動部36が設けられている。回転駆動部36による駆動は、プロジェクター1によって制御される。回転駆動部36は、プロジェクター1の投射画像の投射方向を変更することによって投射位置を変更する位置変更部の一例である。さらに言えば、回転駆動部36は、プロジェクター1(特には、投射部104)を回転させることによってプロジェクター1の投射画像の投射位置を変更する位置変更部の一例である。

プロジェクター1は、支持装置3のアーム駆動部35および回転駆動部36の駆動を制御することで、プロジェクター1の姿勢を調整できる。図1に戻って、プロジェクター1は、PC(パーソナルコンピューター)4から画像情報を受け取り、その画像情報に応じた投射画像を投射部104から投射面5に投射する。

投射面5は、例えば、マグネットスクリーンの投射面である。マグネットスクリーンは、互いに対向する投射面とマグネット面とを有している。マグネットスクリーンの使用の一態様としては、マグネット面が黒板等に張り付けられた状態で、プロジェクター1から、マグネットスクリーンの投射面に投射画像が投射される。なお、投射面5は、マグネットスクリーンの投射面に限らず、例えば、ホワイトボードでもよく適宜変更可能である。

使用者は、投射面5にオブジェクト7を配置することで、投射面5において使用者が投射画像を投射させたい投射領域6を設定する。図1では、4つのオブジェクト7によって四角形の投射領域6が設定されている。具体的には、投射領域6の4つの頂点A~Dの各々の位置にオブジェクト7が配置されている。オブジェクト7は、投射面5に対して着脱自在である。本実施形態では、オブジェクト7として、マグネットを備えた再帰性反射部材が用いられている。なお、オブジェクト7は、マグネットを備えた再帰性反射部材に限らず適宜変更可能である。

プロジェクター1は、オブジェクト7が配置された投射面5を撮像部108で撮像して撮像画像を生成する。プロジェクター1は、撮像画像に基づいて、投射面5に配置されたオブジェクト7の位置を検出する。プロジェクター1は、オブジェクト7の位置に基づいて投射領域6を決定し、投射領域6に投射画像を投射する。

例えば、プロジェクター1は、撮像画像を繰り返し生成し、撮像画像上でのオブジェクト7の移動を検出した場合(例えば、プロジェクター1、投射面5またはオブジェクト7が動かされた場合)に、オブジェクト7の移動後の位置に基づいて投射領域6を決定し、投射領域6に投射画像を投射する。

投射領域6に投射画像を投射する1つの手法としては、プロジェクター1が、支持装置3のアーム駆動部35と回転駆動部36との両方または一方を制御してプロジェクター1の投射面5に対する位置や姿勢を変更することによって投射領域6に投射画像を投射する手法が挙げられる。

他の手法としては、プロジェクター1が、投射領域6に投射画像が投射されるように投射画像に対し台形歪補正を実行する手法が挙げられる。

他の手法としては、プロジェクター1が、投射領域6に投射画像が投射されるように投射画像に対し台形歪補正を実行する手法が挙げられる。

図3は、プロジェクター1を模式的に示した図である。プロジェクター1は、操作部101と、画像処理部102と、ライトバルブ駆動部103と、投射部104と、光源駆動部105と、レンズ駆動部106と、レンズシフト部107と、撮像部108と、記憶部109と、制御部110と、バス111と、を含む。画像処理部102は、画像合成部102aと、台形歪補正部102bと、を含む。投射部104は、光源11と、光変調装置の一例である3つの液晶ライトバルブ12(12R,12G,12B)と、投射光学系13と、を含む。投射光学系13は、ズームレンズ13aと、投射レンズ13bと、を含む。ズームレンズ13aの光軸は、投射レンズ13bの光軸と一致している。図3では、ズームレンズ13aの光軸と投射レンズ13bの光軸とを「光軸13c」で示している。

操作部101は、例えば、各種の操作ボタン、操作キーまたはタッチパネルである。操作部101は、使用者の入力操作を受け取る。なお、操作部101は、入力操作に応じた情報を無線または有線で送信するリモートコントローラー等であってもよい。その場合、プロジェクター1は、リモートコントローラーが送信した情報を受信する受信部を備える。リモートコントローラーは、入力操作を受け取る各種の操作ボタン、操作キーまたはタッチパネルを備える。

画像処理部102は、画像情報に画像処理を施して画像信号を生成する。例えば、画像処理部102は、PC4(図1参照)から受信した画像情報(以下「受信画像情報」とも称する)に画像処理を施して画像信号を生成する。

画像合成部102aは、複数の画像情報を合成したり、単一の画像情報を出力したりする。具体的には、画像合成部102aは、画像メモリー(以下「レイヤー」とも称する)に書き込まれた画像情報を合成したり出力したりする。レイヤーは、画像合成部102aに内蔵されてもよいし内蔵されていなくてもよい。

画像合成部102aは、2つのレイヤー、具体的には、第1レイヤーと第2レイヤーとを備えている。第1レイヤーには、例えば、受信画像情報が書き込まれる。第2レイヤーには、例えば、プロジェクター1の設置をガイドする画像(以下「設置ガイド画像」と称する)を示す設置ガイド画像情報、オブジェクト7の位置を検出するためのパターンを示す位置検出用パターン情報(画像情報)、および射影変換行列を生成するためのパターンを示す行列生成用パターン情報(画像情報)が択一的に書き込まれる。本実施形態では、行列生成用パターン情報として、第1~第3パターン情報が用いられる。射影変換行列については後述する。

第1レイヤーに画像情報が書き込まれており、第2レイヤーに画像情報が書き込まれていない場合、画像合成部102aは、第1レイヤーに書き込まれた画像情報を出力する。第1レイヤーに画像情報が書き込まれておらず、第2レイヤーに画像情報が書き込まれている場合、画像合成部102aは、第2レイヤーに書き込まれた画像情報を出力する。第1レイヤーと第2レイヤーとの双方に画像情報が書き込まれている場合、画像合成部102aは、第1レイヤーに書き込まれた画像情報と、第2レイヤーに書き込まれた画像情報とを合成して合成画像情報を生成し、合成画像情報(画像情報)を出力する。

台形歪補正部102bは、画像合成部102aが出力した画像情報に台形歪補正を施して画像信号を生成する。台形歪補正部102bは、画像合成部102aが出力した画像情報に台形歪補正を施さない場合、画像合成部102aが出力した画像情報に応じた画像信号を生成する。

ライトバルブ駆動部103は、画像信号に基づいて液晶ライトバルブ12(12R,12G,12B)を駆動する。

投射部104は、投射面5に投射画像を投射する。投射部104では、光源11から射出された光を液晶ライトバルブ12が変調して投射画像光(投射画像)を形成し、この投射画像光が投射光学系13から拡大投射される。

光源11は、キセノンランプ、超高圧水銀ランプ、LED(Light Emitting Diode)、またはレーザー光源等である。光源11から射出された光は、不図示のインテグレーター光学系によって輝度分布のばらつきが低減され、その後、不図示の色分離光学系によって光の3原色である赤色(R)、緑色(G)、青色(B)の色光成分に分離される。R,G,Bの色光成分は、それぞれ液晶ライトバルブ12R,12G,12Bに入射する。

液晶ライトバルブ12は、一対の透明基板間に液晶が封入された液晶パネル等によって構成される。液晶ライトバルブ12には、マトリクス状に配列された複数の画素12pからなる矩形の画素領域12aが形成されている。液晶ライトバルブ12では、液晶に対して画素12pごとに駆動電圧を印加することができる。ライトバルブ駆動部103が、画像処理部102から入力される画像信号に応じた駆動電圧を各画素12pに印加すると、各画素12pは、画像信号に応じた光透過率に設定される。このため、光源11から射出された光は、画素領域12aを透過することで変調され、画像信号に応じた画像が色光ごとに形成される。

各色の画像は、図示しない色合成光学系によって画素12pごとに合成され、カラー画像光(カラー画像)である投射画像光(投射画像)が生成される。投射画像光は、投射光学系13によって投射面5に拡大投射される。

光源駆動部105は、光源11を駆動する。例えば、光源駆動部105は、操作部101が電源オン操作を受け取ると、光源11を発光させる。

レンズ駆動部106は、ズームレンズ13aのズーム状態を変更する。具体的には、レンズ駆動部106は、光軸13cに沿ってズームレンズ13aを方向Gに移動することでズームレンズ13aのズーム状態を変更する。レンズ駆動部106は、位置変更部の一例である。

レンズシフト部107は、投射光学系13、さらに言えば投射レンズ13bを、光軸13cと交差する方向H(例えば、光軸13cと直交する方向)にシフトできる。レンズシフト部107は、さらに、投射レンズ13bを、光軸13cと方向Hとの両方に垂直な方向にシフトできる。レンズシフト部107は、投射画像の投射方向を変更することによって投射位置を変更する位置変更部の一例である。

撮像部108は、投射面5を撮像して撮像画像を生成する。

図4は、撮像部108の一例を示した図である。撮像部108は、レンズ等の光学系21と、光学系21にて集光された光を電気信号に変換する撮像素子22等を備えたカメラである。撮像素子22は、例えば、CCD(Charge Coupled Device)イメージセンサーまたはCMOS(Complementary Metal Oxide Semiconductor)イメージセンサーである。撮像部108は、投射面5を繰り返し撮像して撮像画像を時系列で生成する。

図4は、撮像部108の一例を示した図である。撮像部108は、レンズ等の光学系21と、光学系21にて集光された光を電気信号に変換する撮像素子22等を備えたカメラである。撮像素子22は、例えば、CCD(Charge Coupled Device)イメージセンサーまたはCMOS(Complementary Metal Oxide Semiconductor)イメージセンサーである。撮像部108は、投射面5を繰り返し撮像して撮像画像を時系列で生成する。

図3に戻って、記憶部109は、コンピューターが読み取り可能な記録媒体である。記憶部109は、プロジェクター1の動作を規定するプログラムと、種々の情報(例えば、画像合成部102aで使用される画像情報)とを記憶している。画像合成部102aで使用される画像情報は、例えば、設置ガイド画像情報と、位置検出用パターン画像情報と、第1~第3パターン情報である。なお、これらの情報は、記憶部109に予め記憶されている構成に限定されず、プログラムにより都度生成される構成であってもよい。

図5は、設置ガイド画像情報に応じて設置ガイド画像I1を示した図である。設置ガイド画像I1の領域I1aには、使用者にプロジェクター1の設置をガイドするガイド情報が示される。

図6は、位置検出用パターン画像情報に応じた位置検出用パターンI2を示した図である。位置検出用パターンI2は、投射面5に配置されたオブジェクト7を検出するために用いられる。位置検出用パターン画像は、例えば、全体が白色の画像である。

図7は、第1パターン情報に応じた第1パターンI3を示した図である。第1パターンI3では、黒色の背景I3aの上に、白色の矩形パターンI3bが重畳されている。図8は、第2パターン情報に応じた第2パターンI4を示した図である。第2パターンI4は、全体が黒色の画像である。図9は、第3パターン情報に応じた第3パターンI5を示した図である。第3パターンI5では、黒色の背景I5aの上において、図7に示した矩形パターンI3bの4つの頂点の位置と同じ位置に白色のドットI5bが重畳されている。

第1パターンI3と第2パターンI4と第3パターンI5は、射影変換行列を生成するために用いられる。射影変換行列は、液晶ライトバルブ12における画像を撮像画像に射影変換するための行列である。すなわち、射影変換行列は、投射部104が投射した投射画像と、投射画像を撮像した撮像画像との間で位置を対応づける情報である。

図3に戻って、制御部110は、CPU(Central Processing Unit)等のコンピューターである。制御部110は、記憶部109に記憶されているプログラムを読み取り実行することによって、投射制御部41と、撮像制御部42と、位置検出部43と、調整部44と、変換行列生成部45とを実現する。

投射制御部41は、光源駆動部105を制御して投射部104による投射画像の投射を制御する。撮像制御部42は、撮像部108による撮像を制御する。

位置検出部43は、投射面5に配置されたオブジェクト7の位置を、撮像画像に基づいて検出する。また、位置検出部43は、撮像画像に基づいて、撮像画像上でのオブジェクト7の移動を検出する。位置検出部43は、検出部の一例である。

調整部44は、オブジェクト7の位置に基づいて、投射面5における投射画像の投射位置を調整する。例えば、調整部44は、オブジェクト7の移動が検出された場合、オブジェクト7の移動後の位置に基づいて、投射面5における投射画像の投射位置を調整する。調整部44は、台形歪補正部102b、レンズ駆動部106、レンズシフト部107、アーム駆動部35(図2参照)、または回転駆動部36(図2参照)の動作を制御して、投射面5における投射画像の投射位置を調整する。例えば、調整部44は、台形歪補正部102bでの補正量を調整することで画像情報を調整して投射位置を調整する。

変換行列生成部45は、射影変換行列を生成する。変換行列生成部45は、射影変換行列を記憶部109に記憶する。

変換行列生成部45は、射影変換行列を生成する。変換行列生成部45は、射影変換行列を記憶部109に記憶する。

次に、動作を説明する。

まず、電源投入時の動作について説明する。図10は、電源投入に伴う動作を説明するためのフローチャートである。以下では、第1レイヤーに画像情報が書き込まれていないとする。

図11に示したように、マグネットスクリーン等の投射面5が、黒板8に設置されている状況で、使用者は、投射領域6を設定するために複数のオブジェクト7(本実施形態では、4つのオブジェクト7)を投射面5に配置する(図12参照)。

まず、電源投入時の動作について説明する。図10は、電源投入に伴う動作を説明するためのフローチャートである。以下では、第1レイヤーに画像情報が書き込まれていないとする。

図11に示したように、マグネットスクリーン等の投射面5が、黒板8に設置されている状況で、使用者は、投射領域6を設定するために複数のオブジェクト7(本実施形態では、4つのオブジェクト7)を投射面5に配置する(図12参照)。

続いて、使用者は、支持装置3に支持されているプロジェクター1の操作部(例えば、リモコン)101を操作してプロジェクター1の電源をオンする。プロジェクター1が電源オンに伴い起動すると、投射制御部41は、光源駆動部105を制御して光源11を点灯させる。

続いて、使用者は、操作部101を操作して、投射位置の自動調整を開始する旨の補正開始指示を入力する。補正開始指示が入力されると、調整部44は、記憶部109から設置ガイド画像情報を読み取り、設置ガイド画像情報を第2レイヤーに書き込み、さらに台形歪補正部102bでの補正量をゼロにする。これにより、画像処理部102は、設置ガイド画像情報に応じた画像信号を生成し、投射部104は、この画像信号に応じて設置ガイド画像I1(図5参照)を、投射面5に投射する(ステップS1)。

図13は、設置ガイド画像I1の投射例を示した図である。例えば、設置ガイド画像I1の斜線領域が「青色」である場合、領域I1aに示されるガイド情報として、「青色部分にオブジェクトが入るように、プロジェクター等の位置を調整してください」という旨の情報が用いられる。ガイド情報は、適宜変更である。なお、図13では、プロジェクター1と投射面5との相対的な位置関係に起因して、設置ガイド画像I1に台形歪が生じている。

使用者は、ガイド情報に従い、プロジェクター1の向きまたは位置、または、オブジェクト7の位置を手動で調整する。図14は、手動での調整が完了した状態を示した図である。

使用者は、手動での調整を終了すると、操作部101を操作して実行開始指示を入力する。操作部101が実行開始指示を受け取ると(ステップS2:YES)、調整部44は、自動的に投射位置の調整を行うために、各パターンの投射と各パターンの検出を開始する。

まず、調整部44は、記憶部109から位置検出用パターン情報を読み取り、位置検出用パターン情報を第2レイヤーに書き込む。これにより、画像処理部102は、位置検出用パターン情報に応じた画像信号を生成し、投射部104は、この画像信号に応じて、位置検出用パターンI2(図6参照)を、投射面5に投射する(ステップS3)。

図15は、位置検出用パターンI2の投射例を示した図である。位置検出用パターンI2は、オブジェクト7で反射された光を検出するために使用される。本実施形態では、オブジェクト7での反射光を検出しやすくするために、位置検出用パターンI2として、白色の画像が用いられる。

続いて、撮像制御部42は、撮像部108に投射面5を撮像させて撮像画像を生成させる(ステップS4)。このとき、撮像制御部42は、撮像画像が適切な明るさで生成されるように露出制御を行う。

続いて、位置検出部43は、撮像画像を解析して、撮像画像上でのオブジェクト7の位置を検出する(ステップS5)。ステップS5では、以下の処理が実行される。

オブジェクト7は再帰性反射部材を有しているため、撮像画像上では、オブジェクト7は周囲と比べて輝度が高くなる。このため、位置検出部43は、まず、撮像画像上で周囲と比べて輝度が高くなっている領域を、「オブジェクト7が存在する領域」として検出する。続いて、位置検出部43は、オブジェクト7ごとに、「オブジェクト7が存在する領域」の重心位置(重心座標)を、「オブジェクト7の位置」として検出する。

オブジェクト7は再帰性反射部材を有しているため、撮像画像上では、オブジェクト7は周囲と比べて輝度が高くなる。このため、位置検出部43は、まず、撮像画像上で周囲と比べて輝度が高くなっている領域を、「オブジェクト7が存在する領域」として検出する。続いて、位置検出部43は、オブジェクト7ごとに、「オブジェクト7が存在する領域」の重心位置(重心座標)を、「オブジェクト7の位置」として検出する。

なお、オブジェクト7は、重心位置の検出精度が高くなるような形状および反射特性(例えば、(例えば、平面視で円形であって、重心位置に近いほど反射率が高い特性)であることが望ましい。

また、オブジェクト7の位置は、オブジェクト7の重心位置に限らず適宜変更可能である。例えば、オブジェクト7が多角形である場合、オブジェクト7の位置として、オブジェクト7の頂点が用いられてもよい。また、オブジェクト7が厚みのある立体形状(球体、直方体等)の場合には、その厚み分のオフセット量を加味して、オブジェクト7の位置を求めてもよい。

ステップS5が完了すると、変換行列生成部45は、記憶部109から第1パターン情報を読み取り、第1パターン情報を第2レイヤーに書き込む。これにより、画像処理部102は、第1パターン情報に応じた画像信号を生成し、投射部104は、この画像信号に応じて、第1パターンI3(図7参照)を、投射面5に投射する(ステップS6)。図16は、第1パターンI3の投射例を示した図である。

続いて、撮像制御部42は、撮像部108に投射面5を撮像させて第1撮像画像を生成させる(ステップS7)。続いて、撮像部108は、第1撮像画像を変換行列生成部45に出力する。

続いて、変換行列生成部45は、記憶部109から第2パターン情報を読み取り、第2パターン情報を第2レイヤーに書き込む。これにより、画像処理部102は、第2パターン情報に応じた画像信号を生成し、投射部104は、この画像信号に応じて、第2パターンI4(図8参照)を、投射面5に投射する(ステップS8)。図17は、第2パターンI4の投射例を示した図である。

続いて、撮像制御部42は、撮像部108に投射面5を撮像させて第2撮像画像を生成させる(ステップS9)。続いて、撮像部108は、第2撮像画像を変換行列生成部45に出力する。

続いて、変換行列生成部45は、第1撮像画像と第2撮像画像との差分を取って矩形パターンI3bを検出する。続いて、変換行列生成部45は、撮像画像上における矩形パターンI3bの4つの頂点の位置を検出する(ステップS10)。

続いて、変換行列生成部45は、記憶部109から第3パターン情報を読み取り、第3パターン情報を第2レイヤーに書き込む。これにより、画像処理部102は、第3パターン情報に応じた画像信号を生成し、投射部104は、この画像信号に応じて、第3パターンI5(図9参照)を、投射面5に投射する(ステップS11)。図18は、第3パターンI5の投射例を示した図である。

続いて、撮像制御部42は、撮像部108に投射面5を撮像させて第3撮像画像を生成させる(ステップS12)。続いて、撮像部108は、第3撮像画像を変換行列生成部45に出力する。

続いて、変換行列生成部45は、第3撮像画像において、ステップS10で検出した4つの頂点の位置をドットI5bの探索開始位置として用いて、ドットI5bごとに、「ドットI5bが存在する領域」を検出する。続いて、変換行列生成部45は、ドットI5bごとに、「ドットI5bが存在する領域」の重心位置(重心座標)を、「ドットI5bの位置」として検出する(ステップS13)。このように、変換行列生成部45は、高い精度で検出が可能なドットの重心を、検出が容易な矩形パターンの頂点に基づいて検出しているため、所定の位置を高い精度で素早く特定することができる。

続いて、変換行列生成部45は、第3パターン情報で特定される4つのドットI5bの重心座標と、撮像画像における4つのドットI5bの重心座標と、の位置関係に基づいて、射影変換行列を算出する(ステップS14)。続いて、変換行列生成部45は、射影変換行列を記憶部109に記憶する。なお、それほど高い位置精度が要求されない場合には、第3パターンI5(ドットI5b)を用いることなく、矩形パターンI3bの4つの頂点の位置に基づいて射影変換行列を算出してもよい。また、第3パターンI5において、ドットI5bの代わりに十字マーク等を配置して、この交点の位置に基づいて射影変換行列を算出するようにしてもよい。

続いて、位置検出部43は、射影変換行列の逆行列を算出し、この行列を用いて、撮像画像上でのオブジェクト7の位置を、液晶ライトバルブ12上の位置に変換する。

続いて、調整部44は、液晶ライトバルブ12上での4つのオブジェクト7の位置を頂点とする四角形の領域(液晶ライトバルブ12において投射領域6に対応する領域)を、投射画像の投射範囲として決定する。続いて、調整部44は、投射画像の投射範囲に投射画像を収めるための台形歪補正量を算出する(ステップS15)。

続いて、調整部44は、液晶ライトバルブ12上での4つのオブジェクト7の位置を頂点とする四角形の領域(液晶ライトバルブ12において投射領域6に対応する領域)を、投射画像の投射範囲として決定する。続いて、調整部44は、投射画像の投射範囲に投射画像を収めるための台形歪補正量を算出する(ステップS15)。

続いて、調整部44は、ステップS15で算出した台形歪補正量を台形歪補正部102bに設定する。台形歪補正部102bは、台形歪補正量が設定されると、この台形歪補正量に基づいて、画像合成部102aの出力(画像情報)に対して台形歪補正を実行する(ステップS16)。このため、例えば、図19に示したように、オブジェクト7の位置にて特定される投射領域6に投射画像(例えば、受信画像情報に応じた画像)が投射される。

なお、ステップS15において、調整部44は、画像情報に基づいた投射画像のアスペクト比を維持しつつ投射領域に投射画像を収めるための台形歪補正量を算出してもよい。例えば、調整部44は、図20に示すように、投射画像P全体が投射領域6に収まっており、投射領域6のうち投射画像Pが存在しない領域6aが黒で表示されるように、台形歪補正量を算出する。この場合、投射画像Pの縦横比の乱れを抑制することが可能になる。

また、調整部44は、例えば図21に示すように投射画像Pのアスペクト比を維持しつつ、投射領域6全体に投射画像Pが投射されるように、台形歪補正量を算出してもよい。この際、調整部44は、投射画像Pの縦の長さと投射領域6の縦の長さが一致するか、投射画像Pの横の長さと投射領域6の横の長さが一致するように、台形歪補正量を算出する。この場合、投射画像Pの縦横比の乱れを抑制しつつ、投射画像Pのサイズを大きくすることができる。なお、図19~図21のどの態様で投射画像Pを投射するかについては、投射位置の自動調整の開始前または開始後に、使用者がメニュー操作等により選択できるようにすることが望ましい。

次に、撮像画像上でのオブジェクト7の移動を検出した場合(例えば、プロジェクター1、投射面5またはオブジェクト7が動かされた場合)に、オブジェクト7の移動後の位置に基づいて投射領域6を決定し、投射領域6に投射画像を投射する処理(以下「追跡処理」と称する)について説明する。以下では、プロジェクター1が追跡処理を実行する追跡モードを有しているとする。

図22は、追跡処理を説明するためのフローチャートである。図22に示した処理のうち、図10に示した処理と同様の処理には同一符号を付してある。以下、図22に示した処理のうち、図10に示した処理と異なる処理を中心に説明する。

図22は、追跡処理を説明するためのフローチャートである。図22に示した処理のうち、図10に示した処理と同様の処理には同一符号を付してある。以下、図22に示した処理のうち、図10に示した処理と異なる処理を中心に説明する。

操作部101が、追跡モードをオンにする入力操作を受け取ると、図22に示した追跡処理が定期的に実行される。なお、追跡処理の周期(頻度)については、例えば、時間単位、日単位、週単位または月単位等の中から、使用者がメニュー操作等により所望の周期を決定できるようにしてもよい。

位置検出部43は、撮像部108が生成した撮像画像からオブジェクト7を検出し、今回の追跡処理で検出されたオブジェクト7の位置と、前回の追跡処理で検出されたオブジェクト7の位置とを比較し、オブジェクト7が移動したか否かを判断する(ステップS21)。なお、追跡モードがオンになってから最初の追跡処理では、前回の撮像画像は存在しないため、位置検出部43は、オブジェクト7の移動がないと判断する。または、追跡モードをオンにすると、図10に示した処理が実行され、オブジェクト7の初期位置を記憶しておくような構成にしてもよい。ステップS21では、以下の処理が実行される。

位置検出部43は、撮像部108が生成した撮像画像からオブジェクト7を検出し、今回の追跡処理で検出されたオブジェクト7の位置と、前回の追跡処理で検出されたオブジェクト7の位置とを比較し、オブジェクト7が移動したか否かを判断する(ステップS21)。なお、追跡モードがオンになってから最初の追跡処理では、前回の撮像画像は存在しないため、位置検出部43は、オブジェクト7の移動がないと判断する。または、追跡モードをオンにすると、図10に示した処理が実行され、オブジェクト7の初期位置を記憶しておくような構成にしてもよい。ステップS21では、以下の処理が実行される。

マグネットスクリーン(投射面5)が移動されたり、プロジェクター1が移動されたり、投射面5上のオブジェクト7の位置が移動されたりして、撮像画像上の4つのオブジェクト7の各々の位置の移動が所定の閾値を超えた場合、位置検出部43は、オブジェクト7が移動したと判断する。なお、オブジェクト7の移動を判断する閾値は、オブジェクト7の位置に応じて異なる閾値を採用してもよい。

一方、撮像画像上の4つのオブジェクト7の少なくとも1つの位置の移動が所定の閾値を超えない場合、位置検出部43は、オブジェクト7の移動がないと判断する。

このため、例えば、投射面5の振動等に起因して撮像画像上でオブジェクト7が所定の閾値以下の範囲で移動しても、位置検出部43は、オブジェクト7は実質的には移動していないと判断する。

また、例えば、オブジェクト7とプロジェクター1との間を人が横切り、その影響で、一部のオブジェクト7が検出できなかったり、一部のオブジェクト7の移動量のみが所定の閾値を超えたりしても、位置検出部43は、オブジェクト7は実質的には移動していないと判断する。

このため、例えば、投射面5の振動等に起因して撮像画像上でオブジェクト7が所定の閾値以下の範囲で移動しても、位置検出部43は、オブジェクト7は実質的には移動していないと判断する。

また、例えば、オブジェクト7とプロジェクター1との間を人が横切り、その影響で、一部のオブジェクト7が検出できなかったり、一部のオブジェクト7の移動量のみが所定の閾値を超えたりしても、位置検出部43は、オブジェクト7は実質的には移動していないと判断する。

なお、位置検出部43は、オブジェクト7の移動量が所定回数連続して所定の閾値を超えた場合に移動したと判断してもよい。このようにすれば、例えば、一時的な振動によって撮像画像上でオブジェクト7の位置が移動した場合に、オブジェクト7は実質的には移動していないと判断することができる。

また、位置検出部43は、他の手法(例えば、上述した手法の組合せ)で、撮像画像上でオブジェクト7が移動したか否かを判断してもよい。例えば、少なくとも2つのオブジェクト7の位置の移動が所定の閾値を超えた場合、位置検出部43は、オブジェクト7が移動したと判断してもよい。

また、位置検出部43は、他の手法(例えば、上述した手法の組合せ)で、撮像画像上でオブジェクト7が移動したか否かを判断してもよい。例えば、少なくとも2つのオブジェクト7の位置の移動が所定の閾値を超えた場合、位置検出部43は、オブジェクト7が移動したと判断してもよい。

位置検出部43が、オブジェクト7の移動を検出しなかった場合(ステップS21:NO)、今回の追跡処理が終了する。

一方、位置検出部43がオブジェクト7の移動を検出した場合(ステップS21:YES)、まず、射影変換行列を生成するための処理が実行される(ステップS6~S14)。

続いて、調整部44は、オブジェクト7の位置が投射可能領域内であるか否かを判断する(ステップS22)。

具体的には、調整部44は、まず、新たに生成された射影変換行列に基づいて、液晶ライトバルブ12の画素領域12a(投射可能領域)の撮像画像上での位置を推定する。続いて、調整部44は、撮像画像において、オブジェクト7の位置が画素領域12a(投射可能領域)に含まれている場合には、オブジェクト7の位置が投射可能領域内であると判断する。

一方、撮像画像において、オブジェクト7の位置が画素領域12a(投射可能領域)に含まれていない場合には、調整部44は、オブジェクト7の位置が投射可能領域外であると判断する。

具体的には、調整部44は、まず、新たに生成された射影変換行列に基づいて、液晶ライトバルブ12の画素領域12a(投射可能領域)の撮像画像上での位置を推定する。続いて、調整部44は、撮像画像において、オブジェクト7の位置が画素領域12a(投射可能領域)に含まれている場合には、オブジェクト7の位置が投射可能領域内であると判断する。

一方、撮像画像において、オブジェクト7の位置が画素領域12a(投射可能領域)に含まれていない場合には、調整部44は、オブジェクト7の位置が投射可能領域外であると判断する。

オブジェクト7の位置が投射可能領域内である場合には(ステップS22:YES)、ステップS15およびS16が実行され、投射領域6に投射画像が投射される。

オブジェクト7の位置が投射可能領域外である場合には(ステップS22:NO)、投射画像に対する台形歪補正では、投射領域6に投射画像を収めることができない。

そこで、調整部44は、撮像画像上でのオブジェクト7の移動に応じて、レンズ駆動部106、レンズシフト部107、アーム駆動部35および回転駆動部36のうち少なくとも1つを駆動して、プロジェクター1と投射面5との位置関係を変更する(ステップS23)。

そこで、調整部44は、撮像画像上でのオブジェクト7の移動に応じて、レンズ駆動部106、レンズシフト部107、アーム駆動部35および回転駆動部36のうち少なくとも1つを駆動して、プロジェクター1と投射面5との位置関係を変更する(ステップS23)。

例えば、撮像画像に基づいてオブジェクト7が平行に移動したと判断された場合には、調整部44は、その移動に応じた方向に、移動量に応じた量だけ投射レンズ13bが移動するように、レンズシフト部107を駆動する。

プロジェクター1とオブジェクト7との距離が短くなって、撮像画像上での各オブジェクト7の間隔が広がった場合、調整部44は、撮像画像上での各オブジェクト7の間隔が広がった分だけ狭くなるように(プロジェクター1とオブジェクト7との距離が長くなるように)、アーム駆動部35とレンズ駆動部106の両方または一方を駆動する。

また、プロジェクター1とオブジェクト7との距離が長くなって、撮像画像上での各オブジェクト7の間隔が狭くなった場合、調整部44は、撮像画像上での各オブジェクト7の間隔が広がるように、アーム駆動部35とレンズ駆動部106の両方または一方を駆動する。一例を挙げると、撮像画像上での各オブジェクト7の間隔が狭くなった場合、調整部44は、撮像画像上での各オブジェクト7の間隔が所定量だけ広がるように(プロジェクター1とオブジェクト7との距離が短くなるように)、アーム駆動部35とレンズ駆動部106の両方または一方を駆動する。

また、図23に示したように投射面5が回転して、図24に示したように撮像画像9において、オブジェクト7aとオブジェクト7dの距離が長くなり、オブジェクト7bとオブジェクト7cの距離が短くなった場合、調整部44は、撮像画像9において、オブジェクト7aとオブジェクト7dの距離が短くなり、オブジェクト7bとオブジェクト7cの距離が長くなるように、回転駆動部36を駆動する。

プロジェクター1と投射面5との位置関係が変更されると、ステップS3~S5が実行され、その後、処理がステップS22に戻る。

本実施形態のプロジェクター1およびプロジェクター1の制御方法によれば、投射面5に配置された着脱自在のオブジェクト7の位置に応じて投射位置を自動的に調整することが可能になる。また、プロジェクター1と投射面5との位置関係が変化しても、投射位置を自動的に投射領域に合わせることが可能になる。このため、使用者の手間を低減することが可能になる。

<変形例>

本発明は、上述した実施形態に限定されるものではなく、例えば、次に述べるような各種の変形が可能である。また、次に述べる変形の態様の中から任意に選択された一または複数の変形を適宜組み合わせることもできる。

本発明は、上述した実施形態に限定されるものではなく、例えば、次に述べるような各種の変形が可能である。また、次に述べる変形の態様の中から任意に選択された一または複数の変形を適宜組み合わせることもできる。

<変形例1>

位置検出部43が、撮像画像上でのオブジェクト7の移動量を検出してもよい。この場合、調整部44は、ステップS23において、撮像画像上でのオブジェクト7の移動量に応じた量だけ、投射部104が移動するように、レンズ駆動部106、レンズシフト部107、アーム駆動部35および回転駆動部36の少なくともいずれかを駆動してもよい。

位置検出部43が、撮像画像上でのオブジェクト7の移動量を検出してもよい。この場合、調整部44は、ステップS23において、撮像画像上でのオブジェクト7の移動量に応じた量だけ、投射部104が移動するように、レンズ駆動部106、レンズシフト部107、アーム駆動部35および回転駆動部36の少なくともいずれかを駆動してもよい。

<変形例2>

上記実施形態では、射影変換行列を用いて台形歪み補正を行っているが、撮像画像に基づいて、オブジェクト7の位置と投射画像の4つの頂点の位置関係が所定の位置関係になるまで、アーム駆動部35および回転駆動部36を少しずつ駆動させるような制御を行ってもよい。

上記実施形態では、射影変換行列を用いて台形歪み補正を行っているが、撮像画像に基づいて、オブジェクト7の位置と投射画像の4つの頂点の位置関係が所定の位置関係になるまで、アーム駆動部35および回転駆動部36を少しずつ駆動させるような制御を行ってもよい。

<変形例3>

上記実施形態では、位置変更部として、ズームレンズ13aのズーム状態を変更するレンズ駆動部106と、投射レンズ13bをシフトさせるレンズシフト部107を備えた構成を例示したが、画像処理部102によって投射位置を変更するようにしてもよい。例えば、画像処理部102が、液晶ライトバルブ12の画素領域12aよりも小さい範囲に画像を形成することにより画像を縮小させるデジタルズームや、デジタルズームにより縮小された画像を画素領域12a内で移動させるデジタルシフトを行うようにしてもよい。ただし、デジタルズームを使用すると解像度が低下するため、デジタルズームによる調整は優先順位を低くすることが望ましい。

上記実施形態では、位置変更部として、ズームレンズ13aのズーム状態を変更するレンズ駆動部106と、投射レンズ13bをシフトさせるレンズシフト部107を備えた構成を例示したが、画像処理部102によって投射位置を変更するようにしてもよい。例えば、画像処理部102が、液晶ライトバルブ12の画素領域12aよりも小さい範囲に画像を形成することにより画像を縮小させるデジタルズームや、デジタルズームにより縮小された画像を画素領域12a内で移動させるデジタルシフトを行うようにしてもよい。ただし、デジタルズームを使用すると解像度が低下するため、デジタルズームによる調整は優先順位を低くすることが望ましい。

<変形例4>

上記実施形態では、位置変更部としてのアーム駆動部35により、プロジェクター1を光軸方向(前後方向)にスライドさせる構成を例示したが、左右方向または上下方向のスライドが可能な構成としてもよいし、前後方向、左右方向および上下方向のうち、複数の方向にスライドが可能な構成としてもよい。

また、上記実施形態では、位置変更部としての回転駆動部36により、プロジェクター1を水平回転させる構成を例示したが、上下チルトまたは水平ロールの回転が可能な構成としてもよいし、水平回転、上下チルトおよび水平ロールのうち、複数の回転が可能な構成としてもよい。

なお、上記実施形態のようにプロジェクター1をスライドさせる機構と、回転させる機構の両方を備える場合には、回転による調整を行って投射画像を矩形にした後にスライドによる調整を行うことが望ましい。また、回転駆動部36が、水平回転、上下チルトおよび水平ロールの3軸の回転が可能な機構を備える場合には、水平回転、上下チルトの調整を行って投射画像を矩形にした後に水平ロールの調整を行うことが望ましい。

また、調整部44は、複数の位置変更部を組み合わせて投射位置を調整するようにしてもよいし、1つの位置変更部のみを用いて調整を行うようにしてもよい。

上記実施形態では、位置変更部としてのアーム駆動部35により、プロジェクター1を光軸方向(前後方向)にスライドさせる構成を例示したが、左右方向または上下方向のスライドが可能な構成としてもよいし、前後方向、左右方向および上下方向のうち、複数の方向にスライドが可能な構成としてもよい。

また、上記実施形態では、位置変更部としての回転駆動部36により、プロジェクター1を水平回転させる構成を例示したが、上下チルトまたは水平ロールの回転が可能な構成としてもよいし、水平回転、上下チルトおよび水平ロールのうち、複数の回転が可能な構成としてもよい。

なお、上記実施形態のようにプロジェクター1をスライドさせる機構と、回転させる機構の両方を備える場合には、回転による調整を行って投射画像を矩形にした後にスライドによる調整を行うことが望ましい。また、回転駆動部36が、水平回転、上下チルトおよび水平ロールの3軸の回転が可能な機構を備える場合には、水平回転、上下チルトの調整を行って投射画像を矩形にした後に水平ロールの調整を行うことが望ましい。

また、調整部44は、複数の位置変更部を組み合わせて投射位置を調整するようにしてもよいし、1つの位置変更部のみを用いて調整を行うようにしてもよい。

<変形例5>

投射面5に対するプロジェクター1の傾きを、三角測量等の技術を用いて三次元計測できる計測部を備えるようにして、調整部44が、計測された傾きに応じてプロジェクター1の3軸の回転を調整するような構成にしてもよい。

投射面5に対するプロジェクター1の傾きを、三角測量等の技術を用いて三次元計測できる計測部を備えるようにして、調整部44が、計測された傾きに応じてプロジェクター1の3軸の回転を調整するような構成にしてもよい。

<変形例6>

上記実施形態では、追跡モードをオンにすると、図22に示した追跡処理を定期的に実行し、ステップS21でオブジェクト7の移動が検出された場合に、投射位置を調整する処理を行うようにしているが、この態様に限定されない。例えば、オブジェクト7の移動を検出することなく、図10に示した調整処理を定期的に実行するようにしてもよい。

上記実施形態では、追跡モードをオンにすると、図22に示した追跡処理を定期的に実行し、ステップS21でオブジェクト7の移動が検出された場合に、投射位置を調整する処理を行うようにしているが、この態様に限定されない。例えば、オブジェクト7の移動を検出することなく、図10に示した調整処理を定期的に実行するようにしてもよい。

<変形例7>

オブジェクト7の数は4より多くてもよい。特に、投射面5が平面でなく歪んでいる場合には、投射画像の4つの頂点以外の位置にもオブジェクト7を配置することにより、投射面5の歪みに応じた補正を行うことが可能になる。

オブジェクト7の数は4より多くてもよい。特に、投射面5が平面でなく歪んでいる場合には、投射画像の4つの頂点以外の位置にもオブジェクト7を配置することにより、投射面5の歪みに応じた補正を行うことが可能になる。

<変形例8>

上記実施形態では、オブジェクト7は、投射領域を特定するために使用され、撮像画像上での移動を検出するために使用されている。

しかしながら、投射領域を特定するために使用されるオブジェクトと、撮像画像上での移動を検出するために使用されるオブジェクトとは、別々であってもよい。

この場合、投射領域を特定するために使用されるオブジェクトの反射特性と、撮像画像上での移動を検出するために使用されるオブジェクトの反射特性とを、互いに異ならせれば、撮像画像において各オブジェクトを識別することが可能となる。

また、この場合、撮像画像上での移動を検出するために使用されるオブジェクトの数は、4に限らず適宜変更可能である。また、投射領域を特定するために使用されるオブジェクトの数も4に限らず、2以上であってもよい。例えば、投射領域を特定するために使用されるオブジェクトの数が2である場合、この2つのオブジェクトは、矩形の投射領域の対角の位置に設置される。

上記実施形態では、オブジェクト7は、投射領域を特定するために使用され、撮像画像上での移動を検出するために使用されている。

しかしながら、投射領域を特定するために使用されるオブジェクトと、撮像画像上での移動を検出するために使用されるオブジェクトとは、別々であってもよい。

この場合、投射領域を特定するために使用されるオブジェクトの反射特性と、撮像画像上での移動を検出するために使用されるオブジェクトの反射特性とを、互いに異ならせれば、撮像画像において各オブジェクトを識別することが可能となる。

また、この場合、撮像画像上での移動を検出するために使用されるオブジェクトの数は、4に限らず適宜変更可能である。また、投射領域を特定するために使用されるオブジェクトの数も4に限らず、2以上であってもよい。例えば、投射領域を特定するために使用されるオブジェクトの数が2である場合、この2つのオブジェクトは、矩形の投射領域の対角の位置に設置される。

<変形例9>

オブジェクト7を検出しやすくするために、オブジェクト7は、投射面5の反射特性とは異なる反射特性を有することが望ましい。また、オブジェクト7を、反射面そのものの切り替えや光学フィルターの切り替え等によって反射特性を変更可能な構成とすれば、様々な投射面5上でオブジェクト7を容易に検出することが可能となる。この場合、オブジェクト7が、無線通信や赤外線通信により制御信号を受信する手段と、受信した制御信号に基づいて反射特性を変更する手段を備えるようにすれば、使用者がリモコン操作で反射特性を変更することができる。また、プロジェクター1が撮像部108での撮像画像に基づく制御信号をオブジェクト7に送信し、自動で反射特性を切り替えるようにしてもよい。

オブジェクト7を検出しやすくするために、オブジェクト7は、投射面5の反射特性とは異なる反射特性を有することが望ましい。また、オブジェクト7を、反射面そのものの切り替えや光学フィルターの切り替え等によって反射特性を変更可能な構成とすれば、様々な投射面5上でオブジェクト7を容易に検出することが可能となる。この場合、オブジェクト7が、無線通信や赤外線通信により制御信号を受信する手段と、受信した制御信号に基づいて反射特性を変更する手段を備えるようにすれば、使用者がリモコン操作で反射特性を変更することができる。また、プロジェクター1が撮像部108での撮像画像に基づく制御信号をオブジェクト7に送信し、自動で反射特性を切り替えるようにしてもよい。

<変形例10>

図10に示した処理では、最初に、設置ガイド画像が表示されて、使用者がガイド情報に従いプロジェクター1の向きまたはオブジェクト7の位置を手動で調整した。この手動調整は、図22に示した追跡処理を行うことで自動化されてもよい。図25は、この手動調整の代わりに、図22に示した追跡処理が行われる場合の動作例を示したフローチャートである。なお、図25において、図22に示した処理と同一の処理には同一符号を付してある。

図10に示した処理では、最初に、設置ガイド画像が表示されて、使用者がガイド情報に従いプロジェクター1の向きまたはオブジェクト7の位置を手動で調整した。この手動調整は、図22に示した追跡処理を行うことで自動化されてもよい。図25は、この手動調整の代わりに、図22に示した追跡処理が行われる場合の動作例を示したフローチャートである。なお、図25において、図22に示した処理と同一の処理には同一符号を付してある。

<変形例11>

記憶部109が画像情報を記憶している場合には、画像合成部102aは、受信画像情報の代わりに、記憶部109が記憶している画像情報を用いてもよい。

記憶部109が画像情報を記憶している場合には、画像合成部102aは、受信画像情報の代わりに、記憶部109が記憶している画像情報を用いてもよい。

<変形例12>

制御部110がプログラムを実行することによって実現される要素の全部または一部は、例えばFPGA(field programmable gate array)またはASIC(Application Specific IC)等の電子回路によりハードウェアで実現されてもよいし、ソフトウェアとハードウェアとの協働により実現されてもよい。

制御部110がプログラムを実行することによって実現される要素の全部または一部は、例えばFPGA(field programmable gate array)またはASIC(Application Specific IC)等の電子回路によりハードウェアで実現されてもよいし、ソフトウェアとハードウェアとの協働により実現されてもよい。

<変形例13>

投射部104では、光変調装置として液晶ライトバルブが用いられたが、光変調装置は液晶ライトバルブに限らず適宜変更可能である。例えば、光変調装置として、3枚の反射型の液晶パネルを用いた構成であってもよい。また、光変調装置は、1枚の液晶パネルとカラーホイールを組み合わせた方式、3枚のデジタルミラーデバイス(DMD)を用いた方式、1枚のデジタルミラーデバイスとカラーホイールを組み合わせた方式等の構成であってもよい。光変調装置として1枚のみの液晶パネルまたはDMDが用いられる場合には、色分離光学系や色合成光学系に相当する部材は不要である。また、液晶パネルおよびDMD以外にも、光源が発した光を変調可能な構成は、光変調装置として採用できる。