WO2012114876A1 - 電子機器、コンテンツ表示方法、およびコンテンツ表示プログラム - Google Patents

電子機器、コンテンツ表示方法、およびコンテンツ表示プログラム Download PDFInfo

- Publication number

- WO2012114876A1 WO2012114876A1 PCT/JP2012/052860 JP2012052860W WO2012114876A1 WO 2012114876 A1 WO2012114876 A1 WO 2012114876A1 JP 2012052860 W JP2012052860 W JP 2012052860W WO 2012114876 A1 WO2012114876 A1 WO 2012114876A1

- Authority

- WO

- WIPO (PCT)

- Prior art keywords

- touch

- touch panel

- content

- question

- area

- Prior art date

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

- G06F3/0487—Interaction techniques based on graphical user interfaces [GUI] using specific features provided by the input device, e.g. functions controlled by the rotation of a mouse with dual sensing arrangements, or of the nature of the input device, e.g. tap gestures based on pressure sensed by a digitiser

- G06F3/0488—Interaction techniques based on graphical user interfaces [GUI] using specific features provided by the input device, e.g. functions controlled by the rotation of a mouse with dual sensing arrangements, or of the nature of the input device, e.g. tap gestures based on pressure sensed by a digitiser using a touch-screen or digitiser, e.g. input of commands through traced gestures

- G06F3/04883—Interaction techniques based on graphical user interfaces [GUI] using specific features provided by the input device, e.g. functions controlled by the rotation of a mouse with dual sensing arrangements, or of the nature of the input device, e.g. tap gestures based on pressure sensed by a digitiser using a touch-screen or digitiser, e.g. input of commands through traced gestures for inputting data by handwriting, e.g. gesture or text

Definitions

- the present invention relates to an electronic device capable of displaying content such as characters and images on a touch panel, a content display method, and a content display program.

- a technique for displaying characters and images through a touch panel is known.

- a technology for receiving an instruction for scrolling a screen via a touch panel is also known.

- Japanese Patent Application Laid-Open No. 2005-301406 discloses a character input device and a display control method of an input frame.

- the character recognition unit of the character input device performs character recognition based on handwriting input to the input frame detected by the input reception unit.

- the input frame scroll means scrolls the input frame displayed on the display screen in response to handwriting input to the predetermined input frame detected by the input reception means or pressing of the left and right scroll buttons detected by the scroll reception means.

- the display processing means displays the character recognition result and the scroll processing result on the display screen.

- Patent Document 2 discloses an on-vehicle electronic device provided with a handwriting input panel.

- a display unit having a handwriting input panel for handwriting character input is provided, a character input frame is displayed on the display unit, and handwriting is input in the character input frame.

- the on-vehicle electronic device includes a display screen on which the operator operates the character input frame displayed on the display unit and the operator And an input frame switching unit for switching the display of the character input frame to be displayed on the display unit, the input frame switching unit according to the detection result of the angle detection unit And the character input frame is rotated at different angles and switched to be displayed.

- a handwriting input device is disclosed in Japanese Patent Application Laid-Open No. 10-301705 (Patent Document 3).

- Patent Document 3 a button for instructing to change the display position of the handwriting input frame is provided in the handwriting input frame, and when touching this change instruction button, the display position changing means of the handwriting input frame The handwritten input frame is activated and displayed at the designated position, and at the same time, the changed handwritten input frame display position is stored in the memory.

- Japanese Patent Application Laid-Open No. 8-185479 discloses a handwritten character input device.

- the character input box information generation unit generates character input box information based on coordinate input position information from the coordinate input unit and stores the character input box information in the first storage unit.

- the character recognition unit recognizes the character cut out by the character cut-out unit, and stores character code data of the recognition result in the second storage unit.

- the display control unit pops up and displays the character input frame from the first input position on the display panel based on the character input frame information from the first storage unit.

- the character input box information generation unit erases the stored content of the first storage unit based on the recognition end information from the character recognition unit.

- the character input box is automatically erased when character recognition is completed.

- the character input frame is only a frame, the inside of the cell is transparent, and the print characters and the like are not hidden.

- Patent Document 5 Japanese Patent Application Laid-Open No. 7-141092

- Patent Document 5 when "M: 2" is handwritten as a memo command on the screen of the input / display device, the memo is referred to based on the position where the memo command is inputted. A window is opened. At this time, the image data of the memo number 2 designated by the memo command is displayed in the memo window. When the memo content of the memo number 2 is updated, the update data is input by handwriting in the memo window. Then, when the work of updating the contents of the memo is completed and the memo window is closed, a predetermined handwriting operation is performed on the frame reference position box. As a result, the memo window is erased and the memo data of the memo number 2 is updated to the latest image data displayed in the memo window.

- the present invention has been made to solve such a problem, and an object thereof is to improve operability when accepting handwriting input via a touch panel.

- a touch panel a memory for storing content in which at least one predetermined position is set, a first touch position is acquired via the touch panel, and the first touch position is

- An electronic device comprising: a processor for displaying content on a touch panel based on a predetermined position.

- a plurality of predetermined positions are set in the content.

- the processor obtains the touch position of the pen on the touch panel as a second touch position.

- the processor may detect the first touch position when a predetermined time has elapsed after the second touch position is not input.

- the content is displayed on the touch panel based on the second predetermined position of the plurality of predetermined positions.

- the first touch position is a contact position of the palm on the touch panel.

- the processor causes the touch panel to display the content such that the predetermined position with respect to the first touch position is the first relative position.

- the processor obtains the touch position of the pen on the touch panel as a second touch position.

- the processor stores the relative position of the second touch position to the first touch position in the memory as the first relative position.

- a plurality of predetermined positions are set in the content.

- the processor may determine that the first touch position is not input after the predetermined time has elapsed.

- the content is displayed on the touch panel based on the second predetermined position of the plurality of predetermined positions.

- the first touch position corresponds to the touch position of the pen on the touch panel.

- the processor causes the touch panel to display the content such that the first touch position matches the predetermined position.

- the processor stores the center of a rectangle surrounding the touch position of the pen in the memory as a first touch position based on time-series data of the touch position of the pen on the touch panel.

- a handwriting input enabled area and a handwriting input disabled area corresponding to each of at least one predetermined position are set.

- the at least one predetermined position corresponds to the handwriting input enable area.

- the processor causes the touch panel to display the content such that the handwriting input enabled area and the handwriting input disabled area corresponding to the target position are all displayed based on the first touch position.

- a method of displaying content in an electronic device comprising a memory, a touch panel, and a processor for storing content in which at least one predetermined position is set.

- the content display method includes the steps of: a processor acquiring a first touch position via the touch panel; and the processor displaying the content on the touch panel based on the first touch position and a predetermined position.

- a content display program for an electronic device comprising a memory, a touch panel, and a processor for storing content in which at least one predetermined position is set.

- the content display program causes the processor to execute the steps of acquiring the first touch position via the touch panel and displaying the content on the touch panel based on the first touch position and the predetermined position.

- the operativity at the time of receiving a handwriting input via a touch panel improves.

- FIG. 11 is an image diagram showing an operation outline in the case where the electronic notebook 100 according to the present embodiment adjusts the display position of the content by detecting the palm and the pen tip. It is a block diagram showing the hardware constitutions of the electronic note 100 concerning this embodiment.

- FIG. 2 is a block diagram showing a functional configuration of the electronic notebook 100 according to the first embodiment.

- 5 is a first flowchart showing content display processing according to Embodiment 1; 5 is a second flowchart showing content display processing according to the first embodiment.

- FIG. 14 is an image diagram showing an operation outline of the electronic notebook 100 according to the second embodiment.

- FIG. 7 is a block diagram showing a functional configuration of the electronic notebook 100 according to a second embodiment.

- FIG. 16 is a flowchart showing content display processing according to Embodiment 2.

- FIG. FIG. 18 is an image diagram showing an operation outline of the electronic notebook 100 according to the third embodiment.

- FIG. 18 is a block diagram showing a functional configuration of the electronic notebook 100 according to a third embodiment.

- FIG. 16 is a flowchart showing content display processing according to Embodiment 3.

- an electronic notebook will be described as a representative example of “electronic device”.

- the “electronic device” can also be realized by another information terminal having a touch panel, such as a personal computer, a portable telephone, a PDA (Personal Digital Assistant) or the like.

- FIG. 1 is an image diagram showing an operation outline in the case where the electronic notebook 100 according to the present embodiment adjusts the display position of content by detecting a palm and a pen tip.

- FIG. 1A is an image diagram showing a state in which the user is inputting a handwritten character with the stylus pen 190 in a state in which the palm is in contact with the touch panel 120.

- FIG. 1B is an image view showing a state in which the user lifts the stylus pen 190 from the touch panel 120.

- FIG. 1C is an image diagram showing the electronic notebook 100 when a predetermined time has elapsed since the stylus pen 190 is separated from the touch panel 120.

- touch panel 120 of electronic notebook 100 displays content such as text and an image.

- the content includes a plurality of questions and an answer area Y corresponding to each of the plurality of questions.

- a question area X and an answer area Y are set for each question.

- the answer area Y may be included in the problem area X, or may be provided separately from the problem area X.

- the content stores information for specifying the position of the answer area Y for each question.

- the content stores information indicating the center position of the answer area Y and information indicating the upper left end for each question.

- the text data for indicating the answer area Y or the image data itself may be information indicating the position of the answer area. That is, the electronic notebook 100 may display the center of the answer area Y or the answer area Y at a preferable position based on text data or image data for indicating the answer area Y.

- electronic notebook 100 accepts handwriting input for answer area Y and does not accept handwriting input for the outside of answer area Y.

- the palm of the user is in contact with touch panel 120.

- the electronic notebook 100 acquires the touch area Q of the palm of the user on the touch panel 120.

- the electronic notebook 100 calculates the center of gravity of the touch area Q or the center position of the rectangle surrounding the touch area as the touch position R of the palm.

- the user refers to question 1 and inputs the answer in handwriting in answer area Y of question 1.

- the electronic notebook 100 displays a character or an image input by handwriting on the touch panel 120 by sequentially acquiring the contact position S of the stylus pen 190 (or the user's finger or the like) on the touch panel 120.

- the user lifts the stylus pen 190 from the touch panel 120 after finishing writing an answer in the answer area Y of question 1.

- the electronic notebook 100 measures the time after the stylus tip of the stylus pen 190 is not detected.

- the electronic note 100 calculates reference coordinate data A indicating the center position of the rectangle surrounding the handwritten character input in the answer area Y of Problem 1.

- the electronic notebook 100 sets the latest contact position S of the stylus pen 190 as the reference coordinate data A immediately before the pen tip of the stylus pen 190 is not detected.

- the center position of the answer area Y of the question 1 is set as the reference coordinate data A.

- the electronic notebook 100 calculates reference coordinate data B indicating the center position of a rectangle surrounding the touch position R of the palm while a handwritten character is being input to the answer area Y of Problem 1. Alternatively, the electronic notebook 100 sets, as the reference coordinate data B, the contact position R of the palm immediately before the pen tip of the stylus pen 190 is not detected.

- the electronic note 100 calculates the relative position T of the touch position of the stylus pen 190 with respect to the touch position of the palm based on the reference coordinate data A and the reference coordinate data B.

- the electronic note 100 sets the relative position T as reference coordinate data C.

- electronic notebook 100 is registered as reference coordinate data from the current touch position R of the palm when a predetermined time elapses after the pen tip is not detected through touch panel 120.

- the content is displayed again so that the center of the answer area Y of question 2 is located at a position separated by the relative position T.

- the electronic notebook 100 causes the contact position R of the palm of the user's palm and the stylus pen to pass when a predetermined time has elapsed after the user has finished writing the answer in the answer area Y of question 1. Based on the contact position S of 190, the content is automatically displayed again so that the answer area of question 2 is located below the current stylus pen 190. As a result, the user can scroll the content by one problem without performing detailed operations other than handwriting input. That is, operability is improved.

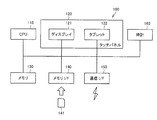

- FIG. 2 is a block diagram showing the hardware configuration of the electronic notebook 100.

- the electronic notebook 100 includes a CPU 110, a touch panel 120, a memory 130, a memory interface 140, and a communication interface 150 as main components.

- Touch panel 120 includes a display 121 and a tablet 122.

- the touch panel 120 may be any type such as a resistive film type, a surface acoustic wave type, an infrared type, an electromagnetic induction type, and a capacitance type.

- the touch panel 120 may include photosensor liquid crystal.

- the touch panel 120 detects a touch operation on the touch panel 120 by an external object at predetermined time intervals, and inputs a touch position (touch coordinate) to the CPU 110.

- the touch panel 120 according to the present embodiment detects the contact position S of the stylus pen 190 and the contact area Q of the palm or the contact position R of the palm.

- the CPU 110 can sequentially acquire the contact position S of the stylus pen 190 and the contact position R of the palm from the touch panel 120.

- the CPU 110 may calculate the contact position S of the stylus pen 190 or the contact position R of the palm based on the image data generated from the sensor signal from the touch panel 120.

- the touch panel 120 displays characters and images based on an instruction (signal) from the CPU 110.

- the CPU 110 causes the touch panel 120 to display characters and images by sending an instruction (signal) to the touch panel 120.

- the memory 130 is realized by various random access memories (RAMs), read-only memories (ROMs), hard disks, and the like.

- the memory 130 stores programs executed by the CPU 110 and various data as described later.

- the CPU 110 controls each part of the electronic notebook 100 by executing a program stored in the memory 130.

- the memory interface 140 reads data from the external storage medium 141.

- the CPU 110 reads the data stored in the external storage medium 141 via the memory interface 140 and stores the data in the memory 130.

- CPU 110 reads data from memory 130 and stores the data in external storage medium 141 via memory interface 140.

- a CD-ROM Compact Disc-Read Only Memory

- DVD-ROM Digital Versatile Disk-Read Only Memory

- USB Universal Serial Bus

- a memory card a FD (Flexible Disk), Hard disk, magnetic tape, cassette tape, MO (Magnetic Optical Disc), MD (Mini Disc), IC (Integrated Circuit) card (except memory card), optical card, mask ROM, EPROM, EEPROM (Electronically Erasable Programmable Read-Only) Media, such as a memory) which stores programs in a nonvolatile manner.

- the communication interface 150 is realized by an antenna or a connector.

- the communication interface 150 exchanges data with other devices by wired communication or wireless communication.

- the CPU 110 receives a program, image data, text data, and the like from another device via the communication interface 150, and transmits image data and text data to the other device.

- the clock 160 transmits the current time to the CPU 110.

- the clock 160 measures an elapsed time after the stylus pen 190 is lifted from the touch panel 120 based on a command from the CPU 110.

- the CPU 110 controls each part of the electronic notebook 100 by executing a program stored in the memory 130 or the storage medium 141. That is, the CPU 110 executes the program stored in the memory 130 or the storage medium 141 to realize the functional blocks shown in FIG. 3 or execute the processes shown in FIGS. 4 and 5.

- FIG. 3 is a block diagram showing a functional configuration of the electronic notebook 100 according to the present embodiment.

- memory 130 stores time-series data (handwriting data 131) of contact position S of stylus pen 190 input via touch panel 120.

- the memory 130 stores the uppermost coordinate, the lowermost coordinate, the rightmost coordinate, the leftmost coordinate, the uppermost coordinate, and the uppermost coordinate of the contact position S of the stylus pen 190 with respect to the problem that the handwritten character is input (objective problem).

- the central coordinates of a rectangle (a rectangle that encloses a handwritten character) having lower coordinates, rightmost coordinates, and leftmost coordinates as vertices are stored as reference coordinate data A.

- the memory 130 stores, as the reference coordinate data A, the latest coordinates of the touch position S of the stylus pen 190 in question.

- the memory 130 stores the center position of the answer area Y of the target question as reference coordinate data A.

- the memory 130 stores the top coordinates, the bottom coordinates, the rightmost coordinates, the leftmost coordinates, the top coordinates, and the bottom coordinates of the contact position R of the palm while the handwriting is input to the target problem.

- the central coordinates of a rectangle having the rightmost coordinate and the leftmost coordinate as vertices are stored as reference coordinate data B.

- the memory 130 stores, as reference coordinate data B, the latest coordinates of the touch position R of the palm while the handwriting is being input for the target problem.

- the memory 130 stores, as reference coordinate data C, the difference between the reference coordinate data A and the reference coordinate data B, that is, the relative position T of the touch position S of the stylus pen 190 with respect to the touch position R of the palm.

- the memory 130 stores problem data 133 (content) including text and images.

- the memory 130 includes question display area data 134 for representing the question area X for each question, extracted from the question data 133, and handwriting available area data 135 for representing the answer area Y for each question.

- the question data 133 includes information indicating the center of the answer area Y.

- the information indicating the center of the answer area Y may be text data or image data indicating the answer area Y.

- the CPU 110 calculates the center of the answer area Y.

- the CPU 110 implements the coordinate detection unit 111, the handwriting processing unit 112, the coordinate processing unit 113, the scroll processing unit 114, and the problem display processing unit 115 by executing a program stored in the memory 130.

- the coordinate detection unit 111, the handwriting processing unit 112, the coordinate processing unit 113, the scroll processing unit 114, and the problem display processing unit 115 are software modules realized by the CPU 110 executing a program. It is. However, the coordinate detection unit 111, the handwriting processing unit 112, the coordinate processing unit 113, the scroll processing unit 114, and the problem display processing unit 115 may be realized by a dedicated hardware circuit.

- the coordinate detection unit 111 acquires the contact position of an external object on the touch panel 120 based on a signal from the tablet 122.

- the coordinate detection unit 111 sequentially stores the acquired touch position S of the stylus pen 190 in the memory 130 as time-series data (handwriting data 131).

- the coordinate detection unit 111 may store the coordinates of the handwritten image and the type of the selected pen in the memory 130 in association with each other.

- the coordinate detection unit 111 stores the center of gravity of the touch area Q in the memory 130 as the touch position R of the palm based on the acquired touch area Q of the palm.

- the handwriting processing unit 112 causes the touch panel 120 to display the locus of the contact position based on the handwriting data 131.

- the locus of the touch position indicates a character or a figure

- the user can recognize the character or the figure displayed on the touch panel 120.

- the handwriting processing unit 112 shifts and displays the locus of the touch position, that is, the handwritten character according to the scroll amount ).

- the coordinate processing unit 113 refers to the touchable area data 135 and writes the touch position S of the stylus pen 190, that is, the handwriting data 131 acquired by the coordinate detection unit 111 that is located in the answer area Y

- the data 131 is stored in the memory 130, and the data located outside the answer area Y is deleted (ignored).

- the coordinate processing unit 113 updates the reference coordinate data A stored in the memory 130 based on the contact position S of the stylus pen 190. More specifically, the coordinate processing unit 113 determines the uppermost coordinate, the lowermost coordinate, the rightmost coordinate, and the leftmost coordinate of the contact position S of the stylus pen 190 with respect to the problem in which the handwritten character is input And center coordinates of a rectangle (rectangle surrounding a handwritten character) having the top coordinates, the bottom coordinates, the rightmost coordinates, and the leftmost coordinates as vertices. Alternatively, the coordinate processing unit 113 updates the latest coordinates of the contact position S of the stylus pen 190 in question. Alternatively, the coordinate processing unit 113 updates the center position of the answer area Y of the target question.

- the coordinate processing unit 113 updates the reference coordinate data B stored in the memory 130 based on the touch position R of the palm. More specifically, the coordinate processing unit 113 calculates the uppermost coordinate, the lowermost coordinate, the rightmost coordinate, and the leftmost coordinate of the contact position R of the palm while the handwriting of the target problem is being input, Update the center coordinates of the rectangle having the top coordinates, the bottom coordinates, the rightmost coordinates and the left coordinates as vertices. Alternatively, the coordinate processing unit 113 updates the latest coordinates of the touch position R of the palm while the handwriting is input for the target problem.

- the coordinate processing unit 113 updates the reference coordinate data C stored in the memory 130. More specifically, the coordinate processing unit 113 updates the relative position T of the touch position S of the stylus pen 190 with respect to the touch position R of the palm based on the reference coordinate data A and the reference coordinate data B.

- the scroll processing unit 114 refers to the clock 160 to acquire an elapsed time from when the coordinate detection unit 111 no longer detects the contact position S of the stylus pen 190. When the elapsed time reaches a predetermined time, the scroll processing unit 114 sets the position of the next problem away from the latest (current) touch position R of the palm based on the reference coordinate data C by the relative position T. The display position of the content is determined so that the center of the answer area Y is located. For example, the scroll processing unit 114 determines the scroll amount of the displayed content.

- the scroll processing unit 114 transitions from a state where the contact position S of the stylus pen 190 is detected in the answer area Y of Problem 1 to a state where the contact position S of the stylus pen 190 is not detected. After waiting for a predetermined time, the scroll amount is determined so that the answer area Y of the next question (question 2) moves to a position away from the touch position R of the current palm by the relative position T. However, the scroll processing unit 114 determines the scroll amount only in the Y direction so that the Y coordinate at the center of the answer area Y of the next question matches the Y coordinate of the relative position T from the current touch position R of the palm. May be

- the problem display processing unit 115 redisplays the content based on the problem data 133 when the scroll processing unit 114 determines that the elapsed time has reached a predetermined time. For example, when the problem display processing unit 115 transitions from a state in which the contact position S of the stylus pen 190 is detected in the answer area Y of Problem 1 to a state in which the contact position S of the stylus pen 190 is not detected Referring to the data 133, the content is redisplayed so that the center of the answer area Y of the next question matches the relative position T from the touch position R of the current palm. However, the problem display processing unit 115 may display the content again so that the Y coordinate of the center of the answer area Y of the next problem matches the Y coordinate of the relative position T from the touch position R of the current palm. .

- the question display processing unit 115 refers to the question display area data 134 and the handwriting area data 135 so that the question area X and the answer area Y of the next question (question 2) are all displayed on the touch panel 120.

- the touch panel 120 is made to display content. That is, the question display processing unit 115 causes the touch panel 120 to display the content such that the question area X and the answer area Y of the next question (question 2) fall within the display area of the touch panel 120.

- FIG. 4 is a first flowchart showing content display processing according to the first embodiment.

- FIG. 5 is a second flowchart showing the content display process according to the first embodiment.

- CPU 110 reads out question data 133 from memory 130, and causes touch panel 120 to read all of question 1 (the subject question), all of question 2 and a part of question 3. Is displayed (step S102).

- the CPU 110 stores the question display area data 134 and the handwriting possible area data 135 in the memory 130 for each question based on the question data (step S104).

- the CPU 110 determines whether the handwriting mode is selected (step S106). For example, CPU 110 selects a mode for accepting input of characters by handwriting via stylus pen 190 or the like, a mode for receiving input of characters by software button, or a mode for receiving input of characters by hardware button. to decide.

- CPU 110 ends the content display process. In this case, for example, the screen is scrolled based on a normal scroll instruction.

- CPU 110 detects the touch position via touch panel 120.

- CPU110 repeats the process of step S108, when a contact position can not be detected (when it is NO in step S108).

- CPU 110 determines whether the palm is in contact with touch panel 120 based on the area (the number of pixels) of the touch position or the pressure ( Step S110). CPU110 performs the process from step S114, when the palm does not contact the touch panel 120 (when it is NO in step S110).

- CPU 110 stores touch position R of the palm as reference coordinate data B in memory 130 (step S112). More specifically, CPU 110 calculates the touch position R of the palm based on the touch area Q acquired from touch panel 120.

- the CPU 110 determines whether the stylus pen 190 is in contact with the touch panel 120 (step S114). If the stylus pen 190 is in contact with the touch panel 120 (YES in step S114), the CPU 110 stores the contact position S of the stylus pen 190 in the memory 130 as the reference coordinate data A (step S116).

- step S118 causes touch panel 120 to change the display mode (for example, the luminance) of the position corresponding to contact position S of stylus pen 190 (step S118). More specifically, the CPU 110 stores the contact position S of the stylus pen 190 in the memory 130 as the handwriting data 131. Then, the CPU 110 causes the touch panel 120 to display the handwritten character along the handwriting data 131 (the locus of the contact position S of the stylus pen 190). The CPU 110 executes the process from step S120.

- the display mode for example, the luminance

- step S114 the CPU 110 refers to the clock 160 and a predetermined time elapses after the contact position S of the stylus pen 190 is not detected. It is determined whether or not it has been made (step S120). If the predetermined time has not elapsed since the contact position S of the stylus pen 190 is not detected (NO in step S120), the CPU 110 repeats the process from step S110.

- step S120 When a predetermined time has elapsed since the contact position S of the stylus pen 190 is not detected (YES in step S120), the CPU 110 stores the reference coordinate data A and the reference coordinate data B in the memory 130. It is determined whether it is set (step S122). Alternatively, CPU 110 determines whether reference coordinate data C is stored in memory 130 or not. When either reference coordinate data A or reference coordinate data B is not stored in memory 130 (NO in step S122), CPU 110 executes the processing from step S126.

- CPU 110 calculates the position where the answer area Y of the next question (question 2) should be displayed. (Step S124). More specifically, the CPU 110 calculates a position separated by the relative position T from the current touch position R of the palm based on the reference coordinate data C.

- the CPU 110 determines whether only the reference coordinate data A is stored in the memory 130 (step S126). That is, the CPU 110 determines whether the coordinate value is stored in the reference coordinate data A and NULL is stored in the reference coordinate data B. If only the reference coordinate data A is not stored in the memory 130 (NO in step S126), the CPU 110 executes the process from step S130.

- the CPU 110 calculates the position where the answer area Y of the next question should be displayed (step S128). More specifically, based on the reference coordinate data A, the CPU 110 updates the center position of the rectangle surrounding the handwritten character input to the answer area Y of Problem 1 or the latest position immediately before the stylus pen 190 does not detect the pen tip.

- the contact position S of the stylus pen 190 is set to a position where the answer area Y should be displayed.

- the CPU 110 determines whether the position where the answer area Y of the next question should be displayed is set (step S130). When the position where the answer area Y of the next question should be displayed is not set (when NO at step S130), CPU 110 repeats the process from step S108.

- step S130 If the position where the answer area Y of the next question should be displayed is set (if YES in step S130), the CPU 110 should display the center W2 of the answer area Y of question 2 as the next answer area Y Try to match the position. Even if the CPU 110 matches the center W2 of the answer area Y of question 2 with the position where the next answer area Y should be displayed, all of the question area X of question 2 and all of the answer area Y are the display areas of the touch panel 120 It is determined whether or not it can be contained within (step S132).

- step S132 the CPU 110 scrolls the screen so that the center W2 of the answer area Y of question 2 and the position where the next answer area Y should be displayed coincide (step S134).

- the CPU 110 repeats the process from step S108.

- step S132 If the center W2 of the answer area Y of question 2 is matched with the position where the next answer area Y should be displayed, all of the question area X of question 2 and all of the answer area Y do not fit within the display area of touch panel 120 If (if NO at step S132), the CPU 110 scrolls the screen so that the question area X and the answer area Y of question 2 fall within the display area of the touch panel 120 (step S136). For example, the CPU 110 scrolls the screen such that the upper end of the problem 2 is displayed on the upper end of the touch panel 120. The CPU 110 repeats the process from step S108.

- the display position of the content is determined based on the contact position R of the palm and the contact position S of the stylus pen 190.

- the electronic notebook 100 may determine the display position of the content based on the contact position R of the palm and the predetermined relative position T.

- the relative position T is set in advance.

- the configuration of the electronic notebook 100 displaying content based on the touch position R of the palm regardless of the touch position S of the stylus pen 190 will be described.

- the description of the same configuration as that of the electronic notebook 100 according to the first embodiment will not be repeated.

- FIG. 6 is an image diagram showing an operation outline of the electronic notebook 100 according to the second embodiment.

- FIG. 6A is an image diagram showing a state in which the user is inputting a handwritten character with the stylus pen 190 in a state in which the palm is in contact with the touch panel 120.

- FIG. 6B is an image view showing a state where the user lifts the stylus pen 190 from the touch panel 120.

- FIG. 6C is an image diagram showing the electronic notebook 100 when a predetermined time has elapsed since the stylus pen 190 is separated from the touch panel 120.

- touch panel 120 of electronic notebook 100 displays content such as text and an image.

- the content includes a plurality of questions and an answer area Y corresponding to each of the plurality of questions.

- a question area X and an answer area Y are set for each question.

- the answer area Y may be included in the problem area X, or may be provided separately from the problem area X.

- the content stores information for specifying the position of the answer area Y for each question.

- the content stores information indicating the center position of the answer area Y and information indicating the upper left end for each question.

- the text data for indicating the answer area Y or the image data itself may be information indicating the position of the answer area. That is, the electronic notebook 100 may display the center of the answer area Y or the answer area Y at a preferable position based on text data or image data for indicating the answer area Y.

- electronic notebook 100 accepts handwriting input for answer area Y and does not accept handwriting input for the outside of answer area Y.

- the user refers to question 1 and inputs the answer in handwriting in answer area Y of question 1.

- the electronic notebook 100 displays characters or an image input by handwriting on the touch panel 120 by sequentially acquiring the contact position S of the stylus pen 190 on the touch panel 120.

- the user lifts the stylus pen 190 from the touch panel 120 after writing the answer in the answer area Y of question 1.

- the electronic notebook 100 measures the time after the stylus tip of the stylus pen 190 is not detected.

- the electronic note 100 need not acquire the reference coordinate data A and the reference coordinate data B.

- the electronic notebook 100 automatically generates an electronic notebook 100 based on the position of the user's palm when a predetermined time has elapsed after the user has finished writing an answer in the answer area Y of question 1. Content is redisplayed so that the answer area of question 2 is positioned below the stylus pen 190. As a result, the user can scroll the content by one problem without performing detailed operations other than handwriting input. That is, operability is improved.

- the hardware configuration of electronic notebook 100 according to the present embodiment is the same as that of the first embodiment, and therefore, the description will not be repeated here.

- FIG. 7 is a block diagram showing a functional configuration of the electronic notebook 100 according to the present embodiment.

- memory 130 according to the present embodiment does not need to store reference coordinate data A and reference coordinate data B in comparison with memory 130 according to the first embodiment, and reference coordinate data. It differs in that C is preset.

- the other data are the same as those of Embodiment 1, and therefore the description will not be repeated here.

- the CPU 110 implements the coordinate detection unit 111, the handwriting processing unit 112, the coordinate processing unit 113, the scroll processing unit 114, and the problem display processing unit 115 by executing a program stored in the memory 130.

- the coordinate detection unit 111, the handwriting processing unit 112, the coordinate processing unit 113, the scroll processing unit 114, and the problem display processing unit 115 are software modules realized by the CPU 110 executing a program. It is. However, the coordinate detection unit 111, the handwriting processing unit 112, the coordinate processing unit 113, the scroll processing unit 114, and the problem display processing unit 115 may be realized by a dedicated hardware circuit.

- the coordinate detection unit 111 and the handwriting processing unit 112 are the same as those of the first embodiment, and therefore the description will not be repeated here.

- the coordinate processing unit 113 refers to the touchable area data 135 and writes the touch position S of the stylus pen 190, that is, the handwriting data 131 acquired by the coordinate detection unit 111 that is located in the answer area Y

- the data 131 is stored in the memory 130, and the data located outside the answer area Y is deleted (ignored).

- the scroll processing unit 114 refers to the clock 160 to acquire an elapsed time from when the coordinate detection unit 111 no longer detects the contact position S of the stylus pen 190. When the elapsed time reaches a predetermined time, the scroll processing unit 114 sets the next position away from the latest (current) touch position R of the palm by a predetermined relative position T based on the reference coordinate data C. The display position of the content is determined so that the center of the question answer area Y is located. For example, the scroll processing unit 114 determines the scroll amount of the displayed content.

- the scroll processing unit 114 transitions from a state where the contact position S of the stylus pen 190 is detected in the answer area Y of Problem 1 to a state where the contact position S of the stylus pen 190 is not detected.

- the scroll amount is determined so that the answer area Y of the next question (question 2) moves to a position separated from the current touch position R of the palm by a predetermined relative position T.

- the scroll processing unit 114 determines the scroll amount only in the Y direction so that the Y coordinate at the center of the answer area Y of the next question matches the Y coordinate of the relative position T from the current touch position R of the palm. May be

- the problem display processing unit 115 redisplays the content based on the problem data 133 when the scroll processing unit 114 determines that the elapsed time has reached a predetermined time. For example, when the problem display processing unit 115 transitions from a state in which the contact position S of the stylus pen 190 is detected in the answer area Y of Problem 1 to a state in which the contact position S of the stylus pen 190 is not detected Referring to the data 133, the content is redisplayed so that the answer area Y of the next question matches the predetermined relative position T from the touch position R of the current palm. However, the problem display processing unit 115 may display the content again so that the Y coordinate of the center of the answer area Y of the next problem matches the Y coordinate of the relative position T from the touch position R of the current palm. .

- the question display processing unit 115 refers to the question display area data 134 and the handwriting area data 135 so that the question area X and the answer area Y of the next question (question 2) are all displayed on the touch panel 120.

- the touch panel 120 is made to display content. That is, the question display processing unit 115 causes the touch panel 120 to display the content such that the question area X and the answer area Y of the next question (question 2) fall within the display area of the touch panel 120.

- FIG. 8 is a flowchart showing content display processing according to the second embodiment.

- CPU 110 reads out problem data 133 from memory 130 and causes touch panel 120 to display all of problem 1, all of problem 2 and a part of problem 3 (step S 202).

- the CPU 110 stores the question display area data 134 and the handwriting possible area data 135 in the memory 130 for each question based on the question data (step S204).

- the CPU 110 determines whether the handwriting mode is selected (step S206). For example, CPU 110 selects a mode for accepting input of characters by handwriting via stylus pen 190 or the like, a mode for receiving input of characters by software button, or a mode for receiving input of characters by hardware button. to decide.

- CPU 110 ends the content display process. In this case, for example, the screen is scrolled based on a normal scroll instruction.

- CPU 110 detects the touch position via touch panel 120.

- CPU110 repeats the process of step S208, when a contact position can not be detected (when it is NO in step S208).

- CPU 110 determines whether stylus pen 190 is in contact with touch panel 120 (step S214). If the stylus pen 190 is in contact with the touch panel 120 (YES in step S214), the CPU 110 stores the contact position S of the stylus pen 190 in the memory 130 as reference coordinate data A (step S216).

- CPU 110 causes touch panel 120 to change the display mode (for example, luminance) of the position corresponding to contact position S of stylus pen 190 (step S218). More specifically, the CPU 110 stores the contact position S of the stylus pen 190 in the memory 130 as the handwriting data 131. Then, the CPU 110 causes the touch panel 120 to display the handwritten character along the handwriting data 131 (the locus of the contact position S of the stylus pen 190). The CPU 110 executes the process from step S220.

- the display mode for example, luminance

- step S214 the CPU 110 refers to the clock 160 and a predetermined time elapses after the contact position S of the stylus pen 190 is not detected. It is determined whether or not it has been made (step S220). If the predetermined time has not elapsed since the contact position S of the stylus pen 190 is not detected (NO in step S220), the CPU 110 repeats the process from step S214.

- step S220 If a predetermined time has elapsed since the contact position S of the stylus pen 190 is not detected (YES in step S220), the CPU 110 should display the answer area Y of the next question (question 2)

- the position is calculated (step S224). More specifically, CPU 110 calculates, based on reference coordinate data C, a position separated by a predetermined relative position T from the touch position R of the current palm.

- the CPU 110 attempts to match the center W2 of the answer area Y of question 2 with the position where the next answer area Y is to be displayed. Even if the CPU 110 matches the center W2 of the answer area Y of question 2 with the position where the next answer area Y should be displayed, all of the question area X of question 2 and all of the answer area Y are the display areas of the touch panel 120 Determine if it fits within.

- step S232 CPU 110 scrolls the screen such that center W2 of answer area Y of question 2 matches the position where the next answer area Y should be displayed (step S234).

- the CPU 110 repeats the process from step S208.

- step S232 If the center W2 of the answer area Y of question 2 is matched with the position where the next answer area Y should be displayed, all of the question area X of question 2 and all of the answer area Y do not fit within the display area of touch panel 120 If (if NO at step S232), the CPU 110 scrolls the screen so that the question area X and the answer area Y of question 2 fall within the display area of the touch panel 120 (step S236). For example, the CPU 110 scrolls the screen such that the upper end of the problem 2 is displayed on the upper end of the touch panel 120. The CPU 110 repeats the process from step S208.

- the display position of the content is determined based on the contact position R of the palm and the contact position S of the stylus pen 190.

- the electronic notebook 100 may determine the display position of the content based on the contact position S of the stylus pen 190 regardless of the contact position R of the palm.

- the configuration of the electronic notebook 100 for displaying the content based on the contact position S of the stylus pen 190 regardless of the contact position R of the palm will be described.

- the description of the same configuration as that of the electronic notebook 100 according to the first embodiment will not be repeated.

- FIG. 9 is an image diagram showing an operation outline of the electronic notebook 100 according to the third embodiment.

- FIG. 9A is an image diagram showing a state in which the user is inputting a handwritten character with the stylus pen 190.

- FIG. 9B is an image view showing a state where the user lifts the stylus pen 190 from the touch panel 120.

- FIG. 9C is an image diagram showing the electronic notebook 100 when a predetermined time has elapsed since the stylus pen 190 is separated from the touch panel 120.

- the touch panel 120 of the electronic notebook 100 displays content such as text and an image.

- the content includes a plurality of questions and an answer area Y corresponding to each of the plurality of questions.

- a question area X and an answer area Y are set for each question.

- the answer area Y may be included in the problem area X, or may be provided separately from the problem area X.

- the content stores information for specifying the position of the answer area Y for each question.

- the content stores information indicating the center position of the answer area Y and information indicating the upper left end for each question.

- the text data for indicating the answer area Y or the image data itself may be information indicating the position of the answer area. That is, the electronic notebook 100 may display the center of the answer area Y or the answer area Y at a preferable position based on text data or image data for indicating the answer area Y.

- electronic notebook 100 accepts handwriting input for answer area Y and does not accept handwriting input for the outside of answer area Y.

- the user refers to question 1 and handwriting-inputs the answer in answer area Y of question 1.

- the electronic notebook 100 displays a character or an image input by handwriting on the touch panel 120 by sequentially acquiring the contact position S of the stylus pen 190 (or the user's finger or the like) on the touch panel 120.

- the user lifts stylus pen 190 from touch panel 120 after writing the answer in answer area Y of question 1.

- the electronic notebook 100 measures the time after the stylus tip of the stylus pen 190 is not detected.

- the electronic notebook 100 calculates reference coordinate data A indicating the center position of the rectangle surrounding the handwritten character input to the answer area Y of Problem 1.

- the electronic notebook 100 sets the latest contact position S of the stylus pen 190 as the reference coordinate data A immediately before the pen tip of the stylus pen 190 is not detected.

- the center position of the answer area Y of the question 1 is set as the reference coordinate data A.

- the answer area Y of question 2 is displayed at the position indicated by the reference coordinate data A. Redisplay the content so that the center position of is located.

- the electronic notebook 100 is based on the contact position S of the stylus pen 190 when a predetermined time has elapsed after the user has finished writing the answer in the answer area Y of Problem 1.

- the content is automatically displayed again so that the answer area of question 2 is located below the stylus pen 190.

- the user can scroll the content by one problem without performing detailed operations other than handwriting input. That is, operability is improved.

- the hardware configuration of electronic notebook 100 according to the present embodiment is the same as that of the first embodiment, and therefore, the description will not be repeated here.

- FIG. 10 is a block diagram showing a functional configuration of the electronic notebook 100 according to the present embodiment.

- memory 130 according to the present embodiment is different from memory 130 of the first embodiment in that reference coordinate data B and reference coordinate data C do not need to be stored.

- the other data are the same as those of Embodiment 1, and therefore the description will not be repeated here.

- the CPU 110 implements the coordinate detection unit 111, the handwriting processing unit 112, the coordinate processing unit 113, the scroll processing unit 114, and the problem display processing unit 115 by executing a program stored in the memory 130.

- the coordinate detection unit 111, the handwriting processing unit 112, the coordinate processing unit 113, the scroll processing unit 114, and the problem display processing unit 115 are software modules realized by the CPU 110 executing a program. It is. However, the coordinate detection unit 111, the handwriting processing unit 112, the coordinate processing unit 113, the scroll processing unit 114, and the problem display processing unit 115 may be realized by a dedicated hardware circuit.

- the coordinate detection unit 111 and the handwriting processing unit 112 are the same as those of the first embodiment, and therefore the description will not be repeated here.

- the coordinate processing unit 113 refers to the touchable area data 135 and writes the touch position S of the stylus pen 190, that is, the handwriting data 131 acquired by the coordinate detection unit 111 that is located in the answer area Y

- the data 131 is stored in the memory 130, and the data located outside the answer area Y is deleted (ignored).

- the coordinate processing unit 113 updates the reference coordinate data A stored in the memory 130 based on the contact position S of the stylus pen 190. More specifically, the coordinate processing unit 113 sets the uppermost coordinate, the lowermost coordinate, the rightmost coordinate, and the leftmost coordinate of the contact position S of the stylus pen 190 for the problem (the target problem) in which the handwritten character is input. And center coordinates of a rectangle (rectangle surrounding a handwritten character) having the top coordinates, the bottom coordinates, the rightmost coordinates, and the leftmost coordinates as vertices. Alternatively, the coordinate processing unit 113 updates the latest coordinates of the contact position S of the stylus pen 190 in question. Alternatively, the coordinate processing unit 113 updates the center position of the answer area Y of the target question.

- the scroll processing unit 114 refers to the clock 160 to acquire an elapsed time from when the coordinate detection unit 111 no longer detects the contact position S of the stylus pen 190.

- the scroll processing unit 114 determines the display position of the content such that the center of the answer area Y of the next question is positioned at the position indicated by the reference coordinate data A when the elapsed time reaches a predetermined time. For example, the scroll processing unit 114 determines the scroll amount of the displayed content.

- the scroll processing unit 114 transitions from a state where the contact position S of the stylus pen 190 is detected in the answer area Y of Problem 1 to a state where the contact position S of the stylus pen 190 is not detected. After waiting for a predetermined time, the scroll amount is determined so that the answer area Y of the next question (question 2) moves to the position indicated by the reference coordinate data A. However, the scroll processing unit 114 may determine the scroll amount only in the Y direction so that the Y coordinate at the center of the answer area Y of the next question matches the Y coordinate indicated by the reference coordinate data A.

- the problem display processing unit 115 redisplays the content based on the problem data 133 when the scroll processing unit 114 determines that the elapsed time has reached a predetermined time. For example, when the problem display processing unit 115 transitions from a state in which the contact position S of the stylus pen 190 is detected in the answer area Y of Problem 1 to a state in which the contact position S of the stylus pen 190 is not detected Referring to the data 133, the content is redisplayed so that the answer area Y of the next question matches the relative position T from the touch position R of the current palm. However, the question display processing unit 115 may redisplay the content such that the Y coordinate at the center of the answer area Y of the next question matches the Y coordinate indicated by the reference coordinate data A.

- the question display processing unit 115 refers to the question display area data 134 and the handwriting area data 135 so that the question area X and the answer area Y of the next question (question 2) are all displayed on the touch panel 120.

- the touch panel 120 is made to display content. That is, the question display processing unit 115 causes the touch panel 120 to display the content such that the question area X and the answer area Y of the next question (question 2) fall within the display area of the touch panel 120.

- FIG. 11 is a flowchart showing content display processing according to the third embodiment.

- CPU 110 reads out problem data 133 from memory 130, and causes touch panel 120 to display all of problem 1 and all of problem 2 and a part of problem 3 (step S302).

- the CPU 110 stores the question display area data 134 and the handwriting possible area data 135 in the memory 130 for each question based on the question data (step S304).

- the CPU 110 determines whether the handwriting mode is selected (step S306). For example, CPU 110 selects a mode for accepting input of characters by handwriting via stylus pen 190 or the like, a mode for receiving input of characters by software button, or a mode for receiving input of characters by hardware button. to decide.

- CPU 110 ends the content display process. In this case, for example, the screen is scrolled based on a normal scroll instruction.

- CPU 110 detects the touch position via touch panel 120.

- CPU110 repeats the process of step S308, when a contact position can not be detected (when it is NO in step S308).

- the CPU 110 determines whether the stylus pen 190 is in contact with the touch panel 120 (step S314). If the stylus pen 190 is in contact with the touch panel 120 (YES in step S314), the CPU 110 stores the contact position S of the stylus pen 190 in the memory 130 as reference coordinate data A (step S316).

- step S3128 causes touch panel 120 to change the display mode (for example, luminance) of the position corresponding to contact position S of stylus pen 190 (step S318). More specifically, the CPU 110 stores the contact position S of the stylus pen 190 in the memory 130 as the handwriting data 131. Then, the CPU 110 causes the touch panel 120 to display the handwritten character along the handwriting data 131 (the locus of the contact position S of the stylus pen 190). The CPU 110 executes the processing from step S320.

- the display mode for example, luminance

- step S314 the CPU 110 refers to the clock 160 and a predetermined time elapses after the contact position S of the stylus pen 190 is not detected. It is determined whether or not it has been made (step S320). If the predetermined time has not elapsed since the contact position S of the stylus pen 190 is not detected (NO in step S320), the CPU 110 repeats the process from step S314.

- the CPU 110 calculates the position at which the answer area Y for the next question should be displayed. (Step S328). More specifically, based on the reference coordinate data A, the CPU 110 updates the center position of the rectangle surrounding the handwritten character input to the answer area Y of Problem 1 or the latest position immediately before the stylus pen 190 does not detect the pen tip.

- the contact position S of the stylus pen 190 is set to a position where the answer area Y should be displayed.

- the CPU 110 attempts to match the center W2 of the answer area Y of question 2 with the position where the next answer area Y is to be displayed. Even if the CPU 110 matches the center W2 of the answer area Y of question 2 with the position where the next answer area Y should be displayed, all of the question area X of question 2 and all of the answer area Y are the display areas of the touch panel 120 It is determined whether or not it can be contained within (step S332).

- step S332 Even if the center W2 of the answer area Y of question 2 is matched with the position where the next answer area Y should be displayed, all of the question area X of question 2 and all of the answer area Y fit within the display area of touch panel 120 If (YES in step S332), the CPU 110 scrolls the screen such that the center W2 of the answer area Y of question 2 and the position where the next answer area Y should be displayed coincide (step S334). The CPU 110 repeats the process from step S308.

- step S332 If the center W2 of the answer area Y of question 2 is matched with the position where the next answer area Y should be displayed, all of the question area X of question 2 and all of the answer area Y do not fit within the display area of touch panel 120 If (if NO at step S332), the CPU 110 scrolls the screen such that the question area X and the answer area Y of question 2 fall within the display area of the touch panel 120 (step S336). For example, the CPU 110 scrolls the screen such that the upper end of the problem 2 is displayed on the upper end of the touch panel 120. The CPU 110 repeats the process from step S308.

- the present invention can be applied to the case where the invention is achieved by supplying a program to a system or apparatus. Then, the external storage medium 141 (memory 130) storing the program represented by the software for achieving the present invention is supplied to the system or apparatus, and the computer (or CPU or MPU) of the system or apparatus is external. By reading and executing the program code stored in the storage medium 141 (memory 130), it is possible to receive the effects of the present invention.

- the program code itself read from the external storage medium 141 implements the functions of the above-described embodiment, and the external storage medium 141 (memory 130) storing the program code

- the present invention is to be configured.

- the present invention also includes the case where the processing of part or all of the actual processing is performed and the processing of the above-described embodiment is realized by the processing.

- Reference Signs List 100 electronic note, 110 CPU, 111 coordinate detection unit, 112 handwriting processing unit, 113 coordinate processing unit, 114 scroll processing unit, 115 problem display processing unit, 120 touch panel, 121 display, 122 tablet, 130 memory, 131 handwriting data, 133 Problem data, 134 problem display area data, 135 handwriting area data, 140 memory interface, 141 storage medium, 150 communication interface, 160 clock, 190 stylus pen, A reference coordinate data, B reference coordinate data, C reference coordinate data, Q Contact area, R palm contact position, S stylus pen contact position, T relative position, W1 Question 1 answer area center, W2 Question 2 answer area center, X Problem area Y answer area.

Landscapes

- Engineering & Computer Science (AREA)

- General Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- Human Computer Interaction (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- User Interface Of Digital Computer (AREA)

- Position Input By Displaying (AREA)

Abstract

タッチパネルを介して手書き入力を受け付ける際の操作性を向上させる。電子機器(100)は、タッチパネル(120)と、少なくとも1つの所定の位置が設定されているコンテンツを記憶するためのメモリ(130)と、タッチパネル(120)を介して第1のタッチ位置を取得し、第1のタッチ位置と所定の位置とに基づいてタッチパネル(120)にコンテンツを表示させるためのプロセッサ(110)とを備える。

Description

本発明は、タッチパネル上に文字や画像などのコンテンツを表示可能な電子機器、コンテンツ表示方法、およびコンテンツ表示プログラムに関する。

タッチパネルを介して文字や画像を表示する技術が知られている。また、タッチパネルを介して手書きの文字や画像の入力を受け付けて、当該タッチパネルに入力された手書きの文字や画像を当該タッチパネルに表示する技術も知られている。また、タッチパネルを介して、画面をスクロールするための命令を受け付ける技術も知られている。

たとえば、特開2005-301406号公報(特許文献1)には、文字入力装置及び入力枠の表示制御方法が開示されている。特開2005-301406号公報(特許文献1)によると、文字入力装置の文字認識手段は、入力受付手段の検知した入力枠に対する手書き入力に基づき文字認識を行う。入力枠スクロール手段は、入力受付手段の検知した所定の入力枠に対する手書き入力又はスクロール受付手段の検知した左、右スクロールボタンの押下に応じて、表示画面上に表示された入力枠のスクロール処理として、自動スクロール処理、左スクロール処理、右スクロール処理のいずれかを行う。表示処理手段は、文字認識結果及びスクロール処理結果を表示画面に表示する。

また、特開2009-237836号公報(特許文献2)には、手書き入力パネルを備えた車載用電子装置が開示されている。特開2009-237836号公報(特許文献2)によると、手書き文字入力のための手書き入力パネルを有する表示部を備え、表示部に文字入力枠を表示し、該文字入力枠内に手書きで入力された文字を識別して特定する手書き入力パネルを備えた車載用電子装置において、車載用電子装置は、表示部に表示される文字入力枠に対して操作者が入力操作する表示画面と操作者による操作の向きのなす角度を検出する角度検出部と、表示部に表示する文字入力枠の表示を切替える入力枠切替部と、を備え、入力枠切替部は、角度検出部の検出結果に応じて、文字入力枠を異なる角度で回転させて表示するように切替える。

また、特開平10-301705号公報(特許文献3)には、手書き入力装置が開示されている。特開平10-301705号公報(特許文献3)によると、手書き入力枠内に手書き入力枠の表示位置を変更指示するボタンを設け、この変更指示ボタンをタッチすると手書き入力枠の表示位置変更手段が起動され、指示された位置に手書き入力枠を表示すると同時に、変更後の手書き入力枠表示位置をメモリに記憶する。

また、特開平8-185479号公報(特許文献4)には、手書き文字入力装置が開示されている。特開平8-185479号公報(特許文献4)によると、文字入力枠情報生成部は座標入力部からの座標入力位置情報に基づいて文字入力枠情報を生成して第1記憶部に記憶する。文字認識部は、文字切り出し部によって切り出された文字を認識し、認識結果の文字コードデータを第2記憶部に記憶する。表示制御部は、第1記憶部からの文字入力枠情報に基づいて表示パネル上の最初の入力位置から文字入力枠をポップアップ表示する。また、文字入力枠情報生成部は文字認識部からの認識終了情報に基づいて第1記憶部の記憶内容を消去する。こうして、文字入力枠は文字認識が終了すると自動的に消去される。その際に、文字入力枠は枠のみであり升目の中は透明であり、活字文字等が隠れない。

また、特開平7-141092号公報(特許文献5)には、手書き入力装置が開示されている。特開平7-141092号公報(特許文献5)によると、入力・表示装置の画面上で、メモコマンドとして“M:2”が手書き入力されると、上記メモコマンドを入力した位置を基準としてメモウィンドウがオープンされる。このとき、メモウィンドウ内には、上記メモコマンドで指定されたメモ番号2のイメージデータが表示される。このメモ番号2のメモ内容を更新するときには、メモウィンドウ内に更新データを手書き入力する。そして、メモ内容の更新作業が済んでメモウィンドウをクローズするときには、枠基準位置ボックス上で所定の手書き操作を行う。これにより、メモウィンドウは消去され、上記メモ番号2のメモデータはメモウィンドウに表示されている最新のイメージデータに更新される。

タッチパネルを介して手書き入力を受け付ける際の操作性の向上が求められている。たとえば、より簡単で手間のかからないスクロール命令の入力方法が求められている。

本発明は、かかる問題を解決するためになされたものであり、その目的は、タッチパネルを介して手書き入力を受け付ける際の操作性を向上させることである。

この発明のある局面に従うと、タッチパネルと、少なくとも1つの所定の位置が設定されているコンテンツを記憶するためのメモリと、タッチパネルを介して第1のタッチ位置を取得し、第1のタッチ位置と所定の位置とに基づいてタッチパネルにコンテンツを表示させるためのプロセッサとを備える、電子機器が提供される。

好ましくは、コンテンツには、複数の所定の位置が設定されている。プロセッサは、タッチパネルにおけるペンの接触位置を第2のタッチ位置として取得する。プロセッサは、複数の所定の位置のうちの第1の所定位置に基づいてコンテンツが表示されている場合に、第2のタッチ位置が入力されなくなってから所定時間が経過すると、第1のタッチ位置と複数の所定の位置のうちの第2の所定位置とに基づいてタッチパネルにコンテンツを表示させる。

好ましくは、第1のタッチ位置は、タッチパネルにおけるパームの接触位置である。

好ましくは、プロセッサは、第1のタッチ位置に対する所定の位置が第1の相対位置となるように、タッチパネルにコンテンツを表示させる。

好ましくは、プロセッサは、第1のタッチ位置に対する所定の位置が第1の相対位置となるように、タッチパネルにコンテンツを表示させる。

好ましくは、プロセッサは、タッチパネルにおけるペンの接触位置を第2のタッチ位置として取得する。プロセッサは、第1のタッチ位置に対する第2のタッチ位置の相対位置を第1の相対位置としてメモリに記憶する。

好ましくは、コンテンツには、複数の所定の位置が設定されている。プロセッサは、複数の所定の位置のうちの第1の所定位置に基づいてコンテンツが表示されている場合に、第1のタッチ位置が入力されなくなってから所定時間が経過すると、第1のタッチ位置と複数の所定の位置のうちの第2の所定位置とに基づいてタッチパネルにコンテンツを表示させる。

好ましくは、第1のタッチ位置は、タッチパネルにおけるペンの接触位置に対応する。

好ましくは、プロセッサは、第1のタッチ位置が所定の位置に一致するように、タッチパネルにコンテンツを表示させる。

好ましくは、プロセッサは、第1のタッチ位置が所定の位置に一致するように、タッチパネルにコンテンツを表示させる。

好ましくは、プロセッサは、タッチパネルにおけるペンの接触位置の時系列データに基づいて、ペンの接触位置を囲う矩形の中心を第1のタッチ位置としてメモリに記憶する。

好ましくは、コンテンツには、少なくとも1つの所定位置の各々に対応する手書き入力可能エリアと手書き入力不可能エリアとが設定されている。少なくとも1つの所定の位置は、手書き入力可能エリアに対応する。

好ましくは、プロセッサは、第1のタッチ位置に基づいて、対象となる所定の位置に対応する手書き入力可能エリアと手書き入力不可能エリアとが全て表示されるようにタッチパネルにコンテンツを表示させる。

この発明の別の局面に従うと、少なくとも1つの所定の位置が設定されているコンテンツを記憶するためのメモリとタッチパネルとプロセッサとを備える電子機器におけるコンテンツ表示方法が提供される。コンテンツ表示方法は、プロセッサが、タッチパネルを介して第1のタッチ位置を取得するステップと、プロセッサが、第1のタッチ位置と所定の位置とに基づいてタッチパネルにコンテンツを表示させるステップとを備える。

この発明の別の局面に従うと、少なくとも1つの所定の位置が設定されているコンテンツを記憶するためのメモリとタッチパネルとプロセッサとを備える電子機器のためのコンテンツ表示プログラムが提供される。コンテンツ表示プログラムは、タッチパネルを介して第1のタッチ位置を取得するステップと、第1のタッチ位置と所定の位置とに基づいてタッチパネルにコンテンツを表示させるステップとをプロセッサに実行させる。

以上のように、この発明によれば、タッチパネルを介して手書き入力を受け付ける際の操作性が向上する。

以下、図面を参照しつつ、本発明の実施の形態について説明する。以下の説明では、同一の部品には同一の符号を付してある。それらの名称および機能も同じである。したがって、それらについての詳細な説明は繰り返さない。以下では、電子ノートを「電子機器」の代表例として説明を行う。ただし、「電子機器」は、パーソナルコンピュータ、携帯型電話機、PDA(Personal Digital Assistant)などのような、タッチパネルを有する他の情報端末によっても実現可能である。

[実施の形態1]

<電子ノート100の動作概要>

まず、本実施の形態に係る電子ノート100が手のひらとペン先とを検知することによってコンテンツの表示位置を調整する場合における動作概要について説明する。図1は、本実施の形態に係る電子ノート100が手のひらとペン先とを検知することによってコンテンツの表示位置を調整する場合における動作概要を示すイメージ図である。

<電子ノート100の動作概要>

まず、本実施の形態に係る電子ノート100が手のひらとペン先とを検知することによってコンテンツの表示位置を調整する場合における動作概要について説明する。図1は、本実施の形態に係る電子ノート100が手のひらとペン先とを検知することによってコンテンツの表示位置を調整する場合における動作概要を示すイメージ図である。

より詳細には、図1(a)は、手のひらがタッチパネル120に接触した状態でユーザがスタイラスペン190によって手書き文字を入力している状態を示すイメージ図である。図1(b)は、ユーザがスタイラスペン190をタッチパネル120から持ち上げた状態を示すイメージ図である。図1(c)は、スタイラスペン190がタッチパネル120から離れてから所定時間が経過したときの電子ノート100を示すイメージ図である。

図1(a)~(c)を参照して、電子ノート100のタッチパネル120は、テキストや画像などのコンテンツを表示する。ここでは、コンテンツは、複数の問題と、当該複数の問題のそれぞれに対応する解答エリアYとを含む。コンテンツには、問題毎に、問題エリアXと解答エリアYとが設定されている。解答エリアYは、問題エリアXに含まれていてもよいし、問題エリアXとは別に設けられてもよい。

コンテンツは、問題毎に解答エリアYの位置を特定するための情報を格納する。たとえば、コンテンツは、問題毎に解答エリアYの中心位置を示す情報や左上端を示す情報を格納する。あるいは、解答エリアYを示すためのテキストデータや画像データ自体が、解答エリアの位置を示す情報であってもよい。すなわち、電子ノート100は、解答エリアYを示すためのテキストデータや画像データに基づいて、解答エリアYの中心または解答エリアYを好ましい位置に表示してもよい。

なお、本実施の形態に係る電子ノート100は、解答エリアYに対する手書き入力を受け付け、解答エリアYの外側に対する手書き入力を受け付けない。

図1(a)を参照して、ユーザの手のひらがタッチパネル120に接触している。電子ノート100は、タッチパネル120におけるユーザの手のひらの接触領域Qを取得する。電子ノート100は、接触領域Qの重心あるいは接触領域を囲う矩形の中心位置を手のひらの接触位置Rとして計算する。ユーザは、問題1を参照して、問題1の解答エリアYに解答を手書き入力する。電子ノート100は、タッチパネル120におけるスタイラスペン190(あるいはユーザの指など)の接触位置Sを逐次取得することによって、手書き入力された文字や画像をタッチパネル120に表示する。

図1(b)を参照して、ユーザは、問題1の解答エリアYに解答を記入し終えると、スタイラスペン190をタッチパネル120から持ち上げる。電子ノート100は、スタイラスペン190のペン先を検知しなくなってからの時間を計測する。

本実施の形態においては、電子ノート100は、問題1の解答エリアYに入力された手書き文字を囲う矩形の中心位置を示す基準座標データAを計算する。あるいは、電子ノート100は、スタイラスペン190のペン先を検知しなくなる直前の、最新のスタイラスペン190の接触位置Sを基準座標データAとして設定する。あるいは、問題1の解答エリアYの中心位置を基準座標データAとして設定する。

電子ノート100は、問題1の解答エリアYに手書き文字が入力されている最中の手のひらの接触位置Rを囲う矩形の中心位置を示す基準座標データBを計算する。あるいは、電子ノート100は、スタイラスペン190のペン先を検知しなくなる直前の、手のひらの接触位置Rを基準座標データBとして設定する。

電子ノート100は、基準座標データAと基準座標データBとに基づいて、手のひらの接触位置に対するスタイラスペン190の接触位置の相対位置Tを計算する。電子ノート100は、相対位置Tを基準座標データCとして設定する。

図1(c)を参照して、電子ノート100は、タッチパネル120を介してペン先を検知しなくなってから所定の時間が経過すると、現在の手のひらの接触位置Rから基準座標データとして登録されている相対位置Tだけ離れた位置に、問題2の解答エリアYの中心が位置するようにコンテンツを表示しなおす。

このように、本実施の形態に係る電子ノート100は、ユーザが問題1の解答エリアYに解答を記入し終えた後で、所定の時間が経過すると、ユーザの手のひらの接触位置Rとスタイラスペン190の接触位置Sとに基づいて、自動的に問題2の解答エリアが現在のスタイラスペン190の下方に位置するようにコンテンツを表示し直す。その結果、ユーザは、手書き入力とは別の細かい操作を行なわなくても、コンテンツを1つの問題分だけスクロールすることができる。すなわち、操作性が向上する。

以下、このような機能を実現するための電子ノート100の具体的な構成について詳述する。

<電子ノート100のハードウェア構成>

次に、電子ノート100の具体的構成の一態様について説明する。図2は、電子ノート100のハードウェア構成を表わすブロック図である。図2を参照して、電子ノート100は、主たる構成要素として、CPU110と、タッチパネル120と、メモリ130と、メモリインターフェイス140と、通信インターフェイス150とを含む。

次に、電子ノート100の具体的構成の一態様について説明する。図2は、電子ノート100のハードウェア構成を表わすブロック図である。図2を参照して、電子ノート100は、主たる構成要素として、CPU110と、タッチパネル120と、メモリ130と、メモリインターフェイス140と、通信インターフェイス150とを含む。

タッチパネル120は、ディスプレイ121とタブレット122とを含む。タッチパネル120は、抵抗膜方式、表面弾性波方式、赤外線方式、電磁誘導方式、静電容量方式などのいずれのタイプであってもよい。タッチパネル120は、光センサ液晶を含んでもよい。

タッチパネル120は、所定時間毎に外部の物体によるタッチパネル120へのタッチ操作を検知して、接触位置(接触座標)をCPU110に入力する。本実施の形態に係るタッチパネル120は、スタイラスペン190の接触位置Sと、手のひらの接触領域Qまたは手のひらの接触位置Rとを検知する。

これによって、CPU110は、タッチパネル120から順次スタイラスペン190の接触位置Sや手のひらの接触位置Rを取得することができる。ただし、CPU110は、タッチパネル120からのセンサ信号から作成された画像データに基づいてスタイラスペン190の接触位置Sや手のひらの接触位置Rを計算してもよい。

タッチパネル120は、CPU110からの命令(信号)に基づいて、文字や画像を表示する。CPU110は、タッチパネル120に命令(信号)を送ることによって、タッチパネル120に文字や画像を表示させる。

メモリ130は、各種のRAM(Random Access Memory)や、ROM(Read-Only Memory)や、ハードディスクなどによって実現される。メモリ130は、CPU110によって実行されるプログラムや、後述するような各種データを記憶する。CPU110は、メモリ130に記憶されているプログラムを実行することによって、電子ノート100の各部を制御する。

メモリインターフェイス140は、外部の記憶媒体141からデータを読み出す。換言すれば、CPU110は、メモリインターフェイス140を介して外部の記憶媒体141に格納されているデータを読み出して、当該データをメモリ130に格納する。逆に、CPU110は、メモリ130からデータを読み出して、メモリインターフェイス140を介して当該データを外部の記憶媒体141に格納する。

なお、記憶媒体141としては、CD-ROM(Compact Disc - Read Only Memory)、DVD-ROM(Digital Versatile Disk - Read Only Memory)、USB(Universal Serial Bus)メモリ、メモリカード、FD(Flexible Disk)、ハードディスク、磁気テープ、カセットテープ、MO(Magnetic Optical Disc)、MD(Mini Disc)、IC(Integrated Circuit)カード(メモリカードを除く)、光カード、マスクROM、EPROM、EEPROM(Electronically Erasable Programmable Read-Only Memory)などの、不揮発的にプログラムを格納する媒体が挙げられる。

通信インターフェイス150は、アンテナやコネクタによって実現される。通信インターフェイス150は、有線通信あるいは無線通信によって他の装置との間でデータをやり取りする。換言すれば、CPU110は、通信インターフェイス150を介して、他の装置からプログラムや画像データやテキストデータなどを受信したり、他の装置に画像データやテキストデータを送信したりする。

時計160は、CPU110に現在時刻を送信する。時計160は、CPU110からの指令に基づいて、タッチパネル120からスタイラスペン190が持ち上げられてからの経過時間を計測する。

CPU110は、メモリ130あるいは記憶媒体141に記憶されているプログラムを実行することによって、電子ノート100の各部を制御する。すなわち、CPU110は、メモリ130あるいは記憶媒体141に記憶されているプログラムを実行することによって、図3に記載の機能ブロックを実現したり、図4および図5に記載の処理を実行したりする。

<電子ノート100の機能構成>

以下では、電子ノート100が有する機能構成について説明する。図3は、本実施の形態に係る電子ノート100の機能構成を示すブロック図である。

以下では、電子ノート100が有する機能構成について説明する。図3は、本実施の形態に係る電子ノート100の機能構成を示すブロック図である。

図3を参照して、まず、メモリ130は、タッチパネル120を介して入力されたスタイラスペン190の接触位置Sの時系列データ(筆跡データ131)を記憶する。メモリ130は、手書き文字が入力されている問題(対象となっている問題)に対するスタイラスペン190の接触位置Sの最上座標と最下座標と最右座標と最左座標と、当該最上座標と最下座標と最右座標と最左座標とを頂点とする矩形(手書き文字を囲う矩形)の中心座標とを基準座標データAとして記憶する。あるいは、メモリ130は、対象となっている問題のスタイラスペン190の接触位置Sの最新の座標を基準座標データAとして記憶する。あるいは、メモリ130は、対象となっている問題の解答エリアYの中心位置を基準座標データAとして記憶する。

メモリ130は、対象となっている問題に対して手書き入力されている間の手のひらの接触位置Rの最上座標と最下座標と最右座標と最左座標と、当該最上座標と最下座標と最右座標と最左座標とを頂点とする矩形の中心座標とを基準座標データBとして記憶する。あるいは、メモリ130は、対象となっている問題に対して手書き入力されている間の手のひらの接触位置Rの最新の座標を基準座標データBとして記憶する。

メモリ130は、基準座標データAと基準座標データBとの差分、すなわち手のひらの接触位置Rに対するスタイラスペン190の接触位置Sの相対位置Tを基準座標データCとして記憶する。

メモリ130は、テキストや画像などを含む問題データ133(コンテンツ)を記憶する。メモリ130は、問題データ133から抽出される、問題毎の問題エリアXを表わすための問題表示エリアデータ134や、問題毎の解答エリアYを表わすための手書き可能エリアデータ135を含む。問題データ133は、解答エリアYの中心を示す情報を含む。あるいは、解答エリアYの中心を示す情報が、解答エリアYを示すテキストデータや画像データであってもよい。この場合には、CPU110が、解答エリアYの中心を計算する。

CPU110は、メモリ130に記憶されているプログラムを実行することによって、座標検知部111、筆跡処理部112、座標処理部113、スクロール処理部114、問題表示処理部115とを実現する。

なお、本実施の形態においては、座標検知部111、筆跡処理部112、座標処理部113、スクロール処理部114、問題表示処理部115は、CPU110がプログラムを実行することによって、実現されるソフトウェアモジュールである。しかしながら、座標検知部111、筆跡処理部112、座標処理部113、スクロール処理部114、問題表示処理部115は、専用のハードウェア回路によって実現されてもよい。

まず、座標検知部111は、タブレット122からの信号に基づいて、タッチパネル120における外部の物体の接触位置を取得する。座標検知部111は、取得したスタイラスペン190の接触位置Sを時系列データ(筆跡データ131)として逐次メモリ130に記憶する。座標検知部111は、手書き画像の座標と、選択されているペンの種類とを対応付けてメモリ130に蓄積してもよい。また、座標検知部111は、取得した手のひらの接触領域Qに基づいて、接触領域Qの重心を手のひらの接触位置Rとしてメモリ130に格納する。

筆跡処理部112は、筆跡データ131に基づいて、接触位置の軌跡をタッチパネル120に表示させる。これによって、接触位置の軌跡が文字や図形を示す場合に、ユーザは、タッチパネル120に表示されている文字や図形を認識することができる。筆跡処理部112は、後述するように画面がスクロールされる(コンテンツの表示位置が変更される)際に、スクロール量に応じて、接触位置の軌跡すなわち手書き文字をずらして表示する(平行移動させる)。

座標処理部113は、手書き可能エリアデータ135を参照して、スタイラスペン190の接触位置Sのうち、すなわち座標検知部111が取得した筆跡データ131のうち、解答エリアY内に位置するものを筆跡データ131としてメモリ130に記憶し、解答エリアY外に位置するものを削除する(無視する)。

座標処理部113は、スタイラスペン190の接触位置Sに基づいて、メモリ130に記憶されている基準座標データAを更新する。より詳細には、座標処理部113は、手書き文字が入力されている問題(対象となっている問題)に対するスタイラスペン190の接触位置Sの最上座標と最下座標と最右座標と最左座標と、当該最上座標と最下座標と最右座標と最左座標とを頂点とする矩形(手書き文字を囲う矩形)の中心座標とを更新する。あるいは、座標処理部113は、対象となっている問題のスタイラスペン190の接触位置Sの最新の座標を更新する。あるいは、座標処理部113は、対象となっている問題の解答エリアYの中心位置を更新する。

座標処理部113は、手のひらの接触位置Rに基づいて、メモリ130に記憶されている基準座標データBを更新する。より詳細には、座標処理部113は、対象となっている問題に対して手書き入力されている間の手のひらの接触位置Rの最上座標と最下座標と最右座標と最左座標と、当該最上座標と最下座標と最右座標と最左座標とを頂点とする矩形の中心座標とを更新する。あるいは、座標処理部113は、対象となっている問題に対して手書き入力されている間の手のひらの接触位置Rの最新の座標を更新する。

座標処理部113は、メモリ130に記憶されている基準座標データCを更新する。より詳細には、座標処理部113は、基準座標データAと基準座標データBとに基づいて、手のひらの接触位置Rに対するスタイラスペン190の接触位置Sの相対位置Tを更新する。

スクロール処理部114は、時計160を参照して、座標検知部111がスタイラスペン190の接触位置Sを検知しなくなったときからの経過時間を取得する。スクロール処理部114は、経過時間が所定の時間に達した際に、基準座標データCに基づいて、最新の(現在の)手のひらの接触位置Rから相対位置Tだけ離れた位置に次の問題の解答エリアYの中心が位置するように、コンテンツの表示位置を決定する。たとえば、スクロール処理部114は、表示されているコンテンツのスクロール量を決定する。

より詳細には、スクロール処理部114は、問題1の解答エリアY内にスタイラスペン190の接触位置Sが検知されている状態から、スタイラスペン190の接触位置Sが検知されない状態へ遷移した場合に、所定時間待機してから次の問題(問題2)の解答エリアYが現在の手のひらの接触位置Rから相対位置Tだけ離れた位置へと移動するようにスクロール量を決定する。ただし、スクロール処理部114は、次の問題の解答エリアYの中心のY座標が現在の手のひらの接触位置Rからの相対位置TのY座標と一致するようにY方向のみのスクロール量を決定してもよい。

問題表示処理部115は、スクロール処理部114が経過時間が所定の時間に達したと判断したときに、問題データ133に基づいてコンテンツを表示し直す。たとえば、問題表示処理部115は、問題1の解答エリアY内にスタイラスペン190の接触位置Sが検知されている状態から、スタイラスペン190の接触位置Sが検知されない状態へ遷移した場合に、問題データ133を参照して、次の問題の解答エリアYの中心が現在の手のひらの接触位置Rからの相対位置Tと一致するようにコンテンツを表示し直す。ただし、問題表示処理部115は、次の問題の解答エリアYの中心のY座標が現在の手のひらの接触位置Rからの相対位置TのY座標と一致するようにコンテンツを表示し直してもよい。

なお、問題表示処理部115は、問題表示エリアデータ134と手書き可能エリアデータ135とを参照することによって、次の問題(問題2)の問題エリアXと解答エリアYとが全てタッチパネル120に表示されるように、タッチパネル120にコンテンツを表示させることが好ましい。すなわち、問題表示処理部115は、次の問題(問題2)の問題エリアXと解答エリアYとがタッチパネル120の表示エリア内に収まるように、タッチパネル120にコンテンツを表示させる。

<コンテンツ表示処理>

以下では、本実施の形態に係るCPU110によって実行されるコンテンツ表示処理について説明する。図4は、実施の形態1に係るコンテンツ表示処理を示す第1のフローチャートである。図5は、実施の形態1に係るコンテンツ表示処理を示す第2のフローチャートである。

以下では、本実施の形態に係るCPU110によって実行されるコンテンツ表示処理について説明する。図4は、実施の形態1に係るコンテンツ表示処理を示す第1のフローチャートである。図5は、実施の形態1に係るコンテンツ表示処理を示す第2のフローチャートである。

図4および図5を参照して、CPU110は、メモリ130から問題データ133を読み出して、タッチパネル120に問題1(対象となっている問題)の全部と問題2の全部と問題3の一部とを表示させる(ステップS102)。CPU110は、問題データに基づいて、問題毎に、問題表示エリアデータ134と、手書き可能エリアデータ135とをメモリ130に格納する(ステップS104)。

CPU110は、手書きモードが選択されているか否かを判断する(ステップS106)。たとえば、CPU110は、スタイラスペン190などを介した手書きによって文字の入力を受け付けるモード、ソフトウェアボタンによって文字の入力を受け付けるモード、ハードウェアボタンによって文字の入力を受けるモード、のいずれが選択されているかを判断する。

手書きモードが選択されていない場合(ステップS106においてNOである場合)、CPU110は、コンテンツ表示処理を終了する。この場合、たとえば、通常のスクロール命令に基づいて、画面をスクロールする。