JP6255706B2 - 表示制御装置、表示制御方法、表示制御プログラムおよび情報提供システム - Google Patents

表示制御装置、表示制御方法、表示制御プログラムおよび情報提供システム Download PDFInfo

- Publication number

- JP6255706B2 JP6255706B2 JP2013089856A JP2013089856A JP6255706B2 JP 6255706 B2 JP6255706 B2 JP 6255706B2 JP 2013089856 A JP2013089856 A JP 2013089856A JP 2013089856 A JP2013089856 A JP 2013089856A JP 6255706 B2 JP6255706 B2 JP 6255706B2

- Authority

- JP

- Japan

- Prior art keywords

- display

- content

- marker

- reference object

- display data

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Classifications

-

- G—PHYSICS

- G09—EDUCATION; CRYPTOGRAPHY; DISPLAY; ADVERTISING; SEALS

- G09G—ARRANGEMENTS OR CIRCUITS FOR CONTROL OF INDICATING DEVICES USING STATIC MEANS TO PRESENT VARIABLE INFORMATION

- G09G5/00—Control arrangements or circuits for visual indicators common to cathode-ray tube indicators and other visual indicators

- G09G5/36—Control arrangements or circuits for visual indicators common to cathode-ray tube indicators and other visual indicators characterised by the display of a graphic pattern, e.g. using an all-points-addressable [APA] memory

- G09G5/37—Details of the operation on graphic patterns

- G09G5/377—Details of the operation on graphic patterns for mixing or overlaying two or more graphic patterns

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/017—Gesture based interaction, e.g. based on a set of recognized hand gestures

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

- G06F3/0481—Interaction techniques based on graphical user interfaces [GUI] based on specific properties of the displayed interaction object or a metaphor-based environment, e.g. interaction with desktop elements like windows or icons, or assisted by a cursor's changing behaviour or appearance

- G06F3/04815—Interaction with a metaphor-based environment or interaction object displayed as three-dimensional, e.g. changing the user viewpoint with respect to the environment or object

Landscapes

- Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- General Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Human Computer Interaction (AREA)

- Computer Hardware Design (AREA)

- User Interface Of Digital Computer (AREA)

- Processing Or Creating Images (AREA)

- Controls And Circuits For Display Device (AREA)

Description

まず、3次元物体のモデルデータであるARコンテンツを、撮像装置の一例であるカメラにより撮像された撮像画像に重ねて表示させるAR技術について説明する。

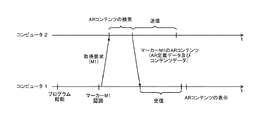

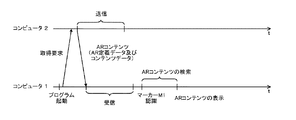

複数種類のARコンテンツの提供を行なうシステムにおいて、ARコンテンツの表示を行なうクライアント装置(コンピュータ1)が、全種類のARコンテンツを保持すると、コンピュータ1の記憶容量への負担が大きくなってしまう。例えばコンピュータ1が移動端末である場合には、コンピュータ1の物理的なサイズの制限により、コンピュータ1がARコンテンツを保持するための充分な記憶容量を備えられないことがある。

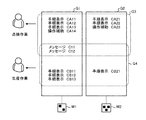

ARコンテンツを表示させる技術は、業務プロセスの遂行支援などに利用される。上述の通り、企業などの組織においては、複数の業務プロセスが遂行される。各々の業務プロセスは、複数の作業を組み合わせであることが多い。本実施形態においては、この作業の組み合わせを一単位とし、それをシナリオと称する。なお、業務プロセスが1つの作業により構成される場合についても、その作業を同様にシナリオと称する。また、同一の業務プロセスであっても、異なるユーザを対象として異なるシナリオが設定されてもよい。例えば、業務プロセスを遂行するユーザが熟練作業者であるか作業初心者であるかに応じて異なるシナリオが提供される。業務プロセスに対応するARコンテンツの内容はシナリオに含まれる作業内容に応じて異なる。すなわち、シナリオが異なる複数の業務プロセスに対してARコンテンツ群が設定されると、そのARコンテンツ群には、単一のシナリオのみに適用される個別のARコンテンツが含まれる。

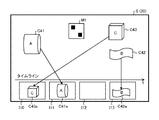

上述の通りシナリオは複数の作業により構成されるが、複数の作業が、一連の工程(ステップ)として順序だてて構成されることがある。シナリオにおいて複数のステップが順序だてて行なわれるとすると、ユーザが実行中でないステップに関するARコンテンツがユーザに提供されても、ユーザが実行中のステップに取り組む際の補助にはならない。例えば、図11の画面S(3)において、ユーザがオイル量の確認を行なうステップである場合には、手順表示のARコンテンツCA13が表示されればよく、手順表示のARコンテンツCA11やCA12が表示されても作業の補助とならない。さらに、現在のステップと異なるステップを対象としたARコンテンツ(CA11やCA12)が、現在のステップで表示されるべきARコンテンツに重なって表示されてしまう事態も生じうる。例えば、画面S(3)においては、オイル量の確認のためのバルブを右に回すというARコンテンツCA13による操作指示がARコンテンツCA11により見えにくくなっている。また、ARコンテンツCA11やCA12の表示により、ユーザが撮像画像を見ることによって確保される視界が遮られてしまう。

図16は、コンピュータ1の機能ブロック構成例を示す。コンピュータ1は、制御部10、取得部11、認識部12、演算部13、生成部14、記憶部15、撮像部16、表示部17、通信部18および入力部19を含む。制御部10は、選択制御部101、イベント検知部102、表示制御部103および設定管理部104を含む。

図17および図18は、AR機能の処理手順を示す。図17および図18に処理手順を示すAR機能は、AR表示モードおよびAR編集モードの2つのモードを提供する。AR機能は、例えばユーザの入力によりプログラムの起動指示が与えられるなどにより呼び出される。AR機能が呼び出されると、制御部10がモード選択画面S(5)の表示イベントを生成し、表示部17が表示イベントの生成に応じてモード選択画面S(5)を表示する(S101)。

図30のイベント検知の手順では、マーカーのフレームアウトの方向によりステップ切り替えのイベントが検知される。認識されたマーカーの態様に応じたステップ切り替え判定の他の手順について説明する。

本実施例においては、複数のシナリオから選択的に1つのシナリオが提供されるが、シナリオが進行する途中で他のシナリオへ遷移するように構成されてもよい。一例においては、遷移先シナリオと遷移条件とを対応付けておき、シナリオの進行中に遷移条件が満たされると、遷移先シナリオが開始されるように構成される。

図17のS102でAR表示モードが選択されなかった場合(S102:NO)には、AR編集モードが呼び出される。本実施形態においては、シナリオごとにARコンテンツの編集が行なわれる。

図10および図13にツリー形式のデータ構造が例示される。図10および図13に示す通り、特定のシナリオに関するARコンテンツは、特定のシナリオのシナリオ定義配下のデータを参照することにより抽出可能である。図13に示す通り、特定のステップに関するARコンテンツは、特定のステップのステップ定義配下のデータを参照することにより抽出可能である。

図48は、コンピュータ1のハードウェア構成例を示す。図16に示す各機能ブロックは、例えば、図48に示すハードウェア構成により実現される。コンピュータ1は、例えば、プロセッサ301、RAM(Random Access Memory)302、ROM(Read Only Memory)303、ドライブ装置304、記憶媒体305、入力インターフェース(入力I/F)306、入力デバイス307、出力インターフェース(出力I/F)308、出力デバイス309、通信インターフェース(通信I/F)310、カメラモジュール311、加速度センサ312、角速度センサ313、表示インターフェース314、表示デバイス315およびバス316などを含む。それぞれのハードウェアはバス316を介して接続されている。

上記の実施形態では、一連のARコンテンツ(シナリオ)を提供するシチュエーションとして、業務プロセスが例示された。一連のARコンテンツが提供される他のシチュエーションにおいても、上述の実施形態に示すシナリオに応じたARコンテンツ提供が行なわれてよい。

(付記1)

複数の作業内容に関連付けられた表示データ群から、前記複数の作業内容のうちの第1の作業内容に関連付けられた1または複数の表示データを取得する取得部と、

取得した前記1または複数の表示データを、画像認識により認識された基準物に基づく表示態様で表示させる制御を行なう制御部と、

を含むことを特徴とする表示制御装置。

(付記2)

前記複数の作業内容のうちの第2の作業内容に前記1または複数の表示データのいずれとも異なる他の表示データが関連付けられる、

ことを特徴とする付記1に記載の表示制御装置。

(付記3)

前記第1の作業内容は、入力に応じて前記複数の作業内容から選択され、

前記入力は、前記第1の作業内容を指定する情報または前記第1の作業内容に示される作業の実行主体を指定する情報である、

ことを特徴とする付記1または付記2に記載の表示制御装置。

(付記4)

前記制御部は、前記取得部が前記1または複数の表示データの取得を開始した後に前記基準物を認識した場合に、前記制御を行なう、

ことを特徴とする付記1〜3のいずれか1つに記載の表示制御装置。

(付記5)

前記1または複数の表示データは、前記表示データ群のうち、前記第1の作業内容および前記第1の作業内容に示される作業の実行主体の組み合わせに関連付けられた表示データである、

ことを特徴とする付記1〜4のいずれか1つに記載の表示制御装置。

(付記6)

前記1または複数の表示データは、第1の基準物に対応する第1の表示データと、第2の基準物に対応する第2の表示データとを含み、

前記制御部は、前記第1の基準物を認識した場合に、前記第1の表示データを前記第1の基準物に基づく表示態様で表示させ、前記第2の基準物を認識した場合に、前記第2の表示データを前記第2の基準物に基づく表示態様で表示させる制御を行なう、

ことを特徴とする付記1〜5のいずれか1つに記載の表示制御装置。

(付記7)

前記第1の作業内容は、順序性を有する複数の工程を含み、

前記第1の表示データに、前記複数の工程のうちの第1の工程が関連付けられており、

前記制御部は、前記第1の基準物を認識した工程が前記第1の工程である場合に、前記第1の表示データを、前記第1の基準物に基づく表示態様で表示させる、

ことを特徴とする付記6に記載の表示制御装置。

(付記8)

前記1または複数の表示データは、第1の基準物に対応する第3の表示データをさらに含み、

前記第3の表示データに、前記複数の工程のうちの第2の工程が関連付けられており、

前記制御部は、前記第1の基準物を認識した工程が前記第1の工程である場合に、前記第3の表示データの少なくとも一部の表示を抑止する、

ことを特徴とする付記7に記載の表示制御装置。

(付記9)

前記制御部は、前記1または複数の表示データに、前記第1の基準物を認識した工程と関連付けられた表示データが含まれない場合に、表示対象の表示データが存在しない旨を示す表示を行なう、

ことを特徴とする付記7または付記8に記載の表示制御装置。

(付記10)

前記制御部は、前記第1の作業内容における工程の進行または後退を、前記画像認識により認識された前記基準物に基づいて判断する、

ことを特徴とする付記7〜9のいずれか1つに記載の表示制御装置。

(付記11)

前記制御部は、前記基準物の認識または非認識の状態が切り替わる際の前記基準物の移動方向に応じて、前記工程の進行または後退を行なう、

ことを特徴とする付記10に記載の表示制御装置。

(付記12)

前記認識または非認識の状態は、前記基準物が前記画像認識の対象画像に対してフレームインまたはフレームアウトすることにより切り替えられる、

ことを特徴とする付記11に記載の表示制御装置。

(付記13)

前記制御部は、指標画像を表示させ、

前記制御部は、前記基準物が前記指標画像の表示位置に表示されると、前記工程の進行または後退を行なう、

ことを特徴とする付記10に記載の表示制御装置。

(付記14)

前記制御部は、前記基準物が所定の角度以上回転した状態で認識されると、前記工程の進行または後進を行なう、

ことを特徴とする付記10に記載の表示制御装置。

(付記15)

コンピュータに、

複数の作業内容のうちの第1の作業内容に関連付けられた1または複数の表示データを取得し、

取得した前記1または複数の表示データを、画像認識により認識された基準物に基づく表示態様で表示させる制御を行なう、

ことを実行させることを特徴とする表示制御方法。

(付記16)

コンピュータに、

複数の作業内容のうちの第1の作業内容に関連付けられた1または複数の表示データを取得し、

取得した前記1または複数の表示データを、画像認識により認識された基準物に基づく表示態様で表示させる制御を行なう、

処理を実行させることを特徴とする表示制御プログラム。

(付記17)

第1のコンピュータ及び第2のコンピュータを含む情報提供システムであって、

前記第1のコンピュータは、

複数の作業内容のうちの第1の作業内容に関連付けられた1または複数の表示データを前記第2のコンピュータに送信する送信部を含み、

前記第2のコンピュータは、

前記1または複数の表示データを受信する受信部と、

受信した前記1または複数の表示データを、画像認識により認識された基準物に基づく表示態様で表示させる制御を行なう、

ことを特徴とする情報提供システム。

(付記18)

前記第2のコンピュータは、

前記第1の作業内容を示す識別情報を選択させる選択部と、

画像認識により認識された基準物に対応付けて、第1の表示データの前記基準物を基準とする位置を示す位置情報を設定する設定部と、

前記基準物に対応付けて前記位置情報が設定された前記第1の表示データを、選択された前記識別情報に示される前記第1の作業内容と関連付けて送信する送信部と、をさらに含み、

前記1または複数の表示データは、前記第1の表示データを含む、

ことを特徴とする請求項17に記載の情報提供システム。

(付記19)

作業内容を示す識別情報を選択させる選択部と、

画像認識により認識された基準物に対応付けて、表示データの前記基準物を基準とする位置を示す位置情報を設定する設定部と、

前記基準物に対応付けて前記位置情報が設定された前記表示データを、選択された前記識別情報と関連付ける管理部と、

を含むことを特徴とする情報設定装置。

(付記20)

コンピュータに、

作業内容を示す識別情報を選択させ、

画像認識により認識された基準物に対応付けて、表示データの前記基準物を基準とする位置を示す位置情報を設定し、

前記基準物に対応付けて前記位置情報が設定された前記表示データを、選択された前記識別情報と関連付ける、

ことを実行させることを特徴とする情報設定方法。

(付記21)

コンピュータに、

作業内容を示す識別情報を選択させ、

画像認識により認識された基準物に対応付けて、表示データの前記基準物を基準とする位置を示す位置情報を設定し、

前記基準物に対応付けて前記位置情報が設定された前記表示データを、選択された前記識別情報と関連付ける、

処理を実行させることを特徴とする情報設定プログラム。

(付記22)

プロセッサを含む表示制御装置であって、

前記プロセッサは、

複数の作業内容のうちの第1の作業内容に関連付けられた1または複数の表示データを取得し、

取得した前記1または複数の表示データを、画像認識により認識された基準物に基づく表示態様で表示させる制御を行なう、

ことを特徴とする表示制御装置。

2 コンピュータ

3 ネットワーク

4 無線基地局

10 制御部

11 取得部

12 認識部

13 演算部

14 生成部

15 記憶部

16 撮像部

17 表示部

18 通信部

19 入力部

21 制御部

22 記憶部

23 通信部

Claims (14)

- 複数の作業内容に関連付けられた表示データ群から、前記複数の作業内容のうちの順序性を有する複数の工程を含む第1の作業内容に関連付けられた複数の表示データを取得する取得部と、

取得した前記複数の表示データを、画像認識により認識された基準物に基づく表示態様で表示させる制御を行なう制御部と、

を含み、

前記複数の表示データは、少なくとも、前記複数の工程のうちの第1の工程と関連付けられた第1の基準物に対応する第1の表示データと、第2の基準物に対応する第2の表示データとを含み、

前記制御部は、前記第1の基準物を認識した工程が前記第1の工程である場合に、前記第1の表示データを前記第1の基準物に基づく表示態様で表示させ、前記第2の基準物を認識した場合に、前記第2の表示データを前記第2の基準物に基づく表示態様で表示させる、

ことを特徴とする表示制御装置。 - 前記第1の作業内容は、入力に応じて前記複数の作業内容から選択され、

前記入力は、前記第1の作業内容を指定する情報または前記第1の作業内容に示される作業の実行主体を指定する情報である、

ことを特徴とする請求項1に記載の表示制御装置。 - 前記制御部は、前記取得部が前記複数の表示データの取得を開始した後に前記基準物を認識した場合に、前記制御を行なう、

ことを特徴とする請求項1または請求項2に記載の表示制御装置。 - 前記複数の表示データは、前記表示データ群のうち、前記第1の作業内容および前記第1の作業内容に示される作業の実行主体の組み合わせに関連付けられた表示データである、

ことを特徴とする請求項1〜3のいずれか1項に記載の表示制御装置。 - 前記複数の表示データは、前記第1の基準物に対応する第3の表示データをさらに含み、

前記第3の表示データに、前記複数の工程のうちの第2の工程が関連付けられており、

前記制御部は、前記第1の基準物を認識した工程が前記第1の工程である場合に、前記第3の表示データの少なくとも一部の表示を抑止する、

ことを特徴とする請求項1〜4のいずれか1項に記載の表示制御装置。 - 前記制御部は、前記複数の表示データに、前記第1の基準物を認識した工程と関連付けられた表示データが含まれない場合に、表示対象の表示データが存在しない旨を示す表示を行なう、

ことを特徴とする請求項1〜5のいずれか1項に記載の表示制御装置。 - 前記制御部は、前記第1の作業内容における工程の進行または後退を、前記画像認識により認識された前記基準物に基づいて判断する、

ことを特徴とする請求項1〜6のいずれか1項に記載の表示制御装置。 - 前記制御部は、前記基準物の認識または非認識の状態が切り替わる際の前記基準物の移動方向に応じて、前記工程の進行または後退を行なう、

ことを特徴とする請求項7に記載の表示制御装置。 - 前記認識または非認識の状態は、前記基準物が前記画像認識の対象画像に対してフレームインまたはフレームアウトすることにより切り替えられる、

ことを特徴とする請求項8に記載の表示制御装置。 - 前記制御部は、指標画像を表示させ、

前記制御部は、前記基準物が前記指標画像の表示位置に表示されると、前記工程の進行または後退を行なう、

ことを特徴とする請求項7に記載の表示制御装置。 - 前記制御部は、前記基準物が所定の角度以上回転した状態で認識されると、前記工程の進行または後進を行なう、

ことを特徴とする請求項7に記載の表示制御装置。 - コンピュータが、

複数の作業内容のうちの順序性を有する複数の工程を含む第1の作業内容に関連付けられた複数の表示データを取得し、

取得した前記複数の表示データを、画像認識により認識された基準物に基づく表示態様で表示させる制御を行なう、

処理を実行し、

前記複数の表示データは、少なくとも、前記複数の工程のうちの第1の工程と関連付けられた第1の基準物に対応する第1の表示データと、第2の基準物に対応する第2の表示データとを含み、

前記制御は、前記第1の基準物を認識した工程が前記第1の工程である場合に、前記第1の表示データを前記第1の基準物に基づく表示態様で表示させ、前記第2の基準物を認識した場合に、前記第2の表示データを前記第2の基準物に基づく表示態様で表示させる、

ことを特徴とする表示制御方法。 - コンピュータに、

複数の作業内容のうちの順序性を有する複数の工程を含む第1の作業内容に関連付けられた複数の表示データを取得し、

取得した前記複数の表示データを、画像認識により認識された基準物に基づく表示態様で表示させる制御を行なう、

処理を実行させ、

前記複数の表示データは、少なくとも、前記複数の工程のうちの第1の工程と関連付けられた第1の基準物に対応する第1の表示データと、第2の基準物に対応する第2の表示データとを含み、

前記制御は、前記第1の基準物を認識した工程が前記第1の工程である場合に、前記第1の表示データを前記第1の基準物に基づく表示態様で表示させ、前記第2の基準物を認識した場合に、前記第2の表示データを前記第2の基準物に基づく表示態様で表示させる、

ことを特徴とする表示制御プログラム。 - 第1のコンピュータ及び第2のコンピュータを含む情報提供システムであって、

前記第1のコンピュータは、複数の作業内容のうちの順序性を有する複数の工程を含む第1の作業内容に関連付けられた複数の表示データを前記第2のコンピュータに送信する送信部を含み、

前記第2のコンピュータは、前記複数の表示データを受信する受信部と、受信した前記複数の表示データを、画像認識により認識された基準物に基づく表示態様で表示させる制御を行なう制御部とを含み、

前記複数の表示データは、少なくとも、前記複数の工程のうちの第1の工程と関連付けられた第1の基準物に対応する第1の表示データと、第2の基準物に対応する第2の表示データとを含み、

前記制御部は、前記第1の基準物を認識した工程が前記第1の工程である場合に、前記第1の表示データを前記第1の基準物に基づく表示態様で表示させ、前記第2の基準物を認識した場合に、前記第2の表示データを前記第2の基準物に基づく表示態様で表示させる、

ことを特徴とする情報提供システム。

Priority Applications (4)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2013089856A JP6255706B2 (ja) | 2013-04-22 | 2013-04-22 | 表示制御装置、表示制御方法、表示制御プログラムおよび情報提供システム |

| US14/244,244 US10147398B2 (en) | 2013-04-22 | 2014-04-03 | Display control method and device |

| EP14163837.9A EP2796963A1 (en) | 2013-04-22 | 2014-04-08 | Display control method and device |

| CN201410162979.2A CN104111812B (zh) | 2013-04-22 | 2014-04-22 | 显示控制方法和装置 |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2013089856A JP6255706B2 (ja) | 2013-04-22 | 2013-04-22 | 表示制御装置、表示制御方法、表示制御プログラムおよび情報提供システム |

Related Child Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2016243523A Division JP6350640B2 (ja) | 2016-12-15 | 2016-12-15 | 表示制御装置、表示制御方法、表示制御プログラム |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2014215646A JP2014215646A (ja) | 2014-11-17 |

| JP6255706B2 true JP6255706B2 (ja) | 2018-01-10 |

Family

ID=50486776

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2013089856A Expired - Fee Related JP6255706B2 (ja) | 2013-04-22 | 2013-04-22 | 表示制御装置、表示制御方法、表示制御プログラムおよび情報提供システム |

Country Status (4)

| Country | Link |

|---|---|

| US (1) | US10147398B2 (ja) |

| EP (1) | EP2796963A1 (ja) |

| JP (1) | JP6255706B2 (ja) |

| CN (1) | CN104111812B (ja) |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US12434342B2 (en) | 2020-07-28 | 2025-10-07 | Shibaura Machine Co., Ltd. | Processing machine, processing system, and method for manufacturing processed object |

Families Citing this family (27)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP6138566B2 (ja) * | 2013-04-24 | 2017-05-31 | 川崎重工業株式会社 | 部品取付作業支援システムおよび部品取付方法 |

| JP6155893B2 (ja) * | 2013-06-20 | 2017-07-05 | カシオ計算機株式会社 | 画像処理装置、及びプログラム |

| JP6318519B2 (ja) * | 2013-09-26 | 2018-05-09 | カシオ計算機株式会社 | 画像処理装置、プログラム及び制御方法 |

| US20150286349A1 (en) * | 2014-04-02 | 2015-10-08 | Microsoft Corporation | Transient user interface elements |

| JP6432182B2 (ja) * | 2014-07-02 | 2018-12-05 | 富士通株式会社 | サービス提供装置、方法、及びプログラム |

| US9811954B2 (en) * | 2014-12-02 | 2017-11-07 | Honeywell International, Inc. | Near-to-eye display systems and methods for verifying aircraft components |

| JP6481354B2 (ja) * | 2014-12-10 | 2019-03-13 | セイコーエプソン株式会社 | 情報処理装置、装置を制御する方法、コンピュータープログラム |

| US9754355B2 (en) | 2015-01-09 | 2017-09-05 | Snap Inc. | Object recognition based photo filters |

| JP6572600B2 (ja) | 2015-04-09 | 2019-09-11 | セイコーエプソン株式会社 | 情報処理装置、情報処理装置の制御方法、および、コンピュータープログラム |

| JP2017054185A (ja) | 2015-09-07 | 2017-03-16 | 株式会社東芝 | 情報処理装置、情報処理方法及び情報処理プログラム |

| JP2017117115A (ja) * | 2015-12-22 | 2017-06-29 | 富士通株式会社 | コンテンツ制御プログラム、コンテンツ制御方法、コンテンツ制御装置、及びコンテンツ表示装置 |

| JP6736898B2 (ja) * | 2016-02-02 | 2020-08-05 | 富士通株式会社 | 設備点検支援プログラム、設備点検支援方法および情報処理装置 |

| JP2018005091A (ja) * | 2016-07-06 | 2018-01-11 | 富士通株式会社 | 表示制御プログラム、表示制御方法および表示制御装置 |

| US20180268614A1 (en) * | 2017-03-16 | 2018-09-20 | General Electric Company | Systems and methods for aligning pmi object on a model |

| US10489651B2 (en) * | 2017-04-14 | 2019-11-26 | Microsoft Technology Licensing, Llc | Identifying a position of a marker in an environment |

| DE102017108622A1 (de) | 2017-04-23 | 2018-10-25 | Goodly Innovations GmbH | System zur unterstützung von teamarbeit mittels augmented reality |

| JP2018195254A (ja) * | 2017-05-22 | 2018-12-06 | 富士通株式会社 | 表示制御プログラム、表示制御装置及び表示制御方法 |

| JP2019016044A (ja) | 2017-07-04 | 2019-01-31 | 富士通株式会社 | 表示制御プログラム、表示制御方法及び表示制御装置 |

| JP6670918B2 (ja) * | 2018-03-12 | 2020-03-25 | 東芝インフォメーションシステムズ株式会社 | 生成装置、生成方法及び生成プログラム |

| JP6387471B1 (ja) * | 2018-03-12 | 2018-09-05 | Scsk株式会社 | 表示プログラム、格納プログラム、表示システム、及び格納システム |

| KR102821604B1 (ko) * | 2018-10-30 | 2025-06-19 | 무진 아이엔씨 | 로봇 시스템을 동작하기 위한 방법, 로봇 시스템 및 컴퓨터로 실행 가능한 명령어를 저장한 비일시적 저장 매체 |

| JP2020149138A (ja) * | 2019-03-11 | 2020-09-17 | 株式会社Nttファシリティーズ | 作業支援システム、作業支援方法、及びプログラム |

| US11295135B2 (en) * | 2020-05-29 | 2022-04-05 | Corning Research & Development Corporation | Asset tracking of communication equipment via mixed reality based labeling |

| US11374808B2 (en) | 2020-05-29 | 2022-06-28 | Corning Research & Development Corporation | Automated logging of patching operations via mixed reality based labeling |

| JP7491831B2 (ja) * | 2020-12-23 | 2024-05-28 | 株式会社クボタ | 挿入量判定用装置および方法 |

| US12290944B2 (en) | 2021-08-09 | 2025-05-06 | Mujin, Inc. | Robotic system with image-based sizing mechanism and methods for operating the same |

| JP7599447B2 (ja) * | 2022-03-08 | 2024-12-13 | 株式会社日本総合研究所 | 情報制御装置、情報制御プログラム及び情報制御方法 |

Family Cites Families (67)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US6697761B2 (en) * | 2000-09-19 | 2004-02-24 | Olympus Optical Co., Ltd. | Three-dimensional position/orientation sensing apparatus, information presenting system, and model error detecting system |

| US6765569B2 (en) * | 2001-03-07 | 2004-07-20 | University Of Southern California | Augmented-reality tool employing scene-feature autocalibration during camera motion |

| JP2003281297A (ja) * | 2002-03-22 | 2003-10-03 | National Institute Of Advanced Industrial & Technology | 情報提示装置および情報提示方法 |

| US8064650B2 (en) * | 2002-07-10 | 2011-11-22 | Hewlett-Packard Development Company, L.P. | File management of digital images using the names of people identified in the images |

| US7427996B2 (en) * | 2002-10-16 | 2008-09-23 | Canon Kabushiki Kaisha | Image processing apparatus and image processing method |

| US7876359B2 (en) * | 2003-01-17 | 2011-01-25 | Insitu, Inc. | Cooperative nesting of mechanical and electronic stabilization for an airborne camera system |

| US9002497B2 (en) * | 2003-07-03 | 2015-04-07 | Kla-Tencor Technologies Corp. | Methods and systems for inspection of wafers and reticles using designer intent data |

| US7277572B2 (en) | 2003-10-10 | 2007-10-02 | Macpearl Design Llc | Three-dimensional interior design system |

| KR100816408B1 (ko) | 2004-06-04 | 2008-03-25 | 미쓰비시덴키 가부시키가이샤 | 동작 환경을 증명하는 증명서 발행 서버 및 증명 시스템 |

| SE525826C2 (sv) * | 2004-06-18 | 2005-05-10 | Totalfoersvarets Forskningsins | Interaktivt förfarande för att presentera information i en bild |

| US8004574B2 (en) * | 2004-07-21 | 2011-08-23 | Nokia Corporation | Portable electronic devices with picture in picture capability |

| ATE428154T1 (de) | 2005-05-03 | 2009-04-15 | Seac02 S R L | Augmented-reality-system mit identifizierung der realen markierung des objekts |

| JP4743522B2 (ja) | 2006-03-15 | 2011-08-10 | 株式会社日立プラントテクノロジー | 画像データ記録方法、画像データによる作業実績記録方法、画像データ記録装置、並びに画像データによる作業実績記録システム |

| KR100914515B1 (ko) | 2006-06-23 | 2009-09-02 | 주식회사 칼라짚미디어 | 색상 기반 이미지 코드의 색상 판별 방법 |

| US20080071559A1 (en) * | 2006-09-19 | 2008-03-20 | Juha Arrasvuori | Augmented reality assisted shopping |

| FR2911707B1 (fr) | 2007-01-22 | 2009-07-10 | Total Immersion Sa | Procede et dispositifs de realite augmentee utilisant un suivi automatique, en temps reel, d'objets geometriques planaires textures, sans marqueur, dans un flux video. |

| US20080266323A1 (en) | 2007-04-25 | 2008-10-30 | Board Of Trustees Of Michigan State University | Augmented reality user interaction system |

| US8384769B1 (en) * | 2007-05-23 | 2013-02-26 | Kwangwoon University Research Institute For Industry Cooperation | 3D image display method and system thereof |

| US20080310686A1 (en) | 2007-06-15 | 2008-12-18 | Martin Kretz | Digital camera system and method of storing image data |

| JP4788732B2 (ja) * | 2008-04-18 | 2011-10-05 | コニカミノルタビジネステクノロジーズ株式会社 | 表示操作部を備えた装置 |

| US8542906B1 (en) * | 2008-05-21 | 2013-09-24 | Sprint Communications Company L.P. | Augmented reality image offset and overlay |

| WO2010001756A1 (ja) | 2008-06-30 | 2010-01-07 | 株式会社ソニー・コンピュータエンタテインメント | 携帯型ゲーム装置及び携帯型ゲーム装置の制御方法 |

| US20100048290A1 (en) | 2008-08-19 | 2010-02-25 | Sony Computer Entertainment Europe Ltd. | Image combining method, system and apparatus |

| US8970690B2 (en) * | 2009-02-13 | 2015-03-03 | Metaio Gmbh | Methods and systems for determining the pose of a camera with respect to at least one object of a real environment |

| JP5298984B2 (ja) * | 2009-03-17 | 2013-09-25 | 株式会社リコー | ヘルプ情報提供システム、サーバ装置、対象機器、携帯通信端末、ヘルプ情報提供方法、プログラム及び記録媒体 |

| JPWO2011004534A1 (ja) * | 2009-07-09 | 2012-12-13 | 株式会社日立ハイテクノロジーズ | 半導体欠陥分類方法,半導体欠陥分類装置,半導体欠陥分類プログラム |

| US8502835B1 (en) * | 2009-09-02 | 2013-08-06 | Groundspeak, Inc. | System and method for simulating placement of a virtual object relative to real world objects |

| US8451266B2 (en) * | 2009-12-07 | 2013-05-28 | International Business Machines Corporation | Interactive three-dimensional augmented realities from item markers for on-demand item visualization |

| US9164577B2 (en) | 2009-12-22 | 2015-10-20 | Ebay Inc. | Augmented reality system, method, and apparatus for displaying an item image in a contextual environment |

| JP2013141049A (ja) | 2010-03-24 | 2013-07-18 | Hitachi Ltd | 世界座標系データベースを利用したサーバ及び端末 |

| US20110234631A1 (en) | 2010-03-25 | 2011-09-29 | Bizmodeline Co., Ltd. | Augmented reality systems |

| EP2537141B1 (en) | 2010-06-10 | 2016-03-30 | Sartorius Stedim Biotech GmbH | Assembling method, operating method, augmented reality system and computer program product |

| JP4914528B1 (ja) | 2010-08-31 | 2012-04-11 | 新日鉄ソリューションズ株式会社 | 拡張現実提供システム、情報処理端末、情報処理装置、拡張現実提供方法、情報処理方法、及びプログラム |

| US9483677B2 (en) | 2010-09-20 | 2016-11-01 | Hid Global Corporation | Machine-readable symbols |

| US8860760B2 (en) | 2010-09-25 | 2014-10-14 | Teledyne Scientific & Imaging, Llc | Augmented reality (AR) system and method for tracking parts and visually cueing a user to identify and locate parts in a scene |

| US8854356B2 (en) * | 2010-09-28 | 2014-10-07 | Nintendo Co., Ltd. | Storage medium having stored therein image processing program, image processing apparatus, image processing system, and image processing method |

| US10909564B2 (en) * | 2010-11-17 | 2021-02-02 | PicScore, Inc. | Fast and versatile graphical scoring device and method |

| JP5859843B2 (ja) | 2010-12-24 | 2016-02-16 | 新日鉄住金ソリューションズ株式会社 | 情報処理装置、情報処理方法、及びプログラム |

| KR20120073726A (ko) * | 2010-12-27 | 2012-07-05 | 주식회사 팬택 | 증강 현실 정보 제공을 위한 인증 장치 및 방법 |

| JP5799521B2 (ja) | 2011-02-15 | 2015-10-28 | ソニー株式会社 | 情報処理装置、オーサリング方法及びプログラム |

| US10133950B2 (en) * | 2011-03-04 | 2018-11-20 | Qualcomm Incorporated | Dynamic template tracking |

| JP5752959B2 (ja) | 2011-03-10 | 2015-07-22 | 株式会社三共 | 遊技機関連情報配信システム、遊技機関連情報配信装置および携帯端末用アプリケーションプログラム |

| US20120249588A1 (en) | 2011-03-22 | 2012-10-04 | Panduit Corp. | Augmented Reality Data Center Visualization |

| JP2012215989A (ja) | 2011-03-31 | 2012-11-08 | Toppan Printing Co Ltd | 拡張現実表示方法 |

| US10242456B2 (en) | 2011-06-23 | 2019-03-26 | Limitless Computing, Inc. | Digitally encoded marker-based augmented reality (AR) |

| US8872852B2 (en) | 2011-06-30 | 2014-10-28 | International Business Machines Corporation | Positional context determination with multi marker confidence ranking |

| KR101832959B1 (ko) * | 2011-08-10 | 2018-02-28 | 엘지전자 주식회사 | 휴대 전자기기 및 이의 제어방법 |

| US9153195B2 (en) * | 2011-08-17 | 2015-10-06 | Microsoft Technology Licensing, Llc | Providing contextual personal information by a mixed reality device |

| US8749396B2 (en) | 2011-08-25 | 2014-06-10 | Satorius Stedim Biotech Gmbh | Assembling method, monitoring method, communication method, augmented reality system and computer program product |

| JP5821526B2 (ja) | 2011-10-27 | 2015-11-24 | ソニー株式会社 | 画像処理装置、画像処理方法及びプログラム |

| JP5783885B2 (ja) | 2011-11-11 | 2015-09-24 | 株式会社東芝 | 情報提示装置、その方法及びそのプログラム |

| JP6226510B2 (ja) * | 2012-01-27 | 2017-11-08 | キヤノン株式会社 | 画像処理システム、処理方法及びプログラム |

| JP2013165366A (ja) * | 2012-02-10 | 2013-08-22 | Sony Corp | 画像処理装置、画像処理方法及びプログラム |

| JP6045796B2 (ja) * | 2012-02-27 | 2016-12-14 | 京セラ株式会社 | 映像処理装置、映像処理方法、および映像表示システム |

| US9087178B2 (en) * | 2012-04-25 | 2015-07-21 | Convivial Corporation | System and method for posting content to network sites |

| US20140002443A1 (en) | 2012-06-29 | 2014-01-02 | Blackboard Inc. | Augmented reality interface |

| US9448758B2 (en) | 2012-07-18 | 2016-09-20 | The Boeing Company | Projecting airplane location specific maintenance history using optical reference points |

| TWI475474B (zh) * | 2012-07-30 | 2015-03-01 | Mitac Int Corp | Gesture combined with the implementation of the icon control method |

| US20140123507A1 (en) | 2012-11-02 | 2014-05-08 | Qualcomm Incorporated | Reference coordinate system determination |

| US8887991B2 (en) | 2012-12-27 | 2014-11-18 | Ciena Corporation | Method and apparatus for configuring and validating telecom and datacom systems |

| US9336629B2 (en) | 2013-01-30 | 2016-05-10 | F3 & Associates, Inc. | Coordinate geometry augmented reality process |

| US9269011B1 (en) * | 2013-02-11 | 2016-02-23 | Amazon Technologies, Inc. | Graphical refinement for points of interest |

| US9946963B2 (en) * | 2013-03-01 | 2018-04-17 | Layar B.V. | Barcode visualization in augmented reality |

| US9418378B2 (en) * | 2013-03-15 | 2016-08-16 | Gilt Groupe, Inc. | Method and system for trying out a product in relation to a real world environment |

| US9898844B2 (en) | 2013-12-31 | 2018-02-20 | Daqri, Llc | Augmented reality content adapted to changes in real world space geometry |

| JP6217437B2 (ja) * | 2014-02-14 | 2017-10-25 | 富士通株式会社 | 端末装置、情報処理装置、表示制御方法、及び表示制御プログラム |

| WO2015148733A2 (en) * | 2014-03-25 | 2015-10-01 | ScStan, LLC | Systems and methods for the real-time modification of videos and images within a social network format |

-

2013

- 2013-04-22 JP JP2013089856A patent/JP6255706B2/ja not_active Expired - Fee Related

-

2014

- 2014-04-03 US US14/244,244 patent/US10147398B2/en active Active

- 2014-04-08 EP EP14163837.9A patent/EP2796963A1/en not_active Ceased

- 2014-04-22 CN CN201410162979.2A patent/CN104111812B/zh not_active Expired - Fee Related

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US12434342B2 (en) | 2020-07-28 | 2025-10-07 | Shibaura Machine Co., Ltd. | Processing machine, processing system, and method for manufacturing processed object |

Also Published As

| Publication number | Publication date |

|---|---|

| JP2014215646A (ja) | 2014-11-17 |

| US20140313223A1 (en) | 2014-10-23 |

| CN104111812A (zh) | 2014-10-22 |

| US10147398B2 (en) | 2018-12-04 |

| EP2796963A1 (en) | 2014-10-29 |

| CN104111812B (zh) | 2017-11-24 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6255706B2 (ja) | 表示制御装置、表示制御方法、表示制御プログラムおよび情報提供システム | |

| JP5991423B2 (ja) | 表示装置、表示方法、表示プログラムおよび位置設定システム | |

| US10078914B2 (en) | Setting method and information processing device | |

| CN104346834B (zh) | 信息处理设备和位置指定方法 | |

| CN102695032B (zh) | 信息处理装置、信息共享方法以及终端设备 | |

| JP6265027B2 (ja) | 表示装置、位置特定プログラム、および位置特定方法 | |

| CN111145294A (zh) | 二维户型图构建方法及装置、存储介质 | |

| CN108604256A (zh) | 零件信息检索装置、零件信息检索方法以及程序 | |

| JP2009069403A (ja) | 地図表示システム | |

| JP6350640B2 (ja) | 表示制御装置、表示制御方法、表示制御プログラム | |

| US20230419628A1 (en) | Reset modeling based on reset and object properties | |

| TWI503800B (zh) | 建築模型影像顯示系統及其方法 | |

| JP6152888B2 (ja) | 情報処理装置、その制御方法、及びプログラム、並びに、情報処理システム、その制御方法、及びプログラム | |

| JP7192953B2 (ja) | 情報処理装置、情報処理方法およびプログラム | |

| CN117632951A (zh) | 算法流程编排方法、装置、计算机设备及存储介质 | |

| CN117631821A (zh) | 用于扩展现实应用程序的物理环境的数字孪生 | |

| KR102805512B1 (ko) | 특정 위치와 연관된 2차원 이미지가 3차원 디지털 트윈 콘텐츠의 대응하는 위치에 배치되는 3차원 디지털 트윈 콘텐츠를 제공하는 방법 및 장치 | |

| JP2013134673A (ja) | 棚割シミュレーションシステム、棚割シミュレーション方法及び棚割シミュレーションプログラム | |

| US10380806B2 (en) | Systems and methods for receiving and detecting dimensional aspects of a malleable target object | |

| KR102804166B1 (ko) | 계층적으로 구조화된 단위 공간들과 연관하여 정보 콘텐츠 항목을 제공하는 3차원 디지털 트윈 콘텐츠를 제공하는 방법 및 장치 | |

| KR102816246B1 (ko) | 실사 지도를 이용한 부동산 정보 표시 방법 및 장치 | |

| HK40106864B (zh) | 用於扩展现实应用程序的物理环境的数字孪生的方法和系统 | |

| JP2019008516A (ja) | 情報処理装置、情報処理方法およびプログラム | |

| JP2018195212A (ja) | Cadシステム |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20160113 |

|

| RD01 | Notification of change of attorney |

Free format text: JAPANESE INTERMEDIATE CODE: A7421 Effective date: 20160401 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20161011 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20161018 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20161215 |

|

| A02 | Decision of refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A02 Effective date: 20170418 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20170718 |

|

| A911 | Transfer to examiner for re-examination before appeal (zenchi) |

Free format text: JAPANESE INTERMEDIATE CODE: A911 Effective date: 20170726 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20170829 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20171024 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20171107 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20171120 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6255706 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| LAPS | Cancellation because of no payment of annual fees |