BR112016002720B1 - Sistema local e método para analisar e classificar quadros de imagem individuais de dados de imagem panorâmica - Google Patents

Sistema local e método para analisar e classificar quadros de imagem individuais de dados de imagem panorâmica Download PDFInfo

- Publication number

- BR112016002720B1 BR112016002720B1 BR112016002720-5A BR112016002720A BR112016002720B1 BR 112016002720 B1 BR112016002720 B1 BR 112016002720B1 BR 112016002720 A BR112016002720 A BR 112016002720A BR 112016002720 B1 BR112016002720 B1 BR 112016002720B1

- Authority

- BR

- Brazil

- Prior art keywords

- thermal imaging

- imaging camera

- images

- camera

- image

- Prior art date

Links

- 238000000034 method Methods 0.000 title claims abstract description 31

- 238000001931 thermography Methods 0.000 claims abstract description 104

- 230000000717 retained effect Effects 0.000 claims abstract description 24

- 238000004458 analytical method Methods 0.000 claims description 20

- 230000007246 mechanism Effects 0.000 claims description 11

- 238000012545 processing Methods 0.000 claims description 11

- 230000008569 process Effects 0.000 claims description 6

- 230000008859 change Effects 0.000 claims description 5

- 238000003384 imaging method Methods 0.000 claims 3

- 230000000284 resting effect Effects 0.000 claims 1

- 230000000875 corresponding effect Effects 0.000 abstract description 12

- 230000002596 correlated effect Effects 0.000 abstract description 6

- 230000005540 biological transmission Effects 0.000 description 7

- 230000008901 benefit Effects 0.000 description 6

- 238000001514 detection method Methods 0.000 description 6

- 238000004364 calculation method Methods 0.000 description 4

- 230000006870 function Effects 0.000 description 4

- 238000004590 computer program Methods 0.000 description 3

- 230000003287 optical effect Effects 0.000 description 3

- 238000004891 communication Methods 0.000 description 2

- 238000005265 energy consumption Methods 0.000 description 2

- 238000001228 spectrum Methods 0.000 description 2

- 238000012546 transfer Methods 0.000 description 2

- 238000003491 array Methods 0.000 description 1

- 230000001413 cellular effect Effects 0.000 description 1

- 239000000470 constituent Substances 0.000 description 1

- 238000010924 continuous production Methods 0.000 description 1

- 238000012937 correction Methods 0.000 description 1

- 238000013461 design Methods 0.000 description 1

- 238000010586 diagram Methods 0.000 description 1

- 230000009977 dual effect Effects 0.000 description 1

- 238000005516 engineering process Methods 0.000 description 1

- 230000000873 masking effect Effects 0.000 description 1

- 230000005055 memory storage Effects 0.000 description 1

- 230000008520 organization Effects 0.000 description 1

- 229920001690 polydopamine Polymers 0.000 description 1

- 230000004044 response Effects 0.000 description 1

- 239000007787 solid Substances 0.000 description 1

- 238000013403 standard screening design Methods 0.000 description 1

- 238000001429 visible spectrum Methods 0.000 description 1

Images

Classifications

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B24—GRINDING; POLISHING

- B24B—MACHINES, DEVICES, OR PROCESSES FOR GRINDING OR POLISHING; DRESSING OR CONDITIONING OF ABRADING SURFACES; FEEDING OF GRINDING, POLISHING, OR LAPPING AGENTS

- B24B9/00—Machines or devices designed for grinding edges or bevels on work or for removing burrs; Accessories therefor

- B24B9/02—Machines or devices designed for grinding edges or bevels on work or for removing burrs; Accessories therefor characterised by a special design with respect to properties of materials specific to articles to be ground

- B24B9/06—Machines or devices designed for grinding edges or bevels on work or for removing burrs; Accessories therefor characterised by a special design with respect to properties of materials specific to articles to be ground of non-metallic inorganic material, e.g. stone, ceramics, porcelain

- B24B9/08—Machines or devices designed for grinding edges or bevels on work or for removing burrs; Accessories therefor characterised by a special design with respect to properties of materials specific to articles to be ground of non-metallic inorganic material, e.g. stone, ceramics, porcelain of glass

- B24B9/14—Machines or devices designed for grinding edges or bevels on work or for removing burrs; Accessories therefor characterised by a special design with respect to properties of materials specific to articles to be ground of non-metallic inorganic material, e.g. stone, ceramics, porcelain of glass of optical work, e.g. lenses, prisms

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/70—Determining position or orientation of objects or cameras

- G06T7/73—Determining position or orientation of objects or cameras using feature-based methods

- G06T7/74—Determining position or orientation of objects or cameras using feature-based methods involving reference images or patches

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B29—WORKING OF PLASTICS; WORKING OF SUBSTANCES IN A PLASTIC STATE IN GENERAL

- B29C—SHAPING OR JOINING OF PLASTICS; SHAPING OF MATERIAL IN A PLASTIC STATE, NOT OTHERWISE PROVIDED FOR; AFTER-TREATMENT OF THE SHAPED PRODUCTS, e.g. REPAIRING

- B29C45/00—Injection moulding, i.e. forcing the required volume of moulding material through a nozzle into a closed mould; Apparatus therefor

- B29C45/0053—Injection moulding, i.e. forcing the required volume of moulding material through a nozzle into a closed mould; Apparatus therefor combined with a final operation, e.g. shaping

- B29C45/0055—Shaping

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/0006—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00 with means to keep optical surfaces clean, e.g. by preventing or removing dirt, stains, contamination, condensation

-

- G—PHYSICS

- G03—PHOTOGRAPHY; CINEMATOGRAPHY; ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ELECTROGRAPHY; HOLOGRAPHY

- G03B—APPARATUS OR ARRANGEMENTS FOR TAKING PHOTOGRAPHS OR FOR PROJECTING OR VIEWING THEM; APPARATUS OR ARRANGEMENTS EMPLOYING ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ACCESSORIES THEREFOR

- G03B37/00—Panoramic or wide-screen photography; Photographing extended surfaces, e.g. for surveying; Photographing internal surfaces, e.g. of pipe

- G03B37/02—Panoramic or wide-screen photography; Photographing extended surfaces, e.g. for surveying; Photographing internal surfaces, e.g. of pipe with scanning movement of lens or cameras

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T1/00—General purpose image data processing

- G06T1/0007—Image acquisition

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T3/00—Geometric image transformations in the plane of the image

- G06T3/40—Scaling of whole images or parts thereof, e.g. expanding or contracting

- G06T3/4038—Image mosaicing, e.g. composing plane images from plane sub-images

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/50—Depth or shape recovery

- G06T7/55—Depth or shape recovery from multiple images

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/20—Cameras or camera modules comprising electronic image sensors; Control thereof for generating image signals from infrared radiation only

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/60—Control of cameras or camera modules

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/60—Control of cameras or camera modules

- H04N23/698—Control of cameras or camera modules for achieving an enlarged field of view, e.g. panoramic image capture

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N5/00—Details of television systems

- H04N5/30—Transforming light or analogous information into electric information

- H04N5/33—Transforming infrared radiation

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B29—WORKING OF PLASTICS; WORKING OF SUBSTANCES IN A PLASTIC STATE IN GENERAL

- B29C—SHAPING OR JOINING OF PLASTICS; SHAPING OF MATERIAL IN A PLASTIC STATE, NOT OTHERWISE PROVIDED FOR; AFTER-TREATMENT OF THE SHAPED PRODUCTS, e.g. REPAIRING

- B29C45/00—Injection moulding, i.e. forcing the required volume of moulding material through a nozzle into a closed mould; Apparatus therefor

- B29C45/0053—Injection moulding, i.e. forcing the required volume of moulding material through a nozzle into a closed mould; Apparatus therefor combined with a final operation, e.g. shaping

- B29C45/0055—Shaping

- B29C2045/0058—Shaping removing material

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B29—WORKING OF PLASTICS; WORKING OF SUBSTANCES IN A PLASTIC STATE IN GENERAL

- B29K—INDEXING SCHEME ASSOCIATED WITH SUBCLASSES B29B, B29C OR B29D, RELATING TO MOULDING MATERIALS OR TO MATERIALS FOR MOULDS, REINFORCEMENTS, FILLERS OR PREFORMED PARTS, e.g. INSERTS

- B29K2023/00—Use of polyalkenes or derivatives thereof as moulding material

- B29K2023/04—Polymers of ethylene

- B29K2023/06—PE, i.e. polyethylene

- B29K2023/0658—PE, i.e. polyethylene characterised by its molecular weight

- B29K2023/0683—UHMWPE, i.e. ultra high molecular weight polyethylene

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B29—WORKING OF PLASTICS; WORKING OF SUBSTANCES IN A PLASTIC STATE IN GENERAL

- B29K—INDEXING SCHEME ASSOCIATED WITH SUBCLASSES B29B, B29C OR B29D, RELATING TO MOULDING MATERIALS OR TO MATERIALS FOR MOULDS, REINFORCEMENTS, FILLERS OR PREFORMED PARTS, e.g. INSERTS

- B29K2995/00—Properties of moulding materials, reinforcements, fillers, preformed parts or moulds

- B29K2995/0018—Properties of moulding materials, reinforcements, fillers, preformed parts or moulds having particular optical properties, e.g. fluorescent or phosphorescent

- B29K2995/0026—Transparent

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B29—WORKING OF PLASTICS; WORKING OF SUBSTANCES IN A PLASTIC STATE IN GENERAL

- B29K—INDEXING SCHEME ASSOCIATED WITH SUBCLASSES B29B, B29C OR B29D, RELATING TO MOULDING MATERIALS OR TO MATERIALS FOR MOULDS, REINFORCEMENTS, FILLERS OR PREFORMED PARTS, e.g. INSERTS

- B29K2995/00—Properties of moulding materials, reinforcements, fillers, preformed parts or moulds

- B29K2995/0018—Properties of moulding materials, reinforcements, fillers, preformed parts or moulds having particular optical properties, e.g. fluorescent or phosphorescent

- B29K2995/0029—Translucent

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B29—WORKING OF PLASTICS; WORKING OF SUBSTANCES IN A PLASTIC STATE IN GENERAL

- B29K—INDEXING SCHEME ASSOCIATED WITH SUBCLASSES B29B, B29C OR B29D, RELATING TO MOULDING MATERIALS OR TO MATERIALS FOR MOULDS, REINFORCEMENTS, FILLERS OR PREFORMED PARTS, e.g. INSERTS

- B29K2995/00—Properties of moulding materials, reinforcements, fillers, preformed parts or moulds

- B29K2995/0037—Other properties

- B29K2995/0094—Geometrical properties

- B29K2995/0097—Thickness

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B29—WORKING OF PLASTICS; WORKING OF SUBSTANCES IN A PLASTIC STATE IN GENERAL

- B29L—INDEXING SCHEME ASSOCIATED WITH SUBCLASS B29C, RELATING TO PARTICULAR ARTICLES

- B29L2031/00—Other particular articles

- B29L2031/764—Photographic equipment or accessories

-

- G—PHYSICS

- G03—PHOTOGRAPHY; CINEMATOGRAPHY; ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ELECTROGRAPHY; HOLOGRAPHY

- G03B—APPARATUS OR ARRANGEMENTS FOR TAKING PHOTOGRAPHS OR FOR PROJECTING OR VIEWING THEM; APPARATUS OR ARRANGEMENTS EMPLOYING ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ACCESSORIES THEREFOR

- G03B11/00—Filters or other obturators specially adapted for photographic purposes

- G03B11/04—Hoods or caps for eliminating unwanted light from lenses, viewfinders or focusing aids

- G03B11/041—Lens caps as separate accessory

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10016—Video; Image sequence

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10028—Range image; Depth image; 3D point clouds

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10048—Infrared image

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30232—Surveillance

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N3/00—Scanning details of television systems; Combination thereof with generation of supply voltages

- H04N3/02—Scanning details of television systems; Combination thereof with generation of supply voltages by optical-mechanical means only

- H04N3/04—Scanning details of television systems; Combination thereof with generation of supply voltages by optical-mechanical means only having a moving aperture also apertures covered by lenses

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N5/00—Details of television systems

- H04N5/222—Studio circuitry; Studio devices; Studio equipment

- H04N5/262—Studio circuits, e.g. for mixing, switching-over, change of character of image, other special effects ; Cameras specially adapted for the electronic generation of special effects

- H04N5/2628—Alteration of picture size, shape, position or orientation, e.g. zooming, rotation, rolling, perspective, translation

Landscapes

- Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Signal Processing (AREA)

- Multimedia (AREA)

- Theoretical Computer Science (AREA)

- Mechanical Engineering (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Chemical & Material Sciences (AREA)

- Inorganic Chemistry (AREA)

- Ceramic Engineering (AREA)

- Manufacturing & Machinery (AREA)

- Optics & Photonics (AREA)

- Studio Devices (AREA)

- Radiation Pyrometers (AREA)

- Lens Barrels (AREA)

- Stereoscopic And Panoramic Photography (AREA)

Abstract

sistema local e método para analisar e classificar quadros de imagem individuais de dados de imagem panorâmica. imagens de câmera de imageamento térmico são obtidas a partir de uma câmera de imageamento térmico (250) que gira ao longo de uma pluralidade de posições de parada. a câmera captura imagens a uma velocidade de quadros constante e ao menos algumas das imagens correspondem a posições de parada. as imagens da câmera de imageamento térmico que correspondem a uma posição de parada são retidas, enquanto as imagens que não correspondem a uma posição de parada são descartadas. as imagens retidas são enviadas por um fluxo de vídeo a um processador de vídeo (240). o fluxo de vídeo é separado em imagens individuais da câmera de imageamento térmico e armazenado para dispositivos de câmera virtual correspondentes que correspondem a posições de parada específicas. além disso, a posição da câmera (250) e dos pixels individuais das imagens são ambas correlacionadas a dados de localização geográfica, e valores de profundidade para os pixels são determinados com base nos dados geográficos.

Description

[0001] Este pedido reivindica o benefício do pedido provisório de patenteUS n° 61/864.196, depositado em 9 de agosto de 2013, intitulado “Métodos para analisar dados de imagem com o uso de uma pluralidade de dispositivos virtuais, que correlaciona valores de profundidade a pixels de imagens, e um sistema incluindo uma tampa de lente sem descontinuidade” ("METHODS FOR ANALYZING THERMAL IMAGE DATA USING A PLURALITY OF VIRTUAL DEVICES, CORRELATING DEPTH VALUES TO IMAGE PIXELS, AND A SYSTEM INCLUDING A SEAMLESS LENS COVER"), que está aqui integralmente incorporado, por referência.

[0002] Imagens panorâmicas podem ser criadas por uma matriz decâmeras de ângulo amplo que juntas criam um campo de visão de até 360 graus, ou por uma câmera com uma lente olho de peixe, ou outro espelho panorâmico, que permite uma imagem em "bola de espelho" contínua que é posteriormente planificada em um computador. Estas imagens têm habilidade limitada para fornecer os detalhes necessários para que sejam úteis para vigilância por vídeo, pois os sensores são estendidos sobre campos de visão amplos (às vezes um giro completo de 360 graus).

[0003] Um meio relativamente novo de se capturar imagens panorâmicastérmicas envolve girar continuamente um sensor térmico resfriado criogenicamente ou outra câmera de alta velocidade a menos que 60 RPM e processar as imagens da câmera em um computador onde elas são unidas e analisadas. Estes sensores resfriados criogenicamente têm a habilidade de capturar imagens em apenas alguns nanossegundos, o que permite que eles produzam vídeo em tempo quase real. Entretanto, estes sensores resfriados consomem muita energia e são dispendiosos, o que os torna pouco práticos em várias aplicações. Além disso, as câmeras de alta velocidade têm necessidades de iluminação muito amplas, o que as torna muito limitadas para uso em condições diferentes das condições de plena luz do dia.

[0004] Mesmo com os avanços existentes na técnica, ainda existe umanecessidade por sistemas de câmera e métodos de análise aprimorados, particularmente aqueles que exibem complexidade e custo mínimos e que podem operar sob necessidades energéticas relativamente baixas.

[0005] A matéria reivindicada na presente invenção não se limita amodalidades que resolvem quaisquer desvantagens ou que operam apenas em ambientes como aqueles descritos acima. Ao invés disso, esses antecedentes são apenas fornecidos para ilustrar uma área de tecnologia exemplificadora em que algumas modalidades aqui descritas podem ser praticadas.

[0006] Implementações da presente invenção compreendem sistemas,métodos e produtos de programa de computador configurados para classificar e analisar quadros de imagem individuais de dados de imagem panorâmica com o uso de uma pluralidade de dispositivos virtuais. Por exemplo, uma modalidade da presente invenção é direcionada a um sistema local para analisar e classificar quadros de imagem individuais de dados de imagem panorâmica com o uso de uma pluralidade de dispositivos virtuais. Esse sistema pode incluir um mecanismo de indexação no qual uma câmera de imageamento térmico é montada para girar a câmera através de uma pluralidade de posições de parada, uma câmera de imageamento térmico, sendo que a câmera de imageamento térmico é configurada para tomar imagens da câmera de imageamento térmico, sendo que ao menos algumas das imagens da câmera de imageamento térmico correspondem às posições de parada à medida que a câmera de imageamento térmico gira através da pluralidade de posições de parada, e um módulo de multiplexação e análise configurado para descartar quaisquer imagens da câmera de imageamento térmico que não correspondem a qualquer uma das posições de parada, de modo que estas imagens da câmera de imageamento térmico que correspondem a qualquer posição de parada sejam retidas. O módulo de multiplexação e análise pode ser configurado para processar um fluxo de vídeo das imagens retidas da câmera de imageamento térmico separando-se o fluxo de vídeo das imagens retidas da câmera de imageamento térmico em imagens individuais da câmera de imageamento térmico, sendo que as imagens retidas da câmera de imageamento térmico são armazenadas para um dispositivo de câmera virtual correspondente. Cada um dos dispositivos de câmera virtual pode corresponder a uma posição de parada específica e os dispositivos de câmera virtual podem estar no local em relação à câmera de imageamento térmico. O módulo de multiplexação e análise pode ser configurado para não unir as imagens retidas da câmera de imageamento térmico em um panorama no local, de modo que as necessidades energéticas totais para o sistema local que inclui a câmera de imageamento térmico, o mecanismo de indexação para girar a câmera e o módulo de multiplexação e análise para classificar as imagens para os dispositivos de câmera virtual não sejam maiores que cerca de 10 watts. As imagens podem ser armazenadas em um sistema local, ou fora do local (por exemplo, e retransmitida no local, se necessário).

[0007] Outra modalidade da presente invenção compreende obter imagensde uma câmera de imageamento térmico a partir de uma câmera de imageamento térmico que gira através de uma pluralidade de posições de parada. A câmera pode capturar imagens de uma câmera de imageamento térmico a uma velocidade de quadros constante. Ao menos parte das imagens da câmera de imageamento térmico correspondem a posições de parada, enquanto outras imagens capturadas pela câmera de imageamento térmico podem não corresponder a qualquer posição de parada. As imagens da câmera de imageamento térmico que correspondem a qualquer uma das posições de parada são retidas, enquanto as imagens da câmera de imageamento térmico que não correspondem a qualquer posição de parada são descartadas. As imagens retidas da câmera de imageamento térmico são enviadas por um fluxo de vídeo até um processador de vídeo onde elas são separadas em imagens individuais da câmera de imageamento térmico e classificadas para um dispositivo de câmera virtual correspondente que corresponde à posição de parada específica a qual a imagem dada corresponde. O armazenamento das imagens retidas e classificadas pode ser local. Em uma outra modalidade, o armazenamento pode ser fora do local, e as imagens retransmitidas no local, conforme necessário. Os dispositivos de câmera virtual são locais, ao invés de remotos, em relação à câmera de imageamento térmico. As imagens da câmera de imageamento térmico são intencionalmente não unidas no local em uma imagem panorâmica local, de modo que as necessidades energéticas totais do sistema local (por exemplo, que inclui a câmera de imageamento térmico, um mecanismo de indexação para girar a câmera e um módulo de multiplexação e análise para classificar as imagens para os dispositivos de câmera virtual) não sejam maiores que cerca de 10 watts.

[0008] Descartar as imagens que não correspondem a qualquer posição deparada pode permitir que o processador de vídeo descanse periodicamente, pois o mesmo nunca recebe aquelas imagens, tornando, assim, o sistema mais eficiente em termos de consumo de energia. De modo similar, devido ao fato de que análises locais são limitadas a funções relativamente simples (por exemplo, não unir as imagens, mas parar e observar um dado local para ver o que está ocorrendo, etc.), o sistema apresenta características de consumo de energia relativamente limitadas. Por exemplo, o sistema local pode precisar de menos que cerca de 10 watts, pode ser deixado sem vigilância por um período de anos e pode ser alimentado por baterias carregadas por células solares relativamente pequenas.

[0009] Em outro aspecto, a presente invenção refere-se a um método paracorrelacionar dados de localização geográfica incluindo a determinação de valores de profundidade (isto é, a distância da câmera) para posições de pixels de um quadro de imagem individual de uma imagem panorâmica. O método pode compreender as etapas de obter imagens da câmera (por exemplo, imagens da câmera de imageamento térmico) a partir de uma única câmera que gira através de uma pluralidade de posições de parada. A câmera pode capturar imagens a uma velocidade de quadros constante, sendo que ao menos algumas das imagens correspondem a posições de parada à medida que a câmera gira através de uma pluralidade de posições de parada. Uma posição da câmera pode ser correlacionada a dados de localização geográfica, posições de pixel de uma dada imagem da câmera podem ser correlacionadas aos dados de localização geográfica e os valores de profundidade para posições de pixels da dada imagem da câmera podem ser determinados com base, ao menos em parte, na localização geográfica da câmera e a orientação ou posição na qual a dada posição de parada está "apontando".

[0010] Este Sumário é fornecido para introduzir uma seleção de conceitos deuma forma simplificada que são adicionalmente descritos abaixo na Descrição Detalhada. Este Sumário não tem por objetivo identificar características chave ou características essenciais da matéria reivindicada, nem tem por objetivo ser usado como um auxiliar na determinação do escopo da matéria reivindicada.

[0011] Características e vantagens adicionais serão definidas na descriçãoque se segue e, em parte, serão óbvias a partir da descrição, ou podem ser aprendidas pela prática dos ensinamentos da presente invenção. Características e vantagens da invenção podem ser realizadas e obtidas por meio dos instrumentos e combinações particularmente apontados nas reivindicações anexas. Características da presente invenção se tornarão evidentes de forma mais completa a partir da descrição e reivindicações anexas a seguir, ou podem ser aprendidas pela prática da invenção conforme apresentada doravante.

[0012] A fim de se descrever a maneira pela qual as vantagens ecaracterísticas supracitadas e adicionais podem ser obtidas, uma descrição mais específica da matéria brevemente descrita acima será apresentada com referência a modalidades específicas que são ilustradas nos desenhos anexos. Entendendo-se que esses desenhos representam apenas modalidades típicas e, portanto, não devem ser considerados como limitadores do escopo, as modalidades serão descritas e explicadas com especificidade e detalhes adicionais através do uso dos desenhos anexos, nos quais:

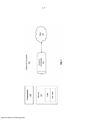

[0013] A Figura 1 ilustra esquematicamente um sistema de computadorexemplificador no qual os princípios aqui descritos podem operar.

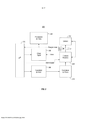

[0014] A Figura 2 ilustra esquematicamente um ambiente específico noqual os princípios aqui descritos podem operar.

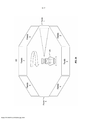

[0015] A Figura 3A ilustra esquematicamente posições da câmera virtual,também denominadas aqui de posições de parada, quando giram no sentido horário, com a câmera apontada para a posição de parada 1.

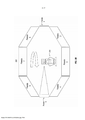

[0016] A Figura 3B ilustra esquematicamente posições da câmera virtual,como na Figura 3A, com a câmera apontada para posição de parada 5.

[0017] A Figura 4 ilustra esquematicamente uma implementação doprocessador de vídeo descrito na Figura 2.

[0018] A Figura 5A é um fluxograma que ilustra um método exemplificador.

[0019] A Figura 5B é um fluxograma que ilustra outro métodoexemplificador de acordo com a presente invenção.

[0020] Implementações da presente invenção compreendem sistemas,métodos e produtos de programa de computador configurados para classificar e analisar quadros de imagem individuais de dados de imagem panorâmica com o uso de uma pluralidade de dispositivos virtuais. Por exemplo, conforme mostrado na Figura 5A, uma modalidade da presente invenção compreende um método S10 para obter imagens de uma câmera de imageamento térmico a partir de uma câmera de imageamento térmico que gira através de uma pluralidade de posições de parada (S12). A câmera pode capturar imagens de uma câmera de imageamento térmico a uma velocidade de quadros constante. Ao menos parte das imagens da câmera de imageamento térmico correspondem a posições de parada, enquanto outras imagens capturadas pela câmera de imageamento térmico podem não corresponder a qualquer posição de parada. As imagens da câmera de imageamento térmico que correspondem a qualquer uma das posições de parada são retidas (S14), enquanto as imagens da câmera de imageamento térmico que não correspondem a qualquer posição de parada são descartadas (S16).

[0021] As imagens retidas da câmera de imageamento térmico são enviadaspor um fluxo de vídeo até um processador de vídeo (S18). As mesmas podem ser separadas em imagens individuais da câmera de imageamento térmico, classificadas e armazenadas para um dispositivo de câmera virtual correspondente que corresponde à posição de parada específica a qual a dada imagem corresponde (S20). Por exemplo, o sistema local pode incluir uma memória adequada para o armazenamento de imagens. Alternativamente, algumas ou todas as imagens podem ser armazenadas fora do local e retransmitidas no local conforme necessário. Os dispositivos de câmera virtual podem estar no local em relação à câmera de imageamento térmico. As imagens da câmera de imageamento térmico não são unidas no local em uma imagem panorâmica local, de modo que as necessidades energéticas totais do sistema local (por exemplo, que inclui a câmera de imageamento térmico, um mecanismo de indexação para girar a câmera e um módulo de multiplexação e análise para classificar as imagens para os dispositivos de câmera virtual) não sejam maiores que cerca de 10 watts.

[0022] As imagens individuais da câmera de imageamento térmico a partirde cada posição de parada podem ser analisadas como uma fluxo de vídeo para detectar uma alteração de uma dada imagem para uma imagem subsequente (S24).

[0023] Descartar as imagens que não correspondem a qualquer posição deparada pode permitir que o processador de vídeo descanse periodicamente, pois o mesmo nunca recebe aquelas imagens, tornando, assim, o sistema mais eficiente em termos de consumo de energia. De modo similar, devido ao fato de que as análises locais são limitadas a funções relativamente simples (por exemplo, não unir as imagens, etc.), o sistema apresenta características de consumo de energia relativamente limitadas (por exemplo, menores que cerca de 10 watts, pode ser deixado sem vigilância por um período de anos e pode ser alimentado por baterias carregadas por células solares relativamente pequenas).

[0024] Em outro aspecto, a presente invenção refere-se a um método (S30- conforme mostrado na Figura 5B) para correlacionar dados de localização geográfica, incluindo determinar valores de profundidade para posições de pixel de um quadro de imagem individual de uma imagem panorâmica. O método pode compreender as etapas de obter imagens da câmera (por exemplo, imagens da câmera de imageamento térmico) a partir de uma única câmera que gira através de uma pluralidade de posições de parada (S32). A câmera pode capturar imagens a uma velocidade de quadros constante, sendo que ao menos algumas das imagens correspondem a posições de parada à medida que a câmera gira através de uma pluralidade de posições de parada. Uma posição da câmera pode ser correlacionada a dados de localização geográfica (S34), posições de pixel de uma dada imagem da câmera podem ser correlacionadas aos dados de localização geográfica (S36) e os valores de profundidade para posições de pixel da dada imagem da câmera podem ser determinados com base, ao menos em parte, na localização geográfica da câmera e a orientação ou posição na qual a dada posição de parada está "apontando" (S38).

[0025] Opcionalmente, determinações de informações de profundidade(por exemplo, cálculos) podem ser feitas fora do local e retransmitidas de volta para o local do sistema de câmera para armazenamento local (S40). Em outras palavras, a análise e o processamento que correlaciona posições de uma imagem com dados de localização, que determinam o valor de profundidade adequado para cada pixel, podem ser feitos fora do local, e os resultados podem ser retransmitidos ao sistema local para uso pelo sistema de câmera, reduzindo ainda mais as necessidades energéticas do sistema local.

[0026] Em uso, um dado valor de profundidade para uma posição de pixelde uma dada imagem de uma câmera de imageamento térmico pode ser comparado a uma imagem da câmera de imageamento térmico obtida anteriormente ou subsequentemente a partir da mesma posição de parada para determinar quaisquer alterações, por exemplo, o tamanho ou velocidade de movimento de um objeto mostrado nas imagens da câmera de imageamento térmico (S42).

[0027] Embora a matéria seja descrita em uma linguagem específica acaracterísticas estruturais e/ou atos metodológicos, deve-se entender que a matéria definida nas reivindicações anexas não é necessariamente limitada às características descritas ou atos descritos aqui ou a ordem das atos aqui descritos. Ao invés disso, as características e atos descritos são revelados como formas exemplificadoras da implementação das reivindicações.

[0028] Sistemas de computador assumem cada vez mais uma amplavariedade de formas atualmente. Os sistemas de computador podem ser, por exemplo, dispositivos portáteis, aparelhos, computadores do tipo laptop, computadores de mesa, unidades de processamento, sistemas de computação distribuída ou mesmo dispositivos que não são convencionalmente considerados sistemas de computador. Nesta descrição e nas reivindicações, o termo "sistema de computador" é definido amplamente como incluindo qualquer dispositivo ou sistema (ou combinações dos mesmos) que inclui ao menos um processador físico e tangível e uma memória física e tangível capaz de ter em si instruções executáveis por computador que podem ser executadas pelo processador.

[0029] A Figura 1 ilustra um sistema de computador exemplificador 100. Emsua configuração mais básica, um sistema de computador 100 inclui, tipicamente, ao menos uma unidade de processamento 102 e uma memória 104. A memória 104 pode ser uma memória de sistema física, a qual pode ser volátil, não volátil ou alguma combinação das duas. O termo "memória" pode também ser usado aqui para se referir a um armazenamento em massa não volátil, como uma mídia de armazenamento física. Se o sistema de computador for distribuído, o processamento, memória e/ou capacidade de armazenamento também podem ser distribuídos.

[0030] Cada um dos sistemas de computador aqui descritos podem serconectados um ao outro ao longo de (ou podem ser parte de) uma rede, como,por exemplo, uma Rede De Área Local ("LAN"), uma Rede De Área Ampla("WAN") e mesmo a Internet. Consequentemente, cada um dos sistemas decomputador descritos, bem como quaisquer outros sistema de computador conectados e seus componentes, pode criar dados relacionados a mensagens e dados relacionados à troca de mensagens (por exemplo, datagramas de Protocolo de Internet ("IP") e outros protocolos de camada mais elevada que utilizam datagramas de IP, como, Protocolo De Controle De Transmissão ("TCP"), Protocolo de Transferência de Hipertexto ("HTTP"), Protocolo De Transferência De Correio Simples ("SMTP"), etc.) ao longo da rede.

[0031] Como usado aqui, o termo "módulo executável" ou "componenteexecutável" pode se referir a objetos de software, roteamentos ou métodos que podem ser executados no sistema de computador. Os diferentes componentes, módulos, mecanismos e serviços aqui descritos podem ser implementados como objetos ou processos que executam tarefas no sistema de computador (por exemplo, como filamentos separados).

[0032] Na descrição que se segue, modalidades são descritas com referênciaa atos que são realizados por um ou mais sistemas de computador. Se tais atos forem implementados em software, um ou mais processadores do sistema de computador associado que realiza o ato dirige a operação do sistema de computador em resposta à execução de instruções executáveis por computador. Por exemplo, tais instruções executáveis por computador podem ser incorporadas em uma ou mais mídias legíveis por computador que formam um produto de programa de computador. Um exemplo de tal operação envolve a manipulação de dados. As instruções executáveis por computador (e os dados manipulados) podem ser armazenados na memória 104 do sistema de computador 100. O sistema de computador 100 pode conter também canais de comunicação 108 que permitem que o sistema de computador 100 se comunique com outros processadores de mensagem ao longo de, por exemplo, uma rede 110.

[0033] As modalidades aqui descritas podem compreender ou utilizar umsistema de computador com um propósito especial ou um propósito geral, que inclui um hardware de computador, como, por exemplo, um ou mais processadores e uma memória de sistema, conforme discutido em maiores detalhes abaixo. A memória de sistema pode estar incluída na memória geral 104. A memória de sistema pode também referir-se a uma "memória principal" e inclui locais de memória que são endereçáveis por ao menos uma unidade de processamento 102 ao longo de um barramento de memória, sendo que, neste caso, o local de endereço é declarado no próprio barramento de memória. A memória de sistema é tradicionalmente volátil, mas os princípios aqui descritos também se aplicam a circunstâncias em que a memória de sistema é parcialmente, ou mesmo totalmente, não volátil.

[0034] Modalidades dentro do escopo da presente invenção incluemtambém mídias físicas e outras mídias legíveis por computador para transportar ou armazenar instruções executáveis por computador e/ou estruturas de dados. Tais mídias legíveis por computador podem ser quaisquer mídias disponíveis que podem ser acessadas por um sistema de computador de propósito geral ou de propósito especial. Mídias legíveis por computador que armazenam instruções executáveis por computador e/ou estruturas de dados são mídias de armazenamento de computador. Mídias legíveis por computador que transportam instruções executáveis por computador e/ou estruturas de dados são mídias de transmissão. Dessa forma, a título de exemplo, e não de limitação, modalidades da invenção podem compreender ao menos dois tipos distintamente diferentes de mídias legíveis por computador: uma mídia de armazenamento de computador e uma mídia de transmissão.

[0035] Mídias de armazenamento de computador são mídias dearmazenamento físicas que armazenam instruções executáveis por computador e/ou estruturas de dados. Mídias de armazenamento físico incluem dispositivos de armazenamento do tipo que se pode gravar, como RAM, ROM, EEPROM, unidades de estado sólido ("SSDs"), memória flash, memória de mudança de fase ("PCM"), armazenamento em disco óptico, armazenamento em disco magnético ou outros dispositivos de armazenamento magnéticos, ou qualquer outra mídia(s) de armazenamento físico de hardware que pode ser usada para armazenar um código de programa sob a forma de instruções executáveis por computador ou estruturas de dados e que podem ser acessadas e executadas por um sistema de computador de propósito geral ou de propósito especial para implementar a funcionalidade aqui descrita.

[0036] As mídias de transmissão podem incluir uma rede e/ou enlaces dedados que podem ser usados para transportar um código de um programa sob a forma de instruções executáveis por computador ou estruturas de dados, e que podem ser acessadas por uma sistema de computador de propósito geral ou de propósito especial. Uma "rede" é definida como um ou mais enlaces de dados que permitem o transporte de dados eletrônicos entre os sistemas de computador e/ou módulos e/ou outros dispositivos eletrônicos. Quando informações são transferidas ou fornecidas ao longo de uma rede ou outra conexão de comunicações (por fio, sem fio ou uma combinação de com fio ou sem fio) a um sistema de computador, o sistema de computador pode ver a conexão como uma mídia de transmissão. Combinações das características supracitadas também devem ser incluídas dentro do escopo de mídias legíveis por computador.

[0037] Adicionalmente, ao alcançar vários componentes do sistema decomputador, um código de programa sob a forma de instruções executáveis por computador ou estruturas de dados pode ser transferido automaticamente da mídia de transmissão à mídia de armazenamento de computador (ou vice- versa). Por exemplo, as instruções executáveis por computador ou estruturas de dados recebidas ao longo de uma rede ou enlace de dados podem ser armazenadas temporariamente em RAM dentro de um módulo de interface de rede (por exemplo, um "NIC"), e então eventualmente transferidas para a RAM do sistema de computador e/ou a uma mídia de armazenamento de computador menos volátil em um sistema de computador. Dessa forma, deve-se compreender que a mídia de armazenamento de computador pode ser incluída em componentes do sistema de computador que também (ou mesmo primariamente) utilizam mídias de transmissão.

[0038] As instruções executáveis por computador compreendem, porexemplo, instruções e dados que, quando executadas em um ou mais processadores, fazem com que um sistema de computador de propósito geral, um sistema de computador de propósito especial ou um dispositivo de processamento de propósito especial realize uma certa função ou grupo de funções. As instruções executáveis por computador podem ser, por exemplo, instruções binárias de formato intermediário, como uma linguagem de montagem ou mesmo um código fonte.

[0039] Os versados na técnica irão observar que a invenção pode serpraticada em ambientes de computação de rede com diversos tipos de configurações de sistema de computador, incluindo computadores pessoais, computadores de mesa, computadores do tipo laptop, processadores de mensagem, dispositivos portáteis, sistemas de multiprocessador, dispositivos eletrônicos de consumo à base de microprocessadores ou programáveis, computadores de rede, minicomputadores, computadores de grande porte, telefones móveis, PDAs, computadores do tipo tablet, pagers, roteadores, chaves e similares. A invenção também pode ser praticada em ambientes de sistema distribuído em que ambos os sistemas de computador local e remoto, que são ligados (por enlaces de dados com fio, enlaces de dados sem fio ou por uma combinação de enlaces de dados com fio e sem fio) através de uma rede, realizam tarefas. Assim, em um ambiente de sistema distribuído, um sistema de computador pode incluir uma pluralidade de sistemas de computador constituintes. Em um ambiente de sistema distribuído, os módulos de programa podem estar situados em ambos os dispositivos de armazenamento de memória local e remoto.

[0040] Os versados na técnica também irão observar que a invenção podeser praticada em um ambiente de computação na nuvem. Ambientes de computação na nuvem podem ser distribuídos, embora isso não seja necessário. Quando distribuídos, ambientes de computação na nuvem podem ser distribuídos internacionalmente dentro de uma organização e/ou podem ter componentes possuídos por múltiplas organizações. Nesta descrição e nas reivindicações a seguir, "computação na nuvem" é definido como um modelo para permitir acesso a rede mediante solicitação a um conjunto compartilhado de recursos de computação configuráveis (por exemplo, redes, servidores, armazenamento, aplicações e serviços). A definição de "computação na nuvem" não se limita a qualquer uma das numerosas vantagens diferentes que podem ser obtidas a partir de tal modelo quando adequadamente empregado.

[0041] Alternativamente, ou além disso, a funcionalidade aqui descrita podeser realizada, ao menos em parte, por um ou mais componentes lógicos de hardware. Por exemplo, e sem limitação, tipos ilustrativos de componentes lógicos de hardware que podem ser usados incluem Matrizes de Portas Programáveis em Campo (FPGAs), Circuitos Integrados De Aplicação Específica (ASICs), Produtos Padrão De Aplicação Específica (ASSPs), Sistemas de sistema-em-um-chip (SOCs), Dispositivos Lógicos Complexos Programáveis (CPLDs), etc.I. Dispositivos de câmera virtual

[0042] A Figura 2 ilustra um diagrama em blocos para o sistema de câmera200. O sistema de câmera 200 permite que uma câmera 250 (por exemplo, uma câmera de imageamento térmico) gire até uma volta total de 360° em torno de um eixo fixo. A revolução completa compreende um número de posições que correspondem a "paradas" onde se deseja que uma imagem seja capturada. Devido às necessidades relacionadas a calibragem de câmera, particularmente com uma câmera de imageamento térmico, a câmera pode capturar imagens a uma velocidade de quadros constante. O espectro capturado pode ser de cerca de 8.000 nm a cerca de 14.000 nm. Naturalmente, é possível empregar os conceitos apresentados aqui em sistemas configurados para capturar e usar dados de imagem com base em outros espectros (por exemplo, luz visível, comprimentos de onda maiores ou menores). Ao se capturar imagens a uma velocidade de quadros constante, algumas das imagens podem corresponder a posições entre posições de "parada" designadas, enquanto outras irão corresponder a uma posição de "parada". Conforme será descrito em maiores detalhes abaixo, apenas aquelas imagens que correspondem a uma posição de "parada" podem ser retidas. As outras podem ser descartadas.

[0043] As posições em que a câmera 250 captura as imagens que serãoretidas são chamadas aqui de posições de parada, pois a câmera 250 precisa estar estacionária, ou momentaneamente parada, de modo que a câmera 250 possa adquirir uma imagem não embaçada. Uma posição de parada pode ser caracterizada como tendo um deslocamento de ângulo em relação a uma posição inicial designada (isto é, "parada" 1) na qual a câmera 250 captura uma imagem. Em algumas implementações, o sistema pode determinar a posição inicial com o uso de um suporte para câmera com um orifício, juntamente com um codificador óptico transmissivo que pode detectar a posição inicial quando o orifício no suporte para câmera se alinhar com o codificador. Tal codificador óptico transmissivo pode ser um codificador de 1 bit. Em outras implementações, um codificador de resolução mais alta pode ser usado para permitir uma retroinformação mais granular da posição real da câmera em qualquer momento.

[0044] O sistema de câmera 200 pode permitir qualquer número de posiçõesde parada por revolução. Em uma modalidade, o número de posições de parada pode estar entre 1 e 16. As paradas podem estar posicionadas em intervalos espaçados uniformemente. Por exemplo, dez posições de parada, ou paradas, por revolução resultariam em dez paradas que estão separadas por 36°. O sistema de câmera 200 pode utilizar qualquer mecanismo de motor adequado para assegurar que a câmera permanece momentaneamente estacionária em cada posição de parada, a fim de facilitar a captura de uma imagem não embaçada em cada posição de parada desejada. Por exemplo, um motor de passo pode ser empregado para manter a câmera 250 estacionária em cada posição de parada pela quantidade de tempo adequada para adquirir uma imagem antes de mover para a próxima posição de parada. Detalhes de mecanismos de motor de passo exemplificadores são revelados no pedido de patente US n° de série PCT/US/2014/033539 dos inventores, depositado em 9 de abril de 2014, intitulado STEPPER MOTOR CONTROL AND FIRE DETECTION SYSTEM, aqui incorporado a título de referência, em sua totalidade. Outro exemplo de um mecanismo de motor que pode ser empregado na rotação da câmera ao longo de uma pluralidade de posições de parada nas quais a câmera permanece estacionária momentaneamente em cada posição de parada inclui um sistema de câmera mecânico, por exemplo, conforme descrito na patente US n° 8.773.503 dos inventores, concedida em 8 de julho de 2014, e intitulada AUTOMATED PANORAMIC CAMERA AND SENSOR PLATFORM WITH COMPUTER AND OPTIONAL POWER SUPPLY, aqui incorporada a título de referência, em sua totalidade. Mecanismos de motor, conforme descritos nas patentes e pedidos acima, bem como qualquer outro projeto adequado, podem ser empregados.

[0045] Conforme mostrado na Figura 2, o sistema pode utilizar doisprocessadores, um microprocessador 210 e um processador de vídeo 240. O microprocessador 210 pode gerenciar a posição e temporização da câmera 250, enquanto o processador de vídeo 240 pode processar o vídeo a partir da câmera 250. Utilizar dois processadores permite que o desempenho em tempo real da câmera 250 e a sincronização do motor pelo microprocessador 210 sejam dissociados do processador de vídeo 240 de alta velocidade. Alternativamente, algumas implementações podem utilizar um processador para gerenciar a posição e a temporização, bem como o vídeo da câmera 250. Naturalmente, mais que dois processadores poderiam ser alternativamente empregados.

[0046] Em uma implementação, os dados da câmera 250 passam através decontatos rotativos 260, o que permite que a câmera 250 gire conforme descrito acima (rotação contínua com paradas intermitentes bem curtas). Devido ao fato de que os períodos em que a câmera está de fato estacionária serem tão curtos, a câmera pode parecer girar continuamente. Em alguns casos, a velocidade de quadros da câmera pode não ser exatamente igual à velocidade de rotação e velocidade de parada do sistema de câmera 200, criando, assim, quadros de vídeo fracionários. Um interruptor digital 230 pode então ser usado para descartar quaisquer quadros de vídeo desnecessários. Em outras palavras, conforme descrito acima, alguns quadros capturados podem corresponder a uma das posições de parada, enquanto outros quadros capturados podem ser capturados enquanto a câmera está girando. Usar o interruptor digital 230 permite que o processador de vídeo 240 descanse durante aqueles momentos em que quadros de vídeo desnecessários são descartados, criando, assim, uma melhor eficiência energética. Naturalmente, em outras modalidades do sistema, o processador de vídeo (por exemplo, um ARM/DSP) pode ter pouco ou nenhum tempo para descansar.

[0047] Quando uma imagem é tomada em cada posição de parada, cadaposição de parada pode ser representada como uma câmera virtual individual. Uma câmera virtual pode agir como uma câmera estacionária apontada em uma única direção. O sistema de câmera 200 pode sustentar qualquer número de posições de parada e um número correspondente de câmeras virtuais. Em uma modalidade, o sistema 200 pode incluir de 1 a 16 posições de parada e de 1 a 16 câmeras virtuais, sendo que cada câmera virtual é associada a uma posição de parada específica. A Figura 3A ilustra como cada posição de parada pode se correlacionar a um espaço físico com a câmera 250 voltada para a posição de parada 1 (isto é, posição inicial). A Figura 3B mostra a câmera 250 girada de modo a estar voltada para a posição de parada 5. Conforme mostrado nas Figuras 3A e 3B, um sistema de numeração usado para as posições de parada pode aumentar em um sentido horário. As Figuras 3A e 3B ilustram uma configuração exemplificadora que inclui 8 posições de parada, embora seja entendido que mais ou menos posições de parada podem ser fornecidas. A título de exemplo, o número de posições de parada pode ser de 2 a cerca de 30, de 4 a cerca de 20 ou de 6 a cerca de 16.

[0048] O período em que a câmera está momentaneamente parada podeser qualquer período de tempo adequado (por exemplo, pode depender das características de capacidade de captura de imagem da câmera). Em uma modalidade, cada período de parada (isto é, o tempo de permanência) pode ser de cerca de 30 ms a cerca de 120 ms (por exemplo, cerca de 60 ms).

[0049] Cada imagem capturada pela câmera 250 que corresponde a umaposição de parada pode ser multiplexada, ou muxada, em um fluxo de vídeo e enviada ao processador de vídeo 240. Cada imagem a ser retida que foi capturada pela câmera 250 pode ser enviada a partir da câmera ao longo da mesma interface. O microprocessador 210 pode gerenciar e rastrear o deslocamento de ângulo (e sua posição de parada correspondente) da câmera 250 quando uma imagem a ser retida é capturada (isto é, a imagem corresponde a uma posição de parada). Mesmo imagens que serão descartadas (isto é, a imagem não correspondente a uma posição de parada), podem ser enviadas para o interruptor digital 230 ao longo da mesma interface que as imagens retidas. No interruptor digital 230, aquelas imagens que serão descartadas podem ser separadas e descartadas, ao invés de passarem para o processador de vídeo 240.

[0050] Uma implementação exemplificadora que mostra como o processadorde vídeo 240 pode operar é descrita com maiores detalhes na Figura 4. Com referência à Figura 4, o acionador de demultiplexação de vídeo 430 separa o fluxo de vídeo em imagens individuais (isto é, quadros) que correspondem cada uma a uma posição de parada específica, ou câmera virtual. Por exemplo, o fluxo de vídeo mencionado neste estágio pode incluir imagens a serem retidas que foram capturadas em posições de parada diferentes. O acionador de demultiplexação 430 pode usar as informações de posição rastreadas pelo microprocessador 210 para determinar a câmera virtual correspondente de cada imagem do fluxo de vídeo, permitindo a classificação das imagens aos seus dispositivos de câmera virtual adequados. Conforme ilustrado pela Figura 4, cada imagem pode ser enviada a sua câmera virtual correspondente (401 - 408) para armazenamento e análises futuras (por exemplo, comparação de imagens tomadas em tempos adjacentes a partir da mesma posição de parada), uma vez que esta determinação foi feita.

[0051] Se for desejado, imagens de posições de parada diferentes podem serunidas para criar uma imagem panorâmica (por exemplo, de até 360°). Uma vantagem das presentes modalidades é que qualquer uma dessas uniões é opcional e não é tipicamente executada no local (se possível). Se realizada, a união pode ser feita fora do local, permitindo que as necessidades energéticas totais para um sistema local 200 não sejam maiores que cerca de 10 watts, uma vez que a união consome muita energia e o processamento do computador é intenso.

[0052] Em algumas implementações, o fluxo de vídeo associado a um dadodispositivo de câmera virtual pode ser analisado para detectar uma alteração de uma dada imagem para uma imagem subsequente. Em outras palavras, ao invés de unir as imagens para criar uma imagem panorâmica, a análise executada pode envolver a comparação entre uma imagem e uma imagem capturada subsequentemente (ou uma imagem capturada anteriormente) a partir da mesma posição de parada (e, dessa forma, o mesmo dispositivo de câmera virtual) para detectar quaisquer alterações (por exemplo, uma alteração na temperatura de um objeto, movimento de um objeto, etc.). Por exemplo, a análise executada pode incluir detecção de fogo, conforme discutido no pedido de patente anterior US n° de série PCT/US/2014/033539 dos inventores, depositado em 9 de abril de 2014, intitulado STEPPER MOTOR CONTROL AND FIRE DETECTION SYSTEM, e no pedido de patente U.S. n° de série PCT/US/2014/033547, depositado em 9 de abril de 2014, intitulado FIRE DETECTION SYSTEM, cada um dos quais está aqui integralmente incorporado, por referência.

[0053] Capturando-se dados de imagem térmica e submetendo-se osdados de imagem térmica a uma análise, o mascaramento do plano de fundo pode ser simplificado em comparação com dados de espectro visível, simplificando a identificação de objetos.

[0054] Energia pode ser suprida ao sistema local com o uso de bateriasque são carregadas através de células solares, o que pode permitir que o sistema seja colocado em um dado local (por exemplo, remoto, fora da rede elétrica) por longos períodos de tempo, como até dois anos ou mais. A vida útil pode ser mais curta que 2 anos, dependendo das características do sistema.

[0055] Cada câmera virtual pode ter um fluxo de vídeo similar àquele queseria obtido por uma câmera estacionária posicionada na posição de parada correspondente. O sistema de câmeras virtuais pode ser local em relação à câmera de imageamento térmico 250. Em algumas implementações, a velocidade de quadros de um fluxo de vídeo de uma câmera virtual é igual à velocidade de rotação do motor 270, visto que a câmera 250 passa por cada parada uma vez por revolução. A velocidade de quadros do sinal muxado pode ser igual à velocidade de rotação do motor 270 multiplicada pelo número de paradas por revolução. Por exemplo, um sistema trabalhando a 30 RPM com 16 paradas por revolução teria uma velocidade de quadros muxada de 8 quadros por segundo (FPS) e cada dispositivo de câmera virtual teria uma velocidade de quadros de % FPS, ou 1 quadro por 2 segundos (por exemplo, 30 RPM / 60 segundos em um minuto = 0,5 FPS).

[0056] Utilizar câmeras virtuais pode permitir que análises e qualquerunião sejam dissociadas da aquisição de imagens. Devido ao fato de que cada câmera virtual pode ter seu próprio fluxo de vídeo, as imagens associadas a cada câmera virtual podem ser processadas independentemente. O sistema 200 pode capturar imagens normalmente em uma ordem numérica (por exemplo, em sentido horário ou anti-horário), mas devido ao fato de que o deslocamento de ângulo a partir da posição inicial (isto é, a posição de parada 1) é conhecido com base no número de parada da câmera virtual, análises ou qualquer união podem ser atualizadas em qualquer ordem desejada.II. Dados de localização geográfica

[0057] Em algumas implementações, o posicionamento da câmera 250 naqual uma imagem é capturada pode estar correlacionado a dados de localização geográfica reais (por exemplo, dados de GPS). Uma vez que se conhece onde a câmera real 250 está situada, com base nos dados de localização geográfica, a câmera pode ser posicionada em um mapa topográfico 3D. De modo similar, os valores de profundidade para pixels individuais de um dado quadro de um dado dispositivo de câmera virtual (isto é, posição de parada) podem ser determinados. Correções podem ser feitas em inclinação e altura.

[0058] Detalhes adicionais de sistemas de detecção de fogoexemplificadores, incluindo a habilidade de correlacionar dados de localização geográfica e determinar valores de profundidade, são encontrados no pedido de patente U.S. n° de série PCT/US/2014/033547, depositado em 9 de abril de 2014, intitulado FIRE DETECTION SYSTEM, aqui já incorporado na íntegra, a título de referência.

[0059] Correlacionar dados de localização geográfica com oposicionamento da câmera 250 pode incluir, mas sem limitação, correlacionar posições de pixels de uma imagem capturada e determinar os valores deprofundidade para as posições de pixel de imagens de uma câmera deimageamento térmico com base na localização geográfica da câmera deimageamento térmico 250. Dada a elevação e orientação da câmera deimageamento térmico 250, o valor de distância ou profundidade para cada pixel de uma imagem pode ser calculado com o uso dos dados de elevação, por exemplo, do Conjunto de Dados de Elevação Nacional (NED).

[0060] O cálculo do valor de profundidade a ser associado a um dado pixelpode ser feito em uma série de etapas para determinar (por exemplo, calcular) como cada pixel representa um raio projetado da câmera através do panorama que cruza o solo. Em geral, isto pode ser alcançado com o uso de uma vista de câmera projetada em um modelo de terreno em grade de linhas criado com o uso de dados de elevação (por exemplo, do Conjunto de Dados de Elevação Nacional) para estimar onde cada pixel renderizado da vista de câmera cruzaria o gráfico em grade de linhas para calcular o valor de profundidade "z" provável do fundo de cada elemento ou pixel da imagem. Tal processo pode empregar um processo contínuo executado através do aumento das distâncias z até que a altura projetada cruze a altura de elevação a uma distância.

[0061] Isto pode ser feito determinando-se (por exemplo, calculando-se) seum raio que tem um comprimento igual à altura da câmera cruza o solo na distância projetada. Esta determinação pode ser repetida aumentando-se repetidamente o comprimento do raio por uma dada quantidade (por exemplo, 1 decímetro) até que o solo seja alcançado (por exemplo, cruzado) ou o raio exceda um dado comprimento (por exemplo, 30 quilômetros). Tal comprimento excessivo pode ser usado para ajudar a fornecer o horizonte. Dados de latitude, longitude, elevação e distância do ponto de intersecção podem ser armazenados, e a determinação (por exemplo, cálculo) pode ser repetida para o próximo pixel de uma coluna. Avançando para cima a partir do fundo, dentro da imagem, uma vez que uma coluna de pixels alcança o horizonte, a determinação pode se mover para uma nova coluna. Tais determinações ou cálculos podem se basear em um Campo de Visão Vertical, Campo de Visão Horizontal, elevação e orientação variáveis. O conjunto de dados final pode ser usado para renderizar uma imagem que representa distância (por exemplo, em escala de cinza) com linhas posicionadas a uma dada distância (por exemplo, a cada 100 metros). A imagem determinada ou calculada pode ser comparada a uma imagem real para um ajuste final das variáveis de entrada. Uma vez completo, o resultado final forneceria um mapa de valor de profundidade "z" que pode ser salvo para disponibilidade de análise imediata futura.

[0062] Ilustrando as etapas descritas acima, uma imagem de 640x512 podeprecisar de aproximadamente 250.000 repetições das determinações descritas.

[0063] Uma vez que os valores de profundidade para as posições de pixelsão determinados, isto pode permitir a determinação do tamanho ou velocidade de movimento de um objeto capturado dentro da imagem. Por exemplo, isto pode proporcionar informações sobre o tamanho ou velocidade de movimento de um incêndio florestal. O processamento que correlaciona posições de pixel de uma imagem a dados de localização e determina um valor de profundidade associado a cada pixel pode ser feito fora do local em um terminal de interface de usuário remoto. Os valores de profundidade reais associados a determinados pixels das imagens podem ser retransmitidos ao sistema de câmera para armazenamento e uso local.

[0064] A retransmissão de quaisquer dados locais para fora do local ouvice-versa pode se dar por qualquer mecanismo adequado, por exemplo, incluindo, mas sem limitação, enlaces ou redes de satélite, enlaces ou redes celulares, enlaces ou redes WiFi, transmissão por rádio, enlace ou redes com fio, etc.

[0065] A presente invenção pode englobar outras formas específicas semque se afaste do espírito ou das características. As modalidades descritas devem ser consideradas em todos os respeitos apenas como ilustrativas e não restritivas. O escopo da invenção é, portanto, indicado pelas reivindicações anexas em vez de pela descrição anteriormente mencionada. Todas as alterações que estão dentro do significado e das faixas de equivalência das reivindicações devem ser abrangidas em seu escopo.

Claims (20)

1. Sistema local (200) para analisar e classificar quadros de imagem individuais de dados de imagem panorâmica com o uso de uma pluralidade de dispositivos virtuais compreendendo:um mecanismo de indexação no qual uma câmera de imageamento térmico (250) é montada para girar a câmera de imageamento térmico (250) ao longo de uma pluralidade de posições de parada;em que a câmera de imageamento térmico (250) é configurada para tomar imagens de câmera de imageamento térmico, sendo que ao menos algumas das imagens da câmera de imageamento térmico correspondem a posições de parada à medida que a câmera de imageamento térmico (250) gira ao longo de uma pluralidade de posições de parada;caracterizado pelo fato de que ainda compreende um módulo de multiplexação e análise que compreende um primeiro processador (210), um segundo processador (240), e um interruptor digital (230), em que o primeiro processador (210) é configurado para gerenciar o posicionamento e o período de tempo da câmera de imageamento térmico, e em que o segundo processador (240) é um processador de vídeo configurado para processar um fluxo de vídeo das imagens retidas da câmera de imageamento térmico através da separação do fluxo de vídeo das imagens retidas da câmera de imageamento térmico em imagens individuais da câmera de imageamento térmico que correspondem a posições de parada específicas, e armazenar as imagens retidas da câmera de imageamento térmico para uma pluralidade de dispositivos de câmera virtual correspondentes (401-408);o interruptor digital (230) do módulo de multiplexação e análise sendo configurado para descartar quaisquer imagens da câmera de imageamento térmico que não correspondam a qualquer uma das posições de parada, sendo que o segundo processador (240) descansa enquanto o interruptor digital (230) descarta imagens que não correspondem a qualquer posição de parada designada; a pluralidade de dispositivos de câmera virtual (401-408) estando no local em relação à câmera de imageamento térmico (250), cada dispositivo de câmera virtual da pluralidade de dispositivos de câmera virtual (401-408) correspondendo a uma posição de parada específica e cada um dos dispositivos de câmera virtual possuindo um fluxo de vídeo separado correspondente, cada fluxo de vídeo separado correspondente compreendendo uma pluralidade de imagens que correspondem a uma posição de parada específica.

2. Sistema local, de acordo com a reivindicação 1, caracterizado pelo fato de que a câmera de imageamento térmico (250) toma as imagens da câmera de imageamento térmico a uma velocidade de quadros constante.

3. Sistema local, de acordo com a reivindicação 1, caracterizado pelo fato de que a energia é fornecida ao sistema local por baterias que são carregadas através de células solares.

4. Sistema local, de acordo com a reivindicação 1, caracterizado pelo fato de que o primeiro processador (210) rastreia um deslocamento de ângulo em relação a uma posição inicial na qual uma imagem da câmera de imageamento térmico é capturada.

5. Sistema local, de acordo com a reivindicação 4, caracterizado pelo fato de que o módulo de multiplexação e análise local compreende um acionador de demultiplexação (430) que classifica as imagens retidas para serem armazenadas para o dispositivo de câmera virtual correspondente.

6. Sistema local, de acordo com a reivindicação 5, caracterizado pelo fato de que o acionador de demultiplexação (430) utiliza as informações de posição fornecidas pelo primeiro processador (210) para determinar a qual posição de parada uma dada imagem corresponde.

7. Sistema local, de acordo com a reivindicação 1, caracterizado pelo fato de que um interruptor digital (230) é configurado para e reter as imagens da câmera de imageamento térmico que correspondem a qualquer posição de parada.

8. Sistema local, de acordo com a reivindicação 7, caracterizado pelo fato de que o segundo processador (240), que é o processador de vídeo, é configurado para tanto (i) processar o fluxo de vídeo das imagens retidas da câmera de imageamento térmico através da separação do fluxo de vídeo das imagens retidas da câmera de imageamento térmico em imagens individuais da câmera de imageamento térmico que são armazenadas para um dispositivo de câmera virtual correspondente, quanto para (ii) descansar durante o descarte das imagens que não correspondem a qualquer posição de parada designada pela interruptor digital (230).

9. Sistema local, de acordo com a reivindicação 8, caracterizado pelo fato de que as imagens retidas da câmera de imageamento térmico são enviadas da câmera de imageamento térmico (250) até o interruptor digital (230) do módulo de multiplexação e análise através de contatos deslizantes (260), de modo que a câmera de imageamento térmico (250) possa girar continuamente.

10. Sistema local, de acordo com a reivindicação 1, caracterizado pelo fato de que o módulo de multiplexação e análise é configurado para não unir as imagens retidas de câmera de imageamento térmico em um panorama no local.

11. Método (S10) para analisar e classificar quadros de imagem individuais de dados de imagem panorâmica com o uso de uma pluralidade de dispositivos virtuais compreendendendo:obter imagens de câmera de imageamento térmico a partir de uma câmera de imageamento térmico (250) que gira ao longo de uma pluralidade de posições de parada, sendo que a câmera de imageamento térmico (250) toma imagens de câmera de imageamento térmico e ao menos algumas das imagens de câmera de imageamento térmico correspondem a posições de parada à medida que a câmera de imageamento térmico (250) gira ao longo da pluralidade de posições de parada;reter as imagens da câmera de imageamento térmico que correspondem a qualquer posição de parada;caracterizado pelo fato de fazer com que um interruptor digital (230) descarte quaisquer imagens da câmera de imageamento térmico que não correspondem a qualquer posição de parada designada;fazer com que um processador de vídeo (240) descanse enquanto o interruptor digital (230) descarta das imagens que não correspondem a qualquer posição de parada designada;separar o fluxo de vídeo em imagens individuais da câmera de imageamento térmico e armazenar as imagens da câmera de imageamento térmico para uma pluralidade de dispositivos de câmera virtual correspondentes (401-408), a pluralidade de dispositivos de câmera virtual (401-408) estando no local em relação à câmera de imageamento térmico (250), cada dispositivo de câmera de imageamento térmico correspondendo a uma posição de parada específica e cada dispositivo de câmera virtual possuindo um fluxo de vídeo separado correspondente, cada fluxo de vídeo separado correspondente compreendendo uma pluralidade de imagens que correspondem a uma posição de parada específica; eenviar as imagens retidas da câmera de imageamento térmico em um fluxo de vídeo para o processador de vídeo (240).

12. Método, de acordo com a reivindicação 11, caracterizado pelo fato de que a câmera de imageamento térmico (250) está fisicamente estacionária ao capturar imagens correspondentes a cada uma das posições de parada.

13. Método, de acordo com a reivindicação 11, caracterizado pelo fato de que a câmera de imageamento térmico (250) não está fisicamente estacionária ao capturar imagens que não correspondem a qualquer posição de parada designada.

14. Método, de acordo com a reivindicação 11, caracterizado pelo fato de que o módulo de multiplexação e análise associado com a câmera de imageamento térmico (250) é configurado para não unir as imagens retidas da câmera de imageamento térmico juntas em um panorama no local.

15. Método, de acordo com a reivindicação 11, caracterizado pelo fato de que imagens individuais da câmera de imageamento térmico a partir de cada posição de parada são analisadas como um fluxo de vídeo para detectar uma alteração de uma dada imagem para uma imagem subsequente.

16. Método, de acordo com a reivindicação 11, caracterizado pelo fato de que as imagens individuais da câmera de imageamento térmico a partir de cada posição de parada são unidas juntas para criar uma imagem panorâmica de até 360°, sendo que a união é realizada fora do local, em uma interface de usuário.

17. Método, de acordo com a reivindicação 11, caracterizado pelo fato de que adicionalmente compreende:correlacionar uma posição da câmera de imageamento térmico (250) com dados de localização geográfica;correlacionar posições de pixel de uma dada imagem de uma câmera de imageamento térmico com dados de localização geográfica; edeterminar valores de profundidade para posições de pixel de uma dada imagem de uma câmera de imageamento térmico com base, ao menos em parte, na localização geográfica da câmera de imageamento térmico (250).

18. Método, de acordo com a reivindicação 17, caracterizado pelo fato de que um dado valor de profundidade para uma posição de pixel de uma dada imagem de uma câmera de imageamento térmico é comparado ao valor de profundidade para uma posição de pixel de uma imagem de uma câmera de imageamento térmico obtida anteriormente ou subsequentemente a partir da mesma posição de parada para determinar o tamanho ou velocidade de movimento de um objeto mostrado nas imagens da câmera de imageamento térmico.

19. Método, de acordo com a reivindicação 18, caracterizado pelo fato de que o processamento que correlaciona as posições de pixel de uma imagem com os dados de localização e determina um valor de profundidade associado a cada pixel é realizado fora do local com relação à câmera de imageamento térmico (250) em um terminal de interface de usuário remoto.

20. Método, de acordo com a reivindicação 19, caracterizado pelo fato de que informações de profundidade são retransmitidas ao local da câmera de imageamento térmico (250) para armazenamento.

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US201361864196P | 2013-08-09 | 2013-08-09 | |

| US61/864,196 | 2013-08-09 | ||

| PCT/US2014/049986 WO2015021186A1 (en) | 2013-08-09 | 2014-08-06 | Methods for analyzing thermal image data using a plurality of virtual devices and methods for correlating depth values to image pixels |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| BR112016002720A2 BR112016002720A2 (pt) | 2017-08-01 |

| BR112016002720A8 BR112016002720A8 (pt) | 2020-02-04 |

| BR112016002720B1 true BR112016002720B1 (pt) | 2021-11-23 |

Family

ID=52461914

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| BR112016002720-5A BR112016002720B1 (pt) | 2013-08-09 | 2014-08-06 | Sistema local e método para analisar e classificar quadros de imagem individuais de dados de imagem panorâmica |

Country Status (8)

| Country | Link |

|---|---|

| US (5) | US9348196B1 (pt) |

| EP (1) | EP3030935B1 (pt) |

| JP (1) | JP6581086B2 (pt) |

| KR (1) | KR102248161B1 (pt) |

| CN (2) | CN108495051B (pt) |

| BR (1) | BR112016002720B1 (pt) |

| MX (1) | MX360725B (pt) |

| WO (1) | WO2015021186A1 (pt) |

Families Citing this family (19)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| NL2008639C2 (en) * | 2012-04-13 | 2013-10-16 | Cyclomedia Technology B V | Device, system and vehicle for recording panoramic images, and a device and method for panoramic projection thereof. |

| WO2014169061A1 (en) | 2013-04-09 | 2014-10-16 | Thermal Imaging Radar, Llc. | Stepper motor control and fire detection system |

| WO2014169066A1 (en) | 2013-04-09 | 2014-10-16 | Thermal Imaging Radar, LLC | Fire detection system |

| KR102248161B1 (ko) | 2013-08-09 | 2021-05-04 | 써멀 이미징 레이다 엘엘씨 | 복수의 가상 장치를 이용하여 열 이미지 데이터를 분석하기 위한 방법들 및 깊이 값들을 이미지 픽셀들에 상관시키기 위한 방법들 |

| WO2016160794A1 (en) | 2015-03-31 | 2016-10-06 | Thermal Imaging Radar, LLC | Setting different background model sensitivities by user defined regions and background filters |

| USD776181S1 (en) | 2015-04-06 | 2017-01-10 | Thermal Imaging Radar, LLC | Camera |

| JP6582805B2 (ja) * | 2015-09-25 | 2019-10-02 | 富士通株式会社 | 符号化装置、符号化システム、符号化方法、及びプログラム |

| JP2019514078A (ja) * | 2016-03-10 | 2019-05-30 | ヴィズビット インコーポレイテッド | 時間多重化プログラム可能な視野撮像 |

| US9888179B1 (en) * | 2016-09-19 | 2018-02-06 | Google Llc | Video stabilization for mobile devices |

| CN106652300B (zh) * | 2016-12-23 | 2019-03-15 | 中科星图股份有限公司 | 一种应用于林区的火点监测方法 |

| CN107424182B (zh) * | 2017-05-03 | 2024-04-12 | 北京海顿中科技术有限公司 | 一种热成像现场监控装置及方法 |

| US10574886B2 (en) | 2017-11-02 | 2020-02-25 | Thermal Imaging Radar, LLC | Generating panoramic video for video management systems |

| EP3553697B1 (en) | 2018-04-13 | 2023-06-07 | Thermal Imaging Radar, LLC | Generating panoramic video for video management systems |

| CN108520615B (zh) * | 2018-04-20 | 2020-08-25 | 吉林省林业科学研究院 | 一种基于图像的火灾识别系统和方法 |

| US11280500B2 (en) | 2018-08-03 | 2022-03-22 | Pixart Imaging Inc. | Auto detection system based on thermal signals |

| US10871394B2 (en) * | 2018-08-03 | 2020-12-22 | Pixart Imaging Inc. | Optical sensor assembly |

| US11601605B2 (en) | 2019-11-22 | 2023-03-07 | Thermal Imaging Radar, LLC | Thermal imaging camera device |

| CN111726522B (zh) * | 2020-06-12 | 2021-06-11 | 上海摩勤智能技术有限公司 | 一种人脸识别设备控制方法及装置 |

| KR102448584B1 (ko) * | 2022-02-24 | 2022-09-29 | 케비스전자 주식회사 | 회전 멀티어레이 써모폴리센서를 이용한 파노라마 열화상 온도 모니터링 시스템 |

Family Cites Families (205)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US3336810A (en) | 1964-04-28 | 1967-08-22 | Sperry Rand Corp | Antifriction support means for gyroscopes |

| US3648384A (en) | 1970-04-07 | 1972-03-14 | Borg Warner | Turntable drive release mechanism |

| US3769501A (en) | 1973-01-02 | 1973-10-30 | Gte Sylvania Inc | Selective actuating mechanism for percussive photoflash lamp array |

| US4977323A (en) * | 1973-08-16 | 1990-12-11 | The United States Of America As Represented By The Secretary Of The Navy | 360 degree infrared surveillance with panoramic display |

| US3883788A (en) | 1973-10-26 | 1975-05-13 | Sperry Sun Well Surveying Co | Gyroscope orientation controller |

| US4263513A (en) | 1979-02-28 | 1981-04-21 | Compagnie Generale De Radiologie | Apparatus for panoramic radiography |

| US4465959A (en) | 1981-07-21 | 1984-08-14 | Epson Corporation | Step motor drive control |

| US4602857A (en) | 1982-12-23 | 1986-07-29 | James H. Carmel | Panoramic motion picture camera and method |