WO2018030019A1 - 運転支援装置 - Google Patents

運転支援装置 Download PDFInfo

- Publication number

- WO2018030019A1 WO2018030019A1 PCT/JP2017/023741 JP2017023741W WO2018030019A1 WO 2018030019 A1 WO2018030019 A1 WO 2018030019A1 JP 2017023741 W JP2017023741 W JP 2017023741W WO 2018030019 A1 WO2018030019 A1 WO 2018030019A1

- Authority

- WO

- WIPO (PCT)

- Prior art keywords

- driver

- state

- driving

- control

- elements

- Prior art date

Links

Images

Classifications

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

- G08G1/16—Anti-collision systems

Definitions

- the present disclosure relates to a driving support device that performs support for bringing a driver into a state suitable for driving.

- the driver's state suitable for driving the vehicle is a calm state.

- a device that estimates a driver state and executes a service for bringing the driver state into a calm state when the driver state is not in a calm state or prompts the driver to rest has been considered.

- the vehicle is routed to a resting point such as a service area, or a display or voice is displayed to the driver.

- a notification that prompts a break is executed.

- the driver can continue driving by taking a break in the service area and the like so that drowsiness and fatigue are eliminated and the driving suitability state is obtained.

- the state unsuitable for driving includes various states other than the state of drowsiness and tiredness, and corresponds to these various unsuitable states of driving (for example, a state where tension or scorching has occurred). It is demanded. Even if a driver can be estimated to be inadequate driving, the degree of inadequate driving can vary from light to heavy (such as shallow or deep sleepiness, light tension or extreme tension). There is tension, etc.), and it is also requested to respond carefully according to the state. Further, even if a fine response is made to the driver, the driver gets used to the response, and there is a possibility that the state of the driver may not be improved.

- An object of the present disclosure is to provide a driving support device that can estimate a driver's state in detail, can cope with the estimated state in detail, and can prevent the driver from getting used to the response.

- a first aspect of the present disclosure is a driving support device that is mounted on a vehicle and supports a driver, and the driver's state is expressed by two of a sleepiness-hyperawake state evaluation axis and a comfort-discomfort state evaluation axis.

- An estimation unit that estimates about one axis, a five-sensory action unit that works by a plurality of factors that control a person against the five senses of the driver, and drive control of the five-sensory action unit based on estimation results for two axes of the driver state And a control unit that controls an element different from the previously controlled element among the plurality of elements.

- FIG. 1 is a functional block diagram of a driving assistance apparatus showing the first embodiment.

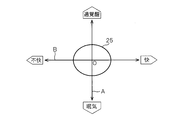

- FIG. 2 is a diagram for explaining a model for estimating the driver state in two axes.

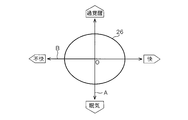

- FIG. 3 is a diagram for explaining Russell's emotional ring model.

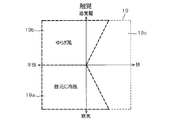

- FIG. 4 is a diagram for explaining a tactile element map for controlling a person.

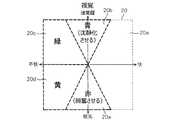

- FIG. 5 is a diagram for explaining a visual element map for controlling a person.

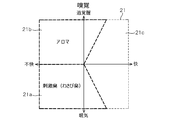

- FIG. 6 is a diagram for explaining an olfactory element map for controlling a person,

- FIG. 7 is a diagram for explaining a taste element map for controlling a person.

- FIG. 1 is a functional block diagram of a driving assistance apparatus showing the first embodiment.

- FIG. 2 is a diagram for explaining a model for estimating the driver state in two axes.

- FIG. 3 is a diagram for explaining Russell's emotional ring model.

- FIG. 4 is a diagram for explaining a tactile element map for controlling a person.

- FIG. 5 is a diagram

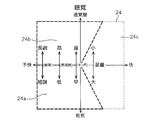

- FIG. 8 is a diagram (part 1) for explaining an auditory element map for controlling a person.

- FIG. 9 is a diagram (part 2) for explaining an auditory element map for controlling a person.

- FIG. 10 is a flowchart of the control for estimating the driver state and executing the HMI control.

- FIG. 11 is a diagram for explaining the distance from the origin of the driving suitability state to the position (P1, P2) where the driver state is estimated,

- FIG. 12 shows a second embodiment, and is a control flowchart for estimating the driver state and executing the HMI control.

- FIG. 13 shows the third embodiment and is a diagram (part 1) for explaining the region of the driving suitability state.

- FIG. 14 is a diagram (part 2) illustrating the region of the driving suitability state.

- the driving support device 1 is mounted on a vehicle (for example, an automobile), and includes a control unit 2 mainly composed of a microcomputer as shown in FIG.

- the control unit 2 includes a driver state estimation unit 3 that estimates a driver state, and an HMI (Human Machine) that performs various types of support (that is, actuation) for the driver in order to make the driver state suitable for driving. Interface) control unit 4.

- HMI Human Machine

- the controller 2 is connected with a camera image information acquisition unit 5, a vehicle information acquisition unit 6, and a biological information acquisition unit 7, and receives signals from them.

- various in-vehicle devices 8 mounted on the vehicle are connected to the control unit 2, and signals from these in-vehicle devices 8 are input.

- a manual operation input device 9 is connected to the control unit 2 and a manual operation signal from the manual operation input device 9 is input.

- the control unit 2 is connected to a communication device 10 that performs wireless communication with the outside, and the control unit 2 can communicate with the external server 11 via the communication device 10.

- the camera image information acquisition unit 5 includes a driver's seat camera that captures the driver's face and the like, and performs image recognition processing on the driver's face image captured by the driver's seat camera, thereby driving the driver's face direction, line of sight, and blinking. Etc., and is configured to transmit information of these detection results to the control unit 2.

- the vehicle information acquisition unit 6 includes a steering sensor, an accelerator sensor, a brake sensor, a clutch sensor, a vehicle speed sensor, a host vehicle position detection device, an inter-vehicle distance detection device, an in-vehicle camera that captures the front of the vehicle, a laser radar, and the like. Information of detection results by these in-vehicle sensors and in-vehicle detection devices is transmitted to the control unit 2.

- the biological information acquisition unit 7 includes various biological sensors such as a body temperature sensor, a heart rate sensor, a sweat sensor, and an electroencephalogram sensor, and information on detection results by these biological sensors (that is, various biological information of the driver, for example, body temperature information). , Heart rate information, sweat information, brain wave information, etc.) are transmitted to the control unit 2.

- various biological sensors such as a body temperature sensor, a heart rate sensor, a sweat sensor, and an electroencephalogram sensor, and information on detection results by these biological sensors (that is, various biological information of the driver, for example, body temperature information).

- Heart rate information, sweat information, brain wave information, etc. are transmitted to the control unit 2.

- the various in-vehicle devices 8 include a car navigation system, a car audio, an air conditioner, a power window, a light, a wiper, and the like, and are configured such that signals from these in-vehicle devices 8 are transmitted to the control unit 2.

- the manual operation input device 9 includes a touch panel provided on the display screen, various switches provided around the display, a remote control, and the like. When the driver operates the manual operation input device 9, the manual operation input device 9 is provided. The manual operation signal is transmitted to the control unit 2.

- control unit 2 is connected to a five-sensory action unit 12 that works on the five senses of the driver to make the driver's state suitable for driving.

- the five-sensory action unit 12 includes a tactile action part 13, a visual action part 14, an olfactory action part 15, a taste action part 16, and an auditory action part 17.

- the tactile action unit 13 includes a car air conditioner, a vibration device that adds vibration to the driver's seat, and the like, by blowing cool air or hot air on the driver's body, or by adding vibration to the driver's seat. Acts on the driver's tactile sensation.

- the visual action unit 14 includes a head-up display (HUD), a center information display (CID) arranged at the center of the instrument panel, various indicators, various displays (displays), etc. Information to be provided, warnings, and the like are displayed on the display device or the like as appropriate to affect the driver's vision.

- HUD head-up display

- CID center information display

- the olfactory action unit 15 includes a device that diffuses aroma (aroma), stimulating odor, and the like in the vehicle interior, and acts on the driver's olfaction by diffusing the aroma, stimulating odor, and the like into the vehicle.

- the taste action unit 16 includes a HUD, a CID, various displays, a sound output device, and the like, and acts on the driver's taste by performing display and sound output for recommending gum, beverages, food, and the like to the driver.

- the auditory action unit 17 includes an in-vehicle audio device, an audio output device, a buzzer, a speaker, and the like, and acts on the hearing of the driver by appropriately outputting music, audio information, warning sound, and the like to be provided to the driver from the speaker. To do.

- the control unit 2 mainly estimates the driver state based on the information from the various information acquisition units 5, 6, 7, etc. described above mainly by the software configuration, and the estimated driver state is the driving suitability state. If not, a process for driving the driver's state to the driving suitability state is executed by executing driving support for driving and controlling the five-sensory action unit 12. In this case, the driver state estimation process is executed by the driver state estimation unit 3, and the action process for changing the driver state to the driving suitability state is executed by the HMI control unit 4.

- the driver state estimation unit 3 uses, as state evaluation axes for estimating the driver's state, a state evaluation axis A for driver drowsiness-hyperwakening and a state evaluation axis B for driver comfort-discomfort.

- state evaluation axis A with the calm state as the origin (that is, the intersection of the two axes A and B), the evaluation is performed in, for example, five levels in the direction in which drowsiness becomes deeper, and 5 It is configured to evaluate in stages.

- the state evaluation axis B is configured so that, for example, five levels are evaluated in a direction in which comfort is deepened, and five levels are evaluated in a direction in which discomfort is deep, with the calm state being the origin.

- the driver state estimation unit 3 receives various information from the camera image information acquisition unit 5, the vehicle information acquisition unit 6, and the biological information acquisition unit 7, and based on the received various information, And the position P2 on the state evaluation axis B is estimated.

- the position P1 relatively accurately by appropriately using a well-known technique (for example, a technique such as a patent gazette) for the state evaluation axis A, that is, for estimating sleepiness-hyperwakening. It is.

- the position P1 as an estimation result is displayed on a display or the like, and the driver confirms the position P1, and the driver inputs a manual operation (that is, operates the manual operation input device 9). Is preferably configured to be changeable.

- the position P2 can be estimated relatively accurately by appropriately using a well-known technique (for example, a technique such as a patent publication) with respect to the state evaluation axis B, that is, estimation of comfort and discomfort. is there.

- a well-known technique for example, a technique such as a patent publication

- a threshold data group for determining pleasantness and discomfort in 10 stages is created.

- the position P2 as an estimation result is displayed on a display or the like so that the driver can confirm the position P2, and the driver can change the position P2 by manual operation input (that is, the manual operation input device 9). It is preferable to configure as described above.

- FIG. 3 is called Russell's emotional ring model.

- the HMI control unit 4 controls the five-sensing action unit 12 to drive the five senses of the driver, and the driver state, that is, the estimated positions (P1, P2) are shown in FIG. 3) Control to enter the region 18 in the above.

- the HMI control unit 4 generates an element map corresponding to FIG. 2 showing the driver state by two state evaluation axes A and B in advance for each of the five senses of the driver, that is, tactile sense, visual sense, smell sense, taste sense, and auditory sense. Created and stored in the memory in the control unit 2.

- the HMI control unit 4 then, based on each element map and the estimated position (P1, P2), the haptic action unit 13, the visual action part 14, the olfactory action part 15, the taste action part 16, and the auditory action part 17 Are controlled to be driven.

- the tactile element map 19 will be described with reference to FIG.

- the tactile action unit 13 in the sleepy and uncomfortable area 19a, the tactile action unit 13 is driven and, for example, a process of blowing cool air around the neck of the driver is executed.

- a process for driving the tactile action unit 13 to generate, for example, a breeze in the passenger compartment is executed.

- the area 19c other than the areas 19a and 19b, no process for acting on the sense of touch is executed.

- the visual action unit 14 is driven to display, for example, red on a HUD or a display.

- red is considered to have an action that excites humans.

- the visual action unit 14 is driven to execute a process of displaying, for example, blue on a HUD or a display device.

- blue has the effect

- the visual action unit 14 is driven to execute processing for displaying, for example, green on a HUD or a display device.

- green has the effect

- the visual action unit 14 is driven to execute processing for displaying, for example, yellow on a HUD or a display device.

- yellow has the effect

- no processing that works on the vision is executed in the area 20e other than the areas 20a, 20b, 20c, and 20d.

- the olfactory element map 21 will be described with reference to FIG.

- the olfactory action unit 15 is driven to execute, for example, a process of diffusing a stimulating odor (eg, wasabi odor) into the vehicle interior.

- a stimulating odor eg, wasabi odor

- a process of driving the olfactory action unit 15 to diffuse, for example, aroma into the passenger compartment is executed.

- the taste element map 22 will be described with reference to FIG.

- a message recommending that the taste action unit 16 is driven to eat for example, gum (for example, mint gum) is displayed on the display. Executes processing that outputs audio. If chewing gum such as mint gum is chewed, it works to awaken humans.

- a process for driving the taste action unit 16 to display a message recommending eating sweet chocolate on the display or outputting the voice is executed. Eating sweets works to calm humans.

- the region 22c other than the regions 22a and 22b, no process for acting on the sense of smell is executed.

- the auditory element map 23 will be described with reference to FIG.

- the auditory action unit 17 in the sleepy area 23a, the auditory action unit 17 is driven to play, for example, a marching song or rock music, or to play an interesting story. Execute. Also, in the region 23b with over-awakening, the auditory action unit 17 is driven to reproduce, for example, healing music, or to output or display a message recommending deep breathing. Further, in the region 23c where there is over-awakening and unpleasantness or sleepiness and unpleasantness, the auditory action unit 17 is driven and, for example, processing for reproducing Mozart music (ie, classical music) or the like is executed.

- element maps 19, 20, 21, 22, and 23 are examples, and one or more element maps can be created and used for tactile sensation, visual sense, smell sense, taste sense, and auditory sense, respectively. It is preferable to configure.

- an element map 24 shown in FIG. 9 is another element map of hearing.

- the auditory action unit 17 is driven to play, for example, music in a minor tone as a tune, having a low frequency and a fast tempo. Execute the process of increasing the volume and playing.

- the auditory action unit 17 is driven to play, for example, music in a major tone as a melody and having a high frequency and a slow tempo at a low volume. Execute.

- the area 24c other than the areas 24a and 24b, no process for acting on hearing is performed.

- step S ⁇ b> 10 of FIG. 10 the control unit 2 acquires camera image information, vehicle information, and biological information from the camera image information acquisition unit 5, the vehicle information acquisition unit 6, and the biological information acquisition unit 7.

- the driver state estimation unit 3 estimates the positions P1 and P2 on the two state evaluation axes A and B shown in FIGS. 2 and 3, and estimates the driver state (ie, emotion). In this case, it is preferable that the estimated positions P1 and P2 on the two state evaluation axes A and B are corrected (ie, self-reported) by manual operation of the driver as necessary. Then, the driver state estimation result, that is, the information on the positions (P1, P2) in FIGS. 2 and 3 is transmitted from the driver state estimation unit 3 to the HMI control unit 4 of the control unit 2.

- step S30 the HMI control unit 4 determines whether or not the position (P1, P2) where the driver state is estimated is within the driving suitability state region 18 in FIGS. .

- the process proceeds to "YES” and returns to step S10.

- step S30 when the estimated position (P1, P2) is not within the driving suitability region 18 (NO), the process proceeds to step S40.

- step S40 as shown in FIG. 11, the HMI control unit 4 moves from the origin of the driving suitability state (that is, the intersection of the two state evaluation axes A and B) O to the estimated position (P1, P2).

- the distance a is calculated and acquired.

- the process proceeds to step S50, and the HMI control unit 4 determines an element that acts on the driver.

- the HMI control unit 4 determines an element that acts on the driver.

- one of the five senses of the driver that is, the sense of touch, vision, smell, taste, and hearing may be selected at random, and control may be performed so as to act on the selected element.

- the selection order may be determined in advance. In this configuration, an element different from the previously controlled (ie, selected) element among the plurality of elements is selected.

- any two, three, or four of the five senses may be selected at random, and the selected two, three, or four elements may be controlled to operate. You may control to work on.

- a combination, order, or the like to be selected may be determined in advance. Also in this configuration, an element different from the previously controlled (ie, selected) element among the plurality of elements is selected.

- the element maps 19 to 24 corresponding to the determined elements are read from the memory.

- the estimated position (P1, P2) of the driver state shown in FIG. 11 falls within the driving suitability state region 18 for the selected element, that is, the position HMI control is performed so that the distance a between (P1, P2) and the origin O is eliminated.

- the selection order may be determined in advance.

- the selected positions (P1, P2) shown in FIG. 11 are selected so as to fall within the driving suitability region 18 for each of the selected elements.

- HMI control is preferably performed so that the distance a between the position (P1, P2) and the origin O is eliminated.

- the HMI control of a plurality of elements is executed substantially simultaneously, that is, with substantially parallel processing.

- the strength of the HMI control is configured to be substantially the same for the selected plurality of elements. That is, when the strength of HMI control for HMI control is set to “1” so that the distance “a” shown in FIG. 11 disappears, the strength of each HMI control is set to “1” for a plurality of selected elements. It was configured as follows. On the other hand, you may comprise so that the intensity

- the strength of HMI control corresponding to the distance a shown in FIG. 11 is set to “1” as described above

- the element C1 For example, the strength of the HMI control is set to “0.3”, the strength of the HMI control of the element C2 is set to “0.5”, for example, and the strength of the HMI control of the element C3 is set to “0.2”, for example. And set. Note that such setting of the strength of HMI control is an example, and can be changed as appropriate.

- one element when one element is selected and there are a plurality of element maps in the one element, one is selected from the plurality of element maps.

- one is selected from the plurality of element maps.

- a plurality of element maps may be selected, and the strength of HMI control when performing HMI control using the selected plurality of element maps may be changed for each of the plurality of element maps.

- the HMI control unit 4 includes an element map corresponding to the selected (ie, determined) element, estimated positions (P1, P2) on the two state evaluation axes A and B,

- the actuation method that is, the HMI control method

- the element is the tactile sense shown in FIG. 4 and the estimated position (P1, P2) is within the region 19a of the element map 19, an action of blowing cold air to the neck of the driver Decide how.

- the amount of cold air, the blowing time, etc. are determined based on the estimated position (P1, P2) or the setting value of the strength of HMI control.

- the other elements are similarly configured to determine the actuation method.

- the position (P1, P2) where the driver state is estimated is in a region where the control is not executed (for example, the region 19c in FIG. 4)

- the setting is made so that the HMI control is not executed.

- step S70 where the HMI control unit 4 executes HMI control (that is, support), specifically, the tactile action unit 13, the visual action unit 14, By driving and controlling the olfactory action unit 15, the taste action part 16, or the auditory action part 17, the driver's five senses, that is, touch, vision, smell, taste, and hearing are acted on. This improves the state of the driver.

- step S60 when it is set not to execute the HMI control, the process of step S70 is skipped (that is, the process of step S70 is not executed).

- step S10 camera image information, vehicle information, and biological information are acquired, and the processes of steps S20 to S70 are repeatedly executed.

- the state of the driver is estimated again, and the five senses of the driver, that is, the sense of touch, vision, smell, taste, and hearing are executed as necessary, that is, feedback control of HMI control is executed.

- It has a configuration.

- the HMI control strength is reduced to prevent the occurrence of overshoot of the HMI control as much as possible. It is preferable to control so as to.

- the driver state estimating unit 3 that estimates the driver state with respect to two axes of the sleepiness-hyperawake state evaluation axis A and the pleasant-unpleasant state evaluation axis B;

- the five senses acting part 12 that works with a plurality of elements that control a person and the five senses acting part 12 based on the estimation results of the two states of the driver state.

- an HMI control unit 4 that controls an element different from the previously controlled element.

- the HMI control unit 4 is configured to control elements different from the previously controlled elements when driving the five-sensory action unit 12, so that the driver performs HMI control (that is, improves the driver state). To get used to it).

- control part 4 is comprised so that the intensity

- control part 4 since the control part 4 is comprised so that two or more elements in the some element of the five sense effect

- the control unit 4 when the driver state is away from the driving suitability state, the control unit 4 increases the number of elements to be controlled or increases the strength of HMI control of the elements. Is configured to reduce the number of elements to be controlled or to reduce the strength of HMI control of the elements when it approaches the driving suitability state, it is possible to prevent the occurrence of overshoot of HMI control as much as possible. it can.

- the five sense action parts 12 are the tactile action part 13 which acts on a tactile sense, the visual action part 14 which acts on vision, the olfactory action part 15 which acts on olfaction, and the taste action which acts on taste. It comprised so that it might have the part 16 and the auditory effect part 17 which acts on hearing. According to this configuration, since it is possible to work on the five senses of the driver, the possibility that the state of the driver is suitable for driving increases.

- the HMI control unit 4 includes the element maps 19 to 24 for driving and controlling the five-sensory action unit 12 corresponding to the driver state estimation results regarding the two state evaluation axes A and B. Because it is configured, you can work with the five senses of the driver. Furthermore, since the element maps 19 to 24 are provided for each sense of touch, vision, smell, taste, and hearing, which are the five senses of the driver, it is possible to work more finely with the five senses of the driver.

- the driver state is estimated with respect to the two axes. Based on the current estimation result regarding the shaft, feedback control for driving and controlling the five-sensory action unit 12 is performed. According to this configuration, it is possible to work on the five senses of the driver while performing feedback control, so that the possibility of making the driver's state suitable for driving can be further increased.

- FIG. 12 shows a second embodiment.

- symbol is attached

- the tactile action part 13, the visual action part 14, the olfactory action part 15, the taste action part 16 or the auditory action part 17 are changed.

- the driver's five senses that is, the sense of touch, vision, smell, taste, and hearing, are acted on, and then a set time is awaited for the effect of the act to appear.

- step S70 the process proceeds to step S80, and the control unit 2 starts driving the five-sensory action unit 12, and then whether or not a set time (for example, 3 minutes, 5 minutes or 10 minutes) has elapsed. Determine whether. If the set time has not elapsed, the process proceeds to “NO” and waits for the set time to elapse.

- step S80 when the set time has elapsed (YES), the process returns to step S10 and the above-described processing is repeatedly executed.

- step S60 when the setting for not performing the HMI control is made, the process of step S70 may be skipped, and then the process of waiting for the set time of step S80 to be executed may be executed. Or you may comprise so that the process which waits for progress of the setting time of step S80 may also be skipped.

- the configuration of the second embodiment other than that described above is the same as the configuration of the first embodiment. Therefore, in the second embodiment, substantially the same operational effects as in the first embodiment can be obtained.

- the driver's five senses are waited for and the effect of the working is sufficiently exhibited. Can do. Thereby, it is possible to prevent the control of the five-sensory action unit 12 and the like from being performed excessively during the feedback control of the HMI control.

- (Third embodiment) 13 and 14 show a third embodiment.

- symbol is attached

- the driving suitability state is indicated by a region 18 in FIG. 2, and the size of the driving suitability state region 18 is fixedly determined in advance.

- the size of the driving suitability state area is changed according to the driving skill level of the driver, self-reporting, and the like.

- the size of the region 25 in the driving suitability state is relatively small, for example, the same size or smaller than the region 18.

- the size of the driving suitability state area 26 is set larger than the driving suitability state area 25 of the beginner driver, as shown in FIG.

- the HMI control is executed.

- the determination of whether the driver is a driving beginner or an expert is preferably made automatically based on camera image information, vehicle information, biometric information, and the like. Moreover, you may comprise so that a driver

- control unit 4 can change the size of the driving suitability state regions 25 and 26 on the plane indicating the state of the driver constituted by the two state evaluation axes A and B. Since it is configured, it is possible to adjust whether or not to execute the HMI control in accordance with the driving skill level of the driver.

- the said 3rd Embodiment although comprised so that two types of magnitude

Landscapes

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Traffic Control Systems (AREA)

Abstract

運転支援装置は、ドライバの状態を、眠気-過覚醒の状態評価軸と快-不快の状態評価軸との2つの軸に関して推定する推定部(3)と、ドライバの五感に対して、人を制御する複数の要素により働きかける五感作用部(12)と、ドライバの状態の2つの軸に関する推定結果に基づいて前記五感作用部(12)を駆動制御するものであり、前記複数の要素の中の前回制御した要素とは異なる要素を制御する制御部(4)とを備えたものである。

Description

本出願は、2016年8月8日に出願された日本出願番号2016-155651号に基づくもので、ここにその記載内容を援用する。

本開示は、ドライバの状態を運転に適した状態にするための支援を行なう運転支援装置に関する。

車両の運転に適したドライバの状態は、平静状態である。ドライバの状態を推定し、平静状態でない場合、ドライバの状態を平静状態にするためのサービスを実行したり、ドライバに休息を促したりする装置が考えられている。例えば特許文献1、2に記載された装置では、車両の長時間連続運転または長距離連続運転を検出したら、車両をサービスエリア等の休息可能地点まで経路誘導したり、ドライバに対して表示や音声等で休憩を促す報知を実行したりしている。これにより、ドライバはサービスエリア等で休憩をとることにより、眠気や疲れなどがなくなり、運転適性状態となることから、引き続き運転を続けることができる。

上記従来構成の装置においては、ドライバの運転不適性の状態のうち、眠気や疲れがでた状態(即ち、限定的な状態)にドライバがなったときだけ、対応することにより、眠気や疲れを解消するようにしている。しかし、運転に不適性の状態としては、眠気や疲れがでた状態以外に、種々様々な状態があり、これら種々様々の運転不適性状態(例えば緊張や焦りなどが発生した状態)に対応することが求められている。また、ドライバが運転不適性状態であると推定できたとしても、その運転不適性状態の程度は、軽いものから重いものまで、いろいろな状態(例えば、浅い眠気や深い眠気、軽い緊張や極度の緊張など)があり、その状態に応じてきめ細かく対応することも要請されている。また、ドライバに対してきめ細かい対応がなされたとしても、ドライバが対応に慣れてしまい、ドライバの状態が改善されないおそれもあった。

本開示の目的は、ドライバの状態をきめ細かく推定し、推定した状態に応じてきめ細かく対応することができ、また、ドライバが対応に慣れることを防止できる運転支援装置を提供することにある。

本開示の第一の態様は、車両に搭載され、ドライバに対する支援を行なう運転支援装置であって、ドライバの状態を、眠気-過覚醒の状態評価軸と快-不快の状態評価軸との2つの軸に関して推定する推定部と、ドライバの五感に対して、人を制御する複数の要素により働きかける五感作用部と、ドライバの状態の2つの軸に関する推定結果に基づいて前記五感作用部を駆動制御するものであり、前記複数の要素の中の前回制御した要素とは異なる要素を制御する制御部とを備えたものである。

本開示についての上記目的およびその他の目的、特徴や利点は、添付の図面を参照しながら下記の詳細な記述により、より明確になる。その図面は、

図1は、第1実施形態を示す運転支援装置の機能ブロック図であり、

図2は、ドライバの状態を2軸で推定するモデルを説明する図であり、

図3は、ラッセルの感情円環モデルを説明する図であり、

図4は、人を制御する触覚要素マップを説明する図であり、

図5は、人を制御する視覚要素マップを説明する図であり、

図6は、人を制御する嗅覚要素マップを説明する図であり、

図7は、人を制御する味覚要素マップを説明する図であり、

図8は、人を制御する聴覚要素マップを説明する図(その1)であり、

図9は、人を制御する聴覚要素マップを説明する図(その2)であり、

図10は、ドライバ状態推定しHMI制御を実行する制御のフローチャートであり、

図11は、運転適性状態の原点からドライバの状態を推定した位置(P1、P2)までの距離を説明する図であり、

図12は、第2実施形態を示すもので、ドライバ状態推定しHMI制御を実行する制御のフローチャートであり、

図13は、第3実施形態を示すもので、運転適性状態の領域を説明する図(その1)であり、

図14は、運転適性状態の領域を説明する図(その2)である。

(第1実施形態)

以下、第1実施形態について、図1ないし図10を参照して説明する。本実施形態の運転支援装置1は、車両(例えば自動車)に搭載されるものであり、図1に示すように、マイクロコンピュータを主体として構成された制御部2を備えている。この制御部2は、ドライバの状態を推定するドライバ状態推定部3と、ドライバの状態を運転適性状態にするためにドライバに対して種々の支援(即ち、アクチュエーション)を実行するHMI(Human Machine Interface)制御部4とを含んで構成されている。

以下、第1実施形態について、図1ないし図10を参照して説明する。本実施形態の運転支援装置1は、車両(例えば自動車)に搭載されるものであり、図1に示すように、マイクロコンピュータを主体として構成された制御部2を備えている。この制御部2は、ドライバの状態を推定するドライバ状態推定部3と、ドライバの状態を運転適性状態にするためにドライバに対して種々の支援(即ち、アクチュエーション)を実行するHMI(Human Machine Interface)制御部4とを含んで構成されている。

制御部2には、カメラ画像情報取得部5と、車両情報取得部6と、生体情報取得部7とが接続され、それらからの信号が入力される。また、制御部2には、車両に搭載された各種の車載機器8が接続され、それら車載機器8からの信号等が入力される。また、制御部2には、手操作入力装置9が接続され、手操作入力装置9からの手操作信号が入力される。また、制御部2には、外部との無線通信を行う通信装置10が接続され、制御部2は通信装置10を介して外部サーバ11と通信可能な構成となっている。

カメラ画像情報取得部5は、ドライバの顔などを撮影する運転席カメラを含んでおり、運転席カメラで撮影したドライバの顔の画像を画像認識処理することにより、ドライバの顔向き、視線、まばたき等を検出する機能を有し、これら検出結果の情報を制御部2へ送信するように構成されている。

車両情報取得部6は、ステアリングセンサ、アクセルセンサ、ブレーキセンサ、クラッチセンサ、車速センサ、自車位置検出装置、車間距離検出装置、車両の前方を撮影する車載カメラやレーザレーダなどを含んでおり、これら車載センサや車載検出装置等による検出結果の情報を制御部2へ送信するように構成されている。

生体情報取得部7は、体温センサ、心拍センサ、発汗センサ、脳波センサなどの各種の生体センサを含んでおり、これら生体センサによる検出結果の情報(即ち、ドライバの各種の生体情報、例えば体温情報、心拍数情報、発汗情報、脳波情報等)が制御部2へ送信されるように構成されている。

各種の車載機器8は、カーナビ、カーオーディオ、エアコン、パワーウインドウ、ライト、ワイパー等を含んでおり、これら車載機器8からの信号等が制御部2へ送信されるように構成されている。

手操作入力装置9は、ディスプレイの画面に設けられたタッチパネルやディスプレイの周囲に設けられた各種のスイッチやリモコン等を含んでおり、ドライバが手操作入力装置9を操作すると、手操作入力装置9から手操作信号が制御部2へ送信されるように構成されている。

また、制御部2には、ドライバの状態を運転適性状態にするためにドライバの五感に働きかける五感作用部12が接続されている。この五感作用部12は、触覚作用部13と、視覚作用部14と、嗅覚作用部15と、味覚作用部16と、聴覚作用部17とを備えている。

触覚作用部13は、カーエアコンや、ドライバの座席に振動を付加する振動装置等を含んでおり、ドライバの身体に冷風や温風を吹き付けたり、ドライバの座席に振動を付加したりすることにより、ドライバの触覚に作用する。視覚作用部14は、ヘッドアップディスプレイ(HUD)や、インストルメントパネルの中央部に配置されたセンターインフォメーションディスプレイ(CID)や、各種インジケータや、各種ディスプレイ(表示機)等を含んでおり、ドライバに提供すべき情報や警告等をそれら表示機等によって適宜表示することにより、ドライバの視覚に作用する。

嗅覚作用部15は、車室内にアロマ(芳香)や刺激臭等を拡散する装置を含んでおり、アロマや刺激臭等を車内に拡散することにより、ドライバの嗅覚に作用する。味覚作用部16は、HUDやCIDや各種表示機や音声出力装置等を含んでおり、ドライバにガムや飲料や食物等を薦める表示や音声出力を行なうことにより、ドライバの味覚に作用する。聴覚作用部17は、車載オーディオ装置や音声出力装置やブザーやスピーカ等を含んでおり、ドライバに提供すべき楽曲や音声情報や警告音等をスピーカから適宜出力することにより、ドライバの聴覚に作用する。

制御部2は、主としてそのソフトウエア的構成により、上記した種々の情報取得部5、6、7等からの情報等に基づいてドライバの状態を推定すると共に、推定したドライバの状態が運転適性状態でないときには、五感作用部12を駆動制御する運転支援を実行することにより、ドライバの状態を運転適性状態に変えるように働きかける処理が実行される。この場合、ドライバの状態の推定処理は、ドライバ状態推定部3によって実行され、ドライバの状態を運転適性状態に変える働きかけの処理は、HMI制御部4によって実行される。

ドライバ状態推定部3は、図2に示すように、ドライバの状態を推定する状態評価軸として、ドライバの眠気-過覚醒という状態評価軸Aと、ドライバの快-不快という状態評価軸Bとを備える、即ち、2つの軸A、Bを採用するように構成した。この場合、状態評価軸Aにおいては、平静状態を原点(即ち、2つの軸A、Bの交点)として、眠気が深くなる方向に例えば5段階で評価し、過覚醒が深くなる方向に例えば5段階で評価する構成となっている。そして、状態評価軸Bにおいては、平静状態を原点として、快が深くなる方向に例えば5段階で評価し、不快が深くなる方向に例えば5段階で評価する構成となっている。

ドライバ状態推定部3は、カメラ画像情報取得部5、車両情報取得部6及び生体情報取得部7からの種々の情報を受信し、受信した種々の情報に基づいて、状態評価軸A上のどこの位置P1にいるかを推定すると共に、状態評価軸B上のどこの位置P2にいるかを推定する。この場合、状態評価軸Aについて、即ち、眠気-過覚醒の推定は、周知の技術(例えば特許公報等の技術)を適宜用いて行うことにより、比較的正確に位置P1を推定することが可能である。尚、本実施形態では、推定結果である上記位置P1をディスプレイ等に表示して、ドライバに確認させると共に、ドライバに手操作入力(即ち、手操作入力装置9を操作)させることにより上記位置P1を変更可能なように構成することが好ましい。

また、状態評価軸Bについて、即ち、快、不快の推定についても、周知の技術(例えば特許公報等の技術)を適宜用いて行うことにより、比較的正確に位置P2を推定することが可能である。例えば、多数の被験者について、実際に車両を運転してもらい、快、不快を例えば5段階+5段階=10段階のレベルで申告してもらうと共に、そのときの、各情報取得部5、6、7からの種々の情報を申告レベルと対応させることにより、快、不快を10段階で判定するための閾値データ群を作成しておく。そして、運転中のドライバの各情報取得部5、6、7からの種々の情報を、上記閾値データ群と比較して、快、不快を10段階で推定するように構成しても良い。尚、本実施形態では、推定結果である上記位置P2をディスプレイ等に表示して、ドライバに確認させると共に、ドライバに手操作入力(即ち、手操作入力装置9)で上記位置P2を変更可能なように構成することが好ましい。

図3は、ラッセルの感情円環モデルと呼ばれるものであり、状態評価軸A、B上の位置P1、P2がわかると、図3に基づいて、そのときのドライバの感情がわかる。ここで、図2及び図3において、破線で囲む領域18が、ドライバの運転適性状態に対応する領域である。そこで、本実施形態では、HMI制御部4は、五感作用部12を駆動制御することにより、ドライバの五感に働きかけ、ドライバの状態、即ち、推定した位置(P1、P2)が図2(または図3)中の上記領域18内に入るように制御する。

この場合、HMI制御部4は、ドライバの状態を2つの状態評価軸A、Bで示す図2に対応する要素マップを、ドライバの五感、即ち、触覚、視覚、嗅覚、味覚、聴覚毎に予め作成して制御部2内のメモリに記憶しておく。そして、HMI制御部4は、各要素マップと上記推定した位置(P1、P2)とに基づいて、触覚作用部13、視覚作用部14、嗅覚作用部15、味覚作用部16、聴覚作用部17をそれぞれ駆動制御するように構成されている。

まず、触覚要素マップ19について、図4を参照して説明する。触覚要素マップ19において、図4に示すように、眠気有り且つ不快の領域19a内については、触覚作用部13を駆動して例えばドライバの首元に冷風を吹き付ける処理を実行する。この場合、眠気の程度が大きくなるほど、吹き付ける冷風の強さを強くするように、または、不快の程度が大きくなるほど、吹き付ける冷風の強さを強くするように制御することが好ましい。また、過覚醒有り且つ不快の領域19b内については、触覚作用部13を駆動して車室内に例えばゆらぎ風を発生させる処理を実行する。尚、上記領域19a、19b以外の領域19c内については、触覚に働きかける処理はなにも実行しない。

次に、視覚要素マップ20について、図5を参照して説明する。視覚要素マップ20において、図5に示すように、眠気有りの領域20a内については、視覚作用部14を駆動して例えば赤色をHUDや表示機等に表示する処理を実行する。尚、赤色は、人間を興奮させる作用を有すると考えられる。この場合、眠気の程度が大きくなるほど、赤色の濃度や輝度等を大きくするように制御することが好ましい。

また、過覚醒有りの領域20b内については、視覚作用部14を駆動して例えば青色をHUDや表示機等に表示する処理を実行する。尚、青色は、人間を鎮静化させる作用を有すると考えられる。この場合、過覚醒の程度が大きくなるほど、青色の濃度や輝度等を大きくするように制御することが好ましい。

また、過覚醒有り且つ不快の領域20c内については、視覚作用部14を駆動して例えば緑色をHUDや表示機等に表示する処理を実行する。尚、緑色は、人間を鎮静化させると共に気持ちを楽にする作用を有すると考えられる。この場合、過覚醒の程度が大きくなるほど、緑色の濃度や輝度等を大きくするように制御することが好ましい。

また、眠気有り且つ不快の領域20d内については、視覚作用部14を駆動して例えば黄色をHUDや表示機等に表示する処理を実行する。尚、黄色は、人間を興奮させると共に気持ちを楽にする作用を有すると考えられる。この場合、眠気の程度が大きくなるほど、黄色の濃度や輝度等を大きくするように制御することが好ましい。尚、上記領域20a、20b、20c、20d以外の領域20e内については、視覚に働きかける処理は何も実行しない。

次いで、嗅覚要素マップ21について、図6を参照して説明する。嗅覚要素マップ21において、図6に示すように、眠気有り且つ不快の領域21a内については、嗅覚作用部15を駆動して例えば刺激臭(例えばわさび臭)を車室内に拡散させる処理を実行する。この場合、眠気の程度が大きくなるほど、刺激臭の拡散量や濃度等を大きくするように、または、不快の程度が大きくなるほど、刺激臭の拡散量や濃度等を大きくするように制御することが好ましい。また、過覚醒有り且つ不快の領域21b内については、嗅覚作用部15を駆動して例えばアロマを車室内に拡散させる処理を実行する。この場合、過覚醒の程度が大きくなるほど、アロマの拡散量や濃度等を大きくするように、または、不快の程度が大きくなるほど、アロマの拡散量や濃度等を大きくするように制御することが好ましい。尚、上記領域21a、21b以外の領域21c内については、嗅覚に働きかける処理はなにも実行しない。

また、味覚要素マップ22について、図7を参照して説明する。味覚要素マップ22において、図7に示すように、眠気有り且つ不快の領域22a内については、味覚作用部16を駆動して例えばガム(例えばミントガム)を食べるように薦めるメッセージをディスプレイに表示したり音声で出力したりする処理を実行する。ミントガム等の刺激性のガムを噛むと、人間を覚醒させる作用がはたらく。また、過覚醒有り且つ不快の領域22b内については、味覚作用部16を駆動して甘いチョコレートを食べるように薦めるメッセージをディスプレイに表示したり音声で出力したりする処理を実行する。甘いものを食べると、人間を落ち着かせる作用がはたらく。尚、上記領域22a、22b以外の領域22c内については、嗅覚に働きかける処理はなにも実行しない。

また、聴覚要素マップ23について、図8を参照して説明する。聴覚要素マップ23において、図8に示すように、眠気有りの領域23a内については、聴覚作用部17を駆動して例えば行進曲やロック音楽等を再生したり、面白い話を再生したりする処理を実行する。また、過覚醒有りの領域23b内については、聴覚作用部17を駆動して例えばヒーリング音楽等を再生したり、深呼吸を薦めるメッセージを音声で出力したり表示したりする処理を実行する。また、過覚醒有り且つ不快または眠気且つ不快の領域23c内については、聴覚作用部17を駆動して例えばモーツアルト音楽(即ち、クラシック音楽)等を再生する処理を実行する。

尚、上記した要素マップ19、20、21、22、23は、各一例であり、触覚、視覚、嗅覚、味覚及び聴覚について、それぞれ、各1つ以上の要素マップを作成して利用可能なように構成することが好ましい。

例えば、聴覚の他の要素マップとして、図9に示す要素マップ24を作成することが好ましい。この要素マップ24において、図9に示すように、眠気有り且つ不快の領域24a内については、聴覚作用部17を駆動して例えば曲調として短調の音楽であって周波数が低く且つテンポが早い音楽を、音量を大にして再生する処理を実行する。また、過覚醒有り且つ不快の領域24b内については、聴覚作用部17を駆動して例えば曲調として長調の音楽であって周波数が高く且つテンポが遅い音楽を、音量を小にして再生する処理を実行する。尚、上記領域24a、24b以外の領域24c内については、聴覚に働きかける処理は何も実行しない。

次に、上記構成の動作について、図10のフローチャートを参照して説明する。尚、図10のフローチャートは、制御部2の制御の内容を示す。まず、図10のステップS10においては、制御部2は、カメラ画像情報取得部5、車両情報取得部6及び生体情報取得部7からカメラ画像情報、車両情報及び生体情報を取得する。

続いて、ステップS20へ進み、制御部2のドライバ状態推定部3は、上記取得した各種の情報に基づいてドライバの状態を推定する。この場合、ドライバ状態推定部3は、図2及び図3に示す2つの状態評価軸A、B上の位置P1、P2を推定し、ドライバの状態(即ち、感情)を推定する。この場合、2つの状態評価軸A、B上の推定した位置P1、P2について、必要に応じてドライバが手操作することにより修正させる(即ち、自己申告させる)ように構成することが好ましい。そして、ドライバの状態の推定結果、即ち、図2及び図3における位置(P1、P2)の情報を、ドライバ状態推定部3から制御部2のHMI制御部4へ送信しておく。

この後、ステップS30へ進み、HMI制御部4は、図2及び図3において、ドライバの状態を推定した位置(P1、P2)が運転適性状態の領域18内に入っているか否かを判断する。ここで、推定した位置(P1、P2)が運転適性状態の領域18内に入っているときには、HMI制御をする必要がないことから、「YES」へ進み、ステップS10へ戻る。

また、上記ステップS30において、推定した位置(P1、P2)が運転適性状態の領域18内に入っていないときには(NO)、ステップS40へ進む。このステップS40では、HMI制御部4は、図11に示すように、運転適性状態の原点(即ち、2つの状態評価軸A、Bの交点)Oから上記推定した位置(P1、P2)までの距離aを算出して取得する。

続いて、ステップS50へ進み、HMI制御部4は、ドライバに働きかける要素を決定する。この場合、ドライバの五感、即ち、触覚、視覚、嗅覚、味覚、聴覚の要素の中から例えばランダムに1つを選択し、選択した1つの要素に働きかけるように制御しても良い。尚、1つの要素をランダムに選択する代わりに、選択する順番を予め決めておくように構成しても良い。この構成の場合、複数の要素の中の前回制御(即ち、選択)された要素とは異なる要素が選択される構成となっている。

また、上記五感の中から例えばいずれか2つ、3つまたは4つをランダムに選択し、選択した2つ、3つまたは4つの要素に働きかけるように制御しても良いし、五感すべての要素に働きかけるように制御しても良い。尚、2つ、3つまたは4つの要素をランダムに選択する代わりに、選択する組み合わせや順番等を予め決めておくように構成しても良い。この構成の場合も、複数の要素の中の前回制御(即ち、選択)された要素とは異なる要素が選択される構成となっている。そして、働きかける要素を決定したら、決定した要素に対応する要素マップ19~24をメモリから読み出しておく。

ここで、1つの要素を選択した場合には、選択した要素について、図11に示すドライバの状態の推定した位置(P1、P2)が運転適性状態の領域18内に入るように、即ち、位置(P1、P2)と原点Oとの距離aがなくなるように、HMI制御する。尚、選択した1つの要素に、複数の要素マップが存在する場合には、それら複数の要素マップの中から1つを例えばランダムに選択するように構成することが好ましい。尚、1つの要素マップをランダムに選択する代わりに、選択する順番を予め決めておくように構成しても良い。

また、複数の要素を選択する場合には、選択した複数の要素について、それぞれ、図11に示す推定した位置(P1、P2)が運転適性状態の領域18内に入るように、即ち、選択した複数の要素のそれぞれについて、位置(P1、P2)と原点Oとの距離aがなくなるように、HMI制御することが好ましい。この場合、複数の要素のHMI制御は、ほぼ同時に、即ち、ほぼ平行処理して実行することが好ましい。尚、複数の要素のHMI制御をシーケンシャルに実行するように構成しても良い。

複数の要素のHMI制御を実行する場合、選択した複数の要素について、HMI制御の強さはほぼ同じになるように構成した。即ち、図11に示す距離aがなくなるようにHMI制御するHMI制御の強さを「1」と設定した場合、選択した複数の要素について、各HMI制御の強さを、すべて「1」となるように構成した。これに対して、HMI制御の強さを、複数の要素毎に変えるように構成しても良い。

例えば、要素C1、C2、C3という3つの要素が選択された場合において、上記したように図11に示す距離aに対応するHMI制御の強さを「1」と設定したときに、要素C1のHMI制御の強さを例えば「0.3」と設定し、要素C2のHMI制御の強さを例えば「0.5」と設定し、要素C3のHMI制御の強さを例えば「0.2」と設定する。尚、このようなHMI制御の強さの設定は、一例であり、適宜変更可能である。

また、前述したように、1つの要素が選択された場合において、その1つの要素に複数の要素マップが存在する場合には、それら複数の要素マップの中から1つを選択するように構成したが、これに限られるものではない。例えば、複数の要素マップを選択すると共に、選択した複数の要素マップを用いてHMI制御する際のHMI制御の強さを、複数の要素マップ毎に変えるように構成しても良い。

この後、ステップS60へ進み、HMI制御部4は、上記選択(即ち、決定)した要素に対応する要素マップと、2つの状態評価軸A、B上の推定した位置(P1、P2)と、HMI制御の強さを変える場合には、HMI制御の強さの設定値とに基づいて、アクチュエーション方法(即ち、HMI制御方法)を決定する。この場合、例えば、要素が図4に示す触覚であったときに、推定した位置(P1、P2)が要素マップ19の領域19a内に入っていたときには、ドライバの首元に冷風を吹き付けるアクチュエーション方法を決定する。尚、冷風の風量や送風時間等は、推定した位置(P1、P2)、または、HMI制御の強さの設定値に基づいて決定する。他の要素についても、同様にしてアクチュエーション方法を決定するように構成されている。一方、ドライバの状態を推定した位置(P1、P2)が制御を実行しない領域(例えば図4の領域19c)に入っている場合には、HMI制御を実行しない設定とする。

次いで、ステップS70へ進み、HMI制御部4は、HMI制御(即ち、支援)を実行する、具体的には、上記ステップS60で決定したアクチュエーション方法で、触覚作用部13、視覚作用部14、嗅覚作用部15、味覚作用部16または聴覚作用部17を駆動制御することにより、ドライバの五感、即ち、触覚、視覚、嗅覚、味覚、聴覚に働きかける。これにより、ドライバの状態が改善される。尚、上記ステップS60において、HMI制御を実行しない設定がなされているときには、ステップS70の処理を飛ばす(即ち、ステップS70の処理を実行しない)。

この後は、ステップS10へ戻り、カメラ画像情報、車両情報及び生体情報が取得され、ステップS20~ステップS70の処理が繰り返し実行される。これにより、再び、ドライバの状態が推定され、必要に応じてドライバの五感、即ち、触覚、視覚、嗅覚、味覚、聴覚への働きかけが実行される、即ち、HMI制御のフィードバック制御が実行される構成となっている。また、上記フィードバック制御時において、ドライバの状態が運転適性状態に近づいたことを検知(即ち、推定)したときには、HMI制御の強さを弱くすることにより、HMI制御のオーバーシュートの発生を極力防止するように制御することが好ましい。換言すると、ドライバの状態が、運転適性状態から離れているとき(即ち、前記距離aが長いとき)には、制御する要素の個数を増やしたり、要素のHMI制御の強さを強くしたりすることにより、ドライバの状態が素早く運転適性状態に戻るように制御する。そして、ドライバの状態が運転適性状態に近づいたら、制御する要素の個数を減らしたり、要素のHMI制御の強さを弱くしたりすることにより、オーバーシュートの発生を極力防止するように構成されている。

このような構成の本実施形態においては、ドライバの状態を、眠気-過覚醒の状態評価軸Aと快-不快の状態評価軸Bとの2つの軸に関して推定するドライバ状態推定部3と、ドライバの五感に対して、人を制御する複数の要素により働きかける五感作用部12と、ドライバの状態の2つの軸に関する推定結果に基づいて五感作用部12を駆動制御するものであって前記複数の要素の中の前回制御した要素とは異なる要素を制御するHMI制御部4とを備えるように構成した。この構成によれば、ドライバの状態を、眠気-過覚醒の状態評価軸Aと快-不快の状態評価軸Bとの2つの軸に関して推定し、推定結果に基づいて五感作用部12を駆動制御するので、ドライバの状態をきめ細かく推定することができ、推定した状態に応じてきめ細かく対応することができる。そして、HMI制御部4は、五感作用部12を駆動制御する際に、前回制御した要素とは異なる要素を制御するように構成されているので、ドライバがHMI制御(即ち、ドライバの状態を改善するための対応)に慣れることを防止できる。

また、上記実施形態では、制御部4は、五感作用部12の複数の要素の制御の強さを各別に設定可能なように構成されているので、ドライバの状態を運転適性状態に素早く且つきめ細かく改善することができる。

また、上記実施形態では、制御部4は、五感作用部12の複数の要素の中の2以上の要素を平行して制御することが可能なように構成されているので、ドライバの状態を運転適性状態に素早く改善することができる。

また、上記実施形態では、制御部4は、ドライバの状態が運転適性状態から離れているときには、制御する要素の個数を増やしたり、要素のHMI制御の強さを強くしたりし、ドライバの状態が運転適性状態に近づいたら、制御する要素の個数を減らしたり、要素のHMI制御の強さを弱くしたりするように構成されているので、HMI制御のオーバーシュートの発生を極力防止することができる。

また、上記実施形態においては、五感作用部12は、触覚に作用する触覚作用部13と、視覚に作用する視覚作用部14と、嗅覚に作用する嗅覚作用部15と、味覚に作用する味覚作用部16と、聴覚に作用する聴覚作用部17とを有するように構成した。この構成によれば、ドライバの五感に働きかけることができるから、ドライバの状態を運転に適した状態にする可能性が高くなる。

また、上記実施形態では、HMI制御部4は、2つの状態評価軸A、Bに関するドライバの状態推定結果に対応して五感作用部12を駆動制御するための要素マップ19~24を備えるように構成したので、ドライバの五感にきめ細かく働きかけることができる。更に、要素マップ19~24は、ドライバの五感である触覚、視覚、嗅覚、味覚、聴覚毎に設けられているので、ドライバの五感により一層きめ細かく働きかけることができる。

また、上記実施形態では、ドライバの状態の2つの軸に関する推定結果に基づいて五感作用部12を駆動制御した後、ドライバの状態を前記2つの軸に関して推定し、更に、ドライバの状態の2つの軸に関する今回の推定結果に基づいて五感作用部12を駆動制御するフィードバック制御を実行するように構成した。この構成によれば、フィードバック制御しながらドライバの五感に働きかけることができるから、ドライバの状態を運転に適した状態にする可能性をより一層高くすることができる。

(第2実施形態)

図12は、第2実施形態を示すものである。尚、第1実施形態と同一構成には、同一符号を付している。第2実施形態では、ステップS70のHMI制御の実施後、即ち、決定されたアクチュエーション方法で、触覚作用部13、視覚作用部14、嗅覚作用部15、味覚作用部16または聴覚作用部17を駆動制御することにより、ドライバの五感、即ち、触覚、視覚、嗅覚、味覚、聴覚に働きかけた後、その働きかけによる効果が現れるのを設定時間待つように構成した。

図12は、第2実施形態を示すものである。尚、第1実施形態と同一構成には、同一符号を付している。第2実施形態では、ステップS70のHMI制御の実施後、即ち、決定されたアクチュエーション方法で、触覚作用部13、視覚作用部14、嗅覚作用部15、味覚作用部16または聴覚作用部17を駆動制御することにより、ドライバの五感、即ち、触覚、視覚、嗅覚、味覚、聴覚に働きかけた後、その働きかけによる効果が現れるのを設定時間待つように構成した。

具体的には、ステップS70の実行後、ステップS80へ進み、制御部2は、五感作用部12を駆動開始した後、設定時間(例えば3分、5分または10分等)が経過したか否かを判断する。ここで、設定時間が経過していないときには、「NO」へ進み、設定時間が経過するのを待つ。また、上記ステップS80において、設定時間が経過したときには(YES)、ステップS10へ戻り、前述した処理を繰り返し実行するように構成されている。尚、前記ステップS60において、HMI制御を実行しない設定がなされた場合は、ステップS70の処理を飛ばした後、ステップS80の設定時間の経過を待つ処理を実行するように構成しても良いし、または、ステップS80の設定時間の経過を待つ処理も飛ばすように構成しても良い。

上述した以外の第2実施形態の構成は、第1実施形態の構成と同じ構成となっている。従って、第2実施形態においても、第1実施形態とほぼ同じ作用効果を得ることができる。特に、第2実施形態によれば、五感作用部12を駆動開始した後、設定時間が経過することを待つことにより、ドライバの五感に働きかけた後、その働きかけによる効果が十分現れることを待つことができる。これにより、前記HMI制御のフィードバック制御時に、五感作用部12等の制御が過敏に実行されることを防止できる。

(第3実施形態)

図13及び図14は、第3実施形態を示すものである。尚、第1実施形態と同一構成には、同一符号を付している。第1実施形態では、運転適性状態を図2において領域18で示しており、運転適性状態の領域18の大きさは、予め固定的に決められていた。これに対して、第3実施形態では、運転適性状態の領域の大きさを、ドライバの運転の熟練度や自己申告等に応じて変更するように構成した。

図13及び図14は、第3実施形態を示すものである。尚、第1実施形態と同一構成には、同一符号を付している。第1実施形態では、運転適性状態を図2において領域18で示しており、運転適性状態の領域18の大きさは、予め固定的に決められていた。これに対して、第3実施形態では、運転適性状態の領域の大きさを、ドライバの運転の熟練度や自己申告等に応じて変更するように構成した。

具体的には、ドライバが運転の初心者である場合には、図13に示すように、運転適性状態の領域25の大きさを比較的小さく例えば前記領域18と同程度またはそれ以下の大きさに設定する。そして、ドライバが運転の熟練者である場合には、図14に示すように、運転適性状態の領域26の大きさを、初心者のドライバの運転適性状態の領域25よりも大きく設定する。

そして、ドライバの状態を推定した推定位置(p1、p2)が、上記領域25、26内に入っているときには、HMI制御を実行しないように構成され、上記推定位置(p1、p2)が、上記領域25、26の外に位置しているときには、HMI制御を実行するように構成されている。尚、ドライバが運転の初心者であるか熟練者であるかの判断は、カメラ画像情報、車両情報及び生体情報等に基づいて自動的に判断するように構成することが好ましい。また、ドライバの運転の熟練度をドライバ自身に自己申告させるように構成しても良い。

上述した以外の第3実施形態の構成は、第1実施形態の構成と同じ構成となっている。従って、第3実施形態においても、第1実施形態とほぼ同じ作用効果を得ることができる。特に、第3実施形態では、制御部4は、2つの状態評価軸A、Bによって構成されたドライバの状態を示す平面において、運転適性状態の領域25、26の大きさを変更可能なように構成されているので、ドライバの運転の熟練度等に応じてHMI制御を実行するか否かを調整することができる。

また、上記第3実施形態では、運転適性状態の領域25、26の大きさとして、2種類の大きさを設けるように構成したが、これに限られるものではなく、3種類以上の大きさを設けるように構成しても良い。また、運転適性状態の領域の大きさを、ドライバの手動操作によって変更可能なように構成しても良い。また、HMI制御のフィードバック制御時の学習に基づいて運転適性状態の領域の大きさを自動的に変更するように構成しても良い。

本開示は、実施例に準拠して記述されたが、本開示は当該実施例や構造に限定されるものではないと理解される。本開示は、様々な変形例や均等範囲内の変形をも包含する。加えて、様々な組み合わせや形態、さらには、それらに一要素のみ、それ以上、あるいはそれ以下、を含む他の組み合わせや形態をも、本開示の範疇や思想範囲に入るものである。

Claims (6)

- 車両に搭載され、ドライバに対する支援を行なう運転支援装置(1)であって、

ドライバの状態を、眠気-過覚醒の状態評価軸と快-不快の状態評価軸との2つの軸に関して推定する推定部(3)と、

ドライバの五感に対して、人を制御する複数の要素により働きかける五感作用部(12)と、

ドライバの状態の2つの軸に関する推定結果に基づいて前記五感作用部(12)を駆動制御するものであり、前記複数の要素の中の前回制御した要素とは異なる要素を制御する制御部(4)と、

を備えた運転支援装置。 - 前記制御部(4)は、前記五感作用部(12)の複数の要素の制御の強さを各別に設定可能なように構成されている請求項1記載の運転支援装置。

- 前記制御部(4)は、前記五感作用部(12)の複数の要素の中の2以上の要素を平行して制御することが可能なように構成されている請求項1または2記載の運転支援装置。

- 前記制御部(4)は、ドライバの状態が運転適性状態から離れているときには、制御する要素の個数を増やしたり、要素のHMI制御の強さを強くしたりし、ドライバの状態が運転適性状態に近づいたら、制御する要素の個数を減らしたり、要素のHMI制御の強さを弱くしたりするように構成されている請求項1から3のいずれか一項記載の運転支援装置。

- 前記制御部(4)は、前記2つの状態評価軸によって構成されたドライバの状態を示す平面において、運転適性状態の領域の大きさを変更可能なように構成されている請求項1から4のいずれか一項記載の運転支援装置。

- 前記五感作用部(12)は、触覚に作用する触覚作用部(13)と、視覚に作用する視覚作用部(14)と、嗅覚に作用する嗅覚作用部(15)と、味覚に作用する味覚作用部(16)と、聴覚に作用する聴覚作用部(17)とを有する請求項1から5のいずれか一項記載の運転支援装置。

Applications Claiming Priority (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2016-155651 | 2016-08-08 | ||

| JP2016155651A JP6668999B2 (ja) | 2016-08-08 | 2016-08-08 | 運転支援装置 |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| WO2018030019A1 true WO2018030019A1 (ja) | 2018-02-15 |

Family

ID=61162123

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| PCT/JP2017/023741 WO2018030019A1 (ja) | 2016-08-08 | 2017-06-28 | 運転支援装置 |

Country Status (2)

| Country | Link |

|---|---|

| JP (1) | JP6668999B2 (ja) |

| WO (1) | WO2018030019A1 (ja) |

Families Citing this family (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR102574937B1 (ko) * | 2018-05-18 | 2023-09-05 | 현대자동차주식회사 | 차량 및 그 제어 방법 |

| US11826147B2 (en) | 2019-02-04 | 2023-11-28 | Nec Corporation | Arousal level control apparatus, arousal level control method, and recording medium |

| EP3922291A4 (en) | 2019-02-04 | 2022-10-05 | NEC Corporation | Degree of wakefulness control device, degree of wakefulness control method and recording medium |

| JP2021012409A (ja) * | 2019-07-03 | 2021-02-04 | 株式会社デンソー | 車載システム |

Citations (7)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH0991569A (ja) * | 1995-09-25 | 1997-04-04 | Mitsubishi Electric Corp | 覚醒低下警報装置 |

| JP2007133692A (ja) * | 2005-11-10 | 2007-05-31 | Toyota Motor Corp | 運転行動評価装置 |

| JP2009208727A (ja) * | 2008-03-06 | 2009-09-17 | Denso Corp | 自動車用ユーザーもてなしシステム |

| JP2011039601A (ja) * | 2009-08-06 | 2011-02-24 | Nissan Motor Co Ltd | 覚醒度調整装置及び方法 |

| WO2011125166A1 (ja) * | 2010-04-05 | 2011-10-13 | トヨタ自動車株式会社 | 生体状態判定装置 |

| WO2013175594A1 (ja) * | 2012-05-23 | 2013-11-28 | トヨタ自動車株式会社 | ドライバ状態判定装置及びドライバ状態判定方法 |

| JP2015110411A (ja) * | 2011-02-18 | 2015-06-18 | 本田技研工業株式会社 | 運転者の挙動に応答するシステムおよび方法 |

Family Cites Families (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2007271378A (ja) * | 2006-03-30 | 2007-10-18 | Denso Corp | 車載ナビゲーション装置 |

| JP6661264B2 (ja) * | 2014-09-24 | 2020-03-11 | 矢崎エナジーシステム株式会社 | 警報装置 |

-

2016

- 2016-08-08 JP JP2016155651A patent/JP6668999B2/ja not_active Expired - Fee Related

-

2017

- 2017-06-28 WO PCT/JP2017/023741 patent/WO2018030019A1/ja active Application Filing

Patent Citations (7)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH0991569A (ja) * | 1995-09-25 | 1997-04-04 | Mitsubishi Electric Corp | 覚醒低下警報装置 |

| JP2007133692A (ja) * | 2005-11-10 | 2007-05-31 | Toyota Motor Corp | 運転行動評価装置 |

| JP2009208727A (ja) * | 2008-03-06 | 2009-09-17 | Denso Corp | 自動車用ユーザーもてなしシステム |

| JP2011039601A (ja) * | 2009-08-06 | 2011-02-24 | Nissan Motor Co Ltd | 覚醒度調整装置及び方法 |

| WO2011125166A1 (ja) * | 2010-04-05 | 2011-10-13 | トヨタ自動車株式会社 | 生体状態判定装置 |

| JP2015110411A (ja) * | 2011-02-18 | 2015-06-18 | 本田技研工業株式会社 | 運転者の挙動に応答するシステムおよび方法 |

| WO2013175594A1 (ja) * | 2012-05-23 | 2013-11-28 | トヨタ自動車株式会社 | ドライバ状態判定装置及びドライバ状態判定方法 |

Also Published As

| Publication number | Publication date |

|---|---|

| JP2018025870A (ja) | 2018-02-15 |

| JP6668999B2 (ja) | 2020-03-18 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP5842857B2 (ja) | 覚醒度改善装置 | |

| WO2018030019A1 (ja) | 運転支援装置 | |

| US9266018B2 (en) | Customizable in-vehicle gaming system | |

| JP6555647B2 (ja) | 車両運転支援システム及び車両運転支援方法 | |

| JP6776681B2 (ja) | ドライバ状態判定装置、及びドライバ状態判定プログラム | |

| US20200073478A1 (en) | Vehicle and control method thereof | |

| WO2018030018A1 (ja) | 運転支援装置 | |

| JP2018189720A (ja) | 情報出力制御装置、情報出力制御方法、情報出力システム、およびプログラム | |

| JP2018167773A (ja) | 車両運転支援システム | |

| JP2011118831A (ja) | 覚醒支援装置 | |

| JP2020052482A (ja) | 危険運転防止装置 | |

| KR20230002180A (ko) | 운전자의 주의 환기 장치 및 그 방법 | |

| JP2020020987A (ja) | 車内システム | |

| JP2004110546A (ja) | 表示装置、音響装置、およびアクチュエータ制御装置 | |

| JP6579043B2 (ja) | 車両用運転支援システム | |

| JP7540319B2 (ja) | 覚醒装置 | |

| JP6428748B2 (ja) | 運転支援システム | |

| WO2017187986A1 (ja) | 車載機器制御装置 | |

| KR20220159646A (ko) | 진동 발생 장치 및 그를 가지는 차량 | |

| JP2019008427A (ja) | 覚醒維持装置 | |

| JP2021171539A (ja) | 乗員感情伝達装置 | |

| CN111783550B (zh) | 驾驶人情绪的监控调节方法及系统 | |

| JP2018013812A (ja) | ドライバ状態誘導装置、及びドライバ状態誘導プログラム | |

| JP2008230280A (ja) | 車載制御装置 | |

| JP2021099562A (ja) | 制御装置およびプログラム |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| 121 | Ep: the epo has been informed by wipo that ep was designated in this application |

Ref document number: 17839093 Country of ref document: EP Kind code of ref document: A1 |

|

| NENP | Non-entry into the national phase |

Ref country code: DE |

|

| 122 | Ep: pct application non-entry in european phase |

Ref document number: 17839093 Country of ref document: EP Kind code of ref document: A1 |