JP2012076216A - ロボット制御システムのカメラ座標系とロボット座標系の結合方法、画像処理装置、プログラム、及び記憶媒体 - Google Patents

ロボット制御システムのカメラ座標系とロボット座標系の結合方法、画像処理装置、プログラム、及び記憶媒体 Download PDFInfo

- Publication number

- JP2012076216A JP2012076216A JP2011184953A JP2011184953A JP2012076216A JP 2012076216 A JP2012076216 A JP 2012076216A JP 2011184953 A JP2011184953 A JP 2011184953A JP 2011184953 A JP2011184953 A JP 2011184953A JP 2012076216 A JP2012076216 A JP 2012076216A

- Authority

- JP

- Japan

- Prior art keywords

- coordinate system

- robot

- axis

- camera

- coordinate

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Granted

Links

- 238000012545 processing Methods 0.000 title claims abstract description 41

- 238000000034 method Methods 0.000 title claims abstract description 34

- 238000005259 measurement Methods 0.000 claims description 74

- 238000004364 calculation method Methods 0.000 claims description 40

- 238000003384 imaging method Methods 0.000 claims description 20

- 239000013598 vector Substances 0.000 claims description 20

- 238000010168 coupling process Methods 0.000 claims description 5

- 241000406668 Loxodonta cyclotis Species 0.000 claims 1

- 230000000007 visual effect Effects 0.000 description 36

- 238000000465 moulding Methods 0.000 description 26

- 239000011521 glass Substances 0.000 description 15

- 238000005286 illumination Methods 0.000 description 14

- 230000000295 complement effect Effects 0.000 description 13

- 230000006870 function Effects 0.000 description 12

- 102220542357 Endogenous retrovirus group K member 113 Pro protein_S20A_mutation Human genes 0.000 description 7

- 230000000694 effects Effects 0.000 description 7

- 239000000919 ceramic Substances 0.000 description 6

- 238000004891 communication Methods 0.000 description 6

- 239000005357 flat glass Substances 0.000 description 5

- 230000008569 process Effects 0.000 description 5

- 102220057255 rs730881172 Human genes 0.000 description 5

- 239000012780 transparent material Substances 0.000 description 5

- 102220498043 Junction plakoglobin_S28A_mutation Human genes 0.000 description 4

- 238000010586 diagram Methods 0.000 description 4

- 230000014509 gene expression Effects 0.000 description 4

- 102220498048 Junction plakoglobin_S24A_mutation Human genes 0.000 description 3

- 230000008878 coupling Effects 0.000 description 3

- 238000005859 coupling reaction Methods 0.000 description 3

- 238000013461 design Methods 0.000 description 3

- 238000001514 detection method Methods 0.000 description 3

- 239000000284 extract Substances 0.000 description 3

- 229920003002 synthetic resin Polymers 0.000 description 3

- 239000000057 synthetic resin Substances 0.000 description 3

- 238000006243 chemical reaction Methods 0.000 description 2

- 238000009792 diffusion process Methods 0.000 description 2

- NJPPVKZQTLUDBO-UHFFFAOYSA-N novaluron Chemical compound C1=C(Cl)C(OC(F)(F)C(OC(F)(F)F)F)=CC=C1NC(=O)NC(=O)C1=C(F)C=CC=C1F NJPPVKZQTLUDBO-UHFFFAOYSA-N 0.000 description 2

- 229920003217 poly(methylsilsesquioxane) Polymers 0.000 description 2

- 229920005989 resin Polymers 0.000 description 2

- 239000011347 resin Substances 0.000 description 2

- 230000032258 transport Effects 0.000 description 2

- NAWXUBYGYWOOIX-SFHVURJKSA-N (2s)-2-[[4-[2-(2,4-diaminoquinazolin-6-yl)ethyl]benzoyl]amino]-4-methylidenepentanedioic acid Chemical compound C1=CC2=NC(N)=NC(N)=C2C=C1CCC1=CC=C(C(=O)N[C@@H](CC(=C)C(O)=O)C(O)=O)C=C1 NAWXUBYGYWOOIX-SFHVURJKSA-N 0.000 description 1

- 238000004458 analytical method Methods 0.000 description 1

- 230000008901 benefit Effects 0.000 description 1

- 230000008859 change Effects 0.000 description 1

- 239000003086 colorant Substances 0.000 description 1

- 239000002131 composite material Substances 0.000 description 1

- 230000001276 controlling effect Effects 0.000 description 1

- 238000007796 conventional method Methods 0.000 description 1

- 238000005516 engineering process Methods 0.000 description 1

- 230000001771 impaired effect Effects 0.000 description 1

- 239000004973 liquid crystal related substance Substances 0.000 description 1

- 230000005389 magnetism Effects 0.000 description 1

- 238000004519 manufacturing process Methods 0.000 description 1

- 239000000463 material Substances 0.000 description 1

- 238000012986 modification Methods 0.000 description 1

- 230000004048 modification Effects 0.000 description 1

- 230000002093 peripheral effect Effects 0.000 description 1

- 230000001105 regulatory effect Effects 0.000 description 1

- 102220070930 rs794728599 Human genes 0.000 description 1

- 239000004065 semiconductor Substances 0.000 description 1

- 238000005507 spraying Methods 0.000 description 1

- 238000012546 transfer Methods 0.000 description 1

Images

Landscapes

- Manipulator (AREA)

Abstract

ハンドリングロボットに認識対象治具を把持する際に正確に把持させる必要が無く、認識対象治具を把持させた状態で、回転及び直線移動させたときの連続画像からハンドツールのツール軸中心と、ロボット座標系とカメラ座標系の傾きを簡単に得ることができるカメラ座標系とロボット座標系の結合を得る方法、画像処理装置を提供する。

【解決手段】

ロボットのハンドツールに保持された認識対象治具の回転動画像からフレーム差分を得て、該フレーム差分に基づく認識対象治具の特徴部位に関する複数の特徴点が含まれる円弧軌跡からカメラ座標系のツール軸中心の位置を算出する。ロボット座標系のX軸に平行に直線移動させた際の認識対象治具の直線移動動画像からフレーム差分を得て、該フレーム差分に基づく認識対象治具の特徴点の直線軌跡からカメラ座標系に対するロボット座標系の傾きを算出する。

【選択図】図4

Description

特許文献1では、ロボットアームの先端に視覚センサが取り付けられており、ロボットのハンドにて、治具を正確に把持した状態で、異なる2点にそれぞれ治具を置いた時の各点におけるロボット座標値を取得する等の作業を行うようにして、取得した座標値等により、カメラ座標系とロボット座標系との関係を得るようにしている(従来技術2)。

従来技術3の実施例3では、ハンドリングロボットで把持した認識対象物を、移動する毎に教示作業が必要であり、手間が掛かる問題がある。

請求項5の発明は、ハンドツールをロボット先端のツール軸の周りで回転させて、前記ハンドツールが保持する認識対象治具の動画像(以下、回転動画像という)を固定カメラから取得し、前記回転動画像から得られたフレーム差分に基づいて前記認識対象治具の特徴部位が描いた軌跡から閉曲線を割り出し、前記閉曲線の中心点をカメラ座標系で算出する第1算出手段と、ロボット座標系の座標軸であって、前記ツール軸と直交するロボット座標系を構成する2つの座標軸のうち少なくとも一方の座標軸(以下、傾き計測座標軸という)に対して、沿うように前記認識対象治具を保持したハンドツールを直線移動させて、前記認識対象治具の動画像(以下、直線移動動画像という)を前記固定カメラで取得し、前記直線移動動画像に基づいて、カメラ座標系に対する前記傾き計測座標軸の傾き指標パラメータを算出する第2算出手段と、前記閉曲線の中心点と前記傾き指標パラメータに基づいてカメラ座標系とロボット座標系の相対位置関係を算出する第3算出手段を備えることを特徴とする画像処理装置を要旨としている。

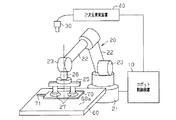

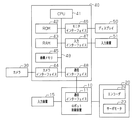

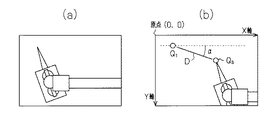

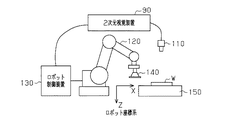

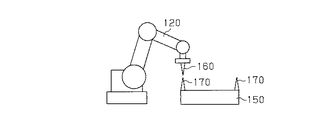

以下、本発明のカメラ座標系とロボット座標系の結合方法、画像処理装置、プログラム、並びに記憶媒体を具体化した第1実施形態を図1〜図7を参照して説明する。図1は、本実施形態のロボット制御システムの全体の概略を示している。ロボット制御システムはロボット制御装置10及びハンドリングロボット(以下、単にロボットという)20、固定カメラとしてのカメラ30及び画像処理装置としての2次元視覚装置40を備えている。本実施形態のロボット制御システムは、パレット等のワーク台60上の図示しないワークに対する物体位置認識によって一つのワークの位置及び姿勢を認識し、ワーク台60上のワークを保持し、目標位置に運搬するためのシステムである。

次に、本実施形態のロボット制御システムにおいて、カメラ30のカメラ座標系とロボット20のロボット座標系を結合する手順について説明する。

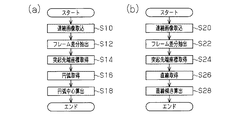

図4(a)において、S10〜S18は、CPU41が、カメラ座標系とロボット座標系の結合のための画像処理プログラムを実行する際、ロボットのハンドツール25の中心座標の求め方のフローチャートである。

この作動制御は、オペレータが入力装置15に対する入力操作により、手動制御されてもよく、或いは、カメラ座標系とロボット座標系の結合のための画像処理プログラムを実行する際に、ロボット制御装置10のROMに格納された自動制御プログラムに基づいて自動制御で行うようにしてもよい。

<2.ロボット座標系の傾き>

図4(b)において、S20〜S28は、CPU41が、カメラ座標系とロボット座標系の結合のための画像処理プログラムを実行する際、ロボット座標系のカメラ座標系に対する傾きの求め方のフローチャートである。

この作動制御は、オペレータが入力装置15に対する入力操作により、手動制御されてもよく、或いは、カメラ座標系とロボット座標系の結合のための画像処理プログラムを実行する際に、ロボット制御装置10のROMに格納された自動制御プログラムに基づいて自動制御で行うようにしてもよい。

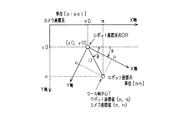

S24では、CPU41は、前記フレーム差分結果である画像データ(以下、フレーム差分画像という)中において、認識対象治具70の特徴部位に関する複数の特徴点Q1〜Qsのカメラ座標系の座標値を取得する。この特徴点の座標値の取得は、フレーム差分画像を予め定められた閾値で2値化処理等の公知の画像処理を行い、特徴点Q1〜Qsを割り出して行う。

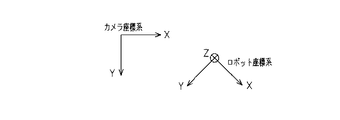

S28では、CPU41は、この得られた直線Dは、ロボット座標系のX軸に平行な直線であるため、この直線Dとカメラ座標系のX軸との傾きαを算出し、RAM43に記憶する。なお、カメラ座標系のX軸は、図6(b)に示す水平方向画素数(640画素)、垂直方向画素数(480画素)からなる画像データにおいて、左上角を原点とした水平方向の軸である。又、カメラ座標系のY軸は、前記原点から下方へ垂直方向に延びる軸である。

<3.カメラ座標系とロボット座標系の相対位置関係の算出>.

上記のようにS18及びS28で取得されたツール軸26のカメラ座標系の円弧の中心の座標値(m,n)と、ロボット座標系のX軸とカメラ座標系のX軸の傾きαに基づいて、CPU41は、カメラ座標系とロボット座標の相対位置関係の算出を行う。この算出は、第3ステップに相当する。

ロボット座標の原点OR(x0,y0)とツール軸の中心(円弧の中心)Tを結ぶ線分のカメラ座標系X軸との角度をθとすると、下記式(1)で求めることができる。なお、ツール軸26の中心Tのロボット座標値(p,q)は、CPU41は通信によりロボット制御装置10から取得し、RAM43に格納されている。

線分OR−Tのロボット座標系での長さUは、

√(p2+q2) [mm]

である。

U= √(p2+q2)× 1/μ [pixel] ……(2)

である。ここで、μは距離係数である。

y0=n−√(p2+q2)× 1/μ ×sinθ ……(4)

このため、CPU41は、式(3)、式(4)を使用して、ロボット座標の原点ORのカメラ座標値(x0,y0)を算出する。θの算出は式(1)を使用する。

以後、カメラ座標系とロボット座標系の相対位置関係が得られているため、実作業を行う際に、2次元視覚装置40からロボット制御装置10へこの相対位置関係が反映された正しい指示を出すことが可能となる。

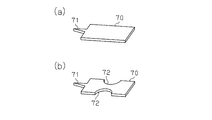

(1) 本実施形態のロボット制御システムのカメラ座標系とロボット座標系の結合方法は、第1ステップでは、ハンドツール25をロボット先端のツール軸26の周りで回転させて、ハンドツール25が保持する認識対象治具70の回転動画像をカメラ30(固定カメラ)で取得し、前記回転動画像から得られたフレーム差分に基づいて認識対象治具70の突起71(特徴部位)が描いた軌跡から円弧(すなわち、閉曲線)を割り出し、前記円弧曲線の中心点をカメラ座標系で算出する。

又、認識対象治具70を回転させるツール軸26の位置のロボット座標系の座標値を予めロボット制御装置のプログラムにセットして固定化するとともに、ロボット座標系のX軸に沿って移動するようにプログラムを組み込みすることにより、全ての演算が自動化できるため、オペレータは、画像処理装置(本実施形態では、2次元視覚装置40)を作動させながらロボットを決められた通りに動かすだけでよい。

(7) 本実施形態の記憶媒体としてのROM42は、コンピュータが読み取り可能であって、上記(6)に記載の画像処理プログラムを記憶する。

次に、第2実施形態を図8、図9を参照して説明する。なお、第2実施形態のロボット制御システムのハード構成は、第1実施形態と同一構成であるため、同一構成については、同一符号を付してその説明を省略する。

第1実施形態では、ロボット座標系のXY座標平面と、カメラ座標系のXY座標平面とが互いに平行であるとともに、カメラ30から見たロボット座標系のX軸及びY軸が直交している場合に有効としている。それに対して、第2実施形態では、ロボット座標系のXY座標平面と、カメラ座標系のXY座標平面とが互いに平行ではないとともに、実機(ロボット)上において、ハンドツール25をロボット座標系のX軸及びY軸に沿ってそれぞれ移動させたときの軌跡が直交していない場合に有効である。なお、ここで前記両軌跡が直交しない理由は、ロボットを構成しているアームの連結構成に機械誤差があるためである。

本実施形態のロボット制御システムにおいて、カメラ30のカメラ座標系とロボット20のロボット座標系を結合する手順について説明する。

図8(a)は、CPU41が、カメラ座標系とロボット座標系の結合のための画像処理プログラムを実行する際、ロボットのハンドツール25の中心座標の求め方のフローチャートである。同フローチャートにおいて、S10〜S14は、第1実施形態と同様であるため、説明を省略するが、なお、S10では、第1実施形態で記述したようにツール軸26は、前記制御により、ロボット座標系のX座標値及びY座標値(p,q)で回転する。

S10〜S18Aは、第1ステップに相当する。

図8(b)において、S20A〜S28Aは、CPU41が、カメラ座標系とロボット座標系の結合のための画像処理プログラムを実行する際、ロボット座標系のカメラ座標系に対する傾きの求め方のフローチャートである。

この作動制御は、オペレータが入力装置15に対する入力操作により、手動制御されてもよく、或いは、カメラ座標系とロボット座標系の結合のための画像処理プログラムを実行する際に、ロボット制御装置10のROMに格納された自動制御プログラムに基づいて自動制御で行うようにしてもよい。

S22Aでは、CPU41は、軸(X軸及びY軸)毎に、時系列順に生成されたフレーム画像において、時間的に隣接するフレーム画像間のフレーム差分を抽出する。

S20A〜S24Aは、第2ステップに相当する。

<3.カメラ座標系とロボット座標系の相対位置関係の算出>.

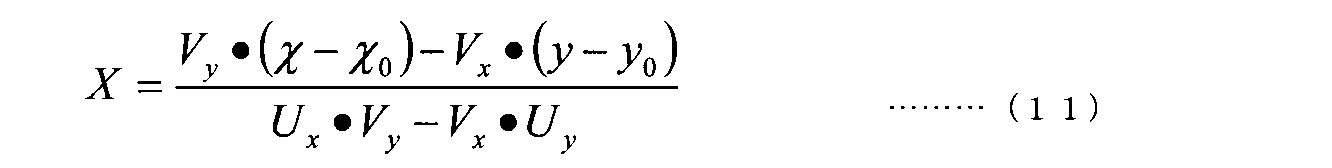

上記のようにS18Aで取得されたツール軸26のカメラ座標系の楕円弧の中心の座標値(m,n)と、S24Aで取得された始点及び終点の座標値に基づいた2つのベクトルに基づいて、CPU41は、カメラ座標系とロボット座標の相対位置関係の算出を、S28Aで行う。この算出は、第3ステップに相当する。

具体的には、直線距離L(mm)移動したときの、X軸に沿った始点、終点を、

Us(x1,y1)、Ue(x2,y2)

とし、Y軸に沿った始点、終点を、

Vs(x3,y3)、Ve(x4,y4)

とする。

次に、CPU41は、カメラ座標値からロボット座標値への変換式を求める。すなわち、カメラ座標系とロボット座標の相対位置関係の算出を行う。

以後、カメラ座標系とロボット座標系の相対位置関係が得られているため、実作業を行う際に、2次元視覚装置40からロボット制御装置10へこの相対位置関係が反映された正しい指示を出すことが可能となる。

(1) ロボット制御システムのカメラ座標系とロボット座標系の結合方法は、第1ステップでは、ハンドツール25をロボット先端のツール軸26の周りで回転させて、ハンドツール25が保持する認識対象治具70の回転動画像をカメラ30(固定カメラ)で取得し、前記回転動画像から得られたフレーム差分に基づいて認識対象治具70の突起71(特徴部位)の楕円弧(すなわち、閉曲線)を割り出し、前記楕円弧の中心点をカメラ座標系で算出する。

第2実施形態の2次元視覚装置40では、認識対象治具70を回転させるツール軸26の位置のロボット座標系の座標値を予めロボット制御装置のプログラムにセットして固定化するとともに、ロボット座標系のX軸、及びY軸に沿って移動するようにプログラムを組み込みすることにより、全ての演算が自動化できるため、オペレータは、画像処理装置(本実施形態では、2次元視覚装置40)を作動させながらロボットを決められた通りに動かすだけでよい。

(4) 本実施形態の記憶媒体としてのROM42は、コンピュータが読み取り可能であって、第2実施形態の(3)に記載の画像処理プログラムを記憶する。

次に、参考例を図10〜図14を参照して説明する。参考例は下記の問題を解消するためのものである。

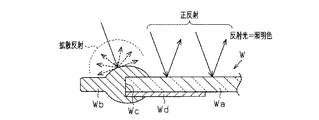

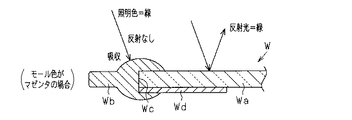

又、本実施形態では、発光体102は、モールWbの表面色に対して補色関係にある色を発光するように設けられている。

さて、上記のように構成された2次元視覚装置40の作用を説明する。

前記説明した条件下で照明装置100によりワークWを照明すると、図12に示すように、カメラ視野内において、本体Waでは正反射し、モールWbでは拡散反射する。ここで、正反射した反射光の色は、光源色に支配されて、本体Waは光源色で撮像素子32により撮像される。一方、モールWbは、拡散反射するため、その反射光はモールWbの表面色に支配される。

2次元視覚装置40は、カメラ30により、取得した画像に対して公知の画像処理を行い、カメラ視野に入った、光源色で撮像された領域(本体Waの領域、すなわち、明るい部分)と、黒色で撮像された領域(モールWbの領域、すなわち、暗い部分)との境界線を抽出する。この境界線の抽出により、該境界線で規定される本体Waの外形形状が得られる。

・ なお、前記参考例では、本体Waの全周部にモールWbを配置したが、モールの配置は全周部に限定するものではない。全周部にモールWbを配置していない場合、ワークWが載置されるワーク台の載置面とモールWbが配置されていない本体Waの部分との境界線(外形線)が識別できるように、前記載置面は拡散反射する面とすることが好ましい。

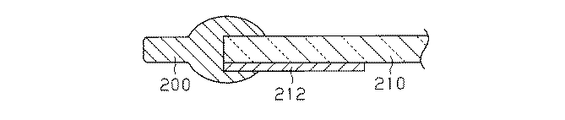

・ 前記各実施形態では、ロボットのハンドツール25は、真空吸着パッド付きのハンド装置としたが、機械式チャック装置に代えても良い。この場合、例えば、機械式チャック装置が互いに対向する指部材で、ワークを把持可能である場合、図2(b)に示すように、認識対象治具70の形状は、長手方向に延びる互いに反対側に位置する両側部に凹部72を設けるものとする。なお、凹部72の形状は、限定するものではない。この変形例の認識対象治具においても、特徴的部位としての端部には、突起71が設けられている。

・ 第2実施形態では、S10〜S18Aを実行した後に、S20A〜S28Aを実行したが、S20A〜S28Aを実行後、S10〜S18Aを実行してもよい。

技術的思想(1)は、光源色を、拡散反射部材の表面色の補色関係の色とすることにより、画像処理手段が取得する画像において、拡散反射部材が撮像された画像領域は黒色となり、正反射光が得られた画像領域は白色となる。このため、ワークにおける本体と拡散反射部材間における境界の形状認識は、前記境界以外の拡散反射部材の変形の影響を受けず精度良く行うことができる。

光を拡散する拡散板を有するとともに、前記拡散反射部材の表面色と補色関係の色を投射して前記拡散板により面光源として前記ワークに対して照明する照明手段と、

前記照明手段から投射されて前記ワークの本体の表面で正反射した正反射光、及び前記拡散反射部材で拡散反射した拡散反射光を、前記カメラで取得して得られた画像中の前記正反射光の光源色と前記拡散反射光による拡散反射部材の表面色の違いに基づいて前記本体及び拡散反射部材の形状認識を行う画像処理手段を備えることを特徴とするワーク形状認識装置。

光を拡散する拡散板を有するとともに、白色光を投射して前記拡散板により面光源として前記ワークに対して照明する照明手段と、

前記照明手段から投射されて前記ワークの本体の表面で正反射した正反射光、及び前記拡散反射部材で拡散反射した拡散反射光を、前記カメラで取得して得られた画像中の前記正反射光の光源色と前記拡散反射光による拡散反射部材の表面色の違いに基づいて前記本体及び拡散反射部材の形状認識を行う画像処理手段を備えることを特徴とするワーク形状認識装置。

26…ツール軸、30…カメラ(固定カメラ)、

40…2次元視覚装置(画像処理装置)、

41…CPU(第1算出手段、第2算出手段、第3算出手段)、

42…ROM(記憶媒体)、70…認識対象治具、71…突起(特徴部位)。

Claims (9)

- ロボットの先端にツール軸を介して設けられたハンドツールと、前記ハンドツールの作業を撮像する固定カメラを備えたロボット制御システムのカメラ座標系とロボット座標系の結合方法において、ハンドツールをロボット先端のツール軸の周りで回転させて、前記ハンドツールが保持する認識対象治具の動画像(以下、回転動画像という)を固定カメラで取得し、前記回転動画像から得られたフレーム差分に基づいて前記認識対象治具の特徴部位が描いた軌跡から閉曲線を割り出し、前記閉曲線の中心点をカメラ座標系で算出する第1ステップと、ロボット座標系の座標軸であって、前記ツール軸が交差可能な座標平面を構成する2つの座標軸のうち少なくとも一方の座標軸(以下、傾き計測座標軸という)に対して、沿うように前記認識対象治具を保持したハンドツールを直線移動させて、前記認識対象治具の動画像(以下、直線移動動画像という)を前記固定カメラで取得し、前記直線移動動画像に基づいて、カメラ座標系に対する前記傾き計測座標軸の傾き指標パラメータを算出する第2ステップと、前記閉曲線の中心点と前記傾き指標パラメータに基づいてカメラ座標系とロボット座標系の相対位置関係を算出する第3ステップを備えることを特徴とするロボット制御システムのカメラ座標系とロボット座標系の結合方法。

- 前記閉曲線が楕円であり、

第2ステップでは、ロボット座標系の2つの座標軸を傾き計測座標軸とし、

前記傾き指標パラメータは、前記2つの傾き計測座標軸に沿って、ハンドツールをそれぞれ移動させた際の、カメラ座標系での始点及び終点の座標値に基づいたベクトルであることを特徴とする請求項1に記載のロボット制御システムのカメラ座標系とロボット座標系の結合方法。 - 前記閉曲線が円であり、

第2ステップでは、ロボット座標系の1つの座標軸を傾き計測座標軸とし、

前記傾き指標パラメータは、前記1つの傾き計測座標軸に沿って、ハンドツールをそれぞれ移動させた際の、直線軌跡と傾き計測座標軸との角度であることを特徴とする請求項1に記載のロボット制御システムのカメラ座標系とロボット座標系の結合方法。 - 前記認識対象治具の特徴部位が、前記認識対象治具の一端に設けられた突起であることを特徴とする請求項1乃至請求項3のうちいずれか1項に記載のロボット制御システムのカメラ座標系とロボット座標系の結合方法。

- ハンドツールをロボット先端のツール軸の周りで回転させて、前記ハンドツールが保持する認識対象治具の動画像(以下、回転動画像という)を固定カメラから取得し、前記回転動画像から得られたフレーム差分に基づいて前記認識対象治具の特徴部位が描いた軌跡から閉曲線を割り出し、前記閉曲線の中心点をカメラ座標系で算出する第1算出手段と、

ロボット座標系の座標軸であって、前記ツール軸と直交するロボット座標系を構成する2つの座標軸のうち少なくとも一方の座標軸(以下、傾き計測座標軸という)に対して、沿うように前記認識対象治具を保持したハンドツールを直線移動させて、前記認識対象治具の動画像(以下、直線移動動画像という)を前記固定カメラで取得し、前記直線移動動画像に基づいて、カメラ座標系に対する前記傾き計測座標軸の傾き指標パラメータを算出する第2算出手段と、

前記閉曲線の中心点と前記傾き指標パラメータに基づいてカメラ座標系とロボット座標系の相対位置関係を算出する第3算出手段を備えることを特徴とする画像処理装置。 - 前記閉曲線が楕円であり、

第2算出手段は、ロボット座標系の2つの座標軸を傾き計測座標軸とし、前記傾き指標パラメータとして、前記2つの傾き計測座標軸に沿って、ハンドツールをそれぞれ移動させた際の、カメラ座標系での始点及び終点の座標値に基づくベクトルを算出することを特徴とする請求項5に記載の画像処理装置。 - 前記閉曲線が円であり、

第2算出手段は、ロボット座標系の1つの座標軸を傾き計測座標軸とし、

前記傾き指標パラメータとして、前記1つの傾き計測座標軸に沿って、ハンドツールをそれぞれ移動させた際の、直線軌跡と傾き計測座標軸との角度を算出することを特徴とする請求項5に記載の画像処理装置。 - コンピュータを、

ハンドツールをロボット先端のツール軸の周りで回転させて、前記ハンドツールが保持する認識対象治具の動画像(以下、回転動画像という)を固定カメラから取得し、前記回転動画像から得られたフレーム差分に基づいて前記認識対象治具の特徴部位が描いた軌跡から閉曲線を割り出し、前記閉曲線の中心点をカメラ座標系で算出する第1算出手段と、

ロボット座標系の座標軸であって、前記ツール軸が交差可能な座標平面を構成する2つの座標軸のうち少なくとも一方の座標軸(以下、傾き計測座標軸という)に対して、沿うように前記認識対象治具を保持したハンドツールを直線移動させて、前記認識対象治具の動画像(以下、直線移動動画像という)を前記固定カメラで取得し、前記直線移動動画像に基づいて、カメラ座標系に対する前記傾き計測座標軸の傾き指標パラメータを算出する第2算出手段と、

前記閉曲線の中心点と前記傾き指標パラメータに基づいてカメラ座標系とロボット座標系の相対位置関係を算出する第3算出手段

として機能させるためのプログラム。 - コンピュータを、

ハンドツールをロボット先端のツール軸の周りで回転させて、前記ハンドツールが保持する認識対象治具の動画像(以下、回転動画像という)を固定カメラから取得し、前記回転動画像から得られたフレーム差分に基づいて前記認識対象治具の特徴部位が描いた軌跡から閉曲線を割り出し、前記閉曲線の中心点をカメラ座標系で算出する第1算出手段と、

ロボット座標系の座標軸であって、前記ツール軸が交差可能な座標平面を構成する2つの座標軸のうち少なくとも一方の座標軸(以下、傾き計測座標軸という)に対して、沿うように前記認識対象治具を保持したハンドツールを直線移動させて、前記認識対象治具の動画像(以下、直線移動動画像という)を前記固定カメラで取得し、前記直線移動動画像に基づいて、カメラ座標系に対する前記傾き計測座標軸の傾き指標パラメータを算出する第2算出手段と、

前記閉曲線の中心点と前記傾き指標パラメータに基づいてカメラ座標系とロボット座標系の相対位置関係を算出する第3算出手段として機能させるためのプログラムを記憶したコンピュータ読み取り可能な記憶媒体。

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2011184953A JP5729219B2 (ja) | 2010-09-06 | 2011-08-26 | ロボット制御システムのカメラ座標系とロボット座標系の結合方法、画像処理装置、プログラム、及び記憶媒体 |

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2010199006 | 2010-09-06 | ||

| JP2010199006 | 2010-09-06 | ||

| JP2011184953A JP5729219B2 (ja) | 2010-09-06 | 2011-08-26 | ロボット制御システムのカメラ座標系とロボット座標系の結合方法、画像処理装置、プログラム、及び記憶媒体 |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2012076216A true JP2012076216A (ja) | 2012-04-19 |

| JP5729219B2 JP5729219B2 (ja) | 2015-06-03 |

Family

ID=46237043

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2011184953A Expired - Fee Related JP5729219B2 (ja) | 2010-09-06 | 2011-08-26 | ロボット制御システムのカメラ座標系とロボット座標系の結合方法、画像処理装置、プログラム、及び記憶媒体 |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP5729219B2 (ja) |

Cited By (14)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2014180720A (ja) * | 2013-03-19 | 2014-09-29 | Yaskawa Electric Corp | ロボットシステム及びキャリブレーション方法 |

| WO2015079740A1 (ja) * | 2013-11-28 | 2015-06-04 | 三菱電機株式会社 | ロボットシステムおよびロボットシステムの制御方法 |

| JP2019119005A (ja) * | 2018-01-05 | 2019-07-22 | 株式会社Fdkエンジニアリング | 部品組付装置の較正方法 |

| CN111015664A (zh) * | 2019-12-26 | 2020-04-17 | 重庆盟讯电子科技有限公司 | 一种基于ccd相机的智能化识别方法 |

| CN112775961A (zh) * | 2019-11-06 | 2021-05-11 | 发那科株式会社 | 控制装置、控制装置的控制方法以及控制系统 |

| CN114043528A (zh) * | 2021-11-25 | 2022-02-15 | 成都飞机工业(集团)有限责任公司 | 一种机器人定位性能测试方法、系统、设备及介质 |

| CN114227691A (zh) * | 2021-12-30 | 2022-03-25 | 中铭谷智能机器人(广东)有限公司 | 一种汽车钣金机器人智能喷漆轨迹安全检测方法 |

| CN114545862A (zh) * | 2022-02-25 | 2022-05-27 | 浪潮电子信息产业股份有限公司 | 一种夹具作业点位确定方法、装置、设备及存储介质 |

| CN114800533A (zh) * | 2022-06-28 | 2022-07-29 | 诺伯特智能装备(山东)有限公司 | 一种用于工业机器人的分拣控制方法及系统 |

| CN114904798A (zh) * | 2022-05-16 | 2022-08-16 | 上海方酋机器人有限公司 | 一种基于图像识别的煤矸石自动分拣方法、系统及介质 |

| CN115250616A (zh) * | 2020-03-31 | 2022-10-28 | 美蓓亚三美株式会社 | 校正系统、信息处理系统、机器人控制系统、校正方法、信息处理方法、机器人控制方法、校正程序、信息处理程序、校正装置、信息处理装置以及机器人控制装置 |

| CN115657531A (zh) * | 2022-10-18 | 2023-01-31 | 兰州大学 | 一种确定盆景抓取位姿并泊停机器人的系统及方法 |

| CN107702653B (zh) * | 2017-11-13 | 2023-06-06 | 易思维(天津)科技有限公司 | 一种机器人涂胶三维信息视觉检测装置及方法 |

| CN117641882A (zh) * | 2024-01-25 | 2024-03-01 | 合肥安迅精密技术有限公司 | 基于机器视觉的贴装误差实时校正方法及系统 |

Families Citing this family (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN107972026B (zh) * | 2016-10-25 | 2021-05-04 | 河北亿超机械制造股份有限公司 | 机器人、机械臂及其控制方法和装置 |

| CN107363823A (zh) * | 2017-06-21 | 2017-11-21 | 深圳市恒科通机器人有限公司 | 机械臂的坐标标定方法 |

Citations (8)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPS6472208A (en) * | 1987-09-11 | 1989-03-17 | Aisin Seiki | Conversion system between robot coordinate and visual coordinate |

| JPH06190756A (ja) * | 1992-12-25 | 1994-07-12 | Mitsubishi Electric Corp | 視覚センサ付きロボットの座標系の設定方法 |

| JPH07227784A (ja) * | 1994-02-15 | 1995-08-29 | Daikin Ind Ltd | ビジョン装置と産業用ロボットとの座標合せ方法およびその装置 |

| JPH07104143B2 (ja) * | 1986-08-25 | 1995-11-13 | マツダ株式会社 | 物品の位置検出方法 |

| JPH08118272A (ja) * | 1994-10-20 | 1996-05-14 | Toyota Motor Corp | ロボットのキャリブレーション方法 |

| JP2002307346A (ja) * | 2001-04-18 | 2002-10-23 | Mitsubishi Electric Corp | ロボットの視覚座標校正方法および装置 |

| JP2006082170A (ja) * | 2004-09-15 | 2006-03-30 | Fuji Photo Film Co Ltd | キャリブレーション方法 |

| JP2011011321A (ja) * | 2009-07-06 | 2011-01-20 | Fuji Electric Holdings Co Ltd | ロボットシステム及びロボットシステムのキャリブレーション方法 |

-

2011

- 2011-08-26 JP JP2011184953A patent/JP5729219B2/ja not_active Expired - Fee Related

Patent Citations (8)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH07104143B2 (ja) * | 1986-08-25 | 1995-11-13 | マツダ株式会社 | 物品の位置検出方法 |

| JPS6472208A (en) * | 1987-09-11 | 1989-03-17 | Aisin Seiki | Conversion system between robot coordinate and visual coordinate |

| JPH06190756A (ja) * | 1992-12-25 | 1994-07-12 | Mitsubishi Electric Corp | 視覚センサ付きロボットの座標系の設定方法 |

| JPH07227784A (ja) * | 1994-02-15 | 1995-08-29 | Daikin Ind Ltd | ビジョン装置と産業用ロボットとの座標合せ方法およびその装置 |

| JPH08118272A (ja) * | 1994-10-20 | 1996-05-14 | Toyota Motor Corp | ロボットのキャリブレーション方法 |

| JP2002307346A (ja) * | 2001-04-18 | 2002-10-23 | Mitsubishi Electric Corp | ロボットの視覚座標校正方法および装置 |

| JP2006082170A (ja) * | 2004-09-15 | 2006-03-30 | Fuji Photo Film Co Ltd | キャリブレーション方法 |

| JP2011011321A (ja) * | 2009-07-06 | 2011-01-20 | Fuji Electric Holdings Co Ltd | ロボットシステム及びロボットシステムのキャリブレーション方法 |

Cited By (26)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2014180720A (ja) * | 2013-03-19 | 2014-09-29 | Yaskawa Electric Corp | ロボットシステム及びキャリブレーション方法 |

| WO2015079740A1 (ja) * | 2013-11-28 | 2015-06-04 | 三菱電機株式会社 | ロボットシステムおよびロボットシステムの制御方法 |

| CN105792996A (zh) * | 2013-11-28 | 2016-07-20 | 三菱电机株式会社 | 机器人系统以及机器人系统的控制方法 |

| JPWO2015079740A1 (ja) * | 2013-11-28 | 2017-03-16 | 三菱電機株式会社 | ロボットシステムおよびロボットシステムの制御方法 |

| US9782896B2 (en) | 2013-11-28 | 2017-10-10 | Mitsubishi Electric Corporation | Robot system and control method for robot system |

| CN107702653B (zh) * | 2017-11-13 | 2023-06-06 | 易思维(天津)科技有限公司 | 一种机器人涂胶三维信息视觉检测装置及方法 |

| JP7064884B2 (ja) | 2018-01-05 | 2022-05-11 | 株式会社Fdkエンジニアリング | 部品組付装置の較正方法 |

| JP2019119005A (ja) * | 2018-01-05 | 2019-07-22 | 株式会社Fdkエンジニアリング | 部品組付装置の較正方法 |

| CN112775961A (zh) * | 2019-11-06 | 2021-05-11 | 发那科株式会社 | 控制装置、控制装置的控制方法以及控制系统 |

| CN111015664A (zh) * | 2019-12-26 | 2020-04-17 | 重庆盟讯电子科技有限公司 | 一种基于ccd相机的智能化识别方法 |

| CN111015664B (zh) * | 2019-12-26 | 2023-05-30 | 重庆盟讯电子科技有限公司 | 一种基于ccd相机的智能化识别方法 |

| CN115250616A (zh) * | 2020-03-31 | 2022-10-28 | 美蓓亚三美株式会社 | 校正系统、信息处理系统、机器人控制系统、校正方法、信息处理方法、机器人控制方法、校正程序、信息处理程序、校正装置、信息处理装置以及机器人控制装置 |

| CN114043528A (zh) * | 2021-11-25 | 2022-02-15 | 成都飞机工业(集团)有限责任公司 | 一种机器人定位性能测试方法、系统、设备及介质 |

| CN114043528B (zh) * | 2021-11-25 | 2023-08-04 | 成都飞机工业(集团)有限责任公司 | 一种机器人定位性能测试方法、系统、设备及介质 |

| CN114227691B (zh) * | 2021-12-30 | 2023-11-28 | 中铭谷智能机器人(广东)有限公司 | 一种汽车钣金机器人智能喷漆轨迹安全检测方法 |

| CN114227691A (zh) * | 2021-12-30 | 2022-03-25 | 中铭谷智能机器人(广东)有限公司 | 一种汽车钣金机器人智能喷漆轨迹安全检测方法 |

| CN114545862A (zh) * | 2022-02-25 | 2022-05-27 | 浪潮电子信息产业股份有限公司 | 一种夹具作业点位确定方法、装置、设备及存储介质 |

| CN114545862B (zh) * | 2022-02-25 | 2024-05-03 | 浪潮电子信息产业股份有限公司 | 一种夹具作业点位确定方法、装置、设备及存储介质 |

| CN114904798B (zh) * | 2022-05-16 | 2024-05-28 | 上海方酋机器人有限公司 | 一种基于图像识别的煤矸石自动分拣方法、系统及介质 |

| CN114904798A (zh) * | 2022-05-16 | 2022-08-16 | 上海方酋机器人有限公司 | 一种基于图像识别的煤矸石自动分拣方法、系统及介质 |

| CN114800533B (zh) * | 2022-06-28 | 2022-09-02 | 诺伯特智能装备(山东)有限公司 | 一种用于工业机器人的分拣控制方法及系统 |

| CN114800533A (zh) * | 2022-06-28 | 2022-07-29 | 诺伯特智能装备(山东)有限公司 | 一种用于工业机器人的分拣控制方法及系统 |

| CN115657531A (zh) * | 2022-10-18 | 2023-01-31 | 兰州大学 | 一种确定盆景抓取位姿并泊停机器人的系统及方法 |

| CN115657531B (zh) * | 2022-10-18 | 2024-11-26 | 兰州大学 | 一种确定盆景抓取位姿并泊停机器人的系统及方法 |

| CN117641882A (zh) * | 2024-01-25 | 2024-03-01 | 合肥安迅精密技术有限公司 | 基于机器视觉的贴装误差实时校正方法及系统 |

| CN117641882B (zh) * | 2024-01-25 | 2024-04-02 | 合肥安迅精密技术有限公司 | 基于机器视觉的贴装误差实时校正方法及系统 |

Also Published As

| Publication number | Publication date |

|---|---|

| JP5729219B2 (ja) | 2015-06-03 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP5729219B2 (ja) | ロボット制御システムのカメラ座標系とロボット座標系の結合方法、画像処理装置、プログラム、及び記憶媒体 | |

| CN110509300B (zh) | 基于三维视觉引导的钢箍加工上料控制系统及控制方法 | |

| US10899001B2 (en) | Method for teaching an industrial robot to pick parts | |

| US10894324B2 (en) | Information processing apparatus, measuring apparatus, system, interference determination method, and article manufacturing method | |

| CN106272424B (zh) | 一种基于单目相机和三维力传感器的工业机器人抓取方法 | |

| JP4309439B2 (ja) | 対象物取出装置 | |

| TWI650626B (zh) | 基於三維影像之機械手臂加工方法及系統 | |

| JP2022028672A (ja) | ロボットモーション用のビジョンシステムの自動ハンドアイ校正のためのシステム及び方法 | |

| US20210192784A1 (en) | Vision system for a robotic machine | |

| JP7064884B2 (ja) | 部品組付装置の較正方法 | |

| JPH0428518B2 (ja) | ||

| CN107009358B (zh) | 一种基于单相机的机器人无序抓取装置及方法 | |

| US20220092330A1 (en) | Image processing device, work robot, substrate inspection device, and specimen inspection device | |

| US20150202776A1 (en) | Data generation device for vision sensor and detection simulation system | |

| CN210589323U (zh) | 基于三维视觉引导的钢箍加工上料控制系统 | |

| US20150343640A1 (en) | System and method for locating vehicle components relative to each other | |

| CN105547153A (zh) | 基于双目视觉的插件元件针脚视觉定位方法及装置 | |

| CN114341930B (zh) | 图像处理装置、拍摄装置、机器人以及机器人系统 | |

| WO2018145025A1 (en) | Calibration article for a 3d vision robotic system | |

| WO2017133756A1 (en) | Robot system calibration | |

| JP2010058243A (ja) | ピッキング装置 | |

| US11090812B2 (en) | Inspection apparatus for optically inspecting an object, production facility equipped with the inspection apparatus, and method for optically inspecting the object using the inspection apparatus | |

| JP7438734B2 (ja) | 先端部材の向き認識方法、先端部材向き合わせ方法、先端部材挿入方法、先端部材向き認識装置及び先端部材向き合わせシステム | |

| TW201819126A (zh) | 非接觸式的手勢教導機器人 | |

| JPH10128689A (ja) | 無人移動体の視覚補正装置 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20131224 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20140924 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20141001 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20141107 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20150310 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20150323 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 5729219 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| LAPS | Cancellation because of no payment of annual fees |