JP4474013B2 - 情報処理装置 - Google Patents

情報処理装置 Download PDFInfo

- Publication number

- JP4474013B2 JP4474013B2 JP2000086807A JP2000086807A JP4474013B2 JP 4474013 B2 JP4474013 B2 JP 4474013B2 JP 2000086807 A JP2000086807 A JP 2000086807A JP 2000086807 A JP2000086807 A JP 2000086807A JP 4474013 B2 JP4474013 B2 JP 4474013B2

- Authority

- JP

- Japan

- Prior art keywords

- data

- person

- processing

- image

- participant

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

- 230000010365 information processing Effects 0.000 title 1

- 238000012545 processing Methods 0.000 claims description 286

- 238000000034 method Methods 0.000 claims description 123

- 210000003128 head Anatomy 0.000 description 189

- 238000010586 diagram Methods 0.000 description 46

- 230000004044 response Effects 0.000 description 15

- 238000005094 computer simulation Methods 0.000 description 8

- 238000012986 modification Methods 0.000 description 8

- 230000004048 modification Effects 0.000 description 8

- 238000012549 training Methods 0.000 description 6

- 238000007796 conventional method Methods 0.000 description 5

- 239000003550 marker Substances 0.000 description 5

- 230000015572 biosynthetic process Effects 0.000 description 4

- 238000010367 cloning Methods 0.000 description 4

- 230000008447 perception Effects 0.000 description 4

- 238000003786 synthesis reaction Methods 0.000 description 4

- 238000009877 rendering Methods 0.000 description 3

- 230000005540 biological transmission Effects 0.000 description 2

- 238000004891 communication Methods 0.000 description 2

- 238000013500 data storage Methods 0.000 description 2

- 210000005069 ears Anatomy 0.000 description 2

- 239000011521 glass Substances 0.000 description 2

- 238000002360 preparation method Methods 0.000 description 2

- 230000000007 visual effect Effects 0.000 description 2

- 238000006243 chemical reaction Methods 0.000 description 1

- 230000000977 initiatory effect Effects 0.000 description 1

- 238000010845 search algorithm Methods 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

- G06F3/012—Head tracking input arrangements

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/16—Sound input; Sound output

- G06F3/167—Audio in a user interface, e.g. using voice commands for navigating, audio feedback

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

- G10L15/24—Speech recognition using non-acoustical features

-

- G—PHYSICS

- G11—INFORMATION STORAGE

- G11B—INFORMATION STORAGE BASED ON RELATIVE MOVEMENT BETWEEN RECORD CARRIER AND TRANSDUCER

- G11B27/00—Editing; Indexing; Addressing; Timing or synchronising; Monitoring; Measuring tape travel

- G11B27/10—Indexing; Addressing; Timing or synchronising; Measuring tape travel

- G11B27/19—Indexing; Addressing; Timing or synchronising; Measuring tape travel by using information detectable on the record carrier

- G11B27/28—Indexing; Addressing; Timing or synchronising; Measuring tape travel by using information detectable on the record carrier by using information signals recorded by the same method as the main recording

-

- G—PHYSICS

- G11—INFORMATION STORAGE

- G11B—INFORMATION STORAGE BASED ON RELATIVE MOVEMENT BETWEEN RECORD CARRIER AND TRANSDUCER

- G11B27/00—Editing; Indexing; Addressing; Timing or synchronising; Monitoring; Measuring tape travel

- G11B27/10—Indexing; Addressing; Timing or synchronising; Measuring tape travel

- G11B27/19—Indexing; Addressing; Timing or synchronising; Measuring tape travel by using information detectable on the record carrier

- G11B27/28—Indexing; Addressing; Timing or synchronising; Measuring tape travel by using information detectable on the record carrier by using information signals recorded by the same method as the main recording

- G11B27/32—Indexing; Addressing; Timing or synchronising; Measuring tape travel by using information detectable on the record carrier by using information signals recorded by the same method as the main recording on separate auxiliary tracks of the same or an auxiliary record carrier

- G11B27/322—Indexing; Addressing; Timing or synchronising; Measuring tape travel by using information detectable on the record carrier by using information signals recorded by the same method as the main recording on separate auxiliary tracks of the same or an auxiliary record carrier used signal is digitally coded

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N7/00—Television systems

- H04N7/14—Systems for two-way working

- H04N7/15—Conference systems

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N7/00—Television systems

- H04N7/18—Closed-circuit television [CCTV] systems, i.e. systems in which the video signal is not broadcast

Landscapes

- Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- General Engineering & Computer Science (AREA)

- Human Computer Interaction (AREA)

- Physics & Mathematics (AREA)

- Multimedia (AREA)

- General Physics & Mathematics (AREA)

- Health & Medical Sciences (AREA)

- Audiology, Speech & Language Pathology (AREA)

- Computational Linguistics (AREA)

- Acoustics & Sound (AREA)

- General Health & Medical Sciences (AREA)

- Information Retrieval, Db Structures And Fs Structures Therefor (AREA)

- Two-Way Televisions, Distribution Of Moving Picture Or The Like (AREA)

Description

【発明が属する技術分野】

本発明は、画像データのアーカイビングを補助するためのデータを生成する画像データの処理に関する。

【0002】

更に、本発明は、画像データ及び音声データのアーカイビングを補助するためのデータを生成する画像データ及び音声データの処理に関する。

【0003】

【従来の技術】

データを格納するためのデータベースは数多く存在している。しかし、既存のデータベースには、データベースから情報を検索するためにデータベースを問い合わせる方法が限られているという問題がある。

【0004】

【発明が解決しようとする課題】

本発明は、上記の問題に留意してなされた。

【0005】

【課題を解決するための手段】

本発明によれば、複数の人物の動きと話し言葉を記録した画像データ及び音声データを、画像処理と音声処理の組み合わせを利用して処理し、画像データ中に示されているどの人物が話をしているかを識別すると共に、音声データを処理し、識別された話者である参加者に従って選択された処理パラメータを使用して、話された言葉に対応するテキストデータを生成する装置又は方法が提供される。

【0006】

データベースからの情報の検索を容易にするために、この後、テキストデータを画像データ及び/又は音声データと共にデータベースに格納しても良い。

【0007】

また、本発明は、画像データを処理することにより複数の人物の三次元位置を判定し、それらの人物が話した言葉を伝達する音声データを処理して音源の方向を三次元で判定し、生成された位置情報を使用して、それらの言葉の話者を識別し、且つ識別された話者に関して、音声/テキスト変換処理を実行するための音声認識パラメータを選択する装置又は方法を提供する。

【0008】

このようにして、話者である参加者を容易に識別し、音声データを処理することができる。

【0009】

各人物の位置は、各人物の少なくとも頭部を追跡するために画像データを処理することにより判定されるのが好ましい。

【0010】

更に、本発明は、そのようなシステムにおいて画像データ及び音声データを処理し、話者である参加者を識別する装置又は方法を提供する。

【0011】

更に、本発明は、信号の形態をとる命令及び記録された形態をとる命令を含めて、プログラム可能処理装置をそのようなシステムにおいて装置として構成させるため又は方法を実行可能にさせるように構成するための命令を提供する。

【0012】

本発明によれば、画像データを処理し、どの人物が画像中でその他の人物の注目を集めているかを判定することにより、画像中のどの人物が話しているかを判定し、且つ音声データを処理し、画像データを処理することにより識別された話者である参加者に従って選択される処理パラメータを使用して、その人物により話された言葉に対応するテキストデータを生成する装置又は方法も提供される。

【0013】

また、本発明は、画像データを処理して、画像中の人物が誰を見ているかを判定すると共に、それに基づいてどの人物が話をしているかを判定し、且つ音声データを処理して、話者である参加者について音声認識を実行する装置又は方法を提供する。

【0014】

このようにして、話者である参加者を容易に識別し、音声データを処理することができる。

【0015】

更に、本発明は、そのようなシステムにおいて画像データを処理する装置又は方法を提供する。

【0016】

更に、本発明は、信号の形態をとる命令及び記録された形態をとる命令を含めて、プログラム可能処理装置をそのようなシステムにおいて装置として構成させるため又は方法を実行可能にさせるように構成するための命令を提供する。

【0017】

【発明の実施の形態】

以下、添付の図面を参照して、単なる例示として、本発明の実施形態を説明する。

【0018】

<第1の実施形態>

図1を参照して説明すると、複数のビデオカメラ(図1に示す例では3台であるが、これとは異なる台数であっても良い)2−1、2−2、2−3と、マイクロホンアレイ4とを使用して、複数の人物6、8、10、12の間で行われる会議から画像データと音声データをそれぞれ記録する。

【0019】

マイクロホンアレイ4は、例えば、英国特許第2140558号、米国特許第4333170号及び米国特許第3392392号に記載されているような、入って来る音の方向を判定できるように配列されたマイクロホンのアレイから構成されている。

【0020】

ビデオカメラ2−1、2−2、2−3からの画像データと、マイクロホンアレイ4からの音声データは、ケーブル(図示せず)を介してコンピュータ20に入力され、コンピュータ20は受信したデータを処理し、データベースにデータを格納して、会議のアーカイブ記録を作成する。後に、このデータベースから情報を検索することができる。

【0021】

コンピュータ20は、従来のように、表示装置26や、この実施形態ではキーボード28及びマウス30であるユーザ入力装置と共に、1つ又は複数のプロセッサ、メモリ、サウンドカードなどを含む処理装置24を有する従来通りのパーソナルコンピュータである。

【0022】

コンピュータ20の構成要素と、それらの構成要素に対し入出力されるデータの流れを図2に概略的に示す。

【0023】

図2を参照すると、処理装置24は、例えば、ディスク32などのデータ記憶媒体に格納されたデータとして及び/又は例えば、インターネットなどの通信ネットワーク(図示せず)を介する送信又は無線送信により遠隔データベースから処理装置24に入力され且つ/又はキーボード28などのユーザ入力装置又は他の入力装置を介してユーザにより処理装置24に入力される信号34として入力されるプログラミング命令に従って動作するようにプログラムされている。

【0024】

プログラミング命令によりプログラムされると、処理装置24は、処理動作を実行するための複数の機能ユニットに有効に構成される。そのような機能ユニットの例とそれらの配線を図2に示す。しかし、図2に示すユニットと配線は概念的なもので、単に理解を助けるために例示を目的として示されているにすぎない。従って、図2のユニットと配線とは、処理装置24のプロセッサ、メモリなどが構成される実際のユニットと接続とを必ずしも表してはいない。

【0025】

図2に示す機能ユニットについて説明すると、中央制御装置36はユーザ入力装置28、30からの入力を処理すると共に、ユーザによりディスク38などの記憶装置に格納されたデータとして、又は処理装置24へ送信される信号40として処理装置24に入力されるデータを受信する。また、中央制御装置36はその他の機能ユニットに対して制御と処理を実行する。メモリ42は、中央制御装置36及びその他の機能ユニットにより使用されるメモリである。

【0026】

頭部追跡装置50はビデオカメラ2−1、2−2、2−3から受信した画像データを処理して、会議のそれぞれの参加者6、8、10、12の頭部の位置と向きを三次元で追跡する。この実施形態では、この追跡を実行するために、頭部追跡装置50は、後述するように、各々の参加者の頭部の三次元コンピュータモデルを定義するデータと、その特徴を定義するデータとを使用する。これらのデータは頭部モデル記憶装置52に格納されている。

【0027】

方向プロセッサ53はマイクロホンアレイ4からの音声データを処理して、マイクロホンにより記録された音が来た方向を判定する。そのような処理は、例えば、英国特許第2140558号、米国特許第4333170号及び米国特許第3392392号に記載されているような従来の方式で実行される。

【0028】

音声認識プロセッサ54はマイクロホンアレイ4から受信された音声データを処理して、そこからテキストデータを生成する。すなわち、音声認識プロセッサ54は、「Dragon Dictate」又はIBMの「ViaVoice」などの従来の音声認識プログラムに従って動作し、参加者6、8、10、12により話された言葉に対応するテキストデータを生成する。音声認識処理を実行するために、音声認識プロセッサ54は、音声認識パラメータ記憶装置56に格納されている、参加者6、8、10、12ごとの音声認識パラメータを定義するデータを使用する。すなわち、音声認識パラメータ記憶装置56に格納されるデータは、音声認識プロセッサを従来の方式で訓練することにより生成される各参加者の音声プロファイルを定義するデータである。例えば、このデータは、訓練後にDragon Dictateの「ユーザファイル」に格納されるデータである。

【0029】

アーカイブプロセッサ58は、頭部追跡装置50、方向プロセッサ53及び音声認識プロセッサ54から受信したデータを使用して、会議アーカイブデータベース60に格納すべきデータを生成する。すなわち、後述するように、カメラ2−1、2−2及び2−3からの映像データと、マイクロホンアレイ4からの音声データとを、音声認識プロセッサ54からのテキストデータ及び所定の時点で会議の各参加者が誰を見ていたかを定義するデータと共に会議アーカイブデータベース60に格納するのである。

【0030】

テキストサーチャ62は、中央制御装置36と関連して、会議アーカイブデータベース60を探索し、後に更に詳細に説明するように、ユーザにより指定される探索基準に適合する会議の1つ又は複数の部分を見出し、その部分の音声データ及び映像データを再生するために使用される。

【0031】

表示プロセッサ64は、中央制御装置36の制御の下に、ユーザに対し表示装置26を介して情報を表示すると共に、会議アーカイブデータベース60に格納された音声データと映像データを再生する。

【0032】

出力プロセッサ66はアーカイブデータベース60のデータの一部又は全てを、例えば、ディスク68などの記憶装置に又は信号70として出力する。

【0033】

会議を始める前に、処理装置24が必要な処理動作を実行できるようにするために必要なデータを入力することにより、コンピュータ20を初期設定する必要がある。

【0034】

図3は、この初期設定中に処理装置24により実行される処理動作を示す。

【0035】

図3を参照して説明すると、ステップS1では、中央制御装置36は表示プロセッサ64に、ユーザが会議に参加するであろう各人物の名前を入力することを要求するメッセージを表示装置26に表示させる。

【0036】

ステップS2では、例えば、ユーザがキーボード28を使用して入力した、名前を定義するデータを受信して、中央制御装置36は各参加者に独自の識別番号を割り当て、識別番号と参加者の名前との関係を定義するデータ、例えば、図4に示すテーブル80を会議アーカイブデータベース60に格納する。

【0037】

ステップS3では、中央制御装置36は表示プロセッサ64に、会議中のかなり長い時間にわたり人物が見ると考えられ、会議アーカイブデータベース60にアーカイブデータを格納することが望まれる物体それぞれの名前をユーザが入力することを要求するメッセージを表示装置26に表示させる。そのような物体としては、例えば、図1に示すフリップチャート14などのフリップチャート、ホワイトボード又は黒板、又はテレビなどが挙げられる。

【0038】

ステップS4では、例えば、ユーザがキーボード28を使用して入力した、物体の名前を定義するデータを受信して、中央制御装置36は各物体に独自の識別番号を割り当て、識別番号と物体の名前との関係を定義するデータ、例えば、図4に示すテーブル80を会議アーカイブデータベース60に格納する。

【0039】

ステップS6では、中央制御装置36は頭部モデル記憶装置52を探索して、会議の参加者ごとに頭部モデルを定義するデータが既に格納されているか否かを判定する。

【0040】

ステップS6で、1人または複数の参加者について頭部モデルがまだ格納されていないと判定されたならば、ステップS8で、中央制御装置36は表示プロセッサ64に、頭部モデルがまだ格納されていない各参加者の頭部モデルを定義するデータをユーザが入力することを要求するメッセージを表示装置26に表示させる。

【0041】

これに応答して、ユーザは、例えば、ディスク38などの記憶媒体にあるデータを入力するか、又は接続している処理装置から信号40としてデータをダウンロードすることにより、必要な頭部モデルを定義するデータを入力する。このような頭部モデルは、従来の方式により、例えば、Valente他の「An Analysis/Synthesis Cooperation for Head Tracking andVideo Face Cloning」(ProceedingsECCV’98Workshop on Perceptionof Human Actionに掲載、ドイツ、フライブルク大学、1998年6月6日)に記載されている方法で生成されれば良い。

【0042】

ステップS10では、中央制御装置36は、ユーザにより入力されたデータを頭部モデル記憶装置52に格納する。

【0043】

ステップS12では、中央制御装置36及び表示プロセッサ64はユーザにより入力された各三次元コンピュータ頭部モデルをレンダリングして、ユーザが各モデルにおいて少なくとも7つの特徴を識別することを要求するメッセージと共に、ユーザに対し表示装置26を介してモデルを表示する。

【0044】

これに応答して、ユーザは、各々のモデルの中で、参加者の頭部の正面、側面及び(可能であれば)背面にある顕著な特徴、例えば、目尻、鼻孔、口、耳又は参加者が掛けている眼鏡の特徴などに対応する30個の点をマウスを使用して指定する。

【0045】

ステップS14では、中央制御装置36は、ユーザにより識別された特徴を定義するデータを頭部モデル記憶装置52に格納する。

【0046】

これに対し、ステップS6で、参加者ごとに頭部モデルが既に頭部モデル記憶装置52に格納されていると判定された場合には、ステップS8からS14を省略する。

【0047】

ステップS16では、中央制御装置36は音声認識パラメータ記憶装置を探索して、参加者ごとに音声認識パラメータが既に格納されているか否かを判定する。

【0048】

ステップS16で、全ての参加者については音声認識パラメータを利用できないと判定されたならば、ステップS18で、中央制御装置36は表示プロセッサ64に、パラメータがまだ格納されていない各参加者について音声認識パラメータを入力することをユーザに要求するメッセージを表示装置26に表示させる。

【0049】

これに応答して、ユーザは、例えば、ディスク38などの記憶媒体のデータを入力するか、又は遠隔処理装置からの信号40として入力することにより、必要な音声認識パラメータを定義するデータを入力する。先に述べた通り、これらのパラメータはユーザの話す音声のプロファイルを定義し、従来の方式で音声認識プロセッサを訓練することにより生成される。従って、例えば、Dragon Dictateを組み込んだ音声認識プロセッサの場合、ユーザにより入力される音声認識パラメータは、Dragon Dictateの「ユーザファイル」に格納されるパラメータに相当する。

【0050】

ステップS20では、中央制御装置36は、ユーザにより入力された音声認識パラメータを定義するデータを音声認識パラメータ記憶装置56に格納する。

【0051】

これに対し、ステップS16で、参加者ごとに音声認識パラメータを既に利用できる状態にあると判定された場合には、ステップS18からS20を省略する。

【0052】

ステップS22では、中央制御装置36は表示プロセッサ64に、カメラ2−1、2−2及び2−3の校正(キャリブレーション)を可能にするためのステップをユーザが実行することを要求するメッセージを表示装置26に表示させる。

【0053】

これに応答して、ユーザは必要なステップを実行し、ステップS24では、中央制御装置36はカメラ2−1、2−2及び2−3を校正するための処理を実行する。すなわち、この実施形態においては、ユーザにより実行されるステップ及び中央制御装置36により実行される処理は、Wiles及びDavisonの「Calibrating and3D Modelling with a Multi−Camera System」(1999IEEE Workshop on Multi−View Modelling and Analysis of Visual Scenes,ISBN 0769501109)に記載されているような方式で実行される。これは、会議室に対する各カメラ2−1,2−2及び2−3の位置及び向きを定義する校正データ(キャリブレーションデータ)と、各カメラ固有のパラメータ(横縦比、焦点距離、主点及び一次半径方向ひずみ係数)とを生成する。カメラ校正データ(カメラキャリブレーションデータ)は、例えば、メモリ42に格納される。

【0054】

ステップS25では、中央制御装置36は表示プロセッサ64に、ステップS4で識別データが格納された物体それぞれの位置と向きを判定できるようにするためのステップをユーザが実行することを要求するメッセージを表示装置26に表示させる。

【0055】

これに応答して、ユーザは必要なステップを実行し、ステップS26では、中央制御装置36は、各物体の位置と向きを判定するための処理を実行する。すなわち、この実施形態においては、ユーザは、会議の参加者が見ると思われる物体の面の周囲、例えば、フリップチャート14の紙の平面にカラーマーカーを置く。次に、中央制御装置36は、カメラ2−1、2−2及び2−3の各々により記録された画像データをステップS24で格納されたカメラ校正データを使用して処理し、従来の方式で、各々のカラーマーカーの三次元位置を判定する。この処理はカメラ2−1、2−2及び2−3ごとに実行されるので、各カラーマーカーの位置は別個に推定され、各カメラ2−1、2−2及び2−3からのデータを使用して計算された位置から、各マーカーの位置について平均位置が判定される。各マーカーの平均位置を使用して、中央制御装置36は、従来の方式により、物体面の中心と、物体面の向きを定義するための面垂線とを計算する。物体ごとに判定された位置と向きは、例えば、メモリ42に物体校正データとして格納される。

【0056】

ステップS27では、中央制御装置36は表示プロセッサ64に、会議の次の参加者(初めてステップS27を実行する場合には、これは最初の参加者である)が着席することを要求するメッセージを表示装置26に表示させる。

【0057】

ステップS28では、要求された参加者に着席する時間を与えるために、処理装置24は所定の期間待機し、ステップS30では、中央制御装置36は各カメラ2−1、2−2及び2−3からのそれぞれの画像データを処理して、カメラごとに、着席した参加者の頭部の推定位置を判定する。すなわち、この実施形態においては、中央制御装置36は従来の方式でカメラごとに別個に処理を実行し、参加者の肌の色に対応する色(この色は、頭部モデル記憶装置52に格納されている参加者の頭部モデルを定義するデータから判定される)を有する、カメラからの画像データの1つのフレームにおける位置をそれぞれ識別し、次に、(頭部は人体の中で最も高い位置にある肌色の部分であると想定されるので)会議室内の最も高い位置に相当する部分を選択する。画像中の識別された部分の位置と、ステップS24で判定されたカメラ校正パラメータとを使用して、中央制御装置36は従来の方式により頭部の三次元推定位置を判定する。この処理はカメラ2−1、2−2及び2−3ごとに実行され、カメラごとに別個の推定頭部位置が得られる。

【0058】

ステップS32では、中央制御装置36は、カメラ2−1、2−2及び2−3ごとに、参加者の頭部の三次元推定向きを判定する。すなわち、この実施形態においては、中央制御装置36は、頭部モデル記憶装置52に格納されている参加者の頭部の三次元コンピュータモデルをそのモデルの複数の異なる向きについてレンダリングして、向きごとに対応するモデルの二次元画像を作成する。この実施形態では、参加者の頭部のコンピュータモデルを108の異なる向きでレンダリングするので、108の対応する二次元画像が得られる。これらの向きは、頭部モデルを0°(正面を向いている場合)、+45°(上を向いている場合)及び−45°(下を向いている場合)のそれぞれについて10°ずつ36回回転させた向きに相当する。次に、中央制御装置36は、モデルの各々の二次元画像を参加者の頭部を示す、カメラ2−1、2−2、2−3からの映像フレームの部分と比較し、モデルの画像が映像データと最も良く整合する向きを選択する。この比較と選択はカメラごとに実行されるので、カメラごとに推定頭部向きが得られる。頭部モデルをレンダリングすることにより生成される画像データをカメラからの映像データと比較するときには、例えば、Schodl、Haro及びEssaの「Head Tracking Using a Textured Polygonal Model」(Proceedings1998Workshop on Perceptual User Interfacesに掲載)に記載されているような従来の技法を使用する。

【0059】

ステップS34では、ステップS30で生成された参加者の頭部のそれぞれの推定位置と、ステップS52で生成された参加者の頭部のそれぞれの推定向きとを頭部追跡装置50に入力し、各々のカメラ2−1、2−2及び2−3から受信した画像データのフレームを処理して、参加者の頭部を追跡する。すなわち、この実施形態においては、頭部追跡装置50は、例えば、Valente他の「An Analysis/Synthesis Cooperation for Head Tracking andVideo Face Cloning」(ProceedingsEECV’98Workshop on Perceptionof Human Action、ドイツ、フライブルク大学、1998年6月6日)に記載されているような従来の方式で頭部を追跡するための処理を実行する。

【0060】

図5は、ステップS34で頭部追跡装置50により実行される処理動作の概要を示す。

【0061】

図5を参照すると、ステップS42−1からS42−n(この実施形態では、カメラは3台であるので、「n」は3である)の各々においては、頭部追跡装置50は会議を記録しているカメラのうち対応する1台からの画像データを処理して、そのカメラからの画像データにおける参加者の頭部の特徴(ステップS14で格納された)の位置を判定すると共に、それに基づき、そのカメラからの画像データの現在フレームについて参加者の頭部の三次元位置と向きを判定する。

【0062】

図6は、ステップS42−1からS42−nの所定の1つで実行される処理動作を示す。この処理動作は各ステップで同一であるが、異なるカメラからの画像データに対して実行されることになる。

【0063】

図6を参照すると、ステップS50では、頭部追跡装置50は参加者の頭部の現在推定3D位置及び現在推定3D向きを読み取る。初めてステップS50を実行する場合、これらは図3のステップS30及びS32で生成される推定位置と推定向きである。

【0064】

ステップS52では、頭部追跡装置50はステップS24で生成されたカメラ校正データを使用して、ステップS50で読み取られた推定位置と推定向きに従って、頭部モデル記憶装置52に格納されている参加者の頭部の三次元コンピュータモデルをレンダリングする。

【0065】

ステップS54では、頭部追跡装置50は、カメラから受信された映像データの現在フレームについて画像データを処理して、ユーザにより識別され、ステップS14で格納された頭部の特徴の中の1つの特徴の期待位置を取り囲む各領域からの画像データを取り出す。この期待位置はステップS50で読み取られた推定位置及び推定向きと、ステップS24で生成されたカメラ校正データとから判定される。

【0066】

ステップS56では、頭部追跡装置50はステップS52で生成された、レンダリングされた画像データと、ステップS54で取り出されたカメラ画像データとを整合し、レンダリングされた頭部モデルに最も良く整合するカメラ画像データを見出す。

【0067】

ステップS58では、頭部追跡装置50は、ステップS56で識別された、レンダリングされた頭部モデルに最も良く整合するカメラ画像データを、ステップS24(図3)で格納されたカメラ校正データと共に使用して、映像データの現在フレームについて参加者の頭部の3D位置と3D向きを判定する。

【0068】

再び図5に戻ると、ステップS44では、頭部追跡装置50は、ステップS42−1からS42−nの各々で識別された、レンダリングされた頭部モデルに最も良く整合するカメラ画像データ(図6のステップS58で識別される)を使用して、映像データの現在フレームについて参加者の頭部の平均3D位置と平均3D向きを判定する。

【0069】

ステップS44を実行するのと同時に、ステップS46では、ステップS42−1からS42−nの各々で判定されたカメラ画像データにおける頭部の特徴の位置(図6のステップS58で識別される)を従来のカルマンフィルタに入力して、映像データの次のフレームについて参加者の頭部の推定3D位置及び推定3D向きを生成する。ビデオカメラ2−1、2−2及び2−3から映像データのフレームが受信されている間、その参加者についてステップS42からS46を繰り返し実行する。

【0070】

再び図3に戻ると、ステップS36では、中央制御装置36は、会議に他の参加者がいるか否かを判定し、参加者ごとに先に説明したように処理が実行され終わるまでステップS27からS36を繰り返す。しかし、参加者ごとにこれらのステップが実行されている間、ステップS34では、頭部追跡装置50は既に着席した各参加者の頭部を追跡し続けている。

【0071】

ステップS36で、会議に他の参加者はなく、従って、各参加者の頭部は頭部追跡装置50により追跡されていると判定されたならば、ステップS38で、中央制御装置36は、参加者の間で会議を始めて良いことを指示するために、処理装置24から可聴信号を出力させる。

【0072】

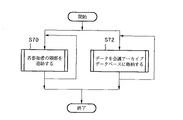

図7は、参加者間で会議が行われている間に処理装置24により実行される処理動作を示す。

【0073】

図7を参照すると、ステップS70では、頭部追跡装置50は会議中の各参加者の頭部を追跡し続ける。ステップS70で頭部追跡装置50により実行される処理は先にステップS34に関して説明した処理と同じであるので、ここでは繰り返し説明しない。

【0074】

頭部追跡装置50がステップS70で各参加者の頭部を追跡しているのと同時に、ステップS72では、データを生成し、会議アーカイブデータベース60に格納するための処理を実行する。

【0075】

図8は、ステップS72で実行される処理動作を示す。

【0076】

図8を参照すると、ステップS80では、アーカイブプロセッサ58は、参加者ごとに、その参加者がどの人物又はどの物体を見ているかを定義するいわゆる「視線パラメータ」を生成する。

【0077】

図9は、ステップS80で実行される処理動作を示す。

【0078】

図9を参照すると、ステップS110では、アーカイブプロセッサ58は頭部追跡装置50から各参加者の頭部の現在三次元位置を読み取る。これは、ステップS44(図5)で頭部追跡装置50により実行される処理で生成された平均位置である。

【0079】

ステップS112では、アーカイブプロセッサ58は頭部追跡装置50から次の参加者(初めてステップS112を実行する場合、これは最初の参加者である)の頭部の現在向きを読み取る。ステップS112で読み取られる向きは、ステップS44(図5)で頭部追跡装置50により実行される処理で生成された平均向きである。

【0080】

ステップS114では、アーカイブプロセッサ58は、参加者がどこを見ているかを定義する線(いわゆる「視線」)と、参加者の頭部を他の参加者の頭部の中心と結ぶ概念上の各々の線とが成す角度を判定する。

【0081】

更に詳細に説明するため、図10及び図11を参照すると、1人の参加者、すなわち、図1の参加者6についてステップS114で実行される処理の一例が示されている。図10を参照すると、ステップS112で読み取られる参加者の頭部の向きは、参加者の両目の中央の一点から、参加者の頭部に対し垂直に延びる視線90を定義する。同様に、図11を参照すると、ステップS110で読み取られる全ての参加者の頭部の位置は、参加者6の両目の中央の点からその他のそれぞれの参加者8、10、12の頭部の中心に至る概念上の線92、94、96を定義する。ステップS114で実行される処理においては、アーカイブプロセッサ58は視線90と、それぞれの概念上の線92、94、96とが成す角度98、100、102を判定する。

【0082】

再び図9に戻ると、ステップS116では、アーカイブプロセッサ58は、最小値を有する角度98、100又は102を選択する。すなわち、図11に示す例でいえば、角度100が選択されることになるであろう。

【0083】

ステップS118では、アーカイブプロセッサ58は、ステップS116で選択した角度が10°より小さい値を有するか否かを判定する。

【0084】

ステップS118で、角度が10°より小さいと判定されれば、ステップS120で、アーカイブプロセッサ58は参加者の視線パラメータを、視線と最小の角度を成す概念上の線により結ばれている参加者の識別番号(図3のステップS2で割り当てられている)に設定する。すなわち、図11に示す例でいえば、角度100が10°より小さければ、角度100は視線90と、参加者6を参加者10と結ぶ概念上の線94とが成す角度であるので、視線パラメータは参加者10の識別番号に設定されるであろう。

【0085】

これに対し、ステップS118で、最小の角度が10°以上であると判定された場合には、ステップS122で、アーカイブプロセッサ58はステップS26(図3)で先に格納された各物体の位置を読み取る。

【0086】

ステップS124では、アーカイブプロセッサ58は、参加者の視線90がいずれかの物体の平面と交わるか否かを判定する。

【0087】

ステップS124で、視線90が1つの物体の平面と交わると判定されたならば、ステップS126で、アーカイブプロセッサ58は参加者の視線パラメータを視線と交わる物体の識別番号(図3のステップS4で割り当てられている)に設定する。視線90と交わる物体が2つ以上ある場合には、これは、視線と交わる物体のうち、参加者に最も近い物体ということになる。

【0088】

これに対し、ステップS124で、視線90が物体の平面と交わらないと判定されたならば、ステップS128で、アーカイブプロセッサ58は参加者の視線パラメータを「0」に設定する。これは、(視線90が概念上の線92、94、96のいずれにも十分近接していないために)参加者はその他の参加者の誰をも見ておらず、また、(視線90が物体と交わらないために)どの物体をも見ていないと判定されたことを示している。このような状況は、例えば、参加者が会議室内の、ステップS4でデータが格納されず且つステップS26で校正が実行されなかった何らかの物体(例えば、図1に示す例において参加者12が手に持っているメモ)を見ている場合などに起こりうるであろう。

【0089】

ステップS130では、アーカイブプロセッサ58は会議に他の参加者がいるか否かを判定し、参加者ごとに先に説明した処理が実行され終わるまでステップS112からS130を繰り返す。

【0090】

再び図8に戻ると、ステップS82では、中央制御装置36及び音声認識プロセッサ54は、映像データの現在フレームに対応する音声データがマイクロホンアレイ4から受信されたか否かを判定する。

【0091】

ステップS82で、音声データが受信されたと判定されれば、ステップS84で、会議中の参加者のうち誰が話をしているかを判定するための処理を実行する。

【0092】

図12は、ステップS84で実行される処理動作を示す。

【0093】

図12を参照すると、ステップS140では、方向プロセッサ53はマイクロホンアレイ4からの音声データを処理して、音声が来ている方向を判定する。この処理は、例えば、英国特許第2140558号、米国特許第4333170号及び米国特許第3392392号に記載されているような従来の方式で実行される。

【0094】

ステップS142では、アーカイブプロセッサ58は、画像データの現在フレームについてステップS44(図5)で頭部追跡装置50により判定された各参加者の頭部の位置を読み取り、それに基づいて、どの参加者の頭部がステップS140で判定された方向、すなわち、音声が来ている方向に対応する位置にあるかを判定する。

【0095】

ステップS144では、アーカイブプロセッサ58は、音声が来ている方向に2人以上の参加者がいるか否かを判定する。

【0096】

ステップS144で、音声が来ている方向には1人しか参加者がいないと判定されれば、ステップS146で、アーカイブプロセッサ58は、音声が来ている方向にいる参加者を画像データの現在フレームの話者として選択する。

【0097】

これに対し、ステップS144で、音声が来ている方向に対応する位置に2人以上の参加者の頭部があると判定された場合には、ステップS148で、アーカイブプロセッサ58は、画像データの直前フレームでそれらの参加者のうち1人が話者として識別されていたか否かを判定する。

【0098】

ステップS148で、音声が来ている方向にいる参加者の1人が画像データの直前フレームで話者として選択されていたと判定されれば、ステップS150で、アーカイブプロセッサ58は画像データの直前フレームで識別されていた話者を画像データの現在フレームについても話者として選択する。これは、画像データの直前フレームの話者が現在フレームの話者と同1人物である確率が高いからである。

【0099】

これに対し、ステップS148で、音声が来ている方向にいる参加者がいずれも直前フレームで話者として識別された参加者ではないと判定された場合、又は直前フレームでは話者が識別されなかった場合には、ステップS152で、アーカイブプロセッサ58は、音声が来ている方向にいるそれぞれの参加者を話者に「なりうる」参加者として選択する。

【0100】

再び図8に戻ると、ステップS86では、アーカイブプロセッサ58は話者である参加者ごとの視線パラメータ値、すなわち、ステップS80で生成された、話者である各参加者が誰を又は何を見ているかを定義する視線パラメータ値を後の解析に備えて、例えば、メモリ42に格納する。

【0101】

ステップS88では、アーカイブプロセッサ58は、ステップS84で判定された話者である各参加者のアイデンティティを音声認識プロセッサ54に報知する。これに応答して、音声認識プロセッサ54は話者である参加者の音声認識パラメータを音声認識パラメータ記憶装置56から選択し、選択されたパラメータを使用して、受信した音声データに対して音声認識処理を実行し、話者である参加者が話した言葉に対応するテキストデータを生成する。

【0102】

他方、ステップS82で、受信した音声データが話し言葉を含まないと判定されたならば、ステップS84からステップS88を省略する。

【0103】

ステップS89では、アーカイブプロセッサ58は、会議アーカイブデータベース60にどの画像データを格納すべきか、すなわち、どのカメラ2−1、2−2及び2−3からの画像データを格納すべきかを判定する。

【0104】

図13は、ステップS89でアーカイブプロセッサ58により実行される処理動作を示す。

【0105】

図13を参照すると、ステップS160では、アーカイブプロセッサ58は、画像データの現在フレームについてステップS82(図8)で何らかの話し言葉が検出されたか否かを判定する。

【0106】

ステップS160で現在フレームについては話し言葉が存在しないと判定されれば、ステップS162で、アーカイブプロセッサ58は、画像データを格納すべきカメラとしてデフォルトカメラを選択する。すなわち、この実施形態においては、アーカイブプロセッサ58は直前フレームで画像データが記録されたカメラを選択する。処理中の現在フレームが全く初めてのフレームである場合には、アーカイブプロセッサ58はカメラ2−1、2−2、2−3のうち1台を無作為に選択する。

【0107】

他方、ステップS160で、処理中の現在フレームに話し言葉があると判定された場合には、ステップS164で、アーカイブプロセッサ58は、次の話者である参加者(初めてステップS164を実行するときには、これは最初の話者である参加者である)についてステップS86で先に格納された視線パラメータを読み取り、その話者である参加者が見ている人物又は物体を判定する。

【0108】

ステップS166では、アーカイブプロセッサ58は、現在考慮されている話者である参加者の頭部の位置と向き(図5のステップS44で判定された)を、話者である参加者の視線の先にいる参加者の頭部の位置と向き(図5のステップS44で判定された)又は話者である参加者の視線の先にある物体の位置と向き(図3のステップS26で格納された)と共に読み取る。

【0109】

ステップS168では、アーカイブプロセッサ58はステップS166で読み取られた位置と向きを処理して、カメラ2−1、2−2、2−3のうちどのカメラが話者である参加者と、話者である参加者が見ている参加者又は物体の双方を最も良く示しているかを判定し、且つこのカメラを現在フレームの画像データを会議アーカイブデータベース60に格納すべきカメラとして選択する。

【0110】

図14は、ステップS168でアーカイブプロセッサ58により実行される処理動作を示す。

【0111】

図14を参照すると、ステップS176では、アーカイブプロセッサ58は次のカメラ(初めてステップS176を実行するときには、これは第1のカメラである)の三次元位置と視野方向を読み取る。この情報は先に図3のステップS24で生成、格納されている。

【0112】

ステップS178では、アーカイブプロセッサ58は、ステップS176で読み取られた情報を、話者である参加者の頭部の三次元位置と向き(図5のステップS44で判定された)を定義する情報及び話者である参加者が見ている参加者の頭部の三次元位置と向き(図5のステップS44で判定された)又は話者である参加者が見ている物体の三次元位置と向き(図3のステップS26で格納された)を定義する情報と共に使用して、話者である参加者と、話者である参加者が見ている参加者又は物体の双方が現在考慮されているカメラの視野の中に入るか否か(すなわち、現在考慮されているカメラが話者である参加者と、話者である参加者が見ている参加者又は物体の双方を捉えることができるか否か)を判定する。すなわち、この実施形態においては、アーカイブプロセッサ58は下記の式を評価し、全ての不等式が成立すれば、カメラは話者である参加者と、話者である参加者が見ている参加者又は物体の双方を捉えることができると判定する。

【0113】

【数1】

【0114】

【数2】

【0115】

【数3】

【0116】

【数4】

【0117】

式中、(Xc,Yc,Zc)は、それぞれ、カメラの主点のx座標、y座標及びz座標(図3のステップS24で先に判定、格納されている)であり、

(dXc、dYc,dZc)は、それぞれ、x方向、y方向及びz方向のカメラの視野方向(同様に、図3のステップS24で先に判定、格納されている)を表し、

θh及びθvは、それぞれ、水平方向と垂直方向のカメラの角視野(同様に、図3のステップS24で判定、格納されている)であり、

(Xp1、Yp1,Zp1)は、それぞれ、話者である参加者の頭部の中心のx座標、y座標及びz座標(図5のステップS44で判定されている)であり、

(dXp1,dYp1,dZp1)は、それぞれ、話者である参加者の視線90の向き(同様に、図5のステップS44で判定されている)を表し、

(Xp2,Yp2,Zp2)は、それぞれ、話者である参加者が見ている参加者の頭部の中心のx座標、y座標及びz座標(図5のステップS44で判定されている)又は話者である参加者が見ている物体の面の中心のx座標、y座標及びz座標(図3のステップS26で判定されている)であり、

(dXp2,dYp2,dZp2)は、それぞれ、話者である参加者が見ている参加者の視線90のx方向、y方向及びz方向の方向(同様に、図5のステップS44で判定されている)又は話者である参加者が見ている物体面に対する垂線のx方向、y方向及びz方向の方向(図3のステップS26で判定されている)を表す。

【0118】

ステップS178で、カメラが話者である参加者と、話者である参加者が見ている参加者又は物体の双方を捉えることができる(すなわち、上記の式(1)、(2)、(3)及び(4)の不等式が成立する)と判定されれば、ステップS180で、アーカイブプロセッサ58は、現在考慮されているカメラが話者である参加者を捉えている視野の画質を表す値を計算し、格納する。すなわち、この実施形態においては、アーカイブプロセッサ58は、下記の式を使用して画質値Q1を計算する。

【0119】

【数5】

【0120】

式中、各項の定義は先の式(1)及び(2)に関して挙げた定義と同じである。

【0121】

ステップS180で計算される画質値Q1は、−1から+1の値をとるスカラであり、話者である参加者の頭部の背面がカメラに直接向いている場合、その値は−1であり、話者である参加者の顔面が直接カメラに向いている場合には+1である。話者である参加者の頭部がその他の向きである場合には、−1と+1の間の値をとる。

【0122】

ステップS182では、アーカイブプロセッサ58は、現在考慮されているカメラが話者である参加者が見ている参加者又は物体を捉えている視野の画質を表す値を計算し、格納する。すなわち、この実施形態においては、アーカイブプロセッサ58は下記の式を使用して、画質値Q2を計算する。

【0123】

【数6】

【0124】

式中、パラメータの定義は先の式(3)及び(4)に関して挙げた定義と同じである。

【0125】

Q2も、同様に、参加者の頭部の背面又は物体の面の背面が直接カメラに向いている場合に−1、参加者の顔面又は物体の正面が直接カメラに向いている場合には+1の値をとるスカラである。参加者の頭部又は物体の面がその他の向きである場合には、−1と+1の間の値をとる。

【0126】

ステップS184では、アーカイブプロセッサ58はステップS180で計算した画質値Q1と、ステップS182で計算した画質値Q2とを比較し、最小値を選択する。この最小値は、カメラが話者である参加者、あるいは話者である参加者が見ている参加者又は物体を捉えている「最悪の視野」を示す(Q1がQ2より小さい場合、最悪の視野は話者である参加者の視野であり、Q2がQ1より小さい場合は、最悪の視野は話者である参加者が見ている参加者又は物体の視野である)。

【0127】

他方、ステップS178で、式(1)、(2)、(3)及び(4)の不等式の1つ又は2つ以上が成立しない(すなわち、カメラが話者である参加者と、話者である参加者が見ている参加者又は物体の双方を捉えることができない)と判定された場合には、ステップS180からS184を省略する。

【0128】

ステップS186では、アーカイブプロセッサ58は、画像データを提供していたカメラが他にあるか否かを判定する。カメラごとに上記の処理が実行され終わるまで、ステップS176からS186を繰り返す。

【0129】

ステップS188では、アーカイブプロセッサ58は、ステップS184で処理を実行したときにカメラごとに格納された「最悪の視野」の値(すなわち、ステップS184でカメラごとに格納されたQ1又はQ2の値)を比較し、格納されているそれらの値の中で最大の値を選択する。この最大値は「最良の最悪の視野」を表し、そこで、ステップS188で、アーカイブプロセッサ58は、ステップS184でこの「最良の最悪の視野」値が格納されていたカメラを会議アーカイブデータベースに画像データを格納すべきカメラとして選択する。これは、このカメラが話者である参加者と、話者である参加者が見ている参加者又は物体の双方を最良の視野で捉えているからである。

【0130】

ステップS170では、アーカイブプロセッサ58は、話者に「なりうる」参加者を含めて、他に話者である参加者がいるか否かを判定する。話者である参加者ごとに、また、話者に「なりうる」参加者ごとに上記の処理が実行され終わるまで、ステップS164からS170を繰り返す。

【0131】

再び図8に戻ると、ステップS90では、アーカイブプロセッサ58はステップS89で選択したカメラから受信された映像データの現在フレームと、マイクロホンアレイ4から受信された音声データとを従来の方式によりMPEG2データとして符号化し、符号化されたデータを会議アーカイブデータベース60に格納する。

【0132】

図15は、会議アーカイブデータベース60へのデータの格納を概略的に示す。図15に示す格納構造は概念上のものであり、格納される情報間のリンクを示すことにより理解を助けることを目的としている。従って、これは、会議アーカイブデータベース60を構成するメモリにデータが厳密にどのように格納されるかを必ずしも表してはいない。

【0133】

図15を参照すると、会議アーカイブデータベース60は水平軸200により表される時間情報を格納している。水平軸200上の各単位は所定の量の時間、例えば、カメラから受信される映像データの1フレーム分の周期を表す。(会議アーカイブデータベース60が一般には図15に示す数より多くの数の時間単位を含むことは言うまでもなく了解されるであろう。)ステップS90で生成されたMPEG2データは、タイミング情報(このタイミング情報は図15では水平軸200に沿ったMPEG2データ202の位置により概略的に表されている)と共に、データ202として会議アーカイブデータベース60に格納されている。

【0134】

再び図8に戻ると、ステップS92では、アーカイブプロセッサ58は、現在フレームについてステップS88で音声認識プロセッサ54により生成されたテキストデータを会議アーカイブデータベース60に格納する(図15には204で示す)。すなわち、テキストデータは対応するMPEG2データへのリンクを伴って格納される。図15においては、このリンクは、テキストデータがMPEG2データと同じ縦列に格納されることによって表されている。話をしていない参加者からは格納すべきテキストデータが得られないことは理解されるであろう。図15に示す例では、参加者1については初めの10個のタイムスロットにテキストが格納され(206で示す)、参加者3については12番目から20番目のタイムスロットに格納され(208で示す)、参加者4については21番目のタイムスロットに格納されている(210で示す)。この例では、参加者2は図15に示すタイムスロットの間は話をしていないので、参加者2のテキストは格納されていない。

【0135】

ステップS94では、アーカイブプロセッサ58は、ステップS80で現在フレームについて参加者ごとに生成された視線パラメータ値を会議アーカイブデータベース60に格納する(図15には212で示す)。図15を参照すると、視線パラメータ値は、参加者ごとに、関連するMPEG2データ202及び関連するテキストデータ204へのリンクと共に格納されている(このリンクは、図15では、視線パラメータ値が関連するMPEG2データ202及び関連するテキストデータ204と同じ縦列にあることによって表されている)。従って、一例として、図15の第1のタイムスロットに関していえば、参加者1の視線パラメータ値は、参加者1が参加者3を見ていることを指示する3であり、参加者2の視線パラメータ値は、参加者2がフリップチャート14を見ていることを指示する5であり、参加者3の視線パラメータ値は、参加者3が参加者1を見ていることを指示する1であり、参加者4の視線パラメータ値は、参加者4が他の参加者の誰も見ていないことを指示する「0」である(図1に示す例では、12で示される参加者は他の参加者ではなく、自分のメモを見ている)。

【0136】

ステップS96では、中央制御装置36及びアーカイブプロセッサ58は、会議の参加者の1人が話を止めたか否かを判定する。この実施形態においては、この検査は、所定の参加者のテキストデータが直前のタイムスロットには存在したが、現在タイムスロットには存在しないことを判定するためにテキストデータ204を検査することにより実行される。いずれかの参加者についてこの条件が満たされれば(すなわち、参加者が話を止めていれば)、ステップS98で、アーカイブプロセッサ58は、話を止めた参加者ごとに、先にステップS86を実行したときに格納されていた視線パラメータ値を処理し(それらの視線パラメータ値は、この時点で止まった話をしていた期間中にその参加者が誰を又は何を見ていたかを定義する)、視線ヒストグラムを定義するデータを生成する。すなわち、参加者が話をしていた期間の視線パラメータ値を処理して、その期間中に話者である参加者がその他の参加者及び物体のそれぞれを見ていた時間の割合(%)を定義するデータを生成するのである。

【0137】

図16A及び図16Bは、図15のテキスと206及び208の期間にそれぞれ相当する視線ヒストグラムを示す。

【0138】

図15及び図16Aを参照すると、参加者1が話していた期間206の間、参加者1は、図16に300で示すように、10個のタイムスロットのうち6個のタイムスロット(すなわち、参加者が話をしていた期間全体の長さの60%)にわたり参加者3を見ており、図16Aに310で示すように、10個のタイムスロットのうち4個のタイムスロット(すなわち、時間の40%)にわたり参加者4を見ていた。

【0139】

同様に、図15及び図16Bを参照すると、期間208の間、参加者3は、図16Bに320で示すように、時間の約45%にわたり参加者1を見ており、図16Bに330で示すように、時間の約33%にわたり物体5(すなわち、フリップチャート14)を見ており、図16Bに340で示すように、時間の約22%にわたり参加者2を見ていた。

【0140】

再び図8に戻ると、ステップS100では、ステップS98で生成した各視線ヒストグラムを、それを生成する元になったテキストの関連する期間とリンクさせて、会議アーカイブデータベース60に格納する。図15を参照すると、格納される視線ヒストグラムは214で示され、テキスト期間206のヒストグラムを定義するデータは216で示され、テキスト期間208のヒストグラムを定義するデータは218で示されている。図15においては、視線ヒストグラムと関連するテキストとのリンクは、視線ヒストグラムがテキストデータと同じ縦列に格納されることにより表されている。

【0141】

他方、ステップS96で、現在時限について参加者の1人が話を止めていないと判定された場合には、ステップS98及びS100を省略する。

【0142】

ステップS102では、アーカイブプロセッサ58は、映像フレームの直前フレーム(すなわち、ステップS80からS100でデータが生成、格納されたばかりのフレームの直前のフレーム)及び他の先行フレームについて、会議アーカイブデータベース60に格納されているデータを必要に応じて修正する。

【0143】

図17は、ステップS102でアーカイブプロセッサ58により実行される処理動作を示す。

【0144】

図17を参照すると、ステップS190では、アーカイブプロセッサ58は、次の先行フレーム(初めてステップS190を実行する場合には、これは現在フレームの直前のフレームであり、すなわち、現在フレームが「i」番目のフレームであれば、「i−1」番目のフレームである)について、話者に「なりうる」参加者のデータを会議アーカイブデータベース60に格納するかどうかを判定する。

【0145】

ステップS190で、考慮されている先行フレームについて話者に「なりうる」参加者のデータが格納されていないと判定されれば、会議アーカイブデータベース60のデータを修正する必要はない。

【0146】

他方、ステップS190で、考慮されている先行フレームについて話者に「なりうる」参加者のデータが格納されていると判定された場合には、ステップS192で、アーカイブプロセッサ58は、先行フレームについてデータが格納された話者に「なりうる」参加者の1人が現在フレームについて識別された話者である参加者(話者に「なりうる」参加者ではない)、すなわち、図12のステップS146で識別された話者である参加者と同1人物であるか否かを判定する。

【0147】

ステップS192で、先行フレームの話者に「なりうる」参加者がいずれも現在フレームについてステップS146で識別された話者である参加者と同じではないと判定されれば、考慮されている先行フレームについて会議アーカイブデータベース60に格納されているデータの修正を実行しない。

【0148】

他方、ステップS192で、先行フレームの話者に「なりうる」参加者が現在フレームについてステップS146で識別された話者である参加者と同1人物であると判定された場合には、ステップS194で、アーカイブプロセッサ58は、現在フレームの話者である参加者と同じではない話者に「なりうる」参加者のそれぞれについて、考慮されている先行フレームのテキストデータ204を会議アーカイブデータベース60から削除する。

【0149】

以上説明したようにステップS190、S192及びS194の処理を実行することにより、現在フレームについて画像データ及び音声データを処理することによって話者が明確に識別された場合、現在フレームの話者は先行フレームの話者と同1人物であるという仮定を利用して、話者に「なりうる」参加者(すなわち、曖昧さなく話者を識別することが不可能であったため)について格納された直前フレームのデータを更新するのである。

【0150】

ステップS194を実行した後、次の先行フレームについてステップS190からS194を繰り返す。すなわち、現在フレームが「i」番目のフレームであれば、初めてステップS190からS194を実行するときに「i−1」番目のフレームを考慮し、2度目にステップS190からS194を実行するときには「i−2」番目のフレームを考慮する。これ以降も同様である。ステップS190で、考慮されている先行フレームについて話者に「なりうる」参加者のデータが格納されていないと判定されるか、またはステップS192で、考慮されている先行フレームにおける話者に「なりうる」参加者がいずれも現在フレームについて曖昧さなく識別された話者である参加者と同じではないと判定されるまで、ステップS190からS194を繰り返し実行し続ける。このようにして、いくつかの連続するフレームにわたり話者に「なりうる」参加者が識別された場合には、次のフレームで話者に「なりうる」参加者の中から実際の話者である参加者が識別されれば、会議アーカイブデータベースに格納されているデータを修正する。

【0151】

再び図8に戻ると、ステップS104では、中央制御装置36は、カメラ2−1、2−2、2−3から映像データの別のフレームが受信されたか否かを判定する。カメラ2−1、2−2、2−3から画像データが受信されている間は、ステップS80からS104を繰り返し実行する。

【0152】

会議アーカイブデータベース60にデータが格納されている場合、会議アーカイブデータベース60を問い合わせて、会議に関連するデータを検索しても良い。

【0153】

図18は、ユーザにより指定される探索基準を満たす会議の各部分に関連するデータを検索する目的で会議アーカイブデータベース60を探索するために実行される処理動作を示す。

【0154】

図18を参照すると、ステップS200では、中央制御装置36は表示プロセッサ64に、要求する会議アーカイブデータベース60の探索を定義する情報をユーザが入力することを求めるメッセージを表示装置26に表示させる。すなわち、この実施形態においては、中央制御装置36は図19Aに示す表示を表示装置26に表示させる。

【0155】

図19Aを参照すると、ユーザは、会議アーカイブデータベース60の中で見出すことを臨む会議の部分を定義する情報を入力することを求められる。すなわち、この実施形態においては、ユーザは、話をしていた参加者を定義する情報400、情報400の中で識別される参加者が口に出した1つ又は複数のキーワードから成る情報410、及び情報400の中で識別される参加者が話している間に見ていた参加者又は物体を定義する情報420を入力することを求められる。更に、ユーザは、探索を実行すべき会議の部分を定義する時間情報を入力することができる。すなわち、ユーザは、その時間を越えたら探索を中止すべきである会議中の時間(すなわち、指定される時間に至るまでの会議の期間を探索すべきである)を定義する情報430と、その時間から探索を実行すべきである会議中の時間を定義する情報440と、探索を実行すべき期間の開始時間と終了時間をそれぞれ定義する情報450及び460とを入力できる。この実施形態においては、情報430、440、450及び460は、例えば、分単位で絶対期限として時間を指定するか、又は会議時間全体に占める割合を指示する小数値を入力することにより相対期限で時間を指定することにより入力されれば良い。例えば、情報430として値0.25を入力した場合、探索は会議の初めの四分の一に限定されるであろう。

【0156】

この実施形態では、ユーザは1回の探索で情報400、410及び420の全てを入力する必要はなく、この情報のうち1つ又は2つを省いても良い。ユーザが情報400、410及び420の全てを入力すれば、会議の中で、情報400の中で識別される参加者が情報420の中で識別される参加者又は物体に向かって話していた部分及び情報400の中で識別される参加者が情報410の中で定義されるキーワードを話した部分をそれぞれ識別するための探索が実行されることになる。これに対し、情報410を省いた場合には、会議の中で、情報400の中で識別される参加者が何を言ったかに関わらず、情報420の中で定義される参加者又は物体に向かって話していた部分をそれぞれ識別するための探索が実行される。情報410及び420を省いた場合には、会議の中で、情報400の中で識別される参加者が何を誰に向かって話したかに関わらず、話していた部分をそれぞれ識別するための探索が実行される。情報400を省いた場合には、会議の中で、いずれかの参加者が情報420の中で定義される参加者又は物体を見ながら情報410の中で定義されるキーワードを話した部分をそれぞれ識別するための探索が実行される。情報400及び410を省いた場合には、会議の中で、いずれかの参加者が情報420の中で定義される参加者又は物体に向かって話した部分をそれぞれ識別するための探索が実行される。情報420を省いた場合には、会議の中で、情報400の中で定義される参加者が情報410の中で定義されるキーワードを誰に向かって話したかに関わらず、キーワードを話した部分をそれぞれ識別するための探索が実行される。同様に、情報400及び420を省いた場合には、会議の中で、誰が誰に向かって言ったかに関わらず、情報410の中で識別されるキーワードが話された部分をそれぞれ識別するための探索が実行される。

【0157】

更に、ユーザは時間情報430、440、450及び460の全てを入力しても良いし、あるいはそのうちいくつかを省いても良い。

【0158】

また、探索者が言葉の組み合わせ又はある言葉に代わる言葉を探索できるようにするために、情報410の中で入力されるキーワードと組み合わせて周知のブール演算子及び探索アルゴリズムを使用しても良い。

【0159】

探索を定義するためにユーザが必要な全ての情報を入力したならば、マウス30などのユーザ入力装置を使用して領域470をクリックすることにより探索を開始する。

【0160】

再び図18に戻ると、ステップS202では、ユーザが入力した探索情報を中央制御装置36により読み取り、命令された探索を実行する。すなわち、この実施形態においては、中央制御装置36は情報400又は420の中で入力された参加者又は物体の名前をテーブル80(図4)を使用して識別番号に変換し、情報400で定義される参加者(情報400が入力されなかった場合は全ての参加者)についてテキスト情報204を考慮する。ユーザにより情報420が入力されていれば、テキストの期間ごとに、中央制御装置36は対応する視線ヒストグラムを定義するデータを検査して、情報420の中で定義される参加者又は物体のヒストグラムにおける注目時間の割合がこの実施形態では25%である閾値以上であるか否かを判定する。このように、話者である参加者が話をしている時間の少なくとも25%にわたって情報420の中で定義される参加者又は物体を見ていれば、話者である参加者が話しの間に他の参加者又は物体を見たとしても、話し言葉(テキスト)の各期間を考慮して、情報400の中で定義される参加者は情報420の中で定義される参加者又は物体に話しかけていたという基準を満たす。従って、例えば、情報420の中で2人以上の参加者が識別されていれば、視線ヒストグラムの値が2人以上の参加者について25%以上であるような話の期間が識別されるであろう。ユーザが情報410を入力した場合、中央制御装置36及びテキストサーチャ62は、先に情報400及び420に基づいて識別されたテキストの各部分(情報400及び420が入力されていなければ、テキストの全ての部分)を探索して、情報410の中で定義されるキーワードを含む各部文を識別する。ユーザが時間情報を入力していれば、上記の探索はそれらの期限により定義される会議時間に限られる。

【0161】

ステップS204では、中央制御装置36は表示プロセッサ64に、探索中に識別された関連話題のリストを表示装置26を介してユーザに対し表示させる。すなわち、中央制御装置36は、図19Bに示すような情報をユーザに対し表示させる。図19Bを参照すると、探索パラメータを満足させる各々の話題のリストが作成され、その話の開始時間を定義する情報が絶対期限と、会議時間全体に占める割合の双方で表示されている。そこで、ユーザは、例えば、リスト中の必要な話題をマウス30を使用してクリックすることにより、話題の1つを選択して、再生させることができる。

【0162】

ステップS206では、中央制御装置36はステップS204でユーザが行った選択を読み取り、格納されている会議の関連部分のMPEG2データ202を会議アーカイブデータベース60から再生させる。すなわち、中央制御装置36及び表示プロセッサ64はMPEG2データ202を復号し、画像データと音声を表示装置26を介して出力するのである。再生すべき話の一部又は全てについて2台以上のカメラからの画像データが格納されている場合には、そのことを表示装置26によりユーザに指示し、ユーザは、例えば、キーボード28を使用して中央制御装置36に命令を入力することにより、再生すべき画像データを選択することができる。

【0163】

ステップS208では、中央制御装置36は、ユーザが会議アーカイブデータベース60の問い合わせを中止することを望むか否かを判定し、望まないのであれば、ステップS200からS208を繰り返す。

【0164】

以上説明した本発明の実施形態に対しては、様々な変形や変更を実施することができる。

【0165】

上記の実施形態では、ステップS34(図3)及びステップS70(図7)においては、会議中の各参加者の頭部を追跡していた。しかし、これに加えて、ステップS4及びS26でデータを格納した物体が移動する場合(そのような物体としては、例えば、参加者により回覧されるようなメモ又は参加者間で手渡されるべき物体などが考えられる)それらの物体を追跡することも可能であろう。

【0166】

上記の実施形態では、複数台のビデオカメラ2−1、2−2、2−3からの画像データを処理していた。しかし、その代わりに、1台のビデオカメラからの画像データを処理しても良い。この場合、例えば、ステップS42−1(図5)のみを実行し、ステップS42−2からS42−nを省略する。同様に、ステップS44を省略し、ステップS42−1で実行される処理の間、画像データの現在フレームに関わる参加者の頭部の3D位置及び向きをステップS58(図6)で判定される3D位置及び向きであるとみなす。ステップS46では、カルマンフィルタに入力される頭部の特徴の位置はその1台のカメラからの画像データにおける位置になるであろう。更に、会議アーカイブデータベース60に画像データを記録すべきカメラを選択するためのステップS89(図8)も省略されるであろう。

【0167】

上記の実施形態では、ステップS168(図13)において、話者である参加者と、話者である参加者が見ている参加者又は物体とを最も良く捉えるカメラを識別するための処理を実行していた、しかし、上記の実施形態において説明したようにカメラを識別する代わりに、処理装置24の初期設定中に、会議テーブルを囲む2つずつの着席位置を最も良く捉え且つ/又は各々の着席位置と所定の物体(フリップチャート14など)を最も良く捉えるのはカメラ2−1、2−2、2−3のうちどれであるかをユーザが定義することも可能である。このようにして、話者である参加者と、話者である参加者が見ている参加者があらかじめ定義された着席位置にいると判定されれば、それらのあらかじめ定義された着席位置を最も良く捉えるとユーザにより定義されたカメラを画像データを格納すべきカメラとして選択することができる。同様に、話者である参加者があらかじめ定義された位置にあり且つある物体を見ている場合、そのあらかじめ定義された着席位置と物体を最も良く捉えるとユーザにより定義されたカメラを画像データを格納すべきカメラとして選択することができる。

【0168】

上記の実施形態では、ステップS162(図13)において、直前フレームで画像データが格納されたカメラとしてデフォルトカメラを選択していた。しかし、その代わりに、例えば、処理装置24の初期設定中に、ユーザがデフォルトカメラを選択しても良い。

【0169】

上記の実施形態では、ステップS194(図17)において、その時点で実際には話者である参加者として識別されなかった話者に「なりうる」参加者について、テキストデータ204を会議アーカイブデータベース60から削除していた。しかし、これに加えて、関連する視線ヒストグラムデータ214も共に削除して良い。更に、カメラ2−1、2−2、2−3のうち2台以上からのMPEG2データ202が格納されていた場合、話者に「なりうる」参加者に関連するMPEG2データも削除して良い。

【0170】

上記の実施形態では、話者である参加者を一意性をもって識別することが不可能である場合、話者に「なりうる」参加者を定義し、話者になりうる参加者についてデータを処理して会議アーカイブデータベース60に格納し、その後、会議アーカイブデータベース60に格納されたデータを修正していた(図8のステップS102)。しかし、話者に「なりうる」参加者についてデータを処理し、格納するのではなく、カメラ2−1、2−2及び2−3から受信した映像データと、マイクロホンアレイ4から受信した音声データとを、後続フレームに関連するデータから話者である参加者が識別されたときの後の処理及びアーカイビングに備えて格納しておいても良い。あるいは、ステップS144(図12)で実行された処理の結果、音声が来ている方向に2人以上の参加者がいることが指示された場合には、カメラ2−1、2−2及び2−3からの画像データを処理して、参加者の唇の動きを検出すると共に、音声が来ている方向にいて、唇が動いている参加者を話者である参加者として選択しても良い。

【0171】

上記の実施形態では、各人物の頭部の位置と、各人物の頭部の向きと、各人物が誰を又は何を見ているかを定義する人物ごとの視線パラメータとを判定するための処理を実行していた。その後、画像データのフレームごとに、各人物の視線パラメータ値を会議アーカイブデータベース60に格納する。しかし、全ての人物について視線パラメータを判定する必要はない。例えば、話者である参加者のみの視線パラメータを判定し、画像データのフレームごとにこの視線パラメータ値のみを会議アーカイブデータベース60に格納することは可能である。従って、この場合、話者である参加者の頭部の位置を判定するだけで良いであろう。このようにすれば、処理及び格納に課される負担を軽減することができる。

【0172】

上記の実施形態では、ステップS202(図18)において、テキストの特定の部分の視線ヒストグラムを考慮し、その視線ヒストグラムにおいて別の参加者又は物体に注目している時間の割合が所定の閾値以上である場合に、参加者は別の参加者と話していた又は別の物体を見ていたと判定していた。しかし、閾値を使用する代わりに、テキスト(話)の期間中、話者である参加者が見ていた参加者又は物体は、視線ヒストグラムの中で最も大きな割合の注目時間を有する参加者又は物体(例えば、図16Aの参加者3及び図16Bの参加者1)であると定義しても良い。

【0173】

上記の実施形態では、カメラ2−1、2−2及び2−3と、マイクロホンアレイ4とからデータが受信されている間、MPEG2データ202、テキストデータ204、視線パラメータ212及び視線ヒストグラム214をリアルタイムで会議アーカイブデータベース60に格納していた。しかし、その代わりに、映像データと音声データを格納し、リアルタイムではなくデータ202、204、2120及び214を生成して、会議アーカイブデータベース60に格納しても良い。

【0174】

上記の実施形態では、会議の定義された部分についてデータを検索するために会議アーカイブデータベース60を問い合わせる前に、MPEG2データ202、テキストデータ204、視線パラメータ212及び視線ヒストグラム214を生成し、データベースに格納していた。しかし、探索の要求に先立ってデータを生成、格納するのではなく、会議アーカイブデータベース60の探索がユーザにより要求されるのに応答して、既に会議アーカイブデータベース60に格納されているデータを処理することにより、視線ヒストグラムデータ214の一部又は全てを生成しても良い。例えば、上記の実施形態では、視線ヒストグラム214はステップS98及びS100(図8)でリアルタイムで計算、格納されていたが、ユーザにより入力される探索要求に応答してそれらのヒストグラムを計算しても良い。

【0175】

上記の実施形態では、テキストデータ204は会議アーカイブデータベース60に格納されていた。テキストデータ204の代わりに、音声データを会議アーカイブデータベース60に格納しても良い。その場合、格納された音声データ自体を音声認識処理を利用してキーワードを求めて探索しても良いし、あるいは音声認識処理を利用して音声データをテキストに変換し、従来のテキストサーチャを使用してそのテキストを探索しても良い。

【0176】

上記の実施形態では、処理装置24は、アーカイブすべきデータを受信し、生成するための機能構成要素(例えば、中央制御装置36、頭部追跡装置50、頭部モデル記憶装置52、方向プロセッサ53、音声認識プロセッサ54、音声認識パラメータ記憶装置56及びアーカイブプロセッサ58)と、アーカイブデータを格納するための機能構成要素(例えば、会議アーカイブデータベース60)と、データベースを探索し、そこから情報を検索するための機能構成要素(例えば、中央制御装置36及びテキストサーチャ62)とを含む。しかし、これらの機能構成要素を別個の装置に設けても良い。例えば、アーカイブすべきデータを生成する1つ又は複数の装置と、データベースを探索する1つ又は複数の装置とをインターネットなどのネットワークを介して1つ又は複数のデータベースに接続しても良い。

【0177】

また、図20を参照して説明すると、1つ又は複数の場所での会議500、510、520から得られた映像データと音声データをデータ処理・データベース記憶装置530(アーカイブデータを生成し、格納するための機能構成要素を具備する)に入力し、データベースを問い合わせて、そこから情報を検索するために、1つ又は複数のデータベース問い合わせ装置540、550をデータ処理・データベース記憶装置530に接続しても良い。

【0178】

上記の実施形態では、プログラミング命令により定義される処理ルーチンを使用して、コンピュータにより処理を実行していた。しかし、処理の一部又は全てをハードウェアを使用して実行することも可能であろう。

【0179】

複数の参加者の間で行われる会議に関して上記の実施形態を説明したが、本発明はこの用途には限定されず、フィルムセットについて画像データ及び音声データを処理するなどの他の用途にも適用することができる。

【0180】

上記の変形の異なる組み合わせも言うまでもなく可能であり、本発明の趣旨から逸脱せずにその他の変更や変形を実施することができる。

【0181】

<第2の実施形態>

図21を参照すると、この実施形態では、1台のビデオカメラ602と、1つ又は複数のマイクロホン604とを使用して、複数の人物606、608、610、612の間で行われている会議から画像データと音声データをそれぞれ記録している。

【0182】

ビデオカメラ602からの画像データと、マイクロホン604からの音声データはケーブル(図示せず)を介してコンピュータ620に入力され、コンピュータ620は受信したデータを処理し、データをデータベースに格納して、会議のアーカイブ記録を作成する。後に、このデータベースから情報を検索することができる。

【0183】

コンピュータ620は、従来のように、表示装置626や、この実施形態においてはキーボード628及びマウス630であるユーザ入力装置と共に、1つ又は複数のプロセッサ、メモリ、サウンドカードなどを含む処理装置624を有する従来通りのパーソナルコンピュータである。

【0184】

コンピュータ620の構成要素と、それらの構成要素に対し入出力されるデータの流れを図22に概略的に示す。

【0185】

図22を参照すると、処理装置624は、例えば、ディスク632などのデータ記憶媒体に格納されたデータとして及び/又は例えば、インターネットなどの通信ネットワーク(図示せず)を介する送信又は大気中を通る送信により遠隔データベースから処理装置624に入力され且つ/又はキーボード628などのユーザ入力装置又は他の入力装置を介してユーザにより処理装置624に入力される信号634として入力されるプログラミング命令に従って動作するようにプログラムされている。

【0186】

プログラミング命令によりプログラムされると、処理装置624は処理動作を実行するための複数の機能ユニットとして有効に構成される。そのような機能ユニットの例と、それらの配線を図22に示す。しかし、図22に示すユニットと配線は概念上のものであり、単に理解を助けるために例示を目的として示されているにすぎない。従って、図22の機能ユニット及び配線は、処理装置624のプロセッサ、メモリなどが実際に構成される厳密なユニットや接続関係を必ずしも表してはいない。

【0187】

図22に示す機能ユニットに関して説明すると、中央制御装置636はユーザ入力装置628,630からの入力を処理し、且つユーザによりディスク638などの記憶装置に格納されたデータとして又は処理装置624へ送信される信号640として処理装置624に入力されるデータを受信する。また、中央処理装置636はその他の複数の機能ユニットに対して制御及び処理を実行する。メモリ642は、中央制御装置636及びその他の機能ユニットにより使用されるべきメモリである。

【0188】

頭部追跡装置650はビデオカメラ602から受信した画像データを処理して、会議中の各々の参加者606、608、610,612の頭部の位置と向きを三次元で追跡する。この実施形態では、この追跡を実行するために、頭部追跡装置650は各々の参加者の頭部の三次元コンピュータモデルを定義するデータと、頭部の特徴を定義するデータとを使用する。それらのデータは、後述するように、頭部モデル記憶装置652に格納される。

【0189】

音声認識プロセッサ654はマイクロホン604から受信される音声データを処理する。音声認識プロセッサ654は、「Dragon Dictate」又はIBMの「ViaVoice」などの従来の音声認識プログラムに従って動作し、参加者606、608、610、612により話された言葉に対応するテキストデータを生成する。音声認識処理を実行するために、音声認識プロセッサ654は、参加者606、608、610、612ごとの音声認識パラメータを定義するデータを使用する。このデータは音声認識パラメータ記憶装置656に格納される。すなわち、音声認識パラメータ記憶装置656に格納されるデータは、音声認識プロセッサを従来の方式で訓練することにより生成される各参加者の音声プロファイルを定義するデータである。例えば、このデータは、訓練後にDragon Dictateの「ユーザファイル」に格納されるデータである。

【0190】

アーカイブプロセッサ658は、頭部追跡装置650及び音声認識プロセッサ654から受信したデータを使用して、会議アーカイブデータベース660に格納すべきデータを生成する。すなわち、後述するように、カメラ602からの映像データとマイクロホン604からの音声データを、音声認識プロセッサ654からのテキストデータ及び会議中の各参加者が所定の時点で誰を見ていたかを定義するデータと共に会議アーカイブデータベース660に格納するのである。

【0191】

テキストサーチャ662は、中央制御装置636と関連して、会議アーカイブデータベース660を探索して、後に更に詳細に説明するように、ユーザにより指定される探索基準に適合する会議の1つ又は複数の部分に対応する音声データと映像データを見出し、再生するために使用される。

【0192】

表示プロセッサ664は、中央制御装置636の制御の下に、表示装置626を介してユーザに情報を表示すると共に、会議アーカイブデータベース660に格納されている音声データと映像データを再生する。

【0193】

出力プロセッサ666はアーカイブデータベース660からのデータの一部又は全てを、例えば、ディスク668などの記憶装置へ出力するか、又は信号670として出力する。

【0194】

会議を始める前に、処理装置624が要求される処理動作を実行できるようにするために必要なデータを入力することによりコンピュータ620を初期設定しなければならない。

【0195】

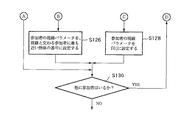

図23は、この初期設定中に処理装置624により実行される処理動作を示す。

【0196】

図23を参照すると、ステップS302では、中央制御装置636は表示プロセッサ664に、ユーザが会議に参加する各人物の名前を入力することを要求するメッセージを表示装置626に表示させる。

【0197】

ステップS304では、中央制御装置636は、例えば、ユーザがキーボード628を使用して入力した名前を定義するデータを受信すると、各参加者に独自の参加者番号を割り当て、参加者番号と参加者の名前との関係を定義するデータ、例えば、図24に示すテーブル680を会議アーカイブデータベース660に格納する。

【0198】

ステップS306では、中央制御装置636は頭部モデル記憶装置652を探索して、会議の参加者ごとに頭部モデルを定義するデータが既に格納されているか否かを判定する。

【0199】

ステップS306で、1人又は2人以上の参加者について頭部モデルがまだ格納されていないと判定されれば、ステップS308で、中央制御装置636は表示プロセッサ664に、モデルがまだ格納されていない各参加者の頭部モデルを定義するデータをユーザが入力することを要求するメッセージを表示装置626に表示させる。

【0200】

これに応答して、ユーザは、例えば、ディスク638などの記憶媒体に格納されたデータとして要求された頭部モデルを定義するデータを入力するか、又は接続している処理装置から信号640としてこのデータをダウンロードすることによりデータを入力する。そのような頭部モデルは、例えば、Valente他の「An Analysis/Synthesis Cooperation for Head Tracking andVideo Face Cloning」(ProceedingsECCV’98Workshop on Perceptionof Human Action、ドイツ、フライブルク大学、1998年6月6日に掲載)に記載されているような従来の方式で生成されれば良い。

【0201】

ステップS310では、中央制御装置636は、ユーザにより入力されたデータを頭部モデル記憶装置652に格納する。

【0202】

ステップS312では、中央制御装置636及び表示プロセッサ664は、ユーザにより入力された各々の三次元コンピュータ頭部モデルをレンダリングして、ユーザが各モデルにおいて少なくとも7つの特徴を識別することを要求するメッセージと共に、モデルをユーザに対し表示装置626を介して表示する。

【0203】

これに応答して、ユーザは、マウス630を使用して、参加者の頭部の正面、側面及び(可能であれば)背面にある顕著な特徴、例えば、目尻、鼻孔、口、耳又は参加者がかけている眼鏡の特徴などに対応する点を各モデルで指定する。

【0204】

ステップS314では、中央制御装置636はユーザにより定義された特徴を頭部モデル記憶装置652に格納する。

【0205】

他方、ステップS306で、参加者ごとに頭部モデルが頭部モデル記憶装置652に既に記憶されていると判定された場合には、ステップS308からS314を省略する。

【0206】

ステップS316では、中央制御装置636は音声認識パラメータ記憶装置656を探索して、参加者ごとに音声認識パラメータが既に格納されているか否かを判定する。

【0207】

ステップS316で、一部の参加者について音声認識パラメータを利用できないと判定されれば、ステップS318で、中央制御装置636は表示プロセッサ664に、パラメータがまだ格納されていない各参加者についてユーザが音声認識パラメータを入力することを要求するメッセージを表示装置626に表示させる。

【0208】

これに応答して、ユーザは、例えば、ディスク638などの記憶媒体に格納されたデータとして又は遠隔処理装置からの信号640として、必要な音声認識パラメータを定義するデータを入力する。先に述べた通り、これらのパラメータはユーザの音声のプロファイルを定義し、音声認識プロセッサを従来の方式で訓練することにより生成される。従って、例えば、Dragon Dictateを組み込んだ音声認識プロセッサの場合、ユーザにより入力される音声認識パラメータはDragon Dictateの「ユーザファイル」に格納されたパラメータに相当する。

【0209】

ステップS320では、中央制御装置636は、ユーザにより入力されたデータを音声認識パラメータ記憶装置656に格納する。

【0210】

他方、ステップS316で、参加者ごとに音声認識パラメータが既に利用可能な状態になっていると判定された場合には、ステップS318及びS320を省略する。

【0211】

ステップS322では、中央制御装置636は表示プロセッサ664に、ユーザがカメラ602の校正を可能にするためのステップを実行することを要求するメッセージを表示装置626に表示させる。

【0212】

これに応答して、ユーザは必要なステップを実行し、ステップS324では、中央制御装置636はカメラ602を校正するための処理を実行する。すなわち、この実施形態においては、ユーザにより実行されるステップ及び中央制御装置636により実行される処理は、Wiles及びDavisonの「Calibrating and3D Modelling with a Multi−Camera System」(1999IEEE Workshop on Multi−View Modelling and Analysis of Visual Scenes、ISBN 0769501109に掲載)に記載されているような方式で実行される。これにより、会議室に対するカメラ602の位置と向きを定義する校正データと、カメラの固有パラメータ(横縦比、焦点距離、主点及び一次半径方向ひずみ係数)とが生成される。校正データはメモリ642に格納される。

【0213】

ステップS326では、中央制御装置636は表示プロセッサ664に、会議の次の参加者(初めてステップS326を実行する場合には、これは最初の参加者である)が着席することを要求するメッセージを表示装置626に表示させる。

【0214】

ステップS328では、要求された参加者に着席する時間を与えるために、処理装置624は所定の時間待機し、その後、ステップS330で、中央制御装置636はカメラ602からの画像データを処理して、着席した参加者の頭部の推定位置を判定する。すなわち、この実施形態においては、中央制御装置636は、参加者の肌の色に対応する色(この色は、頭部モデル記憶装置652に格納されている参加者の頭部モデルを定義するデータから判定される)を有する、カメラ602からの画像データの1フレーム中の各部分を識別するために従来通りの処理を実行し、次に、会議室内の最も高い位置に相当する部分を選択する(頭部は人体の中で最も高い位置にある肌色の部分であると想定されるため)。画像中の識別された部分の位置と、ステップS324で判定されたカメラ校正パラメータとを使用して、中央制御装置636は従来の方式により頭部の三次元推定位置を判定する。

【0215】

ステップS332では、中央制御装置636は参加者の頭部の三次元推定向きを判定する。すなわち、この実施形態においては、中央制御装置636は頭部モデル記憶装置652に格納されている参加者の頭部の三次元コンピュータモデルを複数の異なる向きについてレンダリングして、向きごとにそれぞれ対応するモデルの二次元画像を生成し、モデルの各二次元画像を参加者の頭部を示す、カメラ602からの映像フレームの部分と比較し、モデルの画像が映像データと最も良く整合する向きを選択する。この実施形態では、参加者の頭部のコンピュータモデルを108の異なる向きでレンダリングして、カメラ602からの映像データと比較すべき画像データを生成する。これらの向きは頭部モデルを0°(正面を向いている)、+45°(上を向いている)及び−45°(下を向いている)に相当する3つの頭部の傾きのそれぞれについて10°ずつのステップで36回回転させた向きに相当する。頭部モデルをレンダリングすることにより生成された画像データをカメラ602からの映像データと比較するときには、例えば、Schodl、Haro及びEssaの「Head Tracking Using a Textured Polygonal Model」(Proceedings1998Workshop on Perceptual User Interfacesに掲載)に記載されているような従来の技法を使用する。

【0216】

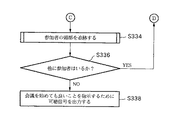

ステップS334では、ステップS330で生成した参加者の頭部の推定位置と、ステップS332で生成した参加者の頭部の推定向きとを頭部追跡装置650に入力し、カメラ602から受信した画像データのフレームを処理して、参加者の頭部を追跡する。すなわち、この実施形態においては、頭部追跡装置650は、例えば、Valente他の「An Analysis/Synthesis Cooperation for Head Tracking andVideo Face Cloning」(ProceedingsEECV’98Workshop on Perceptionof Human Action、ドイツ、フライブルク大学、1998年6月6日)に記載されているような従来の方式で頭部を追跡するための処理を実行する。

【0217】

図25は、ステップS334で頭部追跡装置650により実行される処理動作の概要を示す。

【0218】

図25を参照すると、ステップS350では、頭部追跡装置650は参加者の頭部の現在推定3D位置及び現在推定3D向きを読み取る。ステップS350を初めて実行する場合には、これらは図23のステップS330及びS332で生成される推定位置及び推定向きである。

【0219】

ステップS352では、頭部追跡装置650はステップS324で生成されたカメラ校正データを使用して、頭部モデル記憶装置652に格納されている参加者の頭部の三次元コンピュータモデルをステップS350で読み取った推定位置及び推定向きに従ってレンダリングする。

【0220】

ステップS354では、頭部追跡装置650はカメラ602から受信された映像データの現在フレームについて画像データを処理し、ユーザにより識別され、ステップS314で格納された頭部の特徴のうち1つの特徴の期待位置を取り囲む各々の領域から画像データを取り出す。それらの期待位置は、ステップS350で読み取った推定位置及び推定向きと、ステップS324で生成されたカメラ校正データとから判定される。

【0221】

ステップS356では、頭部追跡装置650はステップS352でレンダリングし、生成した画像データと、ステップS354で取り出したカメラ画像データとを整合し、レンダリングされた頭部モデルに最も良く整合するカメラ画像データを見出す。

【0222】

ステップS358では、頭部追跡装置650は、ステップS356でレンダリングされた頭部モデルに最も良く整合すると識別されたカメラ画像データを使用して、映像データの現在フレームについて参加者の頭部の3D位置及び3D向きを判定する。

【0223】

ステップS358を実行するのと同時に、ステップS360では、ステップS356で判定されたカメラ画像データにおける頭部の特徴の位置を従来のカルマンフィルタに入力して、映像データの次のフレームについて参加者の頭部の推定3D位置及び推定3D向きを生成する。ビデオカメラ602から映像データのフレームが受信されている間、その参加者についてステップS350からS360を繰り加し実行する。

【0224】

再び図23に戻ると、ステップS336では、中央制御装置636は会議に他の参加者がいるか否かを判定し、参加者ごとに先に説明したように処理が実行され終わるまでステップS326からS336を繰り返す。しかし、参加者ごとにこれらのステップを実行している間、ステップS334では、頭部追跡装置650は既に着席した各参加者の頭部を追跡し続けている。

【0225】

ステップS336で、会議にそれ以上の参加者はなく、従って、各参加者の頭部が頭部追跡装置650により追跡されていることが判定されると、ステップS338で、中央制御装置636は、参加者間で会議を始めて良いことを指示するために、処理装置624から可聴信号を出力させる。

【0226】

図26は、参加者間で会議が行われている間に処理装置624により実行される処理動作を示す。

【0227】

図26を参照すると、ステップS370では、頭部追跡装置650は会議中の各参加者の頭部を追跡し続ける。ステップS370で頭部追跡装置650により実行される処理は、先にステップS334に関して説明した処理と同じであるので、ここでは説明を省略する。

【0228】

頭部追跡装置650がステップS370で各参加者の頭部を追跡しているのと同時に、ステップS372では、データを生成し、会議アーカイブデータベース660にデータを格納するための処理を実行する。

【0229】

図27は、ステップS372で実行される処理動作を示す。

【0230】

図27を参照すると、ステップS380では、アーカイブプロセッサ658は、参加者が誰を見ているかを定義するいわゆる「視線パラメータ」を参加者ごとに生成する。

【0231】

図28は、ステップS380で実行される処理動作を示す。

【0232】

図28を参照すると、ステップS410では、アーカイブプロセッサ658は各参加者の頭部の現在三次元位置を頭部追跡装置650から読み取る。これは、ステップS358(図25)で頭部追跡装置650により実行される処理において生成された位置である。

【0233】

ステップS412では、アーカイブプロセッサ658は次の参加者(初めてステップS412を実行する場合には、これは最初の参加者である)の頭部の現在向きを頭部追跡装置650から読み取る。ステップS412で読み取られる向きは、ステップS358(図25)で頭部追跡装置650により実行される処理において生成された向きである。

【0234】

ステップS414では、アーカイブプロセッサ658は、参加者がどこを見ているかを定義する線(いわゆる「視線」)と、参加者の頭部を別の参加者の頭部の中心と結ぶ概念上の各々の線とが成す角度を判定する。

【0235】

図29及び図30を参照して更に詳細に説明する。図29及び図30には、1人の参加者、すなわち、図21の参加者610についてステップS414で実行される処理の一例が示されている。図29を参照すると、ステップS412で読み取られる参加者の頭部の向きは、その参加者の両目の中心の間の一点から出る、参加者の頭部に対し垂直な視線690を定義する。同様に、図30を参照すると、ステップS410で読み取られる全ての参加者の頭部の位置は、参加者610の両目の中心の間の一点から他の各々の参加者606、608、612の頭部の中心に至る概念上の線692、694、696を定義する。ステップS414では、アーカイブプロセッサ658は視線690と、概念上の線692、694、696とがそれぞれ成す角度698、700、702を判定する。

【0236】

再び図28に戻ると、ステップS416では、アーカイブプロセッサ658は最小値を有する角度698、700又は702を選択する。すなわち、図30に示す例で言えば、角度700が選択されることになるであろう。

【0237】

ステップS418では、アーカイブプロセッサ658は選択した角度が10°より小さいか否かを判定する。

【0238】

ステップS418で、角度が10°より小さいと判定されれば、アーカイブプロセッサ658は参加者の視線パラメータを、視線と最小の角度を成す概念上の線により結ばれている参加者の番号(図23のステップS304で割り当てられている)に設定する。すなわち、図30に示す例で言えば、角度700が10°より小さい場合には、角度700は視線690と、参加者610を参加者606と結ぶ概念上の線694とが成す角度であるので、視線パラメータは参加者606の参加者番号に設定されることになるであろう。

【0239】

他方、ステップS418で、最小角度が10°以上であると判定された場合には、ステップS422で、アーカイブプロセッサ658は参加者の視線パラメータを「0」に設定する。これは、視線690が概念上の線692、694、696のいずれにも十分に近接していないために、参加者はその他の参加者の誰も見ていないと判定されたことを示す。そのような状況は、例えば、参加者がメモ又は会議室内の他の何らかの物体を見ているときに起こりうるであろう。

【0240】

ステップS424では、アーカイブプロセッサ658は会議に他の参加者がいるか否かを判定し、参加者ごとに上記の処理がそれぞれ実行され終わるまでステップS412からS424を繰り返す。

【0241】

再び図27に戻ると、ステップS382では、中央制御装置636及び音声認識プロセッサ654は、映像データの現在フレームについてマイクロホン604から音声データが受信されたか否かを判定する。

【0242】

ステップS382で、音声データが受信されていると判定されれば、ステップS384で、アーカイブプロセッサ658はステップS380で生成された視線パラメータを処理して、会議中のどの参加者が話をしているかを判定する。

【0243】

図31は、ステップS384でアーカイブプロセッサ658により実行される処理動作を示す。

【0244】

図31を参照すると、ステップS440では、ステップS380で生成された各視線パラメータ値の出現回数を判定し、ステップS442では、出現回数が最も多い視線パラメータ値を選択する。すなわち、図27のステップS380で実行される処理は、会議中の参加者ごとに、映像データの現在フレームについて1つの視線パラメータ値を生成するのである(従って、図21に示す例では、4つの値が生成されることになるであろう)。各視線パラメータは、その他の参加者のうち1人の参加者番号に相当する値又は「0」を有する。従って、ステップS440及びS442では、アーカイブプロセッサ658は、ステップS380で生成された視線パラメータ値の中で、映像データの現在フレームについて最も多くの回数で出現する値はどれであるかを判定する。

【0245】

ステップS444では、最も出現回数の多い視線パラメータが「0」の値を有するか否かを判定し、「0」の値であれば、ステップS446で、次に出現回数の多い視線パラメータ値を選択する。これに対し、ステップS444で、選択された値が「0」ではないと判定された場合には、ステップS446を省略する。

【0246】

ステップS448では、選択された視線パラメータ値(すなわち、ステップS442で選択された値、又はその値が「0」であれば、ステップS446で選択された値)を話をしている参加者として識別する。これは、会議中の参加者の大半は話者である参加者を見ているからである。

【0247】

再び図27に戻ると、ステップS386では、アーカイブプロセッサ658は話者である参加者の視線パラメータ値、すなわち、ステップS380で生成された、話者である参加者が誰を見ているかを定義する視線パラメータ値を後の解析に備えて、例えば、メモリ642に格納する。

【0248】

ステップS388では、アーカイブプロセッサ658はステップS384で判定された話者である参加者のアイデンティティを音声認識プロセッサ654に報知する。これに応答して、音声認識プロセッサ654は話者である参加者の音声認識パラメータを音声認識パラメータ記憶装置656から選択し、選択したパラメータを使用して、受信された音声データに対して音声認識処理を実行し、話者である参加者が話した言葉に対応するテキストデータを生成する。

【0249】

他方、ステップS382で、受信された音声データが話し言葉を含まないと判定された場合には、ステップS384からS388を省略する。

【0250】

ステップS390では、アーカイブプロセッサ658はカメラ602から受信された映像データの現在フレームと、マイクロホン604から受信された音声データとを従来の方式でMPEG2データを符号化し、符号化されたデータを会議アーカイブデータベース660に格納する。

【0251】

図32は、会議アーカイブデータベース660へのデータの格納状態を概略的に示す。図32に示す格納構造は概念的なものであり、単に理解を助けるために例示を目的として提示されているにすぎない。従って、図32に示す構造は、データが実際に会議アーカイブデータベース660に格納される厳密な状態を必ずしも表してはいない。

【0252】

図32を参照すると、会議アーカイブデータベース660は水平軸800により表される時間情報を格納している。水平軸800に沿った各単位は所定の量の時間、例えば、カメラ602から受信される映像データの1つのフレームを表している。ステップS390で生成されるMPEG2データは、時間情報と共に、データ802として会議アーカイブデータベース660に格納されている(この時間情報は、図32には、水平軸800に沿ったMPEG2データ802の位置により概略的に表されている)。

【0253】

再び図27に戻ると、ステップS392では、アーカイブプロセッサ658は、現在フレームについてステップS388で音声認識プロセッサ654により生成されたテキストデータを会議アーカイブデータベース660に格納する(図32には804で示されている)。すなわち、テキストデータは対応するMPEG2データへのリンクを伴って格納される。このリンクは、図32には、テキストデータがMPEG2データと同じ縦列に格納されることによって表されている。話をしていない参加者からは格納すべきテキストデータが得られないことは理解されるであろう。図32に示す例では、初めの10個のタイムスロットにわたり参加者1についてテキストが格納され(806で示す)、12番目から20番目のタイムスロットには参加者3のテキストが格納され(808で示す)、21番目のタイムスロットには参加者4のテキストが格納されている(810で示す)。この例では、図32に示すタイムスロットの間、参加者2は話をしなかったので、参加者2のテキストは格納されていない。

【0254】

ステップS394では、アーカイブプロセッサ658は、ステップS380で生成された参加者ごとの視線パラメータ値を会議アーカイブデータベース660に格納する(図32には812で示す)。図32を参照すると、視線パラメータ値は、参加者ごとに、関連するMPEG2データ802及び関連するテキストデータ804へのリンクと共に格納されている(このリンクは、図32では、視線パラメータ値が関連するMPEG2データ802及び関連するテキストデータ804と同じ縦列に格納されることにより示されている)。従って、一例として第1のタイムスロットに関して言えば、参加者1の視線パラメータ値は、参加者1が参加者3を見ていることを指示する「3」であり、参加者2の視線パラメータ値は、参加者2が参加者1を見ていることを指示する「1」であり、参加者3の視線パラメータ値も、参加者3が同様に参加者1を見ていることを指示する「1」であり、参加者4の視線パラメータ値は、参加者4が他のどの参加者も見ていない(図21に示す例では、612で示される参加者は他の参加者ではなく、自分のメモを見ている)ことを指示する「0」である。

【0255】

ステップS396では、中央制御装置636及びアーカイブプロセッサ658は、会議中の参加者の1人が話を止めたか否かを判定する。この実施形態においては、この検査は、所定の参加者のテキストデータが直前のタイムスロットには存在したが、現在タイムスロットには存在しないことを判定するためにテキストデータ804を検査することにより実行される。ある参加者についてこの条件が満たされれば(すなわち、参加者が話を止めたならば)、ステップS398で、アーカイブプロセッサ658は、話を止めた参加者について、先にステップS386を実行したときに格納されていた視線パラメータ値を処理して(それらの視線パラメータ値は、その時点で止まった話をしていた期間中にその参加者が誰を見ていたかを定義する)、視線ヒストグラムを定義するデータを生成する。すなわち、参加者が話をしていた期間の視線パラメータ値を処理して、その期間中に話者である参加者がその他の参加者の各々を見ていた時間の割合(%)を定義するデータを生成するのである。

【0256】

図33A及び図33Bは図32のテキスと806及び808の期間にそれぞれ対応する視線ヒストグラムを示す。

【0257】

図32及び図33Aを参照して説明すると、参加者1が話していた期間806の間、図33Aに900で示すように、参加者1は10個のタイムスロットのうち6個(すなわち、参加者1が話していた期間全体の長さの60%)にわたり参加者3を見ており、また、図33Aに910で示すように、4個のタイムスロット(すなわち、時間の40%)にわたり参加者4を見ていた。

【0258】

同様に、図32及び図33Bを参照すると、期間808の間、図33Bに920で示すように、参加者3は時間の約45%にわたり参加者1を見ており、図33Bに930で示すように、時間の約33%にわたり参加者4を見ており、図33Bに940で示すように、時間の約22%にわたり参加者2を見ていた。

【0259】

再び図27に戻ると、ステップS400では、ステップS398で生成された視線ヒストグラムをそれが生成された関連するテキストの期間にリンクさせて、会議アーカイブデータベース660に格納する。図32を参照すると、格納された視線ヒストグラムは814で示されており、816で示されるテキスト期間806に対応するヒストグラムを定義するデータと、818で示されるテキスト期間808に対応するヒストグラムを定義するデータとを伴う。図32において、視線ヒストグラムと関連するテキストとの間のリンクは、視線ヒストグラムがテキストデータと同じ縦列に格納されることにより示されている。

【0260】

他方、ステップS396で、現在時限について、参加者の1人が話を止めていないと判定された場合には、ステップS398及びS400を省略する。

【0261】

ステップS402では、中央制御装置636は、カメラ602から映像データの別のフレームが受信されたか否かを判定する。カメラ602から画像データが受信されている間は、ステップS380からS402を繰り返し実行する。

【0262】

会議アーカイブデータベース660にデータが格納されている場合、会議に関連するデータを検索するために会議アーカイブデータベース660を問い合わせても良い。

【0263】

図34は、ユーザにより指定される探索基準を満たす会議の各部分に関連するデータを検索する目的で会議アーカイブデータベース660を探索するために実行される処理動作を示す。

【0264】

図34を参照すると、ステップS500では、中央制御装置636は表示プロセッサ664に、要求される会議アーカイブデータベース660の探索を定義する情報をユーザが入力することを要求するメッセージを表示装置626に表示させる。すなわち、この実施形態においては、中央制御装置636は図35Aに示す表示を表示装置626に出現させる。

【0265】

図35Aを参照すると、ユーザは、会議アーカイブデータベース660の中で見出したい会議の1つ又は複数の部分を定義する情報を入力することを求められる。すなわち、この実施形態においては、ユーザは話をしていた参加者を定義する情報1000と、情報1000の中で識別される参加者が話した1つ又は複数のキーワードから成る情報1010と、情報1000の中で識別される参加者が話しかけていた参加者を定義する情報1020とを入力することを求められる。更に、ユーザは、探索を実行すべき会議の1つ又は複数の部分を定義する時間情報を入力することができる。すなわち、ユーザは、その時間を越えたときに探索を中断すべき会議中の時間(すなわち、指定される時間以前の会議の期間を探索すべきである)を定義する情報1030と、その時間の後に探索を実行すべきである会議中の時間を定義する情報1040と、探索を実行すべき期間の開始時間と終了時間をそれぞれ定義する情報1050及び1060とを入力することができる。この実施形態では、情報1030、1040、1050及び1060は、例えば、分単位などの絶対期限で時間を指定するか、又は会議時間全体に占める割合を指示する小数値を入力することにより相対期限で時間を指定するかのいずれかにより入力されれば良い。例えば、情報1030として0.25の値を入力すると、探索は会議の初めの四分の一に限られるであろう。

【0266】

この実施形態では、ユーザは1回の探索に際して全ての情報1000、1010及び1020を入力することを求められるわけではなく、そのうち1つ又は2つの情報を省いても良い。ユーザが情報1000、1010及び1020の全てを入力すれば、会議中に情報1000の中で識別される参加者が情報1020の中で識別される参加者に話しかけていた各部分及び情報1010の中で定義されるキーワードを話していた各部分を識別するための探索が実行される。これに対し、情報1010を省いた場合には、会議中に情報1000の中で識別される参加者が、何を言ったかに関わらず、情報1020の中で定義される参加者に話しかけていた各部分を識別するための探索が実行されることになる。情報1010及び1020を省いた場合には、会議中に情報1000の中で定義される参加者が何を誰に向かって話したかに関わらず、話をしていた各部分を識別するための探索が実行される。情報1000を省いた場合には、会議中にいずれかの参加者が情報1010の中で定義されるキーワードを情報1020の中で定義される参加者に向かって話した各部分を識別するための探索が実行される。情報1000及び1010を省いた場合には、会議中にいずれかの参加者が情報1020の中で定義される参加者に話しかけた各部分を識別するための探索が実行される。情報1020を省いた場合には、会議中に情報1000の中で定義される参加者が、誰に向かって話したかに関わらず、情報1010の中で定義されるキーワードを話した各部分を識別するための探索が実行される。同様に、情報1000及び1020を省いた場合には、会議中に、誰が誰に向かって話したかに関わらず、情報1010の中で識別されるキーワードが話された各部分を識別するための探索が実行される。

【0267】

更に、ユーザは時間情報1030、1040、1050及び1060の全てを入力しても良いし、そのうち1つ又は複数の情報を省いても良い。

【0268】

探索を定義するために必要な情報を全て入力したならば、ユーザは、マウス630などのユーザ入力装置を使用して領域1070をクリックすることにより探索を開始する。

【0269】

再び図34に戻ると、ステップS802では、中央制御装置636はユーザにより入力された探索情報を読み取り、命令された探索を実行する。すなわち、この実施形態においては、中央制御装置636は情報1000又は1020の中で入力された参加者の名前をテーブル680(図24)を使用して参加者番号に変換し、情報1000の中で定義される参加者(情報1000が入力されていない場合には全ての参加者)についてテキスト情報804を考慮する。ユーザにより情報1020が入力されていれば、テキストの期間ごとに、中央制御装置636は対応する視線ヒストグラムを定義するデータを検査して、情報1020の中で定義される参加者のヒストグラムにおける注目時間の割合がこの実施形態では25%である閾値以上であるか否かを判定する。このようにして、話し言葉(テキスト)の期間を考慮して、話者である参加者が話している時間の少なくとも25%にわたって情報1020の中で定義される参加者を見ていたならば、情報1000の中で定義される参加者が話をしている間に他の参加者を見たとしても、情報1020の中で定義される参加者に話しかけていたという基準を満たす。従って、情報1020の中で2人以上の参加者が指定されていれば、視線ヒストグラムの値が2人以上の参加者について25%以上であるような話の期間が識別されるであろう。ユーザにより情報1010が入力されていた場合、中央制御装置636及びテキストサーチャ662は、先に情報1000及び1020に基づいて識別されたテキストの各部分(情報1000及び1020が入力されていなければテキストの全ての部分)を探索して、情報1010の中で識別されるキーワードを含む各部分を識別する。ユーザにより時間情報が入力されていた場合、上記の探索はそれらの期限により定義される会議の時間に限られる。

【0270】

ステップS504では、中央制御装置636は表示プロセッサ664に、探索中に識別された関連話題のリストを表示装置626を介してユーザに対し表示させる。すなわち、中央制御装置636は図35Bに示すような情報をユーザに対し表示させる。図35Bを参照すると、探索パラメータを満足させるそれぞれの話題のリストが作成されており、その話題について開始時間を絶対期限と、会議時間全体に占める割合の双方で定義する情報が表示される。そこで、ユーザは、マウス630を使用してリスト中の必要な話題をクリックすることにより、話題の1つを選択し、再生することができる。

【0271】

ステップS506では、中央制御装置636はステップS504でユーザにより実行された選択を読み取り、格納されている会議の関連部分のMPEG2データ802を会議アーカイブデータベース660から再生させる。すなわち、中央制御装置636及び表示プロセッサ664はMPEG2データ802を復号し、画像データと音声を表示装置626を介して出力する。

【0272】

ステップS508では、中央制御装置636は、ユーザが会議アーカイブデータベース660の問い合わせを中止することを望むか否かを判定し、望まないのであれば、ステップS500からS508を繰り返す。

【0273】

以上説明した本発明の実施形態に対し、様々な変形や変更を実施することができる。

【0274】

例えば、上記の実施形態では、マイクロホン604は会議室のテーブルの上に設けられていた。しかし、その代わりに、ビデオカメラ602のマイクロホンを使用して音声データを記録しても良い。

【0275】

上記の実施形態では、1台のビデオカメラ602からの画像データを処理していた。しかし、各参加者の頭部の追跡精度を向上させるために、複数台のビデオカメラからの映像データを処理しても良い。例えば、複数台のカメラからの画像データを図25のステップS350からS356におけるように処理し、全てのカメラから得られたデータをステップS360で従来のようにカルマンフィルタに入力して、カメラごとに映像データの次のフレームにおける各参加者の頭部の位置と向きを更に正確に推定しても良い。複数台のカメラを使用する場合、会議アーカイブデータベース660に格納されるMPEG2データ802は全てのカメラからの映像データということになり、図34のステップS504及びS506では、ユーザが選択した1台のカメラからの画像データが再生される。

【0276】

上記の実施形態では、所定の参加者の視線パラメータは、その参加者が他のどの参加者を見ているかを定義していた。しかし、参加者が表示板、映写機のスクリーンなどのどの物体を見ているかを定義するために視線パラメータを使用しても良い。この場合、会議アーカイブデータベース660を問い合わせるときに、図35Aの情報1020を利用して、参加者が話している間に誰を又は何を見ていたかを指定することが可能になるであろう。

【0277】

上記の実施形態では、ステップS502(図34)で、テキストの特定の部分の視線ヒストグラムを考慮し、視線ヒストグラムにおける別の参加者への注目時間の割合が所定の閾値以上である場合に、参加者はその別の参加者に話しかけていたと判定していた。しかし、閾値を使用せずに、テキストの期間中に話者である参加者が見ていた参加者を視線ヒストグラムにおいて最も大きな割合の注目値を有する参加者(例えば、図33Aの参加者3及び図33Bの参加者1)であると定義しても良い。

【0278】

上記の実施形態では、カメラ602及びマイクロホン604からデータが受信されている間、MPEG2データ802、テキストデータ804、視線パラメータ812及び視線ヒストグラム814をリアルタイムで会議アーカイブデータベース660に格納していた。しかし、映像データと音声データを格納しておき、データ802、804、812及び814をリアルタイムではなく生成し、会議アーカイブデータベース660に格納しても良い。

【0279】

上記の実施形態では、会議の定義された部分のデータを検索するために会議アーカイブデータベース660を問い合わせる前に、MPEG2データ802、テキストデータ804、視線パラメータ812及び視線ヒストグラム814を生成し、会議アーカイブデータベース660に格納していた。しかし、探索の要求に先立ってデータを生成、格納するのではなく、会議アーカイブデータベース660の探索がユーザにより要求されるのに応答して、格納されているMPEG2データ802を処理することによりデータ804、812及び814の一部又は全てを生成しても良い。例えば、上記の実施形態では、ステップS398及びS400(図27)で視線ヒストグラム814をリアルタイムで計算、格納していたが、ユーザにより探索要求が入力されるのに応答してそれらのヒストグラムを計算することもできるであろう。

【0280】

上記の実施形態では、テキストデータ804を会議アーカイブデータベース660に格納していた。テキストデータ804の代わりに、音声データを会議アーカイブデータベース660に格納しても良い。その場合、格納されている音声データ自体を音声認識処理を使用してキーワードを求めて探索するか、又は音声認識処理を使用して音声データをテキストに変換し、従来のテキストサーチャを使用してテキストを探索すれば良い。

【0281】

上記の実施形態では、処理装置624はアーカイブすべきデータを受信し、生成するための機能構成要素(例えば、中央制御装置636、頭部追跡装置650、頭部モデル記憶装置652、音声認識プロセッサ654、音声認識パラメータ記憶装置656及びアーカイブプロセッサ658)と、アーカイブデータを格納するための機能構成要素(例えば、会議アーカイブデータベース660)と、データベースを探索し、そこから情報を検索するための機能構成要素(例えば、中央制御装置636及びテキストサーチャ662)とを含んでいた。しかし、これらの機能構成要素を別個の装置に設けても良い。例えば、アーカイブすべきデータを生成する1つ又は複数の装置と、データベース探索のための1つ又は複数の装置とを、インターネットなどのネットワークを介して1つ又は複数のデータベースに接続しても良い。

【0282】

また、図36を参照して説明すると、一箇所又は複数箇所での会議1100、1110、1120からの映像データと音声データをデータ処理・データベース記憶装置1130(アーカイブデータを生成し且つ格納するための機能構成要素を具備する)に入力し、データベースを問い合わせ、そこから情報を検索するために、1つ又は複数のデータベース問い合わせ装置1140、1150をデータ処理・データベース記憶装置1130に接続しても良い。

【0283】

上記の実施形態では、プログラミング命令により定義される処理ルーチンを使用して、コンピュータにより処理を実行していた。しかし、処理の一部又は全てをハードウェアを使用して実行しても良い。

【0284】

以上、複数の参加者の間で行われる会議に関して実施形態を説明したが、本発明はこの用途には限定されず、フィルムセットなどについて画像データ及び音声データを処理するなど、他の用途にも適用することができる。

【0285】

上記の変形例の異なる組み合わせも言うまでもなく可能であり、本発明の趣旨から逸脱せずにその他の変更や変形を実施することができる。

【図面の簡単な説明】

【図1】第1の実施形態における複数の参加者の間の会議からの音声データ及び映像データの記録を示す図である。

【図2】第1の実施形態の処理装置内部の概念上の機能構成要素の一例を示すブロック線図である。

【図3A】図1に示す参加者間の会議が始まる以前に図2の処理装置24により実行される処理動作を示す図である。

【図3B】図1に示す参加者間の会議が始まる以前に図2の処理装置24により実行される処理動作を示す図である。

【図3C】図1に示す参加者間の会議が始まる以前に図2の処理装置24により実行される処理動作を示す図である。

【図4】 図3のステップS2及びステップS4で会議アーカイブデータベース60に格納されるデータを概略的に示す図である。

【図5】図3のステップS34及び図7のステップS70で実行される処理動作を示す図である。

【図6】図5のステップS42−1、S42−2及びS42−nのそれぞれで実行される処理動作を示す図である。

【図7】参加者間で会議が行われている間に図2の処理装置24により実行される処理動作を示す図である。

【図8A】図7のステップS72で実行される処理動作を示す図である。

【図8B】図7のステップS72で実行される処理動作を示す図である。

【図9A】図8のステップS80で実行される処理動作を示す図である。

【図9B】図8のステップS80で実行される処理動作を示す図である。

【図10】図9のステップS114及びステップS124で実行される処理で使用する参加者の視線を示す図である。

【図11】図9のステップS114で実行される処理において計算される角度を示す図である。

【図12】図8のステップS84で実行される処理動作を示す図である。

【図13】図8のステップS89で実行される処理動作を示す図である。

【図14】図13のステップS168で実行される処理動作を示す図である。

【図15】会議アーカイブデータベース60への情報の格納を概略的に示す図である。

【図16A】会議アーカイブデータベース60に格納されたデータにより定義される視線ヒストグラムの例を示す図である。

【図16B】会議アーカイブデータベース60に格納されたデータにより定義される視線ヒストグラムの例を示す図である。

【図17】図8のステップS102で実行される処理動作を示す図である。

【図18】会議アーカイブデータベース60から情報を検索するために処理装置24により実行される処理動作を示す図である。

【図19A】図18のステップS200でユーザに対し表示される情報を示す図である。

【図19B】図18のステップS204でユーザに対し表示される情報の一例を示す図である。

【図20】1つのデータベースが複数の会議からの情報を格納し、1つ又は複数の遠隔装置からこのデータベースを問い合わせる第1の実施形態の変形例を概略的に示す図である。

【図21】第2の実施形態における複数の参加者の間の会議からの音声データ及び映像データの記録を示す図である。

【図22】第2の実施形態の処理装置内部の概念上の機能構成要素の一例を示すブロック線図である。

【図23A】図21に示す参加者間の会議が始まる以前に図22の処理装置624により実行される処理動作を示す図である。

【図23B】図21に示す参加者間の会議が始まる以前に図22の処理装置624により実行される処理動作を示す図である。

【図23C】図21に示す参加者間の会議が始まる以前に図22の処理装置624により実行される処理動作を示す図である。

【図24】図23のステップS304で会議アーカイブデータベース660に格納されるデータを概略的に示す図である。

【図25】図23のステップS334で実行される処理動作を示す図である。

【図26】参加者間で会議が行われている間に図22の処理装置624により実行される処理動作を示す図である。

【図27A】図26のステップS372で実行される処理動作を示す図である。

【図27B】図26のステップS372で実行される処理動作を示す図である。

【図28】図27のステップS380で実行される処理動作を示す図である。

【図29】図28のステップS414で実行される処理で使用する参加者の視線を示す図である。

【図30】図28のステップS414で実行される処理において計算される角度を示す図である。

【図31】図27のステップS384で実行される処理動作を示す図である。

【図32】会議アーカイブデータベース660への情報の格納を概略的に示す図である。

【図33A】会議アーカイブデータベース660に格納されたデータにより定義される視線ヒストグラムの例を示す図である。

【図33B】会議アーカイブデータベース660に格納されたデータにより定義される視線ヒストグラムの例を示す図である。

【図34】会議アーカイブデータベース660から情報を検索するために処理装置624により実行される処理動作を示す図である。

【図35A】図34のステップS500でユーザに対し表示される情報を示す図である。

【図35B】図34のステップS504でユーザに対し表示される情報の一例を示す図である。

【図36】1つのデータベースが複数の会議からの情報を格納し、1つ又は複数の遠隔装置からこのデータベースを問い合わせる第2の実施形態の変形例を概略的に示す図である。

Claims (78)

- 画像データ及び音声データを処理する装置であって、

少なくとも1台のカメラにより記録され且つ複数の人物の動きを示す画像データを処理して、各人物を三次元で追跡する画像処理手段と、

音声データを処理して、音声の到達方向を判定する音声処理手段と、

画像処理手段により実行される処理の結果と、音声処理手段により実行される処理の結果とに基づいて、どの人物が話しているかを判定する話者識別手段と、

受信した音声データを処理して、話者識別手段により実行される処理の結果に従って音声データからテキストデータを生成する音声認識処理手段とを備えることを特徴とする装置。 - 音声認識処理手段は、人物ごとの対応する音声認識パラメータを格納する記憶手段と、話者識別手段により話していると判定された人物に従って音声データを処理するために使用すべき音声認識パラメータを選択する手段とを含むことを特徴とする請求項1記載の装置。

- 画像処理手段は、処理される画像データを提供する各カメラの位置と向きを定義するカメラ校正データを使用して画像データを処理することにより各人物を追跡するように構成されていることを特徴とする請求項1又は2記載の装置。

- 画像処理手段は、各人物の頭部を追跡することにより各人物を追跡するように構成されていることを特徴とする請求項1乃至3のいずれか1項に記載の装置。

- 画像処理手段は、少なくとも話をしている各人物がどこを見ているかを判定するために画像データを処理するように構成されていることを特徴とする請求項1乃至4のいずれか1項に記載の装置。

- 話者識別手段は、受信した画像データの所定のフレームについて画像処理手段及び音声処理手段により実行される処理の結果を使用して話者を識別できない場合、少なくとも1つの他のフレームに対して画像処理手段及び音声処理手段により実行される処理の結果を使用して所定のフレームにおいて話をしている人物を識別するように構成されていることを特徴とする請求項1乃至5のいずれか1項に記載の装置。

- 受信した画像データ、音声データ、音声認識処理手段により生成されるテキストデータ、及び少なくとも話をしている各人物がどこを見ているかを定義する視線データの少なくとも一部を格納するデータベースを更に具備し、前記データベースは、対応するテキストデータと視線データとが互いに関連すると共に、対応する画像データ及び音声データとも関連するようにデータを格納する構成であることを特徴とする請求項1乃至6のいずれか1項に記載の装置。

- データベースに格納するために、画像データ及び音声データを圧縮する手段を更に具備することを特徴とする請求項7記載の装置。

- 画像データ及び音声データを圧縮する手段は、画像データ及び音声データをMPEGデータとして符号化する手段であることを特徴とする請求項8記載の装置。

- 所定の期間にわたり、その所定の期間中に所定の人物がその他の人物の各々を見るのに費やした時間の割合を定義するデータを生成する手段を更に具備し、データベースは、そのデータが対応する画像データ、音声データ、テキストデータ及び視線データと関連するようにデータを格納する構成であることを特徴とする請求項7乃至9のいずれか1項に記載の装置。

- 所定の期間は所定の人物が話をしていた期間である請求項10記載の装置。

- 画像データ及び音声データを処理する装置において、

少なくとも1台のカメラにより記録され且つ複数の人物の動きを示す画像データを処理して、各人物を三次元で追跡する画像処理手段と、

音声データを処理して、音声の到達方向を判定する音声処理手段と、

画像処理手段により実行される処理の結果と、音声処理手段により実行される処理の結果とに基づいて、どの人物が話しているかを判定する話者識別手段とを具備することを特徴とする装置。 - 画像処理手段は、処理される画像データを提供する各カメラの位置と向きを定義するカメラ校正データを使用して画像データを処理することにより各人物を追跡するように構成されていることを特徴とする請求項12記載の装置。

- 画像処理手段は、各人物の頭部を追跡することにより各人物を追跡するように構成されていることを特徴とする請求項12又は13に記載の装置。

- 画像処理手段は、少なくとも話をしている各人物がどこを見ているかを判定するために画像データを処理するように構成されていることを特徴とする請求項12乃至14のいずれか1項に記載の装置。

- 話者識別手段は、受信した画像データの所定のフレームについて画像処理手段及び音声処理手段により実行される処理の結果を使用して話者を識別できない場合、少なくとも1つの他のフレームに対して画像処理手段及び音声処理手段により実行される処理の結果を使用して所定のフレームにおいて話をしている人物を識別するように構成されていることを特徴とする請求項12乃至15のいずれか1項に記載の装置。

- 画像データ及び音声データを処理する方法において、

少なくとも1台のカメラにより記録され且つ複数の人物の動きを示す画像データを処理して、各人物を三次元で追跡する画像処理ステップと、

音声データを処理して、音声の到達方向を判定する音声処理ステップと、

画像処理ステップで実行される処理の結果と、音声処理ステップで実行される処理の結果とに基づいて、どの人物が話しているかを判定する話者識別ステップと、

受信した音声データを処理して、話者識別ステップで実行される処理の結果に従って音声データからテキストデータを生成する音声認識処理ステップとを備えることを特徴とする方法。 - 音声認識処理ステップは、人物ごとに格納されている音声認識パラメータから、話者識別ステップで話していると判定された人物に従って音声データを処理するために使用すべき音声認識パラメータを選択することを含むことを特徴とする請求項17記載の方法。

- 画像処理ステップでは、処理される画像データを提供する各カメラの位置と向きを定義するカメラ校正データを使用して画像データを処理することにより各人物を追跡することを特徴とする請求項17又は18記載の方法。

- 画像処理ステップでは、各人物の頭部を追跡することにより各人物を追跡することを特徴とする請求項17乃至19のいずれか1項に記載の方法。

- 画像処理ステップでは、少なくとも話をしている各人物がどこを見ているかを判定するために画像データを処理することを特徴とする請求項17乃至20のいずれか1項に記載の方法。

- 話者識別ステップでは、受信した画像データの所定のフレームについて画像処理ステップ及び音声処理ステップにより実行される処理の結果を使用して話者を識別できない場合、少なくとも1つの他のフレームに対して画像処理ステップ及び音声処理ステップにより実行される処理の結果を使用して所定のフレームにおいて話をしている人物を識別することを特徴とする請求項17乃至21のいずれか1項に記載の方法。

- 音声認識処理ステップで生成されるデータを搬送する信号を発生するステップを更に含むことを特徴とする請求項17乃至22のいずれか1項に記載の方法。

- 受信した画像データ、音声データ、音声認識処理ステップにより生成されるテキストデータ、及び少なくとも話をしている各人物がどこを見ているかを定義する視線データの少なくとも一部をデータベースに格納するステップを更に含み、データは、対応するテキストデータと視線データとが互いに関連すると共に、対応する画像データ及び音声データとも関連するようにデータベースに格納されることを特徴とする請求項17乃至23のいずれか1項に記載の方法。

- 画像データ及び音声データは圧縮された形態でデータベースに格納されることを特徴とする請求項24記載の方法。

- 画像データ及び音声データはMPEGデータとして格納されることを特徴とする請求項25記載の方法。

- 所定の期間にわたり、その所定の期間中に所定の人物がその他の人物の各々を見るのに費やした時間の割合を定義するデータを生成するステップと、そのデータが対応する画像データ、音声データ、テキストデータ及び視線データと関連するようにデータをデータベースに格納するステップとを更に含むことを特徴とする請求項24乃至26のいずれか1項に記載の方法。

- 所定の期間は所定の人物が話をしていた期間であることを特徴とする請求項27記載の方法。

- データベースを格納されているデータと共に搬送する信号を発生するステップを更に含むことを特徴とする請求項24乃至28のいずれか1項に記載の方法。

- 信号の記録を生成するために信号を直接に又は間接的に記録するステップを更に含むことを特徴とする請求項29記載の方法。

- 画像データ及び音声データを処理する方法において、

少なくとも1台のカメラにより記録され且つ複数の人物の動きを示す画像データを処理して、各人物を三次元で追跡する画像処理ステップと、

音声データを処理して、音声の到達方向を判定する音声処理ステップと、

画像処理ステップにより実行される処理の結果と、音声処理ステップにより実行される処理の結果とに基づいて、どの人物が話しているかを判定する話者識別ステップとを備えることを特徴とする方法。 - 画像処理ステップでは、処理される画像データを提供する各カメラの位置と向きを定義するカメラ校正データを使用して画像データを処理することにより各人物を追跡することを特徴とする請求項31記載の方法。

- 画像処理ステップでは、各人物の頭部を追跡することにより各人物を追跡することを特徴とする請求項31又は32記載の方法。

- 画像処理ステップでは、少なくとも話をしている各人物がどこを見ているかを判定するために画像データを処理することを特徴とする請求項31乃至33のいずれか1項に記載の方法。

- 話者識別ステップでは、受信した画像データの所定のフレームについて画像処理ステップ及び音声処理ステップにより実行される処理の結果を使用して話者を識別できない場合、少なくとも1つの他のフレームに対して画像処理ステップ及び音声処理ステップにより実行される処理の結果を使用して所定のフレームにおいて話をしている人物を識別することを特徴とする請求項31乃至34のいずれか1項に記載の方法。

- 話者識別ステップで識別された話者のアイデンティティを搬送する信号を発生するステップを更に含むことを特徴とする請求項31乃至35のいずれか1項に記載の方法。

- プログラム可能処理装置を請求項1乃至16の少なくとも1項に記載の装置として構成させるための命令を格納することを特徴とする記憶装置。

- プログラム可能処理装置を請求項17乃至36の少なくとも1項に記載の方法を実行するように動作可能にさせるための命令を格納することを特徴とする記憶装置。

- 画像データ及び音声データを処理する装置であって、

少なくとも1台のカメラにより記録され且つ複数の人物の動きを示す画像データを処理して、各人物がどこを見ているかを判定すると共に、複数の人物がどこを見ているかに基づいてどの人物が話しているかを判定する画像処理手段と、

人物が話した言葉を定義する音声データを処理して、画像処理手段により実行される処理の結果に従って音声データからテキストデータを生成する音声処理手段とを備えることを特徴とする装置。 - 音声処理手段は、人物ごとの対応する音声認識パラメータを格納する記憶手段と、画像処理手段により話をしていると判定された人物に従って音声データを処理するために使用すべき音声認識パラメータを選択する手段とを含むことを特徴とする請求項39記載の装置。

- 画像処理手段は、処理される画像データを提供する各カメラの位置と向きを定義するカメラ校正データを使用して画像データを処理することにより、各人物がどこを見ているかを判定するように構成されていることを特徴とする請求項39又は40記載の装置。

- 画像処理手段は、各人物の頭部の位置と向きを三次元で追跡するために画像データを処理することにより、各人物がどこを見ているかを判定するように構成されていることを特徴とする請求項39乃至41のいずれか1項に記載の装置。

- 画像処理手段は、各々の人物を見ている人物の数に基づいてどの人物が話をしているかを判定するように構成されていることを特徴とする請求項39乃至42のいずれか1項に記載の装置。

- 画像処理手段は、各人物が誰を見ているかを定義する値を人物ごとに生成し且つそれらの値を処理して、話をしている人物を判定するように構成されていることを特徴とする請求項43記載の装置。

- 画像処理手段は、話をしている人物が他の人物の大半が見ている人物であることを判定するように構成されていることを特徴とする請求項39乃至44のいずれか1項に記載の装置。

- 画像データ、音声データ、音声処理手段により生成されるテキストデータ、及び各人物がどこを見ているかを定義する視線データを格納するデータベースを更に備え、前記データベースは、対応するテキストデータと視線データとが互いに関連すると共に、対応する画像データ及び音声データとも関連するようにデータを格納する構成であることを特徴とする請求項39乃至45のいずれか1項に記載の装置。

- データベースに格納するために、画像データ及び音声データを圧縮する手段を更に備えることを特徴とする請求項46記載の装置。

- 画像データ及び音声データを圧縮する手段は、画像データ及び音声データをMPEGデータとして符号化する手段であることを特徴とする請求項47記載の装置。

- 所定の期間にわたり、その所定の期間中に所定の人物がその他の人物の各々を見るのに費やした時間の割合を定義するデータを生成する手段を更に備え、データベースは、そのデータが対応する画像データ、音声データ、テキストデータ及び視線データと関連するようにデータを格納する構成であることを特徴とする請求項46乃至48のいずれか1項に記載の装置。

- 所定の期間は所定の人物が話をしていた期間であることを特徴とする請求項49記載の装置。

- 画像データを処理する装置において、少なくとも1台のカメラにより記録され且つ複数の人物の動きを示す画像データを処理して、各人物がどこを見ているかを判定すると共に、複数の人物がどこを見ているかに基づいてどの人物が話しているかを判定する画像処理手段を備えることを特徴とする装置。

- 画像処理手段は、処理される画像データを提供する各カメラの位置と向きを定義するカメラ校正データを使用して画像データを処理することにより、各人物がどこを見ているかを判定するように構成されていることを特徴とする請求項51記載の装置。

- 画像処理手段は、各人物の頭部の位置と向きを三次元で追跡するために画像データを処理することにより、各人物がどこを見ているかを判定するように構成されていることを特徴とする請求項51又は52記載の装置。

- 画像処理手段は、各々の人物を見ている人物の数に基づいてどの人物が話をしているかを判定するように構成されていることを特徴とする請求項51乃至53のいずれか1項に記載の装置。

- 画像処理手段は、各人物が誰を見ているかを定義する値を人物ごとに生成し且つそれらの値を処理して、話をしている人物を判定するように構成されていることを特徴とする請求項54記載の装置。

- 画像処理手段は、話をしている人物が他の人物の大半が見ている人物であることを判定するように構成されていることを特徴とする請求項51乃至55のいずれか1項に記載の装置。

- 画像データ及び音声データを処理する方法において、

少なくとも1台のカメラにより記録され且つ複数の人物の動きを示す画像データを処理して、各人物がどこを見ているかを判定すると共に、複数の人物がどこを見ているかに基づいてどの人物が話しているかを判定する画像処理ステップと、

人物が話した言葉を定義する音声データを処理して、画像処理手段により実行される処理の結果に従って音声データからテキストデータを生成する音声処理ステップとを備えることを特徴とする方法。 - 音声処理ステップは、人物ごとに格納されているそれぞれの音声認識パラメータから、画像処理ステップで話をしていると判定された人物に従って音声データを処理するために使用すべき音声認識パラメータを選択するステップを含むことを特徴とする請求項57記載の方法。

- 画像処理ステップでは、処理される画像データを提供する各カメラの位置と向きを定義するカメラ校正データを使用して画像データを処理することにより、各人物がどこを見ているかを判定することを特徴とする請求項57又は58記載の方法。

- 画像処理ステップでは、各人物の頭部の位置と向きを三次元で追跡するために画像データを処理することにより、各人物がどこを見ているかを判定することを特徴とする請求項57乃至59のいずれか1項に記載の方法。

- 画像処理ステップでは、各々の人物を見ている人物の数に基づいてどの人物が話をしているかを判定することを特徴とする請求項57乃至60のいずれか1項に記載の方法。

- 画像処理ステップでは、各人物が誰を見ているかを定義する値を人物ごとに生成し且つそれらの値を処理して、話をしている人物を判定することを特徴とする請求項61記載の方法。

- 画像処理ステップでは、話をしている人物が他の人物の大半が見ている人物であることを判定することを特徴とする請求項57乃至62のいずれか1項に記載の方法。

- 画像データ、音声データ、音声処理手段により生成されるテキストデータ、及び各人物がどこを見ているかを定義する視線データをデータベースに格納するステップを更に含み、前記データベースは、対応するテキストデータと視線データとが互いに関連すると共に、対応する画像データ及び音声データとも関連するようにデータを格納することを特徴とする請求項57乃至63のいずれか1項に記載の方法。

- 画像データ及び音声データは圧縮された形態で格納されることを特徴とする請求項64記載の方法。

- 画像データ及び音声データはMPEGデータとして格納されることを特徴とする請求項65記載の方法。

- 所定の期間にわたり、その所定の期間中に所定の人物がその他の人物の各々を見るのに費やした時間の割合を定義するデータを生成するステップと、そのデータが対応する画像データ、音声データ、テキストデータ及び視線データと関連するようにデータをデータベースに格納するステップとを更に含むことを特徴とする請求項64乃至66のいずれか1項に記載の方法。

- 所定の期間は所定の人物が話をしていた期間であることを特徴とする請求項67記載の方法。

- データベースを格納されているデータと共に搬送する信号を発生するステップを更に含むことを特徴とする請求項64乃至68のいずれか1項に記載の方法。

- 信号の記録を生成するために信号を直接に又は間接的に記録するステップを更に含むことを特徴とする請求項69記載の方法。

- 画像データを処理する方法において、少なくとも1台のカメラにより記録され且つ複数の人物の動きを示す画像データを処理して、各人物がどこを見ているかを判定すると共に、複数の人物がどこを見ているかに基づいてどの人物が話しているかを判定するステップを備えることを特徴とする方法。

- 処理される画像データを提供する各カメラの位置と向きを定義するカメラ校正データを使用して画像データを処理することにより、各人物がどこを見ているかを判定することを特徴とする請求項71記載の方法。

- 各人物の頭部の位置と向きを三次元で追跡するために画像データを処理することにより、各人物がどこを見ているかを判定することを特徴とする請求項71又は72記載の方法。

- 各々の人物を見ている人物の数に基づいてどの人物が話をしているかを判定することを特徴とする請求項71乃至73のいずれか1項に記載の方法。

- 各人物が誰を見ているかを定義する値を人物ごとに生成し且つそれらの値を処理して、話をしている人物を判定することを特徴とする請求項74記載の方法。

- 話をしている人物が他の人物の大半が見ている人物であることを判定することを特徴とする請求項71乃至75のいずれか1項に記載の方法。

- プログラム可能処理装置を請求項39乃至56の少なくとも1項に記載の装置として構成させるための命令を格納することを特徴とする記憶装置。

- プログラム可能処理装置を請求項57乃至76の少なくとも1項に記載の方法を実行するように動作可能にさせるための命令を格納することを特徴とする記憶装置。

Applications Claiming Priority (4)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| GB9907103A GB2351627B (en) | 1999-03-26 | 1999-03-26 | Image processing apparatus |

| GB9908546A GB2351628B (en) | 1999-04-14 | 1999-04-14 | Image and sound processing apparatus |

| GB9907103.7 | 1999-04-14 | ||

| GB9908546.6 | 1999-04-14 |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2000352996A JP2000352996A (ja) | 2000-12-19 |

| JP2000352996A5 JP2000352996A5 (ja) | 2007-05-24 |

| JP4474013B2 true JP4474013B2 (ja) | 2010-06-02 |

Family

ID=26315345

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2000086807A Expired - Fee Related JP4474013B2 (ja) | 1999-03-26 | 2000-03-27 | 情報処理装置 |

Country Status (2)

| Country | Link |

|---|---|

| US (1) | US7117157B1 (ja) |

| JP (1) | JP4474013B2 (ja) |

Families Citing this family (51)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US7499574B1 (en) * | 2002-11-07 | 2009-03-03 | Honda Motor Co., Ltd. | Video-based face recognition using probabilistic appearance manifolds |

| EP1453287B1 (en) * | 2003-02-28 | 2007-02-21 | Xerox Corporation | Automatic management of conversational groups |

| US7617094B2 (en) | 2003-02-28 | 2009-11-10 | Palo Alto Research Center Incorporated | Methods, apparatus, and products for identifying a conversation |

| US20050131744A1 (en) * | 2003-12-10 | 2005-06-16 | International Business Machines Corporation | Apparatus, system and method of automatically identifying participants at a videoconference who exhibit a particular expression |

| US20050131697A1 (en) * | 2003-12-10 | 2005-06-16 | International Business Machines Corporation | Speech improving apparatus, system and method |

| JP4595364B2 (ja) * | 2004-03-23 | 2010-12-08 | ソニー株式会社 | 情報処理装置および方法、プログラム、並びに記録媒体 |

| US20050240407A1 (en) * | 2004-04-22 | 2005-10-27 | Simske Steven J | Method and system for presenting content to an audience |

| JP5055781B2 (ja) * | 2006-02-14 | 2012-10-24 | 株式会社日立製作所 | 会話音声分析方法、及び、会話音声分析装置 |

| JP2007318438A (ja) * | 2006-05-25 | 2007-12-06 | Yamaha Corp | 音声状況データ生成装置、音声状況可視化装置、音声状況データ編集装置、音声データ再生装置、および音声通信システム |

| US20080255840A1 (en) * | 2007-04-16 | 2008-10-16 | Microsoft Corporation | Video Nametags |

| US8526632B2 (en) * | 2007-06-28 | 2013-09-03 | Microsoft Corporation | Microphone array for a camera speakerphone |

| US8330787B2 (en) * | 2007-06-29 | 2012-12-11 | Microsoft Corporation | Capture device movement compensation for speaker indexing |

| US8165416B2 (en) * | 2007-06-29 | 2012-04-24 | Microsoft Corporation | Automatic gain and exposure control using region of interest detection |

| JP2010086074A (ja) * | 2008-09-29 | 2010-04-15 | Hitachi Omron Terminal Solutions Corp | 音声処理装置、音声処理方法、および、音声処理プログラム |

| EP2590432B1 (en) | 2010-06-30 | 2020-04-08 | Panasonic Intellectual Property Management Co., Ltd. | Conversation detection device, hearing aid and conversation detection method |

| US8725506B2 (en) * | 2010-06-30 | 2014-05-13 | Intel Corporation | Speech audio processing |

| US8676574B2 (en) | 2010-11-10 | 2014-03-18 | Sony Computer Entertainment Inc. | Method for tone/intonation recognition using auditory attention cues |

| US8756061B2 (en) | 2011-04-01 | 2014-06-17 | Sony Computer Entertainment Inc. | Speech syllable/vowel/phone boundary detection using auditory attention cues |

| US20120259638A1 (en) * | 2011-04-08 | 2012-10-11 | Sony Computer Entertainment Inc. | Apparatus and method for determining relevance of input speech |

| EP2901448A4 (en) * | 2012-09-26 | 2016-03-30 | Nokia Technologies Oy | METHOD, APPARATUS AND COMPUTER PROGRAM PRODUCT FOR CREATING AUDIO COMPOSITION SIGNAL |

| US9031293B2 (en) | 2012-10-19 | 2015-05-12 | Sony Computer Entertainment Inc. | Multi-modal sensor based emotion recognition and emotional interface |

| US9020822B2 (en) | 2012-10-19 | 2015-04-28 | Sony Computer Entertainment Inc. | Emotion recognition using auditory attention cues extracted from users voice |

| US9672811B2 (en) | 2012-11-29 | 2017-06-06 | Sony Interactive Entertainment Inc. | Combining auditory attention cues with phoneme posterior scores for phone/vowel/syllable boundary detection |

| JP5989603B2 (ja) * | 2013-06-10 | 2016-09-07 | 日本電信電話株式会社 | 推定装置、推定方法、およびプログラム |

| WO2014199596A1 (ja) * | 2013-06-10 | 2014-12-18 | パナソニック インテレクチュアル プロパティ コーポレーション オブ アメリカ | 話者識別方法、話者識別装置及び話者識別システム |

| US9672412B2 (en) * | 2014-06-24 | 2017-06-06 | The Chinese University Of Hong Kong | Real-time head pose tracking with online face template reconstruction |

| KR20160024002A (ko) | 2014-08-21 | 2016-03-04 | 삼성전자주식회사 | 비쥬얼 사운드 이미지를 제공하는 방법 및 이를 구현하는 전자 장치 |

| JP6528574B2 (ja) | 2015-07-14 | 2019-06-12 | 株式会社リコー | 情報処理装置、情報処理方法、および情報処理プログラム |

| JP2017028375A (ja) | 2015-07-16 | 2017-02-02 | 株式会社リコー | 映像処理装置、及びプログラム |

| JP2017028633A (ja) | 2015-07-27 | 2017-02-02 | 株式会社リコー | 映像配信端末、プログラム、及び、映像配信方法 |

| US10962780B2 (en) * | 2015-10-26 | 2021-03-30 | Microsoft Technology Licensing, Llc | Remote rendering for virtual images |

| FR3047628B1 (fr) * | 2016-02-05 | 2018-05-25 | Christophe Guedon | Procede d'aide au suivi d'une conversation pour personne malentendante |

| JP6642316B2 (ja) * | 2016-07-15 | 2020-02-05 | コニカミノルタ株式会社 | 情報処理システム、電子機器、情報処理装置、情報処理方法、電子機器処理方法、及びプログラム |

| CN106356067A (zh) * | 2016-08-25 | 2017-01-25 | 乐视控股(北京)有限公司 | 录音方法、装置及终端 |

| CN116679845A (zh) | 2017-02-06 | 2023-09-01 | 平蛙实验室股份公司 | 触摸感测装置 |

| JP6859807B2 (ja) * | 2017-03-31 | 2021-04-14 | 日本電気株式会社 | 情報処理装置、情報処理方法および情報処理プログラム |

| US10091412B1 (en) * | 2017-06-30 | 2018-10-02 | Polycom, Inc. | Optimal view selection method in a video conference |

| CN117311543A (zh) | 2017-09-01 | 2023-12-29 | 平蛙实验室股份公司 | 触摸感测设备 |

| US10951859B2 (en) | 2018-05-30 | 2021-03-16 | Microsoft Technology Licensing, Llc | Videoconferencing device and method |

| WO2020080992A1 (en) | 2018-10-20 | 2020-04-23 | Flatfrog Laboratories Ab | Frame for a touch-sensitive device and tool therefor |