以下、適宜図面を参照しながら、実施の形態を詳細に説明する。但し、必要以上に詳細な説明は省略する場合がある。例えば、既によく知られた事項の詳細説明や実質的に同一の構成に対する重複説明を省略する場合がある。これは、以下の説明が不必要に冗長になるのを避け、当業者の理解を容易にするためである。なお、発明者(ら)は、当業者が本開示を十分に理解するために添付図面および以下の説明を提供するのであって、これらによって特許請求の範囲に記載の主題を限定することを意図するものではない。

(実施の形態1)

実施の形態1では、本開示に係る撮像装置の一例として、画像認識技術に基づいて被写体を検出し、検出した被写体の大きさに応じた収音エリアの制御、及び収音する音声を強調する収音ゲインの制御を行うデジタルカメラについて説明する。

〔1−1.構成〕

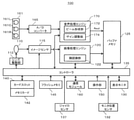

図1は、本実施形態に係るデジタルカメラ100の構成を示す図である。本実施形態のデジタルカメラ100は、イメージセンサ115と、画像処理エンジン120と、表示モニタ130と、コントローラ135とを備える。さらに、デジタルカメラ100は、バッファメモリ125と、カードスロット140と、フラッシュメモリ145と、操作部150と、通信モジュール160とを備える。また、デジタルカメラ100は、マイク161と、マイク用のアナログ/デジタル(A/D)コンバータ165と、音声処理エンジン170とを備える。また、デジタルカメラ100は、例えば光学系110及びレンズ駆動部112を備える。さらに、デジタルカメラ100は、例えば磁気センサ132と、加速度センサ137とを備える。

図2は、デジタルカメラ100の背面を例示する。図2では、デジタルカメラ100の3軸方向X,Y,Zと共に、重力方向Gを例示している。X,YおよびZ軸は、それぞれデジタルカメラ100の水平画角方向、垂直画角方向および光学系110におけるレンズの光軸方向に対応する。図2の例では、デジタルカメラ100のY軸方向が重力方向Gに沿った向き即ち横向きとなっている。

本実施形態のデジタルカメラ100は、ユーザが自身を撮影する自分撮りをしたり、デジタルカメラ100を縦向きに用いる縦撮りをしたりして利用可能である。図3は、自分撮り時のデジタルカメラ100の状態を例示する。図4は、縦撮り時のデジタルカメラ100の状態を例示する。

図1に戻り、光学系110は、フォーカスレンズ、ズームレンズ、光学式手ぶれ補正レンズ(OIS)、絞り、シャッタ等を含む。フォーカスレンズは、イメージセンサ115上に形成される被写体像のフォーカス状態を変化させるためのレンズである。ズームレンズは、光学系で形成される被写体像の倍率を変化させるためのレンズである。フォーカスレンズ等は、それぞれ1枚又は複数枚のレンズで構成される。

レンズ駆動部112は、光学系110におけるフォーカスレンズ等を駆動する。レンズ駆動部112はモータを含み、コントローラ135の制御に基づいてフォーカスレンズを光学系110の光軸に沿って移動させる。レンズ駆動部112においてフォーカスレンズを駆動する構成は、DCモータ、ステッピングモータ、サーボモータ、または超音波モータなどで実現できる。

イメージセンサ115は、光学系110を介して形成された被写体像を撮像して、撮像データを生成する。撮像データは、イメージセンサ115による撮像画像を示す画像データを構成する。イメージセンサ115は、所定のフレームレート(例えば、30フレーム/秒)で新しいフレームの画像データを生成する。イメージセンサ115における、撮像データの生成タイミングおよび電子シャッタ動作は、コントローラ135によって制御される。イメージセンサ115は、CMOSイメージセンサ、CCDイメージセンサ、またはNMOSイメージセンサなど、種々のイメージセンサを用いることができる。

イメージセンサ115は、動画像、静止画像の撮像動作、スルー画像の撮像動作等を実行する。スルー画像は主に動画像であり、ユーザが例えば静止画像の撮像のための構図を決めるために表示モニタ130に表示される。

スルー画像、動画像及び静止画像は、それぞれ本実施形態における撮像画像の一例である。イメージセンサ115は、本実施形態における撮像部の一例である。

画像処理エンジン120は、イメージセンサ115から出力された撮像データに対して各種の処理を施して画像データを生成したり、画像データに各種の処理を施して、表示モニタ130に表示するための画像を生成したりする。各種処理としては、ホワイトバランス補正、ガンマ補正、YC変換処理、電子ズーム処理、圧縮処理、伸張処理等が挙げられるが、これらに限定されない。画像処理エンジン120は、ハードワイヤードな電子回路で構成してもよいし、プログラムを用いたマイクロコンピュータ、プロセッサなどで構成してもよい。

本実施形態において、画像処理エンジン120は、撮像画像の画像認識によって人の顔といった被写体の検出機能を実現する顔認識部122を含む。顔認識部122は、例えば、ルールベースの画像認識処理によって顔検出を行い、検出情報を出力する。顔検出は、種々の画像認識アルゴリズムによって行われてもよい。検出情報は、被写体の検出結果に対応する位置情報を含む。位置情報は、例えば処理対象の画像Im上の水平位置及び垂直位置で規定され、例えば検出された被写体として人の顔を矩形状に囲む領域を示す(図11参照)。

表示モニタ130は、種々の情報を表示する表示部の一例である。例えば、表示モニタ130は、イメージセンサ115で撮像され、画像処理エンジン120で画像処理された画像データが示す画像(スルー画像)を表示する。また、表示モニタ130は、ユーザがデジタルカメラ100に対して種々の設定を行うためのメニュー画面等を表示する。表示モニタ130は、例えば、液晶ディスプレイデバイスまたは有機ELデバイスで構成できる。

本実施形態のデジタルカメラ100は、例えば図2,3に示すように、表示モニタ130の位置を変更可能な可動式で構成される。図2の例では、表示モニタ130が、デジタルカメラ100の背面側(−Z側)に表示面を向けた位置にある。こうした表示モニタ130の位置を以下「通常位置」という。図3の例では、表示モニタ130が、デジタルカメラ100の前面側(+Z側)即ち被写体側に表示面を向けた位置にある。こうした表示モニタ130の位置を以下「自分撮り位置」という。

磁気センサ132は、表示モニタ130が通常位置にあるか又は自分撮り位置にあるかを検知する検知部の一例である。磁気センサ132は、例えば表示モニタ130の位置の検出結果を示す検出信号をコントローラ135に出力する。

可動式の表示モニタ130としては、例えばバリアングル式またはチルト式を採用できる。例えば、表示モニタ130を回動可能にデジタルカメラ100の本体に連結するヒンジ131が設けられる。磁気センサ132は、例えばヒンジ131内部に設けられ、図2,3に対応する2状態を有するスイッチ等で構成される。

加速度センサ137は、例えば3軸方向X,Y,Zの内の1つ又は複数の角速度を検出して、検出信号をコントローラ135に出力する。加速度センサ137は、重力加速度の検出状態に基づき、デジタルカメラ100の姿勢が、図2に例示したような横向きか、又は図4に例示したような縦向きかを検出する姿勢検出部の一例である。

操作部150は、デジタルカメラ100の外装に設けられた操作釦や操作レバー等のハードキーの総称であり、使用者による操作を受け付ける。操作部150は、例えば、レリーズ釦、モードダイヤル、タッチパネル、カーソルボタン、ジョイスティックを含む。操作部150はユーザによる操作を受け付けると、ユーザ操作に対応した操作信号をコントローラ135に送信する。操作部150は、例えば図2に示すように、レリーズボタン151、選択ボタン152、決定ボタン153、機能ボタン154およびタッチパネル155等を含む。

コントローラ135は、デジタルカメラ100全体の動作を統括制御する。コントローラ135はCPU等を含み、CPUがプログラム(ソフトウェア)を実行することで所定の機能を実現する。コントローラ135は、CPUに代えて、所定の機能を実現するように設計された専用の電子回路で構成されるプロセッサを含んでもよい。すなわち、コントローラ135は、CPU、MPU、GPU、DSU、FPGA、ASIC等の種々のプロセッサで実現できる。コントローラ135は1つまたは複数のプロセッサで構成してもよい。また、コントローラ135は、画像処理エンジン120などと共に1つの半導体チップで構成してもよい。

バッファメモリ125は、画像処理エンジン120やコントローラ135のワークメモリとして機能する記録媒体である。バッファメモリ125は、DRAM(Dynamic Random Access Memory)などにより実現される。フラッシュメモリ145は不揮発性の記録媒体である。また、図示していないが、コントローラ135は各種の内部メモリを有してもよく、例えばROMを内蔵してもよい。ROMには、コントローラ135が実行する様々なプログラムが記憶されている。また、コントローラ135は、CPUの作業領域として機能するRAMを内蔵してもよい。

カードスロット140は、着脱可能なメモリカード142が挿入される手段である。カードスロット140は、メモリカード142を電気的及び機械的に接続可能である。メモリカード142は、内部にフラッシュメモリ等の記録素子を備えた外部メモリである。メモリカード142は、画像処理エンジン120で生成される画像データなどのデータを格納できる。

通信モジュール160は、通信規格IEEE802.11またはWi−Fi規格等に準拠した通信を行う通信モジュール(回路)である。デジタルカメラ100は、通信モジュール160を介して、他の機器と通信することができる。デジタルカメラ100は、通信モジュール160を介して、他の機器と直接通信を行ってもよいし、アクセスポイント経由で通信を行ってもよい。通信モジュール160は、インターネット等の通信ネットワークに接続可能であってもよい。

マイク161は、音を収音する収音部の一例である。マイク161は、収音した音声を電気信号であるアナログ信号に変換して出力する。本実施形態のマイク161は、3つのマイクロフォン素子161L,161C及び161Rを含む。マイク161は、2つ又は4つ以上のマイクロフォン素子から構成されてもよい。

マイク用のA/Dコンバータ165は、マイク161からのアナログ信号をデジタル信号の音声データに変換する。マイク用のA/Dコンバータ165は、本実施形態における音声取得部の一例である。なお、マイク161は、デジタルカメラ100の外部にあるマイクロフォン素子を含んでもよい。この場合、デジタルカメラ100は音声取得部として、外部のマイク161に対するインタフェース回路を備える。

音声処理エンジン170は、マイク用のA/Dコンバータ165等の音声取得部から出力された音声データを受信して、受信した音声データに対して種々の音声処理を施す。音声処理エンジン170は、本実施形態における音声処理部の一例である。

本実施形態の音声処理エンジン170は、例えば図1に示すように、ビーム形成部172と、ゲイン調整部174とを備える。ビーム形成部172は、音声の指向性を制御する機能を実現する。ビーム形成部172の詳細については後述する。ゲイン調整部174は、入力される音声データに、例えばコントローラ135によって設定される収音ゲインを乗じる乗算処理を行って、音声を増幅する。ゲイン調整部174は、入力の音声データに負のゲインを乗じて音声を抑圧する処理を行ってもよい。収音ゲイン調整部14はさらに、入力される音声データの周波数特性及びステレオ特性を変化させる機能を有してもよい。収音ゲインの設定についての詳細は後述する。

〔1−1−1.ビーム形成部について〕

本実施形態におけるビーム形成部172の詳細を、以下説明する。

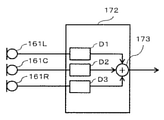

ビーム形成部172は、マイク161が収音する音声の指向性を制御するビームフォーミングを行う。本実施形態におけるビーム形成部172の構成例を図5に示す。

図5に示すように、ビーム形成部172は、例えばフィルタD1〜D3と加算器173を備え、各マイクロフォン素子161L,161C及び161Rで収音された音声の遅延期間を調整して、その重み付き和を出力する。ビーム形成部172によると、マイク161の収音指向性の方向および範囲を制御して、マイク161が収音する物理的な範囲を設定できる。

ビーム形成部172は、図示では1つの加算器173により1チャネルの出力を行うが、2つ以上の加算器を備え、例えばステレオ出力のような各チャネルで異なる出力を行う構成であってもよい。また、加算器173の他に減算器を用いて、特に感度が低い方向である死角を特定方向に有する指向性を形成してもよいし、環境に適応して処理を変える適応ビームフォーミングを行ってもよい。また、音声信号の周波数帯域によって異なる処理を適用してもよい。

図5では、マイクロフォン素子161L,161C及び161Rを直線的に配置した例を示しているが、各マイクロフォン素子の配置は、これに限らない。例えば、三角形状に配置する場合であっても、フィルタD1〜D3の遅延期間及び重みを適宜調整して、マイク161の収音指向性を制御できる。また、ビーム形成部172は、収音指向性の制御に公知の手法を適用してもよい。例えば、OZO Audioといった音声処理技術を用いて、指向性を形成する処理を行い、併せて音声の雑音を抑制する処理等を実行してもよい。

上記のようなビーム形成部172により設定可能なデジタルカメラ100の収音エリアについて説明する。

〔1−1−2.収音エリアについて〕

図6は、デジタルカメラ100において定義される収音エリアの例を示す。図6は、収音エリアを、デジタルカメラ100を中心とする円の扇形領域によって例示している。本実施形態のデジタルカメラ100では、水平画角方向は、マイクロフォン素子161R,161Cおよび161Rが並ぶ方向と一致する。

図6(A)は、角度範囲401(例えば70°)において、デジタルカメラ100の前方(すなわち撮影方向)に収音エリアを向ける「前方中心収音エリア」41を示す。図6(B)は、角度範囲401において、デジタルカメラ100の左方に収音エリアを向ける「左半分収音エリア」42を示す。図6(C)は、角度範囲401において、デジタルカメラ100の右方に収音エリアを向ける「右半分収音エリア」43を示す。図6(D)は、角度範囲401より大きい角度範囲402(例えば160°)において、デジタルカメラ100の前方に収音エリアを向ける「前方収音エリア」44を示す。これらの収音エリアは、本実施形態における複数の所定エリアの一例であり、角度範囲401及び402は、第1の角度範囲及び第2の角度範囲の一例である。

本実施形態のデジタルカメラ100は、被写体が撮像画像の中心部分に位置するとき、図6(A)の前方中心収音エリア41を用いる。また、被写体が撮像画像の左半分に位置するとき、図6(B)の左半分収音エリア42を用い、被写体が撮像画像の右半分に位置するとき、図6(C)の右半分収音エリア43を用いる。さらに、被写体が撮像画像の全体に位置するとき、主に図6(D)の前方収音エリア44を用いる。

図11(B)の例では、収音対象の被写体R1及びR3が撮像画像の中心部分に位置するため、前方中心収音エリア41が用いられる。図11(C)の例では、収音対象の被写体R1及びR2が撮像画像の左半分に位置するため、左半分収音エリア42が用いられる。

デジタルカメラ100のマイク161といった撮像装置の収音部において、マイクロフォン素子の数および配置は、素子の搭載スペース等の事情により制約を受ける。例えば、ユーザが複数の被写体について音声を記録したい撮影場面において、マイクロフォン素子数の制約により収音指向性を十分に狭められない場合がある。こうした場合でも、本実施形態のデジタルカメラ100は、ユーザの撮影場面を想定して収音エリアを定義しておき、顔認識を用いて収音エリアを決定することで、ユーザの意図に沿った収音エリアを提供することができる。

〔1−1−3.マイク設定について〕

デジタルカメラ100におけるマイク161の収音エリアに関する設定について、図7〜図8を用いて説明する。

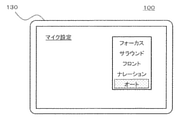

図7は、デジタルカメラ100における設定メニューの表示例を示す。本実施形態のデジタルカメラ100は、マイク161の収音エリアを制御する動作モード(即ち収音モード)として、例えば図7に示すように、「オート」、「サラウンド」、「フロント」、「フォーカス」及び「ナレーション」というモードを有する。

フォーカスモードは、デジタルカメラ100による顔認識及び画角に連動して、自動的にマイク161の指向性を変え、収音エリアを調整する動作モードである。例えば、フォーカスモードは上述した各種収音エリア41〜44を切り替えて用いることにより実現できる。フォーカスモードを4つの収音エリア41〜44で敢えて大まかに実現することにより、被写体の僅かな動きによって頻繁に収音指向性が変化するような事態を回避し、ユーザの聴感上の煩わしさを低減することができる。デジタルカメラ100において更なる収音エリアを図8に例示する。

図8(A)は、サラウンドモードの収音エリア45を例示する。サラウンドモードは、デジタルカメラ100の左右前後に渡る広い範囲の音を収音するための動作モードである。サラウンドモードの収音エリア45は、例えばXZ平面の全周360°といった角度範囲を有する。

図8(B)は、フロントモードの収音エリア46を例示する。フロントモードは、デジタルカメラ100の前方の音を収音するための動作モードである。フロントモードの収音エリア46は、デジタルカメラ100から+Z側に向いており、例えば上述した前方収音エリア44以上の角度範囲を有する。

図8(C)は、ナレーションモードの収音エリア47を例示する。ナレーションモードは、デジタルカメラ100の後方の音を収音するための動作モードである。ナレーションモードの収音エリア47は、デジタルカメラ100から−Z側に向けて形成される。ナレーションモードが設定された状態で、表示モニタ130が自分撮り位置にあることが検出された場合、デジタルカメラ100は、フォーカスモードの動作を実行してもよい。

オートモードは、デジタルカメラ100の撮影状態に連動して、自動的にマイク161の指向性を変え、収音エリアを調整する動作モードである。デジタルカメラ100の撮影状態は、例えばフォーカスモードで考慮される顔認識等に加えて、自分撮りか否か、及び縦撮りか横撮りかなども含む。

以上のような各種の収音モードを設定するマイク設定は、例えばデジタルカメラ100の設定メニューにおける動画メニューの1つとして設けられる。ユーザは、タッチパネル155のタッチ操作あるいは各種ボタン152,153の押下操作により、設定メニューから所望の収音モードを選択可能である。又、マイク設定は、予め機能ボタン154等に割り当てられてもよい。オートモード等の特定の収音モードの設定が、機能ボタン154等に割り当てられてもよい。

〔1−2.動作〕

以上のように構成されるデジタルカメラ100の動作について説明する。以下では、デジタルカメラ100による動画撮影時の動作を説明する。

デジタルカメラ100は順次、光学系110を介して形成された被写体像をイメージセンサ115で撮像して撮像データを生成する。画像処理エンジン120は、イメージセンサ115により生成された撮像データに対して各種処理を施して画像データを生成し、バッファメモリ125に記録する。また、画像処理エンジン120の顔認識部122は、撮像データが示す画像に基づき、被写体の領域を検出して、例えば検出情報をコントローラ135に出力する。

本実施形態のデジタルカメラ100は、顔認識部122に入力された撮像画像において、画像認識処理により顔検出を行い、検出情報に基づいてオートフォーカス(AF)制御の対象とする被写体を特定する動作モードである顔認識モードを備える。

以上の撮像動作と同時並行で、デジタルカメラ100は、マイク161において収音を行う。マイク用のA/Dコンバータ165から収音結果の音声データを音声処理エンジン170にて処理する。音声処理エンジン170は、処理後の音声データAoutをバッファメモリ125に記録する。

コントローラ135は、バッファメモリ125を介して、画像処理エンジン120から受け付ける画像データと音声処理エンジン170から受け付ける音声データとの間で、同期を取って動画をメモリカード142に記録する。また、コントローラ135は逐次、表示モニタ130にスルー画像を表示させる。ユーザは、表示モニタ130のスルー画像により随時、撮影の構図等を確認することができる。動画撮影の動作は、操作部150におけるユーザの操作に応じて開始/終了される。

以上のようなデジタルカメラ100の動画撮影においては、様々な撮影状態においてユーザが収音したい種々の状況が考えられる。例えば撮影者とその同伴者など、仲間内で会話をする被写体のグループに注目して行われる場合がある。この場合、音声についても、当該被写体のグループの発声を明瞭に収音したいとのニーズが考えられる。

本実施形態のデジタルカメラ100は、例えば上述したフォーカスモードの動作として、画像処理エンジン120における顔認識部122の検出情報によって被写体を検出し、AF対象の被写体が決定されたときに、音声処理エンジン170において、当該被写体および撮影する空間で当該被写体の周囲にいる被写体について収音する音声を強調する処理を実行する。このように、画像処理エンジン120の顔認識と音声処理エンジン170の音声強調等とを連動させて、上記のような会話をする被写体のグループによる音声を強調した収音を精度良く実現する。

さらに、本実施形態のデジタルカメラ100は、オートモードの動作として、上記のようなフォーカスモードの動作に加えて、さらに様々な撮影状態に応じて適切な収音制御を実現する。図9を用いて、オートモードの動作の概要を説明する。

図9は、デジタルカメラ100のオートモードと各種収音モードとの対応関係を例示する。オートモードのデジタルカメラ100は、例えば横撮りの状態で顔認識が為されたときは、フォーカスモードと同様の動作を行う。

一方、顔認識が為されていないときは、例えば自撮りでない状態(図2参照)であれば、デジタルカメラ100は、サラウンドモードと同様の動作を行う、すなわちサラウンドモードの収音エリア45を採用する。また、顔認識が為されず、自分撮りが行われる状態(図3参照)では、デジタルカメラ100は、フロントモードと同様の動作を行う。

また、縦撮りの場合、顔認識が為されていないときの動作は、上述した横撮りの場合と同様である。一方、縦撮りにおいて顔認識が為された場合、本実施形態のデジタルカメラ100は、フォーカスモードの代わりに、フロントモードと同様の動作を行う。

以上のようなオートモードの動作によると、図9に示すように、種々の撮影状態に応じて各種の収音モードの動作を組み合わせることにより、それぞれの撮影状態において適切な収音制御を実現し易くすることができる。

〔1−2−1.フォーカスモードの動作〕

図10及び図11を用いて、本実施形態に係るデジタルカメラ100のフォーカスモードの動作の概要を説明する。

図10は、本実施形態に係るデジタルカメラ100のフォーカスモードの動作を例示するフローチャートである。図10のフローチャートに示す各処理は、例えばデジタルカメラ100がフォーカスモードに設定された状態において所定の周期で繰り返し実行される。所定の周期は、例えば動画のフレーム周期である。図11は、本実施形態に係るデジタルカメラ100のフォーカスモードの動作の概要を説明するための図である。

コントローラ135は、顔認識部122による検出情報に基づいてAF対象を特定し、AF制御を実行する(S1)。AF対象は、AF制御の対象とする被写体の画像上の領域を示す。図11(A)は、顔認識部122の検出情報において被写体が検出された領域を示す顔領域R1,R2及びR3を含む撮像画像Imを例示する。顔領域R1,R2及びR3は、本実施形態における被写体領域の一例である。例えば顔領域R1がAF対象の顔領域60として特定される。

次にコントローラ135は、AF対象として特定された顔領域が存在するか否かを判断する(S2)。具体的には、コントローラ135は、顔領域が検出されていて、かつAF対象が顔領域であるか否かを判断する。

AF対象の顔領域60がある場合(S2でYES)、コントローラ135は、検出情報における被写体からマイク161の収音対象を選別する処理を実行する(S3)。収音対象は、マイク161により音声を強調して収音する対象とする被写体である。AF対象として特定された顔領域R1(60)は、収音対象になる。図11(B)は、図11(A)に示す検出情報に基づき、顔領域R1及びR3を収音対象に決定し、一方で顔領域R2を収音対象としない例を示す。

本実施形態のデジタルカメラ100は、収音対象の選別処理(S3)において、AF対象の顔領域R1(60)に加え、撮像画像Imにおいて顔領域R1と同程度の顔の大きさを示す顔R3を、更なる収音対象として決定する。一方で、顔領域R1と異なる大きさの顔領域R2は収音対象から外される。これにより、人物21と人物23がデジタルカメラ100から同程度の距離にいて(すなわち、Z軸方向の距離の差が小さい)、人物22は異なる距離にいることを反映して、例えば仲間内で会話する被写体のグループを収音対象とすることができる。収音対象の選別処理(S3)についての詳細は後述する。

次に、コントローラ135は、決定した収音対象に基づいて、収音エリアを決定する処理を行う(S4)。収音エリアの決定処理(S4)は、決定した全ての収音対象を含む収音エリアを決定する。図11(B)の例において、収音エリアを収音対象の顔領域R1及びR3を含むように前方中心収音エリア41(図6(A))に決定されている。収音エリアの決定処理(S4)についての詳細は後述する。

次に、コントローラ135は、決定した収音対象及び収音エリアに基づいて、顔認識を用いて収音の制御を行う(S5)。顔認識を用いた収音制御(S5)は、コントローラ135が決定した収音対象、収音エリア及び収音ゲインを含む収音パラメータを、音声処理エンジン170に設定することによって行われる。音声処理エンジン170は、収音パラメータに応じた収音指向性及び収音ゲインを実現する。

一方、例えば顔認識モードの動作中に顔領域が検出されない等、AF対象の顔領域60がない場合(S2でNO)、コントローラ135は、顔認識を用いない収音制御(S6)を行う。顔認識を用いた、または用いない収音制御(S5,S6)についての詳細は後述する。

コントローラ135は、ステップS5またはS6の収音制御を実行後、ステップS1以降の処理を繰り返す。

以上の処理によると、本実施形態のデジタルカメラ100は、顔認識により検出した被写体から収音対象を選別し、収音対象を全て含む収音エリアを決定して、顔認識を用いた収音制御を行う。これにより、例えば仲間内で会話をする被写体のグループについて、音声を強調して収音することができる。

なお、顔認識によるAF制御(S1)において、検出情報に基づくAF対象の特定は、例えば表示モニタ130に表示させたスルー画像上に顔領域を示す枠表示等を行い、操作部150によりユーザが枠表示を選択する操作を受けて実行することができる。

図11(C)は、図11(A),(B)とは異なる位置に人物21〜23がいる場合の撮像画像Imの例を示す。デジタルカメラ100は、図11(B)の例と同様に、まず、例えば顔領域R1をAF対象の顔領域60として特定し(S1)、収音対象に決定する。図11(C)の例において、収音対象の選別処理(S3)は、撮像画像Im上で顔領域R1と同程度の顔の大きさである顔領域R2を収音対象に決定し、顔領域R3を収音対象から外す。収音エリアの決定処理(S4)は、収音対象として決定された顔領域R1及びR2を含む左半分収音エリア42(図6(B))を収音エリアに決定する。顔認識を用いた収音制御(S5)は、左半分収音エリア42に指向性を制御して人物21及び22の音声を明瞭に収音するように、収音パラメータを設定することによって行われる。

〔1−2−2.収音対象の選別処理〕

図10のステップS3における収音対象の選別処理の詳細を、図12〜図13を用いて説明する。

図12は、デジタルカメラ100の収音対象の選別処理(S3)を例示するフローチャートである。図12に示すフローチャートによる各処理は、図10のステップS11でYESに進んだとき、例えばデジタルカメラ100のコントローラ135によって実行される。

図13は、デジタルカメラ100における収音対象の選別処理(S3)を説明するための図である。以下では、図11(A),(B)の例で収音対象を決定する動作について説明する。

図12のフローチャートにおいて、コントローラ135は、図10のステップS1において特定したAF対象の顔領域に対応する被写体を収音対象に決定する(S10)。このとき、コントローラ135は、顔認識部122から取得した検出情報に基づいて、AF対象の顔領域の大きさ(即ち顔幅W)を、他の被写体から収音対象を選別する基準に設定する。

図13(A)は、図11(A),(B)の例において収音対象が選別される場合を例示する。顔幅W1,W2,W3は、撮像画像Imにおける顔領域R1,R2,R3の大きさをX軸方向の幅で示す。図13(A)の例において、コントローラ135は、AF対象の顔領域R1の顔幅W1を、基準の顔幅Wに設定する(S10)。設定した顔幅Wは、例えばコントローラ135のRAM等に保持される。

次に、コントローラ135は、AF対象の他に検出された被写体があるか否かを判断する(S11)。具体的には、コントローラ135は、顔認識部122の検出情報がAF対象の顔領域の他に顔領域を含むか否かを判断する。

AF対象の他に検出された被写体がある場合(S11でYES)、コントローラ135は、収音対象の候補である収音候補として、一つの被写体iを選択する(S12)。図13(A)の例では、検出情報はAF対象の顔領域R1の他の顔領域R2及びR3が、ステップS12ごとに順次、収音候補の被写体iに対応付けて選択される。

コントローラ135は、選択した被写体iの顔幅Wiと、基準の顔幅Wとを比較する演算を行う(S13)。具体的には、コントローラ135は、基準の顔幅Wに対する被写体iの顔幅Wiの割合Wi/Wを算出する。図13(A)の例において、顔領域R2を収音候補とする選択時(S12)には、その顔幅W2についての割合W2/Wが算出される(S13)。

コントローラ135は、収音候補の顔幅Wiと基準の顔幅W間の割合Wi/Wが、所定範囲内であるか否かを判断する(S14)。所定範囲は、例えば収音候補の顔幅Wiが相対的に基準の顔幅Wiと同程度であるとみなす範囲を規定する観点から、「1」よりも大きい上限値と、「1」よりも小さい下限値で規定される。なお、所定範囲を設定するためのユーザインタフェースが提供されてもよく、例えばユーザが操作部150により設定した所定範囲がバッファメモリ125等に保持されてもよい。

コントローラ135は、顔幅の割合Wi/Wが所定範囲内であると判断すると(S14でYES)、被写体iを収音対象とすることを決定する(S15)。

一方、コントローラ135は、顔幅の割合Wi/Wが所定範囲内でないと判断すると(S14でNO)、コントローラ135は、被写体iを収音対象としないことを決定する(S16)。図13(A)の例において、割合W2/Wは所定範囲の下限値を下回り、顔領域R2を収音対象としないことが決定される。

コントローラ135は、被写体iを収音対象とするか否かを決定すると(S15またはS16)、例えば被写体iについて決定した結果をバッファメモリ125に記録する(S17)。次に、コントローラ135は、収音候補として選択済みの被写体とは他の被写体について、ステップS11以降の処理を再び行う。

図13(A)の例では、顔領域R2の他に顔領域R3が検出情報に含まれる(S11でYES)。コントローラ135は、顔領域R3に対応する被写体を選択する(S12)と、顔領域R2の場合と同様に、基準の顔幅Wに対する顔幅W3の割合W3/Wを算出する(S13)。図13(A)の例では、割合W3/Wは「1」近傍に算出される。コントローラ135は、算出した顔幅の割合W3/Wが収音対象の所定範囲内であると判断して(S14でYES)、顔領域R3に対応する被写体を収音対象として決定する(S15)。

コントローラ135は、収音候補として選択されていない被写体がなくなるまで(ステップS11でNO)、ステップS11〜S17の処理を繰り返す。その後、コントローラ135は、収音対象の選別処理(S3)を終了して、図10のステップS4に進む。

以上の処理によると、顔認識により検出した被写体について、AF対象として特定した顔領域R1を基準とする相対的な顔領域R2,R3の大きさ比較が行われる。これにより、相対的な顔領域R3の大きさがAF対象の顔領域R1と同程度である被写体を選別して収音対象に決定することができる。

図13(B)は、図11(C)の例において収音対象が選別される場合を例示する。図13(B)の例において、顔領域R1は、図13(A)の例と同様にAF対象として特定されている。このことから、コントローラ135は、顔領域R1を収音対象に決定し、顔幅W1を基準の顔幅Wに設定する(S10)。

図13(B)の例では、顔領域R2の顔幅W2は、基準の顔幅W(=W1)と同程度の大きさである。一方、顔領域R3の顔幅W3は、他の顔幅W1及びW2と比較して大きい。本例において、コントローラ135は、割合W2/Wが所定範囲内であると判断して(S14でYES)、顔領域R2の被写体を収音対象として決定する(S15)。一方、割合W3/Wが所定範囲の上限値を上回るため(S14でNO)、顔領域R3の被写体は収音対象としないことが決定される(S16)。よって、本例の収音対象は、顔領域R1及びR2に対応する2つの被写体に決定される(図11(C)参照)。

図13(C)は、図11(C)と同様の撮影画像Imにおいて顔領域R3がAF対象の顔領域60として特定された(図10のS1)場合を例示する。コントローラ135は、顔領域R3を収音対象に決定し、顔幅W3を基準の顔幅Wに設定する(S10)。図13(C)の例において、割合W2/W及びW1/Wが所定範囲の下限値を下回るため(S14でNO)、顔領域R1及びR2に対応する被写体を収音対象としないことが決定される(S16)。よって、本例の収音対象は、顔領域R3に対応する1つの被写体に決定される。

以上のように、本実施形態のデジタルカメラ100は、画像認識により検出した複数の被写体から、AF対象と同程度の大きさである被写体を収音対象として決定することで、後述するユーザの意図に沿った収音エリアの決定に利用することができる。

〔1−2−3.収音エリアの決定処理〕

図10のステップS4における収音エリアの決定処理の詳細を、図14〜図15を用いて説明する。

図14は、本実施形態のデジタルカメラ100における収音エリアの決定処理(S4)を例示するフローチャートである。図14に示すフローチャートによる各処理は、図10のステップS3を実行した後、例えばデジタルカメラ100のコントローラ135によって実行される。

図15は、デジタルカメラ100における収音エリアの決定処理(S4)を説明するための図である。図15(A),(B)は、それぞれ図13(A),(B)の例に続いて、収音エリアを決定する場合を例示する。図15(C)は、図15(A),(B)とは更に別の場合を例示する。図15(A)〜(C)において、中心位置x0は、X軸方向における撮像画像Imの中心の位置を示し、画像幅Whは、X軸方向における撮像画像Imの幅を示す。画像範囲は、撮像画像Im上で中心位置x0を基準に、X座標−xhからxhの範囲x0±xhと規定される。X座標xhは、xh=Wh/2(>0)で定義される。

図14のフローチャートにおいて、コントローラ135は、全ての収音対象について、顔領域の中心等の位置が撮像画像Imの中心範囲にあるか否かを判断する(S20)。中心範囲は、撮像画像Imにおいて前方中心収音エリア41に対応付けられる範囲である。

中心範囲は、例えば図15(A)に示すように、撮像画像Im上で中心位置x0を基準に、X座標−xeからxeの範囲x0±xeとして規定される。X座標xeは、所定の画角θeと、画像幅Whに対応する水平画角θhとに基づき、例えばxe=xh×θe/θh(>0)で定義される。所定の画角θeは、例えば1人の人物を含める観点から予め設定され、例えば30°等である。コントローラ135は、例えば光学系110のズームレンズのズーム倍率等から現在の水平画角θhを取得して、中心範囲x0±xeを算出する。

水平画角θhが大きい広角撮影においては、X座標xeが小さくなり中心範囲x0±xeは狭い。一方、水平画角θhが小さい望遠撮影においては、X座標xeが大きくなり中心範囲x0±xeは広い。これにより、撮像する物理的な範囲と距離に対応した収音エリアの決定を実現しやすくすることができる。

全収音対象の顔領域の位置が中心範囲内にある場合(S20でYES)、コントローラ135は、収音エリアを前方中心収音エリア41に決定する(S21)。図15(A)の例では、収音対象は顔領域R1及びR3に対応する。それぞれの顔領域R1及びR3の中心の位置x1及びx3は、いずれもx0±xeの範囲内にある(S20でYES)。よって、収音エリアが前方中心収音エリア41に決定される(S21,図11(B)参照)。

一方、少なくとも一つ以上の収音対象の顔領域の位置が中心範囲内にない場合(S20でNO)、前方中心収音エリア41以外の収音エリアが用いられる。この場合、コントローラ135は、全ての収音対象について、例えば顔領域の位置が撮像画像Imにおける左右いずれか半分の範囲のみにあるか否かを判断する(S22)。左半分の範囲はX軸方向の中心位置x0よりもX座標が小さい範囲であり、右半分の範囲は中心位置x0よりもX座標が大きい範囲である。

全ての収音対象について、顔領域の位置が撮像画像Imにおける左半分または右半分の範囲のみにある場合(S22でYES)、コントローラ135は、さらに全収音対象の顔領域の位置が撮像画像Imにおける左半分の範囲内であるか否かを判断する(S23)。

全収音対象の顔領域の位置が撮像画像Imにおける左半分の範囲内である場合(S23でYES)、コントローラ135は、収音エリアを左半分収音エリア42に決定する(S24)。図15(B)の例では、収音対象は顔領域R1及びR2に対応する。顔領域R1の位置x1及び顔領域R2の位置x2が、X軸方向の中心位置x0より左(すなわち、X座標が小さい)側にあるため(S23でYES)、収音エリアは左半分収音エリア42に決定される(S24,図11(C)参照)。

一方、全収音対象の顔領域の位置が撮像画像Imにおける右半分の範囲内であって、左半分の範囲内でない(S23でNO)、コントローラ135は、収音エリアを右半分収音エリア43に決定する(S25)。

また、全ての収音対象の顔領域の位置が、撮像画像Imにおける左右いずれか半分の範囲のみにはない場合(S22でNO)、コントローラ135は、収音エリアを前方収音エリア44に決定する(S26)。図6(D),(A)に示すように、前方収音エリア44は、前方中心収音エリア41の角度範囲401より広い角度範囲402を有する。すなわち、前方収音エリア44は、撮像画像ImにおいてX軸方向に広い範囲に位置する収音対象の被写体を含む。

図15(C)の例では、収音対象は、顔領域R1,R2及びR3に対応する。顔領域R1〜R3の中心の位置x1,x2及びx3は、中心範囲x0±xe外の位置x1及びx2を含み(S20でNO)、且つ、左半分の範囲内の位置x1と右半分の範囲内の位置x2及びx3とを含む(S22,S23でNO)。したがって、本例において収音エリアは、前方収音エリア44に決定される(S26)。

コントローラ135は、収音エリアを決定すると(S21,S24〜S26)、決定した収音エリアをバッファメモリ125等に管理情報として記録する(S27)。これにより、収音エリアの決定処理(S4)は終了し、図10のステップS5に進む。

以上の処理によると、収音対象として決定した被写体の撮像画像上での位置に応じて、予め定義した複数の収音エリアから、全ての収音対象を含むように収音エリアが決定される。これにより、動画撮影において、ユーザの意図に沿った収音対象の被写体を含むように、収音エリアを決定することができる。

図17は、収音エリアの決定処理(S4)によって得られる管理情報を説明するための図である。図17(A)は、図13(A)及び図15(A)の例において、収音対象の選別処理(S3)及び収音エリアの決定処理(S4)を実行した段階で得られる管理情報を例示する。図17(B)は、図13(B)及び図15(B)の例における管理情報を例示する。

管理情報は、例えば収音対象の選別処理(S3)によって決定される「収音対象」、収音エリアの決定処理(S4)によって決定される「収音エリア」、「水平画角」及び「合焦距離」を関連付けて管理する。なお、合焦距離は、例えば顔認識によるAF制御(S1)を実行する際に取得される。例えば、コントローラ135は、合焦時における光学系110の各種レンズの位置或いは焦点距離に基づいて、対応する合焦距離を取得してもよい。また、デジタルカメラ100は、DFD(Depth from Defocus)技術または測距センサによる測定により、合焦距離を検出してもよい。

なお、本実施形態のデジタルカメラ100は、前方中心収音エリアの判断(S20)で用いる中心範囲の画角θeを設定可能であり、例えばコントローラ135のROM等に記録される。また、画角θeを設定するためのユーザインタフェースが提供され、例えばユーザが操作部150により設定した値がバッファメモリ125等に保持されてもよい。

〔1−2−4.収音制御〕

(1)図10のステップS5について

図10のステップS5における顔認識を用いた収音制御の詳細を、図16〜図18を用いて説明する。

収音パラメータ設定による収音制御において、本実施形態のデジタルカメラ100は、例えばAF対象の顔領域に対応する被写体について動画音声を強調するように、収音ゲインの設定を行う。収音ゲインは、例えば周波数フィルタ特性およびステレオセパレーション特性を有する。デジタルカメラ100は、例えばデジタルカメラ100が動画の撮影中に、AF対象の顔領域に合焦したときの水平画角及び合焦距離に基づき、収音ゲインを算出する。収音ゲインは、例えば算出される値が大きいほど人の声以外の周波数帯を抑制したりステレオ効果を制御したりして収音ズーム効果を生じさせるように規定される。

図16は、顔認識を用いた収音制御(S5)を例示するフローチャートである。図16のフローチャートに示す各処理は、図10のステップS4を実行した後、例えばデジタルカメラ100のコントローラ135によって実行される。

デジタルカメラ100は、図17に示す管理情報が保持された状態で、ステップS5の処理を開始する。

コントローラ135は、例えばバッファメモリ125から水平画角を取得して、水平画角に基づくゲインGhを算出する(S30)。図18(A)は、水平画角からゲインGhを求める関係を例示する。図18(A)の例で、ゲインGhは、予め定めたゲインの最大値Gmaxと最小値Gminの間で、水平画角が小さくなるほど増加する。これにより、ズーム等で水平画角が小さいほど収音時にゲインを大きくして、望遠側で撮影される被写体の音声を強調することができる。

コントローラ135は、ステップS30と同様に合焦距離を取得して、合焦距離に基づくゲインGdを算出する(S31)。図18(B)は、合焦距離からゲインGdを求める関係を例示する。図18(B)の例で、ゲインGdは、予め定めたゲインの最大値Gmaxと最小値Gminの間で、合焦距離が大きくなるほど増加する。これにより、デジタルカメラ100から遠い被写体に合焦するときほど収音時にゲインを大きくして、遠い被写体ほど音声を強調することができる。

コントローラ135は、算出した水平画角による収音ゲインGhと、合焦距離による収音ゲインGdと比較し、いずれか大きいゲインを収音ゲインGとする(S32)。これにより、例えば望遠の水平画角または遠い合焦距離で撮影を行うユーザの意図に沿って被写体の音声を強調するように、収音ゲインGを算出することができる。

コントローラ135は、過去の所定回数(例えば5回)にわたり算出された収音ゲインG及び決定された収音エリアが、互いに同じであるか否かを判断する(S33)。例えば収音ゲインGは、図10のステップS1〜S5の実行周期における所定回数の範囲内で、算出される毎に上記の管理情報と共に記憶される。コントローラ135は、過去の所定回数の収音ゲインGおよび収音エリアが同じであると判断した場合と(S33でYES)、ステップS34に進む。

コントローラ135は、ステップS3の収音対象の選別処理により決定した収音対象と、ステップS4の収音エリアの決定処理により決定した収音エリアと、ステップS32で算出した収音ゲインGを、音声処理エンジン170に収音パラメータとして設定する(S34)。音声処理エンジン170は、ビーム形成部172及びゲイン調整部174により、設定された収音パラメータに応じた収音エリア及び収音ゲインを実現する。

収音パラメータの設定(S34)後、コントローラ135は、顔認識を用いた収音制御の処理(S5)を終了する。また、コントローラ135は、過去の所定回数の収音ゲインGおよび収音エリアが同じでないと判断した場合(S33でNO)、ステップS34の処理を行わずに図10のステップS5の処理を終了する。その後、図10のステップS1以降の処理が繰り返される。

以上の処理によると、算出した収音ゲインと、顔認識に基づいて決定された収音対象及び収音エリアを、収音パラメータに設定して、AF対象を含む収音対象の被写体の音声を明瞭に収音しやすくする収音エリア及び収音ゲインを実現することができる。

なお、ステップS30とS31の実行順序は、本フローチャートの順に限らず、例えばステップS31でゲインGdを算出してから、ステップS30でゲインGhを算出してもよく、またはステップS30とS31を並列に実行してもよい。

また、以上のステップS33によると、収音エリア及び収音ゲインGが所定回数(例えば5回)変化しない場合のみ、収音パラメータが設定する処理(S34)が実行される。これにより、被写体の動きなどにより過度に頻繁に収音エリア及び収音ゲインGが変更されることを防ぎ、顔認識を用いた収音制御(S5)をユーザの意図に沿って精度よく実現することができる。

(2)図10のステップS6について

図10のステップS6における顔認識を用いない収音制御(S6)の詳細を、図19を用いて説明する。

図19は、顔認識を用いない収音制御(S6)を例示するフローチャートである。図19のフローチャートに示す各処理は、顔領域が検出されない等、図10のステップS2においてAF対象の顔領域がない(S2でNO)場合に、例えばデジタルカメラ100のコントローラ135によって実行される。

まず、コントローラ135は、収音エリアを、例えば前方収音エリア44に決定する(S40)。

次に、コントローラ135は、水平画角に基づくゲインGhをステップS30と同様に算出して、収音ゲインGとする(S41)。さらに、コントローラ135は、ステップS33と同様に、過去の所定回数にわたり算出された収音ゲインG及び決定された収音エリアが、互いに同じであるか否かを判断する(S42)。

コントローラ135は、過去の所定回数の収音ゲインGおよび収音エリアが同じであると判断した場合(S42でYES)、収音エリアと収音ゲインGを収音パラメータに設定し(S43)、顔認識を用いない収音制御(S6)を終了する。また、コントローラ135は、過去の所定回数の収音ゲインGおよび収音エリアが同じでないと判断した場合(S42でNO)、ステップS43の処理を行わずに図10のステップS6を終了する。ステップS6の終了後、ステップS1以降の処理が繰り返される。

以上の処理によると、AF対象の顔領域がない場合でも、デジタルカメラ100の前方における広い範囲の音声を収音するように、また、ズーム等で水平画角が小さいほど収音ゲインを大きくするようにして、撮像される範囲の音声を明瞭に収音しやすくすることができる。

なお、デジタルカメラ100の動作モードに応じて、デジタルカメラ100の周囲360°の角度範囲を有する全体収音エリアが定義され、ステップS40において全体収音エリアに決定されてもよい。このとき、例えば全体収音エリアのみが収音パラメータに設定されてもよい。

〔1−2−5.オートモードの動作〕

本実施形態に係るデジタルカメラ100のオートモードの動作の詳細を、図20〜図21を用いて説明する。

図20は、実施の形態1に係るデジタルカメラ100のオートモードの動作を例示するフローチャートである。図20のフローチャートに示す各処理は、例えば図10と同様にコントローラ135により、デジタルカメラ100がオートモードに設定された状態において実行される。

図20に示すように、オートモードのデジタルカメラ100において、コントローラ135は、例えば磁気センサ132の検出信号に基づいて、表示モニタ130が自分撮り位置であるか否かを判断する(S51)。コントローラ135は、表示モニタ130が自分撮り位置でないと判断すると(S51でNO)、非顔認識時の収音エリアをサラウンドモードの収音エリア45に設定する(S52)。一方、表示モニタ130が自分撮り位置であると判断すると(S51でYES)、コントローラ135は、非顔認識時の収音エリアをフロントモードの収音エリア46に設定する(S53)。

コントローラ135は、上述したフォーカスモードと同様に、顔認識の処理を行う(S1,S2)。例えば、AF対象の顔領域が検出された場合(S2でYES)、コントローラ135は、加速度センサ137の検出信号に基づいて、デジタルカメラ100が縦撮りの姿勢か否かを判断する(S54)。コントローラ135は、縦撮りでないと判断すると(S54でNO)、フォーカスモードと同様のステップS3〜S5の処理を行い、収音制御を実行する。一方、コントローラ135は、縦撮りと判断すると(S54でYES)、フロントモードの収音エリア46を採用して、収音制御を実行する(S55)。

また、AF対象の顔領域が検出されなかった場合(S2でNO)、コントローラ135は、ステップS52,S53の設定結果に基づいて、顔認識を用いない収音制御を行う(S6A)。ステップS6Aの収音制御は、非顔認識時の収音エリアとして設定された収音エリアを用いて、上述したステップS6と同様に行われる。

以上の処理によると、各種の撮影状態に連動してマイク161の指向性を調整するオートモードの動作を実現できる。オートモードにおける横撮り時と縦撮り時の収音制御について、図21を用いて更に説明する。

図21(A)は、横撮り時の撮像画像Imと収音エリア41〜43との関係を例示する。図21(B)は、縦撮り時にステップS55を行わなかった場合を例示する。図21(C)は、縦撮り時にステップS55を行った場合を例示する。

図21(A)に例示するように、横取り時においては、収音エリアと顔領域R1〜R3と収音エリア41〜43とは同軸上の関係にあり、収音エリア41〜43の切り替えによって所望の顔領域R1〜R3の位置に合わせるような意図通りの収音制御が可能である。しかしながら、縦撮り時においては、図21(B)に示すように、収音エリア41〜43と顔領域R1〜R3との関係が合わなくなる。このことから、所望の顔領域R1〜R3の位置に対して意図通りの収音制御ができず、寧ろ意図に反した収音制御が生じてしまう事態が考えられる。

そこで、本実施形態では、縦撮り時には図21(C)に示すように、収音エリアをフロントモードの収音エリア46に固定する。これにより、撮像中の範囲にわたり収音可能な範囲を確保して、意図に反した収音制御が生じるような事態を回避できる。

〔1−3.効果等〕

本実施形態において、デジタルカメラ100は、撮像部の一例のイメージセンサ115と、音声取得部の一例のマイク161と、設定部の一例の操作部150と、制御部の一例のコントローラ135とを備える。イメージセンサ115は、被写体を撮像して画像データを生成する。マイク161は、撮像部による撮像中に収音される音声を示す音声信号を取得する。操作部150は、ユーザの指示を受けて、音声取得部の指向性を自動で変える動作モードであるオートモードに自装置を設定する。コントローラ135は、音声信号において被写体からの音声を収音する収音エリアを制御する。コントローラ135は、オートモードに設定されている場合、マイク161の指向性を自装置の撮影状態に連動して変えることで、被写体を含めるように収音エリアを制御する。これにより、様々な撮影状態に応じて適切な収音制御が実現でき、音声を取得しながら撮像を行う際に、ユーザの意図に沿って被写体の音声を収音し易くすることができる。

本実施形態のデジタルカメラ100は、画像データにおいて被写体の顔領域を検出する顔検出部の一例の顔認識部122を備える。コントローラ135は、オートモードに設定されている場合、顔認識部122によって検出された顔領域に基づいて音声信号における収音対象とする被写体を決定し、収音対象に決定した被写体を含めるように、収音エリアを制御する。これにより、被写体の各種顔認識のような撮影状態に応じて収音制御を行い、ユーザの意図に沿った収音を行い易くできる。

本実施形態において、コントローラ135は、オートモードに設定されている場合、自装置が縦向きか又は横向きかで撮影する撮影状態に連動して、音声取得部の指向性を変えるように、収音エリアを制御する。これにより、縦撮りか横撮りかといった撮影状態に応じて収音制御を行い、ユーザの意図に沿った収音を行い易くできる。

本実施形態において、コントローラ135は、オートモードに設定されている場合、撮影者が自身を撮影するか否かの撮影状態に連動して、音声取得部の指向性を変えるように、収音エリアを制御する。これにより、自分撮りか否かといった撮影状態に応じて収音制御を行い、ユーザの意図に沿った収音を行い易くできる。

本実施形態のデジタルカメラ100は、表示部の一例の表示モニタ130と、検知部の一例の磁気センサ132とをさらに備える。表示モニタ130は、被写体の画像等を表示する表示面を有し、当該表示面を被写体側に変位可能に構成される。磁気センサ132は、表示モニタ130が被写体側に表示面を変位したか否かを検知する。本実施形態の設定部は、磁気センサ132が、表示モニタ130が被写体側に表示面を変位したことを検知すると、オートモードに設定するものであってもよい。例えば、コントローラ135が磁気センサ132からの検出信号に応じて、表示モニタ130が自分撮り位置にあるときに自動的にデジタルカメラ100オートモードに設定してもよい。

本実施形態のデジタルカメラ100において、設定部は、ユーザの指示に応じて、オートモードのほかに音声取得部の指向性が互いに異なる複数の動作モードうちの少なくとも1つに設定可能である。例えば、サラウンドモード、フロントモード、或いはナビゲーションモードに設定可能であり、更にフォーカスモードに設定可能であってもよい。

本実施形態のデジタルカメラ100において、コントローラ135は、設定部がオートモードに設定している場合にイメージセンサ115によって撮像が開始されると、表示モニタ130に被写体と共にオートモードに設定されていることを示す情報を表示させてもよい。例えば、コントローラ135は、表示モニタ130にオートモード専用のアイコン等を表示させてもよい。

(実施の形態2)

以下、図面を用いて実施の形態2を説明する。実施の形態1では、動画撮影時等に収音対象を選別して決定するデジタルカメラ100について説明した。実施の形態2では、実施の形態1のような動作時に、決定された収音対象に関する情報をユーザに可視化するデジタルカメラ100について説明する。

以下、実施の形態1に係るデジタルカメラ100と同様の構成、動作の説明は適宜省略して、本実施形態に係るデジタルカメラ100を説明する。

〔2−1.概要〕

図22を用いて、本実施形態に係るデジタルカメラ100が各種情報を表示する動作の概要を説明する。

図22は、本実施形態に係るデジタルカメラ100の表示例を示す。図22の表示例は、デジタルカメラ100が図11(B)に例示するように収音対象を決定した場合に、表示部130においてリアルタイムに表示される一例を示す。本表示例において、デジタルカメラ100は表示モニタ130に、AF対象の被写体を示すAF枠11及びAF対象以外の検出された被写体を示す検出枠13に加えて、収音対象の被写体を示す収音アイコン12を、撮像画像Im上に重畳して表示している。

本実施形態のデジタルカメラ100は、収音アイコン12を、AF枠11及び検出枠13に組み合わせて用いることで、AF対象のような主要被写体とそれ以外に検出した被写体が、AF対象及び/または収音対象に決定されているか否かをユーザに可視化する。

例えば図22の表示例において、デジタルカメラ100は、図11(B)の例で顔領域R1(60)に対応する被写体をAF対象かつ収音対象として決定したことから、人物21にAF枠11と収音アイコン12を表示する。また、デジタルカメラ100は、図11(B)の例で顔領域R3に対応する被写体をAF対象以外の収音対象として決定したことから、人物23に検出枠13と収音アイコン12を表示する。さらに、デジタルカメラ100は、収音アイコン12を伴わない検出枠13の表示により、図11(B)の例で顔領域R2に対応するAF対象以外の被写体を収音対象としない決定をしたことをユーザに可視化する。

本実施形態のデジタルカメラ100において、ユーザは、AF枠11または検出枠13のいずれか一方の表示により、検出した被写体がAF対象か否かを確認できる。ユーザはまた、収音アイコン12の有無により、収音対象か否かを確認できる。AF枠11と収音アイコン12との組み合わせは、本実施形態における第1の識別情報の一例である。検出枠13と収音アイコン12との組み合わせは、本実施形態における第2の識別情報の一例である。検出枠13は、第3の識別情報の一例である。

以上のように、本実施形態に係るデジタルカメラ100は、検出情報が含む被写体から決定した収音対象及びAF対象の被写体を区別する表示を行う。これによりユーザは、デジタルカメラ100が検出した被写体のうち収音対象の被写体を把握して、例えば意図に沿った被写体が収音対象として決定されているか否かを確認することができる。

図23(A),(B)は、本実施形態のデジタルカメラ100におけるマニュアル操作を説明するための図である。図23(A)は、特定の人物22が、顔認識部122により検出されていない状態を例示する。例えば、撮影者が人物22の音声を収音したくても、人物22の顔がデジタルカメラ100に対して横向き又は後ろ向きであることにより、顔認識が為されない場合が想定される。また、撮影者が収音したい音源が、人物でないような場合も想定される。こうした場合を考慮して、本実施形態のデジタルカメラ100は、収音エリアを手動で設定可能にするマニュアル操作を入力可能に動作する。

図23(B)は、デジタルカメラ100における収音エリアのマニュアル操作を例示する。例えば、収音エリアのマニュアル操作は、タッチ操作として実装される。図24は、デジタルカメラ100におけるマニュアル操作時の動作を例示するフローチャートである。本フローチャートに示す処理は、例えば上述したオートモード又はフォーカスモードの処理とは独立に実行されてもよいし、オートモード又はフォーカスモードの処理時に割り込んで実行されてもよい。

まず、デジタルカメラ100のコントローラ135は、撮影者などのユーザによるマニュアル操作を受け付ける(S61)。コントローラ135は、例えば図23(B)に示すように、マニュアル操作時において、表示モニタ130に収音エリアの指定範囲48を表示する。この例はマニュアル操作がオートモード又はフォーカスモードの処理時に割り込んで実施される場合である。

図23(B)の例では、撮影者がタッチ操作により、収音エリアの指定範囲48が、顔認識されなかった人物22を含むように調整するマニュアル操作を入力している。コントローラ135は、入力されたマニュアル操作に基づき、収音エリアの指定範囲48を決定する(S62)。マニュアル操作として収音範囲とする始点と終点をタッチ操作で入力すれば、始点と終点を含む所定サイズの収音範囲48が表示される。この状態で表示モニタ130に表示される確定ボタンをタッチ操作すれば、収音範囲48が確定される。

コントローラ135は、決定した収音エリアの指定範囲48をマイク161の収音制御に反映する(S63)。これにより、指定範囲48に対応する収音エリアからの音声を強調するように、収音制御が実行される。

〔2−3.効果等〕

以上のように、本実施形態のデジタルカメラ100は、被写体を撮像して画像データを生成するイメージセンサ115と、イメージセンサ115による撮像中に収音される音声を示す音声信号を取得するマイク161と、被写体の画像を表示する表示モニタ130とを備える。本実施形態のデジタルカメラ100は、表示モニタ130に表示された被写体を、被写体からの音声を収音する収音エリアに設定するユーザ操作を入力する操作部150等の入力部と、音声信号において収音エリアを制御するコントローラ135とを備える。コントローラ135は、収音エリアを設定するユーザ操作が入力されると、ユーザ操作に基づいて、マイク161の指向性を変えることで被写体を含めるように、収音エリアを制御する。こうしたマニュアル操作により、収音エリアを制御でき、ユーザの意図に沿った収音を行い易くすることができる。

本実施形態のデジタルカメラ100において、表示モニタ130は、実施形態1と同様に、被写体側に表示面を変位可能に構成されてもよい。表示モニタ130が、被写体側に表示面が変位された状態において、ユーザ操作がなされてもよい。即ち、デジタルカメラ100において自分撮りを行う際に、上述したマニュアル操作が入力されてもよい。

(他の実施の形態)

以上のように、本出願において開示する技術の例示として、上記の各実施の形態を説明した。しかしながら、本開示における技術は、これに限定されず、適宜、変更、置き換え、付加、省略などを行った実施の形態にも適用可能である。また、上記の各実施の形態で説明した各構成要素を組み合わせて、新たな実施の形態とすることも可能である。

実施の形態1では、マイク161に3つのマイクロフォン素子161L,161C及び161Rを用いる例を説明した。4つのマイクロフォン素子を用いる変形例を、図25〜図26を用いて説明する。

図25は、本変形例のデジタルカメラ100Aにおけるマイク161Aの配置を例示する。本変形例において、デジタルカメラ100Aのマイク161Aは、互いにXZ平面上にある3つのマイクロフォン素子161L,161C及び161Rに加えて、4つ目のマイクロフォン素子161Bを含む。4つ目のマイクロフォン素子161Bは、Y方向における位置が他のマイクロフォン素子161L〜161Rとは異なるように配置される。

図26は、本変形例において縦撮り時の撮像画像Imと収音エリア41A〜43Aとの関係を例示する。上記のマイク161Aの構成によると、デジタルカメラ100のY軸方向においても収音エリアを変えることができる。このため、縦撮り時の収音制御時には、4つ目のマイクロフォン素子161Bを用いた収音エリアを利用することにより、例えば図26に示すように、縦撮り時にも顔認識に追従するような収音制御を実現できる。例えば、本変形例のデジタルカメラ100Aのコンロトーラ135は、図20と同様の処理において、ステップS55の代わりに、上記のような4つ目のマイクロフォン素子161Bを用いた収音制御を行う。これにより、縦撮り時においても、収音エリア41A〜43Aを用いて所望の顔領域R1〜R3の位置に合わせるような意図通りの収音制御が可能となる。

また、上記各実施形態において説明した収音制御においては、顔認識と連動して収音エリアを遷移させる期間に緩急を設けることにより、聴感上の違和感をより抑制することができる。この動作例について、図27を用いて説明する。

図27では、デジタルカメラ100において顔認識の有無に連動して収音指向性の幅(即ち収音エリアの角度範囲)を変化させる動作例を示す。本動作例では、時刻t1においてデジタルカメラ100の顔認識部122により被写体の顔が検出されている。すると、誤検出防止制御(即ちチャタリング)が行われる(図16のS33参照)。

例えば顔認識が一瞬だけ為されたり、顔認識した被写体が横を向いてしまったりしたときに収音指向性を変化させると、収音結果を聴くユーザが聴感上の違和感を覚える事態が考えられる。これに対して、上述した誤検出防止制御によると、被写体の顔認識の位置を常に監視し、一定時間収音エリアにいるときに収音指向性を変化させる。これにより、上記のような聴感上の違和感を回避可能になる。

また、デジタルカメラ100のコントローラ135は、時刻t1からチャタリング後に、収音指向性を狭めるように収音エリアを遷移させる。収音指向性を狭める際の遷移期間は、例えば比較的短く設定される。これにより、画像認識において被写体の顔が検出された際に、検出された顔に向けて収音指向性がフォーカスされるように速やかな変化を与え、収音結果を聴くユーザに聴感上、良好な印象を与えることができる。また、例えば、前方中心収音エリア41と左半分収音エリア42など同じ角度範囲の収音エリアの遷移についても、上記と同様に比較的速やかに行われる。

図27の例においては、例えば被写体が移動したり顔を横向きにしたりする等により、時刻t2において、顔認識部122により被写体の顔が検出されなくなっている。この際も、チャタリング制御の後に、デジタルカメラ100は収音指向性を遷移させる。ここで、収音指向性の範囲を広げるときの遷移期間は、上述した狭めるときの遷移期間よりも長く設定される。これにより、広い範囲からの音が聴こえ出す状況が突然に起こることで生じ得るような聴感上の違和感をユーザに与えることを回避することができる。寧ろ、収音指向性の範囲を広げるときの遷移を遅く実行することにより、ユーザの聴感上の違和感を抑制することができる。

さらに、本例では時刻t3において、収音指向性を広げる遷移期間中に、顔認識が再び為されている。この場合、デジタルカメラ100は、割り込み制御として収音指向性を広げきる前に、再び狭める制御に切り替わる。これにより、被写体の顔認識が断続的で有る場合に、顔認識が為された被写体に対して収音指向性を向ける制御が速やかに行われ、ユーザの聴感上の違和感をさらに抑制することができる。

上記の各実施形態においては、収音対象の検出に顔認識部122を用いた。本実施形態において、収音対象の検出は顔認識部122に限らず、例えばこれに代えて、又は加えて、人間の全体又は少なくとも一部を画像認識する人体認識を用いてもよい。また、収音対象は、必ずしも人物でなくてもよく、例えば各種の動物であってもよい。この場合、動物の一部又は全体の画像認識により、収音対象の検出が行われてもよい。

また、実施の形態2に係る第1の識別情報、第2の識別情報、及び第3の識別情報は、AF枠11の有無において主要被写体か否かを識別し、収音アイコン12の有無において収音対象か否かを識別した。本実施形態において、第1〜第3の識別情報は、特にこれに限らず、例えば3種類の枠表示であってもよい。図22は、本実施形態における3種類の枠表示を例示する。図22の例では、AF対象かつ収音対象の被写体を示す枠表示11A、AF対象以外で収音対象の被写体を示す枠表示13A及び収音対象でない被写体を示す枠表示13Bにより、AF対象及びそれ以外の被写体の表示と収音対象の表示とが一体的に為されている。

上記の実施形態1,2では、オートモードの動作とマニュアル操作とをそれぞれ説明したが、これらは組み合わせてもよい。すなわち、本実施形態のデジタルカメラ100は、被写体の画像を表示する表示部としての表示モニタ135と、表示モニタ135に表示された被写体を、被写体からの音声を収音する収音エリアに設定するユーザ操作を入力する入力部としての操作部150とを備えてもよい。コントローラ135は、収音エリアを設定するユーザ操作が入力されると、ユーザ操作に基づいて、マイク161の指向性を変えることで被写体を含めるように、収音エリアを制御してもよい。こうした場合、表示モニタ135は特に可動式でなくてもよく、例えば上述した通常位置などに固定される固定式であってもよい。

実施の形態1〜2では、図10のフローチャートにおいて、デジタルカメラ100が内蔵するマイク161について、顔認識を用いた又は用いない収音制御(S5又はS6)を行う動作例を説明した。本実施形態のデジタルカメラ100は、内蔵のマイク161に代えて、外付けのマイク(以下「マイク161aという」)を備えてもよい。マイク161aは、デジタルカメラ100の外部にあるマイクロフォン素子を含み、3つ以上のマイクロフォン素子を備える。本実施形態においてコントローラ135は、マイク161aについて、予めマイクロフォン素子の配置に関する情報をバッファメモリ125等に保持しておくことにより、実施の形態1と同様にステップS5又はS6を実行することができる。この場合においても、実施の形態1と同様に決定した収音対象及び/または収音エリアに応じて、被写体の音声を明瞭に得やすくすることができる。

また、実施の形態1〜2では、図16のフローチャートにおいて、デジタルカメラ100の撮像範囲に対応する水平画角に基づき、ゲインGhを算出(S30)する動作例を説明した。この場合の水平画角は、図14のフローチャートにおける前方中心収音エリアの判定(S20)に用いる水平画角θhと同一である。本実施形態において、ゲインGhの算出に、ステップS20における水平画角θhと異なる用いる水平画角を用いてもよい。例えば、撮像画像上で全ての収音対象の被写体を含むX軸方向の幅に対応する角度範囲を、ステップS30における水平画角とする。これにより、収音対象が映る画角に応じて、遠くの被写体の声をより明瞭に収音するように、ゲインGhを算出することができる。

また、実施の形態1〜2では、顔認識部122が人の顔を検出した。本実施形態において、顔認識部122は、例えば動物の顔を検出してもよい。動物の顔は、動物の種別によって大きさが多様であることが考えられる。この場合でも、例えば収音対象を選別するための所定範囲(S14参照)を拡大することにより、実施の形態1と同様に収音対象を選別することができる。さらに、顔認識部122が動物の種別ごとに顔を検出し、種別に応じてステップS14における所定範囲を設定してもよい。

また、実施の形態1〜2では、顔認識部122を備えるデジタルカメラ100を説明した。本実施形態において、顔認識部122は、外部サーバに設けられてもよい。この場合、デジタルカメラ100は、通信モジュール160を介して、外部サーバに撮像画像の画像データを送信し、外部サーバから顔認識部122による処理結果の検出情報を受信してもよい。このようなデジタルカメラ100においては、通信モジュール160が検出部として機能する。

また、実施の形態1〜2では、光学系110及びレンズ駆動部112を備えるデジタルカメラ100を例示した。本実施形態の撮像装置は、光学系110及びレンズ駆動部112を備えなくてもよく、例えば交換レンズ式のカメラであってもよい。

また、実施の形態1〜2では、撮像装置の例としてデジタルカメラを説明したが、これに限定されない。本開示の撮像装置は、画像撮影機能を有する電子機器(例えば、ビデオカメラ、スマートフォン、タブレット端末等)であればよい。

以上のように、本開示における技術の例示として、実施の形態を説明した。そのために、添付図面および詳細な説明を提供した。

したがって、添付図面および詳細な説明に記載された構成要素の中には、課題解決のために必須な構成要素だけでなく、上記技術を例示するために、課題解決のためには必須でない構成要素も含まれ得る。そのため、それらの必須ではない構成要素が添付図面や詳細な説明に記載されていることをもって、直ちに、それらの必須ではない構成要素が必須であるとの認定をするべきではない。

また、上述の実施の形態は、本開示における技術を例示するためのものであるから、特許請求の範囲またはその均等の範囲において種々の変更、置き換え、付加、省略などを行うことができる。