JP2009205685A - シングルポインティングデバイスによるマルチポイントジェスチャのシミュレーション - Google Patents

シングルポインティングデバイスによるマルチポイントジェスチャのシミュレーション Download PDFInfo

- Publication number

- JP2009205685A JP2009205685A JP2009070904A JP2009070904A JP2009205685A JP 2009205685 A JP2009205685 A JP 2009205685A JP 2009070904 A JP2009070904 A JP 2009070904A JP 2009070904 A JP2009070904 A JP 2009070904A JP 2009205685 A JP2009205685 A JP 2009205685A

- Authority

- JP

- Japan

- Prior art keywords

- gesture

- input

- point

- multipoint

- software

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

- 238000004088 simulation Methods 0.000 title description 12

- 238000000034 method Methods 0.000 claims description 30

- 239000013598 vector Substances 0.000 claims description 13

- 238000006243 chemical reaction Methods 0.000 claims description 6

- 230000015654 memory Effects 0.000 claims description 6

- 230000000007 visual effect Effects 0.000 claims 1

- 238000013519 translation Methods 0.000 abstract description 3

- 238000012360 testing method Methods 0.000 description 14

- 238000010586 diagram Methods 0.000 description 7

- 238000011161 development Methods 0.000 description 3

- 238000006073 displacement reaction Methods 0.000 description 3

- 230000006870 function Effects 0.000 description 3

- 239000003550 marker Substances 0.000 description 3

- 230000003068 static effect Effects 0.000 description 3

- 239000008186 active pharmaceutical agent Substances 0.000 description 2

- 238000012986 modification Methods 0.000 description 2

- 230000004048 modification Effects 0.000 description 2

- 230000008569 process Effects 0.000 description 2

- 230000001133 acceleration Effects 0.000 description 1

- 238000004891 communication Methods 0.000 description 1

- 238000001514 detection method Methods 0.000 description 1

- 230000005484 gravity Effects 0.000 description 1

- 230000007480 spreading Effects 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/033—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor

- G06F3/038—Control and interface arrangements therefor, e.g. drivers or device-embedded control circuitry

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/041—Digitisers, e.g. for touch screens or touch pads, characterised by the transducing means

- G06F3/0416—Control or interface arrangements specially adapted for digitisers

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

- G06F3/0487—Interaction techniques based on graphical user interfaces [GUI] using specific features provided by the input device, e.g. functions controlled by the rotation of a mouse with dual sensing arrangements, or of the nature of the input device, e.g. tap gestures based on pressure sensed by a digitiser

- G06F3/0488—Interaction techniques based on graphical user interfaces [GUI] using specific features provided by the input device, e.g. functions controlled by the rotation of a mouse with dual sensing arrangements, or of the nature of the input device, e.g. tap gestures based on pressure sensed by a digitiser using a touch-screen or digitiser, e.g. input of commands through traced gestures

- G06F3/04883—Interaction techniques based on graphical user interfaces [GUI] using specific features provided by the input device, e.g. functions controlled by the rotation of a mouse with dual sensing arrangements, or of the nature of the input device, e.g. tap gestures based on pressure sensed by a digitiser using a touch-screen or digitiser, e.g. input of commands through traced gestures for inputting data by handwriting, e.g. gesture or text

Abstract

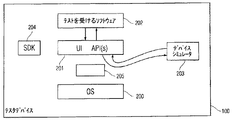

【解決手段】シミュレーションソフトウェアが、(例えば、マウスからの入力などの)シングルポインティング入力を受け取り、これを指のピンチ、逆ピンチ、平行移動、回転などのシミュレートしたマルチポイントジェスチャ入力に変換することができる。このシミュレーションソフトウェアにより、ユーザは、マルチポイントジェスチャ入力を作成する際に、キーボードのキーを使用して追加の制御を行えるようにもなる。

【選択図】図1

Description

Claims (27)

- マルチポイントセンサパネル上のマルチポイントジェスチャをシミュレートするためのシステムであって、

前記マルチポイントセンサパネルの表現を表示するためのディスプレイと、

シングルポインティングユーザ入力デバイスと、

前記シングルポインティングユーザ入力デバイスから入力を受け取り、所定の変換ルールに従って該入力をマルチポイントジェスチャに変換するように構成されたデバイスシミュレータと、

を備えることを特徴とするシステム。 - 前記シングルポインティングユーザ入力デバイスはマウスである、

ことを特徴とする請求項1に記載のシステム。 - 前記システムは、前記センサパネルを含むマルチポイント対応デバイスにおいて実行するように意図されたソフトウェアを実行するように構成されたプロセッサをさらに含み、前記デバイスシミュレータは、前記変換されたマルチポイントジェスチャ入力を、該マルチポイントジェスチャ入力が前記マルチポイント対応デバイスにおいて実行されたとしたら前記ソフトウェアが受け取ったであろうフォーマットと同一のフォーマットで前記ソフトウェアへ送るようにさらに構成された、

ことを特徴とする請求項1に記載のシステム。 - 前記シングルポインティングユーザ入力デバイスからの前記入力は、前記シングルポインティングユーザ入力デバイスが制御するカーソルがたどる経路により定められる、

ことを特徴とする請求項1に記載のシステム。 - 前記変換されたマルチポイントジェスチャ入力は、少なくとも2つの別個のポイントジェスチャ入力により定められ、第1のポイントジェスチャ入力は、前記シングルポインティングデバイスが制御する前記カーソルがたどる前記経路により定められ、少なくとも1つの別のポイントジェスチャ入力は、前記シングルポインティングデバイスが制御する前記カーソルがたどる前記経路から導き出された経路により定められる、

ことを特徴とする請求項4に記載のシステム。 - 前記少なくとも1つの別のポイントジェスチャ入力は、前記シングルポインティングデバイスが制御するカーソルから所定のベクトルだけ変位したポイントがたどる経路により定められる、

ことを特徴とする請求項5に記載のシステム。 - 前記少なくとも1つの別のポイントジェスチャは、前記シングルポインティングデバイスが制御するカーソルの位置と所定のポイントに関して対称の位置にあるポイントがたどる経路により定められる、

ことを特徴とする請求項5に記載のシステム。 - 前記デバイスシミュレータは、前記シングルポインティングデバイスを通じて連続して入力された複数のシングルポイントジェスチャ入力を入力として受け取り、

前記複数の受け取ったシングルポイントジェスチャ入力を前記マルチポイントジェスチャ入力と合成して、前記マルチポイントジェスチャ入力が、前記複数のシングルポイントジェスチャ入力により定められる複数のシングルポイントジェスチャの少なくとも部分的に同時に行われる動作を表すようにすることにより、前記複数のシングルポイントジェスチャ入力を前記マルチポイントジェスチャ入力に変換するように構成された、

ことを特徴とする請求項1に記載のシステム。 - CPU及びコンピュータ可読メモリをさらに含み、前記デバイスシミュレータは、前記コンピュータ可読メモリに記憶されるとともに前記CPUにより実行されるソフトウェアである、

ことを特徴とする請求項1に記載のシステム。 - 前記マルチポイントセンサパネルを含むマルチポイント対応デバイスのためのソフトウェアを開発するように構成されたソフトウェア開発キットをさらに含み、該ソフトウェア開発キットは、前記コンピュータ可読メモリに記憶されるとともに前記CPUにより実行され、前記デバイスシミュレータは前記ソフトウェア開発キットの一部である、

ことを特徴とする請求項9に記載のシステム。 - 前記マルチポイントジェスチャはマルチタッチジェスチャであり、前記マルチポイントセンサパネルはマルチタッチセンサパネルであり、前記マルチポイントジェスチャ入力はマルチタッチジェスチャ入力である、

ことを特徴とする請求項1に記載のシステム。 - マルチポイントジェスチャをシミュレートする方法であって、

シングルポインティングデバイスからシングルトラッキング入力を受け取るステップと、

前記受け取ったシングルトラッキング入力に応答して、2又はそれ以上のシミュレートしたタッチポイントを含むとともに前記シングルトラッキング入力に少なくとも一部基づくシミュレートしたマルチポイントジェスチャの視覚的表現を表示するステップと、

を含むことを特徴とする方法。 - 前記シングルポインティングデバイスから初期位置決めコマンドを受け取るステップと、

前記シングルトラッキング入力を受け取る前に2又はそれ以上のシミュレートしたタッチポイントの初期位置を表示するステップと、

をさらに含むことを特徴とする請求項12に記載の方法。 - 前記シミュレートしたマルチポイントジェスチャは、前記トラッキング入力に所定のルールを適用することにより決定される、

ことを特徴とする請求項12に記載の方法。 - 前記シングルポインティングデバイスはマウスである、

ことを特徴とする請求項12に記載の方法。 - 前記シングルポインティングデバイスはシングルタッチトラックパッドである、

ことを特徴とする請求項12に記載の方法。 - 第1のデバイスにおいて実行するように構成されたソフトウェアを含むコンピュータ可読媒体であって、前記第1のデバイスはシングルポインティングユーザ入力デバイスを含み、前記ソフトウェアは、

前記シングルポインティングユーザ入力デバイスを通じてシングルポインティングジェスチャを受け取るステップと、

前記シングルポインティングジェスチャに基づいて、所定の変換ルールに従ってマルチポイントジェスチャを生成するステップと、

前記マルチポイントジェスチャを表示するステップと、

を行うことにより、マルチポイントセンサパネル上のマルチポイントジェスチャをシミュレートするように構成された、

ことを特徴とするコンピュータ可読媒体。 - 前記マルチポイントジェスチャの生成ステップ及び前記マルチポイントジェスチャの表示ステップは、前記シングルポインティングジェスチャを受け取っている間にリアルタイムで行われる、

ことを特徴とする請求項17に記載のコンピュータ可読媒体。 - 前記ソフトウェアは、

制御信号を受け取り、

前記制御信号に基づいて、前記マルチポイントジェスチャの生成時に従う変換ルールとして複数の所定の前記変換ルールのうちの1つを選択するようにさらに構成された、

ことを特徴とする請求項17に記載のコンピュータ可読媒体。 - 前記シングルポインティングユーザ入力デバイスはマウスである、

ことを特徴とする請求項17に記載のコンピュータ可読媒体。 - 前記第1デバイスにおいて第2のソフトウェアが実行され、該第2のソフトウェアは、前記マルチポイントセンサパネルを含むマルチポイント対応デバイスにおいて実行することを意図されたものであり、前記ソフトウェアは、

前記生成したマルチポイントジェスチャを、該マルチポイントジェスチャが前記マルチポイント対応デバイスにおいて実行されたとしたら前記第2のソフトウェアが受け取ったであろうフォーマットと同一のフォーマットで前記第2のソフトウェアへ送るようにさらに構成された、

ことを特徴とする請求項17に記載のコンピュータ可読媒体。 - 前記シングルポインティングジェスチャは、前記シングルポインティングデバイスが制御するカーソルがたどる経路により定められる、

ことを特徴とする請求項17に記載のコンピュータ可読媒体。 - 前記生成したマルチポイントジェスチャは、少なくとも2つの別個のポイントジェスチャにより定められ、前記第1のポイントジェスチャは、前記シングルポインティングデバイスが制御するカーソルがたどる経路により定められ、少なくとも1つの別のポイントジェスチャは、前記シングルポインティングデバイスが制御するカーソルがたどる経路から導き出された経路により定められる、

ことを特徴とする請求項20に記載のコンピュータ可読媒体。 - 前記少なくとも1つの別のポイントジェスチャは、前記シングルポインティングデバイスが制御するカーソルから所定のベクトルだけ変位した位置がたどる経路により定められる、

ことを特徴とする請求項23に記載のコンピュータ可読媒体。 - 前記少なくとも1つの別のポイントジェスチャは、前記シングルポインティングデバイスが制御するカーソルの位置と所定のポイントに関して対称の位置にあるポイントがたどる経路により定められる、

ことを特徴とする請求項23に記載のコンピュータ可読媒体。 - 前記ソフトウェアはソフトウェア開発キットの一部である、

ことを特徴とする請求項17に記載のコンピュータ可読媒体。 - 前記マルチポイントジェスチャはマルチタッチジェスチャであり、前記マルチポイントセンサパネルはマルチタッチセンサパネルであり、前記マルチポイントジェスチャ入力はマルチタッチジェスチャ入力である、

ことを特徴とする請求項17に記載のコンピュータ可読媒体。

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US12/037,848 US20090213083A1 (en) | 2008-02-26 | 2008-02-26 | Simulation of multi-point gestures with a single pointing device |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2009205685A true JP2009205685A (ja) | 2009-09-10 |

| JP2009205685A5 JP2009205685A5 (ja) | 2010-10-07 |

Family

ID=40565391

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2009070904A Pending JP2009205685A (ja) | 2008-02-26 | 2009-02-26 | シングルポインティングデバイスによるマルチポイントジェスチャのシミュレーション |

Country Status (10)

| Country | Link |

|---|---|

| US (1) | US20090213083A1 (ja) |

| EP (1) | EP2096524A3 (ja) |

| JP (1) | JP2009205685A (ja) |

| CN (1) | CN101520702B (ja) |

| AU (1) | AU2009200298B2 (ja) |

| CA (1) | CA2651409C (ja) |

| DE (1) | DE102009010744A1 (ja) |

| GB (1) | GB2457802B (ja) |

| IL (1) | IL197215A0 (ja) |

| WO (1) | WO2009108584A2 (ja) |

Cited By (19)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2011034451A (ja) * | 2009-08-04 | 2011-02-17 | Fujitsu Component Ltd | タッチパネル装置及び方法並びにプログラム及び記録媒体 |

| JP2011053770A (ja) * | 2009-08-31 | 2011-03-17 | Nifty Corp | 情報処理装置及び入力処理方法 |

| JP2011086035A (ja) * | 2009-10-14 | 2011-04-28 | Nec Corp | 携帯機器、その画像表示制御方法および装置 |

| JP2011138475A (ja) * | 2009-12-25 | 2011-07-14 | Cywee Group Ltd | マルチタッチ信号を生成する方法、マルチタッチ信号を生成するドングル、及び関連した制御システム |

| JP2011257992A (ja) * | 2010-06-09 | 2011-12-22 | Fujitsu Component Ltd | 変換装置及びプログラム |

| JP2012008968A (ja) * | 2010-06-28 | 2012-01-12 | Honda Motor Co Ltd | 携帯機器と連携し、該携帯機器に対して可能な入力操作を実現する車載機器 |

| JP2014059817A (ja) * | 2012-09-19 | 2014-04-03 | Konica Minolta Inc | 画像処理装置、操作標準化方法および操作標準化プログラム |

| KR101381878B1 (ko) * | 2012-04-10 | 2014-04-07 | 주식회사 오비고 | 마우스를 이용하여 터치 입력을 구현하기 위한 방법, 장치, 및 컴퓨터 판독 가능한 기록 매체 |

| JP2014516185A (ja) * | 2012-04-27 | 2014-07-07 | 深▲セン▼瑞高信息技術有限公司 | タッチスクリーン用アプリケーションプログラムの仮想アイコン操作変換方法及びタッチスクリーン端末 |

| JP2014519125A (ja) * | 2011-06-05 | 2014-08-07 | アップル インコーポレイテッド | 物理的なタッチ機能のないタッチユーザインタフェースを制御するためのデバイス、方法及びグラフィカルユーザインタフェース |

| JP2014219867A (ja) * | 2013-05-09 | 2014-11-20 | コニカミノルタ株式会社 | 画像形成装置、画像形成装置が操作方法を案内する方法、プログラム、および、システム |

| JP2014534544A (ja) * | 2011-12-02 | 2014-12-18 | ジーティーテレコム | タッチスクリーン上における画面操作方法 |

| JP2015022695A (ja) * | 2013-07-23 | 2015-02-02 | 三菱電機株式会社 | ユーザインタフェース模擬装置 |

| WO2015033967A1 (ja) * | 2013-09-06 | 2015-03-12 | 株式会社ソニー・コンピュータエンタテインメント | エミュレーション装置、エミュレーション方法、プログラム及び情報記憶媒体 |

| JP2016024580A (ja) * | 2014-07-18 | 2016-02-08 | 富士通株式会社 | 情報処理装置、入力制御方法、および入力制御プログラム |

| WO2020194569A1 (ja) * | 2019-03-27 | 2020-10-01 | 三菱電機株式会社 | 変換システム、変換装置及び変換方法 |

| US10986252B2 (en) | 2015-06-07 | 2021-04-20 | Apple Inc. | Touch accommodation options |

| KR20210083495A (ko) * | 2019-12-27 | 2021-07-07 | 주식회사 이누씨 | 가상 포지셔닝 방법 및 장치 |

| US11947792B2 (en) | 2011-12-29 | 2024-04-02 | Apple Inc. | Devices, methods, and graphical user interfaces for providing multitouch inputs and hardware-based features using a single touch input |

Families Citing this family (33)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP5448370B2 (ja) * | 2008-05-20 | 2014-03-19 | キヤノン株式会社 | 情報処理装置及びその制御方法、プログラム、記憶媒体 |

| TW201007526A (en) * | 2008-08-13 | 2010-02-16 | Elan Microelectronics Corp | Signal processing method of multi-fingers touch apparatus having invisible physical button structure |

| US20100095234A1 (en) * | 2008-10-07 | 2010-04-15 | Research In Motion Limited | Multi-touch motion simulation using a non-touch screen computer input device |

| US8477103B2 (en) | 2008-10-26 | 2013-07-02 | Microsoft Corporation | Multi-touch object inertia simulation |

| US8466879B2 (en) | 2008-10-26 | 2013-06-18 | Microsoft Corporation | Multi-touch manipulation of application objects |

| US20110191787A1 (en) * | 2010-02-02 | 2011-08-04 | Sun Microsystems, Inc. | System and method for providing sensor data from embedded device to software development environment |

| US8239840B1 (en) * | 2010-03-10 | 2012-08-07 | Google Inc. | Sensor simulation for mobile device applications |

| US20110310126A1 (en) * | 2010-06-22 | 2011-12-22 | Emil Markov Georgiev | Method and system for interacting with datasets for display |

| US8922499B2 (en) * | 2010-07-26 | 2014-12-30 | Apple Inc. | Touch input transitions |

| JP2012033059A (ja) * | 2010-07-30 | 2012-02-16 | Sony Corp | 情報処理装置、情報処理方法及び情報処理プログラム |

| CN102541336B (zh) * | 2010-12-31 | 2014-05-07 | 联芯科技有限公司 | 一种模拟操作触摸屏的方法、装置及系统 |

| US8830192B2 (en) * | 2011-01-13 | 2014-09-09 | Elan Microelectronics Corporation | Computing device for performing functions of multi-touch finger gesture and method of the same |

| CN102193863A (zh) * | 2011-04-26 | 2011-09-21 | 青岛海信移动通信技术股份有限公司 | 一种多点触控操作的实现方法及装置 |

| US9535817B2 (en) * | 2011-06-10 | 2017-01-03 | Microsoft Technology Licensing, Llc | Application development environment for portable electronic devices |

| US8176435B1 (en) * | 2011-09-08 | 2012-05-08 | Google Inc. | Pinch to adjust |

| CN102999382A (zh) * | 2011-09-09 | 2013-03-27 | 鸿富锦精密工业(深圳)有限公司 | 电子设备及其切换方法 |

| WO2013104570A1 (en) * | 2012-01-09 | 2013-07-18 | Movea | Command of a device by gesture emulation of touch gestures |

| US8436829B1 (en) * | 2012-01-31 | 2013-05-07 | Google Inc. | Touchscreen keyboard simulation for performance evaluation |

| US20130194197A1 (en) * | 2012-02-01 | 2013-08-01 | Ideacom Technology Inc. | Electronic Apparatus With Touch Panel and the Operating Method Therefor |

| JP2013186702A (ja) * | 2012-03-08 | 2013-09-19 | Sony Corp | 入力処理装置、入力処理プログラム及び入力処理方法 |

| CN102778966B (zh) * | 2012-06-29 | 2016-03-02 | 广东威创视讯科技股份有限公司 | 利用鼠标模拟触摸输入的方法及装置 |

| GB2510333A (en) * | 2013-01-30 | 2014-08-06 | Ibm | Emulating pressure sensitivity on multi-touch devices |

| US9715282B2 (en) * | 2013-03-29 | 2017-07-25 | Microsoft Technology Licensing, Llc | Closing, starting, and restarting applications |

| CN104423826B (zh) * | 2013-09-03 | 2018-07-31 | 上海炬力集成电路设计有限公司 | 一种使用鼠标中键和滚轮实现缩放的方法及装置 |

| US10162737B2 (en) | 2014-02-20 | 2018-12-25 | Entit Software Llc | Emulating a user performing spatial gestures |

| US10025427B2 (en) * | 2014-06-27 | 2018-07-17 | Microsoft Technology Licensing, Llc | Probabilistic touch sensing |

| US10255101B2 (en) * | 2014-12-11 | 2019-04-09 | Sap Se | Device emulator |

| CN104484117B (zh) * | 2014-12-18 | 2018-01-09 | 福州瑞芯微电子股份有限公司 | 人机交互方法及装置 |

| CN104536597B (zh) * | 2014-12-22 | 2018-11-27 | 合肥联宝信息技术有限公司 | 一种笔记本电脑实现多点触控的方法及装置 |

| CN105739890A (zh) * | 2016-01-27 | 2016-07-06 | 深圳市奥拓电子股份有限公司 | 一种触摸屏界面交互方法及装置 |

| CN105975174A (zh) * | 2016-04-26 | 2016-09-28 | 乐视控股(北京)有限公司 | 一种无触摸屏下模拟点击操作的系统及方法 |

| US10572026B2 (en) * | 2018-06-01 | 2020-02-25 | Adobe Inc. | Reference point generation on a vector path |

| US10921975B2 (en) * | 2018-06-03 | 2021-02-16 | Apple Inc. | Devices, methods, and user interfaces for conveying proximity-based and contact-based input events |

Citations (8)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH0196043U (ja) * | 1987-12-18 | 1989-06-26 | ||

| JPH05342046A (ja) * | 1992-06-09 | 1993-12-24 | Fujikura Ltd | エミュレータ |

| JPH05342045A (ja) * | 1992-06-09 | 1993-12-24 | Fujikura Ltd | エミュレータ |

| JP2000040345A (ja) * | 1998-07-23 | 2000-02-08 | Victor Co Of Japan Ltd | 音声データの編集装置及びその制御プログラムを記録したコンピュータ読みとり可能な記録媒体 |

| JP2000347778A (ja) * | 1999-06-04 | 2000-12-15 | Nec Corp | マルチメディアコンテンツ編集装置 |

| JP2003316603A (ja) * | 2002-04-24 | 2003-11-07 | Matsushita Electric Ind Co Ltd | プログラム検証システム |

| WO2006020305A2 (en) * | 2004-07-30 | 2006-02-23 | Apple Computer, Inc. | Gestures for touch sensitive input devices |

| JP2007299384A (ja) * | 2006-05-03 | 2007-11-15 | Mitsubishi Electric Research Laboratories Inc | コンピュータで実施するマルチタッチセンシティブ画面でマウスをエミュレートする方法及びマウスをエミュレートするシステム |

Family Cites Families (23)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US5805132A (en) * | 1991-09-17 | 1998-09-08 | Minolta Co., Ltd. | Image editing apparatus capable of setting image processing region on display screen |

| US5483261A (en) * | 1992-02-14 | 1996-01-09 | Itu Research, Inc. | Graphical input controller and method with rear screen image detection |

| US5488204A (en) * | 1992-06-08 | 1996-01-30 | Synaptics, Incorporated | Paintbrush stylus for capacitive touch sensor pad |

| US5880411A (en) * | 1992-06-08 | 1999-03-09 | Synaptics, Incorporated | Object position detector with edge motion feature and gesture recognition |

| US5555369A (en) * | 1994-02-14 | 1996-09-10 | Apple Computer, Inc. | Method of creating packages for a pointer-based computer system |

| US5825352A (en) * | 1996-01-04 | 1998-10-20 | Logitech, Inc. | Multiple fingers contact sensing method for emulating mouse buttons and mouse operations on a touch sensor pad |

| US5835079A (en) * | 1996-06-13 | 1998-11-10 | International Business Machines Corporation | Virtual pointing device for touchscreens |

| US6310610B1 (en) * | 1997-12-04 | 2001-10-30 | Nortel Networks Limited | Intelligent touch display |

| KR100595912B1 (ko) * | 1998-01-26 | 2006-07-07 | 웨인 웨스터만 | 수동 입력 통합 방법 및 장치 |

| US8479122B2 (en) * | 2004-07-30 | 2013-07-02 | Apple Inc. | Gestures for touch sensitive input devices |

| US7663607B2 (en) * | 2004-05-06 | 2010-02-16 | Apple Inc. | Multipoint touchscreen |

| US6052110A (en) * | 1998-05-11 | 2000-04-18 | Sony Corporation | Dynamic control of zoom operation in computer graphics |

| US6188391B1 (en) * | 1998-07-09 | 2001-02-13 | Synaptics, Inc. | Two-layer capacitive touchpad and method of making same |

| US6298481B1 (en) * | 1998-10-30 | 2001-10-02 | Segasoft, Inc. | System for modifying the functionality of compiled computer code at run-time |

| JP2003173237A (ja) * | 2001-09-28 | 2003-06-20 | Ricoh Co Ltd | 情報入出力システム、プログラム及び記憶媒体 |

| US6995752B2 (en) * | 2001-11-08 | 2006-02-07 | Koninklijke Philips Electronics N.V. | Multi-point touch pad |

| US6690387B2 (en) * | 2001-12-28 | 2004-02-10 | Koninklijke Philips Electronics N.V. | Touch-screen image scrolling system and method |

| US11275405B2 (en) * | 2005-03-04 | 2022-03-15 | Apple Inc. | Multi-functional hand-held device |

| US7366995B2 (en) * | 2004-02-03 | 2008-04-29 | Roland Wescott Montague | Combination tool that zooms in, zooms out, pans, rotates, draws, or manipulates during a drag |

| US20050219210A1 (en) * | 2004-03-31 | 2005-10-06 | The Neil Squire Society | Pointer interface for handheld devices |

| FI20045149A (fi) * | 2004-04-23 | 2005-10-24 | Nokia Corp | Käyttöliittymä |

| US20070061126A1 (en) * | 2005-09-01 | 2007-03-15 | Anthony Russo | System for and method of emulating electronic input devices |

| US8970501B2 (en) * | 2007-01-03 | 2015-03-03 | Apple Inc. | Proximity and multi-touch sensor detection and demodulation |

-

2008

- 2008-02-26 US US12/037,848 patent/US20090213083A1/en not_active Abandoned

-

2009

- 2009-01-28 AU AU2009200298A patent/AU2009200298B2/en not_active Ceased

- 2009-01-28 CA CA2651409A patent/CA2651409C/en not_active Expired - Fee Related

- 2009-02-19 GB GB0902821A patent/GB2457802B/en not_active Expired - Fee Related

- 2009-02-20 WO PCT/US2009/034763 patent/WO2009108584A2/en active Application Filing

- 2009-02-24 IL IL197215A patent/IL197215A0/en unknown

- 2009-02-26 CN CN2009100083431A patent/CN101520702B/zh not_active Expired - Fee Related

- 2009-02-26 EP EP09002733A patent/EP2096524A3/en not_active Withdrawn

- 2009-02-26 DE DE102009010744A patent/DE102009010744A1/de not_active Ceased

- 2009-02-26 JP JP2009070904A patent/JP2009205685A/ja active Pending

Patent Citations (9)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH0196043U (ja) * | 1987-12-18 | 1989-06-26 | ||

| JPH05342046A (ja) * | 1992-06-09 | 1993-12-24 | Fujikura Ltd | エミュレータ |

| JPH05342045A (ja) * | 1992-06-09 | 1993-12-24 | Fujikura Ltd | エミュレータ |

| JP2000040345A (ja) * | 1998-07-23 | 2000-02-08 | Victor Co Of Japan Ltd | 音声データの編集装置及びその制御プログラムを記録したコンピュータ読みとり可能な記録媒体 |

| JP2000347778A (ja) * | 1999-06-04 | 2000-12-15 | Nec Corp | マルチメディアコンテンツ編集装置 |

| JP2003316603A (ja) * | 2002-04-24 | 2003-11-07 | Matsushita Electric Ind Co Ltd | プログラム検証システム |

| WO2006020305A2 (en) * | 2004-07-30 | 2006-02-23 | Apple Computer, Inc. | Gestures for touch sensitive input devices |

| JP2008508601A (ja) * | 2004-07-30 | 2008-03-21 | アップル インコーポレイテッド | タッチ・センシティブ入力デバイスのためのジェスチャ |

| JP2007299384A (ja) * | 2006-05-03 | 2007-11-15 | Mitsubishi Electric Research Laboratories Inc | コンピュータで実施するマルチタッチセンシティブ画面でマウスをエミュレートする方法及びマウスをエミュレートするシステム |

Cited By (33)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2011034451A (ja) * | 2009-08-04 | 2011-02-17 | Fujitsu Component Ltd | タッチパネル装置及び方法並びにプログラム及び記録媒体 |

| JP2011053770A (ja) * | 2009-08-31 | 2011-03-17 | Nifty Corp | 情報処理装置及び入力処理方法 |

| JP2011086035A (ja) * | 2009-10-14 | 2011-04-28 | Nec Corp | 携帯機器、その画像表示制御方法および装置 |

| JP2011138475A (ja) * | 2009-12-25 | 2011-07-14 | Cywee Group Ltd | マルチタッチ信号を生成する方法、マルチタッチ信号を生成するドングル、及び関連した制御システム |

| JP2011257992A (ja) * | 2010-06-09 | 2011-12-22 | Fujitsu Component Ltd | 変換装置及びプログラム |

| JP2012008968A (ja) * | 2010-06-28 | 2012-01-12 | Honda Motor Co Ltd | 携帯機器と連携し、該携帯機器に対して可能な入力操作を実現する車載機器 |

| US10732829B2 (en) | 2011-06-05 | 2020-08-04 | Apple Inc. | Devices, methods, and graphical user interfaces for providing control of a touch-based user interface absent physical touch capabilities |

| US9513799B2 (en) | 2011-06-05 | 2016-12-06 | Apple Inc. | Devices, methods, and graphical user interfaces for providing control of a touch-based user interface absent physical touch capabilities |

| KR101886486B1 (ko) * | 2011-06-05 | 2018-08-07 | 애플 인크. | 물리적 터치 기능이 없는 경우 터치-기반 사용자 인터페이스의 제어를 제공하는 장치, 방법 및 그래픽 사용자 인터페이스 |

| JP2014519125A (ja) * | 2011-06-05 | 2014-08-07 | アップル インコーポレイテッド | 物理的なタッチ機能のないタッチユーザインタフェースを制御するためのデバイス、方法及びグラフィカルユーザインタフェース |

| KR101843903B1 (ko) | 2011-06-05 | 2018-04-02 | 애플 인크. | 물리적 터치 기능이 없는 경우 터치-기반 사용자 인터페이스의 제어를 제공하는 장치, 방법 및 그래픽 사용자 인터페이스 |

| US11775169B2 (en) | 2011-06-05 | 2023-10-03 | Apple Inc. | Devices, methods, and graphical user interfaces for providing control of a touch-based user interface absent physical touch capabilities |

| US11354032B2 (en) | 2011-06-05 | 2022-06-07 | Apple Inc. | Devices, methods, and graphical user interfaces for providing control of a touch-based user interface absent physical touch capabilities |

| KR20150082645A (ko) * | 2011-06-05 | 2015-07-15 | 애플 인크. | 물리적 터치 기능이 없는 경우 터치-기반 사용자 인터페이스의 제어를 제공하는 장치, 방법 및 그래픽 사용자 인터페이스 |

| US10120566B2 (en) | 2011-06-05 | 2018-11-06 | Apple Inc. | Devices, methods, and graphical user interfaces for providing control of a touch-based user interface absent physical touch capabilities |

| JP2018018527A (ja) * | 2011-06-05 | 2018-02-01 | アップル インコーポレイテッド | 物理的なタッチ機能のないタッチユーザインタフェースを制御するためのデバイス、方法及びグラフィカルユーザインタフェース |

| JP2016129034A (ja) * | 2011-06-05 | 2016-07-14 | アップル インコーポレイテッド | 物理的なタッチ機能のないタッチユーザインタフェースを制御するためのデバイス、方法及びグラフィカルユーザインタフェース |

| JP2014534544A (ja) * | 2011-12-02 | 2014-12-18 | ジーティーテレコム | タッチスクリーン上における画面操作方法 |

| US11947792B2 (en) | 2011-12-29 | 2024-04-02 | Apple Inc. | Devices, methods, and graphical user interfaces for providing multitouch inputs and hardware-based features using a single touch input |

| KR101381878B1 (ko) * | 2012-04-10 | 2014-04-07 | 주식회사 오비고 | 마우스를 이용하여 터치 입력을 구현하기 위한 방법, 장치, 및 컴퓨터 판독 가능한 기록 매체 |

| JP2014516185A (ja) * | 2012-04-27 | 2014-07-07 | 深▲セン▼瑞高信息技術有限公司 | タッチスクリーン用アプリケーションプログラムの仮想アイコン操作変換方法及びタッチスクリーン端末 |

| JP2014059817A (ja) * | 2012-09-19 | 2014-04-03 | Konica Minolta Inc | 画像処理装置、操作標準化方法および操作標準化プログラム |

| US9386174B2 (en) | 2013-05-09 | 2016-07-05 | Konica Minolta, Inc. | Image forming apparatus, method for guidance on operation method by image forming apparatus, and system |

| JP2014219867A (ja) * | 2013-05-09 | 2014-11-20 | コニカミノルタ株式会社 | 画像形成装置、画像形成装置が操作方法を案内する方法、プログラム、および、システム |

| JP2015022695A (ja) * | 2013-07-23 | 2015-02-02 | 三菱電機株式会社 | ユーザインタフェース模擬装置 |

| WO2015033967A1 (ja) * | 2013-09-06 | 2015-03-12 | 株式会社ソニー・コンピュータエンタテインメント | エミュレーション装置、エミュレーション方法、プログラム及び情報記憶媒体 |

| JP2016024580A (ja) * | 2014-07-18 | 2016-02-08 | 富士通株式会社 | 情報処理装置、入力制御方法、および入力制御プログラム |

| US10986252B2 (en) | 2015-06-07 | 2021-04-20 | Apple Inc. | Touch accommodation options |

| US11470225B2 (en) | 2015-06-07 | 2022-10-11 | Apple Inc. | Touch accommodation options |

| WO2020194569A1 (ja) * | 2019-03-27 | 2020-10-01 | 三菱電機株式会社 | 変換システム、変換装置及び変換方法 |

| JPWO2020194569A1 (ja) * | 2019-03-27 | 2021-10-14 | 三菱電機株式会社 | 変換システム、変換装置及び変換方法 |

| KR20210083495A (ko) * | 2019-12-27 | 2021-07-07 | 주식회사 이누씨 | 가상 포지셔닝 방법 및 장치 |

| KR102322067B1 (ko) * | 2019-12-27 | 2021-11-04 | 주식회사 이누씨 | 가상 포지셔닝 방법 및 장치 |

Also Published As

| Publication number | Publication date |

|---|---|

| GB2457802B (en) | 2010-11-03 |

| AU2009200298A1 (en) | 2009-09-10 |

| CA2651409C (en) | 2016-09-20 |

| CN101520702B (zh) | 2012-05-30 |

| CN101520702A (zh) | 2009-09-02 |

| GB2457802A (en) | 2009-09-02 |

| CA2651409A1 (en) | 2009-08-26 |

| IL197215A0 (en) | 2009-12-24 |

| WO2009108584A3 (en) | 2010-03-18 |

| GB0902821D0 (en) | 2009-04-08 |

| AU2009200298B2 (en) | 2010-05-13 |

| EP2096524A2 (en) | 2009-09-02 |

| US20090213083A1 (en) | 2009-08-27 |

| WO2009108584A2 (en) | 2009-09-03 |

| EP2096524A3 (en) | 2010-02-03 |

| DE102009010744A1 (de) | 2009-09-24 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| AU2009200298B2 (en) | Simulation of multi-point gestures with a single pointing device | |

| CN102096548B (zh) | 采用触控式显示器复制对象的方法和系统 | |

| TWI459281B (zh) | 在使用者介面顯示上顯現教學動畫 | |

| EP2686758B1 (en) | Input device user interface enhancements | |

| US20100095234A1 (en) | Multi-touch motion simulation using a non-touch screen computer input device | |

| US20110069018A1 (en) | Double Touch Inputs | |

| US20120188164A1 (en) | Gesture processing | |

| US20100328236A1 (en) | Method for Controlling a Computer System and Related Computer System | |

| EP2175350A1 (en) | Multi-touch motion simulation using a non-touch screen computer input device | |

| US9218064B1 (en) | Authoring multi-finger interactions through demonstration and composition | |

| CN108595010B (zh) | 虚拟现实中虚拟物体的交互方法及装置 | |

| Freitag et al. | Enhanced feed-forward for a user aware multi-touch device | |

| Yao et al. | A multi-touch natural user interface framework | |

| Chuan et al. | Proposed usability heuristics for testing gestural interaction | |

| Uddin | Improving Multi-Touch Interactions Using Hands as Landmarks | |

| Sayara et al. | GestureCanvas: A Programming by Demonstration System for Prototyping Compound Freehand Interaction in VR | |

| Lai et al. | Virtual touchpad for cursor control of touchscreen thumb operation in the mobile context | |

| Lee et al. | iSphere: a free-hand 3D modeling interface | |

| Thompson III | Evaluation of a commodity VR interaction device for gestural object manipulation in a three dimensional work environment | |

| Greene et al. | Initial ACT-R extensions for user modeling in the mobile touchscreen domain | |

| Geier et al. | Toward a VR-Native Live Programming Environment | |

| Spano | A model-based approach for gesture interfaces | |

| Luderschmidt et al. | Tuio as3: A multi-touch and tangible user interface rapid prototyping toolkit for tabletop interaction | |

| Lee et al. | iSphere: A proximity-based 3D input interface | |

| TW201109996A (en) | Method for operating a touch screen, method for defining a touch gesture on the touch screen, and electronic device thereof |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20100825 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20110825 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20110829 |

|

| A601 | Written request for extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A601 Effective date: 20111129 |

|

| A602 | Written permission of extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A602 Effective date: 20111202 |

|

| A601 | Written request for extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A601 Effective date: 20111214 |

|

| A602 | Written permission of extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A602 Effective date: 20111219 |

|

| A601 | Written request for extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A601 Effective date: 20120130 |

|

| A602 | Written permission of extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A602 Effective date: 20120202 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20120229 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20120730 |

|

| A601 | Written request for extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A601 Effective date: 20121029 |

|

| A602 | Written permission of extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A602 Effective date: 20121101 |

|

| A601 | Written request for extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A601 Effective date: 20121129 |

|

| A602 | Written permission of extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A602 Effective date: 20121204 |

|

| A601 | Written request for extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A601 Effective date: 20121227 |

|

| A602 | Written permission of extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A602 Effective date: 20130107 |

|

| A02 | Decision of refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A02 Effective date: 20130701 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20131031 |

|

| A911 | Transfer to examiner for re-examination before appeal (zenchi) |

Free format text: JAPANESE INTERMEDIATE CODE: A911 Effective date: 20131107 |

|

| A912 | Re-examination (zenchi) completed and case transferred to appeal board |

Free format text: JAPANESE INTERMEDIATE CODE: A912 Effective date: 20140124 |