DE69835039T2 - Objektbasiertes audiovisuelles Endgerät und entsprechende Bitstromstruktur - Google Patents

Objektbasiertes audiovisuelles Endgerät und entsprechende Bitstromstruktur Download PDFInfo

- Publication number

- DE69835039T2 DE69835039T2 DE69835039T DE69835039T DE69835039T2 DE 69835039 T2 DE69835039 T2 DE 69835039T2 DE 69835039 T DE69835039 T DE 69835039T DE 69835039 T DE69835039 T DE 69835039T DE 69835039 T2 DE69835039 T2 DE 69835039T2

- Authority

- DE

- Germany

- Prior art keywords

- objects

- audiovisual

- composition

- video

- scenes

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Lifetime

Links

- 239000000203 mixture Substances 0.000 claims abstract description 71

- 238000000034 method Methods 0.000 claims abstract description 18

- 239000000872 buffer Substances 0.000 claims description 32

- 230000002085 persistent effect Effects 0.000 claims description 22

- 239000002131 composite material Substances 0.000 claims description 5

- 230000002688 persistence Effects 0.000 claims description 5

- 230000002452 interceptive effect Effects 0.000 claims 1

- 230000011664 signaling Effects 0.000 description 6

- 238000010276 construction Methods 0.000 description 3

- 238000010586 diagram Methods 0.000 description 3

- 230000008859 change Effects 0.000 description 2

- 230000006835 compression Effects 0.000 description 2

- 238000007906 compression Methods 0.000 description 2

- 238000012217 deletion Methods 0.000 description 2

- 230000037430 deletion Effects 0.000 description 2

- 238000013461 design Methods 0.000 description 2

- 230000003993 interaction Effects 0.000 description 2

- 238000012986 modification Methods 0.000 description 2

- 230000004048 modification Effects 0.000 description 2

- 238000012546 transfer Methods 0.000 description 2

- 230000000007 visual effect Effects 0.000 description 2

- 238000013459 approach Methods 0.000 description 1

- 230000008901 benefit Effects 0.000 description 1

- 230000005540 biological transmission Effects 0.000 description 1

- 239000000470 constituent Substances 0.000 description 1

- 230000000694 effects Effects 0.000 description 1

- 230000006870 function Effects 0.000 description 1

- 230000000977 initiatory effect Effects 0.000 description 1

- 230000010354 integration Effects 0.000 description 1

- 230000007246 mechanism Effects 0.000 description 1

- 230000008569 process Effects 0.000 description 1

- 238000012545 processing Methods 0.000 description 1

- 238000000926 separation method Methods 0.000 description 1

- 230000032258 transport Effects 0.000 description 1

- 238000012795 verification Methods 0.000 description 1

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/40—Client devices specifically adapted for the reception of or interaction with content, e.g. set-top-box [STB]; Operations thereof

- H04N21/43—Processing of content or additional data, e.g. demultiplexing additional data from a digital video stream; Elementary client operations, e.g. monitoring of home network or synchronising decoder's clock; Client middleware

- H04N21/4302—Content synchronisation processes, e.g. decoder synchronisation

- H04N21/4307—Synchronising the rendering of multiple content streams or additional data on devices, e.g. synchronisation of audio on a mobile phone with the video output on the TV screen

- H04N21/43072—Synchronising the rendering of multiple content streams or additional data on devices, e.g. synchronisation of audio on a mobile phone with the video output on the TV screen of multiple content streams on the same device

-

- G—PHYSICS

- G11—INFORMATION STORAGE

- G11B—INFORMATION STORAGE BASED ON RELATIVE MOVEMENT BETWEEN RECORD CARRIER AND TRANSDUCER

- G11B27/00—Editing; Indexing; Addressing; Timing or synchronising; Monitoring; Measuring tape travel

- G11B27/02—Editing, e.g. varying the order of information signals recorded on, or reproduced from, record carriers

- G11B27/031—Electronic editing of digitised analogue information signals, e.g. audio or video signals

- G11B27/032—Electronic editing of digitised analogue information signals, e.g. audio or video signals on tapes

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T1/00—General purpose image data processing

- G06T1/60—Memory management

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L19/00—Speech or audio signals analysis-synthesis techniques for redundancy reduction, e.g. in vocoders; Coding or decoding of speech or audio signals, using source filter models or psychoacoustic analysis

- G10L19/002—Dynamic bit allocation

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L19/00—Speech or audio signals analysis-synthesis techniques for redundancy reduction, e.g. in vocoders; Coding or decoding of speech or audio signals, using source filter models or psychoacoustic analysis

- G10L19/008—Multichannel audio signal coding or decoding using interchannel correlation to reduce redundancy, e.g. joint-stereo, intensity-coding or matrixing

-

- G—PHYSICS

- G11—INFORMATION STORAGE

- G11B—INFORMATION STORAGE BASED ON RELATIVE MOVEMENT BETWEEN RECORD CARRIER AND TRANSDUCER

- G11B27/00—Editing; Indexing; Addressing; Timing or synchronising; Monitoring; Measuring tape travel

- G11B27/02—Editing, e.g. varying the order of information signals recorded on, or reproduced from, record carriers

- G11B27/031—Electronic editing of digitised analogue information signals, e.g. audio or video signals

- G11B27/034—Electronic editing of digitised analogue information signals, e.g. audio or video signals on discs

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/234—Processing of video elementary streams, e.g. splicing of video streams or manipulating encoded video stream scene graphs

- H04N21/23412—Processing of video elementary streams, e.g. splicing of video streams or manipulating encoded video stream scene graphs for generating or manipulating the scene composition of objects, e.g. MPEG-4 objects

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/234—Processing of video elementary streams, e.g. splicing of video streams or manipulating encoded video stream scene graphs

- H04N21/2343—Processing of video elementary streams, e.g. splicing of video streams or manipulating encoded video stream scene graphs involving reformatting operations of video signals for distribution or compliance with end-user requests or end-user device requirements

- H04N21/234318—Processing of video elementary streams, e.g. splicing of video streams or manipulating encoded video stream scene graphs involving reformatting operations of video signals for distribution or compliance with end-user requests or end-user device requirements by decomposing into objects, e.g. MPEG-4 objects

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/25—Management operations performed by the server for facilitating the content distribution or administrating data related to end-users or client devices, e.g. end-user or client device authentication, learning user preferences for recommending movies

- H04N21/254—Management at additional data server, e.g. shopping server, rights management server

- H04N21/2541—Rights Management

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/40—Client devices specifically adapted for the reception of or interaction with content, e.g. set-top-box [STB]; Operations thereof

- H04N21/41—Structure of client; Structure of client peripherals

- H04N21/426—Internal components of the client ; Characteristics thereof

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/40—Client devices specifically adapted for the reception of or interaction with content, e.g. set-top-box [STB]; Operations thereof

- H04N21/43—Processing of content or additional data, e.g. demultiplexing additional data from a digital video stream; Elementary client operations, e.g. monitoring of home network or synchronising decoder's clock; Client middleware

- H04N21/433—Content storage operation, e.g. storage operation in response to a pause request, caching operations

- H04N21/4331—Caching operations, e.g. of an advertisement for later insertion during playback

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/40—Client devices specifically adapted for the reception of or interaction with content, e.g. set-top-box [STB]; Operations thereof

- H04N21/43—Processing of content or additional data, e.g. demultiplexing additional data from a digital video stream; Elementary client operations, e.g. monitoring of home network or synchronising decoder's clock; Client middleware

- H04N21/44—Processing of video elementary streams, e.g. splicing a video clip retrieved from local storage with an incoming video stream or rendering scenes according to encoded video stream scene graphs

- H04N21/44012—Processing of video elementary streams, e.g. splicing a video clip retrieved from local storage with an incoming video stream or rendering scenes according to encoded video stream scene graphs involving rendering scenes according to scene graphs, e.g. MPEG-4 scene graphs

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/80—Generation or processing of content or additional data by content creator independently of the distribution process; Content per se

- H04N21/83—Generation or processing of protective or descriptive data associated with content; Content structuring

- H04N21/835—Generation of protective data, e.g. certificates

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N5/00—Details of television systems

- H04N5/222—Studio circuitry; Studio devices; Studio equipment

- H04N5/262—Studio circuits, e.g. for mixing, switching-over, change of character of image, other special effects ; Cameras specially adapted for the electronic generation of special effects

- H04N5/265—Mixing

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N7/00—Television systems

- H04N7/24—Systems for the transmission of television signals using pulse code modulation

- H04N7/52—Systems for transmission of a pulse code modulated video signal with one or more other pulse code modulated signals, e.g. an audio signal or a synchronizing signal

Landscapes

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Signal Processing (AREA)

- Physics & Mathematics (AREA)

- Computer Security & Cryptography (AREA)

- Computational Linguistics (AREA)

- Health & Medical Sciences (AREA)

- Audiology, Speech & Language Pathology (AREA)

- Human Computer Interaction (AREA)

- Acoustics & Sound (AREA)

- Databases & Information Systems (AREA)

- General Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- Mathematical Physics (AREA)

- Two-Way Televisions, Distribution Of Moving Picture Or The Like (AREA)

- Compression Or Coding Systems Of Tv Signals (AREA)

- Television Signal Processing For Recording (AREA)

- Stereophonic System (AREA)

Description

- Technisches Gebiet

- Diese Erfindung betrifft die Darstellung, Übertragung, Verarbeitung und Anzeige von audiovisueller/Video-Information, insbesondere Objekt-basierender Information.

- Hintergrund der Erfindung

- Bild- und Videokompressionstechniken wurden bereits entwickelt, welche im Gegensatz zur herkömmlichen Wellenformcodierung versuchen, eine höhere Struktur an visuellem Inhalt zu erzielen. Eine derartige Struktur wird in Form von Bestandteil-"Objekten" beschrieben, welche unmittelbare visuelle Relevanz besitzen, die übliche physikalische Objekte darstellen, wie zum Beispiel einen Ball, einen Tisch, eine Person, eine Melodie oder einen gesprochenen Satz. Objekte werden unabhängig unter Verwendung einer Kompressionstechnik codiert, welche die beste Qualität für jedes Objekt ergibt. Die komprimierten Objekte werden zusammen mit Zusammensetzungsinformation an ein Endgerät gesendet, welche dem Endgerät mitteilt, wo die Objekte in einer Szene zu positionieren sind. Das Endgerät decodiert die Objekte und positioniert diese in der Szene gemäß Spezifikation durch die Zusammensetzungsinformation. Zusätzlich zur Erzielung von Codierungsgewinnen sind Objekt-basierende Darstellungen in Bezug auf die Modularität, Wiederverwendung des Inhaltes, Leichtigkeit der Manipulation, Leichtigkeit der Wechselwirkung mit individuellen Bildkomponenten und Integration eines natürlichen, Kamera-erfassten Inhalts mit synthetischen, Computer-erzeugten Inhalt nützlich.

- Technische Information bezüglich der vorliegenden Erfindung kann in dem Artikel 'A Proposed Architecture for a Object-Based Audio-Visual Bitstream and Terminal' (MPEG97/M1619), das dem Sevilla Meeting of the working group ISO/IEC JTC1/SC29/WG11 eingereicht wurde, und in der Patentanmeldung EP-A-0 858 288, die den Stand der Technik im Sinne von Art. 54/3 EPC darstellt, gefunden werden.

- Zusammenfassung der Erfindung

- Die vorliegende Erfindung betrifft ein Verfahren und eine Vorrichtung zum Darstellen Objekt-basierender Audio-visueller Daten gemäß den beigefügten Ansprüchen.

- In einer bevorzugten Architektur, Struktur oder Format für auf einer Objektbasierenden Video- oder audiovisuellen (AV-Endgerät) zu verarbeitenden Information, enthält ein Objekt-orientierter Bitstrom Objekte, Zusammensetzungsinformation und Szenenabgenzungsinformation. Die Bitstromstruktur ermöglicht eine Online-Editierung, zum Beispiel Ausschneiden und Einfügen, Einfügen/Löschen, Gruppieren und spezielle Effekte.

- In der bevorzugten Architektur werden im Interesse einer leichten Editierung die AV-Objekte und deren Zusammensetzungsinformation auf getrennten logischen Kanälen (LCs) übertragen oder über diese zugegriffen. Die Architektur macht auch von "Objektpersistenz" Gebrauch, indem der Vorteil genutzt wird, dass einige Objekte eine Lebensdauer in dem Decoder über ihre anfängliche Präsentationszeit hinaus zu einem ausgewählten Ablaufzeitpunkt haben.

- Kurzbeschreibung der Zeichnungen

-

1 ist eine funktionale schematische Darstellung eines exemplarischen Objektbasierenden audio-visuellen Endgerätes. -

2a ist eine schematische Darstellung eines exemplarischen Objekt-basierenden audio-visuellen Zusammensetzungspaketes. -

2b ist eine schematische Darstellung eines exemplarischen Objekt-basierenden audio-visuellen Datenpaketes. -

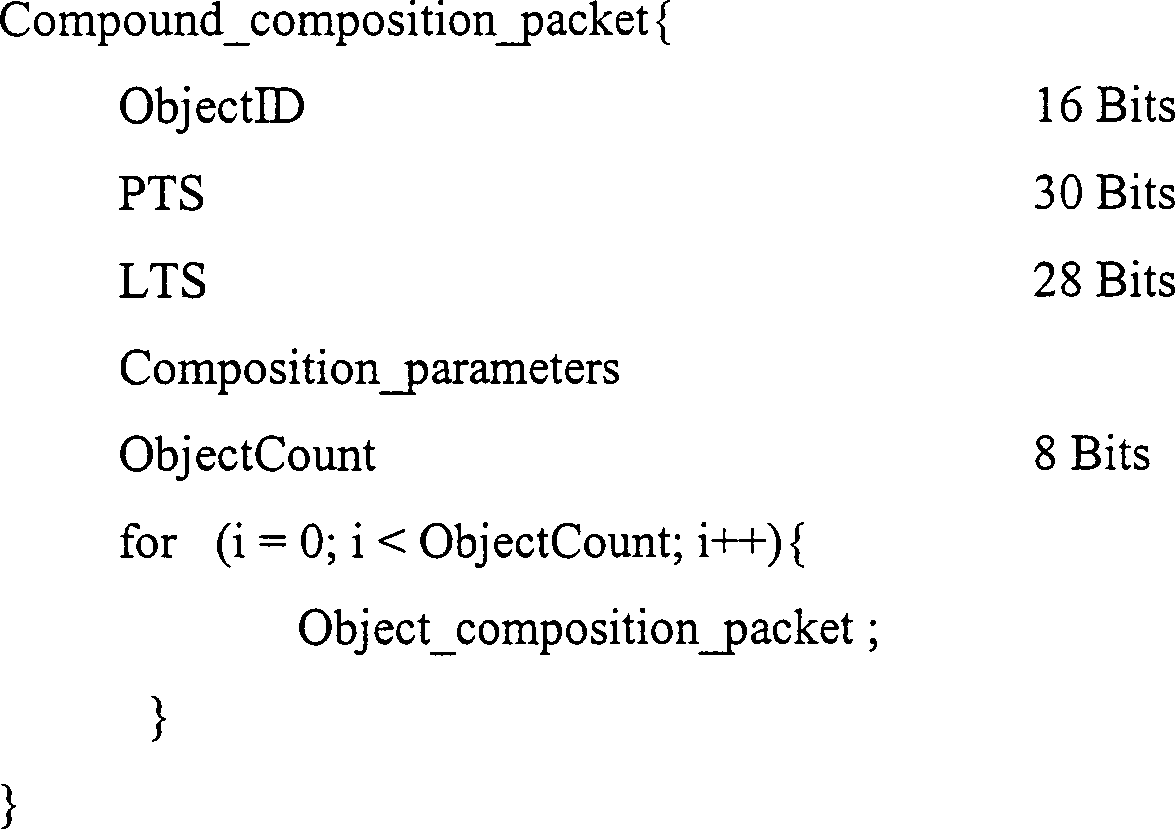

2c ist eine schematische Darstellung eines exemplarischen Mischzusammensetzungspaketes. -

3 ist eine schematische Darstellung einer exemplarischen Knoten- und Szenen-Beschreibungsinformation unter Anwendung einer Zusammensetzung. -

4 ist eine schematische Darstellung einer exemplarischen Strom-Knoten-Zuordnungsinformation. -

5 ist eine schematische Darstellung einer exemplarischen Knoten/Grafik-Aktualisierungsinformation unter Nutzung einer Szene. -

6 ist eine schematische Darstellung einer Auslegung eines exemplarischen audiovisuellen Endgerätes. -

7 ist eine schematische Darstellung einer exemplarischen audio-visuellen Systemsteuerung in dem Endgerät gemäß6 . -

8 ist eine schematische Darstellung eines exemplarischen Informationsflusses in der Steuerung gemäß7 . - Detaillierte Beschreibung

- Ein audio-visuelles (AV)-Endgerät ist eine Systemkomponente, welche zur Erzeugung, Präsentation oder Darstellung von audio-visuellem Inhalt dient. Dieses beinhaltet (ist jedoch nicht darauf beschränkt) Endbenutzer-Endgeräte mit einem Monitorbildschirm und Lautsprechern, sowie Server- und Mainframe-Computeranlagen, in welchen audio-visuelle Information verarbeitet wird. In einem AV-Endgerät kann die gewünschte Funktionalität durch Hardware, Firmware oder Software implementiert sein. Zu verarbeitende Information kann an das Endgerät von einer entfernt angeordneten Informationsquelle über einen Telekommunikationskanal geliefert werden oder kann beispielsweise aus einem lokalen Archiv erhalten werden. Ein Objekt-orientiertes audiovisuelles Endgerät empfängt insbesondere Information individueller Objekte, die gemäß an das Endgerät gelieferter Zusammensetzungsinformation in Szenen zu kombinieren sind.

-

1 stellt ein derartiges Endgerät dar, das einen Demultiplexer (DMUX)1 enthält, der über einen logischen Kanal LC0 mit einer Systemsteuerung (oder "ausführenden Einrichtung")2 und über logische Kanäle LC1 bis LCn mit einem Puffer3 verbunden ist. Die ausführende Einrichtung2 und der Puffer3 sind mit Decodern4 verbunden, welche wiederum mit einer Zusammensetzungseinheit5 verbunden sind. Ferner ist die ausführende Einrichtung2 mit der Zusammensetzereinheit5 direkt verbunden und besitzt beispielsweise für eine Benutzereinwirkung einen externen Eingang. - In der bevorzugten AV-Architektur werden die AV-Objekte und deren Zusammensetzungsinformation auf getrennten logischen Kanälen übertragen und auf diese zugegriffen. Der DMUX empfängt die Mux2 Schicht aus den unteren Schichten und demultiplexiert sie in logische Kanäle. Der LC0 transportiert die Zusammensetzungsinformation, welche an die ausführende Einrichtung übergeben wird. Die auf anderen logischen Kanälen empfangenen AV-Objekte werden in dem Puffer gespeichert, um durch die Decoder bearbeitet zu werden. Die ausführende Einrichtung empfängt die Zusammensetzungsinformation, welche die Decodierungs- und Präsentationszeitstempel enthält und weist die Decoder und die Zusammensetzungseinrichtung dementsprechend an.

- Das System handhabt Objektzusammensetzungspakete (OCP) und Objektdatenpakete (ODP). Ein Zusammensetzungspaket enthält eine Objekt-ID, Zeitstempel und die "Zusammensetzungsparameter" für den Aufbau des Objektes. Ein Objektdatenpaket enthält eine Objekt-ID, einen Ablaufzeitstempel im Falle persistenter Objekte und Objektdaten.

- Bevorzugt wird jede externe Eingabe, zum Beispiel ein Benutzereingriff in "OCP" oder "ODP" umgewandelt, bevor sie der ausführende Einrichtung präsentiert wird. Es besteht kein Bedarf für Vorspann in einem über ein Netzwerk gelieferten Bitstrom. Jedoch werden Vorspanne benötigt, wenn eine MPEG4-Präsentation in einer Datei gespeichert wird.

-

2a und2b stellen die Zusammensetzungsstruktur und Datenpakete detaillierter dar. Relevante Merkmale sind wie folgt:

Eine Objekt-ID besteht aus einem Objekttyp und einer Objektnummer. Die Vorgabelänge der Objekt-ID ist 2 Byte, welche 10 Bits für die Objektnummer und 6 für den Objekttyp (zum Beispiel Text, Grafik, MPEG2, VOP, Mischobjekt) enthalten. Ein erweiterbarer Code wird dazu genutzt, mehr als 1023 Objekte oder mehr als 31 Objekttypen zu ermöglichen. Die nachstehende Konvention wird ferner hinzugefügt: ein Wert von 0b111111 in den ersten sechs Bit des Objekt-ID entspricht 31 plus dem Wert des Bytes unmittelbar nach dem Objekt-ID; ein Wert von 0b11.1111.1111 in den niedrigstwertigen 10 Bits des Objekt-ID entspricht 1023 plus dem Wert der zwei Bytes unmittelbar nach dem Objekt-ID (ohne Zählen der Objekttyperweiterungsbyte, falls vorhanden). Die nachstehenden Objekttypen sind definiert: Zusammensetzungsobjekte (16 Bit Objekt-IDs)0X0000 Szenenkonfigurationsobjekt 0X0001 Knotenhierarchiespezifikation 0X0002 Stromknotenzuordnung 0X0003 Knoten/Szenen-Aktualisierung 0X0004 Mischobjekt 0b00.0010 Text 0b00.0011 MPEG2 VOP (rechteckiger VOP) - Persistente Objekte (PO) sind Objekte, die bei dem Decoder zur Verwendung zu einem späteren Zeitpunkt gespeichert werden sollten. Ein Ablaufzeitstempel (ETS) gibt die Lebensdauer eines PO mit Millisekunden an. Ein PO steht für den Decoder nach dem Ablauf des ETS nicht mehr zur Verfügung. Wenn ein PO zu einem späteren Zeitpunkt in einer Szene verwendet werden soll, muss nur die entsprechende Zusammensetzungsinformation an das AV-Endgerät gesendet werden.

- Decodierungszeitstempel (DTS) zeigt den Zeitpunkt an, an dem ein Objekt (Zugriffseinheit) durch den Decoder decodiert werden sollte.

- Präsentationszeitstempel (PTS) zeigt den Zeitpunkt an, an welchem ein Objekt (Zugriffseinheit) durch den Decoder präsentiert werden sollte.

- Lebensdauerzeitstempel (LTS) gibt die Dauer (in Millisekunden) an, über die ein Objekt in einer Szene dargestellt werden sollte. Der LTS ist in einigen Fällen implizit, zum Beispiel in einer Videosequenz, in welcher ein Rahmen für 1/Rahmenrate angezeigt wird oder bis der nächste Rahmen verfügbar ist, je nachdem was größer ist. Ein expliziter LTS wird verwendet, wenn Grafik und Text dargestellt wird. Ein AV-Objekt sollte nur einmal zur Verwendung während seiner Lebensdauer decodiert werden.

- Ablaufzeitstempel (ETS) ist spezifiziert, um den Begriff der Objektpersistenz zu unterstützen. Ein Objekt, wird nach seiner Präsentation bei dem Decoder (Cache) bis zu einem durch die ETS gegebenen Zeitpunkt gespeichert. Ein derartiges Objekt kann mehrere Male verwendet werden, bevor der ETS abläuft. Ein PO mit einem abgelaufenen ETS ist für den Decoder nicht mehr verfügbar.

- Objektzeitbasis (OTB) definiert den Zeitbegriff eines gegebenen AV-Objektcodierers. Unterschiedliche Objekte können zu unterschiedlichen Zeitbasen gehören. Das AV-Endgerät passt die Zeitbasen der lokalen gemäß Spezifikation in dem MSDL VM an.

- Objekttaktbezug (OCR) kann verwendet werden falls erforderlich, um die Geschwindigkeit des OCP an den Decoder zu übertragen. Durch diesen Mechanismus können die OCPs an dem AV-Endgerät zurückgewonnen/angepasst werden.

- Zusammensetzungsparameter werden verwendet, um eine Szene (Platz eines Objektes in einer Szene) zu komponieren. Diese beinhalten die Verschiebung von der oberen linken Ecke des Präsentationsrahmens, Rotationswinkel, Vergrößerungsfaktoren und so weiter.

- Priorität gibt die Priorität eines Objektes für die Übertragung, Decodierung und Darstellung an. MPEG4 unterstützt 32 Prioritätswerte. Niedrigere Zahlen zeigen höhere Prioritäten an.

- Persistenzindikator (PI) zeigt an, ob ein Objekt persistent ist.

- Fortsetzungsindikator (CI) zeigt das Ende eines Objektes in dem momentanen Paket (oder Fortsetzung) an.

- Objektgruppierung erleichtert Operationen, die auf einen Satz von Objekten mit einer einzigen Operation anzuwenden sind. Ein derartiges Merkmal kann dazu genutzt werden, die Menge an gesendeter Zusammensetzungsinformation zu minimieren, sowie eine hierarchische Szenenzusammensetzung auf der Basis unabhängiger Sub-Szenen zu unterstützen. Die Zusammensetzungseinrichtung manipuliert die Komponenten und Objekte als eine Gruppe. Die Struktur eines Mischzusammensetzungspaketes (CCP) ist in

2c dargestellt. - Bitstromstruktur enthält Objektzusammensetzungspakete zum Beschreibung der Zusammensetzung und Steuerung der Präsentation dieser Pakete und Objektdatenpakete, die die Daten für die Objekte enthalten. Eine Szene besteht aus einem Satz von Zusammensetzungspaketen. Der Bitstrom unterstützt die Darstellung von Szenen als eine Hierarchie unter Verwendung von Mischzusammensetzungsobjekten (CCP), was auch als Knotenhierarchie bekannt ist. Eine CCP ermöglicht, die Kombination von Zusammensetzungsobjekten, um komplexe audio-visuelle Szenen zu erzeugen.

- Objekt-Datenpaket:

-

- Objekt-ID – min (Vorgabe) 10 Bits

- CI und PI könnten kombiniert sein:

- 00 – Beginn von nicht persistent

- 10 – Beginn von persistent

- 10 – Fortsezung

- 11 – Ende des Objekts

- Priorität: 5 Bits, nur vorhanden, wenn CI/PI is 0b00 or 0b1

- ETS: 30 Bits, vorhanden, wenn C1/P1 is 0b1

-

-

- Das Szenenkonfigurationspaket (SCP) wird verwendet, um eine Referenzszenen-Breite, -Höhe zu verändern, um den Puffer zu leeren und andere Konfigurationsfunktionen. Der Objekttyp für SCPs ist 0b00.0000. Dieses ermöglicht 1024 unterschiedliche Konfigurationspakete. Die Objektnummer 0b00.0000.0000 (Objekt-ID 0X0000) ist definiert zur Verwendung mit der Löschung der Endgerätepuffer.

- Zusammensetzungssteuerung für Puffermanagement (Objekt-ID 0x0000)

- Die AV-Endgerätepuffer werden unter Verwendung von Flush_Cache- und Scene_Update-Flags gelöscht. Wenn eine hierarchische Szenenstruktur verwendet wird, wird das momentane Szenenbild gelöscht, und das Endgerät lädt die neue Szene aus dem Bitstrom. Die Verwendung von Flags erlaubt die Speicherung der aktuellen Szenenstruktur anstelle deren Löschung. Diese Flags werden dazu genutzt, die Bezugszenenbreite und Höhe zu aktualisieren, sobald eine neue Szene beginnt. Wenn das Flash_Cache-Flag gesetzt ist, wird der Cache gelöscht, was die Objekte, falls vorhanden) entfernt. Wenn das Scene_Update-Flag gesetzt ist, gibt es zwei Möglichkeiten: (i) das Flash_Cache-Flag ist gesetzt, was impliziert, dass die Objekte in dem Cache nicht mehr verwendet werden; (ii) das Flash_Cache-Flag ist nicht gesetzt, die neue Szene, die gerade eingeführt wird (ein Editierungsvorgang auf dem Bitstrom) teilt die momentane Szene auf und die Objekte in der Szene werden nach dem Ende der neuen Szene verwendet. Die ETS der Objekte, falls vorhanden, werden für die Dauer der neuen eingeführten Szene eingefroren. Der Beginn der nächsten Szene wird durch ein weiteres Szenenkonfigurationspaket angezeigt.

- Zusammensetzungssteuerung für Szenenbeschreibung (Objekt-ID 0x0001)

- Eine Hierarchie von Knoten ist definiert, die eine Szene beschreibt. Die Szenekonfigurationspakete können auch zur Definition einer Szenenhierarchie verwendet werden, was eine Beschreibung von Szenen als eine Hierarchie von AV-Objekten ermöglicht. Jeder Knoten in einer derartigen Graphik ist eine Gruppierung von Knoten, die die Blätter und/oder andere Knoten der Graphik in ein Misch-AV-Objekt gruppiert. Jeder Knoten (Blatt) besitzt eine eindeutige ID, gefolgt von dessen Parametern gemäß Darstellung in

3 . - Zusammensetzungssteuerung für Stromknotenzuordnung (Objekt-ID 0x0002)

- Gemäß Darstellung durch

4 ordnen Tabelleneinträge die elementaren Objektströme in den logischen Kanälen den Knoten in einer hierarchischen Szene zu. Die Strom-IDs sind eindeutig, aber nicht die Knoten IDs. Dieses impliziert, dass mehr als ein Strom denselben Knoten zugeordnet sein kann. - Zusammensetzungssteuerung für Szenenaktualisierungen (Objekt-ID 0x0003)

-

5 veranschaulicht die Aktualisierung der Knoten in der Szenenhierarchie durch Modifizieren der spezifischen Parameter des Knotens. Die Graphik selbst kann durch Hinzufügen/Weglassen der Knoten in der Graphik aktualisiert werden. Der Aktualisierungstyp in dem Paket zeigt den Typ der an der Graphik durchzuführenden Aktualisierung an. - Aufbau-Ausführungsform

- Die nachstehend beschriebene Ausführungsform beinhaltet einen Objekt-basierenden AV-Bitstrom und einen Endgeräteaufbau Die Bitstromauslegung spezifiziert in einem binären Format, wie AV-Objekte repräsentiert werden, und wie sie zusammenzusetzen sind. Die AV-Endgerätestruktur spezifiziert wie die Objekte in dem binären Bitstrom zu decodieren und dazustellen sind.

- AV-Endgeräteaufbau

- Ferner ist gemäß

1 und gemäß spezifischer Bezugnahme auf6 das Eingangssignal zu dem Demultiplexer1 ein Objekt-basierender Bitstrom, wie zum Beispiel ein MPEG-4 Bitstrom der aus AV-Objekten und deren in logische Kanäle (LC) multiplexierten Zusammensetzungsinformation besteht. Die Zusammensetzung der Objekte in einer Szene kann als eine Sammlung von Objekten mit unabhängiger Zusammensetzungsspezifikation oder als eine hierarchische Szenegraphik spezifiziert sein. Die Zusammensetzungs- und Steuerinformation ist im LC0 enthalten. Die Steuerinformation enthält Steuerbefehle für die Aktualisierung von Szenegraphiken die Rücksetzung von Decoderpuffern und so weiter. Die logischen Kanäle 1 und darüber enthalten Objektdaten. Das System enthält eine Steuerung (oder "ausführende Einrichtung")2 , welche den Betrieb des AV-Endgerätes steuert. - Das Endgerät enthält ferner Eingabepuffer

3 , AV-Objekt-Decoder4 , Puffer4' für decodierte Daten, eine Zusammensetzungsvorrichtung5 , eine Anzeige6 und einen Objektcache7 . Der Eingangsbitstrom kann aus einer Netzwerkverbindung oder einer lokalen Speichervorrichtung, wie zum Beispiel einer DVD, CD-ROM oder Computer-Festplatte eingelesen werden. Der die Zusammensetzungsinformation enthaltende LC0 wird der Steuerung zugeführt. Der DMUX-Speicher speichert die Objekte im LC1 und darüber an der durch die Steuerung spezifizierten Stelle im Puffer. Im Falle einer Zuführung über das Netzwerk arbeiten der Codierer und der Stromserver zusammen um sicherzustellen, dass die Eingabeobjektpuffer niemals über- oder unterlaufen. Die codierten Datenobjekte werden in dem Eingabedatenpuffern gespeichert, bis sie durch die Decoder zu ihrem Decodierungszeitpunkt gelesen werden, der typischerweise durch einen zugeordneten Decodierungszeitstempel angegeben ist. Vor dem Schreiben eines Datenobjektes in den Puffer entfernt der DMUX die Zeitstempel und andere Vorspanne aus dem Objektdatenpaket und übergibt diese an die Steuerung zur Signalisierung der entsprechenden Decoder und Eingabepuffer. Die Decoder decodieren nach der Signalisierung durch die Steuerung die Daten in den Eingabepuffern und speichern diese in den Decoderausgabepuffern. Das AV-Endgerät handhabt auch eine externe Eingabe, wie zum Beispiel einen Benutzereingriff. - In dem Objektcache

7 werden Objekte über ihre anfängliche Präsentationszeit hinaus gespeichert. Derartige Objekte verbleiben in dem Cache, selbst wenn deren zugeordneter Knoten aus der Szenegraphik gelöscht ist, und werden nur nach Ablauf eines zugeordneten Zeitintervalls gelöscht, welches als der Ablaufzeitstempel bezeichnet wird. Dieses Merkmal kann in Präsentationen verwendet werden, in welchen ein Objekt wiederholt, im Verlauf einer Sitzung verwendet wird. Die derartigen Objekten zugeordnete Zusammensetzung kann mit geeigneten Aktualisierungsmeldungen aktualisiert werden. Beispielsweise kann das Logo der Sendestation zu Beginn der Präsentation heruntergeladen werden, und dieselbe Kopie kann für eine wiederholte Anzeige während einer Sendung verwendet werden. Anschließende Zusammensetzungsaktualisierungen können die Position des Logos auf der Anzeigeeinrichtung verändern. Objekte, die über ihre erste Präsentation hinaus wieder verwendet werden können, können als persistente Objekte bezeichnet werden. - Systemsteuerung (SC)

- Die Systemsteuerung steuert die Decodierung und die Wiedergabe von Bitströmen auf dem AV-Endgerät. Bei dem Startvorgang, ab einem Benutzereingriff oder Warten auf eine Sitzung bei einer Vorgabenetzwerkadresse initialisiert die SC zuerst den DMUX, um aus einer lokalen Speichervorrichtung oder einem Netzwerkport zu lesen. Die Steuerlogik wird in dem Programm-RAM zum Zeitpunkt der Initialisierung geladen. Der Instruktionsdecoder liest die Instruktionen aus dem Programm und führt diese aus. Die Ausführung kann das Lesen der Daten aus den Eingabepuffern (Zusammensetzung- oder externe Daten) die Initialisierung der Objektzeitgeber, dass Laden oder Aktualisieren der Objekttabelle in dem Daten-RAM, das Laden von Objektzeitgebern oder die Steuersignalisierung beinhalten.

-

7 stellt die Systemsteuerung in weiteren Details dar. Der DMUX liest den Eingabebitstrom und führt die Zusammensetzungsdaten auf dem LC0 der Steuerung zu. Die Zusammensetzungsdaten beginnen mit der Beschreibung der ersten Szene in der AV- Präsentation. Diese Szene kann als eine hierarchische Sammlung von Objekten unter Verwendung von Mischzusammensetzungspaketen, oder als eine Sammlung von unabhängigen Objekt-Zusammensetzungspaketen beschrieben sein. Eine Tabelle, die die elementaren Ströme den Knoten in der Szenenbeschreibung zuordnet, folgt unmittelbar der Szenenbeschreibung. Die Steuerung lädt die Objekt-IDs (Strom-IDs) in die Objektliste und Aufbauliste, welche in dem Daten-RAM geführt werden. Die Aufbauliste enthält die Liste der Objekte, die auf der Anzeigevorrichtung aufzubauen sind. Ein Objekt, das durch Benutzereingriff deaktiviert ist, wird aus der Aufbauliste entfernt. Ein Knotenlöschbefehl, der über ein Zusammensetzungssteuerpaket gesendet wird, bewirkt die Löschung der entsprechenden Objekt-IDs aus der Objektliste. Die Knotenhierarchie wird auch in dem Daten-RAM geführt und jedesmal aktualisiert, wenn eine Zusammensetzungsaktualisierung empfangen wird. - Der Zusammensetzungsdecoder liest Daten aus dem Zusammensetzungs- und extern Datenpuffer aus und wandelt diese in ein für den Instruktionsdecoder verständliches Format um. Die externe Eingabe beinhaltet Benutzereingriff, um Objekte auszuwählen, Objekte und bestimmte vordefinierte Operationen an den Objekten zu deaktivieren und zu aktivieren. Während der Ausführung des Programms werden zwei Listen in den Daten-Rahmen erzeugt. Die Objektliste, die eine Liste von Objekten (Objekt-IDs) enthält, die momentan durch die Decoder behandelt werden, und eine Aufbauliste, welche die Liste der aktiven Objekte in der Szene enthält. Diese Listen werden dynamisch aktualisiert, sobald die Zusammensetzungsinformation empfangen wird. Beispielsweise wird, wenn ein Benutzer entscheidet, ein Objekt zu verbergen, indem er einen Befehl über einen externen Eingang eingibt, das Objekt aus der bisher durch den Benutzer spezifizierten Aufbauliste entfernt. Dieses ist auch so, wie eine externe Eingabe durch das System behandelt wird. Sobald irgendein externer Eingriff vorliegt, liest der Zusammensetzungsdecoder den externen Datenpuffer aus und führt die angeforderte Operation durch.

- Die SC führt auch eine Zeitsteuerung für jedes AV-Objekt, um den Decodern und Decoderpuffern einen Decodierungs- und Präsentationszeitpunkt zu signalisieren. Die Zeitinformation für die AV-Objekte ist in Form ihrer Zeitbasis spezifiziert. Das Endgerät verwendet den Systemtakt, um eine Objektzeitbasis in Systemzeit umzuwandeln. Für Objekte, die keine Decodierung erfordern, sind nur Präsentationszeitgeber erforderlich. Diese Zeitgeber werden mit den Decodierungs- und Präsentationszeitstempeln für dieses AV-Objekt geladen. Die Steuerung erhält die Zeitstempel aus dem DMUX für jedes Objekt. Wenn ein Decodierungszeitgeber für ein Objekt abläuft, wird dem geeigneten Decoder signalisiert, Daten aus den Eingabepuffern auszulesen und den Decodierungsprozess zu starten. Wenn ein Präsentationszeitgeber abläuft, werden die decodierten Daten für dieses Objekt an den Rahmenpuffer zur Anzeige übertragen. Ein Doppelpuffer-Lösungsansatz könnte dazu verwendet werden, um ein Schreiben eines Rahmenpuffers zu ermöglichen während die Inhalte des zweiten Puffers auf dem Monitor angezeigt werden. Der Instruktionsdecoder kann auch den DMUX oder der Eingabepuffer zurücksetzten, indem eine Rücksetzung signalisiert, welcher diesen auf einen Vorgabezustands initialisiert.

- Informationsfluss in der Steuerung

-

8 stellt den Informationsfluss in der Steuerung dar. Um die Figur einfach zu halten, sind die in den Instruktionsdecoder ausgeführten Operationen in Gruppen dargestellt. Die drei Gruppen betreffen jeweils Objekteigenschaftsmodifikationen, Objektzeitgebung und Signalisierung. - Objekteigenschaftsmodifikationen

- Diese Operationen manipulieren die Objekt-IDs, die auch als Elementarstrom-IDs bezeichnet werden. Wenn eine Szene zu Beginn geladen wird, wird eine Szenengraphik mit den Objekt-IDs der Objekte in der Szene erzeugt. Die Steuerung erzeugt und führt auch eine Liste von Objekten in der Szene (Objektliste) und aktiver Objekte in den Objekt aus der Aufbauliste. Weitere Operationen setzen und aktualisieren Objekteigenschaften, wie zum Beispiel Zusammensetzungsparameter, wenn das Endgerät ein Zusammensetzungspaket empfängt.

- Objektzeitsteuerung

- Diese Gruppe von Operationen befasst sich mit der Verwaltung von Objektzeitgebern zur Synchronisation, Präsentation und Decodierung. Ein in Form seiner Objektzeitbasis spezifizierter Objektzeitstempel wird in die Systemzeit umgewandelt und die Präsentations- und Decodierungszeit dieses Objektes werden gesetzt. Diese Operationen setzen und rücksetzen die Ablaufzeitstempel für persistente Objekte.

- Signalisierung

- Signalisierungsoperationen steuern die Gesamtoperation des Endgerätes. Verschiedene Komponenten des Endgerätes werden gesetzt, zurückgesetzt und durch die Steuerungssignalisierung betrieben. Die Steuerung prüft die Decodierungs- und Präsentationszeitpunkte der Objekte in der Aufbauliste und signalisiert die Decoder und Präsentationsrahmenpuffer dementsprechend. Sie initialisiert auch den DEMUX zum Lesen aus einem Netzwerk oder einer lokalen Speichervorrichtung. Nach dem Anstoß der Steuerung liest der Decoder die Daten aus den Eingabepuffern und übergibt die decodierten Daten an die Decoderausgabepuffer. Die decodierten Daten werden an die Präsentationsvorrichtung weitergegeben, wenn dieses durch die Steuerung signalisiert wird.

Claims (18)

- Verfahren zum Darstellen Objekt-basierender audiovisueller/Video-Daten, mit den Schritten: (a) Empfangen mehrerer audiovisueller/Video-Objekte und von Zusammensetzungsinformation für die Objekte im Verlauf der Zeit, wobei auf die audiovisuellen/Video-Objekte und auf die Zusammensetzungsinformation für die audiovisuellen/Video-Objekte auf getrennten logischen Kanälen zugegriffen wird; (b) Speichern wenigstens eines von den Objekten in einem Cache-Speicher (

3 ); (c) Verwenden der Zusammensetzungsinformation zum Zusammensetzen (5 ) von Szenen aus den Objekten einschließlich einem von den in dem Cache-Speicher gespeicherten Objekten; und (d) Darstellen (5 ) der zusammengesetzten Szenen; dadurch gekennzeichnet, dass wenigstens eines von den Objekten ein persistentes Objekt aufweist, wobei das persistente Objekt eine über seine ursprüngliche Präsentationszeit hinausgehende Lebensdauer bis zu einer Ablaufzeit besitzt, und wobei ein wiederholt über eine Sitzung hinweg verwendetes persistentes Objekt mittels geeigneten Aktualisierungsmeldungen aktualisiert wird. - Verfahren nach Anspruch 1, wobei ein Ablaufzeitstempel das Leben des persistenten Objektes angibt, wobei das persistente Objekt nach Ablauf des Ablaufzeitstempels nicht mehr verfügbar ist.

- Verfahren nach Anspruch 1, wobei das persistente Objekt mehrere Male in den Szenen verwendet wird.

- Verfahren nach Anspruch 1, wobei die audiovisuellen/Video-Objekte und die Zusammensetzungsinformation für die Objekte in einer Bitstromstruktur angeordnet sind, wobei die Bitstromstruktur aufweist: Objektzusammensetzungspakete zum Beschreiben der Zusammensetzung und Steuern der Präsentation der Pakete; und Objektdatenpakete, die die Daten für die Objekte enthalten.

- Verfahren nach Anspruch 1, wobei wenigstens eines von den Objekten aus einer Netzwerkverbindung empfangen wird.

- Verfahren nach Anspruch 1, wobei wenigstens eines von den Objekten aus einem lokalen Speicher empfangen wird.

- Verfahren nach Anspruch 1, wobei wenigstens eines von den Objekten aus dem lokalen Speicher empfangen wird und wenigstens ein weiteres von den Objekten aus einer Netzwerkverbindung empfangen wird, und wobei die zusammengesetzten Szenen das eine und das andere von den Objekten enthalten.

- Verfahren nach Anspruch 1, welches ferner eine Reaktion auf eine interaktive Benutzereingabe aufweist.

- Verfahren nach Anspruch 2, wobei das persistente Objekt in einem Objekt-Cache (

7 ) zur Verwendung über eine ursprüngliche Präsentationszeit hinaus gespeichert wird, wobei die Objekte in dem Cache (7 ) bis zu dem Ablauf des Ablaufzeitstempels verbleiben. - Verfahren nach Anspruch 1, wobei eine Persistenzanzeige anzeigt, ob ein Objekt ein persistentes Objekt ist oder nicht.

- Verfahren nach Anspruch 4, wobei das Objektdatenpaket eine Persistenzanzeige aufweist, wobei die Persistenzanzeige anzeigt, ob das Objekt ein persistentes Objekt aufweist.

- Verfahren nach Anspruch 4, wobei der Bitstrom die Repräsentation der Szenen als eine Hierarchie unter Nutzung von Befehlszusammensetzungsobjekten unterstützt.

- Verfahren nach Anspruch 4, wobei Tabelleneinträge die elementaren Objektströme in den logischen Kanälen zu Knoten in einer hierarchischen Szene zuordnen.

- Vorrichtung zum Darstellen Objekt-basierender audiovisueller/Video-Daten, mit: (a) einer Steuereinrichtung (

2 ) zum Steuern der Erfassung mehrerer audiovisueller/Video-Objekte und von Zusammensetzungsinformation für die Objekte im Verlauf der Zeit, wobei auf die audiovisuellen/Video-Objekte und auf die Zusammensetzungsinformation für die audiovisuellen/Video-Objekte auf getrennten logischen Kanälen zugegriffen wird (b) einer Cache-Speichereinrichtung (3 ) zum Speichern von wenigstens einem von den Objekten; (c) einer Zusammensetzungseinrichtung (5 ), die mit dem Cache-Speicher (3 ) verbunden ist, um Szenen aus den Videoobjekten einschließlich dem einen von den Objekten, das in dem Cache-Speicher gespeichert ist, zusammenzusetzen; und (d) eine Darstellungseinrichtung (6 ) zum Darstellen einer Szene; dadurch gekennzeichnet, dass wenigstens eines von den Objekten ein persistentes Objekt aufweist, wobei das persistente Objekt eine über seine ursprüngliche Präsentationszeit hinausgehende Lebensdauer bis zu einer Ablaufzeit besitzt, und wobei ein wiederholt über eine Sitzung hinweg verwendetes persistentes Objekt mittels geeigneten Aktualisierungsmeldungen aktualisiert wird. - Vorrichtung nach Anspruch 14, die einen Prozessor aufweist, welcher dafür instruiert ist: (a) eine Erfassung mehrerer audiovisueller/Video-Objekte und von Zusammensetzungsinformation für die Objekte im zeitlichen Verlauf zu steuern, wobei auf die audiovisuellen/Video-Objekte und auf die Zusammensetzungsinformation auf getrennten logischen Kanälen zugegriffen wird (b) wenigstens eines von den Objekten zu speichern; (c) Szenen aus den Video-Objekten einschließlich dem einen von den Objekten, das in dem Cache-Speicher gespeichert ist, zusammenzusetzen (

5 ); und (d) die zusammengesetzten Szenen darzustellen (6 ); dadurch gekennzeichnet, dass wenigstens eines von den Objekten ein persistentes Objekt aufweist, wobei das persistente Objekt mehrere Male in den Szenen verwendet wird. - Vorrichtung nach Anspruch 14, mit: (a) einer Einrichtung (

1 ), die über einen logischen Kanal mit der Einrichtung (2 ) verbunden ist, um die Erfassung mehrerer audiovisueller/Video-Objekte und von Zusammensetzungsinformation für die Objekte im Verlauf der Zeit zu steuern; (b) einer Decodereinrichtung (4 ) zum Lesen und Decodieren der Daten des Cache-Speichers (3 ); (c) einer Puffereinrichtung (4 ) zum Speichern decodierter Daten; und (d) einer Speichereinrichtung (7 ) zum Speichern audiovisueller/Video-Objekte über deren anfängliche Präsentationszeit hinaus. - Vorrichtung nach Anspruch 14, wobei auf die Objekt-basierenden audiovisuellen/Video-Objekte als mehrere elementare Objektströme in logischen Kanälen zugegriffen wird.

- Vorrichtung nach Anspruch 16, wobei das persistente Objekt in einem Objekt-Cache (

7 ) zur Verwendung über die anfängliche Präsentationszeit hinaus gespeichert wird, wobei das Objekt in dem Cache (7 ) bis zu dem Ablauf eines Ablaufzeitstempels verbleibt.

Applications Claiming Priority (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US3777997P | 1997-02-14 | 1997-02-14 | |

| US37779 | 1997-02-14 |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| DE69835039D1 DE69835039D1 (de) | 2006-08-03 |

| DE69835039T2 true DE69835039T2 (de) | 2007-07-12 |

Family

ID=21896290

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| DE69835039T Expired - Lifetime DE69835039T2 (de) | 1997-02-14 | 1998-02-13 | Objektbasiertes audiovisuelles Endgerät und entsprechende Bitstromstruktur |

Country Status (9)

| Country | Link |

|---|---|

| US (9) | US8421923B2 (de) |

| EP (3) | EP1010318A4 (de) |

| JP (1) | JP4393591B2 (de) |

| AT (1) | ATE331390T1 (de) |

| CA (1) | CA2281538C (de) |

| DE (1) | DE69835039T2 (de) |

| ES (1) | ES2266396T3 (de) |

| HK (1) | HK1053929A1 (de) |

| WO (1) | WO1998036559A1 (de) |

Families Citing this family (31)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| ATE331390T1 (de) | 1997-02-14 | 2006-07-15 | Univ Columbia | Objektbasiertes audiovisuelles endgerät und entsprechende bitstromstruktur |

| US6295380B1 (en) * | 1997-02-27 | 2001-09-25 | Matsushita Electric Industrial Co., Ltd. | Object data processing apparatus, object data recording apparatus, data storage media, data structure for transmission |

| US7920143B1 (en) * | 1997-03-27 | 2011-04-05 | At&T Intellectual Property Ii, L.P. | Method for defining animation parameters for an animation definition interface |

| US6535530B1 (en) | 1997-07-23 | 2003-03-18 | Matsushita Electric Industrial Co., Ltd. | Apparatus and method for demultiplexing multiplexed data |

| US7630570B1 (en) * | 1998-05-06 | 2009-12-08 | At&T Intellectual Property Ii, L.P. | Method and apparatus to prioritize video information during coding and decoding |

| US6580756B1 (en) * | 1998-12-11 | 2003-06-17 | Matsushita Electric Industrial Co., Ltd. | Data transmission method, data transmission system, data receiving method, and data receiving apparatus |

| US6970641B1 (en) | 2000-09-15 | 2005-11-29 | Opentv, Inc. | Playback of interactive programs |

| AU770163B2 (en) * | 1999-10-29 | 2004-02-12 | Opentv, Corp. | System and method for recording pushed data |

| US8250617B2 (en) | 1999-10-29 | 2012-08-21 | Opentv, Inc. | System and method for providing multi-perspective instant replay |

| US7000245B1 (en) | 1999-10-29 | 2006-02-14 | Opentv, Inc. | System and method for recording pushed data |

| JP2001189713A (ja) | 1999-12-28 | 2001-07-10 | Toshiba Corp | データ伝送装置およびデータ伝送方法 |

| JP2004507172A (ja) | 2000-08-16 | 2004-03-04 | コーニンクレッカ フィリップス エレクトロニクス エヌ ヴィ | マルチメディアアプリケーションを再生する方法 |

| US6496217B1 (en) * | 2001-06-12 | 2002-12-17 | Koninklijke Philips Electronics N.V. | Video communication system using model-based coding and prioritzation techniques |

| JP2003018580A (ja) * | 2001-06-29 | 2003-01-17 | Matsushita Electric Ind Co Ltd | コンテンツ配信システムおよび配信方法 |

| US6814842B1 (en) | 2001-12-14 | 2004-11-09 | Networks Associates Technology, Inc. | System and method for organizing objects of a voice call in a tree representation |

| US6604139B1 (en) | 2001-12-14 | 2003-08-05 | Networks Associates Technology, Inc. | Voice protocol filtering system and method |

| US6970823B1 (en) | 2001-12-14 | 2005-11-29 | Networks Associates Technology, Inc. | System, method and computer program product for monitoring voice application calls over a network |

| KR100497497B1 (ko) * | 2001-12-27 | 2005-07-01 | 삼성전자주식회사 | 엠펙 데이터의 송수신시스템 및 송수신방법 |

| JP4408677B2 (ja) * | 2002-11-29 | 2010-02-03 | キヤノン株式会社 | 受信装置及び受信方法 |

| EP1499131A1 (de) * | 2003-07-14 | 2005-01-19 | Deutsche Thomson-Brandt Gmbh | Verfahren und Vorrichtung zum Dekodieren eines Datenstromes in Audio-Videoübertragungssystemen |

| US7711840B2 (en) * | 2003-10-23 | 2010-05-04 | Microsoft Corporation | Protocol for remote visual composition |

| JP2006261860A (ja) * | 2005-03-15 | 2006-09-28 | Toshiba Corp | 情報再生方法及び情報再生装置 |

| KR100929073B1 (ko) | 2005-10-14 | 2009-11-30 | 삼성전자주식회사 | 휴대 방송 시스템에서 다중 스트림 수신 장치 및 방법 |

| KR100733965B1 (ko) | 2005-11-01 | 2007-06-29 | 한국전자통신연구원 | 객체기반 오디오 전송/수신 시스템 및 그 방법 |

| KR100942142B1 (ko) * | 2007-10-11 | 2010-02-16 | 한국전자통신연구원 | 객체기반 오디오 콘텐츠 송수신 방법 및 그 장치 |

| CN101859333A (zh) * | 2010-05-17 | 2010-10-13 | 山东大学 | 数字电视处理芯片多核系统片上网络拓扑结构 |

| US9838823B2 (en) | 2013-04-27 | 2017-12-05 | Intellectual Discovery Co., Ltd. | Audio signal processing method |

| US9286383B1 (en) | 2014-08-28 | 2016-03-15 | Sonic Bloom, LLC | System and method for synchronization of data and audio |

| US11130066B1 (en) | 2015-08-28 | 2021-09-28 | Sonic Bloom, LLC | System and method for synchronization of messages and events with a variable rate timeline undergoing processing delay in environments with inconsistent framerates |

| US20170344523A1 (en) * | 2016-05-25 | 2017-11-30 | Samsung Electronics Co., Ltd | Method and apparatus for presentation customization and interactivity |

| WO2022211459A1 (ko) * | 2021-04-02 | 2022-10-06 | 현대자동차주식회사 | 세그멘테이션을 이용하는 비디오 코딩방법 및 장치 |

Family Cites Families (48)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US4899299A (en) * | 1987-12-23 | 1990-02-06 | International Business Machines Corporation | Method for managing the retention of electronic documents in an interactive information handling system |

| FR2661061B1 (fr) * | 1990-04-11 | 1992-08-07 | Multi Media Tech | Procede et dispositif de modification de zone d'images. |

| JP2654324B2 (ja) | 1991-12-31 | 1997-09-17 | インターナショナル・ビジネス・マシーンズ・コーポレイション | マルチメディア・データ処理システム及びマルチメディア・データ処理システムの動作方法 |

| US5590252A (en) * | 1992-04-29 | 1996-12-31 | Canon Kabushiki Kaisha | Video processor system and audio processor system |

| JPH07325934A (ja) * | 1992-07-10 | 1995-12-12 | Walt Disney Co:The | 仮想世界に向上したグラフィックスを提供する方法および装置 |

| US5450140A (en) | 1993-04-21 | 1995-09-12 | Washino; Kinya | Personal-computer-based video production system |

| JP3427416B2 (ja) | 1993-05-25 | 2003-07-14 | ソニー株式会社 | 多重化データ分離装置および方法 |

| US5557342A (en) * | 1993-07-06 | 1996-09-17 | Hitachi, Ltd. | Video display apparatus for displaying a plurality of video signals having different scanning frequencies and a multi-screen display system using the video display apparatus |

| US5430485A (en) | 1993-09-30 | 1995-07-04 | Thomson Consumer Electronics, Inc. | Audio/video synchronization in a digital transmission system |

| US5548346A (en) * | 1993-11-05 | 1996-08-20 | Hitachi, Ltd. | Apparatus for integrally controlling audio and video signals in real time and multi-site communication control method |

| US5852669A (en) | 1994-04-06 | 1998-12-22 | Lucent Technologies Inc. | Automatic face and facial feature location detection for low bit rate model-assisted H.261 compatible coding of video |

| US5592602A (en) * | 1994-05-17 | 1997-01-07 | Macromedia, Inc. | User interface and method for controlling and displaying multimedia motion, visual, and sound effects of an object on a display |

| AU694267B2 (en) | 1994-09-08 | 1998-07-16 | Weather Central, Lp | Method and apparatus for determining the location of a reflective object within a video field |

| US5781184A (en) * | 1994-09-23 | 1998-07-14 | Wasserman; Steve C. | Real time decompression and post-decompress manipulation of compressed full motion video |

| US5760838A (en) | 1994-09-30 | 1998-06-02 | Intel Corporation | Method and system for configuring a display |

| US5541662A (en) | 1994-09-30 | 1996-07-30 | Intel Corporation | Content programmer control of video and data display using associated data |

| US5767911A (en) | 1994-12-20 | 1998-06-16 | Matsushita Electric Industrial Co., Ltd. | Object-based digital image predictive coding transfer method and apparatus, and decoding apparatus |

| US5826102A (en) | 1994-12-22 | 1998-10-20 | Bell Atlantic Network Services, Inc. | Network arrangement for development delivery and presentation of multimedia applications using timelines to integrate multimedia objects and program objects |

| US5943046A (en) * | 1995-07-19 | 1999-08-24 | Intervoice Limited Partnership | Systems and methods for the distribution of multimedia information |

| US5896176A (en) | 1995-10-27 | 1999-04-20 | Texas Instruments Incorporated | Content-based video compression |

| US5784620A (en) | 1995-11-15 | 1998-07-21 | Philips Electronics North America Corp. | Object-oriented system having shared-persistent class pattern |

| KR100211056B1 (ko) | 1995-12-23 | 1999-07-15 | 이계철 | 다수개의 비디오에 대한 윈도우 제어방법 |

| US5778098A (en) | 1996-03-22 | 1998-07-07 | Microsoft Corporation | Sprite coding |

| US6037988A (en) | 1996-03-22 | 2000-03-14 | Microsoft Corp | Method for generating sprites for object-based coding sytems using masks and rounding average |

| KR100209412B1 (ko) | 1996-05-10 | 1999-07-15 | 전주범 | 비디오 신호의 유호 색차 성분 부호화 방법 |

| US6084912A (en) | 1996-06-28 | 2000-07-04 | Sarnoff Corporation | Very low bit rate video coding/decoding method and apparatus |

| US5880792A (en) | 1997-01-29 | 1999-03-09 | Sarnoff Corporation | Command and control architecture for a digital studio |

| US6134269A (en) | 1996-09-25 | 2000-10-17 | At&T Corp | Fixed or adaptive deinterleaved transform coding for image coding and intra coding of video |

| US6055330A (en) | 1996-10-09 | 2000-04-25 | The Trustees Of Columbia University In The City Of New York | Methods and apparatus for performing digital image and video segmentation and compression using 3-D depth information |

| US6512775B1 (en) | 1996-11-08 | 2003-01-28 | The Trustees Of Columbia University In The City Of New York | Method and apparatus for a programmable bitstream parser for audiovisual and generic decoding systems |

| US5872565A (en) | 1996-11-26 | 1999-02-16 | Play, Inc. | Real-time video processing system |

| US6047088A (en) | 1996-12-16 | 2000-04-04 | Sharp Laboratories Of America, Inc. | 2D mesh geometry and motion vector compression |

| JP2001507541A (ja) | 1996-12-30 | 2001-06-05 | シャープ株式会社 | スプライトベースによるビデオ符号化システム |

| US6148026A (en) | 1997-01-08 | 2000-11-14 | At&T Corp. | Mesh node coding to enable object based functionalities within a motion compensated transform video coder |

| US6028539A (en) * | 1997-02-07 | 2000-02-22 | Matsushita Electric Industrial Co., Ltd. | Buffer control method, and decoding apparatus performing buffer control |

| ATE331390T1 (de) | 1997-02-14 | 2006-07-15 | Univ Columbia | Objektbasiertes audiovisuelles endgerät und entsprechende bitstromstruktur |

| US6005980A (en) | 1997-03-07 | 1999-12-21 | General Instrument Corporation | Motion estimation and compensation of video object planes for interlaced digital video |

| CA2257566C (en) | 1997-04-07 | 2002-01-01 | At&T Corp. | System and method for generation and interfacing of bitstreams representing mpeg-coded audiovisual objects |

| WO1998046005A2 (en) | 1997-04-07 | 1998-10-15 | At & T Corp. | System and method for processing object-based audiovisual information |

| EP0922360A4 (de) | 1997-04-07 | 1999-12-29 | At & T Corp | Adaptive steuerung ermöglichendes system und verfahren zur schnittstellenbildung mit mpeg-codierten audiovisuellen objekten |

| GB9712724D0 (en) | 1997-06-18 | 1997-08-20 | Holmes Steven | Method and apparatus for interaction with broadcast television content |

| US6233356B1 (en) | 1997-07-08 | 2001-05-15 | At&T Corp. | Generalized scalability for video coder based on video objects |

| WO1999019864A2 (en) | 1997-10-15 | 1999-04-22 | At & T Corp. | Improved system and method for processing object-based audiovisual information |

| US6414678B1 (en) | 1997-11-20 | 2002-07-02 | Nintendo Co., Ltd. | Image creating apparatus and image display apparatus |

| US7199836B1 (en) * | 1998-02-13 | 2007-04-03 | The Trustees Of Columbia University In The City Of New York | Object-based audio-visual terminal and bitstream structure |

| US6621932B2 (en) | 1998-03-06 | 2003-09-16 | Matsushita Electric Industrial Co., Ltd. | Video image decoding and composing method and video image decoding and composing apparatus |

| US7149770B1 (en) | 1999-01-29 | 2006-12-12 | The Trustees Of Columbia University In The City Of New York | Method and system for client-server interaction in interactive communications using server routes |

| JP4151158B2 (ja) | 1999-06-14 | 2008-09-17 | ソニー株式会社 | シーン記述生成装置及び方法 |

-

1998

- 1998-02-13 AT AT02075022T patent/ATE331390T1/de not_active IP Right Cessation

- 1998-02-13 WO PCT/US1998/002668 patent/WO1998036559A1/en not_active Application Discontinuation

- 1998-02-13 ES ES02075022T patent/ES2266396T3/es not_active Expired - Lifetime

- 1998-02-13 CA CA002281538A patent/CA2281538C/en not_active Expired - Lifetime

- 1998-02-13 JP JP53587898A patent/JP4393591B2/ja not_active Expired - Lifetime

- 1998-02-13 EP EP98906337A patent/EP1010318A4/de not_active Withdrawn

- 1998-02-13 EP EP02075022A patent/EP1209915B1/de not_active Expired - Lifetime

- 1998-02-13 EP EP02077707A patent/EP1276326A3/de not_active Withdrawn

- 1998-02-13 DE DE69835039T patent/DE69835039T2/de not_active Expired - Lifetime

-

2003

- 2003-07-15 HK HK03105108.5A patent/HK1053929A1/zh unknown

-

2007

- 2007-03-20 US US11/688,368 patent/US8421923B2/en not_active Expired - Fee Related

-

2009

- 2009-06-10 US US12/482,292 patent/US8115873B2/en not_active Expired - Fee Related

-

2010

- 2010-09-20 US US12/885,687 patent/US8531608B2/en not_active Expired - Fee Related

-

2012

- 2012-01-06 US US13/345,208 patent/US8854552B2/en not_active Expired - Fee Related

-

2013

- 2013-02-14 US US13/767,632 patent/US8922717B2/en not_active Expired - Fee Related

- 2013-08-01 US US13/956,860 patent/US8917357B2/en not_active Expired - Fee Related

-

2014

- 2014-09-03 US US14/476,530 patent/US20140368739A1/en not_active Abandoned

- 2014-12-10 US US14/566,396 patent/US20150095040A1/en not_active Abandoned

-

2016

- 2016-08-01 US US15/225,045 patent/US20170069350A1/en not_active Abandoned

Also Published As

| Publication number | Publication date |

|---|---|

| US20170069350A1 (en) | 2017-03-09 |

| CA2281538C (en) | 2006-01-03 |

| US20070165139A1 (en) | 2007-07-19 |

| JP4393591B2 (ja) | 2010-01-06 |

| EP1276326A2 (de) | 2003-01-15 |

| US20110007219A1 (en) | 2011-01-13 |

| EP1010318A4 (de) | 2001-01-31 |

| JP2001512637A (ja) | 2001-08-21 |

| DE69835039D1 (de) | 2006-08-03 |

| EP1209915A2 (de) | 2002-05-29 |

| EP1010318A1 (de) | 2000-06-21 |

| CA2281538A1 (en) | 1998-08-20 |

| US8854552B2 (en) | 2014-10-07 |

| ATE331390T1 (de) | 2006-07-15 |

| US8922717B2 (en) | 2014-12-30 |

| US20150095040A1 (en) | 2015-04-02 |

| US20130314602A1 (en) | 2013-11-28 |

| WO1998036559A1 (en) | 1998-08-20 |

| US8421923B2 (en) | 2013-04-16 |

| EP1209915A3 (de) | 2003-07-09 |

| US8531608B2 (en) | 2013-09-10 |

| US20140368739A1 (en) | 2014-12-18 |

| US20120105727A1 (en) | 2012-05-03 |

| HK1053929A1 (zh) | 2003-11-07 |

| EP1276326A3 (de) | 2003-12-10 |

| US8917357B2 (en) | 2014-12-23 |

| US20090245389A1 (en) | 2009-10-01 |

| EP1209915B1 (de) | 2006-06-21 |

| ES2266396T3 (es) | 2007-03-01 |

| US20130159006A1 (en) | 2013-06-20 |

| US8115873B2 (en) | 2012-02-14 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| DE69835039T2 (de) | Objektbasiertes audiovisuelles Endgerät und entsprechende Bitstromstruktur | |

| DE69829935T2 (de) | Codier-/Decodiervorrichtung, Codier-/Decodiersystem und multiplexierter Bitstrom | |

| DE69637230T2 (de) | Transportkodierer für einen Paketstrom und Verfahren zu dessen Betrieb | |

| DE69735379T2 (de) | Schnelle abtrennung von programmspezifischer information aus mehreren transportströmen | |

| DE69936264T2 (de) | Verfahren und vorrichtung zur verwaltung einer multimediadatei | |

| DE19512811B4 (de) | Telekonferenzkonsole | |

| DE69907673T2 (de) | Verfahren und gerät zur verarbeitung von grafischen osd-daten hoher bandbreite über ein ieee-1394 verteiltes netzwerk mit einem isochronen datenübertragungsformat | |

| DE69838869T2 (de) | Vorrichtung und Verfahren zum Spleißen von codierten Datenströmen sowie Vorrichtung und Verfahren zur Erzeugung von codierten Datenströmen | |

| DE69835211T2 (de) | Umschaltung zwischen komprimierten videobitströmen | |

| DE69535553T2 (de) | Videokompression | |

| DE69434014T2 (de) | Vorrichtung und verfahren zur bilderzeugung | |

| DE60033485T2 (de) | Formatierung und Speicherung von Videodaten | |

| DE3102455A1 (de) | Zusammenwirkendes videoerzeugungsverfahren und -system | |

| DE19709391A1 (de) | MPEG-Codier- und Decodiersystem für Multimediaanwendungen | |

| DE10392598T5 (de) | Unterstützung von fortschrittlichen Codierungsformaten in Mediendateien | |

| DE60314688T2 (de) | Effizientes Verfahren und System zum Senden von Ressourcen in der Sendetechnik | |

| DE69822883T2 (de) | Gerät zur erzeugung der digitalen daten für bilder in einer animations-/informationsfolge für eine elektrische vorrichtung | |

| DE69838672T2 (de) | Vorrichtung zur reproduktion eines kodierten signals | |

| DE19717453C2 (de) | Verfahren zum Einblenden eines neuen Bildabschnittes an einer vorbestimmten Stelle eines datenreduzierten Video-Datenstromes | |

| DE69937601T2 (de) | Informationsserver | |

| AT503668B1 (de) | Verfahren und vorrichtung zur darstellung von signalen auf einer anzeigevorrichtung | |

| EP1954055A2 (de) | Verfahren zum Betrieb eines Rundfunkempfängers und Rundfunkempfänger zur Durchführung des Verfahrens | |

| DE10323186B4 (de) | Einrichtungen zur Verarbeitung eines MPEG-2-Datenstroms und Verfahren zur Verarbeitung eines MPEG-2 Datenstroms | |

| EP0899965A2 (de) | Verfahren und Vorrichtung zur Fehlerlokalisierung in einer Bilddatenübertragung | |

| DE10301572A1 (de) | Verfahren zum Komprimieren einer Folge von Bildern |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| 8364 | No opposition during term of opposition |