WO2010071173A1 - 撮影装置および合焦位置決定方法 - Google Patents

撮影装置および合焦位置決定方法 Download PDFInfo

- Publication number

- WO2010071173A1 WO2010071173A1 PCT/JP2009/071040 JP2009071040W WO2010071173A1 WO 2010071173 A1 WO2010071173 A1 WO 2010071173A1 JP 2009071040 W JP2009071040 W JP 2009071040W WO 2010071173 A1 WO2010071173 A1 WO 2010071173A1

- Authority

- WO

- WIPO (PCT)

- Prior art keywords

- focus

- lens

- imaging

- optical system

- focusing

- Prior art date

Links

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/20—Image signal generators

- H04N13/204—Image signal generators using stereoscopic image cameras

- H04N13/239—Image signal generators using stereoscopic image cameras using two 2D image sensors having a relative position equal to or related to the interocular distance

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B7/00—Mountings, adjusting means, or light-tight connections, for optical elements

- G02B7/28—Systems for automatic generation of focusing signals

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B7/00—Mountings, adjusting means, or light-tight connections, for optical elements

- G02B7/28—Systems for automatic generation of focusing signals

- G02B7/36—Systems for automatic generation of focusing signals using image sharpness techniques, e.g. image processing techniques for generating autofocus signals

- G02B7/38—Systems for automatic generation of focusing signals using image sharpness techniques, e.g. image processing techniques for generating autofocus signals measured at different points on the optical axis, e.g. focussing on two or more planes and comparing image data

-

- G—PHYSICS

- G03—PHOTOGRAPHY; CINEMATOGRAPHY; ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ELECTROGRAPHY; HOLOGRAPHY

- G03B—APPARATUS OR ARRANGEMENTS FOR TAKING PHOTOGRAPHS OR FOR PROJECTING OR VIEWING THEM; APPARATUS OR ARRANGEMENTS EMPLOYING ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ACCESSORIES THEREFOR

- G03B13/00—Viewfinders; Focusing aids for cameras; Means for focusing for cameras; Autofocus systems for cameras

- G03B13/18—Focusing aids

-

- G—PHYSICS

- G03—PHOTOGRAPHY; CINEMATOGRAPHY; ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ELECTROGRAPHY; HOLOGRAPHY

- G03B—APPARATUS OR ARRANGEMENTS FOR TAKING PHOTOGRAPHS OR FOR PROJECTING OR VIEWING THEM; APPARATUS OR ARRANGEMENTS EMPLOYING ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ACCESSORIES THEREFOR

- G03B13/00—Viewfinders; Focusing aids for cameras; Means for focusing for cameras; Autofocus systems for cameras

- G03B13/18—Focusing aids

- G03B13/20—Rangefinders coupled with focusing arrangements, e.g. adjustment of rangefinder automatically focusing camera

-

- G—PHYSICS

- G03—PHOTOGRAPHY; CINEMATOGRAPHY; ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ELECTROGRAPHY; HOLOGRAPHY

- G03B—APPARATUS OR ARRANGEMENTS FOR TAKING PHOTOGRAPHS OR FOR PROJECTING OR VIEWING THEM; APPARATUS OR ARRANGEMENTS EMPLOYING ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ACCESSORIES THEREFOR

- G03B13/00—Viewfinders; Focusing aids for cameras; Means for focusing for cameras; Autofocus systems for cameras

- G03B13/18—Focusing aids

- G03B13/20—Rangefinders coupled with focusing arrangements, e.g. adjustment of rangefinder automatically focusing camera

- G03B13/22—Rangefinders coupled with focusing arrangements, e.g. adjustment of rangefinder automatically focusing camera coupling providing for compensation upon change of camera lens

-

- G—PHYSICS

- G03—PHOTOGRAPHY; CINEMATOGRAPHY; ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ELECTROGRAPHY; HOLOGRAPHY

- G03B—APPARATUS OR ARRANGEMENTS FOR TAKING PHOTOGRAPHS OR FOR PROJECTING OR VIEWING THEM; APPARATUS OR ARRANGEMENTS EMPLOYING ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ACCESSORIES THEREFOR

- G03B13/00—Viewfinders; Focusing aids for cameras; Means for focusing for cameras; Autofocus systems for cameras

- G03B13/18—Focusing aids

- G03B13/24—Focusing screens

-

- G—PHYSICS

- G03—PHOTOGRAPHY; CINEMATOGRAPHY; ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ELECTROGRAPHY; HOLOGRAPHY

- G03B—APPARATUS OR ARRANGEMENTS FOR TAKING PHOTOGRAPHS OR FOR PROJECTING OR VIEWING THEM; APPARATUS OR ARRANGEMENTS EMPLOYING ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ACCESSORIES THEREFOR

- G03B13/00—Viewfinders; Focusing aids for cameras; Means for focusing for cameras; Autofocus systems for cameras

- G03B13/32—Means for focusing

-

- G—PHYSICS

- G03—PHOTOGRAPHY; CINEMATOGRAPHY; ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ELECTROGRAPHY; HOLOGRAPHY

- G03B—APPARATUS OR ARRANGEMENTS FOR TAKING PHOTOGRAPHS OR FOR PROJECTING OR VIEWING THEM; APPARATUS OR ARRANGEMENTS EMPLOYING ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ACCESSORIES THEREFOR

- G03B13/00—Viewfinders; Focusing aids for cameras; Means for focusing for cameras; Autofocus systems for cameras

- G03B13/32—Means for focusing

- G03B13/34—Power focusing

-

- G—PHYSICS

- G03—PHOTOGRAPHY; CINEMATOGRAPHY; ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ELECTROGRAPHY; HOLOGRAPHY

- G03B—APPARATUS OR ARRANGEMENTS FOR TAKING PHOTOGRAPHS OR FOR PROJECTING OR VIEWING THEM; APPARATUS OR ARRANGEMENTS EMPLOYING ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ACCESSORIES THEREFOR

- G03B13/00—Viewfinders; Focusing aids for cameras; Means for focusing for cameras; Autofocus systems for cameras

- G03B13/32—Means for focusing

- G03B13/34—Power focusing

- G03B13/36—Autofocus systems

-

- G—PHYSICS

- G03—PHOTOGRAPHY; CINEMATOGRAPHY; ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ELECTROGRAPHY; HOLOGRAPHY

- G03B—APPARATUS OR ARRANGEMENTS FOR TAKING PHOTOGRAPHS OR FOR PROJECTING OR VIEWING THEM; APPARATUS OR ARRANGEMENTS EMPLOYING ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ACCESSORIES THEREFOR

- G03B19/00—Cameras

- G03B19/02—Still-picture cameras

- G03B19/04—Roll-film cameras

- G03B19/07—Roll-film cameras having more than one objective

-

- G—PHYSICS

- G03—PHOTOGRAPHY; CINEMATOGRAPHY; ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ELECTROGRAPHY; HOLOGRAPHY

- G03B—APPARATUS OR ARRANGEMENTS FOR TAKING PHOTOGRAPHS OR FOR PROJECTING OR VIEWING THEM; APPARATUS OR ARRANGEMENTS EMPLOYING ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ACCESSORIES THEREFOR

- G03B3/00—Focusing arrangements of general interest for cameras, projectors or printers

- G03B3/10—Power-operated focusing

-

- G—PHYSICS

- G03—PHOTOGRAPHY; CINEMATOGRAPHY; ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ELECTROGRAPHY; HOLOGRAPHY

- G03B—APPARATUS OR ARRANGEMENTS FOR TAKING PHOTOGRAPHS OR FOR PROJECTING OR VIEWING THEM; APPARATUS OR ARRANGEMENTS EMPLOYING ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ACCESSORIES THEREFOR

- G03B35/00—Stereoscopic photography

- G03B35/08—Stereoscopic photography by simultaneous recording

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/10—Processing, recording or transmission of stereoscopic or multi-view image signals

- H04N13/189—Recording image signals; Reproducing recorded image signals

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/20—Image signal generators

- H04N13/296—Synchronisation thereof; Control thereof

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/21—Server components or server architectures

- H04N21/218—Source of audio or video content, e.g. local disk arrays

- H04N21/21805—Source of audio or video content, e.g. local disk arrays enabling multiple viewpoints, e.g. using a plurality of cameras

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/45—Cameras or camera modules comprising electronic image sensors; Control thereof for generating image signals from two or more image sensors being of different type or operating in different modes, e.g. with a CMOS sensor for moving images in combination with a charge-coupled device [CCD] for still images

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/60—Control of cameras or camera modules

- H04N23/67—Focus control based on electronic image sensor signals

- H04N23/673—Focus control based on electronic image sensor signals based on contrast or high frequency components of image signals, e.g. hill climbing method

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N2013/0074—Stereoscopic image analysis

- H04N2013/0081—Depth or disparity estimation from stereoscopic image signals

Definitions

- the present invention relates to an imaging apparatus including a first imaging unit and a second imaging unit and performing imaging using these two imaging units, and a method of determining a focus position in the imaging apparatus.

- the two imaging units are provided side by side with parallax at the positions corresponding to the right eye and the left eye, and from both imaging units An image signal for the right eye and an image signal for the left eye are respectively generated by the signal processing unit in the subsequent stage based on the output image signal.

- the image signal for the right eye and the image signal for the left eye generated by the signal processing unit of the imaging device are input to a display device having a display screen capable of three-dimensional display as described in Non-Patent Document 1. Then, a stereoscopic image is displayed on the display screen.

- the in-focus position determination means provided inside moves the focus lens in the photographing optical system within the predetermined search area

- AF Auto Focus

- the in-focus position determination unit performs an AF search to move the focus lenses included in both imaging units in opposite directions to each other.

- a technique has been proposed in which the in-focus position of both imaging units is determined using the AF search result of the imaging unit in which the in-focus position is detected first.

- the lens diameter of the focus lens, the diameter of the lens barrel, the variation in the light receiving sensitivity of the image pickup element, and the like are absolutely present (in the following description, these are collectively referred to as solid differences). Therefore, if the in-focus position of one imaging unit is reflected in the other imaging unit as in Patent Documents 1 and 2 described above, the in-focus position of the other imaging unit is shifted due to the difference in the solid state.

- the present invention provides an imaging device capable of accurately determining the in-focus position of each of two imaging units in the same time as conventional, and a focusing position determination method in the imaging device.

- the purpose is

- a first imaging device of the present invention for achieving the above object is A first imaging optical system including a first focusing lens, a first focusing lens driving unit for moving the first focusing lens in the optical axis direction, and an object being imaged by the first imaging optical system

- a first imaging unit having a first imaging element that receives an object light and generates an image signal representing the object

- a second imaging optical system including a second focusing lens, a second focusing lens driving unit for moving the second focusing lens in the optical axis direction, and an image of an object formed by the second imaging optical system

- the in-focus position is searched while moving the first focus lens within a predetermined first search area, and the first focus lens is stopped at the in-focus position, and the second photographing optical system is In the second search area narrower than the first search area, including the expected focusing position of the second focus lens corresponding to the in-focus position of the first focus lens And a

- the in-focus position determining means executes the AF search within the predetermined first search area for the first focus lens in the first imaging optical system.

- the AF search is performed in the second search area narrower than the first search area including the in-focus expected position corresponding to the in-focus position of the first focus lens Do. That is, the in-focus position determination means does not arrange the second focus lens in the second imaging optical system at the in-focus expected position corresponding to the in-focus position of the first imaging optical system.

- the second focus lens is moved to a second search narrower than the first search area, including the expected focusing position, so as to eliminate the fixed difference between the second and third imaging optical systems. After searching for the in-focus position while moving the second focus lens to the in-focus position and stopping.

- the solid-state difference between the first imaging optical system and the second imaging optical system is eliminated, and the first focus lens and the second focus lens are respectively disposed at appropriate focusing positions.

- the AF search is completed in substantially the same time as in the prior art without much time.

- a second imaging device of the present invention for achieving the above object is A first imaging optical system including a first focusing lens, a first focusing lens drive unit for moving the first focusing lens in the optical axis direction, and an image of an object formed by the first imaging optical system

- a first imaging unit having a first imaging device that receives an object light and generates an image signal representing the object

- a second imaging optical system including a second focusing lens, a second focusing lens driving unit for moving the second focusing lens in the optical axis direction, and an image of an object formed by the second imaging optical system

- a deviation storage unit which nonvolatilely stores deviations of the in-focus position of the second focus lens from the in-focus position of the first focus lens;

- the deviation storage unit for example, when manufacturing this imaging device, the deviation of the in-focus position indicating the solid difference between the first imaging unit and the second imaging unit is obtained in advance You should remember.

- the in-focus position determining means executes the AF search within the predetermined first search area for the first focus lens in the first imaging optical system.

- the second focus lens is not disposed at the expected focusing position detected by the AF search on the first photographing unit side, and the deviation storage is more than the expected focusing position.

- the second focus lens is moved to a position deviated by the deviation stored in the unit and stopped.

- the in-focus position determination means does not arrange the second focus lens in the second imaging optical system at the in-focus expected position corresponding to the in-focus position of the first imaging optical system.

- the first focusing lens is deviated from the expected focusing position by the deviation stored in the deviation storage unit.

- the second focus lens is moved and stopped.

- the solid-state difference between the first imaging optical system and the second imaging optical system is eliminated, and the first focus lens and the second focus lens are respectively disposed at appropriate focusing positions.

- the AF search ends in substantially the same time as in the prior art.

- a third imaging apparatus of the present invention for achieving the above object is A first imaging optical system including a first focusing lens, a first focusing lens drive unit for moving the first focusing lens in the optical axis direction, and an image of an object formed by the first imaging optical system

- a first imaging unit having a first imaging device that receives an object light and generates an image signal representing the object

- a second imaging optical system including a second focusing lens, a second focusing lens driving unit for moving the second focusing lens in the optical axis direction, and an image of an object formed by the second imaging optical system

- Focusing position determination means for stopping each lens at each focusing position; Deviation storage for storing the deviation of the in-focus position of the second focus lens searched by the in-focus position determination means from the in-focus position of the first focus lens searched by the in-focus position determination means Equipped with

- the in-focus position determination means searches for the in-focus position while moving the first focusing lens in the first imaging optical system.

- the first focus lens is stopped at the in-focus position, and the second focus lens corresponds to the second focus lens corresponding to the in-focus position of the first focus lens. It is characterized in that it is moved to a position deviated by the deviation stored in the above-mentioned deviation storage unit from the in-focus expected position of.

- the case where the deviation is stored in the deviation storage unit is, for example, the second time after the power supply is temporarily turned off and the power switch is turned on again when the deviation storage unit is configured of volatile memory. In the case of the following shooting.

- the focusing position determining means first instructs each of the first and second focus lens driving units to obtain the first and second focusing lenses for the first photographing. While moving each focus lens in the direction of the optical axis, each focus position is searched, and the first and second focus lenses are stopped at each focus position. The deviation from the in-focus position of the first focus lens to the in-focus position of the second focus lens found at the time of the first photographing is stored in the deviation storage unit, and for the second and subsequent photographing

- the focusing position determination means executes an AF search for the first focusing lens in the predetermined first search area for the first shooting optical system, and the second shooting optical system for the second shooting optical system. The second focus lens is moved to a position where the second focus lens is biased by the deviation stored in the deviation storage unit so as to eliminate the fixed difference between the system and the first imaging optical system, and then stopped. .

- the solid-state difference between the first imaging optical system and the second imaging optical system is eliminated in any imaging cycle, and the first focusing lens and the second focusing lens are respectively positioned at appropriate focusing positions. Be placed.

- the distance for searching the second focus lens is limited to a section shorter than the first search, and it does not take much time, and the AF search is completed in about the same time as in the past. After that, the AF search ends in approximately the same time as in the past.

- the second and subsequent shooting after power on is described as an example in the case where the deviation is stored in the deviation storage unit, but in the case where the deviation is stored in the deviation storage unit, for example, a zoom switch

- the imaging is performed once, the deviation is stored in the deviation storage unit, and the imaging is performed again with the same focal length.

- the deviation storage unit is configured by, for example, a non-volatile memory

- the contents of the non-volatile memory may be erased by, for example, a reset operation.

- the second and subsequent photographing after being reset corresponds to the case where the deviation is stored.

- both the first imaging optical system and the second imaging optical system are variable in focal length and are adjusted to the same focal length

- the deviation storage unit records the deviation for each of a plurality of focal distances.

- both of the first and second focus lenses are disposed at appropriate in-focus positions by using the deviation corresponding to the focal length.

- the first photographing optical system and the second photographing optical system are arranged side by side to generate an image signal for stereoscopic vision.

- an image signal for the right eye and an image signal for the left eye, which are in focus, are obtained by the first imaging optical system and the second imaging optical system, respectively.

- a first imaging optical system including a first focusing lens, a first focusing lens drive unit for moving the first focusing lens in the optical axis direction, and an image of an object formed by the first imaging optical system

- a second imaging optical system including a second focus lens, and a first imaging unit having a first imaging element that receives an object light and generates an image signal representing the object

- a second focus lens drive unit for moving the second focus lens in the optical axis direction

- a focusing position determining method in an imaging apparatus comprising: both imaging units comprising a second imaging unit having a second imaging element; A first step of searching for a focusing position while moving the first focusing lens within a predetermined first search area and stopping the first focusing lens at the focusing position; In the second search area narrower than the first search area, including the expected focusing position of the second focus lens corresponding to

- the second focus lens includes the in-focus expected position of the second focus lens corresponding to the in-focus position of the first focus lens.

- Each of the first and second focus lenses is disposed at the correct in-focus position by searching for the in-focus position while moving in the second search area narrower than the first search area. .

- the solid-state difference between the first imaging optical system and the second imaging optical system is eliminated, and the first focus lens and the second focus lens are respectively disposed at appropriate focusing positions.

- the AF search is completed in substantially the same time as in the prior art without much time.

- a first imaging optical system including a first focusing lens, a first focusing lens drive unit for moving the first focusing lens in the optical axis direction, and an image of an object formed by the first imaging optical system

- a second imaging optical system including a second focus lens, and a first imaging unit having a first imaging element that receives an object light and generates an image signal representing the object

- a second focus lens drive unit for moving the second focus lens in the optical axis direction

- light from the subject formed by the second imaging optical system to receive light from the subject to generate an image signal representing the subject

- a focus position determination method in the imaging apparatus comprising deviation memory to keep nonvolatile manner, A first step of searching for the in-focus position while moving the first focus lens and stopping the first focus lens at the in-focus position; The second focus lens is moved to a position deviated from the expected in-focus position of the second focus lens corresponding to the in-focus position of the first focus lens by the deviation stored in the deviation storage unit. And a second step.

- the second focus lens is set to be closer than the in-focus expected position of the second focus lens corresponding to the in-focus position of the first focus lens.

- a first imaging optical system including a first focusing lens, a first focusing lens drive unit for moving the first focusing lens in the optical axis direction, and an image of an object formed by the first imaging optical system

- a second imaging optical system including a second focus lens, and a first imaging unit having a first imaging element that receives an object light and generates an image signal representing the object

- a second focus lens drive unit for moving the second focus lens in the optical axis direction

- light from the subject formed by the second imaging optical system to receive light from the subject to generate an image signal representing the subject

- a focus position determination method in the imaging apparatus comprising deviation memory for storing, Instruct each of the first and second focus lens drive units to move each of the first and second focus lenses in the direction of the optical axis while searching for the in-focus position of each of the first and second focus lenses.

- the first focus lens While searching for the in-focus position, the first focus lens is stopped at the in-focus position, and for the second imaging optical system, the second focus lens is used as the in-focus position of the first focus lens. And a third step of moving to a position deviated by the deviation stored in the deviation storage unit from the expected focusing position of the second focus lens corresponding to.

- the second focus lens is a second focus lens corresponding to the in-focus position of the first focus lens.

- Each of the first and second focus lenses is accurate by searching for the in-focus position while moving within the second search area narrower than the first search area, including the in-focus expected position. It is placed at the in-focus position.

- the solid-state difference between the first imaging unit and the second imaging unit is eliminated, and the first focus lens and the second focus lens are respectively disposed at appropriate focusing positions.

- the AF search is completed in substantially the same time as in the prior art without much time.

- the deviation obtained at the time of the first photographing is stored in the deviation storage unit, and the second focusing lens corresponds to the in-focus position of the first focusing lens for the next and subsequent photographing.

- the second focus lens By placing the second focus lens at a position deviated by the deviation stored in the deviation storage unit from the expected focusing position of the second focus lens, the solid-state difference between the first imaging unit and the second imaging unit is eliminated.

- the first focus lens and the second focus lens are respectively disposed at the correct in-focus positions. At this time, the AF search ends at the same time as in the conventional case.

- the imaging apparatus capable of accurately determining the in-focus position of each of the two imaging units and the in-focus position determination method in the imaging apparatus can be realized in the same time as in the related art.

- FIG. 1 It is a figure showing the photographing device which is one embodiment of the present invention. It is a block diagram which shows the structure inside the imaging device 1 of FIG.

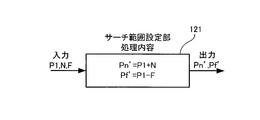

- the main CPU 100 instructs the first F lens drive unit 104A and the second F lens drive unit 104B to move the first and second focus lenses while setting the focusing position determination method to be performed by the AF detection unit 120. It is a figure explaining. It is a figure explaining the processing content of the search range setting part 121.

- FIG. It is a flowchart which shows the process sequence of the focusing position determination which main CPU100 performs in cooperation with AF detection part. It is a figure which shows 2nd Embodiment.

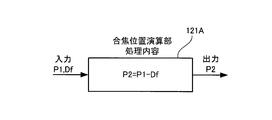

- FIG. 6 instructs the first F lens drive unit 104A and the second F lens drive unit 104B to move the first and second focus lenses while focusing on the AF detection unit 120. It is a figure explaining the position determination method. It is a figure explaining the processing content of focusing position operation part 121A.

- FIG. 7 is a flowchart showing a processing procedure of in-focus position determination that is executed by the main CPU shown in FIG. 6 in cooperation with a DSP that constitutes an AF detection unit and an F lens drive unit. It is a figure explaining 3rd Embodiment.

- the main CPU 100 shown in FIG. 10 instructs the first F lens drive unit 104A and the second F lens drive unit 104B to move the first and second focus lenses while focusing on the AF detection unit 120.

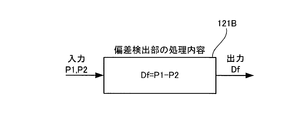

- FIG. 10 It is a figure explaining the position determination method. It is a figure explaining the processing content of a deviation detection part. It is a flowchart which shows the process sequence of the focusing position determination which main CPU100 shown in FIG. 10 performs in cooperation with DSP which comprises AF detection part etc.

- FIG. 10 It is a figure explaining the position determination method. It is a figure explaining the processing content of a deviation detection part. It is a flowchart which shows the process sequence of the focusing position determination which main CPU100 shown in FIG. 10 performs in cooperation with DSP which comprises AF detection part etc.

- FIG. 1 is a view showing an imaging apparatus according to an embodiment of the present invention.

- FIG. 1A shows a perspective view of the photographing device 1 as viewed obliquely from above.

- the imaging device 1 shown in FIG. 1A includes two imaging units 1A and 1B.

- the two imaging units are described as a first imaging unit 1A and a second imaging unit 1B to be distinguished.

- the first imaging unit 1A and the second imaging unit 1B are arranged side by side so as to be able to generate image signals for stereoscopic viewing, and these imaging units 1A and 1B are used for the right eye Image signals for the left eye are respectively generated.

- the power switch 10A on the upper surface of the photographing apparatus 1 of FIG. 1 is operated, and the photographing mode dial 10B is set to, for example, a mode called stereoscopic mode and the shutter button 10C is operated, It is generated by the units 1A and 1B.

- the shutter button 10C provided in the photographing apparatus 1 has two operation modes of half pressing and full pressing.

- this photographing apparatus 1 when the shutter button 10C is half pressed, exposure adjustment or Focus adjustment is performed, and shooting is performed when the shutter button is fully pressed.

- a flash emission window WD for emitting a flash toward the subject when the field brightness is dark is provided above the photographing unit 1B.

- a monitor DISP capable of three-dimensional display is provided on the back, and on the monitor DISP, the same subject captured by both the imaging units 1A and 1B is It is displayed as a stereoscopic image. Furthermore, operators such as the zoom switch 10D, the menu / OK button 10E, and the cross key 10F are also provided.

- the power switch 10A, the shutter button 10B, the mode dial 10C, the zoom switch 10D, the menu / OK button 10E, the cross key 10F, and the like may be collectively referred to as the operation unit 10.

- FIG. 2 is a block diagram showing an internal configuration of the photographing apparatus 1 of FIG.

- the internal configuration of the photographing device 1 will be described with reference to FIG.

- the operation of the photographing device 1 is generally controlled by the main CPU 100.

- a ROM 101 is connected to the main CPU 100 via a bus Bus, and the ROM 101 stores programs necessary for the imaging device 1 to operate.

- the main CPU 100 centrally controls the operation of the photographing apparatus 1 in accordance with the procedure of this program.

- the main CPU 100 controls the power control unit 1001 to supply the power from the battery BT to each unit in FIG. 2 through the power control unit 1001.

- the imaging device 1 is put into operation.

- the main CPU 100 starts the photographing process.

- the AF detection unit 120, the search range setting unit 121, the AE / AWB detection unit 130, the image input controller 114A, the digital signal processing unit 116A, and the 3D image generation unit 117 are configured by a processor such as DSP (Digital Signal Processor). It is assumed that the main CPU 100 executes processing in cooperation with the DSP.

- the display control unit 119 and the monitor DISP are assumed to be configured by an LCD.

- each component of the first imaging unit 1A will be described with the word 'first'

- each component of the second imaging unit 1B will be described with the word 'second'.

- a first imaging optical system 110A including a first focus lens FLA, and a first focus lens drive unit for moving the first focus lens FLA in the optical axis direction (hereinafter referred to as the first F lens driving unit 1) 104A, and a first image pickup element 111A that receives object light formed by the first imaging optical system and generates an image signal representing the object.

- the first F lens driving unit 1A a first imaging optical system 110A including a first focus lens FLA, and a first focus lens drive unit for moving the first focus lens FLA in the optical axis direction

- the first F lens driving unit 1A a first image pickup element 111A that receives object light formed by the first imaging optical system and generates an image signal representing the object.

- a first stop IA is disposed in the first photographing optical system 110A, and a first stop driving unit 105A is provided to change the aperture diameter of the first stop IA.

- the first photographing optical system 100A is a zoom lens, and is also provided with a Z lens drive unit 103A that controls the zoom lens to have a predetermined focal length.

- FIG. 2 schematically shows that the entire photographing optical system is a zoom lens with a single lens ZL.

- the second imaging unit 1B moves the imaging optical system including the second focus lens FLB and the second focus lens FLB in the direction of the optical axis in the same manner as the first imaging unit 1A.

- a second focus lens driving unit (hereinafter referred to as a second F lens driving unit) 104B and light from a subject formed by the second imaging optical system to receive light from the subject and generate an image signal representing the subject A second imaging element 111B is provided.

- the first imaging unit 1A and the second imaging unit 1B generate stereoscopic image signals, that is, the first imaging unit 1A generates an image signal for the right eye, and the second imaging unit 1B generates the left imaging signal. Image signals for the eyes are respectively generated.

- the first imaging unit 1A and the second imaging unit 1B have the same configuration except that they generate an image signal for the right eye or an image signal for the left eye.

- the image signals of both imaging units are converted into digital signals by the A / D 113A and the second A / D 113B, and the processing after leading to the bus Bus is the same, so the image signals for the first imaging unit 1A I will explain the configuration along the flow of

- the main CPU 100 controls the power control unit 1001 to supply the power from the battery BT to each unit to shift the photographing device 1 to the operation state.

- the main CPU 100 controls the F lens drive unit 104A and the diaphragm drive unit 105A to start adjustment of exposure and focus. Further, the TG 106A is instructed to set the electronic shutter in the imaging device 111A, and for example, the imaging device 111A outputs an image signal to the analog signal processing unit 112A every 1/60 seconds.

- the analog signal processing unit 112A receives the supply of the timing signal from the TG 106A, receives the supply of the image signal every 1/60 seconds from the imaging device 111A, performs noise reduction processing and the like, and performs noise reduction processing.

- the analog image signal is supplied to the next stage A / D 113A. Also in the A / D 113A, conversion processing of an analog image signal to a digital image signal is performed every 1/60 seconds in synchronization with the timing signal from the TG 106A.

- the digital image signal converted and output by the A / D 113A is led to the bus Bus every 1/60 seconds by the image input controller 114A, and the image signal led to the bus Bus is stored in the SDRAM 115. Since an image signal is output from the imaging element 111A every 1/60 second, the content of the SDRAM 115 is rewritten every 1/60.

- the image signal stored in the SDRAM 115 is read out every 1/60 by the DSP that constitutes the AF detection unit 120, the AE / AWB detection unit 130, and the digital signal processing unit 116A.

- the main CPU 100 controls the F lens drive unit 104A to move the focus lens FLA, and an AF search is performed. Based on the detection result of the AF detection unit 120, the main CPU 100 instructs the F lens drive unit 104A to move the first focus lens FLA to the in-focus position and to stop it. For this reason, regardless of which direction the first imaging unit 1A is directed, the focus is adjusted immediately, and the subject in focus is displayed almost always on the monitor DISP.

- the AE / AWB detection unit 130 detection of luminance and calculation of gains to be set to the white balance amplifier in the digital signal processing unit 116A are performed every 1/60.

- the main CPU 100 controls the diaphragm driving unit 105A according to the detection result of the luminance of the AE / AWB detection unit 130 to change the aperture diameter of the diaphragm I. Further, the digital signal processing unit 116A receives the detection result from the AE / AWB detection unit 130 and sets the gain of the white balance amplifier.

- the digital signal processing unit 116A processes the image signal suitable for display, and the image signal converted to a signal suitable for display by the signal processing of the digital signal processing unit 116A is a 3D image generation unit Then, the image signal for display for the right eye is generated by the 3D image generation unit 117, and the generated image signal for the right eye is stored in the VRAM 118.

- the same operation as the operation up to this point is also performed by the second imaging unit 1B at the same timing.

- the VRAM 118 stores two types of image signals, one for the right eye and one for the left eye.

- the main CPU 100 causes the display control unit 119 to transfer the image signal for the right eye and the image signal for the left eye in the VRAM 118 to display an image on the monitor DISP.

- the image signal for the right eye and the image signal for the left eye are superimposed and displayed on the monitor DISP of FIG. 1, the image on the monitor DISP can be viewed stereoscopically to the human eye. Since the image signals are continuously output from the first and second imaging elements 111A and 111B every 1/60, the image signal in the VRAM 118 is rewritten every 1/60, and the stereoscopic image on the monitor DISP is also 1/60. It is switched and displayed every 60, and a stereoscopic image is displayed as a moving image.

- the main CPU 100 causes the AE / AWB detection unit 130 to immediately before the shutter button 10C is fully pressed.

- the detected AE value is received and instructed to the first and second diaphragm driving units 105A and 105B to make the first and second diaphragms IA and IB have a diameter corresponding to the AE value, and the first F lens

- the control unit 104A instructs the AF detection unit 120 to detect the contrast while moving the first focus lens FLA in the first search area.

- the main CPU 100 receives the in-focus position P1 at which the maximum contrast is obtained and stops the first focus lens FLA at the in-focus position P1.

- the first search including the second focusing lens FLB and the expected focusing position of the second focusing lens FLB corresponding to the focusing position of the first focusing lens FLA

- the AF detection unit 120 is made to search for the in-focus position while moving within the second search area narrower than the area.

- the main CPU 100 receives the search result from the AF detection unit 120 and stops the second focus lens FLB at the in-focus position indicated by the search result.

- the AF detection unit 120 instructs the search range setting unit 121 to set the focus position P1 of the first focus lens FLA and data indicating the search area read from the flash ROM 102 (near side deviation N And a second search area narrower than the first search area including the in-focus expected position corresponding to the in-focus position of the first focus lens on the basis of F. and the far-side deviation F), and the main CPU 100 calculates the second search area.

- the calculation result of the second search area is received, and the second F lens drive unit 104B is instructed to perform an AF search for searching for the in-focus position in the second search area.

- the focus lens FLA of the first imaging unit 1A is made to perform the conventional AF search

- the second imaging unit 1B includes the first expected range including the expected focusing position of the second focus lens FLB. Even if the AF search is performed in the narrower second range, the second imaging unit 1B only needs to perform the AF search in a short region across the expected focusing position, and thus the same degree as in the conventional case AF search ends in time.

- the main CPU 100 causes the first and second TGs 106A and 106B to set the electronic shutter and starts still image shooting processing.

- the main CPU 100 causes the first and second image pickup elements 111A and 111B to output image signals to the first and second analog signal processing units 112A and 112B at the off timing of the electronic shutter, and the first and second analog The signal processing units 112A and 112B perform noise reduction processing. Thereafter, analog image signals are converted to digital image signals by the first and second A / Ds 113A and 113B.

- gains are set in the internal white balance amplifier in the first and second digital signal processing units 116A and 116B based on the white balance information detected immediately before the full press detected by the AE / AWB detection unit 130. Appropriate white balance adjustment is performed.

- the first and second image input controllers 114A guide the digital image signals converted by the first and second A / Ds 113A and 113B to the bus Bus side according to the instruction of the main CPU 100, and pass the bus Bus. Then, all image signals are temporarily stored in the SDRAM 115. Thereafter, the digital signal processing units 116A and 116B read out the image signal of the SDRAM 115, convert the image signal into an image signal suitable for display, and transfer the converted image signal to the 3D image generation unit 117. Thus, the first and second digital signal processors 116A and 116B generate an image signal for the right eye and an image signal for the left eye suitable for display, and the 3D image generator 117 displays the image signal on the monitor DISP.

- the main CPU 100 After the image signal for the right eye for display and the image signal for the left eye are generated, the main CPU 100 causes the image signal for the right eye and the image signal for the left eye in the 3D image generation unit 117 to be bus Bus It supplies to the compression / decompression processing unit 150 by using. After the main CPU 100 causes the compression / decompression processing unit 150 to compress the image data, the compressed image data is transferred to the media control unit using the bus Bus, and header information related to the compression and photographing. Are supplied to the media control unit 160, the media control unit 160 generates an image file, and the memory card 161 records the image file.

- the focusing lenses are arranged at the correct focusing positions in almost the same time as before.

- 2 also includes a flash 181 which emits a flash from the light emission window WD of FIG. 1 in response to an instruction from the flash control unit 180 and the flash control unit 180 and a clock unit W for detecting the current time, Furthermore, an attitude detection sensor 190 for detecting the attitude of the imaging device 1 is illustrated.

- the main CPU 100, the first and second F lens drive units 104A and 104B, the first and second focus lenses FLA and FLB, the flash ROM 102, the AF detection unit 120, and the search range setting unit 121 An example of the in-focus position determination means according to the present invention is configured.

- the main CPU 100 instructs the first and second F lens drive units 104A and 104B to move the first and second focus lenses to make the AF detection unit 120 move in order to make it easier to understand the operation described so far.

- a focusing position determination method to be performed will be described in an easy-to-understand manner with reference to FIGS. 3 and 4.

- the main CPU 100 instructs the first F lens drive unit 104A and the second F lens drive unit 104B to move the first and second focus lenses FLA and FLB to the AF detection unit 120. It is a figure explaining the focusing position determination method to make it go.

- FIG. 4 is a diagram for explaining the processing content of the search range setting unit.

- FIG. 3A shows a first search area of the first focus lens FLA

- FIG. 3B shows a second search area of the second focus lens FLB.

- the main CPU 100 causes the first F lens drive unit 104A to move the first focus lens FLA in the first search area (Pn to Pf) while the AF detection unit 120 is set for contrast.

- the focus position is searched by detecting the maximum.

- the main CPU 100 receives the in-focus position P1 at which the AF evaluation value (contrast) detected by the AF detection unit 120 is maximum, and instructs the first F lens drive unit 104A to set the in-focus position P1 of the focus lens FLA. Move to and stop.

- the AF detection unit 120 inputs the in-focus position P1 to the search range setting unit 121 and reads out the constants (the near side deviation N and the far side deviation F) related to the second search area from the flash ROM 102 Then, the search range setting unit 121 is caused to calculate the second search area.

- the main CPU 100 receives the calculation result via the bus Bus and instructs the second F lens drive unit 104B to move the second focus lens FLB in the second search range (Pn 'to Pf').

- the AF detection unit 120 is made to search for the in-focus position.

- the main CPU 100 receives the in-focus position P2 at which the AF evaluation value (contrast) of the second imaging unit 1B detected by the AF detection unit 120 is maximum, and instructs the second F lens drive unit 104A to focus lens FLB Is stopped at the in-focus position P2.

- the search range setting unit 121 in the search range setting unit 121, the in-focus position P1 of the first focus lens FLA detected by the AF detection unit 120 and the near side deviation N stored in advance in the flash ROM 102.

- a combination of data representing the near side deviation N and the far side deviation F can eliminate the solid-state difference between the first imaging unit 1A and the second imaging unit 1B. It is assumed that a plurality of focal lengths and a plurality of focal positions are stored.

- the main CPU 100 receives this calculation result and instructs the second F lens drive unit 104B to set the second focus lens FLB in the second search area (Pn 'to Pf') narrower than the first search area.

- the AF position detection unit 120 searches for the in-focus position P2 and receives the in-focus position, and instructs the second lens driving unit 104B to arrange the second focus lens FLB.

- FIG. 5 is a flowchart showing the procedure of the in-focus position determination that the main CPU 100 executes in cooperation with the DSP that constitutes the AF detection unit 120, the AE / AWB detection unit 130, and the like.

- step S501 the main CPU 100 determines whether the shutter button 10C has been half-pressed. If the main CPU 100 determines in step S501 that the shutter button 10C is not half-pressed, the process proceeds to No and repeats the process of step S501. If the main CPU 100 determines that the shutter button 10C is half-pressed in step S501, the process proceeds to Yes .

- the AE / AWB detection unit 130 in the DSP starts an AE operation in response to a process start instruction from the main CPU 100 in step S502, and the process proceeds to step S503, and the AF detection unit 120 in the DSP Start AF operation.

- step S504 the main CPU 100 first sets the first search area (Pn to Pf in FIG. 4) in the first F lens drive unit 104A, and in the next step S505.

- the AF detection unit 120 detects the in-focus position while moving the first focus lens FLA of the first imaging optical system.

- step S506 the main CPU 100 receives the first F lens in response to the AF detection unit 120 having acquired the in-focus position P1 of the first focus lens FLA in the photographing optical system included in the first photographing unit 1A.

- the drive unit 104A By instructing the drive unit 104A, the first focus lens FLA is stopped at the first focus position P1.

- Main CPU 100 receives the calculation result and sets search start position Pn 'and search end position Pf' in second F lens drive unit 104B, and moves focus lens FLB in the second search range in step S508.

- the AF detection unit 120 detects the second in-focus position P2 while causing the second focus position P2.

- the main CPU 100 acquires the in-focus position P2 from the AF detection unit 120 in step S509, and instructs the second F lens drive unit 104B in step S510.

- the second focus lens FLB is moved to its in-focus position P2 and stopped.

- the main CPU 100 waits for full depression of the shutter button 10C in step S512. If the main CPU 100 determines that the shutter button 10C is not fully pressed in this step S512, the process proceeds to No and repeats the processing of step S512, and if it is determined that the shutter button 10C is fully pressed, the process proceeds to Yes and the photographing process is executed. End the processing of this flow.

- step S504 to step S506 corresponds to an example of the process of the first step according to the present invention

- the process from step S507 to step S510 is the process of the second step according to the present invention. It corresponds to an example.

- the first imaging unit 1A and the second imaging unit 1A take about the same time as in the prior art. An accurate focusing position determination in which a solid difference with the imaging unit 1B is eliminated is performed.

- FIG. 6 is a diagram showing a second embodiment.

- FIG. 6 A block diagram substantially the same as FIG. 2 is shown in FIG. 6, and the portion of the search range setting unit 121 of FIG. 2 is replaced with the in-focus position calculation unit 121A.

- FIG. 7 after the main CPU 100 instructs the first F lens driver 104A to move the first focus lens while causing the AF detection unit 120 to perform the operation, the flash ROM 102 for the second focus lens is used. It is a figure explaining the focus position determination method changed to the structure which moves the 2nd focus lens FLB to a focus position, and is stopped using deviation Df of the inside. Further, FIG. 8 is a diagram for explaining the processing contents of the in-focus position calculation unit 121A.

- the main CPU 100 instructs the second F lens drive unit 104B to make the second focus lens FLB a short second including the in-focus expected position corresponding to the in-focus position of the first focus lens.

- the deviation of the in-focus position representing the solid difference between the first imaging unit 1A and the second imaging unit 1B at the time of manufacture before the imaging device 1 is shipped to the market The deviation is stored in advance in the flash ROM 102, and at the time of shooting, the AF detection unit 120 is made to detect the first focusing position P1 while moving only the first focusing lens, and then the second focusing lens For FLB, the AF search while moving the second focus lens FLB is omitted, and the second focus position P2 is calculated using the deviation Df in the focus position calculation unit 121A, and the second position is calculated.

- a configuration has been proposed in which the focus lens is moved and stopped.

- the main CPU 100, the first and second F lens drive units 104A and 104B, the first and second focus lenses FLA and FLB, the flash ROM 102, the AF detection unit 120, and the in-focus position calculation unit An example of the in-focus position determination means according to the present invention is constituted by 121A.

- FIG. 7A shows the first search area of the first focus lens FLA

- FIG. 7B shows the in-focus position calculation unit 121A without searching the second focus lens FLB. It is shown that the second focus lens is moved to the second in-focus position P2 calculated to be stopped.

- the main CPU 100 instructs the F lens drive unit 104A to move the first focus lens FLA in the first search area (Pn to Pf) while focusing on the AF detection unit 120. It is the same as the first embodiment up to the point of detecting P1.

- the AF detection unit 120 supplies the in-focus position P1 of the first focus lens to the in-focus position calculation unit 102A and the deviation Df from the flash ROM 102.

- the AF search is completed in the same time as in the related art, and the solid difference between the first imaging unit and the second imaging unit is The first and second focus lenses are disposed at the correct in-focus position after cancellation.

- the in-focus positions of the first and second focus lenses FLA and FLB change. Deviations for different focal distances are recorded in the flash ROM 102, and the AF detection unit 120 receives current focal distance information from the main CPU 100 and reads out the deviation according to the focal distance information.

- the arrangement may be made without searching.

- the solid-state difference between the first imaging unit and the second imaging unit is eliminated as in the first embodiment, and the first imaging unit 1A includes the second imaging unit.

- An accurate focusing position can be obtained for each of the first focus lens and the second focus lens provided in the second imaging unit 1B.

- the second focus lens FLB is moved and stopped at a position deviated from the first focus position by the deviation Df without moving the second focus lens. Since there is, the AF search ends in almost the same time as in the past.

- FIG. 9 is a flowchart showing a processing procedure of in-focus position determination in which the main CPU 100 of the second embodiment executes processing in cooperation with a DSP that constitutes the AF detection unit 120 and the like.

- step S507 Since the process of step S507 is changed to step S507A and the process of step S508 and step S509 is omitted, the process is the same as the process of the flow of FIG.

- step S507A the AF detection unit 120 reads the deviation Df from the flash ROM 102 and supplies it to the in-focus position calculation unit 102A to calculate the in-focus position P2 of the second focus lens FLB.

- step S510 the main CPU 100 focuses on The focus position P2 calculated by the position calculation unit 121A is received, and the F lens drive unit 104B is instructed to move the focus lens FLB to the focus position P2 and stop it.

- step S504 to step S506 corresponds to an example of the process of the first step according to the present invention

- the process from step S507A to step S510 is the process of the second step according to the present invention. It corresponds to an example.

- FIG. 10 is a view showing an internal configuration of the photographing apparatus of FIG. 1 similarly to FIG. 2 and is a view showing the same configuration as FIG. 2 except that the search range setting unit 121 is replaced by the deviation detection unit 121B. It is. Also, in FIG. 11, the main CPU 100 instructs the first F lens drive unit 104A and the second F lens drive unit 104B at the time of the first shooting to move the first and second focus lenses FLA and FLB.

- the AF detection unit 120 detects the first and second in-focus positions P1 and P2 and stores the deviation Df of the in-focus position in the DRAM 115, and drives the first F lens in the next and subsequent photographing.

- the unit 104A instructs the AF detection unit 120 to detect the first focus position P1 while moving the first focus lens FLA, and the deviation detection unit is supplied with the deviation Df and the first focus position P1. It is a figure explaining the focusing position determination method of calculating the 2nd focusing position of the 2nd focus lens FLB. Moreover, FIG. 12 is a figure explaining the processing content of the deviation detection part 121B.

- the second focus lens is moved to the in-focus position P1 and stopped using the focusing position determination method of the first embodiment at the time of the first shooting, and the first shooting at the time of the first shooting

- AF detection is performed using the in-focus position determination method of the second embodiment in the subsequent imaging

- the unit 120 reads the deviation Df from the SDRAM 115 and supplies it to the deviation detection unit 121B to cause the deviation detection unit 121B to calculate the second focus position P2, and the main CPU 100 calculates the second focus position P2 as the deviation detection unit 121B.

- the second driving unit 104B to move the second focus lens FLB to a position deviated by the deviation Df and stop the position.

- the main CPU 100 the first and second F lens drive units 104A and 104B, the first and second focus lenses FLA and FLB, the flash ROM 102, the AF detection unit 120, and the deviation detection unit 121B.

- An example of the in-focus position determination means according to the present invention is configured.

- the main CPU 100 instructs the first F lens drive unit 104A and the second F lens drive unit 104B to move the first and second focus lenses while the AF detection unit 120 is moved.

- the AF search is performed while moving the first focus lens FLA and the second focus lens FLB. It is shown that. Further, in FIGS. 11C and 11D, in the second and subsequent shootings, the AF search is performed while moving the first focus lens FLA, and the first shooting for the second focus lens FLB. It is shown that the second focus lens is placed at the in-focus position using the deviation obtained by

- the main CPU 100 instructs the first F lens drive unit 104A to execute the first search area (Pn to Pf).

- the AF detection unit 120 is made to search for the in-focus position while moving the focus lens FLA.

- the main CPU 100 receives the in-focus position P1 at which the AF evaluation value (contrast) detected by the AF detection unit 120 is maximum, and instructs the first F lens drive unit 104A to set the in-focus position P1 of the focus lens FLA. Stop it.

- the AF detection unit 120 inputs the in-focus position P1 to the deviation detection unit 121, reads out the constants (the near side deviation N, the far side deviation F) related to the second search area from the flash ROM 102, and outputs the same to the deviation detection unit 121B.

- the transfer is performed, and the deviation detection unit 121B is caused to calculate the second search area.

- the main CPU 100 receives the calculation result via the bus Bus and instructs the second F lens drive unit 104B to move the second focus lens FLB in the second search range (Pn 'to Pf'). In the meantime, the AF detection unit 120 is made to search for the in-focus position.

- the main CPU 100 receives the in-focus position P2 at which the AF evaluation value (contrast) of the second imaging unit 1B detected by the AF detection unit 120 is maximum, and instructs the second F lens drive unit 104A to focus lens FLB Is stopped at the in-focus position P2.

- the deviation detection unit 121B calculates the deviation Df between the first in-focus position P1 and the second in-focus position P2 using the equation P1-P2, and calculates the deviation Df in the SDRAM 115.

- the main CPU 100 instructs the first F lens driving unit 104A to set the first focus lens FLA in the first search area (Pn After the AF detection unit 120 detects the in-focus position P1 while moving from Pf to Pf), the AF detection unit 115 reads the deviation Df in the SDRAM 115 and supplies the deviation Df to the deviation detection unit 121B.

- the in-focus position P2 of the second focus lens FLB of the second photographing unit 1B is calculated, and the main CPU 100 receives the in-focus position P2 and instructs the second F lens drive unit 104B to perform the second focus lens FLB. Is moved to its in-focus position P2 and stopped.

- FIG. 13 is a flowchart showing the procedure of the in-focus position determination that the main CPU 100 executes in cooperation with the DSP.

- step S501 the main CPU 100 determines whether the shutter button 10C has been half-pressed. If the main CPU 100 determines in step S501 that the shutter button 10C is not half-pressed, the process proceeds to No, and the process of step S501 is repeated. If it is determined in step S501 that the shutter button 10C is half-pressed, the process proceeds to Yes . If YES in step S502, the AE / AWB detection unit 130 in the DSP starts an AE operation in response to a process start instruction from the main CPU 100 in step S502, and proceeds to step S503A to determine whether the first shooting is performed.

- step S503A determines in step S503A that the first shooting is to be performed. If the main CPU 100 determines in step S503A that the first shooting is to be performed, the process proceeds to Yes, and upon receiving a shooting start instruction from the main CPU 100, the AF detection unit starts an AF operation. More specifically, it is determined whether or not the first photographing is performed in step S503A based on whether or not the value of the effective deviation Df is stored in the SDRAM 115.

- step S504 the main CPU 100 first sets the first search area (Pn to Pf in FIG. 4) in the first F lens driver 104A, and in the next step S505 the first focus of the first imaging optical system

- the AF detection unit 120 detects the in-focus position while moving the lens FLA.

- step S506 the main CPU 100 receives the first F lens in response to the AF detection unit 120 having acquired the in-focus position P1 of the first focus lens FLA in the photographing optical system included in the first photographing unit 1A.

- the drive unit 104A By instructing the drive unit 104A, the first focus lens FLA is stopped at the first focus position P1.

- step S507 the AF detection unit 120 supplies the in-focus position P1 to the deviation detection unit 121B, and the near side deviation N and the far side deviation F are read from the flash ROM 102 and supplied to the deviation detection unit 121.

- the second search area is calculated using the equation of FIG.

- the main CPU 100 acquires the second search area from the deviation detection unit 121B, and sets the search start position Pn 'and the search end position Pf' in the second F lens drive unit 104B in step S508.

- step S509 the AF detection unit 120 detects the in-focus position P2 while moving the focus lens FLB in the second search range.

- step S510 the main CPU 100 receives the in-focus position P2 from the AF detection unit 120 and instructs the second F lens drive unit 104B to move the second focus lens FLB to the in-focus position P2 and stop it.

- the AF detection unit 120 causes the deviation detection unit 121B to calculate the deviation between the in-focus position P1 and the in-focus position P2, and stores the deviation in the SDRAM 115.

- step S512 the main CPU 100 waits for full depression of the shutter button 10C in step S512. If the main CPU 100 determines that the shutter button 10C is not fully pressed in this step S512, the process proceeds to No and repeats the processing of step S512, and if it is determined that the shutter button 10C is fully pressed, the process proceeds to Yes and the photographing process is executed. Do.

- the first shooting process ends here.

- step S514 the first search area (Pn to Pf in FIG. 11C) is first set in the first F lens drive unit 104A.

- the AF detection unit 120 is made to detect the in-focus position while moving the first focus lens FLA of the first imaging optical system. Then, based on the in-focus position P1 detected by the AF detection unit 120, the first F lens drive unit 104A is instructed to move the first focus lens FLA to the in-focus position P1 and to stop it.

- step S516 the AF detection unit 120 acquires the in-focus position P1 of the first focus lens FLA in the imaging optical system included in the first imaging unit 1A and supplies it to the deviation detection unit 121B.

- the deviation Df of the above is read out and supplied to the deviation detection unit 121B.

- the main CPU 100 receives the second focus position P2 from the deviation detection unit 121B and instructs the second lens drive unit 104B to move the second focus lens to the second focus position P2 and stop it.

- the processing from step S504 to step S509 of the flow related to the first photographing on the right side of FIG. 13 corresponds to an example of the processing of the first step in the present invention.

- the processing of step S5091 of the flow according to the present invention corresponds to an example of the processing of the second step according to the present invention, and the processing from step S514 to step S517 of the flow related to the second and subsequent photographing on the left side of FIG. It corresponds to an example of processing of the 3rd step said to.

- the AF search is completed in approximately the same time as in the conventional case, and a solid between the first and second shooting units The difference is eliminated and the accurate focusing position determination is performed, and in the next and subsequent photographings, as in the second embodiment, the AF search is ended in the same time as in the prior art, and the first photographing unit and the first photographing unit The individual differences between the two imaging units are eliminated, and accurate focusing position determination is performed.

- the deviation Df is stored in the SDRAM 115.

- the deviation Df may be stored in the flash ROM 102. If the configuration is stored in the flash ROM 102, it is not necessary to store the deviation in the first shooting after the power is turned off and the power is turned on. If a non-volatile flash ROM which can be rewritten even after mounting is used, it is not necessary to store the data in the flash ROM at the time of manufacture as in the second embodiment, and the photographer can operate every week or month by operation.

- the present invention can be extended to a configuration in which the deviation is freely stored in the deviation storage unit.

- the imaging apparatus for performing stereoscopic imaging has been described.

- the present invention may be an imaging apparatus for performing panoramic imaging with two imaging units, and the sensitivity may be different between the two imaging units.

- the imaging apparatus may perform imaging with a different color, or may perform imaging with different colors in two imaging sections.

- the imaging apparatus may perform imaging with different brightness in each of the two imaging sections. Also good.

- the focusing position determination method of the present invention is applicable to any imaging device.

- 1 Shooting device 1A First shooting unit 1B Second shooting unit 100 Main CPU 101 ROM 102 Flash ROM 104A first F lens drive unit 104B second F lens drive unit 110A first imaging optical system 110B second imaging optical system 111A first imaging device 111B second imaging device 112A first analog signal processing unit 112B second analog signal processing unit 116A first digital signal processing unit 116B second digital signal processing unit 120 AF detection unit 121 search range setting unit 121A focusing position calculation unit 121B deviation detection unit 130 AE and AWB detection unit

Landscapes

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Signal Processing (AREA)

- Optics & Photonics (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Human Computer Interaction (AREA)

- Databases & Information Systems (AREA)

- Studio Devices (AREA)

- Automatic Focus Adjustment (AREA)

- Focusing (AREA)

- Lens Barrels (AREA)

Abstract

従来と同じ程度の時間で、2つの撮影部各々の合焦位置を正確に決定することができる撮影装置、およびその撮影装置における合焦位置決定方法を提供することを目的とし、サーチ範囲設定部121は、AF検出部120が検出した第1のフォーカスレンズFLAの合焦位置P1とフラッシュROM102に記憶されている近傍側の探索領域の境界値Nと遠方側の探索領域の境界値Fとに基づいて、第2のサーチ領域となる一方の境界値Pn´をPn´=Pn+Nという式から算出するとともに他方の境界値Pf´をPf´=P1-Fという式から算出し、メインCPU100は、この算出結果を受け取って第2のFレンズ駆動部104Bに指示して、第2のフォーカスレンズFLBを第1のサーチ領域よりも狭い第2のサーチ領域(Pn´からPf´)で移動させながら合焦位置P2をAF検出部120に探索させる。

Description

本発明は、第1の撮影部と第2の撮影部とを備え、これらの2つの撮影部を使って撮影を行なう撮影装置およびその撮影装置における合焦位置決定方法に関する。

従来より2つの撮影部を備えた撮影装置が数多く提案されている(特許文献1、2参照)。このように2つの撮影部が備えられていると、2つの撮影部を使って超広角のパノラマ撮影や2つの撮影部各々で異なる感度での撮影等を行なうことができる。上記特許文献1、2等の中には、立体撮影を行なうことができるものもある。

2つの撮影部で上記立体撮影を行なうものにあっては、2つの撮影部が、右眼、左眼に相当する位置に視差を持たせて並べられて設けられており、双方の撮影部から出力された画像信号に基づいて後段の信号処理部で右眼用の画像信号と左眼用の画像信号とが各々生成される。こうして撮影装置の信号処理部で生成された右眼用の画像信号と左眼用の画像信号とが、非特許文献1にあるような3次元表示が可能な表示画面を有する表示装置に入力されると、その表示画面上に立体画像が表示される。

ところで、デジタルカメラにおいては、ピント調整、つまり合焦位置の調整を行なうにあたって、内部に配備されている合焦位置決定手段が、撮影光学系内のフォーカスレンズを所定のサーチ領域内で移動させそのフォーカスレンズを移動させている間中コントラストを検出してコントラストが最大となる位置をフォーカスレンズの合焦位置とする、いわゆるAF(Auto Focus)サーチを行なっているものが多い。

上記特許文献1の撮影装置においては、2つの撮影部が同じ被写体を捉えているということを理由に、一方の撮影部のみでAFサーチを実施しそのAFサーチの結果を他方の撮影部に反映することで、2つの撮影部を有する撮影装置のAFサーチに要する時間の短縮化が図られている。また特許文献2の撮影装置には、内部の合焦位置決定手段に、双方の撮影部が備えるフォーカスレンズを相互に逆の方向にそれぞれ移動させるというAFサーチを行わせて、双方の撮影部のうち、先に合焦位置を検出した撮影部の方のAFサーチ結果を使って双方の撮影部の合焦位置を決定するという技術が提案されている。

しかし2つの撮影部には、フォーカスレンズのレンズ径やレンズ鏡胴の径や撮像素子の受光感度のばらつき等がどうしても存在する(以降の記載においてはこれらを総称して固体差という)。このため、上記特許文献1,2のように一方の撮影部の合焦位置を他方の撮影部に反映させる構成にすると、その固体差により他方の撮影部の合焦位置がずれてしまう。

インターネット<URL: http://www.3dc.gr.jp/jp/act_rep/050902/Yuuki.pdf>

本発明は、上記事情に鑑み、従来と同じ程度の時間で、2つの撮影部各々の合焦位置を正確に決定することができる撮影装置、およびその撮影装置における合焦位置決定方法を提供することを目的とする。

上記目的を達成する本発明の第1の撮影装置は、

第1のフォーカスレンズを含む第1の撮影光学系と、該第1のフォーカスレンズを光軸方向に移動させる第1のフォーカスレンズ駆動部と、被写体が上記第1の撮影光学系で結像されてなる被写体光を受光して該被写体を表わす画像信号を生成する第1の撮像素子とを有する第1の撮影部と、

第2のフォーカスレンズを含む第2の撮影光学系と、該第2のフォーカスレンズを光軸方向に移動させる第2のフォーカスレンズ駆動部と、被写体が上記第2の撮影光学系で結像されてなる被写体光を受光して該被写体を表わす画像信号を生成する第2の撮像素子とを有する第2の撮影部と、

上記第1のフォーカスレンズを所定の第1のサーチ領域内で移動させながら合焦位置を探索して該第1のフォーカスレンズを合焦位置に停止させ、上記第2の撮影光学系については、上記第2のフォーカスレンズを、上記第1のフォーカスレンズの合焦位置に対応した上記第2のフォーカスレンズの合焦期待位置を含む、上記第1のサーチ領域よりも狭い第2のサーチ領域内で移動させながら合焦位置を探索して、該第2のフォーカスレンズを合焦位置に停止させる合焦位置決定手段とを備えたことを特徴とする。

第1のフォーカスレンズを含む第1の撮影光学系と、該第1のフォーカスレンズを光軸方向に移動させる第1のフォーカスレンズ駆動部と、被写体が上記第1の撮影光学系で結像されてなる被写体光を受光して該被写体を表わす画像信号を生成する第1の撮像素子とを有する第1の撮影部と、

第2のフォーカスレンズを含む第2の撮影光学系と、該第2のフォーカスレンズを光軸方向に移動させる第2のフォーカスレンズ駆動部と、被写体が上記第2の撮影光学系で結像されてなる被写体光を受光して該被写体を表わす画像信号を生成する第2の撮像素子とを有する第2の撮影部と、

上記第1のフォーカスレンズを所定の第1のサーチ領域内で移動させながら合焦位置を探索して該第1のフォーカスレンズを合焦位置に停止させ、上記第2の撮影光学系については、上記第2のフォーカスレンズを、上記第1のフォーカスレンズの合焦位置に対応した上記第2のフォーカスレンズの合焦期待位置を含む、上記第1のサーチ領域よりも狭い第2のサーチ領域内で移動させながら合焦位置を探索して、該第2のフォーカスレンズを合焦位置に停止させる合焦位置決定手段とを備えたことを特徴とする。

上記本発明の第1の撮影装置によれば、上記合焦位置決定手段が、上記第1の撮影光学系については第1のフォーカスレンズを所定の第1のサーチ領域内でAFサーチを実行し、第2の撮影光学系については、上記第1のフォーカスレンズの合焦位置に対応する合焦期待位置を含む、その第1のサーチ領域よりも狭い第2のサーチ領域内でAFサーチを実施する。つまり、上記合焦位置決定手段は、第1の撮影光学系の合焦位置に対応する上記合焦期待位置に第2の撮影光学系内の第2のフォーカスレンズをそのまま配置せずに、第2の撮影光学系と第1の撮影光学系との固定差を解消するように第2のフォーカスレンズをその合焦期待位置を含む、上記第1のサーチ領域よりも狭い第2のサーチを移動させながら合焦位置を探索してから第2のフォーカスレンズを合焦位置に移動させ停止させる。

その結果、第1の撮影光学系と第2の撮影光学系との間の固体差が解消され、第1のフォーカスレンズと第2のフォーカスレンズが的確な合焦位置に各々配置される。このときには、第2のフォーカスレンズをサーチさせる距離が上記第1のサーチよりも短い区間に限定されるためにさほど時間が係ることもなく従来とほぼ同じ程度の時間でAFサーチが終了する。

上記目的を達成する本発明の第2の撮影装置は、

第1のフォーカスレンズを含む第1の撮影光学系と、その第1のフォーカスレンズを光軸方向に移動させる第1のフォーカスレンズ駆動部と、被写体が上記第1の撮影光学系で結像されてなる被写体光を受光してその被写体を表わす画像信号を生成する第1の撮像素子とを有する第1の撮影部と、

第2のフォーカスレンズを含む第2の撮影光学系と、その第2のフォーカスレンズを光軸方向に移動させる第2のフォーカスレンズ駆動部と、被写体が上記第2の撮影光学系で結像されてなる被写体光を受光してその被写体を表わす画像信号を生成する第2の撮像素子とを有する第2の撮影部と、

上記第2のフォーカスレンズの合焦位置の、上記第1のフォーカスレンズの合焦位置からの偏差を不揮発的に記憶しておく偏差記憶部と、

上記第1の撮影光学系について、上記第1のフォーカスレンズを移動させながら合焦位置を探索してその第1のフォーカスレンズを合焦位置に停止させ、上記第2の撮影光学系については、上記第2のフォーカスレンズを、上記第1のフォーカスレンズの合焦位置に対応した上記第2のフォーカスレンズの合焦期待位置よりも上記偏差記憶部に記憶された偏差だけ偏倚した位置に移動させる合焦位置決定手段とを備えたこと特徴とする。

第1のフォーカスレンズを含む第1の撮影光学系と、その第1のフォーカスレンズを光軸方向に移動させる第1のフォーカスレンズ駆動部と、被写体が上記第1の撮影光学系で結像されてなる被写体光を受光してその被写体を表わす画像信号を生成する第1の撮像素子とを有する第1の撮影部と、

第2のフォーカスレンズを含む第2の撮影光学系と、その第2のフォーカスレンズを光軸方向に移動させる第2のフォーカスレンズ駆動部と、被写体が上記第2の撮影光学系で結像されてなる被写体光を受光してその被写体を表わす画像信号を生成する第2の撮像素子とを有する第2の撮影部と、

上記第2のフォーカスレンズの合焦位置の、上記第1のフォーカスレンズの合焦位置からの偏差を不揮発的に記憶しておく偏差記憶部と、

上記第1の撮影光学系について、上記第1のフォーカスレンズを移動させながら合焦位置を探索してその第1のフォーカスレンズを合焦位置に停止させ、上記第2の撮影光学系については、上記第2のフォーカスレンズを、上記第1のフォーカスレンズの合焦位置に対応した上記第2のフォーカスレンズの合焦期待位置よりも上記偏差記憶部に記憶された偏差だけ偏倚した位置に移動させる合焦位置決定手段とを備えたこと特徴とする。

ここで上記偏差記憶部には、例えばこの撮影装置を製造しているときに、第1の撮影部と第2の撮影部との間の固体差を示す合焦位置の偏差を予め取得して記憶しておけば良い。

上記本発明の第2の撮影装置によれば、上記合焦位置決定手段が、上記第1の撮影光学系については第1のフォーカスレンズを所定の第1のサーチ領域内でAFサーチを実行し、第2の撮影光学系については、その第1の撮影部側のAFサーチで検出された合焦期待位置に第2のフォーカスレンズを配置せずに、その合焦期待位置よりも上記偏差記憶部に記憶された偏差だけ偏倚した位置に第2のフォーカスレンズを移動させ停止させる。

つまり、上記合焦位置決定手段は、第1の撮影光学系の合焦位置に対応する上記合焦期待位置に第2の撮影光学系内の第2のフォーカスレンズをそのまま配置せずに、第2の撮影光学系と第1の撮影光学系との間の固定差を解消するように第1のフォーカスレンズをその合焦期待位置よりも上記偏差記憶部に記憶された偏差だけ偏倚した位置に第2のフォーカスレンズを移動させ停止させることになる。その結果、第1の撮影光学系と第2の撮影光学系との間の固体差が解消され、第1のフォーカスレンズと第2のフォーカスレンズが的確な合焦位置に各々配置される。このときには、従来とほぼ同じ時間でAFサーチが終了する。

上記目的を達成する本発明の第3の撮影装置は、

第1のフォーカスレンズを含む第1の撮影光学系と、その第1のフォーカスレンズを光軸方向に移動させる第1のフォーカスレンズ駆動部と、被写体が上記第1の撮影光学系で結像されてなる被写体光を受光してその被写体を表わす画像信号を生成する第1の撮像素子とを有する第1の撮影部と、

第2のフォーカスレンズを含む第2の撮影光学系と、その第2のフォーカスレンズを光軸方向に移動させる第2のフォーカスレンズ駆動部と、被写体が上記第2の撮影光学系で結像されてなる被写体光を受光してその被写体を表わす画像信号を生成する第2の撮像素子とを有する第2の撮影部と、

上記第1および第2のフォーカスレンズ駆動部各々に指示し上記第1および第2のフォーカスレンズ各々を光軸方向に移動させながら各々の合焦位置を探索しその第1及びその第2のフォーカスレンズ各々を各々の合焦位置に停止させる合焦位置決定手段と、

上記合焦位置決定手段により探索された上記第2のフォーカスレンズの合焦位置の、上記合焦位置決定手段により探索された上記第1のフォーカスレンズの合焦位置からの偏差を記憶する偏差記憶部とを備え、

上記合焦位置決定手段は、上記偏差記憶部に上記偏差が記憶されている場合には、第1の撮影光学系について、上記第1のフォーカスレンズを移動させながら合焦位置を探索してその第1のフォーカスレンズを合焦位置に停止させ、上記第2の撮影光学系については、上記第2のフォーカスレンズを、上記第1のフォーカスレンズの合焦位置に対応した上記第2のフォーカスレンズの合焦期待位置よりも上記偏差記憶部に記憶された偏差だけ偏倚した位置に移動させることを特徴とする。

第1のフォーカスレンズを含む第1の撮影光学系と、その第1のフォーカスレンズを光軸方向に移動させる第1のフォーカスレンズ駆動部と、被写体が上記第1の撮影光学系で結像されてなる被写体光を受光してその被写体を表わす画像信号を生成する第1の撮像素子とを有する第1の撮影部と、

第2のフォーカスレンズを含む第2の撮影光学系と、その第2のフォーカスレンズを光軸方向に移動させる第2のフォーカスレンズ駆動部と、被写体が上記第2の撮影光学系で結像されてなる被写体光を受光してその被写体を表わす画像信号を生成する第2の撮像素子とを有する第2の撮影部と、

上記第1および第2のフォーカスレンズ駆動部各々に指示し上記第1および第2のフォーカスレンズ各々を光軸方向に移動させながら各々の合焦位置を探索しその第1及びその第2のフォーカスレンズ各々を各々の合焦位置に停止させる合焦位置決定手段と、

上記合焦位置決定手段により探索された上記第2のフォーカスレンズの合焦位置の、上記合焦位置決定手段により探索された上記第1のフォーカスレンズの合焦位置からの偏差を記憶する偏差記憶部とを備え、

上記合焦位置決定手段は、上記偏差記憶部に上記偏差が記憶されている場合には、第1の撮影光学系について、上記第1のフォーカスレンズを移動させながら合焦位置を探索してその第1のフォーカスレンズを合焦位置に停止させ、上記第2の撮影光学系については、上記第2のフォーカスレンズを、上記第1のフォーカスレンズの合焦位置に対応した上記第2のフォーカスレンズの合焦期待位置よりも上記偏差記憶部に記憶された偏差だけ偏倚した位置に移動させることを特徴とする。

ここで上記偏差記憶部に偏差が記憶されている場合というのは、例えばその偏差記憶部が揮発性のメモリで構成されているときには電源が一旦オフされ再度電源スイッチがオンされた後の2回目以降の撮影の場合を指す。

したがって、上記本発明の第3の撮影装置では、例えば初回の撮影については上記合焦位置決定手段が、まず上記第1および第2のフォーカスレンズ駆動部各々に指示し上記第1および第2のフォーカスレンズ各々を光軸方向に移動させながら各々の合焦位置を探索しその第1及びその第2のフォーカスレンズ各々を各々の合焦位置に停止させる。この初回の撮影時に探索した上記第2のフォーカスレンズの合焦位置の、上記第1のフォーカスレンズの合焦位置からの偏差を上記偏差記憶部に記憶しておいて2回目以降の撮影については上記合焦位置決定手段が上記第1の撮影光学系については第1のフォーカスレンズを所定の第1のサーチ領域内でAFサーチを実行し、第2の撮影光学系については第2の撮影光学系と第1の撮影光学系との間の固定差を解消するように第2のフォーカスレンズを上記偏差記憶部に記憶された偏差だけ偏倚させた位置に第2のフォーカスレンズを移動させ停止させる。

その結果、どの撮影回においても第1の撮影光学系と第2の撮影光学系との間の固体差が解消され、第1のフォーカスレンズと第2のフォーカスレンズが的確な合焦位置に各々配置される。初回の撮影時には、第2のフォーカスレンズをサーチさせる距離が上記第1のサーチよりも短い区間に限定されるためにさほどの時間が係ることがなく従来とほぼ同じ程度の時間でAFサーチが終了し、それ以降については、従来とほぼ同じ時間でAFサーチが終了する。

なお上記では電源投入後の2回目以降の撮影を上記偏差記憶部に偏差が記憶されている場合の例として掲げたが、上記偏差記憶部に記憶されている場合の中には、例えばズームスイッチが操作されて焦点距離が変更された後で一度撮影が行なわれ偏差が偏差記憶部に記憶された後、同じ焦点距離で撮影が再度行なわれるような場合等も含まれる。

また、上記偏差記憶部が例えば不揮発性のメモリで構成されている場合には、例えばリセット操作でその不揮発性メモリの内容が消去されることもある。このような構成の場合には、リセットされた後の2回目以降の撮影が、上記偏差が記憶されている場合に該当する。