BR122020006972B1 - Método de normalização de volume com base em um valor de volume alvo, aparelho de processamento de áudio configurado para normalizar o volume com base em um valor de volume alvo e dispositivo de armazenamento de método implementado por computador legível por uma máquina - Google Patents

Método de normalização de volume com base em um valor de volume alvo, aparelho de processamento de áudio configurado para normalizar o volume com base em um valor de volume alvo e dispositivo de armazenamento de método implementado por computador legível por uma máquina Download PDFInfo

- Publication number

- BR122020006972B1 BR122020006972B1 BR122020006972-4A BR122020006972A BR122020006972B1 BR 122020006972 B1 BR122020006972 B1 BR 122020006972B1 BR 122020006972 A BR122020006972 A BR 122020006972A BR 122020006972 B1 BR122020006972 B1 BR 122020006972B1

- Authority

- BR

- Brazil

- Prior art keywords

- audio

- type

- short

- voip

- content

- Prior art date

Links

- 238000000034 method Methods 0.000 title claims abstract description 151

- 238000012545 processing Methods 0.000 title claims description 67

- 238000003860 storage Methods 0.000 title claims description 13

- 238000010606 normalization Methods 0.000 title claims description 7

- 230000005236 sound signal Effects 0.000 claims abstract description 138

- 238000009499 grossing Methods 0.000 claims description 29

- 230000000694 effects Effects 0.000 claims description 22

- 230000007774 longterm Effects 0.000 claims description 17

- 230000002452 interceptive effect Effects 0.000 abstract description 16

- 230000007704 transition Effects 0.000 description 47

- 230000006870 function Effects 0.000 description 40

- 238000003672 processing method Methods 0.000 description 40

- 230000003595 spectral effect Effects 0.000 description 40

- 230000008569 process Effects 0.000 description 27

- 230000008859 change Effects 0.000 description 26

- 238000010586 diagram Methods 0.000 description 25

- 238000005457 optimization Methods 0.000 description 22

- 230000000875 corresponding effect Effects 0.000 description 21

- 238000004422 calculation algorithm Methods 0.000 description 13

- 230000007423 decrease Effects 0.000 description 11

- 230000001965 increasing effect Effects 0.000 description 11

- 238000004590 computer program Methods 0.000 description 10

- 230000001276 controlling effect Effects 0.000 description 10

- 238000012986 modification Methods 0.000 description 10

- 230000004048 modification Effects 0.000 description 10

- 230000002596 correlated effect Effects 0.000 description 9

- 230000003247 decreasing effect Effects 0.000 description 8

- 238000010801 machine learning Methods 0.000 description 7

- 230000001755 vocal effect Effects 0.000 description 7

- 238000001514 detection method Methods 0.000 description 6

- 230000033764 rhythmic process Effects 0.000 description 6

- 230000001020 rhythmical effect Effects 0.000 description 6

- 230000006399 behavior Effects 0.000 description 5

- 230000000295 complement effect Effects 0.000 description 5

- 238000000605 extraction Methods 0.000 description 5

- 238000012706 support-vector machine Methods 0.000 description 5

- 238000012546 transfer Methods 0.000 description 5

- 238000005303 weighing Methods 0.000 description 5

- 206010028403 Mutism Diseases 0.000 description 4

- 238000004458 analytical method Methods 0.000 description 4

- 230000033228 biological regulation Effects 0.000 description 4

- 230000001419 dependent effect Effects 0.000 description 4

- 238000005516 engineering process Methods 0.000 description 4

- 239000000203 mixture Substances 0.000 description 4

- 230000003287 optical effect Effects 0.000 description 4

- 239000011435 rock Substances 0.000 description 4

- 230000003068 static effect Effects 0.000 description 4

- NAWXUBYGYWOOIX-SFHVURJKSA-N (2s)-2-[[4-[2-(2,4-diaminoquinazolin-6-yl)ethyl]benzoyl]amino]-4-methylidenepentanedioic acid Chemical compound C1=CC2=NC(N)=NC(N)=C2C=C1CCC1=CC=C(C(=O)N[C@@H](CC(=C)C(O)=O)C(O)=O)C=C1 NAWXUBYGYWOOIX-SFHVURJKSA-N 0.000 description 3

- 230000006854 communication Effects 0.000 description 3

- 238000009826 distribution Methods 0.000 description 3

- 230000007246 mechanism Effects 0.000 description 3

- 238000012544 monitoring process Methods 0.000 description 3

- 230000009466 transformation Effects 0.000 description 3

- 230000003044 adaptive effect Effects 0.000 description 2

- 238000013459 approach Methods 0.000 description 2

- 230000008901 benefit Effects 0.000 description 2

- 230000003139 buffering effect Effects 0.000 description 2

- 238000004364 calculation method Methods 0.000 description 2

- 238000004891 communication Methods 0.000 description 2

- 238000013461 design Methods 0.000 description 2

- 239000003623 enhancer Substances 0.000 description 2

- 230000002708 enhancing effect Effects 0.000 description 2

- 230000004907 flux Effects 0.000 description 2

- 238000013507 mapping Methods 0.000 description 2

- 239000000463 material Substances 0.000 description 2

- 238000007781 pre-processing Methods 0.000 description 2

- 230000000644 propagated effect Effects 0.000 description 2

- 230000004044 response Effects 0.000 description 2

- 230000011218 segmentation Effects 0.000 description 2

- 239000004065 semiconductor Substances 0.000 description 2

- 230000002123 temporal effect Effects 0.000 description 2

- WURBVZBTWMNKQT-UHFFFAOYSA-N 1-(4-chlorophenoxy)-3,3-dimethyl-1-(1,2,4-triazol-1-yl)butan-2-one Chemical compound C1=NC=NN1C(C(=O)C(C)(C)C)OC1=CC=C(Cl)C=C1 WURBVZBTWMNKQT-UHFFFAOYSA-N 0.000 description 1

- 230000015572 biosynthetic process Effects 0.000 description 1

- 230000015556 catabolic process Effects 0.000 description 1

- 238000007796 conventional method Methods 0.000 description 1

- 230000002950 deficient Effects 0.000 description 1

- 238000006731 degradation reaction Methods 0.000 description 1

- 210000005069 ears Anatomy 0.000 description 1

- 238000004880 explosion Methods 0.000 description 1

- 239000000835 fiber Substances 0.000 description 1

- 230000006872 improvement Effects 0.000 description 1

- 230000000670 limiting effect Effects 0.000 description 1

- 238000012886 linear function Methods 0.000 description 1

- 239000004973 liquid crystal related substance Substances 0.000 description 1

- 230000005923 long-lasting effect Effects 0.000 description 1

- 238000004519 manufacturing process Methods 0.000 description 1

- 230000036651 mood Effects 0.000 description 1

- 239000013307 optical fiber Substances 0.000 description 1

- 238000003909 pattern recognition Methods 0.000 description 1

- 238000001303 quality assessment method Methods 0.000 description 1

- 230000000717 retained effect Effects 0.000 description 1

- 230000008054 signal transmission Effects 0.000 description 1

- 230000001629 suppression Effects 0.000 description 1

- 238000012360 testing method Methods 0.000 description 1

- 238000012549 training Methods 0.000 description 1

- 238000000844 transformation Methods 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L25/00—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00

- G10L25/48—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00 specially adapted for particular use

- G10L25/51—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00 specially adapted for particular use for comparison or discrimination

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L21/00—Speech or voice signal processing techniques to produce another audible or non-audible signal, e.g. visual or tactile, in order to modify its quality or its intelligibility

- G10L21/02—Speech enhancement, e.g. noise reduction or echo cancellation

- G10L21/0316—Speech enhancement, e.g. noise reduction or echo cancellation by changing the amplitude

- G10L21/0364—Speech enhancement, e.g. noise reduction or echo cancellation by changing the amplitude for improving intelligibility

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L25/00—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00

- G10L25/27—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00 characterised by the analysis technique

- G10L25/30—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00 characterised by the analysis technique using neural networks

-

- H—ELECTRICITY

- H03—ELECTRONIC CIRCUITRY

- H03G—CONTROL OF AMPLIFICATION

- H03G3/00—Gain control in amplifiers or frequency changers

- H03G3/20—Automatic control

- H03G3/30—Automatic control in amplifiers having semiconductor devices

- H03G3/3089—Control of digital or coded signals

-

- H—ELECTRICITY

- H03—ELECTRONIC CIRCUITRY

- H03G—CONTROL OF AMPLIFICATION

- H03G3/00—Gain control in amplifiers or frequency changers

- H03G3/20—Automatic control

- H03G3/30—Automatic control in amplifiers having semiconductor devices

- H03G3/32—Automatic control in amplifiers having semiconductor devices the control being dependent upon ambient noise level or sound level

-

- H—ELECTRICITY

- H03—ELECTRONIC CIRCUITRY

- H03G—CONTROL OF AMPLIFICATION

- H03G5/00—Tone control or bandwidth control in amplifiers

- H03G5/16—Automatic control

- H03G5/165—Equalizers; Volume or gain control in limited frequency bands

-

- H—ELECTRICITY

- H03—ELECTRONIC CIRCUITRY

- H03G—CONTROL OF AMPLIFICATION

- H03G7/00—Volume compression or expansion in amplifiers

- H03G7/002—Volume compression or expansion in amplifiers in untuned or low-frequency amplifiers, e.g. audio amplifiers

-

- H—ELECTRICITY

- H03—ELECTRONIC CIRCUITRY

- H03G—CONTROL OF AMPLIFICATION

- H03G7/00—Volume compression or expansion in amplifiers

- H03G7/007—Volume compression or expansion in amplifiers of digital or coded signals

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L25/00—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00

- G10L25/78—Detection of presence or absence of voice signals

- G10L25/81—Detection of presence or absence of voice signals for discriminating voice from music

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04M—TELEPHONIC COMMUNICATION

- H04M2203/00—Aspects of automatic or semi-automatic exchanges

- H04M2203/30—Aspects of automatic or semi-automatic exchanges related to audio recordings in general

- H04M2203/305—Recording playback features, e.g. increased speed

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04M—TELEPHONIC COMMUNICATION

- H04M7/00—Arrangements for interconnection between switching centres

- H04M7/006—Networks other than PSTN/ISDN providing telephone service, e.g. Voice over Internet Protocol (VoIP), including next generation networks with a packet-switched transport layer

Landscapes

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Acoustics & Sound (AREA)

- Signal Processing (AREA)

- Health & Medical Sciences (AREA)

- Audiology, Speech & Language Pathology (AREA)

- Human Computer Interaction (AREA)

- Physics & Mathematics (AREA)

- Computational Linguistics (AREA)

- Quality & Reliability (AREA)

- Artificial Intelligence (AREA)

- Evolutionary Computation (AREA)

- Stereophonic System (AREA)

- Circuit For Audible Band Transducer (AREA)

- Tone Control, Compression And Expansion, Limiting Amplitude (AREA)

- Control Of Amplification And Gain Control (AREA)

- Measurement Of Mechanical Vibrations Or Ultrasonic Waves (AREA)

Abstract

São divulgados um controlador de nivelador de volume e um método de controle. Em uma modalidade, um controlador de nivelador de volume inclui um classificador de conteúdo de áudio para identificar o tipo de conteúdo de um sinal de áudio em tempo real; e uma unidade de ajuste para ajustar um nivelador de volume de maneira contínua com base no tipo de conteúdo tal como identificado. A unidade de ajuste pode ser configurada para correlacionar positivamente o ganho dinâmico do nivelador de volume com tipos informativos de conteúdo do sinal de áudio, e correlacionar negativamente o ganho dinâmico do nivelador de volume com tipos interferentes de conteúdo de sinal de áudio.

Description

[001] Este pedido reivindica prioridade ao Pedido de Patente chinês N° 201310100422.1, depositado em 26 de março de 2013 e ao Pedido de Patente Provisória dos Estados Unidos N° 61/811.072, depositado em 11 de abril de 2013, cada um deles sendo incorporado aqui por referência em sua totalidade.

[002] O presente pedido refere-se, de modo geral, a um processamento de sinal de áudio. Especificamente, as modalidades do presente pedido se relacionam a aparelhos e métodos para classificação e processamento de áudio, especialmente para controlar o otimizador de diálogo, o virtualizador de surround, o nivelador de volume e o equalizador.

[003] Alguns dispositivos de melhoria de áudio tendem a modificar os sinais de áudio, em domínio temporal ou espectral, para melhorar a qualidade geral do áudio e aperfeiçoar a experiência dos usuários de maneira correspondente. Vários dispositivos de melhoria de áudio foram desenvolvidos para várias finalidades. Alguns exemplos típicos de dispositivos de melhoria de áudio incluem:

[004] Otimizador de diálogo: O diálogo é o componente mais importante em um programa de rádio ou TV para compreender a história. Métodos foram desenvolvidos para otimizar os diálogos a fim de aumentar sua clareza e inteligibilidade, sobretudo para idosos com capacidade auditiva decrescente.

[005] Virtualizador de surround: Um virtualizador de surround possibilita que um sinal de som surround (multicanais) seja distribuído aos alto-falantes internos do PC ou nos fones de ouvido. Isto é, com o dispositivo estéreo (como alto-falantes ou fones de ouvido), ele cria um efeito surround virtualmente e proporciona uma experiência cinemática aos consumidores.

[006] Nivelador de volume: Um nivelador de volume direciona-se ao ajuste do volume do conteúdo de áudio em playback e mantê-lo praticamente consistente ao longo de um período de tempo com base no valor alvo de intensidade.

[007] Equalizador: Um equalizador fornece consistência de balanceamento espectral, mais conhecida como "tom" ou "timbre", e permite que os usuários configurem o perfil geral (curva ou formato) da resposta de frequência (ganho) em cada banda de frequência individual, a fim de enfatizar determinados sons ou remover sons indesejados. Em um equalizador tradicional, diferentes pré-ajustes do equalizador podem ser proporcionados a diferentes sons, como gêneros musicais diferentes. A partir do momento em que o pré-ajuste é selecionado, ou que um perfil de equalização é estabelecido, os mesmos ganhos de equalização serão aplicados ao sinal até que o perfil de equalização seja modificado manualmente. Em contraste, um equalizador dinâmico atinge uma consistência de balanceamento espectral pelo monitoramento constante do balanceamento espectral do áudio, comparando-o a um tom desejado e ajustando dinamicamente um filtro de equalização para transformar o tom original do áudio em um tom desejado.

[008] Em geral, dispositivos de melhoria de áudio têm seu próprio contexto/cenário de aplicação. Isto é, um dispositivo de melhoria de áudio pode ser apropriado para apenas uma determinada série de conteúdos, mas não para todos os sinais de áudio possíveis, pois diferentes conteúdos podem precisar ser processados de maneiras diferentes. Por exemplo, um método de otimização de diálogo costuma ser aplicado ao conteúdo do filme. Se for aplicado à música em que não existem diálogos, pode impulsionar falsamente algumas subbandas de frequência e inserir pesadas mudanças de timbre e inconsistência perceptual. De maneira similar, se um método de supressão de ruído for aplicado aos sinais da música, fortes artefatos serão audíveis.

[009] Entretanto, para um sistema de processamento de áudio que geralmente compreende uma série de dispositivos de melhoria de áudio, sua entrada poderia ser inevitavelmente de todos os tipos possíveis de sinais de áudio. Por exemplo, um sistema de processamento de áudio, integrado em um PC, receberá o conteúdo de áudio de uma variedade de fontes, incluindo filmes, músicas, VoIP e jogos. Assim, identificar ou diferenciar o conteúdo a ser processado se torna importante para aplicar melhores algoritmos ou melhores parâmetros de cada algoritmo ao conteúdo correspondente.

[0010] A fim de diferenciar o conteúdo de áudio e aplicar melhores parâmetros ou melhores algoritmos de melhora de áudio, de maneira correspondente, os sistemas tradicionais costumam pré-projetar uma série de pré-ajustes e solicita-se que os usuários selecionem um pré- ajuste para o conteúdo a ser tocado. Um pré-ajuste geralmente codifica uma série de algoritmos de melhoria de áudio e/ou seus melhores parâmetros que serão aplicados, como pré-ajuste "Filme" e um pré-ajuste "Música" que é projetado especificamente para um filme ou playback de música.

[0011] Todavia, a seleção manual é inconveniente para os usuários. Os usuários, em geral, não alternam com frequência entre os pré-ajustes predefinidos, mas simplesmente mantêm-se usando um pré-ajuste para todo o conteúdo. Além disso, mesmo em algumas soluções automáticas, os parâmetros ou a configuração de algoritmos nos pré-ajustes são geralmente discretas (como ligar ou desligar em um algoritmo específico em relação a um conteúdo específico), eles não podem ajustar parâmetros de uma maneira contínua com base no conteúdo.

[0012] O primeiro aspecto do presente pedido é configurar automaticamente os dispositivos de melhoria de áudio de uma maneira contínua, com base no conteúdo de áudio no playback. Com esse modo "automático", os usuários podem simplesmente aproveitar o conteúdo sem se preocupar em selecionar diferentes pré-ajustes. Por um lado, um ajuste contínuo é mais importante para evitar artefatos audíveis em pontos de transição.

[0013] De acordo com uma modalidade do primeiro aspecto, um aparelho de processamento de áudio inclui um classificador de áudio para classificar um sinal de áudio em pelo menos um tipo de áudio em tempo real; um dispositivo de melhoria de áudio para melhorar a experiência da audiência; e uma unidade de ajuste para ajustar pelo menos um parâmetro do dispositivo de melhoria de áudio de uma maneira contínua com base no valor de confiança de um tipo de áudio.

[0014] O dispositivo de melhoria de áudio pode ser qualquer otimizador de diálogo, visualizador surround, nivelador de volume e equalizador.

[0015] De maneira correspondente, um método de processamento de áudio inclui: classificar um sinal de áudio em pelo menos um tipo de áudio em tempo real; e ajustar pelo menos um parâmetro para a melhora de áudio de maneira contínua com base no valor de confiança de pelo menos um tipo de áudio.

[0016] De acordo com uma outra modalidade do primeiro aspecto, um controlador de nivelador de volume inclui um classificador de conteúdo de áudio para identificar o tipo de conteúdo de um sinal de áudio em tempo real; e uma unidade de ajuste para ajustar um nivelador de volume de maneira contínua com base no tipo de conteúdo, conforme identificado. A unidade de ajuste pode ser configurada para se correlacionar de maneira coletiva a um ganho dinâmico do nivelador de volume com tipos de conteúdo informativo do sinal de áudio e correlacionar negativamente o ganho dinâmico do nivelador de volume com os tipos de conteúdo de interferência do sinal de áudio.

[0017] É divulgado, ademais, um aparelho de processamento de áudio que compreende um controlador de nivelador de volume, conforme afirmado acima.

[0018] De maneira correspondente, um método de controle do nivelador de volume inclui: a identificação do tipo de conteúdo de um sinal de áudio em tempo real; e o ajuste de um nivelador de volume de maneira contínua com base no tipo de conteúdo, conforme identificado, pela correlação positiva do ganho dinâmico do nivelador de volume com os tipos de conteúdo informativo do sinal de áudio e pela correlação negativa do ganho dinâmico do nivelador de volume com os tipos de conteúdo de interferência do sinal de áudio.

[0019] De acordo com outra modalidade do primeiro aspecto, ainda, um controlador de equalizador inclui um classificador de áudio para identificar o tipo de áudio de um sinal de áudio em tempo real; e uma unidade de ajuste para ajustar um equalizador de uma maneira contínua com base no valor de confiança do tipo de áudio, conforme identificado.

[0020] É divulgado, ademais, um aparelho de processamento de áudio que compreende um controlador de equalizador, conforme afirmado acima.

[0021] De maneira correspondente, um método de controle de equalizador inclui: identificar um tipo de áudio de um sinal de áudio em tempo real; e uma unidade de ajuste para ajustar um equalizador de uma maneira contínua com base no valor de confiança do tipo de áudio, conforme identificado.

[0022] O presente pedido fornece ainda um meio legível em computador com instruções de programa de computador gravadas nele, quando executado por um processador, as instruções permitindo que o processador execute o método de processamento de áudio supracitado, ou o método de controle do nivelador de volume, ou o método de controle do equalizador.

[0023] De acordo com as modalidades do primeiro aspecto, o dispositivo de melhoria de áudio, que pode ser: o otimizador de diálogo, o virtualizador de surround, o nivelador de volume e o equalizador, pode ser ajustado continuamente de acordo com o tipo de sinal de áudio e/ou o valor de confiança do tipo.

[0024] O segundo aspecto do presente pedido é desenvolver um componente de identificação de conteúdo para identificar múltiplos tipos de áudio, e os resultados detectados podem ser usados para controlar/orientar os comportamentos de vários dispositivos de melhoria de áudio, encontrando melhores parâmetros de maneira contínua.

[0025] De acordo com uma modalidade do segundo aspecto, um classificador de áudio inclui: um extrator de recursos de curta duração para extrair recursos de curta duração de segmentos de áudio de curta duração, cada um compreendendo uma sequência de frames de áudio; um classificador de curta duração para classificar uma sequência de segmentos de curta duração em um segmento de áudio de longa duração em tipos de áudio de curta duração utilizando seus respectivos recursos de curta duração; um extrator de estatísticas para calcular as estatísticas dos resultados do classificador de curta duração em relação à sequência de segmentos de curta duração no segmento de áudio de longa duração, como recursos de longa duração; e um classificador de longa duração para classificar, usando recursos de longa duração, o segmento de áudio de longa duração em tipos de áudio de longa duração.

[0026] É divulgado também um aparelho de processamento de áudio que compreende um classificador de áudio, como indicado acima.

[0027] De maneira correspondente, um método de classificação de áudio inclui: a extração de recursos de curta duração de segmentos de áudio de curta duração, cada um compreendendo uma sequência de frames de áudio; a classificação de uma sequência de segmentos de curta duração em um segmento de áudio de longa duração em tipos de áudio de curta duração utilizando os respectivos recursos de curta duração; o cálculo das estatísticas dos resultados da operação de classificação em relação à sequência de segmentos de curta duração no segmento de áudio de longa duração, como recursos de longa duração; e a classificação do segmento de áudio de longa duração em tipos de áudio de longa duração utilizando os recursos de longa duração.

[0028] De acordo com outra modalidade do segundo aspecto, um classificador de áudio inclui: um classificador de conteúdo de áudio para identificar o tipo de conteúdo de um segmento de curta duração de um sinal de áudio e um classificador de contexto de áudio para identificar um tipo de contexto do segmento de curta duração pelo menos parcialmente com base no tipo de contexto identificado pelo classificador do conteúdo de áudio.

[0029] É divulgado, ademais, um aparelho de processamento de áudio que compreende um classificador de áudio, conforme indicado acima.

[0030] De maneira correspondente, um método de classificação de áudio inclui: a identificação de um tipo de conteúdo de um segmento de curta duração de um sinal de áudio; e a identificação de um tipo de contexto do segmento de curta duração, pelo menos parcialmente com base no tipo de conteúdo, conforme identificado.

[0031] O presente pedido fornece ainda um meio legível em computador com instruções de programa de computador gravadas nele, quando executado por um processador, as instruções permitindo que o processador execute os métodos de classificação de áudio supramencionados.

[0032] De acordo com as modalidades do segundo aspecto, um sinal de áudio pode ser classificado em diferentes tipos de contexto ou de longa duração, que são diferentes dos tipos de conteúdo ou de curta duração. Os tipos de sinal de áudio e/ou o valor de confiança dos tipos podem ser utilizados ainda para ajustar um dispositivo de melhoria de áudio, como um otimizador de diálogo, um virtualizador de surround, um nivelador de volume ou um equalizador. Breve Descrição das Figuras

[0033] O presente pedido é ilustrado a título de exemplo, e não a título de limitação, nas figuras das ilustrações em anexo, em que numerais de referência semelhantes se referem a elementos semelhantes e em que:

[0034] A Figura 1 é um diagrama que ilustra um aparelho de processamento de áudio, de acordo com uma modalidade do pedido;

[0035] As Figuras 2 e 3 são diagramas que ilustram variantes da modalidade, como mostrado na Figura 1;

[0036] As Figuras 4-6 são diagramas que ilustram a possível arquitetura dos classificadores para identificar múltiplos tipos de áudio e o cálculo do valor de confiança;

[0037] As Figuras 7-9 são diagramas que ilustram mais modalidades do aparelho de processamento de áudio do presente pedido;

[0038] A Figura 10 é um diagrama que ilustra uma transição entre diferentes tipos de áudio;

[0039] As Figuras 11-14 são fluxogramas que ilustram um método de processamento de áudio de acordo com modalidades do presente pedido;

[0040] A Figura 15 é um diagrama que ilustra um controlador de otimizador de diálogo de acordo com uma modalidade do presente pedido;

[0041] As Figuras 16 e 17 são fluxogramas que ilustram o uso do método de processamento de áudio de acordo com o presente pedido no controle de um otimizador de diálogo;

[0042] A Figura 18 é um diagrama que ilustra um controlador do virtualizador de surround, de acordo com uma modalidade do presente pedido;

[0043] A Figura 19 é um fluxograma que ilustra o uso do método de processamento de áudio, de acordo com o presente pedido, no controle de um virtualizador de surround;

[0044] A Figura 20 é um diagrama que ilustra um controlador de nivelador de volume, de acordo com uma modalidade do presente pedido;

[0045] A Figura 21 é um diagrama que ilustra o efeito do controlador de nivelador de volume, de acordo com o presente pedido;

[0046] A Figura 22 é um diagrama que ilustra um controlador de equalizador, de acordo com uma modalidade do presente pedido;

[0047] A Figura 23 ilustra diversos exemplos de pré-ajustes de balanceamento espectral desejados;

[0048] A Figura 24 é um diagrama que ilustra um classificador de áudio, de acordo com uma modalidade do presente pedido;

[0049] As Figuras 25 e 26 são diagramas que ilustram alguns recursos a serem usados pelo classificador de áudio do presente pedido;

[0050] As Figuras 27-29 são diagramas que ilustram mais modalidades do classificador de áudio, de acordo com o presente pedido;

[0051] As Figuras 30-33 são fluxogramas que ilustram um método de classificação de áudio de acordo com modalidades do presente pedido;

[0052] A Figura 34 é um diagrama que ilustra um classificador de áudio, de acordo com outra modalidade do presente pedido;

[0053] A Figura 35 é um diagrama que ilustra um classificador de áudio, de acordo com outra modalidade do presente pedido, ainda;

[0054] A Figura 36 é um diagrama que ilustra as normas heurísticas usadas no classificador de áudio do presente pedido;

[0055] As Figuras 37 e 38 são diagramas que ilustram mais modalidades do classificador de áudio, de acordo com o presente pedido;

[0056] As Figuras 39 e 40 são fluxogramas que ilustram um método de classificação de áudio de acordo com modalidades do presente pedido;

[0057] A Figura 41 é um diagrama de blocos que ilustra um sistema exemplar para implementar modalidades do presente pedido. Descrição Detalhada

[0058] As modalidades do presente pedido são descritas abaixo referindo-se às figuras. Deve ser notas que, para fins de clareza, as representações e descrições quanto a esses componentes e processos conhecidos por aqueles versados na técnica, mas não necessárias para compreender o presente pedido, são omitidas nas figuras e na descrição.

[0059] Como será apreciado por uma pessoa versada na técnica, os aspectos do presente pedido podem ser incorporados como um sistema, um dispositivo (por exemplo, um telefone celular, um reprodutor de mídia portátil, um computador pessoal, um servidor, um set-top box de televisão ou um gravador de vídeo digital, ou qualquer outro reprodutor de mídia), um método ou um produto de programa de computador. Com efeito, os aspectos do presente pedido podem assumir a forma de uma modalidade de hardware, uma modalidade de software (incluindo firmware, software residente, microcódigos, etc.) ou uma modalidade combinando aspectos de software e hardware que podem todos, de maneira geral, ser referidos aqui como "circuito", "módulo" ou "sistema". Além disso, os aspectos do presente pedido podem assumir a forma de um produto de programa de computador incorporado em um ou mais meios legíveis em computador com um código de programa legível em computador a eles acoplados.

[0060] Qualquer combinação de um ou mais meios legíveis em computador pode ser utilizada. O meio legível em computador pode ser um meio de sinal legível em computador ou um meio de armazenamento legível em computador. Um meio de armazenamento legível por computador pode ser, por exemplo, mas sem se limitar a, um sistema, aparelho ou dispositivo eletrônico, magnético, óptico, eletromagnético, infravermelho, ou de semicondutores, ou qualquer combinação adequada dos supracitados. Exemplos mais específicos (uma lista não exaustiva) de meio de armazenamento legível por computador incluem o seguinte: uma conexão elétrica que tem um ou mais fios, um disquete de computador portátil, um disco rígido, uma memória de acesso aleatório (RAM), uma memória somente leitura (ROM), uma memória programável apagável somente de leitura (EPROM ou memória Flash), uma fibra óptica, uma disco compacto portátil somente de leitura (CD-ROM), um dispositivo de armazenamento óptico, um dispositivo de armazenamento magnético, ou qualquer combinação adequada dos anteriores. No contexto deste documento, um meio de armazenamento legível em computador pode ser qualquer meio tangível que possa conter ou armazenar um programa para uso por um em conexão com um dispositivo, aparelho ou sistema de execução de instruções.

[0061] Um meio de sinal legível em computador pode incluir um sinal de dados propagado com um código de programa legível em computador a ele incorporado, por exemplo, em banda de base ou como parte de uma onda de transportadora. Esse sinal propagado pode assumir qualquer uma dentre uma variedade de formas, incluindo, sem se limitar a, um sinal ótico ou eletromagnético ou qualquer combinação apropriada destes.

[0062] Um meio de sinal legível em computador pode ser qualquer meio legível em computador que não seja um meio de armazenamento legível em computador e possa comunicar, propagar ou transportar um programa para uso por ou em conexão com um dispositivo, aparelho ou sistema de execução de instruções.

[0063] O código de programa incorporado a um meio legível em computador pode ser transmitindo utilizando qualquer meio apropriado, incluindo, sem se limitar a, cabo de fibra ótica, RF, linha com fio, sem fio, etc., ou qualquer combinação apropriada destes.

[0064] O código do programa de computador para realizar operações para os aspectos do presente pedido pode ser escrito em qualquer combinação de uma ou mais linguagens de programação, incluindo uma linguagem de programação orientada para o objeto, como Java, Smalltalk, C++ ou afins e linguagens de programação processuais convencionais, como linguagem de programação "C" ou linguagens de programação semelhantes. O código do programa pode executar inteiramente no computador do usuário como um pacote de software autônomo ou parcialmente no computador do usuário e parcialmente em um computador remoto ou inteiramente no servidor ou computador remoto. No último cenário, o computador remoto pode estar conectado ao computador do usuário através de qualquer tipo de rede, incluindo uma rede de área local (LAN) ou uma rede de longa distância (WAN), ou a conexão pode ser feita para um computador externo (por exemplo, através da Internet usando um Provedor de Serviços de Internet).

[0065] Os aspectos do presente pedido encontram-se descritos abaixo com referência às ilustrações do fluxograma e/ou aos diagramas de bloco dos métodos, aparelhos (sistemas) e produtos de programa de computador de acordo com modalidades do pedido. Será entendido que cada bloco (também referido como bloco) do das ilustrações do fluxograma e/ou diagramas de bloco e as combinações de blocos nas ilustrações do fluxograma e/ou diagramas de bloco pode ser implementado por instruções de programa legíveis por computador. Estas instruções de programa de computador podem ser fornecidas a um processador de um computador com finalidade geral, computador com finalidade especial, ou outro aparelho de processamento de dados programáveis para produzir uma máquina, de modo que as instruções, que executam via processador do computador ou outro aparelho de processamento de dados programáveis, criam meios para a implementação de funções/atos especificados no fluxograma e/ou no bloco ou nos blocos do diagrama de bloco.

[0066] Essas instruções de programa de computador também podem ser armazenadas em um meio legível em computador que pode direcionar um computador, outros aparelhos de processamento de dados programáveis ou outros dispositivos para funcionar de um jeito específico, de modo que as instruções armazenadas no meio legível em computador produzam um artigo de produção incluindo instruções que implementem a função/o ato especificado no fluxograma e/ou no bloco ou blocos do diagrama de bloco.

[0067] As instruções de programa de computador podem também ser carregadas em um computador, outros aparelhos de processamento de dados, ou outros dispositivos para fazer com que uma série de operações operacionais seja realizada no computador, outros aparelhos ou dispositivos para produzir um processo implementado por computador, de modo que as instruções executadas no computador ou outros aparelhos programáveis forneçam processos para implementar funções/atos especificados no fluxograma e/ou blocos ou bloco do diagrama de bloco.

[0068] Abaixo serão descritas em detalhes as modalidades do presente pedido. Para maior clareza, a descrição é organizada na seguinte arquitetura:

[0069] Parte 1: Aparelhos e métodos de processamento de áudio

[0070] Seção 1.1 Tipos de áudio

[0071] Seção 1.2 Valores de confiança de tipos de áudio e arquitetura dos classificadores Seção 1.3 Unificação dos valores de confiança dos tipos de áudio

[0072] Seção 1.4 Ajuste de parâmetro

[0073] Seção 1.5 Uniformização de parâmetro

[0074] Seção 1.6 Transição de tipos de áudio

[0075] Seção 1.7 Combinação das modalidades e cenários de aplicação

[0076] Seção 1.8 Método de processamento de áudio

[0077] Parte 2: Controlador do otimizador de diálogo e método de controle

[0078] Seção 2.1 Nível de otimização do diálogo

[0079] Seção 2.2 Limites para determinar bandas de frequência a serem potencializadas

[0080] Seção 2.3 Ajuste ao nível de fundo

[0081] Seção 2.4 Combinação das modalidades e cenários de aplicação

[0082] Seção 2.5 Método de controle do otimizador de diálogo

[0083] Parte 3: Controlador do Virtualizador de surround e Método de Controle

[0084] Seção 3.1 Quantidade de Aumento de Surround

[0085] Seção 3.2 Frequência inicial

[0086] Seção 3.3 Combinação das modalidades e cenários de aplicação

[0087] Seção 3.4 Método de controle do virtualizador de surround

[0088] Parte 4: Controlador do nivelador de volume e método de controle

[0089] Seção 4.1 Tipos informativos de conteúdo de intervenção

[0090] Seção 4.2 Tipos de conteúdo em diferentes contextos

[0091] Seção 4.3 Tipos de contexto

[0092] Seção 4.4 Combinação das modalidades e cenários de aplicação

[0093] Seção 4.5 Método de controle do nivelador de volume

[0094] Parte 5: Controlador do equalizador e método de controle

[0095] Seção 5.1 Controle com base no tipo de conteúdo

[0096] Seção 5.2 Probabilidade de fontes dominantes na música

[0097] Seção 5.3 Pré-ajustes do equalizador

[0098] Seção 5.4 Controle com base no tipo de contexto

[0099] Seção 5.5 Combinação das modalidades e cenários de aplicação

[00100] Seção 5.6 Método de controle do equalizador

[00101] Parte 6: Classificadores de áudio e métodos de classificação

[00102] Seção 6.1 Classificador de contexto com base na classificação do tipo de conteúdo

[00103] Seção 6.2 Extração de característica de longa duração

[00104] Seção 6.3 Extração de características de curta duração

[00105] Seção 6.4 Combinação das modalidades e cenários de aplicação

[00106] Seção 6.5 Métodos de classificação de áudio

[00107] Parte 7: Classificadores de VoIP e métodos de classificação

[00108] Seção 7.1 Classificação de contexto com base no segmento de curta duração

[00109] Seção 7.2 Classificação usando fala de VoIP e ruído VoIP

[00110] Seção 7.3 Flutuação de uniformização

[00111] Seção 7.4 Combinação das modalidades e cenários de aplicação

[00112] Seção 7.5 Métodos de classificação de VoIP

[00113] Parte 1: Aparelho de processamento de áudio e métodos

[00114] A Figura 1 ilustra uma estrutura geral de um aparelho de processamento de áudio adaptativo ao conteúdo 100 que suporta uma configuração automática de pelo menos um dispositivo de melhoria de áudio 400 com parâmetros melhorados com base no conteúdo de áudio em playback. Ela compreende três componentes principais: um classificador de áudio 200, uma unidade de ajuste 300 e um dispositivo de melhoria de áudio 400.

[00115] O classificador de áudio 200 é para classificar um sinal de áudio em pelo menos um tipo de áudio em tempo real. Ele identifica automaticamente os tipos de áudio do conteúdo em playback. Qualquer uma das tecnologias de classificação de áudio, como através de processamento de sinal, aprendizagem de máquina e reconhecimento de padrão, podem ser aplicadas para identificar o conteúdo de áudio. Os valores de confiança, que representam as probabilidades do conteúdo de áudio quanto a uma série de tipos de áudio alvo pré-definidos, são estimados realmente ao mesmo tempo.

[00116] O dispositivo de melhoria de áudio 400 é para melhorar a experiência da audiência, realizando um processamento sobre o sinal de áudio, e será discutido em detalhes posteriormente.

[00117] A unidade de ajuste 300 é para ajustar pelo menos um parâmetro do dispositivo de melhoria de áudio de uma maneira contínua com base no valor de confiança de pelo menos um tipo de áudio. Ela é projetada para controlar o comportamento do dispositivo de melhoria de áudio 400. Ela estima os parâmetros mais apropriados do dispositivo de melhoria de áudio correspondente com base nos resultados obtidos a partir do classificador de áudio 200.

[00118] Vários dispositivos de melhoria de áudio podem ser aplicados nesse aparelho. A Figura 2 mostra um sistema de exemplo que compreende quatro dispositivos de melhoria de áudio, incluindo o otimizador de Diálogo (DE) 402, o Virtualizador Surround (SV) 404, o Nivelador de Volume (VL) 406 e o Equalizador (EQ) 408. Cada dispositivo de melhoria de áudio pode ser ajustado automaticamente de maneira contínua, com base nos resultados (valores de confiança e/ou tipos de áudio) obtidos no classificador de áudio 200.

[00119] Naturalmente, o aparelho de processamento de áudio pode não incluir, necessariamente, todos os tipos de dispositivos de melhoria de áudio, mas pode incluir apenas um ou mais deles. Por outro lado, os dispositivos de melhoria de áudio não são limitados àqueles dispositivos fornecidos na presente divulgação e podem incluir mais tipos de dispositivos de melhoria de áudio que também fazem parte do escopo do presente pedido. Além disso, os nomes daqueles dispositivos de melhoria de áudio discutidos na presente divulgação, incluindo otimizador de Diálogo (DE) 402, Virtualizador surround (SV) 404, Nivelador de Volume (VL) 406 e Equalizador (EQ) 408, não devem constituir uma limitação e cada um deles deve ser considerado como abrangendo quaisquer outros dispositivos que realizam funções semelhantes ou as mesmas funções. 1.1 Tipos de áudio

[00120] Para controlar corretamente vários tipos de dispositivo de melhoria de áudio, o presente pedido fornece ainda uma nova arquitetura de tipos de áudio, ainda que esses tipos de áudio do estado da técnica também sejam aplicáveis aqui.

[00121] Especificamente, os tipos de áudio de diferentes níveis semânticos são modelos, incluindo elementos de áudio de nível baixo que representam os componentes fundamentais nos sinais de áudio e nos gêneros de áudio de nível alto que representam os conteúdos de áudio mais populares nas aplicações de entretenimento do usuário na vida real. O anterior também pode ser denominado "tipo de conteúdo". Os tipos de conteúdo de áudio fundamentais podem incluir fala, música (incluindo sons), sons de fundo (ou efeitos sonoros) e ruídos.

[00122] O significado de fala e músicas é auto-evidente. O ruído no presente pedido significa ruído físico, não ruído semântico. O ruído físico no presente pedido pode incluir os ruídos, por exemplo, de ar condicionados e aqueles ruídos que se originam de motivos técnicos, como ruídos rosas por conta da passagem de transmissão de sinal. Em contraste, os "sons de fundo" no presente pedido são aqueles efeitos sonoros que podem ser eventos auditivos que ocorrem em torno do alvo principal da atenção do ouvinte. Por exemplo, em um sinal de áudio em uma ligação telefônica, além da voz de quem fala, também pode haver outros sons não intencionais, como vozes de outras pessoas irrelevantes para a ligação telefônica, sons de teclado, sons de passos e assim por diante. Esses sons indesejados são referidos como "sons de fundo", não ruídos. Em outras palavras, pode- se definir "sons de fundo" como aqueles sons que não são o alvo (ou o alvo principal da atenção do ouvinte), ou mesmo não desejados, mas que ainda têm valor semântico; enquanto que "ruídos" podem ser definidos como sons indesejados, exceto pelos sons alvo e pelos sons de fundo.

[00123] Às vezes os sons do fundo são realmente não "indesejados"< mas criados intencionalmente e portam algumas informações úteis, como aqueles sons de fundo em um filme, programa de TV ou programa de rádio. Assim, às vezes eles também podem ser definidos como "efeitos sonoros". Doravante, na presente divulgação, apenas "sons de fundo" é usado por questão de concisão e pode ser abreviado ainda como "fundo".

[00124] Ademais, a música pode ser classificada ainda como música sem fontes dominantes e música com fontes dominantes. Se houver uma fonte (voz ou um instrumento) que é muito mais intensa do que as outras fontes em uma parte da música, ela é denominada "música com fonte dominante"; do contrário, ela é denominada "música sem fonte dominante". Por exemplo, em uma música polifônica acompanhada de vocal e vários instrumentos, se estiver harmonicamente equilibrado, ou a energia de várias fontes mais salientes forem comparáveis umas às outras, considera-se uma música sem fonte dominante; em contraste, se uma fonte (por exemplo, voz) for muito mais alta e as outras forem muito mais baixas, considera-se que contém uma fonte dominante. Como um outro exemplo, os tons de instrumentos singulares e distintivos são "músicas com fonte dominante".

[00125] A música pode ser classificada ainda como diferentes tipos com base em diferentes padrões. Pode ser classificado com base nos gêneros da música, como rock, jazz, rap e folk, mas não se limita a estes. Pode também ser classificado com base nos instrumentos, como música vocal e instrumental. A música instrumental pode incluir várias músicas reproduzidas com diferentes instrumentos, como piano e violão. Outros padrões exemplificativos incluem ritmo, tempo, timbre da música e/ou qualquer outro atributo musical, de modo que a música possa ser agrupada com base na semelhança de tais atributos. Por exemplo, de acordo com o timbre, o vocal pode ser classificado como tenor, barítono, baixo, soprano, mezzo soprano e alto.

[00126] O tipo de conteúdo de um sinal de áudio pode ser classificado em relação aos segmentos de áudio de curta duração, como compreendido em uma pluralidade de frames. Geralmente, um frame de áudio é uma extensão de múltiplos milissegundos, como 20 ms, e a extensão de um segmento de áudio de curta duração a ser classificado pelo classificador de áudio pode ter uma extensão de várias centenas de milissegundos a vários segundos, como 1 segundo.

[00127] Para controlar o dispositivo de melhoria de áudio de uma maneira adaptativa ao conteúdo, o sinal de áudio pode ser classificado em tempo real. Para o tipo de conteúdo indicado acima, o tipo de conteúdo do presente segmento de áudio de curta duração representa o tipo de conteúdo do presente sinal de áudio. Visto que a extensão de um segmento de áudio de curta duração não é muito longa, o sinal de áudio pode ser dividido como segmentos de áudio de curta duração não-sobrepostos, um após o outro. Entretanto, os segmentos de áudio de curta duração também podem ser amostrados continuamente/semi- continuamente ao longo da linha de tempo do sinal de áudio. Isto é, os segmentos de áudio de curta duração podem ser amostrados com uma janela com uma extensão pré-determinada (extensão pretendida do segmento de áudio de curta duração) que se move ao longo da linha de tempo do sinal de áudio a um tamanho de etapa de um ou mais frames.

[00128] Os gêneros de áudio de nível elevado podem ser denominados "tipo de contexto", pois indicam um tipo de longa duração do sinal de áudio e podem ser considerados um ambiente ou contexto do evento sonoro do momento, o qual pode ser classificado em tipos de conteúdo, como indicado acima. De acordo com o presente pedido, o tipo de contexto pode incluir as aplicações de áudio mais populares, como mídias do tipo filme, músicas (incluindo sons), jogos e VoIP (Voice on Internet Protocol).

[00129] O significado de músicas, jogos e VoIP é auto-evidente. As mídias do tipo filme podem incluir filmes, programas de TV, programas de rádio ou qualquer outra mídia de áudio semelhante supramencionada. A característica principal das mídias do tipo filme é uma mistura de possíveis falas, músicas e vários tipos de sons de fundo (efeitos sonoros).

[00130] Pode-se notar que o tipo de conteúdo e o tipo de contexto incluem músicas (incluindo sons). Doravante, no presente pedido, foram utilizados, os termos "músicas de curta duração" e "músicas de longa duração" para distingui-las, respectivamente.

[00131] Para algumas modalidades do presente pedido, algumas outras arquiteturas de tipo de contexto são propostas.

[00132] Por exemplo, um sinal de áudio pode ser classificado como áudio de alta qualidade (como mídias do tipo filme e CDs de música) ou áudio de baixa qualidade (como VoIP, áudio de streaming online de taxa de bits baixa e conteúdo gerado por usuário), que pode ser coletivamente denominado "tipos de qualidade de áudio".

[00133] Como outro exemplo, um sinal de áudio pode ser classificado como VoIP e não-VoIP, que pode ser considerado como uma transformação na arquitetura de tipo de 4 contextos mencionada acima (VoIP, mídias do tipo filme, músicas (de longa duração) e jogos). Em relação ao contexto de VoIP ou de non-VoIP, um sinal de áudio pode ser classificado como tipos de conteúdo de áudio relacionado a VoIP, como fala em VoIP, fala não-VoIP, ruído VoIP e ruído não-VoIP. A arquitetura de tipos de conteúdo de áudio em VoIP é especialmente útil para diferenciar contextos VoIP e não-VoIP, visto que o contexto VoIP geralmente é o cenário de aplicação mais desafiador de um nivelador de volume (um tipo de dispositivo de melhoria de áudio).

[00134] Geralmente, o tipo de contexto de um áudio de sinal pode ser classificado em relação a segmentos de áudio de longa duração mais longos do que os segmentos de áudio de curta duração. Um segmento de áudio de longa duração é compreendido de uma pluralidade de frames em uma quantidade superior à quantidade de frames em um segmento de áudio de curta duração. Um segmento de áudio de longa duração também pode ser compreendido de uma pluralidade de segmentos de áudio de curta duração. Geralmente, um segmento de áudio de longa duração pode ter uma extensão na ordem de segundos, como de vários segundos a dezenas de segundos, por exemplo, 10 segundos.

[00135] Para controlar o dispositivo de melhoria de áudio de uma maneira adaptativa, o sinal de áudio pode ser classificado em tipos de contexto em tempo real. De modo semelhante, o tipo de contexto do presente segmento de áudio de longa duração representa o tipo de contexto do presente sinal de áudio. Visto que a extensão de um segmento de áudio de longa duração é relativamente longa, o sinal de áudio pode ser amostrado continuamente/semi-continuamente ao longo da linha de tempo do sinal de áudio para evitar uma mudança abrupta de seu tipo de contexto e, portanto, uma mudança abrupta dos parâmetros de funcionamento do(s) dispositivo(s) de melhoria de áudio. Isto é, os segmentos de áudio de longa duração podem ser amostrados com uma janela com uma extensão pré-determinada (extensão pretendida do segmento de áudio de longa duração) que se move ao longo da linha de tempo do sinal de áudio a um tamanho de etapa de um ou mais frames ou de um ou mais segmentos de curta duração.

[00136] Acima, foram descritos o tipo de conteúdo e o tipo de contexto. Nas modalidades do presente pedido, a unidade de ajuste 300 pode ajustar pelo menos um parâmetro do(s) dispositivo(s) de melhoria de áudio com base em pelo menos um dentre vários tipos de conteúdo e/ou pelo menos um dentre vários tipos de contexto. Consequentemente, como mostrado na Figura 3, em uma variante da modalidade mostrada na Figura 1, o classificador de áudio 200 pode compreender um classificador de conteúdo de áudio 202 ou um classificador de contexto de áudio 204, ou ambos.

[00137] Foram mencionados acima diferentes tipos de áudio com base em diferentes padrões (como para os tipos de contexto), bem como diferentes tipos de áudio em diferentes níveis hierárquicos (como para os tipos de conteúdo). Entretanto, os padrões e os níveis hierárquicos são apenas para a conveniência da presente descrição e definitivamente não são limitadores. Em outras palavras, no presente pedido, qualquer um dentre dois ou mais tipos de áudio supramencionados podem ser identificados pelo classificador de áudio 200 ao mesmo tempo e ser considerados pela unidade de ajuste 300 ao mesmo tempo, conforme será descrito posteriormente. Em outras palavras, todos os tipos de áudio em diferentes níveis hierárquicos podem ser paralelos ou estar no mesmo nível. 1.2 Valores da confiança de tipos de áudio e arquitetura dos classificadores

[00138] O classificador de áudio 200 pode enviar os resultados de decisão complicada ou a unidade de ajuste 300 pode considerar os resultados do classificador de áudio 200 como resultados de decisão complicada. Mesmo para a decisão complicada, os múltiplos tipos de áudio podem ser atribuídos a um segmento de áudio. Por exemplo, um segmento de áudio pode ser rotulado como "fala" e "música de curta duração", visto que pode ser um sinal de mistura de fala ou de música de curta duração. Os rótulos obtidos podem ser usados diretamente para controlar o(s) dispositivo(s) de melhoria de áudio 400. Um exemplo simples é ativar o otimizador de diálogo 402 quando houver fala e desligá-lo quando não houver fala. Entretanto, esse método de decisão complicada pode trazer certa artificialidade nos pontos de transição de um tipo de áudio a outro, se não houver um esquema cauteloso de uniformização (que será discutido posteriormente).

[00139] A fim ter mais flexibilidade e ajustar os parâmetros dos dispositivos de melhoria de áudio de uma maneira contínua, o valor de confiança de cada tipo de áudio alvo pode ser estimado (decisão branda). Um valor de confiança representa o nível combinado entre o conteúdo de áudio a ser identificado e o tipo de áudio alvo, com valores de 0 a 1.

[00140] Como indicado antes, muitas técnicas de classificação podem enviar diretamente valores de confiança. O valor de confiança também pode ser calculado a partir de vários métodos, que podem ser considerados como uma parte do classificador. Por exemplo, se os modelos de áudio forem treinados por algumas tecnologias probabilísticas de modelagem, como os Modelos de Mistura Gaussiana (GMM), uma probabilidade posterior pode ser usada para representar o valor de confiança, como

[00141] onde x é uma parte do segmento de áudio; C é um tipo de áudio alvo, N é o número de tipos de áudios alvo, p(xlci) é a probabilidade de que o segmento de áudio X seja do tipo de áudio c; e p (c;lx) é a probabilidade posterior correspondente.

[00142] Por outro lado, se os modelos de áudio forem treinados a partir de alguns métodos discriminativos, como a Máquina de Vetor de Suporte (SVM) e adaBoost, são obtidas apenas contagens (valores reais) a partir da comparação modelo. Nesses casos, uma função sigmoide é geralmente utilizada para mapear a contagem obtida (teoricamente, de -» a ») para a confiança esperada (de 0 a 1):

[00143] onde y é a contagem de saída da SVM ou adaBoost, A e B são dois parâmetros que necessitam ser estimados a partir de uma série de dados de treinamento usando algumas tecnologias bem conhecidas.

[00144] Para algumas modalidades do presente pedido, a unidade de ajuste 300 pode usar mais de dois tipos de conteúdo e/ou mais de dois tipos de contexto. Em seguida, o classificador de conteúdo de áudio 202 precisa identificar mais de dois tipos de conteúdo e/ou o classificador de contexto de áudio 204 precisa identificar mais de dois tipos de contexto. Em tal situação, o classificador de conteúdo de áudio 202 ou o classificador de contexto de áudio 204 podem ser um grupo de classificadores organizados em uma certa arquitetura.

[00145] Por exemplo, se a unidade de ajuste 300 necessitar de todos os quatro tipos de mídia de tipo filme de tipos de contexto, música de longa duração, jogos e VoIP, então o classificador de contexto de áudio 204 pode ter as diferentes arquiteturas a seguir:

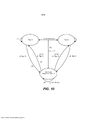

[00146] Primeiramente, o classificador de contexto de áudio 204 pode compreender 6 classificadores binários de um a um (cada classificador discrimina um tipo de áudio alvo de outro tipo de áudio alvo) organizados conforme mostrado na Figura 4, 3 classificadores binários de um para outros (cada classificador discrimina um tipo de áudio alvo dos outros) organizados conforme mostrado na Figura 5 e 4 classificadores de um para outros organizados conforme mostrado na Figura 6. Há também outras arquiteturas, como a arquitetura de Gráfico Acíclico Direcionada para a Decisão (DDAG). Note que nas Figuras 4-6 e a descrição correspondente abaixo, utiliza-se "filme" em vez de "mídia do tipo filme" por questão de concisão.

[00147] Cada classificador binário produzirá uma contagem de confiança H(x) para sua saída (x representa um segmento de áudio). Depois que as saídas de cada classificador binário forem obtidas, será necessário mapeá-las para os valores finais de confiança dos tipos de contexto identificados.

[00148] Geralmente, supondo que o sinal de áudio deva ser classificado nos tipos de contexto M (M é um número inteiro positivo). A arquitetura um a um convencional constrói M(M— 1)/2 classificadores, onde cada um é treinado nos dados de duas classes, em seguida, cada classificador um a um lança um voto para sua classe preferida e o resultado final é a classe com o maior número de votos entre as classificações dos M(M— 1)/2 classificadores. Em comparação à arquitetura um a um convencional, a arquitetura hierárquica da Figura 4 também precisa construir M(M— 1)/2 classificadores. Todavia, as iterações de teste podem ser abreviadas para M— 1, visto que o segmento x será determinado como estando/não estando na classe correspondente a cada nível hierárquico e a contagem geral de nível é M— 1. Os valores finais de confiança para vários tipos do contexto podem ser calculados a partir da confiança de classificação binária Hk (x), por exemplo, (k=1, 2,... 6, representando diferentes tipos de contexto):

[00149] Na arquitetura mostrada na Figura5, a função de mapeamento da classificação binária resulta em Hk(x) para que os valores finais de confiança possam ser definidos como o exemplo a seguir:

[00150] Na arquitetura ilustrada na Figura 6, os valores finais de confiança podem ser iguais aos resultados de classificação binária correspondentes Hk (x) ou se a soma dos valores de confiança para todas as classes precisar ser 1, então os valores finais de confiança podem ser simplesmente normalizados com base no Hk(x) estimado:

[00151] Esse um ou mais de um com os valores máximos de confiança pode ser determinado como sendo a classe final identificada.

[00152] Deve-se notar que nas arquiteturas mostradas nas Figuras4-6, a sequência de classificadores binários diferentes não são necessariamente como mostrado, mas podem ser outras sequências, as quais podem ser selecionadas por atribuição manual ou aprendizagem automática, de acordo com diferentes requisitos de várias aplicações.

[00153] As descrições acima são direcionadas aos classificadores de contexto de áudio 204. Quanto ao classificador de conteúdo de áudio 202, a situação é semelhante.

[00154] De maneira alternativa, o classificador de conteúdo de áudio 202 ou o classificador de contexto de áudio 204 podem ser implementados como um único classificador identificando todos os tipos de conteúdo/de contexto ao mesmo tempo e dando os valores de confiança correspondentes ao mesmo tempo. Existem muitas técnicas para fazer isso.

[00155] Utilizando o valor de confiança, a saída do classificador de áudio 200 pode ser representada como um vetor, com cada dimensão representando o valor de confiança de cada tipo de áudio alvo. Por exemplo, se os tipos de áudio alvo estiverem (fala, música de curta duração, ruído, fundo) em sequência, um resultado de saída exemplificativo poderia ser (0,9, 0,5, 0,0, 0,0), indicando que é 90% certo o conteúdo de áudio é de fala, e 50% certo que o áudio é música. Nota-se que a soma de todas as dimensões no vetor de saída não precisa ser um (por exemplo, os resultados da Figura 6 não são necessariamente normalizados), o que significa que o sinal de áudio pode ser um sinal de mistura de fala e de música de curta duração.

[00156] Posteriormente, nas Partes 6 e 7, uma nova implementação da classificação do contexto de áudio e da classificação do conteúdo de áudio serão discutidas em detalhes. 1.3 Uniformização dos valores de confiança dos tipos de áudio

[00157] Opcionalmente, depois que cada segmento de áudio foi classificado em tipos de áudio pré-definidos, uma etapa adicional é uniformizar os resultados de classificação ao longo da linha de tempo para evitar um salto abrupto de um tipo para outro e fazer uma estimativa de uniformização dos parâmetros nos dispositivos de melhoria de áudio. Por exemplo, um excerto longo é classificado como mídia de tipo filme, exceto por apenas um segmento classificado como VoIP, então a decisão VoIP abrupta pode ser revisada para a mídia de tipo filme por uniformização.

[00158] Assim, em uma variante da modalidade, conforme mostrado na Figura 7, uma unidade de uniformização de tipo 712 é fornecida ainda para, para cada tipo de áudio, uniformizar o valor de confiança do sinal de áudio no momento atual.

[00159] Um método de uniformização comum é baseado na média pesada, como o cálculo de uma soma ponderada do valor de confiança atual no presente e um valor de confiança uniformizado do tempo mais recente, conforme segue:

[00160] onde t representa o tempo atual (o segmento de áudio atual), t-1 representa o tempo mais recente (o último segmento de áudio), β é o peso, conf e smoothConf são os valores de confiança antes e depois da uniformização, respectivamente.

[00161] Do ponto de vista dos valores de confiança, os resultados da decisão complicada dos classificadores também podem ser representados com valores de confiança, com os valores sendo de 0 ou 1. Isto é, se um tipo de áudio alvo é escolhido e atribuído a um segmento de áudio, a confiança correspondente é 1; do contrário, a confiança é 0. Assim, mesmo se o classificador de áudio 200 não der o valor de confiança mas der apenas uma decisão complicada quanto ao tipo de áudio, um ajuste contínuo da unidade de ajuste 300 ainda é possível através da operação de uniformização da unidade de uniformização de tipo 712.

[00162] O algoritmo de uniformização pode ser "assimétrico", utilizando um peso de uniformização diferente para casos diferentes. Por exemplo, os pesos para calcular a soma ponderada podem ser alterados de maneira adaptativa com base no valor de confiança do tipo de áudio do sinal de áudio. O valor de confiança do segmento atual sendo maior, seu peso é maior

[00163] De outro ponto da vista, os pesos para calcular a soma ponderada podem ser alterados de maneira adaptativa com base nos diferentes pares de transição de um tipo de áudio para outro tipo de áudio, sobretudo quando o(s) dispositivo(s) de melhoria de áudio forem ajustados com base nos múltiplos tipos de conteúdo, como identificado pelo classificador de áudio 200, em vez de baseados na presença ou ausência de um único tipo de conteúdo. Por exemplo, para uma transição de um tipo de áudio que aparece com mais frequência em um certo contexto para outro tipo de áudio que não aparece com tanta frequência no contexto, o valor de confiança deste pode ser uniformizado, de modo que não aumentará tão depressa, porque pode ser apenas uma interrupção ocasional.

[00164] Um outro fator é a tendência a alteração (aumento ou diminuição), incluindo a taxa de alteração. Supondo que seja mais importante a latência quando um tipo de áudio se torna presente (isto é, quando seu valor de confiança aumenta), pode-se projetar o algoritmo de uniformização da seguinte maneira:

[00165] A fórmula acima permite que o valor de confiança uniformizado responda rapidamente ao estado atual quando o valor de confiança aumenta e uniformiza lentamente quando o valor de confiança diminui. As variantes das funções de uniformização podem ser facilmente projetadas de maneira semelhante. Por exemplo, a fórmula (4) pode ser revisada de modo que o peso do conf(t) se torne maior quando conf(t)>=smoothConf(t-1). Na verdade, na fórmula (4), pode-se considerar que β =0 e o peso de conf(t) se torna o maior, isto é: 1.

[00166] De um ponto de vista diferente, considerar a tendência a alteração de determinado tipo de áudio é apenas um exemplo específico de considerar diferentes pares de transição dos tipos de áudio. Por exemplo, o aumento do valor de confiança do tipo A pode ser considerado como uma transição de não-A para A e a diminuição do valor de confiança de tipo A pode ser considerado como uma transição de A para não-A. 1.4 Ajuste de parâmetro

[00167] A unidade de ajuste 300 é projetada para estimar ou ajustar parâmetros apropriados para o(s) dispositivo(s) de melhoria de áudio 400 com base nos resultados obtidos a partir do classificador de áudio 200. Diferentes algoritmos de ajuste podem ser projetados para diferentes dispositivos de melhoria de áudio utilizando o tipo de conteúdo ou o tipo de contexto, ou ambos, para uma decisão conjunta. Por exemplo, com informações do tipo de contexto, como mídia de tipo filme e música de longa duração, os pré-ajustes, como mencionado anteriormente, podem ser selecionados automaticamente ou aplicados sobre o conteúdo correspondente. Com as informações do tipo de conteúdo disponíveis, os parâmetros de cada dispositivo de melhoria de áudio podem ser sintonizados de uma maneira mais fina, como mostrado nas partes subsequentes. As informações do tipo de conteúdo e as informações de contexto podem ser usadas de maneira conjunta, ainda, na unidade de ajuste 300 para balancear as informações de curta e de longa duração. O algoritmo de ajuste específico para um dispositivo de melhoria de áudio específico pode ser considerado como uma unidade de ajuste separada ou os algoritmos de ajuste diferentes podem ser considerados coletivamente como uma unidade de ajuste unida.

[00168] Isto é, a unidade de ajuste 300 pode ser configurado para ajustar pelo menos um parâmetro do dispositivo de melhoria de áudio com base no valor de confiança de pelo menos um tipo de conteúdo e/ou no valor de confiança de pelo menos um tipo de contexto. Para um dispositivo de melhoria de áudio específico, alguns tipos de áudio são informativos e alguns tipos de áudio são de intervenção. Com efeito, os parâmetros do dispositivo de melhoria de áudio específico pode ser positivamente ou negativamente correlacionado ao(s) valor(es) de confiança do(s) tipo(s) de áudio informativo ou do(s) tipo(s) de áudio de intervenção. Aqui, "positivamente correlacionado" quer dizer que o parâmetro aumenta ou diminui com o aumento ou a diminuição do valor de confiança do tipo de áudio, de maneira linear ou não-linear. "Negativamente correlacionado" quer dizer que o parâmetro aumenta ou diminui com, respectivamente, a diminuição ou o aumento do valor de confiança do tipo de áudio, de maneira linear ou não-linear.

[00169] Aqui, a diminuição e o aumento do valor de confiança são diretamente "transferidos" aos parâmetros a serem ajustados pela correlação positiva ou negativa. Em matemática, tal correlação ou "transferência" pode ser incorporada como uma proporção linear ou proporção inversa, operação de mais ou menos (adição ou subtração), operação de multiplicação ou divisão ou função não-linear. Todas essas formas de correlação podem ser denominadas "função de transferência". Para determinar o aumento ou a diminuição do valor de confiança, pode-se também comparar o valor de confiança atual ou sua transformação matemática com o último valor de confiança ou com uma pluralidade de valores de confiança do histórico, ou suas transformações matemáticas. No contexto do presente pedido, o termo "comparar" significa comparação através de operação de subtração ou comparação através de operação de divisão. Pode-se determinar um aumento ou uma diminuição determinando se a diferença é superior a 0 ou se a razão é superior a 1.

[00170] Em implementações específicas, pode-se relacionar diretamente os parâmetros com os valores de confiança ou suas razões ou diferenças através do algoritmo apropriado (como a função de transferência) e não é necessário que um "observador externo" saiba explicitamente se um valor de confiança específico e/ou um parâmetro específico aumentou ou diminuiu. Alguns exemplos específicos serão dados nas partes 2-5 subsequentes quanto aos dispositivos de melhoria de áudio específicos.

[00171] Como indicado na seção anterior, em relação ao mesmo segmento de áudio, o classificador 200 pode identificar múltiplos tipos de áudio com os respectivos valores de confiança, cujos valores de confiança podem não necessariamente chegar a 1, visto que o segmento de áudio pode compreender múltiplos componentes ao mesmo tempo, como música e fala e sons de fundo. Em tal situação, os parâmetros dos dispositivos de melhoria de áudio devem ser equilibrados entre os diferentes tipos de áudio. Por exemplo, a unidade de ajuste 300 pode ser configurada para considerar pelo menos alguns dos múltiplos tipos de áudio através da pesagem dos valores de confiança de pelo menos um tipo de áudio com base na importância de pelo menos um tipo de áudio. Quanto mais importante for um tipo específico de áudio, mais importante são os parâmetros influenciados por este.

[00172] O peso também pode refletir o efeito informativo e de intervenção do tipo de áudio. Por exemplo, para um tipo de áudio de intervenção, um peso de menos pode ser dado. Alguns exemplos específicos serão dados nas partes 2-5 subsequentes quanto aos dispositivos de melhoria de áudio específicos.

[00173] Observe-se que no contexto do presente pedido, "peso" tem um significado mais amplos do que os coeficientes em uma multinomial. Além dos coeficientes em uma multinomial, ele também pode assumir o formato de uma potência ou um expoente. Quando os coeficientes estiverem em uma multinomial, os coeficientes de pesagem pode ser ou não normalizados. Em resumo, o peso representa apenas quanta influência o objeto pesado tem sobre o parâmetro a ser ajustado.

[00174] Em algumas outras modalidades, para os múltiplos tipos de áudio contidos no mesmo segmento de áudio, os valores de confiança destes podem ser convertidos para pesos através de sua normalização, e então o parâmetro final pode ser determinado através do cálculo de uma soma de valores pré-ajustados de parâmetro para cada tipo de áudio e pesado pelos pesos com base nos valores de confiança. Isto é, a unidade de ajuste 300 pode ser configurada para considerar os múltiplos tipos de áudio através da pesagem dos efeitos dos múltiplos tipos de áudio com base nos valores de confiança.

[00175] Como um exemplo específico de pesagem, a unidade de ajuste é configurada para considerar que pelo menos um tipo de áudio dominante com base nos valores de confiança. Para aqueles tipos de áudio com valores de confiança muito baixos (menos do que um limite), eles podem não ser considerados. Isso equivale aos pesos dos outros tipos de áudio cujos valores de confiança forem inferiores ao limite serem estabelecidos como zero. Alguns exemplos específicos serão dados nas partes 2-5 subsequentes quanto aos dispositivos de melhoria de áudio específicos.

[00176] O tipo de conteúdo e de contexto podem ser considerados em conjunto. Em uma modalidade, eles podem ser considerados como no mesmo nível e seus valores de confiança podem ser seus respectivos pesos. Em outra modalidade, tal como a denominação sugere, o "tipo de contexto" é o contexto ou ambiente em que o "tipo de contexto" se situa e, assim, a unidade de ajuste 200 pode ser configurada de modo que a um tipo de conteúdo em um sinal de áudio de um tipo de contexto diferente é atribuído um peso diferente, dependendo do tipo de contexto do sinal de áudio. Falando de modo geral, qualquer tipo de áudio pode constituir um contexto de outro tipo de áudio e, assim, a unidade de ajuste 200 pode ser configurada para modificar o peso de um tipo de áudio com o valor de confiança de outro tipo de áudio. Alguns exemplos específicos serão dados nas partes 2-5 subsequentes quanto aos dispositivos de melhoria de áudio específicos.

[00177] No contexto do presente pedido, "parâmetro" tem um significado mais amplo do que seu significado literal. Além de um parâmetro com um valor único, isso também significa um pré-ajuste, como mencionado antes, que inclui uma série de parâmetros diferentes, um vetor compreendido de diferentes parâmetros ou um perfil. Especificamente, nas partes 2-5 subsequentes os parâmetros a seguir serão discutidos, mas o presente pedido não se limita a isso: o nível de otimização de diálogo, os limites para a determinação das bandas de frequência a terem os diálogos otimizados, o nível de fundo, a quantidade de boost do surround, a frequência inicial do virtualizador de surround, o ganho dinâmico ou a amplitude do ganhou dinâmico de um nivelador de volume, os parâmetros indicativos do grau de sinal de áudio sendo um novo evento de áudio perceptível, o nível de equalização, os perfis de equalização e os pré-ajustes de balanceamento espectral. 1.5 Uniformização de parâmetro

[00178] Na Seção 1.3, foi discutida a uniformização do valor de confiança de um tipo de áudio para evitar sua mudança abrupta e, portanto, a mudança abrupta dos parâmetros do(s) dispositivo(s) de melhoria de áudio. Outras medidas também são possíveis. Uma é uniformizar o parâmetro ajustado com base no tipo de áudio, que será discutido nesta seção; a outra é configurar o classificador de áudio e/ou a unidade de ajuste de modo a retardar a mudança dos resultados do classificador de áudio, e isso será discutido na Seção 1.6.

[00179] Em uma modalidade, o parâmetro pode ser uniformizado, ainda, para evitar uma mudança rápida, a qual pode inserir artefatos audíveis nos pontos de transição, como

[00180] onde ’L(t) ' é o parâmetro uniformizado, L(t) é o parâmetro não-uniformizado, T é um coeficiente que representa uma constante de tempo, t é o tempo atual e t-1 é o tempo mais recente.

[00181] Isto é, como mostrado na Figura 8, o aparelho de processamento de áudio pode compreender uma unidade de uniformização de parâmetro 814 para, para um dispositivo de melhoria de áudio (como pelo menos um dentre o otimizador de diálogo 402, o virtualizador surround 404, o nivelador de volume 406 e o equalizador 408) ajustado pela unidade de ajuste 300, o valor de parâmetro de uniformização determinado pela unidade de ajuste 300 no tempo atual calculando-se uma soma ponderada do valor de parâmetro determinado pela unidade de ajuste no tempo atual e um valor de parâmetro uniformizado do tempo mais recente.

[00182] A constante de tempo t pode ser um valor fixo com base no requisito específico de uma aplicação e/ou a implementação do dispositivo de melhoria de áudio 400. Ela também poderia ser alterada de maneira adaptativa com base no tipo de áudio, especialmente com base em diferentes tipos de transição de um tipo de áudio para outro, como de música para fala e de fala para música.

[00183] Tome o equalizador como exemplo (mais detalhes podem ser referidos na parte 5). A equalização é boa para aplicar no conteúdo musical, mas não no conteúdo de fala. Assim, para uniformizar o nível de equalização, a constante de tempo pode ser relativamente pequena quando o sinal de áudio transita de música para fala, de modo que um nível de equalização menor possa ser aplicado ao conteúdo mais rapidamente. Por um lado, a constante de tempo para a transição de fala para música pode ser relativamente maior a fim de evitar artefatos audíveis nos pontos de transição.

[00184] Para estimar o tipo da transição (por exemplo, de fala para música ou de música para fala), os resultados de classificação de conteúdo podem ser usados diretamente. Isto é, a classificação do conteúdo de áudio em música ou fala simplifica a obtenção do tipo de transição. Para estimar a transição de uma maneira mais contínua, pode-se confiar também no nível de equalização não-uniformizado estimado em vez de comparar diretamente as decisões complicadas dos tipos de áudio. A ideia geral é, se o nível de equalização não- uniformizado estiver aumentando, ele indica uma transição de fala para música (ou mais do tipo música); do contrário, é mais uma transição de música para fala (ou mais do tipo fala). Pela diferenciação de diferentes tipos de transição, a constante de tempo pode ser ajustada de maneira correspondente, um exemplo é:

[00185] onde o T (t) é a constante de tempo variante com o tempo que depende do conteúdo, T 1 e T 2 são dois valores constantes de tempo pré-ajustados, geralmente satisfazendo t1> t 2. Intuitivamente, a função acima indica uma transição relativamente lenta quando o nível de equalização estiver aumentando e uma transição relativamente rápida quando o nível de equalização estiver diminuindo, mas o presente pedido não se limita a isso. Ademais, o parâmetro não se limita ao nível de equalização, mas podem ser outros parâmetros. Isto é, a unidade de uniformização de parâmetro 814 pode ser configurada de modo que os pesos para calcular a soma ponderada são alterados de maneira adaptativa com base em uma tendência de aumento ou de diminuição do valor de parâmetro determinado pela unidade de ajuste 300. 1.6 Transição de tipos de áudio

[00186] Em referência às Figuras 9 e 10, será descrito outro esquema para evitar a mudança abrupta do tipo de áudio e, assim, evitar a mudança abrupta dos parâmetros do(s) dispositivo(s) de melhoria de áudio.