RU2560794C2 - Выражение визуального представления, основанное на выражении игрока - Google Patents

Выражение визуального представления, основанное на выражении игрока Download PDFInfo

- Publication number

- RU2560794C2 RU2560794C2 RU2011154346/08A RU2011154346A RU2560794C2 RU 2560794 C2 RU2560794 C2 RU 2560794C2 RU 2011154346/08 A RU2011154346/08 A RU 2011154346/08A RU 2011154346 A RU2011154346 A RU 2011154346A RU 2560794 C2 RU2560794 C2 RU 2560794C2

- Authority

- RU

- Russia

- Prior art keywords

- user

- gesture

- data

- temperament

- visual representation

- Prior art date

Links

Images

Classifications

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/20—Input arrangements for video game devices

- A63F13/21—Input arrangements for video game devices characterised by their sensors, purposes or types

- A63F13/213—Input arrangements for video game devices characterised by their sensors, purposes or types comprising photodetecting means, e.g. cameras, photodiodes or infrared cells

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/20—Input arrangements for video game devices

- A63F13/23—Input arrangements for video game devices for interfacing with the game device, e.g. specific interfaces between game controller and console

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/40—Processing input control signals of video game devices, e.g. signals generated by the player or derived from the environment

- A63F13/42—Processing input control signals of video game devices, e.g. signals generated by the player or derived from the environment by mapping the input signals into game commands, e.g. mapping the displacement of a stylus on a touch screen to the steering angle of a virtual vehicle

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/017—Gesture based interaction, e.g. based on a set of recognized hand gestures

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T13/00—Animation

- G06T13/80—2D [Two Dimensional] animation, e.g. using sprites

Abstract

Изобретение относится к визуализации визуального представления пользователя. Технический результат - обеспечение визуального представления, отражающего эмоции и позицию пользователя. Способ применения анимации для визуального представления на основании данных, характерных для темперамента пользователя, к визуальному представлению содержит: визуализацию визуального представления пользователя; прием данных, характерных для пользователя в физическом пространстве; анализ упомянутых данных, характерных для пользователя в физическом пространстве, для выведения эмоций и темперамента пользователя; определение заранее заготовленной анимации визуального представления для отображения на основании выведенных эмоций и темперамента пользователя и отображение упомянутой заранее заготовленной анимации для визуального представления на устройстве отображения. 3 н. и 12 з.п. ф-лы, 10 ил.

Description

УРОВЕНЬ ТЕХНИКИ

[0001] Обычно различные приложения будут отображать визуальное представление, которое соответствует пользователю, при этом пользователь осуществляет управление через некоторые действия, такие как выбор кнопок на удаленном или перемещающимся контроллере некоторым способом. Визуальное представление может быть в форме аватара, нереального персонажа, мультипликационного изображения или животного, курсора, руки или подобного. Визуальное представление является компьютерным представлением, соответствующим пользователю, которое обычно принимает форму двумерной (2D) или трехмерной (3D) модели в различных приложениях, таких как компьютерные игры, видеоигры, чаты, форумы, сообщества, службы мгновенной передачи сообщений и т.п. Многие вычислительные приложения, такие как компьютерные игры, мультимедийные приложения, офисные приложения или подобное, обеспечивают выбор предварительно определенных анимированных персонажей, которые могут быть выбраны для использования в приложении в качестве аватара пользователя. Некоторые системы могут включать камеру, которая способна делать снимок пользователя и идентифицировать признаки из этого кадра данных. Однако эти системы требуют захвата признака пользователя, обработки изображения и затем применения к персонажу в среде нереального времени, и применяемые признаки имеют низкую точность, обычно основанную на единственном снимке пользователя.

СУЩНОСТЬ ИЗОБРЕТЕНИЯ

[0002] Может быть желательно настроить визуальное представление пользователя на основании обнаруженных характеристик пользователя, и может быть желательно применить эти характеристики к визуальному представлению в реальном времени. Также может быть желательно, чтобы система обрабатывала изменения для характеристик пользователя в физическом пространстве и могла обновить визуальное представление в реальном времени. Из этих характеристик может быть желательно, чтобы система идентифицировала характер (темперамент) пользователя и применяла атрибуты, указывающие этот характер, к визуальному представлению пользователя.

[0003] В настоящем описании раскрываются способы для обеспечения визуального представления пользователя, такого как аватар или нереальный (фантастический) персонаж, который может отражать характер пользователя в реальном времени. Используя способы распознавания лиц и распознавания жестов/положения тела, система может выводить характер пользователя. Система может естественным образом передавать эмоции и отношения пользователя с помощью применения атрибутов характера пользователя к визуальному представлению пользователя. Также раскрываются способы для отслеживания пользователя в физическом пространстве в течение времени и применения модификаций или обновлений к визуальному представлению в реальном времени. Например, система может отслеживать выражения лица и перемещения тела пользователя для идентификации характера и затем применять атрибуты, указывающие этот характер, к визуальному представлению. Система может использовать любые обнаруживаемые характеристики для оценки характера пользователя для приложения к визуальному представлению.

[0004] Эта сущность изобретения обеспечивается, чтобы ввести выбор понятий в упрощенной форме, которые дополнительно описываются ниже в подробном описании. Эта сущность изобретения не предназначается для идентификации ключевых признаков или существенных признаков заявленной сущности изобретения, и при этом она не предназначается для использования, чтобы ограничить область заявленной сущности изобретения. Кроме того, заявленная сущность изобретения не ограничивается реализациями, которые решают любые или все недостатки, отмеченные в какой-либо части этого раскрытия.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

[0005] Системы, способы и считываемые компьютером носители для модификации визуального представления в соответствии с настоящим описанием дополнительно описываются со ссылками на сопроводительные чертежи, на которых:

[0006] Фиг. 1 иллюстрирует примерный вариант осуществления системы распознавания, анализа и отслеживания цели посредством пользователя, играющего в игру.

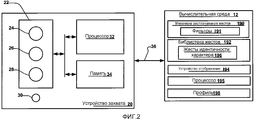

[0007] Фиг. 2 иллюстрирует примерный вариант осуществления устройства захвата, которое может быть использовано в системе распознавания, анализа и отслеживания цели и способах встроенного формирования цепочки и смешивания анимации.

[0008] Фиг. 3 иллюстрирует примерный вариант осуществления вычислительной среды, в которой могут осуществляться описанные в настоящем описании способы анимации.

[0009] Фиг. 4 иллюстрирует другой примерный вариант осуществления вычислительной среды, в которой могут осуществляться описанные в настоящем описании способы анимации.

[0010] Фиг. 5A иллюстрирует скелетное отображение пользователя, который был сгенерирован из изображения глубины.

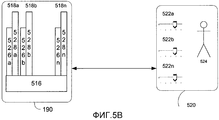

[0011] Фиг. 5B иллюстрирует дополнительные подробности архитектуры блока распознавания жестов, показанного на Фиг. 2.

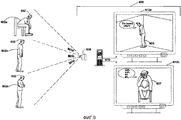

[0012] Фиг. 6 изображает примерную систему распознавания, анализа и отслеживания цели и примерный вариант осуществления пользователя в физическом пространстве и отображения визуального представления пользователя.

[0013] Фиг. 7 изображает примерную блок-схему для способа применения атрибутов, указывающих характер пользователя, к визуальному представлению.

[0014] Фиг. 8 изображает примерную таблицу поиска для выведения характера пользователя.

[0015] Фиг. 9 изображает другую примерную систему распознавания, анализа и отслеживания цели, примерные варианты осуществления пользователя в физическом пространстве и примерные варианты осуществления отображения визуального представления пользователя.

ПОДРОБНОЕ ОПИСАНИЕ ИЛЛЮСТРАТИВНЫХ ВАРИАНТОВ ОСУЩЕСТВЛЕНИЯ

[0016] В настоящем описании раскрываются способы для обеспечения визуального представления пользователя, такого как аватар, которое может отражать характер пользователя. Визуальное представление пользователя может быть в форме персонажа, анимации, аватара, курсора на экране, руки или любого другого визуального представления, которое соответствует пользователю в физическом пространстве. Используя способы распознавания лиц и распознавания жестов/положения тела, система может естественным образом передавать эмоции и позицию пользователя с помощью визуального представления пользователя. Например, устройство захвата может идентифицировать признаки пользователя и настраивать визуальное представление пользователя на основании этих идентифицированных признаков, таких как эмоции, выражения и настроения. В примерном варианте осуществления система генерирует и использует аспекты скелетной или сеточной модели человека на основании данных изображения, захваченных устройством захвата, и использует способы распознавания тела для определения характера пользователя.

[0017] Также раскрываются способы для отображения визуального представления в реальном времени и применения атрибутов, указывающих характер пользователя, к визуальному представлению в реальном времени. Система может отслеживать пользователя в физическом пространстве в течение времени и применять модификации или обновления к визуальному представлению в реальном времени. Система может отслеживать обнаруживаемые характеристики, такие как характеристики пользователя, жесты, статус приложения и т.д., чтобы выводить характер (темперамент) пользователя. Характеристики пользователя, например, такие как выражения лица и перемещения тела, могут быть использованы для выведения характера, и затем атрибуты этого характера могут быть применены к визуальному представлению таким образом, чтобы визуальное представление отражало характер пользователя. Например, устройство захвата может идентифицировать поведение и характерные черты, эмоции, образцы голоса, данные истории или подобное пользователя для определения характера пользователя и применения их к визуальному представлению пользователя. Система может использовать любые обнаруживаемые признаки для оценки характера пользователя для приложения к визуальному представлению.

[0018] Для генерирования модели, представляющей цель или объект в физическом пространстве, устройство захвата может захватывать изображение глубины сцены и сканировать цели или объекты на сцене. Цель может быть человеком-целью, такой как пользователь в физическом пространстве. Таким образом, как используется в настоящем описании, подразумевается, что цель и пользователь могут быть использованы взаимозаменяемо. В одном варианте осуществления устройство захвата может определять, соответствует ли одна или более целей или объектов на сцене человеку-цели, такой как пользователь. Чтобы определить, соответствует ли цель или объект на сцене человеку-цели, каждая из целей может заливаться цветом и сравниваться с образцом модели человеческого тела. Каждая цель или объект, который соответствует модели человеческого тела, может затем сканироваться для генерирования скелетной модели, ассоциированной с ней. Например, цель, идентифицированная как человек, может сканироваться для генерирования скелетной модели, ассоциированной с ней. Затем скелетная модель может быть выдана вычислительной среде для отслеживания скелетной модели и визуализации визуального представления, ассоциированного со скелетной моделью. Вычислительная среда может определять, какие выполнять элементы управления при выполнении приложения в компьютерной среде на основании, например, жестов пользователя, которые были распознаны и сопоставлены со скелетной моделью. Таким образом, может быть отображена пользовательская обратная связь, такая как с помощью аватара на экране, и пользователь может управлять движением этого аватара посредством жестов в физическом пространстве.

[0019] Движение визуального представления может управляться посредством сопоставления перемещения визуального представления с движением пользователя в физическом пространстве. Например, цель может быть пользователем-человеком, который двигается или жестикулирует в физическом пространстве. Визуальное представление цели может быть аватаром, отображенным на экране, и движение аватара может соответствовать движению пользователя. Движение в физическом пространстве может быть преобразовано в элемент управления в системе или пространстве приложения, таком как виртуальное пространство и/или игровое пространство. Например, движения пользователя могут быть отслежены, смоделированы и отображены, и жесты пользователя могут управлять некоторыми аспектами приложения операционной системы или выполняющего приложения. Жесты пользователя могут быть преобразованы в элемент управления в системе или пространстве приложения для применения атрибутов, указывающих характер, к визуальному представлению.

[0020] Захваченное движение может быть любым движением в физическом пространстве, которое захватывается устройством захвата, таким как камера. Захваченное движение может включать в себя движение цели в физическом пространстве, такой как пользователь или объект. Захваченное движение может включать в себя жест, который преобразует в элемент управления в операционной системе или приложении. Движение может быть динамичным, таким как непрерывное движение, или движение может быть статическим, таким как пользователь, который зафиксирован в позиции с небольшим перемещением.

[0021] Система, способы и компоненты распознавания лица и тела для передачи атрибутов и эмоций пользователя, описанных в настоящем описании, могут осуществляться на мультимедийной консоли, такой как игровая консоль, или на любом другом вычислительном устройстве, в котором желательно отобразить визуальное представление цели, включающей в себя посредством примера и без какого-либо заданного ограничения спутниковые приемники, телевизионные приставки, аркадные игры, персональные компьютеры (PC), портативные телефоны, персональные цифровые ассистенты (ассистенты PDA) и другие переносные устройства.

[0022] Фиг. 1 иллюстрирует примерный вариант осуществления конфигурации системы 10 распознавания, анализа и отслеживания цели, которая может использовать способы для применения характеристик пользователя к визуальному представлению. В примерном варианте осуществления пользователь 18 играет в игру в бокс. В примерном варианте осуществления система 10 может распознавать, анализировать и/или отслеживать цель человека, такую как пользователь 18. Система 10 может собирать информацию, относящуюся к движениям, выражениям лица, языку тела, эмоциям и т.д. пользователя, в физическом пространстве. Например, система может идентифицировать и сканировать человека-цель 18. Система 10 может использовать способы распознавания положения тела для идентификации характера человека-цели 18. Например, если пользователь 18 сутулится, складывает руки на груди и медленно поворачивает свою голову в сторону, система 10 может идентифицировать части тела пользователя 18 и то, как они двигаются. Система 10 может сравнивать движения с библиотекой эмоций, настроений, отношений, выражений и т.д., чтобы интерпретировать характер пользователя.

[0023] Как показано на Фиг. 1, система 10 распознавания, анализа и отслеживания цели может включать в себя вычислительную среду 12. Вычислительная среда 12 может быть компьютером, игровой системой или консолью или подобным. Согласно примерному варианту осуществления вычислительная среда 12 может включать в себя компоненты аппаратного обеспечения и/или компоненты программного обеспечения таким образом, чтобы вычислительная среда 12 могла быть использована для выполнения приложений, таких как игровые приложения, неигровые приложения или подобное.

[0024] Как показано на Фиг. 1, система 10 распознавания, анализа и отслеживания цели может дополнительно включать в себя устройство 20 захвата. Устройством 20 захвата может быть, например, камера, которая может быть использована для визуального контроля одного или более пользователей, таких как пользователь 18, таким образом, чтобы жесты, выполняемые одним или более пользователями, могли быть захвачены, проанализированы и отслежены для выполнения одного или более элементов управления или действий в приложениях, как будет описано более подробно ниже.

[0025] Согласно одному варианту осуществления система 10 распознавания, анализа и отслеживания цели может быть соединена с аудиовизуальным устройством 16, таким как телевизор, монитор, высококачественный телевизор (HDTV) или подобное, которые могут обеспечивать графику и/или аудиоигры или приложения пользователю, такому как пользователь 18. Например, вычислительная среда 12 может включать в себя видеоадаптер, такой как карта графических данных, и/или аудиоадаптер, такой как звуковая плата, которая может обеспечивать аудиовизуальные сигналы, ассоциированные с игровым приложением, неигровым приложением или подобным. Аудиовизуальное устройство 16 может принимать аудиовизуальные сигналы от вычислительной среды 12 и затем может выводить графику и/или аудиоигры или приложения, ассоциированные с аудиовизуальными сигналами, пользователю 18. Согласно одному варианту осуществления аудиовизуальное устройство 16 может быть соединено с вычислительной средой 12 с помощью, например, кабеля S-видео, коаксиального кабеля, HDMI кабеля, DVI кабеля, VGA кабеля или подобного.

[0026] Как показано на Фиг. 1, система 10 распознавания, анализа и отслеживания цели может быть использована для распознавания, анализа и/или отслеживания человека-цели, такой как пользователь 18. Например, пользователь 18 может отслеживаться, используя устройство 20 захвата, таким образом, чтобы перемещения пользователя 18 могли интерпретироваться как элементы (средства) управления, которые могут быть использованы, чтобы влиять на приложение, выполняемое компьютерной средой 12. Таким образом, согласно одному варианту осуществления пользователь 18 может перемещать его или ее тело, чтобы управлять приложением. Система 10 может отслеживать тело и движения пользователя, выполняемые телом пользователя, включая жесты, которые управляют аспектами системы, такими как приложение, операционная система или подобное. Система может сравнивать положение тела пользователя, выражения лица, выражения голоса и тон, направленные пристальные взгляды и т.д. для определения характера пользователя или отношения и применения характеристик этого характера или отношения к аватару.

[0027] Система 10 может преобразовывать введенные данные на устройство 20 захвата в анимацию, причем введенные данные представляет движение пользователя таким образом, чтобы анимация возбуждалась посредством этих введенных данных. Таким образом, движения пользователя могут преобразовываться в визуальное представление 40 таким образом, чтобы движения пользователя в физическом пространстве выполнялись посредством аватара 40. Движения пользователя могут быть жестами, которые применяются к средству управления в приложении. Как показано на Фиг. 1, в примерном варианте осуществления приложение, выполняющееся в вычислительной среде 12, может быть игрой в бокс, в которую может играть пользователь 18.

[0028] Вычислительная среда 12 может использовать аудиовизуальное устройство 16 для обеспечения визуального представления аватара 40 игрока, которым пользователь 18 может управлять посредством его или ее перемещений. Например, пользователь 18 может сделать удар в физическом пространстве, чтобы заставить аватар 40 игрока сделать удар в игровом пространстве. Аватар 40 игрока может иметь характеристики пользователя, идентифицированного устройством 20 захвата, или система 10 может использовать признаки известного боксера или создавать изображение телосложения профессионального боксера для визуального представления, которое сопоставляется с движениями пользователя. Система 10 может отслеживать пользователя и модифицировать характеристики аватара пользователя на основании обнаруживаемых признаков пользователя в физическом пространстве. Вычислительная среда 12 может также использовать аудиовизуальное устройство 16 для обеспечения визуального представления боксирующего противника 38 пользователю 18. Согласно примерному варианту осуществления компьютерная среда 12 и устройство 20 захвата системы 10 распознавания, анализа и отслеживания цели могут быть использованы для распознавания и анализа удара пользователя 18 в физическом пространстве таким образом, чтобы удар мог интерпретироваться как управление игрой аватара 40 игрока в игровом пространстве. Множественные пользователи могут взаимодействовать друг с другом из удаленных местоположений. Например, визуальное представление боксирующего противника 38 может представлять другого пользователя, такого как второй пользователь в физическом пространстве, посредством пользователя 18 или сетевого пользователя во втором физическом пространстве.

[0029] Другие перемещения пользователем 18 могут также интерпретироваться как другие элементы управления или действия, такие как элементы управления, чтобы подпрыгнуть, раскачиваться, перемещаться, блокировать, атаковать или сделать множество ударов различной силы. Кроме того, некоторые перемещения могут интерпретироваться как элементы управления, которые могут соответствовать действиям, отличным от управления аватаром 40 игрока. Например, игрок может использовать перемещения, чтобы закончить, остановить или сохранить игру, выбрать уровень, просмотреть лучшие результаты, пообщаться с другом и т.д. Дополнительно, полный диапазон перемещения пользователя 18 может быть доступным, использоваться и анализироваться любым подходящим способом, чтобы взаимодействовать с приложением.

[0030] В примерных вариантах осуществления человек-цель, такая как пользователь 18, может иметь объект. В таких вариантах осуществления пользователь электронной игры может держать объект таким образом, чтобы движения игрока и объекта могли быть использованы для регулирования и/или управления параметрами игры. Например, движение игрока, держащего ракетку, может быть отслежено и использовано для управления ракеткой на экране в электронной спортивной игре. В другом примерном варианте осуществления движение игрока, держащего объект, может быть отслежено и использовано для управления оружием на экране в электронной боевой игре.

[0031] Жесты или движение пользователя могут интерпретироваться как элементы управления, которые могут соответствовать действиям, отличным от управления аватаром 40 игрока. Например, игрок может использовать перемещения, чтобы закончить, остановить или сохранить игру, выбрать уровень, просмотреть лучшие результаты, пообщаться с другом и т.д. Игрок может использовать перемещения, чтобы применить атрибуты, указывающие характер, к визуальному представлению пользователя. Фактически любой управляемый аспект операционной системы и/или приложения может управляться перемещениями цели, такой как пользователь 18. Согласно другим примерным вариантам осуществления система 10 распознавания, анализа и отслеживания цели может интерпретировать перемещения цели для аспектов управления операционной системы и/или приложения, которые находятся вне области игр.

[0032] Применение признака пользователя к визуальному представлению или обнаружение некоторых эмоций или отношений пользователя может быть аспектом операционной системы и/или приложения, которые могут управляться или распознаваться из жестов пользователя. Например, жест для рук пользователя, сложенных на его или ее груди, может быть жестом, распознанным как настроение расстройства. Распознавание системой жеста, который указывает, что пользователь расстроен, наряду с выражением пользователя, таким как хмурый взгляд, может привести к визуальному представлению, которое отражает расстроенный характер.

[0033] Жест пользователя может быть элементами управления, применимыми к операционной системе, неигровым аспектам игры или неигровому приложению. Жесты пользователя могут интерпретироваться как манипуляция объектом, такая как управление пользовательским интерфейсом. Например, рассмотрим пользовательский интерфейс, имеющий интерфейс блейдов или интерфейс на основе вкладок, вертикально упорядоченный слева направо, где выбор каждого блейда или вкладки открывает варианты для различных элементов управления в приложении или системе. Система может идентифицировать жест руки пользователя для перемещения вкладки, где рука пользователя в физическом пространстве виртуальным образом соответствует вкладке в пространстве приложения. Жест, включающий в себя паузу, движение захвата и затем взмах руки налево, может интерпретироваться как выбор вкладки и затем ее перемещение таким образом, чтобы открыть следующую вкладку.

[0034] Фиг. 2 иллюстрирует примерный вариант осуществления устройства 20 захвата, которое может быть использовано для распознавания цели, анализа и отслеживания, где цель может быть пользователем или объектом. Согласно примерному варианту осуществления устройство 20 захвата может быть сконфигурировано для захвата видео с информацией глубины, включающей в себя изображение глубины, которое может включать в себя значения глубины, с помощью любого подходящего способа, включающего в себя, например, время прохождения, структурированный свет, стереоизображение или подобное. Согласно одному варианту осуществления устройство 20 захвата может организовать вычисленную информацию глубины в "Z уровни" или уровни, которые могут быть перпендикулярны оси Z, простирающейся от камеры глубины вдоль ее луча обзора.

[0035] Как показано на Фиг. 2, устройство 20 захвата может включать в себя компонент 22 камеры изображения. Согласно примерному варианту осуществления компонент 22 камеры изображения может быть камерой глубины, которая может захватывать изображение глубины сцены. Изображение глубины может включать в себя двумерную (2-D) пиксельную область захваченной сцены, где каждый пиксель в 2-D пиксельной области может представлять значение глубины, такое как длина или расстояние, например, в сантиметрах, миллиметрах или подобном, объекта в захваченной сцене от камеры.

[0036] Как показано на Фиг. 2, согласно примерному варианту осуществления компонент 22 камеры изображения может включать в себя компонент 24 IR (инфракрасного) света, трехмерную (3-D) камеру 26 и камеру RGB 28, которые могут быть использованы для захвата изображения глубины сцены. Например, при анализе способом времени прохождения компонент 24 ИК света устройства 20 захвата может испускать инфракрасный свет на сцену и затем может использовать датчики (не показаны) для обнаружения обратно рассеянного света от поверхности одной или более целей и объектов на сцене, используя, например, 3-D камеру 26 и/или камеру 28 RGB. В некоторых вариантах осуществления пульсирующий инфракрасный свет может быть использован таким образом, чтобы время между исходящим световым импульсом и соответствующим входящим световым импульсом могло быть измерено и использовано для определения физического расстояния от устройства 20 захвата до конкретного местоположения в отношении целей или объектов на сцене. Дополнительно, в других примерных вариантах осуществления фаза исходящей световой волны может сравниваться с фазой входящей световой волны для определения фазового сдвига. Затем сдвиг фаз может быть использован для определения физического расстояния от устройства 20 захвата до конкретного местоположения в отношении целей или объектов.

[0037] Согласно другому примерному варианту осуществления анализ способом времени прохождения может быть использован, чтобы косвенно определить физическое расстояние от устройства 20 захвата до конкретного местоположения в отношении целей или объектов посредством анализа интенсивности отраженного пучка света в течение времени с помощью различных способов, включающих в себя, например, формирование изображения прерывистого светового импульса.

[0038] В другом примерном варианте осуществления устройство 20 захвата может использовать структурированный свет для захвата информации глубины. В таком анализе текстурированный свет (то есть свет, отображенный как известный шаблон, такой как шаблон сетки или шаблон полосы) может быть спроецирован на сцену с помощью, например, компонента 24 ИК света. После нанесения удара по поверхности одной или более целей или объектов на сцене, шаблон в ответ на это может стать деформированным. Такая деформация шаблона может быть захвачена, например, 3-D камерой 26 и/или камерой 28 RGB и затем может быть проанализирована для определения физического расстояния от устройства 20 захвата до конкретного местоположения в отношении целей или объектов.

[0039] Согласно другому варианту осуществления устройство 20 захвата может включать в себя две или более физически отделенные камеры, которые могут просматривать сцену с различных углов, получать визуальные стереоданные, которые могут быть разрешены для генерирования информации глубины.

[0040] Устройство 20 захвата может дополнительно включать в себя микрофон 30 или множество микрофонов. Микрофон 30 может включать в себя преобразователь или датчик, который может принимать и преобразовывать звук в электрический сигнал. Согласно одному варианту осуществления микрофон 30 может быть использован для уменьшения обратной связи между устройством 20 захвата и вычислительной средой 12 в системе 10 распознавания, анализа и отслеживания цели. Дополнительно, микрофон 30 может быть использован для приема аудиосигналов, которые также могут быть выданы пользователем для управления приложениями, такими как игровые приложения, неигровые приложения или подобное, которые могут выполняться вычислительной средой 12.

[0041] В примерном варианте осуществления устройство 20 захвата может дополнительно включать в себя процессор 32, который может находиться в оперативной связи с компонентом 22 камеры изображения. Процессор 32 может включать в себя стандартизированный процессор, специализированный процессор, микропроцессор или подобное, которые могут выполнять команды, которые могут включать в себя команды для приема изображения глубины, определения, может ли подходящая цель быть включена в изображение глубины, преобразования подходящей цели в скелетное представление или модель цели или любую другую подходящую команду.

[0042] Устройство 20 захвата может дополнительно включать в себя компонент 34 памяти, который может сохранять команды, которые могут выполняться процессором 32, изображения или кадры изображений, захваченные 3-D камерой 26 или камерой 28 RGB, или любую другую подходящую информацию, изображения или подобное. Согласно примерному варианту осуществления компонент 34 памяти может включать в себя оперативное запоминающее устройство (RAM), постоянное запоминающее устройство (ROM), кэш, флэш-память, накопитель на жестких дисках или любой другой подходящий компонент хранения. Как показано на Фиг. 2, в одном варианте осуществления компонент 34 памяти может быть отдельным компонентом в связи с компонентом 22 захвата изображения и процессором 32. Согласно другому варианту осуществления компонент 34 памяти может быть объединен в процессор 32 и/или компонент 22 захвата изображения.

[0043] Как показано на Фиг. 2, устройство 20 захвата может находиться в связи с вычислительной средой 12 с помощью линии 36 связи. Линия 36 связи может быть проводным соединением, включающим в себя, например, соединение USB, соединение Firewire, кабельное соединение Ethernet или подобное, и/или беспроводным соединением, таким как беспроводное соединение 802.11b, g, a или n. Согласно одному варианту осуществления вычислительная среда 12 может обеспечивать часы устройству 20 захвата, которые могут быть использованы для определения, когда захватить, например, сцену с помощью линии 36 связи.

[0044] Дополнительно, устройство 20 захвата может выдавать информацию глубины и изображения, захваченные, например, 3-D камерой 26 и/или камерой 28 RGB, и скелетную модель, которая может генерироваться устройством 20 захвата к вычислительной среде 12 с помощью линии 36 связи. Затем вычислительная среда 12 может использовать скелетную модель, информацию глубины и захваченные изображения, например, для управления приложением, таким как игровой или текстовой процессор. Например, как показано на Фиг. 2, вычислительная среда 12 может включать в себя библиотеку 190 жестов.

[0045] Как показано на Фиг. 2, вычислительная среда 12 может включать в себя библиотеку 190 жестов и механизм 192 распознавания жестов. Механизм 192 распознавания жестов может включать в себя коллекцию фильтров 191 жеста. Фильтр может содержать код и ассоциированные данные, которые могут распознавать жесты или иначе обрабатывать глубину, RGB или скелетные данные. Каждый фильтр 191 может содержать информацию, определяющую жест наряду с параметрами, или метаданными, для этого жеста. Например, бросок, который содержит движение одной из рук из-за задней части тела мимо передней части тела, может быть реализовано как фильтр 191 жеста, содержащий информацию, представляющую движение одной из рук пользователя из-за задней части тела мимо передней части тела, когда это движение было захвачено камерой глубины. Затем для этого жеста могут быть установлены параметры. В случае когда жест является броском, параметр может быть предельной скоростью, которой рука должна достигнуть, расстоянием, которое рука должна пройти (или абсолютным, или относительным размера пользователя в целом), и оценкой достоверности посредством механизма устройства распознавания, что жест имел место. Эти параметры для жеста могут варьироваться между приложениями, между контекстами одного приложения или в пределах одного контекста одного приложения в течение времени.

[0046] В то время как рассматривается, что механизм распознавания жестов может включать в себя коллекцию фильтров жеста, причем фильтр может содержать код или иначе представлять компонент для обработки глубины, RGB или скелетных данных, причем использование фильтра не предназначается для ограничения анализа фильтром. Фильтр является представлением примерного компонента или секции кода, которая анализирует данные сцены, принятые системой, и сравнивает эти данные с базовой информаций, которая представляет жест. В результате анализа система может сделать вывод, соответствующий тому, соответствуют ли введенные данные жесту. Базовая информация, представляющая жест, может регулироваться, чтобы соответствовать повторяющемуся признаку в истории данных, представляющих движение захвата пользователя. Базовая информация, например, может быть частью фильтра жеста, как описано выше. Однако рассматривается любой подходящий способ для анализа введенных данных и данных жеста.

[0047] Жест может быть распознан как жест идентичности характера (темперамента). В примерном варианте осуществления движение в физическом пространстве может представлять жест, распознанный как запрос применить атрибуты конкретного характера к визуальному представлению цели. Множество жестов может представлять конкретный жест идентичности характера. Таким образом, пользователь может управлять формой визуального представления посредством жеста в физическом пространстве, который распознается как жест идентичности характера. Например, как описано выше, движение пользователя может сравниваться с фильтром жеста, таким как фильтр 191 жеста из Фиг. 2. Фильтр 191 жеста может содержать информацию для жеста идентичности характера из жестов 196 идентичности характера в библиотеке 190 жестов.

[0048] Множество жестов идентичности характера может представлять характер, имеющий атрибуты, которые должны быть применены к визуальному представлению на экране. Например, жест идентификации "взволнованный" может быть распознан из идентичности движения пользователя, содержащего движение прыжка вверх и вниз с руками пользователя, поднятыми в воздух. Результат может быть применением атрибутов, непосредственно сопоставленных с движением пользователя, и/или анимации в дополнение к движению пользователя, к визуальному представлению пользователя.

[0049] Данные, захваченные камерами 26, 28 и устройством 20 в форме скелетной модели, и перемещения, ассоциированные с ними, могут сравниваться с фильтрами 191 жеста в библиотеке 190 жестов для идентификации, когда пользователь (как представлено скелетной моделью) выполнил один или более жестов. Таким образом, вводы в фильтр, такой как фильтр 191, могут содержать данные, такие как данные соединения о соединенной позиции пользователя, как углы, сформированные костями, которые имеют место в суставе, данные цвета RGB из сцены и скорость изменения аспекта пользователя. Как упомянуто, параметры могут быть установлены для жеста. Выходные данные от фильтра 191 могут содержать параметры, такие как достоверность, что выполняется заданный жест, скорость, с которой выполняется движение жеста, и время, в которое жест имеет место.

[0050] Вычислительная среда 12 может включать в себя процессор 195, который может обрабатывать изображение глубины для определения, какие цели находятся на сцене, например, пользователь 18 или объект в комнате. Это может быть сделано, например, посредством группировки пикселей изображения глубины, которые совместно используют аналогичное значение расстояния. Изображение также может быть интерпретировано для формирования скелетного представления пользователя, где идентифицируются признаки, такие как суставы и ткани, которые находятся между суставами. Здесь существуют способы скелетного сопоставления для захвата человека камерой глубины, и из этого определяются различные точки на скелете этого пользователя, суставы руки, запястья, локти, колени, нос, лодыжки, плечи и где таз переходит в спинной хребет. Другие способы включают в себя преобразование изображения в представление модели человеческого тела и преобразование изображения в представление сетчатой модели человека.

[0051] В варианте осуществления обработка выполняется непосредственно на устройстве 20 захвата, и предварительные данные изображения значений глубины и цвета (где устройство 20 захвата содержит 3D камеру 26) передаются в вычислительную среду 12 с помощью линии 36 связи. В другом варианте осуществления выполняется обработка процессором 32, подсоединенным к камере 402, и затем проанализированные данные изображения посылают в вычислительную среду 12. В еще одном варианте осуществления как предварительные данные изображения, так и структурно проанализированные данные изображения посылаются в вычислительную среду 12. Вычислительная среда 12 может принимать структурно проанализированные данные изображения, но она может все еще принимать необработанные данные для выполнения текущего процесса или приложения. Например, если изображение сцены передается через компьютерную сеть другому пользователю, вычислительная среда 12 может передавать необработанные данные для обработки посредством другой вычислительной среды.

[0052] Вычислительная среда 12 может использовать библиотеку 190 жестов для интерпретации перемещений скелетной модели и управления приложением на основании этих перемещений. Вычислительная среда 12 может моделировать и отображать представление пользователя, например, в форме аватара или указателя, на дисплее, таком как в устройстве 193 отображения. Устройство 193 отображения может включать в себя монитор компьютера, телевизионный экран или любое подходящее устройство отображения. Например, управляемая камерой компьютерная система может захватывать пользовательские данные изображения и отображать пользовательскую обратную связь на телевизионном экране, который сопоставляется с жестами пользователя. Пользовательская обратная связь может быть отображена как аватар на экране, таком как показан на Фиг. 1A и 1B. Движение аватара может непосредственно управляться посредством сопоставления перемещения аватара с перемещениями пользователя. Жесты пользователя могут интерпретироваться некоторыми аспектами управления приложения.

[0053] Как описано выше, может быть желательно применить атрибуты характера к визуальному представлению цели. Например, пользователь может желать вынудить визуальное представление пользователя выполнить танец на экране, чтобы показать счастье пользователя. Пользователь может инициировать применение таких атрибутов посредством выполнения конкретного жеста идентичности характера.

[0054] Согласно примерному варианту осуществления цель может быть человеком-целью в любой позиции, такой как положение стоя или положение сидя, человеком-целью с объектом, двумя или более людьми-целями, одной или более частями одной или более людей-целей, или подобным, которые могут сканироваться, отслеживаться, моделироваться и/или оцениваться для генерирования виртуального экрана, сравнения пользователя с одним или более сохраненными профилями и/или сохранения информации 198 профиля о цели в вычислительной среде, такой как вычислительная среда 12. Информация 198 профиля может быть в форме профилей пользователя, персональных профилей, профилей приложения, профилей системы или любого другого подходящего способа для сохранения данных для более позднего доступа. Информация 198 профиля может быть доступной с помощью приложения или может быть доступной во всей системе, например. Информация 198 профиля может включать в себя таблицы поиска для загрузки специфичной пользовательской информации профиля. Виртуальный экран может взаимодействовать с приложением, которое может выполняться вычислительной средой 12, описанной выше с ссылками на Фиг. 1A-1B.

[0055] Согласно примерным вариантам осуществления таблицы поиска могут включать в себя специфичную для пользователя информацию профиля. В одном варианте осуществления вычислительная среда, такая как вычислительная среда 12, может включать в себя сохраненные данные 198 профиля об одном или более пользователях в таблицах поиска. Сохраненные данные 198 профиля, помимо всего прочего, могут включать в себя отсканированные цели или оцененный размер тела, скелетные модели, модели тела, голосовые примеры или пароли, возраст цели, предыдущие жесты, ограничения цели и стандартное использование системы целью, такое как, например, предпочтение сидеть, доминирование левой руки или правой руки, или предпочтение стоять очень близко к устройству захвата. Эта информация может быть использована для определения, есть ли соответствие между целью на сцене захвата и одним или более профилями 198 пользователя, которые в одном варианте осуществления могут позволить системе приспособить виртуальный экран к пользователю или приспособить другие элементы вычислительного или игрового опыта согласно профилю 198.

[0056] Один или более персональных профилей 198 могут быть сохранены в компьютерной среде 12 и использоваться во многих пользовательских сеансах, или один или более персональных профилей могут быть созданы только для единственного сеанса. Пользователи могут иметь опцию установления профиля, где они могут выдавать информацию в систему, такую как сканирование голоса или тела, возраст, персональные предпочтения, доминирование левой руки или правой руки, аватар, имя или подобное. Персональные профили также могут быть обеспечены для "гостей", которые не выдают информацию в систему за пределами вхождения в пространство захвата. Временный персональный профиль может быть установлен для одного или более "гостей". В конце сеанса гостя персональный профиль гостя может быть сохранен или удален.

[0057] Библиотека 190 жестов, механизм 192 распознавания жестов и профиль 198 могут быть реализованы в аппаратном обеспечении, программном обеспечении или их комбинации. Например, библиотека 190 жестов и механизм 192 распознавания жестов могут быть реализованы как программное обеспечение, которое выполняется на процессоре, таком как процессор 195, вычислительной среде 12 (или в блоке 101 обработки Фиг. 3 или блоке 259 обработки Фиг. 4).

[0058] Подчеркивается, что блок-схема, изображенная на Фиг. 2 и Фиг. 3-4, описанных ниже, является примерной и не предназначается, чтобы подразумевать конкретную реализацию. Таким образом, процессор 195 или 32 на Фиг. 1, блок 101 обработки согласно Фиг. 3 и блок 259 обработки согласно Фиг. 4 могут быть реализованы как единственный процессор или множественные процессоры. Множественные процессоры могут быть распределенными или центрально расположенными. Например, библиотека 190 жестов может быть реализована как программное обеспечение, которое выполняется на процессоре 32 устройства захвата или может быть реализована как программное обеспечение, которое выполняется на процессоре 195 в вычислительной среде 12. В настоящем описании рассматриваются любые комбинации процессоров, которые являются подходящими для выполнения раскрытых способов. Множественные процессоры могут связываться беспроводным образом с помощью жесткой проводниковой системы или ее комбинации.

[0059] Кроме того, используемая в настоящем описании вычислительная среда 12 может относиться к единственному вычислительному устройству или вычислительной системе. Вычислительная среда может включать в себя невычислительные компоненты. Вычислительная среда может включать в себя устройство отображения, такое как устройство 193 отображения, показанное на Фиг. 2. Устройство отображения может быть объектом, отдельным, но подсоединенным к вычислительной среде, или устройство отображения может быть вычислительным устройством, которое обрабатывает и отображает, например. Таким образом, вычислительная система, вычислительное устройство, вычислительная среда, компьютер, процессор или другой вычислительный компонент могут быть использованы взаимозаменяемо.

[0060] Библиотека жестов и параметры фильтра могут быть настроены для приложения или контекста приложения посредством инструмента жеста. Контекст может быть культурным контекстом и может быть контекстом среды. Культурный контекст относится к культуре пользователя, использующего систему. Различные культуры могут использовать аналогичные жесты для передачи заметно различных значений. Например, американский пользователь, который желает сказать другому пользователю "смотри" или "используй свои глаза", может положить свой указательный палец на свою голову близко к наружной стороне своего глаза. Однако итальянский пользователь может интерпретировать этот жест как отношение к мафии.

[0061] Аналогично могут существовать различные контексты среди различных сред одного приложения. Возьмем игру "шутер («стрелялку») от первого лица", которая включает управление автомобилем. В то время как пользователь находится на ногах, сжатие кулака пальцами по направлению к земле и вытягивание кулака вперед и от тела может представлять жест удара кулаком. В то время как пользователь находится в контексте вождения, то же движение может представлять жест "переключения скоростей". Относительно модификаций к визуальному представлению различные жесты могут вызывать различные модификации в зависимости от среды. Отличающийся жест механизма инициации модификации может быть использован для входа в режим модификации, специфичный для приложения, в отличие от режима модификации всей системы. Каждый режим модификации может быть укомплектован независимым набором жестов, который соответствует режиму модификации, введен в эксплуатацию как результат жеста механизма инициации модификации. Например, в игре "боулинг" раскачивающееся движение руки может быть жестом, идентифицированным как раскачивание шара для боулинга, чтобы кинуть его вниз на виртуальную дорожку. Однако в другом приложении раскачивающееся движение руки может быть жестом, идентифицированным как запрос удлинить руку аватара пользователя, отображенного на экране. Также может быть одна или более сред меню, где пользователь может сохранить свою игру, выбрать среди оборудования своего персонажа или выполнить аналогичные действия, которые не содержат непосредственную игру в игру. В этой среде один и тот же жест может иметь третье значение, например, выбрать что-нибудь или перейти к другому экрану.

[0062] Жесты могут группироваться в пакеты жанра дополнительных жестов, которые, вероятно, должны быть использованы приложением в этом жанре. Дополнительные жесты - являются или дополнительными, как те, которые обычно используются вместе, или дополнительными в случае, когда при изменении одного параметра изменяются параметр другого - могут группироваться в пакеты жанра. Эти пакеты могут быть выданы к приложению, которое может выбрать по меньшей мере один. Приложение может настраивать или модифицировать параметр жеста или фильтр 191 жестов, чтобы лучше соответствовать уникальным аспектам этого приложения. Когда настраивается этот параметр, второй, дополнительный, параметр (во взаимозависимом смысле) или жеста или второго жеста также настраивается таким образом, чтобы параметры оставались дополнительными. Пакеты жанра для видеоигр могут включать в себя жанры, такие как "шутер от первого лица", "экшен", "вождение" и спортивные игры.

[0063] Фиг. 3 иллюстрирует примерный вариант осуществления вычислительной среды, которая может быть использована для интерпретации одного или более жестов в системе распознавания, анализа и отслеживания цели. Вычислительная среда, такая как вычислительная среда 12, описанная выше с ссылками на Фиг. 1, 2, может быть мультимедийной консолью 100, такой как игровая консоль. Как показано на Фиг. 3, мультимедийная консоль 100 имеет центральный процессор (CPU) 101, имеющий кэш 102 уровня 1, кэш 104 уровня 2 и флеш ROM (постоянное запоминающее устройство) 106. Кэш 102 уровня 1 и кэш 104 уровня 2 временно хранят данные и, следовательно, сокращают количество циклов доступа к памяти, таким образом улучшая скорость обработки и производительность. Может быть обеспечен центральный процессор 101, имеющий более чем одно ядро, и, таким образом, дополнительные кэши 102 и 104 уровня 1 и уровня 2. Флеш ROM 106 может сохранять выполняемый код, который загружается во время первоначальной фазы процесса загрузки, когда включается мультимедийная консоль 100.

[0064] Блок 108 обработки графических данных (GPU) и видеокодер/видеокодек 114 (кодер/декодер) формируют магистраль обработки видео для обработки графических данных с высокой скоростью и при высоком разрешении. Данные переносятся от блока 108 обработки графических на видеокодер/видеокодек 114 по шине. Магистраль обработки видео выводит данные в порт 140 A/V (аудио/видео) для передачи на телевизор или другой дисплей. Контроллер 110 памяти соединяется с GPU 108, чтобы облегчить доступ процессора к различным типам памяти 112, такой как, но не ограниченной, RAM (оперативное запоминающее устройство).

[0065] Мультимедийная консоль 100 включает в себя контроллер 120 I/O (ввода/вывода), контроллер 122 управления системой, блок 123 аудиообработки, контроллер 124 интерфейса сети, хост-контроллер 126 первого USB, контроллер 128 второго USB и подсистему 130 I/O передней панели, которые предпочтительно реализуются в модуле 118. Контроллеры 126 и 128 USB служат как хосты для контроллеров 142 (1)-142 (2) периферийных устройств, беспроводного адаптера 148 и устройства 146 внешней памяти (например, флэш-память, внешний дисковод ROM CD/DVD, сменные носители и т.д.). Интерфейс 124 сети и/или беспроводной адаптер 148 обеспечивают доступ к сети (например, Интернету, домашней сети и т.д.) и могут быть любым широким разнообразием различных проводных или беспроводных компонентов адаптера, включающих в себя карту Ethernet, модем, модуль Bluetooth, кабельный модем и т.п.

[0066] Память 143 системы обеспечивается для хранения данных приложения, которые загружаются во время процесса загрузки. Медианакопитель 144 обеспечивается и может содержать дисковод DVD/CD, накопитель на жестких дисках или другой накопитель сменных носителей и т.д. Медианакопитель 144 может быть внутренним или внешним по отношению к мультимедийной консоли 100. Данные приложения могут быть доступны с помощью медианакопителя 144 для выполнения, воспроизведения и т.д. посредством мультимедийной консоли 100. Медианакопитель 144 соединяется с контроллером 120 I/O с помощью шины, такой как последовательная шина ATA или другое высокоскоростное соединение (например, IEEE 1394).

[0067] Контроллер 122 управления системой обеспечивает множество функций обслуживания, связанных с обеспечением доступности мультимедийной консоли 100. Блок 123 аудиообработки и аудиокодек 132 формируют соответствующую магистраль аудиообработки с высокой точностью и стерео обработку. Аудиоданные переносятся между блоком 123 аудиообработки и аудиокодеком 132 с помощью линии связи. Магистраль аудиообработки выводит данные в порт 140 A/V для воспроизведения посредством внешнего аудиоплейера или устройства, имеющего возможности аудио.

[0068] Подсистема 130 I/O передней панели поддерживает функциональные возможности кнопки 150 питания и кнопки 152 выгрузки, а также любых диодов LED (светоизлучающих диодов) или другие индикаторов, расположенных на внешней поверхности мультимедийной консоли 100. Модуль 136 электропитания системы обеспечивает энергию для компонентов мультимедийной консоли 100. Вентилятор 138 охлаждает схему в мультимедийной консоли 100.

[0069] Центральный процессор 101, GPU 108, контроллер 110 памяти и различные другие компоненты в мультимедийной консоли 100 соединяются с помощью одной или более шин, включающих в себя последовательные и параллельные шины, шину памяти, периферийную шину и процессор или локальную шину, используя любое множество шинных архитектур. Посредством примера такие архитектуры могут включать в себя шину межсоединения периферийных компонентов (PCI), PCI-Express шину и т.д.

[0070] Когда включается мультимедийная консоль 100, данные приложения могут быть загружены из памяти 143 системы в память 112 и/или кэши 102, 104 и выполняться на центральном процессоре 101. Приложение может представлять графический пользовательский интерфейс, который обеспечивает последовательный опыт пользователя при осуществлении навигации к различным видам носителей, доступных на мультимедийной консоли 100. Во время работы приложения и/или другие носители, содержащиеся на медиа накопителе 144, могут быть запущены или воспроизведены с медиа накопителя 144, чтобы обеспечить дополнительные функциональные возможности мультимедийной консоли 100.

[0071] Мультимедийная консоль 100 может управляться как автономная система посредством простого соединения системы с телевизором или другим дисплеем. В этом автономном режиме мультимедийная консоль 100 разрешает одному или более пользователям взаимодействовать с системой, смотреть кино или слушать музыку. Однако посредством интеграции широкополосной возможности соединения, доступной через интерфейс 124 сети или беспроводной адаптер 148, мультимедийная консоль 100 может дополнительно включаться как участник большего сетевого сообщества.

[0072] Когда мультимедийная консоль 100 включается, установленное количество ресурсов аппаратного обеспечения сохраняется для использования системы посредством операционной системой мультимедийной консоли. Эти ресурсы могут включать в себя резервирование памяти (например, 16 МБ), центральный процессор и циклы GPU (например, 5%), полосу пропускания вычислительной сети (например, 8 КБ) и т.д. Так как эти ресурсы резервируются во время загрузки системы, с точки зрения приложения не существует зарезервированных ресурсов.

[0073] В частности, резервирование памяти предпочтительно является достаточно большим, чтобы содержать ядро запуска, параллельные приложения системы и драйверы. Резервирование центрального процессора является предпочтительно постоянным таким образом, чтобы, если сохраненное использование центрального процессора не используется системными приложениями, неактивный поток потреблял бы любые неиспользованные циклы.

[0074] Относительно резервирования GPU легковесные сообщения, генерируемые приложениями системы (например, всплывающие окна), отображаются посредством использования прерывания GPU, чтобы запланировать код для визуализации всплывающего окна в программу оверлея. Объем памяти, требуемый для программы оверлея, зависит от размера области программы оверлея, и программа оверлея предпочтительно масштабируется в соответствии с разрешением экрана. В случае когда полный пользовательский интерфейс используется параллельным системным приложением, предпочтительно использовать разрешение независимо от разрешения приложения. Блок масштабирования может быть использован для установления этого разрешения таким образом, чтобы устранить необходимость изменять частоту и вызывать повторную синхронизацию TV.

[0075] После того как мультимедийная консоль 100 загружается и ресурсы системы резервируются, параллельные приложения системы выполняются для обеспечения функциональных возможностей системы. Функциональные возможности системы формируются в наборе системных приложений, которые выполняются в зарезервированных ресурсах системы, описанных выше. Ядро операционной системы идентифицирует потоки, которые являются потоками системного приложения, в зависимости от потоков игрового приложения. Системные приложения предпочтительно планируются для работы на CPU 101 в заранее определенное время и интервалы для обеспечения последовательного просмотра ресурсов системы приложению. Планирование должно минимизировать разрушение кэша для игрового приложения, работающего на консоли.

[0076] Когда параллельное системное приложение требует аудио, аудиообработка планируется асинхронно для игрового приложения из-за чувствительности по времени. Администратор приложений мультимедийной консоли (описанный ниже) управляет уровнем аудио игрового приложения (например, без звука, уменьшение звука), когда приложения системы являются активными.

[0077] Устройства ввода (например, контроллеры 142 (1) и 142 (2)) совместно используются игровыми приложениями и системными приложениями. Устройства ввода не являются зарезервированными ресурсами, но должны переключаться между системными приложениями и игровыми приложением таким образом, чтобы каждое приложение имело фокус устройства. Администратор приложений предпочтительно управляет переключением потока ввода, не зная о знании игрового приложения, и драйвер поддерживает информацию состояния относительно переключений фокуса. Камеры 26, 28 и устройство 20 захвата могут определять дополнительные устройства ввода для консоли 100.

[0078] Фиг. 4 иллюстрирует другой примерный вариант осуществления вычислительной среды 220, которая может быть вычислительной средой 12, показанной на Фиг. 1A-2, используемой для интерпретации одного или более жестов в системе распознавания, анализа и отслеживания цели. Вычислительная среда 220 системы является только одним примером подходящей вычислительной среды и не предназначается для выведения любого ограничения относительно области использования или функциональных возможностей в настоящий момент раскрываемой сущности изобретения. Вычислительная среда 220 не должна интерпретироваться как имеющая какую-либо зависимость или требования, относящиеся к любому одному или комбинации компонентов, иллюстрированных в примерной операционной среде 220. В некоторых вариантах осуществления различные изображенные вычислительные элементы могут включать в себя схему, сконфигурированную для иллюстрирования примерами конкретных аспектов настоящего описания. Например, используемый в раскрытии термин "схема" может включать в себя специализированные компоненты аппаратного обеспечения, сконфигурированные для выполнения функции(й) посредством программно-аппаратного обеспечения или переключений. В других примерных вариантах осуществления термин "схема" может включать в себя блок обработки специального назначения, память и т.д., сконфигурированные командами программного обеспечения, которые реализуют логику, действующую для выполнения функции(й). В примерных вариантах осуществления, где схема включает в себя комбинацию аппаратного обеспечения и программного обеспечения, блок реализации может написать исходный код, реализующий логику, и этот исходный код может компилироваться в считываемый машиной код, который может быть обработан блоком обработки специального назначения. Так как специалист в данной области техники может оценить, что состояние области техники развилось до точки, в которой существует небольшая разница между аппаратным обеспечением, программным обеспечением или комбинацией аппаратного обеспечения/программного обеспечения, выбор аппаратного обеспечения против программного обеспечения для реализации конкретных функций является выбором разработки, оставленной конструктору. Более конкретно, специалист в данной техники может оценить, что процесс программного обеспечения может быть преобразован в эквивалентную структуру аппаратного обеспечения и структура аппаратного обеспечения сама может быть преобразована в эквивалентный процесс программного обеспечения. Таким образом, выбор реализации в виде аппаратного обеспечения или реализации виде программного обеспечения является одним из выбора разработки и оставляется конструктору.

[0079] На Фиг. 4 вычислительная среда 220 содержит компьютер 241, который обычно включает в себя множество считываемых компьютером носителей. Считываемый компьютером носитель может быть любыми доступными носителями, которые могут быть доступны посредством компьютера 241, и они включают в себя как энергозависимые, так и энергонезависимые носители, сменные и несменные носители. Память 222 системы включает в себя компьютерные запоминающие носители в форме энергозависимой и/или энергонезависимой памяти, такой как постоянное запоминающее устройство (ROM) 223 и оперативное запоминающее устройство (RAM) 260. Базовая система 224 ввода/вывода (BIOS), содержащая базовые операции, которые помогают передавать информацию между элементами в компьютере 241, например, во время запуска, обычно хранится в ROM 223. RAM 260 обычно содержит данные и/или программные модули, которые являются немедленно доступными и/или в настоящее время управляются посредством блока 259 обработки. Посредством примера, а не ограничения, Фиг. 4 иллюстрирует операционную систему 225, прикладные программы 226, другие программные модули 227 и программные данные 228.

[0080] Компьютер 241 может также включать в себя другие сменные/несменные, энергозависимые/энергонезависимые компьютерные запоминающие носители. Только посредством примера Фиг. 4 иллюстрирует накопитель 238 на жестких дисках, который считывает с или записывает на несменные энергонезависимые магнитные носители, накопитель 239 на магнитных дисках, который считывает с или записывает на сменный энергонезависимый магнитный диск 254, и накопитель 240 на оптических дисках, который считывает с или записывает на сменный энергонезависимый оптический диск 253, такой как CD-ROM, или другие оптические носители. Другие сменные/несменные, энергозависимые/энергонезависимые компьютерные запоминающие носители, которые могут быть использованы в примерной операционной среде, включают в себя, но не ограничиваются, кассеты магнитной ленты, карты флэш-памяти, универсальные цифровые диски, цифровую видеоленту, твердотельное RAM, твердотельное ROM и т.п. Накопитель 238 на жестких дисках обычно соединен с системной шиной 221 через интерфейс несменной памяти, такой как интерфейс 234, и накопитель 239 на магнитных дисках и накопитель 240 на оптических дисках обычно соединены с системной шиной 221 посредством интерфейса сменной памяти, такого как интерфейс 235.

[0081] Драйверы и их ассоциированные компьютерные запоминающие носители, рассмотренные выше и иллюстрированные на Фиг. 4, обеспечивают сохранение считываемых компьютером команд, структур данных, программных модулей и других данных для компьютера 241. На Фиг. 4, например, накопитель 238 на жестких дисках иллюстрируется как сохраняющая операционная система 258, прикладные программы 257, другие программные модули 256 и программные данные 255. Отмечается, что эти компоненты могут быть или одними и теми же или отличаться от операционной системы 225, прикладных программ 226, других программных модулей 227 и программных данных 228. Операционной системе 258, прикладным программам 257, другим программным модулям 256 и программным данным 255 в настоящем описании задаются различные номера, чтобы иллюстрировать, что как минимум они являются различными копиями. Пользователь может вводить команды и информацию в компьютер 241 через устройства ввода, такие как клавиатура 251 и указывающее устройство 252, обычно называемое мышью, трэкболом или тачпадом. Другие устройства ввода (не показаны) могут включать в себя микрофон, джойстик, геймпад, спутниковую антенну, сканер или подобное. Эти и другие устройства ввода часто соединяются с блоком 259 обработки через пользовательский интерфейс 236 ввода, который подсоединяется к системной шине, но могут быть соединены с другими интерфейсами и шинными структурами, такими как параллельный порт, порт игры или универсальная последовательная шина (USB). Камеры 26, 28 и устройство 20 захвата могут определять дополнительные устройства ввода для консоли 100. Монитор 242 или другой тип устройства отображения также соединяется с шиной 221 системы с помощью интерфейса, такого как видеоинтерфейс 232. В дополнение к монитору компьютеры могут также включать в себя другие периферийные устройства вывода, такие как динамики 244 и принтер 243, который может быть соединен через интерфейс 233 периферийного устройства вывода.

[0082] Компьютер 241 может работать в сетевой среде, используя логические соединения с одним или более удаленными компьютерами, такими как удаленный компьютер 246. Удаленный компьютер 246 может быть персональным компьютером, сервером, маршрутизатором, сетевым PC, одноранговым устройством или другим общим узлом сети, и обычно включает в себя многие или все элементы, описанные выше относительно компьютера 241, хотя только запоминающее устройство 247 было иллюстрировано на Фиг. 4. Логические соединения, изображенные на Фиг. 2, включают в себя локальную сеть (LAN) 245 и глобальную сеть (WAN) 249, но могут также включать в себя другие сети. Такие сетевые среды широко распространены в офисах, компьютерных сетях всего предприятия, интранете и Интернете.

[0083] При использовании в сетевой среде LAN компьютер 241 соединяется с LAN 245 через сетевой интерфейс или адаптер 237. При использовании в сетевой среде WAN, компьютер 241 обычно включает в себя модем 250 или другое средство для установления связи по WAN 249, такой как Интернет. Модем 250, который может быть внутренним или внешним, может быть соединен с системной шиной 221 с помощью пользовательского интерфейса 236 ввода или другого соответствующего механизма. В сетевой среде программные модули, изображенные относительно компьютера 241 или его части, могут быть сохранены на удаленном запоминающем устройстве. Посредством примера, а не ограничения Фиг. 4 иллюстрирует удаленные прикладные программы 248, которые постоянно находятся на запоминающем устройстве 247. Следует оценить, что показанные сетевые соединения являются примерными, и могут быть использованы другие средства для установления линии связи между компьютерами.

[0084] Считываемый компьютером запоминающий носитель может содержать считываемые компьютером команды для изменения визуального представления. Команды могут содержать команды для визуализации визуального представления, приема данных сцены, где данные включают в себя данные, представляющие жест идентичности характера пользователя в физическом пространстве, и изменения визуального представления на основании жеста идентичности характера пользователя, где жест идентичности характера является жестом, который сопоставляется с элементом управления для применения атрибутов, указывающих характер, к визуальному представлению пользователя.

[0085] Фиг. 5A изображают примерное скелетное сопоставление пользователя, которое может генерироваться из данных изображения, захваченных устройством 20 захвата. В этом варианте осуществления идентифицируется множество суставов и костей: каждая рука 502, каждое предплечье 504, каждый локоть 506, каждый бицепс 508, каждое плечо 510, каждый таз 512, каждое бедро 514, каждое колено 516, каждая нога 518, каждая стопа 520, голова 522, туловище 524, верх 526 и низ 528 позвоночника, и талия 530. В случае, когда отслеживается больше точек, могут быть идентифицированы дополнительные признаки, такие как кости и суставы пальцев рук или пальцев ноги, или индивидуальные признаки лица, такие как нос и глаза.

[0086] Посредством перемещения своего тела пользователь может выполнять жесты. Жест содержит движение или позу пользователем, которая может быть захвачена как данные изображения и структурно проанализирована для значения. Жест может быть динамичным, содержащим движение, такое как имитация броска шара. Жест может быть статической позой, такой как фиксация скрещенных рук 504 перед своим туловищем 524. Жест может также включать предметы, например, посредством размахивания имитирующего меча. Жест может содержать более чем одну часть тела, например, хлопанье в ладоши 502, или еле заметное движение, такое как сжимание губ.

[0087] Жесты пользователя могут быть использованы для ввода в общем вычислительном контексте. Например, различные движения рук 502 или другие части тела могут соответствовать общим задачам всей системы, таким как осуществление навигации вверх или вниз в иерархическом списке, открытие файла, закрытие файла и сохранение файла. Например, пользователь может держать свою руку с пальцами, указывающими вверх, и ладонью, обращенной к устройству 20 захвата. Затем он может приблизить свои пальцы к ладони, чтобы сжать кулак, и это может быть жестом, который указывает, что должно быть закрыто сфокусированное окно в вычислительное среде пользовательского интерфейса, основанного на окне. Жесты также могут быть использованы в контексте, специфичном для видеоигры, в зависимости от этой игры. Например, в игре "вождение автомобиля" различные движения рук 502 и стоп 520 могут соответствовать управлению направления движения транспортного средства, переключению передачи, ускорению и торможению. Таким образом, жест может указывать широкое разнообразие движений, которые сопоставляются с отображенным представлением пользователя и в широком разнообразии приложений, таких как видеоигры, текстовые редакторы, обработка текста, обработка данных и т.д.

[0088] Пользователь может генерировать жест, который соответствует ходьбе или бегу посредством хождения или бега на месте в физическом пространстве. Например, пользователь может поочередно поднимать и опускать каждую ногу 512-520, чтобы имитировать ходьбу без перемещения. Система может анализировать этот жест посредством анализа таза 512 и каждого бедра 514. Шаг может быть распознан, когда один угол таз-бедро (как измерено относительно вертикальной линии, где неподвижная нога имеет угол таз-бедро 0°, и прямая горизонтально вытянутая нога имеет угол таз-бедро 90°) превышает некоторый предел относительно другого бедра. Ходьба или бег могут быть распознаны после некоторого количества последовательных шагов посредством чередования ног. Время между двумя последними шагами может быть рассмотрено как период. После некоторого количества периодов, в которых не удовлетворяется этот предельный угол, система может определить, что жест ходьбы или бега прекратился.

[0089] Принимая во внимание жест "ходьбы или бега", приложение может устанавливать значения для параметров, ассоциированных с этим жестом. Эти параметры могут включать в себя вышеупомянутый предельный угол, количество требуемых шагов, чтобы инициировать жест ходьбы или бега, ряд периодов, где не имеет место шаг, чтобы закончить жест, и предельный период, который определяет, является ли жест ходьбой или бегом. Быстрый период может соответствовать бегу, поскольку пользователь будет двигать своими ногами быстро, и более медленный период может соответствовать ходьбе.

[0090] Жест может быть ассоциирован с рядом установленных по умолчанию параметров вначале, которые приложение может заменять своими собственными параметрами. В этом сценарии приложению не нужно обеспечивать параметры, но вместо этого оно может использовать ряд установленных по умолчанию параметров, которые разрешают жесту распознаваться в отсутствии определенных приложением параметров. Информация, относящаяся к жесту, может храниться в целях предварительно заготовленной анимации.

[0091] Существует множество выводов, которые могут быть ассоциированы с жестом. Могут быть базовые показатели "да или нет" относительно того, имеет ли место жест. Также может быть уровень достоверности, который соответствует вероятности, что отслеженное перемещение пользователя соответствует жесту. Это может быть линейным масштабом, который варьируется в соответствии с числами с плавающей запятой между 0 и 1 включительно. Там, где приложение, принимающее эту информацию жеста, не может принять ошибочные срабатывания как ввод, оно может использовать только те распознанные жесты, которые имеют высокий уровень достоверности, такой по меньшей мере 0,95. В случае когда приложение должно распознать каждый случай жеста даже за счет ошибочных срабатываний, оно может использовать жесты, которые имеют по меньшей мере намного более низкий уровень достоверности, например, который просто больше чем 0,2. Жест может иметь вывод в течение времени между двумя самыми последними шагами, и где был зарегистрирован только первый шаг, он может быть установлен в зарезервированное значение, такое как 1 (так как время между любыми двумя шагами должно быть положительным). Жест может также иметь вывод для самого высокого угла бедра, достигнутого во время самого последнего шага.

[0092] Другим примерным жестом является "прыжок с подъемом пяток". Здесь пользователь может создавать жест посредством подъема своих пяток от земли, но сохраняя свои пальцы ног расположенными на земле. Альтернативно, пользователь может прыгнуть в воздух, где его ноги 520 полностью отрываются от земли. Система может структурно проанализировать скелет для этого жеста посредством анализа отношения угла плеч 510, таза 512 и коленей 516, чтобы увидеть, находятся ли они в позиции выравнивания, равного положению прямо. Затем эти точки, и верхние 526 и нижние 528 точки позвоночника могут контролироваться для любого восходящего ускорения. Достаточная комбинация ускорения может инициировать жест прыжка. Достаточная комбинация ускорения с конкретным жестом может удовлетворять параметрам точки перехода.

[0093] Учитывая этот жест "прыжка с подъемом пяток", приложение может установить значения для параметров, ассоциированных с этим жестом. Параметры могут включать в себя вышеупомянутый предел ускорения, который определяет, как быстро некоторая комбинация плеч 510, таза 512 и коленей 516 пользователя должна перемещаться вверх, чтобы инициировать жест, а также максимальный угол выравнивания между плечами 510, тазом 512 и коленями 516, в котором все еще может быть инициирован прыжок. Выводы могут содержать уровень достоверности, а также угол тела пользователя во время прыжка.

[0094] Установление параметров для жеста на основании подробных сведений приложения, которое примет жест, являются важными при точной идентификации жестов. Должным образом идентифицировавшие жесты и намерение пользователя очень помогают при создании положительного опыта пользователя.

[0095] Приложение может устанавливать значения для параметров, ассоциированных с различными точками перехода, чтобы идентифицировать точки для использования предварительно заготовленной анимации. Точки перехода могут быть определены различными параметрами, такими как идентификация конкретного жеста, скорость, угол цели или объекта, или любой их комбинации. Если точка перехода определяется по меньшей мере частично посредством идентификации конкретного жеста, то должным образом идентификация жестов способствует увеличению уровня достоверности, при котором были удовлетворены параметры точки перехода.

[0096] Другой параметр для жеста может быть перемещенным расстоянием. В случае когда жесты пользователя управляют действиями визуального представления в виртуальной среде, этот аватар может быть длиной руки от шара. Если пользователь желает взаимодействовать с шаром и схватить его, может потребоваться, чтобы пользователь вытянул свою руку 502-510 в полную длину, выполняя жест захвата. В этой ситуации аналогичный жест захвата, где пользователь только частично вытягивает свою руку 502-510, может не достигнуть результата взаимодействия с шаром. Аналогично, параметр точки перехода может быть идентификацией жеста захвата, где, если пользователь только частично вытягивает свою руку 502-510, таким образом, не достигая результата взаимодействия с шаром, жест пользователя также не будет удовлетворять параметры точки перехода.