JP6286123B2 - 情報処理装置、コンテンツ提供方法及びコンピュータプログラム - Google Patents

情報処理装置、コンテンツ提供方法及びコンピュータプログラム Download PDFInfo

- Publication number

- JP6286123B2 JP6286123B2 JP2012285514A JP2012285514A JP6286123B2 JP 6286123 B2 JP6286123 B2 JP 6286123B2 JP 2012285514 A JP2012285514 A JP 2012285514A JP 2012285514 A JP2012285514 A JP 2012285514A JP 6286123 B2 JP6286123 B2 JP 6286123B2

- Authority

- JP

- Japan

- Prior art keywords

- content

- information

- trigger

- mobile terminal

- captured

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

- 230000010365 information processing Effects 0.000 title claims description 21

- 238000000034 method Methods 0.000 title claims description 10

- 238000004590 computer program Methods 0.000 title claims description 8

- 238000003384 imaging method Methods 0.000 claims description 52

- 230000003190 augmentative effect Effects 0.000 claims description 16

- 238000010586 diagram Methods 0.000 description 47

- 230000000694 effects Effects 0.000 description 12

- 230000008901 benefit Effects 0.000 description 7

- 238000004891 communication Methods 0.000 description 7

- 230000008450 motivation Effects 0.000 description 7

- 230000008859 change Effects 0.000 description 5

- 239000003550 marker Substances 0.000 description 5

- 230000006870 function Effects 0.000 description 4

- 101001053302 Homo sapiens Serine protease inhibitor Kazal-type 7 Proteins 0.000 description 3

- 102100024376 Serine protease inhibitor Kazal-type 7 Human genes 0.000 description 3

- 238000001914 filtration Methods 0.000 description 3

- 230000009471 action Effects 0.000 description 2

- 238000005516 engineering process Methods 0.000 description 2

- 230000008569 process Effects 0.000 description 2

- 230000002123 temporal effect Effects 0.000 description 2

- 239000008186 active pharmaceutical agent Substances 0.000 description 1

- 230000000295 complement effect Effects 0.000 description 1

- 238000010191 image analysis Methods 0.000 description 1

- 229910044991 metal oxide Inorganic materials 0.000 description 1

- 150000004706 metal oxides Chemical class 0.000 description 1

- 238000012986 modification Methods 0.000 description 1

- 230000004048 modification Effects 0.000 description 1

- 230000001737 promoting effect Effects 0.000 description 1

- 230000004044 response Effects 0.000 description 1

- 239000004065 semiconductor Substances 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V20/00—Scenes; Scene-specific elements

- G06V20/20—Scenes; Scene-specific elements in augmented reality scenes

Landscapes

- Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Multimedia (AREA)

- Theoretical Computer Science (AREA)

- Information Transfer Between Computers (AREA)

- Processing Or Creating Images (AREA)

- Management, Administration, Business Operations System, And Electronic Commerce (AREA)

- User Interface Of Digital Computer (AREA)

Description

<1.本開示の一実施形態>

[システムの概要]

[サーバ装置の機能構成例]

[携帯端末の機能構成例]

[サーバ装置及び携帯端末の動作例]

[携帯端末の表示画面例]

<2.まとめ>

[システムの概要]

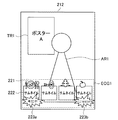

まず、図面を参照しながら本開示の一実施形態に係るARアプリケーションが用いられたシステムの概要を説明する。図1は、本開示の一実施形態に係るARアプリケーションが用いられたシステムの概要を示す説明図である。以下、図1を用いて本開示の一実施形態に係るARアプリケーションが用いられたシステムの概要について説明する。

図2は、本開示の一実施形態に係るサーバ装置100の機能構成例を示す説明図である。以下、図2を用いて本開示の一実施形態に係るサーバ装置100の機能構成例について説明する。

図3は、本開示の一実施形態に係る携帯端末200の機能構成例を示す説明図である。以下、図3を用いて本開示の一実施形態に係る携帯端末200の機能構成例について説明する。

図4は、本開示の一実施形態に係るサーバ装置100及び携帯端末200の動作例を示す説明図である。図4に示した流れ図は、携帯端末200で実空間の画像を撮像し、サーバ装置100で、その画像に重畳させるARコンテンツ、及びトリガ情報に関連するECGコンテンツを取得して携帯端末200に提供する際の動作例である。以下、図4を用いて本開示の一実施形態に係るサーバ装置100及び携帯端末200の動作例について説明する。

以上説明したように本開示の一実施形態によれば、携帯端末200において撮像画像が撮像された時点の状況又は過去のコンテンツの取得状況、及び携帯端末200で撮像されるトリガ情報に対応した、ARコンテンツ情報が含まれるコンテンツを携帯端末200に提供することが出来るサーバ装置100が提供される。

(1)

撮像画像を取得し、該撮像画像に含まれている所定のトリガ情報を認識するトリガ認識部と、

前記撮像画像が撮像された時点の状況又は過去のコンテンツの取得状況、及び前記トリガ認識部が認識した前記所定のトリガ情報に対応した、拡張現実情報が含まれるコンテンツを取得するコンテンツ取得部と、

を備える、情報処理装置。

(2)

前記コンテンツ取得部は、前記過去のコンテンツの取得状況として前記所定のトリガ情報の撮像に基づいて取得されたコンテンツの履歴を用いてコンテンツを取得する、前記(1)に記載の情報処理装置。

(3)

前記コンテンツ取得部は、前記所定のトリガ情報の撮像に基づくコンテンツに関連するコンテンツが既に取得されているか否かに応じて、取得するコンテンツを変化させる、(2)に記載の情報処理装置。

(4)

前記コンテンツ取得部は、過去に同一のトリガ情報が撮像されていたか否かに応じて、取得するコンテンツを変化させる、前記(2)または(3)に記載の情報処理装置。

(5)

前記コンテンツ取得部は、同一のトリガ情報の過去の撮像回数に応じて、取得するコンテンツを変化させる、前記(2)〜(4)のいずれかに記載の情報処理装置。

(6)

前記コンテンツ取得部は、前記撮像画像が撮像された時点の状況として前記撮像画像が撮像された環境に関する情報を用いてコンテンツを取得する、前記(1)〜(5)のいずれかに記載の情報処理装置。

(7)

前記コンテンツ取得部は、前記撮像画像が撮像された環境に関する情報として前記撮像画像が撮像された日時の情報を用いてコンテンツを取得する、前記(6)に記載の情報処理装置。

(8)

前記コンテンツ取得部は、前記撮像画像が撮像された環境に関する情報として前記撮像画像が撮像された場所の情報を用いてコンテンツを取得する、前記(6)または(7)に記載の情報処理装置。

(9)

前記コンテンツ取得部は、前記撮像画像が撮像された時点の状況として前記撮像画像を取得したユーザの属性を用いてコンテンツを取得する、前記(1)〜(8)のいずれかに記載の情報処理装置。

(10)

撮像画像を取得し、該撮像画像に含まれている所定のトリガ情報を認識するトリガ認識ステップと、

前記撮像画像が撮像された時点の状況又は過去のコンテンツの取得状況、及び前記トリガ認識部が認識した前記所定のトリガ情報に対応した、拡張現実情報が含まれるコンテンツを取得するコンテンツ取得ステップと、

を備える、コンテンツ提供方法。

(11)

コンピュータに、

撮像画像を取得し、該撮像画像に含まれている所定のトリガ情報を認識するトリガ認識ステップと、

前記撮像画像が撮像された時点の状況又は過去のコンテンツの取得状況、及び前記トリガ認識部が認識した前記所定のトリガ情報に対応した、拡張現実情報が含まれるコンテンツを取得するコンテンツ取得ステップと、

を実行させる、コンピュータプログラム。

102 トリガ認識部

104 ARコンテンツ表示制御部

106 ARコンテンツ情報管理データベース

108 データ制御部

110 ECG表示制御部

112 ECGコンテンツ情報管理データベース

114 関連付けエンジン部

116 ログ管理データベース

118 ポイント管理データベース

200 携帯端末

202 撮像部

204 データ通信部

206 位置情報取得部

208 表示制御部

210 操作部

212 表示部

Claims (11)

- 撮像画像を取得し、該撮像画像に含まれている拡張現実コンテンツを表示するための所定のトリガ情報を認識するトリガ認識部と、

前記撮像画像が撮像された時点の状況又は過去のコンテンツの取得状況、及び前記トリガ認識部が認識した前記所定のトリガ情報に対応した、拡張現実情報が含まれるコンテンツを取得するコンテンツ取得部と、

を備え、

前記コンテンツ取得部は、前記トリガ情報に関連する少なくとも1つの他のトリガ情報が前記所定のトリガ情報に存在する場合、前記トリガ情報に対応する前記拡張現実情報と前記少なくとも1つの他のトリガ情報とを含む前記コンテンツを取得する、情報処理装置。 - 前記コンテンツ取得部は、前記過去のコンテンツの取得状況として前記所定のトリガ情報の撮像に基づいて取得されたコンテンツの履歴を用いてコンテンツを取得する、請求項1に記載の情報処理装置。

- 前記コンテンツ取得部は、前記所定のトリガ情報の撮像に基づくコンテンツに関連するコンテンツが既に取得されているか否かに応じて、取得するコンテンツを変化させる、請求項2に記載の情報処理装置。

- 前記コンテンツ取得部は、過去に同一のトリガ情報が撮像されていたか否かに応じて、取得するコンテンツを変化させる、請求項2または3に記載の情報処理装置。

- 前記コンテンツ取得部は、同一のトリガ情報の過去の撮像回数に応じて、取得するコンテンツを変化させる、請求項2〜4のいずれかに記載の情報処理装置。

- 前記コンテンツ取得部は、前記撮像画像が撮像された時点の状況として前記撮像画像が撮像された環境に関する情報を用いてコンテンツを取得する、請求項1〜5のいずれかに記載の情報処理装置。

- 前記コンテンツ取得部は、前記撮像画像が撮像された環境に関する情報として前記撮像画像が撮像された日時の情報を用いてコンテンツを取得する、請求項6に記載の情報処理装置。

- 前記コンテンツ取得部は、前記撮像画像が撮像された環境に関する情報として前記撮像画像が撮像された場所の情報を用いてコンテンツを取得する、請求項6または7に記載の情報処理装置。

- 前記コンテンツ取得部は、前記撮像画像が撮像された時点の状況として前記撮像画像を取得したユーザの属性を用いてコンテンツを取得する、請求項1〜8のいずれかに記載の情報処理装置。

- 撮像画像を取得し、該撮像画像に含まれている拡張現実コンテンツを表示するための所定のトリガ情報を認識するトリガ認識ステップと、

前記撮像画像が撮像された時点の状況又は過去のコンテンツの取得状況、及び前記トリガ認識ステップで認識された前記所定のトリガ情報に対応した、拡張現実情報が含まれるコンテンツを取得するコンテンツ取得ステップと、

を備え、

前記コンテンツ取得ステップでは、前記トリガ情報に関連する少なくとも1つの他のトリガ情報が前記所定のトリガ情報に存在する場合、前記トリガ情報に対応する前記拡張現実情報と前記少なくとも1つの他のトリガ情報とを含む前記コンテンツが取得される、プロセッサによるコンテンツ提供方法。 - コンピュータに、

撮像画像を取得し、該撮像画像に含まれている拡張現実コンテンツを表示するための所定のトリガ情報を認識するトリガ認識ステップと、

前記撮像画像が撮像された時点の状況又は過去のコンテンツの取得状況、及び前記トリガ認識ステップで認識された前記所定のトリガ情報に対応した、拡張現実情報が含まれるコンテンツを取得するコンテンツ取得ステップと、

を実行させ、

前記コンテンツ取得ステップでは、前記トリガ情報に関連する少なくとも1つの他のトリガ情報が前記所定のトリガ情報に存在する場合、前記トリガ情報に対応する前記拡張現実情報と前記少なくとも1つの他のトリガ情報とを含む前記コンテンツが取得される、コンピュータプログラム。

Priority Applications (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2012285514A JP6286123B2 (ja) | 2012-12-27 | 2012-12-27 | 情報処理装置、コンテンツ提供方法及びコンピュータプログラム |

| US14/104,220 US9418293B2 (en) | 2012-12-27 | 2013-12-12 | Information processing apparatus, content providing method, and computer program |

| CN201310711161.7A CN103902641B (zh) | 2012-12-27 | 2013-12-20 | 信息处理设备,内容提供方法和计算机程序 |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2012285514A JP6286123B2 (ja) | 2012-12-27 | 2012-12-27 | 情報処理装置、コンテンツ提供方法及びコンピュータプログラム |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2014127148A JP2014127148A (ja) | 2014-07-07 |

| JP2014127148A5 JP2014127148A5 (ja) | 2016-02-12 |

| JP6286123B2 true JP6286123B2 (ja) | 2018-02-28 |

Family

ID=50993967

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2012285514A Active JP6286123B2 (ja) | 2012-12-27 | 2012-12-27 | 情報処理装置、コンテンツ提供方法及びコンピュータプログラム |

Country Status (3)

| Country | Link |

|---|---|

| US (1) | US9418293B2 (ja) |

| JP (1) | JP6286123B2 (ja) |

| CN (1) | CN103902641B (ja) |

Families Citing this family (26)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US20140067869A1 (en) * | 2012-08-30 | 2014-03-06 | Atheer, Inc. | Method and apparatus for content association and history tracking in virtual and augmented reality |

| US10289204B2 (en) * | 2012-11-15 | 2019-05-14 | Quantum Interface, Llc | Apparatuses for controlling electrical devices and software programs and methods for making and using same |

| JP2015090553A (ja) * | 2013-11-05 | 2015-05-11 | 株式会社ソニー・コンピュータエンタテインメント | 端末装置、付加情報管理装置、および付加情報管理方法 |

| JP6422259B2 (ja) * | 2014-08-05 | 2018-11-14 | 株式会社ステラリンク | 情報提供システム |

| WO2016093106A1 (ja) * | 2014-12-11 | 2016-06-16 | 恵比寿十四株式会社 | 情報提示装置、情報提示システム、情報提示方法および情報提示プログラム |

| JP6731605B2 (ja) * | 2014-12-11 | 2020-07-29 | 株式会社リリピア | 情報提示装置、情報提示システム、情報提示方法および情報提示プログラム |

| JP6622990B2 (ja) * | 2015-06-29 | 2019-12-18 | オリンパス株式会社 | 情報弁別装置、情報弁別方法及び情報弁別プログラム |

| JP6256430B2 (ja) * | 2015-08-17 | 2018-01-10 | コニカミノルタ株式会社 | コンテンツ提供サーバ、コンテンツ提供方法、およびコンピュータプログラム |

| US20170116664A1 (en) * | 2015-10-27 | 2017-04-27 | Sk Planet Co., Ltd. | Method and apparatus for constructing information about location of displayed commodity |

| CN105577820A (zh) * | 2016-01-27 | 2016-05-11 | 姚茜晨 | 基于云端匹配通过手机app进行商品即拍即售的方法 |

| JP6900633B2 (ja) * | 2016-04-13 | 2021-07-07 | 凸版印刷株式会社 | 携帯通信端末、携帯通信端末を制御するためのプログラム、情報処理方法、および、コンピュータに情報処理方法を実現させるためのプログラム |

| CN108697934A (zh) | 2016-04-29 | 2018-10-23 | 奥瑞斯玛有限公司 | 与目标图像有关的引导信息 |

| TWI615776B (zh) * | 2016-12-23 | 2018-02-21 | 李雨暹 | 移動物件的虛擬訊息建立方法、搜尋方法與應用系統 |

| CN107123013B (zh) | 2017-03-01 | 2020-09-01 | 阿里巴巴集团控股有限公司 | 基于增强现实的线下交互方法及装置 |

| JP6395012B1 (ja) * | 2017-03-17 | 2018-09-26 | ラスパンダス株式会社 | コンピュータプログラム |

| CN107230237A (zh) * | 2017-06-19 | 2017-10-03 | 歌尔科技有限公司 | 信息处理方法及装置 |

| US10949667B2 (en) * | 2017-09-14 | 2021-03-16 | Ebay Inc. | Camera platform and object inventory control |

| CN108108023B (zh) * | 2018-01-02 | 2021-02-19 | 联想(北京)有限公司 | 一种显示方法和显示系统 |

| US10558878B2 (en) | 2018-01-19 | 2020-02-11 | Timothy R. Fitzpatrick | System and method for organizing edible or drinkable materials |

| CN108932632A (zh) * | 2018-06-01 | 2018-12-04 | 北京市商汤科技开发有限公司 | 广告互动方法及装置、电子设备和存储介质 |

| JP7110738B2 (ja) * | 2018-06-05 | 2022-08-02 | 大日本印刷株式会社 | 情報処理装置、プログラム及び情報処理システム |

| US10916220B2 (en) | 2018-08-07 | 2021-02-09 | Apple Inc. | Detection and display of mixed 2D/3D content |

| KR20200017325A (ko) * | 2018-08-08 | 2020-02-18 | 주식회사 소울핑거 | 증강현실 컨텐츠 제공 시스템 및 방법 |

| JP6889304B1 (ja) * | 2020-03-31 | 2021-06-18 | 株式会社博報堂Dyホールディングス | 拡張現実表示システム、拡張現実表示方法、及びコンピュータプログラム |

| JP7364757B1 (ja) | 2022-09-02 | 2023-10-18 | 株式会社電通 | 情報処理システム、情報処理方法、プログラム、記憶媒体及び情報処理装置 |

| JP2024049672A (ja) * | 2022-09-29 | 2024-04-10 | 富士フイルム株式会社 | システム、端末、サーバ、画像表示方法、及びプログラム |

Family Cites Families (22)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US6678425B1 (en) * | 1999-12-06 | 2004-01-13 | Xerox Corporation | Method and apparatus for decoding angular orientation of lattice codes |

| US6935562B2 (en) * | 1999-12-06 | 2005-08-30 | Xerox Corporation | Operations on images having glyph carpets |

| US6765569B2 (en) * | 2001-03-07 | 2004-07-20 | University Of Southern California | Augmented-reality tool employing scene-feature autocalibration during camera motion |

| US7707039B2 (en) * | 2004-02-15 | 2010-04-27 | Exbiblio B.V. | Automatic modification of web pages |

| US8547401B2 (en) * | 2004-08-19 | 2013-10-01 | Sony Computer Entertainment Inc. | Portable augmented reality device and method |

| JP5032798B2 (ja) * | 2006-03-24 | 2012-09-26 | 富士フイルム株式会社 | 情報提供装置、情報提供システムおよび情報提供方法 |

| JP5063023B2 (ja) * | 2006-03-31 | 2012-10-31 | キヤノン株式会社 | 位置姿勢補正装置、位置姿勢補正方法 |

| US8726195B2 (en) * | 2006-09-05 | 2014-05-13 | Aol Inc. | Enabling an IM user to navigate a virtual world |

| US8023725B2 (en) * | 2007-04-12 | 2011-09-20 | Samsung Electronics Co., Ltd. | Identification of a graphical symbol by identifying its constituent contiguous pixel groups as characters |

| US20080266323A1 (en) * | 2007-04-25 | 2008-10-30 | Board Of Trustees Of Michigan State University | Augmented reality user interaction system |

| US20100309226A1 (en) * | 2007-05-08 | 2010-12-09 | Eidgenossische Technische Hochschule Zurich | Method and system for image-based information retrieval |

| US20090286570A1 (en) * | 2008-05-15 | 2009-11-19 | Sony Ericsson Mobile Communications Ab | Portable communication device and method of processing embedded visual cues |

| JP2010039095A (ja) * | 2008-08-04 | 2010-02-18 | Seiko Epson Corp | 音声出力制御装置、音声出力装置、音声出力制御方法、及び、プログラム |

| US8831279B2 (en) * | 2011-03-04 | 2014-09-09 | Digimarc Corporation | Smartphone-based methods and systems |

| US20110153341A1 (en) * | 2009-12-17 | 2011-06-23 | General Electric Company | Methods and systems for use of augmented reality to improve patient registration in medical practices |

| KR101002030B1 (ko) * | 2010-04-30 | 2010-12-16 | (주)올라웍스 | 단말 장치로 입력되는 입력 영상 및 상기 입력 영상에 관련된 정보를 이용하여 증강 현실을 제공하기 위한 방법, 단말 장치 및 컴퓨터 판독 가능한 기록 매체 |

| US20110287811A1 (en) * | 2010-05-21 | 2011-11-24 | Nokia Corporation | Method and apparatus for an augmented reality x-ray |

| KR101338818B1 (ko) * | 2010-11-29 | 2013-12-06 | 주식회사 팬택 | 이동 단말기 및 이를 이용한 정보 표시 방법 |

| JP2012155655A (ja) | 2011-01-28 | 2012-08-16 | Sony Corp | 情報処理装置、報知方法及びプログラム |

| JP5765019B2 (ja) * | 2011-03-31 | 2015-08-19 | ソニー株式会社 | 表示制御装置、表示制御方法、およびプログラム |

| JP2012215989A (ja) * | 2011-03-31 | 2012-11-08 | Toppan Printing Co Ltd | 拡張現実表示方法 |

| JP2013105345A (ja) * | 2011-11-14 | 2013-05-30 | Sony Corp | 情報登録装置、情報登録方法、情報登録システム、情報提示装置、情報提示方法、情報提示システムおよびプログラム |

-

2012

- 2012-12-27 JP JP2012285514A patent/JP6286123B2/ja active Active

-

2013

- 2013-12-12 US US14/104,220 patent/US9418293B2/en active Active

- 2013-12-20 CN CN201310711161.7A patent/CN103902641B/zh active Active

Also Published As

| Publication number | Publication date |

|---|---|

| US9418293B2 (en) | 2016-08-16 |

| JP2014127148A (ja) | 2014-07-07 |

| CN103902641A (zh) | 2014-07-02 |

| CN103902641B (zh) | 2019-03-22 |

| US20140185871A1 (en) | 2014-07-03 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6286123B2 (ja) | 情報処理装置、コンテンツ提供方法及びコンピュータプログラム | |

| CN105283896B (zh) | 营销系统以及营销方法 | |

| JP6070705B2 (ja) | 情報処理装置、そのデータ処理方法、およびプログラム | |

| CN203224887U (zh) | 显示控制设备 | |

| TWI624796B (zh) | Method for accessing network information through graphic coding, client device and server | |

| CN108388637A (zh) | 一种用于提供增强现实服务的方法、装置以及相关设备 | |

| US20150067041A1 (en) | Information services for real world augmentation | |

| JP2012190094A (ja) | サーバ装置、情報処理方法及びプログラム | |

| JP6120467B1 (ja) | サーバ装置、端末装置、情報処理方法、およびプログラム | |

| US20150088637A1 (en) | Information processing system, information processing method, and non-transitory computer readable storage medium | |

| CN104025615A (zh) | 交互式视频流 | |

| WO2014017393A1 (ja) | 情報処理装置、そのデータ処理方法、およびプログラム | |

| JP2018128955A (ja) | スクリーンショット画像解析装置、スクリーンショット画像解析方法、およびプログラム | |

| JP2007200099A (ja) | アイテム選択支援装置、方法およびプログラム | |

| JP2012027746A (ja) | コンテンツシステム、サーバ装置及びサーバ装置の動作方法 | |

| KR101096365B1 (ko) | 로고를 이용한 모바일 서비스 방법 및 이를 수행하는 이동 통신 단말기 | |

| JP2013250743A (ja) | コーディネート提案装置、コーディネート提案システム、コーディネート提案方法、プログラム、記録媒体 | |

| KR20170091803A (ko) | 가상 피팅 장치 및 그 동작 방법 | |

| JP7281012B1 (ja) | プログラム、情報処理方法及び情報処理システム | |

| JP2017228278A (ja) | サーバ装置、端末装置、情報処理方法、およびプログラム | |

| JP2012048648A (ja) | 情報サービスシステムおよび情報サービス方法 | |

| JP6580762B1 (ja) | 仮想カプセルトイゲームシステム及び仮想カプセルトイゲーム方法 | |

| JP6422259B2 (ja) | 情報提供システム | |

| KR101523349B1 (ko) | 피사체의 시각적 정보 기반 소셜 네트워크 서비스 시스템 | |

| US20160225001A1 (en) | Information processing apparatus |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20151214 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20151214 |

|

| A711 | Notification of change in applicant |

Free format text: JAPANESE INTERMEDIATE CODE: A711 Effective date: 20160729 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20161025 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20161115 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20170213 |

|

| A02 | Decision of refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A02 Effective date: 20170725 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20171127 |

|

| A911 | Transfer to examiner for re-examination before appeal (zenchi) |

Free format text: JAPANESE INTERMEDIATE CODE: A911 Effective date: 20171205 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20180109 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20180205 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6286123 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| S111 | Request for change of ownership or part of ownership |

Free format text: JAPANESE INTERMEDIATE CODE: R313113 |

|

| R350 | Written notification of registration of transfer |

Free format text: JAPANESE INTERMEDIATE CODE: R350 |