JP4966260B2 - 画像処理方法および画像処理装置、プログラム並びに、コンピュータ読み取り可能な記憶媒体 - Google Patents

画像処理方法および画像処理装置、プログラム並びに、コンピュータ読み取り可能な記憶媒体 Download PDFInfo

- Publication number

- JP4966260B2 JP4966260B2 JP2008166253A JP2008166253A JP4966260B2 JP 4966260 B2 JP4966260 B2 JP 4966260B2 JP 2008166253 A JP2008166253 A JP 2008166253A JP 2008166253 A JP2008166253 A JP 2008166253A JP 4966260 B2 JP4966260 B2 JP 4966260B2

- Authority

- JP

- Japan

- Prior art keywords

- image data

- specific part

- information

- area

- decoding

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

- 238000012545 processing Methods 0.000 title claims abstract description 128

- 238000003672 processing method Methods 0.000 title abstract description 15

- 241000593989 Scardinius erythrophthalmus Species 0.000 claims abstract description 89

- 201000005111 ocular hyperemia Diseases 0.000 claims abstract description 89

- 210000001508 eye Anatomy 0.000 claims description 37

- 238000004590 computer program Methods 0.000 claims description 4

- 238000000034 method Methods 0.000 description 122

- 238000001514 detection method Methods 0.000 description 99

- 230000008569 process Effects 0.000 description 94

- 238000012937 correction Methods 0.000 description 57

- 230000000694 effects Effects 0.000 description 34

- 230000015654 memory Effects 0.000 description 26

- 230000009467 reduction Effects 0.000 description 23

- 238000007639 printing Methods 0.000 description 20

- 238000010586 diagram Methods 0.000 description 12

- 230000006835 compression Effects 0.000 description 8

- 238000007906 compression Methods 0.000 description 8

- 230000006870 function Effects 0.000 description 7

- 238000013139 quantization Methods 0.000 description 7

- 238000004458 analytical method Methods 0.000 description 6

- 238000004364 calculation method Methods 0.000 description 5

- 238000006243 chemical reaction Methods 0.000 description 4

- 238000005516 engineering process Methods 0.000 description 4

- 230000003287 optical effect Effects 0.000 description 3

- 210000000056 organ Anatomy 0.000 description 3

- 238000007796 conventional method Methods 0.000 description 2

- 230000006866 deterioration Effects 0.000 description 2

- 239000000284 extract Substances 0.000 description 2

- 238000000605 extraction Methods 0.000 description 2

- 238000003702 image correction Methods 0.000 description 2

- 230000006872 improvement Effects 0.000 description 2

- 230000010354 integration Effects 0.000 description 2

- 239000000463 material Substances 0.000 description 2

- 239000000049 pigment Substances 0.000 description 2

- 210000001747 pupil Anatomy 0.000 description 2

- 238000011946 reduction process Methods 0.000 description 2

- 230000035945 sensitivity Effects 0.000 description 2

- 230000009466 transformation Effects 0.000 description 2

- 230000000007 visual effect Effects 0.000 description 2

- 230000002087 whitening effect Effects 0.000 description 2

- 208000029152 Small face Diseases 0.000 description 1

- 230000008901 benefit Effects 0.000 description 1

- 210000004204 blood vessel Anatomy 0.000 description 1

- 210000005252 bulbus oculi Anatomy 0.000 description 1

- 230000008859 change Effects 0.000 description 1

- 238000011161 development Methods 0.000 description 1

- 230000008921 facial expression Effects 0.000 description 1

- 230000007246 mechanism Effects 0.000 description 1

- 239000000203 mixture Substances 0.000 description 1

- 238000000926 separation method Methods 0.000 description 1

- 239000013589 supplement Substances 0.000 description 1

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N1/00—Scanning, transmission or reproduction of documents or the like, e.g. facsimile transmission; Details thereof

- H04N1/46—Colour picture communication systems

- H04N1/56—Processing of colour picture signals

- H04N1/60—Colour correction or control

- H04N1/62—Retouching, i.e. modification of isolated colours only or in isolated picture areas only

- H04N1/624—Red-eye correction

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T5/00—Image enhancement or restoration

- G06T5/90—Dynamic range modification of images or parts thereof

- G06T5/94—Dynamic range modification of images or parts thereof based on local image properties, e.g. for local contrast enhancement

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/70—Determining position or orientation of objects or cameras

- G06T7/73—Determining position or orientation of objects or cameras using feature-based methods

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/10—Human or animal bodies, e.g. vehicle occupants or pedestrians; Body parts, e.g. hands

- G06V40/18—Eye characteristics, e.g. of the iris

- G06V40/193—Preprocessing; Feature extraction

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N1/00—Scanning, transmission or reproduction of documents or the like, e.g. facsimile transmission; Details thereof

- H04N1/46—Colour picture communication systems

- H04N1/56—Processing of colour picture signals

- H04N1/60—Colour correction or control

- H04N1/62—Retouching, i.e. modification of isolated colours only or in isolated picture areas only

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30216—Redeye defect

Landscapes

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- Signal Processing (AREA)

- Computer Vision & Pattern Recognition (AREA)

- General Health & Medical Sciences (AREA)

- Health & Medical Sciences (AREA)

- Ophthalmology & Optometry (AREA)

- Human Computer Interaction (AREA)

- Image Processing (AREA)

- Television Signal Processing For Recording (AREA)

- Editing Of Facsimile Originals (AREA)

- Color Image Communication Systems (AREA)

- Image Analysis (AREA)

- Studio Devices (AREA)

Description

図1は本実施形態を実現する、画像処理を実行するコンピュータ(画像処理装置)の構成例を示すブロック図である。

(1)画像情報を輝度成分と色差成分に色分解。

(2)各色成分毎に所定画素単位にブロック化。

(3)ブロック内で直交変換(DCT:離散コサイン変換)。

(4)DCT係数を視覚特性に適合させた量子化ステップにおいて量子化。

(5)AC量子化係数を低周波域から高周波域にかけてジグザグスキャンの規則性に基づいて一次元配列に並び替え。

(6)係数ゼロの連続するラン数と係数ゼロ後に出現した非ゼロの有意係数との2次元ハフマン符号化。

(7)DC量子化係数は近接ブロックとDPCM符号化。

※JEIDA:(Japan Electronic Industry Development Association)

次に、1枚の画像データ中に顔領域が複数個あり、上記画像データに顔領域情報が複数付随される場合について説明する。本実施形態では、例として、1枚の撮影画像データに複数個の顔領域があり、ExifTag情報内に顔領域位置情報が複数記載されている場合のより効果的な実施形態について記載を行う。

次に、例えば、写真の元となる撮影画像データといった画像データ中の顔領域の上下方向が該画像データの上下方向と一致しない場合の実施形態について記載を行う。

本実施形態では、画像処理装置が取得する画像データや画像ファイルに、例えば、目、鼻、口、肌といった、顔領域以外の人物領域の座標情報が添付されている場合について記載を行う。図11は本実施形態の目領域の座標情報(目領域情報)が格納されている画像データに対する、赤目の検出処理の詳細を示す処理フロー図である。該処理の制御は、CPU101がROM102または記憶装置105に格納された図11に示す処理を行うプログラムを読み出し、該プログラムを実行することによって行われる。本実施形態では、目領域が(xe1,ye1)、(xe2,ye2)という座標形式でExifTagに記載されているとして各処理の説明を行う。

本発明は、複数の機器(例えばコンピュータ、インターフェース機器、リーダ、プリンタなど)から構成されるシステムに適用することも、1つの機器からなる装置(複合機、プリンタ、ファクシミリ装置など)に適用することも可能である。

101 CPU

102 ROM

103 RAM

104 ビデオカード

105 記憶装置

106 ポインティングデバイス

107 キーボード

108 インタフェイス

109システムバス

110 プリンタ

111 スキャナ

112 ディジタルカメラ

113 モニタ

114 ネットワーク

115 ネットワークインタフェイスカード

Claims (17)

- 画像データを取得する手段と、

特定部位を少なくとも含む画像データの一領域の位置に関する特定部位情報が前記取得された画像データに付随されている場合、該特定部位情報を取得する手段と、

前記取得された特定部位情報に基づいて、前記画像データにおける、前記特定部位を検出するためにデコードするデコード領域を決定する手段と、

前記画像データについて前記デコード領域をデコードして、第1のデコード後の画像データを生成する手段と、

前記生成された第1のデコード後の画像データから前記特定部位を検出し、該特定部位の位置に関する特定部位位置情報を取得する手段と、

前記画像データをデコードして、第2のデコード後の画像データを生成する手段と、

前記第2のデコード後の画像データに対して、前記取得された特定部位位置情報に基づいて前記特定部位の補正を行う手段と

を備えることを特徴とする画像処理装置。 - 前記特定部位は、赤目であることを特徴とする請求項1に記載の画像処理装置。

- 補正を行う手段は、前記画像データ中の赤目を補正することを特徴とする請求項2に記載の画像処理装置。

- 前記特定部位は、目、口、輪郭のうち少なくとも1つの部位であることを特徴とする請求項1に記載の画像処理装置。

- 前記特定部位情報は、前記画像データにおける顔領域の位置を示す顔領域情報であり、

前記決定する手段は、前記顔領域情報に基づいて、前記顔領域と同一、あるいは所定の画素分だけ拡大または縮小した領域であって、前記特定部位を少なくとも含む領域を前記デコード領域と決定することを特徴とする請求項1乃至4のいずれかに記載の画像処理装置。 - 前記顔領域が前記画像データに対して所定の角度だけ傾いている場合、前記角度を抽出する手段と、

前記抽出された角度に基づいて前記第1のデコード後の画像データを前記傾きが補正されるように回転する手段と

をさらに備えることを特徴とする請求項5に記載の画像処理装置。 - 前記特定部位情報は、前記特定部位の位置を示す情報であり、

前記決定する手段は、前記特定部位の位置を示す情報に基づいて、前記特定部位を少なくとも含む領域を前記デコード領域と決定することを特徴とする請求項1乃至4のいずれかに記載の画像処理装置。 - 前記画像データには、前記特定部位情報が複数付随されており、

前記決定する手段は、前記複数の特定部位情報の各々に基づいて、複数のデコード領域を決定することを特徴とする請求項1乃至7のいずれかに記載の画像処理装置。 - 前記画像データを取得する手段にて取得されるデータは、前記画像データを格納した画像ファイルであることを特徴とする請求項1乃至8のいずれかに記載の画像処理装置。

- 前記画像ファイルは、JPEGファイルであることを特徴とする請求項9に記載の画像処理装置。

- 前記特定部位情報は、Exifフォーマットに準拠した形式であることを特徴とする請求項1乃至10のいずれかに記載の画像処理装置。

- 前記特定部位情報は、前記画像処理装置とは異なる装置によって取得された情報であることを特徴とする請求項1乃至11のいずれかに記載の画像処理装置。

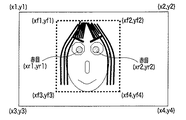

- 前記特定部位情報とは、矩形の4点の座標を示す情報であることを特徴とする請求項1乃至12のいずれかに記載の画像処理装置。

- 前記決定する手段は、前記特定部位情報にて特定される領域と同一の領域を前記デコード領域と決定することを特徴とする請求項1乃至13のいずれかに記載の画像処理装置。

- 画像データを取得する工程と、

特定部位を少なくとも含む画像データの一領域の位置に関する特定部位情報が前記取得された画像データに付随されている場合、該特定部位情報を取得する工程と、

前記取得された特定部位情報に基づいて、前記画像データにおける、前記特定部位を検出するためにデコードするデコード領域を決定する工程と、

前記画像データについて前記デコード領域をデコードして、第1のデコード後の画像データを生成する工程と、

前記生成された第1のデコード後の画像データから前記特定部位を検出し、該特定部位の位置に関する特定部位位置情報を取得する工程と、

前記画像データをデコードして、第2のデコード後の画像データを生成する工程と、

前記第2のデコード後の画像データに対して、前記取得された特定部位位置情報に基づいて前記特定部位の補正を行う工程と

を有することを特徴とする画像処理方法。 - コンピュータを請求項1乃至14のいずれかに記載の画像処理装置として機能させるためのコンピュータプログラム。

- コンピュータにより読み出し可能なプログラムを格納した記憶媒体であって、請求項16記載のコンピュータプログラムを格納したことを特徴とする記憶媒体。

Priority Applications (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2008166253A JP4966260B2 (ja) | 2008-06-25 | 2008-06-25 | 画像処理方法および画像処理装置、プログラム並びに、コンピュータ読み取り可能な記憶媒体 |

| US12/488,142 US20090324063A1 (en) | 2008-06-25 | 2009-06-19 | Image processing method and apparatus for correcting specific part |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2008166253A JP4966260B2 (ja) | 2008-06-25 | 2008-06-25 | 画像処理方法および画像処理装置、プログラム並びに、コンピュータ読み取り可能な記憶媒体 |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2010009227A JP2010009227A (ja) | 2010-01-14 |

| JP2010009227A5 JP2010009227A5 (ja) | 2011-07-21 |

| JP4966260B2 true JP4966260B2 (ja) | 2012-07-04 |

Family

ID=41447513

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2008166253A Expired - Fee Related JP4966260B2 (ja) | 2008-06-25 | 2008-06-25 | 画像処理方法および画像処理装置、プログラム並びに、コンピュータ読み取り可能な記憶媒体 |

Country Status (2)

| Country | Link |

|---|---|

| US (1) | US20090324063A1 (ja) |

| JP (1) | JP4966260B2 (ja) |

Families Citing this family (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US9721160B2 (en) * | 2011-04-18 | 2017-08-01 | Hewlett-Packard Development Company, L.P. | Manually-assisted detection of redeye artifacts |

| JP6440604B2 (ja) * | 2015-09-29 | 2018-12-19 | 富士フイルム株式会社 | 被写体評価システム,被写体評価方法,被写体評価プログラムおよびそのプログラムを格納した記録媒体 |

| US11770535B2 (en) * | 2021-02-19 | 2023-09-26 | Samsung Display Co., Ltd. | Systems and methods for joint color channel entropy encoding with positive reconstruction error |

| CN116456098A (zh) * | 2022-01-05 | 2023-07-18 | 南宁富联富桂精密工业有限公司 | 视频压缩方法、终端及计算机可读存储介质 |

Family Cites Families (16)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US6940545B1 (en) * | 2000-02-28 | 2005-09-06 | Eastman Kodak Company | Face detecting camera and method |

| US6895103B2 (en) * | 2001-06-19 | 2005-05-17 | Eastman Kodak Company | Method for automatically locating eyes in an image |

| JP4061907B2 (ja) * | 2002-01-15 | 2008-03-19 | セイコーエプソン株式会社 | 画像処理済み画像データの出力および保存 |

| WO2004055735A1 (ja) * | 2002-12-16 | 2004-07-01 | Canon Kabushiki Kaisha | パターン識別方法、その装置及びそのプログラム |

| JP4121026B2 (ja) * | 2004-01-21 | 2008-07-16 | 富士フイルム株式会社 | 撮像装置および方法並びにプログラム |

| JP2005250556A (ja) * | 2004-03-01 | 2005-09-15 | Fuji Photo Film Co Ltd | トリミング処理方法および装置並びにプログラム |

| US7720295B2 (en) * | 2004-06-29 | 2010-05-18 | Sanyo Electric Co., Ltd. | Method and apparatus for coding images with different image qualities for each region thereof, and method and apparatus capable of decoding the images by adjusting the image quality |

| JP2006167917A (ja) * | 2004-12-10 | 2006-06-29 | Canon Inc | 画像記録装置及びその印刷データ生成方法、並びに制御プログラム |

| JP2006279460A (ja) * | 2005-03-29 | 2006-10-12 | Seiko Epson Corp | 画像処理装置、印刷装置、画像処理方法、および、画像処理プログラム |

| US7548647B2 (en) * | 2005-04-29 | 2009-06-16 | Hewlett-Packard Development Company, L.P. | Method and apparatus for digital-image red-eye correction that facilitates undo operation |

| JP4904108B2 (ja) * | 2006-07-25 | 2012-03-28 | 富士フイルム株式会社 | 撮影装置及び画像表示制御方法 |

| JP2008090398A (ja) * | 2006-09-29 | 2008-04-17 | Seiko Epson Corp | 画像処理装置、印刷装置、画像処理方法、および、画像処理プログラム |

| JP2008090611A (ja) * | 2006-10-02 | 2008-04-17 | Sony Corp | 画像処理装置、画像処理方法、およびプログラム |

| JP4309928B2 (ja) * | 2007-03-15 | 2009-08-05 | アイシン精機株式会社 | 瞼検出装置、瞼検出方法、及び、プログラム |

| KR20080101277A (ko) * | 2007-05-16 | 2008-11-21 | 삼성테크윈 주식회사 | 히스토그램을 디스플레이 하는 디지털 영상 처리 장치 및그의 동작 방법 |

| JP4434236B2 (ja) * | 2007-06-11 | 2010-03-17 | ソニー株式会社 | 画像処理装置、画像表示装置、撮像装置、これらの処理方法およびプログラム |

-

2008

- 2008-06-25 JP JP2008166253A patent/JP4966260B2/ja not_active Expired - Fee Related

-

2009

- 2009-06-19 US US12/488,142 patent/US20090324063A1/en not_active Abandoned

Also Published As

| Publication number | Publication date |

|---|---|

| JP2010009227A (ja) | 2010-01-14 |

| US20090324063A1 (en) | 2009-12-31 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| EP2264995B1 (en) | Image processing apparatus, image processing method, and computer program | |

| JP4991604B2 (ja) | 画像処理装置、画像処理方法 | |

| US8169656B2 (en) | Image processing devices and methods for resizing an original image therefor | |

| JP2011071767A (ja) | 画像処理装置及びその処理方法 | |

| JP2010103681A (ja) | 画像処理装置および画像処理方法 | |

| JP5049921B2 (ja) | 画像処理装置及び画像処理方法 | |

| JP4582204B2 (ja) | 画像処理装置、画像変換方法、およびコンピュータプログラム | |

| US8249321B2 (en) | Image processing apparatus and method for red eye detection | |

| JP4966260B2 (ja) | 画像処理方法および画像処理装置、プログラム並びに、コンピュータ読み取り可能な記憶媒体 | |

| JP2010056827A (ja) | 画像処理装置および画像処理プログラム | |

| JP2009010618A (ja) | 画像領域指定装置及びその制御方法、システム | |

| US8139237B2 (en) | Image generating apparatus, image processing apparatus, recording medium and computer readable recording medium | |

| JP2003289550A (ja) | データ格納フォーマット、画像データを格納する方法、及び、格納データを用いる方法 | |

| JP2010146218A (ja) | 画像処理装置、画像処理方法、コンピュータプログラム | |

| JP2009296150A (ja) | 画像処理装置、画像変換方法、およびコンピュータプログラム | |

| JP5335581B2 (ja) | 画像処理装置、画像処理方法及びプログラム | |

| JP2008042345A (ja) | 画像処理方法、画像処理装置 | |

| JP2006113658A (ja) | 画像処理装置及び方法、及びプログラムを記録した記憶媒体 | |

| JP2010050832A (ja) | 画像処理装置、画像処理方法、プログラムおよび記録媒体 | |

| JP3346051B2 (ja) | 画像処理装置 | |

| JP2007200091A (ja) | 画像処理装置 | |

| JP7301529B2 (ja) | 画像処理装置、画像処理方法、及びプログラム | |

| JP2010016781A (ja) | 画像処理装置及びその制御方法 | |

| JP4936524B2 (ja) | 画像処理システムおよび画像処理方法 | |

| US12184818B2 (en) | Image processing method and image processing device which generate reprint image data in correspondence with plurality of image regions of recorded print and further based on image data thereof, as well as printing method and print output system which output reprint in which optimum image is recorded based on reprint image data |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| RD02 | Notification of acceptance of power of attorney |

Free format text: JAPANESE INTERMEDIATE CODE: A7422 Effective date: 20101106 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20110602 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20110602 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20120227 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20120302 |

|

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20120330 |

|

| R151 | Written notification of patent or utility model registration |

Ref document number: 4966260 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R151 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20150406 Year of fee payment: 3 |

|

| LAPS | Cancellation because of no payment of annual fees |