JP3991020B2 - 画像表示方法及び画像表示システム - Google Patents

画像表示方法及び画像表示システム Download PDFInfo

- Publication number

- JP3991020B2 JP3991020B2 JP2003341627A JP2003341627A JP3991020B2 JP 3991020 B2 JP3991020 B2 JP 3991020B2 JP 2003341627 A JP2003341627 A JP 2003341627A JP 2003341627 A JP2003341627 A JP 2003341627A JP 3991020 B2 JP3991020 B2 JP 3991020B2

- Authority

- JP

- Japan

- Prior art keywords

- image

- color

- simple model

- real

- data

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/30—Determination of transform parameters for the alignment of images, i.e. image registration

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T15/00—3D [Three Dimensional] image rendering

- G06T15/10—Geometric effects

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T17/00—Three dimensional [3D] modelling, e.g. data description of 3D objects

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T19/00—Manipulating 3D models or images for computer graphics

- G06T19/006—Mixed reality

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T19/00—Manipulating 3D models or images for computer graphics

- G06T19/20—Editing of 3D images, e.g. changing shapes or colours, aligning objects or positioning parts

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2219/00—Indexing scheme for manipulating 3D models or images for computer graphics

- G06T2219/20—Indexing scheme for editing of 3D models

- G06T2219/2012—Colour editing, changing, or manipulating; Use of colour codes

Landscapes

- Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- General Physics & Mathematics (AREA)

- Computer Graphics (AREA)

- Software Systems (AREA)

- Computer Hardware Design (AREA)

- General Engineering & Computer Science (AREA)

- Geometry (AREA)

- Architecture (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Processing Or Creating Images (AREA)

- Testing, Inspecting, Measuring Of Stereoscopic Televisions And Televisions (AREA)

- Image Analysis (AREA)

Description

任意視点における現実空間の現実画像に仮想空間の画像情報を重畳し、観察者に提示する画像表示装置の画像表示方法であって、

入力手段が、CADデータに基づいて簡易的に作成された簡易模型を含む現実空間の画像情報を撮像デバイスによって撮像することにより得られた現実画像を取り込む入力工程と、

計測手段が、前記撮像デバイス及び前記簡易模型の位置及び姿勢を計測し、前記現実画像中の前記簡易模型の位置及び姿勢を示す位置/姿勢情報を取得する計測工程と、

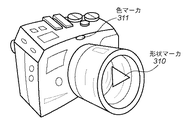

抽出手段が、前記現実画像より、色情報記憶手段に記憶された所定の色を含む領域を抽出する領域抽出工程と、

合成手段が、前記位置/姿勢情報と前記CADデータとに基づいて、前記領域抽出工程で抽出された領域以外の、前記現実画像中の前記簡易模型の部分にコンピュータグラフィック画像を描画して、前記現実画像と前記コンピュータグラフィック画像を合成する合成工程とを備え、

前記簡易模型が、前記色情報記憶手段に記憶されている前記所定の色とは異なる色で着色されている。

任意視点における現実空間の現実画像に仮想空間の画像情報を重畳し、観察者に提示する画像表示システムであって、

CADデータに基づいて簡易的に作成された簡易模型を含む現実空間の画像情報を撮像デバイスにより撮影することにより得られた現実画像を取り込む入力手段と、

前記撮像デバイス及び前記簡易模型の位置及び姿勢を計測し、前記現実画像中の該簡易模型の位置及び姿勢を示す位置/姿勢情報を取得する計測手段と、

前記現実画像より、色情報記憶手段に記憶された所定の色を含む領域を抽出する領域抽出手段と、

前記位置/姿勢情報と前記CADデータとに基づいて、前記領域抽出手段で抽出された領域以外の、前記現実画像中の前記簡易模型の部分にコンピュータグラフィック画像を描画して、前記現実画像と前記コンピュータグラフィック画像を合成する合成手段とを備え、

前記簡易模型が、前記色情報記憶手段に記憶されている前記所定の色とは異なる色で着色されている。

第1実施形態では、3D−CADで生成された3次元データに基づいて作成された簡易試作物(簡易モックアップ)やその背景の色を工夫することにより、簡易試作物に3DCGデータを重ね合わせて表示する際の、体験者の手に相当する部分の抽出を容易とした複合現実感システムを説明する。

第1実施形態においては、磁気を利用した位置・姿勢計測を例に説明した。しかしながら、磁気を利用した位置・姿勢計測においては、環境により計測精度が不安定になる場合がある。たとえば磁気トランスミッタの近傍に金属物体が存在する場合には磁場が乱れ、磁気センサの出力する値が不安定になる。また、磁気トランスミッタと磁気センサの距離が遠くなるほど、計測精度が悪化するなどの問題がある。このような計測精度の問題は、磁気利用のセンサに限らず、種々の方式の計測装置において発生する。

XD=XA+3×(XB−XA)+4×(XC−XA) …(A)

によって求めることができる。

(1)マーカが複数ある場合でも、「3点の目印みの計測」を行なっておけばよく、計測の回数が少なくて済む。

(2)マーカを貼り直した場合、マーカの位置は目印を目安に簡単に算出することができ、改めて計測をやり直す必要がない(レーザ計測器などを用いた計測には手間がかかる)。

第3実施形態では、第2実施形態における簡易試作物(簡易モックアップ)への目印の付加を、簡易試作物の3D−CADデータに目印の形状データを付加することによって実現する。第3実施形態における処理の流れを図11を参照して説明する。なお、第2実施形態の処理(図10)と同じ処理については、同一の参照番号を付してある。また、第3実施形態における複合現実感システムの構成は、第2実施形態の構成(図9)と同じである。

第4実施形態では、3D−CADデータ中にセンサ埋め込み位置を指定することにより、簡易試作物(簡易モックアップ)にセンサ埋め込み用の形状が作成されるようにした複合現実感システムを示す。

Claims (6)

- 任意視点における現実空間の現実画像に仮想空間の画像情報を重畳し、観察者に提示する画像表示装置の画像表示方法であって、

入力手段が、CADデータに基づいて簡易的に作成された簡易模型を含む現実空間の画像情報を撮像デバイスによって撮像することにより得られた現実画像を取り込む入力工程と、

計測手段が、前記撮像デバイス及び前記簡易模型の位置及び姿勢を計測し、前記現実画像中の前記簡易模型の位置及び姿勢を示す位置/姿勢情報を取得する計測工程と、

抽出手段が、前記現実画像より、色情報記憶手段に記憶された所定の色を含む領域を抽出する領域抽出工程と、

合成手段が、前記位置/姿勢情報と前記CADデータとに基づいて、前記領域抽出工程で抽出された領域以外の、前記現実画像中の前記簡易模型の部分にコンピュータグラフィック画像を描画して、前記現実画像と前記コンピュータグラフィック画像を合成する合成工程とを備え、

前記簡易模型が、前記色情報記憶手段に記憶されている前記所定の色とは異なる色で着色されていることを特徴とする画像表示方法。 - 前記簡易模型が、前記色情報記憶手段に記憶されている前記所定の色に対して補色関係となる色で着色されていることを特徴とする請求項1に記載の画像表示方法。

- 前記入力工程で入力される前記現実画像は、前記簡易模型の色と略同一色の背景の前で前記撮像デバイスにより前記簡易模型を撮像することにより得られたものであることを特徴とする請求項1に記載の画像表示方法。

- 前記入力工程で入力される前記現実画像は、前記所定の色及び前記簡易模型の色とは異なる色の背景の前で前記撮像デバイスにより前記簡易模型を撮像することにより得られたものであることを特徴とする請求項1に記載の画像表示方法。

- 任意視点における現実空間の現実画像に仮想空間の画像情報を重畳し、観察者に提示する画像表示システムであって、

CADデータに基づいて簡易的に作成された簡易模型を含む現実空間の画像情報を撮像デバイスにより撮影することにより得られた現実画像を取り込む入力手段と、

前記撮像デバイス及び前記簡易模型の位置及び姿勢を計測し、前記現実画像中の該簡易模型の位置及び姿勢を示す位置/姿勢情報を取得する計測手段と、

前記現実画像より、色情報記憶手段に記憶された所定の色を含む領域を抽出する領域抽出手段と、

前記位置/姿勢情報と前記CADデータとに基づいて、前記領域抽出手段で抽出された領域以外の、前記現実画像中の前記簡易模型の部分にコンピュータグラフィック画像を描画して、前記現実画像と前記コンピュータグラフィック画像を合成する合成手段とを備え、

前記簡易模型が、前記色情報記憶手段に記憶されている前記所定の色とは異なる色で着色されていることを特徴とする画像表示システム。 - 前記簡易模型が、前記色情報記憶手段に記憶されている前記所定の色に対して補色関係となる色で着色されていることを特徴とする請求項5に記載の画像表示システム。

Priority Applications (5)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2003341627A JP3991020B2 (ja) | 2003-09-30 | 2003-09-30 | 画像表示方法及び画像表示システム |

| DE602004008001T DE602004008001T2 (de) | 2003-09-30 | 2004-09-28 | Bildanzeigeverfahren und Bildanzeigesystem |

| EP04255922A EP1521215B1 (en) | 2003-09-30 | 2004-09-28 | Image display method and image display system |

| US10/953,935 US7397481B2 (en) | 2003-09-30 | 2004-09-29 | Image display method and image display system |

| CNB200410080657XA CN1304930C (zh) | 2003-09-30 | 2004-09-29 | 图像显示方法和图像显示系统 |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2003341627A JP3991020B2 (ja) | 2003-09-30 | 2003-09-30 | 画像表示方法及び画像表示システム |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2005107969A JP2005107969A (ja) | 2005-04-21 |

| JP2005107969A5 JP2005107969A5 (ja) | 2006-12-28 |

| JP3991020B2 true JP3991020B2 (ja) | 2007-10-17 |

Family

ID=34309071

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2003341627A Expired - Fee Related JP3991020B2 (ja) | 2003-09-30 | 2003-09-30 | 画像表示方法及び画像表示システム |

Country Status (5)

| Country | Link |

|---|---|

| US (1) | US7397481B2 (ja) |

| EP (1) | EP1521215B1 (ja) |

| JP (1) | JP3991020B2 (ja) |

| CN (1) | CN1304930C (ja) |

| DE (1) | DE602004008001T2 (ja) |

Families Citing this family (33)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR100503789B1 (ko) * | 2002-03-11 | 2005-07-26 | 삼성전자주식회사 | 렌더링시스템, 렌더링방법 및 그 기록매체 |

| JP4227561B2 (ja) * | 2004-06-03 | 2009-02-18 | キヤノン株式会社 | 画像処理方法、画像処理装置 |

| JP4667111B2 (ja) * | 2005-04-21 | 2011-04-06 | キヤノン株式会社 | 画像処理装置、画像処理方法 |

| JP4914123B2 (ja) | 2005-07-15 | 2012-04-11 | キヤノン株式会社 | 画像処理装置及び方法 |

| CN100590660C (zh) * | 2005-07-15 | 2010-02-17 | 佳能株式会社 | 图像处理设备和设计方法 |

| US8264477B2 (en) * | 2005-08-05 | 2012-09-11 | Pioneer Corporation | Image display apparatus |

| JP4795091B2 (ja) * | 2006-04-21 | 2011-10-19 | キヤノン株式会社 | 情報処理方法および装置 |

| FR2901049B1 (fr) * | 2006-05-12 | 2008-11-21 | Techviz Soc Par Actions Simpli | Procede de codage et systeme d'affichage sur un ecran d'une maquette numerique d'un objet sous forme d'une image de synthese |

| JP4764305B2 (ja) * | 2006-10-02 | 2011-08-31 | 株式会社東芝 | 立体画像生成装置、方法およびプログラム |

| DE102007045834B4 (de) * | 2007-09-25 | 2012-01-26 | Metaio Gmbh | Verfahren und Vorrichtung zum Darstellen eines virtuellen Objekts in einer realen Umgebung |

| JP4950834B2 (ja) * | 2007-10-19 | 2012-06-13 | キヤノン株式会社 | 画像処理装置、画像処理方法 |

| JP5403974B2 (ja) | 2008-09-09 | 2014-01-29 | キヤノン株式会社 | 三次元cadシステム |

| JP2010121999A (ja) * | 2008-11-18 | 2010-06-03 | Omron Corp | 3次元モデルの作成方法および物体認識装置 |

| WO2010064148A1 (en) | 2008-12-03 | 2010-06-10 | Xuan Jiang | Displaying objects with certain visual effects |

| WO2011014419A1 (en) * | 2009-07-31 | 2011-02-03 | 3Dmedia Corporation | Methods, systems, and computer-readable storage media for creating three-dimensional (3d) images of a scene |

| US20110025830A1 (en) | 2009-07-31 | 2011-02-03 | 3Dmedia Corporation | Methods, systems, and computer-readable storage media for generating stereoscopic content via depth map creation |

| US9380292B2 (en) | 2009-07-31 | 2016-06-28 | 3Dmedia Corporation | Methods, systems, and computer-readable storage media for generating three-dimensional (3D) images of a scene |

| US8947455B2 (en) | 2010-02-22 | 2015-02-03 | Nike, Inc. | Augmented reality design system |

| US9344701B2 (en) | 2010-07-23 | 2016-05-17 | 3Dmedia Corporation | Methods, systems, and computer-readable storage media for identifying a rough depth map in a scene and for determining a stereo-base distance for three-dimensional (3D) content creation |

| US9185388B2 (en) | 2010-11-03 | 2015-11-10 | 3Dmedia Corporation | Methods, systems, and computer program products for creating three-dimensional video sequences |

| US8274552B2 (en) | 2010-12-27 | 2012-09-25 | 3Dmedia Corporation | Primary and auxiliary image capture devices for image processing and related methods |

| US10200671B2 (en) | 2010-12-27 | 2019-02-05 | 3Dmedia Corporation | Primary and auxiliary image capture devices for image processing and related methods |

| US8843350B2 (en) * | 2011-06-03 | 2014-09-23 | Walter P. Moore and Associates, Inc. | Facilities management system |

| GB2501924B (en) * | 2012-05-11 | 2015-06-24 | Sony Comp Entertainment Europe | System and method of book leaf tracking |

| JP5791082B2 (ja) * | 2012-07-30 | 2015-10-07 | 国立大学法人横浜国立大学 | 画像合成装置、画像合成システム、画像合成方法およびプログラム |

| JP6138566B2 (ja) * | 2013-04-24 | 2017-05-31 | 川崎重工業株式会社 | 部品取付作業支援システムおよび部品取付方法 |

| DE102013207528A1 (de) * | 2013-04-25 | 2014-10-30 | Bayerische Motoren Werke Aktiengesellschaft | Verfahren zum Interagieren mit einem auf einer Datenbrille angezeigten Objekt |

| GB201310373D0 (en) * | 2013-06-11 | 2013-07-24 | Sony Comp Entertainment Europe | Head-Mountable Apparatus and systems |

| JP6237326B2 (ja) * | 2014-02-25 | 2017-11-29 | 富士通株式会社 | 姿勢推定装置、姿勢推定方法及び姿勢推定用コンピュータプログラム |

| JP6491068B2 (ja) * | 2015-09-29 | 2019-03-27 | 富士フイルム株式会社 | 三次元造形システム、情報処理装置及び方法、並びにプログラム |

| IT201700009585A1 (it) * | 2017-01-30 | 2018-07-30 | The Edge Company S R L | Metodo per il riconoscimento di oggeti per motori di realta' aumentata mediante un dispositivo elettronico |

| CN107918665B (zh) * | 2017-11-23 | 2021-12-14 | 上海模袋网络科技有限公司 | 一种三维模型的快速渲染及cad信息查询的系统和方法 |

| JP6746651B2 (ja) * | 2018-09-26 | 2020-08-26 | 株式会社不動テトラ | 地盤改良工事の合成画像表示方法 |

Family Cites Families (7)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US5423554A (en) * | 1993-09-24 | 1995-06-13 | Metamedia Ventures, Inc. | Virtual reality game method and apparatus |

| JPH10320590A (ja) * | 1997-05-19 | 1998-12-04 | Honda Motor Co Ltd | 合成映像作成装置及び合成映像作成方法 |

| US6522312B2 (en) | 1997-09-01 | 2003-02-18 | Canon Kabushiki Kaisha | Apparatus for presenting mixed reality shared among operators |

| JP2002157606A (ja) * | 2000-11-17 | 2002-05-31 | Canon Inc | 画像表示制御装置、複合現実感提示システム、画像表示制御方法、及び処理プログラムを提供する媒体 |

| US7053915B1 (en) * | 2002-07-30 | 2006-05-30 | Advanced Interfaces, Inc | Method and system for enhancing virtual stage experience |

| JP4401727B2 (ja) * | 2003-09-30 | 2010-01-20 | キヤノン株式会社 | 画像表示装置及び方法 |

| JP2005108108A (ja) * | 2003-10-01 | 2005-04-21 | Canon Inc | 三次元cg操作装置および方法、並びに位置姿勢センサのキャリブレーション装置 |

-

2003

- 2003-09-30 JP JP2003341627A patent/JP3991020B2/ja not_active Expired - Fee Related

-

2004

- 2004-09-28 EP EP04255922A patent/EP1521215B1/en not_active Expired - Lifetime

- 2004-09-28 DE DE602004008001T patent/DE602004008001T2/de not_active Expired - Lifetime

- 2004-09-29 US US10/953,935 patent/US7397481B2/en active Active

- 2004-09-29 CN CNB200410080657XA patent/CN1304930C/zh not_active Expired - Fee Related

Also Published As

| Publication number | Publication date |

|---|---|

| EP1521215A1 (en) | 2005-04-06 |

| US20050068316A1 (en) | 2005-03-31 |

| DE602004008001D1 (de) | 2007-09-20 |

| US7397481B2 (en) | 2008-07-08 |

| EP1521215B1 (en) | 2007-08-08 |

| JP2005107969A (ja) | 2005-04-21 |

| CN1604026A (zh) | 2005-04-06 |

| CN1304930C (zh) | 2007-03-14 |

| DE602004008001T2 (de) | 2008-04-30 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP3991020B2 (ja) | 画像表示方法及び画像表示システム | |

| JP4401727B2 (ja) | 画像表示装置及び方法 | |

| JP4434890B2 (ja) | 画像合成方法及び装置 | |

| US11928838B2 (en) | Calibration system and method to align a 3D virtual scene and a 3D real world for a stereoscopic head-mounted display | |

| JP4667111B2 (ja) | 画像処理装置、画像処理方法 | |

| JP4677273B2 (ja) | 情報処理方法および情報処理装置 | |

| EP1596329B1 (en) | Marker placement information estimating method and information processing device | |

| JP4708752B2 (ja) | 情報処理方法および装置 | |

| JP4933406B2 (ja) | 画像処理装置、画像処理方法 | |

| JP4834424B2 (ja) | 情報処理装置、情報処理方法、及びプログラム | |

| US7782320B2 (en) | Information processing method and information processing apparatus | |

| JP2004062756A (ja) | 情報提示装置および情報処理方法 | |

| JP2002163670A (ja) | 複合現実感提示装置及びその制御方法 | |

| JP4242529B2 (ja) | 関連情報呈示装置及び関連情報呈示方法 | |

| JP2005327204A (ja) | 画像合成システムおよび画像合成方法、および画像合成装置 | |

| JP2006012042A (ja) | 画像生成方法及び装置 | |

| JP4366165B2 (ja) | 画像表示装置及び方法並びに記憶媒体 | |

| JP2006085375A (ja) | 画像処理方法、画像処理装置 | |

| JP6545847B2 (ja) | 画像処理装置、画像処理方法及びプログラム | |

| WO2024095356A1 (ja) | グラフィックス生成装置、グラフィックス生成方法及びプログラム | |

| TWI564841B (zh) | 即時影像合成裝置、方法與電腦程式產品 | |

| JP4810403B2 (ja) | 情報処理装置、情報処理方法 | |

| JP2002056407A (ja) | 画像生成システム | |

| JP7465133B2 (ja) | 情報処理装置、情報処理方法 | |

| JP2006252059A (ja) | 画像処理方法、画像処理装置 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20061115 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20070409 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20070608 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20070706 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20070723 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20100727 Year of fee payment: 3 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 3991020 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20100727 Year of fee payment: 3 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20110727 Year of fee payment: 4 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20120727 Year of fee payment: 5 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20120727 Year of fee payment: 5 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20130727 Year of fee payment: 6 |

|

| LAPS | Cancellation because of no payment of annual fees |