JP2017215664A - 端末装置 - Google Patents

端末装置 Download PDFInfo

- Publication number

- JP2017215664A JP2017215664A JP2016107450A JP2016107450A JP2017215664A JP 2017215664 A JP2017215664 A JP 2017215664A JP 2016107450 A JP2016107450 A JP 2016107450A JP 2016107450 A JP2016107450 A JP 2016107450A JP 2017215664 A JP2017215664 A JP 2017215664A

- Authority

- JP

- Japan

- Prior art keywords

- target image

- unit

- terminal device

- feature

- feature information

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

- 238000003384 imaging method Methods 0.000 claims description 15

- 238000001514 detection method Methods 0.000 claims description 12

- 238000005516 engineering process Methods 0.000 abstract description 3

- 238000000034 method Methods 0.000 description 50

- 230000008569 process Effects 0.000 description 45

- 238000004891 communication Methods 0.000 description 14

- 230000004048 modification Effects 0.000 description 14

- 238000012986 modification Methods 0.000 description 14

- 241000587161 Gomphocarpus Species 0.000 description 4

- 125000002066 L-histidyl group Chemical group [H]N1C([H])=NC(C([H])([H])[C@](C(=O)[*])([H])N([H])[H])=C1[H] 0.000 description 4

- 238000012790 confirmation Methods 0.000 description 4

- 238000005034 decoration Methods 0.000 description 4

- 230000000694 effects Effects 0.000 description 4

- 239000000284 extract Substances 0.000 description 3

- 238000012545 processing Methods 0.000 description 3

- 230000001133 acceleration Effects 0.000 description 2

- 238000004590 computer program Methods 0.000 description 2

- 230000001629 suppression Effects 0.000 description 2

- 230000008901 benefit Effects 0.000 description 1

- 230000006870 function Effects 0.000 description 1

- 239000011521 glass Substances 0.000 description 1

- 230000008520 organization Effects 0.000 description 1

- 230000002093 peripheral effect Effects 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/0101—Head-up displays characterised by optical features

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/017—Head mounted

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F1/00—Details not covered by groups G06F3/00 - G06F13/00 and G06F21/00

- G06F1/16—Constructional details or arrangements

- G06F1/1613—Constructional details or arrangements for portable computers

- G06F1/163—Wearable computers, e.g. on a belt

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F16/00—Information retrieval; Database structures therefor; File system structures therefor

- G06F16/50—Information retrieval; Database structures therefor; File system structures therefor of still image data

- G06F16/58—Retrieval characterised by using metadata, e.g. metadata not derived from the content or metadata generated manually

- G06F16/587—Retrieval characterised by using metadata, e.g. metadata not derived from the content or metadata generated manually using geographical or spatial information, e.g. location

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T5/00—Image enhancement or restoration

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V20/00—Scenes; Scene-specific elements

- G06V20/20—Scenes; Scene-specific elements in augmented reality scenes

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/0101—Head-up displays characterised by optical features

- G02B2027/0138—Head-up displays characterised by optical features comprising image capture systems, e.g. camera

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/0101—Head-up displays characterised by optical features

- G02B2027/014—Head-up displays characterised by optical features comprising information/image processing systems

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/0101—Head-up displays characterised by optical features

- G02B2027/0141—Head-up displays characterised by optical features characterised by the informative content of the display

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/017—Head mounted

- G02B2027/0178—Eyeglass type

Abstract

Description

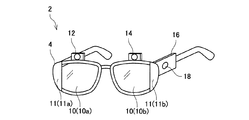

(端末装置2の構成;図1、図2)

図1に示す端末装置2は、ユーザの頭部に装着して用いられる画像表示装置(いわゆるヘッドマウントディスプレイ)である。端末装置2は、フレーム4と、表示部10a、10bと、投影部11a、11bと、第1のカメラ12と、第2のカメラ14と、コントロールボックス16と、操作部18とを備えている。

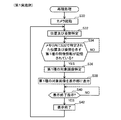

図3を参照して、本実施例の端末装置2の制御部30が実行する記録処理について説明する。ユーザが端末装置2を自身の頭部に装着し、端末装置2の電源をオンした後で、操作部18に所定の記録処理開始指示を入力すると、制御部30は、図3の記録処理を開始する。

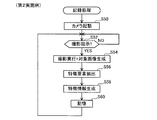

図4を参照して、本実施例の端末装置2の制御部30が実行する再現処理について説明する。ユーザが端末装置2を自身の頭部に装着し、端末装置2の電源をオンした後で、操作部18に所定の再現処理開始指示を入力すると、制御部30は、図4の再現処理を開始する。

図5、図6を参照して、本実施例において、第1種の対象画像が表示部10に表示される際(図4のS38参照)の表示例を説明する。図5、図6の例では、ユーザが、入居時のアパートの居室内の状態を撮影した第1種の対象画像50と、現在(例えば退去前の引き渡し時点)のアパートの居室内の状態(以下では「現状」と呼ぶ場合がある)60と、を比較することを希望する状況が想定されている。より具体的には、入居時の居室の状態と、現在の居室の状態とを比較し、居住期間中に生じた傷や汚れがどのくらい存在するのかを確認することを希望する状況が想定されている。図5、図6は、いずれも、上記の状況下における第1種の対象画像50の表示例を示す。制御部30は、表示切替指示が入力されると、図5の表示態様と図6の表示態様とを切り替えて表示部10に表示させることができる。

上記の通り、本実施例では、端末装置2は、第1種の対象画像と第1種の特徴情報とを対応付けてメモリ32に記憶させた後(図3のS20)、第1種の特徴情報が示す特徴(即ち、対象位置及び対象姿勢)に一致する特徴(即ち、端末装置2の位置及び姿勢)が検出される場合(図4のS34でYES)に、当該第1種の特徴情報に対応付けられてメモリ32に記憶されている第1種の対象画像を表示部10に表示させる(S36、S38)。従って、本実施例の端末装置2によると、予め定められた条件が成立する場合(即ち、第1種の特徴情報が示す特徴に一致する特徴が検出される場合)に、撮影済みの第1種の対象画像を適切に表示部10に表示させることができる。

本実施例と請求項の対応関係を説明する。第1のカメラ12及び第2のカメラ14が「撮影部」の一例である。GPS受信機20が「位置検出手段」の一例である。メモリ32が「記憶部」の一例である。図4のS34でYESの場合が「特定の場合」の一例である。

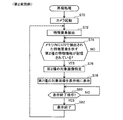

第1実施例とは異なる点を中心に説明する。本実施例の端末装置2も、基本的な構成は第1実施例の端末装置2(図1、図2参照)と共通するが、GPS受信機20及びセンサ22を備えない点が第1実施例と異なる。そのため、本実施例では、記録処理と再現処理の内容の一部も第1実施例とは異なる(図7、図8参照)。

S50〜S54の処理は、図3のS10〜S14の処理と同様であるため説明を省略する。S56では、制御部30は、S54で生成された対象画像中の特徴要素を抽出する。例えば、図9の例に示すように、対象画像に自動車72の画像が含まれる場合、当該自動車72のフロント部分74の構成(例えば、ヘッドライト、フロントグリル、ナンバープレートの各形状及び配置等)を特徴要素として抽出する。

S70では、制御部30は、カメラを起動させ、カメラを動作モードで動作させる。そして、続くS72では、制御部30は、動作モードで動作しているカメラが撮影している画像中の特徴要素を抽出する。即ち、S72では、制御部30は、カメラが撮影する画像中の特徴要素をリアルタイムで抽出する。

図9、図10を参照して、本実施例において、第2種の対象画像が表示部10に表示される際(図8のS78参照)の表示例を説明する。図9、図10の例では、ユーザが、レンタカーのレンタル開始時点の状態を撮影した第2種の対象画像70と、現在(例えば返却時点)のレンタカーの状態(以下では「現状」と呼ぶ場合がある)80と、を比較することを希望する状況が想定されている。図9、図10は、いずれも、上記の状況下における第2種の対象画像70の表示例を示す。制御部30は、表示切替指示が入力されると、図9の表示態様と図10の表示態様とを切り替えて表示部10に表示させることができる。

上記の通り、本実施例では、特徴情報は、対象画像中の特徴要素を示す情報を含む。端末装置2は、第2種の対象画像と第2種の特徴情報とを対応付けてメモリ32に記憶させた後、カメラによって再び特徴要素が撮影される場合(図8のS74でYES)に、第2種の対象画像を表示部10に表示させることができる。ユーザは、第2種の対象画像が撮影されたタイミングにおいて抽出された特徴要素を再びカメラに撮影させれば、表示部10に表示された第2種の対象画像を見ることができる。そのため、端末装置2のユーザは、第2種の対象画像の撮影時の状況と現在の状況とを適切に比較することができる。本実施例では、図8のS74でYESの場合が「特定の場合」の一例である。

第3実施例は第2実施例の変形例である。第3実施例について、第2実施例と異なる点を中心に説明する。本実施例の端末装置2の構成も、基本的な構成は第2実施例の端末装置2と共通する。本実施例では、制御部30は、記録処理(図7参照)を実行しない点が第2実施例とは異なる。本実施例では、制御部30は、事前に記録処理を実行することに代えて、事前に他の装置(例えば、撮影部を備える端末装置等)から通信I/F24を介して対象画像と特徴情報との組合せを取得し、取得された対象画像と特徴情報との組合せをメモリ32の画像記憶領域36に記憶させる処理を行う。即ち、本実施例で画像記憶領域36に記憶される対象画像と特徴情報との組合せは、事前に他の装置によって生成されたものである。本実施例の対象画像は、他の装置によって撮影された画像である。その上で、本実施例でも、制御部30は、第3実施例と同様に再現処理(図8参照)を実行する。

図11、図12を参照して、本実施例において、第2種の対象画像が表示部10に表示される際(図8のS78参照)の表示例を説明する。図11、図12の例では、ユーザが、遊技機(具体的にはパチンコ台)の審査機関による審査合格時点(若しくは遊技機メーカー出荷時点)の状態を撮影した第2種の対象画像90と、現在(例えば遊技店で稼働を開始した後の時点)の同種の遊技機の状態(以下では「現状」と呼ぶ場合がある)100と、を比較することを希望する状況が想定されている。より具体的には、遊技機の審査合格時点の遊技機の釘の向きと、現在の釘の向きとを比較し、釘の向きが過度に変更されていないか否かを確認することを希望する状況が想定されている。図11、図12は、いずれも、上記の状況下における第2種の対象画像90の表示例を示す。なお、図12は、理解の容易のために、遊技機の入賞口94(104)周辺部分を拡大した表示例を示す。本実施例でも、制御部30は、表示切替指示が入力されると、図11の表示態様と図12の表示態様とを切り替えて表示部10に表示させることができる。

上記の通り、本実施例の端末装置2では、制御部30は、記録処理(図7参照)を実行することに代えて、事前に他の装置(例えば、撮影部を備える端末装置等)から対象画像と特徴情報との組合せを取得し、取得された対象画像と特徴情報との組合せをメモリ32の画像記憶領域36に記憶させる。そして、再現処理(図8参照)を実行する。そのため、本実施例による場合も、第2実施例と同様に、第2種の対象画像が撮影されたタイミングにおいて抽出された第2種の特徴要素を再びカメラに撮影させれば、表示部10に表示された第2種の対象画像を見ることができる。そのため、端末装置2のユーザは、第2種の対象画像の撮影時の状況と現在の状況とを適切に比較することができる。本実施例では、撮影部を備える他の装置が「撮影部」の一例である。

第4実施例は第3実施例の変形例である。第4実施例について、第3実施例と異なる点を中心に説明する。本実施例でも、制御部30は、事前に記録処理を実行することに代えて、事前に他の装置から通信I/F24を介して対象画像と特徴情報との組合せを取得し、取得された対象画像と特徴情報との組合せをメモリ32の画像記憶領域36に記憶させる処理を行う。ただし、本実施例では、事前に他の装置から取得する対象画像は、他の装置のカメラ等によって事前に撮影された画像(即ち撮影画像)ではなく、他の装置において事前に生成された仮想画像である点が第3実施例とは異なる。

図14を参照して、本実施例において、第2種の対象画像(即ち図13の対象画像110)が表示部10に表示される際(図8のS78参照)の表示例を説明する。図14の例では、図12の例と同様に、表示部10の全面に第2種の対象画像110が表示されている。表示部10は光透過性を有するため、ユーザは、第2種の対象画像110を通して、その向こう側に存在する現状100を視認することができる。図14に示すように、ユーザが、仮想画像の入賞口114と現実の入賞口104とが重なるように位置合わせをすることにより、仮想画像の釘の頭部116と、現在の遊技機102の釘106の頭部の位置とをより容易に比較することができる。

本実施例による場合も、第2種の対象画像に対応付けられてメモリ32に記憶されている第2種の特徴要素をカメラに撮影させれば、表示部10に表示された第2種の対象画像を見ることができる。そのため、端末装置2のユーザは、第2種の対象画像と現在の状況とを適切に比較することができる。

4:フレーム

10(10a,10b):表示部

11(11a,11b):投影部

12:第1のカメラ

14:第2のカメラ

16:コントロールボックス

18:操作部

20:GPS受信機

22:センサ

24:通信I/F

30:制御部

32:メモリ

34:アプリケーションプログラム

36:画像記憶領域

50:第1種の対象画像

52:窓枠

60:現状

62:窓枠

64:カーテン

66:傷

68:汚れ

70:第2種の対象画像

72:自動車

74:フロント部分(特徴要素)

80:現状

82:自動車

84:フロント部分(特徴要素)

86:傷

90:第2種の対象画像

92:遊技機

93:盤面(特徴要素)

94:入賞口(特徴要素)

95:装飾(特徴要素)

96:釘(特徴要素)

100:現状

102:遊技機

103:盤面(特徴要素)

104:入賞口(特徴要素)

105:装飾(特徴要素)

106:釘(特徴要素)

110:対象画像(第2種の対象画像)

114:入賞口(特徴要素)

116:釘の頭部(特徴要素)

Claims (6)

- 端末装置であって、

撮影部と、

表示部と、

制御部と、

記憶部と、を備え、

前記制御部は、

前記撮影部に撮影を実行させる撮影制御部と、

前記撮影部が対象画像を撮影する対象タイミングにおける前記端末装置の環境の特徴を示す特徴情報を生成する生成部と、

撮影された前記対象画像と、生成された前記特徴情報と、を対応付けて前記記憶部に記憶させる記憶制御部と、

前記対象画像及び前記特徴情報が前記記憶部に記憶された後で、前記特徴が検出される特定の場合に、当該特徴を示す前記特徴情報に対応付けられて前記記憶部に記憶されている前記対象画像を前記表示部に表示させる、表示制御部と、を備える、

端末装置。 - 前記端末装置は、さらに、所定の領域内における前記端末装置の位置を検出する位置検出手段を備え、

前記生成部は、前記対象タイミングにおいて前記位置検出手段によって検出される対象位置を含む前記特徴を示す前記特徴情報を生成し、

前記表示制御部は、前記対象画像及び前記特徴情報が前記記憶部に記憶された後で、前記位置検出手段によって前記対象位置が検出される前記特定の場合に、当該対象位置を含む前記特徴を示す前記特徴情報に対応付けられて前記記憶部に記憶されている前記対象画像を、前記表示部に表示させる、

請求項1に記載の端末装置。 - 前記端末装置は、さらに、前記端末装置の姿勢を検出するセンサを備え、

前記生成部は、前記対象タイミングにおいて前記センサによって検出される対象姿勢をさらに含む前記特徴を示す前記特徴情報を生成し、

前記表示制御部は、前記対象画像及び前記特徴情報が前記記憶部に記憶された後で、前記位置検出手段によって前記対象位置が検出されるとともに、前記センサによって前記対象姿勢が検出される前記特定の場合に、当該対象位置及び当該対象姿勢を含む前記特徴を示す前記特徴情報に対応付けられて前記記憶部に記憶されている前記対象画像を、前記表示部に表示させる、

請求項2に記載の端末装置。 - 前記生成部は、前記対象タイミングにおいて前記撮影部が撮影する前記対象画像内に含まれる特徴要素を特定し、特定された前記特徴要素を含む前記特徴を示す前記特徴情報を生成し、

前記表示制御部は、前記対象画像及び前記特徴情報が前記記憶部に記憶された後で、前記撮影部によって前記特徴要素が撮影されることが検出される前記特定の場合に、当該特徴要素を含む前記特徴を示す前記特徴情報に対応付けられて前記記憶部に記憶されている前記対象画像を、前記表示部に表示させる、

請求項1に記載の端末装置。 - 前記端末装置は、さらに、

ユーザの頭部に装着可能なフレームを備え、

前記撮影部は、前記フレームに搭載され、前記フレームを装着した前記ユーザの視界範囲に対応する範囲を撮影可能であり、

前記表示部は、前記フレームに搭載され、前記フレームを装着した前記ユーザの右眼と左眼の少なくとも一方に対向する位置に配置される、

請求項1から4のいずれか一項に記載の端末装置。 - 端末装置であって、

表示部と、

制御部と、

記憶部と、を備え、

前記制御部は、

撮影部が撮影した対象画像と、前記撮影部が前記対象画像を撮影する対象タイミングにおける前記撮影部の環境の特徴を示す特徴情報と、を取得する取得部と、

取得された前記対象画像と前記特徴情報とを対応付けて前記記憶部に記憶させる記憶制御部と、

前記対象画像及び前記特徴情報が前記記憶部に記憶された後で、前記特徴が検出される特定の場合に、当該特徴を示す前記特徴情報に対応付けられて前記記憶部に記憶されている前記対象画像を前記表示部に表示させる、表示制御部と、を備える、

端末装置。

Priority Applications (5)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2016107450A JP2017215664A (ja) | 2016-05-30 | 2016-05-30 | 端末装置 |

| PCT/JP2017/018455 WO2017208814A1 (ja) | 2016-05-30 | 2017-05-17 | 端末装置 |

| EP17806372.3A EP3467768B1 (en) | 2016-05-30 | 2017-05-17 | Terminal apparatus |

| CN201780033528.0A CN109196552B (zh) | 2016-05-30 | 2017-05-17 | 终端装置 |

| US16/305,682 US11016296B2 (en) | 2016-05-30 | 2017-05-17 | Terminal device |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2016107450A JP2017215664A (ja) | 2016-05-30 | 2016-05-30 | 端末装置 |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2017215664A true JP2017215664A (ja) | 2017-12-07 |

| JP2017215664A5 JP2017215664A5 (ja) | 2019-06-27 |

Family

ID=60479455

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2016107450A Pending JP2017215664A (ja) | 2016-05-30 | 2016-05-30 | 端末装置 |

Country Status (5)

| Country | Link |

|---|---|

| US (1) | US11016296B2 (ja) |

| EP (1) | EP3467768B1 (ja) |

| JP (1) | JP2017215664A (ja) |

| CN (1) | CN109196552B (ja) |

| WO (1) | WO2017208814A1 (ja) |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2021099816A (ja) * | 2017-01-31 | 2021-07-01 | キヤノンマーケティングジャパン株式会社 | 情報処理装置、情報処理システム、情報処理方法及びプログラム |

Families Citing this family (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP7143092B2 (ja) * | 2018-03-12 | 2022-09-28 | ソニー・オリンパスメディカルソリューションズ株式会社 | 医療用画像処理装置、医療用観察装置、および画像処理方法 |

| US11227007B2 (en) * | 2019-07-23 | 2022-01-18 | Obayashi Corporation | System, method, and computer-readable medium for managing image |

Citations (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2005147674A (ja) * | 2003-11-11 | 2005-06-09 | Nippon Telegr & Teleph Corp <Ntt> | 景観記録ナビゲーション装置 |

| JP2006071746A (ja) * | 2004-08-31 | 2006-03-16 | Olympus Corp | 重畳型画像観察装置 |

| JP2010176346A (ja) * | 2009-01-29 | 2010-08-12 | Sony Corp | 撮像装置および検索方法、並びにプログラム |

| JP2011138258A (ja) * | 2009-12-28 | 2011-07-14 | Rakuten Inc | 景観再現システム |

Family Cites Families (16)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH11144042A (ja) | 1997-11-12 | 1999-05-28 | Naoki Harigai | レンタカ−の新規傷発見方法と、その方法を実施するための傷発見装置 |

| JP4077608B2 (ja) | 2001-02-27 | 2008-04-16 | 株式会社エヌ・ティ・ティ・ドコモ | 特徴領域抽出方法およびその装置ならびに情報提供方法およびその装置 |

| EP2356583B9 (en) * | 2008-11-10 | 2014-09-10 | Metaio GmbH | Method and system for analysing an image generated by at least one camera |

| US9122707B2 (en) | 2010-05-28 | 2015-09-01 | Nokia Technologies Oy | Method and apparatus for providing a localized virtual reality environment |

| JP2012203668A (ja) * | 2011-03-25 | 2012-10-22 | Sony Corp | 情報処理装置、物体認識方法、プログラム及び端末装置 |

| US9530232B2 (en) * | 2012-09-04 | 2016-12-27 | Qualcomm Incorporated | Augmented reality surface segmentation |

| JP6040715B2 (ja) | 2012-11-06 | 2016-12-07 | ソニー株式会社 | 画像表示装置及び画像表示方法、並びにコンピューター・プログラム |

| US9916691B2 (en) * | 2013-02-14 | 2018-03-13 | Seiko Epson Corporation | Head mounted display and control method for head mounted display |

| US20150103183A1 (en) * | 2013-10-10 | 2015-04-16 | Nvidia Corporation | Method and apparatus for device orientation tracking using a visual gyroscope |

| US10430985B2 (en) * | 2014-03-14 | 2019-10-01 | Magic Leap, Inc. | Augmented reality systems and methods utilizing reflections |

| US9626802B2 (en) * | 2014-05-01 | 2017-04-18 | Microsoft Technology Licensing, Llc | Determining coordinate frames in a dynamic environment |

| JP2016033759A (ja) * | 2014-07-31 | 2016-03-10 | セイコーエプソン株式会社 | 表示装置、表示装置の制御方法、および、プログラム |

| US9898868B2 (en) * | 2014-11-06 | 2018-02-20 | Seiko Epson Corporation | Display device, method of controlling the same, and program |

| JP6403262B2 (ja) | 2014-12-04 | 2018-10-10 | タイガースポリマー株式会社 | 中空円筒状樹脂成形体の製造方法 |

| US9746675B2 (en) * | 2015-05-28 | 2017-08-29 | Microsoft Technology Licensing, Llc | Alignment based view matrix tuning |

| JP6594666B2 (ja) * | 2015-06-01 | 2019-10-23 | オリンパス株式会社 | 撮像補助装置、撮像装置および撮像補助方法 |

-

2016

- 2016-05-30 JP JP2016107450A patent/JP2017215664A/ja active Pending

-

2017

- 2017-05-17 WO PCT/JP2017/018455 patent/WO2017208814A1/ja unknown

- 2017-05-17 US US16/305,682 patent/US11016296B2/en active Active

- 2017-05-17 CN CN201780033528.0A patent/CN109196552B/zh active Active

- 2017-05-17 EP EP17806372.3A patent/EP3467768B1/en active Active

Patent Citations (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2005147674A (ja) * | 2003-11-11 | 2005-06-09 | Nippon Telegr & Teleph Corp <Ntt> | 景観記録ナビゲーション装置 |

| JP2006071746A (ja) * | 2004-08-31 | 2006-03-16 | Olympus Corp | 重畳型画像観察装置 |

| JP2010176346A (ja) * | 2009-01-29 | 2010-08-12 | Sony Corp | 撮像装置および検索方法、並びにプログラム |

| JP2011138258A (ja) * | 2009-12-28 | 2011-07-14 | Rakuten Inc | 景観再現システム |

Cited By (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2021099816A (ja) * | 2017-01-31 | 2021-07-01 | キヤノンマーケティングジャパン株式会社 | 情報処理装置、情報処理システム、情報処理方法及びプログラム |

| JP7273325B2 (ja) | 2017-01-31 | 2023-05-15 | キヤノンマーケティングジャパン株式会社 | 情報処理装置、情報処理システム、情報処理方法及びプログラム |

Also Published As

| Publication number | Publication date |

|---|---|

| CN109196552B (zh) | 2022-09-23 |

| EP3467768B1 (en) | 2021-11-24 |

| US11016296B2 (en) | 2021-05-25 |

| WO2017208814A1 (ja) | 2017-12-07 |

| CN109196552A (zh) | 2019-01-11 |

| EP3467768A4 (en) | 2020-01-22 |

| EP3467768A1 (en) | 2019-04-10 |

| US20200326540A1 (en) | 2020-10-15 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| CN107026973B (zh) | 图像处理装置、图像处理方法与摄影辅助器材 | |

| JP4983784B2 (ja) | 撮像システム、画像提示方法、制御装置、プログラム | |

| WO2013069047A1 (ja) | 画像生成装置および画像生成方法 | |

| WO2013069050A1 (ja) | 画像生成装置および画像生成方法 | |

| WO2013069049A1 (ja) | 画像生成装置および画像生成方法 | |

| CN110012228A (zh) | 显示控制设备和显示控制设备的控制方法 | |

| WO2013069048A1 (ja) | 画像生成装置および画像生成方法 | |

| US20120026376A1 (en) | Anamorphic projection device | |

| CN105141942B (zh) | 3d图像合成方法及装置 | |

| US20140072274A1 (en) | Computer-readable storage medium having information processing program stored therein, information processing apparatus, information processing system, and information processing method | |

| WO2017208814A1 (ja) | 端末装置 | |

| JP5530322B2 (ja) | 表示装置および表示方法 | |

| JP2019176249A (ja) | 画像処理装置、画像処理方法、画像処理プログラム及び撮像装置 | |

| CN106664361A (zh) | 信息处理装置、信息处理系统、信息处理方法和程序 | |

| US9478068B2 (en) | Computer-readable medium, image processing device, image processing system, and image processing method | |

| JP5880135B2 (ja) | 検出装置、検出方法及びプログラム | |

| WO2017122270A1 (ja) | 画像表示装置 | |

| JPWO2020146785A5 (ja) | ||

| US9066010B2 (en) | Photographing apparatus, photographing method and medium recording photographing control program | |

| JP2014011654A (ja) | 画像解析装置、画像解析方法、および画像解析システム | |

| US20220070365A1 (en) | Mixed reality image capture and smart inspection | |

| KR101724754B1 (ko) | 동작 인식을 이용한 차량주변 촬영시스템 | |

| JP2015103918A (ja) | 撮像装置及び撮像装置の制御方法 | |

| US20230351632A1 (en) | Method for providing visual content, host, and computer readable storage medium | |

| JP2010268127A (ja) | 制御装置、撮像装置、撮像システム、画像取得方法、及びプログラム |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20190522 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20190522 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20200421 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20200619 |

|

| A02 | Decision of refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A02 Effective date: 20200728 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20201019 |

|

| C60 | Trial request (containing other claim documents, opposition documents) |

Free format text: JAPANESE INTERMEDIATE CODE: C60 Effective date: 20201019 |

|

| A911 | Transfer to examiner for re-examination before appeal (zenchi) |

Free format text: JAPANESE INTERMEDIATE CODE: A911 Effective date: 20201027 |

|

| C21 | Notice of transfer of a case for reconsideration by examiners before appeal proceedings |

Free format text: JAPANESE INTERMEDIATE CODE: C21 Effective date: 20201104 |

|

| A912 | Re-examination (zenchi) completed and case transferred to appeal board |

Free format text: JAPANESE INTERMEDIATE CODE: A912 Effective date: 20201113 |

|

| C211 | Notice of termination of reconsideration by examiners before appeal proceedings |

Free format text: JAPANESE INTERMEDIATE CODE: C211 Effective date: 20201117 |

|

| C22 | Notice of designation (change) of administrative judge |

Free format text: JAPANESE INTERMEDIATE CODE: C22 Effective date: 20210629 |

|

| C22 | Notice of designation (change) of administrative judge |

Free format text: JAPANESE INTERMEDIATE CODE: C22 Effective date: 20211019 |

|

| C23 | Notice of termination of proceedings |

Free format text: JAPANESE INTERMEDIATE CODE: C23 Effective date: 20211026 |

|

| C03 | Trial/appeal decision taken |

Free format text: JAPANESE INTERMEDIATE CODE: C03 Effective date: 20211130 |

|

| C30A | Notification sent |

Free format text: JAPANESE INTERMEDIATE CODE: C3012 Effective date: 20211130 |