DE112009000485T5 - Objektvergleich für Verfolgung, Indizierung und Suche - Google Patents

Objektvergleich für Verfolgung, Indizierung und Suche Download PDFInfo

- Publication number

- DE112009000485T5 DE112009000485T5 DE112009000485T DE112009000485T DE112009000485T5 DE 112009000485 T5 DE112009000485 T5 DE 112009000485T5 DE 112009000485 T DE112009000485 T DE 112009000485T DE 112009000485 T DE112009000485 T DE 112009000485T DE 112009000485 T5 DE112009000485 T5 DE 112009000485T5

- Authority

- DE

- Germany

- Prior art keywords

- signature

- match

- camera system

- image capture

- objects

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

- 238000001514 detection method Methods 0.000 claims abstract description 50

- 238000000034 method Methods 0.000 claims description 99

- 230000006870 function Effects 0.000 claims description 63

- 230000001186 cumulative effect Effects 0.000 claims description 43

- 238000012549 training Methods 0.000 claims description 41

- 230000033001 locomotion Effects 0.000 claims description 32

- 230000008569 process Effects 0.000 claims description 28

- 230000004044 response Effects 0.000 claims description 7

- 238000012546 transfer Methods 0.000 claims description 6

- 238000013507 mapping Methods 0.000 claims 2

- 230000005540 biological transmission Effects 0.000 claims 1

- 230000000875 corresponding effect Effects 0.000 description 34

- 230000009466 transformation Effects 0.000 description 33

- 238000010586 diagram Methods 0.000 description 20

- 230000002123 temporal effect Effects 0.000 description 16

- 238000012545 processing Methods 0.000 description 13

- 239000013598 vector Substances 0.000 description 13

- 238000000844 transformation Methods 0.000 description 9

- 230000004913 activation Effects 0.000 description 7

- 230000008901 benefit Effects 0.000 description 5

- 238000005457 optimization Methods 0.000 description 4

- 238000012552 review Methods 0.000 description 4

- 241001465754 Metazoa Species 0.000 description 3

- 230000000694 effects Effects 0.000 description 3

- 238000012360 testing method Methods 0.000 description 3

- 238000012795 verification Methods 0.000 description 3

- 230000008859 change Effects 0.000 description 2

- 230000007423 decrease Effects 0.000 description 2

- 230000007704 transition Effects 0.000 description 2

- BUHVIAUBTBOHAG-FOYDDCNASA-N (2r,3r,4s,5r)-2-[6-[[2-(3,5-dimethoxyphenyl)-2-(2-methylphenyl)ethyl]amino]purin-9-yl]-5-(hydroxymethyl)oxolane-3,4-diol Chemical compound COC1=CC(OC)=CC(C(CNC=2C=3N=CN(C=3N=CN=2)[C@H]2[C@@H]([C@H](O)[C@@H](CO)O2)O)C=2C(=CC=CC=2)C)=C1 BUHVIAUBTBOHAG-FOYDDCNASA-N 0.000 description 1

- 241000282412 Homo Species 0.000 description 1

- 235000015055 Talinum crassifolium Nutrition 0.000 description 1

- 244000010375 Talinum crassifolium Species 0.000 description 1

- 230000002547 anomalous effect Effects 0.000 description 1

- 230000000739 chaotic effect Effects 0.000 description 1

- 239000003795 chemical substances by application Substances 0.000 description 1

- 230000006835 compression Effects 0.000 description 1

- 238000007906 compression Methods 0.000 description 1

- 238000010276 construction Methods 0.000 description 1

- 230000002596 correlated effect Effects 0.000 description 1

- 238000013500 data storage Methods 0.000 description 1

- 230000007613 environmental effect Effects 0.000 description 1

- 238000011156 evaluation Methods 0.000 description 1

- 230000007717 exclusion Effects 0.000 description 1

- 230000006872 improvement Effects 0.000 description 1

- 230000010354 integration Effects 0.000 description 1

- 230000001788 irregular Effects 0.000 description 1

- 230000014759 maintenance of location Effects 0.000 description 1

- 239000000463 material Substances 0.000 description 1

- 238000005259 measurement Methods 0.000 description 1

- 238000012986 modification Methods 0.000 description 1

- 230000004048 modification Effects 0.000 description 1

- 238000012544 monitoring process Methods 0.000 description 1

- 230000003287 optical effect Effects 0.000 description 1

- 238000013139 quantization Methods 0.000 description 1

- 229920006395 saturated elastomer Polymers 0.000 description 1

- 238000012216 screening Methods 0.000 description 1

- 230000011664 signaling Effects 0.000 description 1

- 238000001356 surgical procedure Methods 0.000 description 1

- 230000001960 triggered effect Effects 0.000 description 1

- 238000001429 visible spectrum Methods 0.000 description 1

- XLYOFNOQVPJJNP-UHFFFAOYSA-N water Substances O XLYOFNOQVPJJNP-UHFFFAOYSA-N 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/80—Analysis of captured images to determine intrinsic or extrinsic camera parameters, i.e. camera calibration

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N5/00—Details of television systems

- H04N5/222—Studio circuitry; Studio devices; Studio equipment

- H04N5/262—Studio circuits, e.g. for mixing, switching-over, change of character of image, other special effects ; Cameras specially adapted for the electronic generation of special effects

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/20—Analysis of motion

- G06T7/246—Analysis of motion using feature-based methods, e.g. the tracking of corners or segments

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F18/00—Pattern recognition

- G06F18/20—Analysing

- G06F18/21—Design or setup of recognition systems or techniques; Extraction of features in feature space; Blind source separation

- G06F18/213—Feature extraction, e.g. by transforming the feature space; Summarisation; Mappings, e.g. subspace methods

- G06F18/2132—Feature extraction, e.g. by transforming the feature space; Summarisation; Mappings, e.g. subspace methods based on discrimination criteria, e.g. discriminant analysis

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F18/00—Pattern recognition

- G06F18/20—Analysing

- G06F18/22—Matching criteria, e.g. proximity measures

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F18/00—Pattern recognition

- G06F18/20—Analysing

- G06F18/24—Classification techniques

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F18/00—Pattern recognition

- G06F18/20—Analysing

- G06F18/24—Classification techniques

- G06F18/245—Classification techniques relating to the decision surface

- G06F18/2453—Classification techniques relating to the decision surface non-linear, e.g. polynomial classifier

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F18/00—Pattern recognition

- G06F18/40—Software arrangements specially adapted for pattern recognition, e.g. user interfaces or toolboxes therefor

- G06F18/41—Interactive pattern learning with a human teacher

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/20—Analysis of motion

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/70—Determining position or orientation of objects or cameras

- G06T7/73—Determining position or orientation of objects or cameras using feature-based methods

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V20/00—Scenes; Scene-specific elements

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V20/00—Scenes; Scene-specific elements

- G06V20/40—Scenes; Scene-specific elements in video content

- G06V20/41—Higher-level, semantic clustering, classification or understanding of video scenes, e.g. detection, labelling or Markovian modelling of sport events or news items

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V20/00—Scenes; Scene-specific elements

- G06V20/50—Context or environment of the image

- G06V20/52—Surveillance or monitoring of activities, e.g. for recognising suspicious objects

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V20/00—Scenes; Scene-specific elements

- G06V20/60—Type of objects

- G06V20/64—Three-dimensional objects

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V30/00—Character recognition; Recognising digital ink; Document-oriented image-based pattern recognition

- G06V30/10—Character recognition

- G06V30/24—Character recognition characterised by the processing or recognition method

- G06V30/242—Division of the character sequences into groups prior to recognition; Selection of dictionaries

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/10—Human or animal bodies, e.g. vehicle occupants or pedestrians; Body parts, e.g. hands

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/10—Human or animal bodies, e.g. vehicle occupants or pedestrians; Body parts, e.g. hands

- G06V40/103—Static body considered as a whole, e.g. static pedestrian or occupant recognition

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/60—Control of cameras or camera modules

- H04N23/61—Control of cameras or camera modules based on recognised objects

- H04N23/611—Control of cameras or camera modules based on recognised objects where the recognised objects include parts of the human body

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/60—Control of cameras or camera modules

- H04N23/63—Control of cameras or camera modules by using electronic viewfinders

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/60—Control of cameras or camera modules

- H04N23/63—Control of cameras or camera modules by using electronic viewfinders

- H04N23/631—Graphical user interfaces [GUI] specially adapted for controlling image capture or setting capture parameters

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/60—Control of cameras or camera modules

- H04N23/66—Remote control of cameras or camera parts, e.g. by remote control devices

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/60—Control of cameras or camera modules

- H04N23/66—Remote control of cameras or camera parts, e.g. by remote control devices

- H04N23/661—Transmitting camera control signals through networks, e.g. control via the Internet

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N7/00—Television systems

- H04N7/18—Closed-circuit television [CCTV] systems, i.e. systems in which the video signal is not broadcast

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N7/00—Television systems

- H04N7/18—Closed-circuit television [CCTV] systems, i.e. systems in which the video signal is not broadcast

- H04N7/181—Closed-circuit television [CCTV] systems, i.e. systems in which the video signal is not broadcast for receiving images from a plurality of remote sources

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F2218/00—Aspects of pattern recognition specially adapted for signal processing

- G06F2218/12—Classification; Matching

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10016—Video; Image sequence

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30232—Surveillance

Landscapes

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Theoretical Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Signal Processing (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Data Mining & Analysis (AREA)

- Human Computer Interaction (AREA)

- Artificial Intelligence (AREA)

- Evolutionary Computation (AREA)

- Life Sciences & Earth Sciences (AREA)

- General Engineering & Computer Science (AREA)

- Bioinformatics & Cheminformatics (AREA)

- Bioinformatics & Computational Biology (AREA)

- Evolutionary Biology (AREA)

- Software Systems (AREA)

- Computational Linguistics (AREA)

- Mathematical Physics (AREA)

- Nonlinear Science (AREA)

- Image Analysis (AREA)

- Information Retrieval, Db Structures And Fs Structures Therefor (AREA)

- Sorting Of Articles (AREA)

- Image Processing (AREA)

- Studio Devices (AREA)

Abstract

einer Bilderfassungsvorrichtung (102) mit einem Blickfeld, die Bilddaten erzeugt, die mehrere Bilder des Blickfeldes darstellen;

einem Objektdetektionsmodul (204), das mit der Bilderfassungsvorrichtung (102) verbunden ist und die Bilddaten empfängt, wobei das Objektdetektionsmodul (204) betriebsfähig ist, um Objekte zu detektieren, die in einem oder mehreren der mehreren Bilder erscheinen;

einem Objektverfolgungsmodul (206), das mit dem Objektdetektionsmodul (204) verbunden ist und betriebsfähig ist, um Fälle eines ersten Objekts, das in einer ersten Gruppe der mehreren Bilder detektiert wird, zeitlich zuzuordnen, wobei das erste Objekt eine erste Signatur aufweist, die Merkmale des ersten Objekts darstellt, die von den Bildern der ersten Gruppe abgeleitet sind; und

einem Übereinstimmungsklassifikator (218), der mit dem Objektverfolgungsmodul (206) verbunden ist, zum Vergleichen von Objektfällen, wobei der Übereinstimmungsklassifikator (218) betriebsfähig ist, um Objektfälle durch Analysieren von Daten, die von der ersten Signatur des ersten Objekts und einer zweiten Signatur eines zweiten Objekts...

Description

- Verwandte Anmeldungen

- Diese Anmeldung beansprucht den Nutzen unter 35 U. S. C. § 119(e) der vorläufigen US-Anmeldung Nr. 61/033 349 mit dem Titel ”Method of Dynamic Object and Event Classification”, eingereicht am 3. März 2008, und der vorläufigen US-Anmeldung Nr. 61/033 284 mit dem Titel ”Method and System for Tracking Objects Under Video Surveillance”, eingereicht am 3. März 2008, die beide durch den Hinweis in ihren Gesamtheiten hierin aufgenommen werden.

- Technisches Gebiet

- Diese Offenbarung bezieht sich im Allgemeinen, aber nicht ausschließlich auf eine Videoüberwachung und insbesondere auf den Vergleich von Objekten, die in mehreren Bildern dargestellt sind.

- Hintergrundinformationen

- Automatisierte Sicherheits- und Überwachungssysteme verwenden typischerweise Videokameras oder andere Bilderfassungsvorrichtungen oder Sensoren, um Bilddaten zu sammeln. In den einfachsten Systemen werden durch die Bilddaten dargestellte Bilder für eine zeitgleiche Rasterung durch Sicherheitspersonal angezeigt und/oder für eine spätere Bezugnahme nach einem Sicherheitsbruch aufgezeichnet. In diesen Systemen wird die Aufgabe der Detektion von interessierenden Objekten von einem menschlichen Beobachter durchgeführt. Ein signifikanter Vorteil tritt auf, wenn das System selbst die Objektdetektion und -verfolgung entweder teilweise oder vollständig durchführen kann.

- In einem typischen Überwachungssystem kann man beispielsweise an der Verfolgung eines detektieren Objekts wie z. B. eines Menschen, eines Fahrzeugs, eines Tiers, usw., das sich durch die Umgebung bewegt, interessiert sein.

- Existierende Systeme, die zur Verfolgung von detektierten Objekten in der Lage sind, versuchen, Objekte unter Verwendung von Bewegungsvorhersage und Verfolgung von ausgewählten Merkmalen in aufeinander folgenden Videoeinzelbildern zu verfolgen. Andere Verfahren, wie z. B. das SIFT-Verfahren, versuchen, das Aussehen eines Falls eines Objekts genau darzustellen, so dass die Darstellung verwendet werden kann, um mehrere Fälle eines Objekts ungeachtet ihrer zeitlichen Nähe zu vergleichen. Bekannte Verfolgungssysteme leiden jedoch unter einem oder mehreren (1) der Unfähigkeit, trainiert zu werden, (2) dem Mangel an Integration in Objektsuch-, Objektindizierungs- und Objektklassifikationssysteme, (3) einer ungeeigneten Objektverfolgungs- und Objektsuchleistung, und (4) ineffektiven Verfolgungsfähigkeiten über Kameras.

- Kurzbeschreibung der Zeichnungen

-

1 ist ein bildhaftes Diagramm eines Kamerasystems gemäß einem Ausführungsbeispiel. -

2 ist ein vereinfachtes Blockdiagramm von einer der Bilderfassungsvorrichtungen in dem in1 gezeigten System. -

3 ist ein Blockdiagramm, das ein Verfahren zum Erzeugen einer Eingabe für den Übereinstimmungsklassifikator von2 gemäß einem Ausführungsbeispiel darstellt. -

4 ist ein Blockdiagramm des Übereinstimmungsklassifikators von2 . -

5A ist ein Blockdiagramm, das einen der anfänglichen N – 1 Schritte in dem in4 gezeigten Übereinstimmungsklassifikator zeigt. -

5B ist eine Darstellung von Annahme- und Ablehnungsschwellenwerten, die in dem in5A gezeigten Schritt verwendet werden. -

6 ist ein Ablaufplan, der ein Verfahren zur Verwendung des Übereinstimmungsklassifikators gemäß einem Ausführungsbeispiel darstellt. -

7 ist ein Ablaufdiagramm eines Übereinstimmungsklassifikator-Trainingsverfahrens. -

8 ist ein Ablaufplan eines Übereinstimmungsklassifikator-Trainingsverfahrens. -

9 ist ein Ablaufplan eines weiteren Übereinstimmungsklassifikator-Trainingsverfahrens. -

10 ist ein Blockdiagramm eines Objektverfolgungssystems. -

11 ist ein Ablaufplan eines Objektverfolgungsverfahrens. -

12 ist ein Hybrid-Blockdiagramm und Ablaufplan eines weiteren Objektverfolgungssystems. -

13A und13B sind Hybrid-Blockdiagramme und Ablaufpläne eines Verfolgungsverfahrens zwischen Kameras. -

14 ist ein Blockdiagramm eines Objektindizierungssystems. -

15 ist ein bildhaftes Diagramm eines Objektsuchverfahrens. - Ausführliche Beschreibung von Ausführungsbeispielen

- Überblick

- Ein Kamerasystem umfasst eine Bilderfassungsvorrichtung, ein Objektdetektionsmodul, das mit der Bilderfassungsvorrichtung verbunden ist, ein Objektverfolgungsmodul, das mit dem Objektdetektionsmodul verbunden ist, und einen Übereinstimmungsklassifikator, der mit dem Objektverfolgungsmodul verbunden ist. Die Bilderfassungsvorrichtung weist ein Blickfeld auf und erzeugt Bilddaten, die mehrere Bilder des Blickfeldes darstellen. Das Objektdetektionsmodul empfängt die Bilddaten und ist betriebsfähig, um Objekte zu detektieren, die in einem oder mehreren der mehreren Bilder erscheinen. Das Objektverfolgungsmodul ist betriebsfähig, um Fälle eines ersten Objekts, das in einer ersten Gruppe der mehreren Bilder detektiert wird, zeitlich zuzuordnen. Das erste Objekt weist eine erste Signatur auf, die Merkmale des ersten Objekts darstellt, die von den Bildern der ersten Gruppe abgeleitet werden. Der Übereinstimmungsklassifikator ist betriebsfähig, um Objektfälle durch Analysieren von Daten, die von der ersten Signatur des ersten Objekts und einer zweiten Signatur eines zweiten Objekts abgeleitet sind, zu vergleichen. Das zweite Objekt wird in einem zweiten Bild detektiert, das von den Bildern der ersten Gruppe verschieden ist. Die zweite Signatur stellt Merkmale des zweiten Objekts dar, die vom zweiten Bild abgeleitet werden. Der Übereinstimmungsklassifikator analysiert den ersten Satz von Daten, um festzustellen, ob die zweite Signatur mit der ersten Signatur übereinstimmt oder nicht. Der Übereinstimmungsklassifikator arbeitet zum Vergleichen von Objektfällen in einer Weise, die zumindest teilweise durch einen Trainingsprozess festgelegt wurde, der den Übereinstimmungsklassifikator unter Verwendung eines Satzes von möglichen Objektmerkmalen automatisch konfiguriert.

- Ein Verfahren verfolgt ein durch ein Kamerasystem erfasstes Objekt. Das Verfahren erfasst erste und zweite Bilder eines Blickfeldes des Kamerasystems, detektiert ein erstes Objekt, das im ersten Bild erfasst ist, und ein zweites Objekt, das im zweiten Bild erfasst ist, und erzeugt eine erste Signatur des ersten Objekts und eine zweite Signatur des zweiten Objekts. Die erste Signatur stellt einen ersten Satz von Merkmalen des ersten Objekts dar und die zweite Signatur stellt einen zweiten Satz von Merkmalen des zweiten Objekts dar. Das Verfahren erzeugt Daten, die von der ersten und der zweiten Signatur abgeleitet sind. Die Daten entsprechen einer ersten Teilmenge von Merkmalen, die aus dem ersten Satz ausgewählt sind, und einer zweiten Teilmenge von Merkmalen, die aus dem zweiten Satz ausgewählt sind. Ein Trainingsprozess bestimmt automatisch die Merkmale des ersten und des zweiten Satzes, die für die Aufnahme in die erste und die zweite Teilmenge ausgewählt werden sollen. Das Verfahren analysiert die Daten, um festzustellen, ob das zweite Objekt ein Fall des ersten Objekts ist.

- Ein Verfahren erzeugt Indexelemente von Objekten in Bildern, die von einem Kamerasystem erfasst werden. Das Verfahren erfasst eine erste Gruppe von mehreren Bildern eines Objekts in einem Blickfeld des Kamerasystems, detektiert das Objekt in der ersten Gruppe von mehreren Bildern und erzeugt einen ersten Satz von Einzelbildsignaturen des Objekts. Die Einzelbildsignaturen des ersten Satzes entsprechen Merkmalen des Objekts, die von den mehreren Bildern der ersten Gruppe abgeleitet sind. Das Verfahren erzeugt eine erste mittlere Signatur des Objekts. Die erste mittlere Signatur ist ein Mittelwert der Einzelbildsignaturen des ersten Satzes. Die erste mittlere Signatur ist ein erstes Indexelement des Objekts. Das Verfahren erzeugt eine kumulative Signatur des Objekts. Die kumulative Signatur ist ein gewichteter Mittelwert der Einzelbildsignaturen des ersten Satzes. Das Verfahren erfasst ein zweites Bild des Objekts, detektiert das Objekt im zweiten Bild und erzeugt eine zweite Einzelbildsignatur, die vom zweiten Bild abgeleitet ist. Das Verfahren aktualisiert die kumulative Signatur durch Gewichten der zweiten Einzelbildsignatur und Mitteln der gewichteten zweiten Einzelbildsignatur mit der kumulativen Signatur. Das Verfahren stellt fest, ob die aktualisierte kumulative Signatur und die erste gemittelte Signatur als Übereinstimmung angenommen oder abgelehnt werden soll. Die erste mittlere Signatur wird auf der Basis der zweiten Einzelbildsignatur aktualisiert, wenn die aktualisierte kumulative Signatur und die erste mittlere Signatur als Übereinstimmung angenommen werden. Eine zweite mittlere Signatur des Objekts wird auf der Basis der zweiten Einzelbildsignatur erzeugt, wenn die aktualisierte kumulative Signatur und die erste mittlere Signatur als Übereinstimmung abgelehnt werden. Die zweite mittlere Signatur ist ein zweites Indexelement des Objekts.

- Ein Verfahren durchsucht Daten, um Bilder eines Objekts zu identifizieren, das von einem Kamerasystem erfasst wird. Das Verfahren erfasst ein erstes Objekt in einem Bild eines Blickfeldes des Kamerasystems. Das erste Objekt weist eine erste Signatur auf, die Merkmale des ersten Objekts darstellen. Das Verfahren zeigt ein Bild des ersten Objekts auf einer Anzeige an, nimmt eine Benutzereingabe an, die eine Auswahl des ersten Objekts angibt, und führt Feststellungen hinsichtlich dessen durch, ob die erste Signatur einer Gruppe von Signaturen entspricht, die einem Satz von Objekten entsprechen, die in Bildern des Blickfeldes des Kamerasystems erfasst wurden. Das Verfahren sendet eine Benachrichtigung, wenn eine zweite Signatur eines zweiten Objekts des Satzes mit der ersten Signatur übereinstimmt.

- Ein Kamerasystem umfasst eine Bilderfassungsvorrichtung, ein Objektdetektionsmodul, das mit der Bilderfassungsvorrichtung verbunden ist, eine Benutzerschnittstelle, die mit der Bilderfassungsvorrichtung verbunden ist, einen Übereinstimmungsklassifikator, ein Objektverfolgungsmodul, das mit dem Übereinstimmungsklassifikator und dem Objektdetektionsmodul verbunden ist, und ein Suchmodul, das mit dem Übereinstimmungsklassifikator und der Benutzerschnittstelle verbunden ist. Die Bilderfassungsvorrichtung weist ein Blickfeld auf und erzeugt Bilddaten, die mehrere Bilder des Blickfeldes darstellen. Das Objektdetektionsmodul empfängt die Bilddaten und ist betriebsfähig, um Objekte zu detektieren, die in einem oder mehreren der mehreren Bilder erscheinen. Die Benutzerschnittstelle umfasst eine Anzeige zum Anzeigen von Objekten, die vom Objektdetektionsmodul detektiert werden, und eine Eingabevorrichtung, die betriebsfähig ist, um Objekte, die vom Objektdetektionsmodul detektiert werden, in Reaktion auf Benutzerbefehle auszuwählen. Der Übereinstimmungsklassifikator ist betriebsfähig, um Objekte, die durch das Objektdetektionsmodul detektiert werden, zu vergleichen. Das Objektverfolgungsmodul ist betriebsfähig, um Fälle von Objekten, die vom Objektdetektionsmodul detektiert werden, zeitlich zuzuordnen, und ist auch betriebsfähig, um den Übereinstimmungsklassifikator heranzuziehen, um festzustellen, ob Fälle von Objekten zugeordnet werden sollen oder nicht. Das Suchmodul ist betriebsfähig, um gespeicherte Bilder von Objekten, die durch die Eingabevorrichtung ausgewählt werden, abzurufen, und ist auch betriebsfähig, um den Übereinstimmungsklassifikator heranzuziehen, um ein gespeichertes Bild eines ausgewählten Objekts aufzufinden.

- Kamerasystem

- Mit Bezug auf die vorstehend aufgelisteten Zeichnungen beschreibt dieser Abschnitt spezielle Ausführungsbeispiele und ihre ausführliche Konstruktion und Operation. Die hierin beschriebenen Ausführungsbeispiele werden nur zur Erläuterung und nicht zur Begrenzung dargelegt. Der Fachmann auf dem Gebiet wird angesichts der Lehren hierin erkennen, dass ein Bereich von Äquivalenten zu den hierin beschriebenen Beispielausführungsbeispielen besteht. Vor allem sind andere Ausführungsbeispiele möglich, Veränderungen können an den hierin beschriebenen Ausführungsbeispielen vorgenommen werden und es können Äquivalente zu den Komponenten, Teilen oder Schritten bestehen, die die beschriebenen Ausführungsbeispiele bilden.

- Wie ein Fachmann auf dem Gebiet angesichts dieser Offenbarung erkennen wird, können bestimmte Ausführungsbeispiele bestimmte Vorteile gegenüber dem bekannten Stand der Technik erreichen, einschließlich einiger oder aller der folgenden: (1) Vereinigung von Objektverfolgungs-, Objektindizierungs- und Objektsuchverfahren, (2) Implementieren eines trainierbaren Übereinstimmungsklassifikators für die Objektverfolgung, -indizierung und -suche, (3) Fähigkeit, nach Fällen eines Objekts zu suchen, das vor einer Regelverletzung erfasst wurde, (4) Fähigkeit, vorher erfasste Objekte zu erkennen, nachdem ein neuer Objekttyp zu einer Detektionsbibliothek hinzugefügt ist, (5) Fähigkeit, die Objektverfolgung, -indizierung und -suche an Umgebungsänderungen anzupassen, (6) Fähigkeit, neue Merkmale hinzuzufügen, um die Detektions- und Klassifikationsgenauigkeit zu optimieren, (7) Implementieren eines Verfolgungssystems mit hoher Geschwindigkeit, das eine genaue Verfolgung selbst bei relativ niedrigen Bildraten ermöglicht, (8) Implementieren eines genauen Verfolgungssystems an einer eingebetteten Plattform unter Verwendung einer kostengünstigen Hardware, (9) Fähigkeit, die Objektdetektionsgenauigkeit und Objektklassifikationsgenauigkeit durch Zurückführen von genauen Verfolgungsdaten zu verbessern, und (10) Fähigkeit, Objekte über Kameras in Echtzeit automatisch zu verfolgen. Diese und weitere Vorteile von verschiedenen Ausführungsbeispielen werden beim Lesen des Rests dieses Abschnitts ersichtlich.

- Der Deutlichkeit und Kürze halber werden bestimmte Aspekte von Komponenten oder Schritten von bestimmten Ausführungsbeispielen ohne übermäßiges Detail dargestellt, wenn ein solches Detail für den Fachmann auf dem Gebiet angesichts der Lehren hierin ersichtlich wäre und/oder wenn ein solches Detail ein Verständnis von relevanteren Aspekten der Ausführungsbeispiele verschleiern würde.

-

1 ist ein bildhaftes Diagramm eines Kamerasystems100 gemäß einem Ausführungsbeispiel. Das Kamerasystem100 umfasst Bilderfassungsvorrichtungen102 , eine Benutzerschnittstelle104 und eine entfernte Speicher/Verarbeitungseinheit106 (z. B. einen entfernten Server), die in einem Netzwerk108 miteinander verbunden sind. Das Netzwerk108 kann einen beliebigen Typ von verdrahtetem oder drahtlosem Netzwerk umfassen. Obwohl das Kamerasystem100 von1 mehrere Bilderfassungsvorrichtungen102 umfasst, die in einem Netzwerk verbunden sind, kann das Kamerasystem100 eine einzelne Bilderfassungsvorrichtung102 umfassen. Die Bilderfassungsvorrichtungen102 können ein internes Speichersystem110 mit einem Festplattenlaufwerk (HD)111 und einer Metadaten-Datenbank (DB)112 umfassen. Die Bilderfassungsvorrichtungen102 können beispielsweise ein Speichersystem umfassen, das in der im gemeinsamen Besitz stehenden US-Patentanmeldung Nrn. 12/105 971 und 12/105 893 mit dem Titel ”Content Aware Storage of Video Data” bzw. ”Extending the Operational Lifetime of a Hard-Disk Drive Used in Video Data Storage Applications” beschrieben ist, die beide durch den Hinweis in ihren Gesamtheiten hierin aufgenommen werden. Die Benutzerschnittstelle104 umfasst eine Anzeige114 und eine Eingabevorrichtung116 . Die Bilderfassungsvorrichtungen102 erfassen Bilder von ihrem jeweiligen Blickfeld und erzeugen Bilddaten, die die Bilder darstellen. Es soll selbstverständlich sein, dass Bilder sich auf Standbilder oder Bewegungsvideobilder beziehen können. Die Bilddaten werden über das Netzwerk108 zur Benutzerschnittstelle104 übertragen und Bilder von einem oder mehreren der Blickfelder werden auf der Anzeige114 dargestellt. Die Eingabevorrichtung116 ist betriebsfähig, um einem Benutzer zu ermöglichen, Benutzerrückmeldungsinformationen für das Kamerasystem100 bereitzustellen. Die Bilddaten können auch über das Netzwerk108 zur entfernten Speicher/Verarbeitungseinheit106 übertragen werden. -

2 ist ein vereinfachtes Blockdiagramm von einer der Bilderfassungsvorrichtungen102 . Die Bilderfassungsvorrichtung102 kann eine Videokamera mit hoher Auflösung wie z. B. eine Megapixel-Videokamera sein. Die Bilderfassungsvorrichtung102 kann auch Daten von außerhalb des sichtbaren Spektrums (z. B. Wärmeenergie) erfassen. Zusätzlich zum Speichersystem110 umfasst die Bilderfassungsvorrichtung102 eine Bildverarbeitungseinheit, die ein Videoanalysemodul200 zum Analysieren von Bildern, die durch die Bilderfassungsvorrichtung102 erfasst werden, umfasst. Die Bildverarbeitungseinheit muss nicht in einem Gehäuse202 der Bilderfassungsvorrichtung102 enthalten sein, wie in2 dargestellt. Überdies kann die entfernte Speicher/Verarbeitungseinheit106 auch eine Bildverarbeitungseinheit umfassen. - Das Videoanalysemodul

200 umfasst eine Anzahl von Modulen zum Durchführen von verschiedenen Aufgaben. Das Videoanalysemodul200 umfasst beispielsweise ein Objektdetektionsmodul204 zum Detektieren von Objekten, die im Blickfeld der Bilderfassungsvorrichtung102 erscheinen. Das Objektdetektionsmodul204 kann ein beliebiges bekanntes Objektdetektionsverfahren wie beispielsweise eine Bewegungsdetektion oder Fleckdetektion verwenden. Das Objektdetektionsmodul204 kann die Systeme umfassen und die Detektionsverfahren verwenden, die in der im gemeinsamen Besitz stehenden US-Patentanmeldung Nr. 10/884 486 mit dem Titel ”Methods and Systems for Detecting Objects of Interest in Spatio-Temporal Signals” beschrieben sind, deren gesamter Inhalt durch den Hinweis hierin aufgenommen wird. - Das Videoanalysemodul

200 umfasst auch ein Objektverfolgungsmodul206 , das mit dem Objektdetektionsmodul204 verbunden ist. Wie hierin verwendet, bedeutet der Begriff ”verbunden” direkt oder indirekt über eine oder mehrere Vermittler logisch oder physikalisch verbunden. Das Objektverfolgungsmodul206 ist betriebsfähig, um Fälle eines durch das Objektdetektionsmodul204 detektierten Objekts zeitlich zuzuordnen. Das Objektverfolgungsmodul206 erzeugt Metadaten entsprechend Objekten, die es verfolgt. Die Metadaten können Signaturen des Objekts entsprechen, die das Aussehen oder andere Merkmale des Objekts darstellen. Die Metadaten können zur Metadaten-Datenbank112 zur Speicherung übertragen werden. Das Objektverfolgungsmodul206 wird nachstehend genauer beschrieben. - Das Videoanalysemodul

200 umfasst auch ein zeitliches Objektklassifikationsmodul208 . Das zeitliche Objektklassifikationsmodul208 ist betriebsfähig, um ein Objekt gemäß seinem Typ (z. B. Mensch, Fahrzeug, Tier) durch Betrachten des Aussehens des Objekts über die Zeit zu klassifizieren. Mit anderen Worten, das Objektverfolgungsmodul206 verfolgt ein Objekt für mehrere Einzelbilder (d. h. mehrere Bilder) und das zeitliche Objektklassifikationsmodul208 bestimmt den Typ des Objekts auf der Basis seines Aussehens in den mehreren Einzelbildern. Das zeitliche Objektklassifikationsmodul208 kann Informationen hinsichtlich der Bahn eines Objekts (z. B. ob die Bahn glatt oder chaotisch ist, ob sich das Objekt bewegt oder bewegungslos ist) und das Vertrauen von Klassifikationen, die durch ein Objektklassifikationsmodul210 durchgeführt werden, die über mehrere Einzelbilder gemittelt werden, kombinieren. Klassifikationsvertrauenswerte, die durch das Objektklassifikationsmodul210 bestimmt werden, können beispielsweise auf der Basis der Gleichmäßigkeit der Bahn des Objekts eingestellt werden. Das zeitliche Objektklassifikationsmodul208 kann ein Objekt einer unbekannten Klasse zuweisen, bis das Objekt durch das Objektklassifikationsmodul eine ausreichende Anzahl von Malen klassifiziert wird und eine vorbestimmte Anzahl von Statistiken erhoben wurde. Beim Klassifizieren eines Objekts kann das zeitliche Objektklassifikationsmodul208 auch berücksichtigen, wie lange das Objekt im Blickfeld war. Das zeitliche Objektklassifikationsmodul208 kann eine Endbestimmung über die Klasse eines Objekts auf der Basis der vorstehend beschriebenen Informationen durchführen. Das zeitliche Objektklassifikationsmodul208 kann auch eine Hysteresemethode zum Ändern der Klasse eines Objekts verwenden. Beispielsweise kann ein Schwellenwert für den Übergang der Klassifikation eines Objekts von unbekannt zu einem Menschen festgelegt werden und dieser Schwellenwert kann größer sein als ein Schwellenwert für den entgegengesetzten Übergang (z. B. von einem Menschen zu unbekannt). Das zeitliche Objektklassifikationsmodul208 kann Metadaten in Bezug auf die Klasse eines Objekts erzeugen und die Metadaten können in der Metadaten-Datenbank112 gespeichert werden. - Das Videoanalysemodul

200 umfasst auch das Objektklassifikationsmodul210 , das mit dem Objektdetektionsmodul204 verbunden ist. Im Gegensatz zum zeitlichen Objektklassifikationsmodul208 bestimmt das Objektklassifikationsmodul210 den Typ eines Objekts auf der Basis eines einzelnen Falls (d. h. eines einzelnen Bildes) des Objekts. Das Objektklassifikationsmodul kann die Systeme umfassen und die Verfahren verwenden, die in der im gemeinsamen Besitz stehenden US-Patentanmeldung Nr. _/_,_ (Anwaltsregisternr. 37686/8:2) mit dem Titel ”Dynamic Object Classification” beschrieben sind, deren gesamter Inhalt durch den Hinweis hierin aufgenommen wird. Das zeitliche Objektklassifikationsmodul208 kann die vom Objektklassifikationsmodul210 durchgeführten Klassifikationen zusammenfassen. - Das Videoanalysemodul

200 umfasst auch ein Objektindizierungsmodul212 , das mit dem Speichersystem110 verbunden ist. Das Objektindizierungsmodul212 ist betriebsfähig, um Signaturen für Objekte zu erzeugen. Die Signaturen können in der Metadaten-Datenbank112 gespeichert werden und können als Indexelemente für Videobilder der Objekte wirken. Das Objektindizierungsmodul212 wird nachstehend genauer beschrieben. - Das Videoanalysemodul

200 umfasst auch ein Objektsuchmodul214 , das mit dem Speichersystem110 und der Benutzerschnittstelle104 verbunden ist. Das Objektsuchmodul214 ist betriebsfähig, um Signaturen zu durchsuchen, die im Speichersystem110 gespeichert sind, um zu identifizieren, ob ein Objekt in vorher erfassten Bildern vorhanden war. Das Objektsuchmodul214 wird nachstehend genauer beschrieben. - Das Videoanalysemodul

200 umfasst auch ein Objektkategorisierungsmodul216 , das mit dem Objektklassifikationsmodul210 verbunden ist. Das Objektkategorisierungsmodul216 ist betriebsfähig, um die Verfolgung zu priorisieren, wenn mehrere Objekte in einem Bild detektiert werden. Das Objektkategorisierungsmodul216 ist beispielsweise betriebsfähig, um Klassifikationsinformationen zu verwenden, die vom Objektklassifikationsmodul210 erzeugt werden, um eine Reihenfolge festzulegen, um zu versuchen, Objekte eines aktuellen Einzelbildes Objekten, die in vergangenen Einzelbildern detektiert wurden, zuzuordnen. Das Objektkategorisierungsmodul216 wird nachstehend genauer beschrieben. - Daten, die vom Videoanalysemodul

200 erzeugt werden, können von einer Regelmaschine220 verwendet werden, um festzustellen, ob eine oder mehrere vom Benutzer festgelegte Regeln verletzt wurden oder nicht. Die Regelmaschine220 kann beispielsweise einen Alarm auslösen, der auf der Anzeige114 der Benutzerschnittstelle dargestellt wird, wenn ein Mensch im Blickfeld von einer der Bilderfassungsvorrichtungen102 detektiert wird. - Wie hierin verwendet, ist der Begriff ”Modul” eine Komponente, die ein oder mehrere Hardware-Schaltungen oder -vorrichtungen und/oder eine oder mehrere Softwareroutinen, Funktionen, ein Objekt oder dergleichen umfassen kann. Ein Modul kann vollständig Hardware, vollständig Software sein, Firmware umfassen oder eine gewisse Kombination der vorangehenden umfassen. Wie hierin verwendet, bezieht sich der Begriff ”System” auf eine materielle Sache.

- Übereinstimmungsklassifikator

- Das Videoanalysemodul

200 umfasst auch einen Übereinstimmungsklassifikator218 , der mit dem Objektverfolgungsmodul206 , dem Objektindizierungsmodul212 und dem Objektsuchmodul214 verbunden ist. Der Übereinstimmungsklassifikator218 ist betriebsfähig, um ein Eingangsmuster z zu empfangen, das Signaturen von zwei Objekten darstellt, und festzustellen, ob die Signaturen übereinstimmen (z. B. ob die Signaturen ausreichend ähnlich sind). Der Übereinstimmungsklassifikator218 kann vom Objektverfolgungsmodul206 , vom Objektindizierungsmodul212 und vom Objektsuchmodul214 verwendet werden, um die Module bei ihren verschiedenen Operationen zu unterstützen. Folglich kann ein einheitliches Gerüst zum Verfolgen, Indizieren und Suchen über den Übereinstimmungsklassifikator218 erreicht werden. - Der Übereinstimmungsklassifikator

218 ist betriebsfähig, um Objekte auf der Basis der Signaturen (z. B. Merkmale oder Aussehenseigenschaften) der Objekte zu vergleichen. Der Übereinstimmungsklassifikator218 empfängt beispielsweise Daten (d. h. das Eingangsmuster z) in Bezug auf die Signaturen von zwei Objekten, die in verschiedenen Einzelbildern erfasst sind, und stellt fest, ob die Objekte demselben physikalischen Objekt entsprechen. - Eine Signatur eines Objekts kann aus einer Teilmenge von Merkmalen

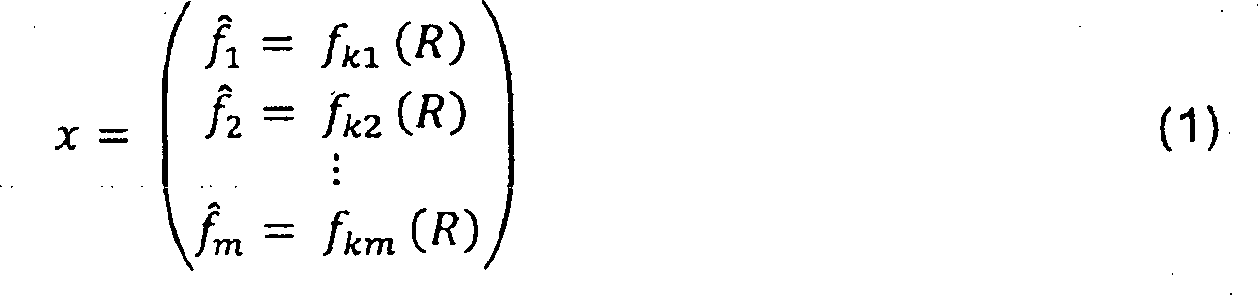

F ^ = {fk1, fk2, ..., fkm} - Die Merkmale

f ^1, f ^2, ..., f ^m 218 mit sowohl Farb- als auch Schwarz-Weiß-Bildern arbeitet. Ein Bild eines Objekts kann in Bereiche oder Unterfenster unterteilt werden und die Merkmalef ^1, f ^2, ..., f ^m f ^1, f ^2, ..., f ^m 218 verwendet werden, um festzustellen, ob Objekte übereinstimmen oder nicht. Histogramme der Kantenorientierungen eines Objekts können beispielsweise für verschiedene Bereiche (z. B. Unterfenster) des Bildes des Objekts konstruiert werden. Mit anderen Worten, ein Bild eines Objekts kann in Unterfenster unterteilt werden und Kantenorientierungen können für jedes Pixel der Unterfenster berechnet werden. Die Kantenorientierung eines Pixels kann unter Verwendung eines steuerbaren Filters (z. B. unter Verwendung eines Gauß-Ableitungsfilters in mehreren Richtungen) abgeleitet werden. Ein Bild kann beispielsweise mit einer ersten Ableitung einer Gauß-Verteilung, die in null und 90 Grad orientiert ist, gefaltet werden, die als Basisfilter verwendet werden können, um zahlreiche Orientierungen zu synthetisieren. Gauß-Ableitungsantworten können in acht Orientierungen für jedes Pixel berechnet werden und für jedes Pixel kann die Orientierung mit der maximalen Antwort als Richtung für das Pixel gewählt werden. Die Verwendung eines steuerbaren Filters ermöglicht, dass dominante Richtungen den Pixeln eines Unterfensters zugewiesen werden, und ermöglicht, dass ein Histogramm der Richtungen für das Unterfenster konstruiert wird. Für ein gegebenes Pixel kann beispielsweise ein steuerbares Filter in mehreren Richtungen verwendet werden, um mehrere Antworten zu erzeugen, und die Richtung, die der maximalen Richtungsableitungsantwort entspricht, wird als Richtung des Pixels zugewiesen. Eine Signatur x eines Objekts kann die Eindeutigkeit des Objekts erfassen, während sie Aussehensvariationen unter verschiedenen Fällen des Objekts ermöglicht. Obwohl es nicht erforderlich ist, kann eine Signatur eines Objekts mit der für das Kamerasystem100 erhältlichen maximalen Auflösung berechnet werden und kann durch eine nachträgliche Abwärtsabtastung oder Kompression nicht beeinflusst werden. -

3 ist ein Blockdiagramm, das ein Verfahren300 zeigt, das verwendet werden kann, um eine Eingabe z für den Übereinstimmungsklassifikator218 auf der Basis einer Signatur x von einem ersten Objekt und einer Signatur y von einem zweiten Objekt zu erzeugen. Im Allgemeinen werden die Signaturen x und y vom ersten und vom zweiten Objekt kombiniert, um die Eingabe z zu bilden (Schritt302 ). Das Merkmalf ^1 f ^1 f ^1 f ^1 218 geliefert und der Übereinstimmungsklassifikator218 trifft eine Entscheidung hinsichtlich dessen, ob das erste und das zweite Objekt übereinstimmen. Wie nachstehend beschrieben, kann ein Trainingsprozess automatisch die besten Merkmale der Signaturen x und y zusammen mit der besten Kombination oder dem besten Abstandsmaß wählen, um ein hohes Niveau an Genauigkeit beim Vergleich von Objekten zu erreichen. Die Ausgabe des Übereinstimmungsklassifikators218 kann einem Entscheidungsschrittwert s(z) entsprechen, wie nachstehend beschrieben. Der Entscheidungsschrittwert s(z) kann angeben, ob das erste und das zweite Objekt übereinstimmen, und kann einen Wert umfassen, der einem Vertrauensniveau in seiner Entscheidung entspricht. - Der Übereinstimmungsklassifikator

218 kann durch ein Klassifikationsproblem dargestellt werden, das im Allgemeinen durch eine Klassifikatorfunktion Γ(z) definiert ist, wobei zwei Objekte, die durch das Eingangsmuster z dargestellt sind, als Übereinstimmung deklariert werden, wenn Γ(z) > 0, oder als Nicht-Übereinstimmung, wenn Γ(z) < 0. Im Allgemeinen wird die Klassifikatorfunktion Γ(z) mit einem Satz von Parametern parametrisiert und die Eingabe z besteht aus einer Kombination der vorstehend beschriebenen Merkmale. Die Größe der Ausgabe der Klassifikatorfunktion kann das Vertrauensniveau des Übereinstimmungsklassifikators218 in seiner Entscheidung widerspiegeln. Dieses Vertrauensniveau kann ein Maß der Ähnlichkeit (oder Unähnlichkeit) bilden. - Ein Ausführungsbeispiel der Struktur des Übereinstimmungsklassifikators

218 wird nun mit Bezug auf4 –6 genauer beschrieben. Der Übereinstimmungsklassifikator218 umfasst mehrere Schritte400 (N Entscheidungsschritte), die in einer Kaskadenkonfiguration konfiguriert sind (d. h. Schritt 1, gefolgt von Schritt 2, gefolgt von Schritt 3, ..., gefolgt von Schritt N), wie in4 gezeigt. Die N Schritte arbeiten zum Feststellen, ob zwei Signaturen übereinstimmen oder nicht. Im Gegensatz zu einem bekannten Kaskadenklassifikationssystem, das in Paul Viola & Michael Jones, "Robust Real-Time Face Detection", International Journal of Computer Vision, S. 137–154 (2004), vorgeschlagen ist, ist jeder der anfänglichen N – 1 Schritte des vorliegenden Ausführungsbeispiels betriebsfähig, um eine von drei Entscheidungen zu treffen: (1) Annehmen von zwei Objekten als Übereinstimmung, (2) Ablehnen der Objekte als Übereinstimmung (d. h. Deklarieren als Nicht-Übereinstimmung) und (3) Weiterleiten der Entscheidung zum nächsten Schritt. Die Eingabe z wird beispielsweise zu Schritt 1 geliefert und Schritt 1 entscheidet, ob (1) die Objekte als Übereinstimmung angenommen werden sollen, (2) die Objekte als Übereinstimmung abgelehnt werden sollen, oder (3) die Entscheidung zu Schritt 2 weitergeleitet werden soll. Die Entscheidung zum Annehmen, Ablehnen oder Weiterleiten basiert auf einem durch den Schritt erzeugten Wert (d. h. dem Entscheidungsschrittwert s(z)). Der letzte oder N-te Schritt ist betriebsfähig, um entweder (1) die Objekte als Übereinstimmung anzunehmen oder (2) die Objekte als Übereinstimmung abzulehnen. -

5A ist ein Blockdiagramm, das einen der anfänglichen N – 1 Schritte400 genauer zeigt. Jeder Schritt400 umfasst eine oder mehrere Stufen500 . Für jede der Stufen500 wird eine Kombination (z. B. ein Abstandsmaß oder eine Verkettung) von einem der Merkmalef ^1, f ^2, ..., f ^m f ^1, f ^2, ..., f ^m 502 dargestellt) und zu ihrer entsprechenden Stufe500 geliefert. Eine Kombination des Merkmalsf ^1 f ^1 500 geliefert werden. Jede Stufe500 weist daher eine entsprechende Merkmalskombination auf, die ihr zugeordnet ist. Die Stufen/Merkmals-Kombination kann durch einen Lernalgorithmus während eines Trainingsprozesses vorbestimmt werden, wie nachstehend beschrieben. Überdies kann eine zur ersten Stufe (Stufe 1) von5 gelieferte Merkmalskombination beispielsweise verschieden sein von oder dieselbe sein wie die zur zweiten Stufe (Stufe 2) gelieferte Merkmalskombination. - Im Allgemeinen kann eine Stufe

500 durch eine Stufenfunktion g dargestellt werden, die folgendermaßen definiert ist:g:(x, y) → γ g ∊ G (x, y) ∊ z und γ ∊ [–1, 1] (2) 500 geliefert wird, als Abstandsmaß d betrachtet werden. Der Satz G kann daher als G = D × T geschrieben werden, wobei D ein Satz aller möglichen Abstandsmaße ist, die in Schritt302 von3 berechnet werden (z. B. d ∊ D, d: (x, y) → z) und T einen Satz von möglichen Transformationen (d. h. Abbildungen) darstellt, so dass für t ∊ T, t:z → γ. Folglich kann die Stufenfunktion g die folgende erweiterte Form annehmen:gi(f ^ x / k, f ^ y / k) = t(d(f ^ x / k, f ^ y / k)) (3) - Eine Stufe

500 stellt eine Diskriminantenfunktion dar, die einen Gewichtsvektor w ⇀ und eine Aktivierungsfunktion β umfasst. Wie vorstehend angegeben, können die Merkmalef ^1, f ^2, ..., f ^m gi(d ⇀k) = βi(w ⇀i·d ⇀k) (4) w ⇀i·d ⇀k d ⇀k d ⇀k w ⇀i 500 während des Trainings automatisch bestimmt, wie nachstehend beschrieben. - Jeder Schritt

400 ist eine lineare Kombination (durch den Skalierungs- und Summierblock502 dargestellt) von einer oder mehreren der Stufen500 . Mit anderen Worten, die Skalarwerte γ der Stufen500 werden skaliert und summiert, um den Entscheidungsschrittwert s(z) zu erzeugen. Im Allgemeinen kann diese Funktion mathematisch wie folgt dargestellt werden: - Da s(z) (d. h. der Entscheidungsschrittwert) eine konvexe Kombination von Stufen ist, weisen s(z) und g(x, y) denselben Bereich auf. Gewichtungskoeffizienten α werden durch einen Lernalgorithmus während des Trainings gewählt. Der Entscheidungsschrittwert wird mit einem oder beiden eines Annahmeschwellenwerts τa und eines Ablehnungsschwellenwerts τr verglichen (durch den Block

506 dargestellt), um festzustellen, ob zwei Objekte übereinstimmen, die Objekte als Übereinstimmung abgelehnt werden sollen oder die Entscheidung zum nächsten Schritt400 weitergeleitet werden soll. Der Vergleich kann folgendermaßen dargestellt werden:Annehmen, wenn τa < s(z) ≤ 1 Weiterleiten, wenn τr < s(z) ≤ τa Ablehnen, wenn –1 < s(z) ≤ τr (6) -

5B stellt ein Beispiel des Annahme- und des Ablehnungsschwellenwerts im Intervall [–1, +1] dar. Der Annahmeschwellenwert τa und der Ablehnungsschwellenwert τr werden während des Trainings durch einen Lernalgorithmus auf der Basis von benutzerspezifischen falsch positiven und falsch negativen Raten gewählt. Jeder Schritt400 kann Werte für τa und τr aufweisen, die verschieden sind von oder dieselben sind wie die anderen Schritte400 . Eine Entscheidung zum ”Annehmen” impliziert, dass der Klassifikator zuversichtlich ist, dass zwei Objekte übereinstimmen. Eine Entscheidung zum ”Weiterleiten” impliziert, dass der Klassifikator unsicher ist und die Entscheidung zum nächsten Schritt verschiebt. Eine Entscheidung zum ”Ablehnen” impliziert, dass der Klassifikator zuversichtlich ist, dass zwei Objekte nicht übereinstimmen. In irgendeinem Schritt wird, wenn die Entscheidung nicht darin besteht, zum nächsten Schritt400 ”weiterzuleiten”, die Annahme/Ablehnungs-Entscheidung an diesem Punkt getroffen und die Auswertung ist vollständig. Der Entscheidungsschrittwert s(z) in diesem Schritt ist der Ausgangswert für den Übereinstimmungsklassifikator218 . Der Entscheidungsschrittwert kann einem Entscheidungsvertrauensniveau für den entsprechenden Schritt400 entsprechen. Ein Entscheidungsschrittwert nahe eins kann beispielsweise darstellen, dass der entsprechende Schritt400 zuversichtlicher ist, dass zwei Objekte übereinstimmen, im Vergleich zu einem Entscheidungsschrittwert, der geringfügig über dem Annahmeschwellenwert τa liegt. Alternativ kann eine Erhöhung des Entscheidungsschrittwerts nicht notwendigerweise einem höheren Entscheidungsvertrauensniveau entsprechen (d. h. eine Wahrscheinlichkeit, dass die Entscheidung korrekt war). Das Vertrauensniveau, das jedem Entscheidungsschrittwert zugeordnet ist, kann während des Trainings empirisch abgeschätzt werden, wenn Objekte mit verschiedenen Entscheidungsschrittwerten korrekt und falsch verglichen werden. Die Vertrauensniveaus der Entscheidungsschrittwerte werden nachstehend genauer beschrieben. Wie vorstehend angegeben, wird die Endstufe (Stufe N) im Übereinstimmungsklassifikator218 dazu gezwungen, immer anzunehmen oder abzulehnen:Annehmen, wenn 0 < s(z) ≤ 1 Ablehnen, wenn –1 < s(z) ≤ 0 (7) -

6 ist ein Ablaufplan, der einen Operationsablauf600 des Übereinstimmungsklassifikators218 als Beispiel darstellt. Zuerst werden die Signaturen eines ersten und eines zweiten Objekts kombiniert (Schritt602 ). Das erste und das zweite Objekt können demselben physikalischen Objekt entsprechen. Schritt602 korreliert mit Schritt302 von3 . Die Eingabe z wird zum ersten Schritt400 des Übereinstimmungsklassifikators218 übertragen (Schritt604 ). Die kombinierten Merkmale (z. B. die Abstandsmaße), die der ersten bis S-ten Stufe500 entsprechen, werden in der Eingabe z identifiziert und aus dieser gewählt (Schritt606 ). Alternativ können anstelle der Übertragung der Eingabe z zum ersten Schritt400 die kombinierten Merkmale, die von den Stufen500 des ersten Schritts400 verwendet werden, ausgewählt werden und nur diese kombinierten Merkmale können zum ersten Schritt400 übertragen werden. Die kombinierten Merkmale werden zu ihren jeweiligen Stufen500 geliefert und die Stufen500 bilden die kombinierten Merkmale auf Skalarwerte γ ab (Schritt608 ). Die Skalarwerte werden skaliert (d. h. gewichtet) und summiert, um einen Entscheidungsschrittwert s(z) zu erzeugen (Schritt610 ). Der Entscheidungsschrittwert wird mit einem oder mehreren des Annahmeschwellenwerts τa und des Ablehnungsschwellenwerts τr verglichen (Schritt612 ). Wenn der Entscheidungsschrittwert größer ist als der Annahmeschwellenwert τa, werden das erste und das zweite Objekt als Übereinstimmung angenommen (Schritt614 ). Wenn der Entscheidungsschrittwert geringer als oder gleich dem Ablehnungsschwellenwert τr ist, werden das erste und das zweite Objekt als Übereinstimmung abgelehnt (Schritt616 ). Wenn der Entscheidungsschrittwert größer ist als der Ablehnungsschwellenwert τr, aber geringer als oder gleich dem Annahmeschwellenwert τa ist, wird die Eingabe z zum zweiten Schritt400 weitergeleitet (oder als Alternative werden nur diejenigen Merkmalskombinationen, die vom zweiten Schritt400 verwendet werden, zum zweiten Schritt400 übertragen) (Schritt618 ). Das erste und das zweite Objekt können in irgendeinem Schritt400 innerhalb der Kaskade als Übereinstimmung angenommen oder abgelehnt werden. - Training des Übereinstimmungsklassifikators

- Ein Verfahren zum Trainieren des Übereinstimmungsklassifikators

218 wird nun beschrieben. Herkömmliche Klassifikatoren können mit dem Lernalgorithmus AdaBoost oder einer gewissen Variante von AdaBoost trainiert werden. Obwohl AdaBoost in einigen Anwendungen seinen Wert bewiesen hat, haben der Algorithmus und die Zielfunktion, die in diesem Lernprozess verwendet wird, gewisse Begrenzungen. Damit AdaBoost wirksam ist, können beispielsweise Abstandsmaße von übereinstimmenden und nicht-übereinstimmenden Objekten einander nicht signifikant im Merkmalsraum überlappen. Mit anderen Worten, die Merkmale der Objekte sollten einen Klassifikationsraum gut trennen. Da AdaBoost schwache Lerner verwendet, kann überdies eine große Sammlung von schwachen Lernern erforderlich sein, um einen vollständigen Klassifikator zu bilden, der in der Lage ist, eine gewünschte Genauigkeit zu erreichen. - Gemäß einem Ausführungsbeispiel wird eine alternative Zielfunktion und ein Lernalgorithmus, der Sequentielle Diskriminantenfehlerminimierung (SDEM) genannt wird, verwendet, um den Übereinstimmungsklassifikator

218 zu trainieren. SDEM wurde in Saptharishi, "Sequential Discriminant Error Minimization: The Theory and its Application to Real-Time Video Object Recognition" (Carnegie Mellon University, 2005), vorgeschlagen, dessen gesamter Inhalt durch den Hinweis hierin aufgenommen wird. SDEM kann Merkmale oder Abstandsmaße behandeln, die einen Klassifikationsraum nicht notwendigerweise gut auftrennen. Im Gegensatz zu AdaBoost und anderen ähnlichen Unterstützungsverfahren kann SDEM schwache Lerner oder andere Diskriminantenfunktionen verwenden, die nicht notwendigerweise als schwach betrachtet werden. Folglich kann die Anzahl von Schritten400 und Stufen500 eines Objektklassifikators unter Verwendung von SDEM zum Training im Vergleich zu AdaBoost signifikant geringer sein. Für ein gegebenes Merkmal ist SDEM häufig in der Lage, den besten Klassifikator für den entsprechenden Merkmalsraum zu lernen. Die besten Merkmale von Objekten, Abstandsmaße und Transformationen können automatisch für ein gegebenes Klassifikationsproblem ausgewählt werden. - Im Allgemeinen wird der SDEM-Algorithmus verwendet, um die Kombination von Stufen

500 für jeden Schritt400 zu trainieren. Wie in Gleichung (3) definiert, umfasst eine Stufe500 eine Stufenfunktion gi(x, y), die gleich einer Transformation t eines Abstandsmaßes d von Merkmalenf ^ x / k f ^ y / k t(d(f ^ x / k, f ^ y / k)) f ^k 500 zu einem Schritt400 hinzugefügt wird, die Leistung des Objektklassifikators maximiert wird. Mit anderen Worten, der SDEM-Algorithmus wählt die Transformation t, das Abstandsmaß d und das Merkmalf ^k f ^k, f ^k, ∊^(g) g(f ^ x / k, f ^ y / k) = min∀(k,j)∀t∈T{∊ ^(t(dj(f ^ x / k, f ^ y / k)))} (8) - Wenn jede Stufe

500 zu einem Schritt400 hinzugefügt wird, kann es n eindeutige Merkmalstypen und b eindeutige Abstandsmaße geben. Folglich können insgesamt n × b Paare (f ^k, 500 hinzugefügt wird. Eine der Eigenschaften des SDEM-Algorithmus besteht darin, dass, wenn eine Stufe500 zu einem Schritt400 hinzugefügt wird, das Hinzufügen der Stufe500 die Leistung des Objektklassifikators an dem Trainingsdatensatz verbessert. Wenn eine neue Stufe nicht identifiziert werden kann, die die Leistung des Objektklassifikators verbessert, endet der SDEM-Algorithmus automatisch. Anstatt zu warten, bis der SDEM-Algorithmus automatisch endet, kann alternativ eine Anzahl von Stufen500 eines Schritts400 durch einen Benutzer bestimmt werden. Mit anderen Worten, der SDEM-Algorithmus beendet das Training, wenn eine maximale Anzahl von Stufen500 , die vom Benutzer festgelegt werden, erreicht ist oder wenn keine Stufe500 hinzugefügt werden kann, die die Leistung verbessert. - Der SDEM-Algorithmus wählt eine Reihe von Merkmalen, Abstandsmaßen und Transformationen derart aus, dass, wenn sie kombiniert werden, die Reihe ein einzelnes der Merkmale/Abstandsmaße/Transformationen übertrifft. Obwohl das Seitenverhältnis eines Objekts beispielsweise ein schlechtes Merkmal für die Verwendung zum Vergleich sein könnte, kann, wenn es mit lokalen Gradienteninformationen kombiniert wird, das Seitenverhältnis die Übereinstimmungsgenauigkeit, die den lokalen Gradienteninformationen allein entspricht, verbessern. Eine Anzahl von einfachen Merkmalen, Abstandsmaßen und Transformationen kann kombiniert werden, um einen sehr genauen Übereinstimmungsklassifikator

218 zu erzeugen. Die Trainingsaufgabe erzeugt Supermerkmale durch Kombinieren eines Satzes von Aussehensmerkmalen und Abstandsmaßen für zwei Objekte. - Die Trainingsaufgabe zum Aufbauen der Stufen

500 des ersten Schritts400 wird nun mit Bezug auf7 und8 genauer beschrieben. Die folgende Beschreibung ist auch auf die Stufen500 der anderen Schritte400 anwendbar.7 ist ein Blockdiagramm eines Verfahrens700 zum Erzeugen von Trainingsdaten. Eine Sequenz von Bildern von Objekten kann einem Benutzer zur Überprüfung hinsichtlich dessen, ob die Bilder demselben Objekt oder verschiedenen Objekten entsprechen, präsentiert werden. Zwei Bilder können beispielsweise dem Benutzer zur Überprüfung gleichzeitig präsentiert oder nacheinander präsentiert werden. Wenn die Bilder demselben Objekt entsprechen, wird ein Übereinstimmungsbeispiel erzeugt (Schritt702 ). Wenn die Bilder verschiedenen Objekten entsprechen, wird ein Nicht-Übereinstimmungs-Beispiel erzeugt (Schritt704 ). Abstandsmaße d1, d2, ..., dm werden für die Merkmale des Übereinstimmungs- und Nicht-Übereinstimmungs-Beispiels verwendet. Den Merkmalenf ^1,f ^2, ..., f ^k f ^1, f ^2, ..., f ^k f ^1 f ^1, f ^2, ..., f ^k f ^1 f ^1 f ^1 f ^1 f ^1, f ^2, ..., f ^k 218 zu trainieren (Schritt706 ). -

8 ist ein Ablaufplan eines Trainingsverfahrens800 , das verwendet werden kann, um den Übereinstimmungsklassifikator218 zu trainieren. Die Kombinationen von Merkmalenf ^1, f ^2, ..., f ^m 802 ) werden identifiziert und dem Abstandsmaß (z. B. d1, d2) zugeordnet, die verwendet wurden, um die Merkmale zu kombinieren (Schritte804a ,804b ,804c ). Für das Abstandsmaß d1 werden beispielsweise die Kombinationen des geeigneten Merkmals f ^, die unter Verwendung von d1 gebildet werden, identifiziert (Schritt804a ). - Nachdem die Merkmalskombinationen

802 , die den Abstandsmaßen d1, d2, ..., dm entsprechen, identifiziert sind, wird die beste Transformation t für jedes der Abstandsmaße d1, d2, ..., dm ausgewählt (Schritte806a ,806b und806c ). Da ein spezielles Merkmal f ^ jedem Abstandsmaß zugeordnet ist, wird die beste Transformation nicht nur für das Abstandsmaß, sondern auch für das Merkmal, das dem Abstandsmaß zugeordnet ist, ausgewählt. Die Transformationen können auf der Basis von Standard-Optimierungsverfahren ausgewählt werden. Eine Transformation t kann als Entscheidungsgrenze betrachtet werden, die die Merkmalskombinationen802 der Übereinstimmungs- und Nicht-Übereinstimmungs-Beispiele trennt. Folglich entspricht die beste Transformation t einer Entscheidungsgrenze, die die Übereinstimmungs- und Nicht-Übereinstimmungs-Beispiele für das entsprechende Merkmal f ^ und Abstandsmaß am besten trennt. Im Zusammenhang mit der Diskriminantenfunktion, die aus dem Gewichtsvektorw ⇀i w ⇀i, - Nachdem die Transformationen für die Abstandsmaße d1, d2, ..., dm ausgewählt sind, wird ein Wert einer Zielfunktion entsprechend jeder Abstandsmaß/Transformations-Kombination berechnet (Schritte

808a ,808b und808c ). Die Zielfunktion kann zu einem Maß von Fehlern proportional sein (z. B. Deklarieren einer Übereinstimmung als Nicht-Übereinstimmung oder umgekehrt) oder sie kann eine nicht-lineare, aber monoton veränderliche Funktion der Klassifikationsfehler sein. Die berechneten Werte der Zielfunktion können mit der Anzahl und/oder Schwere von Klassifikationsfehlern in Zusammenhang stehen, die von den verschiedenen Abstandsmaß/Transformations-Kombinationen gemacht werden. Ein erster berechneter Wert kann beispielsweise mit der Anzahl von Klassifikationsfehlern in Zusammenhang stehen, der vom Abstandsmaß d1 und seiner entsprechenden Transformation gemacht werden. Die berechneten Werte der Zielfunktion werden verglichen und die Abstandsmaß/Transformations-Kombination, die den maximalen berechneten Wert aufweist, wird für die erste Stufe500 des ersten Schritts400 ausgewählt (Schritt810 ). - Nachdem das Abstandsmaß (und sein zugehöriges Merkmal) und die Transformation für die erste Stufe

500 ausgewählt sind, werden die Merkmalskombinationen802 der verschiedenen Übereinstimmungs- und Nicht-Übereinstimmungs-Beispiele unter Berücksichtigung der von der ersten Stufe500 getroffenen Entscheidungen mit verschiedenen Gewichten gewichtet (Schritt812 ). Jede der Merkmalskombinationen802 der Übereinstimmungs- und Nicht-Übereinstimmungs-Beispiele kann man sich als Datenpunkten im Funktionsraum entsprechend vorstellen. Die Merkmalskombinationen802 der Übereinstimmungs- und Nicht-Übereinstimmungs-Beispiele können als Funktion dessen gewichtet werden, wie nahe ihre entsprechenden Datenpunkte an der durch die erste Stufe500 dargestellten Entscheidungsgrenze liegen. Die Merkmalskombinationen802 , die Datenpunkten nahe der Entscheidungsgrenze im Merkmalsraum entsprechen, können beispielsweise mit höheren Gewichten im Vergleich zu Merkmalskombinationen802 mit Datenpunkten, die von der Entscheidungsgrenze weit weg liegen, gewichtet werden, so dass eine zweite Stufe500 trainiert werden kann, indem man sich mehr auf diejenigen Merkmalskombinationen802 konzentriert, die die erste Stufe500 etwas verwirrt haben. Der Abstand zwischen einem Datenpunkt und der Entscheidungsgrenze der ersten Stufe500 kann mit dem Skalarwert γ in Beziehung stehen, der für das dem Datenpunkt entsprechende Beispiel berechnet wurde. - Nachdem die Merkmalskombinationen

802 der Beispiele gewichtet sind, werden die besten Transformationen wieder für die Abstandsmaße d1, d2, ..., dm ausgewählt (Schritte806a ,806b und806c werden wiederholt). Die Merkmalskombinationen802 , die den Abstandsmaßen d1, d2, ..., dm entsprechen, werden jedoch nun gewichtet und die beste Transformation t für jedes der Abstandsmaße d1, d2, ..., dm wird unter Berücksichtigung der ersten Stufe500 ausgewählt. Die beste Transformation t kann der Transformation entsprechen, die zur größten Erhöhung des Zielfunktionswerts führt. Die Werte der Zielfunktion werden wieder berechnet und verglichen, um das Abstandsmaß/die Transformation für die zweite Stufe500 zu bestimmen (Schritte808a ,808b ,808c und810 werden wiederholt). Um eine dritte Stufe500 aufzubauen, werden die Merkmalskombinationen802 der Übereinstimmungs- und Nicht-Übereinstimmungs-Beispiele erneut gewichtet, wobei den Beispielen, die für die erste und die zweite Stufe500 etwas verwirrend waren, höhere Gewichte gegeben werden. Wieder werden die Schritte806a ,806b und806c wiederholt, aber die Merkmalskombinationen802 , die den Abstandsmaßen d1, d2, ..., dm entsprechen, werden nun erneut gewichtet und die beste Transformation t für jedes der Abstandsmaße d1, d2, ..., dm wird unter Berücksichtigung der ersten und zweiten Stufe500 ausgewählt. Die Werte der Zielfunktion werden wieder berechnet und verglichen, um das Abstandsmaß/die Transformation für die dritte Stufe500 zu bestimmen (Schritte808a ,808b ,808c und810 werden wiederholt). Der Prozess des Auswählens des besten Abstandsmaßes, der besten Transformation und der Gewichtung der Merkmalskombinationen802 der Beispiele über jede Iteration des Trainings einer neuen Stufe kann sich als Gradientenanstieg im Funktionsraum oder als Prozess zum Erhöhen des Gesamtwerts der Zielfunktion vorgestellt werden. - Sobald der erste Schritt

400 trainiert ist, werden die Schwellenwerte τa und τr derart ausgewählt, dass gewünschte falsch positive und falsch negative Raten erreicht werden können. Wenn die Stufen500 für den ersten Schritt400 konstruiert werden, werden überdies die Gewichtungskoeffizienten α auch ausgewählt. Wenn jede Stufe500 zum ersten Schritt400 hinzugefügt wird, werden beispielsweise die Gewichtungskoeffizienten α für die Stufen eingestellt, um die Werte für die Gewichtungskoeffizienten α zu finden, die der niedrigsten Gesamtfehlerrate für den ersten Schritt400 entsprechen. Die Gewichtungskoeffizienten α können beispielsweise unter Verwendung einer Liniensuchoptimierungsstrategie ausgewählt werden. - Nachdem der erste Schritt

400 trainiert ist, können die Stufen500 eines zweiten Schritts400 trainiert werden. Weniger als alle der Übereinstimmungs- und Nicht-Übereinstimmungs-Beispiele, die zum Trainieren des ersten Schritts400 verwendet werden, können jedoch verwendet werden, um den zweiten Schritt400 zu trainieren. Beispielsweise können nur diejenigen Übereinstimmungs- und Nicht-Übereinstimmungs-Beispiele, die der erste Schritt400 weder annehmen noch ablehnen konnte, zum Trainieren des zweiten Schritts400 verwendet werden. Mit anderen Worten, der zweite Schritt400 wird mit den Beispielen trainiert, die einen entsprechenden Entscheidungsschrittwert hatten, der größer war als der Ablehnungsschwellenwert τr, aber geringer als oder gleich dem Annahmeschwellenwert τa war. Dies ermöglicht, dass sich der zweite Schritt400 nur auf diejenigen Beispiele konzentriert, die der erste Schritt400 verwirrend fand. - Sobald der Übereinstimmungsklassifikator

218 mit den Beispielen trainiert ist, kann der Übereinstimmungsklassifikator218 durch andere Trainingsschritte fortfahren, um die für die verschiedenen Stufen500 ausgewählten Abstandsmaße/Transformationen zu verfeinern. Eine Methode hoher Ebene für das Trainieren des Übereinstimmungsklassifikators218 ist im Ablaufplan von9 gezeigt, der ein Trainingsverfahren900 darstellt. Bilddaten901 (z. B. rohe Videodaten) werden zu einem einfachen Basis- oder Keimsystem geliefert, das zu einer Basisdetektion, -verfolgung und -klassifikation von Objekten in der Lage ist. Das Basissystem detektiert, verfolgt und klassifiziert Objekte, die in den Bilddaten901 dargestellt sind, und erzeugt Metadaten, die den Objekten entsprechen (Schritt902 ). Das Basissystem wählt einen Satz von Objekten aus, die detektiert und verfolgt werden (Schritt904 ). Die Auswahl der Objekte kann von der Menge an Zeit abhängen, die sich ein Objekt im Blickfeld einer Bilderfassungsvorrichtung102 befand, oder kann davon abhängen, wie zuversichtlich das Basissystem bei seiner Klassifikation eines Objekts war. Andere Regeln können festgelegt werden, um vorzugeben, ob ein Objekt durch das Basissystem ausgewählt wird oder nicht. - Bilder der Objekte, die vom Basissystem ausgewählt werden, werden einem Benutzer auf einer Anzeige präsentiert, so dass der Benutzer die Objekte als Übereinstimmungs- oder Nicht-Übereinstimmungs-Beispiele manuell bezeichnen kann. Der Benutzer bezeichnet die Objekte manuell und die bezeichneten Beispiele werden zum trainierten Übereinstimmungsklassifikator

218 geliefert (Schritt906 ). Merkmalskombinationen können für die bezeichneten Beispiele unter Verwendung der Abstandsmaße d1, d2, ..., dm berechnet werden. Die Merkmalskombinationen der manuell bezeichneten Beispiele können den vorstehend beschriebenen Merkmalskombinationen802 entsprechen. Der Übereinstimmungsklassifikator218 wird mit den Merkmalskombinationen802 trainiert, wie z. B. gemäß dem Trainingsverfahren800 , wie vorstehend mit Bezug auf8 beschrieben (Schritt800 ). Bilddaten901 werden zum Übereinstimmungsklassifikator218 geliefert. Der Übereinstimmungsklassifikator218 stellt fest, ob Objekte, die in den Bilddaten901 dargestellt sind, übereinstimmen oder nicht, und erzeugt Metadaten, die übereinstimmende und nicht-übereinstimmende Objekte darstellen (Schritt910 ). Jeder Übereinstimmung und Nicht-Übereinstimmung, die vom Übereinstimmungsklassifikator218 erzeugt wird, ist ein Übereinstimmungsvertrauensniveau zugeordnet. Das Übereinstimmungsvertrauensniveau entspricht dem Entscheidungsschrittwert des Schritts400 , der die Übereinstimmung oder Nicht-Übereinstimmung deklariert hat. Die durch den Übereinstimmungsklassifikator218 erzeugten Übereinstimmungsvertrauensniveaus werden analysiert, um Fälle von Objekten zu identifizieren, die für den Übereinstimmungsklassifikator218 verwirrend waren (z. B. Übereinstimmungen und Nicht-Übereinstimmungen mit niedrigen Übereinstimmungsvertrauensniveaus). Die Leistung des Übereinstimmungsklassifikators218 wird ausgewertet, um festzustellen, ob die Leistung des Übereinstimmungsklassifikators annehmbar ist (Schritt912 ). - Um festzustellen, ob die Leistung des Übereinstimmungsklassifikators annehmbar ist, kann ein zerlegter Testsatz verwendet werden, wobei Übereinstimmungen und Nicht-Übereinstimmungen des zerlegten Testsatzes vor der Klassifikation durch den Übereinstimmungsklassifikator

218 bekannt sind. Die Bilddaten901 , die zum Übereinstimmungsklassifikator218 geliefert werden, können dem zerlegten Testsatz entsprechen, und die durch den trainierten Objektklassifikator durchgeführten Klassifikationen können mit den tatsächlichen Übereinstimmungen und Nicht-Übereinstimmungen verglichen werden. Aus diesem Vergleich kann die Leistung des Übereinstimmungsklassifikators218 bestimmt werden. Wenn die Leistung nicht gleich der oder über irgendeinem vordefinierten Leistungsniveau liegt, werden die verwirrenden Objekte für den Benutzer für manuelle Bezeichnungen dargestellt (Schritt904 ). Der Benutzer bezeichnet die verwirrenden Objekte und die neuen bezeichneten Übereinstimmungen und Nicht-Übereinstimmungen werden verwendet, um den Übereinstimmungsklassifikator218 erneut zu trainieren (Schritte906 und908 ). Wenn der Übereinstimmungsklassifikator218 erneut trainiert wird, können die Abstandsmaß/Transformations-Kombinationen für die verschiedenen Stufen500 auf der Basis der neuen bezeichneten Beispiele aktualisiert werden. Der erneut trainierte Übereinstimmungsklassifikator wird verwendet, um Objekte zu klassifizieren, die in den Bilddaten901 dargestellt sind, und die Leistung des erneut trainierten Übereinstimmungsklassifikators wird ausgewertet (Schritte910 und912 ). Der Neutrainingsprozess kann fortfahren, bis die Leistung des Übereinstimmungsklassifikators218 annehmbar ist. Wenn die Leistung des Übereinstimmungsklassifikators218 annehmbar ist, kann er eingesetzt werden (Schritt914 ). Der Trainingsprozess kann in die folgenden Schritte umgestaltet werden: - 1. Manuelles Bezeichnen eines gewissen kleinen Bruchteils eines Datensatzes.

- 2. Trainieren eines Übereinstimmungsklassifikators

218 unter Verwendung des Bruchteils des Datensatzes. - 3. Verwenden eines neu trainierten Klassifikators, um den vollständigen Datensatz automatisch zu bezeichnen.

- 4. Auswählen eines Satzes von automatisch bezeichneten Datenpunkten, die für den Übereinstimmungsklassifikator

218 verwirrend waren. - 5. Manuelles Bezeichnen der verwirrenden Datenpunkte.

- 6. Wiederholen des Trainings mit allen neuen bezeichneten Datenpunkten.

- 7. Gehen zu Schritt 3.

- In Anbetracht der Architektur des Übereinstimmungsklassifikators

218 mit Schritten von Stufen kann ein neuer Schritt zum Übereinstimmungsklassifikator218 hinzugefügt werden. Dieser neue Schritt kann trainiert werden, um Fehler zu korrigieren, die vom Übereinstimmungsklassifikator218 gemacht wurden. Alternativ kann ein neuer Schritt trainiert werden, um den letzten oder N-ten Schritt des Übereinstimmungsklassifikators218 zu ersetzen. Nachdem der Übereinstimmungsklassifikator218 durch den vorstehend beschriebenen Prozess trainiert ist, kann der Übereinstimmungsklassifikator218 verschiedene Operationen durchführen, wie z. B. Verfolgen, Erzeugen von Indexelementen und Durchführen von Suchen auf Objektbasis (z. B. Aussehensbasis). Mit anderen Worten, der Übereinstimmungsklassifikator218 muss nicht separat für jede seiner verschiedenen Operationen trainiert werden. - Die Weise, in der der Übereinstimmungsklassifikator

218 arbeitet, um Objektfälle zu vergleichen, wurde zumindest teilweise durch einen Trainings- oder Selbstlernprozess bestimmt, der den Übereinstimmungsklassifikator218 automatisch unter Verwendung eines Satzes von möglichen Objektmerkmalen konfiguriert. Diese Konfiguration kann eine oder mehrere der folgenden Bestimmungen umfassen: (1) Auswählen, welche Merkmale aus dem Satz von möglichen Merkmalen verwendet werden sollen; (2) Bestimmen der Reihenfolge, in der die ausgewählten Merkmale ausgewertet werden; (3) Bestimmen, wie mehrere Merkmale kombiniert werden (d. h. die zum Kombinieren von mehreren Variablen verwendeten Gewichtungskoeffizienten); (4) Auswählen von Abstandsmaßen aus einem Satz von verfügbaren Abstandsmaßen (z. B. L2, Manhattan, Bhattacharyya). Weitere Aspekte des Übereinstimmungsklassifikators218 können während des Trainingsprozesses konfiguriert werden. Der Trainingsprozess kann offline vor dem Einsatz des Übereinstimmungsklassifikators218 und/oder online während des Online-Betriebs des Übereinstimmungsklassifikators218 stattfinden. - Übereinstimmungsvertrauen

- Der Entscheidungsschrittwert s(z) ist mit der Abschätzung des Übereinstimmungsklassifikators hinsichtlich dessen, wie ähnlich er denkt, dass zwei Objekte sind, korreliert (z. B. Übereinstimmungsvertrauen). Die Korrelation kann nicht linear sein, d. h. der Schritt

400 kann einen hohen positiven Wert erzeugen, aber die Objekte können nicht übereinstimmen. Durch den Trainingsprozess gilt typischerweise, je höher der Wert von s(z) ist, desto weniger wahrscheinlich hat Schritt400 einen Fehler gemacht. Das Vertrauensniveau, das einem bestimmten Wert von s(z) zugeordnet ist, kann berechnet werden, indem zuerst eine Indikatorfunktion ε(Γ(z)) definiert wird, in der gilt: - Eine Vertrauensfunktion Ψ(Γ(z)) kann als Wahrscheinlichkeit, dass der Schritt

400 zwei Fälle als Übereinstimmung deklariert hat und dass es für eine Ausgabe von s(z) = v korrekt war, definiert werden. Folglich kann für ein kleines Quantisierungsintervall [v – Δ, v + Δ] die Vertrauensfunktion folgendermaßen ausgedrückt werden:Ψ(Γ(z)) = Pε,Ω|Γ(ε(Γ(z)) = 0, ω = Übereinstimmung|s(z) < v + Δ) – Pε,Ω|Γ(ε(Γ(z)) = 0, ω = Übereinstimmung|s(z) < v – Δ) (10) - Es ist zu beachten, dass betrachtet werden kann, dass der Schritt

400 zwei Fälle als Übereinstimmung deklariert, wenn s(z) > 0, d. h. P.Ω|Γ(ω = Übereinstimmung|s(z) > 0) = 1. Für v > 0, kann folglich die Gleichung (10) ausgedrückt werden als:Ψ(Γ(z)) = Pε|Ω,Γ(ε(Γ(z)) = 0|ω = Übereinstimmung, 0 < s(z) ≤ v + Δ) – Pε|Ω,Γ(ε(Γ(z)) = 0|ω = Übereinstimmung, 0 < s(z) < v – Δ) (11) - Gleichung (11) stellt die wahre positive Rate dar, wenn v ∊ [Δ, 1 – Δ] und s(z) ∊ [v – Δ, v + Δ].

- Ebenso kann das Vertrauen eines Schritts

400 beim Deklarieren, dass das Objekt zur negativen Klasse für v ≤ –Δ gehört, ausgedrückt werden als:Ψ(Γ(z)) = Pε|Ω,Γ(ε(Γ(z)) = 0|ω = keine Übereinstimmung, v + Δ ≤ s(z) ≤ 0) – Pε|Ω,Γ(ε(Γ(z)) = 0|ω = keine Übereinstimmung, v – Δ < s(z) ≤ 0) (12) - Gleichung (12) stellt die wahre negative Rate dar, wenn v ∊ [–1 +Δ, –Δ] und s(z) ∊ [v – Δ, v + Δ]. Wenn die Wahrscheinlichkeit (wie in Gleichungen (11) und (12) definiert), dass der Schritt

400 für irgendeinen beobachteten Ausgangswert s(z) = v korrekt ist, hoch ist, dann wird folglich Schritt400 als in seiner Antwort vertrauenswürdig betrachtet. Für diese Selbstbewertung des Vertrauens wird ein Wahrscheinlichkeitsmaßp ^ε|Ω,Γ 400 für diesen Ausgangswert als unsicher oder verwirrt betrachtet. Unsichere Klassifikationen werden zum nächsten Schritt400 weitergeleitet. Somit kann die Vertrauensfunktion Ψ(Γ(z)) während des Trainings verwendet werden, um die Objekte, die für einen Übereinstimmungsklassifikator218 verwirrend sind, zu identifizierten. Wenn Diskriminantenfunktionen, die die Stufen500 bilden, eine gute Näherung für die optimale Bayes-Entscheidungsgrenze sind, dann steht der Entscheidungsschrittwert s(z) monoton mit der Vertrauensfunktion Ψ(Γ(z)) in Beziehung. Für die anfänglichen Schritte400 kann der Objektklassifikator sich nicht gut der Bayes-Entscheidungsgrenze nähern. Folglich können der Entscheidungsschrittwert s(u) für einen gegebenen Schritt400 und die Vertrauensfunktion Ψ(Γ(z)) nicht immer monoton in Beziehung stehen. - Die Vertrauensfunktion Ψ(Γ(z)) kann verwendet werden, um den Annahmeschwellenwert τa und den Ablehnungsschwellenwert τr für die verschiedenen Schritte