JP2010533006A - System and method for communicating with a virtual world - Google Patents

System and method for communicating with a virtual world Download PDFInfo

- Publication number

- JP2010533006A JP2010533006A JP2009551806A JP2009551806A JP2010533006A JP 2010533006 A JP2010533006 A JP 2010533006A JP 2009551806 A JP2009551806 A JP 2009551806A JP 2009551806 A JP2009551806 A JP 2009551806A JP 2010533006 A JP2010533006 A JP 2010533006A

- Authority

- JP

- Japan

- Prior art keywords

- user

- communication device

- real

- communication

- virtual world

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

Images

Classifications

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

-

- A63F13/12—

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/30—Interconnection arrangements between game servers and game devices; Interconnection arrangements between game devices; Interconnection arrangements between game servers

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06Q—INFORMATION AND COMMUNICATION TECHNOLOGY [ICT] SPECIALLY ADAPTED FOR ADMINISTRATIVE, COMMERCIAL, FINANCIAL, MANAGERIAL OR SUPERVISORY PURPOSES; SYSTEMS OR METHODS SPECIALLY ADAPTED FOR ADMINISTRATIVE, COMMERCIAL, FINANCIAL, MANAGERIAL OR SUPERVISORY PURPOSES, NOT OTHERWISE PROVIDED FOR

- G06Q30/00—Commerce

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04L—TRANSMISSION OF DIGITAL INFORMATION, e.g. TELEGRAPHIC COMMUNICATION

- H04L67/00—Network arrangements or protocols for supporting network services or applications

- H04L67/01—Protocols

- H04L67/131—Protocols for games, networked simulations or virtual reality

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/20—Input arrangements for video game devices

- A63F13/23—Input arrangements for video game devices for interfacing with the game device, e.g. specific interfaces between game controller and console

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/60—Generating or modifying game content before or while executing the game program, e.g. authoring tools specially adapted for game development or game-integrated level editor

- A63F13/61—Generating or modifying game content before or while executing the game program, e.g. authoring tools specially adapted for game development or game-integrated level editor using advertising information

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/70—Game security or game management aspects

- A63F13/79—Game security or game management aspects involving player-related data, e.g. identities, accounts, preferences or play histories

- A63F13/795—Game security or game management aspects involving player-related data, e.g. identities, accounts, preferences or play histories for finding other players; for building a team; for providing a buddy list

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F2300/00—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game

- A63F2300/10—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game characterized by input arrangements for converting player-generated signals into game device control signals

- A63F2300/105—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game characterized by input arrangements for converting player-generated signals into game device control signals using inertial sensors, e.g. accelerometers, gyroscopes

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F2300/00—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game

- A63F2300/10—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game characterized by input arrangements for converting player-generated signals into game device control signals

- A63F2300/1081—Input via voice recognition

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F2300/00—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game

- A63F2300/10—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game characterized by input arrangements for converting player-generated signals into game device control signals

- A63F2300/1087—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game characterized by input arrangements for converting player-generated signals into game device control signals comprising photodetecting means, e.g. a camera

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F2300/00—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game

- A63F2300/30—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game characterized by output arrangements for receiving control signals generated by the game device

- A63F2300/308—Details of the user interface

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F2300/00—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game

- A63F2300/40—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game characterised by details of platform network

- A63F2300/406—Transmission via wireless network, e.g. pager or GSM

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F2300/00—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game

- A63F2300/40—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game characterised by details of platform network

- A63F2300/407—Data transfer via internet

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F2300/00—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game

- A63F2300/50—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game characterized by details of game servers

- A63F2300/55—Details of game data or player data management

- A63F2300/5506—Details of game data or player data management using advertisements

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F2300/00—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game

- A63F2300/60—Methods for processing data by generating or executing the game program

- A63F2300/6063—Methods for processing data by generating or executing the game program for sound processing

- A63F2300/6072—Methods for processing data by generating or executing the game program for sound processing of an input signal, e.g. pitch and rhythm extraction, voice recognition

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F2300/00—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game

- A63F2300/80—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game specially adapted for executing a specific type of game

- A63F2300/807—Role playing or strategy games

Landscapes

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Computer Networks & Wireless Communication (AREA)

- Signal Processing (AREA)

- Business, Economics & Management (AREA)

- Strategic Management (AREA)

- General Business, Economics & Management (AREA)

- Economics (AREA)

- Finance (AREA)

- Marketing (AREA)

- Accounting & Taxation (AREA)

- Physics & Mathematics (AREA)

- Development Economics (AREA)

- General Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- Processing Or Creating Images (AREA)

- Information Transfer Between Computers (AREA)

- User Interface Of Digital Computer (AREA)

- Position Input By Displaying (AREA)

- Storage Device Security (AREA)

- Telephonic Communication Services (AREA)

Abstract

仮想世界と通信するためのシステムおよび方法が開示されている。仮想世界はシミュレートされた公共空間と、シミュレートされたひとつ以上の私的空間と、を含んでもよい。各私的空間は、ある特定のユーザに関連付けられてもよい。ユーザの仮想世界とのやりとりは、アバターのひとつ以上の動作によって表されてもよい。仮想世界のなかに通信装置がシミュレートされてもよい。シミュレートされた通信装置と現実の通信装置との間で通信が行われてもよい。仮想世界はひとつ以上のプロセッサによって生成されてもよい。そのプロセッサは仮想世界のなかに通信装置をシミュレートし、そのシミュレートされた通信装置と現実の通信装置との間で通信を行わせる。アバターを使用した仮想世界通信のためのシステムおよび方法、カスタムアバタージェスチャのためのシステムおよび方法、ユーザの感情の状態をアバターにマッピングするためのシステムおよび方法、および仮想および現実の通信装置間で通信をルーティングするためのシステムおよび方法もまた開示される。

【選択図】図2ESystems and methods for communicating with a virtual world are disclosed. The virtual world may include a simulated public space and one or more simulated private spaces. Each private space may be associated with a particular user. The user's interaction with the virtual world may be represented by one or more actions of the avatar. A communication device may be simulated in the virtual world. Communication may be performed between the simulated communication device and the actual communication device. The virtual world may be generated by one or more processors. The processor simulates a communication device in the virtual world and allows communication between the simulated communication device and a real communication device. Systems and methods for virtual world communication using avatars, systems and methods for custom avatar gestures, systems and methods for mapping user emotional states to avatars, and communication between virtual and real communication devices Systems and methods for routing are also disclosed.

[Selection] Figure 2E

Description

(関連出願の参照)

本願は、譲受人を同じくする同時係属中の英国特許出願番号0703974.6、名称「ENTERTAINMENT DEVICE」、2007年3月1日出願、の優先権の利益を享受する。この出願は本明細書において参照により開示される。

(Refer to related applications)

This application enjoys the benefit of the priority of co-pending UK patent application No. 0703974.6 with the same assignee, the name “ENTERTAINMENT DEVICE”, filed on March 1, 2007. This application is disclosed herein by reference.

本願は、譲受人を同じくする同時係属中の英国特許出願番号0704225.2、名称「ENTERTAINMENT DEVICE AND METHOD」、2007年3月5日出願、の優先権の利益を享受する。この出願は本明細書において参照により開示される。 This application enjoys the benefit of the priority of co-pending UK patent application No. 070425.2, named “ENTERTAINMENT DEVICE AND METHOD”, filed Mar. 5, 2007, with the same assignee. This application is disclosed herein by reference.

本願は、譲受人を同じくする同時係属中の英国特許出願番号0704235.1、名称「ENTERTAINMENT DEVICE AND METHOD」、2007年3月5日出願、の優先権の利益を享受する。この出願は本明細書において参照により開示される。 This application enjoys the benefit of the priority of co-pending UK patent application No. 070425.1 with the same assignee, name “ENTERTAINMENT DEVICE AND METHOD”, filed Mar. 5, 2007. This application is disclosed herein by reference.

本願は、譲受人を同じくする同時係属中の英国特許出願番号0704227.8、名称「ENTERTAINMENT DEVICE AND METHOD」、2007年3月5日出願、の優先権の利益を享受する。この出願は本明細書において参照により開示される。 This application enjoys the benefit of the priority of co-pending UK patent application number 070427.8 with the same assignee, name “ENTERTAINMENT DEVICE AND METHOD”, filed Mar. 5, 2007. This application is disclosed herein by reference.

本願は、譲受人を同じくする同時係属中の英国特許出願番号0704246.8、名称「ENTERTAINMENT DEVICE AND METHOD」、2007年3月5日出願、の優先権の利益を享受する。この出願は本明細書において参照により開示される。 This application enjoys the benefit of the priority of co-pending UK patent application No. 070426.8 with the same assignee, entitled “ENTERTAINMENT DEVICE AND METHOD”, filed Mar. 5, 2007. This application is disclosed herein by reference.

本願は、同時係属中の米国仮特許出願番号60/892,397、名称「VIRTUAL WORLD COMMUNICATION SYSTEMS AND METHODS」、2007年3月1日出願、の優先権の利益を享受する。この出願は本明細書において参照により開示される。 This application benefits from the priority of co-pending US Provisional Patent Application No. 60 / 889,397, entitled “VIRTUAL WORLD COMMUNICATION SYSTEMS AND METHODS”, filed Mar. 1, 2007. This application is disclosed herein by reference.

本願は、譲受人を同じくする同時係属中の米国特許出願番号11/682,281、発明者Tomas Gillo他、名称「SYSTEM AND METHOD FOR COMMUNICATING WITH AVIRTUAL WORLD」、2007年3月5日出願、と関連する。この出願は本明細書において参照により開示される。 This application is related to co-pending U.S. Patent Application No. 11 / 682,281 with the same assignee, inventor Thomas Gillo et al., “SYSTEM AND METHOD FOR COMMUNICATION WITH AVIRTUAL WORD”, filed March 5, 2007, and related. To do. This application is disclosed herein by reference.

本願は、譲受人を同じくする同時係属中の米国特許出願番号11/682,284、発明者Tomas Gillo他、名称「SYSTEM AND METHOD FOR ROUTING COMMUNICATIONS AMONG REAL AND VIRTUAL COMMUNICATION DEVICES」、2007年3月5日出願、と関連する。この出願は本明細書において参照により開示される。 This application is co-pending U.S. patent application Ser. No. 11 / 682,284 with the same assignee, inventor Thomas Gillo et al., “SYSTEM AND METHOD FOR ROUTING COMMUNICATIONS AMONG REAL AND VIRTUAL COMMUNICATION DEVICES, 7th of March, 200”. Related to the application. This application is disclosed herein by reference.

本願は、譲受人を同じくする同時係属中の米国特許出願番号11/682,287、発明者Tomas Gillo他、名称「SYSTEM AND METHOD FOR COMMUNICATING WITH AN AVATAR」、2007年3月5日出願、と関連する。この出願は本明細書において参照により開示される。 This application is related to co-pending U.S. Patent Application No. 11 / 682,287 with the same assignee, inventor Thomas Gillo et al., The name “SYSTEM AND METHOD FOR COMMUNICING WITH AN AVATAR”, filed March 5, 2007, To do. This application is disclosed herein by reference.

本願は、譲受人を同じくする同時係属中の米国特許出願番号11/682,292、発明者Tomas Gillo他、名称「MAPPING USER EMOTIONAL STATE TO AVATAR IN A VIRTUAL WORLD」、2007年3月5日出願、と関連する。この出願は本明細書において参照により開示される。 This application is co-pending U.S. Patent Application No. 11 / 682,292, with the same assignee, inventor Thomas Gillo et al. Related to. This application is disclosed herein by reference.

本願は、譲受人を同じくする同時係属中の米国特許出願番号11/682,298、発明者Tomas Gillo他、名称「AVATAR CUSTOMIZATION」、代理人事件番号SCEA0701JDI05、2007年3月5日出願、と関連する。この出願は本明細書において参照により開示される。 This application is related to co-pending US Patent Application No. 11 / 682,298 with the same assignee, inventor Thomas Gillo et al., Name “AVATAR CUSTOMIZATION”, agent case number SCEA0701JDI05, filed March 5, 2007, To do. This application is disclosed herein by reference.

本願は、譲受人を同じくする同時係属中の米国特許出願番号11/682,299、名称「AVATAR EMAIL AND METHODS FOR COMMUNICATING BETWEEN REAL AND VIRTUAL WORLDS」、2007年3月5日出願、と関連する。この出願は本明細書において参照により開示される。 This application is related to co-pending U.S. patent application Ser. No. 11 / 682,299, entitled “AVATAR EMAIL AND METHODS FOR COMMUNICATING BETWEEN REAL AND VIRTUAL WORLDS”, filed Mar. 5, 2007. This application is disclosed herein by reference.

(技術分野)

本発明は、双方向的なコンピュータエンタテイメントに関し、特に仮想世界のユーザ間のコミュニケーションに関する。

(Technical field)

The present invention relates to interactive computer entertainment, and more particularly to communication between users in a virtual world.

仮想世界とは、ユーザがひとつ以上のコンピュータプロセッサを介して互いにやりとりできるシミュレートされた環境である。ユーザはいわゆるアバターとしてビデオスクリーンに表れる。シミュレートされた環境とアバターとの間の相互作用の度合いは、例えば物理的シミュレーションやユーザ間の情報交換などの相互作用を支配するひとつ以上のコンピュータアプリケーションによって実現される。 A virtual world is a simulated environment in which users can interact with each other via one or more computer processors. The user appears on the video screen as a so-called avatar. The degree of interaction between the simulated environment and the avatar is realized by one or more computer applications that govern the interaction, such as physical simulation or information exchange between users.

仮想世界のユーザ間のやりとりの性質はその仮想世界を実現しているシステムの制約によってしばしば制限される。

本発明の実施の形態はこのような点に鑑み創作されたものである。

The nature of interactions between users in a virtual world is often limited by the constraints of the system that implements the virtual world.

The embodiment of the present invention has been created in view of these points.

本発明の教示するところは、添付図面とあわせて以下の詳細な説明を考慮することにより容易に理解されるであろう。 The teachings of the present invention can be readily understood by considering the following detailed description in conjunction with the accompanying drawings, in which:

以下の記述においては、例示のために多くの特定的な詳細を含むが、本発明の範囲内において、以下の詳細について多くの変形や変更が可能であることは、当業者には理解されるところである。したがって、下記に示す本発明の実施例は、請求項に記載の発明の一般性を失わせるものでも制約を設けるものでもない。 While the following description includes many specific details for purposes of illustration, those skilled in the art will appreciate that many variations and modifications may be made to the following details within the scope of the present invention. By the way. Accordingly, the embodiments of the present invention described below are not intended to detract from the generality of the claimed invention or impose limitations.

本発明の実施の形態によると、ユーザは仮想世界とやりとりしてもよい。ここで仮想世界という用語は、現実のもしくは架空の環境を表すものを意味する。この環境はひとつ以上のプロセッサによってシミュレートされた相互作用則を有する。現実のユーザはひとつ以上の表示装置を介してこの環境を認識し、および/または、現実のユーザはひとつ以上のユーザインタフェースを介してこの環境とやりとりする。ここでユーザインタフェースという用語は、ユーザが仮想世界へ入力を送るために、もしくは仮想世界からの出力を受けるために使用される現実の装置を指す。仮想世界は、ひとつ以上のプロセッサモジュールによってシミュレートされてもよい。複数のプロセッサモジュールは、ネットワークを介して互いにリンクされてもよい。ユーザは、ユーザインタフェース装置を介して仮想世界とやりとりしてもよい。このユーザインタフェース装置は、ネットワークを介して複数のプロセッサモジュールおよび他のユーザインタフェース装置と通信できる。仮想世界のある側面は、コンピュータモニタ、テレビモニタ、もしくは同様のディスプレイなどのグラフィックス用のディスプレイにグラフィックスの形でユーザに示されてもよい。仮想世界の他の側面は、スピーカからの音声の形でユーザに示されてもよく、この場合スピーカは、グラフィックス用のディスプレイと共に設けられてもよい。 According to an embodiment of the present invention, the user may interact with the virtual world. Here, the term virtual world means something that represents a real or fictional environment. This environment has an interaction law that is simulated by one or more processors. Real users recognize this environment via one or more display devices and / or real users interact with this environment via one or more user interfaces. As used herein, the term user interface refers to a real device used by a user to send input to the virtual world or to receive output from the virtual world. The virtual world may be simulated by one or more processor modules. The plurality of processor modules may be linked to each other via a network. A user may interact with the virtual world via a user interface device. The user interface device can communicate with a plurality of processor modules and other user interface devices via a network. Certain aspects of the virtual world may be presented to the user in the form of graphics on a graphics display such as a computer monitor, television monitor, or similar display. Other aspects of the virtual world may be shown to the user in the form of audio from a speaker, where the speaker may be provided with a graphics display.

例として、仮想世界はシミュレートされた公共空間とひとつ以上のシミュレートされた私的空間とを備えてもよい。ある実施の形態では、そのような公共空間および私的空間は、仮想世界の模式的な表現もしくは地図を示すグラフィックス用のディスプレイを介してユーザに示されてもよい。例として、図1Aに示されるように、世界地図10は「ホーム」位置11を示してもよい。ホーム位置11は、ある特定のユーザに限られた仮想世界中の私的空間であってもよい。他のユーザは、そのホーム位置11に関連付けられたユーザからの招待がある場合にのみそのホーム位置11を「訪れる」ことができる。世界地図10は、種々の他の位置12をも示してもよい。ユーザは、例えばカーソルで選ぶことによってもしくは同様のグラフィカルユーザインタフェースによってそれらの位置12を訪れることができる。ベンダがこれらの位置のスポンサーとなってもよく、これらの位置は地図上で、対応する会社のロゴや他のよく知られたシンボルによって表されてもよい。そのような位置は仮想世界のユーザによって訪問されてもよい。仮想世界は固定量の仮想「不動産」を有してもよいし、有さなくてもよい。好適な実施の形態では、仮想不動産の量は固定されていない。

As an example, the virtual world may comprise a simulated public space and one or more simulated private spaces. In some embodiments, such public and private spaces may be shown to the user via a graphic display showing a schematic representation or map of the virtual world. By way of example, as shown in FIG. 1A, the

本発明のある実施の形態では、仮想世界はここで「ロビー」と称される複数の公共空間を有してもよい。各ロビーはそれに付随した別個のチャットチャネルを有してもよい。これによりそのロビーにいるユーザは互いにやりとりできる。各ロビーは、ホテルやオフィスビルや共同住宅や映画館や他の公共の建物などの公共の建物におけるロビーの外観を有してもよい。図1Bは、そのようなロビーのスクリーンショットを示す。ロビーはユーザがそれを用いてやりとりできる物を含んでもよい。そのような物は例えばゲームである。図1Bに見られる通り、仮想世界の部分部分は3次元(3D)グラフィックスの形でユーザに示される。ここで3次元(3D)の形という用語は、長さ、幅、および深さ(もしくは少なくとも深さの錯覚)を有する表現を指す。ロビーは「スクリーン」13を含んでもよい。このスクリーン13は、写真や記録されたビデオやストリーミングビデオを見せるために使用されうる空間中の領域である。

In one embodiment of the invention, the virtual world may have multiple public spaces, referred to herein as “lobby”. Each lobby may have a separate chat channel associated with it. This allows users in the lobby to interact with each other. Each lobby may have the appearance of a lobby in a public building, such as a hotel, office building, apartment house, movie theater, or other public building. FIG. 1B shows a screenshot of such a lobby. The lobby may include things that the user can interact with. Such a thing is a game, for example. As seen in FIG. 1B, a portion of the virtual world is shown to the user in the form of three-dimensional (3D) graphics. Here, the term three-dimensional (3D) shape refers to a representation having length, width, and depth (or at least an illusion of depth). The lobby may include a “screen” 13. This

仮想世界のなかではユーザはアバターによって表示されてもよい。仮想世界のなかの各アバターは、個々のユーザに独自のものとして関連付けられてもよい。ユーザの名前もしくは仮名がアバターの隣に表示されてもよく、それによってユーザは容易に互いを認識しうる。あるユーザの仮想世界とのやりとりは、ひとつ以上の対応するアバター動作によって表されてもよい。異なる複数のユーザが公共空間のなかでアバターを通じて互いにやりとりしてもよい。ユーザを表すアバターは、人間、動物もしくは物体と似た外観を有しうる。人間の形をしたアバターは、ユーザと同じ性もしくは異なる性を有してもよい。ユーザがアバターを仮想世界の他の物体と共に見ることができるように、アバターがディスプレイに表示されてもよい。あるいはまた、ディスプレイは世界をアバターの視点から表示し、そのアバターそのものは表示しなくてもよい。ユーザからの(もしくはアバターからの)仮想世界の見え方は、仮想カメラの視野であると考えてもよい。ここで仮想カメラは、仮想世界のなかの3次元シーンを2次元画像に描画するのに使用されうる仮想世界のなかの視点を指す。ユーザは、自己のアバターを介し、個々のロビーに関連付けられたチャットチャネルを用いて互いにやりとりしてもよい。ユーザは、他のユーザとチャットするために自己のユーザインタフェースを介してテキストを入力してもよい。すると、そのテキストがユーザのアバターの上もしくは隣に表れてもよい。その表れ方は、例えば漫画様のふきだしの形であり、しばしばチャットバブルと呼ばれる。そのようなチャットは、しばしばクイックチャットと呼ばれる、予め用意されたフレーズを用いるチャットシステムを使用することで簡単化されてもよい。クイックチャットでは、ユーザはメニューからひとつ以上のチャットフレーズを選択してもよい。 In the virtual world, the user may be displayed by an avatar. Each avatar in the virtual world may be uniquely associated with an individual user. The user's name or pseudonym may be displayed next to the avatar so that the users can easily recognize each other. A user's interaction with the virtual world may be represented by one or more corresponding avatar actions. A plurality of different users may interact with each other through an avatar in a public space. An avatar representing a user may have an appearance similar to a human, animal or object. A human-shaped avatar may have the same or different gender as the user. The avatar may be displayed on the display so that the user can see the avatar along with other objects in the virtual world. Alternatively, the display may display the world from the viewpoint of the avatar, and the avatar itself may not be displayed. The view of the virtual world from the user (or from the avatar) may be considered as the field of view of the virtual camera. Here, the virtual camera refers to a viewpoint in the virtual world that can be used to draw a three-dimensional scene in the virtual world into a two-dimensional image. Users may interact with each other through their own avatar using chat channels associated with individual lobbies. Users may enter text via their user interface to chat with other users. The text may then appear on or next to the user's avatar. The appearance is, for example, in the form of a comic balloon, often called a chat bubble. Such chats may be simplified by using a chat system that uses pre-prepared phrases, often referred to as quick chat. In quick chat, the user may select one or more chat phrases from a menu.

本発明の実施の形態では、特定のユーザもしくはユーザグループに関連付けられていないという意味、かつどのユーザもしくはユーザグループも他のユーザをその公共空間から排除できないという意味で公共空間は公共である。これと比較して各私的空間は複数のユーザのなかのある特定のユーザに関連付けられる。私的空間に関連付けられた特定のユーザが他のユーザによるその私的空間へのアクセスを制限できるという意味で、私的空間は私的である。私的空間は、よく見られる私的な不動産の外観を有してもよい。例えば、図1Cに見られるように、私的空間は共同住宅もしくは個人宅に似せて設けられてもよい。私的空間には、仮想のものが含まれてもよい。仮想のものの例には、家具15、装飾16、および仮想ラジオや仮想ビデオスクリーンなどの仮想通信装置17が含まれるが、それに限定されない。

In the embodiment of the present invention, the public space is public in the sense that it is not associated with a particular user or user group and that no user or user group can exclude other users from the public space. In comparison, each private space is associated with a particular user among multiple users. A private space is private in the sense that a particular user associated with the private space can restrict access to that private space by other users. A private space may have the appearance of a private property that is often seen. For example, as seen in FIG. 1C, the private space may be provided to resemble an apartment house or a private house. Private space may include virtual objects. Examples of virtual things include, but are not limited to,

本発明のある実施の形態では、仮想世界のユーザは、仮想通信装置を用いて通信してもよい。ここで仮想通信装置という用語は一般的に、仮想世界を構成するシステムの資産を使用して生成される、現実世界の装置の仮想世界におけるシミュレーションを指す。例として、図1Dに示される通り、仮想通信装置18は、ユーザによる装置の操作が簡単になるような形でディスプレイに表示される。図1Dに示される例では、仮想通信装置はソニープレイステーションポータブル(PSP)などの携帯型のゲームコンソールの外観を有する。仮想世界とやりとりするためにユーザが使用する現実のコントローラのボタンは、仮想通信装置の対応するボタン19もしくは他の制御にマッピングされてもよく、この場合ユーザと仮想通信装置との間のやりとりが容易となる。

In some embodiments of the invention, users in the virtual world may communicate using a virtual communication device. Here, the term virtual communication device generally refers to a simulation in the virtual world of a real-world device that is generated using the assets of the systems that make up the virtual world. As an example, as shown in FIG. 1D, the

仮想通信装置は、それに付随した仮想世界のなかでの位置を有してもよく、その位置は固定されていても可動とされていてもよい。仮想世界のなかでシミュレートされた通信装置のインタフェースをシミュレートし、そのシミュレートされたインタフェースをそれを介してやりとりするためにユーザに提示することによって通信装置がシミュレートされてもよい。例として、その仮想の装置は仮想世界において、ユーザに認知されうる形もしくは外観を有してもよい。この形もしくは外観は、ユーザのやりとりを容易にするように、対応する現実世界の装置のそれを模倣するものであってもよい。例えば、仮想の電話機は、ユーザがコントローラを使用して操作するボタンを有するものとして表示されてもよい。その仮想の電話機はさらに、スピーカ、送話口、およびおそらくはグラフィックスディスプレイスクリーンを有するものとして表示されてもよい。シミュレートされた通信装置は、シミュレートされたハンドヘルド通信装置であってもよく、そのようなシミュレートされたハンドヘルド通信装置は例えば、シミュレートされた電話機、シミュレートされた移動電話機(例えば、セルラー電話機もしくはコードレス電話機)、シミュレートされたボイスオーバーインターネットプロトコル(VoIP)電話機、シミュレートされた携帯型テキストメッセージ装置、シミュレートされた携帯型電子メール装置、シミュレートされた携帯型ゲーム装置、シミュレートされたツーウェイラジオ、もしくは他のシミュレートされたハンドヘルド装置である。 The virtual communication device may have a position in a virtual world associated therewith, and the position may be fixed or movable. The communication device may be simulated by simulating the interface of the simulated communication device in the virtual world and presenting the simulated interface to the user for interaction therethrough. By way of example, the virtual device may have a shape or appearance that can be perceived by a user in a virtual world. This shape or appearance may mimic that of a corresponding real-world device so as to facilitate user interaction. For example, a virtual telephone may be displayed as having a button that a user operates using a controller. The virtual phone may further be displayed as having a speaker, mouthpiece, and possibly a graphics display screen. The simulated communication device may be a simulated handheld communication device, such as a simulated telephone, a simulated mobile phone (eg, a cellular phone) Phone or cordless phone), simulated voice over internet protocol (VoIP) phone, simulated portable text messaging device, simulated portable email device, simulated portable gaming device, simulated Two-way radio, or other simulated handheld device.

本発明の実施の形態によると、仮想通信装置が仮想世界のなかでシミュレートされ、そのシミュレートされた通信装置と現実の通信装置との間で通信が行われてもよい。その現実の通信装置は、現実のハンドヘルド通信装置であってもよく、そのような現実のハンドヘルド通信装置は例えば、電話機、移動電話機(例えば、セルラー電話機もしくはコードレス電話機)、ボイスオーバーインターネットプロトコル(VoIP)電話機、携帯型テキストメッセージ装置、携帯型電子メール装置、携帯型ゲーム装置、ツーウェイラジオ、もしくは他のハンドヘルド装置である。現実の通信装置は、他の現実の通信装置と仮想世界とは独立したひとつ以上の通信チャネルを通じて通信することが好ましい。ここで「仮想世界とは独立した通信チャネル」という用語は、そのチャネルを通じて通信が行われるために仮想世界の存在が必要とされない通信チャネルを意味する。例えば、仮想世界によって提供される通信資産を介して現実のセルラー電話機に電話をかける(もしくはその反対)のために仮想電話機が使用されうる。しかしながら、その現実のセルラー電話機は、たとえ仮想世界が存在しなくとも、他の現実のセルラー電話機もしくは電話機に電話をかけることができる。ある実施の形態では、現実の電話機は、シミュレートされた電話機から電話を受けた際には特有の呼び出し音を生成してもよい。また代替的な実施の形態では、シミュレートされた通信装置および現実の通信装置は、互いにテキストメッセージかつ/またはビデオ画像を用いて通信してもよい。 According to the embodiment of the present invention, a virtual communication device may be simulated in a virtual world, and communication may be performed between the simulated communication device and an actual communication device. The actual communication device may be a real handheld communication device, such as a telephone, a mobile phone (eg, a cellular phone or a cordless phone), a voice over internet protocol (VoIP), etc. A telephone, a portable text message device, a portable electronic mail device, a portable game device, a two-way radio, or other handheld device. The actual communication device preferably communicates with one another through one or more communication channels independent of the virtual world. Here, the term “communication channel independent of the virtual world” means a communication channel in which the existence of the virtual world is not required because communication is performed through the channel. For example, a virtual phone can be used to call a real cellular phone (or vice versa) via communication assets provided by the virtual world. However, that real cellular telephone can make calls to other real cellular telephones or telephones even in the absence of a virtual world. In some embodiments, a real phone may generate a unique ringing tone when receiving a call from a simulated phone. In alternative embodiments, the simulated communication device and the actual communication device may communicate with each other using text messages and / or video images.

図1Eは、仮想世界をシミュレートするために使用されうるシステム20の例を示すブロック図である。システム20は、シミュレーションサーバ22とビューサーバ24とを含む。各シミュレーションサーバ22は、仮想世界のある部分をシミュレートするコード化されたインストラクションを実行するひとつ以上のプロセッサモジュールを含んでもよい。例として、各シミュレーションサーバは、デュアルコア、クアッドコアもしくはセルプロセッサなどの複数コアプロセッサをひとつ以上含んでもよい。限られた数のシミュレーションサーバ22とひとつのビューサーバ24とが図1Eに示されているが、この設定は任意の数のサーバの場合に自由に拡張されうる。シミュレーションサーバ22の数とビューサーバ24の数とは両方とも増減されてもよい。例えば、ひとつのシミュレーションサーバ22が多くのビューサーバ24を受け入れてもよいし、多くのシミュレーションサーバ22がひとつのビューサーバ24を受け入れてもよい。シミュレーションサーバ24をより多く加えることにより、仮想世界をより大きくかつ/またはより良くシミュレーションすることができる。ビューサーバ24をより多く加えることにより、システム20はより多くのユーザを取り扱うことができる。無論システム20は、シミュレーションサーバ22およびビューサーバ24の両方をより多く加えることによって、より大きくてより良いシミュレーションとより多くのユーザの受け入れの両方を実現できる。理論的にはシミュレーションサーバ22の数は無限大まで増やすことができる。しかしながらネットワークの帯域幅が限られていることに鑑みると、計算とネットワークの帯域幅による制限のために、ビューサーバ14の数はあるユーザ数を越えると有限の上限値に達すると考えるのが妥当であろう。

FIG. 1E is a block diagram illustrating an example of a

本発明の実施の形態に限定を行うものではなく例示を目的として、以下にセルプロセッサに関する例が説明される。セルプロセッサについては、例えばセルブロードバンドエンジンアーキテクチャ(Cell Broadband Engine Architecture)、著作権者インターナショナルビジネスマシーンコーポレーション(International Business Machines Corporation)、株式会社ソニー・コンピュータエンタテインメント(Sony Computer Entertainment Incorporated)、株式会社東芝(Toshiba Corporation)、2005年8月8日発行、に詳細が記載されている。この書物の複写物はhttp://cell.scei.co.JP/からダウンロード可能である。この書物は本明細書において参照により開示される。典型的なセルプロセッサは、パワープロセッサユニット(PPU)と、シナジスティックプロセシングユニット(SPU)と称される8つまでの付加的なプロセッサとを有する。各SPUは、典型的には主プロセッサと補助プロセッサとを含むひとつのチップ、もしくはそのチップの一部である。全てのSPUおよびPPUは、例えばメモリフローコントローラ(MFC)を通じて主メモリにアクセス可能である。SPUは主プロセッサで走っているプログラムと共同して並列的な操作処理を行うことができる。SPUは小さなローカルメモリ(典型的にはおよそ256キロバイト)を有し、このローカルメモリはソフトウエアによって管理されなければならない。つまり、コードおよびデータはローカルSPUメモリへ手動で移送されなければならず、またローカルSPUメモリから手動で移送されなければならない。高い性能を得るためには、このコードおよびデータはSPUソフトウエアによって管理されなければならない(PPUソフトウエアの関与は最小化されなければならない)。SPUからのコードおよびデータを管理する技術は多くある。そのような技術の例が、米国特許出願番号11/238,077、発明者John P. Bates、Payton White、Attila Vass、名称「CELL PROCESSOR APPARATUS AND METHODS」、2005年9月27日出願、および、米国特許出願番号11/238,095、発明者Richard B. StensonおよびJohn P. Bates、名称「CELL PROCESSOR TASK AND DATA MANAGEMENT」、2005年9月27日出願、および、米国特許出願11/238,086、発明者Tatsuya Iwamoto、名称「CELL PROCESSOR TASK AND DATA MANAGEMENT」、2005年9月27日出願、および、米国特許出願番号11/238,087、発明者John P. Bates、Payton R. White、Richard B. Stenson、Howard Berkey、Attila Vass、Mark Cerny、John Morgan、名称「SPU TASK MANAGER FOR CELL PROCESSOR」、2005年9月27日出願、および、米国特許出願番号11/257,761、発明者Tatsuya Iwamoto、名称「SECURE OPERATION OF CELL PROCESSORS」、2005年10月24日出願、および、米国特許出願番号11/461,390、発明者John P. Bates、Keisuke Inoue、Mark Cerny、名称「CELL PROCESSOR METHODS AND APPARATUS」、2006年7月31日出願、に記載されている。これら全ての出願は本明細書において参照により開示される。

For purposes of illustration and not limitation to the embodiments of the present invention, examples relating to cell processors are described below. Cell processors include, for example, Cell Broadband Engine Architecture, Copyright Business International Business Machines Corporation, Sony Computer Entertainment Corporation, Sony Computer Entertainment Corporation, and Sony Computer Entertainment Corporation. ), Issued August 8, 2005, for details. A copy of this book can be found at http: // cell. scei. co. It can be downloaded from JP /. This book is disclosed herein by reference. A typical cell processor has a power processor unit (PPU) and up to eight additional processors called synergistic processing units (SPUs). Each SPU is typically a chip or a part of a chip that includes a main processor and an auxiliary processor. All SPUs and PPUs can access the main memory through, for example, a memory flow controller (MFC). The SPU can perform parallel operation processing in cooperation with a program running on the main processor. The SPU has a small local memory (typically around 256 kilobytes), which must be managed by software. That is, code and data must be manually transferred to and from the local SPU memory. In order to obtain high performance, this code and data must be managed by the SPU software (PPU software involvement must be minimized). There are many techniques for managing code and data from SPUs. Examples of such techniques are described in US patent application Ser. No. 11 / 238,077, inventor John P. et al. Bates, Payton White, Attila Vass, name “CELL PROCESSOR APPARATUS AND METHODS”, filed Sep. 27, 2005, and US Patent Application No. 11 / 238,095, inventor Richard B. Stenson and John P. Bates, name “CELL PROCESSOR TASK AND DATA MANAGEMENT”, filed on September 27, 2005, and

シミュレーションサーバ22は高速データ移送リンク26を介して互いにおよびビューサーバ24と通信してもよい。例としては、そのデータ移送リンクは、毎秒10ギガビットのイーサネット(登録商標)接続であってもよい。シミュレーションサーバ22は互いに離れて設置されているかもしくは互いに近接して設置されてもよい。データ移送を最適化するためには、シミュレーションサーバ22を、例えば同じ部屋もしくは同じサーバラックに収納するなど互いに物理的にとても近くに設置することが望ましい。ビューサーバ24は、シミュレーションサーバ22からシミュレーションデータを受け取り、広域ネットワーク(wide area network)30を通じて離れて散らばっているクライアント装置28にビューデータを送る。この広域ネットワークは例えばインターネットや他の広域ネットワークである。クライアント装置28は、ネットワーク30を通じて通信できる任意の適切な装置であってもよい。ネットワーク30を通じた通信は、高速データリンク26を通じた通信よりも遅くてもよい。

The simulation servers 22 may communicate with each other and the

例として、クライアント装置28は、ソニープレイステーション3などのビデオゲームコンソール装置であってもよい。あるいはまた、クライアント装置28はハンドヘルドからワークステーションなどまでのあらゆるコンピュータ装置であってもよい。日本国の東京都にあるソニー・コンピュータエンタテインメント製のプレイステーションポータブルなどのハンドヘルドビデオゲーム装置は、他のハンドヘルド装置のなかでも本発明の実施の形態においてクライアント装置28として特に用いられうる例である。クライアント装置28はビューサーバ24に、他のクライアントのアバターやシミュレートされた環境との所望のやりとりに関するインストラクションを送ってもよい。例えば、クライアントユーザが彼もしくは彼女のアバターをシミュレートされた環境の別の位置に動かしたいと思うかもしれない。各クライアント装置28はインストラクションをビューサーバ24のひとつに送る。このインストラクションはそのビューサーバによって中継され、やりとりをシミュレートするために必要な計算を行うシミュレーションサーバに届けられる。

As an example, the

他の装置29もまたネットワーク30を通じて互いに通信してもよい。そのような他の装置の例は、電話機、セルラー電話機、ボイスオーバーインターネットプロトコル(VoIP)電話機、パーソナルコンピュータ、携帯型ウェブブラウザ、携帯型電子メール装置、テキストメッセージ装置、携帯型ゲーム装置などを含む。そのような他の装置29間の通信は、仮想世界を生成するシミュレーションサーバ22およびビューサーバ26とは独立したものであってもよい。他の装置29はシステム20の一部とは考えられてはいないものの、それらの装置はネットワーク30を介してシステム20とやりとりを行ってもよい。

クライアント装置28のユーザはたいていその周辺の物に興味がある。ビューサーバ24は、各クライアント28がその周辺物についての関連データを適切な順序で確実に受け取れるようにする。ビューサーバ24は、クライアントが何を必要としているかを、クライアントのアバターの位置や向きや動きなどに基づいて決定する。例として、各ビューサーバは、公共空間や私的空間を表示するためにクライアント装置が使用するコードかつ/またはデータを生成してもよい。

The user of the

複雑なシミュレートされた世界を実現するために、クライアントとサーバの間で、もしくはクライアント装置と他のクライアント装置との間で、ピアツーピア通信が行われることが望ましい。たとえば、同じ公共空間内のユーザ間の音声/ビデオ(A/V)チャットは、それらのユーザ間の直接のピアツーピア通信によって実現されてもよい。そのようなピアツーピア通信によると、サーバの負荷を低減できる。本発明の実施の形態では、ピアリブ(Peerlib)を使用してネットワークアドレストランスレータ(NATs)を横断し、同じ公共空間内のユーザ間のピアツーピア接続を確立する。NATを横断することは、たとえば米国特許出願番号11/245,853、発明者Yutaka Takeda、名称「METHOD FOR PEER− TO−PEER COMMUNICATION TRAVERSING NETWORK ADDRESS TRANSLATORS OF TYPE SYMMETRIC」、2005年10月4日出願、に記載されている。この出願は本明細書において参照により開示される。

In order to achieve a complex simulated world, it is desirable for peer-to-peer communication to occur between a client and a server or between a client device and another client device. For example, voice / video (A / V) chat between users in the same public space may be achieved by direct peer-to-peer communication between those users. Such peer-to-peer communication can reduce the load on the server. In an embodiment of the present invention, peer ribs are used to traverse network address translators (NATs) to establish peer-to-peer connections between users in the same public space. Crossing NAT, for example, U.S. Patent Application No. 11 / 245,853, Inventor Yutaka Takeda, Name "METHOD FOR PEER- TO-PEER COMMUNICATION TRAVERSING NETWORK ADDRESS TRANSLATORS OF

図1Fは、クライアント装置28として使用されうるマルチメディア処理システム100およびシステム20によって生成される仮想世界とのユーザインタフェースのひとつの実施態様を示す。処理システム100は、静止画や動画や音楽や放送やゲームなどの複数のメディアにまたがる複数のコンテンツを処理することができる複合装置を含んでもよい。複数のコンテンツの処理とは、プレゼンテーション、記録、およびマルチメディア処理システム100によって行われる他の関連タスクを含む。例として、マルチメディア処理システム100は、マルチメディア処理装置102と、ディスプレイ104(例えば、モニタもしくはテレビ)と、コントローラ114と、を備える。コントローラ114のボタンは、図1Dおよび上で説明された仮想コントローラ18の対応するボタン19にマッピングされてもよい。

FIG. 1F shows one embodiment of a

マルチメディア処理装置102は、放送メディアやインターネット(もしくは他のネットワーク)のメディアや光学ディスク110やメモリカード112などの種々のメディア源からマルチメディアコンテンツを受け取ってもよい。放送メディアからのコンテンツは、放送データチャネル106を通じて受信されてもよい。一方、インターネットのメディアからのコンテンツはネットワークデータチャネル108を通じて受信されうる。放送およびネットワークデータチャネル106、108は、無線チャネル、有線チャネルのいずれであってもよい。放送メディアおよびインターネットのメディアからのコンテンツは、マルチメディア処理装置102によって記録、保存されてもよい。受信されたコンテンツは、仮想世界とのやりとりに使用されるだけでなく、マルチメディア処理装置102の種々の機能(例えば、ゲーム)によって使用されてもよい。

The

受信されたマルチメディアコンテンツは、ディスプレイ104に表示されてもよい。ディスプレイは、静止画像や動画像を表示するための陰極線管(CRT)やフラットスクリーンなどのビデオモニタを含んでもよい。ディスプレイ104は、ユーザに音声を提供するために、ひとつ以上の音声スピーカをさらに含んでもよい。コントローラ114は、ユーザにマルチメディア処理に関する種々のインストラクションを入力せしめ、かつ、ユーザにマルチメディア処理装置102の機能を制御せしめる。

The received multimedia content may be displayed on the

システム100は、ディスプレイ104によって提供される可視画像かつ/または可聴音声をもってユーザのやりとりを容易にするために、音声入力およびビデオ入力を含んでもよい。そのような入力は、カメラなどのビデオ撮像装置116およびマイクロホンなどの音声信号取得装置118を含んでもよい。ビデオ撮像装置116は、ディスプレイ104の上に載置されてもよく、またはディスプレイ104と一体化されてもよい。また、ビデオ撮像装置116は、マルチメディア処理装置102と、ケーブルによって、もしくは光学データリンク(例えば、赤外線)や無線周波数データリンク(例えば、ブルートゥース)などの空中接続(over−the−air connections)によって接続されてもよい。撮像装置116は、ディスプレイ104の前付近の画像を取得できるような他のいかなる近隣位置に置かれてもよいことは理解されるべきである。これらの動きややりとりを捉える技術は種々あるが、そのような技術の例が、英国特許出願GB0304024.3(PCT/GB2004/000693)およびGB 0304022.7 (PCT/GB2004/000703)に記載されている。このそれぞれは2003年2月21日に出願されており、本明細書において参照により開示される。撮像装置116は、例えばUSB2.0型のカメラなどのデジタルカメラであってもよい。そのようなカメラは、約75度の視野と、1.5程度のF値と、を有してもよく、また、毎秒約120フレームまでのフレームレートで画像を取得しうる。例として、ビデオ撮像装置は、カリフォルニア州フリーモントにあるロジテック(Logitech)社から購入可能なアイトイカメラ(EyeToy Camera)であってもよい。メディア処理装置102は、ゲームコンソール、テレビ、デジタルビデオレコーダ(DVR)、ケーブルセットトップボックス(cable set−top−box)、ホームメディアサーバ、もしくはユーザからの制御にしたがって自身を描画しうる装置を含む家庭用電気機器であってもよい。代替的な実施の形態では、撮像装置は3次元(3D)カメラであってもよい。ここで3Dカメラ(もしくはゼッドカメラ(zed camera))とは、画像中の物体の深さを決定することを容易にする撮像装置を指す。この文脈において用語「深さ」とは、画像平面と垂直な方向における物体の位置を指す。

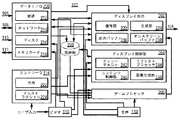

図2Aは、マルチメディア処理装置102の実施態様を示す機能ブロック図である。示される実施態様においては、マルチメディア処理装置102は、コントローラ114と、ビデオ撮像装置116と、音声信号取得装置118と、データ入力/出力(I/O)部200と、ディスプレイ出力部202と、ディスプレイ制御部204と、保持部208と、ゲーム/仮想世界プロセッサ206と、を含む。例として、ゲーム/仮想世界プロセッサ206は、セルプロセッサなどの並列プロセッサであってもよく、またそれを含んでもよい。この並列プロセッサは、ひとつ以上のシナジスティックプロセシングユニット(SPU)と結合されたパワープロセシングユニット(PPU)を有する。セルプロセッサについては、例えば米国特許出願番号11/238,077に記載されており、この出願は本明細書において参照により開示される。マルチメディア処理装置102はさらに、データ入力機能、データ維持機能、画像処理機能、描画機能、および他の関係する機能などの種々の機能を実現するためのプログラムおよびインストラクションを含む。

FIG. 2A is a functional block diagram illustrating an embodiment of the

コントローラ114は、ユーザの入力から4つの向き(つまり、上向き、下向き、左向き、および右向き)のひとつもしくは組み合わせを決定する向き決定部222と、ユーザの入力からインストラクションを決定するインストラクション決定部224と、を含んでもよい。インストラクションは、マルチメディアコンテンツを示すためのコマンド、その提示を終了させるためのコマンド、メニュー画面を呼び出すためのコマンド、および他の関係するコマンドかつ/またはインストラクションを発行するためのコマンドを含んでもよい。コントローラ114、ビデオ撮像装置116および音声信号取得装置118からの出力は、ディスプレイ出力部202と、ディスプレイ制御部204と、ゲーム/仮想世界プロセッサ206と、に振り向けられる。

The

図1Bおよび図2Aに示される実施態様では、向き決定部222およびインストラクション決定部224は、方向およびインストラクションを起動、感知、および決定するためのボタン、回路、およびプログラムの組み合わせで構成されてもよい。ボタンは十字キーもしくはジョイスティックを含みうる。メニュー画面を呼び出すためのインストラクションに関連したボタンはトグル式に設定されてもよく、この場合、そのボタンが押される度にメニュー画面が表示モードと非表示モードとの間で切り替えられる。

In the embodiment shown in FIGS. 1B and 2A,

ある実施態様では、向き決定部222はボタンの斜めの動きを、動きの向きを2つの向きのうちの一方と定めるバイナリコマンドとして決定してもよい。ここでは、上向きと右向きとの間の斜めの動きは、上向きかもしくは右向きのいずれか一方と定められうる。別の実施態様では、向き決定部222はボタンの斜めの動きを、動きの向きを測定精度の範囲内におけるある特定の向きに定めるアナログコマンドとして決定してもよい。ここでは、上向きと右向きとの間の斜めの動きは、北西向きと定められうる。後述される通り、方向性の動きは、ユーザとビデオ撮像装置116とディスプレイ制御204との間のやりとりを通じて決定されてもよい。

In one embodiment, the

データI/O部200は、放送チャネル106を介して放送コンテンツを入力する放送入力部212と、ネットワークチャネル108を介してウェブコンテンツなどのデータを入出力するネットワーク通信部214と、ディスク110に保持されるデータを入力するディスク読み取り部216と、メモリカード112にデータを入力しかつ/またはメモリカード112からデータを出力するメモリカード読み取り部218と、を含んでもよい。データI/O部200の出力は、ディスプレイ出力部202と、ディスプレイ制御部204と、ゲームプロセッサ206と、保持部208と、に振り向けられてもよい。

The data I /

ディスプレイ出力部202は、復号部232と、合成部234と、出力バッファ236と、オンスクリーンバッファ238と、を含んでもよい。復号部232は、データI/O部200もしくは保持部208から受け取る入力データを復号する。ここで、入力データは、放送コンテンツ、映画、および音楽を含んでもよい。合成部234は、コントローラ114から受け取るユーザの方針/インストラクションに基づいて復号された入力データを処理する。合成部234の出力は出力バッファ236に保持される。オンスクリーンバッファ238は、ディスプレイ制御部204によって生成されるメニュー画面の画像データを保持してもよい。ディスプレイ出力部202の出力は、ディスプレイ104に伝送される。

The

ディスプレイ制御部204は、メニューマネジャ242と、エフェクトプロセッサ244と、コンテンツ制御部246と、画像生成部248と、を含んでもよい。メニューマネジャ242は、保持部208およびデータI/O部200から受け取り、メニュー画面に示されるメディア体およびマルチメディアコンテンツを管理する。エフェクトプロセッサ244は、メニュー画面のアイコンおよびアイコンアレイの操作を処理する。エフェクトプロセッサ244は、メニュー画面に表示されるべき種々の動作およびエフェクトを管理する。コンテンツ制御部246は、メディア体およびマルチメディアコンテンツの処理、およびデータI/O部、保持部208、およびゲーム/仮想世界プロセッサ206からのデータの取り扱いを制御する。画像生成部248は、メディアアイコンアレイおよびコンテンツアイコンアレイを含むメニュー画面を生成する。

The

ゲーム/仮想世界プロセッサ206は、データI/O部200もしくは保持部208から読み出されたデータを使用して、ゲームかつ/または仮想世界プログラムを実行する。ゲーム/仮想世界プロセッサ206は、ゲームプログラムを実行し、もしくはコントローラ114から受け取るユーザインストラクションに基づき、ユーザの仮想世界とのやりとりを容易にする。実行されたゲームプログラムまたは仮想世界とのやりとりのディスプレイデータは、ディスプレイ出力部202へ伝送される。

The game / virtual world processor 206 uses the data read from the data I /

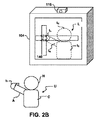

本発明の実施の形態では、ビデオ撮像装置116および音声信号取得装置118からの信号は、ユーザがディスプレイ104に表される画像とやりとりし、それを操作することを可能とする。特に、本発明の実施の形態は、ユーザがオブジェクトをディスプレイ104上のある位置から別の位置へ「グラブ(grab)」して「ドラッグ(drag)」することを可能としてもよい。図2Bに示される通り、ビデオ撮像装置116は、ユーザUの像IUに向けられそれを撮像する。そして像IUは、アルファブレンディング(alpha blending)として知られている技術を用いて、ディスプレイ104上で他の像からなる背景の上に表示されてもよい。

In an embodiment of the present invention, signals from

「アルファブレンディング」という用語は一般に、2つの色の凸結合を指し、コンピュータグラフィックスの分野における透過性効果のためのものである。カラーコードにおける値アルファ(alpha)は0.0から1.0の範囲にあってもよく、0.0は十分に透明な色を示し、1.0は十分に不透明な色を示す。例として、色Value1が色Value0の背景の上に描かれた場合、その結果として得られる色の値(Value)は以下の式で与えられてもよい。

Value = Value0 (1.0 - alpha) + Value1 (alpha)

The term “alpha blending” generally refers to the convex combination of two colors and is for transparency effects in the field of computer graphics. The value alpha in the color code may be in the range of 0.0 to 1.0, with 0.0 indicating a sufficiently transparent color and 1.0 indicating a sufficiently opaque color. As an example, when the color Value1 is drawn on the background of the color Value0, the resulting color value (Value) may be given by the following equation.

Value = Value0 (1.0-alpha) + Value1 (alpha)

32ビットRGBAに見られるように、アルファ成分は、赤緑青の3成分を均等に混合するために使用される。あるいはまた、スペクトルカラーフィルタリング(spectral color filtering)における原色のそれぞれに対応して3つのアルファ値が指定される。 As seen in 32-bit RGBA, the alpha component is used to evenly mix the three components red, green and blue. Alternatively, three alpha values are designated corresponding to each of the primary colors in spectral color filtering.

ユーザの手hが認識されると、エフェクトプロセッサは、ユーザの手の変位の向きを、通常はコントローラ114から受け取るような向きの入力と関連付けてもよい。変位の大きさで速さの入力を制御できるようにされてもよい。

When the user's hand h is recognized, the effects processor may correlate the orientation of the user's hand displacement with an orientation input that would normally be received from the

ある実施の形態では、像IUは、ユーザの頭Hと手hとを含んでもよい。像IUとのユーザのやりとりを容易にするために、ユーザの像IUはユーザUの鏡像として画面に表示されてもよいことを注意しておく。ここでは、ユーザUが手hをユーザの左側に動かした場合、手の像Ihもまたユーザの左側に動く。エフェクトプロセッサ244は、ユーザの手hを認識し、また手の像Ihの縦横比(高さと幅の比)の変化を認識するよう構成されてもよい。縦横比のこの変化は、コントローラ114にユーザがディスプレイ上のオブジェクト140を「グラブした(grabbed)」もしくは「クリックした(clicked)」ことを知らせるために使用されてもよい。そしてエフェクトプロセッサ244は、選択されたオブジェクトをユーザの手hの像Ihの動きに合わせて動かしうる。ある実施の形態では、ユーザは変形可能な「C」字形状のオブジェクト142を握ってもよい。この変形可能な「C」字形状のオブジェクト142には、ビデオ撮像装置116からの像を解釈する際に、エフェクトプロセッサ244がより容易に認識可能な色がつけられる。ここで「クラム(clam)」と呼ぶこととするオブジェクト142の変形は、ディスプレイ104上のオブジェクトを「グラブ(grab)」もしくは「クリック(click)」するためのコマンドとして認識される縦横比の変化を提供しうる。

In some embodiments, the image I U may include the user's head H and hand h. To facilitate user interaction with the image I U, the image I U of users it is to be noted that the may be displayed on the screen as a mirror image of the user U. Here, when the user U moves the hand h to the left side of the user, the hand image I h also moves to the left side of the user. The effects processor 244 may be configured to recognize the user's hand h and to recognize changes in the aspect ratio (height to width ratio) of the hand image Ih. This change in aspect ratio may be used to inform the

ユーザUがディスプレイ104上のオブジェクト140を操作するのに左手を使用しているか右手を使用しているかをエフェクトプロセッサ244が認識できることが、しばしば望まれる。例えば、ディスプレイ104上のオブジェクトを左手で操作している場合、オブジェクトがユーザの頭Hの左側に表れることが多くの場合望ましい。このような場合、コントローラはユーザの手h、頭H、腕A、および腰Cをそのそれぞれに対応する像Ih、IH、IA、およびICによって認識するソフトウエアを含んでもよい。この情報をもとにコントローラ114は、ユーザUが左手を使用しているか右手を使用しているかを決めることができる。例えば、ユーザの手hが頭Hの左側にあり、腕Aは腰と交差していない場合、ユーザUは左手を使用していると決めることができる。同様に、ユーザの手hが頭の左側にあり、腕は腰と交差している場合、ユーザUは右手を使用していると決めることができる。

It is often desirable for the effects processor 244 to be able to recognize whether the user U is using the left or right hand to manipulate the

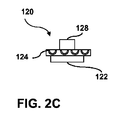

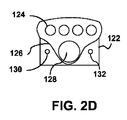

本発明のある実施の形態では、撮像装置116および音声信号取得装置118はひとつの機器として統合されてもよい。例えば、図2Cおよび図2Dは、マルチメディア処理システム100で使用されてもよい撮像装置120を示す。装置120は、例えばデジタルカメラ(もしくは3Dカメラ)である光学撮像装置122と、ひとつ以上のマイクロホン124とを含む。マイクロホン124はアレイ状に配置され、かつ互いに既知の距離だけ離されて配置されてもよい。例示であり一般性を失わない範囲において、マイクロホン124は直線アレイ状に間隔を置いて配置され、隣接するマイクロホンは中心間の距離にして約2センチメートルだけ離されてもよい。個々のマイクロホンは、約16キロヘルツの共振周波数を有してもよい。このようなマイクロホンアレイは、装置102の動作および仮想世界とのやりとりと共同して、ひとつ以上の音源の位置を探して追跡するために使用されてもよい。このようなマイクロホンアレイの音源位置発見および追跡のための使用については、例えば米国特許出願11/381,724、11/381,725、および11/381,729、2006年5月4日出願、に記載されている。これらは本明細書において参照により開示される。

In an embodiment of the present invention, the

本発明のある実施の形態では、マイクロホン124が撮像装置122と共に動くことが望ましい。例えば、マイクロホン124はフレーム126に取り付けられてもよい。このフレーム126は、マイクロホンと撮像装置、例えばレンズ128、との位置関係を固定されたものとする。複数のマイクロホンが水平な直線状に配列されているように示されているが、それらは代替的には垂直に向けられてもよく、また斜めに向けられてもよく、また2次元的に配列されてもよい。

In certain embodiments of the invention, it is desirable for the

ある実施の形態では、装置120は可視LED130および赤外線LED132を含んでもよい。これらは撮像装置122の視野にある物体を照らすために使用されうる。赤外線像の取得を容易とするため、レンズ128は、可視光および選択された赤外領域の周波数(例えば、940nm程度の周波数)を通過させるいわゆる「デイ−ナイト(day−night)」コーティングを含んでもよい。

In certain embodiments, the

例として、彼もしくは彼女のアバターに仮想携帯電話をとらせて番号をダイアルさせ、現実のもしくは仮想の電話へ現実に電話をかけさせるように、システム20の要素および装置102は設定されてもよい。その電話を受ける側が仮想世界の他のユーザである場合、システム20および装置102は、そのユーザの仮想電話に接続するよう適切にプログラムされていてもよい。ここでこの接続は、例えばその電話がなされる時点でそのユーザがオンラインであり仮想世界とやりとりを行っている場合にはVoIPを介して行われる。システム20の要素および装置102は、デフォルトでは受け側の仮想電話(もしあれば)にその電話をルーティングするよう設定されていてもよい。受け側がオンラインでない場合、その電話は受け側の現実の通信装置へ再ルーティングされてもよい。現実の通信装置の例は、電話(例えば、固定電話回線、携帯電話、もしくはVoIP電話)、もしくはボイスメール(これは現実のもしくは仮想の電話に伴われうる)、もしくは携帯型ゲーム装置およびそのようなものを含むVoIP対応の任意のネットワーク装置を含んでもよいが、それに限定されない。あるいはまた、電話はデフォルトでユーザの現実の通信装置にルーティングされてもよい。そのような実施の形態では、システム20の要素および装置102は、仮想世界と現実の通信装置との間の賢い双方向ルーティングを可能とするように使用されてもよい。

By way of example, elements of

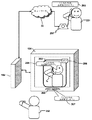

例示を目的とし一般性を失わない範囲で、現実の装置と仮想の装置との間の通信は、図2Eおよび図2Fを参照して理解されうる。図2Eに示されるように、2人以上のユーザ251、252は、図1Eに関して上述した通り、例えばシステム20を介しネットワーク30を通じて仮想世界とやりとりしてもよい。個々のユーザは、クライアント装置253、254を介してネットワーク30を通じてシステム20と結びついてもよい。これらのクライアント装置253、254は、例えば図1Fおよび2Aに関して上述した通りに適切に設定されてもよい。個々のクライアント装置253、254は、仮想通信装置255、256を生成するのに適切なハードウエアかつ/またはソフトウエアを含んでもよい。装置アバターは仮想世界のなかでは仮想通信装置を表してもよい。装置アバターは、例えば上述の通りに現実の装置の外観を有してもよい。あるいはまた、ユーザは全く任意のかつ/または架空の外観を有するように装置アバターをカスタマイズしてもよい。個々のユーザ251、252は、固定電話257、258および携帯電話259、260などの現実の通信装置を使用することができてもよい。本発明の実施の形態は、任意の数のユーザおよび任意の数の現実のかつ/または仮想の通信装置で実現されうることは、当業者であれば分かる。

For purposes of illustration and without loss of generality, communication between a real device and a virtual device can be understood with reference to FIGS. 2E and 2F. As shown in FIG. 2E, two or

個々のクライアント装置253、254は、現実の装置と仮想の装置との間の電話のルーティングを容易とするための設定可能なルータ261、262を備えてもよい。ルータ261、262は、サーバ、ピアツーピアネットワーク、それらの組み合わせ等のなかにソフトウエアもしくはハードウエアの形で存在してもよい。図2Eに示される例ではルータ261、262はクライアント装置253、254上に設けられているが、これは唯一の可能な配置構成ではない。代替的にはルータ261、262は、シミュレーションサーバ22上、ビューサーバ24上、もしくはネットワーク30に接続された他の装置上など、いかなる場所に設けられてもよい。ルータ261、262は種々の装置からおよび複数の手段でアクセスされうる。これは、仮想電話もしくは通信装置、現実の通信装置、ネットワークウェブページ、および同様のものを含むがそれらに限定されない。個々のルータ261、262は、ルーティング機能を制御するためにひとつ以上のルーティングの優先度を有してもよい。ルータ261、262は、通信ソース(source)または通信ターゲット(target)においてルーティング優先処理を実行してもよい。本実施の形態で使用されている意味において通信「ソース」とは一般的に、通信を発する側(例えば、電話の「発信者(caller)」もしくはテキストメッセージまたは電子メールの「送信者(sender)」)を指す。本実施の形態で使用されている意味において通信「ターゲット」とは一般的に、通信の受け側を指す。ソースおよびターゲットは仮想世界のユーザでなくてもよいことが示される。

例として、第1のユーザ251が第2のユーザ252と例えば仮想通信装置255を使用して通信することを所望する場合を考える。この場合、第1のユーザ251は電話のソースであり、第2のユーザ252は電話のターゲットである。第1のユーザのルータ261は、第2のユーザ252の仮想通信装置256へ優先的に接続を試みるよう設定されていてもよい。そのユーザがオンラインでなく仮想世界を使用していない場合、第1のユーザのルータ261は、第2のユーザの固定電話258へ接続を試みてもよい。そしてそれが失敗した場合は、ルータ261は、第2のユーザ252の携帯電話260に接続を試みてもよい。代替的な例では、第2のユーザのルータ260は第1のユーザ251から通信を受けた場合に、自身のルーティング優先処理を実行してもよいことが示される。例えば、第2のユーザのルータ262は、第1のユーザ251からの電話を優先的に第2のユーザの携帯電話260にルーティングし、次いで第2のユーザの固定電話258にルーティングし、次いで第2のユーザの仮想装置256にルーティングしてもよい。

As an example, consider the case where the

好適な実施の形態では、個々のユーザ251、252はそのユーザの現実のおよび仮想の通信装置のそれぞれに対応するひとつの電話番号を有してもよい。ルータ261、262は、ユーザが有する異なる装置のなかのあるひとつのユーザの番号に電話を自動的にルーティングしてもよい。そのようなルーティングは、ユーザの優先度、ユーザの行動、もしくはそれらのある組み合わせに基づいてもよい。ルータ261、262は通信ソースの正体かつ/または通信ターゲットの正体に依存して異なる優先度を有するようにプログラムされてもよいことが示される。

In a preferred embodiment, each

例えば、あるモードでは、第1のユーザのルータ261は、第1のユーザの番号に電話をかけるソースからの電話を受けうる。そのモードでは、第1のユーザ251は、第1のユーザ251がオンラインであることを示す情報をルータ261に提供してもよい。そのような情報は、例えばコントローラ114を使用してマルチメディア処理装置102のなかにプログラムされてもよい。あるいはまた、ルータ261は、第1のユーザ251がオンラインであるかどうかをチェックしてもよい。もしそうであれば、ルータ261はその「電話」を第1のユーザの仮想通信装置255へルーティングしてもよい。この仮想通信装置255は、たとえ第1のユーザ251が第2のユーザのクライアント装置254を介してオンラインであったとしても「鳴る」ように設定されていてもよい。

For example, in one mode, the first user's

他のモードでは、ルータ261は、第1のユーザ251がオンラインであるかどうか、およびターゲット(例えば、第2のユーザ252)がオフラインであるかどうかについての情報を得てもよいし、そうであるかどうかを決めるためにチェックを行ってもよい。この場合、第1のユーザのルータ261は、固定電話258や携帯電話260などの第2のユーザの現実の通信装置へ「電話」をルーティングしてもよい。

In other modes, the

他のモードでは、第1のユーザのルータ261は、第1のユーザ251がオンラインであるかどうか、および第2のユーザ252がオンラインであるかどうかについての情報を得てもよいし、そうであるかどうかを決めてもよい。この場合、「テキストメッセージ」が仮想世界のなかで、例えば第2のユーザのアバターやターゲットの第2のユーザの仮想装置256へ、ルーティングされてもよい。

In other modes, the first user's

他のモードでは、ルータ261は、第2のユーザ252がオンラインであるかどうかについての情報を得てもよいし、そうであるかどうかを決めるためにチェックを行ってもよい。第2のユーザ252がオフラインである場合、「テキストメッセージ」が、固定電話258や携帯電話260などの第2のユーザに関連付けられた現実世界の装置にルーティングされてもよい。

In other modes, the

上記の例に関して多くの他の置換もまた可能である。例えば、上記の例で、ソースは仮想世界のなかから電話をかけてもよいし、アバター仮想装置を通じて仮想世界のなかで電話をかけてもよいし、任意のVoIP装置またはサービスを通じてもしくは任意の現実の電話線および電話ソースを通じて電話をかけてもよい。 Many other permutations are also possible with respect to the above example. For example, in the above example, the source may make a call from within the virtual world, may make a call in the virtual world through an avatar virtual device, through any VoIP device or service, or any reality. You may make a call through any telephone line and source.

他の設定では、ユーザがオンライン時にアバター電話ではなく現実の携帯電話が鳴って欲しいなどのユーザの優先度に基づき、上述の賢いルーティングが行われてもよい。他の設定では、ステートコントロール(STATE CONTROLS)に基づき、上述の賢いルーティングが行われてもよい。このステートコントロールでは、ある状況の下でのみアプリケーションの設定に依存して電話がアバター電話もしくは現実の電話にルーティングされる。例えば、ターゲットがオンラインゲームに参加しており邪魔されたくない場合、電話はターゲットの現実のもしくは仮想のボイスメールへルーティングされてもよい。さらに別の設定では、電話は仮想装置へルーティングされ、そこでもしその装置が鳴らなかった場合は、仮想ボイスメールへ行く代わりに電話は現実の電話などの現実の装置へ再ルーティングされてもよい。 In other settings, the smart routing described above may be performed based on the user's priority, such as when the user wants a real mobile phone to ring instead of an avatar phone when online. In other settings, the above-described clever routing may be performed based on state control (STATE CONTROLS). With this state control, the phone is routed to an avatar phone or a real phone only under certain circumstances, depending on the application settings. For example, if the target is participating in an online game and does not want to be disturbed, the call may be routed to the target's real or virtual voicemail. In yet another setting, the phone is routed to a virtual device, and if that device does not ring, the phone may be rerouted to a real device, such as a real phone, instead of going to virtual voicemail.

図2Fに示されるように、本発明の実施の形態は、第1のユーザ251が第2のユーザ252へ固定電話257などの現実の電話を使用して電話をかける状況を許す。第1のユーザ251はその電話に向けて話をし、第1のユーザのアバター263が第2のユーザの仮想通信装置256に表れる。このアバター263は、第2のユーザ252が所有するマルチメディア処理装置102に接続されたディスプレイ104に表示される。ディスプレイ104上には、第1のユーザの名前266もまた第1のユーザのアバター263の近くに表示されてもよい。第1のユーザの発言265は、装置102、シミュレーションサーバ22、ビューサーバ24、もしくは他の装置に実装されていてもよい音声認識ソフトウエアかつ/またはハードウエアを使用してテキストに変換されてもよい。その結果得られるテキストはディスプレイ104上で第1のユーザのアバター263の近くのふきだし(text bubbles)264として表示されてもよい。オーディオスピーカ267は、第1のユーザと第2のユーザとの間の通信の間、第1のユーザの発言265の可聴音声を再生してもよい。

As shown in FIG. 2F, the embodiment of the present invention allows a situation where the

同じルーティング処理が、テキストメッセージングや電子メールなどの他のタイプのメッセージングに対して使用されうることが示される。このシステムのひとつの利点は、現実の電話かつ/またはテキストメッセージが、あるユーザから別のユーザへ、現実の通信装置で発生する長距離電話料金や他の電話料金を避けうる形でルーティングされうるということである。受け手側の(ユーザの)現実の電話機もしくはテキストメッセージ装置は、システム20によって維持されている仮想世界とのやりとりを容易とするためのミドルウエアを備えてもよい。

It is shown that the same routing process can be used for other types of messaging such as text messaging and email. One advantage of this system is that a real phone and / or text message can be routed from one user to another in a way that avoids long distance charges and other phone charges generated by real communication devices. That's what it means. The recipient's (user's) real phone or text message device may include middleware to facilitate interaction with the virtual world maintained by the

ある実施の形態では、ユーザは現実の通信装置を使用して仮想世界のコンテンツにアクセスできてもよい。例えば、携帯電話や携帯型インターネット装置などがユーザのアバター、公共空間、もしくは私的空間に変更を加えるために使用されてもよい。あるいはまた、現実の通信装置は仮想通信装置のコンテンツに離れた場所からアクセスするために使用されてもよい。特に、現実の通信装置は、シミュレートされた通信装置とユーザとの間のインタフェースとして使用されてもよい。例えば、仮想通信装置がユーザの私的空間内に配された仮想デジタルビデオレコーダ(DVR)であったとする。ユーザは現実の携帯電話および電子プログラミングガイドを使用して現実のもしくは仮想の出来事を記録するために仮想DVRにアクセスしてもよい。 In some embodiments, a user may be able to access virtual world content using real-world communication devices. For example, a mobile phone or a portable internet device may be used to make changes to the user's avatar, public space, or private space. Alternatively, a real communication device may be used to access the content of the virtual communication device from a remote location. In particular, a real communication device may be used as an interface between a simulated communication device and a user. For example, suppose that the virtual communication device is a virtual digital video recorder (DVR) placed in the user's private space. A user may access a virtual DVR to record real or virtual events using a real mobile phone and an electronic programming guide.

上述した通り、現実の通信装置と仮想通信装置との間で通信を行うことは、ビデオ通信を含んでもよい。ある実施の形態によると、ビデオ通信の間現実の通信装置にアバターの像が表示されてもよい。仮想世界を生成するシステムは、アバター像を、そのアバターに関連付けられたユーザによって生成された現実のもしくは合成された音声にリップシンクさせてもよい。例えば、ユーザは現実の装置へ送るべき音声メッセージをビデオメッセージの一部として記録してもよい。システムはビデオメッセージを音声メッセージをしゃべるアバターと共に生成してもよい。この場合、そのアバターの唇の動きはメッセージ中のユーザの発言と同期している。あるいはまた、ユーザは仮想の装置にメッセージのテキストを入力してもよい。システムはそのテキストからアバターに対して音声を合成し、アバターのビデオ画像を生成してもよい。この場合、アバターの唇の動きは合成された音声と同期している。他の実施の形態では、ユーザは例えばビデオ撮像装置116および音声信号取得装置118を使用して、音声およびビデオメッセージを記録してもよい。

As described above, performing communication between a real communication device and a virtual communication device may include video communication. According to an embodiment, an avatar image may be displayed on a real communication device during video communication. A system that generates a virtual world may lip-sync the avatar image to real or synthesized speech generated by a user associated with the avatar. For example, a user may record an audio message to be sent to a real device as part of a video message. The system may generate a video message with an avatar speaking a voice message. In this case, the movement of the lips of the avatar is synchronized with the user's statement in the message. Alternatively, the user may enter the text of the message on the virtual device. The system may synthesize speech for the avatar from the text and generate a video image of the avatar. In this case, the movement of the lips of the avatar is synchronized with the synthesized voice. In other embodiments, the user may record audio and video messages using, for example,

ある実施の形態では、アバター14は、ある感情を伝えるためのアニメーション、顔色の変化、音、パーティクル(particle)もしくはチャットバブルの変化を通じて感情を表現してもよい。このようなアバターによる感情の表現(しばしば「エモーツ(emotes)」と呼ばれる)は、予めプログラムされ、ユーザコマンドによってトリガされてもよい。本発明のある実施の形態では、仮想世界とのやりとりのなかでユーザが示した感情は、ユーザのアバターによって表される感情にマッピングされてもよい。ある実施の形態では、ユーザはアバターに反映されうる感情状態を選択してもよい。例として、アバターエモーツは装置102によってユーザに提供されるメニューから選択されてもよい。例えば、ユーザが「嬉しい(happy)」を選択した場合、ユーザのアバターは笑みを浮かべた形で表されてもよい。ユーザが「悲しい(sad)」を選択した場合、アバターはしかめづらを表してもよい。このようなメニュー駆動の感情は、ユーザが素早く使用したい場合にはややぎこちないかもしれない。そこで、ある実施の形態では、装置102はリアルタイムでユーザの感情の状態を検出し、その状態を反映するように適切にユーザのアバターの特徴に変化を加えてもよい。このようなリアルタイムでのユーザの感情の状態の追跡は、例えばユーザのアバターの像が現実の装置に表示されるビデオ通信の間、アバターにユーザの感情の状態をマッピングする際に特に有用である。

In some embodiments, the

限定しない例として、装置102は、撮像装置116を使用してユーザUのひとつ以上の画像を取得し、ユーザのひとつ以上の顔色を解析することによって、ユーザの感情の状態をリアルタイムで追跡してもよい。ゲーム/仮想世界プロセッサ206は、ユーザの唇、目、まぶた、まゆげ、ほほ、歯、もしくは小鼻などの顔色、もしくは姿勢や腕や手の置き方などのボディーランゲージを使用してこれらの画像を解析しユーザの感情の状態を決めるようプログラムされてもよい。このような顔色かつ/またはボディーランゲージ解析は、3Dカメラを使用して画像を生成することによって強化されうる。

By way of non-limiting example, the

あるいはまた、ユーザの発話もしくは音声信号取得装置118によって検出される他の発声のなかに示されるユーザの声の抑揚を解析することによって、ユーザの感情状態はリアルタイムで追跡されてもよい。ユーザがテキストを介して通信する場合は、感情状態を示すある言葉、フレーズ、もしくは言語パターンについてテキストを解析することによって感情が追跡されてもよい。加えて、心電計(EKG)データ、脳波(EEG)データ、皮膚電気反射データ、もしくはサーモグラフィデータなどの他の生物測定学的データを使用してユーザの感情の状態が追跡されてもよい。このようなデータは、コントローラ114に設けられた適切なセンサを通じて取得され、プロセッサ206に導入されている適切に設定されたソフトウエア、ハードウエア、もしくはファームウエアによって解析されてもよい。サーモグラフィデータは、撮像装置116が赤外線画像を取得可能な場合にも得られる。

Alternatively, the user's emotional state may be tracked in real time by analyzing the user's voice inflection shown in the user's utterance or other utterance detected by the audio

ユーザの感情の状態がいったん決定されてしまうと、その感情の状態を示すボディーランゲージと顔色の種々の組み合わせがアバターのアニメーションによって表されるエモーツに反映されてもよい(例えば、歯をむき出して拳を振り上げた様子は怒りを示す)。 Once the emotional state of the user is determined, various combinations of body language and complexion indicating the emotional state may be reflected in the emoticons represented by the animation of the avatar (e.g. Angry shows anger).

ある実施の形態では、ユーザは自己のアバターに対してカスタマイズされたジェスチャもしくは「エモーツ」を使用したいと思うかもしれない。これを容易とするため、アバターに対してひとつ以上のカスタムジェスチャが生成されてもよい。これらのカスタムジェスチャは、ユーザのアバターがコマンドに基づきジェスチャを行うことができるように、ひとつ以上のユーザインタフェース信号と関連付けられてもよい。例として、カスタムジェスチャは、ユーザがジェスチャを行う際にユーザの身体の動きもしくはユーザの表情のマッピングを記録しデジタル化するためのモーションキャプチャもしくはパフォーマンスキャプチャ技術を使用して生成されてもよい。ある実施の形態では、撮像装置116がこの目的のために使用されうる。あるいはまた、商業的なモーションキャプチャスタジオもしくはパフォーマンスキャプチャスタジオがこの目的のために使用されてもよい。

In some embodiments, a user may wish to use a customized gesture or “emotes” for his avatar. To facilitate this, one or more custom gestures may be generated for the avatar. These custom gestures may be associated with one or more user interface signals so that the user's avatar can make a gesture based on the command. As an example, custom gestures may be generated using motion capture or performance capture techniques to record and digitize the user's body movements or user facial expression mappings as the user makes gestures. In certain embodiments, the

モーションキャプチャでは、ユーザもしくは他のパフォーマは各関節にマーカを付け、そのマーカの位置もしくはマーカ間の角度によって動きを認識させてもよい。音声マーカ、慣性マーカ、LEDマーカ、磁気マーカ、もしくは反射性マーカ、あるいはそれらの任意の組み合わせが、最適には所望の動きの速さの少なくとも2倍の速さで、ミリメートル以下の位置精度で、追跡される。モーションキャプチャコンピュータソフトウエアは、位置、角度、速さ、加速度、および力積を記録し、動きの正確なデジタル表現を提供する。例として、光学的なモーションキャプチャシステムは、重なり合う映像を提供するよう較正されたひとつ以上のカメラの間でマーカの3D位置を三角測量してもよい。受動的な光学システムは、カメラのレンズの近くで生成される光を反射する再帰反射性材料で覆われたマーカを使用してもよい。明るいマーカだけがサンプルされ肌や生地を無視できるように、カメラの感度は大抵のカメラが有する狭い範囲の光感度を利用して調整されうる。あるいはまた、マーカそのものが電源を有し自身から光を放つ能動的な光学システムが使用されてもよい。電源は個々のマーカに順番に提供されてもよく、その場合キャプチャシステムと同期してもよい。これによりフレームレートを犠牲にして、所与のキャプチャフレームに対して個々のマーカを独立して認識できる。 In motion capture, a user or other performer may attach a marker to each joint and recognize the movement by the position of the marker or the angle between the markers. A voice marker, inertia marker, LED marker, magnetic marker, or reflective marker, or any combination thereof, is optimally at least twice as fast as the desired speed of motion, with sub-millimeter position accuracy, Be tracked. Motion capture computer software records position, angle, speed, acceleration, and impulse, and provides an accurate digital representation of movement. As an example, an optical motion capture system may triangulate the 3D position of a marker between one or more cameras calibrated to provide overlapping images. Passive optical systems may use markers covered with a retroreflective material that reflects light generated near the camera lens. Camera sensitivity can be adjusted using the narrow range of light sensitivity that most cameras have so that only bright markers are sampled and skin and fabric can be ignored. Alternatively, an active optical system where the marker itself has a power source and emits light from itself may be used. Power may be provided to individual markers in turn, in which case it may be synchronized with the capture system. This allows individual markers to be recognized independently for a given capture frame at the expense of frame rate.

パフォーマンスキャプチャは、パフォーマンスの双方向的な性質により、通常のモーションキャプチャとは異なる。パフォーマンスキャプチャでは、参照する動きのデータを取得し後に動きを一緒に編集するのではなく、体や手や表情を全て一度に取得する。 Performance capture differs from normal motion capture due to the interactive nature of performance. Performance capture captures all of your body, hands, and facial expressions at once, rather than acquiring the motion data you want to reference and later editing the motion together.

ジェスチャのためのユーザの体の動きかつ/または表情がデジタル化されると、そのデジタル化されたジェスチャは、そのジェスチャをアバターが行うようにアバターのアニメーションに関するコード化されたインストラクションもしくは他のユーザインタフェース信号を生成するために使用されてもよい。そのコードや他のユーザインタフェース信号は、一人以上の他のユーザに配布されてもよい。一人以上の他のユーザは、カスタムジェスチャを行うように自己のアバターをカスタマイズできる。カスタマイズされたアバタージェスチャは、カスタマイズされたアバターの服、履き物、ヘアスタイル、民族的な特徴、および他のカスタムアバター特徴と組み合わされて、社会のなかである特定のグループに属していることを示す手段とされてもよい。ある実施の形態では、例えば不必要に他のユーザを刺激したり法を犯したりすることを避けるために、カスタムジェスチャの使用を加減することが望ましい。ここで加減するもしくは加減(moderating or moderation)は、仮想世界のなかで受け入れられうる行動に対してある程度の規制を課すことを指す。このような加減はビューサーバ24によって実装されうる。このビューサーバ24は、カスタムジェスチャが無礼でないかもしくは他の不適切さはないかについて解析してもよい。

When the user's body movements and / or facial expressions for a gesture are digitized, the digitized gesture is a coded instruction or other user interface regarding the animation of the avatar so that the avatar performs the gesture. It may be used to generate a signal. The code and other user interface signals may be distributed to one or more other users. One or more other users can customize their avatars to make custom gestures. Customized avatar gestures, combined with customized avatar clothes, footwear, hairstyles, ethnic characteristics, and other custom avatar characteristics, indicate that they belong to a particular group in society It may be a means. In certain embodiments, it may be desirable to moderate the use of custom gestures, for example, to avoid unnecessarily stimulating other users or committing law. “Adjusting” or “modifying or moderating” here means imposing a certain degree of regulation on actions that can be accepted in the virtual world. Such adjustment can be implemented by the

カスタムジェスチャの表示を加減することは、所定の基準にしたがって、ある特定のユーザについてアバターにカスタムジェスチャを行わせることを制限すること、またはある特定のユーザがカスタムジェスチャを行うアバターを知覚できなくすることを含んでもよい。この所定の基準は、ユーザの年齢や、ジェスチャの視聴者や、宗教的な、民族的な、もしくは視聴者の他の帰属先に基づいて視聴者が侮辱と感じる感受性を含んでもよい。 Adjusting the display of custom gestures restricts avatars from making custom gestures for certain users according to predetermined criteria, or makes certain users unable to perceive avatars that perform custom gestures You may include that. This predetermined criteria may include the sensitivity of the viewer to feel insult based on the age of the user, the viewer of the gesture, religious, ethnic or other attribution of the viewer.

本発明の代替的な実施の形態によると、上述のシステムおよび方法は、仮想世界を使用する通信を実現するように変更されてもよい。特にアバターと電子メールの発信元とが関連付けられてもよい。ユーザは仮想世界のなかで電子メールを生成し、自己のアバターのひとつ以上の画像をその電子メールに関連付けてもよい。その電子メールは仮想世界から現実の装置へ送られてもよい。アバターの画像は電子メールの届け先において、例えば電子メールの添付を自己解凍することによって提示されてもよい。電子メールは、例えば仮想世界のなかの仮想通信装置を使用して生成されてもよい。限定を加えるものではない例として、電子メールの届け先は、例えば電子メールメッセージを受信するように構成された任意の現実の装置である現実の通信装置であってもよい。現実の通信装置は、他の現実の通信装置と仮想世界とは独立したひとつ以上の通信チャネルを通じて通信してもよい。 According to alternative embodiments of the present invention, the systems and methods described above may be modified to implement communication using a virtual world. In particular, an avatar and an email sender may be associated with each other. The user may generate an email in the virtual world and associate one or more images of his / her avatar with the email. The email may be sent from the virtual world to a real device. The avatar image may be presented at the e-mail delivery destination, for example, by self-decompression of the attachment of the e-mail. The email may be generated using a virtual communication device in a virtual world, for example. By way of example without limitation, the e-mail recipient may be a real communication device, for example, any real device configured to receive e-mail messages. Real communication devices may communicate with one another through one or more communication channels independent of the virtual world.

例示であり一般性を失わない範囲において、仮想世界は複数のユーザ間のやりとりを容易にするシミュレートされた公共空間とひとつ以上のシミュレートされた私的空間とを含んでもよい。私的空間の各々は、複数のユーザのなかの個々のユーザに例えば上述のように関連付けられる。 To the extent that it is exemplary and does not lose generality, the virtual world may include a simulated public space and one or more simulated private spaces that facilitate interaction between multiple users. Each private space is associated with an individual user of the plurality of users, for example as described above.

記録されたもしくは合成された音声と電子メールとが関連付けられ、その音声が届け先でひとつ以上の画像と共に提供されてもよい。アバター画像は、特に電子メールのために生成されるアバターのアニメーションを含んでもよい。そのアニメーションは届け先で、例えば電子メールの添付を自己解凍することによって提示されてもよい。加えて、ひとつ以上のジェスチャがアバターのアニメーションに例えば上述のようにマッピングされてもよい。電子メールメッセージの発信元の音声かつ/またはビデオを記録しその音声かつ/またはビデオのひとつ以上の特徴要素をアニメーション中のアバターのひとつ以上の特徴要素にマッピングすることによって、ジェスチャはマッピングされてもよい。 The recorded or synthesized voice and email may be associated and the voice may be provided with one or more images at the destination. The avatar image may include an animation of an avatar generated specifically for email. The animation may be presented at the destination, for example by self-extracting an email attachment. In addition, one or more gestures may be mapped to the animation of the avatar, for example as described above. Gestures can be mapped by recording the voice and / or video from which the email message originated and mapping one or more features of the voice and / or video to one or more features of the animated avatar. Good.

ある実施の形態では、テーマとアニメーションのなかでの仮想カメラの動きとが関連付けられてもよい。限定を加えるものではない例として、テーマは、仮想カメラのアングルの選択やトラッキングやパンや傾斜やズームやクローズアップや擬似光などを含んでもよい。仮想カメラの位置は固定されてもよいし動いてもよい。加えて、テーマはアバターに対して背景描写を選択することを含んでもよい。 In some embodiments, the theme and the movement of the virtual camera in the animation may be associated. By way of example without limitation, the theme may include virtual camera angle selection, tracking, panning, tilting, zooming, close-up, simulated light, and the like. The position of the virtual camera may be fixed or moved. In addition, the theme may include selecting a background depiction for the avatar.

ある実施の形態では、電子メールを作成することは、例えば上述のように発信元の感情の状態を追跡し、その感情の状態をテーマにマッピングすることを含んでもよい。例えば、穏やかなもしくは静かな感情の状態は、固定されたカメラ位置もしくは仮想カメラの比較的遅い移動によって特徴付けられるテーマにマッピングされてもよい。動揺もしくは興奮の感情の状態は、がたがたしたカメラの動きや極度のクローズアップや厳しいカメラのアングルなどによって特徴付けられるテーマにマッピングされてもよい。 In some embodiments, creating the email may include tracking the emotional state of the sender, eg, as described above, and mapping that emotional state to the theme. For example, a calm or quiet emotional state may be mapped to a theme characterized by a fixed camera position or a relatively slow movement of the virtual camera. The emotional state of upset or excitement may be mapped to a theme characterized by rattling camera movements, extreme close-ups, harsh camera angles, and the like.

上述のタイプのアバター電子メール通信は、例えば図1Eのシステム20かつ/または図1Fおよび図2Aのマルチメディア装置102を適切に設定することによって、実現されうる。

Avatar email communication of the type described above may be implemented, for example, by appropriately configuring the

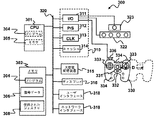

本発明の実施形態によれば、上述のタイプの仮想世界システムおよび方法は、クライアント装置28および例えばシステム20の要素によって生成される仮想世界とやりとりするためのユーザインタフェースとしてコンソールビデオゲーム装置を使用することで実装されうる。図3に示される通り、コンソールビデオゲーム装置300は、プロセッサ301とメモリ302(例えば、RAM、DRAM、ROMなど)を備える。加えて、ビデオゲーム装置300は、並列処理が実装されるのであれば、複数のプロセッサ301を備えてもよい。メモリ302はデータとゲームプログラムコード304を備え、上述のように仮想世界とのユーザのやりとりを容易とする部分を備える。具体的には、メモリ302は上述したような保存コントローラ経路情報を含む慣性信号データ306を備えてもよい。メモリ302は、保存ジェスチャデータ308、例えば、ゲームプログラム304に関連した一つ以上のジェスチャを表すデータなどを含んでもよい。プロセッサ302上で実行されるコード化されたインストラクションは、上述のように構成され機能する複数入力型ミキサ305を使用してもよい。

According to embodiments of the present invention, a virtual world system and method of the type described above uses a console video game device as a user interface for interacting with the

システム300はまた、入出力(I/O)要素311、電源(P/S)312、クロック(CLK)313およびキャッシュ314などの公知のサポート機能310を備えてもよい。装置300は任意に、プログラムおよび/またはデータ保存のためのディスクドライブ、CD−ROMドライブ、テープドライブなどの大容量記憶装置315を備えてもよい。コントローラは任意に、装置300とユーザとのやりとりを容易にするために、ディスプレイ部316と入力部318を備えてもよい。ディスプレイ部316は、テキスト、数値、グラフ記号や画像を表示する陰極線管(CRT)、またはフラットパネルスクリーンの形であってもよい。ユーザインタフェース318は、キーボード、マウス、ジョイスティック、ライトペンや他の装置を備えてもよい。また、ユーザ入力318は分析対象の信号を直接取り込むために、マイクロホン、ビデオカメラ、またはその他の信号変換装置を備えてもよい。装置300は、仮想世界のサーバや他の同様に設定された装置とインターネットなどのネットワークを介して通信できるようにネットワークインタフェース319を含んでもよい。装置300のプロセッサ301、メモリ302、ユーザ入力318、ネットワークインタフェース319および他の部品は図3に示すように、システムバス320を介して、互いに信号(例えばコード化されたインストラクションおよびデータ)を交換してもよい。

The

マイクロホン配列322は、入出力装置311を介してシステム300に接続されてもよい。マイクロホン配列は、約2〜約8個のマイクロホン、好ましくは約4個を、隣接するマイクロホンとは約4cm未満、好ましくは約1〜2cmの距離離間して備えてもよい。好適には、配列322のマイクロホンは無指向性マイクロホンである。オプションである撮像装置323(例えばデジタルカメラ)は、入出力装置311を介して装置300に接続されてもよい。撮像装置の位置決めを制御するために、一つ以上の位置決めアクチュエータ325がカメラに機械的に接続されてもよい。これらのアクチュエータ325は、入出力装置311を介してプロセッサ301との間で信号を交換してもよい。

The

本明細書では、「入出力装置」という用語は、概して装置300との間および周辺装置との間でデータを送受信するプログラム、操作または装置のいずれかを指す。すべてのデータ送受信は、ある装置からの出力と別の装置への入力と考えてよい。周辺装置には、キーボードやマウスなどの入力専用装置、プリンタなどの出力専用装置に加えて、入力装置および出力装置の両方として作動できる書き込み可能CD-ROMなどの装置が含まれてもよい。「周辺装置」という用語には、マウス、キーボード、プリンタ、モニタ、マイクロホン、ゲームコントローラ、カメラ、外部Zipドライバまたはスキャナなどの外部装置に加えて、CD−ROMドライブ、CD−Rドライブまたは内部モデムなどの内部装置、または、フラッシュメモリリーダ/ライタやハードドライブなどの他の周辺装置が含まれる。

As used herein, the term “input / output device” generally refers to any program, operation or device that sends and receives data to and from

本発明のある実施形態では、装置300は、有線(例えばUSBケーブル)または無線、例えば赤外線もしくはラジオ周波数(ブルートゥースなど)接続の使用、を通じて入出力装置311を介してプロセッサに接続されたコントローラ330を具備してもよい。コントローラ330は、ビデオゲームプレイ中に通常使用されるコントロール信号を提供するアナログジョイスティックコントロール331と既知のボタン333を具備してもよい。そのようなビデオゲームは、メモリ302、または大容量記憶装置315に関連する他のプロセッサ読み取り可能媒体に保存されるプログラム304からの、プロセッサ読み取り可能データおよび/またはインストラクションとして実装されてもよい。

In some embodiments of the present invention, the

ジョイスティックコントロール331は、通常、コントロールスティックを左右に動かすとX軸沿いの動きの信号を発信し、前後(上下)に動かすとY軸沿いの信号を発信するように構成されていてもよい。3次元の動き用に構成されたジョイスティックでは、スティックを左(反時計回り)または右(時計回り)に捻るとZ軸沿いの動きの信号を発信してもよい。これらX,Y,Zの3軸は、特に航空機に関する場合に、それぞれロール、ピッチ、ヨーと呼ばれることがある。

The

従来の特徴に加えて、コントローラ330は、一つ以上の慣性センサ332を備えてもよい。慣性センサ332は、慣性信号を介して位置情報および/または方向情報をプロセッサ301に提供できる。方向情報には、コントローラ330の傾き、ロールまたはヨーなどの角度情報が含まれていてもよい。例示として、慣性センサ332には、任意の数の加速度計、ジャイロスコープまたは傾斜センサ、またはこれらの任意の組み合わせが含まれていてもよい。好適な実施形態では、慣性センサ332には、傾斜およびロール軸に対するジョイスティックコントローラの方向を検知するように適応された傾斜センサ、ヨー軸沿いの加速度を検知するように適応された第1の加速度計、およびヨー軸に対する角加速度を検知するように適応された第2の加速度計を備える。加速度計は、例えば、一つ以上のばねで取り付けられた質量と一つ以上の方向に対する質量の変位を検知するセンサとを備えるMEMS装置として実装されてもよい。質量の変位に依存するセンサからの信号は、ジョイスティックコントローラ330の加速度決定に用いられてもよい。そのような技術は、メモリ302に保存されプロセッサ301によって実行されるゲームプログラム304からのインストラクションによって実現される。

In addition to conventional features, the

例示として、慣性センサ332として適した加速度計は、例えば、ばねなどで、フレームに3〜4点で伸縮自在に接続された単一の質量であってもよい。ピッチ軸とロール軸は、ジョイスティックコントローラ330に設けられたフレームと交差する面に存在する。フレーム(およびジョイスティックコントローラ330)がピッチ軸、ロール軸の回りを回転するにつれて、質量が重力の影響下で変位し、ばねがピッチ角および/またはロール角に依存する態様で伸縮する。質量の変位が検知され、ピッチ量および/またはロール量に依存した信号に変換される。ヨー軸回りの角加速度またはヨー軸沿いの線形加速度は、ばねの伸縮または質量の動きの特徴的なパターンを生成し、それらのパターンは検知されて角加速度量または線形加速度量に応じた信号に変換される。そのような加速度計装置は、質量の動きおよびばねの伸縮力を追跡することによって、傾斜、ヨー軸回りのロール角加速度およびヨー軸沿いの線形加速度を計測できる。質量の位置および/またはそれに働く力を追跡する方法には多くの違った方法があり、それらの方法には、抵抗歪みゲージ、音響センサ、磁気センサ、ホール効果素子、圧電素子、容量センサなどが含まれる。

By way of example, an accelerometer suitable as

また、ジョイスティックコントローラ330は、発光ダイオード(LED)などの光源334を一つ以上含んでもよい。光源334は、コントローラを他のコントローラと識別するために用いられる。例えば、一つ以上のLEDがあれば、LEDのパターンコードをぱっと光らせたり保持することで識別できる。例示として、ジョイスティックコントローラ330上に5個のLEDが直線または2次元模様で設けることができる。LEDを直線状に配列することが好ましいが、他の方法として、四角形またはアーチ状に配置して、撮像装置323で得られたLEDパターン画像の分析時に、LED配列の画面の決定を容易にするようになされてもよい。さらに、LEDパターンコードは、ゲームプレイ中のジョイスティックコントローラ330の位置決定にも使用できる。例えば、LEDは、コントローラの傾斜、ヨーおよびロールの特定を助けることができる。この検出パターンによって、例えば飛行機ゲームなどのゲームで、ユーザによりよい感情を提供できる。撮像装置323は、ジョイスティックコントローラ330と光源334を含む像を撮影してもよい。そのような画像を分析すると、ジョイスティックコントローラの位置および/または方向が決定できる。そのような分析は、メモリ302に保存されプロセッサ301で実行されるプログラムコードインストラクション304によって実現されてもよい。撮像装置323による光源334の撮像を容易にするために、光源334は、ジョイスティックコントローラ330の複数の異なる端部、例えば、前方と後方に配置してもよい(影として示す)。そのような配置することによって、撮像装置323は、ユーザのジョイスティックコントローラ330の保持の仕方に応じたジョイスティックコントローラ330の種々の方向に対して、光源334の像を得ることができる。

The

さらに、光源334は、例えば、パルスコード、振幅変調または周波数変調フォーマットでテレメトリ信号をプロセッサ301に提供してもよい。そのようなテレメトリ信号は、いずれのジョイスティックボタンが押されているか、および/またはどれ位強くボタンが押されているかを表してもよい。テレメトリ信号は、例えばパルス符号化、パルス幅変調、周波数変調または光強度(振幅)変調などによって、光信号に符号化されてもよい。プロセッサ301は、光信号からテレメトリ信号を復号化し、復号化されたテレメトリ信号に応じてゲームコマンドを実行してもよい。テレメトリ信号は、撮像装置323で得られたジョイスティックコントローラ330の画像の分析から復号化されてもよい。または、装置301は、光源334からのテレメトリ信号受信専用の独立した光学センサを具備してもよい。コンピュータプログラムとのインタフェースにおける強度決定に併せてのLEDの使用は、例えば、2006年5月4日出願の米国特許出願番号11/429,414、名称「USE OF COMPUTER IMAGE AND AUDIO PROCESSING IN DETERMINING AN INTENSITY AMOUNT WHEN INTERFACING WITH A COMPUTER PROGRAM」(代理人事件番号SONYP052)、発明者Richard L. Marks他に開示されており、その開示内容は全体として、参照により本明細書に援用される。また、光源334を含む画像の分析は、テレメトリおよびジョイスティックコントローラ330の位置および/または方向の決定にも用いることができる。そのような技術は、メモリ302に保存されプロセッサ301によって実行されるプログラム304のインストラクションによって実現されてもよい。

Further, the

プロセッサ301は、撮像装置323で検出された光源334からの光信号、および/またはマイクロホン配列322によって検出された音響信号からの音源場所と音源特性情報と共に、慣性センサ332からの慣性信号を用いて、コントローラ330および/またはユーザの場所および/または方向に関する情報を推測してもよい。例えば、「音響レーダ」の音源場所およびその特性は、マイクロホン配列322と共に用いられて、ジョイスティックコントローラの動きが(慣性センサ332および/または光源334を通して)独立に追跡されている間、移動音源を追跡する。音響レーダにおいて、較正済み聴取領域が実行時間中に選択されてもよい。較正済み聴取領域以外の音源から発生した音はフィルタされて除かれてもよい。較正済み聴取領域は、撮像装置323の焦点または視野にある音量に対応した聴取領域を含んでいてもよい。音響レーダの例は、米国特許出願番号11/381,724、発明者Xiadong Mao、名称「METHODS AND APPARATUS FOR TARGETED SOUND DETECTION AND CHARACTERIZATION」、2006年5月4日出願、に開示されており、その開示内容は参照により本明細書に援用される。

The processor 301 uses the inertial signal from the

コントロール信号をプロセッサ301に供給するための種々の形態を種々組み合わせたものも、本発明の実施形態と併せて用いられてもよい。そのような技術は、メモリ302に保存されプロセッサ301で実行されるプログラムコードインストラクション304によって実現されてもよく、また、任意に、実行時間中は較正済み聴取領域を選択し、較正済み聴取領域以外の音源から発生した音はフィルタをかけて除くための一つ以上のプロセッサを指揮する一以上の指令を含んでもよい。較正済み聴取領域は、撮像装置323の焦点または視野にある音量に対応した聴取領域を含んでいてもよい。

Various combinations of various forms for supplying control signals to the processor 301 may also be used in conjunction with embodiments of the present invention. Such techniques may be implemented by

プログラム304は任意に、マイクロホン配列322のマイクロホンM0…MMから離散時間領域入力信号Xm(t)を生成し、聴取セクタを決定し、有限インパルス応答フィルタ係数を選択するセミブラインド(semi−blind)音源分離において聴取セクタを用いて、入力信号Xm(t)から異なる音源を分離する一つ以上のプロセッサを指揮する一以上のインストラクションを含んでもよい。プログラム304は、基準マイクロホンM0からの入力信号X0(t)以外の選択入力信号Xm(t)に、一つ以上の非整数遅延(fractional delay)を適用するインストラクションをさらに備えてもよい。マイクロホン配列からの離散時間領域出力信号y(t)の信号対雑音比を最適化するために、各非整数遅延が選択されてもよい。非整数遅延は、基準マイクロホンM0からの信号が、配列の他のマイクロホンからの信号に対して最初であるように選択されてもよい。プログラム304は、非整数遅延Δを、y(t+Δ)=X(t+Δ)*b0+X(t−1+Δ)*b1+X(t−2+δ)*b2+…+X(t−N+Δ)bNとなるようにマイクロホン配列の出力信号y(t)に導入するインストラクションを含んでもよい。ここで、Δは0〜±1である。そのような技術の例は、2006年5月4日出願の米国特許出願番号11/381,729、名称「ULTRA SMALL MICROPHONE ARRAY」、発明者Xiadong Mao、に詳細に開示されており、その開示内容は参照により本明細書に援用される。

The

プログラム304は、実行されると、システム300に、音源を含んだ事前較正済み聴取領域を選択させる一つ以上のインストラクションを含んでもよい。そのようなインストラクションによって、音源が最初の領域内にあるか、またはその領域の特定の側にあるか否かを装置が判断するようになされていてもよい。音源が初期設定領域内に存在しない場合、インストラクションは、実行時に、初期設定領域の特定の側にある別の領域を選択してもよい。別の領域は、最適値に最も近い入力信号の減衰によって特徴付けられてもよい。これらのインストラクションは、実行されると、マイクロホン配列322からの入力信号の減衰と最適値への減衰を計算してもよい。インストラクションは、実行されると、装置300が、一つ以上の領域に対する入力信号の減衰値を決定し、減衰が最適値に最も近い領域を選択するようになされてもよい。そのような技術の例は、2006年5月4日出願の米国特許出願番号11/381,725、名称「METHOD AND APPARATUS FOR TARGETED SOUND DETECTION」、発明者Xiadong Maoに開示されており、その開示内容は参照により本明細書に援用される。

The