WO2018190327A1 - 仮想現実提供システム、3次元表示データ提供装置、仮想空間提供システム及びプログラム - Google Patents

仮想現実提供システム、3次元表示データ提供装置、仮想空間提供システム及びプログラム Download PDFInfo

- Publication number

- WO2018190327A1 WO2018190327A1 PCT/JP2018/015012 JP2018015012W WO2018190327A1 WO 2018190327 A1 WO2018190327 A1 WO 2018190327A1 JP 2018015012 W JP2018015012 W JP 2018015012W WO 2018190327 A1 WO2018190327 A1 WO 2018190327A1

- Authority

- WO

- WIPO (PCT)

- Prior art keywords

- virtual

- data

- flying object

- display data

- flying

- Prior art date

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63B—APPARATUS FOR PHYSICAL TRAINING, GYMNASTICS, SWIMMING, CLIMBING, OR FENCING; BALL GAMES; TRAINING EQUIPMENT

- A63B69/00—Training appliances or apparatus for special sports

- A63B69/0002—Training appliances or apparatus for special sports for baseball

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63B—APPARATUS FOR PHYSICAL TRAINING, GYMNASTICS, SWIMMING, CLIMBING, OR FENCING; BALL GAMES; TRAINING EQUIPMENT

- A63B71/00—Games or sports accessories not covered in groups A63B1/00 - A63B69/00

- A63B71/06—Indicating or scoring devices for games or players, or for other sports activities

- A63B71/0619—Displays, user interfaces and indicating devices, specially adapted for sport equipment, e.g. display mounted on treadmills

- A63B71/0622—Visual, audio or audio-visual systems for entertaining, instructing or motivating the user

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/017—Head mounted

- G02B27/0172—Head mounted characterised by optical features

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F13/00—Interconnection of, or transfer of information or other signals between, memories, input/output devices or central processing units

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

- G06F3/012—Head tracking input arrangements

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V20/00—Scenes; Scene-specific elements

- G06V20/20—Scenes; Scene-specific elements in augmented reality scenes

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V20/00—Scenes; Scene-specific elements

- G06V20/40—Scenes; Scene-specific elements in video content

- G06V20/41—Higher-level, semantic clustering, classification or understanding of video scenes, e.g. detection, labelling or Markovian modelling of sport events or news items

- G06V20/42—Higher-level, semantic clustering, classification or understanding of video scenes, e.g. detection, labelling or Markovian modelling of sport events or news items of sport video content

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/236—Assembling of a multiplex stream, e.g. transport stream, by combining a video stream with other content or additional data, e.g. inserting a URL [Uniform Resource Locator] into a video stream, multiplexing software data into a video stream; Remultiplexing of multiplex streams; Insertion of stuffing bits into the multiplex stream, e.g. to obtain a constant bit-rate; Assembling of a packetised elementary stream

- H04N21/23614—Multiplexing of additional data and video streams

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/40—Client devices specifically adapted for the reception of or interaction with content, e.g. set-top-box [STB]; Operations thereof

- H04N21/47—End-user applications

- H04N21/472—End-user interface for requesting content, additional data or services; End-user interface for interacting with content, e.g. for content reservation or setting reminders, for requesting event notification, for manipulating displayed content

- H04N21/4728—End-user interface for requesting content, additional data or services; End-user interface for interacting with content, e.g. for content reservation or setting reminders, for requesting event notification, for manipulating displayed content for selecting a Region Of Interest [ROI], e.g. for requesting a higher resolution version of a selected region

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/40—Client devices specifically adapted for the reception of or interaction with content, e.g. set-top-box [STB]; Operations thereof

- H04N21/47—End-user applications

- H04N21/478—Supplemental services, e.g. displaying phone caller identification, shopping application

- H04N21/4781—Games

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/80—Generation or processing of content or additional data by content creator independently of the distribution process; Content per se

- H04N21/81—Monomedia components thereof

- H04N21/8146—Monomedia components thereof involving graphical data, e.g. 3D object, 2D graphics

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/80—Generation or processing of content or additional data by content creator independently of the distribution process; Content per se

- H04N21/81—Monomedia components thereof

- H04N21/816—Monomedia components thereof involving special video data, e.g 3D video

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63B—APPARATUS FOR PHYSICAL TRAINING, GYMNASTICS, SWIMMING, CLIMBING, OR FENCING; BALL GAMES; TRAINING EQUIPMENT

- A63B69/00—Training appliances or apparatus for special sports

- A63B69/0002—Training appliances or apparatus for special sports for baseball

- A63B2069/0004—Training appliances or apparatus for special sports for baseball specially adapted for particular training aspects

- A63B2069/0008—Training appliances or apparatus for special sports for baseball specially adapted for particular training aspects for batting

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63B—APPARATUS FOR PHYSICAL TRAINING, GYMNASTICS, SWIMMING, CLIMBING, OR FENCING; BALL GAMES; TRAINING EQUIPMENT

- A63B71/00—Games or sports accessories not covered in groups A63B1/00 - A63B69/00

- A63B71/06—Indicating or scoring devices for games or players, or for other sports activities

- A63B71/0619—Displays, user interfaces and indicating devices, specially adapted for sport equipment, e.g. display mounted on treadmills

- A63B71/0622—Visual, audio or audio-visual systems for entertaining, instructing or motivating the user

- A63B2071/0636—3D visualisation

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63B—APPARATUS FOR PHYSICAL TRAINING, GYMNASTICS, SWIMMING, CLIMBING, OR FENCING; BALL GAMES; TRAINING EQUIPMENT

- A63B71/00—Games or sports accessories not covered in groups A63B1/00 - A63B69/00

- A63B71/06—Indicating or scoring devices for games or players, or for other sports activities

- A63B71/0619—Displays, user interfaces and indicating devices, specially adapted for sport equipment, e.g. display mounted on treadmills

- A63B2071/0647—Visualisation of executed movements

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63B—APPARATUS FOR PHYSICAL TRAINING, GYMNASTICS, SWIMMING, CLIMBING, OR FENCING; BALL GAMES; TRAINING EQUIPMENT

- A63B71/00—Games or sports accessories not covered in groups A63B1/00 - A63B69/00

- A63B71/06—Indicating or scoring devices for games or players, or for other sports activities

- A63B71/0619—Displays, user interfaces and indicating devices, specially adapted for sport equipment, e.g. display mounted on treadmills

- A63B2071/0658—Position or arrangement of display

- A63B2071/0661—Position or arrangement of display arranged on the user

- A63B2071/0666—Position or arrangement of display arranged on the user worn on the head or face, e.g. combined with goggles or glasses

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/0101—Head-up displays characterised by optical features

- G02B2027/0132—Head-up displays characterised by optical features comprising binocular systems

- G02B2027/0134—Head-up displays characterised by optical features comprising binocular systems of stereoscopic type

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/0101—Head-up displays characterised by optical features

- G02B2027/0141—Head-up displays characterised by optical features characterised by the informative content of the display

Definitions

- the present invention relates to a virtual reality providing system, a three-dimensional display data providing apparatus, a virtual space providing system, and a program.

- HMD head mounted display

- the practice support system of Patent Document 1 is an HMD that has a display means that presents a three-dimensional image of a virtual space that is mounted on a practitioner's head and in which a virtual motion object that is a virtual object of a tool handled by the practitioner is arranged.

- Head position detecting means for detecting the position and orientation of the practitioner's head, angular velocity detecting means attached to the tool, and calculating means for calculating the trajectory data of the virtual operating body based on the angular velocity data acquired by the angular velocity detecting means

- a storage means for storing the trajectory data, and a trajectory image of the virtual motion body in the virtual space is generated based on the trajectory data, and corresponds to the position and orientation of the practitioner's head detected by the head position detection means

- Image generation means for causing the display means to present a trajectory image from the viewpoint position in the virtual space.

- the live video is for watching games, and it is not possible to experience the performance of athletes appearing in the video.

- the present invention provides a virtual reality providing system, a three-dimensional display data providing apparatus, a virtual space providing system, and a program capable of not only watching an athlete's performance from a video but also experiencing the athlete's performance by himself / herself. There is.

- One aspect of the present invention is a virtual space using a tracking data acquisition unit that acquires tracking data of a flying object obtained from sensor information of a sensor that tracks a flying object emitted from an athlete, and the acquired tracking data.

- a 3D display data generating unit for generating 3D display data for displaying a flying image of a virtual flying object corresponding to the flying object, and a flying of the virtual flying object in a virtual space using the 3D display data.

- a virtual reality providing system comprising: at least one virtual space providing system for displaying video; and a transmission unit for transmitting the three-dimensional display data to the at least one virtual space providing system.

- One aspect of the present invention is a virtual space using a tracking data acquisition unit that acquires tracking data of a flying object obtained from sensor information of a sensor that tracks a flying object emitted from an athlete, and the acquired tracking data.

- a three-dimensional display data providing apparatus having a transmission unit that transmits to one or more virtual space providing systems.

- One embodiment of the present invention is generated from tracking data obtained from sensor information of a display unit that displays a virtual space and a sensor that tracks a flying object emitted from an athlete, and corresponds to the flying object in the virtual space.

- a receiving unit for receiving three-dimensional display data for displaying a flying image of a virtual flying object, a process for detecting the position and orientation of the user in the virtual space, three-dimensional display data of the virtual flying object, Using the object data of the virtual flying object and the position and orientation of the user, the flying image of the virtual flying object from the viewpoint position in the virtual space corresponding to the position and orientation of the user is displayed on the display unit.

- a virtual space providing system having an image processing unit.

- One aspect of the present invention uses a tracking data acquisition process for acquiring tracking data of a flying object obtained from sensor information of a sensor that tracks a flying object emitted from an athlete, and a virtual space using the acquired tracking data.

- 3D display data generation processing for generating 3D display data for displaying a flying image of a virtual flying object corresponding to the flying object in a virtual space displayed on a providing system; and the 3D display data,

- One aspect of the present invention is a computer program of a virtual space providing system that provides a user with a three-dimensional image of a virtual space, and tracking data obtained from sensor information of a sensor that tracks a flying object emitted from an athlete Reception processing for receiving three-dimensional display data for displaying a flying image of a virtual flying object corresponding to the flying object in the virtual space, user position data in the virtual space, and user orientation data Using the detection process for detecting the three-dimensional display data of the virtual flying object, the object data of the virtual flying object, and the position data and orientation data of the user in the virtual space corresponding to the position and orientation of the user

- FIG. 1 is a schematic configuration diagram of a virtual reality providing system according to the first embodiment.

- FIG. 2 is a diagram showing a coordinate system of each parameter of tracking data.

- FIG. 3 is a diagram for explaining the amount of change.

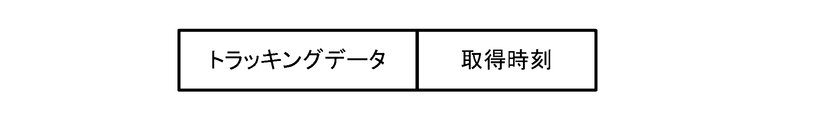

- FIG. 4 is a diagram for explaining the data structure of the tracking data.

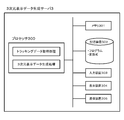

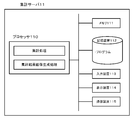

- FIG. 5 is a block diagram of the three-dimensional display data generation server 3 configured by a computer system.

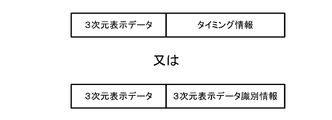

- FIG. 6 is a diagram for explaining the data structure of the three-dimensional display data.

- FIG. 7 is a block diagram of the head mounted display system 5.

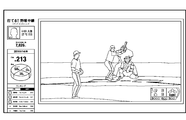

- FIG. 8 is a diagram illustrating an example of a three-dimensional image displayed on the display unit 511.

- FIG. 9 is a sequence diagram showing a flow of processing and information from the tracking system 2 to the head mounted display system 55 in the first embodiment.

- FIG. 9 is a sequence diagram showing a flow of processing and information from the tracking system 2 to the head mounted display system 55 in the first embodiment.

- FIG. 9 is a sequence diagram showing a

- FIG. 10 is a schematic configuration diagram of a virtual reality providing system in a modified example of the first embodiment.

- FIG. 11 is a sequence diagram showing a process and information flow from the broadcasting facility 7 to the head mounted display system 5 in the modification of the first embodiment.

- FIG. 12 is a schematic configuration diagram of a virtual reality providing system according to the second embodiment.

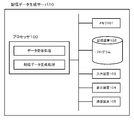

- FIG. 13 is a block diagram of the distribution data generation server 10 configured by a computer system.

- FIG. 14 is a block diagram of the head mounted display system 5 in the second embodiment.

- FIG. 15 is a sequence diagram showing a process and information flow from the live video generation unit 9 to the head mounted display system 5 in the second embodiment.

- FIG. 16 is a block diagram of the head mounted display system 5 according to the third embodiment.

- FIG. 17 is a diagram illustrating an example of an image when a virtual ball and a virtual bat collide.

- FIG. 18 is a diagram illustrating an example of a trajectory image of the virtual ball after the collision between the virtual ball and the virtual bat.

- FIG. 19 is a diagram showing an example of a plurality of different virtual examples.

- FIG. 20 is a schematic configuration diagram of a virtual reality providing system according to the fourth embodiment.

- FIG. 21 is a block diagram of the aggregation server 11 configured by a computer system.

- FIG. 22 is an example of a statistical result image when the virtual flying object is a ball and the virtual concrete is a bat.

- FIG. 23 is a diagram illustrating an example of a video in which a live video and a statistical image are combined.

- FIG. 24 is a schematic configuration diagram of a virtual reality providing system according to the fifth embodiment.

- FIG. 1 is a schematic configuration diagram of a virtual reality providing system according to the first embodiment.

- 1 is a real athlete (actual athlete) playing a game at a stadium, etc.

- 2 is a tracking system

- 3 is a three-dimensional (3D) display data generation server

- 4 is broadcast transmission.

- 5 is a head-mounted display system (virtual space providing system)

- 6 is a camera

- 7 is a broadcasting facility

- 8 is a television.

- a head mounted display system will be described as an example of a virtual space providing system.

- the virtual space providing system is not limited to the head-mounted display system, and may be any system that can present a three-dimensional virtual space to the user.

- the left-eye and right-eye images taken at the same time are displayed on the screen, and the user wears glasses such as a linear polarization filter method or a liquid crystal shutter method to view the virtual space. It may be a system as provided.

- Athlete 1 is an athlete who is playing a game in a situation where it is broadcast live via television broadcast, such as a professional baseball game.

- the baseball game is shot by the camera 6, and the video of the game is broadcast by the broadcasting equipment 7 and viewed by the television 8.

- a baseball game is taken as an example, but not limited to baseball, tennis, table tennis, golf, soccer, martial arts (boxing, fencing), or the like may be used.

- the tracking system 2 is a system that tracks the athlete 1 and the flying object emitted from the athlete 1 and converts it into data.

- the flying object is a typical example of a ball that is thrown or kicked from the athlete 1, but is not limited thereto.

- a part of the body of the athlete 1 for example, a boxing punch

- a tool worn by the athlete 1 for example, a fencing sword

- the tracking system 2 includes a sensor 21 such as a radar and a camera, and a tracking data generation unit 22 that generates tracking data of the athlete 1, the ball, and the referee on the pitch from the data obtained from the sensor 21.

- a tracking system 2 systems such as TrackMan and PITCHf / x are provided.

- tracking data for all moving objects (athlete 1, referee, etc.) on the pitch is not required, and the tracking system 2 tracks at least a flying object (for example, a ball) emitted from the athlete 1. It only needs to be able to generate data.

- the coordinate system of each parameter is based on a predetermined position of the home base, the catcher direction is the front, the catcher direction is the front, the catcher right direction is the X direction (X axis), and the catcher direction is the Y direction.

- (Y axis) is a coordinate system in which the height direction is the Z direction (Z axis).

- the tracking data may be of any type as long as it represents the movement of the athlete 1 or the ball. Moreover, it is preferable that the tracking system 2 includes the acquisition time when the tracking data is acquired in the tracking data as shown in FIG. 4, for example.

- the three-dimensional (3D) display data generation server 3 is a virtual vehicle in which a flying object such as a ball is visualized in a virtual space, and a virtual image in which a real athlete 1 is imaged in a virtual space.

- Three-dimensional display data (three-dimensional coordinate data) for displaying a moving object is generated from tracking data.

- the 3D display data generation server 3 includes a tracking data acquisition unit 31 and a 3D display data generation unit 32.

- the tracking data acquisition unit 31 acquires tracking data provided from the tracking system 2.

- the three-dimensional display data generation unit 32 generates, from the tracking data, three-dimensional display data for displaying a virtual flying object such as a virtual ball and a virtual moving object such as a virtual athlete 1 on the head mounted display system 5. .

- the 3D display data for displaying the virtual moving body of the real athlete 1 is not necessarily required as long as at least 3D display data for displaying the virtual flying object can be generated.

- the three-dimensional display data generation server 3 can be realized by a computer system (information processing apparatus) having a processor that performs various arithmetic processes.

- FIG. 5 is a block diagram of the three-dimensional display data generation server 3 configured by a computer system.

- the three-dimensional display data generation server 3 includes a processor 300, a memory (ROM or RAM) 301, a storage device (hard disk, semiconductor disk, etc.) 302, an input device (keyboard, mouse, touch panel, etc.) 303, a display device 304, and a communication device 305. It can be constituted by a general-purpose computer having hardware resources such as

- the 3D display data generation server 3 implements tracking data acquisition processing and 3D display data generation processing by loading a program stored in the storage device 302 into the memory 301 and executing it by the processor 300. It is.

- the tracking data acquisition process corresponds to the tracking data acquisition unit 31, and the 3D display data generation process corresponds to the 3D display data generation unit 32.

- the tracking data acquisition process is a process for acquiring tracking data provided from the tracking system 2.

- the three-dimensional display data generation processing is a three-dimensional display data for displaying a virtual moving object (virtual athlete in this example) such as a virtual flying object (virtual ball in this example) or a virtual athlete on the head mounted display system 5.

- a virtual moving object virtual athlete in this example

- a virtual flying object virtual ball in this example

- a virtual athlete on the head mounted display system 5 Is generated from the tracking data. More specifically, when the tracking data is data relating to a pitch change, a hitting angle, an athlete on the field, a hitting ball, and a movement of a pitching, the head-mounted display system 5 stores a virtual ball or a virtual athlete. This is a process of converting into the three-dimensional display data necessary for display.

- the three-dimensional display data is a concept including data obtained by converting tracking data into a data format that can be processed by the head mounted display system 5. Therefore, the three-dimensional display data generation process may be a process that simply converts the tracking data into a data format that can be processed by the head mounted display system 5, or a process that generates from tracking data to orbit data such as a virtual flying object. But it ’s okay.

- the head mounted display system 5 is necessary for reproducing and displaying the virtual ball (virtual flying object) corresponding to the actual ball from the tracking data of the actual ball.

- An example of generating the three-dimensional display data will be described.

- the flying image of the virtual ball (virtual flying object) can be reproduced and displayed if the following four elements are determined.

- Release point coordinates Release point coordinates can be obtained from tracking data.

- the release point coordinates are not necessarily exact coordinate values because they match the pitching motion of the pitcher's virtual moving body displayed on the head mounted display system 5.

- Acceleration added to each display frame of the head mounted display system 5 (ball bending force)

- the acceleration can be obtained by dividing the amount of change acquired from the tracking data by the display frame rate of the head mounted display system 5.

- Air resistance to the ball is set so that the final speed (speed indicated with actual landing point coordinates) is 90% -92% with respect to the initial speed.

- the vector in the Y direction from the pitcher to the home base can be obtained from the initial speed acquired from the tracking data.

- vectors in the X direction and the Z direction cannot be acquired from the tracking data.

- the actual landing points are different, it is possible to simulate pitching with exactly the same speed and variation. Accordingly, the ball landing point is brought closer to the original actual landing point while gradually changing the values of the initial velocity vector in the X direction and the Z direction.

- the vectors in the X direction and the Z direction when the ball landing point is closest to the actual landing point are adopted as the X direction and Z direction vectors.

- these four elements are generated as 3D display data.

- the head mounted display system 5 is moved to a virtual ball (in synchronization with a predetermined video section of the video of the athlete 1 game broadcasted by the broadcasting facility 7.

- Timing information related to the timing for displaying the flying image of the virtual flying object is included in the generated three-dimensional display data.

- Timing information may be of any type as long as the time of a predetermined video section is known, but includes time information, a time code of a video of an athlete 1 game, and the like.

- the predetermined video section is, for example, a section in which the commentator announces that a virtual ball (virtual flying object) can experience the flying image, or a virtual ball (virtual flying object) flying image on the broadcast image.

- the video section is a concept including only sound such as radio broadcasting.

- the predetermined video section may be acquired by the 3D display data generation server 3 storing a predetermined video section, or may be received from the broadcast facility 7 as appropriate.

- timing information for example, after a scene (video section) in which A pitcher threw a determined ball, A pitcher throws during a video section displaying a notice that he can experience the determined pitch of A pitcher.

- the flying image of the determined virtual ball can be reproduced by the head mounted display system 5. In this way, cooperation with a television relay or the like can be performed.

- timing information needs to specify tracking data of the flying object actually released by the athlete 1.

- the tracking data can be specified by using the tracking data acquisition time included in the tracking data.

- the 3D display data includes 3D display data identification information that can uniquely identify the 3D display data, and the head mounted display system 5 You may make it transmit to.

- the 3D display data identification information only needs to be able to individually identify each 3D display data, and includes the above-described tracking data acquisition time, an identifier for uniquely identifying the 3D display data, and the like. .

- the flying image of the virtual ball is displayed on the head mounted display system 5.

- Execution information including 3D display data identification information for identifying 3D display data used for executing virtual reality is transmitted from the 3D display data generation server 3 or the broadcast transmission system 4 at the display timing. To do.

- the head mounted display system 5 receives the execution information and displays the flying image of the virtual ball (virtual flying object) using the 3D display data specified by the 3D display data identification information included in the execution information. Display on system 5.

- the 3D display data is transmitted to at least one or more head mounted display systems 5 via the broadcast transmission system 4.

- the 3D display data generation server 3 may acquire not only the 3D display data but also only the audio from the TV video of the game and transmit it together with the 3D display data. At this time, time information is also given to the audio data so that the tracking data acquisition time and the audio data are synchronized. In this way, as will be described later, when the video of the virtual space is displayed in the head mounted display system 5, the live sound actually emitted in the stadium is output, and the virtual space with a more realistic feeling is output. Can be realized.

- the 3D display data generation server 3 may be configured by a single computer or by distributed computing using a plurality of computers. In order to increase the processing speed, part or all of the functions of the three-dimensional display data generation server 3 can be realized by using dedicated hardware (eg, GPU, FPGA, ASIC, etc.).

- dedicated hardware eg, GPU, FPGA, ASIC, etc.

- Broadcast transmission system 4 is a system that broadcasts three-dimensional display data to a plurality of head mounted display systems 5 connected to a network.

- a content delivery network Content (Delivery Network: CDN).

- the broadcast transmission system 4 preferably broadcasts the three-dimensional display data with real-time characteristics synchronized with the video broadcast of the game broadcast described above.

- One of the implementation methods is to refer to the tracking data acquisition time included in the 3D display data and the time code on the TV image side so that the 3D display data can be synchronized with the TV image. Can be sent.

- the head-mounted display (head-mounted display: “Head-Mounted Display”, HMD) system 5 has a display unit capable of displaying a three-dimensional image having a depth for a user who wears the head-mounted display. And it is comprised so that the three-dimensional image

- positioned can be displayed on a display part.

- the display unit is disposed so as to cover both eyes of the user.

- the display unit displays a 3D video to the user by displaying images with parallax on the left and right image display surfaces, respectively. Thereby, a user wearing a head mounted display on the head can experience a sense close to reality as a three-dimensional image in the virtual space.

- FIG. 7 is a block diagram of the head mounted display system 5.

- the head mounted display system 5 includes a head mounted display 51 and a computer 52.

- the head mounted display 51 includes a display unit 511 on which a virtual space image is displayed, a head position detection sensor 512, and a speaker 513.

- the head position detection sensor 512 is configured to detect the position and posture of the user's head in the absolute coordinate system of the user's head and output the detection signal to the computer 52. Since the head position detection sensor 512 is provided integrally with the head mounted display 51, the head mounted display 51 is mounted on the user's head, thereby tracking the movement of the user's head and detecting the position and posture. Can be detected. The detection result is fed back to the three-dimensional video in the virtual space displayed by the display unit 511 of the head mounted display 51, thereby presenting the three-dimensional video viewed from the viewpoint position corresponding to the movement of the user's head. be able to.

- the speaker 513 outputs sound to the user, and for example, outputs sound corresponding to the situation in the virtual space to the user.

- the means for transmitting the voice to the user is not limited to the speaker 513, and may be other voice output means such as an earphone.

- the head mounted display 51 having such a function there are, for example, HTC Vive, Oculus VR Rift of Oculus VR, and the like.

- the head position detection sensor 512 may be provided separately from the head mounted display 51 and mounted on the user's head.

- the computer 52 is for generating a video to be displayed on the display unit 511 of the head mounted display 51, various arithmetic processes, and the like.

- the computer 52 includes hardware resources such as a processor 520, a memory (ROM or RAM) 521, a storage device (hard disk, semiconductor disk, etc.) 522, an input device (keyboard, mouse, touch panel, etc.) 523, a display device 524, and a communication device 525. It can comprise with the general purpose computer which has.

- the storage device 522 stores a processing program for generating a video or the like to be displayed on the display unit 511 of the head mounted display 51 and performing various arithmetic processes. Furthermore, various objects for generating by the processor 520 a virtual athlete (virtual moving object) in the virtual space of the athlete 1, a virtual ball (virtual flying object) emitted from the virtual athlete, a virtual home base as a background, and the like. Data is stored.

- the program stored in the storage device 522, the object data, and the received three-dimensional display data are loaded into the memory 521, and the processor 520 displays a virtual space image displayed on the display unit 511 of the head mounted display 51 based on the program. Etc. are generated.

- the processor 520 performs image generation processing based on the program.

- the image generation processing includes three-dimensional display data of a virtual ball (virtual flying object) emitted from a virtual athlete (virtual moving object) and a user's head detected by the head position detection sensor 512 by a known computer graphics technique. Using the position and posture of the robot and various object data such as a virtual athlete (virtual moving object) and a virtual ball (virtual flying object), a 3D image of the movement of the virtual athlete and the flying image of the virtual ball is generated in sequence. Are displayed on the display unit 511.

- the image generation process specifies the displayable period by the time information and the time code of the video included in the timing information, and only during that period, A three-dimensional image such as a flying image of a virtual ball is displayed.

- FIG. 8 is a diagram illustrating an example of a three-dimensional image displayed on the display unit 511.

- a virtual pitcher, a virtual ball flying video, a virtual stadium, and the like viewed from a viewpoint position in the virtual space corresponding to the position and orientation of the user are displayed.

- the 3D display data includes 3D display data identification information

- the 3D image such as the flying image of the virtual ball

- the distributed execution information in response to the reception of the execution information, Using the 3D display data specified by the 3D display data identification information included in the execution information, a process of displaying a 3D image such as a flying image of the virtual ball is started.

- the head-mounted display includes a virtual-reality (VR) type head-mounted display in which only a virtual space created by computer graphics or the like is displayed, and a real space (for example, an optically transmitted real space). ) And a virtual space are displayed in real time, there is a Mixed Reality (MR) type head mounted display, but the present invention can be applied to any head mounted display.

- VR virtual-reality

- MR Mixed Reality

- An example of the MR type head mounted display is Microsoft's HoloLens.

- the head mounted display system 5 described above, an example in which the head mounted display 51 and the computer 52 are physically configured as separate housings has been described, but the present invention is not limited thereto.

- the head mounted display system 5 may be configured by integrating the head mounted display 51 and the computer 52.

- An example of the head mounted display system 5 in which the head mounted display 51 and the computer 52 are integrated is the above-mentioned HoloLens of Microsoft Corporation.

- the head mounted display system 5 may not be a dedicated head mounted display system.

- a smartphone is attached to a goggle-type headset, the same function as a head-mounted display can be realized.

- An example of this is Samsung's Galaxy Gear VR.

- FIG. 9 is a sequence diagram showing a flow of processing and information from the tracking system 2 to the head mounted display system 5 in the first embodiment.

- the tracking system 2 senses the ball thrown from the athlete 1 (pitcher) on the pitch of the game being relayed in real time with a radar, a camera or the like.

- the athlete 1, the referee, and the like on the pitch may be sensed in real time by a radar, a camera, or the like (Step 1).

- At least tracking data of the ball thrown from the athlete 1 (pitcher) is generated from the sensed data. It is also possible to generate tracking data such as athlete 1 on the pitch, referee, etc. (Step 2).

- time information of tracking data is also acquired.

- the tracking data including time information is transmitted to the three-dimensional display data generation server 3.

- the 3D display data generation server 3 acquires tracking data (Step 3).

- the three-dimensional display data generation server 3 generates three-dimensional display data for displaying the flying image of the virtual ball on the head mounted display system 5 based on the acquired tracking data.

- Three-dimensional display data for displaying a virtual athlete may also be generated (Step 4).

- the timing information for displaying the flying image of the virtual ball is included in the three-dimensional display data using the tracking data acquisition time.

- the tracking data acquisition time may be included in the generated three-dimensional display data. Then, the three-dimensional display data is transmitted to the broadcast transmission system 4.

- Broadcast transmission system 4 broadcasts the received three-dimensional display data to a plurality of head mounted display systems 5 connected to the network (Step 5).

- the broadcast transmission of the 3D display data is performed in the order from the time code information of the video relayed on the television when the tracking data acquisition time is included in the 3D display data. By doing so, it is possible to broadcast the 3D display data in a form following the TV broadcast of the game, and to maintain the real-time property to some extent.

- the head mounted display system 5 receives the 3D display data (Step 6).

- the head mounted display system 5 specifies the displayable period based on the time information included in the timing information and the time code of the video, and is mounted during that period.

- a three-dimensional image (flying image) of the virtual ball viewed from the viewpoint position corresponding to the movement of the user's head is displayed (Step 7).

- the head mounted display system 5 is mounted at the timing when the execution information including the 3D display data identification information is received.

- a three-dimensional image (flying image) of the virtual ball viewed from the viewpoint position corresponding to the movement of the user's head is displayed (Step 7).

- the virtual pitcher (virtual athlete) who throws the virtual ball may be displayed using the object data of the virtual pitcher stored in advance in the head mounted display system 5, or the actual pitcher is displayed on the three-dimensional display data. If display data is stored, it may be used to display a virtual pitcher.

- information on movements of athletes, balls, and the like is broadcast to the head mounted display system while maintaining a certain degree of synchronism with the video of a game such as a delivered sport.

- the user can not only watch the athlete's performance from the video but also experience the athlete's performance from the user's free viewpoint by using the head mounted display system.

- FIG. 10 is a schematic configuration diagram of a virtual reality providing system in a modified example of the first embodiment.

- the head mounted display system 5 and the television 8 are compatible with the hybrid cast standard

- the head mounted display system 5 is connected to the television 8 with the hybrid cast standard.

- the broadcast transmission system 4 functions as a hybrid cast server.

- the broadcast transmission system 4 adds the three-dimensional display data to the three-dimensional display data such as a virtual flying object (virtual ball) acquired from the three-dimensional display data generation server 3.

- the three-dimensional display data identification information that can be uniquely identified is transmitted to the head mounted display system 5.

- the 3D display data identification information may be any information as long as each 3D display data can be individually identified, and includes the tracking data acquisition time and the identifier for individually identifying the 3D display data.

- the broadcasting facility 7 broadcasts an event message storing 3D display data identification information for identifying 3D display data used when executing virtual reality at the timing of executing virtual reality in the head mounted display system 5.

- the 3D display data identification information is, for example, an identifier for individually identifying the tracking data acquisition time and the 3D display data described above.

- the television 8 detects and analyzes the event message broadcast from the broadcasting facility 7 and transmits the 3D display data identification information stored in the event message to the head mounted display system 5.

- the image generation processing unit 520 of the head mounted display system 5 uses the three-dimensional display data having the three-dimensional display data identification information transmitted from the television 8 among the received three-dimensional display data. As in the embodiment, a three-dimensional image of the virtual athlete's motion and the flying image of the virtual ball is sequentially generated and displayed on the display unit 511.

- FIG. 11 is a sequence diagram showing a process and information flow from the broadcasting facility 7 to the head mounted display system 5 in the modification of the first embodiment.

- the broadcasting facility 7 broadcasts a live video of the game being relayed (Step 1).

- the television 8 receives the broadcast wave and displays a live video (Step 2).

- the tracking system 2 senses the ball thrown from the athlete 1 (pitcher) on the pitch of the game being relayed in real time with a radar, a camera or the like.

- the athlete 1, the referee, and the like on the pitch may be sensed in real time by a radar, a camera, or the like (Step 3).

- At least tracking data of the ball thrown from the athlete 1 (pitcher) is generated from the sensed data. It is also possible to generate tracking data such as athlete 1 on the pitch, referee, etc. (Step 4). Then, the tracking data is transmitted to the three-dimensional display data generation server 3.

- the 3D display data generation server 3 acquires tracking data (Step 5).

- the three-dimensional display data generation server 3 generates three-dimensional display data for displaying the flying image of the virtual ball on the head mounted display system 5 based on the acquired tracking data (Step 6).

- three-dimensional display data for displaying a virtual athlete may also be generated (Step 4).

- a three-dimensional display data identifier for identifying the three-dimensional display data is included in the generated three-dimensional display data.

- the three-dimensional display data is transmitted to the broadcast transmission system 4.

- the three-dimensional display data identifier used here is a three-dimensional display data identifier shared with the broadcasting facility 7 in advance.

- the broadcast transmission system 4 transmits the received three-dimensional display data to the head mounted display system 5 using hybrid cast (Step 7).

- the head mounted display system 5 receives the three-dimensional display data (Step 8).

- the broadcasting facility 7 broadcasts an event message in which a three-dimensional display data identifier is stored at the timing of executing virtual reality in the head mounted display system 5 (Step 9).

- the television 8 detects an event message broadcast from the broadcasting facility 7, analyzes the event message, and transmits a three-dimensional display data identifier to the head mounted display system 5 (Step 10).

- the head mounted display system 5 collates the three-dimensional display data identifier received from the television 8 with the three-dimensional display data identifier of the received three-dimensional display data (Step 11). Then, using the three-dimensional display data having the three-dimensional display data identifier received from the television 8, a three-dimensional image (flight image) of the virtual ball viewed from the viewpoint position corresponding to the movement of the head of the wearing user. Is displayed (Step 12). At this time, the virtual pitcher or virtual pitcher (virtual athlete) may display the virtual pitcher object data stored in the head-mounted display system 5 in advance, or may display the actual pitcher as three-dimensional display data. If the display data is stored, the virtual pitcher may be displayed using the display data.

- the broadcast station side generates 3D display data of tracking data for a predetermined player and part of the game time, generates 3D display data for the player and time, and broadcasts it. May broadcast an event message including the corresponding three-dimensional display data identification information.

- the broadcast station side can designate the timing for executing virtual reality on the head mounted display system 5 as a program-linked service, and the program video of a game such as sports to be broadcast and The interlocked virtual reality can be provided by the head mounted display system 5.

- FIG. 12 is a schematic configuration diagram of a virtual reality providing system according to the second embodiment.

- the video of the baseball game shot by the camera 6 is not transmitted to the television broadcast but to a terminal such as a tablet or a smartphone by a content delivery network system. Broadcast transmission.

- the second embodiment is different from the first embodiment in that the three-dimensional display data is transmitted together with the transmitted game video data.

- a live video generation unit 9 that generates video data of a live video of a game

- a distribution data generation server that generates distribution data by including 3D display data in the video data of a live video of a game 10 are provided.

- symbol is attached

- the distribution data generation server 10 can be realized by a computer system having a processor that performs various arithmetic processes.

- FIG. 13 is a block diagram of the distribution data generation server 10 configured by a computer system.

- the distribution data generation server 10 includes a processor 100, a memory (ROM or RAM) 101, a storage device (hard disk, semiconductor disk, etc.) 102, an input device (keyboard, mouse, touch panel, etc.) 103, a display device 104, a communication device 105, and the like.

- a processor 100 a memory (ROM or RAM) 101, a storage device (hard disk, semiconductor disk, etc.) 102, an input device (keyboard, mouse, touch panel, etc.) 103, a display device 104, a communication device 105, and the like.

- ROM or RAM read-only memory

- storage device hard disk, semiconductor disk, etc.

- an input device keyboard, mouse, touch panel, etc.

- display device 104 a display device 104

- a communication device 105 and the like.

- a general-purpose computer having hardware resources can be used.

- the distribution data generation server 10 implements distribution data generation processing by loading a program stored in the storage device 102 into the memory 101 and executing it by the processor 100.

- the processor 100 performs reception processing for receiving live video data and 3D display data, and distribution data generation processing for generating distribution data.

- the distribution data generation process generates distribution data in a format in which live video data and 3D display data can be separated on the head mounted display system 5 side. For example, an identifier that identifies video data is assigned to the header of a packet of video data, and an identifier that identifies that it is 3D display data is appended to the header of a packet of 3D display data. Generate data. On the head mounted display system 5 side, the video data and the three-dimensional display data can be separated by the identifier. Further, when there is a field that can include data other than video data in the payload of each packet of video data, the field may be inserted in a format that can identify 3D display data.

- the distribution data generation process refers to the time code of the video data and the acquisition time of the tracking data included in the 3D display data, and generates the distribution data so that the data are synchronized with each other. For example, if there is a field that can include data other than video data in the payload of each packet of video data, 3D display data having the same tracking data acquisition time as the time code of the packet is displayed. Insert into the field. This example is merely an example, and other methods may be used.

- the distribution data generation server 10 transmits the generated distribution data to the broadcast transmission system 4.

- Broadcast transmission system 4 broadcasts to head mounted display system 5 and tablets and smartphones for viewing images.

- FIG. 14 is a block diagram of the head mounted display system 5 in the second embodiment.

- the processor 520 performs a data separation process for separating the video data and the three-dimensional display data by a predetermined separation method. Specifically, when an identifier for identifying the type of each data is assigned to the packet, the video data and the three-dimensional display data are separated based on the identifier. When the payload of each packet of video data includes 3D display data together with the identifier, the video data and 3D display data are separated based on the identifier.

- the image generation process displays a three-dimensional image of the virtual space on the display unit, as in the first embodiment.

- the head mounted display system 5 is a system that can also view distributed video data, either a live video or a three-dimensional video in a virtual space may be selected by the user.

- FIG. 15 is a sequence diagram illustrating a process and information flow from the live video generation unit 9 to the head mounted display system 5 according to the second embodiment.

- the same step number was given about the operation

- the live video generation unit 9 generates video data of the game being relayed (Step 1).

- the generated video data is transmitted to the distribution data generation server 10.

- the ball thrown from the athlete 1 (pitcher) on the pitch of the game being relayed is sensed in real time by a radar, a camera or the like.

- the athlete 1, the referee, and the like on the pitch may be sensed in real time by a radar, a camera, or the like (Step 1).

- At least tracking data of the ball thrown from the athlete 1 (pitcher) is generated from the sensed data. It is also possible to generate tracking data such as athlete 1 on the pitch, referee, etc. (Step 2).

- time information of tracking data is also acquired.

- the tracking data including time information is transmitted to the three-dimensional display data generation server 3.

- the 3D display data generation server 3 acquires tracking data (Step 3).

- the three-dimensional display data generation server 3 generates three-dimensional display data for displaying a flying image of the virtual ball on the head mounted display system 5 based on the acquired tracking data (Step 4). Note that three-dimensional display data for displaying the virtual athlete may also be generated. At this time, the tracking data acquisition time is included in the generated three-dimensional display data. Then, the three-dimensional display data is transmitted to the distribution data generation server 10.

- the distribution data generation server 10 generates the distribution data by including the 3D display data in the video data of the live video of the game (Step 11).

- the generated distribution data is transmitted to the broadcast transmission system 4.

- Broadcast transmission system 4 broadcasts the received distribution data to a plurality of head mounted display systems 5, tablets and smartphones (not shown) connected to the network (Step 5).

- the head mounted display system 5 receives the distribution data (Step 6).

- the head mounted display system 5 performs a data separation process for separating the video data and the three-dimensional display data by a predetermined separation method (Step 12).

- the head mounted display system 5 displays a three-dimensional image (flying image) of the virtual ball viewed from the viewpoint position corresponding to the movement of the head of the user who is wearing (Step 7).

- the virtual pitcher or virtual pitcher may display the virtual pitcher object data stored in the head-mounted display system 5 in advance, or may display the actual pitcher as three-dimensional display data. If the display data is stored, the virtual pitcher may be displayed using the display data.

- the second embodiment can synchronize the distribution of 3D display data and the distribution of live video on the data distribution side. As a result, the user can experience the athlete's performance at a more synchronized timing with the current game.

- the second embodiment can also include timing information in the three-dimensional display data.

- the tracking data acquisition time may not be included in the three-dimensional display data, but only the timing information may be included.

- the distribution data generation server 10 sends the 3D display data and the video data to the head mounted display before the timing (predetermined video section) for displaying the 3D video (flight video) specified by the timing information.

- Distribution data is generated in a format that can be separated on the system 5 side.

- the second embodiment can obtain the same effects as those of the first embodiment.

- the 3D display data may be transmitted to the head mounted display system 5 by including 3D display data identification information that can uniquely identify the 3D display data.

- the flying image of the virtual ball is displayed on the head mounted display system 5.

- the distribution data generation server 10 transmits execution information including 3D display data identification information for identifying 3D display data used when executing virtual reality.

- the head mounted display system 5 receives the execution information and displays the flying image of the virtual ball (virtual flying object) using the 3D display data specified by the 3D display data identification information included in the execution information. Display on system 5.

- the second embodiment can obtain the same effects as those of the first embodiment.

- the third embodiment is in addition to the first embodiment (including modifications of the first embodiment) or the second embodiment (including modifications of the second embodiment).

- FIG. 16 is a block diagram of the head mounted display system 5 in the third embodiment.

- the tool tracking acquisition unit 520 for tracking the movement of the tool used by the user in a state where the user wears the head mounted display 51 is provided.

- the tool tracking acquisition unit 520 can use Microsoft's Kinect (registered trademark), ASUS Xtion Pro (registered trademark), or the like. It is also possible to provide an acceleration sensor in the tool and acquire the tracking data of the tool.

- the processor 520 of the computer 52 performs the tool 3D display data generation process.

- the tool 3D display data generation process calculates virtual specific 3D display data (trajectory data) corresponding to the tool based on the tool tracking data acquired by the tool tracking acquisition unit 520. In addition, based on the three-dimensional display data (orbit data) of the virtual flying object and the three-dimensional display data (orbit data) for the virtual object, a new one resulting from the collision between the virtual object and the virtual object in the virtual space. 3D display data (orbit data) of a virtual flying object is calculated.

- the tool 3D display data generation process is such that when the virtual flying object is a virtual ball and the virtual object is a virtual bat, the user swings the bat according to the flying image of the virtual ball thrown from the virtual athlete. Then, three-dimensional display data (orbit data) of the swing of the virtual bat is calculated from the tracking data of the bat. Then, the tool 3D display data generation process is performed by using the virtual bat and the virtual ball in the virtual space based on the virtual bat 3D display data (orbit data) and the virtual ball 3D display data (orbit data). Determine whether to collide (determine whether the virtual ball hits the virtual bat).

- three-dimensional display data (orbit data) of the flight trajectory of the virtual ball after the collision is generated based on the size of the virtual bat and the coefficient of restitution.

- the image generation process generates and displays a flying image of the virtual ball after the collision based on the three-dimensional display data (orbit data) of the flying trajectory of the virtual ball.

- FIG. 17 is an example of an image when the virtual ball and the virtual bat collide

- FIG. 18 is an example of a flying image of the virtual ball after the collision between the virtual ball and the virtual bat.

- a plurality of virtual tool sizes and restitution coefficients corresponding to tools used by the user may be prepared so that the user can select them.

- the tool is a bat, as shown in FIG. 19, a plurality of virtual bats having different sizes and different restitution coefficients may be prepared and selected by the user.

- the user sees the performance of the athlete, but also the user can hit or catch a virtual flying object similar to a ball or the like emitted by the real athlete. Can challenge.

- a collision result indicating whether a virtual flying object and a virtual concrete in each head mounted display system 5 collide, and a new trajectory of the virtual flying object. This is a mode in which the flight results of the virtual flying object obtained from the data are totaled and the totaled results are reflected in the live video.

- FIG. 20 is a schematic configuration diagram of a virtual reality providing system according to the fourth embodiment.

- the computer 52 of the head mounted display system 5 determines whether or not the virtual flying object collides with the virtual concrete. For example, it is determined whether or not the virtual ball and the virtual bat collide, that is, the virtual ball can be hit.

- the flight result of the virtual flying object is calculated. For example, whether a hit ball hit a virtual ball is a hit or a home run. Then, the collision result and the flight result are transmitted to the aggregation server 11. Furthermore, the collision result and flight result of each user are managed individually.

- the aggregation server 11 can be specifically realized by a computer system having a processor that performs various arithmetic processes.

- FIG. 21 is a block diagram of the aggregation server 11 configured by a computer system.

- the aggregation server 11 includes hardware such as a processor 110, a memory (ROM or RAM) 111, a storage device (hard disk, semiconductor disk, etc.) 112, an input device (keyboard, mouse, touch panel, etc.) 113, a display device 114, and a communication device 115.

- a processor 110 a memory (ROM or RAM) 111

- a storage device hard disk, semiconductor disk, etc.

- an input device keyboard, mouse, touch panel, etc.

- display device 114 a display device 114

- a communication device 115 a general-purpose computer having resources can be used.

- the aggregation server 11 performs the aggregation process by loading the program stored in the storage device 112 into the memory 111 and executing it by the processor 110.

- the tabulation process tabulates the collision result and the flight result transmitted from each head mounted display system 5. For example, the number of head mounted display systems 5 that transmitted the collision result and the flight result, the ratio of the collision result (collision) to the number of the head mounted display system 5, or the ratio of the flight result.

- the aggregation server 11 performs an aggregation result image generation process for generating an aggregation result image that is an image of the aggregation result.

- FIG. 22 is an example of an image of a statistical result when the virtual flying object is a ball and the virtual concrete is a bat.

- the aggregation server 11 transmits the generated statistical image to a broadcasting facility or a broadcast transmission system.

- FIG. 23 is a diagram illustrating an example of a video in which a live video and a statistical image are combined.

- the fourth embodiment is applicable not only when broadcasting live video, but also when transmitting live video using a content delivery network system.

- the performance of the user wearing the head mounted display is reflected in the live video, it is possible not only to simply watch the live broadcast but also to provide a new experience in which the user can become the main player.

- the fifth embodiment is in addition to the first embodiment (including modifications of the first embodiment) or the second embodiment (including modifications of the second embodiment).

- the server 1 has a prediction server 12 that predicts the ball type of the ball that the athlete 1 such as a pitcher will throw next to the batter from past results.

- FIG. 24 is a schematic configuration diagram of a virtual reality providing system according to the fifth embodiment.

- the prediction server 12 includes a tracking data acquisition unit 121 and a prediction unit 122.

- the tracking data acquisition unit 121 acquires tracking data provided from the tracking system 2.

- the acquired tracking data includes data for identifying the pitcher and the batter who is fighting.

- the prediction unit 122 machine-learns the ball type that each pitcher has thrown against each batter in the past and inputs the acquired tracking data, and then predicts the ball type that the pitcher will throw next to the batter.

- the predicted sphere type is transmitted to the three-dimensional display data generation server 3 in the same format as the tracking data.

- the 3D display data generation server 3 acquires tracking data from the prediction server 12.

- the three-dimensional display data generation unit 32 generates three-dimensional display data for displaying a flying image of the predicted virtual ball type on the head mounted display system 5 as in the above-described embodiment. Then, the generated three-dimensional display data is transmitted to at least one or more head mounted display systems 5 via the broadcast transmission system 4.

- the fifth embodiment is the same as that of the first embodiment described above (including modifications of the first embodiment) or the second embodiment (including modifications of the second embodiment).

- the user can experience the ball of the ball type that the pitcher is expected to throw next.

- the fifth embodiment can be configured not only in the first embodiment described above (including modifications of the first embodiment) but also in combination with the second to fourth embodiments. it can.

- At least one virtual space providing system for providing a user with a three-dimensional image of the virtual space; tracking data acquisition means for acquiring tracking data of a flying object emitted from a real athlete at least on the pitch, acquired from a sensor; Three-dimensional coordinate data generating means for generating three-dimensional coordinate data for displaying a virtual flying object corresponding to the flying object in a virtual space displayed on the virtual space providing system based on the acquired tracking data;

- a virtual reality providing system comprising: a transmitting unit that transmits the three-dimensional coordinate data to the at least one virtual space providing system via a broadcast transmitting unit.

- the tracking data includes tracking data of a real athlete's movement on the pitch

- the three-dimensional coordinate data generating means generates three-dimensional coordinate data for displaying a virtual operating body corresponding to the real athlete in a virtual space displayed on the virtual space providing system based on the acquired tracking data.

- the virtual reality providing system according to attachment 1.

- Distribution data generation means for generating distribution data including video data of the athlete's actual video and the three-dimensional coordinate data;

- the transmission means transmits the distribution data to the at least one virtual space providing system via the broadcast transmission means,

- the virtual space providing system according to Supplementary Note 1 or Supplementary Note 2, wherein the virtual space providing system includes a separating unit that separates the video data and the three-dimensional coordinate data from the distribution data.

- the virtual space providing system includes: Storage means for storing object data of the virtual flying object and the virtual moving object, and virtual specific object data corresponding to the tool handled by the user; Receiving means for receiving the three-dimensional coordinate data; Position / orientation detection means for detecting the user position data and the user orientation data in the virtual space; Tool tracking data acquisition means for acquiring tracking data of the tool handled by the user; First calculation means for calculating three-dimensional coordinate data for displaying virtual details corresponding to the tool in a virtual space displayed on the virtual space providing system based on the tracking data of the tool; Based on the three-dimensional coordinate data of the virtual flying object and the three-dimensional coordinate data for the virtual, the flight of the virtual flying object caused by the collision between the virtual flying object and the virtual concrete in the virtual space A second computing means for calculating the three-dimensional coordinate data of the trajectory; Based on the three-dimensional coordinate data, the object data, and the position data and orientation data of the user, the virtual flying object from the viewpoint position in the virtual space corresponding to the position and orientation of the user, the

- the storage means includes flying object data relating to at least the size of a plurality of virtual flying objects, flying object restitution coefficient data of restitution coefficients of the plurality of virtual flying objects for the virtual tool, and tools relating to at least the size of the plurality of virtual tools.

- Data and tool restitution coefficient data of restitution coefficient for the virtual flying object of the plurality of virtual tools are stored;

- the second calculation means refers to the flying object data, the flying object restitution coefficient data, the tool data, and the restitution coefficient data, and the new calculation means resulting from a collision between the virtual flying object and the virtual object.

- the virtual reality providing system according to appendix 5, which calculates the trajectory data of the virtual flying object.

- the virtual space providing system includes: Third calculation means for calculating a collision result of whether the virtual flying object collides with the virtual concrete and a flying result of the virtual flying object obtained from three-dimensional coordinate data of a flying trajectory of the virtual flying object When, Transmission means for transmitting the collision result and the flight result to the aggregation server;

- the aggregation server is The virtual space providing system totalizes the collision result and the flight result transmitted from to calculate a total result, and displays the total result on a broadcast video or a broadcast transmission video that is a real video of the real athlete.

- the virtual reality providing system according to supplementary note 5 or supplementary note 6, comprising means for transmitting to the knitting apparatus.

- the virtual space providing system is a head mounted display system that is mounted on a user's head and includes a display unit that displays a 3D video of the virtual space, and a 3D video generation unit that generates the 3D video of the virtual space.

- the virtual reality providing system according to any one of appendix 1 to appendix 7, wherein

- a computer program of a virtual space providing system for providing a user with a 3D image of a virtual space, Three-dimensional coordinate data for displaying a virtual flying object corresponding to the flying object in a virtual space generated from the tracking data of the flying object emitted from at least a pitched real athlete obtained from the sensor is broadcast. Processing received from the transmission means; A process of detecting the user position data and the user orientation data in the virtual space; Based on the three-dimensional coordinate data of the virtual flying object, the object data of the virtual flying object, and the position data and orientation data of the user, the virtual flying from the viewpoint position in the virtual space corresponding to the position and orientation of the user.

- the program is Processing for obtaining tracking data of the tool handled by the user; Based on the tracking data of the tool, a process of calculating specific virtual three-dimensional coordinate data corresponding to the tool; Based on the three-dimensional coordinate data of the virtual flying object and the three-dimensional coordinate data for the virtual, the flight of the virtual flying object caused by the collision between the virtual flying object and the virtual concrete in the virtual space Processing to calculate the three-dimensional coordinate data of the trajectory; Based on the three-dimensional coordinate data, the object data, and the user position data and orientation data, the virtual flying object and the virtual specific trajectory from the viewpoint position in the virtual space corresponding to the position and orientation of the user Processing for generating video and displaying it on the display means of the virtual space providing system; The viewpoint in the virtual space corresponding to the position and orientation of the user based on the three-dimensional coordinate data of the flight trajectory of the virtual flying object resulting from the collision between the virtual flying object and the virtual concrete in the virtual space

- the program according to appendix 8 further comprising: processing for generating a trajectory image of the

- the program is A process of calculating a collision result of whether the virtual flying object and the virtual concrete collide, and a flying result of the virtual flying object obtained from three-dimensional coordinate data of a flying trajectory of the virtual flying object;

- the virtual space providing system is a head mounted display system that is mounted on a user's head and includes a display unit that displays a 3D video of the virtual space, and a 3D video generation unit that generates the 3D video of the virtual space.

- the program according to any one of appendix 9 to appendix 11, wherein

- Athlete (actual athlete) 2 Tracking system 3 Three-dimensional (3D) display data generation server 4 Broadcast transmission system 5 Head mounted display system 6 Camera 7 Broadcasting equipment 8 Television 9 Live video generation unit 10 Distribution data generation server 11 Aggregation server 12 Prediction server

Abstract

アスリートから放たれた飛体をトラッキングするセンサのセンサ情報から得られた飛体のトラッキングデータを取得するトラッキングデータ取得部と、取得したトラッキングデータを用いて、仮想空間に飛体に対応する仮想飛体の飛翔映像を表示するための3次元表示データを生成する3次元表示データ生成部と、3次元表示データを用いて、仮想空間に仮想飛体の飛翔映像を表示する少なくとも一以上の仮想空間提供システムと、3次元表示データを、少なくとも1以上の仮想空間提供システムに送信する送信部とを有する仮想現実提供システムである。

Description

本発明は仮想現実提供システム、3次元表示データ提供装置、仮想空間提供システム及びプログラムに関する。

ユーザの頭部に装着され、眼前に配置されたディスプレイ等によってユーザに3次元仮想空間画像を提示可能なヘッドマウントディスプレイ(HMD)が知られている。このヘッドマウントディスプレイを利用した練習支援システムが、特許文献1に記載されている。

特許文献1の練習支援システムは、練習者の頭部に装着され、練習者が扱う用具の仮想オブジェクトである仮想動作体を配置した仮想空間の3次元映像を提示する表示手段を有するHMDと、練習者の頭部の位置姿勢を検出する頭部位置検出手段と、用具に取り付けられる角速度検出手段と、角速度検出手段によって取得された角速度データに基づいて仮想動作体の軌道データを算出する演算手段と、軌道データを記憶する記憶手段と、軌道データに基づいて仮想空間内での仮想動作体の軌道映像を生成し、頭部位置検出手段によって検出された練習者の頭部の位置姿勢に対応する仮想空間内の視点位置からの軌道映像を表示手段に提示させる画像生成手段とを備える。

国内のプロ野球中継やJリーグ中継をはじめ、世界的なオリンピックやワールドカップ等、世界中の人々が家にいながらして、テレビやネットを通じたスポーツのライブ観戦を楽しんでいる。

しかし、ライブの映像は観戦のためのものであり、その映像に登場するアスリートのパフォーマンスを体感できるものではない。

そこで、本発明は、映像からアスリートのパフォーマンスを観戦するだけでなく、そのアスリートのパフォーマンスを自ら体験することができる仮想現実提供システム、3次元表示データ提供装置、仮想空間提供システム及びプログラムを提供することにある。

本発明の一態様は、アスリートから放たれた飛体をトラッキングするセンサのセンサ情報から得られた前記飛体のトラッキングデータを取得するトラッキングデータ取得部と、取得したトラッキングデータを用いて、仮想空間に前記飛体に対応する仮想飛体の飛翔映像を表示するための3次元表示データを生成する3次元表示データ生成部と、前記3次元表示データを用いて、仮想空間に仮想飛体の飛翔映像を表示する少なくとも一以上の仮想空間提供システムと、前記3次元表示データを、前記少なくとも1以上の仮想空間提供システムに送信する送信部とを有する仮想現実提供システムである。

本発明の一態様は、アスリートから放たれた飛体をトラッキングするセンサのセンサ情報から得られた前記飛体のトラッキングデータを取得するトラッキングデータ取得部と、取得したトラッキングデータを用いて、仮想空間提供システムに表示される仮想空間に前記飛体に対応する仮想飛体の飛翔映像を表示するための3次元表示データを生成する3次元表示データ生成部と、前記3次元表示データを、前記少なくとも1以上の仮想空間提供システムに送信する送信部とを有する3次元表示データ提供装置である。

本発明の一態様は、仮想空間を表示する表示部と、アスリートから放たれる飛体をトラッキングするセンサのセンサ情報から得られたトラッキングデータから生成され、前記仮想空間に前記飛体に対応する仮想飛体の飛翔映像を表示するための3次元表示データを受信する受信部と、前記仮想空間におけるユーザの位置及び前記ユーザの向きを検出する処理と、前記仮想飛体の3次元表示データ、前記仮想飛体のオブジェクトデータ及び前記ユーザの位置及び向きを用いて、前記ユーザの位置姿勢に対応する前記仮想空間内の視点位置からの前記仮想飛体の飛翔映像を、前記表示部に表示する画像処理部とを有する仮想空間提供システムである。