JP5523027B2 - 情報送信装置及び情報送信方法 - Google Patents

情報送信装置及び情報送信方法 Download PDFInfo

- Publication number

- JP5523027B2 JP5523027B2 JP2009202690A JP2009202690A JP5523027B2 JP 5523027 B2 JP5523027 B2 JP 5523027B2 JP 2009202690 A JP2009202690 A JP 2009202690A JP 2009202690 A JP2009202690 A JP 2009202690A JP 5523027 B2 JP5523027 B2 JP 5523027B2

- Authority

- JP

- Japan

- Prior art keywords

- information

- attribute information

- processing device

- network

- receiving

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N7/00—Television systems

- H04N7/18—Closed-circuit television [CCTV] systems, i.e. systems in which the video signal is not broadcast

- H04N7/183—Closed-circuit television [CCTV] systems, i.e. systems in which the video signal is not broadcast for receiving images from a single remote source

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/20—Analysis of motion

- G06T7/254—Analysis of motion involving subtraction of images

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/20—Analysis of motion

- G06T7/262—Analysis of motion using transform domain methods, e.g. Fourier domain methods

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V10/00—Arrangements for image or video recognition or understanding

- G06V10/94—Hardware or software architectures specially adapted for image or video understanding

- G06V10/95—Hardware or software architectures specially adapted for image or video understanding structured as a network, e.g. client-server architectures

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V20/00—Scenes; Scene-specific elements

- G06V20/50—Context or environment of the image

- G06V20/52—Surveillance or monitoring of activities, e.g. for recognising suspicious objects

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10016—Video; Image sequence

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/20—Special algorithmic details

- G06T2207/20048—Transform domain processing

- G06T2207/20052—Discrete cosine transform [DCT]

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30232—Surveillance

Description

監視装置において、移動物体の位置や外接矩形等属性情報を映像と共に記録し、再生時において移動物体の外接矩形を映像に重畳して表示する方式が開示されている(特許文献1)。また、移動物体情報をメタデータとして配信する技術がある(特許文献2)。

一方、ネットワーク経由でデバイスの状態取得や制御を行う標準規格であるUPnPにおいて、制御端末であるコントロールポイントから制御対象であるデバイスの属性を変化させたり、逆に属性の変化情報を取得したりする技術が開示されている。ここで、UPnPとは、Universal Plug and Playの略である。

本実施形態では、映像中の物体情報等のメタデータを処理装置に配信するネットワークカメラ(コンピュータ)と、前記メタデータを受信して解析処理や表示処理等を行う処理装置(コンピュータ)と、からなるネットワークシステムを用いて説明を行なう。ネットワークカメラは、処理装置で行う処理の種別等に応じてメタデータの配信内容を変更する。なお、メタデータは、属性情報の一例である。

本実施形態におけるネットワークシステムの典型的なシステム構成を図1に示す。図1は、ネットワークシステムのシステム構成の一例を示す図である。図1に示されるように、ネットワークシステムでは、ネットワークカメラ100、警報装置210、表示装置220、録画装置230がネットワーク経由で通信可能に接続されている。警報装置210、表示装置220、録画装置230は、処理装置の一例である。

ネットワークカメラ100は、物体を検出する機能や検出した物体の状態を簡易判別する機能を持つ。ネットワークカメラ100からは映像に加えて物体情報を含む各種情報がメタデータとして配信される。ネットワークカメラ100は、メタデータを後述するように映像に添付するか、若しくは映像とは別ストリームで配信する。映像やメタデータは警報装置210、表示装置220、録画装置230等の処理装置が受信する。これら処理装置は受信した映像とメタデータとを利用して、映像への物体枠の重畳表示や、物体の種別判定、認証等の処理を行う。

図2に示されるように、ネットワークカメラ100は、CPU10と、記憶装置11と、ネットワークインターフェース12と、撮像装置13と、雲台装置14と、を含む。なお、後述するように、撮像装置13と、雲台装置14と、をあわせて撮像装置、雲台装置110ともいう。

CPU10は、バス等を介して接続された他の構成要素を制御する。例えば、CPU10は、雲台装置14及び撮像装置13を制御し、物体を撮像する。記憶装置11は、RAM及び/又はROM及び/又はHDD等であって、撮像装置13で撮像された画像や、後述する処理に必要な情報及びデータ、プログラム等を記憶する。ネットワークインターフェース12は、ネットワークカメラ100をネットワークに接続する。CPU10は、ネットワークインターフェース12を介して例えば、画像等を送信したり、要求を受信したりする。

CPU10が、記憶装置11に記憶されているプログラムに基づき処理を実行することによって、後述するネットワークカメラ100の機能及び後述するフローチャートに係る処理等が実現される。

表示装置220からのパン、チルト、ズーム制御要求は、通信I/F部131経由で制御要求受信部132が受信し、撮影制御部121に渡される。そして撮影制御部121は、撮像装置、雲台装置110を制御する。一方、映像は撮影制御部121経由で、映像入力部122によって取得され、映像符号化部123において符号化される。ここで符号化方式としてはJPEGやMPEG−2、MPEG−4、H.264等の方式がある。

一方、入力映像は物体検出部127にも送信され、物体検出部127が映像中(画像中)の物体を検出する。次に解析処理部128において物体の状態を判別し、状態判別情報を出力する。解析処理部128は複数同時に平行して処理を行うことも可能である。物体検出部127で検出される物体情報は、例えば位置、面積、外接矩形、存在時間、静止度、領域マスク等である。また解析処理部128で解析された結果の状態判別情報は、例えば入場、退場、置き去り、持ち去り、通過等である。制御要求受信部132は、検出したい物体情報、解析したい状態判別情報の設定に関する要求を受信し、解析制御部130で前記要求を解析し、変更内容を解読して、検出したい物体情報、解析したい状態判別情報の設定を変更する。

図4は、表示装置の機能構成の一例を示す図である。表示装置220は、ネットワークカメラ100から受信した物体情報を表示する機能を持つ。図4において表示装置220は、通信I/F部221、映像受信部222、メタデータ解読部223、シーン情報表示部224を機能構成として含む。

図5は、表示装置における物体情報の表示の一例を示す図である。図5は画面上の1つのウィンドウを表したものであり、ウィンドウ枠400と、映像表示領域410とから構成される。映像表示領域410に表示されている映像上には置き去り検知イベント発生を示す枠412が示されている。

事前に知識のない物体領域を検出するためには、背景差分用いられることが多い。背景差分とは、現在の映像を過去の映像から生成した背景モデルと比較することによって物体を検出する手法である。本実施形態ではJPEGで用いるような、ブロック単位の離散コサイン変換後のDCT成分から求めた複数の特徴量を、背景モデルに利用する。特徴量としては、DCT計数の絶対値和や、隣接フレーム間の対応成分の差分和等があるが、本実施形態は特定の特徴量に依存するものではない。またブロック単位で背景モデルを持つ手法の他にも画素単位の濃度分布を持つ手法(例えば特開平10−255036号公報)もあり、本実施形態では何れの手法も利用が可能である。

図6において、背景更新処理の開始後、CPU10は、S501で画像の取得を行い、次にS510で周波数成分(DCT係数)を生成する。次にCPU10は、S511で周波数成分から特徴量(画像特徴量)を抽出する。CPU10は、S512においてS511で抽出した複数の特徴量が既存の背景モデルと合致するかを判別する。

背景の変化に対応するため、背景モデルは複数の状態を持つ。この状態をモードと称する。各モードは前述した複数の特徴量を背景の一状態として保持する。原画像との比較は特徴量ベクトルの差分演算によって行われる。CPU10は、S512では既存モードと比較して、類似モードが存在する場合はY分岐し、S514で対応するモードの特徴量を更新する。これは新規特徴量と、既存特徴量と、を一定比率で混合することによる。

図6の方式によれば、背景モデルを逐次更新しながら安定して物体情報を抽出することができる。

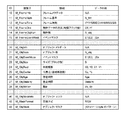

シーン情報は、フレーム情報と、個別の物体情報と、物体の領域マスク情報と、から構成される。フレーム情報は、ID番号10から15までであり、フレーム番号、フレーム時刻、物体データの次元(縦横ブロック数)、イベントマスクから構成される。ID10は、フレーム情報をまとめて配信する際に指定する識別子である。イベントとは、物体の状態を示す属性値がある一定の条件にあてはまることを示すものであり、置き去り、持ち去り、出現等がある。イベントマスクとは当該フレームにおいて、前記イベントがあるかどうかをビット単位で示すものである。

領域被覆率と領域重複率とは、何れも検出領域と物体領域とが重複する面積を分子とする割合である。領域被覆率は、検出領域面積に対する前記重複面積の割合である。一方、領域重複率は、物体面積に対する前記重複面積の割合である。上記の二つを用いることによって、置き去りと持ち去りとの区別が可能である。即ち、検出領域を持ち去り対象物体の周囲に設定することにより、持ち去り発生時に領域被覆率と領域重複比率との両方が共に所定の値より高い値になる。なお、領域は矩形に限定されず、多角形での設定が可能である。

図9に示される画面は、例えば表示装置220等の処理装置に表示される。図9等の画面を介して処理装置で設定されたパラメータの設定値は、HTTPのGETメソッドを用いてネットワークカメラ100に渡すことができる。

なお、物体がうろつき状態かどうかを判別するためには、存在時間と静止時間とを用いる。即ち、CPU10は、所定の面積以上の物体において、存在時間が所定の時間より長く、静止時間が所定の時間より短い場合はうろつき状態と判別することができる。

まず個別データで設定する方法がある。これは処理装置が、例えば、M_ObjSize,M_ObjRect,等の指定により、シーン情報を個別に指定する方法である。

CPU10は、指定された個別のシーン情報に基づいて、前記指定に係る処理装置に対して送信するシーンメタデータを変更し、変更したシーンメタデータを送信する。

次にカテゴリで指定する方法がある。これは処理装置が、M_FrameInfo,M_ObjectInfo,M_ObjectMaskInfo,のように、個別のシーンデータをまとめたカテゴリ単位で指定する方式である。

CPU10は、指定された個別のシーンデータをまとめたカテゴリに基づいて、前記指定に係る処理装置に対して送信するシーンメタデータを変更し、変更したシーンメタデータを送信する。

更にクライアントタイプによる指定方法がある。これはデータを受信するクライアント、即ち処理装置の種別によって配信するデータを決定するものである。処理装置は、クライアントタイプとして、ビューワー(M_ClientViewer)、録画サーバー(M_ClientRecorder)、画像解析装置(M_CilentAanlizer)、等の指定を行う。

CPU10は、指定されたクライアントタイプに基づいて、前記指定に係る処理装置に対して送信するシーンメタデータを変更し、変更したシーンメタデータを送信する。

例えばビューワーと指定した場合、物体単位でのイベントマスクと外接矩形とがあれば、表示装置220は、図5のような表示を行なうことができる。例えば、クライアントタイプと、送信するシーンメタデータとの対応情報は、新規のクライアントタイプを作成するのに合わせて事前にネットワークカメラ100に登録しておくものとする。

上述した設定(指定)は、イベント判別処理と同様にHTTPのGETメソッドを用いて、各処理装置からネットワークカメラ100に設定することができる。また、ネットワークカメラ100が、メタデータ配信の途中であっても、上述した設定を動的に変更することができる。

図11は、シーンメタデータをXML形式で表現した一例を示す図(その1)である。図7のシーンメタデータのうち、フレーム情報と、2つの物体情報と、を表現した例である。これは図5のようなビューワーへの配信を想定しており、受信側で置き去り物体を矩形で表示することができる。一方、バイナリ表現の場合は、バイナリXMLとして送信することもできるし、図7に示すデータが順に並ぶ独自表現とすることもできる。

図12においてネットワークカメラ100は、S602で初期化処理を実行後、リクエストの到着を待つ。一方で表示装置220は、S601で初期化処理を実行後、S603でネットワークカメラ100との接続要求を行う。接続要求には、ユーザー名やパスワードが含まれる。ネットワークカメラ100は、接続要求を受信すると、S604で接続要求に含まれるユーザー名やパスワードに基づき認証処理を行い、S606で接続許可を行う。その結果、表示装置220側で、接続の確立が確認される(S607)。

続いてS609で表示装置220からは、イベント判別ルールの設定要求として、設定値(送信内容(配信内容)を指定する値)が送信される。これに対してネットワークカメラ100は、設定値を受信し(S610)、設定値に基づいてS612でイベント判別ルール(判別条件の設定パラメータ等)の設定処理を行う。これにより配信するシーンメタデータが決定される。

以上説明した手法によれば、映像中の物体情報やイベント情報等のシーンメタデータを配信するネットワークカメラと、シーンメタデータを受信して各種処理を行う処理装置とからなるシステムにおいて、処理装置の後処理等に応じて配信するメタデータを変更する。その結果不要な処理を省くことが可能となり、ネットワークカメラ、及び、処理装置の高速化や、ネットワーク帯域への負荷を軽減することができる。

第2の実施形態としては、データ受信側の処理装置が検出物体の識別や認証を行う場合、ネットワークカメラ100から送信するシーンメタデータに物体マスクデータを加えて送信する。これにより、処理装置が行う認識処理の負荷を軽減できる。本実施形態のシステム構成は第1の実施形態と同じであるため、説明を省略し、以下、第1の実施形態と異なる部分を中心に説明する。

本実施形態における受信側の処理装置の構成例を図13に示す。なお、録画装置230のハードウェア構成は、例えば、CPU、記憶装置、ディスプレイ等を含み、CPUが、記憶装置に記憶されたプログラムに基づき、処理を実行することにより、以下に示す録画装置230の機能等が実現される。

録画装置230は、複数のネットワークカメラからの映像を受信し、映像中に特定の物体が存在するかどうかを判別する機能を持つ。一般に物体の識別には、画像や画像から抽出した特徴量の照合(マッチング)による方法が用いられる。識別機能を受信装置側に持つ利点は、物体情報のデータベースは容量が大きいため、制限のある組み込み環境では、十分な容量を確保できないからである。識別処理の例としては、検出された静止物体の種類(箱、バッグ、ペットボトル、衣類、玩具、傘、雑誌等)を識別する機能がある。これにより箱、バッグ、ペットボトルのような危険物が含まれる可能性が高いものを優先して警告することができる。

ここでネットワークカメラ100は、シーンメタデータとして、第1の実施形態に加えて、物体の領域マスク情報を送信する。これにより物体識別処理部234において、物体の存在する部分に関してのみ識別処理を行うことで、録画装置230の処理負荷を軽減することができる。物体形状が正確な矩形となることは稀なため、領域マスク情報と共に送信した方がより負荷の軽減につながる。

第3の実施形態としては、処理装置側で物体の追尾や人物の行動解析を行いたい場合、ネットワークカメラ100から物体の速度情報や物体のマスク情報を送信すると効率がよい。行動解析を行う場合、人物の追尾による軌跡の抽出が必要である。これは異なるフレーム間で検出した人物の対応付けであり、そのためには速度情報(M_ObjMotion)が有効である。また人物画像のテンプレートマッチングによる対応付け手法が採用されることもあり、この場合、物体領域のマスク情報(M_ObjeMaskInfo)を利用してマッチングを効率よく行うことができる。これらのメタデータの配信指定は、第1の実施形態で述べたように、メタデータの個別指定、カテゴリ指定、受信クライアントタイプによる指定が可能である。クライアントタイプによる指定の場合、行動解析を行う受信装置をM_ClientAnalizerとして表記し、配信するシーンメタデータの組と共に事前に登録する。

また、本発明は、以下の処理を実行することによっても実現される。即ち、上述した実施形態の機能を実現するソフトウェア(プログラム)を、ネットワーク又は各種記憶媒体を介してシステム或いは装置に供給し、そのシステム或いは装置のコンピュータ(又はCPUやMPU等)がプログラムを読み出して実行する処理である。

Claims (6)

- 画像中の物体の属性情報を検出する検出手段と、

前記検出手段で検出された物体の属性情報を、ネットワークを介して通信可能な処理装置に送信する送信手段と、

前記ネットワークを介して通信可能な処理装置より、前記送信手段で送信すべき属性情報に関する要求として前記処理装置の種別を受信する受信手段と、

前記受信手段で受信された前記種別に基づいて前記処理装置に送信する前記属性情報を決定する制御手段とを有し、

前記制御手段は、前記種別がビューワーである場合、検出された物体の外接矩形を前記処理装置に送信することを決定する情報送信装置。 - 画像中の物体の属性情報を検出する検出手段と、

前記検出手段で検出された物体の属性情報を、ネットワークを介して通信可能な処理装置に送信する送信手段と、

前記ネットワークを介して通信可能な処理装置より、前記送信手段で送信すべき属性情報に関する要求として前記処理装置の種別を受信する受信手段と、

前記受信手段で受信された前記種別に基づいて前記処理装置に送信する前記属性情報を決定する制御手段とを有し、

前記制御手段は、前記種別が行動解析を行う装置である場合、検出された物体の速度情報を前記処理装置に送信することを決定する情報送信装置。 - 情報送信装置が実行する情報送信方法であって、

画像中の物体の属性情報を検出する検出ステップと、

前記検出ステップで検出された物体の属性情報に関する要求として処理装置の種別を、ネットワークを介して通信可能な処理装置より受信する受信ステップと、

前記受信ステップで受信された前記種別に基づいて前記ネットワークを介して通信可能な処理装置に送信する前記属性情報を決定する制御ステップと、

前記決定された属性情報を前記処理装置に送信する送信ステップとを含み、

前記制御ステップでは、前記種別がビューワーである場合、検出された物体の外接矩形を前記処理装置に送信することを決定する情報送信方法。 - 情報送信装置が実行する情報送信方法であって、

画像中の物体の属性情報を検出する検出ステップと、

前記検出ステップで検出された物体の属性情報に関する要求として処理装置の種別を、ネットワークを介して通信可能な処理装置より受信する受信ステップと、

前記受信ステップで受信された前記種別に基づいて前記ネットワークを介して通信可能な処理装置に送信する前記属性情報を決定する制御ステップと、

前記決定された属性情報を前記処理装置に送信する送信ステップとを含み、

前記制御ステップでは、前記種別が行動解析を行う装置である場合、検出された物体の速度情報を前記処理装置に送信することを決定する情報送信方法。 - コンピュータを、

画像中の物体の属性情報を検出する検出手段と、

前記検出手段で検出された物体の属性情報を、ネットワークを介して通信可能な処理装置に送信する送信手段と、

前記ネットワークを介して通信可能な処理装置より、前記送信手段で送信すべき属性情報に関する要求として前記処理装置の種別を受信する受信手段と、

前記受信手段で受信された前記種別に基づいて前記処理装置に送信する前記属性情報を決定する制御手段として機能させ、

前記制御手段は、前記種別がビューワーである場合、検出された物体の外接矩形を前記処理装置に送信することを決定するプログラム。 - コンピュータを、

画像中の物体の属性情報を検出する検出手段と、

前記検出手段で検出された物体の属性情報を、ネットワークを介して通信可能な処理装置に送信する送信手段と、

前記ネットワークを介して通信可能な処理装置より、前記送信手段で送信すべき属性情報に関する要求として前記処理装置の種別を受信する受信手段と、

前記受信手段で受信された前記種別に基づいて前記処理装置に送信する前記属性情報を決定する制御手段として機能させ、

前記制御手段は、前記種別が行動解析を行う装置である場合、検出された物体の速度情報を前記処理装置に送信することを決定するプログラム。

Priority Applications (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2009202690A JP5523027B2 (ja) | 2009-09-02 | 2009-09-02 | 情報送信装置及び情報送信方法 |

| US12/872,847 US20110050901A1 (en) | 2009-09-02 | 2010-08-31 | Transmission apparatus and processing apparatus |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2009202690A JP5523027B2 (ja) | 2009-09-02 | 2009-09-02 | 情報送信装置及び情報送信方法 |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2011055270A JP2011055270A (ja) | 2011-03-17 |

| JP2011055270A5 JP2011055270A5 (ja) | 2012-10-11 |

| JP5523027B2 true JP5523027B2 (ja) | 2014-06-18 |

Family

ID=43624321

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2009202690A Active JP5523027B2 (ja) | 2009-09-02 | 2009-09-02 | 情報送信装置及び情報送信方法 |

Country Status (2)

| Country | Link |

|---|---|

| US (1) | US20110050901A1 (ja) |

| JP (1) | JP5523027B2 (ja) |

Families Citing this family (34)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP5397014B2 (ja) * | 2009-05-21 | 2014-01-22 | ソニー株式会社 | 監視システム、撮像装置、解析装置及び監視方法 |

| KR101703931B1 (ko) * | 2011-05-24 | 2017-02-07 | 한화테크윈 주식회사 | 감시 시스템 |

| JP6024952B2 (ja) * | 2012-07-19 | 2016-11-16 | パナソニックIpマネジメント株式会社 | 画像送信装置、画像送信方法、画像送信プログラム及び画像認識認証システム |

| JP6059239B2 (ja) * | 2012-09-28 | 2017-01-11 | オリンパス株式会社 | 撮影機器、撮影システム、撮影方法及び撮影制御プログラム |

| WO2014065127A1 (ja) * | 2012-10-22 | 2014-05-01 | ソニー株式会社 | 情報処理端末、撮像機、情報処理方法、プログラム、および遠隔撮像システム |

| JP6103948B2 (ja) * | 2013-01-17 | 2017-03-29 | キヤノン株式会社 | 撮像装置、遠隔操作端末、カメラシステム、撮像装置の制御方法およびプログラム、遠隔操作端末の制御方法およびプログラム |

| US9020190B2 (en) * | 2013-01-31 | 2015-04-28 | International Business Machines Corporation | Attribute-based alert ranking for alert adjudication |

| EP2993907A4 (en) * | 2013-04-30 | 2016-12-21 | Sony Corp | INFORMATION PROCESSING DEVICE AND INFORMATION PROCESSING METHOD |

| JP6316023B2 (ja) * | 2013-05-17 | 2018-04-25 | キヤノン株式会社 | カメラシステム及びカメラ制御装置 |

| JP6327816B2 (ja) * | 2013-09-13 | 2018-05-23 | キヤノン株式会社 | 送信装置、受信装置、送受信システム、送信装置の制御方法、受信装置の制御方法、送受信システムの制御方法、及びプログラム |

| US10127783B2 (en) | 2014-07-07 | 2018-11-13 | Google Llc | Method and device for processing motion events |

| US9213903B1 (en) | 2014-07-07 | 2015-12-15 | Google Inc. | Method and system for cluster-based video monitoring and event categorization |

| US9501915B1 (en) | 2014-07-07 | 2016-11-22 | Google Inc. | Systems and methods for analyzing a video stream |

| US10140827B2 (en) | 2014-07-07 | 2018-11-27 | Google Llc | Method and system for processing motion event notifications |

| US9449229B1 (en) | 2014-07-07 | 2016-09-20 | Google Inc. | Systems and methods for categorizing motion event candidates |

| US9420331B2 (en) | 2014-07-07 | 2016-08-16 | Google Inc. | Method and system for categorizing detected motion events |

| JP6435550B2 (ja) * | 2014-08-29 | 2018-12-12 | キヤノンマーケティングジャパン株式会社 | 情報処理装置、情報処理装置の制御方法及びプログラム |

| USD782495S1 (en) | 2014-10-07 | 2017-03-28 | Google Inc. | Display screen or portion thereof with graphical user interface |

| US9361011B1 (en) | 2015-06-14 | 2016-06-07 | Google Inc. | Methods and systems for presenting multiple live video feeds in a user interface |

| JP6241796B2 (ja) | 2015-12-25 | 2017-12-06 | パナソニックIpマネジメント株式会社 | 置去り物監視装置およびこれを備えた置去り物監視システムならびに置去り物監視方法 |

| US9710934B1 (en) | 2015-12-29 | 2017-07-18 | Sony Corporation | Apparatus and method for shadow generation of embedded objects |

| JP6390860B2 (ja) * | 2016-01-25 | 2018-09-19 | パナソニックIpマネジメント株式会社 | 置去り物体監視装置およびこれを備えた置去り物体監視システムならびに置去り物体監視方法 |

| CN106027962B (zh) * | 2016-05-24 | 2019-06-11 | 浙江宇视科技有限公司 | 视频监控的覆盖率计算方法及装置、布点方法及系统 |

| US10506237B1 (en) | 2016-05-27 | 2019-12-10 | Google Llc | Methods and devices for dynamic adaptation of encoding bitrate for video streaming |

| US10380429B2 (en) | 2016-07-11 | 2019-08-13 | Google Llc | Methods and systems for person detection in a video feed |

| US11783010B2 (en) | 2017-05-30 | 2023-10-10 | Google Llc | Systems and methods of person recognition in video streams |

| US10582119B2 (en) * | 2017-07-26 | 2020-03-03 | Sony Corporation | Image processing method and device for composite selfie image composition for remote users |

| US10664688B2 (en) | 2017-09-20 | 2020-05-26 | Google Llc | Systems and methods of detecting and responding to a visitor to a smart home environment |

| JP6532043B2 (ja) * | 2017-10-26 | 2019-06-19 | パナソニックIpマネジメント株式会社 | 置去り物監視装置およびこれを備えた置去り物監視システムならびに置去り物監視方法 |

| JP7073120B2 (ja) * | 2018-01-26 | 2022-05-23 | キヤノン株式会社 | 映像送信装置、情報処理装置、システム、情報処理方法及びプログラム |

| JP7176719B2 (ja) * | 2018-06-11 | 2022-11-22 | 日本電気通信システム株式会社 | 検出装置、検出システム、検出方法及びプログラム |

| JP6545342B1 (ja) * | 2018-10-15 | 2019-07-17 | 株式会社フォトロン | 異常検知装置及び異常検知プログラム |

| CN110312099A (zh) * | 2019-05-31 | 2019-10-08 | 中徽绿管家科技(北京)有限公司 | 一种可视化园林施工现场监控系统 |

| WO2024047794A1 (ja) * | 2022-08-31 | 2024-03-07 | 日本電気株式会社 | 映像処理システム、映像処理装置及び映像処理方法 |

Family Cites Families (21)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| EP0715453B1 (en) * | 1994-11-28 | 2014-03-26 | Canon Kabushiki Kaisha | Camera controller |

| US7116357B1 (en) * | 1995-03-20 | 2006-10-03 | Canon Kabushiki Kaisha | Camera monitoring system |

| JP2002165210A (ja) * | 2000-08-04 | 2002-06-07 | Matsushita Electric Ind Co Ltd | データ送信端末及びデータ送受信装置 |

| JP4140202B2 (ja) * | 2001-02-28 | 2008-08-27 | 三菱電機株式会社 | 移動物体検出装置 |

| JP4177598B2 (ja) * | 2001-05-25 | 2008-11-05 | 株式会社東芝 | 顔画像記録装置、情報管理システム、顔画像記録方法、及び情報管理方法 |

| JP3880495B2 (ja) * | 2002-09-25 | 2007-02-14 | キヤノン株式会社 | 撮像装置の制御方法及び画像配信装置 |

| US20040114176A1 (en) * | 2002-12-17 | 2004-06-17 | International Business Machines Corporation | Editing and browsing images for virtual cameras |

| US20040196369A1 (en) * | 2003-03-07 | 2004-10-07 | Canon Kabushiki Kaisha | Monitoring system |

| US7129855B2 (en) * | 2003-09-26 | 2006-10-31 | Openpeak Inc. | Device control system, method, and apparatus |

| EP2955662B1 (en) * | 2003-07-18 | 2018-04-04 | Canon Kabushiki Kaisha | Image processing device, imaging device, image processing method |

| JP2005151147A (ja) * | 2003-11-14 | 2005-06-09 | Toshiba Corp | 再生装置及び再生方法 |

| JP2005301513A (ja) * | 2004-04-08 | 2005-10-27 | Fujitsu Ltd | プログラム内蔵デバイス |

| JP2006042188A (ja) * | 2004-07-29 | 2006-02-09 | Soten:Kk | 通話録音・確認システム |

| JP4498104B2 (ja) * | 2004-11-16 | 2010-07-07 | キヤノン株式会社 | 監視装置、その制御方法、およびプログラム |

| JP2007201742A (ja) * | 2006-01-25 | 2007-08-09 | Ntt Software Corp | コンテンツ配信システム |

| JP4363421B2 (ja) * | 2006-06-30 | 2009-11-11 | ソニー株式会社 | 監視システム、監視システム用サーバ及び監視方法 |

| JP4453684B2 (ja) * | 2006-06-30 | 2010-04-21 | ソニー株式会社 | 監視システム、監視装置、検索方法及び検索プログラム |

| JP5389778B2 (ja) * | 2007-03-29 | 2014-01-15 | コーニンクレッカ フィリップス エヌ ヴェ | 論理的アドレスを用いるネットワーク化された制御システム |

| JP4389956B2 (ja) * | 2007-04-04 | 2009-12-24 | ソニー株式会社 | 顔認識装置及び顔認識方法、並びにコンピュータ・プログラム |

| JP5136170B2 (ja) * | 2007-04-20 | 2013-02-06 | ソニー株式会社 | データ通信システム、携帯電子機器、サーバ装置、およびデータ通信方法 |

| JP2009104599A (ja) * | 2007-10-04 | 2009-05-14 | Toshiba Corp | 顔認証装置、顔認証方法、及び顔認証システム |

-

2009

- 2009-09-02 JP JP2009202690A patent/JP5523027B2/ja active Active

-

2010

- 2010-08-31 US US12/872,847 patent/US20110050901A1/en not_active Abandoned

Also Published As

| Publication number | Publication date |

|---|---|

| JP2011055270A (ja) | 2011-03-17 |

| US20110050901A1 (en) | 2011-03-03 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP5523027B2 (ja) | 情報送信装置及び情報送信方法 | |

| CN102045543B (zh) | 图像处理装置及图像处理方法 | |

| TWI435279B (zh) | 監控系統,影像擷取裝置,分析裝置及監控方法 | |

| JP5358083B2 (ja) | 人物画像検索装置及び画像検索装置 | |

| US11670147B2 (en) | Method and apparatus for conducting surveillance | |

| EP1185106A1 (en) | Method of image feature encoding and method of image search | |

| JP2005312018A (ja) | 監視システム、撮像制御装置、撮像設定装置、制御方法、及びプログラム | |

| KR102133207B1 (ko) | 통신장치, 통신 제어방법 및 통신 시스템 | |

| US11688079B2 (en) | Digital representation of multi-sensor data stream | |

| WO2018122895A1 (ja) | 映像処理装置、映像処理方法、映像処理プログラム、及び映像監視システム | |

| JP6203188B2 (ja) | 類似画像検索装置 | |

| KR20210104979A (ko) | 영상 검색 장치 및 이를 포함하는 네트워크 감시 카메라 시스템 | |

| JP5693147B2 (ja) | 撮影妨害検知方法、妨害検知装置及び監視カメラシステム | |

| JP7084795B2 (ja) | 画像処理装置、画像提供装置、それらの制御方法及びプログラム | |

| JP2017068627A (ja) | 画像処理端末及び画像処理サーバ | |

| CA3057924A1 (en) | System and method to optimize the size of a video recording or video transmission by identifying and recording a region of interest in a higher definition than the rest of the image that is saved or transmitted in a lower definition format | |

| JP2015073191A (ja) | 画像処理システムおよびその制御方法 | |

| EP3454254A1 (en) | Image processing apparatus, image providing apparatus, control methods thereof, and program | |

| CN101959033B (zh) | 广播接收装置 | |

| JP6261191B2 (ja) | 表示制御装置、表示制御方法、プログラム | |

| JP6184133B2 (ja) | 撮像装置 | |

| US10194087B2 (en) | Transmission apparatus, setting apparatus, transmission method, reception method, and storage medium | |

| CN114153214B (zh) | 一种mr/ar/vr留言和创作场景控制方法、移动终端与可读存储介质 | |

| JP2023178007A (ja) | 情報処理装置、情報処理装置の制御方法、及びプログラム | |

| KR20180046044A (ko) | 전방위 영상 표시 장치 및 그 표시 방법 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20120824 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20120824 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20130227 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20130312 |

|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20130507 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20140107 |

|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20140212 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20140311 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20140408 |

|

| R151 | Written notification of patent or utility model registration |

Ref document number: 5523027 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R151 |