JP5473750B2 - 情報処理装置、情報処理方法及びプログラム - Google Patents

情報処理装置、情報処理方法及びプログラム Download PDFInfo

- Publication number

- JP5473750B2 JP5473750B2 JP2010100107A JP2010100107A JP5473750B2 JP 5473750 B2 JP5473750 B2 JP 5473750B2 JP 2010100107 A JP2010100107 A JP 2010100107A JP 2010100107 A JP2010100107 A JP 2010100107A JP 5473750 B2 JP5473750 B2 JP 5473750B2

- Authority

- JP

- Japan

- Prior art keywords

- person

- disappearing

- behavior

- area

- unit

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Landscapes

- Information Retrieval, Db Structures And Fs Structures Therefor (AREA)

- Management, Administration, Business Operations System, And Electronic Commerce (AREA)

Description

例えば、一般家庭の各部屋の天井に備え付けたカメラ及びマイクにより住居人の行動を記録し続け、そこで起こる行動へのアノテーションを半自動的につけることを目指した技術が知られている。

また、床に圧力センサ、天井にカメラやマイクを多数設置された家庭内での生活行動を記録し、人のいる位置に基づく記録映像の要約・閲覧や、家具や人同士のインタラクション検出を行う技術も知られている。

更に、ユーザの現状況の変化に応じて将来状況を予測し、その予測に応じて時間を要する情報処理を前もって始めて、そのユーザの行動に先行させて機器の制御を完了させておく技術も知られている。より具体的には、この技術には、ユーザがテレビ番組を見ている際、CMになったらトイレに行く確率が高いので、CMになる前に便座を暖める情報処理を開始しておく、ということが示されている。

また、カメラを利用する場合、一般家庭環境においてオクルージョンを発生させる事が無いように数多くのカメラを設置して、人物の行動を全て記録することは非常に困難であり、カメラで追跡していた人物が消失してしまうことがしばしば発生する。

即ち、現実には、家庭環境下での全行動を記録しようとしても、それらは部分的に欠損し、細かく分断されたものになる。すると、記録の連続性が利用できないため、人物の行動を記録するための情報処理そのもの(例えば映像からの人物抽出)や、人物行動記録からの行動パターンの抽出が破綻しやすいといった問題が生じる。

こうした問題に対処しうる技術として、家庭環境下での行動を対象にするものではないが、ある一つの行動から時間的・場所的に連続していない未来の行動を予測する技術が、開示されている(特許文献1)。この特許文献1では、「ある行動」とそのあとに続く行動との組合せパターンを使って、「ある行動」の観察に基づくその後の行動予測を行う技術が開示されている。例として、ある人が、朝の決まった時刻に駅の通過した日は、必ずその夕方にビールを購買するという行動パターンがある際には、その人物の朝の駅通過時刻に基づいて、その夕方にはビールを購買するという行動を予測するという例が示されている。

以下に示す実施形態では、映像情報処理装置は、記録できた「ある行動」に関する情報と、その「ある行動」の発現後に得られる情報と、を利用して、再び記録が可能になる「次の行動」を予測する。「次の行動」を予測可能にすることによって、部分的に欠損し細かく分断された行動記録しかできない環境下において、行動記録の非連続性に起因する情報処理の破綻を解決することできる。

即ち以下に示す実施形態では、より少ないセンサ数(究極的にはカメラ一台だけ)で、一般家庭環境下における人物の行動を記録する環境において、人物がカメラの視野外に消失している間、映像情報処理装置は、消失前の情報を利用してその間の行動を推定する。このことで、人物が再度、カメラの前に登場した時の行動追跡等の情報処理精度を向上させることを目指す。

より具体的には、映像情報処理装置は、カメラ映像に映る範囲での行動は従来例と同様に映像として記録すると共に、カメラ映像に映らない範囲での行動は、対象人物が存在する場所を特定した上で定性的に推定し、それをデータとして記録する。映像情報処理装置は、人物存在場所の特定を、カメラ映像において人が消失若しくは登場したエリアに基づいて特定する。この技術を適用する場所が広大ではない一般家庭であれば、消失後若しくは登場前に人が存在しうる場所は限定的であるので、家の中心にあることの多い居間等にカメラを一台設置すれば、消失後若しくは登場前に人が存在していた場所を特定することができる。若しくは少数の候補に限定することができる。更に、一般家庭における場所のそれぞれで起こりうる行動の種類は多くないので、場所が特定(又は限定)されるのであれば、少ないセンサで、若しくはカメラ一台だけでも、そこでの人物行動を高い精度で定性的には推定することができる。そして、映像情報処理装置は、推定した消失時行動に基づき、再度、カメラの前に人物が登場した時の動作、服装、姿勢、場所を予測して行動追跡に必要な初期値やデータベースを切替える。又は、映像情報処理装置は、消失時行動に応じた家電やロボット等の自律制御機器の制御処理の内容をプランニングする。このようにすることで、人物再登場時の行動に適応した情報処理を実施することを目指す。

なお、カメラ映像に映る範囲での行動記録においても、人が物体等の陰に隠れてそこでの行動が映像に記録されないということは、例え複数台のカメラを用いていても、物の多い一般家庭環境では多く起こりうる。よって、以下に示す実施形態は、カメラ映像に映る範囲での行動記録に対しても有効である。

情報処理装置の一例である映像情報処理装置は、カメラ一台だけで、その視野外を含む一般家庭における人物の行動を推定し、推定した内容に基づいた人物際登場時の予測に合わせて情報処理方法を自律的に制御する。以下、図を用いて一例を示す。

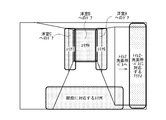

図1は、一般家庭の間取り例を示す図である。一例として3LDKのマンションを想定したものである。即ち、南側(図の下側)にリビングダイニングと和室とがあり、リビングダイニングの北側(図の上側)にカウンターキッチン、そして壁を挟んで洋室Aがある。和室の北側(図の上側)にはバス・トイレがあり、そして壁を挟んで洋室Bがある。また、リビングダイニングから洋室Aと、洋室B、バス・トイレとの間に廊下が伸びて、廊下の北側(図の上側)に玄関がある。

以下、本実施形態に係る映像情報処理装置の構成及び処理について説明する。

図2は、映像情報処理装置のハードウェア構成及びソフトウェア構成等を示す図である。図2の(b)に示すように、映像情報処理装置100は、ハードウェア構成として、CPU110と、記憶装置111と、通信装置112と、を含む。なお、映像情報処理装置100は、カメラ101をハードウェア構成として有してもよいし、カメラ101を映像情報処理装置100とは別体としてもよい。カメラ101を映像情報処理装置100とは別体とする場合、映像情報処理装置100は、ネットワーク等を介してカメラ101からカメラ101で撮影された画像を取得する。カメラ101は、撮影手段の一例であり、現実空間を撮影する。カメラ101は、映像情報処理装置100と通信可能であれば、天井から吊り下げられてもよいし、床や台やテレビの上に据え置いてもよいし、テレビ等の家電に内蔵させてもよい。以下では、図1に示すような一般家庭のリビングの角(図1における右下)に設置されるものとして説明する。この場合、カメラ101は図3に示すようなシーンを撮影する。即ち、カメラ101は、カメラの視野中心にリビングダイニングが映り、左手に和室の引き戸、右手にキッチン、奥側(上側)やや右寄りにバス・トイレへのドア、そしてその右隣に二つの洋室と玄関に続く廊下が映るシーンを撮影する。

CPU110は、記憶装置111等に記憶されているプログラムに基づき処理を実行することによって、図1の(a)に示されるような映像情報処理装置100の機能構成(ソフトウェア構成)を実現する。通信装置112は、CPU110の制御に基づき映像、映像情報処理装置100と他の装置(例えば、カメラ101等)との通信を制御する。なお、図2(a)に示される消失中行動推定モデル保持部104、登場時行動予測モデル保持部107は、より具体的には、記憶装置111の所定の領域である。

カメラ101で撮影された画像(撮影画像)撮影映像は人物抽出部102へと出力される。パンチルトやズームといったカメラパラメータは、固定でもよいし可変であってもよい。カメラパラメータが固定な場合は、パラメータは事前に計測され、人物消失エリア判定部103が保持しているか、参照可能な状態になっている。カメラパラメータが可変な場合、その可変値はカメラ101において計測され、人物消失エリア判定部103へと出力される。

人物抽出部102は、カメラ101から映像を受け取り、この映像中から人物が映っている領域(人物領域)を抽出する処理を行う。この処理に関しては、公知の技術(例えば参考文献1参照)であるので、ここでは詳しく述べない。

<参考文献1>米国特許出願公開第2007/0237387号明細書

人物抽出部102は、映像から人物を検出した際に、その検出領域の情報を人物抽出領域情報として人物消失エリア判定部103に出力する。ここで人物抽出領域情報とは、例えば、座標情報の集まりであったり、代表座標と形状情報との組であったりする。

人物抽出部102は、人物認識機能・服装認識機能・姿勢認識機能・動作認識機能等を備える。人物抽出部102は、映像から抽出された人物が、誰であるか、どんな人であるか(男性か女性か、何歳くらいか、等)、どんな服装であるか、どんな姿勢であるか、どんな動作をしているか、どんな行動をしているか、何を持っているか、等を認識してもよい。この場合、人物抽出部102は、抽出した人物の特徴認識結果を人物抽出領域情報に加えて、人物消失エリア判定部103に出力する。

また、人物抽出部102は、人物が保持する特徴や人物が置かれている状況に応じた認識手法やパラメータを数種類持っており、それらの手法とパラメータとを適応的に変更することで、最適な人物抽出を行うことができる。例えば、日常生活において人物の見え方が劇的に変化する場合として入浴後がある(入浴後は一般的に人物の着衣が変わっている上に、肌の色や髪型も変化しているため)。このような入浴後の人物を抽出するために入浴前の服装や肌の色や髪型によらない方法ならびにパラメータを使うようにすることで、より破綻が少なく人物の抽出を行うことができる。

エリアは、例えば図4に示すような映像の部分領域である。即ち、バス・トイレへのドア及びその近辺が映っている部分映像領域が、現実空間に存在するバス・トイレへのドアに対応付けられて、「バス・トイレへのドアに対応するエリア」となっている。

部分映像領域と現実空間との対応付けには、カメラ101のカメラパラメータが利用される。この対応付け方法は公知の技術であるため(例えば参考文献2参照)、ここでは詳しく述べない。カメラパラメータが変化した場合、映像中のエリアが移動したり変形したりする。全映像領域が何らかのエリアとして定義されていてもよいし、人が消失しうる(映像に映らなくなりうる)領域(の一部)のみが、エリアとして用意されていてもよい。

<参考文献2>出口光一郎、ロボットビジョンの基礎、コロナ社、2000年

人物消失エリアとは、例えば、人物消失エリア判定部103が人物抽出部102から一定時間以上、人物抽出領域情報を受け取り続けたあとに、人物抽出領域情報が受け取れなくなった場合における、最後に受け取った人物抽出領域が含まれるエリアである。この人物消失エリアの定義はあくまで例であり、他の定義を用いてもよい。

人物消失エリア判定部103は、まず、人物消失エリアの存在を、内部に保持する人物抽出領域情報の受け取り履歴(人物抽出領域情報の受け取った時刻のリスト)を参照して確認する。人物消失エリアの存在が確認できた場合、人物消失エリア判定部103は、最後に受け取った人物抽出情報が示す領域が含まれるエリアを、人物消失エリアと判定する。

人物消失エリア判定部103は、人物消失エリアを判定すると、そのエリアを示す情報と人物消失エリアを判定した時刻とを含んだ人物消失エリア情報を消失中行動推定モデル選択部105へと出力する。人物抽出領域情報に抽出された人物の特徴認識結果が含まれる場合、人物消失エリア判定部103は、その特徴認識結果を人物消失エリア情報に含めて、消失中行動推定モデル選択部105へと出力する。

各消失中行動推定モデルは、行動を推定する時刻、(人物消失エリア情報が含む)人物が消失した時刻、その人物が消失してからの時間の長さ、の何れか若しくは全てを変数として持つ。即ち、消失中行動推定モデルの例としては、人物の消失時間帯ごとに消失中行動推定結果がリスト化されているものや、人物の消失時刻及び消失からの経過時間の長さによって消失中行動推定結果が変化する関数等である。

例えば、エリアB用のモデルには、人物がエリアBで消失してから10分以内であれば消失中の人物行動は「トイレの利用」と推定し、10分以上が経過すると消失中の人物行動は「入浴」と推定するようなテーブルが用意されている。

なお、バス・トイレの利用時間は個々人で差があるため、映像情報処理装置100は、その個人差を機械学習等で学習して、消失中行動推定モデルを適応的に変更してもよい。例えば、映像情報処理装置100は、エリアBで人が消失してから10分以上経って人物が再登場した際に、人物の着衣や髪型に変化が無ければ、入浴では無かった(掃除又はトイレ)と判断し、テーブルの情報を書き換えるようにしてもよい。

ここで、人物の行動を推定するモデルは、機械学習における教師なし学習の枠組みの一つでもある参考文献3の自己組織化マップや参考文献4のSOINN等の手法を用いることで効果的に学習することができる。

<参考文献3> 平野廣美著 "C++とJavaでつくるニューラルネットワーク"、パーソナルメディア、2008、p234−257

<参考文献4> Shen Furao and Osamu Hasegawa、 "An Incremental Network for On−line Unsupervised Classification and Topology Learning"、 Neural Networks 、 2005

消失中行動推定モデル選択部105は、人物消失エリア判定部103より人物消失エリア情報を受け取ると、受け取った情報に示される人物消失エリア用の消失中行動推定モデルを消失中行動推定モデル保持部104から取得(又は選択)する。そして、消失中行動推定モデル選択部105は、取得した消失中行動推定モデルを消失中行動推定部106へと出力する。

消失中行動推定モデル選択部105は、人物消失エリア情報に抽出された人物の特徴認識結果が含まれる場合、その特徴認識結果ごとに用意された、人物消失エリア用の消失中行動推定モデルを消失中行動推定モデル保持部104から取得する。そして、消失中行動推定モデル選択部105は、取得した消失中行動推定モデルを消失中行動推定部106へと出力する。例えば、住居人それぞれの用の行動推定モデルが用意されていたり、人物消失時の(正確には消失直前の)人物姿勢や人物動作ごとに行動推定モデルが用意されていたりする。

消失中行動推定部106は、消失中行動推定モデル選択部105より消失中行動推定モデルを受け取ると、受け取った消失中行動推定モデルを利用してカメラ101が撮影している映像中から人物が消失している間の行動を推定する。消失中行動推定部106は、人物の消失が判定された後はその人物が再び映像から抽出されるまで逐次推定を行い、消失中行動推定結果を登場時行動予測部108へと出力する。一例として、エリアBで人物が消失した場合、消失中行動推定部106は、消失中行動推定モデル保持部104から取得したモデルにより、消失してから10分経過するまでは、トイレの使用であると推定し、10分を経過した後は、入浴であると推定する。

登場時行動予測部108は、消失中行動推定部106から消失中行動推定結果を受け取ると、受け取った情報に示される消失中行動推定結果用の登場時行動予測モデルを登場時行動予測モデル保持部107から取得し、これに基づき登場時の行動を予測する。例えば、消失中行動推定結果が「入浴」である場合、登場時行動予測部108は、「消失時とは違う服装で登場する」と予測する。そして、登場時行動予測部108は、登場時行動の予測結果を、情報処理方法変更部109へと出力する。

情報処理方法変更部109は、登場時行動予測部108から登場時行動の予測結果を受け取ると、予測結果に合わせ、必要に応じて情報処理方法を変更する。例えば、登場時行動予測部108で人物が「浴衣に着替え、顔を火照らせて登場する」と予測した場合、情報処理方法変更部109は、以下のように情報処理を変更する。即ち、情報処理方法変更部109は、人物検出処理時に消失前の服装を想定しないように、予め人物抽出部102における服装抽出機能のパラメータを変更したり、顔の火照りを加味し肌色抽出のためのパラメータを変更したりする。この場合、人物抽出部102は、情報処理方法変更部109の変更結果を受け取り、人物抽出に必要なパラメータや抽出手法の変更を行う。

以上のように、人物消失中の行動を推定し、それに基づいて再度、人物が登場するときの行動を予測して情報処理方法を変更することで、例えば人物検出のための初期値を最適化することができる。

以上が、本実施形態にかかる映像情報処理装置100に関する構成部分である。

続いて、図5に示したフローチャートを用いて、本実施形態の映像情報処理装置100が行う処理について説明する。

処理が開始されると、まずステップS100において、カメラ101は、現実空間の撮影を行う。引き続いて、カメラ101は、撮影映像を人物抽出部102に送る。人物抽出部102は、撮影映像中から人物が映っている領域を抽出する。人物抽出部102は、人物が映る領域が抽出されなかった場合、ステップS200へと処理を進める。人物抽出部102は、人物が映る領域が抽出された場合、その抽出領域の情報を人物抽出領域情報として人物消失エリア判定部103に出力する。人物抽出部102が人物認識機能や服装認識機能等を備える場合、抽出された人物の特徴認識結果を人物抽出領域情報に加えて、人物消失エリア判定部103に出力する。それを受け取った人物消失エリア判定部103は、その時刻に人物抽出部102から人物抽出領域情報を受け取ったという情報を内部に記録する。

ステップS200において、人物消失エリア判定部103は、その時刻以前の一定時間に、人物抽出部102から人物抽出領域情報を受け取っているか否かを、内部記録を参照して確認する。人物消失エリア判定部103は、過去の一定時間(例えば3秒)の間に、人物抽出領域情報を受け取っていなければ、即ち人物が継続的に映像中に映っていないと解釈し、処理をステップS100に戻す。逆に、人物消失エリア判定部103は、過去の一定時間(例えば3秒)の間に、人物抽出領域情報を受け取っていれば、即ち過去の一定時間の間に人物が映像中から消失したと解釈し、処理をステップS300へと進める。

ステップS400において、消失中行動推定モデル選択部105は、人物消失エリア判定部103より受け取った人物消失エリア情報に基づいて、人物消失エリアに対応する消失中行動推定モデルを、消失中行動推定モデル保持部104より取得する。人物消失エリア情報に抽出された人物の特徴認識結果が含まれる場合、消失中行動推定モデル選択部105は、抽出された人物の特徴認識結果にも対応している消失中行動推定モデルを消失中行動推定モデル保持部104より取得する。消失中行動推定モデル選択部105は、取得したモデルを、消失中行動推定部106へと送る。その後、消失中行動推定モデル選択部105は、処理をステップS500へと進める。

例えば、図4に示した和室の引き戸に対応するエリアAが人物消失エリアで、人物消失時刻が21時以降で朝6時前であり、消失した人物が消失前にあくびをしていた場合、消失中行動推定部106は「(消失した人物が)和室で寝ている」と推定する。また例えば、図4に示したバス(お風呂)・トイレのドアに対応するエリアBが人物消失エリアで、行動推定時刻が人物消失時刻の5分後であれば、消失中行動推定部106は「(消失した人物が)トイレに入っている」と推定する。時間が経過して、行動推定時刻が人物消失時刻の10分後になり、かつ、人物消失時刻が18時以降24時前であれば、消失中行動推定部106は「(消失した人物が)お風呂に入っている」と推定する。また例えば、同じくエリアBが人物消失エリアで、人物消失時刻が18時よりも前で、消失した人物が掃除道具をもっている場合、消失中行動推定部106は、「(消失した人物が)トイレかお風呂を掃除している」と推定する。また例えば、図4に示した廊下に対応するエリアCが人物消失エリアで、行動推定時刻が人物消失時刻の30分後であれば、消失中行動推定部106は、「(消失した人物が)外出している」と推定する。また例えば、図4に示したキッチンに対応するエリアDが人物消失エリアで、行動推定時刻が夕方17時前後で、消失した人物がこの家の家事を担当する人であれば、消失中行動推定部106は、「(消失した人物が)夕食を準備している」と推定する。

こうして消失した人物の消失中行動を推定すると、消失中行動推定部106は、その消失中行動推定結果を登場時行動予測部108へと送り、処理をステップS600へと進める。

例えば、図4に示したバス(お風呂)・トイレのドアに対応するエリアBが人物消失エリアで、ステップS500の消失中行動推定において「(消失した人物が)お風呂に入っている」と推定されていた場合、人物が再登場する際には着衣の大きな変化が予測できる。したがって、登場時行動予測部108は、エリアBより人物は浴衣に着替えて、消失したエリアと同じエリアBから再登場すると予測する。また、入浴後には体温が上昇するので、登場時行動予測部108は、肌の色が赤味を帯びて登場すると予測する。別の例として、「(消失した人物が)和室で寝ている」と推定されていた場合、登場時行動予測部108は、朝になって再登場するときには着替えていると予想して、見た目上の大きな変化があると予測する。逆に、「(消失した人物が)トイレに入っている」「(消失した人物が)トイレかお風呂を掃除している」と推定されていた場合、登場時行動予測部108は、着衣の変化や肌の色変化等は特に生じないと予測する。

こうして消失した人物が再登場する時の行動を予測すると、登場時行動予測部108は、その行動予測結果を情報処理方法変更部109へと送り、処理をステップS700へと進める。

例えば、ワイシャツとズボンとを着ていた人物がエリアBから消失し、入浴後に再度、エリアBから登場するときには浴衣を着ていると予測された場合、情報処理方法変更部109は、以下のように情報処理を変更する。即ち、情報処理方法変更部109は、入浴前に全身のパーツ情報を利用して人物抽出を行っていたのに対して、入浴後は頭部又は上半身までの情報を利用した方法に切替える。これは、ワイシャツとズボンとを着ていた場合、腕や足のパーツが映像中から分離して抽出することができるが、浴衣を着て登場した場合、ワイシャツやズボンの時ほど腕や足のパーツが明確に抽出できなくなるためである。また、入浴後は入浴前と比べ、体温が上昇しているため、顔や腕の色が赤味を帯びる傾向にある。したがって、肌色抽出を行う場合、情報処理方法変更部109は、予め登録しておいた肌色の情報に加えて、赤味成分も加味した色抽出パラメータを設定する。また、消失人物の身長等の情報が予め入力されているシステムの場合、情報処理方法変更部109等は、再登場時の頭の位置を大まかに推定することも可能である。そのため、情報処理方法変更部109は、再登場時に行う人物探索エリアを限定しておくこともできる。

このようにして、消失した人物が再度、登場する際の行動予測に基づいて人物抽出の方法ならびにパラメータを変更すると、情報処理方法変更部109は、人物抽出部102にその結果を反映し、処理をステップS800へと進める。なお、ここでは、人物が再度、登場する際に認識方法を変更する処理について言及したが、必ずしもアルゴリズムの変更や設置したカメラパラメータの変更するだけに留まらない。情報処理方法変更部109は、人物の行動を推定・予測することで対人ロボットのような自律制御機器の制御処理の内容を変更するようにしてもよい。例えば、入浴後にエリアBより身体に障害がある人物が再登場する場合、情報処理方法変更部109は、対人ロボットに制御処理の内容を変更するパラメータ等を、無線等を介して送信する。対人ロボットは、無線等を介してパラメータ等を受信すると、受信したパラメータに基づき、例えば、予めエリアB付近に待機しておき、登場後、直ぐにケアできるような姿勢をとるように制御を実行する。

以上の処理によって、映像情報処理装置100は、カメラ一台だけで、視野外を含む一般家庭における人物の行動を推定し、推定した内容に基づいた人物再登場時行動の予測に合わせて情報処理方法を自律的に制御することができる。

本実施形態に係る映像情報処理装置は、視野の重なりのない複数台のカメラと、それぞれのカメラのそばにあるセンサと、それぞれのカメラから離れた場所にあるセンサとにより、カメラの視野外を含む一般家庭における人物の行動を推定する。そして、映像情報処理装置は、推定した内容に基づいて人物再登場時行動の予測に合わせて情報処理方法を自律的に制御する。以下、図を用いて一例を示す。

図6及び図7は、本実施形態が対象とする一般家庭の間取りの例を示す図である。4LDKの2階建て戸建てを想定したものである。図6が1階間取り、図7が2階間取りを示している。図6に示した1階にはソファとダイニングテーブルとが置かれたリビングダイニング、和室、キッチン、トイレ1、玄関、2階への階段がある。図7に示した2階には1階からの階段、洋室A、洋室B、洋室C、洗面所・バス、トイレ2がある。

以下、本実施形態に係る映像情報処理装置の構成及び処理について説明する。

図8は、映像情報処理装置のソフトウェア構成等を示す図である。なお、本実施形態の映像情報処理装置200のハードウェア構成は、第一実施形態の映像情報処理装置100のハードウェア構成と同様である。なお、映像情報処理装置200は、各カメラ及び各センサをハードウェア構成として有してもよいし、各カメラ及び各センサを映像情報処理装置200とは別体としてもよい。各カメラ及び各センサを映像情報処理装置200とは別体とする場合、映像情報処理装置200は、ネットワーク等を介して各カメラ及び各センサと通信可能に接続されているものとする。

カメラ201は、現実空間を撮影する。カメラ201は、映像情報処理装置200と通信可能であれば、天井から吊り下げられてもよいし、床や台やテレビの上に据え置いてもよいし、テレビ等の家電に内蔵させてもよい。以下では、図6に示すようなリビングの南側の(図の下側の)壁際に置かれるテレビの上にカメラを置く場合を想定する。この場合、カメラ201には図9に示すようなシーンが映り、この住居に住む家族がリビングダイニングで食事をしたり、くつろいだりする様子が撮影できる。しかし、リビングダイニング以外の場所である和室、キッチン、トイレ1、玄関、2階への階段の様子は撮影されない。

カメラ210も、現実空間を撮影する。カメラ210も、映像情報処理装置200と通信可能であれば、天井から吊り下げられてもよいし、床や台やテレビの上に据え置いてもよいし、テレビ等の家電に内蔵させてもよい。以下では、図7に示すような、1階からの階段を上ったところの天井にカメラが設置される場合を想定する。この場合、カメラ210には図10に示すようなシーンが映る。即ち、洋室A、洋室B、洋室Cのドアと、トイレ2及び洗面所・バスへと続く短い廊下と、が映る。

なお、消失中行動推定モデル保持部204、登場時行動予測モデル保持部207は、より具体的には、記憶装置111の所定の領域である。

カメラ201及びカメラ210の撮影映像は、両方とも人物抽出部202へと出力される。パンチルトやズームといったカメラパラメータは、カメラ201及びカメラ210の何れも、固定でもよいし可変であってもよい。カメラパラメータが固定な場合は、パラメータは事前に計測され、人物消失エリア判定部203が保持しているか、参照可能な状態になっている。カメラパラメータが可変な場合、その可変値はカメラ201、カメラ210それぞれにおいて計測され、人物消失エリア判定部203へと出力される。

人物抽出部202は、カメラ201及びカメラ210から映像を受け取り、この映像中から人物が映っている領域を抽出する処理を行う。人物抽出部202は、映像から人物を抽出した際に、その抽出領域の情報を人物抽出領域情報として人物消失エリア判定部203に出力する。ここで人物抽出領域情報とは、例えば座標情報の集まりであったり、代表座標と形状情報との組であったりする。更に人物抽出領域情報は、その抽出がどのカメラで行われたのかがわかるデータを含んでいる。

人物抽出部202は、人物認識機能・服装認識機能・姿勢認識機能・動作認識機能等を備える。人物抽出部202は、映像から抽出された人物が、誰であるか、どんな人であるか(男性か女性か、何歳くらいか、等)、どんな服装であるか、どんな姿勢であるか、どんな動作をしているか、どんな行動をしているか、何を持っているか、等を認識してもよい。この場合、人物抽出部202は、抽出した人物の特徴認識結果を人物抽出領域情報に加えて、人物消失エリア判定部203に出力する。

人物消失エリア判定部203は、現実空間の部分領域に対応付けられた映像の部分領域(「エリア」)から、カメラ201若しくはカメラ210が撮影している映像中で人物が消失したエリア(人物消失エリア)を判定する。人物消失エリア判定部203は、人物消失エリアを判定すると、そのエリアを示す情報と人物消失エリアを判定した時刻とを含んだ人物消失エリア情報を消失中行動推定モデル選択部205へと出力する。人物抽出領域情報に抽出された人物の特徴認識結果が含まれる場合、人物消失エリア判定部203は、その特徴認識結果を人物消失エリア情報に含めて、人物消失エリア情報を消失中行動推定モデル選択部205へと出力する。

消失中行動推定モデル選択部205は、人物消失エリア判定部203より人物消失エリア情報を受け取ると、受け取った情報に示される人物消失エリア用の消失中行動推定モデルを消失中行動推定モデル保持部204から取得する。そして、消失中行動推定モデル選択部205は、取得した消失中行動推定モデルを消失中行動推定部206へと出力する。人物消失エリア情報に抽出された人物の特徴認識結果が含まれる場合、消失中行動推定モデル選択部205は、その特徴認識結果ごとに用意された、人物消失エリア用の消失中行動推定モデルを消失中行動推定モデル保持部204から取得する。そして、消失中行動推定モデル選択部205は、取得した消失中行動推定モデルを消失中行動推定部206へと出力する。

消失中行動推定部206は、消失中行動推定モデル選択部205より消失中行動推定モデルを受け取ると、それを利用してカメラ201若しくはカメラ210が撮影している映像中から人物が消失した後の行動を推定する。ここで、消失中行動推定部206は、受け取った消失中行動推定モデルの中身に基づき、必要であればセンサ211、センサ212、センサ213よりセンサ出力を得る。消失中行動推定部206は、人物の消失が判定された後はその人物が再び映像から抽出されるまで逐次推定を行い、消失中行動推定結果を登場時行動予測部208へと出力する。

登場時行動予測部208は、消失中行動推定部206から消失中行動推定結果を受け取ると、受け取った情報に示される消失中行動推定結果用の登場時行動予測モデルを登場時行動予測モデル保持部207から取得し、これに基づき登場時の行動を予測する。そして登場時行動予測部208は、登場時行動の予測結果を、情報処理方法変更部209へと出力する。

情報処理方法変更部209は、登場時行動予測部208から登場時行動の予測結果を受け取ると、予測結果に合わせ、必要に応じて情報処理方法を変更する。例えば、登場時行動予測部208で人物が「浴衣に着替え、顔を火照らせて登場する」と予測された場合、情報処理方法変更部209は、以下のように情報処理の方法を変更する。即ち、情報処理方法変更部209は、人物抽出処理時に消失前の服装を想定しないように予め人物抽出部202における服装抽出機能のパラメータを変更したり、顔の火照りを加味し肌色抽出のためのパラメータを変更したりする。この場合、人物抽出部202は、情報処理方法変更部209の変更結果を受け取り、人物抽出に必要なパラメータや抽出手法の変更を行う。なお、先に述べたように、本実施形態の場合、消失した人物は必ずしも消失した場所(人物消失エリア)から再び登場するとは限らない。ということは、必ずしも人物の消失を判定したカメラと同じカメラで再登場を検出するとは限らない。したがって、情報処理方法変更部209は、人物抽出部202の情報処理方法やそのパラメータを変更する際、以下の様に情報処理方法を変更する。即ち、情報処理方法変更部209は、登場時行動予測に含まれる「どのカメラ映像のどの場所(エリア)から人物が登場するか」という予測内容に基づき、しかるべきカメラに関する情報処理方法を変更する。

センサ211は、カメラ201及びカメラ210とは離れた場所に設置される現実空間における現象を計測又は検知するセンサである。例えば、カメラ201とカメラ210との視野外の現実空間におかれた家電製品や電灯のON/OFFを検知するセンサであったり、人の存在を検知する人感センサであったりする。説明上、センサ211と単数表記をしているが、センサ自体が複数あってもよいし、複数の場所にそれぞれ独立に存在していてもよい(即ち、センサ214、センサ215、・・・と数多くのセンサが存在してよい。)。

なお、本実施形態では、カメラ201及びカメラ210の出力を人物抽出部202へ入力して情報を統合した上で人物の消失中行動を推定しているが、必ずしも入力を統合してから消失中行動を推定する必要はない。つまり、カメラ201とカメラ210との入力をそれぞれ異なる系統で処理を行い、別々に出力された結果をそれぞれの場合に応じて適応的に選択して情報処理方法変更部209で認識方法やパラメータを変更してもよい。それはカメラを設置するシーンや構築するシステムに応じて好適な手段を選択すればよい。

以上が、本実施形態にかかる映像情報処理装置200に関する構成部分である。

続いて、図11に示したフローチャートを用いて、本実施形態の映像情報処理装置200が行う処理について説明する。

処理が開始されると、まずステップS101において、カメラ201及びカメラ210は、現実空間の撮影を行う。引き続いて、カメラ201及びカメラ210は、撮影映像を人物抽出部202に送る。人物抽出部202は、撮影映像中から人物が映っている領域を抽出する。人物抽出部202は、人物が映る領域が抽出されなかった場合、ステップS201へと処理を進める。人物抽出部202は、人物が映る領域が抽出された場合、その抽出領域の情報を、どちらのカメラの領域であるかを示す識別情報も含めて、人物抽出領域情報として人物消失エリア判定部203に出力する。人物抽出部202が人物認識機能や服装認識機能等を備える場合、人物抽出部202は、抽出した人物の特徴認識結果を人物抽出領域情報に加えて、人物消失エリア判定部203に出力する。それ受け取った人物消失エリア判定部203は、その時刻に人物抽出部202から人物抽出領域情報を受け取ったという情報を内部に記録する。ここで、原理的にはカメラ201及びカメラ210の両方で同時に人物が検出されうるし、実際に同時に行ってもよいが、以下の説明では、それぞれのカメラ映像における人物抽出は同時には行われない場合を想定して、説明を続ける。

ステップS201において、人物消失エリア判定部203は、その時刻以前の一定時間に、人物抽出部202から人物抽出領域情報を受け取っているか否かを、内部記録を参照して確認する。ここで、過去の一定時間(例えば3秒)の間に、人物抽出領域情報を受け取っていなければ、人物消失エリア判定部203は、即ち人物が継続的に映像中に映っていないと解釈し、処理をステップS101に戻す。逆に、過去の一定時間(例えば3秒)の間に、人物抽出領域情報を受け取っていれば、人物消失エリア判定部203は、即ち過去の一定時間の間に人物が映像中から消失したと解釈し、処理をステップS301へと進める。

ステップS401において、消失中行動推定モデル選択部205は、人物消失エリア判定部203より受け取る人物消失エリア情報に基づいて、人物消失エリアに対応する行動推定モデルを、消失中行動推定モデル保持部204より取得する。人物消失エリア情報に抽出された人物の特徴認識結果が含まれる場合、消失中行動推定モデル選択部205は、抽出された人物の特徴認識結果にも対応している行動推定モデルを消失中行動推定モデル保持部204より取得する。消失中行動推定モデル選択部205は、取得したモデルを、消失中行動推定部206へと送る。その後、消失中行動推定モデル選択部205は、処理をステップS501へと進める。

例えば、以下の場合を例に説明を行う。

(1)図12に示した玄関及びトイレ1へと続く扉のある方向に対応するカメラ201の映像中のエリアEが人物消失エリアで、センサ212のうちのその方向を向いたマイクが室内ドアの開閉音を録音した場合

(2)センサ212のエリアEの方を向いたマイクが屋外ドアの開閉音と鍵をかける音を録音した場合

(3)図12に示した和室・キッチン・階段へと続く方向に対応するカメラ201の映像中のエリアFが人物消失エリアで、センサ212のエリアFの方向を向いたマイクが水の音を録音した場合

(4)キッチンに置かれたコーヒーメーカーのスイッチがONになったことがセンサ211の出力から判断された場合

(5)センサ212のエリアFの方向を向いたマイクが襖を開け閉めする音を録音した場合

(6)センサ212のエリアFの方向を向いたマイクが階段を登る音を録音した場合

(7)図13に示した洋室A/B/Cのドアに対応するカメラ210映像中のエリアG/H/Iが人物消失エリアで、人物消失時間が21時以降で朝6時前であり、かつ、消失人物がその洋室A/B/Cを主に利用する人物である場合

(8)エリアG/H/Iが人物消失エリアで、人物消失時間が深夜0時以降で朝6時前であり、消失人物がその洋室A/B/Cを主に利用しない人物で、かつ、カメラ210のそばに備え付けられたセンサ213が咳き込む音を記録した場合

(9)図13に示したトイレ2、洗面所・バスのある方向に対応するカメラ210映像中のエリアJが人物消失エリアであり、洗面台の電灯のスイッチがONになったことがセンサ213の出力から判断された場合

(10)センサ213が浴室の引き戸が閉まる音を記録した場合

(11)センサ213がトイレ2のドアが閉まる音を記録した場合

(12)図13に示した階段に続く方向に対応するカメラ210の映像中のエリアKが人物消失エリアである場合、

(1)の場合、消失中行動推定部206は、「(消失した人物が)トイレに入った」と推定する。(2)の場合、消失中行動推定部206は「(消失した人物が)外出した」と推定する。(3)の場合、消失中行動推定部206は「(消失した人物が)キッチンで水仕事をしている」と推定する。(4)の場合、消失中行動推定部206は、「(消失した人物が)キッチンでコーヒーをつくっている」と推定する。(5)の場合、消失中行動推定部206は、「(消失した人物が)和室に入った」と推定する。(6)の場合、消失中行動推定部206は、「(消失した人物が)二階へ行った」と推定する。(7)の場合、消失中行動推定部206は、「(消失した人物が)自分の部屋で寝た」と推定する。(8)の場合、消失中行動推定部206は、「(消失した人物が)洋室A/B/Cの主を心配して見に行った」と推定する。(9)の場合、消失中行動推定部206は、「(消失した人物が)洗面台を使っている」と推定する。(10)の場合、消失中行動推定部206は、「(消失した人物が)お風呂に入った」と推定する。(11)の場合、消失中行動推定部206は、「(消失した人物が)トイレに入った」と推定する。(12)の場合、消失中行動推定部206は、「(消失した人物が)一階へ降りて行った」と推定する。

消失した人物の消失中の行動を推定すると、消失中行動推定部206は、その行動推定結果を登場時行動予測部208へと送り、処理をステップS601へと進める。

ステップS701において、情報処理方法変更部209は、登場時行動予測部208から受け取った予測結果に基づいて、人物抽出部202の人物抽出方法ならびに抽出に用いるパラメータ、若しくはカメラ201に適応するカメラパラメータを変更する。その後、情報処理方法変更部209は、人物抽出部202にその結果を反映し、処理をステップS801へと進める。

先の例でも挙げた通り、登場時行動予測結果に基づく情報処理方法の変更は、人物抽出方法の変更に限らない。例えば、自律移動型の介護ロボットの制御内容を変更してもよい。このケースを想定した場合、センサ213の値から、「(消失した人物が)入浴が終了し、今から着替えて数分後にエリアJより登場する」ことが予測できたとすると、情報処理方法変更部209は、現在進行中の作業を一旦停止する旨の命令が発行する。この命令に基づき、自律移動型の介護ロボットは、介護作業を行うためエリアJに移動する処理に移る。

以上の処理によって、映像情報処理装置200は、視野の重なりのない複数台のカメラと、それぞれのカメラのそばにあるセンサと、それぞれのカメラから離れた場所にあるセンサとにより、視野外を含む一般家庭における人物の行動を推定する。そして、映像情報処理装置200は、推定した内容に基づいた人物再登場時行動の予測を行うことで情報処理方法を自律的に制御する。なお、本実施形態ではカメラが二台を例にしているが、カメラの台数はこれに制限されるものではない。また、本実施形態ではセンサとしてマイクと家電のONを検知するセンサとを例にしているが、センサの種類等はこれに制限されるものではない。

本実施形態に係る映像情報処理装置は、撮像装置の視野内に人物がいるにも関わらずオクルージョンによって一時的に消失した場合、その消失中の人物の行動を推定し、推定した内容に基づいた人物再登場時行動の予測に合わせた情報処理方法の自律制御を実現する。以下、図を用いて一例を示す。

図14及び図15は、本実施形態が対象とする一般家庭の間取りの例を示す図である。第1実施形態で対象とした間取りと一緒である。但し、カメラを設置する位置が異なっている。

以下、本実施形態に係る映像情報処理装置の構成及び処理について説明する。

図16は、映像情報処理装置のソフトウェア構成等を示す図である。なお、本実施形態の映像情報処理装置300のハードウェア構成は、第一実施形態の映像情報処理装置100のハードウェア構成と同様である。なお、映像情報処理装置300は、カメラ301及びセンサ310をハードウェア構成として有してもよいし、カメラ301及びセンサ310を映像情報処理装置300とは別体としてもよい。カメラ301及びセンサ310を映像情報処理装置300とは別体とする場合、映像情報処理装置300は、ネットワーク等を介してカメラ301及びセンサ310と通信可能に接続されているものとする。

カメラ301は、現実空間を撮影する。カメラ301は、映像情報処理装置300と通信可能であれば、天井から吊り下げられてもよいし、床や台やテレビの上に据え置いてもよいし、テレビ等の家電に内蔵させてもよい。以下では、カメラ301は、一般家庭のリビングの壁際に観察対象となる人物と同じくらいの目線の高さで設置されるものとして説明する。この場合、カメラ301は、図14に示すようなシーン、即ち、カメラの視野中心にリビングダイニングが映り、左手にバス・トイレへのドア、右手の手前にカウンター、その奥にキッチン、そして玄関に続く廊下が映るシーンを撮影する。

なお、消失中行動推定モデル保持部304、登場時行動予測モデル保持部307は、より具体的には、記憶装置111の所定の領域である。

カメラ301の撮影映像は人物抽出部302へと出力される。パンチルトやズームといったカメラパラメータは、固定でもよいし可変であってもよい。カメラパラメータが固定な場合は、パラメータは事前に計測され、人物消失エリア判定部303が保持しているか、参照可能な状態になっている。カメラパラメータが可変な場合、その可変値はカメラ301において計測され、人物消失エリア判定部303へと出力される。

人物抽出部302は、カメラ301から映像を受け取り、この映像中から人物が映っている領域を抽出する処理を行う。処理の詳細は第一実施形態で説明した処理内容と同一であるため、ここでは説明を省略する。

人物消失エリアの判定は、まず、人物消失エリア判定部303が人物消失エリアの存在を、内部に保持する人物抽出領域情報の受け取り履歴(人物抽出領域情報の受け取った時刻のリスト)を参照して確認する。人物消失エリアの存在が確認できた場合、人物消失エリア判定部303は、最後に受け取った人物抽出情報が示す領域が含まれるエリアを、人物消失エリアと判定する。続いて人物消失エリア判定部303は、人物消失エリアを判定すると、それが事前に定義されている「他の空間への移動に伴う消失が起こるエリア」であるかどうかを判別する。そして、人物消失エリア判定部303は、その判別結果を示す情報とそのエリアを示す情報と人物消失エリアを判定した時刻とを含んだ人物消失エリア情報を、消失中行動推定モデル選択部305へと出力する。人物抽出領域情報に抽出された人物の特徴認識結果が含まれる場合、人物消失エリア判定部303は、その特徴認識結果を人物消失エリア情報に含めて、人物消失エリア情報を消失中行動推定モデル選択部305へと出力する。

消失中行動推定部306は、消失中行動推定モデル選択部305より消失中行動推定モデルを受け取ると、それを利用してカメラ301が撮影している映像中から人物が消失している間の行動を推定する。ここで、受け取った消失中行動推定モデルの中身に基づき、消失中行動推定部306は、必要であればセンサ310よりセンサ出力を得る。例えば、図15に示すように人物が「他の空間への移動に伴う消失が起こるエリア」ではない、ある人物消失エリアで消失した際に、センサ310が「ドン」という大きな音を計測した場合は、消失中行動推定部306は、以下のように推定する。つまり、消失中行動推定部306は、消失してからの時間が経過せずとも物陰で人物が何らかの異常行動を起こしたと推定する。消失中行動推定部306は、このような推定を、人物の消失が判定された後、その人物が再び映像から抽出されるまで逐次行い、消失中行動推定結果を登場時行動予測部308へと出力する。

登場時行動予測部308は、消失中行動推定部306から消失中行動推定結果を受け取ると、受け取った情報に示される消失中行動推定結果用の登場時行動予測モデルを登場時行動予測モデル保持部307から取得し、これに基づき登場時の行動を予測する。そして、登場時行動予測部308は、登場時行動予測結果を、情報処理方法変更部309へと出力する。

情報処理方法変更部309は、登場時行動予測部308から登場時行動の予測結果を受け取ると、第一実施形態と同様に予測結果に合わせ、必要に応じて情報処理方法を変更する。例えば、空間の移動ではなく物陰に隠れた場合の消失については、再び映像に登場するときに見た目はあまり変わらないが登場する場所は消失する場所と異なるケースが多い。したがって、情報処理方法変更部309は、消失前の行動(例えば移動方向)等に基づいて、登場する場所を事前に予測し、その場所が映る映像を重点的に処理することで登場時行動の認識精度を上げる等の情報処理方法の変更を行う。

以上のように、人物消失中の行動を推定し、それに基づいて再度、人物が登場するときの行動を予測して情報処理方法を変更することで、例えば人物検出のための初期値を最適化することができる。

以上が、本実施形態にかかる映像情報処理装置300に関する構成部分である。

続いて、図17に示したフローチャートを用いて、本実施形態の映像情報処理装置300が行う処理について説明する。

処理が開始されると、まずステップS102において、カメラ301は、現実空間の撮影を行う。それ以降のステップS202からステップS402までの処理は、第一実施形態と同様であるため、ここでは処理の説明を省略する。

ステップS502において、消失中行動推定部306は、消失中行動推定モデル選択部305から受け取った消失中行動推定モデルに基づいて、カメラ301の撮影映像中から消失した人物の、消失中の行動推定を行う。この消失中行動推定方法は、行動を推定する時刻ならびに人物消失エリア情報が含む人物消失時刻、ならびにセンサ310のセンサ出力を用いて行われ、その実現方法はなんでもよい。以下、消失中行動推定部306における推定の例を示す。

消失中行動推定部306は、以下に示すような場合、第一実施形態及び第二実施形態と同様の処理に基づいて処理を行う。つまり、例えば、図15に示すような「バス・トイレへのドアに対応するエリアL」、「キッチンに対応するエリアM」、「玄関・外出に対応するエリアN」が対応付けられていた場合で、かつ、それらのエリアから人物が消失した場合である。一方、図15に示すようにカウンターの後ろ(エリアL〜N以外の領域)で急に人物が消失した場合で、そのカウンターの後ろ側に何か日用品を保管していた場合、消失中行動推定部306は、「日用品を取るために人物が消失した」と推定する。このとき、センサ310が不自然な物音を同時に記録していた場合、消失中行動推定部306は、その人物が何らかの異常行動を起こしたと推定する。

こうして消失した人物の消失中の行動を推定すると、消失中行動推定部306は、その消失時行動推定結果を登場時行動予測部308へと送り、処理をステップS602へと進める。

例えば、図15に示すようにカウンターの後ろ(エリアL〜N以外の領域)で急に人物が消失した場合で、何らかの異常音等が確認されない場合、消失中行動推定部306は、「日用品を取るために人物が消失した」と推定する。そして、登場時行動予測部308は、「数秒後又は数分後にはカウンター付近から人物が登場する」と予測する。また、何らかの異常音が確認された場合、登場時行動予測部308は、「(転倒等の異常行動の発生により)このままでは人物は再登場しない」と予測する。その後、登場時行動予測部308は、その行動予測結果を情報処理方法変更部309へと送り、処理をステップS702へと進める。

先の例でも挙げた通り、登場時行動予測結果に基づく情報処理方法の変更は、人物抽出方法の変更に限らない。例えば、要介護者が人物消失エリア以外で一定時間出てこない場合、若しくはカメラ以外のセンサによって、何らかの異常が発生したと予測できる場合、その異常に対応すべく、情報処理方法変更部309は、処理内容を変更してもよい。即ち、出力装置がディスプレイであった場合、情報処理方法変更部309は、異常がある旨をディスプレイに警告表示したり、音で提示したりする。また、情報処理方法変更部309は、自律移動型ロボットに、消失したと思われる地点に移動し人物を発見するといった行動をとらせるよう制御する。また、予測の結果、特に処理内容を変更する必要がない場合、情報処理方法変更部309は、現在進行中の処理を継続して行わせる。

このようにして、消失した人物が再度、登場する際の行動予測に基づいて情報処理方法を変更すると、情報処理方法変更部309は、人物抽出部302にその結果を反映し、処理をステップS802へと進める。

また、以上の実施形態で述べた、消失中行動推定に用いる人物消失エリア、消失中行動推定時刻、人物消失時刻、人物消失時刻からの経過時間等の閾値パラメータは、使用者の行動や室内の構造・配置に応じて、使用者が自由に設定してよい。又は、上記映像情報処理装置を設置した際に、上述の消失中行動推定結果の記録と実際の行動との差異から上記パラメータを最適化する初期化操作を行ってもよい。また使用者の年齢変化に応じて、上記パラメータを自動的に変化させたり行動変化の結果を用いて自動学習させたりしてもよい。

また、本発明は、以下の処理を実行することによっても実現される。即ち、上述した実施形態の機能を実現するソフトウェア(プログラム)を、ネットワーク又は各種記憶媒体を介してシステム或いは装置に供給し、そのシステム或いは装置のコンピュータ(又はCPUやMPU等)がプログラムを読み出して実行する処理である。

Claims (11)

- 撮影手段で撮影された映像から消失した人物の消失中の行動を推定する消失中行動推定手段と、

前記消失中行動推定手段で推定された消失中行動に対応する登場時行動予測モデルを、消失中行動ごとの複数の登場時行動予測モデルを保持する登場時行動予測モデル保持手段より取得する取得手段と、

前記取得手段で取得した登場時行動予測モデルに基づき前記映像から消失した人物が再び映像中に登場するときの行動を予測する登場時行動予測手段と、

を有する情報処理装置。 - 撮影手段で撮影された映像から人物領域を抽出する人物抽出手段と、

前記人物抽出手段で抽出された人物領域に基づき前記映像から人物が消失したエリアを判定する人物消失エリア判定手段と、

を更に有し、

前記消失中行動推定手段は、前記人物消失エリア判定手段で判定されたエリアに対応する消失中行動推定モデルを、エリアごとの複数の消失中行動推定モデルを保持する消失中行動推定モデル保持手段より取得し、取得した消失中行動推定モデルに基づき映像から消失した人物の消失中の行動を推定する請求項1記載の情報処理装置。 - 前記人物消失エリア判定手段は、前記人物抽出手段で抽出された人物領域に基づき前記映像から人物が消失したエリアが事前に定義された他の空間への移動に伴う消失が起こるエリアであるか否かを判定する請求項2記載の情報処理装置。

- 前記登場時行動予測手段で予測された行動に基づき、実行すべき処理を変更する変更手段を更に有する請求項2記載の情報処理装置。

- 前記変更手段は、前記登場時行動予測手段で予測された行動に基づき、前記人物抽出手段での人物抽出処理を変更する請求項4記載の情報処理装置。

- 前記変更手段は、前記登場時行動予測手段で予測された行動に基づき、自律制御機器の制御処理の内容を変更する請求項4記載の情報処理装置。

- 前記消失中行動推定モデルは、前記人物の消失が起こった時刻に基づいて消失中行動推定結果を推定するモデルである請求項2乃至6何れか1項記載の情報処理装置。

- 前記人物抽出手段は、撮影手段で撮影された映像から人物領域を抽出し、抽出した人物領域の人物の特徴を認識し、

前記消失中行動推定モデルは、前記人物抽出手段で認識された人物の特徴に基づいて、消失中行動推定結果を推定するモデルである請求項2乃至6何れか1項記載の情報処理装置。 - 現象を計測又は検知するセンサを更に有し、

前記消失中行動推定モデルは、人物の消失中に得られる前記センサの出力に基づいて消失中行動推定結果を推定するモデルである請求項2乃至6何れか1項記載の情報処理装置。 - 情報処理装置が実行する情報処理方法であって、

撮影手段で撮影された映像から消失した人物の消失中の行動を推定する消失中行動推定ステップと、

前記消失中行動推定ステップで推定された消失中行動に対応する登場時行動予測モデルを、消失中行動ごとの複数の登場時行動予測モデルを保持する登場時行動予測モデル保持手段より取得する取得ステップと、

前記取得ステップで取得した登場時行動予測モデルに基づき前記映像から消失した人物が再び映像中に登場するときの行動を予測する登場時行動予測ステップと、

を含む情報処理方法。 - コンピュータを、

撮影手段で撮影された映像から消失した人物の消失中の行動を推定する消失中行動推定手段と、

前記消失中行動推定手段で推定された消失中行動に対応する登場時行動予測モデルを、消失中行動ごとの複数の登場時行動予測モデルを保持する登場時行動予測モデル保持手段より取得する取得手段と、

前記取得手段で取得した登場時行動予測モデルに基づき前記映像から消失した人物が再び映像中に登場するときの行動を予測する登場時行動予測手段と、

して機能させるプログラム。

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2010100107A JP5473750B2 (ja) | 2010-04-23 | 2010-04-23 | 情報処理装置、情報処理方法及びプログラム |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2010100107A JP5473750B2 (ja) | 2010-04-23 | 2010-04-23 | 情報処理装置、情報処理方法及びプログラム |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2011232822A JP2011232822A (ja) | 2011-11-17 |

| JP2011232822A5 JP2011232822A5 (ja) | 2013-06-06 |

| JP5473750B2 true JP5473750B2 (ja) | 2014-04-16 |

Family

ID=45322099

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2010100107A Active JP5473750B2 (ja) | 2010-04-23 | 2010-04-23 | 情報処理装置、情報処理方法及びプログラム |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP5473750B2 (ja) |

Families Citing this family (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP5849762B2 (ja) * | 2012-02-22 | 2016-02-03 | 日本電気株式会社 | 予測情報提示システム、予測情報提示装置、予測情報提示方法および予測情報提示プログラム |

| JP5956248B2 (ja) * | 2012-05-21 | 2016-07-27 | セコム株式会社 | 画像監視装置 |

| JP7268604B2 (ja) * | 2017-12-25 | 2023-05-08 | コニカミノルタ株式会社 | 被監視者監視支援装置、被監視者監視支援システム、被監視者監視支援方法、および、被監視者監視支援プログラム |

| CN110094782B (zh) * | 2019-05-20 | 2020-09-04 | 珠海格力电器股份有限公司 | 一种智能油烟机的控制方法及智能油烟机 |

Family Cites Families (7)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP5027359B2 (ja) * | 2001-06-14 | 2012-09-19 | パナソニック株式会社 | 人体検知装置 |

| US6856249B2 (en) * | 2002-03-07 | 2005-02-15 | Koninklijke Philips Electronics N.V. | System and method of keeping track of normal behavior of the inhabitants of a house |

| JP2004185431A (ja) * | 2002-12-04 | 2004-07-02 | Sekisui Chem Co Ltd | 生活状況環境表現装置及び表現装置 |

| JP2005199403A (ja) * | 2004-01-16 | 2005-07-28 | Sony Corp | 情動認識装置及び方法、ロボット装置の情動認識方法、ロボット装置の学習方法、並びにロボット装置 |

| JP2008052626A (ja) * | 2006-08-28 | 2008-03-06 | Matsushita Electric Works Ltd | 浴室異常検知システム |

| JP2009098774A (ja) * | 2007-10-15 | 2009-05-07 | Mitsubishi Electric Corp | 人物追跡システム及び人物追跡方法及び人物追跡プログラム |

| JP5012589B2 (ja) * | 2008-03-10 | 2012-08-29 | 三菱電機株式会社 | 画像情報を用いた人物追跡システム |

-

2010

- 2010-04-23 JP JP2010100107A patent/JP5473750B2/ja active Active

Also Published As

| Publication number | Publication date |

|---|---|

| JP2011232822A (ja) | 2011-11-17 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| US11120559B2 (en) | Computer vision based monitoring system and method | |

| US20110091069A1 (en) | Information processing apparatus and method, and computer-readable storage medium | |

| JP2007156577A (ja) | 生活支援ロボットによる色情報獲得方法 | |

| CN114391163A (zh) | 手势检测系统和方法 | |

| US20150302310A1 (en) | Methods for data collection and analysis for event detection | |

| JP6725411B2 (ja) | 行動評価装置、行動評価方法 | |

| JP5473750B2 (ja) | 情報処理装置、情報処理方法及びプログラム | |

| GB2525476A (en) | Method and device for monitoring at least one interior of a building, and assistance system for at least one interior of a building | |

| JP6720909B2 (ja) | 行動検知装置、該方法および該プログラム、ならびに、被監視者監視装置 | |

| CN109753865B (zh) | 对象历史关联的系统和方法 | |

| WO2013006508A1 (en) | Activity recognition in multi-entity environments | |

| CN104742140B (zh) | 状态判定系统、状态判定方法及移动机器人 | |

| Dovgan et al. | Intelligent elderly-care prototype for fall and disease detection | |

| JP7407562B2 (ja) | 危険行動予防装置、危険行動予防システム、危険行動予防方法及び危険行動予防プログラム | |

| EP3616095A1 (en) | Computer vision based monitoring system and method | |

| WO2020022371A1 (ja) | ロボットならびにその制御方法および制御プログラム | |

| US11869104B2 (en) | Visitor-tailored property configuration | |

| EP3992987A1 (en) | System and method for continously sharing behavioral states of a creature | |

| WO2022009489A1 (ja) | 行動認識装置、行動認識方法、及びプログラム | |

| Przybylo | Landmark detection for wearable home care ambient assisted living system | |

| WO2021084949A1 (ja) | 情報処理装置、情報処理方法およびプログラム | |

| JP7388200B2 (ja) | リハビリテーションを支援する情報の提供の方法およびリハビリテーション支援システム | |

| Ismail et al. | Multimodal indoor tracking of a single elder in an AAL environment | |

| JP7465644B2 (ja) | 監視システム、及び監視方法 | |

| Vasileiadis et al. | A living lab infrastructure for investigating activity monitoring needs in service robot applications |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20130423 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20130423 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20131224 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20140107 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20140204 |

|

| R151 | Written notification of patent or utility model registration |

Ref document number: 5473750 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R151 |