JP2013037274A - 信号処理装置および方法、信号処理システム、並びにプログラム - Google Patents

信号処理装置および方法、信号処理システム、並びにプログラム Download PDFInfo

- Publication number

- JP2013037274A JP2013037274A JP2011174934A JP2011174934A JP2013037274A JP 2013037274 A JP2013037274 A JP 2013037274A JP 2011174934 A JP2011174934 A JP 2011174934A JP 2011174934 A JP2011174934 A JP 2011174934A JP 2013037274 A JP2013037274 A JP 2013037274A

- Authority

- JP

- Japan

- Prior art keywords

- enthusiasm

- signal

- unit

- singing

- audio signal

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Ceased

Links

Images

Classifications

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10K—SOUND-PRODUCING DEVICES; METHODS OR DEVICES FOR PROTECTING AGAINST, OR FOR DAMPING, NOISE OR OTHER ACOUSTIC WAVES IN GENERAL; ACOUSTICS NOT OTHERWISE PROVIDED FOR

- G10K15/00—Acoustics not otherwise provided for

- G10K15/04—Sound-producing devices

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10H—ELECTROPHONIC MUSICAL INSTRUMENTS; INSTRUMENTS IN WHICH THE TONES ARE GENERATED BY ELECTROMECHANICAL MEANS OR ELECTRONIC GENERATORS, OR IN WHICH THE TONES ARE SYNTHESISED FROM A DATA STORE

- G10H1/00—Details of electrophonic musical instruments

- G10H1/36—Accompaniment arrangements

- G10H1/361—Recording/reproducing of accompaniment for use with an external source, e.g. karaoke systems

- G10H1/366—Recording/reproducing of accompaniment for use with an external source, e.g. karaoke systems with means for modifying or correcting the external signal, e.g. pitch correction, reverberation, changing a singer's voice

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10H—ELECTROPHONIC MUSICAL INSTRUMENTS; INSTRUMENTS IN WHICH THE TONES ARE GENERATED BY ELECTROMECHANICAL MEANS OR ELECTRONIC GENERATORS, OR IN WHICH THE TONES ARE SYNTHESISED FROM A DATA STORE

- G10H1/00—Details of electrophonic musical instruments

- G10H1/36—Accompaniment arrangements

- G10H1/38—Chord

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10H—ELECTROPHONIC MUSICAL INSTRUMENTS; INSTRUMENTS IN WHICH THE TONES ARE GENERATED BY ELECTROMECHANICAL MEANS OR ELECTRONIC GENERATORS, OR IN WHICH THE TONES ARE SYNTHESISED FROM A DATA STORE

- G10H2210/00—Aspects or methods of musical processing having intrinsic musical character, i.e. involving musical theory or musical parameters or relying on musical knowledge, as applied in electrophonic musical tools or instruments

- G10H2210/155—Musical effects

- G10H2210/245—Ensemble, i.e. adding one or more voices, also instrumental voices

- G10H2210/261—Duet, i.e. automatic generation of a second voice, descant or counter melody, e.g. of a second harmonically interdependent voice by a single voice harmonizer or automatic composition algorithm, e.g. for fugue, canon or round composition, which may be substantially independent in contour and rhythm

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10H—ELECTROPHONIC MUSICAL INSTRUMENTS; INSTRUMENTS IN WHICH THE TONES ARE GENERATED BY ELECTROMECHANICAL MEANS OR ELECTRONIC GENERATORS, OR IN WHICH THE TONES ARE SYNTHESISED FROM A DATA STORE

- G10H2220/00—Input/output interfacing specifically adapted for electrophonic musical tools or instruments

- G10H2220/155—User input interfaces for electrophonic musical instruments

- G10H2220/371—Vital parameter control, i.e. musical instrument control based on body signals, e.g. brainwaves, pulsation, temperature, perspiration; biometric information

Abstract

【解決手段】熱唱度算出部51は、楽曲の歌唱者の熱唱状態を示す特徴量からなる熱唱度を算出する。ハーモニ信号制御部56は、熱唱度算出部51により算出された熱唱度に基づいて、ピッチ検出部52、ハーモニ音程決定部53、およびピッチシフタ54により生成されたハモリ音声信号を、楽曲の歌唱者の歌唱音声信号に重畳するか否かを判定し、判定結果に基づいて、ハモリ音声信号を歌唱音声信号に対して重畳する。本技術は、カラオケ装置に適用することができる。

【選択図】図4

Description

図1を参照して、本技術を適用した信号処理システムの構成例について説明する。

次に、図2を参照して、音声処理装置1の構成例について説明する。

次に、図3を参照して、DSP30の構成例について説明する。

次に、図4を参照して、ハーモニ信号制御部56の構成例について説明する。

次に、図5を参照して、熱唱度サーバ2の構成例について説明する。

次に、図6のフローチャートを参照して、演奏処理について説明する。

次に、図7のフローチャートを参照して、ハーモニ制御処理について説明する。

ここで、図8のフローチャートを参照して、熱唱度算出処理について説明する。

・・・(1)

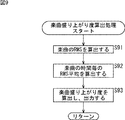

ここで、図8のフローチャートを参照して、楽曲盛り上がり度算出処理について説明する。

(1) 楽曲の歌唱者の熱唱状態を示す特徴量からなる熱唱度を算出する熱唱度算出部と、

前記熱唱度算出部により算出された前記熱唱度に基づいて、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するか否かを判定するハモリ音声信号重畳判定部と、

前記ハモリ音声信号重畳判定部の判定結果に基づいて、前記ハモリ音声信号を前記歌唱音声信号に対して重畳するハモリ音声信号重畳部と

を含む信号処理装置。

(2) 前記熱唱度算出部は、前記楽曲の歌唱者の歌唱音声信号に基づいて、前記歌唱者の熱唱状態を示す特徴量からなる熱唱度を算出する

(1)に記載の信号処理装置。

(3) 前記歌唱者の生体情報を取得する生体情報取得部をさらに含み、

前記熱唱度算出部は、前記楽曲の歌唱者の生体情報に基づいて、前記歌唱者の熱唱状態を示す特徴量からなる熱唱度を算出する

(1)または(2)に記載の信号処理装置。

(4) 前記ハモリ音声信号重畳判定部は、前記熱唱度算出部により算出された前記熱唱度と、前記熱唱度に対して設定される熱唱度閾値とを比較して、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するか否かを判定し、前記熱唱度が前記熱唱度閾値よりも高い場合、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するものと判定する

(1)乃至(3)のいずれかに記載の信号処理装置。

(5) 前記楽曲の音声信号である楽曲音声信号に基づいて、前記楽曲の盛り上がり度を算出する盛り上がり度算出部をさらに含み、

前記ハモリ音声信号重畳判定部は、前記熱唱度算出部により算出された前記熱唱度、および、前記盛り上がり度算出部により算出された前記盛り上がり度に基づいて、前記歌唱音声信号にハモリ音声信号を重畳するか否かを判定する

(1)乃至(4)のいずれかに記載の信号処理装置。

(6) 前記熱唱度閾値算出部は、複数の歌唱者による前記熱唱度の平均値を利用して熱唱度閾値を算出し、

前記ハモリ音声信号重畳判定部は、前記熱唱度算出部により算出された前記熱唱度と、前記熱唱度に対して設定され、複数の歌唱者による熱唱度の平均値を利用して求められた熱唱度閾値とを比較して、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するか否かを判定し、前記熱唱度が前記熱唱度閾値よりも高い場合、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するものと判定する

(1)乃至(5)のいずれかに記載の信号処理装置。

(7) 前記熱唱度を算出する熱唱度算出部を含む複数の(1)乃至(6)のいずれかに記載の信号処理装置よりネットワークを介して前記熱唱度算出部により算出された熱唱度を取得する熱唱度取得部と、

前記熱唱度取得部により複数の前記信号処理装置より取得された熱唱度の平均値を利用して熱唱度閾値を算出する熱唱度閾値算出部と、

前記熱唱度閾値算出部により算出された熱唱度閾値を前記複数の信号処理装置に配信する配信部と

を含む情報処理装置と、

前記(1)乃至(6)のいずれかに記載の信号処理装置とからなり、

前記ハモリ音声信号重畳判定部は、前記熱唱度算出部により算出された前記熱唱度と、前記熱唱度に対して設定され、前記配信部により配信されてくる熱唱度閾値とを比較して、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するか否かを判定し、前記熱唱度が前記熱唱度閾値よりも高い場合、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するものと判定する

信号処理システム。

(7) 楽曲の歌唱者の熱唱状態を示す特徴量からなる熱唱度を算出する熱唱度算出部における、楽曲の歌唱者の熱唱状態を示す特徴量からなる熱唱度を算出する熱唱度算出ステップと、

前記熱唱度算出部により算出された前記熱唱度に基づいて、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するか否かを判定するハモリ音声信号重畳判定部における、前記熱唱度算出ステップの処理により算出された前記熱唱度に基づいて、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するか否かを判定するハモリ音声信号重畳判定ステップと、

前記ハモリ音声信号重畳判定部の判定結果に基づいて、前記ハモリ音声信号を前記歌唱音声信号に対して重畳するハモリ音声信号重畳部における、前記ハモリ音声信号重畳判定ステップの処理での判定結果に基づいて、前記ハモリ音声信号を前記歌唱音声信号に対して重畳するハモリ音声信号重畳ステップと

を含む信号処理方法。

(8) 楽曲の歌唱者の熱唱状態を示す特徴量からなる熱唱度を算出する熱唱度算出部と、

前記熱唱度算出部により算出された前記熱唱度に基づいて、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するか否かを判定するハモリ音声信号重畳判定部と、

前記ハモリ音声信号重畳判定部の判定結果に基づいて、前記ハモリ音声信号を前記歌唱音声信号に対して重畳するハモリ音声信号重畳部と

を含む信号処理装置を制御するコンピュータに、

前記熱唱度算出部における、楽曲の歌唱者の熱唱状態を示す特徴量からなる熱唱度を算出する熱唱度算出ステップと、

前記ハモリ音声信号重畳判定部における、前記熱唱度算出ステップの処理により算出された前記熱唱度に基づいて、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するか否かを判定するハモリ音声信号重畳判定ステップと、

前記ハモリ音声信号重畳部における、前記ハモリ音声信号重畳判定ステップの処理での判定結果に基づいて、前記ハモリ音声信号を前記歌唱音声信号に対して重畳するハモリ音声信号重畳ステップと

を含む処理を実行させるプログラム。

Claims (9)

- 楽曲の歌唱者の熱唱状態を示す特徴量からなる熱唱度を算出する熱唱度算出部と、

前記熱唱度算出部により算出された前記熱唱度に基づいて、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するか否かを判定するハモリ音声信号重畳判定部と、

前記ハモリ音声信号重畳判定部の判定結果に基づいて、前記ハモリ音声信号を前記歌唱音声信号に対して重畳するハモリ音声信号重畳部と

を含む信号処理装置。 - 前記熱唱度算出部は、前記楽曲の歌唱者の歌唱音声信号に基づいて、前記歌唱者の熱唱状態を示す特徴量からなる熱唱度を算出する

請求項1に記載の信号処理装置。 - 前記歌唱者の生体情報を取得する生体情報取得部をさらに含み、

前記熱唱度算出部は、前記楽曲の歌唱者の生体情報に基づいて、前記歌唱者の熱唱状態を示す特徴量からなる熱唱度を算出する

請求項1に記載の信号処理装置。 - 前記ハモリ音声信号重畳判定部は、前記熱唱度算出部により算出された前記熱唱度と、前記熱唱度に対して設定される熱唱度閾値とを比較して、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するか否かを判定し、前記熱唱度が前記熱唱度閾値よりも高い場合、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するものと判定する

請求項1に記載の信号処理装置。 - 前記楽曲の音声信号である楽曲音声信号に基づいて、前記楽曲の盛り上がり度を算出する盛り上がり度算出部をさらに含み、

前記ハモリ音声信号重畳判定部は、前記熱唱度算出部により算出された前記熱唱度、および、前記盛り上がり度算出部により算出された前記盛り上がり度に基づいて、前記歌唱音声信号にハモリ音声信号を重畳するか否かを判定する

請求項1に記載の信号処理装置。 - 前記熱唱度閾値算出部は、複数の歌唱者による前記熱唱度の平均値を利用して熱唱度閾値を算出し、

前記ハモリ音声信号重畳判定部は、前記熱唱度算出部により算出された前記熱唱度と、前記熱唱度に対して設定され、複数の歌唱者による熱唱度の平均値を利用して求められた熱唱度閾値とを比較して、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するか否かを判定し、前記熱唱度が前記熱唱度閾値よりも高い場合、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するものと判定する

請求項1に記載の信号処理装置。 - 前記熱唱度を算出する熱唱度算出部を含む複数の請求項1乃至4のいずれかに記載の信号処理装置よりネットワークを介して前記熱唱度算出部により算出された熱唱度を取得する熱唱度取得部と、

前記熱唱度取得部により複数の前記信号処理装置より取得された熱唱度の平均値を利用して熱唱度閾値を算出する熱唱度閾値算出部と、

前記熱唱度閾値算出部により算出された熱唱度閾値を前記複数の信号処理装置に配信する配信部と

を含む情報処理装置と、

前記請求項1乃至4のいずれかに記載の信号処理装置とからなり、

前記ハモリ音声信号重畳判定部は、前記熱唱度算出部により算出された前記熱唱度と、前記熱唱度に対して設定され、前記配信部により配信されてくる熱唱度閾値とを比較して、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するか否かを判定し、前記熱唱度が前記熱唱度閾値よりも高い場合、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するものと判定する

信号処理システム。 - 楽曲の歌唱者の熱唱状態を示す特徴量からなる熱唱度を算出する熱唱度算出部における、楽曲の歌唱者の熱唱状態を示す特徴量からなる熱唱度を算出する熱唱度算出ステップと、

前記熱唱度算出部により算出された前記熱唱度に基づいて、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するか否かを判定するハモリ音声信号重畳判定部における、前記熱唱度算出ステップの処理により算出された前記熱唱度に基づいて、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するか否かを判定するハモリ音声信号重畳判定ステップと、

前記ハモリ音声信号重畳判定部の判定結果に基づいて、前記ハモリ音声信号を前記歌唱音声信号に対して重畳するハモリ音声信号重畳部における、前記ハモリ音声信号重畳判定ステップの処理での判定結果に基づいて、前記ハモリ音声信号を前記歌唱音声信号に対して重畳するハモリ音声信号重畳ステップと

を含む信号処理方法。 - 楽曲の歌唱者の熱唱状態を示す特徴量からなる熱唱度を算出する熱唱度算出部と、

前記熱唱度算出部により算出された前記熱唱度に基づいて、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するか否かを判定するハモリ音声信号重畳判定部と、

前記ハモリ音声信号重畳判定部の判定結果に基づいて、前記ハモリ音声信号を前記歌唱音声信号に対して重畳するハモリ音声信号重畳部と

を含む信号処理装置を制御するコンピュータに、

前記熱唱度算出部における、楽曲の歌唱者の熱唱状態を示す特徴量からなる熱唱度を算出する熱唱度算出ステップと、

前記ハモリ音声信号重畳判定部における、前記熱唱度算出ステップの処理により算出された前記熱唱度に基づいて、前記楽曲の歌唱者の歌唱音声信号にハモリ音声信号を重畳するか否かを判定するハモリ音声信号重畳判定ステップと、

前記ハモリ音声信号重畳部における、前記ハモリ音声信号重畳判定ステップの処理での判定結果に基づいて、前記ハモリ音声信号を前記歌唱音声信号に対して重畳するハモリ音声信号重畳ステップと

を含む処理を実行させるプログラム。

Priority Applications (6)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2011174934A JP2013037274A (ja) | 2011-08-10 | 2011-08-10 | 信号処理装置および方法、信号処理システム、並びにプログラム |

| US14/236,435 US20140174280A1 (en) | 2011-08-10 | 2012-08-01 | Signal processing apparatus and method, signal processing system, and program |

| BR112014002649A BR112014002649A8 (pt) | 2011-08-10 | 2012-08-01 | aparelho, sistema e método de processamento de sinal, e, programa |

| PCT/JP2012/069612 WO2013021896A1 (ja) | 2011-08-10 | 2012-08-01 | 信号処理装置および方法、信号処理システム、並びにプログラム |

| CN201280038232.5A CN103733255A (zh) | 2011-08-10 | 2012-08-01 | 信号处理装置和方法、信号处理系统以及程序 |

| RU2014103583/28A RU2014103583A (ru) | 2011-08-10 | 2012-08-01 | Устройство и способ обработки сигнала, система обработки сигнала и программа |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2011174934A JP2013037274A (ja) | 2011-08-10 | 2011-08-10 | 信号処理装置および方法、信号処理システム、並びにプログラム |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2013037274A true JP2013037274A (ja) | 2013-02-21 |

| JP2013037274A5 JP2013037274A5 (ja) | 2014-09-18 |

Family

ID=47668406

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2011174934A Ceased JP2013037274A (ja) | 2011-08-10 | 2011-08-10 | 信号処理装置および方法、信号処理システム、並びにプログラム |

Country Status (6)

| Country | Link |

|---|---|

| US (1) | US20140174280A1 (ja) |

| JP (1) | JP2013037274A (ja) |

| CN (1) | CN103733255A (ja) |

| BR (1) | BR112014002649A8 (ja) |

| RU (1) | RU2014103583A (ja) |

| WO (1) | WO2013021896A1 (ja) |

Families Citing this family (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US20140142928A1 (en) * | 2012-11-21 | 2014-05-22 | Harman International Industries Canada Ltd. | System to selectively modify audio effect parameters of vocal signals |

| CN106653037B (zh) * | 2015-11-03 | 2020-02-14 | 广州酷狗计算机科技有限公司 | 音频数据处理方法和装置 |

| JP6791211B2 (ja) * | 2018-06-28 | 2020-11-25 | 横河電機株式会社 | 掃引信号発生装置 |

| JP7190284B2 (ja) * | 2018-08-28 | 2022-12-15 | ローランド株式会社 | ハーモニー生成装置およびそのプログラム |

Citations (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH0944174A (ja) * | 1995-07-31 | 1997-02-14 | Sanyo Electric Co Ltd | カラオケ装置 |

| JPH10187178A (ja) * | 1996-10-28 | 1998-07-14 | Omron Corp | 歌唱の感情分析装置並びに採点装置 |

| JPH1173193A (ja) * | 1997-08-29 | 1999-03-16 | Brother Ind Ltd | カラオケ装置 |

| JP2009015119A (ja) * | 2007-07-06 | 2009-01-22 | Sanyo Electric Co Ltd | サビ位置検出装置 |

| JP2009198714A (ja) * | 2008-02-20 | 2009-09-03 | Brother Ind Ltd | カラオケ装置及びカラオケ伴奏音楽の再生処理方法及びプログラム |

Family Cites Families (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2806351B2 (ja) * | 1996-02-23 | 1998-09-30 | ヤマハ株式会社 | 演奏情報分析装置及びそれを用いた自動編曲装置 |

| JP3709631B2 (ja) * | 1996-11-20 | 2005-10-26 | ヤマハ株式会社 | カラオケ装置 |

| JP4010019B2 (ja) * | 1996-11-29 | 2007-11-21 | ヤマハ株式会社 | 歌唱音声信号切換装置 |

| WO2011011413A2 (en) * | 2009-07-20 | 2011-01-27 | University Of Florida Research Foundation, Inc. | Method and apparatus for evaluation of a subject's emotional, physiological and/or physical state with the subject's physiological and/or acoustic data |

| US20120234158A1 (en) * | 2011-03-15 | 2012-09-20 | Agency For Science, Technology And Research | Auto-synchronous vocal harmonizer |

-

2011

- 2011-08-10 JP JP2011174934A patent/JP2013037274A/ja not_active Ceased

-

2012

- 2012-08-01 US US14/236,435 patent/US20140174280A1/en not_active Abandoned

- 2012-08-01 BR BR112014002649A patent/BR112014002649A8/pt not_active Application Discontinuation

- 2012-08-01 WO PCT/JP2012/069612 patent/WO2013021896A1/ja active Application Filing

- 2012-08-01 CN CN201280038232.5A patent/CN103733255A/zh active Pending

- 2012-08-01 RU RU2014103583/28A patent/RU2014103583A/ru not_active Application Discontinuation

Patent Citations (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH0944174A (ja) * | 1995-07-31 | 1997-02-14 | Sanyo Electric Co Ltd | カラオケ装置 |

| JPH10187178A (ja) * | 1996-10-28 | 1998-07-14 | Omron Corp | 歌唱の感情分析装置並びに採点装置 |

| JPH1173193A (ja) * | 1997-08-29 | 1999-03-16 | Brother Ind Ltd | カラオケ装置 |

| JP2009015119A (ja) * | 2007-07-06 | 2009-01-22 | Sanyo Electric Co Ltd | サビ位置検出装置 |

| JP2009198714A (ja) * | 2008-02-20 | 2009-09-03 | Brother Ind Ltd | カラオケ装置及びカラオケ伴奏音楽の再生処理方法及びプログラム |

Also Published As

| Publication number | Publication date |

|---|---|

| US20140174280A1 (en) | 2014-06-26 |

| CN103733255A (zh) | 2014-04-16 |

| BR112014002649A2 (pt) | 2017-06-13 |

| WO2013021896A1 (ja) | 2013-02-14 |

| RU2014103583A (ru) | 2015-08-10 |

| BR112014002649A8 (pt) | 2017-06-20 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP3196715B2 (ja) | 楽音情報の通信装置、通信方法、制御装置、制御方法及びプログラムを記録した媒体 | |

| US8838835B2 (en) | Session terminal apparatus and network session system | |

| US20030045274A1 (en) | Mobile communication terminal, sensor unit, musical tone generating system, musical tone generating apparatus, musical tone information providing method, and program | |

| WO2013021896A1 (ja) | 信号処理装置および方法、信号処理システム、並びにプログラム | |

| US11087727B2 (en) | Auto-generated accompaniment from singing a melody | |

| CN101667422A (zh) | 一种调节歌曲伴奏的调式的方法及装置 | |

| JP2007293373A (ja) | アルペジオ演奏装置 | |

| JP6514874B2 (ja) | リファレンスの音高差と歌唱音声の音高差を比較して採点を行うカラオケ採点装置 | |

| JP4281601B2 (ja) | 情報通信システム、通信カラオケ端末、配信用ホスト装置及びプログラム | |

| US10937447B2 (en) | Harmony generation device and storage medium | |

| JP5394401B2 (ja) | オーディオプレーヤ間の出力ボリュームの類似性の改善のためのシステムおよび方法 | |

| WO2011115210A1 (ja) | ミキシングデータ配信サーバ | |

| JP4453580B2 (ja) | カラオケシステムおよびカラオケ装置 | |

| TWI496136B (zh) | A sound processing device, a communication sound processing system, a sound processing method and a computer program | |

| JP3729772B2 (ja) | 楽曲の音階に基づいて歌声をピッチシフトするカラオケ装置 | |

| JP2014197082A (ja) | 楽器音出力装置 | |

| US20150112686A1 (en) | Audio data synthesis terminal, audio data recording terminal, audio data synthesis method, audio output method, and program | |

| JPH09134181A (ja) | カラオケ装置 | |

| JP2017138359A (ja) | カラオケ装置,及びプログラム | |

| JP2006308650A (ja) | 歌唱支援装置 | |

| JP6415341B2 (ja) | ハーモニー歌唱のためのピッチシフト機能を備えたカラオケシステム | |

| JP2015087436A (ja) | 音声処理装置、音声処理装置の制御方法およびプログラム | |

| JP2010237532A (ja) | カラオケシステム、カラオケ装置、サーバ | |

| JP6286255B2 (ja) | カラオケシステム | |

| KR101063941B1 (ko) | 악기연주 설정 동기화를 위한 음악 장비 시스템 및 동기화된 악기연주 설정을 유지하는 디지털 악기 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20140806 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20140806 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20141118 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20150107 |

|

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20150217 |

|

| A045 | Written measure of dismissal of application [lapsed due to lack of payment] |

Free format text: JAPANESE INTERMEDIATE CODE: A045 Effective date: 20150625 |