以下、本発明の実施の形態について図を参照して説明する。なお、説明は以下の順序で行う。

1.第1の実施の形態(入力画像が3分割構図の画像として評価される例)

2.第2の実施の形態(入力画像が対比構図の画像として評価される例)

3.第3の実施の形態(入力画像が対角線構図の画像として評価される例)

4.第4の実施の形態(撮像装置に適用された場合について)

<1.第1の実施の形態>

[画像処理装置の構成例について]

図1は、本発明を適用した画像処理装置の一実施の形態の機能構成例を示している。

図1の画像処理装置11は、例えば、デジタルカメラ等の撮像装置から入力された入力画像の撮影状況に応じた構図パターンを選択し、その撮影状況と構図パターンとに基づいて、入力画像の構図を評価することで、入力画像を評価する。

画像処理装置11は、撮影状況識別部21、構図パターン選択部22、構図評価部23、および評価結果出力部24から構成される。

画像処理装置11に入力された入力画像は、撮影状況識別部21および評価結果出力部24に供給される。

撮影状況識別部21は、入力画像が撮影(撮像)されたときの撮影状況を入力画像から識別し、その撮影状況を表す撮影状況情報を、構図パターン選択部22、構図評価部23、および評価結果出力部24に供給する。撮影状況は、入力画像における被写体やシーン、色によって決定され、識別される。

[撮影状況識別部の機能構成例について]

図2は、撮影状況識別部21の機能構成例を示している。

撮影状況識別部21は、注目領域抽出部31、シーン判別部32、および色情報比較部33を備えている。

注目領域抽出部31は、入力画像において注目する注目領域を抽出し、その注目領域を表す注目領域情報を、構図パターン選択部22に供給する。注目領域は、入力画像における被写体(物体)を含む(囲む)矩形領域であり、入力画像中の被写体の数だけ設定され、抽出される。注目領域情報は、例えば、矩形領域の頂点の位置等とされる。

[注目領域抽出部の機能構成例について]

図3は、注目領域抽出部31の機能構成例を示している。

注目領域抽出部31は、注目度算出部51、注目矩形領域決定部52、および顔矩形領域決定部53を備えている。

注目度算出部51は、入力画像の各画素について特徴量を求め、その特徴量から画素毎の注目度を算出する。ここで、特徴量とは、画像のエッジ成分の大きさ、近傍画素との色相の差、画像の所定の領域における色分布、画像全体の平均色と各画素の色相の差などである。さらに、注目度算出部51は、画素毎の注目度(特徴量)から、1枚の入力画像に対応する注目度マップを生成し、注目矩形領域決定部52に供給する。注目度算出部51によって生成される注目度マップは、いわば、1枚の入力画像において注目すべき被写体が含まれる領域を表す情報である。

また、注目度算出部51は、入力画像の各画素について求めた特徴量から、顔度(顔らしさ度)を算出し、1枚の入力画像に対応する顔度マップを生成し、顔矩形領域決定部53に供給する。注目度算出部51によって生成される顔度マップは、いわば、1枚の入力画像において注目すべき顔が含まれる領域を表す情報である。

注目矩形領域決定部52は、注目度算出部51からの注目度マップを基に、注目矩形領域を決定し、その注目矩形領域を表す注目矩形領域情報を、構図パターン選択部22および構図評価部23に供給する。より具体的には、注目矩形領域決定部52は、注目度マップにおいて、所定の閾値より高い注目度の画素(位置)を矩形の中心とし、その周辺で、他の閾値より低い注目度の画素(位置)を矩形の端点(頂点)とすることで、注目矩形領域を決定する。

また、複数の注目矩形領域が決定された場合、矩形の中心同士が所定の距離より小さいときには、それらを併せて含む最小の矩形領域を、注目矩形領域とする。

顔矩形領域決定部53は、注目度算出部51からの顔度マップを基に、顔矩形領域を決定し、その顔矩形領域を表す顔矩形領域情報を、構図パターン選択部22および構図評価部23に供給する。より具体的には、顔矩形領域決定部53は、顔度マップにおいて、顔の鼻の画素(位置)を矩形の中心とし、その周辺で、顔度が急激に変化する(下がる)画素(位置)を矩形の端点(頂点)とすることで、顔矩形領域を決定する。

なお、注目矩形領域決定部52によって得られる注目矩形領域情報と、顔矩形領域決定部53によって得られる顔矩形領域情報とを併せて注目領域情報という。

図2に戻り、シーン判別部32は、入力画像を周波数変換することで周波数情報を抽出し、その周波数情報を特徴量(ベクトル)として、入力画像のシーンを判別し、判別の結果得られる、シーンを表すシーン情報を、色情報比較部33、構図パターン選択部22、および評価結果出力部24に供給する。より具体的には、シーン判別部32は、予め設定した学習用画像と、例えば、SVM(Support Vector Machines)等の機械学習とを用いてシーン判別を行う。

SVMにおいては、2クラス判別(1対1の判別)が行われ、例えば、「海岸」のクラスとそれ以外のクラス、「田園風景」のクラスとそれ以外のクラス、「空」のクラスとそれ以外のクラス、「山」のクラスとそれ以外のクラス、・・・のように判定され、それぞれのスコアが比較され、最もスコアの高いクラスが、判別結果とされる。

なお、シーン判別部32は、SVMを用いることとしたが、これに限らず、例えば、ニューラルネットワークを用いたパターン認識や、パターンマッチング等によるパターン認識を用いるようにしてもよい。

色情報比較部33は、シーン判別部32からのシーン情報で表わされるシーンに対応して予め用意された領域画像の色についての情報(色情報)と、入力画像の色情報とを比較し、領域画像と入力画像との類似度を算出する。領域画像は、所定のシーンの画像においてよく得られる色の領域(色領域)で構成される画像であり、シーン情報で表わされるシーン毎に複数用意されている。

[色情報比較部の機能構成例について]

図4は、色情報比較部33の機能構成例を示している。

色情報比較部33は、スケーリング部71、領域分割部72、領域画像DB(Database)73、領域画像選択部74、および類似度算出部75を備えている。

スケーリング部71は、入力画像に対してスケーリング処理を施し、領域分割部72に供給する。ここで、スケーリング処理とは、入力画像の大きさを、領域画像の大きさと同一の大きさに変更する処理をいう。

領域分割部72は、スケーリング部71から供給された入力画像を、同一または近似した色からなる色領域に分割し、類似度算出部75に供給する。

領域画像DB73は、シーン情報で表わされるシーン毎に、複数の領域画像を記憶している。領域画像DB73に記憶されている領域画像は、所定の大きさに統一されており、必要に応じて領域画像選択部74に読み出される。

領域画像選択部74は、シーン判別部32からのシーン情報に基づいて、そのシーン情報で表わされるシーンの領域画像を領域画像DB73から読み出し、類似度算出部75に供給する。

類似度算出部75は、領域分割部72からの入力画像と、領域画像選択部74からの領域画像とを比較し、入力画像と色配置が最も似ている領域画像を決定する。具体的には、類似度算出部75は、領域画像選択部74からの領域画像の色領域と、入力画像の色領域との類似度を算出し、領域画像の中から、最も類似度が高くなる領域画像(以下、参照領域画像という)を決定する。類似度算出部75は、入力画像と参照領域画像との類似度を構図評価部23に供給するとともに、参照領域画像を評価結果出力部24に供給する。

なお、注目領域抽出部31によって得られる注目領域情報、シーン判別部32によって得られるシーン情報、並びに、色情報比較部33によって得られる類似度および参照領域画像のいずれか1つでも含む情報を撮影状況情報という。

図1に戻り、構図パターン選択部22は、撮影状況識別部21からの撮影状況情報で表わされる撮影状況に基づいて、入力画像に適用すべき構図パターンを選択する。具体的には、構図パターン選択部22は、注目領域抽出部31からの注目領域情報の数と、シーン判別部32からのシーン情報の少なくともいずれか一方に基づいて、入力画像に対応する構図パターンを選択し、構図評価部23および評価結果出力部24に供給する。構図パターンは、注目領域(被写体)の数とシーンとに対応して予め決められている。構図パターンの詳細については、図10を参照して後述することとする。

構図評価部23は、撮影状況識別部21からの撮影状況情報と、構図パターン選択部22からの構図パターンとを基に、画像処理装置11に入力された入力画像の構図を評価し、評価結果を数値化したスコアを評価結果出力部24に供給する。

[構図評価部の機能構成例について]

図5は、構図評価部23の機能構成例を示している。

構図評価部23は、配置評価部111、重要度評価部112、色評価部113、およびスコア算出部114を備えている。

配置評価部111は、構図パターン選択部22からの構図パターンと、注目領域抽出部31(図2)からの注目領域情報で表わされる注目領域の位置および大きさとに基づいて、入力画像に構図パターンを適用した場合の注目領域の配置を評価する。配置評価部111は、評価結果である配置要素をスコア算出部114に供給する。

重要度評価部112は、注目領域抽出部31(図2)からの注目領域情報で表わされる注目領域の注目度(または顔度)に基づいて、入力画像における注目領域の重要度を評価し、その評価結果である重要度要素をスコア算出部114に供給する。

色評価部113は、色情報比較部33(図2)からの類似度(入力画像と参照領域画像との類似度)に基づいて、入力画像の色(色情報)が、シーン判別部32で判別されたシーンと、どの程度適合するかを評価する。色評価部113は、評価結果である色要素をスコア算出部114に供給する。

スコア算出部114は、配置評価部111からの配置要素、重要度評価部112からの重要度要素、および色評価部113からの色要素を、重み付け加算することで、入力画像の構図の評価結果を、スコアとして算出し、評価結果出力部24に供給する。

なお、配置要素、重要度要素、色要素の詳細については、後述することとする。

図1に戻り、評価結果出力部24は、構図評価部23からのスコア、撮影状況識別部21からの撮影状況情報(シーン情報および参照領域画像)、構図パターン選択部22からの構図パターンを、入力画像とともに、図示せぬ表示装置等に出力する。

[画像処理装置の画像評価処理について]

次に、図6のフローチャートを参照して、図1の画像処理装置11の画像評価処理について説明する。

ステップS11において、撮影状況識別部21は、撮影状況識別処理を実行し、入力画像が撮影されたときの撮影状況を入力画像から識別し、その撮影状況を表す撮影状況情報を、構図パターン選択部22、構図評価部23、および評価結果出力部24に供給する。

[撮影状況識別部の撮影状況識別処理について]

ここで、図7のフローチャートを参照して、図6のフローチャートのステップS11における撮影状況識別処理について説明する。

ステップS31において、注目領域抽出部31は、入力画像に対応する注目度マップおよび顔度マップを生成する。より詳細には、注目度算出部51は、入力画像に対応する注目度マップを生成し、注目矩形領域決定部52に供給するとともに、入力画像に対応する顔度マップを生成し、顔矩形領域決定部53に供給する。

ステップS32において、注目領域抽出部31は、注目度マップおよび顔度マップに基づいて、入力画像において注目する注目領域を抽出し、決定する。より詳細には、注目矩形領域決定部52は、注目度算出部51からの注目度マップを基に、注目矩形領域を決定し、その注目矩形領域を表す注目矩形領域情報を、構図パターン選択部22および構図評価部23に供給する。また、顔矩形領域決定部53は、注目度算出部51からの顔度マップを基に、顔矩形領域を決定し、その顔矩形領域を表す顔矩形領域情報を、構図パターン選択部22および構図評価部23に供給する。

なお、ステップS32においては、注目領域として、注目矩形領域と顔矩形領域とを決定するようにしたが、顔矩形領域を、注目矩形領域としてまとめて処理するようにしてもよい。

ステップS33において、シーン判別部32は、入力画像を周波数変換することで周波数情報を抽出し、その周波数情報を特徴量(ベクトル)として、入力画像のシーンを判別し、判別の結果得られる、シーンを表すシーン情報を、色情報比較部33、構図パターン選択部22、および評価結果出力部24に供給する。

ステップS34において、色情報比較部33は、入力画像に対して、色情報比較処理を実行し、シーン判別部32からのシーン情報で表わされるシーンに対応する領域画像の色情報と、入力画像の色情報とを比較し、領域画像と入力画像との類似度を算出する。

[色情報比較部の色情報比較処理について]

ここで、図8のフローチャートを参照して、図7のフローチャートのステップS34における色情報比較処理について説明する。

ステップS51において、スケーリング部71は、入力画像に対してスケーリング処理を施し、入力画像の大きさを、領域画像DB73に記憶されている領域画像の大きさと同一の大きさに変更して、領域分割部72に供給する。

ステップS52において、領域分割部72は、スケーリング部71からの、スケーリング処理された入力画像を、同一または近似した色の色領域に分割し、類似度算出部75に供給する。画像の色による領域分割は、例えば、「Mean Shift: A Robust Approach toward Feature Space Analysis, Dorin Comaniciu et al., IEEE Transactions on Pattern Analysis and Machine Intelligence, vol.25, no.5, 2003」に開示されている、平均値シフトアルゴリズムを用いた手法により行われる。なお、他の手法により、色による領域分割を実現するようにしてももちろんよい。

ステップS53において、領域画像選択部74は、シーン判別部32からのシーン情報に基づいて、そのシーン情報で表わされるシーンの領域画像を領域画像DB73から読み出し、類似度算出部75に供給する。

ステップS54において、類似度算出部75は、領域分割部72からの入力画像と、領域画像選択部74からの領域画像とを比較し、入力画像と領域画像との類似度の1つである形状類似度を算出する。なお、形状類似度は、入力画像の色領域の形状と、シーン情報に対応する領域画像の色領域の形状との類似の度合を示すものである。

例えば、入力画像として、晴れた日の夕暮れ時の水平線を撮影した画像が入力されたとすると、図9の左側に示されるように、入力画像Iiは、領域分割部72によって、夕焼けに染まったオレンジ色の空に対応する色領域Ri1と、夕焼けの影響で茶色がかった海に対応する色領域Ri2とに領域分割される。図9の入力画像Iiにおいては、水平線(色領域Ri1と色領域Ri2との境界)は、入力画像Iiを上下にほぼ等分するように位置している。

図9で説明したような入力画像Iiが画像処理装置11に入力された場合、シーン判別部32によれば、“海”を表すシーン情報が領域画像選択部74に供給される。そして、領域画像選択部74によれば、シーンが“海”である複数の領域画像が、領域画像DB73から読み出される。このとき読み出される領域画像は、例えば、図9の右側に示されるような、いわゆる水平線構図となる領域画像Ijとなる。領域画像Ijは、色領域Rj1と色領域Rj2とから構成され、また、色領域Rj1と色領域Rj2との境界は、領域画像Ijの下から3分の1程度に位置している。

なお、図9の例の場合、シーンが“海”となる画像には、同一の構図であっても、入力画像Iiのような夕暮れ時のものもあれば、青い空と海からなる日中帯のもの等もあるので、領域画像Ijは、色領域Rj1と色領域Rj2との色の組み合わせにより複数用意されている。

このような場合、ステップS54においては、類似度算出部75により、入力画像Iiの色領域Ri1および色領域Ri2との形状と、領域画像Ijの色領域Rj1と色領域Rj2の形状との類似度(形状類似度)が算出される。具体的には、例えば、「構図に基づく類似画像検索のための類似度, 山本敦 et al., 情報処理学会論文誌. データベース, vol.48(SIG_14(TOD_35)), pp.82-90, 2007」に開示されている、Jaccard係数に領域の大きさを加味した類似度算出の手法により、以下の式(1)で示される形状類似度simS(Ii,Ij)が算出される。

式(1)において、p,qは、それぞれ入力画像Iiおよび領域画像Ijにおける色領域を特定する値であり、図9の例では、それぞれ1および2の値をとる。

なお、類似度算出部75は、他の手法により、形状類似度を算出するようにしてももちろんよい。

ステップS55において、類似度算出部75は、領域分割部72からの入力画像と、領域画像選択部74からの領域画像とを比較し、入力画像と領域画像との類似度の1つである色類似度を算出する。なお、色類似度は、入力画像の色領域の色情報と、シーン情報に対応する領域画像の色領域の色情報との類似の度合を示すものである。

具体的は、例えば、類似度算出部75は、以下の式(2)で示される色類似度simC(Ii,Ij)を算出する。

なお、式(2)において、h(Rip),h(Rjq)は、それぞれ入力画像Iiおよび領域画像Ijにおける各色領域における各画素の色相の平均を表している。また、δpqは、以下の式(3)で示される、いわゆるクロネッカーのデルタである。

式(2)において、第2項は、入力画像Iiにおける色領域と、領域画像Ijにおける色領域とが一致している全ての色領域についての色差の平均を表している。すなわち、入力画像Iiと領域画像Ijとで、各色領域(図9の場合、色領域Ri1と色領域Rj2、および、色領域Ri1と色領域Rj2)の色が似ているほど、式(2)における第2項の値が小さくなり、色類似度simC(Ii,Ij)の値は大きくなる。

類似度算出部75は、シーン情報に対応する複数の領域画像について算出した形状類似度および色類似度に基づいて、例えば、所定の閾値より大きい形状類似度を有する領域画像のうち、もっとも大きい色類似度を有する領域画像を参照領域画像として、評価結果出力部24に供給する。また、類似度算出部75は、入力画像と参照領域画像との類似度(形状類似度および色類似度)を、構図評価部23に供給し、処理は、図7のフローチャートのステップS34に戻る。

なお、類似度算出部75は、例えば、色領域の分割数が同一である領域画像のうち、もっとも大きい色類似度を有する領域画像を参照領域画像とし、入力画像と参照領域画像との形状類似度および色類似度を、それぞれ類似度とするようにしてもよい。

図7のフローチャートに戻り、ステップS34の後、処理は、図6のフローチャートのステップS11に戻る。

図6のフローチャートに戻り、ステップS11の後、処理はステップS12に進み、構図パターン選択部22は、注目領域抽出部31からの注目領域情報の数と、シーン判別部32からのシーン情報とに基づいて、入力画像に適用すべき(推奨される)構図パターンを選択し、構図評価部23および評価結果出力部24に供給する。

ここで、図10を参照して、注目領域(被写体)の数とシーンとに基づいて選択される構図パターンについて説明する。

図10においては、注目領域(被写体)の数と、シーンである「海岸」、「田園風景」、「空」、「山」、「高速道路」、「街路」、「街中」、「高層ビル」それぞれに対応して、種々の構図パターンが決められている。

図10によれば、例えば、シーンが「海岸」である入力画像において、注目領域の数が0であるとき(すなわち、海岸の風景のみのとき)には、構図パターンとして水平線構図が設定される。注目領域の数が1であるときには、構図パターンとして3分割構図と水平線構図とが選択される。また、注目領域の数が2乃至5であるときには、構図パターンとして対比構図と水平線構図が選択され、注目領域の数が6以上であるときには、構図パターンとして対比構図と水平線構図とが選択される。

また、シーンが「田園風景」である入力画像において、注目領域の数が0であるとき(すなわち、田園風景のみのとき)には、構図パターンとして放射線構図が選択される。注目領域の数が1であるときには、構図パターンとして3分割構図と放射線構図とが選択される。また、注目領域の数が2乃至5であるときには、構図パターンとして対比構図と放射線構図が選択され、注目領域の数が6以上であるときには、構図パターンとして放射線構図とパターン構図とが選択される。

同様にして、シーンが「空」である入力画像、「山」である入力画像、「高速道路」である入力画像、・・・における注目領域の数に応じて、構図パターンが選択される。

なお、構図パターンが2つ選択されている場合、それぞれの構図を満たすような構図パターンが構図評価部23および評価結果出力部24に供給される。

また、以降においては、入力画像における注目領域の数は1であり、入力画像の構図パターンとして、3分割構図が設定されたものとして説明する。

図6のフローチャートに戻り、ステップS13において、構図評価部23は、撮影状況識別部21からの撮影状況情報と、構図パターン選択部22からの構図パターンとを基に、構図評価処理を実行し、画像処理装置11に入力された入力画像の構図を採点する。

[構図評価部の構図評価処理について]

ここで、図11のフローチャートを参照して、図6のフローチャートのステップS13における構図評価処理について説明する。

ステップS71において、構図評価部23の配置評価部111は、構図パターン選択部22からの構図パターンと、注目領域抽出部31からの注目領域情報で表わされる注目領域の位置および大きさとに基づいて、配置評価処理を実行する。

[配置評価部の配置評価処理について]

ここで、図12のフローチャートを参照して、図11のフローチャートのステップS71における配置評価処理について説明する。

ステップS111において、配置評価部111は、注目領域抽出部31からの注目領域情報で表わされる注目領域の大きさに基づいて、注目領域(以下、適宜、主題領域という)のアスペクト比を求める。

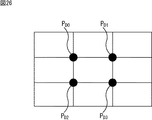

ステップS112において、配置評価部111は、主題領域のアスペクト比に応じた参照位置と主題領域の重心位置との距離を算出する。ここで、参照位置とは、3分割構図において水平方向を3分割する線(水平3分割線)LDh,垂直方向を3分割する線(垂直3分割線)LDv,および、水平3分割線と垂直3分割線との交点(3分割線交点)PDを示している。すなわち、主題領域の重心位置をPMとすると、配置評価部111は、距離| LDh - PM |,| LDv - PM |,| PD - PM |を算出する。

ステップS113において、配置評価部111は、参照位置と主題領域の重心位置との距離に基づいて、以下の式(4)で示される値GDLhM,GDLvM,GDPMを求める。

なお、式(4)において、dは、入力画像の対角線の長さを表している。式(4)で示される値GDLhM,GDLvM,GDPMのそれぞれは、主題領域の重心位置が、水平3分割線、垂直3分割線、3分割線交点のそれぞれに近づくほど大きい値となる。

ステップS114において、配置評価部111は、主題領域のアスペクト比に基づいて、注目領域の形状についての係数αhM,αvM,αpMを求める。

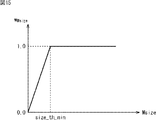

係数αhM,αvM,αpMは、主題領域の幅、高さをそれぞれsal_widthM,sal_heightMとしたとき、以下の式(5)で与えられる主題領域のアスペクト比sal_aspect_ratioMに応じて、それぞれ、図13の上段図乃至下段図で示されるように変化するパラメータである。図13上段図乃至下段図において、横軸はアスペクト比sal_aspect_ratioMを、縦軸はそれぞれの係数αhM,αvM,αpMの値を示している。

図13の上段図によれば、アスペクト比sal_aspect_ratioMが0乃至r_minのとき、係数αhMは1.0となり、アスペクト比sal_aspect_ratioMがr_mid1より大きいとき、係数αhMは0.0となる。また、アスペクト比sal_aspect_ratioMがr_min乃至r_mid1のときは、アスペクト比sal_aspect_ratioMの増加に応じて、係数αhMは減少する。すなわち、主題領域が縦長であるときに、係数αhMは有効となる。

図13の中段図によれば、アスペクト比sal_aspect_ratioMが0乃至r_mid2のとき、係数αvMは0.0となり、アスペクト比sal_aspect_ratioMがr_maxより大きいとき、係数αvMは1.0となる。また、アスペクト比sal_aspect_ratioMがr_mid2乃至r_maxのときは、アスペクト比sal_aspect_ratioMの増加に応じて、係数αvMは増加する。すなわち、主題領域が横長であるときに、係数αvMは有効となる。

図13下段図によれば、アスペクト比sal_aspect_ratioMが0乃至r_min、または、r_maxより大きいとき、係数αpMは0.0となり、アスペクト比sal_aspect_ratioMがr_mid1乃至r_mid2のとき、係数αpMは1.0となる。また、アスペクト比sal_aspect_ratioMがr_min乃至r_mid1のときは、アスペクト比sal_aspect_ratioMの増加に応じて、係数αpMは増加し、アスペクト比sal_aspect_ratioMがr_mid2乃至r_maxのときは、アスペクト比sal_aspect_ratioMの増加に応じて、係数αpMは減少する。すなわち、主題領域が正方形に近い形であるときに、係数αpMは有効となる。

ステップS115において、配置評価部111は、値GDLhM,GDLvM,GDPM、係数αhM,αvM,αpM、および主題領域の大きさに応じた重み係数wMsizeに基づいて、入力画像に構図パターンを適用した場合の主題領域の配置の評価結果を表す配置要素elem_pを算出する。

まず、以下の式(6)で示される、入力画像における主題領域の配置を評価する評価関数E(M)が求められる。ここで、Mは、評価関数Eが主題領域についての評価関数であることを示している。

式(6)は、図14に示されるように、主題領域が、縦長である領域L1ならば水平3分割線に、横長である領域L2ならば垂直3分割線に、正方形に近い領域L3であるならば3分割線交点に近づくほど、評価関数E(M)の値が大きくなることを示している。

そして、評価関数E(M)と重み係数wMsizeとに基づいて、以下の式(7)で示される配置要素elem_pが求められる。

重み係数wMsizeは、主題領域の大きさ(サイズ)Msizeに応じて、図15で示されるように変化するパラメータである。図15において、横軸は主題領域のサイズMsizeを、縦軸は重み係数wMsizeの値を示している。

図15によれば、サイズMsizeがsize_th_minより大きいとき、重み係数wMsizeは1.0となる。なお、サイズMsizeが0乃至size_th_minのときは、サイズMsizeの増加に応じて、重み係数wMsizeは増加する。すなわち、主題領域の大きさが所定の大きさsize_th_min以下である場合には、主題領域の大きさに応じて重み係数wMsizeによる重みは大きくなる。

以上のようにして、主題領域が、縦長であるならば水平3分割線に、横長であるならば垂直3分割線に、正方形に近い形状であるならば3分割線交点に近づくほど、値が大きくなる配置要素elem_pが算出される。算出された配置要素elem_pは、スコア算出部114に供給される。

図11のフローチャートに戻り、ステップS72において、重要度評価部112は、注目領域抽出部31からの注目領域情報で表わされる注目領域の注目度(または顔度)に基づいて、重要度評価処理を実行し、入力画像における注目領域の重要度を評価する。

[重要度評価部の重要度評価処理について]

ここで、図16のフローチャートを参照して、図11のフローチャートのステップS72における重要度評価処理について説明する。

ステップS131において、重要度評価部112は、注目領域抽出部31からの注目領域情報で表わされる注目領域(主題領域)の注目度(また顔度)salMを用いて、以下の式(8)で示される、入力画像に構図パターンを適用した場合の主題領域の重要度の評価結果を表す重要度要素elem_sを算出する。

このようにして、主題領域の注目度(また顔度)が大きいほど、値が大きくなる重要度要素elem_sが算出される。なお、重要度要素elem_sは、上述の式(8)によって求められる値に限らず、他の方法によって求められるようにしてもよい。算出された重要度要素elem_sは、スコア算出部114に供給される。

図11のフローチャートに戻り、ステップS73において、色評価部113は、色情報比較部33からの類似度に基づいて、色評価処理を実行し、入力画像の色(色情報)が、シーン判別部32で判別されたシーンと、どの程度適合するかを評価する。

[色評価部の色評価処理について]

ここで、図17のフローチャートを参照して、図11のフローチャートのステップS73における色評価処理について説明する。

ステップS151において、色評価部113は、色情報比較部33からの形状類似度に基づいて、重み係数wshape_layoutを算出する。

重み係数wshape_layoutは、色情報比較部33からの形状類似度simSに応じて、図18で示されるように変化するパラメータである。図18において、横軸は形状類似度simSを、縦軸は重み係数wshape_layoutの値を示している。

図18によれば、形状類似度simSがsims_th_minより小さいとき、重み係数wshape_layoutはws_th_minとなり、形状類似度simSがsims_th_maxより大きいとき、重み係数wshape_layoutは1.0となる。なお、形状類似度simSがsims_th_min乃至sims_th_maxのときは、形状類似度simSの増加に応じて、重み係数wshape_layoutは増加する。すなわち、形状類似度simSが高いほど、重み係数wshape_layoutによる重みは大きくなる。

ステップS152において、色評価部113は、色情報比較部33からの色類似度に基づいて、重み係数wcolor_layoutを算出する。

重み係数wcolor_layoutは、色情報比較部33からの色類似度simCに応じて、図19で示されるように変化するパラメータである。図19において、横軸は色類似度simCを、縦軸は重み係数wcolor_layoutの値を示している。

図19によれば、色類似度simCがsimc_th_minより小さいとき、重み係数wcolor_layoutはwc_th_minとなり、色類似度simCがsimc_th_maxより大きいとき、重み係数wcolor_layoutは1.0となる。なお、色類似度simCがsimc_th_min乃至simc_th_maxのときは、色類似度simCの増加に応じて、重み係数wcolor_layoutは増加する。すなわち、色類似度simCが高いほど、重み係数wcolor_layoutによる重みは大きくなる。

ステップS153において、色評価部113は、重み係数wshape_layoutおよびwcolor_layoutから、以下の式(9)で示される、入力画像における色の、入力画像のシーンとの適合の度合の評価結果を表す色要素elem_cを算出する。

このようにして、入力画像と参照画像との形状類似度および色類似度が高いほど、値が大きくなる色要素elem_cが算出される。なお、色要素elem_cは、上述の式(9)によって求められる値に限らず、他の方法によって求められるようにしてもよい。算出された色要素elem_cは、スコア算出部114に供給される。

図11のフローチャートに戻り、ステップS74において、スコア算出部114は、配置評価部111からの配置要素elem_p、重要度評価部112からの重要度要素elem_s、および色評価部113からの色要素elem_cに基づいて、入力画像の構図の評価結果であるスコアを算出し、評価結果出力部24に供給する。

具体的には、スコア算出部114は、配置要素elem_p、重要度要素elem_s、および色要素elem_cを重み付け加算することで、以下の式(10)で示されるスコアScoreを算出する。

式(10)において、係数α、β、およびγは、それぞれ配置要素elem_p、重要度要素elem_s、および色要素elem_cについての重み係数であり、以下の式(11)の関係を有する。

具体的には、例えば、α=40、β=20、γ=40などとされる。ここで、配置要素elem_p、重要度要素elem_s、および色要素elem_cをそれぞれ、0乃至1の値をとるように正規化することで、式(10)で示されるスコアScoreは、0乃至100の値をとるようになる。また、係数α、β、およびγについて、α=100、β=0、γ=0とした場合には、スコアScoreは、注目領域の配置のみに注目した評価結果となり、α=0、β=0、γ=100とした場合には、スコアScoreは、入力画像の色のみに注目した評価結果となる。

以上のようにして、入力画像における主題領域の配置および重要度についての評価結果と、入力画像の色とシーンとの適合性の評価結果とから、入力画像についての構図の評価結果(スコア)が算出される。算出されたスコアは、評価結果出力部24に供給される。

さて、図6のフローチャートに戻り、ステップS14において、評価結果出力部24は、構図評価部23からのスコアScore、シーン判別部32からのシーン情報、色情報比較部33からの参照領域画像、および構図パターン選択部22からの構図パターンを、入力画像とともに、出力画像として、図示せぬ表示装置等に出力する。

図20は、図示せぬ表示装置に出力された出力画像の例を示している。

図20においては、晴れた日の夕暮れ時の水平線に沈む太陽が撮影された入力画像に、シーン情報、構図パターン、スコア、および参照領域画像を示す縮小画像がOSD(On Screen Display)表示されている。

具体的には、入力画像の左上には、シーン情報として「scene:海岸+夕景」、構図パターンとして「推奨構図:3分割構図+水平線構図」、スコアとして「Score:50」の文字列が表示されている。また、入力画像の右上には、「参照領域画像」の文字列と参照領域画像を示す縮小画像が表示されている。

また、図20においては、被写体としての太陽と色領域を決定する水平線とが、矩形によって囲まれて表示され、入力画像全体に対して、3分割構図を表す3分割線が表示されている。

以上の処理によれば、入力画像の撮影状況に応じた構図パターンとしての3分割構図が選択され、その撮影状況と構図パターンとに基づいて、入力画像の構図が評価され、評価結果としてのスコアが出力される。これにより、ユーザは、撮像装置から入力した入力画像を、入力画像に推奨される構図と比較することができるとともに、入力画像の構図についての評価結果として、入力画像に推奨される構図に基づいた評価結果を容易に確認することができる。

以上においては、入力画像における注目領域(主題領域)の数は1で、入力画像の構図パターンとして、3分割構図が選択された場合の画像評価処理について説明してきたが、以下においては、入力画像における注目領域の数は2で、入力画像の構図パターンとして、対比構図が選択された場合の処理について説明する。

<2.第2の実施の形態>

入力画像における注目領域の数は2で、入力画像の構図パターンとして、対比構図が選択された場合の画像評価処理においては、配置評価処理および重要度評価処理以外の処理は、上述で説明したものと同様となるので、それらの説明は省略する。

なお、以下では、入力画像において、注目領域の数が2である場合、2つの注目領域のうち、例えば注目度が大きい方の注目領域を主題領域といい、注目度が小さい方の注目領域を副題領域という。

[対比構図が選択された場合の配置評価処理について]

まず、図21のフローチャートを参照して、対比構図が選択された場合の配置評価処理について説明する。

ステップS211において、配置評価部111は、主題領域についての配置評価処理を実行し、主題領域についての配置要素elem_pMを算出する。なお、ここで算出される配置要素elem_pMは、図12のフローチャートを参照して説明した配置評価処理によって算出される配置要素elem_pと同様にして算出されるので、詳細な説明は省略する。すなわち、配置要素elem_pMは、入力画像における主題領域の配置についての評価関数E(M)と、主題領域の大きさに応じた重み係数wMsizeとの積E(M)・wMsizeとして算出される。

ステップS212において、配置評価部111は、副題領域についての配置評価処理を実行し、副題領域についての配置要素elem_pSを算出する。なお、ここで算出される配置要素elem_pSもまた、図12のフローチャートを参照して説明した配置評価処理によって算出される配置要素elem_pと同様にして算出されるので、詳細な説明は省略する。すなわち、配置要素elem_pSは、入力画像における副題領域の配置についての評価関数E(S)と、副題領域の大きさに応じた重み係数wSsizeとの積E(S)・wSsizeとして算出される。なお、評価関数E(S)におけるSや、重み係数wSsizeの添え字のSは、評価関数や重み関数が、副題領域についての評価関数や重み関数であることを示している。

ステップS213において、配置評価部111は、主題領域についての配置要素elem_pM(=E(M)・wMsize)、副題領域についての配置要素elem_pS(=E(S)・wSsize)、および主題領域についての重み関数αMに基づいて、以下の式(12)で示される配置要素elem_pを算出する。

式(12)において、重み関数αMは、0<αM<1の範囲の値をとり、主題領域への注目の度合に応じて予め設定される。すなわち、重み関数αMは、対比構図において、主題領域に対応する被写体と、副題領域に対応する被写体とで、主題領域に対応する被写体をどの程度際立たせるかを決めるためのパラメータとも言える。

また、ここでは、配置要素elem_pは、対比構図における主題領域および副題領域の配置を評価するための指標であり、主題領域および副題領域のそれぞれが、参照位置である3分割線や3分割線交点に近づくほど大きい値となる。

しかしながら、主題領域および副題領域のそれぞれが、同一の3分割線または3分割線交点に近い場合、例えば、図22に示されるように、主題領域LMおよび副題領域LSのそれぞれが、3分割構図上の左上の3分割線交点PDに近い場合、対比構図としては、決してバランスが良くないにもかかわらず、式(12)で示される配置要素elem_pは大きい値となってしまう。

そこで、主題領域および副題領域のそれぞれが、同一の3分割線または3分割線交点に近い場合には、配置要素elem_pに、例えば0.5などの所定の係数を乗じることで、その値を下げるようにしてもよい。

また、主題領域および副題領域のそれぞれが同一の参照位置に近い場合に限らず、図23に示される構図Aや構図Bのように、対比構図としてバランスのよい特定の構図(主題領域および副題領域の配置)を複数、予め決めておき、これらの配置と大きく異なる配置の場合には、主題領域および副題領域のそれぞれが異なる参照位置に近い場合でも、配置要素elem_pに、所定の係数を乗じることで、その値を下げるようにしてもよい。

以上のようにして、入力画像において、3分割構図上で主題領域および副題領域の2つの注目領域が存在することで対比構図が選択された場合の配置要素elem_pが算出される。

[対比構図が選択された場合の重要度評価処理について]

次に、図24のフローチャートを参照して、対比構図が選択された場合の重要度評価処理について説明する。

ステップS231において、重要度評価部112は、注目領域抽出部31からの注目領域情報で表わされる主題領域の注目度salM、副題領域の注目度salS、および主題領域についての重み関数αMを用いて、以下の式(13)で示される重要度要素elem_sを算出する。

式(13)において、重み関数αMは、式(12)で説明したものと同一である。

このようにして、主題領域および副題領域の注目度が大きいほど、値が大きくなる重要度要素elem_sが算出される。なお、ここでも、重要度要素elem_sは、上述の式(13)によって求められる値に限らず、他の方法によって求められるようしてもよい。

このように、注目領域の数は2で、入力画像の構図パターンとして対比構図が選択された場合であっても、その撮影状況と構図パターンとに基づいて、入力画像の構図が評価され、評価結果としてのスコアが出力される。これにより、ユーザは、撮像装置から入力した入力画像を、入力画像に推奨される構図と比較することができるとともに、入力画像の構図についての評価結果として、入力画像に推奨される構図に基づいた評価結果を容易に確認することができる。

以上においては、入力画像における注目領域の数は2で、入力画像の構図パターンとして対比構図が選択された場合の画像評価処理について説明してきたが、以下においては、入力画像における注目領域の数は2で、入力画像の構図パターンとして対角線構図が選択された場合の処理について説明する。

<3.第3の実施の形態>

入力画像における注目領域の数は2で、入力画像の構図パターンとして対角線構図が選択された場合の画像評価処理においては、配置評価処理以外の処理は、対比構図が選択された場合の処理について説明したものと同様であるので、その説明は省略する。

[対角線構図が選択された場合の配置評価処理について]

すなわち、図25のフローチャートを参照して、対角線構図が選択された場合の配置評価処理について説明する。

ステップS311において、配置評価部111は、注目領域抽出部31からの注目領域情報で表わされる注目領域のうちの主題領域の大きさに基づいて、主題領域のアスペクト比を求める。

ステップS312において、配置評価部111は、主題領域のアスペクト比に応じた参照位置と主題領域の重心位置との距離を算出する。

なお、上述で説明したように、3分割構図が選択された場合においては、水平3分割線、垂直3分割線、および3分割線交点のそれぞれと主題領域の重心位置との距離が算出されるようにしたが、ここでは、3分割線交点と主題領域の重心位置との距離のみが算出される。すなわち、配置評価部111は、図26に示される3分割線交点PDi(但し、i=0,1,2,3)のそれぞれと、主題領域の重心位置PMとの距離| PDi - PM |を算出する。

ステップS313において、配置評価部111は、参照位置(3分割線交点PDi)と主題領域の重心位置との距離に基づいて、上述した式(4)で示される値GDPMを求める。

ステップS314において、配置評価部111は、主題領域のアスペクト比に基づいて、主題領域の形状についての係数αpMを求める。ここで、係数αpMは、図13を参照して説明した係数αpMと同様にして求められる。

ステップS315において、配置評価部111は、注目領域抽出部31からの注目領域情報で表わされる注目領域のうちの副題領域の大きさに基づいて、副題領域のアスペクト比を求める。

ステップS316において、配置評価部111は、副題領域のアスペクト比に応じた参照位置と副題領域の重心位置との距離を算出する。

ここで、副題領域の重心位置PSとすると、ステップS312の処理と同様に、配置評価部111は、図26に示される3分割線交点PDiのそれぞれと、副題領域の重心位置PSとの距離| PDi - PS |を算出する。

ステップS317において、配置評価部111は、参照位置(3分割線交点PDi)と副題領域の重心位置との距離に基づいて、上述した式(4)で示される値GDPMと同様にして、値GDPMを求める。

ステップS318において、配置評価部111は、副題領域のアスペクト比に基づいて、副題領域の形状についての係数αpSを求める。なお、係数αpSは、図13を参照して説明した係数αpMと同様にして求められる。

このように、対角線構図においては、注目領域(主題領域および副題領域)が縦長であったり横長であることは無視され、注目領域が正方形に近い形であることのみが注目されている。

ステップS319において、配置評価部111は、入力画像の対角線上に参照位置をとる主題領域についての値GDPM、係数αpM、および重み係数wMsizeと、副題領域についての値GDPS、係数αpS、および重み係数wSsizeとに基づいて、配置要素elem_pを算出する。

まず、以下の式(14)で示される、入力画像における主題領域の配置についての評価関数Epm(M)、および、入力画像における副題領域の配置についての評価関数Epn(S)が求められる。

式(14)は、主題領域および副題領域が、それぞれ3分割線交点に近づくほど、評価関数Epm(M)およびEpn(S)の値が大きくなることを示している。

また、式(14)において、添え字m,nは、それぞれ、図26で示された3分割線交点PDiの添え字iがとる値のうち、3分割線交点PDiが対角線上に位置する値をとる。すなわち、図26においては、3分割線交点PD0およびPD3、3分割線交点PD1およびPD2が対角線上に位置するので、添え字m,nは、その組み合わせとして、(m,n)=(0,3),(1,2),(2,1),(3,0)の4通りで与えられ、一方の値が決まれば、他方の値も一意に決まる。したがって、評価関数Epm(M)およびEpn(S)は、4通りの組み合わせで求められる。

そして、評価関数Epm(M)およびEpn(S)、重み係数wMsizeおよびwSsize、並びに、重み関数αMに基づいて、以下の式(15)で示される配置要素elem_pが求められる。

式(15)において、括弧{}内の値をAとすると、max{A}(maxの下にmが記されている)は、所定の値mによって与えられる値Aのうち、最大となる値Aを示している。すなわち、式(15)においては、4通りの組み合わせで求められる評価関数Epm(M)およびEpn(S)はで与えられる値Aのうち、最大となる値Aが配置要素elem_pとして算出される。また、式(15)において、重み関数αMは、式(12)等で説明したものと同一である。

以上のようにして、主題領域および副題領域がそれぞれ、対角線上に並ぶ3分割線交点のそれぞれに近づくほど、値が大きくなる配置要素elem_pが算出される。

このように、注目領域の数は2で、入力画像の構図パターンとして対角線構図が選択された場合であっても、その撮影状況と構図パターンとに基づいて、入力画像の構図が評価され、評価結果としてのスコアが出力される。これにより、ユーザは、撮像装置から入力した入力画像を、入力画像に推奨される構図と比較することができるとともに、入力画像の構図についての評価結果として、入力画像に推奨される構図に基づいた評価結果を容易に確認することができる。

以上のように、ユーザは、撮像装置から入力した入力画像を、入力画像に推奨される様々な構図と比較することができるとともに、入力画像の構図についての評価結果として、日の丸構図などの単純な構図についての評価結果でなく、入力画像に推奨される様々な構図に基づいた評価結果を容易に確認することができるので、ユーザの撮影に関する技術をより向上させることが可能となる。

なお、上述で説明した、3分割構図、対比構図、および対角線構図以外の構図パターンが選択された場合であっても、3分割構図上の参照位置と注目領域の重心位置とに基づいて、その構図パターンに応じた配置要素elem_pが算出されれば、画像処理装置11は、その選択された構図パターンに基づいた評価結果を出力することが可能である。

以上においては、撮像装置等で撮像された画像を入力画像として、入力画像の構図を採点する画像処理装置について説明してきたが、撮像した撮像画像の構図をそのまま採点する構成を撮像装置に設けるようにしてもよい。

<4.第4の実施の形態>

[撮像装置の構成例について]

図27は、撮像した撮像画像の構図を採点するようにした撮像装置の構成例を示している。なお、図27の撮像装置511において、図1の画像処理装置11に設けられたものと同様の機能を備える構成については、同一名称および同一符号を付するものとし、その説明は、適宜省略するものとする。

すなわち、図27の撮像装置511において、図1の画像処理装置11と異なるのは、撮像部521、画像処理部522、および表示部523を新たに設けた点である。

なお、図27の評価結果出力部24は、構図評価部23からのスコア、撮影状況識別部21からの撮影状況情報(シーン情報および参照領域画像)、構図パターン選択部22からの構図パターンを、撮像画像とともに、表示部523に供給する。

撮像部521は、光学レンズ、撮像素子、A/D(Analog/Digital)変換部(いずれも図示せず)を含むように構成される。撮像部521は、光学レンズに入射された光を、撮像素子が受光して光電変換することにより被写体を撮像し、得られたアナログの画像信号をA/D変換する。撮像部521は、A/D変換の結果得られたデジタルの画像データ(撮像画像)を画像処理部522に供給する。

画像処理部522は、撮像部521からの撮像画像に対し、ノイズ除去処理等の画像処理を施し、撮影状況識別部21に供給する。

表示部523は、評価結果出力部24から撮像画像とともに供給された、シーン情報、構図パターン、スコア、および参照領域画像を、撮像画像とともに表示する。

[撮像装置の画像評価処理について]

次に、図28のフローチャートを参照して、図27の撮像装置511の画像評価処理について説明する。なお、図28のフローチャートにおけるステップS513乃至S515の処理は、図6のフローチャートを参照して説明したステップS11乃至S13の処理と同様であるので、その説明は省略するものとする。

すなわち、ステップS511において、撮像部521は、被写体を撮像し、得られた撮像画像を画像処理部522に供給する。

ステップS512において、画像処理部522は、撮像部521からの撮像画像に対し、ノイズ除去処理等の画像処理を施し、撮影状況識別部21および評価結果出力部24に供給する。

ステップS516において、評価結果出力部24は、構図評価部23からのスコアScore、シーン判別部32からのシーン情報、色情報比較部33からの参照領域画像、および構図パターン選択部22からの構図パターンを、撮像画像とともに、表示部523に供給する。表示部523は、評価結果出力部24から撮像画像とともに供給された、シーン情報、構図パターン、スコア、および参照領域画像を、撮像画像とともに表示する。

図29は、撮像装置511の表示部523に表示された表示例を示している。

図29に示される撮像装置511の表示部523においては、図20と同様に、晴れた日の夕暮れ時の水平線に沈む太陽が撮影された撮像画像に、シーン情報、構図パターン、スコア、および参照領域画像を示す縮小画像がOSD表示されている。

具体的には、撮像画像の左上には、シーン情報として「scene:海岸+夕景」、構図パターンとして「推奨構図:3分割構図+水平線構図」、スコアとして「Score:50」の文字列が表示されている。また、撮像画像の右上には、「参照領域画像」の文字列と参照領域画像を示す縮小画像が表示されている。

また、図29においては、被写体としての太陽と色領域を決定する水平線とが、矩形によって囲まれて表示され、撮像画像全体に対して、3分割構図を表す3分割線が表示されている。

以上の処理によれば、撮影状況に応じた構図パターンが選択され、その撮影状況と構図パターンとに基づいて、撮像画像の構図が評価され、評価結果としてのスコアが出力される。これにより、ユーザは、撮像した撮像画像を、撮像画像に推奨される様々な構図と比較することができるとともに、撮像画像の構図についての評価結果として、日の丸構図などの単純な構図についての評価結果でなく、撮像画像に推奨される様々な構図に基づいた評価結果を容易にかつリアルタイムに確認することができるので、ユーザの撮影に関する技術をより向上させることが可能となる。

また、図29の撮像装置511において、表示部523の右側に配置されている、ボタンやダイヤルから構成される操作部などが操作されることにより、図30に示されるように、ユーザに対して、スコアがより高くなるようなアドバイスを表示させるようにしてもよい。

図30においては、撮像装置511の表示部523に表示されている撮像画像と3分割構図を表す3分割線とに加え、ユーザに対するアドバイスが表示されている。具体的には、表示部523において、被写体としての太陽については、右上の3分割線交点に合わせるように示唆する矢印および「主題を3分割交点に合わせるとGood」のアドバイスが表示されている。また、撮像画像の色領域を決定する水平線については、下側の垂直3分割線に合わせるように示唆する矢印および「水平線を3分割線に合わせるとGood」のアドバイスが表示されている。

これは、例えば、構図評価部23の配置評価部111によって求められる、注目領域(主題領域)の重心位置と参照位置との距離に基づいて、その距離がより小さくなる注目領域の重心位置の移動先(方向)を求めることにより実現される。これにより、配置要素の値がより大きくなり、ひいては、スコアがより高くなるようになる。

このように、ユーザに対して、スコアがより高くなるようなアドバイスが表示されることにより、ユーザは、撮像している画像について、推奨される構図に近づけるためのノウハウを知ることができるので、ユーザの撮影に関する技術をさらに向上させることが可能となる。

なお、以上においては、入力画像(または撮像画像)の構図についての評価結果として、数値化されたスコアを出力(または表示)するようにしたが、数値化されたスコアに基づいた5段階評価結果としての文字(例えばA乃至E)やアイコンを出力するようにしてもよいし、配置要素、重要度要素、および色要素の値をそれぞれグラフ化した図形を表示するようにしてもよい。

上述した一連の処理は、ハードウェアにより実行することもできるし、ソフトウェアにより実行することもできる。一連の処理をソフトウェアにより実行する場合には、そのソフトウェアを構成するプログラムが、専用のハードウェアに組み込まれているコンピュータ、または、各種のプログラムをインストールすることで、各種の機能を実行することが可能な、例えば汎用のパーソナルコンピュータ等に、プログラム記録媒体からインストールされる。

図31は、上述した一連の処理をプログラムにより実行するコンピュータのハードウェアの構成例を示すブロック図である。

コンピュータにおいて、CPU(Central Processing Unit)901,ROM(Read Only Memory)902,RAM(Random Access Memory)903は、バス904により相互に接続されている。

バス904には、さらに、入出力インタフェース905が接続されている。入出力インタフェース905には、キーボード、マウス、マイクロホン等よりなる入力部906、ディスプレイ、スピーカ等よりなる出力部907、ハードディスクや不揮発性のメモリ等よりなる記憶部908、ネットワークインタフェース等よりなる通信部909、磁気ディスク、光ディスク、光磁気ディスク、或いは半導体メモリ等のリムーバブルメディア911を駆動するドライブ910が接続されている。

以上のように構成されるコンピュータでは、CPU901が、例えば、記憶部908に記憶されているプログラムを、入出力インタフェース905およびバス904を介して、RAM903にロードして実行することにより、上述した一連の処理が行われる。

コンピュータ(CPU901)が実行するプログラムは、例えば、磁気ディスク(フレキシブルディスクを含む)、光ディスク(CD-ROM(Compact Disc-Read Only Memory),DVD(Digital Versatile Disc)等)、光磁気ディスク、もしくは半導体メモリ等よりなるパッケージメディアであるリムーバブルメディア911に記録して、あるいは、ローカルエリアネットワーク、インターネット、デジタル衛星放送といった、有線または無線の伝送媒体を介して提供される。

そして、プログラムは、リムーバブルメディア911をドライブ910に装着することにより、入出力インタフェース905を介して、記憶部908にインストールすることができる。また、プログラムは、有線または無線の伝送媒体を介して、通信部909で受信し、記憶部908にインストールすることができる。その他、プログラムは、ROM902や記憶部908に、あらかじめインストールしておくことができる。

なお、コンピュータが実行するプログラムは、本明細書で説明する順序に沿って時系列に処理が行われるプログラムであっても良いし、並列に、あるいは呼び出しが行われたとき等の必要なタイミングで処理が行われるプログラムであっても良い。

また、本発明の実施の形態は、上述した実施の形態に限定されるものではなく、本発明の要旨を逸脱しない範囲において種々の変更が可能である。