CN105814886B - 图像处理设备、图像处理方法和程序 - Google Patents

图像处理设备、图像处理方法和程序 Download PDFInfo

- Publication number

- CN105814886B CN105814886B CN201480067077.9A CN201480067077A CN105814886B CN 105814886 B CN105814886 B CN 105814886B CN 201480067077 A CN201480067077 A CN 201480067077A CN 105814886 B CN105814886 B CN 105814886B

- Authority

- CN

- China

- Prior art keywords

- image

- image data

- area

- region

- automobile

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

- 238000012545 processing Methods 0.000 title claims abstract description 121

- 238000003672 processing method Methods 0.000 title description 7

- 239000002131 composite material Substances 0.000 claims abstract description 131

- 230000008859 change Effects 0.000 claims description 28

- 230000005855 radiation Effects 0.000 claims description 11

- 230000004397 blinking Effects 0.000 claims description 5

- 230000006870 function Effects 0.000 claims description 4

- 238000000034 method Methods 0.000 description 190

- 230000008569 process Effects 0.000 description 180

- 238000006243 chemical reaction Methods 0.000 description 53

- 238000010586 diagram Methods 0.000 description 45

- 238000012937 correction Methods 0.000 description 28

- 239000007787 solid Substances 0.000 description 20

- 230000002194 synthesizing effect Effects 0.000 description 19

- 230000015572 biosynthetic process Effects 0.000 description 16

- 238000003786 synthesis reaction Methods 0.000 description 16

- 238000003702 image correction Methods 0.000 description 12

- 230000003068 static effect Effects 0.000 description 4

- 230000008034 disappearance Effects 0.000 description 2

- 230000000694 effects Effects 0.000 description 2

- 238000003384 imaging method Methods 0.000 description 2

- 239000000203 mixture Substances 0.000 description 2

- 238000012986 modification Methods 0.000 description 2

- 230000004048 modification Effects 0.000 description 2

- 230000002123 temporal effect Effects 0.000 description 2

- 230000009466 transformation Effects 0.000 description 2

- 235000004522 Pentaglottis sempervirens Nutrition 0.000 description 1

- 230000002730 additional effect Effects 0.000 description 1

- 238000010420 art technique Methods 0.000 description 1

- 230000008901 benefit Effects 0.000 description 1

- 238000004891 communication Methods 0.000 description 1

- 238000013461 design Methods 0.000 description 1

- 238000005516 engineering process Methods 0.000 description 1

- 210000000887 face Anatomy 0.000 description 1

- 230000001678 irradiating effect Effects 0.000 description 1

- 230000004807 localization Effects 0.000 description 1

- 238000012544 monitoring process Methods 0.000 description 1

- 210000005036 nerve Anatomy 0.000 description 1

- 230000002093 peripheral effect Effects 0.000 description 1

- 230000003252 repetitive effect Effects 0.000 description 1

- 230000001953 sensory effect Effects 0.000 description 1

- 230000004936 stimulating effect Effects 0.000 description 1

- 238000006467 substitution reaction Methods 0.000 description 1

- 230000007704 transition Effects 0.000 description 1

- 238000013519 translation Methods 0.000 description 1

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N7/00—Television systems

- H04N7/18—Closed-circuit television [CCTV] systems, i.e. systems in which the video signal is not broadcast

- H04N7/181—Closed-circuit television [CCTV] systems, i.e. systems in which the video signal is not broadcast for receiving images from a plurality of remote sources

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T19/00—Manipulating 3D models or images for computer graphics

- G06T19/20—Editing of 3D images, e.g. changing shapes or colours, aligning objects or positioning parts

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60R—VEHICLES, VEHICLE FITTINGS, OR VEHICLE PARTS, NOT OTHERWISE PROVIDED FOR

- B60R1/00—Optical viewing arrangements; Real-time viewing arrangements for drivers or passengers using optical image capturing systems, e.g. cameras or video systems specially adapted for use in or on vehicles

- B60R1/02—Rear-view mirror arrangements

- B60R1/06—Rear-view mirror arrangements mounted on vehicle exterior

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T3/00—Geometric image transformation in the plane of the image

- G06T3/40—Scaling the whole image or part thereof

- G06T3/4038—Scaling the whole image or part thereof for image mosaicing, i.e. plane images composed of plane sub-images

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60R—VEHICLES, VEHICLE FITTINGS, OR VEHICLE PARTS, NOT OTHERWISE PROVIDED FOR

- B60R1/00—Optical viewing arrangements; Real-time viewing arrangements for drivers or passengers using optical image capturing systems, e.g. cameras or video systems specially adapted for use in or on vehicles

- B60R1/20—Real-time viewing arrangements for drivers or passengers using optical image capturing systems, e.g. cameras or video systems specially adapted for use in or on vehicles

- B60R1/22—Real-time viewing arrangements for drivers or passengers using optical image capturing systems, e.g. cameras or video systems specially adapted for use in or on vehicles for viewing an area outside the vehicle, e.g. the exterior of the vehicle

- B60R1/23—Real-time viewing arrangements for drivers or passengers using optical image capturing systems, e.g. cameras or video systems specially adapted for use in or on vehicles for viewing an area outside the vehicle, e.g. the exterior of the vehicle with a predetermined field of view

- B60R1/27—Real-time viewing arrangements for drivers or passengers using optical image capturing systems, e.g. cameras or video systems specially adapted for use in or on vehicles for viewing an area outside the vehicle, e.g. the exterior of the vehicle with a predetermined field of view providing all-round vision, e.g. using omnidirectional cameras

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T1/00—General purpose image data processing

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T3/00—Geometric image transformation in the plane of the image

- G06T3/40—Scaling the whole image or part thereof

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

- G08G1/16—Anti-collision systems

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60R—VEHICLES, VEHICLE FITTINGS, OR VEHICLE PARTS, NOT OTHERWISE PROVIDED FOR

- B60R2300/00—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle

- B60R2300/10—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle characterised by the type of camera system used

- B60R2300/107—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle characterised by the type of camera system used using stereoscopic cameras

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60R—VEHICLES, VEHICLE FITTINGS, OR VEHICLE PARTS, NOT OTHERWISE PROVIDED FOR

- B60R2300/00—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle

- B60R2300/30—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle characterised by the type of image processing

- B60R2300/303—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle characterised by the type of image processing using joined images, e.g. multiple camera images

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60R—VEHICLES, VEHICLE FITTINGS, OR VEHICLE PARTS, NOT OTHERWISE PROVIDED FOR

- B60R2300/00—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle

- B60R2300/60—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle characterised by monitoring and displaying vehicle exterior scenes from a transformed perspective

- B60R2300/607—Details of viewing arrangements using cameras and displays, specially adapted for use in a vehicle characterised by monitoring and displaying vehicle exterior scenes from a transformed perspective from a bird's eye viewpoint

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10016—Video; Image sequence

- G06T2207/10021—Stereoscopic video; Stereoscopic image sequence

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/20—Special algorithmic details

- G06T2207/20212—Image combination

- G06T2207/20221—Image fusion; Image merging

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30248—Vehicle exterior or interior

- G06T2207/30252—Vehicle exterior; Vicinity of vehicle

Abstract

图像处理设备电路从与汽车相邻的区域的第一图像捕获装置接收第一图像数据并且还从相邻区域的第二图像捕获装置接收第二图像数据。该电路将第一图像数据与第二图像数据进行组合,以形成相邻区域的至少一部分的接合区域的复合图像数据。该电路随时间推移,改变从所述第一图像捕获装置和所述第二图像捕获装置取得的各个图像区域,以形成所述接合区域的所述复合图像数据。

Description

相关申请的交叉引用

本申请要求2013年12月16日提交的日本优先权专利申请JP2013-259593的权益,该专利申请的全部内容通过引用并入本文中。

技术领域

本公开涉及图像处理设备、图像处理方法和程序。具体地讲,例如,本公开涉及将通过安装在车辆上的多个相机捕获的图像进行合成并且产生与从车辆上方观察时相同的图像的图像处理设备以及图像处理方法和程序。

背景技术

当从驾驶员的座位不能直接看到行驶方向上的车辆的正前方、侧面、后方等的状态时,存在车辆可能撞上位于行驶方向上的隐蔽障碍物的危险。用于避免这种危险的系统包括驾驶辅助系统,该驾驶辅助系统合成由安装在车辆的前方、后方和侧面的多个广角相机捕获的图像,产生从车辆上方观察到的虚拟图像,并且在设置在驾驶员座位处的显示单元上显示图像。

同时,从车辆上方观察到的图像被称为“环视图像”、“顶视图像”或“鸟瞰图像”等。下文中,在本说明书中,将在假设从车辆上方观察到的图像是“顶视图像”的前提下进行描述。

在此系统中,期望安装在车辆附近的相机近距离捕获具有尽可能宽的区域的图像,因此包括诸如例如鱼眼镜头的广角镜头。该相机可通过使用广角镜头捕获具有宽区域的图像。然而,在使用广角镜头捕获的图像中,出现图像失真。特别地讲,存在图像附近区域中出现大量失真的问题。

相关技术的通用驾驶辅助系统被配置为对捕获图像执行失真校正,以产生从车辆上方观察到的作为校正图像的“顶视图像”,并且将产生的图像输出到显示单元。

同时,用于产生顶视图像的图像校正过程被称为“顶视转换”。

然而,车辆上安装相机的位置包括车辆的前方、后方和侧面等。各相机能够捕获图像的范围被限于车辆的前方区域、后方区域、右侧区域和左侧区域中的任一个区域。因此,为了产生包括车辆的环视图像的顶视图像,需要执行将基于位于不同位置的多个相机捕获的图像而产生的顶视图像进行联合的合成过程。

然而,当执行将通过执行对使用广角镜头捕获的图像执行顶视转换而产生的多个顶视图像进行联合的合成过程时,多个图像之间的接合区域中的物体会被擦除,而没有保留在合成图像中。这是因为,使用地面作为参考平面执行了失真校正。例如,当有物体(立体对象)位于比参考平面高的位置时,在顶视转换之后,物体被压到图像之间的接合边界之外,因此不会保留在合成图像中。

例如,假设在作为待合成对象的图像A和图像B这二者中的每个的大体边界附近,捕获从地面向上延伸的立体对象X,该地面等同于顶视转换中的参考平面。

当通过联合通过对图像A和图像B执行顶视转换而得到的校正图像(顶视图像)来产生合成图像时,图像A和图像B之间的接合区域经受联合过程,在联合过程中,将作为顶视转换参考平面的地面的对应位置设置成接合线。通过切除在图像A和图像B之间的接合线之外的图像,执行联合图像A和图像B的过程。

当执行这种联合过程时,会出现以下情形:在图像A中捕获的立体对象X被设置到图像A的接合线之外,即,在图像A中捕获的立体对象X被设置到从图像A切除的区域。另一方面,在图像B中捕获的立体对象X也被设置到图像B的接合线之外,即,在图像B中捕获的立体对象X被设置到从图像B切除的区域。

结果,图像A和图像B之间的边界附近的立体对象X没有保留在合成图像中。即,不能确认作为原始存在的物体的立体对象X是否在合成图像中。

用于解决此问题的相关领域的技术是PTL1(日本未审查的专利申请公开No.2007-109166)。PTL1公开了如下配置:通过顶视转换来合成由安装在车辆外周的成像装置捕获的图像,使得产生并且显示从车辆上方观察到的合成图像。PTL1公开了如下配置:在作为待合成对象的两个顶视图像彼此重叠的区域中,以梳状形状交替地显示两个校正图像。

在梳状形状的显示区域中,显示通过伴随着失真校正的顶视转换被压到图像之外的物体。因此,作为图像观察者的驾驶员可确认在该区域中存在某种类型的对象,并且可注意到该对象。

PTL1公开了如下配置:以两个顶视图像交替设置成梳状形状的固定图案来显示具有彼此重叠的两个顶视图像的区域。然而,在使用地面平面作为参考平面的顶视转换中,没有对梳状形状显示区域中显示的立体对象正确执行转换。因此,仍有失真,且没有恢复原始形状。另外,因为由于两个图像正显示为梳状形状而导致显示是断开的,所以会难以致使观察者(驾驶员)识别到存在可能发生碰撞的立体对象。

[引用列表]

[专利文献]

[PTL1]

日本未审查的专利申请公开No.2007-109166

发明内容

[技术问题]

期望提供产生通过将使用广角镜头捕获的多个图像进行合成的过程而产生的合成图像作为能够容易识别真实物体的图像并且显示该图像的图像处理设备、图像处理方法和程序。

[问题的解决方案]

一种图像处理设备,具有从与汽车相邻的区域的第一图像捕获装置接收第一图像数据并且还从该相邻区域的第二图像捕获装置接收第二图像数据的电路。所述电路将第一图像数据与第二图像数据进行组合,以形成相邻区域的至少一部分的接合区域的复合图像数据。所述电路随时间推移,改变从所述第一图像捕获装置和所述第二图像捕获装置取得的各个图像区域,以形成所述接合区域的所述复合图像数据。

根据一个方面,描述了一种汽车图像处理系统,所述汽车图像处理系统包括:

第一图像捕获装置,其被安装到所述汽车的前方并且被配置为捕获具有相对于所述汽车中的驾驶员座位向前看的视角的第一图像数据;

第二图像捕获装置,其被安装到所述汽车的侧面并且被配置为捕获具有相对于所述汽车中的驾驶员座位向侧面看的视角的第二图像数据,以及

电路,其被配置为接收所述第一图像数据,接收所述第二图像数据,将所述第一图像数据与所述第二图像数据进行组合,以形成所述第一图像数据和所述第二图像数据之间的接合区域的复合图像数据,以及

随时间推移改变从所述第一图像捕获装置和所述第二图像捕获装置取得的各个图像区域,以形成所述接合区域的所述复合图像数据,其中,

所述接合区域的所述复合图像数据提供所述汽车的顶视图的至少一部分。

根据另一个方面,描述了一种辆监视系统,所述车辆监视系统包括:车

第一图像捕获装置,其被安装到所述汽车的前方并且被配置为捕获具有相对于所述汽车中的驾驶员座位向前看的视角的第一图像数据;

第二图像捕获装置,其被安装到所述汽车的侧面并且被配置为捕获具有相对于所述汽车中的驾驶员座位向侧面看的视角的第二图像数据;

电路,其被配置为

接收所述第一图像数据,

接收所述第二图像数据,

将所述第一图像数据与所述第二图像数据进行组合,以形成所述第一图像数据和所述第二图像数据之间的接合区域的复合图像数据,以及

随时间推移改变从所述第一图像捕获装置和所述第二图像捕获装置取得的各个图像区域,以形成所述接合区域的所述复合图像数据,其中,所述接合区域的所述复合图像数据提供所述汽车的顶视图的至少一部分;以及

显示器,其被安装到所述汽车的内部并且被配置为显示包括所述接合区域的所述汽车的顶视图。

[本发明的有利效果]

根据本公开的实施例的配置,能够产生并且显示从车辆上方观察到的图像,该图像使得容易识别立体对象。

具体地讲,通过分别校正由设置在车辆的不同位置(诸如前方、后方、右侧和左侧)的多个相机捕获的图像,产生多个顶视图像,并且通过将产生的多个顶视图像彼此联合,产生合成图像。图像处理单元产生具有接合区域的合成图像,该接合区域被设置成使得待联合的多个顶视图像的显示区域随时间的变化而改变。例如,彼此待联合的第一图像和第二图像交替设置成条带形状,并且产生具有接合区域的合成图像,该接合区域被设置成使得条带的位置随着时间的变化而改变。

使用这种配置,能够产生并且显示从车辆上方观察的图像,该图像使得容易识别立体对象。

同时,本说明书中描述的效果只是示例,可增加额外的效果。

附图说明

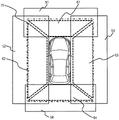

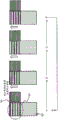

[图1]图1是示出相机安装在车辆上的示例的示图。

[图2]图2是示出使用广角镜头捕获的图像的示例的示图。

[图3]图3是示出作为使用广角镜头捕获的图像的校正示例的顶视转换的示图。

[图4]图4是示出作为使用广角镜头捕获的图像的校正示例的顶视转换的示图。

[图5]图5是示出在图像包括作为物体的立体对象的情况下使用广角镜头捕获的图像的示例的示图。

[图6]图6是使用广角镜头捕获的图像的校正的示例,并且是示出在图像包括作为物体的立体对象的情况下的顶视转换的示图。

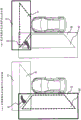

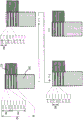

[图7]图7是示出合成多个顶视图像的过程的示例的示图。

[图8]图8是示出合成图像的示例的示图。

[图9]图9是示出立体对象从基于顶视图像的合成图像中消失的示例的示图。

[图10]图10是示出立体对象从基于顶视图像的合成图像中消失的示例的示图。

[图11]图11示出根据本公开的实施例产生的合成图像,并且是示出在车辆的驾驶员座位处设置的显示单元上显示的合成图像的示例的示图。

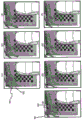

[图12]图12是示出根据本公开的实施例的在合成图像的接合区域中显示模式随着时间的变化而改变的示例的示图。

[图13]图13是示出根据本公开的实施例的在合成图像的接合区域中显示立体对象的实施例的示图。

[图14]图14是示出根据本公开的实施例的应用于合成图像的显示控制的参数的示图。

[图15]图15是示出根据本公开的实施例的应用于合成图像的显示控制的参数的示图。

[图16]图16是示出根据本公开的实施例的应用于合成图像的显示控制的参数的示图。

[图17]图17是示出根据本公开的实施例的合成图像的显示控制序列的流程图。

[图18]图18是根据本公开的实施例的在合成图像的接合区域中显示立体对象的示例的示图。

[图19]图19示出根据本公开的实施例产生的合成图像,并且是示出在车辆的驾驶员座位处设置的显示单元上显示的合成图像的示例的示图。

[图20]图20是示出根据本公开的实施例的在合成图像的接合区域中显示模式随着时间的变化而改变的实施例的示图。

[图21]图21是示出根据本公开的实施例的在合成图像的接合区域中显示立体对象的实施例的示图。

[图22]图22是示出根据本公开的实施例的在合成图像的接合区域中显示立体对象的实施例的示图。

[图23]图23示出根据本公开的实施例产生的合成图像,并且是示出在车辆的驾驶员座位处设置的显示单元上显示的合成图像的示例的示图。

[图24]图24是示出根据本公开的实施例的在合成图像的接合区域中显示模式随着时间的变化而改变的示例的示图。

[图25]图25是示出根据本公开的实施例的在合成图像的接合区域中显示立体对象的示例的示图。

[图26]图26是示出根据本公开的实施例的在合成图像的接合区域中显示立体对象的示例的示图。

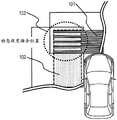

[图27]图27是示出作为当产生合成图像时使用的辅助信息的激光辐射图案的示图。

[图28]图28是示出本公开的图像处理设备的硬件配置的示例的示图。

[图29]图29是示出本公开的图像处理设备的硬件配置的示例的示图。

具体实施方式

下文中将参照附图详细描述本公开的图像处理设备、图像处理方法和程序。同时,将按照以下条目进行描述。

1.关于顶视转换过程和产生合成图像过程的概况和立体对象消失的示例

2.关于动态改变待合成图像的接合区域中的图像的显示区域的实施例

3.关于图像的接合区域中的显示控制序列

4.关于强调接合区域中显示的特定对象的过程的示例

5.关于接合区域中的显示模式改变的示例

5-1.交替设置弯曲条带型显示区域的实施例(第二实施例)

5-2.接合区域的图像边界移动的实施例(第三实施例)

6.关于当产生合成图像时使用的辅助信息

7.关于图像处理设备的硬件配置的示例

8.本公开的配置的结论

<1.关于顶视转换过程和产生合成图像过程的概况和立体对象消失的示例>

首先,将描述如下的过程的概况:通过对由安装在车辆的不同位置(诸如前方、后方、右侧和左侧)的相机捕获的图像中的每个执行顶视转换以及通过将产生的多个顶视图像彼此联合来产生合成图像,还将描述在这个过程中产生的立体对象消失的示例。

图1是示出相机安装在车辆上的示例的示图。

如图1(A)中所示,四个相机安装在车辆10前方、后方、右侧和左侧的位置处。

四个相机(即,相机F21、相机L22、相机R23和相机B24)分别安装在车辆10的前方、左侧、右侧和后方。

如在图1(B)的相机配置中所示的,相机F21至R24中的每个被配置为包括诸如例如鱼眼镜头的广角镜头并且通过将成像方向设置成朝下方向(朝地面方向)来大范围地捕获地面和地面上的立体对象的图像。

在使用广角镜头捕获的图像中出现失真。将参照图2描述使用广角镜头捕获的图像的示例。

图2(a)示出图像捕获环境。物体31是其上绘制栅格图案的地面。广角相机30设置在物体31的顶部中心,以执行图像捕获。

相机30是其上安装有诸如例如鱼眼镜头的广角镜头的相机。

在图2(a)中示出的图像捕获环境中捕获的图像的示例是在图2(b)中示出的捕获图像。

如图2(b)的捕获图像中所示的,捕获图像上的地面的栅格图案发生弯曲失真。

失真是由于使用广角镜头捕获图像而导致的图像的失真。

为了通过去除图2(b)中示出的捕获图像的失真来产生与真实物体具有相同形状的图像,需要执行图像校正,即,顶视转换。

以下,将参照图3描述这个校正过程的示例。

图3分别示出与图2(b)中的捕获图像相同的捕获图像和通过捕获图像的校正过程(顶视转换)而产生的校正图像(顶视图像)。

同时,从上方观察到的图像被称为“顶视图像”,执行到“顶视图像”的转换的图像校正过程被称为“顶视转换”。图3(c)中示出的校正图像是“顶视图像”,根据图3(b)的捕获图像产生校正图像的校正过程等同于“顶视转换”。

图3(c)的校正图像(顶视图像)是具有与图2(a)的上述图像捕获环境中的物体31的栅格图案相同的栅格图案的图像并且是从地面上方观察到的校正顶视图像,并且地面的栅格图案是恢复真实物体的形状的图案。

图4是示出校正用诸如鱼眼相机的广角相机捕获的图像的过程的示例的示图,该广角相机是朝着倾斜向下方向安装的。如图4(a)中所示,由朝着倾斜向下方向安装的广角相机30将其上绘制栅格图案的地面的图像作为物体31进行捕获。图4(b)和图4(c)分别示出图4(a)中示出的图像捕获环境中捕获的捕获图像和校正图像。

通过去除图4(b)中示出的图像的鱼眼失真而被转换成中心捕获图像的所谓失真校正图像是图4(c)中示出的校正图像。

在图4中示出的示例中的失真校正过程中,物体31(其上绘制四方栅格图案的地面)的梯形得自图4(b)中示出的一系列图像,这一系列图像是从广角相机30的倾斜位置捕获的,通过执行鱼眼失真校正过程反映立体图。

换句话讲,在进行失真校正过程时,得到图4(c)中示出的梯形图像,在该梯形图像中,捕获图像的弯曲失真被去除并且立体图保留。

能够执行以下过程:通过去除图4(c)中保留的梯形失真,对从物体31正上方的虚拟相机30F的位置捕获的图像执行转换,以移位至虚拟相机点。这一系列过程被作为一体过程执行,因此得到根据倾斜信息观察到的地面的顶视图像。

同时,下文中,其中从倾斜方向观察到的图像的失真转换结合顶视转换的上述一体转换过程将被统称为“顶视转换”。以这种方式,顶视转换用作包括将从上方倾斜观察到的图像转换成从上方观察到的图像的过程的过程。然而,以下将省略对从倾斜方向观察图像的过程的描述。

使用特定水平平面作为参考平面,执行如图3中所示的顶视转换。图3示出使用其上绘制栅格图案的地面作为参考平面来执行的转换过程的示例,并且以高准确度恢复绘制在地面上的栅格图案。

然而,设置一个参考平面的顶视转换的问题是,除了参考平面外的物体被投影到不同于其安装点的位置。

以下,将参照图5和图6描述这个问题。

类似于参照图2进行的以上描述,图5分别示出图像捕获环境和捕获的图像。

类似于图2(a),图2(a)的图像捕获环境包括其上绘制栅格图案的地面。然而,设置从地面向上延伸的立体对象32。

广角相机30安装在地面上的有限距离处,并且朝向地面设置。

类似于参照图2(b)进行的以上描述,在图2(b)的捕获图像中,在地面的栅格图案中出现失真。另外,还在失真状态下捕获立体对象32的图像。

同时,附图是示意图,立体对象32的失真根据其位置和高度以各种方式变化。

图6是示出校正图6(b)的捕获图像的过程(即,使用地面平面作为参考平面的顶视转换过程)的示例的示图。

如图6(c)的校正图像(顶视图像)中所示,明确地校正地面的栅格图案。然而,立体对象32的失真保留下来,因此立体对象以变成不同于观察到的真实形状的形状进行显示。

图6(d)中示出的参考图像是理想地从无限远处观察到的顶视图像的示例。在这个图像中,直接从上方观察立体对象32。

同时,图6是示意图,因顶视转换而保留在立体对象32中的失真根据其位置和高度以各种方式变化。

接下来,将参照图7和图8描述通过连接由安装在车辆上的多个广角相机捕获的图像来产生合成图像的过程。

图7是示出由以上参照图1描述的、安装在车辆的正面、后面、右面和左面这四个面上安装的四个相机捕获的图像区域和被应用于产生合成图像的合成区域的示例的示图。

图7中示出的前方图像捕获区域51表示由图1中示出的相机F21捕获的区域。左侧图像捕获区域52表示由相机L22捕获的区域,右侧图像捕获区域53表示由相机R23捕获的区域,后方图像捕获区域54表示由相机B24捕获的区域。

通过对这四个捕获图像执行顶视转换,产生四个校正图像(顶视图像),然后将顶视图像彼此联合,以形成一个合成图像。

图7中示出的四个虚线梯形区域是从各个捕获图像中被选择作为合成图像70的组成的区域(合成区域)。

通过连接下面的四个合成区域,产生合成图像70。

将四个区域(即,(a)作为前方图像捕获区域51的一部分的前方图像合成区域61、(b)作为左侧图像捕获区域52的一部分的左侧图像合成区域62、(c)作为右侧图像捕获区域53的一部分的右侧图像合成区域63、(d)作为后方图像捕获区域54的一部分的后方图像合成区域64)彼此连接,从而完成一个合成图像70。

同时,在进行合成过程之前,对图像执行顶视转换。即,合成通过执行顶视转换过程而产生的四个顶视图像。

通过合成过程产生一个合成图像70。

图8示出合成图像70的示例。如图8中所示,合成图像70等同于以车辆图像71为中心从上方观察车辆附近的地面得到的图像。

同时,车辆图像71不是相机捕获的图像,而是预先设置的这个系统上安装的车辆的伪图像。

产生要输出到设置在车辆驾驶员座位处的显示单元的图像的数据处理单元对由相机捕获的图像执行将车辆图像71附接到通过执行顶视转换而产生的车辆周围环境的图像(顶视图像)的过程和合成过程,以产生待输出图像并且在显示单元上显示该图像。

驾驶员观察该图像,以确认车辆周围环境的情形并且安全地驾驶。

然而,当产生其中多个顶视图像彼此连接的合成图像时,存在的问题是,站在相邻相机之间的边界上的地面上的物体彼此联合,因此从顶视图像中消失。

如以上参照图5和图6描述的立体对象32中一样,这在物体(对象)存在于不同于顶视转换的参考平面(地面)的位置的情况下出现。

以下,将参照图9描述物体消失的示例。图9是示出合成前方图像合成区域61和左侧图像合成区域62的过程的示例的示图。

图9(a)示出通过对左侧图像捕获区域52和左侧图像合成区域62中捕获的图像执行顶视转换而得到的图像上的立体对象32的位置。

顶视转换图像等同于例如以上参照图6(c)描述的校正图像(顶视图像)。

如图9(a)中所示,立体对象32被转换并且投影到从具有梯形形状的左侧图像合成区域62移开的位置上。

另一方面,图9(b)示出通过对前方图像捕获区域51和前方图像合成区域61中捕获的图像执行顶视转换而得到的图像上的立体对象32的位置。

如图9(b)中所示,立体对象32也被转换并且投影到从具有梯形形状的前方图像合成区域61移开的位置上。

具有梯形形状的左侧图像合成区域62和具有梯形形状的前方图像合成区域61被彼此联合,从而产生最终合成图像。

所得的合成图像并不包括立体对象32的图像,立体对象32消失。

即,如图10中所示,立体对象32并不被包括在合成图像70的左侧图像和前方图像之间的接合区域81中,并且产生其中立体对象32消失的合成图像70。

以这种方式,当产生并且合成多个顶视图像的过程是基于地面平面进行时,在顶视图像之间的边界区域中存在的立体对象会消失。

结果,在驾驶员座位处的显示单元上显示的合成图像中,没有显示立体对象。因此,驾驶员不能够识别到障碍物,从而导致驾驶员危险驾驶的可能性。

<2.关于动态改变待合成图像的接合区域中的图像显示区域的实施例>

接下来,将描述用于解决上述问题的本公开的实施例的配置。

在本公开的实施例中,执行动态改变待合成图像之间的接合区域中待合成图像的显示区域的过程。

以下,将参照图11和后续附图描述这个实施例。

图11是示出在车辆的驾驶员座位处设置的显示单元上显示的合成图像的一部分的示图。图11示出作为构成合成图像的图像的前方图像101和左侧图像102之间的接合区域103的附近。

同时,图11中示出的前方图像101和左侧图像102二者都是在它们被执行顶视转换过程之后的图像。

前方图像101是通过对由安装在车辆前方的前方相机(等同于图1中示出的相机F)捕获的图像执行顶视转换而得到的图像。

左侧图像102是通过对由安装在车辆左侧的左侧相机(等同于图1中示出的相机L)捕获的图像执行顶视转换而得到的图像。

在这个实施例中,前方图像101和左侧图像102之间的接合区域103具有以下配置。

以矩形条带区域为单元,交替地设置前方图像101和左侧图像102的显示区域,并且条带位置随着时间的变化而顺序地移动。

因此,执行将接合区域103内的前方图像101和左侧图像102的显示区域随着时间的变化而改变的过程,即,显示区域的动态改变过程。

以下,将参照图12描述显示区域的动态改变过程。

图12是示出随着时间的变化而改变前方图像101和左侧图像102之间的接合区域103的过程的示例的示图。

时间以t1、t2、t3和t4的次序变化,示出这各个时间处的接合区域的显示模式变化的状态。

前方图像101的条带区域随着时间的变化(t1→t2→t3→t4)而顺序向上移动。

同时,在时间t5处,时间t4和后续时间具有与时间t1的条带位置相同的条带位置。另外,分别以与t2、t3和t4相同的方式来设置t6、t7和t8,然后重复进行同样的条带移动。

在图12中示出的示例中,前方图像101和左侧图像102之间的接合区域103是矩形区域。在该矩形区域中,一些部分对应于前方图像101的显示区域,而其它部分对应于左侧图像102的显示区域。显示区域随着时间的变化而顺序地改变。

在从时间t1至时间t5的一个显示时间段内,前方图像101的显示时间段和左侧图像102的显示时间段交替地设置在构成接合区域103的所有矩形区域中。

即,接合区域103的整个区域对应于其中可确认前方图像101和左侧图像102这二者的区域。

如上所述,在构成合成图像的两个顶视图像的接合区域中,各个顶视图像的显示区域的显示动态改变,即,各个顶视图像的显示区域的显示随着时间的变化顺序地改变,从而解决了以上参照图9和图10描述的立体对象从合成图像中消失的问题。

由于不能通过交替地显示图像来精确地看到所有图像,因此难以仅仅通过观看图像来确定危险。然而,通过顺序地并且可变地按时间顺序移动图像的边界,立体对象的边界线在屏幕上动态地移动。

即,在这种方法中,由于接合区域103的整个区域被设置成其中可确认前方图像101和左侧图像102这二者的区域,因此立体对象的显示区域没有被完全切除,并且动态边界线移动,从而允许识别特定的立体对象。

另外,在这种显示方法中,由于接合区域的显示模式随着时间的变化而变化,因此刺激形成动态立体图,使得更容易在外围视场内用动态立体图进行刺激从而吸引注意,尽管驾驶员没有正盯着对象。

即,在接合区域中,相比于合成图像中的其它区域(静态区域),立体对象看上去好像它正沿着边界移动,因此接合区域用作吸引注意的区域。

这种吸引注意的区域用作观察者(驾驶员)检测接合区域中存在的立体对象的有效手段。

同时,优选地给出以下配置:设置在接合区域103中的前方图像101的条带宽度和左侧图像102的条带宽度彼此不相等并且条带宽度中的任一个被设置成大于另一个。用这种配置,观察者可优先地且可视地确认接合区域103内的前方图像101和左侧图像102中的任一个图像,即,被设置成具有更大条带宽度的图像,使得更容易更精确地确认与立体对象的边界的动态移动关联的情形。

现在,将参照图13描述在接合区域中显示立体对象的示例。

图13示出在时间t1至时间t4的接合区域的以上参照图12描述的显示模式之中的时间t1和时间t3的两种显示模式下显示立体对象的示例。即,示出显示下面两个合成图像的示例。

(a)时间t1处的合成图像

(b)时间t3处的合成图像

示出在不同定时处显示合成图像的示例。

立体对象的显示区域被包括在具有条带形状并且被设置成接合区域的前方图像和左侧图像中的每个中。

在前方图像101中,前方图像内的立体对象111显示在设置有条带的接合区域的前方图像显示区域中。

另一方面,另外在左侧图像102中,左侧图像内的立体对象112显示在设置有条带的接合区域的左侧图像显示区域中。

立体对象等同于在图9的上述合成图像中被切除的物体(立体对象)并且从合成图像中消失。

如以上参照图9描述的,这个过程示例被配置为,使得在顶视图像的端部没有被切除的情况下,待联合的两个顶视图像全都可在顶视图像之间的接合区域中被观察到,因此能够观察到顶视图像中包括的所有物体。

图13分别示出两个不同定时处的合成图像的显示模式。

(a)时间t1处的合成图像

(b)时间t3处的合成图像

示出这些定时处的合成图像。这些定时处的合成图像的接合区域中显示的图像互不相同。

即,随着时间的变化,前方图像的显示区域不同于左侧图像的显示区域,并且随着时间的变化,各个图像内的立体对象的显示区域互不相同。

观察者(驾驶员)的注意力有面对显示信息改变的图像区域,而非没有变化的静态区域的倾向。

因此,观察者(驾驶员)的眼睛有面对显示信息动态改变的接合区域的倾向,因此能够增加在不被忽略的情况下确认接合区域中显示的立体对象的可能性。

<3.关于图像的接合区域中的显示控制序列>

接下来,将描述以上参照图11至图13描述的接合区域的显示控制过程的序列。

以下将描述的过程序列是以下的显示控制过程的序列:设置其中两个顶视图像交替设置成条带形状的图像接合区域,以及执行随着时间推移将图像接合区域中设置的图像的条带区域顺序移动的显示控制。

首先,将参照图14至图16描述应用于显示控制过程的参数。

在图14中示出参数的列表。

图15和图16是示出前方图像101和左侧图像102之间的接合区域103的配置示例和参数的设置的示图。

图15和图16中示出的前方图像101和左侧图像102二者都是在它们被执行作为校正过程的顶视转换之后的顶视图像。

如图14中所示,接合区域103的显示控制过程中将使用的参数如下。

i:条带标识符,接合区域的任一个图像(在这个示例中,前方[f]图像)的条带标识符,而第一条带标识符i=0

j:图像形成像素的行标识符,从接合区域的任一个图像(在这个示例中,前方[f]图像)的各条带开始位置起的行标识符,而各条带起始位置的行j=0

ZN:条带数量指定值,能够在设置条带标识符i的图像(在这个示例中,前方[f]图像)的接合区域中设置的条带标识符(i)的最大值

Wf:条带宽度指定值,等同于设置条带标识符i的图像(在这个示例中,前方[f]图像)的一个条带的宽度的行标识符(j)的最大值

Ws:条带宽度指定值,等同于作为没有设置条带标识符i的图像(在这个示例中,前方[f]图像)的其它图像(在这个示例中,左侧[s]图像)的条带宽度的行的数量

Wf+Ws:接合区域中的交替显示条带间隔指定值,等同于设置条带标识符i的图像(在这个示例中,前方[f]图像)的条带间隔的行的数量

SW:条带移位宽度指定值,设置条带标识符i的图像(在这个示例中,前方[f]图像)的每个单位帧的条带移位行的数量

f:显示帧标识符

使用这些参数执行接合区域103的显示控制。

如图15中所示,条带标识符i是接合区域的任一个图像(在这个示例中,前方[f]图像)的条带标识符。

例如,从上开始依次设置标识符i、i+1和i+2。

同时,使用0作为第一条带标识符,将条带标识符设置为0、1、2、3…。

如图16中所示,行标识符j是指示从接合区域的任一个图像(在这个示例中,前方[f]图像)的各条带起始位置起的行的数量的标识符。

然而,各条带起始位置的行的标识符被设置成j=0。

同时,如上所述,优选地给出以下配置:设置在接合区域103中的前方图像101的条带宽度和左侧图像102的条带宽度彼此不相等,并且通过更多地显示给驾驶员而更有效的条带宽度中的任一个被设置成大于其它条带宽度。

在图16中示出的示例中,前方图像101的条带宽度被设置成三行,左侧图像102的条带宽度(=前方图像的条带之间的宽度)被设置成五行。

用这种配置,观察者可优先地在接合区域103内确认被设置成具有较大条带宽度的左侧图像102,因此更容易地确认立体对象。

条带数量指定值ZN是在设置条带标识符i的图像(在这个示例中,前方[f]图像)的接合区域中可设置的条带标识符(i)的最大值。

在图15中示出的示例中,满足ZN=4的关系。

具有指定值Wf的条带是等同于设置条带标识符i的图像(在这个示例中,前方[f]图像)的一个条带的宽度的行标识符(j)的最大值。

图16中示出的示例示出以下配置:可设置具有行标识符j=0至2的宽度的条带,并且满足Wf=2的关系。

条带宽度指定值Ws是条带宽度指定值,并且是等同于作为没有设置条带标识符i的图像(在这个示例中,前方[f]图像)的其它图像(在这个示例中,左侧[s]图像)的条带宽度的行的数量。

在图16中示出的示例中,满足Ws=5的关系。

交替显示条带间隔指定值Wf+Ws是接合区域中的交替显示条带间隔指定值,并且是等同于设置条带标识符i的图像(在这个示例中,前方[f]图像)的条带间隔的行的数量。

在图16中示出的示例中,满足Wf+Ws=7的关系。

条带移位宽度指定值SW是设置条带标识符i的图像(在这个示例中,前方[f]图像)的每个单位帧的条带移位行数。

在图16中示出的示例中,满足SW=2的关系。

显示帧标识符f是指示显示帧编号的标识符。

如图16中所示,按帧f、帧f+1、帧f+2和帧f+3的次序,以1帧为单元顺序地执行接合区域的条带的移位过程。

条带在向上方向和向下方向中的任一个方向上移动。

同时,在这个示例中,移位过程以1帧为单元来执行,但不限于此。

例如,该过程可被设置成以10帧为单元来执行。

用这种配置,条带的移动使得被设置得更低。

使用这些参数来执行接合区域103的显示控制。

接下来,将参照图17中示出的流程图来描述使用这些参数的显示控制序列的具体序列。

图17中示出的处理流程是示出根据多个顶视图像产生的合成图像的部分区域的显示控制处理序列的流程。

具体地讲,例如,显示控制过程序列等同于图15中示出的接合区域103和该接合区域下方的左侧图像102的图像区域的显示过程的控制序列。

同时,另外在其它区域中,以相同顺序执行显示控制。

例如,在数据处理单元(控制单元)的控制下执行图17中示出的流程,该数据处理单元执行安装在车辆上的显示单元的显示控制。

例如,数据处理单元(控制单元)包括具有执行程序的功能的CPU,并且数据处理单元基于其中记录有根据图16中示出的流程的过程序列的程序来控制过程。

该程序被存储在作为可由数据处理单元(控制单元)访问的存储单元的存储器或存储介质等中。作为替代地,可提供以下配置:通过通信单元从外部服务器等获取该程序。

下文中,将顺序地描述图17中示出的流程图的步骤的过程。

同时,作为开始流程之前的过程,初始地设置以下参数。

条带标识符i=0

行标识符j=0

在执行初始设置这些参数之后,执行步骤S101的过程和后续过程。

[步骤S101]

首先,在步骤S101中,前方图像的第j行被作为构成合成图像的接合区域的行输出。

例如,步骤S101的过程等同于产生由图15和图16中示出的前方图像101构成的条带区域的过程。

同时,如上所述,初始设置是j=0。初始地,输出前方图像的第0行。例如,这等同于输出j=0的行的过程,j=0的行是图16中示出的帧f中的前方图像101的最上面的行。即,该过程等同于从前方图像101获取第一条带(条带标识符:i=0)的最上面的行(行标识符:j=0)以及输出最上面的行的过程。

[步骤S102]

接下来,在步骤S102中,执行将行标识符j与条带宽度指定值Wf进行比较的过程。如上所述,条带宽度指定值Wf是等同于设置条带标识符i的图像(在这个示例中,前方[f]图像)的一个条带的宽度的行标识符(j)的最大值。例如,在图16中示出的示例中,创建Wf=2的关系。

在步骤S102中,确定行标识符j是否等于或大于条带宽度指定值Wf。即,确定是否创建了“j等于或大于Wf”的确定表述。

这个确定表述是用于确定在步骤S101中输出的前方图像的行的数量(即,构成前方图像101的条带的行的数量)是否达到条带宽度指定值Wf的过程。

例如,当在Wf=2的情况下j=2时,步骤S102的确定结果是“是”,因此过程前进至步骤S104。

在j=0或j=1的情况下,步骤S102的确定结果是“否”,因此过程前进至步骤S103。

在第一阶段中,由于满足j=0的关系,因此步骤S102的确定结果是“否”,因此过程前进至步骤S103。

[步骤S103]

在步骤S103中,执行更新行标识符j的过程。即,根据更新表达式j=j+1,将j的值递增1。

在第一阶段中,由于满足j=0的关系,因此通过更新过程创建关系j=1。

在步骤S103中更新参数之后,在步骤S101中执行与更新后的行标识符j对应的过程。

即,当创建j=1的关系时,前方图像的第一行作为构成合成图像的接合区域的行被输出。

重复从步骤S101至步骤S103的循环,直至创建步骤S102的确定表述,即,“j等于或大于Wf”的确定表述。即,构成前方图像101的行被输出到接合区域103,直至行标识符j达到条带宽度指定值Wf。

例如,如图16中示出的示例中一样,当在条带宽度指定值Wf=2的情况下j=2时,步骤S102的确定结果是“是”,因此过程前进至步骤S104。

因此,完成接合区域的一个条带(例如,i=0的条带)。

[步骤S104]

接下来,在步骤S104中,行标识符j递增1。即,根据更新表达式j=j+1,更新行标识符j的值。

同时,首先,当在条带宽度指定值Wf=2的情况下行标识符j=2时,步骤S102的确定结果是“是”,因此执行步骤S104。在创建行标识符j=3的关系之后,过程前进至步骤S105。

[步骤S105]

接下来,在步骤S105中,左侧图像的第j行作为构成合成图像的接合区域的行被输出。

例如,步骤S105的过程等同于产生由图15和图16中示出的左侧图像102构成的条带区域(=前方图像101的条带之间的区域)的过程。

当在条带宽度指定值Wf=2的情况下行标识符j=3时,执行步骤S105。在图16的帧f的示例中,执行将左侧图像102的行数据作为行j=3输出的过程。即,执行将左侧图像102的行数据作为构成前方图像101的条带之间的区域的行输出的过程。

[步骤S106]

接下来,在步骤S106中,执行将行标识符j与通过将前方[f]图像的条带宽度指定值Wf与左侧[s]图像的条带宽度指定值Ws相加而得到的值(Wf+Ws:交替显示条带间隔指定值)进行比较的过程。

如上所述,条带宽度指定值Wf是等同于设置条带标识符i的图像(在这个示例中,前方[f]图像)的一个条带的宽度的行标识符(j)的最大值。例如,在图16的示例中创建Wf=2的关系。

另外,条带宽度指定值Ws是等同于作为没有设置条带标识符i的图像(在这个示例中,前方[f]图像)的其它图像(在这个示例中,左侧[s]图像)的条带宽度的行的数量。

同时,在图16中示出的示例中,满足Ws=5的关系。

在步骤S106中,确定行标识符j是否等于或大于将条带宽度指定值Wf与条带宽度指定值Ws相加而得到的值(Wf+Ws:交替显示条带间隔指定值)。即,确定是否创建了“j等于或大于(Wf+Ws)”的确定表述。

这个确定表述是以下过程:用于确定构成已经通过步骤S101的非重复过程产生的条带的行的数量和构成正在步骤S105中产生的条带的行的数量之和是否达到接合区域中的两个图像的条带间隔指定值Wf与条带宽度指定值Ws之和(Wf+Ws:交替显示条带间隔指定值)。

例如,当在对应于前方[f]图像的条带宽度指定值Wf=2和对应于左侧[s]图像的条带宽度指定值Ws=5的情况下j=5时,步骤S106的确定结果是“是”,因此过程前进至步骤S107。

在j=3至6的情况下,步骤S106的确定结果是“否”,因此过程返回步骤S104。

在第一阶段中,由于满足j=3的关系,因此步骤S106的确定结果是“否”,从而过程返回步骤S104,以执行参数更新,以用于将j的值递增1,即,j=j+1。然后,还执行步骤S105的过程。

即,在j=3至7时,重复地执行步骤S105的过程。例如,这个过程是将左侧图像102的图像输出到图16中示出的帧f的行j=3至7的过程。即,这个过程等同于用左侧图像102的图像填充条带之间的空间的过程。

重复从步骤S104至步骤S106的循环,直至创建步骤S106的确定表述,即,“j等于或大于(Wf+Ws)”的确定表述。即,例如,如图16中所示,构成左侧图像102的行被输出到接合区域103,直至行标识符j达到条带宽度指定值Wf和条带宽度指定值Ws之和(Wf+Ws:交替显示条带间隔指定值)。

例如,如图16中示出的示例中一样,当在条带宽度指定值Wf=2并且条带宽度指定值Ws=5的情况下j=7时,步骤S106的确定结果是“是”,因此过程前进至步骤S107。

当步骤S104至S106的重复循环终止时,接合区域的条带之间的一个区域完成。

[步骤S107至步骤S108]

接下来,在步骤S107中,执行将条带标识符i与条带数量指定值ZN进行比较的过程。

如图15中所示,条带标识符i是接合区域的任一个图像(在这个示例中,前方[f]图像)的条带标识符。例如,从上开始依次设置标识符i、i+1和i+2。同时,使用0作为第一条带标识符,将条带标识符i设置为0、1、2、3…。

条带数量指定值ZN是在设置条带标识符i的图像(在这个示例中,前方[f]图像)的接合区域中可设置的条带标识符(i)的最大值。

在图15中示出的示例中,满足ZN=4的关系。

在步骤S107中,确定条带标识符i是否被设置成等于或大于条带数量指定值ZN。即,确定是否创建了“i等于或大于ZN”的确定表述。

这是用于确定步骤S101至步骤S106中产生的条带的数量是否达到指定上限的过程。

例如,在图15中示出的示例中,满足条带数量指定值ZN=4,接合区域103内可设置的条带的数量是5。因此,可设置条带,直至满足条带标识符i=4的关系。

即,在i=0至3的情况下,步骤S107的确定结果是“否”,因此过程前进至步骤S108,以执行用于将条带标识符i递增1以及将行标识符j重置成0的参数更新。然后,重复步骤S101至步骤S106的过程。

即,执行输出条带之间的间隔的后续过程。

在图15和图16中示出的示例中,通过输出前方图像101的3行来产生一个条带区域,通过输出左侧图像102的5行来产生条带之间的区域。

这个过程重复进行指定次数,即,直至满足步骤S107中的确定表述“i等于或大于ZN”。

重复这个过程,从而完成例如输出图15中示出的接合区域103内的图像的配置。即,完成由包含前方图像101的条带图像的3行和左侧图像的条带之间的5行图像的重复配置构成的接合区域的图像。

[步骤S109]

接下来,在步骤S109中,执行顺序地将左侧图像的行附接到合成图像的接合区域的连续区域的过程。

例如,这个过程等同于输出图15中示出的接合区域103下方的左侧图像102的过程。

[步骤S110]

在步骤S110中,确定针对一帧的图像的输出是否终止。

即,确定是否完成左侧图像102的输出。

当输出没有终止时,过程返回步骤S109,以顺序地输出构成左侧图像102的行。

当在步骤S110中确定针对一帧的图像的输出终止时,过程前进至步骤S111。

图17中示出的流程是如下的流程:其中对合成图像的一部分(即,图15中示出的接合区域103和接合区域下方的左侧图像102的待输出区域)执行显示控制。

还能够仅仅通过改变图17中示出的流程中的“前方图像”和“左侧图像”的设置,用相同的过程序列对合成图像中的其它区域执行输出控制。

[步骤S111]

在步骤S111中,更新帧标识符f。即,根据更新表达式f=f+1,帧标识符f递增1。

例如,该过程等同于图16中示出的执行从帧f转变至帧f+1的过程。

[步骤S112]

在步骤S112中,执行将开始显示的第j行移位预定行数的过程。

这里,SW是条带移位宽度指定值,是设置条带标识符i的图像(在这个示例中,前方[f]图像)的每个单位帧的条带移位行数。

在图16中示出的示例中,满足SW=2的关系。

即,执行将设置行标识符j=0的关系的行移位2行的过程。

例如,在图15中示出的示例中,指示前方图像101的第一条带的第一行的位置的j=0的位置与帧f中的前方图像101的最上面的行的位置关联。如在设置帧f+1时一样,执行将j=0的位置在朝下方向上移动2行的过程。

这个过程的结果是,由前方图像101构成的条带的待输出位置移位,即,位移达条带移位行数。

在执行该移位过程之后,执行步骤S101的过程和后续过程。

该过程的结果是,例如,产生以及输出包括具有图15中示出的帧f+1的设置的条带配置的接合区域的图像。

当在步骤S110中确定帧f+1的图像的输出完成时,在步骤S111中执行满足条带移位行数SW=2的移位过程,然后,执行步骤S01的过程和后续过程。

作为该过程的结果,例如,产生以及输出包括具有图15中示出的帧f+2的设置的条带配置的接合区域的图像。

类似地,当在步骤S110中确定帧f+2的图像的输出完成时,在步骤S111中执行满足条带移位行数SW=2的移位过程,然后,执行步骤S01的过程和后续过程。

作为该过程的结果,例如,产生以及输出包括具有图15中示出的帧f+3的设置的条带配置的接合区域的图像。

作为该过程的结果,接合区域中的条带顺序地移位,前方图像101和左侧图像的显示区域随着时间的变化而改变以及显示。

同时,可不同地设置每一帧的移位量(SW),并且可能够按照移位量(SW)的设置以各种方式改变条带的移动速度。

另外,还能够不同地设置其它参数,即,条带宽度指定值Ws、条带间隔指定值Wf和条带数量指定值ZN,并且通过调节这些参数来改变接合区域中显示的条带的图案。

另外,如以上参照图16描述的,在这个示例中,移位过程以1帧为单元来执行,但不限于此。该过程可以任何数量的帧为单元或者以n个帧为单元来执行。本文中,n是等于或大于1的整数。

在这种情况下,步骤S110的确定过程可被设置为确定表述“n帧的输出终止了吗?”,步骤S111的过程可被设置成设置“f=f+n”的更新过程。

为了增大更新过程的间隔,可增大n的值,可将n设置成10或20。用这种配置,条带的移动速度被设置成较低。

<4.关于强调接合区域中显示的特定对象的过程的示例>

如上所述,上述实施例被配置为在顶视转换图像之间的接合区域中随着时间的变化而改变这两个顶视转换图像的显示区域。

以这种方式,能够用显示信息的动态改变来吸引作为观察者的驾驶员注意。

另外,将描述强调在接合区域中显示的立体对象从而更强烈地将注意力引导到在接合区域中显示的立体对象的过程的示例。

图18示出在前方图像101和左侧图像102之间的接合区域103中显示立体对象的显示示例。

立体对象被显示为作为前方图像101的显示区域的条带区域中的前方图像内的立体对象111,并且被显示为作为左侧图像的显示区域的条带间区域中的左侧图像内的立体对象112。

强调立体对象的显示。具体地讲,通过闪烁显示或者通过改变颜色和亮度等,以醒目的显示模式来执行强调。

同时,以下面方式中的任一种来设置接合区域中的强调的程度。

(a)对立体对象区域整体均匀地执行强调。

(b)对立体对象区域的与接合图像的边界靠近的一部分执行强调的程度被设置成较高,随着与接合图像边界的距离增大,强调的程度被设置成较低。

同时,在检测前方图像101和左侧图像102中的每个所包括的立体对象区域的过程中,计算前方图像101和左侧图像102的像素值之间的差异,并且确定像素值之间的差异较大的区域是立体对象的显示区域。

如上所述,顶视转换是基于一个参考平面执行的转换过程。在这种情况下,参考平面是地面。由于相对于地面去除了前方图像101和左侧图像102的失真,因此位于所述地面上的物体在各个图像的对应显示的位置处显示。因此,各个图像的对应像素的位置的像素值基本上相同,它们之间几乎没有出现差异。

然而,由于尽管执行了顶视转换,在立体对象中还是保留了失真,因此位于前方图像101和左侧图像102的对应像素的各个位置处的像素用作不同物体的显示区域的可能性高,因此两个顶视转换图像的对应像素的位置的像素值之间出现差异。确定保持此差异的像素区域是立体对象的显示区域。同时,以图像的预定单元区域的多个像素为单元执行计算的绝对差值和(SAD)可应用于确定这两个图像的对应像素的位置的像素值之间的差异的过程。

<5.关于接合区域中的显示模式改变的示例>

在上述实施例中,已描述了以下的配置示例:其中矩形条带型显示区域交替设置在其间的接合区域中的两个顶视图像中并且矩形条带型显示区域随着时间的变化而移动。

下文中,将描述具有与上述实施例的显示配置不同的显示配置的实施例。

<5-1.交替设置弯曲条带型显示区域的实施例(第二实施例)>

作为第二实施例,将参照图19和后续附图描述交替设置弯曲条带型显示区域的实施例。

图19是示出在车辆的驾驶员座位处设置的显示单元上显示的合成图像的一部分的示图。即,图19是示出作为构成合成图像的图像的前方图像101和左侧图像102之间的接合区域103的附近的示图。

同时,图19中示出的前方图像101和左侧图像102二者都是在它们被执行顶视转换过程之后的图像。

即,前方图像101是通过对由安装在车辆前方的前方相机(等同于图1中示出的相机F)捕获的图像执行顶视转换而得到的图像。

左侧图像102是通过对由安装在车辆左侧的左侧相机(等同于图1中示出的相机L)捕获的图像执行顶视转换而得到的图像。

这个实施例被配置为,使得前方图像101和左侧图像102的显示区域以弯曲条带型显示区域为单元交替地设置在前方图像101和左侧图像102之间的接合区域103中。另外,这些条带位置随着时间的变化而顺序地移动。

即,接合区域103中的前方图像101和左侧图像102的显示区域被设置成随着时间的变化而改变。

以下,将参照图20描述显示区域的动态改变过程。

图20是示出前方图像101和左侧图像102之间的接合区域103随着时间的变化而变化的示图。示出以t1、t2和t3的次序的时间变化和这各个时间处的接合区域的变化的状态。

前方图像101的具有弯曲形状的条带区域随着时间的变化(t1->t2->t3)而顺序在左上方向上倾斜移动。同时,时间t4、时间t3和后续时间具有与时间t1的条带位置相同的条带位置。另外,分别以与t2和t3相同的方式来设置t5和t6,然后重复进行同样的条带移动。

在图20中示出的示例中,前方图像101和左侧图像102的显示区域在接合区域103内以弯曲条带为单元交替地设置。然而,显示区域随着时间的变化而顺序地改变。

在从时间t1至时间t4的一个显示时间段内,前方图像101的显示时间段和左侧图像102的显示时间段在整个接合区域103中交替地设置,观察者可在整个接合区域103中确认前方图像101和左侧图像102这二者。

因此,类似于设置矩形条带区域的上述实施例,同样,在这个示例中,解决了以上参照图9和图10描述的立体对象从合成图像中消失的问题。

即,同样在这个实施例中,由于整个接合区域103被设置成可在其中确认前方图像101和左侧图像102这二者的区域,因此可在未被切除的情况下确认立体对象的显示区域。

另外,同样在这个实施例中,接合区域用作随着时间的变化而改变的显示区域,因此用作吸引观察者注意的区域。即,相比于合成图像中的其它区域(静态区域),接合区域用作更吸引注意的区域,即,吸引注意的区域。通过设置这种吸引注意的区域,观察者(驾驶员)容易地确认接合区域中的立体对象。

同时,优选地提供以下配置:接合区域103中设置的前方图像101的弯曲条带的宽度和左侧图像102的弯曲条带的宽度(=前方图像101的弯曲条带之间的间隔)彼此不相等并且宽度中的任一个被设置成大于另一个。用这种配置,观察者可优先地且可视地确认接合区域103内的前方图像101和左侧图像102中的任一个图像(即,被设置成具有更大条带宽度的图像),从而更容易确认立体对象。

图21是示出实际显示根据该实施例的合成图像的示例的示图。图21示出接合区域的显示信息随着时间的变化而改变。扇形条带的位置逐渐移动。可在接合区域中观察到立体对象。

该图中示出的前方图像内的立体对象151是在前方图像显示区域中显示的立体对象。

左侧图像内的立体对象152是在左侧图像显示区域中显示的立体对象。

立体对象是在图9的上述过程中被切除的图像区域中所包括的物体(立体对象)。

这个过程示例被配置为,使得可在顶视图像的端部没有被切除的情况下、在顶视图像之间的接合区域中观察到待联合的两个顶视图像,因此能够观察到顶视图像中所包括的所有物体。

另外,在这个实施例中,能够执行强调在接合区域中显示的立体对象从而进一步将注意引导到在接合区域中显示的立体对象的过程。

图22示出在前方图像101和左侧图像102之间的接合区域103中显示立体对象的显示示例。

立体对象被显示为作为前方图像101的显示区域的条带区域中的前方图像内的立体对象151,并且被显示为作为左侧图像的显示区域的条带间区域中的左侧图像内的立体对象152。

强调立体对象的显示。具体地讲,通过闪烁显示或者通过改变颜色和亮度等,以醒目的显示模式执行强调。

同时,在检测前方图像101和左侧图像102中的每个中所包括的立体对象区域的过程中,能够如以上参照图18描述地计算前方图像101和左侧图像102的像素值之间的差异并且确定像素值之间的差异较大的区域是立体对象的显示区域。

具体地讲,能够应用用于以图像的预定单元区域的多个像素为单元执行计算的绝对差值和(SAD)。

通过立体对象的这种协作显示过程,能够更强烈地吸引作为观察者的驾驶员的注意。

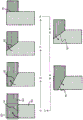

<5-2.接合区域的图像边界移动的实施例(第三实施例)>

接下来,作为第三实施例,将参照图23和后续附图描述接合区域的图像边界移动的实施例。

图23是示出在车辆的驾驶员座位处设置的显示单元上显示的合成图像的一部分的示图。即,图23是示出作为构成合成图像的图像的前方图像101和左侧图像102之间的接合区域103的附近的示图。

同时,图23中示出的前方图像101和左侧图像102二者都是在它们被执行顶视转换过程之后的图像。

即,前方图像101是通过对由安装在车辆前方的前方相机(等同于图1中示出的相机F)捕获的图像执行顶视转换而得到的图像。

左侧图像102是通过对由安装在车辆左侧的左侧相机(等同于图1中示出的相机L)捕获的图像执行顶视转换而得到的图像。

这个实施例被配置为,使得前方图像101和左侧图像102的显示区域被前方图像101和左侧图像102之间的接合区域103中的一个图像边界161分隔开。图像边界161随着时间的变化而移动。

以下,将参照图24描述图像边界161的移动过程的示例。

图24是示出设置在前方图像101和左侧图像102之间的接合区域103内的前方图像101和左侧图像102之间的图像边界161随着时间的变化而移动的示图。时间以t1、t2、t3和t4的次序变化,示出这各个时间处的接合区域内的图像边界161的位置的变化状态。

首先,图像边界161以接合区域103的左下端为中心顺时针旋转。

在时间t1,整个接合区域103被设置成前方图像101的显示区域。此后,从时间t1至时间t4,图像边界161顺时针旋转,接合区域103中的前方图像101的显示区域从其左下侧顺序地切换成左侧图像102的显示区域。

在时间t4,整个接合区域103被设置成左侧图像102的显示区域。此后,从时间t4至时间t7,图像边界161逆时针旋转,接合区域103中的左侧图像102的显示区域从其右上侧顺序地切换成前方图像101的显示区域。

类似于时间t1,在时间t7,整个接合区域103被设置成前方图像101的显示区域。

下文中,类似地,图像边界161重复相同的移动,即,其右旋转和左旋转。即,图像边界以与车辆的挡风玻璃刮水器相同的方式来回往复。

以这种方式,这个实施例的合成图像具有接合区域,该接合区域被设置成,使得以预定点为中心,边界位置重复其右旋转和左旋转。

同时,优选地,给出以下配置:其中右旋转的速度与左旋转的速度不同并且任一个方向上的旋转速度被设置成低于其它方向上的旋转速度。例如,以1至2或更大的比率将旋转速度设置成互不相同。

用这种配置,观察者可优先地观察缓慢旋转情况下的图像,因此容易确认此时的立体对象的整个图像。

在从时间t1至时间t7的一个显示时间段中,在整个接合区域103中设置前方图像101和左侧图像102的显示时段,观察者可在整个接合区域103中确认前方图像101和左侧图像102这二者。

因此,类似于其中设置矩形条带区域的上述实施例,同样,在这个实施例中,解决了以上参照图9和图10描述的立体对象从合成图像中消失的问题。

即,同样在这个实施例中,由于整个接合区域103被设置成可在其中确认前方图像101和左侧图像102这二者的区域,因此可在没有进行切除的情况下确认立体对象的显示区域。

图25是示出实际显示根据这个实施例的合成图像的示例的示图。图25示出接合区域的显示信息随着时间的变化而变化。图像边界161逐渐移动。可在接合区域中观察到立体对象。

该图中示出的左侧图像内的立体对象172是在左侧图像显示区域中显示的立体对象。前方图像内的立体对象171是在前方图像显示区域中显示的立体对象。

立体对象是在图9的上述过程中被切除的图像区域中所包括的物体(立体对象)。

这个过程示例被配置为,使得可在顶视图像的端部没有被切除的情况下在顶视图像之间的接合区域中观察待联合的两个顶视图像,因此能够观察到顶视图像中所包括的所有物体。

另外,同样在这个实施例中,接合区域用作随着时间的变化而变化的显示区域,因此用作吸引观察者注意的区域。即,相比于合成图像中的其它区域(静态区域),接合区域用作更吸引注意的区域,即,吸引注意的区域。通过设置这种吸引注意的区域,观察者(驾驶员)容易地确认接合区域中的立体对象。

另外,在这个实施例中,为了进一步将注意引导到在接合区域中显示的立体对象,能够执行强调在接合区域中显示的立体对象的过程。

图26示出在前方图像101和左侧图像102之间的接合区域103中显示立体对象的显示示例。

立体对象被显示为前方图像101的显示区域中的前方图像内的立体对象171,并且被显示为作为左侧图像的显示区域的条带间区域中的左侧图像内的立体对象172。

强调立体对象的显示。具体地讲,通过闪烁显示或者通过改变颜色和亮度等,以醒目的显示模式执行强调。

同时,在检测前方图像101和左侧图像102中的每个中所包括的立体对象区域的过程中,能够如以上参照图18描述地计算前方图像101和左侧图像102的像素值之间的差异并且确定像素值之间的差异较大的区域是立体对象的显示区域。

具体地讲,能够应用用于以图像的预定单元区域的多个像素为单元执行计算的绝对差值和(SAD)。

通过立体对象的这种协作显示过程,能够更强烈地吸引作为观察者的驾驶员的注意。

<6.关于当产生合成图像时使用的辅助信息>

所有上述实施例期望通过合成由安装在不同位置处的多个相机捕获的图像来产生一个合成图像的过程。

当产生合成图像时,需要精确地执行相机捕获的图像的定位。

为了进行定位,用特定图案辐射捕获图像的多个相机能够执行图像捕获的位置,然后相机执行图像捕获。能够使用由各个相机捕获的图像中所包括的辐射图案执行定位,来产生位置偏差小的合成图像。

将参照图27描述用于执行这个过程的特定配置示例。

图27中示出的激光校准参照图案辐射单元180用校准参考图案181辐射地面,校准参考图案181具有如该图中示出的特定图像图案。

用校准参考图案181对车辆10前方的相机F21和车辆10左侧的相机L22能够捕获图像的位置执行辐射。

如该图中所示,校准参考图案181具有诸如例如十字形和栅格形图案的特定图案。

同时,激光校准参照图案辐射单元180由例如固态激光光源和图案产生全息滤光器构成。

在由车辆10前方的相机F21和车辆10左侧的相机L22捕获的图像中捕获校准参考图案181。

当执行合成根据由相机F21捕获的图像产生的顶视图像和根据由相机L22捕获的图像产生的顶视图像的过程时,使用各个捕获图像中所包括的发射图案图像。

即,在产生具有接合区域的上述实施例中描述的合成图像时,执行定位,以便将两个图像的辐射图案设置在合成图像上的同一位置处。因此,能够容易地产生具有小位置偏差的合成图像。

同时,例如,图27中示出的激光校准参照图案辐射单元180可被配置为按照相机捕获图像的图像捕获帧的图像捕获定时用校准参考图案来执行辐射,而非连续地执行激光辐射。多个相机与校准参考图案的辐射时序关联地执行图像捕获。图像处理单元根据多个连续捕获图像帧之间的差异来检测校准参考图案,并且执行将用校准参考图案辐射的区域应用于产生合成图像时的图像定位的图像合成过程。

另外,图像处理设备可被配置为以固定间隔或者在产生图像时执行校准,作为向其应用包括校准参考图案的捕获图像的相机调节过程。

<7.关于图像处理设备的硬件配置的示例>

接下来,将描述根据上述实施例的执行图像显示过程的图像处理设备的硬件配置的示例。

图28是示出包括图像处理单元201和多个相机的图像处理设备的整体的配置示例的示图,该图像处理单元201根据上述实施例执行图像显示过程,这多个相机捕获待处理的图像。

相机F 202F等同于设置在车辆10前方的图1中示出的相机F21。

相机L 202L等同于设置在车辆10左侧的图1中示出的相机L22。

相机R 202R等同于设置在车辆10右侧的图1中示出的相机R23。

相机B 202B等同于设置在车辆10后方的图1中示出的相机B24。

相机中的每个(即,包括广角镜头(诸如例如鱼眼镜头)的相机)以预定的帧速率执行影片捕获并且将捕获的影片输出到图像处理单元201。

图像处理单元201将由相机F 202F捕获的图像输入相机B202B,产生将在显示单元205上显示的合成图像,并且输出产生的合成图像。产生的合成图像是以上面安装有例如相机F 202F至相机B 202B的车辆为中心从上方观察到的顶视图像。

图像处理单元201通过对由相机F 202F至相机B 202B捕获的各个图像执行顶视转换来产生四个顶视图像,并且产生具有上述实施例的任一个图案的接合区域的合成图像并且将产生的图像输出到显示单元205。

用户使用输入单元203来输入各条设置信息。具体地讲,使用输入单元进行各种输入,诸如,例如,在显示单元205上显示的图像的切换和显示模式的设置。

图像处理单元201按照从输入单元203输入的信息,执行对显示单元205上的显示信息的切换和控制。

车辆状态信息获取单元204获取关于车辆状态的信息,具体地讲,诸如例如车辆的方向、角度、倾斜度和高度的信息。车辆主体在例如斜坡上倾斜,各个相机的图像捕获方向也根据车辆主体的倾斜度被设置成不同于垂直方向的方向。这种信息应用于校正由相机捕获的图像,因此被输入图像处理单元201。

激光校准参考图案辐射单元211执行以上参照图27描述的激光辐射。

控制单元210控制相对于各组件的过程的执行,并且控制组件之间的数据输入和输出。

同时,控制单元210包括具有执行程序功能的处理器,并且控制单元210按照存储在图中未示出的存储器中的程序来控制过程。

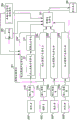

接下来,将参照图29详细描述图像处理单元201的配置和由图像处理单元执行的过程。

如图29中所示,由安装在车辆的四个不同位置处的相机捕获的四个图像被输入到图像处理单元201。即,输入输入图像F210F、输入图像L 210L、输入图像R 210R和输入图像B210B,输入图像F210F是由设置在车辆前方的相机F 202F捕获的图像,输入图像L210L是由设置在车辆左侧的相机L 202L捕获的图像,输入图像R210R是由设置在车辆右侧的相机R202R捕获的图像,输入图像B210B是由设置在车辆后方的相机B 202B捕获的图像。

同时,图像是使用诸如鱼眼镜头的广角镜头捕获的影片。

图像处理单元201包括校正各个输入图像并且产生对应于各个图像的顶视图像的校正图像产生单元F 220F至校正图像产生单元B220B。

校正图像产生单元F 220F至校正图像产生单元B 220B具有相同的配置和过程。在该图中,示出针对作为由安装在车辆前方的相机F202F捕获的图像的输入图像F 210F执行过程的校正图像产生单元F220F的配置,并且省略其它校正图像产生单元L 220L至B 220B的内部配置。

以下,将代表性地描述校正图像产生单元F 220F的配置和过程。校正图像产生单元F 220F针对作为由安装在车辆前方的相机F202F捕获的图像的输入图像F 210F执行过程。

校正参数计算单元221计算为了根据作为由包括广角镜头的相机捕获的图像的输入图像F 210F产生顶视图像而应用的参数。

同时,参数包括相机内部参数和相机外部参数。

相机内部参数是指诸如相机镜头的焦距、镜头的失真特征和镜头安装的位置误差的特定信息,该信息是独立于车辆状态来确定的。

相机外部参数是指能够呈现出安装位置和相机方向的波动、车辆高度相对于道路表面的波动、取决于驾驶情形的波动的特定信息。

为了根据使用广角镜头捕获的图像、使用地面作为参考平面来执行顶视转换,需要校正通过使用相机捕获车辆附近而得到的图像的失真以及执行产生从作为假定视点的车辆上方观察到的图像的图像校正过程。

校正参数计算单元221计算校正图像所需的参数。

图像校正单元222通过执行向其应用由校正参数计算单元221计算出的参数的图像校正过程来产生顶视图像。同时,由图像校正单元222执行的图像校正构成包括去除输入图像F 210F中所包括的失真的失真校正过程、作为放大和缩小图像的过程的缩放过程、由视点校正伴随的顶视转换过程,该视点校正执行到从作为假定视点的车辆上方观察到的图像的转换。

同时,从输入单元203输入的信息和从车辆状态信息获取单元204输入的车辆状态信息被输入到校正参数计算单元221和图像校正单元222。另外,在需要时,执行向其应用这些条输入信息的参数计算和图像校正。

校正图像产生单元F 220F的图像校正单元222将产生的顶视图像(即,基于作为由车辆前方的相机F 202F捕获的图像的输入图像F 210F而产生的车辆的前方区域的顶视图像)输出到图像合成单元251。

另外,校正图像产生单元L 220L基于作为由车辆左侧的相机L202L捕获的图像的输入图像L 210L产生车辆左侧区域的顶视图像,并且将产生的图像输出到图像合成单元251。

另外,校正图像产生单元R 220R基于作为由车辆右侧的相机R202R捕获的图像的输入图像R 210R产生车辆右侧区域的顶视图像,并且将产生的图像输出到图像合成单元251。

另外,校正图像产生单元B 220B基于作为由车辆后方的相机B202B捕获的图像的输入图像B 210B产生车辆后方区域的顶视图像,并且将产生的图像输出到图像合成单元251。

图像合成单元251输入这四个顶视图像,以产生将在显示单元205上显示的合成图像,并且将产生的图像输出到显示单元205。

如以上在实施例中描述的,图像合成单元251产生如下的合成图像,该合成图像被配置为使得顶视图像之间的接合区域具有其中待显示图像随着时间的变化而改变并且移动的边界区域,并且图像合成单元251将产生的图像输出到显示单元205。

具体地讲,例如,图像合成单元产生以下的合成图像中的具有接合区域的任一个合成图像:即,

(a)具有以上参照图12等描述的矩形条带区域并且具有被配置为使得矩形条带区域随着时间的变化而移动的接合区域的合成图像,

(b)具有以上参照图20等描述的弯曲条带区域并且具有被配置为使得弯曲条带区域随着时间的变化而移动的接合区域的合成图像,以及

(c)具有被配置为使得以上参照图24等描述的图像的边界区域随着时间的变化交替地重复进行右旋转和左旋转的接合区域的合成图像。

同时,当图像合成单元251产生合成图像时,从各图像中检测以上参照图27描述的激光辐射图案,以执行向其应用检测到的激光辐射图案的定位过程。能够通过执行该过程来以高准确度执行图像定位。

同时,图像合成单元251可被配置为对在合成图像中的接合区域内显示的立体对象的图像执行强调,使得图像容易吸引到观察者的注意。这个过程是以上参照图13、图18和图25描述的过程。

如上所述,待联合图像的对应像素的位置的像素值之间的差异(例如,用于以图像的预定单元区域的多个像素为单元执行计算的绝对差值和(SAD))可应用于检测立体对象。

显示单元205显示由图像合成单元251产生的合成图像。

显示单元205上显示的合成图像等同于以下合成图像中的具有接合区域的任一个合成图像:即,

(a)具有以上参照图12等描述的矩形条带区域并且具有被配置为使得矩形条带区域随着时间的变化而移动的接合区域的合成图像,

(b)具有以上参照图20等描述的弯曲条带区域并且具有被配置为使得弯曲条带区域随着时间的变化而移动的接合区域的合成图像,以及

(c)具有被配置为使得以上参照图24等描述的图像的边界区域随着时间的变化交替地重复进行右旋转和左旋转的接合区域的合成图像。

在显示单元205上显示上述的合成图像(a)至(c)的具有接合区域的任一个合成图像。

根据显示过程,能够可靠地显示存在于接合区域中的立体对象,而不造成立体对象消失。因此,能够致使观察者(驾驶员)识别到立体对象的存在,并且促使观察者更安全地驾驶。

<8.本公开的配置的结论>

到目前为止,参照特定实施例给出了对本公开的实施例的详细描述。然而,显而易见,本领域的技术人员可在不脱离本公开的范围的情况下对实施例进行修改和更换。即,本公开在本文中的描述只是出于例证目的,不应该进行排他性理解。为了确定本公开的范围,应该考虑随附权利要求书。

同时,本说明书中公开的技术可采用以下配置。

(1)一种图像处理设备,所述图像处理设备包括:电路,其被配置为从与汽车相邻的区域的第一图像捕获装置接收第一图像数据;从与所述汽车相邻的区域的至少一部分的第二图像捕获装置接收第二图像数据;将所述第一图像数据与所述第二图像数据进行组合,以形成与所述汽车相邻的区域的至少一部分的接合区域的复合图像数据;随时间推移,改变从所述第一图像捕获装置和所述第二图像捕获装置取得的各个图像区域,以形成所述接合区域的所述复合图像数据。

(2)根据(1)所述的图像处理设备,其中,来自所述第一图像捕获装置的所述第一图像数据是得自相对于所述汽车的第一视角,来自所述第二图像捕获装置的所述第二图像数据是得自相对于所述汽车的第二视角,并且所述接合区域的所述复合图像数据提供所述汽车的顶视图的至少一部分。

(3)根据(1)所述的图像处理设备,其中,所述接合区域处于所述第一图像捕获装置和所述第二图像捕获装置的各个视场边缘处。

(4)根据(1)所述的图像处理设备,其中,所述电路被配置为从所述第一图像捕获装置取得具有多个条带的条带形状的图像区域,并且所述电路被配置为随时间推移改变所述多个条带中的至少一个的位置。

(5)根据(4)所述的图像处理设备,其中,所述电路将所述第一图像数据与所述第二图像数据进行组合,以形成包括当位于所述接合区域中时能观察到的立体对象的合成图像。

(6)根据(4)所述的图像处理设备,其中,所述第二图像数据的图像包括与所述第一图像数据的多个条带交错的条带。

(7)根据(6)所述的图像处理设备,其中,所述电路被配置为通过将所述第一图像中的预定数量的行识别为具有预定宽度的第一条带并且附上具有其它预定宽度的所述第二图像中的其它预定数量的行来形成所述复合图像的一部分。

(8)根据(7)所述的图像处理设备,其中,所述电路被配置为通过在其它图像帧中将所述第一图像和所述第二图像的行移位,随时间推移改变所述条带中的至少一个的位置。

(9)根据(7)所述的图像处理设备,其中,所述电路被配置为随着条带宽度指定值Ws、条带间隔指定值Wf、和/或条带数量指定值ZN的变化,随时间推移调节所述条带中的至少一个的位置。

(10)根据(4)所述的图像处理设备,其中,所述电路被配置为改变条带形状的图案。

(11)根据(5)所述的图像处理设备,其中,所述电路被配置为在用在连续帧中变化的颜色、变化的亮度和闪烁地明灭中的至少一者强调所述立体对象的情况下形成所述合成图像。

(12)根据(4)所述的图像处理设备,其中,所述条带形状中的多个条带在所述接合区域中被布置成矩形。

(13)根据(4)所述的图像处理设备,其中,所述条带形状中的多个条带在所述接合区域中被布置成弯曲状。

(14)根据(4)所述的图像处理设备,其中,所述条带形状中的多个条带在所述接合区域中被布置成扇形。

(15)根据(3)所述的图像处理设备,其中,所述电路被配置为随着时间的变化,改变所述第一图像捕获装置和所述第二图像捕获装置的各个视场边缘。

(16)一种汽车图像处理系统,所述汽车图像处理系统包括:第一图像捕获装置,其被安装到所述汽车的前方并且被配置为获取具有相对于所述汽车中的驾驶员座位向前看的视角的第一图像数据;第二图像捕获装置,其被安装到所述汽车的侧面并且被配置为获取具有相对于所述汽车中的驾驶员座位向侧面看的视角的第二图像数据;以及电路,其被配置为接收所述第一图像数据,接收所述第二图像数据,将所述第一图像数据与所述第二图像数据进行组合,以形成所述第一图像数据和所述第二图像数据之间的接合区域的复合图像数据,并且随时间推移改变从所述第一图像捕获装置和所述第二图像捕获装置取得的各个图像区域,以形成所述接合区域的所述复合图像数据,其中,所述接合区域的所述复合图像数据提供所述汽车的顶视图的至少一部分。

(17)根据(16)所述的图像处理设备,还包括激光校准参考图案辐射发生器,其被安装到所述汽车并且被配置为在所述接合区域中产生校准参考图案,其中,

所述电路被配置为:通过检测所述校准参考图案并且进行图像处理调节直至所述复合图像数据在由所述激光校准参考图案辐射发生器产生的所述校准参考图案的预定容差内产生所述校准参考图案的副本为止,来进行自校准。

(18)一种车辆监视系统,所述车辆监视系统包括:第一图像捕获装置,其被安装到所述汽车的前方并且被配置为获取具有相对于所述汽车中的驾驶员座位向前看的视角的第一图像数据;第二图像捕获装置,其被安装到所述汽车的侧面并且被配置为获取具有相对于所述汽车中的驾驶员座位向侧面看的视角的第二图像数据;电路,其被配置为接收所述第一图像数据,接收所述第二图像数据,将所述第一图像数据与所述第二图像数据进行组合,以形成所述第一图像数据和所述第二图像数据之间的接合区域的复合图像数据,并且随时间推移改变从所述第一图像捕获装置和所述第二图像捕获装置取得的各个图像区域,以形成所述接合区域的所述复合图像数据,其中,所述接合区域的所述复合图像数据提供所述汽车的顶视图的至少一部分;以及显示器,其被安装到所述汽车的内部并且被配置为显示包括所述接合区域的所述汽车的顶视图。

(19)根据(18)所述的车辆监视系统,其中,所述电路还被配置为包括在所述显示器上显示的所述顶视图中的所述汽车顶部的模拟图像。

(20)根据(18)所述的车辆监视系统,其中,所述电路被配置为在所述顶视图中包括由所述第一图像捕获装置和所述第二图像捕获装置在所述接合区域中捕获的立体对象的图像。

(A01)一种图像处理设备,所述图像处理设备包括:

图像处理单元,其通过分别校正由设置在不同位置处的多个相机捕获的图像来产生多个顶视图像,并且通过将产生的所述多个顶视图像彼此联合来产生合成图像,

其中,所述图像处理单元产生具有被设置成使得待联合的所述多个顶视图像的显示区域随着时间的变化而改变的接合区域的合成图像。

(A02)根据上述(A01)所述的图像处理设备,其中,所述图像处理单元将彼此待联合的第一图像和第二图像交替地设置成条带形状,并且产生具有被设置成使得条带位置随着时间的变化而改变的接合区域的合成图像。

(A03)根据上述(A02)所述的图像处理设备,其中,所述图像处理单元将彼此待联合的第一图像和第二图像交替地设置成矩形或弯曲条带形状。

(A04)根据(A02)或(A03)所述的图像处理设备,其中,所述图像处理单元将彼此待联合的第一图像和第二图像的条带宽度设置成不同宽度。

(A05)根据上述(A01)至(A04)中的任一项所述的图像处理设备,其中,所述图像处理单元产生具有被设置成使得彼此待联合的所述第一图像和所述第二图像之间的边界位置的随着时间变化而改变的接合区域的合成图像。

(A06)根据上述(A05)所述的图像处理设备,其中,所述图像处理单元产生具有被设置成使得以预定点为中心重复进行彼此待联合的所述第一图像和所述第二图像之间的边界位置的右旋转和左旋转的接合区域的合成图像。

(A07)根据上述(A06)所述的图像处理设备,其中,所述图像处理单元产生具有被设置成使得所述边界位置的左旋转和右旋转具有不同速度的接合区域的合成图像。

(A08)根据上述(A01)至(A07)中的任一项所述的图像处理设备,其中,当在所述接合区域的显示信息中包括立体对象时,所述图像处理单元产生所述立体对象被部分或全部强调的合成图像。

(A09)根据上述(A08)所述的图像处理设备,其中,所述强调是闪烁显示或者改变和显示亮度和颜色中的至少一个的过程。

(A10)根据上述(A09)所述的图像处理设备,其中,所述图像处理单元通过以所述接合区域中的彼此待联合的多个图像的预定区域为单元应用绝对差值和(SAD)来检测立体对象。

(A11)根据上述(A01)至(A10)中的任一项所述的图像处理设备,其中,所述图像处理设备包括校准参考图案辐射单元,所述校准参考图案辐射单元用具有特定图案的标准参考图案辐射所述相机的图像捕获区域,其中,所述多个相机产生包括校准参考图案辐射区域的捕获图像,其中,所述图像处理单元执行图像合成过程,在所述图像合成过程中,在产生合成图像时将校准参考图案辐射区域应用于图像定位。

(A12)根据上述(A11)所述的图像处理设备,其中,所述图像处理单元的所述校准参考图案辐射单元由固态激光光源和产生图案的全息滤波器构成。

(A13)根据上述(A01)至(A12)中的任一项所述的图像处理设备,其中,所述图像处理设备包括校准参考图案辐射单元,所述校准参考图案辐射单元按照由相机捕获的帧的图像捕获定时用校准参考图案辐射图像捕获区域,其中,所述多个相机与所述校准参考图案的辐射定时关联地捕获图像,其中,所述图像处理单元根据多个连续捕获图像帧之间的差异来检测所述校准参考图案,并且执行图像合成过程,在所述图像合成过程中,在产生合成图像时将所述校准参考图案辐射区域应用于图像定位。

(A14)根据上述(A01)至(A13)中的任一项所述的图像处理设备,其中,所述图像处理设备以固定间隔或者在产生所述合成图像时执行校准,作为应用包括所述校准参考图案的捕获图像的相机调节过程。

(A15)根据上述(A01)至(A14)中的任一项所述的图像处理设备,其中,所述相机设置在车辆的前方、后方、右侧和左侧,其中,所述图像处理单元产生顶视图像作为所述合成图像,在所述顶视图像中,从所述车辆上方观察所述车辆的周围区域。

(A16)根据上述(A15)所述的图像处理设备,其中,所述相机包括广角镜头。

(A17)一种在图像处理设备中执行的图像处理方法,所述方法包括:

通过分别校正由设置在不同位置处的多个相机捕获的图像来产生多个顶视图像,以及

通过将产生的所述多个顶视图像彼此联合来产生合成图像,

其中,在产生所述合成图像的过程中,所述图像处理单元产生具有接合区域的合成图像,所述接合区域被设置成使得待联合的所述多个顶视图像的显示区域随着时间的变化而改变。

(A18)一种使得图像处理设备执行图像处理的程序,所述处理包括:

使得图像处理单元通过分别校正由设置在不同位置处的多个相机捕获的图像来产生多个顶视图像,以及

通过将产生的所述多个顶视图像彼此联合来产生合成图像;以及

使得在产生所述合成图像的过程中产生具有接合区域的合成图像,所述接合区域被设置成使得待联合的所述多个顶视图像的显示区域随着时间的变化而改变。

另外,本文中描述的这一系列处理可由硬件、软件、或这二者的组合配置来执行。当由软件执行处理时,其中记录了处理序列的程序可被安装在嵌入专用硬件中的计算机内的存储器中并且被执行,或者程序可被安装在可执行各条处理和执行的通用计算机中。例如,程序可被预先记录在记录介质中。程序可不仅被从记录介质安装到计算机,而且还可经由诸如局域网(LAN)或互联网的网络来接收并且安装在诸如内置硬盘的记录介质中。

同时,本文中描述的各条处理可以以说明书中的次序按时序顺序执行或者可根据执行处理的装置的处理能力或者根据必需性以并行或单独的方式执行。另外,本说明书中使用的术语“系统”是多个装置的逻辑复杂配置,具有各种配置的装置不一定设置在同一外壳中。

本领域的技术人员应该理解,可根据设计要求和其它因素想到各种修改、组合、子组合和替代,只要它们在随附权利要求书或其等同物的范围内即可。

[工业可应用性]

如上所述,根据本公开的实施例,能够产生图像,能够产生并且显示从车辆上方观察到的图像,该图像使得容易地识别立体对象。

具体地讲,通过分别校正由设置在车辆的不同位置(诸如前方、后方、右侧和左侧)处的多个相机捕获的图像,产生多个顶视图像,并且通过将产生的多个顶视图像彼此联合,产生合成图像。图像处理单元产生具有接合区域的合成图像,该接合区域被设置成使得待联合的多个顶视图像的显示区域随时间变化而改变。例如,待联合的第一图像和第二图像交替设置成条带形状,并且产生具有被设置成使得条带的位置随着时间的变化而改变的接合区域的合成图像。

使用这种配置,当在相邻图像合成范围中存在立体对象时,具有动态主体的边界部分的图像被显示为待显示图像。结果,能够产生并且显示从车辆上方观察到的图像,该图像使得容易通过刺激人类动态主体感觉神经来识别立体对象。

[附图标记列表]

10 车辆

21至24 相机

30 广角相机

31 物体

32 立体对象

70 合成图像

101 前方图像

102 左侧图像

103 接合区域

111 前方图像内的立体对象

112 左侧图像内的立体对象

161 图像边界

171 前方图像内的立体对象

172 左侧图像内的立体对象

180 激光校准参考图案辐射单元

181 校准参考图案

201 图像处理单元

202 相机

203 输入单元

204 车辆状态信息获取单元

205 显示单元

210 控制单元

211 激光校准参考图案辐射单元

210 输入图像

220 校正图像产生单元

221 校正参数计算单元

222 图像校正单元

251 图像合成单元

Claims (19)

1.一种图像处理设备,所述图像处理设备包括:

处理器和存储器,所述存储器存储有指令,当所述指令被所述处理器执行时,所述指令使得所述处理器:

从与汽车相邻的第一区域的第一图像捕获装置接收第一图像数据;

从与所述汽车相邻的第二区域的第二图像捕获装置接收第二图像数据;

将所述第一图像数据与所述第二图像数据进行组合,以形成由第一区域与第二区域接合形成的接合区域的复合图像数据;

随时间推移,动态改变待合成图像的所述接合区域中的图像显示区域,以形成所述接合区域的所述复合图像数据,

其中,所述指令还使所述处理器从所述第一图像捕获装置取得具有多个条带的条带形状的图像区域,并且随时间推移改变所述多个条带中的至少一个的位置。

2.根据权利要求1所述的图像处理设备,其中,

来自所述第一图像捕获装置的所述第一图像数据得自相对于所述汽车的第一视角,

来自所述第二图像捕获装置的所述第二图像数据得自相对于所述汽车的第二视角,以及

所述接合区域的所述复合图像数据提供所述汽车的顶视图的至少一部分。

3.根据权利要求1所述的图像处理设备,其中,所述接合区域处于所述第一图像捕获装置和所述第二图像捕获装置的各个视场边缘处。

4.根据权利要求1所述的图像处理设备,其中,所述指令使得所述处理器将所述第一图像数据与所述第二图像数据进行组合,以形成包括当位于所述接合区域中时能观察到的立体对象的合成图像。

5.根据权利要求1所述的图像处理设备,其中,所述第二图像数据的图像包括与所述第一图像数据的所述多个条带交错的条带。

6.根据权利要求5所述的图像处理设备,其中,所述指令使得所述处理器通过将所述第一图像中的预定数量的行识别为具有预定宽度的第一条带来形成所述复合图像数据的一部分,以及附上所述第二图像中的具有另外的预定宽度的另外的预定数量的行。

7.根据权利要求6所述的图像处理设备,其中,所述指令使得所述处理器:通过在另外的图像帧中将所述第一图像和所述第二图像的行移位,随时间推移改变所述多个条带中的至少一个的位置。

8.根据权利要求6所述的图像处理设备,其中,所述指令使得所述处理器:根据条带宽度指定值Ws、条带间隔指定值Wf、和/或条带数量指定值ZN,随时间推移调节所述多个条带中的所述至少一个的位置。

9.根据权利要求1所述的图像处理设备,其中,所述指令使得所述处理器改变条带形状的图案。

10.根据权利要求4所述的图像处理设备,其中,所述指令使得所述处理器:在由连续帧中变化的颜色、变化的亮度和闪烁地明灭中的至少一者来强调所述立体对象的情况下,形成所述合成图像。

11.根据权利要求1所述的图像处理设备,其中,所述条带形状中的所述多个条带在所述接合区域中被布置成矩形。

12.根据权利要求1所述的图像处理设备,其中,所述条带形状中的所述多个条带在所述接合区域中被布置成弯曲状。

13.根据权利要求1所述的图像处理设备,其中,所述条带形状中的所述多个条带在所述接合区域中被布置成扇形。

14.根据权利要求3所述的图像处理设备,其中,所述指令使得所述处理器根据时间,改变所述第一图像捕获装置和所述第二图像捕获装置的各个视场边缘。

15.一种汽车图像处理系统,所述汽车图像处理系统包括:

第一图像捕获装置,其被安装到汽车的前方并且被配置为捕获具有相对于所述汽车中的驾驶员座位向前看的视角的第一图像数据;

第二图像捕获装置,其被安装到所述汽车的侧面并且被配置为捕获具有相对于所述汽车中的驾驶员座位向侧面看的视角的第二图像数据;以及

电路,其被配置为

接收所述第一图像数据,

接收所述第二图像数据,

将所述第一图像数据与所述第二图像数据进行组合,以形成所述第一图像数据和所述第二图像数据之间的接合区域的复合图像数据,以及

随时间推移,动态改变待合成图像的所述接合区域中的图像显示区域,以形成所述接合区域的所述复合图像数据,其中,

所述接合区域的所述复合图像数据提供所述汽车的顶视图的至少一部分,并且

其中,所述电路还被配置为从所述第一图像捕获装置取得具有多个条带的条带形状的图像区域,并且随时间推移改变所述多个条带中的至少一个的位置。

16.根据权利要求15所述的汽车图像处理系统,还包括:

激光校准参考图案辐射发生器,其被安装到所述汽车并且被配置为在所述接合区域中产生校准参考图案,其中,

所述电路被配置为通过以下来进行自校准:通过检测所述校准参考图案以及进行图像处理调节,直至所述复合图像数据在由所述激光校准参考图案辐射发生器产生的所述校准参考图案的预定容差内产生所述校准参考图案的副本为止。

17.一种车辆监视系统,所述车辆监视系统包括:

第一图像捕获装置,其被安装到汽车的前方并且被配置为获取具有相对于所述汽车中的驾驶员座位向前看的视角的第一图像数据;

第二图像捕获装置,其被安装到所述汽车的侧面并且被配置为获取具有相对于所述汽车中的驾驶员座位向侧面看的视角的第二图像数据;

电路,其被配置为

接收所述第一图像数据,

接收所述第二图像数据,

将所述第一图像数据与所述第二图像数据进行组合,以形成所述第一图像数据和所述第二图像数据之间的接合区域的复合图像数据,以及

随时间推移,动态改变待合成图像的所述接合区域中的图像显示区域,以形成所述接合区域的所述复合图像数据,其中,所述接合区域的所述复合图像数据提供所述汽车的顶视图的至少一部分,并且其中,所述电路还被配置为从所述第一图像捕获装置取得具有多个条带的条带形状的图像区域,并且随时间推移改变所述多个条带中的至少一个的位置;以及

显示器,其被安装到所述汽车的内部并且被配置为显示所述汽车的包括所述接合区域的顶视图。

18.根据权利要求17所述的车辆监视系统,其中,所述电路还被配置为包括在所述显示器上显示的所述顶视图中的所述汽车的顶部的模拟图像。

19.根据权利要求17所述的车辆监视系统,其中,所述电路被配置为在所述顶视图中包括由所述第一图像捕获装置和所述第二图像捕获装置在所述接合区域中捕获的立体对象的图像。

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2013259593A JP6232994B2 (ja) | 2013-12-16 | 2013-12-16 | 画像処理装置、および画像処理方法、並びにプログラム |

| JP2013-259593 | 2013-12-16 | ||

| PCT/JP2014/005932 WO2015092981A1 (en) | 2013-12-16 | 2014-11-27 | Image processing apparatus, image processing method, and program |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| CN105814886A CN105814886A (zh) | 2016-07-27 |

| CN105814886B true CN105814886B (zh) | 2020-09-15 |

Family

ID=52101553

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| CN201480067077.9A Expired - Fee Related CN105814886B (zh) | 2013-12-16 | 2014-11-27 | 图像处理设备、图像处理方法和程序 |

Country Status (7)

| Country | Link |

|---|---|

| US (1) | US10140775B2 (zh) |

| EP (1) | EP3039644B1 (zh) |

| JP (1) | JP6232994B2 (zh) |

| CN (1) | CN105814886B (zh) |

| BR (1) | BR112016013307A2 (zh) |

| RU (1) | RU2679987C2 (zh) |

| WO (1) | WO2015092981A1 (zh) |

Families Citing this family (25)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US9902341B2 (en) * | 2014-02-26 | 2018-02-27 | Kyocera Corporation | Image processing apparatus and image processing method including area setting and perspective conversion |

| US10891736B1 (en) * | 2015-06-23 | 2021-01-12 | Amazon Technologies, Inc. | Associating an agent with an event using motion analysis |

| JP6413974B2 (ja) * | 2015-08-05 | 2018-10-31 | 株式会社デンソー | キャリブレーション装置、キャリブレーション方法、及びプログラム |

| US10157452B1 (en) * | 2015-09-28 | 2018-12-18 | Amazon Technologies, Inc. | Image processing system for image rectification |

| JP6493143B2 (ja) * | 2015-10-15 | 2019-04-03 | 株式会社デンソー | 表示制御装置及び表示制御プログラム |

| JP6512449B2 (ja) * | 2016-01-20 | 2019-05-15 | パナソニックIpマネジメント株式会社 | 表示装置 |

| KR102371588B1 (ko) * | 2016-05-02 | 2022-03-07 | 현대자동차주식회사 | 영상기반 장애물 인식 시스템 및 방법 |

| US10636110B2 (en) * | 2016-06-28 | 2020-04-28 | Intel Corporation | Architecture for interleaved rasterization and pixel shading for virtual reality and multi-view systems |

| KR101844885B1 (ko) * | 2016-07-11 | 2018-05-18 | 엘지전자 주식회사 | 차량 운전 보조장치 및 이를 포함하는 차량 |

| WO2018037789A1 (ja) | 2016-08-22 | 2018-03-01 | ソニー株式会社 | 画像処理装置、および画像処理方法、並びにプログラム |

| JP2018085008A (ja) | 2016-11-25 | 2018-05-31 | 株式会社ジャパンディスプレイ | 画像処理装置および画像処理装置の画像処理方法 |

| KR102433824B1 (ko) * | 2017-01-12 | 2022-08-17 | 현대모비스 주식회사 | Avm 자동 공차 보정 시스템 및 그 방법 |

| KR102466305B1 (ko) * | 2017-01-12 | 2022-11-10 | 현대모비스 주식회사 | Avm 자동 공차 보정 시스템 및 그 방법 |

| DE102017214545A1 (de) * | 2017-08-21 | 2019-02-21 | Bayerische Motoren Werke Aktiengesellschaft | Verfahren und Vorrichtung zur Ermittlung einer Wahrscheinlichkeit, mit der sich ein Objekt in einem Sichtfeld eines Fahrers eines Fahrzeugs befindet |

| JPWO2019049709A1 (ja) * | 2017-09-07 | 2020-12-03 | ソニー株式会社 | 画像処理装置、画像処理方法、および画像表示システム |

| JP6897442B2 (ja) * | 2017-09-12 | 2021-06-30 | 株式会社Jvcケンウッド | 車両用装置、キャリブレーション結果判定システム、および、キャリブレーション結果判定方法、ならびに、プログラム |

| JP7013751B2 (ja) * | 2017-09-15 | 2022-02-01 | 株式会社アイシン | 画像処理装置 |

| DE102017216822A1 (de) * | 2017-09-22 | 2019-03-28 | Continental Automotive Gmbh | Vorrichtung und Verfahren zum Anpassen einer Bildverarbeitung basierend auf einer Form einer Anzeigeneinrichtung für ein Kraftfahrzeug |

| JP6472864B1 (ja) * | 2017-11-29 | 2019-02-20 | 株式会社近江デジタルファブリケーションズ | 画像配信システム、及び配信画像生成方法 |

| US20210243367A1 (en) * | 2018-04-26 | 2021-08-05 | Tenntwo Co., Ltd. | Wide-angle image providing system |

| US11024012B2 (en) | 2018-08-02 | 2021-06-01 | Apple Inc. | Directional scaling systems and methods |

| CN108995592B (zh) * | 2018-08-02 | 2021-06-15 | 张士文 | 汽车影像系统 |

| CN113170084A (zh) * | 2018-12-11 | 2021-07-23 | 索尼集团公司 | 图像处理装置、图像处理方法和图像处理系统 |

| DE102019205440A1 (de) * | 2019-04-16 | 2020-10-22 | Zf Friedrichshafen Ag | Lern-Verfahren zur winkelunabhängigen Objekterkennung für bewegliche und orts-feste Systeme |

| JP7225079B2 (ja) | 2019-11-29 | 2023-02-20 | 日立Astemo株式会社 | 障害物認識装置 |

Citations (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2001083921A (ja) * | 1999-09-16 | 2001-03-30 | Dainippon Printing Co Ltd | モニタのコントラスト調整方法 |

| CN103338325A (zh) * | 2013-06-14 | 2013-10-02 | 杭州普维光电技术有限公司 | 基于全景摄像机的车底盘图像采集方法 |

Family Cites Families (18)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2003030833A (ja) | 2001-07-13 | 2003-01-31 | Matsushita Electric Ind Co Ltd | 光記録媒体、光記録媒体の記録方法及び光記録媒体の記録装置 |

| ATE311725T1 (de) | 2001-09-07 | 2005-12-15 | Matsushita Electric Ind Co Ltd | Vorrichtung zum anzeigen der umgebung eines fahrzeuges und system zur bildbereitstellung |

| JP4744823B2 (ja) * | 2004-08-05 | 2011-08-10 | 株式会社東芝 | 周辺監視装置および俯瞰画像表示方法 |

| JP4639753B2 (ja) * | 2004-10-25 | 2011-02-23 | 日産自動車株式会社 | 運転支援装置 |

| EP1807732B1 (en) * | 2004-10-25 | 2008-10-01 | Koninklijke Philips Electronics N.V. | Display device |

| US7512262B2 (en) * | 2005-02-25 | 2009-03-31 | Microsoft Corporation | Stereo-based image processing |

| JP4934308B2 (ja) | 2005-10-17 | 2012-05-16 | 三洋電機株式会社 | 運転支援システム |

| JP4861034B2 (ja) * | 2006-03-29 | 2012-01-25 | クラリオン株式会社 | 車載カメラのキャリブレーションシステム |

| US8243994B2 (en) * | 2006-05-09 | 2012-08-14 | Nissan Motor Co., Ltd. | Vehicle circumferential image providing device and vehicle circumferential image providing method |

| JP2009077022A (ja) * | 2007-09-19 | 2009-04-09 | Sanyo Electric Co Ltd | 運転支援システム及び車両 |

| JP5068779B2 (ja) * | 2009-02-27 | 2012-11-07 | 現代自動車株式会社 | 車両周囲俯瞰画像表示装置及び方法 |

| JP5165631B2 (ja) * | 2009-04-14 | 2013-03-21 | 現代自動車株式会社 | 車両周囲画像表示システム |

| JP2012147149A (ja) * | 2011-01-11 | 2012-08-02 | Aisin Seiki Co Ltd | 画像生成装置 |

| TWM407861U (en) * | 2011-03-17 | 2011-07-21 | Acard Technology Corp | Panorama motor vehicle auxiliary recorder |

| JP5483120B2 (ja) * | 2011-07-26 | 2014-05-07 | アイシン精機株式会社 | 車両周辺監視システム |

| JP5870608B2 (ja) * | 2011-10-13 | 2016-03-01 | アイシン精機株式会社 | 画像生成装置 |

| WO2013074604A2 (en) * | 2011-11-15 | 2013-05-23 | Magna Electronics, Inc. | Calibration system and method for vehicular surround vision system |

| US9139133B2 (en) * | 2012-05-31 | 2015-09-22 | GM Global Technology Operations LLC | Vehicle collision warning system and method |

-

2013

- 2013-12-16 JP JP2013259593A patent/JP6232994B2/ja not_active Expired - Fee Related

-

2014

- 2014-11-27 BR BR112016013307A patent/BR112016013307A2/pt not_active IP Right Cessation

- 2014-11-27 EP EP14812308.6A patent/EP3039644B1/en not_active Not-in-force

- 2014-11-27 US US14/917,711 patent/US10140775B2/en active Active

- 2014-11-27 CN CN201480067077.9A patent/CN105814886B/zh not_active Expired - Fee Related

- 2014-11-27 RU RU2016122956A patent/RU2679987C2/ru not_active IP Right Cessation

- 2014-11-27 WO PCT/JP2014/005932 patent/WO2015092981A1/en active Application Filing

Patent Citations (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2001083921A (ja) * | 1999-09-16 | 2001-03-30 | Dainippon Printing Co Ltd | モニタのコントラスト調整方法 |

| CN103338325A (zh) * | 2013-06-14 | 2013-10-02 | 杭州普维光电技术有限公司 | 基于全景摄像机的车底盘图像采集方法 |

Also Published As

| Publication number | Publication date |

|---|---|

| EP3039644A1 (en) | 2016-07-06 |

| JP6232994B2 (ja) | 2017-11-22 |

| EP3039644B1 (en) | 2019-11-27 |

| WO2015092981A1 (en) | 2015-06-25 |

| US20160217625A1 (en) | 2016-07-28 |

| JP2015119225A (ja) | 2015-06-25 |

| US10140775B2 (en) | 2018-11-27 |

| RU2016122956A (ru) | 2017-12-12 |

| BR112016013307A2 (pt) | 2022-07-19 |

| CN105814886A (zh) | 2016-07-27 |

| RU2016122956A3 (zh) | 2018-07-16 |

| RU2679987C2 (ru) | 2019-02-14 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| CN105814886B (zh) | 图像处理设备、图像处理方法和程序 | |

| CN108604366B (zh) | 使用预定视点查找表的环绕视图的三维渲染 | |

| US10040394B2 (en) | Vehicle vision system | |

| KR101339121B1 (ko) | 다중 룩업 테이블을 이용한 차량 어라운드 뷰 영상 생성장치 | |

| JP2012248183A (ja) | 3d表面形状をキャプチャーするための方法およびシステム | |

| US10897600B1 (en) | Sensor fusion based perceptually enhanced surround view | |

| JP2007150658A (ja) | 車載周辺画像表示装置 | |

| JP4830380B2 (ja) | 車両周辺監視装置及び車両周辺監視方法 | |

| JP2015201680A (ja) | 画像表示装置、画像表示方法及び画像表示プログラム | |

| KR101469717B1 (ko) | 광각 카메라를 이용한 영상 시스템 및 그 방법 | |

| WO2017033518A1 (ja) | 車両用表示装置および車両用表示方法 | |

| JP6293089B2 (ja) | 後方モニタ | |

| US11145093B2 (en) | Semiconductor device, image processing system, image processing method and computer readable storage medium | |

| KR101230909B1 (ko) | 차량용 광각 영상 처리장치 및 그 방법 | |

| CN107548501B (zh) | 用于驾驶员辅助系统的图像合成装置 | |

| CN114219895A (zh) | 一种三维视觉图像构建方法和装置 | |

| KR20110088680A (ko) | 복수개의 영상을 합성한 합성 영상에 대한 보정 기능을 구비하는 영상 처리 장치 | |

| JP2018014583A (ja) | 画像処理装置 | |

| US11017508B2 (en) | Image matching method and apparatus | |

| KR20110082873A (ko) | 복수개의 영상을 합성한 합성 영상에서 거리 정보를 제공하는 기능을 구비하는 영상 처리 장치 및 방법 | |

| WO2023095340A1 (ja) | 画像処理方法、画像表示方法、画像処理装置、及び画像表示装置 | |

| CN109703461B (zh) | 车辆驾驶支援装置 | |

| JP2020092387A (ja) | 画像合成装置、及び、制御方法 | |

| KR20160080461A (ko) | 분할 영역 영상의 영상 합성 처리장치 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| C06 | Publication | ||

| PB01 | Publication | ||

| SE01 | Entry into force of request for substantive examination | ||

| SE01 | Entry into force of request for substantive examination | ||

| GR01 | Patent grant | ||

| GR01 | Patent grant | ||

| CF01 | Termination of patent right due to non-payment of annual fee | ||

| CF01 | Termination of patent right due to non-payment of annual fee |

Granted publication date: 20200915 |