CN100557553C - 信息处理设备及其控制方法和图像处理设备 - Google Patents

信息处理设备及其控制方法和图像处理设备 Download PDFInfo

- Publication number

- CN100557553C CN100557553C CNB2007101021965A CN200710102196A CN100557553C CN 100557553 C CN100557553 C CN 100557553C CN B2007101021965 A CNB2007101021965 A CN B2007101021965A CN 200710102196 A CN200710102196 A CN 200710102196A CN 100557553 C CN100557553 C CN 100557553C

- Authority

- CN

- China

- Prior art keywords

- image

- unit

- mixed reality

- fit

- virtual

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T15/00—3D [Three Dimensional] image rendering

- G06T15/10—Geometric effects

- G06T15/20—Perspective computation

Landscapes

- Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- Physics & Mathematics (AREA)

- Computing Systems (AREA)

- Geometry (AREA)

- Computer Graphics (AREA)

- General Physics & Mathematics (AREA)

- Processing Or Creating Images (AREA)

- Controls And Circuits For Display Device (AREA)

- Image Processing (AREA)

- Studio Devices (AREA)

Abstract

一种连接到显示设备的信息处理设备包括:获取单元,适合获取由成像设备捕获的实像;生成单元,适合基于所述成像设备的取向生成虚像;检测单元,适合检测实像的倾斜;校正单元,适合基于所述检测到的实像倾斜校正所述实像;合成单元,适合基于校正的实像和所述虚像生成合成图像;和输出单元,适合向所述显示设备输出校正的合成图像。

Description

技术领域

本发明涉及信息处理设备及其控制方法和图像处理设备。更具体地,本发明涉及混合现实技术。

背景技术

有许多已知的基于混合现实技术的系统(MR系统或混合现实系统),该技术以一种自然方式合并真实世界和虚拟世界而不会引起任何不适。这种MR系统在显示设备如HMD上显示混合现实图像,通过合并由成像设备如照相机获取的实像(实际感测图像)和使用CG(计算机图形)绘制的虚拟空间图像(虚像)来创建该混合现实图像。通过此过程,MR系统向它的用户提供混合现实。在上面的描述中,CG代表计算机图形,而HMD代表头戴式显示器。

由于这种MR系统创建虚像以跟踪实像中的变化,所以需要实时地捕获用户观察点的位置和取向。6-自由度位置和取向传感器设备被广泛用于捕获位置和取向。MR系统将用户观察点的位置和取向,如6-自由度位置和取向传感器设备所测量的,转换成虚拟空间中虚拟的观察点位置和取向,使用CG绘制虚像,并且合并所述虚像与实像。因此,MR系统的用户将能够观察在其上描绘虚拟对象的图像,就好像它们真实地存在于真实空间中。

MR系统的用户一般使用头部固定型显示设备,如HMD。HMD装备有与观察者的观察点的位置和取向近似光学一致配置的视频照相机。使用HMD的MR系统从佩戴HMD的用户(观察者)的观察点的位置和取向获取实像,并且创建从相同的位置和取向观察到的虚拟空间图像。结果,这种MR图像能增强观察者沉浸其中的感觉。

另一方面,有了使用HMD的MR系统,仅有佩戴HMD的观察者能观察到混合现实图像,并且不佩戴HMD的第三人不能观察到混合现实图像。为此原因,被呈现给所述观察者的相同混合现实图像被显示在固定显示设备如CRT、投影仪或大显示器上,以呈现给非特定的第三人。因此,甚至不佩戴HMD的第三人能体验佩戴HMD的观察者所体验的相同混合现实。

在此情况下,第三人将观察从所述观察者的观察点创建的混合现实图像。如果观察者移动或倾斜他的/她的头,即使第三人保持固定,对应于所述观察者的位置和取向中的变化的混合现实图像将被呈现给第三人。因此,例如,当观察者为了向下注视目标而倾斜他的/她的头时,倾斜的混合现实图像将呈现在观察者的HMD上,并且同时,倾斜的混合现实图像将呈现在第三人看到的固定显示设备上。由于混合现实图像被创建以显示在观察者的HMD上,因此,明显地,该混合现实图像对于观察者是合适的。但是,由于第三人观看所述固定显示器时不会以与观察者相同的方式倾斜,所以第三人将不可避免地感觉到呈现的混合现实图像以与他/她自己的头倾斜不一致的角度不自然地倾斜。此外,由于佩戴HMD的观察者的头的位置和取向不断变化,上面提及的观察固定显示设备的第三人感觉的不自然将增加。因此,当观察所呈现的混合现实图像时,第三人可能最终觉得不适。

换句话说,使用如上所述MR系统,存在这样的情况:适于倾斜他/她的头的观察者的混合现实图像可能不适于第三人,该第三人具有的观察点的位置和取向不同于该观察者的观察点位置和取向。因此,要求对应于观察者的位置和取向中变化的混合现实图像被呈现给观察者,同时不具有由所述观察者的位置和取向中的变化导致的倾斜的混合现实图像被呈现给第三人。

在公开号为10-164426的日本专利中公开的电子照相机控制将被记录的图像,以通过检测成像平面的取向来维持恒定的垂直取向。

但是,公开号为10-164426的日本专利中公开的电子照相机执行的处理被局限在检测成像单元的旋转方向和角度以及基于所述检测结果的图像旋转。因此,上述发明既不能向佩戴HMD的观察者也不能向没佩戴HMD的第三人呈现合适的混合现实图像。

发明内容

考虑到上述问题作出本发明,并且它的目标是提供能够向佩戴HMD的观察者和没佩戴HMD的第三人呈现合适的混合现实图像的技术。

为了实现以上目标,信息处理设备连接到显示设备,信息处理设备包括:

获取单元,适合获取由成像设备捕获的实像;

生成单元,适合基于成像设备的取向生成虚像;

检测单元,适合检测实像的倾斜;

校正单元,适合基于所检测到的实像的倾斜校正实像;

合成单元,适合基于校正的实像和虚像生成合成图像;

输出单元,适合向显示设备输出校正的合成图像。

此外,根据本发明另一个信息处理设备被配置如下。即,

信息处理设备连接到显示设备,信息处理设备包括:

获取单元,适合获取由成像设备捕获的实像;

生成单元,适合基于成像设备的取向生成虚像;

合成单元,适合基于实像和虚像生成合成图像;

检测单元,适合检测实像的倾斜;

校正单元,适合基于所检测到的实像倾斜校正合成图像;和

输出单元,适合向显示设备输出校正的合成图像。

此外,一种图像处理设备,包括:

图像获取单元,适合获取图像;

检测单元,适合检测图像的倾斜;

图像生成单元,适合生成图像,以用该图像生成合成图像;

校正单元,适合基于检测单元的检测结果校正图像获取单元获取的图像;

第一合成单元,适合基于由图像生成单元生成的图像和校正单元校正的图像生成合成图像;

第一输出单元,适合输出第一合成单元生成的合成图像。

此外,根据本发明另一个图像处理设备被配置如下。即,

一种图像处理设备,包括:

图像获取单元,适合获取图像;

检测单元,适合检测所述图像的倾斜;

图像生成单元,适合生成图像,以用该图像生成合成图像;

合成单元,适合基于由图像获取单元获取的图像和图像生成单元生成的图像生成合成图像;

校正单元,适合基于检测单元的检测结果校正由图像合成单元生成的合成图像;和

第一输出单元,适合输出校正单元校正的图像。

此外,根据本发明用于信息处理设备控制方法配置如下。即,

一种用于信息处理设备的控制方法,该控制方法包括:

获取图像的图像获取步骤;

检测图像倾斜的检测步骤;

生成图像的图像生成步骤,用该图像生成合成图像;

基于检测步骤的检测结果来校正在图像获取步骤获取的图像的校正步骤;

基于在图像生成步骤中生成的图像和在校正步骤中校正的图像,生成合成图像的第一合成步骤;和

输出在第一合成步骤中生成的合成图像的第一输出步骤。

此外,根据本发明用于信息处理设备的另一个控制方法配置如下。即,

一种用于信息处理设备的控制方法,控制方法包括:

获取图像的图像获取步骤;

检测所述图像倾斜的检测步骤;

生成图像的图像生成步骤,使用该图像生成合成图像;

基于在图像捕获步骤中捕获的图像和在图像生成步骤中生成的图像,生成合成图像的第一合成步骤;

基于检测步骤的检测结果来校正在图像合成步骤中生成的合成图像的校正步骤;和

输出在校正步骤中校正的图像的第一输出步骤。

此外,根据本发明的另一个信息处理设备配置如下。即,

一种图像处理设备,具有显示设备、第二显示设备、及连接到显示设备和第二显示设备的信息处理设备,该图像处理设备包括:

获取单元,适合获取由成像设备捕获的实像;

检测单元,适合检测实像的倾斜;

校正单元,适合基于所检测到的实像倾斜校正所述实像;和

输出单元,适合向显示设备输出校正的实像,并且向第二显示设备输出获取单元获取的所述实像。

根据下面参考附图的示范实施例的描述,本发明的更多特征将变得明显。

附图说明

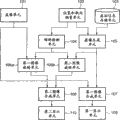

图1是框图,示出根据第一实施例的图像处理设备的功能配置的概要;

图2是图像旋转单元执行的处理的解释示意图;

图3是流程图,示出了由图像处理设备执行的处理流程;

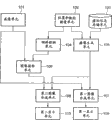

图4是方框图,示出了根据第二个实施例的图像处理设备的功能配置的概要;

图5是示出了根据第三个实施例的图像处理设备的功能配置概要的框图;

图6是示出了根据第四个实施例的图像处理设备的功能配置概要的框图;

图7是示出由图像处理设备执行的处理流程的流程图;

图8是示出了根据第五个实施例的图像处理设备的功能配置概要的框图;

图9是示出了根据第六个实施例的图像处理设备的功能配置概要的框图;

图10是示出了图像处理设备的硬件配置概要的框图;

图11是示出了根据第七个实施例的图像处理设备的功能配置概要的框图;

图12是示出了根据第八个实施例的图像处理设备的功能配置概要的框图;

图13是示出了根据第九个实施例的图像处理设备的功能配置概要的框图;

图14是描绘旋转之后图像中出现缺陷的示意图;和

图15是修整处理的解释示意图。

具体实施方式

现在将参考附图详细描述本发明的优选实施例。但是,应注意的是,结合实施例描述的部件仅是解释性的,并且不限制本发明的范围。

[第一个实施例]

(图像处理设备的概要配置)

在第一个实施例中,将给出如下配置的描述,在该配置中由佩戴HMD并且体验混合现实的观察者观察的图像被输出到HMD和固定显示器。在这种情况下,普通的混合现实图像被显示在HMD上,同时校正倾斜的混合现实图像被显示在固定显示器上。

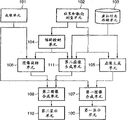

图10是示出了根据本发明图像处理设备的硬件配置概要的框图。图10中示出的矩形表示实现根据本发明配置的模块。箭头表示模块之间图像或信号的流动。

混合现实呈现设备(信息处理设备)100是执行根据本发明的图像处理设备主要功能的模块。基于从HMD 200上提供的成像单元101以及位置和取向测量单元102的输出,混合现实呈现设备100创建混合现实图像,并且在HMD 200和固定显示设备300上显示所创建的图像。稍后将描述HMD 200的成像单元101以及位置和取向测量单元102。

实际上,可由信息处理设备(如个人计算机或工作站)实现混合现实呈现设备100。在这种情况下,混合现实呈现设备100包括CPU,CPU控制整个设备和存储装置(如RAM、ROM或(硬)盘),并且通过执行程序代码控制处理。但是,实现所述混合现实呈现设备100的方法不限于这种布置,并且所述混合现实呈现设备100可配置为执行相同处理的半导体集成电路。

如下面详细的描述,混合现实呈现设备100从成像单元101获取被捕获的实像,基于HMD 200(成像单元101)的取向创建虚像,并且检测实像的倾斜。此外,混合现实呈现设备100基于检测的实像倾斜校正所述实像和虚像,基于被分别校正的实像和虚像创建合成图像,并且在固定显示设备300上输出所述合成图像。

HMD 200(根据本发明的第二显示设备)是一个显示设备,比如观察者安装或固定在他/她的头上的HMD。HMD 200在观察者的眼前光学显示输入到HMD 200的图像。在本实施例中,HMD 200装备有内置视频照相机,该照相机被安装为与观察者的观察点的位置和取向近似光学一致。内置于HMD200的视频照相机获取从观察者的观察点位置观察到的实像,并且向混合现实呈现设备100输出所述图像。此外,HMD 200具有测量观察者的观察点的位置和取向的功能,并且向混合现实呈现设备100输出所测量的位置和取向信息。注意到HMD200不需限制为被配置安装在观察者的头上的显示设备。例如,被配置为握在观察者的手里等的显示设备可执行与HMD 200相同的功能。

固定显示设备(显示设备)300是一个大屏幕显示设备,如等离子显示器,并且在屏幕上显示从混合现实呈现设备100输出的图像。固定显示设备300允许不同于使用HMD 200的观察者的第三人能观看混合现实图像。

实现等价于上述每个设备的那些功能的软件可被配置为替换所述硬件设备。

此外,虽然为了易于解释本实施例的图像处理设备被描述为特征在于上面三个模块的配置,但是图像处理设备的配置不限于这个例子。例如,可配置上面三个模块以便通过单个设备实现。例如,可替换地,本实施例可配置为由内置于HMD 200或固定显示设备300的混合现实呈现设备100而实现。例如,可替换选地,通过将所述混合现实呈现设备100的功能分布到多个信息处理设备上虚拟实现的部件并使用所述信息处理设备执行平行处理,来配置并实现本实施例。

(图像处理设备的功能配置)

现在将参考图1描述根据本实施例的图像处理设备的功能配置。图1是示出根据本实施例的图像处理设备的功能配置概要的框图。

在图1中,成像单元101获取从观察者的观察点观察的实际感测图像(实像)。在本实施例中,内置于HMD 200中的视频照相机实现成像单元101的功能。由成像单元101获取的实像被输出到图像旋转单元106a和第一图像合成单元107。

HMD 200上提供的位置和取向测量单元102在三维空间中测量观察者的观察点的位置和取向,并且向倾斜检测单元104和虚像生成单元105输出所述位置和取向。所述位置和取向测量单元102是由测量装置例如6-自由度传感器(但不限于它)实现。例如,可替换地,通过设置成像单元101捕获被布置在空间中的指示符(标记)并且从捕获的图像中检测所述指示符的坐标来估计位置和取向,所述空间具有已知的三维位置。以此方式计算的位置和取向可被输出到倾斜检测单元104和虚像生成单元105。这样,将从成像单元101输出的实像被输入到位置和取向测量单元102。

虚拟信息存储单元103存储用于生成虚像的虚像生成单元105所使用的虚像空间信息。当生成虚像时,虚拟信息存储单元103向虚像生成单元105提供虚拟空间信息。在本实施例中,将虚拟空间呈现为三维CG图像必须的信息,例如关于在虚拟世界中放置的CG目标的三维形状信息、布置信息、光源信息、对象合成和纹理图像,被保存作为虚拟空间信息。关于三维形状的信息包括顶点坐标、关于表面配置的信息、法向矢量等等。

倾斜检测单元104从位置和取向测量单元102接收关于佩戴HMD 200的观察者的观察点取向的信息作为输入,并且基于取向信息检测实像的倾斜,并且向图像旋转单元106a和106b输出检测的倾斜。在本实施例中,通过从安装在HMD 200中的位置和取向测量单元102输出的取向信息中提取一个滚转角(roll angle)来检测实像的倾斜,当观察点给定为所述旋转轴时,滚转角是一个旋转角。通过从位置和取向测量单元102输出的取向信息计算在三维空间中的旋转矩阵,并且将矩阵分解为滚转角(roll angle)、俯仰角(pitch angle)和偏转角(yaw angle)的各个分量,来执行滚转角的提取。倾斜检测单元104向图像旋转单元106a和106b输出提取的滚转角。当滚转角被包括在由位置和取向测量单元102测量的取向中,并且位置和取向测量单元102能直接输出滚转角时,倾斜检测单元104输出所输入的滚转角而不用修改图像旋转单元106a和106b。本实施例提供了两个图像旋转单元,并且倾斜检测单元104向两个图像旋转单元106a和106b输出滚转角。

基于来自位置和取向测量单元102和虚拟信息存储单元103的信息,虚像生成单元105执行CG绘制以生成虚像。虚像生成单元105向图像旋转单元106b和图像合成单元107输出生成的虚像。更具体地,虚像生成单元105将从位置和取向测量单元102输出的位置和取向设置为一个观察点,从该观察点观察虚拟空间。基于此观察点将保存在虚拟信息存储单元103中的CG对象布置在虚拟空间中之后,虚像生成单元105通过执行CG绘制来生成虚像。

基于从倾斜检测单元104输出的图像倾斜,各个图像旋转单元106a和106b在从成像单元101或虚像生成单元105输出的图像上施加旋转变换,以抵消所述图像倾斜。在本实施例中,由于从倾斜检测单元104输出来自观察者的观察点的滚转角(当观察点给定为旋转轴时是旋转角),将以所述滚转角的相反方向旋转所述输入图像。

图2是由图像旋转单元106执行的处理的解释框图。例如,假定旋转之前的图像10和-45度的滚转角已输入到图像旋转单元106。图像旋转单元106对图2所示的旋转之前的图像10执行旋转变换,以抵消-45度的滚转角。换句话说,图像旋转单元10将旋转之前的图像10旋转+45度,并且输出旋转之后的图像20。

当用(u,v)T表示旋转之前的图像10中每个像素的坐标,当用(u′,v′)T表示旋转之后的图像20中每个像素的坐标,并且输入的滚转角用θ表示时,可用下面的公式表示旋转之后的图像20中每个像素,这里旋转中心给定为(u,v)T=(0,0)T。

[公式1]

例如,可使用图像中心、或图像中相应于成像单元101等的光学中心的点坐标作为旋转中心。可由成像单元101等的校准来计算成像单元101的光学中心。由于计算光学中心的具体方法已经是公知常识,将省略它的描述。

根据本发明的图像处理设备包括两个图像旋转单元106a和106b(它们将共同标注为106)。第一图像旋转单元(根据本发明的第一图像旋转单元)106a接收从成像单元101输出的实像和从倾斜检测单元104输出的滚转角作为输入,并且向第二图像合成单元108输出旋转20之后的图像。第二图像旋转单元(根据本发明的第二图像旋转单元)106b接收从虚像生成单元105输出的虚像和从倾斜检测单元104输出的滚转角作为输入,并且向第二图像合成单元108输出旋转20之后的图像。

第一图像合成单元(根据本发明的第二合成单元)107把虚像生成单元105生成的虚像叠加到成像单元101捕获的实像上,以生成混合现实图像。第二图像合成单元108把第二图像旋转单元106b输出的旋转后的虚像叠加到第一图像旋转单元106a输出的旋转后的实像上,以生成混合现实图像。由第一图像合成单元107生成的混合现实图像输出到第一显示单元109上,而由第二图像合成单元108生成的混合现实图像输出到第二显示单元110上。

如上所述,根据本发明的图像处理设备包括两个图像合成单元107和108。第一图像合成单元107接收从成像单元101输出的实像和从虚像生成单元105输出的虚像作为输入,并且向第一显示单元109输出生成的混合现实图像。第二图像合成单元108(根据本发明的第一合成单元)分别接收从两个图像旋转单元106a和106b输出的旋转20后的图像作为输入,并且向第二显示单元110输出所生成的混合现实图像。在本实施例中,第一图像合成单元107和第二图像合成单元108首先将虚像叠加到实像上。对虚像的背景部分不执行叠加处理。实像被叠加到虚像的除了所述背景外的部分。叠加处理的结果是,在第一图像合成单元107和第二图像合成单元108生成的混合现实图像中,虚像将仅被部分地叠加到所述实像中的存在虚拟空间CG的部分。

也可将存在虚拟空间CG的虚像的部分任意地设置为不执行叠加的部分,以便创造特殊效果。例如,通过执行处理使得虚像不被叠加到包括特定颜色的实像的部分,可避免总是在真实对象前面观察到虚拟空间CG的现象。例如使用公开号为2003-296759的日本专利中公开的方法可执行这种处理。本实施例中,第一图像合成单元107和第二图像合成单元108之间的仅有区别是,向图像合成单元输入图像的源模块和从图像合成单元输出图像的目的模块。另外,第一图像合成单元107和第二图像合成单元108执行的处理内容是相同的。

第一显示单元(根据本发明的第二输出单元)109接收从第一图像合成单元107输出的混合现实图像作为输入,并且显示所输入的混合现实图像。第二显示单元(根据本发明的第一输出单元)110接收从第二图像合成单元108输出的混合现实图像作为输入,并且显示所输入的混合现实图像。在HMD 200提供第一显示单元109,并且该显示单元显示从使用HMD 200的观察者的观察点中观察的混合现实图像。换句话说,第一显示单元109显示图像旋转单元106尚未将旋转变换施加到其上的混合现实图像。在固定显示设备300上提供第二显示单元110,并且该显示单元显示从使用HMD 200的观察者的观察点中观察的混合现实图像,其中图像倾斜已从混合现实图像上除去。换句话说,第二显示单元110显示图像旋转单元106已将旋转变换施加到其上的混合现实图像。本实施例中,具有屏幕的显示设备用作第二显示单元110,该屏幕比第一显示单元109的屏幕大。这允许将佩戴HMD200的观察者所观察的混合现实图像呈现给未佩戴HMD 200的第三人。

(基本处理)

现在将参考图3给出根据本实施例的图像处理设备执行的控制的描述,如上所述配置该设备。图3示出了根据本实施例的图像处理设备执行的处理流程的流程图。根据流程图示出的程序代码存储于未示出的存储装置,比如在图像处理设备中提供的盘装置或RAM,并且由CPU读取和执行。

首先,在步骤S1010中,激活根据本实施例的图像处理设备,并且执行必要的初始化。必要的初始化包括CPU执行的从盘装置读取程序代码或虚拟空间信息的处理,并将其存储在RAM中。

在步骤S1020中,成像单元101从佩戴HMD 200的观察者的观察点获取实像。

在步骤S1030中,位置和取向测量单元102测量佩戴HMD 200的观察者的观察点的位置和取向。

在步骤S1040中,倾斜检测单元104检测在步骤S1020中获取的实像倾斜。

在步骤S1050中,虚像生成单元105使用在步骤S1030中测量的位置和取向作为观察点来执行虚拟空间的CG绘制,并且生成虚像。

在步骤S1060中,图像旋转单元106将旋转变换施加到步骤S1020中获取的实像和步骤S1050中生成的虚像。

在步骤S1070中,第一图像合成单元107和第二图像合成单元108接收实像和虚像作为输入,并且生成混合现实图像,其中虚像被叠加到实像上。如上所述,本实施例包括两个图像合成单元107和108。第一图像合成单元107形成步骤S1020中获取的实像和步骤S1050中生成的虚像的合成图像,并且向第一显示单元109输出合成图像。第二图像合成单元108形成步骤S1020中获取的实像和在步骤S1060中已将旋转变换应用到其上的虚像的合成图像,并且向第二显示单元110输出合成图像。

在步骤S1080中,确定关于是否终止本处理。如果是,结束根据实施例的处理。相反地,如果否,处理返回步骤S1020,从那里继续。

应注意到在本实施例中,在短的时间周期执行步骤S1020到S1080的一系列处理。完成单程的这一系列处理需要时间通常在数毫秒到数百毫秒之内。因此,通过重复执行步骤S1020到S1080的处理,根据本实施例的图像处理设备连续地显示在短时间周期内变化的混合现实图像。因此,观察者和第三人将所述混合现实图像识别为一系列移动图像。

虽然上面已经提供了根据本发明的控制流程的描述,但是描述的顺序仅是示例性的,并且可修改部分处理的顺序。例如,可任意地修改处理的次序,只要在步骤S1060的处理之前执行步骤S1020的处理,在步骤S1040的处理之前执行步骤S1030的处理,以及在步骤S1060的处理之前执行步骤S1040的处理。但是,不可改变步骤S1010、S1070和S1080的次序。

如上所述,混合现实呈现设备100从成像单元101获取已捕获的实像,基于HMD 200(成像单元101)的取向创建虚像,并且检测实像的倾斜。此外,混合现实呈现设备100基于检测的实像倾斜来校正实像和虚像,基于各自校正的实像和虚像创建合成图像,并且将合成图像输出到固定显示设备300上。因此,基于检测的实像倾斜,向固定显示设备300输出校正的图像。因此,根据第一个实施例的配置能分别向佩戴头部固定型显示设备(HMD)的观察者和不佩戴头部固定型显示设备的第三人呈现合适的混合现实图像。

[第二个实施例]

根据第二个实施例的图像处理设备向HMD 200和固定显示器300输出由佩戴HMD并体验混合现实的观察者所看到的图像。在这种情况下,普通的混合现实图像被显示在HMD上,而倾斜校正的混合现实图像被显示在固定显示器300上。虽然在第二个实施例的配置和控制与第一个实施例的配置和控制之间存在许多相似,但是在用于检测实像中倾斜的方法上,第二个实施例不同于第一个实施例。在根据第一个实施例的配置中,使用由在HMD 200中提供的位置和取向测量单元102获取的位置和取向来检测实像的倾斜。但是,在根据第二个实施例的配置中,使用由成像单元101获取的实像来检测倾斜。

图4是方框图,示出了根据本实施例的图像处理单元功能配置的概要。与根据第一个实施例的功能配置(图1)比较,倾斜检测单元104与其区别在于,取代了输入从位置和取向测量单元102输出的取向,它输入从成像单元101输出的实像。关于本实施例的配置,现在仅将描述它的不同于第一个实施例的部分。

在本实施例中,成像单元101向图像旋转单元106a、图像合成单元107和倾斜检测单元104输出所获取的实像。此外,在本实施例中,位置和取向测量单元102向虚像生成单元105输出测量的位置和取向信息。

在本实施例中,倾斜检测单元104接收来自成像单元101的实像作为输入,并且检测该图像的倾斜。倾斜检测单元104向图像旋转单元106输出检测的倾斜。倾斜检测单元104为成像单元101输出的图像计算一个滚转角,当观察点给定为旋转轴时,所述滚转角是旋转角。倾斜检测单元104向图像旋转单元106输出所提取的滚转角。

下面将描述根据本实施例的倾斜检测单元104所执行的计算滚转角的处理。倾斜检测单元104计算来自从成像单元101输出的实像的光流。光流指示图像上每个点的移动速度。多个方法是计算光流的已知方法,比如基于梯度的方法或块匹配方法。在本实施例中,当光流的位移矢量的原点由A表示,它的终点由B表示,并且图像的中心由O表示时,为每个位移矢量计算表示为∠AOB的角,并且向图像旋转单元106输出其平均值作为一个滚转角。

在上面的描述中,虽然基于图像中的光流由倾斜检测单元104计算滚转角,但是本实施例不限于这个设置。只要可从成像单元101获取的图像得到观察者的视线周围的旋转角,任何方法都可用于实现倾斜检测单元104的功能。

如上所述,根据本实施例的配置分析获取的实像以检测倾斜。因此,即使HMD 200不能检测取向,仍可检测实像的倾斜,以便以恰当方式校正图像。因此,根据第二个实施例配置能将恰当的混合现实图像呈现给佩戴头部固定型显示设备(HMD)的观察者和不佩戴头部固定型显示设备的第三人。显然,结合本实施例描述的检测实像倾斜的方法可不仅应用于根据第一实施例的配置,而且应用于根据下面将描述的第三个实施例的配置。

[第三个实施例]

根据第三个实施例的图像处理设备向HMD 200和固定显示器300输出由佩戴HMD并体验混合现实的观察者所看到的图像。在这种情况下,普通的混合现实图像被显示在HMD 200上,而校正倾斜的混合现实图像被显示在固定显示器300上。虽然在第三个实施例的配置和控制与第一个实施例的配置和控制之间存在许多相似,但是在用于检测虚像中倾斜的方法上第三个实施例不同于第一个实施例。根据第一个实施例的配置通过旋转所生成的虚像来执行校正。相反地,根据第三个实施例的配置校正呈现虚拟空间的取向,并且据此生成虚像。换句话说,根据第三个实施例的配置在校正倾斜状态下生成虚像。

图5是示出了根据本实施例的图像处理设备的功能配置概要的框图。与根据第一个实施例的功能配置(图1)比较,现在仅有一个图像旋转单元106,并且新增加第二虚像生成单元111。

在本实施例中,混合现实呈现设备100获取由成像单元101捕获的实像,检测实像的倾斜,并且基于检测的实像倾斜校正实像。此外,混合现实呈现设备100基于成像单元101(HMD 200)的取向和检测的实像倾斜来生成虚像,基于校正的实像和虚像生成合成图像,并且向固定显示设备300输出合成图像。

关于本实施例的配置与控制,现在仅将描述它不同于第一个实施例的部分。在本实施例中,位置和取向测量单元102向倾斜检测单元104、虚像生成单元105和第二虚像生成单元111输出测量的位置和取向信息。此外,在本实施例中,倾斜检测单元104向图像旋转单元106和第二虚像生成单元111输出所检测的倾斜。

基于来自位置和取向测量单元102、虚拟信息存储单元103和倾斜检测单元104的信息,第二虚像生成单元111执行CG绘制以生成虚像。生成的虚像被送到第二图像合成单元108。以与虚像生成单元105相同的方式,在基于观察者的观察点把保存在虚拟信息存储单元103中CG对象放置虚拟空间中之后,第二虚像生成单元111执行CG绘制以生成虚像。此时,基于来自倾斜检测单元104的滚转角,从位置和取向测量单元102输出的取向中移除滚转角分量。更具体地,从表示所述取向的三维旋转矩阵R计算滚转角、俯仰角和偏转角。随后,使用俯仰角和偏转角执行另一个计算,以获得三维旋转矩阵R′。换句话说,在从R获得的角中,仅丢弃滚转角(滚转角分量被设置为0)来构建R′。结果,第二虚像生成单元111生成虚像,从该虚像中移除观察者的视线(在虚像的像平面上)周围的旋转。

当滚转角被包括在位置和取向测量单元102测量的取向中,以及位置和取向测量单元102能直接输出所述滚转角时,第二虚像生成单元111仅需将输入的滚转角设置为0度并执行CG绘制。在此情况下,将不需要从倾斜检测单元104输出。

在本实施例中,第二图像合成单元108接收由成像单元106输出的实像和由第二虚像生成单元111输出的虚像的旋转20后的图像作为输入,并且向第二显示单元110输出生成的混合现实图像。

在图3所示的步骤S1050中,使用根据本实施例的图像处理设备,虚像生成单元105和第二虚像生成单元111生成虚像。

如上所述,在本实施例中,混合现实呈现设备100获取由成像单元101捕获的实像,检测实像的倾斜,并且基于检测的实像倾斜来校正实像。此外,混合现实呈现设备100基于成像单元101(HMD 200)的取向及检测的实像倾斜来生成虚像,基于校正的实像和虚像生成合成图像,并且向固定显示设备300输出合成图像。

因此,不同于第一个实施例,根据本实施例的配置旋转观察点(从该观察点执行CG绘制),并且不旋转虚像本身。因此,由于旋转导致的缺陷在不出现在虚像中。因此,根据第三个实施例配置能向佩戴头部固定型显示设备(HMD)的观察者和不佩戴头部固定型显示设备的第三人呈现合适的混合现实图像。

[第四个实施例]

根据第四个实施例的图像处理设备向HMD 200和固定显示器300输出由佩戴HMD并体验混合现实的观察者所看到的图像。在这种情况下,普通的混合现实图像被显示在HMD 200上,而校正倾斜的混合现实图像被显示在固定显示器300上。虽然第四个实施例的配置和控制与第一个实施例的配置和控制之间存在许多相似,但是取代了在第一个实施例中都校正所述实像和虚像,根据第四个实施例的配置在将虚像叠加到实像之后校正图像的倾斜。

图6是示出了根据本实施例的图像处理设备的功能配置概要的框图。与第一个实施例比较,现在仅有一个图像旋转单元106,并且省略了第二图像合成单元108。

在本实施例中,混合现实呈现设备100获取来自成像单元101的捕获的实像,基于成像单元101(HMD 200)的取向创建虚像,基于实像和虚像生成合成图像,并且检测实像的倾斜。此外,混合现实呈现设备100基于检测的实像倾斜校正合成图像,并且向固定显示设备300输出合成图像。

关于本实施例的配置与控制,现在仅将描述它的不同于第一个实施例的部分。在本实施例中,虚像生成单元105向第一图像合成单元107a输出生成的虚像。此外,在本实施例中,第一图像合成单元107a接收从成像单元101输出的实像和从虚像生成单元105输出的虚像作为输入,并且向第一显示单元109和图像旋转单元106输出生成的混合现实图像。此外,在本实施例中,图像旋转单元106接收从第一图像合成单元107a输出的混合现实图像和从图像旋转单元104输出的滚转角作为输入,并且向第二显示单元110输出旋转20之后的图像。

现在将描述如上所述配置的本实施例的控制。图7是示出根据本实施例的图像处理设备执行的处理流程的流程图。与第一个实施例的控制(图3)相比较,已删除步骤S1060的处理并增加步骤S1075的处理。

在步骤S1070中,第一图像合成单元107接收实像和虚像作为输入,生成其中虚像被叠加到实像上的混合现实图像,并且向图像旋转单元106和第一显示单元109输出生成的混合现实图像。

在步骤S1075中,图像旋转单元106将旋转变换应用到步骤S1070中生成的混合现实图像,并且向第二显示单元110输出图像。接下来处理进行到步骤S1080。

如上所述,在本实施例中,混合现实呈现设备100获取来自成像单元101的捕获的实像,基于成像单元101(HMD 200)的取向创建虚像,且基于实像和虚像生成合成图像。此外,混合现实呈现设备100检测实像的倾斜,基于检测的实像倾斜来校正合成图像,并且向固定显示设备300输出合成图像。

如根据本实施例的配置中所见,由于仅对从第一图像合成单元107输出的虚像执行图像校正处理,可使用相对简单的设置实现根据本实施例的配置。因此,如上所述,根据第四个实施例配置能够向佩戴头部固定型显示设备(HMD)的观察者和不佩戴头部固定型显示设备的第三人呈现合适的混合现实图像。

[第五个实施例]

根据第五个实施例的图像处理设备向HMD 200和固定显示器300输出由佩戴HMD并体验混合现实的观察者所看到的图像。在这种情况下,普通的混合现实图像被显示在HMD 200上,而普通的混合现实图像、或校正倾斜的混合现实图像被显示在固定显示器300上。虽然第五个实施例的配置和控制与第一个实施例的配置和控制之间存在许多相似,但是第五个实施例不同于第一个实施例在于被增加到其上的功能配置,它允许用户选择是否对第二显示单元110显示的混合现实图像执行倾斜校正。

图8是示出了根据本实施例的图像处理设备的功能配置概要的框图。与第一个实施例相比较,第五个实施例增加了选择单元112。关于本实施例的配置与控制,现在仅将描述它的不同于第一个实施例的部分。

选择单元112功能是作为由用户使用的用户接口,该接口用于启动或禁止倾斜检测单元104的处理。选择单元112向倾斜检测单元104输出指示选择结果的控制信号。在本实施例中,由用户操作的输入装置(如开关、键盘或鼠标)连接到图像处理设备。提供给用户两个选择,即“校正图像倾斜”和“不校正图像倾斜”。基于用户向输入装置的输入,选择单元112启动或禁止倾斜检测单元104的处理。选择单元112在显示器上显示这些选择,并且接受用户的选择。当用户选择“校正图像倾斜”时,选择单元112输出控制信号以启动倾斜检测单元104的处理。当用户选择“不校正图像倾斜”时,选择单元112输出控制信号以禁止倾斜检测单元104的处理。

在本实施例中,倾斜检测单元104接收来自选择单元112的控制信号作为输入,并且向图像旋转单元106和第二虚像生成单元111输出检测的图像倾斜。当将从选择单元112输出的控制信号设置为禁止倾斜检测单元104的处理时,倾斜检测单元104向图像旋转单元106输出0度的滚转角。否则,倾斜检测单元104执行与在其它实施例中相同的处理。

如上所述,根据第五个实施例的配置允许用户任意地选择是否对第二显示单元110上显示的混合现实图像执行倾斜校正。虽然已给出本实施例的示例描述,其中将选择单元112增加到根据第一个实施例的配置,但是可选地将选择单元112添加到其它实施例的配置,并且仅当用户选择执行这种校正处理时才设置执行上述的校正处理。

[第六个实施例]

根据第六个实施例的图像处理设备向HMD 200和固定显示器300输出由佩戴HMD并体验混合现实的观察者所看到的图像。在这种情况下,普通的混合现实图像显示在HMD 200上,而普通的混合现实图像、或校正倾斜的混合现实图像显示在固定显示器300上。在第六个实施例的配置和控制与第一个和第五个实施例的配置和控制之间存在许多相似。但是,不同于第一个实施例,一个功能配置已被增加到第六个实施例上,其允许用户选择是否对第二显示单元110显示的混合现实图像执行倾斜校正。此外,虽然第五个实施例被设置为切换是否通过控制倾斜校正单元104对图像执行倾斜校正,第六个实施例被设置为在校正倾斜的图像输出和没校正倾斜的图像输出之间切换,由此选择是否对图像执行倾斜校正。

图9是示出了根据本实施例的图像处理设备的功能配置概要的框图。与第一个实施例相比较,第六个实施例增加了选择单元112。关于本实施例的配置与控制,现在仅将描述它的不同于第一个实施例的部分。

在本实施例中,选择单元112接收来自两个图像合成单元107和108的混合现实图像作为输入,并且选择混合现实图像的任意之一,并且向第二显示单元110输出选择的图像。在这种情况下,基于用户输入的指令执行混合现实图像的选择。

换句话说,选择单元112也是作为由用户使用的用户接口,以选择是否对图像执行校正。

在本实施例中,用户操作的输入装置(如开关、键盘或鼠标)被连接到图像处理设备。提供给用户两个选择,即“校正图像倾斜”和“不校正图像倾斜”。基于用户向输入装置的输入,选择单元112选择混合现实图像的任意一个。选择单元112在显示器上显示这些选择,并且接受用户的选择。当用户选择“校正图像倾斜”时,选择单元112输出从第二图像合成单元108输出的混合现实图像。当用户输入“不校正图像倾斜”时,选择单元112输出从第一图像合成单元107输出的混合现实图像。

如上所述,根据第六个实施例的配置允许用户任意地选择是否对第二显示单元110上显示的混合现实图像执行倾斜校正。虽然已给出本实施例的示例描述,其中将选择单元112增加到根据第一个实施例的配置,但是可替换地可以把选择单元112增加到其它实施例的配置,并且仅当用户选择执行这种校正处理时才设置执行上面描述的校正处理。

[第七个实施例]

根据第七个实施例的设备向HMD 200和固定显示器300输出由佩戴HMD并体验混合现实的观察者所看到的图像。在这种情况下,普通的混合现实图像被显示在HMD 200上,而普通的混合现实图像、或校正倾斜的混合现实图像被显示在固定显示器300上。在第七个实施例的配置和控制与第五个实施例的配置和控制之间存在许多相似。但是,不同于第五个实施例,一个功能配置被增加到第七个实施例上,其根据保存在虚拟信息存储单元103中CG的属性来自动控制是否对第二显示单元110显示的混合现实图像执行倾斜校正。

图11是示出了根据本实施例的图像处理设备的功能配置概要的框图。与第五个实施例相比较,选择单元112与其的区别在于接受来自虚拟信息存储单元103的输出。关于本实施例的配置与控制,现在仅将描述它的不同于第五个实施例的部分。

选择单元112选择启动或禁止倾斜检测单元104的处理。选择单元112向倾斜检测单元104输出指示选择结果的控制信号。在本实施例中,根据虚拟信息存储单元103的内容,选择单元112选择启动/禁止倾斜检测单元104的处理。本实施例中,如果虚拟信息存储单元103向虚像生成单元105输出包括字符信息的CG对象,禁止倾斜检测单元104的处理。否则,启动倾斜检测单元104的处理。基于诸如存储在虚拟信息存储单元103中的根据虚拟信息指示对象类型的信息,可设置进行启动或禁止倾斜检测单元104处理的决定,该决定由选择单元112执行。可替换地,例如,使用已知的字符识别技术可分析虚拟信息,从而当字符可识别时禁止倾斜检测单元104的处理,以及当字符不能识别时启动该处理。

本实施例中,即使在涉及观察点移动时,虚像生成单元105总是使用第一显示单元109上显示的图像中的方向来生成字符信息的虚像,使得字符信息不会随着佩戴HMD 200的观察者移动。因此,在本实施例中,当虚拟信息存储单元103向虚像生成单元105输出包括字符信息的CG对象时,通过不校正图像的倾斜来合适地控制在第二显示单元110上显示包括字符信息的混合现实图像。以与第一个实施例相同的方式来校正不包括字符信息的混合现实图像的倾斜。

本实施例中,如果虚拟信息存储单元103向虚像生成单元105输出包括字符信息的CG对象,选择单元112进行选择,该选择禁止倾斜检测单元104的处理。但是,本实施例不限于这个设置。例如,可依照字符以外的属性来进行启动或禁止倾斜校正的选择。

此外,可设置第六个实施例的选择单元112接受来自虚拟信息存储单元103的输出,使得选择单元112分别接收来自两个图像合成单元107的混合现实图像作为输入,选择混合现实图像,并且向第二显示单元110输出选择的图像。在这种情况下,将如结合本实施例所描述的,进行关于启动和禁止校正图像倾斜处理的控制。显然,在这种情况下可实现相似的优点。

如上所述,根据第七个实施例,现在可以根据保存在虚拟信息存储单元103中的CG的属性来自动控制切换是否对图像执行倾斜校正。虽然已给出本实施例的示例描述的将选择单元112增加到根据第一个实施例的配置,但是可替换地可将选择单元112增加到其它实施例的配置,并且仅当用户选择执行这种校正处理时才设置执行上述的校正处理。

[第八个实施例]

根据第八个实施例的图像处理设备向HMD 200和固定显示器300输出由佩戴HMD并体验混合现实的观察者所看到的图像。在这种情况下,普通的混合现实图像被显示在HMD 200上,而普通的混合现实图像、或校正倾斜的混合现实图像被显示在固定显示器300上。虽然第八个实施例的配置和控制与第三个实施例的配置和控制之间存在许多相似,但是不同于第三个实施例,第八个实施例根据保存在虚拟信息存储单元103中的CG的属性对具有特定属性的CG的部分不执行倾斜校正。

图12是示出了根据本实施例的图像处理设备的功能配置概要的框图。与第三个实施例相比较,第三虚像生成单元113被进一步加入到第八个实施例。关于本实施例的配置与控制,现在仅将描述它的不同于第三个实施例的部分。

基于来自位置和取向测量单元102和虚拟信息存储单元103的信息,第三虚像生成单元113执行CG绘制以生成虚像。第三虚像生成单元113向第二图像合成单元108输出生成的虚像。尽管第三虚像生成单元113的处理的具体细节与虚像生成单元105的相同,但在本实施例中,第三虚像生成单元113仅对被保存在虚拟信息存储单元103的CG对象中的包括字符信息的CG对象执行呈现。

在本实施例中,第二虚像生成单元111仅对被保存在虚拟信息存储单元103的CG对象中的不包括字符信息的CG对象执行呈现。其它处理的细节与第三个实施例相同。可使用结合第七个实施例描述的方法执行字符信息是否存在的确定。

第二图像合成单元108分别接收从成像单元106输出的实像旋转20得到的图像、从第二虚像生成单元111输出的校正倾斜的虚像、及从第三虚像生成单元113输出的未校正倾斜的虚像作为输入。第二图像合成单元108向第二显示单元110输出生成的混合现实图像。

配置本实施例使得对被保存的CG对象中的不包括字符信息的CG对象执行倾斜校正,而对包括字符信息的CG对象不执行倾斜校正。但是,本实施例不限于这个设置。例如,可使用字符信息以外的属性将CG对象分类成为对其执行倾斜校正的那些对象和对其不执行倾斜校正的那些对象。

如上所述,根据第八个实施例,依照保存在虚拟信息存储单元103中的CG对象的属性来自动执行确定是否对图像执行倾斜校正,并根据这种确定结果控制校正处理。换句话说,在期望对图像不执行倾斜校正的CG,对图像将不执行倾斜校正,而校正倾斜的混合现实图像将被呈现给其它CG。因此,依照CG的属性,可将合适的图像提供给固定显示设备300。虽然已给出本实施例的示例描述中将选择单元112增加到根据第一个实施例的配置,但是可替换地将选择单元112增加到其它实施例的配置,并且仅当用户选择执行这种校正处理时才设置执行上述的校正处理。

[第九个实施例]

根据第九个实施例的图像处理设备向HMD 200和固定显示器300输出由佩戴HMD并体验混合现实的观察者所看到的图像。在这种情况下,普通的混合现实图像被显示在HMD 200上,而校正倾斜的混合现实图像被显示在固定显示器300上。虽然在第九个实施例的配置和控制与第一个实施例的配置和控制之间存在许多相似,但是不同于第一个实施例,设置第九个实施例使得仅对实像执行倾斜校正,并且对虚像不执行倾斜校正。例如,当确定保存在虚拟信息存储单元103中的CG对象全部由字符信息组成时,仅对实像执行倾斜校正。

图13是示出了根据本实施例的图像处理设备的功能配置概要的框图。与第一个实施例相比较,第九个实施例区别在于现在仅有一个图像旋转单元106。关于本实施例的配置,现在仅将描述它的不同于第一个实施例的部分。

在本实施例中,混合现实呈现设备100从成像单元101获取捕获的实像,基于HMD 200的取向(成像单元101)创建虚像,检测实像的倾斜,并且基于检测的实像倾斜校正实像。此外,混合现实呈现设备100基于倾斜校正的实像和所述虚像生成合成图像,并且向固定显示设备300输出校正的合成图像。

在本实施例中,基于来自位置和取向测量单元102和虚拟信息存储单元103的信息,虚像生成单元105执行CG绘制以生成虚像。虚像生成单元105向第一图像合成单元107输出生成的虚像。

在本实施例中,第二图像合成单元108将虚像生成单元105输出的未校正的虚像叠加到从图像旋转单元106输出的旋转后的实像。第二图像合成单元108生成的混合现实图像被输出到第二显示单元110。

如上所述,在CG对象被限定为全部由字符信息构成的情况下,根据第九个实施例的配置使得仅对实像执行倾斜校正。

[第十个实施例]

根据第十个实施例的图像处理设备向HMD 200和固定显示器300输出由佩戴HMD并体验混合现实的观察者所看到的图像。在这种情况下,普通的混合现实图像被显示在HMD 200上,而校正倾斜的混合现实图像被显示在固定显示器300上。虽然第十个实施例的配置和控制与第一个实施例的配置和控制之间存在许多相似,但是不同于第一个实施例,第十个实施例被设置为对倾斜校正已应用于其上的混合现实图像执行有效区域的修整。通过这种执行,本实施例的配置能阻止混合现实图像中出现缺陷。

根据本实施例的图像处理设备的功能配置具有与第一个实施例的功能配置(图1)相同的概要。关于本实施例的配置,现在仅将描述它的不同于第一个实施例的部分。

在本实施例中,第二图像合成单元108在从两个图像旋转单元106输出的旋转后的实像上叠加从其它图像旋转单元106输出的旋转后的虚像,此外还执行修整,并且生成混合现实图像。第二图像合成单元108向第二显示单元110输出生成的混合现实图像。现在将描述根据本实施例的第二图像合成单元108执行的修整。

在本实施例中,在从图像旋转单元106输出的旋转后的混合现实图像中已出现缺陷。图14是描述旋转后的图像21中出现缺陷的示意图,其是通过旋转在旋转之前的图像11而创建的图像。由于旋转之后的图像21中阴影区表示的区域不存在于旋转之前的图像11中,所以旋转之后的图像21中不能表示这区域。因此,在旋转之后的图像21中出现了缺陷。

在本实施例中,如图15所示,对旋转之后的图像20的有效区域执行修整,以获得修整图像30。图15是由第二图像合成单元108执行的修整的解释示意图图。在这种情况下,修整是指在输出到固定显示单元300的图像和固定显示单元300的显示区的重叠部分中包括的矩形图像中的处理。注意的是,矩形图像的边平行于显示区的各个边的任何一个。

一般地,根据图像以其旋转的角度(滚转角),旋转之后的图像20的有效区域不同。在本实施例中,对于旋转之后的图像20,不管旋转角是多少总以90度的滚转角执行有效区域的修整。结果,对任意角度都可获得没有缺陷的修整图像30。

此外,在本实施例中,虽然除了根据第一个实施例的图像处理设备的配置之外还执行混合现实图像的修整,但是修整也可应用于根据第二和第四到第九实施例的配置。但是,当将上述的修整应用到根据第四个实施例的配置时,将由图像旋转单元106执行修整。

如上所述,在根据本实施例的配置中,提取并输出在输出图像和固定显示单元300的显示区的叠加部分中包括的矩形图像,使得矩形图像的各边之一平行于显示区的任何一边。因此,根据本实施例的配置允许呈现没有由于旋转所导致的缺陷的混合现实图像。

[第十一个实施例]

根据第十一个实施例的图像处理设备向HMD 200和固定显示器300输出由佩戴HMD并体验混合现实的观察者所看到的图像。在这种情况下,普通的混合现实图像显示在HMD 200上,而校正倾斜的混合现实图像显示在固定显示器300上。虽然第十一个实施例的配置和控制与第一个实施例的配置和控制之间存在许多相似,但是不同于第一个实施例,第十一个实施例被设置为检测相对于某个参考值的图像的相对倾斜以进行校正。现在可将佩戴HMD 200观察者的头倾斜的状态(例如,当向下注视一个对象时)用作一个参考,来校正在固定设备300上显示的混合现实图像的倾斜。换句话说,保持其中固定显示设备300上显示的混合现实图像被所述参考值倾斜这一状态不变。

根据本实施例的功能配置的概要与第一个实施例的(图1)相同。关于本实施例的配置,现在仅将描述它的不同于第一个实施例的部分。

在本实施例中,倾斜检测单元104接收来自位置和取向测量单元102的关于佩戴HMD 200的观察者的观察点取向的信息作为输入,检测实像的倾斜,并且向图像旋转单元106输出检测的倾斜。在本实施例中,通过从安装在HMD 200中的位置和取向测量单元102输出的取向提取一个滚转角来检测所述实像的倾斜,其中当所述观察点为旋转轴时所述滚转角是一个旋转角。此时,从提取的滚转角中减去一个旋转参考值,并且减后的值被传送给图像旋转单元106。所述旋转参考值保存在混合现实呈现设备100中提供的未显示的盘设备或RAM等中,并且根据本实施例在图像处理设备的初始化过程中被设置。在替换设置中,可通过图像处理设备中单独提供的输入单元的用户操作来修改所述旋转参考值。

如上所述,使用根据第十一个实施例的配置,现在可以保持固定显示设备300上显示的混合现实图像由参考值倾斜这一状态不变。

[其它的实施例]

虽然上面已详细描述本发明的示例可仿效的实施例,但是本发明可采取形式为例如系统、设备、方法、程序或存储媒介。更具体地,本发明可应用于由多个装置构成的系统或由单个装置构成的设备。

本发明也包括这样一些情况,在这里实现上述实施例功能的软件程序被直接或远程提供给系统或设备,并且所述功能由读取和执行提供的系统或设备程序代码的计算机实现。

因此,程序代码本身(其将被安装到计算机以使得计算机能实现本发明的功能和处理)也被包括在本发明的技术范围。换句话说,本发明也包括实现本发明的功能和处理的计算机程序本身。

在这种情况下,只要保留程序功能,程序可采取的形式例如为目标代码、编译器可执行程序、或供给OS的用于执行的脚本数据。

例如,提供程序的记录媒介包括软(注册商标)盘、硬盘、光盘、磁光盘、MO、CD-ROM、CD-R、CD-RW,磁带、非易失性存储卡、ROM、DVD(DVD-ROM、DVD-R)等。

提供程序的其它方法可包括这些情况,其中客户计算机的浏览器用于连接因特网主页,以将根据本发明的计算机程序或具有自动安装功能的压缩文件下载进记录媒介如硬盘。此外,也可通过将包括本发明程序的程序代码划分为多个文件和并且从不同的主页下载每个文件来实现本发明。换句话说,WWW服务器也包括于本发明,WWW服务器允许由多个用户在计算机上下载实现本发明的功能和处理的程序代码。

此外,也可以通过首先编码根据本发明的程序并且将编码程序存储于将分配给用户的存储媒介如CD-ROM来提供程序。随后,将允许满足某种条件的用户通过因特网从主页下载解码的关键信息。所述关键信息可用于执行所述编码程序以在计算机上安装它,以实现本发明。

通过由计算机执行读取程序也可实现上述实施例的功能。换句话说,通过由在计算机上运行的OS等执行的处理,可实现上述实施例的功能,其中OS等基于来自程序的指令执行部分的或所有的实际处理。

此外,通过使所述程序从存储媒介读出、写入到被插入计算机或连接到计算机的功能扩展单元的功能扩展主板上提供的存储器,也可实现上述实施例的功能。换句话说,通过功能扩展板或功能扩展单元上提供的CPU等基于程序指令来执行部分的或所有的实际处理,也可完成上述实施例的功能。

根据本发明,可提供一种技术,能够向佩戴HMD的观察者和不佩戴HMD的第三人分别呈现合适的混合现实图像。

虽然参考示例实施例描述本发明,但是将理解的是,本发明不限于公开的示例实施例。将给予下面的权利要求的范围最宽广的解释,以便包括所有这种修改和等价结构和功能。

Claims (16)

1.一种连接到第一显示设备的信息处理设备,所述信息处理设备包括:

获取单元,适合获取由成像设备捕获的实像;

生成单元,适合基于所述成像设备的取向生成虚像;

检测单元,适合检测所述实像的倾斜;

校正单元,适合基于检测到的所述实像的倾斜来校正所述实像;

合成单元,适合基于所述校正的实像和所述虚像生成校正的合成图像;和

输出单元,适合向所述第一显示设备输出所述校正的合成图像。

2.根据权利要求1的信息处理设备,其中

所述校正单元基于所述实像的倾斜来校正由所述生成单元生成的所述虚像,和

所述合成单元使用校正的实像和校正的虚像生成合成图像。

3.根据权利要求1的信息处理设备,其中

所述生成单元基于所述成像设备的取向和所述实像的倾斜来生成所述虚像,和

所述合成单元使用所述校正的实像以及基于所述成像设备的取向和所述实像的倾斜生成的所述虚像来生成合成图像。

4.根据权利要求1的信息处理设备,进一步包括第二合成单元,适合基于未校正的实像和所述虚像生成合成图像;其中

所述第二合成单元生成的合成图像被输出到第二显示设备。

5.根据权利要求4的信息处理设备,其中

所述第一显示设备是固定显示器,并且所述第二显示设备是便携的显示器。

6.根据权利要求1的信息处理设备,其中

所述检测单元基于由6-自由度传感器测量的所述成像设备的取向、基于包括在所述实像中的标记图像的分析、或基于所述实像计算的光流中至少一个来执行所述检测。

7.根据权利要求1的信息处理设备,进一步包括:

确定单元,适合确定所述虚像是否包括字符;其中

当确定单元确定所述虚像不包括字符时,所述校正单元执行所述校正。

8.根据权利要求1的信息处理设备,其中

所述校正涉及图像旋转。

9.一种连接到显示设备的信息处理设备,该信息处理设备包括:

获取单元,适合获取由成像设备捕获的实像;

生成单元,适合基于所述成像设备的取向生成虚像;

合成单元,适合基于所述实像和所述虚像生成合成图像;

检测单元,适合检测所述实像的倾斜;

校正单元,适合基于检测到的实像的倾斜来校正所述合成图像;和

输出单元,适合向所述显示设备输出所述校正的合成图像。

10.一种图像处理设备,包括:

图像获取单元,适合获取图像;

检测单元,适合检测所述图像的倾斜;

图像生成单元,适合生成用于生成一个混合现实图像的图像,在所述混合现实图像中,虚像叠加在实际感测图像上;

第一校正单元,适合基于所述检测单元的检测结果校正由所述图像获取单元获取的所述图像;

第一合成单元,适合基于由所述图像生成单元生成的所述图像和由所述第一校正单元校正的图像生成所述混合现实图像;

第一输出单元,适合输出由所述第一合成单元生成的所述混合现实图像。

11.根据权利要求10的图像处理设备,进一步包括:

第二合成单元,适合基于由所述图像生成单元生成的所述图像和由所述图像获取单元获取的所述图像生成混合现实图像,在该混合现实图像中,虚像叠加在实际感测图像上;和

第二输出单元,适合输出由所述第二合成单元生成的所述混合现实图像。

12.根据权利要求10的图像处理设备,进一步包括:

第二校正单元,适合基于所述检测单元的检测结果校正所述图像生成单元生成的所述图像;和

第二输出单元,适合基于由所述图像获取单元获取的图像和由所述第二校正单元校正的图像生成混合现实图像,并且输出所述混合现实图像,在该混合现实图像中,虚像叠加在实际感测图像上。

13.一种图像处理设备,包括:

图像获取单元,适合获取图像;

检测单元,适合检测所述图像的倾斜;

图像生成单元,适合生成用于生成一个混合现实图像的图像,在该混合现实图像中,虚像叠加在实际感测图像上;

图像合成单元,适合基于由所述图像获取单元获取的图像和由所述图像生成单元生成的图像生成所述混合现实图像;

校正单元,适合基于所述检测单元的检测结果校正由所述图像合成单元生成的混合现实图像;和

第一输出单元,适合输出由所述校正单元校正的图像。

14.根据权利要求13的图像处理设备,进一步包括:

第二输出单元,适合输出由所述图像合成单元生成的所述混合现实图像。

15.一种用于信息处理设备的控制方法,该控制方法包括:

获取图像的图像获取步骤;

检测所述图像的倾斜的检测步骤;

生成图像的图像生成步骤,该图像被用于生成一个混合现实图像,在该混合现实图像中,虚像叠加在实际感测图像上;

基于所述检测步骤的检测结果,校正所述图像获取步骤中获取的图像的校正步骤;

基于在所述图像生成步骤中生成的图像和在所述校正步骤中校正的图像,生成所述混合现实图像的第一合成步骤;和

输出在所述第一合成步骤中生成的所述混合现实图像的第一输出步骤。

16.一种用于信息处理设备的控制方法,该控制方法包括:

获取图像的图像获取步骤;

检测所述图像的倾斜的检测步骤;

生成图像的图像生成步骤,该图像被用于生成一个混合现实图像,在该混合现实图像中,虚像叠加在实际感测图像上;

基于在所述图像获取步骤中获取的图像和在所述图像生成步骤中生成的图像,生成所述混合现实图像的合成步骤;

基于所述检测步骤的检测结果,校正在所述图像合成步骤中生成的混合现实图像的校正步骤;和

输出在所述校正步骤中校正的图像的第一输出步骤。

Applications Claiming Priority (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2006128579 | 2006-05-02 | ||

| JP2006128579A JP4810295B2 (ja) | 2006-05-02 | 2006-05-02 | 情報処理装置及びその制御方法、画像処理装置、プログラム、記憶媒体 |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| CN101067762A CN101067762A (zh) | 2007-11-07 |

| CN100557553C true CN100557553C (zh) | 2009-11-04 |

Family

ID=38355560

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| CNB2007101021965A Expired - Fee Related CN100557553C (zh) | 2006-05-02 | 2007-04-29 | 信息处理设备及其控制方法和图像处理设备 |

Country Status (4)

| Country | Link |

|---|---|

| US (1) | US20070258658A1 (zh) |

| EP (1) | EP1852828A3 (zh) |

| JP (1) | JP4810295B2 (zh) |

| CN (1) | CN100557553C (zh) |

Cited By (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN104685869A (zh) * | 2012-09-27 | 2015-06-03 | 京瓷株式会社 | 显示装置、控制方法和控制程序 |

| CN105683813A (zh) * | 2013-11-11 | 2016-06-15 | Lg电子株式会社 | 头戴式显示器及其控制方法 |

Families Citing this family (33)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP5247590B2 (ja) * | 2009-05-21 | 2013-07-24 | キヤノン株式会社 | 情報処理装置及びキャリブレーション処理方法 |

| CN101995941B (zh) * | 2009-08-13 | 2012-05-23 | 昆山扬明光学有限公司 | 头戴式显示系统 |

| JP2011090400A (ja) * | 2009-10-20 | 2011-05-06 | Sony Corp | 画像表示装置および方法、並びにプログラム |

| CN101794193A (zh) * | 2010-02-23 | 2010-08-04 | 华为终端有限公司 | 画面控制方法及电子设备 |

| WO2012063542A1 (ja) | 2010-11-09 | 2012-05-18 | 富士フイルム株式会社 | 拡張現実感提供装置 |

| JP5704313B2 (ja) * | 2010-11-16 | 2015-04-22 | セイコーエプソン株式会社 | 映像表示装置及び映像表示方法 |

| JP2012160898A (ja) * | 2011-01-31 | 2012-08-23 | Brother Ind Ltd | 画像処理装置 |

| TWI436241B (zh) * | 2011-07-01 | 2014-05-01 | J Mex Inc | 遙控裝置及將其用於校正螢幕的控制系統及方法 |

| FR2984057B1 (fr) | 2011-12-13 | 2014-01-03 | Solidanim | Systeme de tournage de film video |

| GB201208088D0 (en) * | 2012-05-09 | 2012-06-20 | Ncam Sollutions Ltd | Ncam |

| KR101995258B1 (ko) * | 2012-05-14 | 2019-07-02 | 삼성전자 주식회사 | 카메라를 구비하는 휴대단말기의 동영상 촬영장치 및 방법 |

| US10666860B2 (en) * | 2012-09-11 | 2020-05-26 | Ricoh Company, Ltd. | Image processor, image processing method and program, and imaging system |

| JP6159069B2 (ja) * | 2012-09-27 | 2017-07-05 | 京セラ株式会社 | 表示装置 |

| JP6143469B2 (ja) * | 2013-01-17 | 2017-06-07 | キヤノン株式会社 | 情報処理装置、情報処理方法及びプログラム |

| JP6138566B2 (ja) * | 2013-04-24 | 2017-05-31 | 川崎重工業株式会社 | 部品取付作業支援システムおよび部品取付方法 |

| JP5884811B2 (ja) * | 2013-11-18 | 2016-03-15 | コニカミノルタ株式会社 | Ar表示装置、ar表示制御装置、印刷条件設定システム、印刷システム、印刷設定表示方法およびプログラム |

| JP2016110319A (ja) * | 2014-12-04 | 2016-06-20 | ソニー株式会社 | 表示制御装置、表示制御方法およびプログラム |

| EP3046080A3 (en) * | 2015-01-14 | 2016-11-30 | Ricoh Company, Ltd. | Information processing apparatus, information processing method, and computer-readable recording medium |

| CN106157924B (zh) * | 2015-04-01 | 2020-05-26 | 联想(北京)有限公司 | 一种电子设备和信息处理方法 |

| US10545714B2 (en) * | 2015-09-04 | 2020-01-28 | Samsung Electronics Co., Ltd. | Dual screen head mounted display |

| CN105353878B (zh) * | 2015-11-10 | 2019-02-01 | 华勤通讯技术有限公司 | 现实增强信息处理方法、装置及系统 |

| JP6532393B2 (ja) | 2015-12-02 | 2019-06-19 | 株式会社ソニー・インタラクティブエンタテインメント | 表示制御装置及び表示制御方法 |

| JP6640876B2 (ja) * | 2015-12-22 | 2020-02-05 | シャープ株式会社 | 作業支援装置、作業支援方法、作業支援プログラム、及び記録媒体 |

| JP6604314B2 (ja) * | 2016-11-15 | 2019-11-13 | 京セラドキュメントソリューションズ株式会社 | 画像読取装置、画像形成装置、画像読取方法 |

| US10248191B2 (en) * | 2016-12-12 | 2019-04-02 | Microsoft Technology Licensing, Llc | Virtual rigid framework for sensor subsystem |

| JP7013128B2 (ja) * | 2017-01-27 | 2022-01-31 | キヤノン株式会社 | 画像表示装置、画像表示方法及びプログラム |

| JP7148779B2 (ja) * | 2017-07-31 | 2022-10-06 | キヤノンマーケティングジャパン株式会社 | 画像処理装置と、その処理方法、プログラム |

| JP7319575B2 (ja) * | 2017-07-31 | 2023-08-02 | キヤノンマーケティングジャパン株式会社 | 画像処理装置と、その処理方法、プログラム |

| EP3454300A1 (en) * | 2017-09-12 | 2019-03-13 | HTC Corporation | Three dimensional reconstruction method, apparatus and non-transitory computer readable storage medium thereof |

| JP7057197B2 (ja) * | 2018-04-12 | 2022-04-19 | キヤノン株式会社 | 画像処理装置、画像処理方法、およびプログラム |

| JP7462591B2 (ja) * | 2020-03-26 | 2024-04-05 | 株式会社ソニー・インタラクティブエンタテインメント | 表示制御装置及び表示制御方法 |

| JP7030906B2 (ja) * | 2020-07-17 | 2022-03-07 | キヤノン株式会社 | 情報処理装置、情報処理方法及びプログラム |

| CN113068003A (zh) * | 2021-01-29 | 2021-07-02 | 深兰科技(上海)有限公司 | 数据显示方法、装置、智能眼镜、电子设备和存储介质 |

Citations (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN1340798A (zh) * | 2000-05-26 | 2002-03-20 | 精工爱普生株式会社 | 图像处理电路和图像数据处理方法、电光装置及电子设备 |

| US6445815B1 (en) * | 1998-05-08 | 2002-09-03 | Canon Kabushiki Kaisha | Measurement of depth image considering time delay |

| US6624853B1 (en) * | 1998-03-20 | 2003-09-23 | Nurakhmed Nurislamovich Latypov | Method and system for creating video programs with interaction of an actor with objects of a virtual space and the objects to one another |

| CN1451243A (zh) * | 2000-02-11 | 2003-10-22 | 福特维索麦迪卡股份公司 | 用于俘获三维图象的设备的设计,功能与应用 |

Family Cites Families (22)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US4876488A (en) * | 1987-09-30 | 1989-10-24 | The Boeing Company | Raster rotation circuit |

| US5841409A (en) * | 1995-04-18 | 1998-11-24 | Minolta Co., Ltd. | Image display apparatus |

| JPH10164426A (ja) | 1996-11-28 | 1998-06-19 | Nikon Corp | 電子カメラ |

| JPH11252523A (ja) * | 1998-03-05 | 1999-09-17 | Nippon Telegr & Teleph Corp <Ntt> | 仮想空間画像の生成装置および仮想空間システム |

| JP3363861B2 (ja) | 2000-01-13 | 2003-01-08 | キヤノン株式会社 | 複合現実感提示装置及び複合現実感提示方法並びに記憶媒体 |

| US7110013B2 (en) * | 2000-03-15 | 2006-09-19 | Information Decision Technology | Augmented reality display integrated with self-contained breathing apparatus |

| US6903707B2 (en) * | 2000-08-09 | 2005-06-07 | Information Decision Technologies, Llc | Method for using a motorized camera mount for tracking in augmented reality |

| US7312766B1 (en) * | 2000-09-22 | 2007-12-25 | Canadian Space Agency | Method and system for time/motion compensation for head mounted displays |

| US7190825B2 (en) * | 2001-08-17 | 2007-03-13 | Geo-Rae Co., Ltd. | Portable communication device for stereoscopic image display and transmission |

| JP3805231B2 (ja) * | 2001-10-26 | 2006-08-02 | キヤノン株式会社 | 画像表示装置及びその方法並びに記憶媒体 |

| US20030179308A1 (en) * | 2002-03-19 | 2003-09-25 | Lucia Zamorano | Augmented tracking using video, computed data and/or sensing technologies |

| JP2004085476A (ja) * | 2002-08-28 | 2004-03-18 | Sony Corp | ヘッドトラッキング方法及び装置 |

| US7427996B2 (en) * | 2002-10-16 | 2008-09-23 | Canon Kabushiki Kaisha | Image processing apparatus and image processing method |

| JP2004213355A (ja) * | 2002-12-27 | 2004-07-29 | Canon Inc | 情報処理方法 |

| EP1599036A1 (en) * | 2003-02-25 | 2005-11-23 | Matsushita Electric Industrial Co., Ltd. | Image pickup processing method and image pickup apparatus |

| JP4406824B2 (ja) * | 2003-08-21 | 2010-02-03 | ソニー株式会社 | 画像表示装置、画素データ取得方法、およびその方法を実行させるためのプログラム |

| JP4502361B2 (ja) * | 2003-09-30 | 2010-07-14 | キヤノン株式会社 | 指標姿勢検出方法および装置 |

| JP4272966B2 (ja) * | 2003-10-14 | 2009-06-03 | 和郎 岩根 | 3dcg合成装置 |

| JP4373286B2 (ja) * | 2004-05-06 | 2009-11-25 | オリンパス株式会社 | 頭部装着型表示装置 |

| JP4336245B2 (ja) * | 2004-05-18 | 2009-09-30 | 矢崎総業株式会社 | ヘッドアップディスプレイ装置 |

| KR100656342B1 (ko) * | 2004-12-16 | 2006-12-11 | 한국전자통신연구원 | 다중 입체 영상 혼합 제시용 시각 인터페이스 장치 |

| US20060250322A1 (en) * | 2005-05-09 | 2006-11-09 | Optics 1, Inc. | Dynamic vergence and focus control for head-mounted displays |

-

2006

- 2006-05-02 JP JP2006128579A patent/JP4810295B2/ja not_active Expired - Fee Related

-

2007

- 2007-04-25 US US11/739,925 patent/US20070258658A1/en not_active Abandoned

- 2007-04-29 CN CNB2007101021965A patent/CN100557553C/zh not_active Expired - Fee Related

- 2007-04-30 EP EP07107202A patent/EP1852828A3/en not_active Withdrawn

Patent Citations (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US6624853B1 (en) * | 1998-03-20 | 2003-09-23 | Nurakhmed Nurislamovich Latypov | Method and system for creating video programs with interaction of an actor with objects of a virtual space and the objects to one another |

| US6445815B1 (en) * | 1998-05-08 | 2002-09-03 | Canon Kabushiki Kaisha | Measurement of depth image considering time delay |

| CN1451243A (zh) * | 2000-02-11 | 2003-10-22 | 福特维索麦迪卡股份公司 | 用于俘获三维图象的设备的设计,功能与应用 |

| CN1340798A (zh) * | 2000-05-26 | 2002-03-20 | 精工爱普生株式会社 | 图像处理电路和图像数据处理方法、电光装置及电子设备 |

Cited By (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN104685869A (zh) * | 2012-09-27 | 2015-06-03 | 京瓷株式会社 | 显示装置、控制方法和控制程序 |

| CN104685869B (zh) * | 2012-09-27 | 2018-12-28 | 京瓷株式会社 | 显示装置、控制方法 |

| US10341642B2 (en) | 2012-09-27 | 2019-07-02 | Kyocera Corporation | Display device, control method, and control program for stereoscopically displaying objects |

| CN105683813A (zh) * | 2013-11-11 | 2016-06-15 | Lg电子株式会社 | 头戴式显示器及其控制方法 |

Also Published As

| Publication number | Publication date |

|---|---|

| EP1852828A2 (en) | 2007-11-07 |

| CN101067762A (zh) | 2007-11-07 |

| JP2007299326A (ja) | 2007-11-15 |

| EP1852828A3 (en) | 2007-11-14 |

| US20070258658A1 (en) | 2007-11-08 |

| JP4810295B2 (ja) | 2011-11-09 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| CN100557553C (zh) | 信息处理设备及其控制方法和图像处理设备 | |

| US10893219B2 (en) | System and method for acquiring virtual and augmented reality scenes by a user | |

| AU2020202551B2 (en) | Method for representing points of interest in a view of a real environment on a mobile device and mobile device therefor | |

| CN100426198C (zh) | 校准方法和装置 | |

| US10140723B2 (en) | Information processing apparatus and method | |

| CN105934775B (zh) | 用于构建锚定在真实世界物体上的虚拟图像的方法和系统 | |

| CN105144283B (zh) | 用于基于设备旋转的图像操纵的方法及装置 | |

| JP4976756B2 (ja) | 情報処理方法および装置 | |

| CN105210009B (zh) | 显示控制装置、显示控制方法和记录介质 | |

| CN1380996A (zh) | 用于通过图象处理而不用三维建模来指示目标的设备和方法 | |

| AU2012238301A1 (en) | Combined object capturing system and display device and associated method | |

| JP5726024B2 (ja) | 情報処理方法および装置 | |

| JP6109213B2 (ja) | 情報処理装置および方法、プログラム | |

| CN116524154A (zh) | 一种ar系统及ar设备 | |

| BARON et al. | APPLICATION OF AUGMENTED REALITY TOOLS TO THE DESIGN PREPARATION OF PRODUCTION. | |

| CN105630170B (zh) | 一种信息处理方法及电子设备 | |

| CN110287872A (zh) | 一种基于移动终端的兴趣点视线方向识别方法及装置 | |

| Piszczek et al. | Elements of Augmented Reality for Vision Systems | |

| Laberge et al. | An auto-calibrated laser-pointing interface for collaborative environments | |

| KR101855105B1 (ko) | 헤드 마운트 디스플레이에서의 눈의 초점 위치 분석 시스템 및 그 방법 | |

| Pourazar et al. | A Comprehensive Framework for Evaluation of Stereo Correspondence Solutions in Immersive Augmented and Virtual Realities | |

| Tahir | Global Positioning System (GPS) Based Location Finder on Android | |

| CN118796049A (zh) | 定位方法、第二电子设备及电子设备系统 | |

| Williams | Real-Time Hybrid Tracking for Outdoor Augmented Reality | |

| Järleberg | Stabilizing Projected Points inAugmented Reality Applications |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| C06 | Publication | ||

| PB01 | Publication | ||

| C10 | Entry into substantive examination | ||

| SE01 | Entry into force of request for substantive examination | ||

| C14 | Grant of patent or utility model | ||

| GR01 | Patent grant | ||

| CF01 | Termination of patent right due to non-payment of annual fee | ||

| CF01 | Termination of patent right due to non-payment of annual fee |

Granted publication date: 20091104 Termination date: 20180429 |