WO2021100513A1 - 放射線撮影システム、放射線撮影方法、画像処理装置およびプログラム - Google Patents

放射線撮影システム、放射線撮影方法、画像処理装置およびプログラム Download PDFInfo

- Publication number

- WO2021100513A1 WO2021100513A1 PCT/JP2020/041695 JP2020041695W WO2021100513A1 WO 2021100513 A1 WO2021100513 A1 WO 2021100513A1 JP 2020041695 W JP2020041695 W JP 2020041695W WO 2021100513 A1 WO2021100513 A1 WO 2021100513A1

- Authority

- WO

- WIPO (PCT)

- Prior art keywords

- image

- information indicating

- skeleton

- optical image

- joint angle

- Prior art date

Links

- 238000003384 imaging method Methods 0.000 title claims abstract description 84

- 230000005855 radiation Effects 0.000 title claims abstract description 47

- 238000012545 processing Methods 0.000 title claims description 26

- 230000003287 optical effect Effects 0.000 claims abstract description 148

- 238000002601 radiography Methods 0.000 claims description 99

- 238000000034 method Methods 0.000 claims description 27

- 238000004891 communication Methods 0.000 description 8

- 238000012986 modification Methods 0.000 description 7

- 230000004048 modification Effects 0.000 description 7

- 238000010586 diagram Methods 0.000 description 6

- 238000010801 machine learning Methods 0.000 description 6

- 230000006870 function Effects 0.000 description 3

- 238000007689 inspection Methods 0.000 description 3

- 238000013528 artificial neural network Methods 0.000 description 2

- 230000010365 information processing Effects 0.000 description 2

- 238000013135 deep learning Methods 0.000 description 1

- 230000007717 exclusion Effects 0.000 description 1

- 239000004973 liquid crystal related substance Substances 0.000 description 1

- 238000012706 support-vector machine Methods 0.000 description 1

- 230000002194 synthesizing effect Effects 0.000 description 1

- 238000003325 tomography Methods 0.000 description 1

- 238000012549 training Methods 0.000 description 1

- 230000007704 transition Effects 0.000 description 1

Images

Classifications

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B6/00—Apparatus or devices for radiation diagnosis; Apparatus or devices for radiation diagnosis combined with radiation therapy equipment

- A61B6/04—Positioning of patients; Tiltable beds or the like

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B6/00—Apparatus or devices for radiation diagnosis; Apparatus or devices for radiation diagnosis combined with radiation therapy equipment

- A61B6/46—Arrangements for interfacing with the operator or the patient

- A61B6/461—Displaying means of special interest

- A61B6/463—Displaying means of special interest characterised by displaying multiple images or images and diagnostic data on one display

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B6/00—Apparatus or devices for radiation diagnosis; Apparatus or devices for radiation diagnosis combined with radiation therapy equipment

- A61B6/54—Control of apparatus or devices for radiation diagnosis

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T1/00—General purpose image data processing

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T11/00—2D [Two Dimensional] image generation

- G06T11/20—Drawing from basic elements, e.g. lines or circles

- G06T11/206—Drawing of charts or graphs

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T11/00—2D [Two Dimensional] image generation

- G06T11/60—Editing figures and text; Combining figures or text

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T19/00—Manipulating 3D models or images for computer graphics

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/70—Determining position or orientation of objects or cameras

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B6/00—Apparatus or devices for radiation diagnosis; Apparatus or devices for radiation diagnosis combined with radiation therapy equipment

- A61B6/50—Apparatus or devices for radiation diagnosis; Apparatus or devices for radiation diagnosis combined with radiation therapy equipment specially adapted for specific body parts; specially adapted for specific clinical applications

- A61B6/505—Apparatus or devices for radiation diagnosis; Apparatus or devices for radiation diagnosis combined with radiation therapy equipment specially adapted for specific body parts; specially adapted for specific clinical applications for diagnosis of bone

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B6/00—Apparatus or devices for radiation diagnosis; Apparatus or devices for radiation diagnosis combined with radiation therapy equipment

- A61B6/52—Devices using data or image processing specially adapted for radiation diagnosis

- A61B6/5211—Devices using data or image processing specially adapted for radiation diagnosis involving processing of medical diagnostic data

- A61B6/5229—Devices using data or image processing specially adapted for radiation diagnosis involving processing of medical diagnostic data combining image data of a patient, e.g. combining a functional image with an anatomical image

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2200/00—Indexing scheme for image data processing or generation, in general

- G06T2200/24—Indexing scheme for image data processing or generation, in general involving graphical user interfaces [GUIs]

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/20—Special algorithmic details

- G06T2207/20081—Training; Learning

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30196—Human being; Person

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2210/00—Indexing scheme for image generation or computer graphics

- G06T2210/41—Medical

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2219/00—Indexing scheme for manipulating 3D models or images for computer graphics

- G06T2219/004—Annotating, labelling

Definitions

- the present invention relates to a radiography system, a radiography method, an image processing device, and a program.

- Patent Document 1 an optical camera is attached to a radiation generator, and an optical image taken by the optical camera when the radiation generator generates radiation is stored together with a radiation image and a patient's imaging condition. Then, a technique of generating a guide image from an optical image and superimposing the guide image on an optical moving image displayed on a display device of an imaging system at the time of subsequent imaging of the same patient is disclosed.

- the present invention has been made in view of the above problems, and an object of the present invention is to improve the reproducibility of positioning the patient's posture in imaging using a radiography system.

- the radiography system is based on an acquisition means for acquiring a radiographic image based on the radiation applied to the subject and a first optical image of the subject acquired at the first time point.

- a first generation means for generating a first processed image including at least one of information indicating the skeleton of the subject and information indicating the joint angle related to the first optical image, and the first generation means.

- a second generation means for generating a second processed image including at least one of the information, and a display control means for displaying the first processed image and the second processed image superimposed on the display unit. It is characterized by being prepared.

- the reproducibility of positioning the patient's posture can be improved in imaging using a radiography system.

- the radiological imaging system is a radiological imaging system that displays an optical image of a patient on a display device and enables positioning during radiographic imaging while viewing the optical image, and has a positioning accuracy during examination. The purpose is to improve.

- the image is displayed in the same posture in the past.

- Information indicating the skeleton and information indicating the joint angle related to the captured past images are superimposed.

- the inspector performs positioning based on the information indicating the superimposed and displayed skeleton and the joint angle related to the past image and the information indicating the skeleton and the joint angle superimposed and displayed on the current image. It can be carried out.

- a mode in which two pieces of information, information indicating the skeleton and information indicating the joint angle, are superimposed on the optical image will be described as an example, but it is not always necessary to superimpose the two pieces of information, and the information indicating the skeleton At least one of the information indicating the joint angle may be superimposed on the optical image.

- the information superimposed on the current image and the information superimposed on the past image match.

- the information superimposed on the current image and the information superimposed on the past image do not have to be exactly the same, and may be partially matched.

- the radiography system will be described as an example, but the modality for performing imaging may be an MRI apparatus, a three-dimensional ultrasonic imaging apparatus, a photoacoustic tomography apparatus, or the like. That is, the present invention can be applied to any device that is required to take pictures under the same conditions in the past and the present. Further, the optical image obtained by photographing the patient to be inspected does not necessarily have to be an image acquired by one image acquisition device, and may be an image obtained by a different image acquisition device.

- FIG. 1 is a configuration example of the entire radiography system of this embodiment.

- This system is composed of a radiography control device 100, a radiography imaging device 110, a radiation generator 120, and an image acquisition device 130 via a network 140.

- the network 140 may be a wired network or a wireless network.

- the radiography control device 100 is a device composed of an information processing device such as a computer that communicates with the radiography imaging device 110 and controls radiography. Further, the radiography control device 100 communicates with the radiation generator 120 and acquires information when radiation is irradiated from the radiation generator 120. Further, the radiography control device 100 communicates with the image acquisition device 130 to control the image acquisition device 130 and acquire the image captured by the image acquisition device 130.

- an information processing device such as a computer that communicates with the radiography imaging device 110 and controls radiography. Further, the radiography control device 100 communicates with the radiation generator 120 and acquires information when radiation is irradiated from the radiation generator 120. Further, the radiography control device 100 communicates with the image acquisition device 130 to control the image acquisition device 130 and acquire the image captured by the image acquisition device 130.

- the radiography apparatus 110 is an apparatus including an FPD (Flat Panel Detector) and the like, and generates a radiographic image based on the incident radiation.

- the transition to the imaging enable state is performed according to the instruction from the radiography control device 100.

- it is a device that performs radiation imaging under predetermined imaging conditions set by the user while synchronizing with the radiation generator 120, and generates an image based on the radiation emitted from the radiation generator 120. That is, the radiography apparatus 110 corresponds to an example of an acquisition means for acquiring a radiographic image based on the radiation applied to the subject.

- the number of radiographic imaging devices 110 is not limited to one, and a configuration in which a plurality of radiographic imaging devices are used may be used.

- the radiation generator 120 detects the radiation irradiation instruction by the exposure switch 121 and generates radiation from the tube 122 based on the irradiation information set by the user input device (not shown) that accepts the user operation such as the operation panel. It is a device to make it.

- the image acquisition device 130 is a device that acquires an image by taking an image according to an instruction from the radiography control device 100.

- an optical camera is used in the image acquisition device 130 to acquire an optical image. That is, the image acquisition device 130 acquires an optical image by optically photographing the subject.

- the image acquisition device 130 is attached to the tube 122 to take an image of the radiation generation direction of the tube 122.

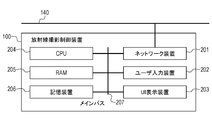

- FIG. 2 is a hardware configuration example of the radiography control device 100 of the radiography imaging system of the present embodiment.

- the radiography control device 100 includes a network device 201 connected to the network 140, a user input device 202 that accepts user operations such as a keyboard, and the like.

- the radiological imaging control device 100 includes an operation screen such as a liquid crystal display, a UI display device 203 for displaying a radiographic image, and a CPU 204 for controlling the entire radiographic imaging control device.

- an operation screen such as a liquid crystal display

- a UI display device 203 for displaying a radiographic image

- a CPU 204 for controlling the entire radiographic imaging control device.

- the radiography control device 100 is a storage device 206 that stores a RAM 205 that provides a workspace for the CPU 204, various control programs, a radiographic image received from the radiography camera 110, and image information received from the image acquisition device 130. Has.

- each device constituting the radiography control device 100 is connected by the main bus 207, and data can be transmitted and received to each other.

- the user input device 202 and the UI display device 203 are described as separate devices, an operation unit in which these devices are integrated may be used.

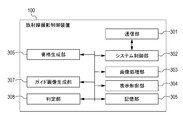

- FIG. 3 is an example of the functional configuration of the radiography control device 100 of the radiography imaging system of the present embodiment.

- Each functional unit shown in FIG. 3 is realized by the CPU 204 on the radiography control device 100 reading the control program stored in the storage device 206 onto the RAM 205 and executing the control program.

- the radiography control device 100 includes a communication unit 301, a system control unit 302, an image processing unit 303, a display control unit 304, a storage unit 305, a skeleton generation unit 306, a guide image generation unit 307, and a determination unit 308.

- the communication unit 301 is software that controls the network device 201 to perform communication.

- the system control unit 302 controls the image acquisition device 130, acquires irradiation information of the radiation generator 120 and imaging information of the radiation imaging device 110, and manages the respective states via the communication unit 301. Further, the system control unit 302 acquires a radiographic image from the radiographic imaging device 110 and an optical image from the image acquisition device 130 via the communication unit 301.

- system control unit 302 is a program that realizes the basic functions of the radiography control device 100, and controls the operation of each unit.

- the image processing unit 303 processes the radiographic image acquired via the system control unit 302 to generate an image to be used by the radiography control device 100.

- the display control unit 304 displays the image generated by the image processing unit 303 via the UI display device 203. Further, the display control unit 304 displays the guide image generated by the guide image generation unit 307 via the UI display device 203. Further, the display control unit 304 displays the past guide image generated from the images taken in the same posture in the past via the UI display device 203. Further, the display control unit 304 reflects the processing on the image instructed by the system control unit 302 based on the operation from the user input device 202, performs the processing of switching the screen display of the UI display device 203, and the like.

- the storage unit 305 uses the radiation image generated by the image processing unit 303, the patient's imaging conditions (patient ID, examination ID, examination site, imaging direction, etc.) related to the radiation image, and the irradiation information (tube) of the radiation generator 120. Save voltage, tube current, etc.). In addition, the storage unit 305 also stores the guide image generated by the guide image generation unit 307 related to the radiographic image.

- the skeleton generation unit 306 estimates the patient's skeleton and joint angle in the optical image using the optical image obtained from the image acquisition device 130, and generates information indicating the skeleton and information indicating the joint angle. Specifically, the skeleton generation unit 306 currently uses a trained model obtained by performing machine learning using the captured optical image of the human body as input data and the captured skeleton and joint angle of the human body as labels. Estimate the patient's skeleton and joint angles in the image. Then, information indicating the skeleton and information indicating the joint angle are generated from the estimated skeleton and joint angle.

- the trained model is a machine learning model that follows a machine learning algorithm such as deep learning using a support vector machine or a neural network, and is trained using appropriate learning data in advance.

- the machine learning model is shown. It should be noted that the trained model does not require further learning, and additional learning can be performed.

- the training data is composed of one or more pairs of input data and output data (correct answer data).

- the trained model according to the present embodiment is a model constructed by supervised learning using a neural network, and has input data (optical image of a human body) and a label (skeleton of the human body, joint angle). The set is learned as learning data.

- the skeleton generation unit 306 uses a trained model learned as a set of a plurality of optical images of the human body, information indicating the skeleton of the plurality of optical images in the human body, and information indicating the joint angle. It corresponds to an example of an estimation means for estimating the skeleton and joint angle of a subject from the optical image of 1.

- the machine learning algorithm and learning data set used for learning are not limited to the above, and for example, the model for estimating the skeleton and the model for estimating the joint angle may be different.

- the skeleton generation unit 306 generates information indicating the skeleton and information indicating the joint angle, but it may be configured to generate at least one of them.

- the skeleton generation unit 306 generates information indicating the joint angle, but the joint position may be learned as a label as well as the joint angle with respect to the trained model. In that case, the joint position is indicated. Information can be generated in the same way.

- the configuration is not limited as long as the skeleton generation unit 306 can generate information indicating the patient's skeleton and information indicating the joint angle in the optical image using the optical image obtained from the image acquisition device 130.

- the skeleton of the patient in the optical image is shown by acquiring the position information having the optical image and the distance information from the image acquisition device 130, acquiring the coordinates of each joint of the patient, and applying it to the human body data saved in advance. Information and information indicating the joint angle may be generated.

- the guide image generation unit 307 uses the information indicating the skeleton generated by the skeleton generation unit 306, the information indicating the joint angle, and the optical image obtained from the image acquisition device 130, and the information indicating the skeleton and the joint on the optical image. Generates a guide image in which information indicating the angle is superimposed and displayed. That is, based on the first optical image of the subject acquired at the first time point, at least one of the information indicating the skeleton of the subject and the information indicating the joint angle related to the first optical image. A first processed image containing information is generated. After that, the guide image generation unit 307 instructs the display control unit 304 to display the guide image on the screen.

- the guide image generation unit 307 acquires the information of the past guide image of the patient stored in the storage unit 305, and the past guide image. To generate. That is, based on the second optical image of the subject acquired at a second time point different from the first time point, the information indicating the skeleton of the subject related to the second optical image and the said. A second processed image containing at least one of the information indicating the joint angle is generated.

- the information of the past guide image includes, for example, the past image, the information indicating the skeleton of the patient related to the past image, and the information indicating the joint angle.

- the past guide image shows, for example, an image in which information indicating a skeleton related to the past image and information indicating a joint angle are superimposed on the past image.

- the guide image generation unit 307 instructs the display control unit 304 to display the guide image on which the past guide image is superimposed on the screen.

- the determination unit 308 determines whether or not there is information that matches the past patient imaging conditions of the storage unit 305 based on the imaging conditions of the patient to be imaged that are input in advance to the radiography control device 100 by the user.

- the determination unit 308 uses at least information on the patient ID, examination ID, examination site, and imaging direction as the imaging conditions of the patient, but the information can be determined to match the imaging conditions of the past patient. If so, there are no restrictions on the configuration.

- the determination unit 308 uses the latest information as the matched information.

- the information used as the matched information is not limited to the above, and does not have to be the latest information.

- FIG. 4 is a flowchart showing an example of a display processing process at the time of patient imaging of the radiography control device 100.

- step S401 the system control unit 302 sets the radiography control device 100 to the inspection start state for performing imaging control based on the user operation. Specifically, the system control unit 302 transmits an instruction to prepare for imaging to the radiography imaging device 110 via the communication unit 301 based on the imaging conditions of the patient instructed by the user operation. When the radiography imaging device 110 is ready for imaging, the radiography imaging device 110 returns and sends a notification of completion of preparation for radiography to the radiography imaging control device 100. After receiving the preparation completion notification, the system control unit 302 sets the radiography imaging control device 100 in an imaging enable state and accepts step S411 described later. Further, the system control unit 302 transmits an instruction to start shooting to the image acquisition device 130 via the communication unit 301. After receiving the imaging start instruction, the image acquisition device 130 returns to the radiography imaging control device 100 and sequentially transmits the optical images acquired by itself.

- step S402 and S410 sequential parallel processing by the system control unit 302 is executed. That is, it is a reception of control processing and user control in steps S403, steps S404 to S406, steps S407 to S409, and other operations.

- the processing between steps is executed by the system control unit 302 until step S411 is executed or the inspection is stopped (not shown) by the user operation.

- the processing between S402 and S410 does not necessarily have to be parallel processing, and is generated from an optical image of a patient, a guide image generated from the optical image, and an optical image of the patient taken in the past. It suffices if the past guide image can be displayed on the display device.

- step S403 After executing the process of step S403, the process of steps S404 to S406 may be executed, and then the processes of steps S407 to S409 may be performed.

- step S403 the system control unit 302 displays the optical image acquired from the image acquisition device 130 via the communication unit 301 on the UI display device 203 via the display control unit 304.

- step S404 the skeleton generation unit 306 generates information indicating the patient's skeleton and information indicating the joint angle in the optical image based on the optical image acquired via the system control unit 302.

- step S405 the guide image generation unit 307 generates a guide image based on the information indicating the skeleton generated by the skeleton generation unit 306 and the information indicating the joint angle.

- step S406 the display control unit 304 displays the first superimposed image 502 on which the guide image as shown in FIG. 5 is superimposed on the optical image on the UI display device 203. That is, the display control unit 304 displays at least one of the information indicating the skeleton of the subject and the information indicating the joint angle related to the first optical image obtained by optically photographing the subject as the first optical image.

- the first processed image generated by superimposing on the display unit is displayed on the display unit.

- Steps S403 to S406 are steps of superimposing the information indicating the skeleton and the information indicating the joint angle on the optical image obtained by photographing the patient undergoing the examination in real time and displaying the information on the UI display device 203. ..

- the optical image 500 is an optical image acquired from the image acquisition device 130 displayed on the UI display device 203 in step S403.

- an object within the imaging range of the image acquisition device 130 is reflected, such as the presence of the radiographing device 110 behind the patient, but for the sake of explanation, the patient's body is reflected in the optical image 500.

- the guide image 501 is an image generated by the guide image generation unit 307 based on the information indicating the patient's skeleton and the information indicating the joint angle generated by the skeleton generation unit 306.

- the guide image generation unit 307 gives an instruction to superimpose and display the guide image 501 on the optical image 500 to the display control unit 304, and the optical image 500 on which the guide image 501 is superimposed and displayed is displayed as the first superposed image 502.

- the joint angle of the patient generated by the skeleton generation unit 306 is displayed at the angle position formed between the joint positions of the human body.

- the display method there is no limitation on the display method as long as it is a method of expressing the joint angle in which the location of the joint position of the human body is specified.

- steps S407 to S409 information indicating the patient's skeleton and information indicating the joint angle are superimposed on the optical image obtained by photographing the patient under the same imaging conditions in the past, and the information is displayed on the UI display device 203. It is a process.

- step S407 the determination unit 308 determines whether or not there is a past imaging condition that matches the imaging condition of the patient instructed to be examined by searching the storage unit 305.

- step S408 the guide image generation unit 307 determines the optical image and the skeleton associated with the optical image from the imaging conditions of the storage unit 305.

- the information indicating the above and the information indicating the joint angle are acquired, and the second superimposed image 701 is generated.

- step S409 the display control unit 304 superimposes the second superimposed image 701 on the optical image and the guide image as shown in FIG. 7, and displays them on the UI display device 203. That is, the display control unit 304 uses at least one of the information indicating the skeleton of the subject and the information indicating the joint angle stored in association with the second optical image taken in the past of the first optical image. The second processed image generated by superimposing on the optical image of 2 is displayed on the display unit.

- the radiography control device 100 does not generate the past guide image, that is, does not execute the processes from step S408 to step S409. ..

- FIG. 6 is a diagram showing an example of the configuration of patient information stored in the storage unit 305.

- the storage unit 305 has a past patient imaging condition table 600, and is composed of an imaging condition unit 601 and a guide image information unit 602.

- the imaging condition unit 601 stores the radiation image generated by the image processing unit 303, the imaging conditions of the patient related to the radiation image, the irradiation information of the radiation generator 120, and the like.

- the determination unit 308 uses at least information such as the patient ID, the examination ID, the examination site, and the imaging direction as the imaging conditions of the patient, but can be used for determining the matching of the imaging conditions of the past patients. As long as it is information, there are no restrictions on the configuration. Further, in the present embodiment, when the imaging conditions of a plurality of past patients match, the determination unit 308 uses the latest information as the matched information.

- the information used as the matched information is not limited to the above, and does not have to be the latest information.

- the guide image information unit 602 includes an optical image acquired from the image acquisition device 130 and information indicating the skeleton generated by the skeleton generation unit 306 and a joint angle stored in the imaging condition unit 601 when the radiation image is generated by the image processing unit 303. Memorize the information indicating.

- the optical image, the information indicating the skeleton associated with the optical image, and the information indicating the joint angle are stored in association with each other, but the guide image generated by the guide image generation unit 307 is also combined. It may be stored, or it may be configured to store only the guide image.

- the information indicating the skeleton and the information indicating the joint angle are stored as image information, but only the joint coordinate information of the information indicating the skeleton is stored, and the guide image generation unit 307 stores the information indicating the skeleton from the joint coordinate information.

- the configuration may be such that information indicating the skeleton and information indicating the joint angle are generated. That is, the information indicating the skeleton and the information indicating the joint angle do not necessarily have to be stored / displayed as image information as shown in FIG. 6, but may be simply stored / displayed as characters or numerical parameters.

- the guide image generation unit 307 refers to the imaging condition table 600 of the past patient in the storage unit 305, but there is no limitation on the configuration as long as the determination in step S407 can be performed. That is, the determination may be made using the information on the information processing device (not shown) having the imaging condition table 600 of the past patient via the network 140.

- FIG. 7 is a diagram showing an example of the configuration related to the display of the past guide image.

- the first superimposed image 700 is an image generated in the same manner as the above-mentioned first superimposed image 502.

- the guide image generation unit 307 displays an optical image that matches a predetermined imaging condition from the storage unit 305, information indicating the skeleton associated with the optical image, and information indicating the joint angle. Is an image generated based on them. Further, the guide image generation unit 307 gives an instruction to the display control unit 304 to superimpose and display the second superimposed image 701 on the first superimposed image 700. Then, the display control unit 304 that receives the display instruction displays the first superimposed image 700 in which the second superimposed image 701 is superimposed and displayed as the third superimposed image 702.

- step S411 the user presses the exposure switch 121 of the radiation generator 120 to start photographing.

- the radiation generator 120 When imaging is started, the radiation generator 120 generates radiation from the tube 122, the radiation that has passed through the patient is detected by the radiation imaging device 110, and the radiation imaging device generates a radiographic image. After that, the radiography imaging device 110 transmits a radiographic image to the radiography imaging control device 100. Further, in parallel with the processing, the radiation generator 120 transmits the irradiation information of the radiography to the radiography control device 100.

- step S412 the system control unit 302 stores the radiation image, the imaging conditions of the patient related to the radiation image, the irradiation information of the radiation generator 120, and the like in the storage unit 305. Further, in parallel with the above processing, the system control unit 302 stores the optical image at the time of photographing, the information indicating the skeleton associated with the optical image, and the information indicating the joint angle in the storage unit 305.

- the processing of the radiography system according to the present embodiment is performed.

- the display control unit 304 is a guide image generated based on the optical image acquired from the image acquisition device 130 at the start of the inspection, the information indicating the skeleton generated by the skeleton generation unit 306, and the information indicating the joint angle. Are superimposed and displayed on the UI display device 203. Further, the display control unit 304 determines a patient who has taken an image under the same imaging conditions in the past, and is based on an optical image of the past examination, information indicating a skeleton associated with the optical image, and information indicating a joint angle. The past guide image generated in this manner is superimposed and displayed on the UI display device 203.

- the inspector quantitatively positions the information based on the information indicating the skeleton superimposed on the past image and the information indicating the joint angle, and the information indicating the skeleton superimposed on the current image and the information indicating the joint angle. It can be performed.

- the display control unit 304 superimposes the information indicating the skeleton related to the current image and the information indicating the joint angle, and the information indicating the skeleton and the joint angle stored in association with the past image.

- the positioning accuracy was improved by superimposing and displaying the past image on which the information indicating the above is superimposed.

- the display control unit 304 changes the pixel value based on the information indicating the skeleton related to the current image and the information indicating the joint angle, and the skeleton stored in association with the past image.

- the past image whose pixel value is changed based on the information indicating the above and the information indicating the angle of the joint is superimposed and displayed.

- a guide image is generated by changing the pixel value of.

- the past guide image is generated by changing the pixel values of the pixels constituting the past image so that the information indicating the patient's skeleton and the information indicating the joint angle in the past image can be visually recognized.

- the examiner obtains the information indicating the skeleton superimposed and displayed on the past image and the information indicating the joint angle, and the information indicating the skeleton superimposed and displayed on the current image and the joint angle. Positioning can be performed quantitatively based on the information shown.

- the display control unit 304 superimposes the information indicating the skeleton related to the current image and the information indicating the joint angle, and the information indicating the skeleton and the joint angle stored in association with the past image.

- the positioning accuracy was improved by superimposing and displaying the past image on which the information indicating the above is superimposed.

- the display control unit 304 has only information indicating the skeleton related to the current image and information indicating the joint angle and information indicating the skeleton stored in association with the past image and information indicating the joint angle. Are superimposed and displayed.

- the guide image 501 as shown in FIG. 5 and the past guide image 901 as shown in FIG. 9 are superimposed and displayed.

- positioning can be performed based only on the information indicating the skeleton and the information indicating the angle of the joint without displaying the optical image of the patient, so that the patient's privacy is taken into consideration and the quantity is quantified. Positioning can be performed.

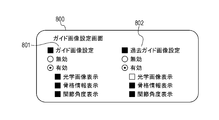

- FIG. 8 is a diagram showing an example of the configuration of the guide image setting screen of the radiography control device 100 of the present embodiment.

- the guide image generation unit 307 additionally has a guide image setting screen 800, and the guide image setting screen 800 is a display instruction from the system control unit 302 (for example, the user operates the radiography control device 100 and the system setting screen. It is displayed on the UI display device 203 by (for example, when the screen is selected from (not shown)).

- the guide image setting screen 800 has a guide image setting unit 801 and a past guide image setting unit 802.

- the guide image setting unit 801 has a setting related to the optical image and the guide image generated based on the information indicating the skeleton and the information indicating the joint angle related to the optical image.

- the radiography control device 100 does not generate the guide image. Specifically, the processes of steps S403 to S406 of FIG. 4 described above are not executed.

- the display of the optical image, the information indicating the skeleton associated with the optical image, and the information indicating the joint angle is additionally set. Of the items, only the items that are validly set by the user are displayed as the optical image and the guide image of the radiography control device 100. In the description of the present embodiment, the description will be continued with the display of the optical image, the information indicating the skeleton associated with the optical image, and the information indicating the joint angle enabled.

- the past guide image setting unit 802 is generated based on the optical images taken in the past that match the predetermined shooting conditions, the information indicating the skeleton associated with the optical images, and the information indicating the joint angle. Has settings related to past guide images.

- the radiography control device 100 does not generate the past guide image. Specifically, the process of steps S407 to S409 of FIG. 4 described above is not executed.

- the display of the optical image, the information indicating the skeleton associated with the optical image, and the information indicating the joint angle is additionally set. Only the items that are validly set by the user will be displayed as the past guide image of the radiography control device 100. In the description of the present embodiment, the description will be continued assuming that the display of the information indicating the skeleton and the information indicating the joint angle is enabled.

- the location and position of the joint angle may be additionally displayed. Specifically, for example, the joint angle and the joint position information may be displayed together, or the location of the joint angle portion may be highlighted by enclosing it with a figure.

- FIG. 9 is a diagram showing an example of the configuration related to the display of the past guide image. Since the configuration for displaying the optical image and the guide image is the same as that in the first embodiment, the description of the same configuration will be omitted. Further, the guide image setting of the radiography control device 100 here is based on the setting of the guide image setting screen 800 of FIG.

- the superimposed image 900 is an image generated by the guide image generation unit 307 in steps S403 to S406 of the first embodiment based on the settings of the guide image setting screen 800.

- the guide image generation unit 307 acquires and generates information indicating the skeleton and joint angle from the storage unit 305 based on the setting of the guide image setting screen 800 in step S408 of the first embodiment. It is an image.

- the guide image generation unit 307 gives an instruction to superimpose and display the past guide image 901 on the superposed image 900 to the display control unit 304, and the superposed image 900 on which the past guide image 901 is superposed and displayed is displayed as the past guide superposed image 902. .

- the radiography control device 100 controls the display of the guide image based on the user setting, the guide image based on the display content setting of the past guide image, and the past guide image. As a result, the user can selectively display appropriate information for reproducing the positioning.

- the radiography control device 100 adds a process of generating a guide image based on the three-dimensional patient skeleton information and the joint angle.

- FIG. 10 is a configuration example of the radiography control device 100 of the radiography system of the present embodiment.

- the radiography control device 100 additionally has a three-dimensional skeleton generation unit 1000.

- the three-dimensional skeleton generation unit 1000 generates information indicating a three-dimensional skeleton and information indicating a three-dimensional joint angle.

- the generation method the same method as in the first embodiment can be used.

- the three-dimensional skeleton generator 1000 uses a trained model obtained by performing machine learning using an optical image of a human body as input data and a three-dimensional skeleton and joint angle of the captured human body as labels. , Estimate the skeleton and joint positions of the human body in the current image.

- the three-dimensional image used as the input data may be generated, for example, by synthesizing two-dimensional images captured from different angles by a plurality of optical cameras.

- the three-dimensional image used as the input data may be generated from the two-dimensional image taken by driving one optical camera and changing the angle. That is, in the present embodiment, the method of acquiring the three-dimensional image is not limited, and it is sufficient that the three-dimensional image obtained by capturing the subject is acquired.

- information indicating a three-dimensional skeleton and information indicating a three-dimensional joint angle are generated.

- the information generated in the present embodiment may be generated based on a two-dimensional optical image or may be generated based on a three-dimensional optical image.

- the configuration of the three-dimensional skeleton generation unit 1000 is not limited as long as it can generate information indicating the three-dimensional skeleton and information indicating the three-dimensional joint angle. For example, by acquiring position information having optical image and distance information from the image acquisition device 130, acquiring the coordinates of each joint of the patient, and applying it to the human body data saved in advance, the three-dimensional shape of the patient in the optical image can be obtained. Information indicating the skeleton and information indicating the three-dimensional joint angle may be generated.

- FIG. 11 is a flowchart showing an example of a display processing process at the time of patient imaging of the radiography control device 100 of the present embodiment.

- step S1101 the three-dimensional skeleton generation unit 1000 uses the information indicating the skeleton generated by the skeleton generation unit 306 and the information indicating the joint angle to provide information indicating the three-dimensional skeleton and information indicating the three-dimensional joint angle. Generate. Therefore, in the subsequent step S406, a guide image is generated based on the information indicating the three-dimensional skeleton generated by the three-dimensional skeleton generation unit 1000 and the information indicating the three-dimensional joint angle, and the UI is generated via the display control unit 304.

- the display device 203 superimposes and displays the optical image.

- step S408 for the generation of the past guide image, the information indicating the three-dimensional skeleton generated by the three-dimensional skeleton generation unit 1000 stored in correspondence with the past image and the information indicating the three-dimensional joint angle are used.

- the three-dimensional guide image 1201 is an image generated by the guide image generation unit 307 based on the information indicating the three-dimensional skeleton of the patient and the information indicating the three-dimensional joint angle generated by the three-dimensional skeleton generation unit 1000 in step S1101. Is.

- the guide image generation unit 307 gives an instruction to the display control unit 304 to superimpose and display the three-dimensional guide image 1201 on the optical image 500, and the optical image 500 on which the three-dimensional guide image 1201 is superposed and displayed as the guide image superimposition display image 1202 is displayed. Is displayed.

- the information indicating the three-dimensional joint angle of the patient generated by the three-dimensional skeleton generation unit 1000 is expressed by the character string display in the three-dimensional polar coordinate format. That is, for the information indicating the skeleton in the direction from the inside to the outside at the joint position of the human body, the angle ⁇ formed by the z-axis and the angle ⁇ formed by the information indicating the skeleton lowered on the x-axis and the xy plane are displayed. ..

- the method is not limited to the above as long as it is a method for expressing a three-dimensional joint angle.

- the radiography control device 100 generates a guide image based on the information indicating the three-dimensional skeleton and the information indicating the three-dimensional joint angle.

- the user can refer to the information indicating the three-dimensional skeleton and the information indicating the three-dimensional joint angle, and the reproducibility of the positioning of the user's posture can be further improved.

- the radiography control device 100 has a configuration in which the patient himself / herself can improve the reproducibility of the posture by showing the image displayed on the UI display device 203 to the patient.

- the display control unit 304 additionally has a control function capable of displaying the optical image, the superimposed display image, or the past superimposed display image displayed on the UI display device 203 in reverse left and right (not shown).

- the user activates the control function and presents the UI display device 203 to the patient.

- the patient himself can confirm the superimposed display of the past guide image generated based on the information indicating the joint angle.

- the patient himself in addition to improving the reproducibility of the posture positioning of the user, the patient himself can improve the reproducibility of the posture.

Landscapes

- Engineering & Computer Science (AREA)

- Life Sciences & Earth Sciences (AREA)

- Health & Medical Sciences (AREA)

- Medical Informatics (AREA)

- Physics & Mathematics (AREA)

- Animal Behavior & Ethology (AREA)

- Radiology & Medical Imaging (AREA)

- Veterinary Medicine (AREA)

- Public Health (AREA)

- General Health & Medical Sciences (AREA)

- Biophysics (AREA)

- High Energy & Nuclear Physics (AREA)

- Surgery (AREA)

- Nuclear Medicine, Radiotherapy & Molecular Imaging (AREA)

- Optics & Photonics (AREA)

- Pathology (AREA)

- Molecular Biology (AREA)

- Biomedical Technology (AREA)

- Heart & Thoracic Surgery (AREA)

- General Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- Human Computer Interaction (AREA)

- Computer Hardware Design (AREA)

- Computer Graphics (AREA)

- General Engineering & Computer Science (AREA)

- Software Systems (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Apparatus For Radiation Diagnosis (AREA)

- Image Processing (AREA)

Abstract

本発明に係る放射線撮影システムは、被検体に対して照射された放射線に基づいて放射線画像を取得する取得手段と、第1の時点で取得された前記被検体の第1の光学画像に基づいて、前記第1の光学画像に関連する前記被検体の骨格を示す情報と関節角度を示す情報の少なくとも一方の情報を含む第1の処理画像を生成する第1の生成手段と、前記第1の時点と異なる第2の時点で取得された前記被検体の第2の光学画像に基づいて、前記第2の光学画像に関連する前記被検体の前記骨格を示す情報と前記関節角度を示す情報のうち少なくとも一方の情報を含む第2の処理画像を生成する第2の生成手段と、前記第1の処理画像および前記第2の処理画像を表示部に重畳して表示する表示制御手段と、を備えることを特徴とする。

Description

本発明は、放射線撮影システム、放射線撮影方法、画像処理装置およびプログラムに関する。

従来、医療分野における放射線撮影システムを用いた撮影において、経過観察の再診等で過去と同一の姿勢で撮影部位の撮影を行う場合がある。このような場合、医師等のユーザが過去に撮影された画像から同一姿勢を判断しなければならず、患者の姿勢の位置決めに時間がかかってしまうという問題があった。

近年、上記の問題に対し、次のような構成を有するものが存在する。

特許文献1では、放射線発生装置に光学式カメラを取り付け、放射線発生装置が放射線を発生した際に光学式カメラにより撮影される光学画像を放射線画像および患者の撮影条件と共に記憶する。そして、光学画像からガイド画像を生成し、以降の同一患者の撮影時に撮影システムの表示装置に表示された光学動画像上にガイド画像を重畳表示する技術が開示されている。

しかしながら、過去に検査を行った光学画像をガイドとして重畳表示するだけでは、関節を撮影する場合など、患者の骨格や関節角度を把握しながら位置決めを行うことが望ましい場合に、必ずしも位置決めの再現性を向上させられない可能性があった。

本発明は上記課題に鑑みてなされたものであり、放射線撮影システムを用いた撮影において、患者の姿勢の位置決めの再現性を向上させることを目的とする。

本発明に係る放射線撮影システムは、被検体に対して照射された放射線に基づいて放射線画像を取得する取得手段と、第1の時点で取得された前記被検体の第1の光学画像に基づいて、前記第1の光学画像に関連する前記被検体の骨格を示す情報と関節角度を示す情報の少なくとも一方の情報を含む第1の処理画像を生成する第1の生成手段と、前記第1の時点と異なる第2の時点で取得された前記被検体の第2の光学画像に基づいて、前記第2の光学画像に関連する前記被検体の前記骨格を示す情報と前記関節角度を示す情報のうち少なくとも一方の情報を含む第2の処理画像を生成する第2の生成手段と、前記第1の処理画像および前記第2の処理画像を表示部に重畳して表示する表示制御手段と、を備えることを特徴とする。

本発明によれば、放射線撮影システムを用いた撮影において、患者の姿勢の位置決めの再現性を向上させられる。

以下、添付図面に従って本発明に係る放射線撮影システムの好ましい実施形態について詳説する。ただし、この実施形態に記載されている構成要素はあくまで例示であり、本発明に係る放射線撮影システムの技術的範囲は、特許請求の範囲によって確定されるのであって、以下の個別の実施形態によって限定されるわけではない。また、本発明に係る下記実施形態に限定されるものではなく、本発明の趣旨に基づき種々の変形(各実施例の有機的な組合せを含む)が可能であり、それらを本発明の範囲から除外するものではない。即ち、後述する各実施例およびその変形例を組み合わせた構成も全て本発明の実施形態に含まれるものである。

[実施形態1]

本実施形態に係る放射線撮影システムは、患者を撮影した光学画像を表示装置に表示し、その光学画像を見ながら放射線撮影時の位置決めが可能な放射線撮影システムであって、検査時の位置決め精度の向上を目的としたものである。

本実施形態に係る放射線撮影システムは、患者を撮影した光学画像を表示装置に表示し、その光学画像を見ながら放射線撮影時の位置決めが可能な放射線撮影システムであって、検査時の位置決め精度の向上を目的としたものである。

より具体的には、検査対象となる患者を撮影した光学画像(現在画像)に骨格を示す情報や関節角度を示す情報を重畳して表示しつつ、その画像に対して、過去に同一姿勢で撮影した過去画像に関連する骨格を示す情報や関節角度を示す情報が重畳されている。そして、検査者は、過去画像に関連する重畳表示された骨格を示す情報や関節角度を示す情報と、現在画像に重畳表示された骨格を示す情報や関節角度を示す情報とに基づいて位置決めを行うことができる。

本実施形態においては、骨格を示す情報と関節角度を示す情報の2つの情報を光学画像に重畳する形態を例として説明するが、必ずしも2つの情報を重畳する必要はなく、骨格を示す情報と関節角度を示す情報のうち少なくとも一方の情報が光学画像に重畳されていればよい。なお、いずれか一方の情報のみを光学画像に重畳する場合には、現在画像に対して重畳する情報と、過去画像に対して重畳する情報は一致していることが望ましい。しかしながら、現在画像に重畳する情報と過去画像に重畳する情報とは完全一致している必要はなく、部分的に一致していればよい。

また、本実施形態では放射線撮影システムを例に説明を行うが、撮影を行うモダリティは、MRI装置、3次元超音波撮影装置、光音響トモグラフィ装置などであってもよい。すなわち、過去と現在とで同じ条件で撮影することが求められる装置であれば本発明が適用可能である。さらに、検査対象となる患者を撮影することにより得られる光学画像は、必ずしも1つの画像取得装置により取得された画像である必要はなく、異なる画像取得装置により得られた画像であってもよい。

以下では、本実施形態のシステム構成について、図1から図3を用いて説明する。

図1は、本実施形態の放射線撮影システム全体の構成例である。本システムは、ネットワーク140を介して、放射線撮影制御装置100と放射線撮影装置110、放射線発生装置120、画像取得装置130から構成される。なお、ネットワーク140は、有線ネットワークでも無線ネットワークでもよい。

放射線撮影制御装置100は、放射線撮影装置110と通信し、放射線撮影を制御する、コンピュータなどの情報処理装置で構成される装置である。また、放射線撮影制御装置100は、放射線発生装置120と通信し、放射線発生装置120から放射線を照射した際の情報を取得する。さらに、放射線撮影制御装置100は、画像取得装置130と通信し、画像取得装置130の制御、および、画像取得装置130が撮影した画像を取得する。

放射線撮影装置110は、FPD(Flat Panel Detector)などを含む装置であって、入射した放射線に基づく放射線画像を生成する。放射線撮影制御装置100からの指示により撮影可能状態へと遷移する。そして、放射線発生装置120と同期を取りながらユーザが設定した所定の撮影条件で放射線撮影を実施し、放射線発生装置120から照射された放射線に基づき画像を生成する装置である。すなわち、放射線撮影装置110は、被検体に対して照射された放射線に基づいて放射線画像を取得する取得手段の一例に相当する。

なお、放射線撮影装置110の台数は一台に限定されるものではなく、複数台の放射線撮影装置を用いる構成でも良い。

放射線発生装置120は、曝射スイッチ121による放射線照射指示を検知し、操作パネルなどのユーザ操作を受け付けるユーザ入力装置(不図示)により設定された照射情報を元に、管球122より放射線を発生させる装置である。

画像取得装置130は、放射線撮影制御装置100からの指示により撮影を行い、画像を取得する装置である。本実施形態では、画像取得装置130に光学カメラを用い、光学画像を取得するものとする。すなわち、画像取得装置130は、被検体を光学的に撮影することにより光学画像を取得する。なお、撮影された画像情報を取得可能であれば、画像取得装置130の構成に制限はない。また、本実施形態では、画像取得装置130は管球122に取り付けられ、管球122の放射線発生方向の撮影を行うものとする。

図2は、本実施形態の放射線撮影システムの放射線撮影制御装置100のハードウェア構成例である。

放射線撮影制御装置100は、ネットワーク140に接続するネットワーク装置201、キーボードなどユーザ操作を受け付けるユーザ入力装置202を有する。

また、放射線撮影制御装置100は、液晶ディスプレイなど操作画面、放射線画像を表示するUI表示装置203、放射線撮影制御装置全体を制御するCPU204を有する。

さらに、放射線撮影制御装置100は、CPU204のワークスペースを提供するRAM205、各種制御プログラム、および放射線撮影装置110から受信した放射線画像、並びに画像取得装置130から受信した画像情報などを記憶する記憶装置206を有する。

ここで、放射線撮影制御装置100を構成する各装置は、メインバス207で接続されており、相互にデータの送受信が可能である。

なお、ユーザ入力装置202とUI表示装置203を別々の装置として記載しているが、これらの装置が一体となった操作部としてもよい。

図3は、本実施形態の放射線撮影システムの放射線撮影制御装置100の機能構成例である。

図3に示す各機能部は、放射線撮影制御装置100上のCPU204が、記憶装置206に記憶される制御プログラムをRAM205上に読み出して実行することで実現される。

放射線撮影制御装置100は、通信部301、システム制御部302、画像処理部303、表示制御部304、記憶部305、骨格生成部306、ガイド画像生成部307、判定部308を有する。

通信部301は、ネットワーク装置201を制御して通信を行うソフトウェアである。

システム制御部302は、通信部301を介して、画像取得装置130の制御、および放射線発生装置120の照射情報や放射線撮影装置110の撮影情報の取得、並びに各々の状態管理を行う。また、システム制御部302は、通信部301を介して、放射線撮影装置110から放射線画像を、画像取得装置130から光学画像を、各々取得する。

さらに、システム制御部302は、放射線撮影制御装置100の基本的な機能を実現するプログラムであり、各部の動作制御を行う。

画像処理部303は、システム制御部302を介して取得した放射線画像を処理し、放射線撮影制御装置100で使用する画像を生成する。

表示制御部304は、画像処理部303により生成された画像を、UI表示装置203を介して表示する。また、表示制御部304は、ガイド画像生成部307が生成したガイド画像を、UI表示装置203を介して表示する。また、表示制御部304は、過去に同一姿勢で撮影された画像から生成された過去ガイド画像を、UI表示装置203を介して表示する。さらに、表示制御部304は、ユーザ入力装置202からの操作に基づきシステム制御部302で指示される画像への処理反映や、UI表示装置203の画面表示の切り替え処理などを行う。

記憶部305は、画像処理部303が生成した放射線画像や、放射線画像に関連する患者の撮影条件(患者ID、検査ID、検査部位、撮影方向など)、および放射線発生装置120の照射情報(管電圧や管電流など)を保存する。また、記憶部305は、放射線画像に関連する、ガイド画像生成部307が生成したガイド画像をあわせて保存する。

骨格生成部306は、画像取得装置130から得られた光学画像を用いて、光学画像内の患者の骨格、および関節角度を推定し、骨格を示す情報と関節角度を示す情報を生成する。具体的には、骨格生成部306は、人体を撮像した光学画像を入力データとし、撮像された人体の骨格および関節角度をラベルとして機械学習を行うことにより得られる学習済みモデルを用いて、現在画像における患者の骨格および関節角度を推定する。そして、推定された骨格および関節角度から骨格を示す情報と関節角度を示す情報を生成する。

ここで、学習済みモデルとは、サポートベクターマシンやニューラルネットワークを利用した深層学習(ディープラーニング)等の機械学習アルゴリズムに従った機械学習モデルであって、予め適切な学習データを用いて学習を行った機械学習モデルを示す。なお、学習済みモデルは、それ以上の学習を行わないものではなく、追加の学習を行うこともできる。学習データは、一つ以上の、入力データと出力データ(正解データ)とのペア群で構成される。本実施形態に係る学習済みモデルは、ニューラルネットワークを用いた教師あり学習を行うことにより構築されたモデルであり、入力データ(人体を撮像した光学画像)とラベル(人体の骨格、関節角度)の組を学習データとして学習している。すなわち、骨格生成部306は、人体を撮像した複数の光学画像と、該複数の光学画像の人体における骨格を示す情報と関節の角度を示す情報を組として学習した学習済みモデルを用いて、第1の光学画像から被検体の骨格と関節角度を推定する推定手段の一例に相当する。なお、学習に用いられる機械学習アルゴリズムや、学習データセットは上記に限定されず、例えば、骨格を推定するモデルと関節角度を推定するモデルは別でもよい。また、本実施形態では、骨格生成部306は、骨格を示す情報と関節角度を示す情報を生成するが、少なくとも一方を生成する構成であればよい。さらに、上記では、骨格生成部306は、関節角度を示す情報を生成するが、学習済みモデルに対して関節角度だけでなく関節位置をラベルとして学習してもよく、その場合、関節位置を示す情報も同様にして生成できる。

なお、骨格生成部306が、画像取得装置130から得られた光学画像を用いて、光学画像内の患者の骨格を示す情報と関節角度を示す情報を生成できれば構成に制限はない。例えば、画像取得装置130から光学画像と距離の情報を持った位置情報を取得し患者の各関節の座標を取得し、予め保存した人体データに適用することで光学画像内の患者の骨格を示す情報と関節角度を示す情報を生成しても良い。

ガイド画像生成部307は、骨格生成部306が生成した骨格を示す情報と関節角度を示す情報と、画像取得装置130から得られた光学画像を用いて、光学画像上に骨格を示す情報と関節角度を示す情報を重畳表示したガイド画像を生成する。すなわち、第1の時点で取得された前記被検体の第1の光学画像に基づいて、前記第1の光学画像に関連する前記被検体の骨格を示す情報と関節角度を示す情報の少なくとも一方の情報を含む第1の処理画像を生成する。その後、ガイド画像生成部307は、表示制御部304に対して、ガイド画像の画面表示を指示する。

また、ガイド画像生成部307は、後述の判定部308が過去に同一姿勢を撮影した患者と判断した場合、記憶部305が記憶する当該患者の過去のガイド画像の情報を取得し、過去ガイド画像を生成する。すなわち、前記第1の時点と異なる第2の時点で取得された前記被検体の第2の光学画像に基づいて、前記第2の光学画像に関連する前記被検体の前記骨格を示す情報と前記関節角度を示す情報のうち少なくとも一方の情報を含む第2の処理画像を生成する。過去のガイド画像の情報とは、例えば、過去画像と、該過去画像に関連する患者の骨格を示す情報と関節角度を示す情報を含む。また、過去ガイド画像は、例えば、過去画像に対して、該過去画像に関連する骨格を示す情報と関節角度を示す情報を重畳した画像を示す。その後、ガイド画像生成部307は、表示制御部304に対して、過去ガイド画像を重畳したガイド画像の画面表示を指示する。

判定部308は、放射線撮影制御装置100にユーザにより予め入力された撮影する患者の撮影条件を元に、記憶部305の過去の患者の撮影条件と一致する情報が存在するかを判定する。本実施形態では、判定部308は、患者の撮影条件として少なくとも患者ID、検査ID、検査部位、撮影方向の情報を用いるものとするが、過去の患者の撮影条件と一致すると判断可能な情報であれば構成に制限はない。なお、本実施形態では、判定部308は、複数の過去の患者の撮影条件が一致した場合、最新の情報を一致した情報として用いるものとする。なお、一致した情報として用いる情報は上記に限定されず、最新の情報でなくてもよい。

本実施形態における、放射線撮影制御装置100の患者撮影時の表示処理の方法について図4を用いて説明する。また、光学画像およびガイド画像の表示に関する構成の一例について図5から図7を用いて説明する。

図4は、放射線撮影制御装置100の患者撮影時の表示処理工程の一例を示したフローチャート図である。

ステップS401において、システム制御部302が、ユーザ操作に基づき、放射線撮影制御装置100を撮影制御を行う検査開始の状態とする。具体的には、システム制御部302が、ユーザ操作により検査指示された患者の撮影条件に基づき、放射線撮影装置110へ撮影のための準備を行う指示を、通信部301を介して送信する。放射線撮影装置110は、自身の撮影準備が完了となると放射線撮影制御装置100へ折り返し準備完了通知を送信する。準備完了通知を受けた後、システム制御部302は、放射線撮影制御装置100を撮影可能状態とし、後述するステップS411を受け付けるようになる。また、システム制御部302は、画像取得装置130へ撮影開始を行う指示を、通信部301を介して送信する。画像取得装置130は、撮影開始指示を受けた後、放射線撮影制御装置100へ折り返し、自身が取得した光学画像を逐次送信する。

S402からS410の間では、システム制御部302による逐次並列処理が実行される。すなわち、ステップS403、ステップS404からS406、ステップS407からS409、およびそれ以外の制御処理並びにユーザ制御の受付である。ステップ間の処理は、ステップS411が実行されるか、ユーザ操作による検査の中止(不図示)が行われるまで、システム制御部302により実行される。

なお、S402からS410の間の処理は、必ずしも並列処理されなくてもよく、患者を撮影している光学画像、該光学画像から生成されたガイド画像及び該患者を過去に撮影した光学画像から生成された過去ガイド画像を表示装置に表示できればよい。

例えば、ステップS403の処理を実行した後に、ステップS404からステップS406の処理を実行し、それに続いてステップS407からステップS409の処理が行われてもよい。

ステップS403において、システム制御部302が、通信部301を介して画像取得装置130から取得した光学画像を、表示制御部304を介してUI表示装置203に表示する。

ステップS404において、骨格生成部306が、システム制御部302を介して取得した光学画像に基づいて、光学画像内の患者の骨格を示す情報と関節角度を示す情報を生成する。

ステップS405において、ガイド画像生成部307が、骨格生成部306が生成した骨格を示す情報と関節角度を示す情報に基づいてガイド画像を生成する。

ステップS406において、表示制御部304は、図5に示すようなガイド画像を光学画像に重畳した第1の重畳画像502をUI表示装置203に表示する。すなわち、表示制御部304は、被検体を光学的に撮影することにより得られる第1の光学画像に関連する被検体の骨格を示す情報と関節角度を示す情報の少なくとも一方を第1の光学画像に重畳することにより生成された第1の処理画像を表示部に表示する。

ここで、ステップS403からS406でUI表示装置203に表示される光学画像およびガイド画像の表示に関する構成を図5で説明する。

ステップS403からステップS406は、検査を受けている患者をリアルタイムに撮影して得られる光学画像に対して骨格を示す情報と関節角度を示す情報を重畳し、UI表示装置203に表示する工程である。

光学画像500は、ステップS403にてUI表示装置203に表示される画像取得装置130から取得した光学画像である。なお、実際の光学画像には患者の背後に放射線撮影装置110が存在しているなど、画像取得装置130の撮影範囲内の物体が映り込むが、説明のため、光学画像500には患者の身体情報のみ表現した図を用いる。また、以降の光学画像および光学画像に関連する画像に関しても、特記されない限り同様に患者の身体情報のみ表現した図を用いる。

ガイド画像501は、骨格生成部306が生成する患者の骨格を示す情報と関節角度を示す情報に基づいて、ガイド画像生成部307が生成する画像である。ガイド画像生成部307は、ガイド画像501を光学画像500へ重畳表示する指示を表示制御部304に行い、第1の重畳画像502としてガイド画像501が重畳表示された光学画像500が表示される。なお、本実施形態では、骨格生成部306が生成する患者の関節角度を、人体の関節位置間の成す角度位置に表示している。しかしながら、人体の関節位置の場所が特定される関節角度の表現方法であれば、表示方法に制限はなく、例えば、関節角度の位置情報を表す文字列を併記してもよい。

図4のフローチャート図の説明に戻る。

ステップS407からステップS409は、患者の過去に同一の撮影条件で撮影して得られた光学画像に対して患者の骨格を示す情報と関節角度を示す情報を重畳し、UI表示装置203に表示する工程である。

ステップS407において、判定部308が、検査指示された患者の撮影条件と一致する過去の撮影条件が存在するか否かを、記憶部305を検索することで判定する。

ステップS407で過去に同一の撮影条件を行った患者であると判定された場合、ステップS408において、ガイド画像生成部307が、記憶部305の撮影条件から光学画像と、該光学画像と関連する骨格を示す情報と関節角度を示す情報を取得し第2の重畳画像701を生成する。

ステップS409において、表示制御部304が、図7に示すように第2の重畳画像701を光学画像およびガイド画像に重畳し、UI表示装置203に表示する。すなわち、表示制御部304は、第1の光学画像よりも過去に撮影された第2の光学画像と関連付けて記憶された被検体の骨格を示す情報と関節角度を示す情報のうち少なくとも一方を第2の光学画像に重畳することにより生成された第2の処理画像を表示部に表示する。

なお、ステップS407において過去に同一の撮影条件を行った患者と判断されなかった場合、放射線撮影制御装置100は、過去ガイド画像の生成を行わず、すなわちステップステップS408からステップS409の処理を実行しない。

ここで、ステップS407からステップS409でUI表示装置203に表示される過去ガイド画像に関する記憶部305に記憶された患者情報の構成の一例を、図6を用いて説明する。また、過去ガイド画像の表示に関する構成の一例を、図7を用いて説明する。

図6は、記憶部305に記憶された患者情報の構成の一例を示す図である。記憶部305は、過去の患者の撮影条件テーブル600を有しており、撮影条件部601、ガイド画像情報部602で構成される。

撮影条件部601は、画像処理部303が生成した放射線画像や、放射線画像に関連する患者の撮影条件、および放射線発生装置120の照射情報などを記憶する。本実施形態では、判定部308は、患者の撮影条件として少なくとも患者ID、検査ID、検査部位、撮影方向などの情報を用いるものとするが、過去の患者の撮影条件の一致判定に使用可能な情報であれば構成に制限はない。また、本実施形態では、判定部308は、複数の過去の患者の撮影条件が一致した場合、最新の情報を一致した情報として用いるものとする。なお、一致した情報として用いる情報は上記に限定されず、最新の情報でなくてもよい。

ガイド画像情報部602は、撮影条件部601の、画像処理部303の放射線画像生成時に記憶される、画像取得装置130から取得した光学画像および骨格生成部306が生成した骨格を示す情報と関節角度を示す情報を記憶する。なお、本実施形態では、光学画像と、該光学画像と関連する骨格を示す情報と関節角度を示す情報を各々関連付けて記憶しているが、ガイド画像生成部307が生成するガイド画像を合わせて記憶してもよいし、ガイド画像のみを記憶する構成としてもよい。また、本実施形態では、骨格を示す情報と関節角度を示す情報を画像情報として記憶しているが、骨格を示す情報の関節座標情報のみを記憶し、ガイド画像生成部307が関節座標情報から骨格を示す情報と関節角度を示す情報を生成する構成としてもよい。すなわち、骨格を示す情報と関節角度を示す情報は、例えば、図6に示すように必ずしも画像情報として記憶/表示される必要はなく、単に文字や数値パラメータとして記憶/表示されてもよい。

なお、本実施形態では、ガイド画像生成部307が、記憶部305内の過去の患者の撮影条件テーブル600を参照しているが、ステップS407の判定が行えれば構成に制限はない。すなわち、ネットワーク140を介して、過去の患者の撮影条件テーブル600を有する情報処理装置(不図示)上の情報を用いた判定を行ってもよい。

図7は、過去ガイド画像の表示に関する構成の一例を示す図である。

第1の重畳画像700は、前述の第1の重畳画像502と同様にして生成される画像である。

第2の重畳画像701は、ステップS408において、ガイド画像生成部307が、記憶部305から所定の撮影条件と一致する光学画像と、該光学画像と関連する骨格を示す情報と関節角度を示す情報を取得し、それらに基づいて生成する画像である。また、ガイド画像生成部307は、第2の重畳画像701を第1の重畳画像700へ重畳表示する指示を表示制御部304に行う。そして、表示指示を受けた表示制御部304が、第3の重畳画像702として第2の重畳画像701が重畳表示された第1の重畳画像700を表示する。

再び図4のフローチャート図の説明に戻る。

ステップS411において、ユーザが放射線発生装置120の曝射スイッチ121を押下し、撮影を開始する。撮影が開始されると、放射線発生装置120が管球122から放射線を発生させ、患者を通過した放射線が放射線撮影装置110により検知され、放射線撮影装置が放射線画像を生成する。その後、放射線撮影装置110は、放射線撮影制御装置100へ放射線画像を送信する。また、処理と並行して、放射線発生装置120が、放射線撮影の照射情報を、放射線撮影制御装置100へ送信する。

ステップS412において、システム制御部302が、放射線画像や、放射線画像に関連する患者の撮影条件、および放射線発生装置120の照射情報などを、記憶部305へ記憶する。また、システム制御部302は、上記の処理と並行して、撮影時の光学画像と、該光学画像と関連する骨格を示す情報と関節角度を示す情報を記憶部305へ記憶する。

以上により、本実施形態に係る放射線撮影システムの処理が行われる。

上記によれば、表示制御部304は、検査開始時に画像取得装置130から取得した光学画像と、骨格生成部306が生成した骨格を示す情報と関節角度を示す情報に基づいて生成されたガイド画像を重畳してUI表示装置203に表示する。また、表示制御部304は、過去に同一の撮影条件で撮影を行った患者を判定し、過去の検査の光学画像と、該光学画像と関連する骨格を示す情報と関節角度を示す情報に基づいて生成された過去ガイド画像を重畳してUI表示装置203に表示する。

これにより、検査対象となる患者が撮影されている様子を表示した光学画像だけでなく、過去に撮影された光学画像から生成された過去画像についても骨格を示す情報と関節角度を示す情報を重畳した状態で表示装置に表示することが出来る。そのため、検査者は、過去画像に重畳表示された骨格を示す情報と関節角度を示す情報と、現在画像に重畳表示された骨格を示す情報と関節角度を示す情報とに基づいて定量的に位置決めを行うことができる。

(変形例1)

上述の実施形態1では、表示制御部304が、現在画像に関連する骨格を示す情報や関節角度を示す情報を重畳した現在画像と、過去画像と関連付けて記憶された骨格を示す情報や関節角度を示す情報を重畳した過去画像を重畳して表示することにより位置決め精度を向上させた。

上述の実施形態1では、表示制御部304が、現在画像に関連する骨格を示す情報や関節角度を示す情報を重畳した現在画像と、過去画像と関連付けて記憶された骨格を示す情報や関節角度を示す情報を重畳した過去画像を重畳して表示することにより位置決め精度を向上させた。

それに対し、本変形例では、表示制御部304は、現在画像に関連する骨格を示す情報や関節角度を示す情報に基づいて画素値を変更した現在画像と、過去画像と関連付けて記憶された骨格を示す情報や関節の角度を示す情報に基づいて画素値を変更した過去画像を重畳して表示する。

より具体的には、骨格生成部306が、実施形態1と同様にして推定された、現在画像における患者の骨格を示す情報および関節角度を示す情報を視認可能なように現在画像を構成する画素の画素値を変更することによりガイド画像を生成する。また、過去画像における患者の骨格を示す情報および関節角度を示す情報を視認可能なように過去画像を構成する画素の画素値を変更することにより過去ガイド画像を生成する。

上記によれば、実施形態1と同様に、検査者は、過去画像に重畳表示された骨格を示す情報と関節角度を示す情報と、現在画像に重畳表示された骨格を示す情報と関節角度を示す情報とに基づいて定量的に位置決めを行うことができる。

(変形例2)

上述の実施形態1では、表示制御部304が、現在画像に関連する骨格を示す情報や関節角度を示す情報を重畳した現在画像と、過去画像と関連付けて記憶された骨格を示す情報や関節角度を示す情報を重畳した過去画像を重畳して表示することにより位置決め精度を向上させた。

上述の実施形態1では、表示制御部304が、現在画像に関連する骨格を示す情報や関節角度を示す情報を重畳した現在画像と、過去画像と関連付けて記憶された骨格を示す情報や関節角度を示す情報を重畳した過去画像を重畳して表示することにより位置決め精度を向上させた。

それに対し、本変形例では、表示制御部304が、現在画像に関連する骨格を示す情報や関節角度を示す情報と過去画像と関連付けて記憶された骨格を示す情報や関節の角度を示す情報のみを重畳して表示する。

より具体的には、図5に示すようなガイド画像501と、図9に示すような過去ガイド画像901とを重畳して表示する。

上記によれば、患者を撮影した光学画像を表示せずに、骨格を示す情報や関節の角度を示す情報のみに基づいて位置決めを行うことができるため、患者のプライバシーに配慮しつつ、且つ定量的に位置決めを行える。

[実施形態2]

次に、本発明に係る放射線撮影システムの実施形態2を説明する。

次に、本発明に係る放射線撮影システムの実施形態2を説明する。

実施形態2の構成では、放射線撮影制御装置100による、ユーザ設定に基づくガイド画像、過去ガイド画像の表示内容の設定に基づく変更を行う処理を追加する。

以下、図8から図9を用いて、実施形態1からの差分のみ説明する。

図8は、本実施形態の放射線撮影制御装置100のガイド画像設定画面の構成の一例を示す図である。

ガイド画像生成部307は、ガイド画像設定画面800を追加で有し、ガイド画像設定画面800は、システム制御部302からの表示指示(例えば、ユーザが放射線撮影制御装置100を操作し、システム設定画面(不図示)から当該画面を選択した場合など)によりUI表示装置203に表示される。

ガイド画像設定画面800は、ガイド画像設定部801と過去ガイド画像設定部802を有する。

ガイド画像設定部801は、光学画像と、該光学画像に関連する骨格を示す情報と関節角度を示す情報に基づいて生成されるガイド画像に関する設定を有する。ユーザが当該設定を無効に設定した場合、放射線撮影制御装置100は、ガイド画像の生成を行わない。具体的には、前述の図4のステップS403からS406の処理を実行しない。ユーザが当該項目を有効にした場合、加えて光学画像と、該光学画像と関連する骨格を示す情報と関節角度を示す情報の表示の設定を行う。ユーザが項目のうち有効に設定した項目のみが、放射線撮影制御装置100の光学画像およびガイド画像として表示されることとなる。本実施形態の説明では、光学画像と、該光学画像と関連する骨格を示す情報と関節角度を示す情報の表示を有効にした状態として説明を続ける。

過去ガイド画像設定部802は、過去に撮影された光学画像のうち、所定の撮影条件と一致する光学画像と、該光学画像と関連する骨格を示す情報と関節角度を示す情報に基づいて生成される過去ガイド画像に関する設定を有する。ユーザが当該設定を無効に設定した場合、放射線撮影制御装置100は、過去ガイド画像の生成を行わない。具体的には、前述の図4のステップS407からS409の処理を実行しない。ユーザが当該項目を有効にした場合、加えて光学画像と、該光学画像と関連する骨格を示す情報と関節角度を示す情報の表示の設定を行う。ユーザが項目のうち有効に設定した項目のみが、放射線撮影制御装置100の過去ガイド画像として表示されることとなる。本実施形態の説明では、骨格を示す情報と関節角度を示す情報の表示を有効にした状態として説明を続ける。

なお、関節角度を示す情報の表示のみを有効とした場合、関節角度の場所や位置を追加で表示してもよい。具体的には、例えば、関節角度と関節位置情報を合わせて表示してもよいし、関節角度の部位の場所を図形で囲んで強調表示してもよい。

図9は、過去ガイド画像の表示に関する構成の一例を示す図である。なお、光学画像およびガイド画像の表示に関する構成も実施形態1と同様であるため、同様の構成については説明を割愛する。また、ここでの放射線撮影制御装置100のガイド画像設定は、図8のガイド画像設定画面800の設定に基づくものとする。

重畳画像900は、実施形態1のステップS403からS406でガイド画像生成部307が、ガイド画像設定画面800の設定に基づいて生成する画像である。

過去ガイド画像901は、実施形態1のステップS408でガイド画像生成部307が、ガイド画像設定画面800の設定に基づき、記憶部305から骨格を示す情報と関節角度を示す情報を取得し、生成する画像である。ガイド画像生成部307は、過去ガイド画像901を重畳画像900へ重畳表示する指示を表示制御部304に行い、過去ガイド重畳画像902として過去ガイド画像901が重畳表示された重畳画像900が表示される。

以上により、実施形態2では、放射線撮影制御装置100が、ユーザ設定に基づくガイド画像、過去ガイド画像の表示内容の設定に基づくガイド画像、過去ガイド画像の表示制御を行う。これにより、位置決めを再現するにあたって適切な情報をユーザによって選択的に表示できる。

[実施形態3]

次に、本発明に係る放射線撮影システムの第3の実施形態を説明する。

次に、本発明に係る放射線撮影システムの第3の実施形態を説明する。

実施形態3の構成では、放射線撮影制御装置100による、3次元の患者の骨格情報、関節角度に基づいたガイド画像の生成処理を追加する。

以下、図10から図12を用いて、実施形態1からの差分のみ説明する。

図10は、本実施形態の放射線撮システムの放射線撮影制御装置100の構成例である。放射線撮影制御装置100は、3次元骨格生成部1000を追加で有する。

3次元骨格生成部1000は、3次元の骨格を示す情報と3次元の関節角度を示す情報を生成する。なお、生成方法は実施形態1と同様の手法を用いることができる。

例えば、3次元骨格生成部1000は、人体を撮像した光学画像を入力データとし、撮像された人体の3次元の骨格および関節角度をラベルとして機械学習を行うことにより得られる学習済みモデルを用いて、現在画像における人体の骨格および関節位置を推定する。

なお、本実施形態において、入力データとして用いる3次元画像は、例えば、複数の光学カメラによって異なる角度から撮像された2次元画像を合成することにより生成されてもよい。あるいは、入力データとして用いる3次元画像は、1つの光学カメラを駆動し、角度を変えながら撮像した2次元画像から生成されてもよい。すなわち、本実施形態において、3次元画像を取得する方法は限定されず、被検体を撮像した3次元画像が取得できればよい。

そして、推定された骨格および関節位置から3次元の骨格を示す情報と3次元の関節角度を示す情報を生成する。なお、本実施形態において生成される情報は、2次元の光学画像に基づいて生成されてもよいし、3次元の光学画像に基づいて生成されてもよい。

なお、3次元骨格生成部1000は、3次元の骨格を示す情報と3次元の関節角度を示す情報が生成できれば、構成に制限はない。例えば、画像取得装置130から光学画像と距離の情報を持った位置情報を取得し患者の各関節の座標を取得し、あらかじめ保存した人体データに適用することで光学画像内の患者の3次元の骨格を示す情報と3次元の関節角度を示す情報を生成してもよい。

図11は、本実施形態の放射線撮影制御装置100の患者撮影時の表示処理工程の一例を示すフローチャートである。

ステップS1101では、3次元骨格生成部1000が、骨格生成部306が生成した骨格を示す情報と関節角度を示す情報を用いて、3次元の骨格を示す情報と3次元の関節角度を示す情報を生成する。そのため、後段のステップS406では、3次元骨格生成部1000が生成した3次元の骨格を示す情報と3次元の関節角度を示す情報に基づいてガイド画像を生成し、表示制御部304を介してUI表示装置203に光学画像に重畳表示する。

ステップS403からS406、およびステップS1101においてUI表示装置203に表示される光学画像およびガイド画像の表示に関する構成を、図12を用いて説明する。なお、過去ガイド画像の表示に関する構成も同様であるため説明を割愛する。すなわち、ステップS408において過去ガイド画像の生成には、過去画像に対応付いて記憶された3次元骨格生成部1000が生成した3次元の骨格を示す情報と3次元の関節角度を示す情報を用いる。

3次元ガイド画像1201は、ステップS1101において3次元骨格生成部1000が生成する患者の3次元の骨格を示す情報と3次元の関節角度を示す情報に基づいて、ガイド画像生成部307が生成する画像である。ガイド画像生成部307は、3次元ガイド画像1201を光学画像500へ重畳表示する指示を表示制御部304に行い、ガイド画像重畳表示画像1202として3次元ガイド画像1201が重畳表示された光学画像500が表示される。

なお、本実施形態では、3次元骨格生成部1000が生成する患者の3次元の関節角度を示す情報を、3次元極座標形式の文字列表示で表現している。すなわち、人体の関節位置において内側から外側へ向かう方向の骨格を示す情報に対し、z軸となす角度θ、x軸とxy平面に下ろした骨格を示す情報がなす角度φを各々表示している。しかしながら、3次元の関節角度を表現する方法であれば、上記に限定されない。

以上により、実施形態3では、放射線撮影制御装置100は、3次元の骨格を示す情報と3次元の関節角度を示す情報に基づいてガイド画像の生成を行う。これにより、ユーザは3次元の骨格を示す情報と3次元の関節角度を示す情報を参照できるようになり、ユーザの姿勢の位置決めの再現性をより向上させることができる。

[実施形態4]

次に、本発明に係る放射線撮影システムの実施形態4を説明する。

次に、本発明に係る放射線撮影システムの実施形態4を説明する。

実施形態4では、放射線撮影制御装置100は、UI表示装置203に表示された画像を患者に見せることで、患者自身が姿勢の再現性を向上させることができる構成を有する。

具体的には、表示制御部304は、UI表示装置203に表示する光学画像、重畳表示画像または過去重畳表示画像を左右に反転表示が可能な制御機能を追加で有する(不図示)。前述の図4のステップS402からS410の処理の間、ユーザが制御機能を有効にし、UI表示装置203を患者に提示する。

以上により、現在画像と、該現在画像に関連する患者の骨格を示す情報と関節角度を示す情報に基づいて生成されるガイド画像、および、過去画像と、該過去画像に関連する骨格を示す情報と関節角度を示す情報に基づいて生成される過去ガイド画像の重畳表示を患者自身が確認できる。これにより、ユーザの姿勢の位置決めの再現性を向上に加えて、患者自身が姿勢の再現性を向上させることが可能となる。

本発明は上記実施の形態に制限されるものではなく、本発明の精神及び範囲から離脱することなく、様々な変更及び変形が可能である。従って、本発明の範囲を公にするために以下の請求項を添付する。

本願は、2019年11月18日提出の日本国特許出願特願2019-208330を基礎として優先権を主張するものであり、その記載内容の全てをここに援用する。

Claims (20)

- 被検体に対して照射された放射線に基づいて放射線画像を取得する取得手段と、

第1の時点で取得された前記被検体の第1の光学画像に基づいて、前記第1の光学画像に関連する前記被検体の骨格を示す情報と関節角度を示す情報の少なくとも一方の情報を含む第1の処理画像を生成する第1の生成手段と、

前記第1の時点と異なる第2の時点で取得された前記被検体の第2の光学画像に基づいて、前記第2の光学画像に関連する前記被検体の前記骨格を示す情報と前記関節角度を示す情報のうち少なくとも一方の情報を含む第2の処理画像を生成する第2の生成手段と、

前記第1の処理画像および前記第2の処理画像を表示部に重畳して表示する表示制御手段と、

を備えることを特徴とする放射線撮影システム。 - 前記第1の生成手段は、前記骨格を示す情報と前記関節角度を示す情報の少なくとも一方の情報を前記第1の光学画像に重畳することにより第1の処理画像を生成し、

前記第2の生成手段は、前記骨格を示す情報と前記関節角度を示す情報の少なくとも一方の情報を前記第2の光学画像に重畳することにより第2の処理画像を生成することを特徴とする請求項1に記載の放射線撮影システム。 - 前記第1の生成手段は、前記第1の光学画像において、前記被検体の骨格の位置と前記関節角度のうち少なくとも一方の情報が視認可能なように前記第1の光学画像を構成する画素の画素値を変更することにより前記第1の処理画像を生成し、

前記第2の生成手段は、前記第2の光学画像において、前記骨格の位置と前記関節角度のうち少なくとも一方の情報が視認可能なように前記第2の光学画像を構成する画素の画素値を変更することにより前記第2の処理画像を生成することを特徴とする請求項1に記載の放射線撮影システム。 - 前記第1の光学画像および前記第1の光学画像に関連する前記骨格を示す情報と前記関節角度を示す情報、または、前記第1の処理画像のうち少なくとも一方を記憶部に記憶する記憶手段をさらに備えることを特徴とする請求項1乃至3のいずれか1項に記載の放射線撮影システム。

- 前記記憶手段は、前記第1の光学画像と、前記第1の光学画像に関連する前記骨格を示す情報と前記関節角度を示す情報及び前記第1の処理画像を記憶部に記憶することを特徴とする請求項4に記載の放射線撮影システム。

- 前記第1の光学画像から前記被検体の前記骨格と前記関節角度を推定する推定手段をさらに備え、

前記第1の生成手段は、前記推定手段により推定された前記骨格と前記関節の角度に基づいて生成された前記被検体の前記骨格を示す情報と前記関節角度を示す情報のうち少なくとも一方の情報に基づいて前記第1の処理画像を生成することを特徴とする請求項1乃至5のいずれか1項に記載の放射線撮影システム。 - 前記推定手段が推定する前記被検体の前記骨格と前記関節角度は3次元の情報であり、

前記第1の生成手段は、前記推定手段により推定された3次元の前記骨格と3次元の前記関節の角度に基づいて生成された前記被検体の3次元の前記骨格を示す情報と3次元の前記関節角度を示す情報のうち少なくとも一方の情報に基づいて前記第1の処理画像を生成することを特徴とする請求項6に記載の放射線撮影システム。 - 前記推定手段は、人体を撮像した複数の光学画像と、該複数の光学画像の前記人体における骨格を示す情報と関節の角度を示す情報を組として学習した学習モデルを用いて、前記第1の光学画像から前記被検体の前記骨格と前記関節角度を推定することを特徴とする請求項6または7に記載の放射線撮影システム。

- 前記第1の光学画像よりも過去に撮影された光学画像のうち、所定の撮影条件に基づいて得られた光学画像が存在するか否かを判定する判定手段をさらに備え、

前記第2の生成手段は、前記第1の光学画像よりも過去に撮影された光学画像のうち、前記所定の撮影条件に基づいて得られた前記第2の光学画像と関連付けて記憶された前記被検体の前記骨格を示す情報と前記関節の角度を示す情報のうち少なくとも一方を前記第2の光学画像に重畳することにより第2の処理画像を生成することを特徴とする請求項1乃至6のいずれか1項に記載の放射線撮影システム。 - 前記所定の撮影条件は、患者ID、検査ID、検査部位あるいは撮影方向の情報を含むことを特徴とする請求項7に記載の放射線撮影システム。

- 前記第2の生成手段は、前記第1の生成手段が、前記骨格を示す情報に基づいて前記第1の処理画像を生成する場合、前記第2の光学画像と関連付けて記憶された前記骨格を示す情報に基づいて第2の処理画像を生成し、前記第1の生成手段が、前記関節角度を示す情報に基づいて前記第1の処理画像を生成する場合、前記第2の光学画像と関連付けて記憶された前記関節角度を示す情報に基づいて第2の処理画像を生成することを特徴とする請求項1乃至8のいずれか1項に記載の放射線撮影システム。

- 前記第1の生成手段は、前記被検体の前記骨格を示す情報及び前記関節角度を示す情報に基づいて前記第1の処理画像を生成し、

前記第2の生成手段は、前記第2の光学画像と関連付けて記憶された前記被検体の前記骨格を示す情報と前記関節角度を示す情報に基づいて前記第2の処理画像を生成することを特徴とする請求項1乃至9のいずれか1項に記載の放射線撮影システム。 - 前記第1の処理画像と前記第2の処理画像の生成に関する設定の選択をユーザから受け付ける受付手段をさらに備え、

前記表示制御手段は、前記受付手段により選択された設定に基づいた情報を前記表示部に表示することを特徴とする請求項1乃至12のいずれか1項に記載の放射線撮影装置。 - 前記第1の処理手段は、前記受付手段により受け付けられた設定に基づいて、前記第1の処理画像を生成し、

前記第2の処理手段は、前記受付手段により受け付けられた設定に基づいて、前記第2の処理画像を生成することを特徴とする請求項13に記載の放射線撮影システム。 - 前記受付手段は、前記第1の光学画像、前記骨格を示す情報、あるいは、前記関節角度を示す情報のうち、少なくとも1つの情報について、前記表示部に表示するか否かの設定を受け付けることを特徴とする請求項13または14に記載の放射線撮影システム。

- 前記表示制御部は、前記表示部に表示された前記第1の光学画像、前記第1の処理画像及び前記第2の処理画像を左右に反転表示が可能なことを特徴とする請求項1乃至15のいずれか1項に記載の放射線撮影システム。

- 被検体に対して照射された放射線に基づいて放射線画像を取得する取得手段と、

第1の時点で取得された被検体の第1の光学画像に関連する前記被検体の骨格を示す情報と関節角度を示す情報の少なくとも一方の情報に基づいて生成される第1のガイド画像と、前記第1の時点と異なる第2の時点で取得された第2の光学画像に関連する前記被検体の前記骨格を示す情報と前記関節角度を示す情報のうち少なくとも一方の情報に基づいて生成される第2のガイド画像とを重畳して表示部に表示する表示制御手段と、

を備えることを特徴とする放射線撮影システム。 - 第1の時点で取得された被検体の第1の光学画像に基づいて、前記第1の光学画像における前記被検体の骨格を示す情報と関節角度を示す情報の少なくとも一方の情報を含む第1の処理画像を生成する第1の生成手段と、

前記第1の時点と異なる第2の時点で取得された前記被検体の第2の光学画像と、前記第2の光学画像における前記被検体の骨格を示す情報と関節角度を示す情報の少なくとも一方の情報を含む第2の処理画像を生成する第2の生成手段と、

前記第1の処理画像および前記第2の処理画像が重畳して表示部に表示させる表示制御手段と、

を備えることを特徴とする画像処理装置。 - 被検体に対して照射された放射線に基づいて放射線画像を取得する取得工程と、

第1の時点で取得された前記被検体の第1の光学画像に基づいて、前記第1の光学画像に関連する前記被検体の骨格を示す情報と関節角度を示す情報の少なくとも一方の情報を含む第1の処理画像を生成する第1の生成工程と、

前記第1の時点と異なる第2の時点で取得された前記被検体の第2の光学画像に基づいて、前記第2の光学画像に関連する前記被検体の前記骨格を示す情報と前記関節角度を示す情報のうち少なくとも一方の情報を含む第2の処理画像を生成する第2の生成工程と、

前記第1の処理画像および前記第2の処理画像を表示部に重畳して表示する表示制御工程と、

を備えることを特徴とする放射線撮影方法。 - 請求項19に記載の放射線撮影方法をコンピュータに実行させるためのプログラム。

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US17/742,238 US20220265228A1 (en) | 2019-11-18 | 2022-05-11 | Radiation imaging system, radiation imaging method, image processing apparatus, and storage medium |

Applications Claiming Priority (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2019-208330 | 2019-11-18 | ||

| JP2019208330A JP7527773B2 (ja) | 2019-11-18 | 2019-11-18 | 放射線撮影システム、放射線撮影方法、画像処理装置およびプログラム |

Related Child Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| US17/742,238 Continuation US20220265228A1 (en) | 2019-11-18 | 2022-05-11 | Radiation imaging system, radiation imaging method, image processing apparatus, and storage medium |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| WO2021100513A1 true WO2021100513A1 (ja) | 2021-05-27 |

Family

ID=75965711

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| PCT/JP2020/041695 WO2021100513A1 (ja) | 2019-11-18 | 2020-11-09 | 放射線撮影システム、放射線撮影方法、画像処理装置およびプログラム |

Country Status (3)

| Country | Link |

|---|---|

| US (1) | US20220265228A1 (ja) |

| JP (1) | JP7527773B2 (ja) |

| WO (1) | WO2021100513A1 (ja) |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2024090050A1 (ja) * | 2022-10-27 | 2024-05-02 | 富士フイルム株式会社 | 画像処理装置、方法およびプログラム、並びに学習装置、方法およびプログラム |

Families Citing this family (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| EP4364668A1 (en) * | 2022-11-03 | 2024-05-08 | Koninklijke Philips N.V. | A device, computer program product and method for assisting in positioning at least one body part of a patent for an x-ray acquisition |

| WO2024177072A1 (ja) * | 2023-02-21 | 2024-08-29 | 富士フイルム株式会社 | 情報処理装置、情報処理方法及び情報処理プログラム |

Citations (6)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2004057804A (ja) * | 2002-06-05 | 2004-02-26 | Fuji Photo Film Co Ltd | 骨関節評価方法、装置およびそのためのプログラム |

| WO2013085048A1 (ja) * | 2011-12-08 | 2013-06-13 | シャープ株式会社 | 情報端末装置、遠隔測定システム、情報端末装置の制御方法、制御プログラムおよび記録媒体 |

| JP2014117368A (ja) * | 2012-12-14 | 2014-06-30 | Toshiba Corp | X線診断装置及びその制御方法 |

| JP2015198824A (ja) * | 2014-04-09 | 2015-11-12 | 株式会社東芝 | 医用画像診断装置 |

| WO2016086266A1 (en) * | 2014-12-05 | 2016-06-09 | Myfiziq Limited | Imaging a body |

| JP2017136300A (ja) * | 2016-02-05 | 2017-08-10 | 東芝メディカルシステムズ株式会社 | X線撮影システム |

Family Cites Families (10)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN101123911B (zh) * | 2005-11-25 | 2012-02-15 | 株式会社东芝 | 医学影像诊断装置 |

| US8562403B2 (en) * | 2010-06-11 | 2013-10-22 | Harmonix Music Systems, Inc. | Prompting a player of a dance game |

| US10033979B2 (en) * | 2012-03-23 | 2018-07-24 | Avigilon Fortress Corporation | Video surveillance systems, devices and methods with improved 3D human pose and shape modeling |

| KR20140116740A (ko) * | 2013-03-25 | 2014-10-06 | 삼성전자주식회사 | 안무 영상을 표시하는 디스플레이 장치 및 표시 방법 |

| EP2808760B1 (en) * | 2013-05-29 | 2023-08-16 | Dassault Systèmes | Body posture tracking |

| US10670679B2 (en) * | 2016-07-01 | 2020-06-02 | Canon Medical Systems Corporation | Magnetic resonance imaging apparatus and image processing apparatus |

| US20180121729A1 (en) * | 2016-11-02 | 2018-05-03 | Umbo Cv Inc. | Segmentation-based display highlighting subject of interest |

| JP7067912B2 (ja) * | 2017-12-13 | 2022-05-16 | キヤノン株式会社 | 放射線撮像装置および放射線撮像システム |

| US20190370537A1 (en) * | 2018-05-29 | 2019-12-05 | Umbo Cv Inc. | Keypoint detection to highlight subjects of interest |

| US10956724B1 (en) * | 2019-09-10 | 2021-03-23 | Facebook Technologies, Llc | Utilizing a hybrid model to recognize fast and precise hand inputs in a virtual environment |

-

2019

- 2019-11-18 JP JP2019208330A patent/JP7527773B2/ja active Active

-

2020

- 2020-11-09 WO PCT/JP2020/041695 patent/WO2021100513A1/ja active Application Filing

-

2022

- 2022-05-11 US US17/742,238 patent/US20220265228A1/en active Pending

Patent Citations (6)