WO2011090107A1 - 画像処理装置、撮像装置、プログラム及び画像処理方法 - Google Patents

画像処理装置、撮像装置、プログラム及び画像処理方法 Download PDFInfo

- Publication number

- WO2011090107A1 WO2011090107A1 PCT/JP2011/050948 JP2011050948W WO2011090107A1 WO 2011090107 A1 WO2011090107 A1 WO 2011090107A1 JP 2011050948 W JP2011050948 W JP 2011050948W WO 2011090107 A1 WO2011090107 A1 WO 2011090107A1

- Authority

- WO

- WIPO (PCT)

- Prior art keywords

- light receiving

- value

- unit

- pixel value

- light

- Prior art date

Links

- 238000003384 imaging method Methods 0.000 title claims abstract description 34

- 238000003672 processing method Methods 0.000 title claims abstract description 6

- 238000000034 method Methods 0.000 claims description 163

- 238000004364 calculation method Methods 0.000 claims description 62

- 230000006870 function Effects 0.000 claims description 45

- 238000011156 evaluation Methods 0.000 claims description 42

- 230000008569 process Effects 0.000 claims description 27

- 238000013528 artificial neural network Methods 0.000 claims description 16

- 238000003860 storage Methods 0.000 claims description 14

- 230000035945 sensitivity Effects 0.000 claims description 3

- 238000010586 diagram Methods 0.000 description 41

- 238000005070 sampling Methods 0.000 description 17

- 230000004927 fusion Effects 0.000 description 9

- 230000008859 change Effects 0.000 description 8

- 230000003287 optical effect Effects 0.000 description 8

- 238000001514 detection method Methods 0.000 description 6

- 238000009826 distribution Methods 0.000 description 6

- 230000000052 comparative effect Effects 0.000 description 4

- 238000012986 modification Methods 0.000 description 4

- 230000004048 modification Effects 0.000 description 4

- 238000007476 Maximum Likelihood Methods 0.000 description 2

- 230000003044 adaptive effect Effects 0.000 description 2

- 230000006866 deterioration Effects 0.000 description 2

- 230000000694 effects Effects 0.000 description 2

- 230000002093 peripheral effect Effects 0.000 description 2

- 230000009467 reduction Effects 0.000 description 2

- 230000002194 synthesizing effect Effects 0.000 description 2

- NAWXUBYGYWOOIX-SFHVURJKSA-N (2s)-2-[[4-[2-(2,4-diaminoquinazolin-6-yl)ethyl]benzoyl]amino]-4-methylidenepentanedioic acid Chemical compound C1=CC2=NC(N)=NC(N)=C2C=C1CCC1=CC=C(C(=O)N[C@@H](CC(=C)C(O)=O)C(O)=O)C=C1 NAWXUBYGYWOOIX-SFHVURJKSA-N 0.000 description 1

- 238000013144 data compression Methods 0.000 description 1

- 238000009795 derivation Methods 0.000 description 1

- 230000002542 deteriorative effect Effects 0.000 description 1

- 238000001914 filtration Methods 0.000 description 1

- 230000017525 heat dissipation Effects 0.000 description 1

- 230000007246 mechanism Effects 0.000 description 1

- 238000004091 panning Methods 0.000 description 1

- 238000012887 quadratic function Methods 0.000 description 1

- 238000011946 reduction process Methods 0.000 description 1

- 230000003252 repetitive effect Effects 0.000 description 1

- 239000007787 solid Substances 0.000 description 1

- 230000002123 temporal effect Effects 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T3/00—Geometric image transformations in the plane of the image

- G06T3/40—Scaling of whole images or parts thereof, e.g. expanding or contracting

- G06T3/4053—Scaling of whole images or parts thereof, e.g. expanding or contracting based on super-resolution, i.e. the output image resolution being higher than the sensor resolution

- G06T3/4069—Scaling of whole images or parts thereof, e.g. expanding or contracting based on super-resolution, i.e. the output image resolution being higher than the sensor resolution by subpixel displacements

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N25/00—Circuitry of solid-state image sensors [SSIS]; Control thereof

- H04N25/40—Extracting pixel data from image sensors by controlling scanning circuits, e.g. by modifying the number of pixels sampled or to be sampled

- H04N25/46—Extracting pixel data from image sensors by controlling scanning circuits, e.g. by modifying the number of pixels sampled or to be sampled by combining or binning pixels

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/60—Control of cameras or camera modules

- H04N23/667—Camera operation mode switching, e.g. between still and video, sport and normal or high- and low-resolution modes

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/95—Computational photography systems, e.g. light-field imaging systems

- H04N23/951—Computational photography systems, e.g. light-field imaging systems by using two or more images to influence resolution, frame rate or aspect ratio

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N25/00—Circuitry of solid-state image sensors [SSIS]; Control thereof

- H04N25/48—Increasing resolution by shifting the sensor relative to the scene

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N25/00—Circuitry of solid-state image sensors [SSIS]; Control thereof

- H04N25/60—Noise processing, e.g. detecting, correcting, reducing or removing noise

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N7/00—Television systems

- H04N7/015—High-definition television systems

- H04N7/0152—High-definition television systems using spatial or temporal subsampling

- H04N7/0155—High-definition television systems using spatial or temporal subsampling using pixel blocks

Definitions

- the present invention relates to an image processing device, an imaging device, a program, an image processing method, and the like.

- Some modern digital cameras and video cameras can be used by switching between still image shooting mode and movie shooting mode. For example, there is a camera that can shoot a still image with a resolution higher than that of a moving image by a user operating a button during moving image shooting.

- the method of switching between the still image shooting mode and the moving image shooting mode has a problem that when the user notices a photo opportunity, a decisive moment is often missed already.

- Patent Documents 1 and 2 disclose a method of synthesizing a high resolution image from a low resolution image acquired by pixel shift.

- the methods of Patent Documents 1 and 2 have problems that the processing load increases and pixel value estimation may be difficult.

- an image processing device an imaging device, a program, an image processing method, and the like that can acquire a high resolution image from a low resolution moving image with simple processing.

- a light reception unit which is a unit for obtaining a light reception value, is set for each of a plurality of pixels of an image sensor, and pixel values of a plurality of pixels included in the light reception unit are added to receive light of the light reception unit.

- a storage unit that stores the acquired low-resolution frame image and a plurality of low-resolution frame images stored in the storage unit

- An estimation calculation unit that estimates a pixel value of each pixel included in the light-receiving unit, and a high-resolution frame having a higher resolution than the low-resolution frame image based on the pixel value estimated by the estimation calculation unit

- An image output unit that outputs an image, wherein the light reception values of the light reception units are read while sequentially shifting pixels while superimposing the light reception units, and the low-resolution frame image is acquired, and the estimation calculation unit Is said Units based on a plurality of received-light value obtained by sequentially pixel shift, related to the image processing apparatus for estimating a pixel value of each pixel included in the light receiving unit.

- pixel values of a plurality of pixels included in a light reception unit are added to read a light reception value, and a low resolution frame image is acquired.

- the received light value is read while sequentially shifting the pixels while superimposing the received light units.

- the pixel value of each pixel included in the light reception unit is estimated, and a high-resolution frame image is output based on the estimated pixel value Is done.

- the light receiving unit is sequentially set to a first position and a second position next to the first position by the pixel shift, and the light receiving unit of the first position is set. And the light receiving unit of the second position overlap, the estimation calculation unit obtains a difference value of the light receiving values of the light receiving units of the first and second positions, and calculates from the light receiving unit of the first position.

- a first intermediate pixel value that is a light receiving value of the first light receiving region excluding the overlapping region, and a second light receiving value of the second light receiving region that excludes the overlapping region from the light receiving unit of the second position. Is expressed using the difference value, the first and second intermediate pixel values are estimated using the relational expression, and the estimated first intermediate pixel value is used.

- the pixel value of each pixel of the light receiving unit may be obtained. .

- the estimation calculation unit may use an intermediate pixel of the intermediate pixel value pattern when a continuous intermediate pixel value including the first and second intermediate pixel values is an intermediate pixel value pattern.

- the relational expression between the values is expressed using the received light value of the light receiving unit, and the similarity is evaluated by comparing the intermediate pixel value pattern expressed by the relational expression between the intermediate pixel values with the received light value of the light receiving unit.

- the intermediate pixel value of the intermediate pixel value pattern may be determined based on the similarity evaluation result so that the similarity is the highest.

- an intermediate pixel value can be estimated based on a plurality of light reception values acquired by pixel shifting while superimposing light reception units.

- the estimation calculation unit obtains an evaluation function representing an error between the intermediate pixel value pattern represented by a relational expression between intermediate pixel values and the received light value of the light receiving unit, and the evaluation

- the intermediate pixel value of the intermediate pixel value pattern may be determined so that the function value is minimized.

- the intermediate pixel value is determined so that the similarity between the intermediate pixel value pattern and the received light value is the highest. it can.

- the correspondence relationship of the intermediate pixel value pattern with respect to the light reception value of the light reception unit is based on a known high-resolution frame image between the light reception value of the light reception unit and the intermediate pixel value pattern.

- the estimation calculation unit based on the foresight information, the intermediate pixel value pattern represented by a relational expression between intermediate pixel values and the received light reception value of the light receiving unit You may evaluate the similarity with.

- the estimation calculation unit includes a neural network that uses a coefficient obtained as the look-ahead information by learning based on the known high-resolution frame image as a node weighting coefficient,

- the neural network receives the intermediate pixel value pattern and the light reception value of the light receiving unit and outputs the similarity evaluation result, and the estimation calculation unit is configured to output the similarity based on the similarity evaluation result from the neural network.

- the value of the intermediate pixel value of the intermediate pixel value pattern may be determined.

- the similarity evaluation based on the foresight information can be realized by using the neural network that uses the node weighting coefficient as the foreseeing information.

- each pixel value of the light reception unit is weighted and added and read as a light reception value of the light reception unit, and the estimation calculation unit receives the light reception value of the light reception unit obtained by weighted addition. Based on the above, the pixel value of each pixel of the light receiving unit may be estimated.

- each pixel value of the light receiving unit is weighted and added to obtain a low-resolution frame image, and the pixel value of the high-resolution frame image can be estimated from the obtained low-resolution frame image.

- the pixel shift is performed in each frame, the light reception unit is sequentially set to a plurality of positions by the pixel shift, the light reception unit is set to the same position for each of a plurality of frames,

- the low-resolution frame image is a continuous low-resolution frame image acquired corresponding to each position in time series, a process of interpolating the light-receiving values of the light-receiving units at the plurality of positions in each frame

- the interpolation processing unit includes a light receiving value of a light receiving unit at a missing position in the continuous low-resolution frame image of the interpolation target frame, and the received light value of the frame before and after the interpolation target frame.

- time axis interpolation is performed using the received light value of the received light unit at the same position as the missing position, and the estimation calculation unit Based on the continuous low-resolution frame image interpolated by axis interpolation, the pixel value of each pixel of the light receiving unit in each frame may be estimated.

- the light reception value is acquired by the pixel shift, the light reception value of the missing position is interpolated using the acquired light reception value, and the pixel value of each pixel of the light reception unit is obtained from the light reception value after the interpolation. Can do.

- the image output unit outputs the high-resolution frame image in each frame based on the pixel value of each pixel of the light receiving unit in each frame estimated by the estimation calculation unit. Alternatively, it may be output as a still image or a moving image.

- a high-resolution frame image in each frame can be output as a still image or a moving image.

- the interpolation processing unit may perform the time axis interpolation using a time axis interpolation filter.

- time axis interpolation can be performed by the time axis interpolation filter.

- the interpolation processing unit may detect the missing position in the interpolation target frame when a difference value of light reception values of light reception units in the preceding and following frames is smaller than a predetermined threshold.

- the received light value of the received light unit is interpolated using the received light value of the received light unit in the same position as the missing position in the preceding and succeeding frames, and the difference value of the received light value of the received light unit in the preceding and succeeding frames is predetermined. If the received light value is larger than the threshold value, the light reception value of the light reception unit at the missing position in the interpolation target frame may be interpolated using the light reception value acquired in the interpolation target frame.

- the first light receiving unit and the second light receiving unit are adjacent light receiving units, and the first and second light receiving units are shifted from each other by the pixel shift to the first position and the first light receiving unit.

- Sequentially set to the second position next to the first position the first light receiving units of the first and second positions overlap in a first overlapping region, and the first and second positions of the first and second positions overlap.

- the estimation calculation unit is a first light receiving region obtained by removing the first overlapping region from the first light receiving unit at the first position.

- the third intermediate pixel value which is the light receiving value of the third light receiving area excluding the second overlapping area, is set as an unknown number, and the second overlapping area is excluded from the second light receiving unit at the second position.

- a fourth intermediate pixel value that is a light reception value of the fourth light reception region is expressed by a relational expression using the unknown and is obtained as an intermediate pixel value of the second light reception region that is the same region as the third light reception region.

- the unknown search range may be set based on the second intermediate pixel value, and the third intermediate pixel value may be estimated by exploring the unknown in the set search range.

- an unknown search range to be estimated next can be set.

- the first light receiving unit and the second light receiving unit are adjacent light receiving units, and the first and second light receiving units are shifted from each other by the pixel shift to the first position and the first light receiving unit.

- Sequentially set to the second position next to the first position the first light receiving units of the first and second positions overlap in a first overlapping region, and the first and second positions of the first and second positions overlap.

- the estimation calculation unit is a first light receiving region obtained by removing the first overlapping region from the first light receiving unit at the first position.

- a fifth intermediate pixel value that is a light reception value of a fifth light receiving region that is an overlapping region of the first light receiving unit at the second position and the second light receiving unit at the first position.

- Including a first intermediate pixel value that is a continuous intermediate pixel value that does not include the first and fourth intermediate pixel values, and the third and fifth light receiving regions are In the case of the same light receiving area, the intermediate pixel value of the same light receiving area is Through third intermediate pixel value and the second obtained by the estimation of the pattern, the third may be finally determined based on the intermediate pixel value of the fifth.

- the final intermediate pixel value of the light receiving area can be determined based on the three estimated values obtained by estimating the intermediate pixel value of the same light receiving area three times.

- the estimation calculation unit may perform a filter process with different filter coefficients on the pixel value obtained by the estimation according to the pixel position in the light receiving unit.

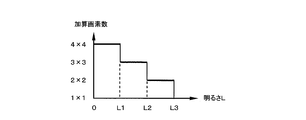

- the number of pixels included in the light receiving unit is set to a larger number of pixels as the brightness of the subject is darker, and the image output unit is more sensitive as the brightness of the subject is darker.

- the high-resolution frame image may be output.

- the number of pixels included in the light receiving unit is set according to the brightness of the subject, and a high-resolution frame image with sensitivity according to the brightness of the subject can be output.

- the image sensor is a color image sensor, and a plurality of adjacent pixels are set in the light receiving unit regardless of the color of the pixel, and the adjacent plurality of pixels set in the light receiving unit.

- the pixel values of the pixels are added and read out, the low-resolution frame image is acquired, and the estimation calculation unit estimates the pixel value of each pixel of the light receiving unit based on the acquired low-resolution frame image

- the image output unit may output the color high-resolution frame image based on the pixel value estimated by the estimation calculation unit.

- the image sensor is a color image sensor

- a plurality of pixels of the same color are set as the light reception unit

- pixel values of the pixels of the same color set as the light reception unit Are added and read out

- the low resolution frame image is acquired

- the estimation calculation unit estimates a pixel value of each pixel of the light receiving unit based on the acquired low resolution frame image, and outputs the image

- the unit may output the color high-resolution frame image based on the pixel value estimated by the estimation calculation unit.

- a low-resolution frame image is acquired, and pixel values are estimated from the low-resolution frame image to obtain a high-resolution color image.

- a frame image can be acquired.

- a light receiving unit is set for each of the imaging element and the plurality of pixels of the imaging element, and pixel values of the plurality of pixels of the light receiving unit are added to obtain a light receiving value of the light receiving unit.

- a readout control unit that reads out and acquires a low resolution frame image, a storage unit that stores the low resolution frame image acquired by the readout control unit, and a plurality of low resolution frame images stored in the storage unit Based on an estimation calculation unit that estimates a pixel value of each pixel of the light receiving unit, and a high-resolution frame image having a higher resolution than the low-resolution frame image based on the pixel value estimated by the estimation calculation unit

- An image output unit that outputs the received light value of the light receiving unit while sequentially shifting the pixels while superimposing the light receiving unit to obtain the low-resolution frame image, and the estimation Performance Parts, the light receiving unit based on a plurality of received-light value obtained by sequentially pixel shift, related to the image pickup apparatus for estimating a

- a light receiving unit which is a unit for obtaining a light receiving value, is set for each of a plurality of pixels of an image sensor, and pixel values of a plurality of pixels included in the light receiving unit are added to the light receiving unit.

- a storage unit that stores the acquired low-resolution frame image when a low-resolution frame image is acquired and is read as a light reception value in units, and a plurality of low-resolution frame images stored in the storage unit Based on the estimation calculation unit for estimating the pixel value of each pixel included in the light receiving unit, and on the basis of the pixel value estimated by the estimation calculation unit, a higher resolution than the low-resolution frame image.

- the computer functions as an image output unit that outputs an image frame image, and the light reception value of the light reception unit is read while sequentially shifting the pixels while superimposing the light reception units, and the low resolution frame image is obtained.

- the estimation calculation section the light receiving unit based on a plurality of received-light value obtained by sequentially pixel shifting, there is provided a program for estimating the pixel value of each pixel included in the light receiving unit.

- a light receiving unit is set for each of a plurality of pixels of an image sensor, and pixel values of the plurality of pixels of the light receiving unit are added while sequentially shifting the pixels while superimposing the light receiving units.

- the received light value is read as the received light unit and a low resolution frame image is acquired, the acquired low resolution frame image is stored, and the received light that constitutes the plurality of stored low resolution frame images

- the pixel value of each pixel of the light receiving unit is estimated based on a plurality of light receiving values obtained by sequentially shifting the light receiving unit, which is a value, and the low value is calculated based on the estimated pixel value.

- the present invention relates to an image processing method for outputting a high resolution frame image having a higher resolution than the resolution frame image.

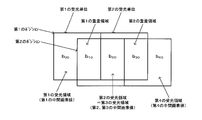

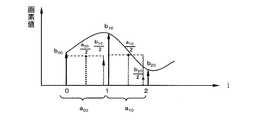

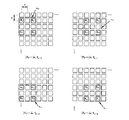

- FIG. 1A is an explanatory diagram of an estimation processing block

- FIG. 1B is an explanatory diagram of a light receiving unit.

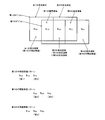

- FIG. 2A is an explanatory diagram of estimated pixel values

- FIG. 2B is an explanatory diagram of intermediate pixel values.

- FIG. 3 is an explanatory diagram of an intermediate pixel value estimation method in the first estimation method.

- FIG. 4 is an explanatory diagram of an intermediate pixel value estimation method in the first estimation method.

- FIG. 5 is an explanatory diagram of an intermediate pixel value estimation method in the first estimation method.

- FIG. 6A and FIG. 6B are explanatory diagrams of an estimation method of an estimated pixel value in the first estimation method.

- FIG. 7 is an explanatory diagram of an estimation method of an estimated pixel value in the first estimation method.

- FIG. 8 is an explanatory diagram of an estimation method of an estimated pixel value in the first estimation method.

- FIG. 9 is an explanatory diagram of an estimation method of an estimated pixel value in the first estimation method.

- FIG. 10 is an explanatory diagram of the second estimation method.

- FIG. 11 is an explanatory diagram of the second estimation method.

- FIG. 12 is an explanatory diagram of the second estimation method.

- FIG. 13 is an explanatory diagram of the second estimation method.

- FIG. 14 is an explanatory diagram of search range setting in the second estimation method.

- FIG. 15 is a schematic explanatory diagram of the second estimation method.

- FIG. 16 is an explanatory diagram of a third estimation method.

- FIG. 17 is a schematic explanatory diagram of a third estimation method.

- FIG. 16 is an explanatory diagram of a third estimation method.

- FIG. 18 is an explanatory diagram of a fourth estimation process.

- FIG. 19 shows a configuration example of a noise filter.

- FIG. 20 is an explanatory diagram of weighting factors in the fifth estimation process.

- FIGS. 21A and 21B are explanatory diagrams of an intermediate pixel value estimation method in the fifth estimation process.

- FIG. 22 is an explanatory diagram of an intermediate pixel value estimation method in the fifth estimation process.

- FIG. 23 is an explanatory diagram of an intermediate pixel value estimation method in the fifth estimation process.

- FIG. 24 is an explanatory diagram of an intermediate pixel value estimation method in the fifth estimation process.

- FIG. 25A and FIG. 25B are explanatory diagrams of an estimation method of an estimated pixel value in the fifth estimation process.

- FIG. 26 is an explanatory diagram of an estimation method of an estimated pixel value in the fifth estimation process.

- FIG. 27 is an explanatory diagram of an estimation method of an estimated pixel value in the fifth estimation process.

- FIG. 28 is an explanatory diagram of an estimation method of an estimated pixel value in the fifth estimation process.

- FIG. 29 is an explanatory diagram of a first interpolation method of received light values.

- FIG. 30 is a timing chart example of interpolation processing.

- FIG. 31 is a first detailed configuration example of an imaging apparatus and an image processing apparatus.

- FIG. 32 is an explanatory diagram of motion compensation for a fusion frame.

- FIG. 33 is an explanatory diagram of a second interpolation method of received light values.

- FIG. 34 is an explanatory diagram of a second interpolation method of received light values.

- FIG. 35 is an explanatory diagram of a first estimation method of a color image.

- FIG. 36 is an explanatory diagram of a second estimation method of a color image.

- FIG. 37 is an explanatory diagram of a second color image estimation method.

- FIG. 38 is an explanatory diagram of a second estimation method of a color image.

- FIG. 39 is an explanatory diagram of a second color image estimation method.

- FIG. 40 shows a method for setting the number of added pixels adapted to the brightness.

- FIG. 41 is a second detailed configuration example of the imaging device and the image processing device.

- Comparative Example First a comparative example of this embodiment will be described.

- digital camera and video camera products there are those in which a digital camera mainly for still image shooting has a moving image shooting function, and in which a video camera mainly for moving image shooting has a still image shooting function.

- Many of these cameras are used by switching between a still image shooting mode and a moving image shooting mode. Some of them enable high-definition still images to be shot at a high-speed frame rate comparable to that of moving image shooting, and high-speed continuous shooting in a short time is possible. If such a device is used, there is the convenience that a still image and a moving image can be shot with a single device.

- a high-pixel image sensor capable of shooting a high-definition image with multiple pixels is used, and a low-resolution image is obtained by thinning-out readout of pixels or addition readout of adjacent pixels.

- a method realized by reducing data is conceivable.

- a high-definition image cannot be taken at a high frame rate.

- a technique for obtaining a high-resolution image from a low-resolution image for example, a technique for generating a high-resolution image by performing so-called super-resolution processing on a low-resolution image captured by pixel shifting is conceivable.

- a method using addition reading can be considered. That is, after the low-resolution image is read out while sequentially shifting the position, a high-definition image is temporarily assumed based on the plurality of position-shifted images. Then, the assumed image is degraded to generate a low resolution image, which is compared with the original low resolution image, the high definition image is deformed so that the difference is minimized, and the high definition image is estimated.

- ML Maximum-Likelihood

- MAP Maximum A Posterior

- a POCS Projection Onto Convex Set

- IBP Iterative Back Projection

- Patent Document 1 As a technique using super-resolution processing, there is a technique disclosed in Patent Document 1 described above. In this method, low-resolution images that have been pixel-shifted during moving image shooting are sequentially shot in time series, and a plurality of low-resolution images are combined to assume a high-resolution image. Then, the super-resolution processing is performed on the assumed high-resolution image, and a high-resolution image with high likelihood is estimated.

- Patent Document 2 discloses a technique for generating a high-resolution image using a plurality of pixel-shifted low-resolution images.

- a temporary pixel constituting a high-resolution image to be obtained is set as a sub-pixel, and the pixel value of the sub-pixel is set so that the average value of the sub-pixel matches the pixel value of the captured low-resolution image.

- initial values of a plurality of subpixels are set, pixel values of subpixels excluding the subpixels to be calculated are subtracted from pixel values of the low resolution image, and pixel values are obtained sequentially. Applies to pixels.

- a low-resolution moving image with a high frame rate is captured by shifting pixels, and a high-resolution image is generated from the low-resolution moving image by a simple pixel estimation method. Then, using the generated high-resolution image, a high-resolution still image at an arbitrary timing in the moving image is acquired, or a high-resolution moving image with a high frame rate is acquired.

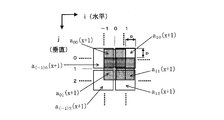

- 1A and 1B are schematic explanatory diagrams of an estimation processing block and a light receiving unit used for pixel estimation.

- pixels on the image sensor are indicated by solid-line squares

- pixel positions in the horizontal direction (horizontal scanning direction) are indicated by i

- pixel positions in the vertical direction are indicated by j ( i and j are natural numbers).

- estimation processing blocks Bk 00 , Bk 10 ,... With m ⁇ n pixels as one block are set.

- pixel value estimation processing for a high resolution image is performed for each estimation processing block.

- FIG. 1B schematically shows one of the above estimation processing blocks.

- four pixels (a plurality of pixels in a broad sense) are set as one light receiving unit, and pixel values of four pixels in the light receiving unit are added and read (mixed reading) to receive light.

- the unit light reception values a 00 to a (m ⁇ 1) (n ⁇ 1) are acquired.

- This light reception unit is set for every four pixels, and the light reception values a 00 to a (m ⁇ 1) (n ⁇ 1) are sequentially obtained by setting the light reception unit by shifting one pixel at a time for each frame. For example, a 00 , a 20 ,... Are acquired in the first frame, a 10 , a 30 ,... Are acquired in the second frame, and a 11 , a 31 ,. And a 01 , a 21 ,... Are acquired in the fourth frame.

- a pixel estimation method will be described with reference to FIGS.

- the light reception values a 00 to a 11 used for pixel estimation may be the light reception values themselves acquired by addition reading, or may be light reception values interpolated by time axis interpolation described later.

- FIG. 2A and 2B are explanatory diagrams of the estimated pixel value and the intermediate pixel value.

- the pixel values v 00 to v 22 are finally estimated using the received light values a 00 to a 11 . That is, assuming that the pixel pitch of the image sensor is p, a high resolution image having the same resolution (number of pixels) as that of the image sensor having the pixel pitch p is estimated from the low resolution image acquired by the light receiving unit having the pixel pitch 2p.

- an intermediate pixel value b 00 to b 21 (intermediate estimated pixel value, two-pixel added value) is estimated from the received light values a 00 to a 11 and the intermediate pixel value b 00 Pixel values v 00 to v 22 are estimated from .about.b 21 .

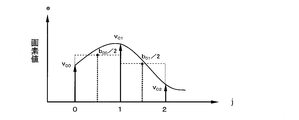

- This intermediate pixel value estimation method will be described using the intermediate pixel values b 00 to b 20 in the first horizontal row shown in FIG. 3 as an example.

- the intermediate pixel values b 10 and b 20 can be expressed as a function of b 00 as shown in the following equation (2).

- b 00 (unknown number)

- b 10 a 00 -b 00

- ⁇ i 0 is a difference value between the received light values one shift away, and corresponds to the difference value between the intermediate pixel values b 20 and b 00 .

- a pattern ⁇ a 00 , a 10 ⁇ based on pixel values detected by superposition shift sampling is compared with a pattern ⁇ b 00 , b 10 , b 20 ⁇ based on intermediate pixel values. Then, an unknown number b 00 that minimizes the error is derived, and the derived unknown number b 00 is set as the final intermediate pixel value b 00 .

- error evaluation is performed on the average value of the intermediate pixel values and the pattern ⁇ a 00 , a 10 ⁇ having a low frequency component.

- the pattern including many high frequency components as the estimated solution of the intermediate pixel values ⁇ b 00, b 10, b 20 ⁇ is derived. That is, even if the estimation of the unknown is inaccurate, an image including a large amount of low frequency components is generated. For this reason, it is possible to suppress generation of a pattern including an error in a high frequency component in which unnaturalness is more easily emphasized than in a low frequency component, and the natural appearance of the image is not lost. Thereby, rational pixel estimation is possible for a natural image having a small high frequency component compared to a low frequency component.

- the value of the intermediate pixel value b 00 is estimated, and the estimated value of b 00 is substituted into the above equation (2) to determine the values of the intermediate pixel values b 10 and b 20 .

- the intermediate pixel values b 01 to b 21 in the second row are estimated using b 01 as an unknown number.

- 6A and 6B schematically illustrate the intermediate pixel value and the estimated pixel value.

- estimation is performed using two columns of intermediate pixel values b 00 to b 11 out of the three columns of intermediate pixel values b 00 to b 21 estimated by the above-described method.

- pixel values v 00 to v 12 are estimated from the intermediate pixel values b 00 to b 11 .

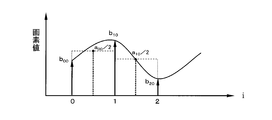

- the pixel values v 00 to v 02 in the first column shown in FIG. 7 will be described as an example.

- the pixel values v 00 to v 02 are estimated by a method similar to the above-described intermediate pixel value estimation method.

- the intermediate pixel values b 00 and b 01 are equivalent to values obtained by superimposing and sampling the pixel values v 00 to v 02 while shifting the pixel values v 00 to v 02 one pixel at a time in the vertical direction. Therefore, the relationship of the following formula (5) is established between the intermediate pixel value and the estimated pixel value.

- b 00 v 00 + v 01

- b 01 v 01 + v 02 (5)

- the pixel values v 01 and v 02 can be expressed as a function of the unknown v 00 .

- v 00 (unknown number)

- v 01 b 00 ⁇ v 00

- ⁇ j 0 is a difference value between the intermediate pixel values separated by one shift, and corresponds to the difference value between the pixel values v 02 and v 00 .

- pixel values v 10 to v 12 in the second column are obtained by the same processing, and final estimated pixel values v 00 , v 01 , v 10 , and v 11 are determined.

- an appropriate noise reduction process may be performed on the image data composed of the final estimated pixel values to obtain a display image.

- the method of switching between the still image shooting mode and the moving image shooting mode has a problem that when the user notices a photo opportunity, a decisive moment is often already missed.

- the method of synthesizing a high-resolution still image from a low-resolution moving image by super-resolution processing since the super-resolution processing is a heavy load processing, there is a problem that the scale of the processing circuit increases. is there.

- a light reception unit which is a unit for acquiring a light reception value (addition pixel value, four pixel addition value), is set for each of a plurality of pixels of the image sensor. Pixel values of a plurality of pixels included in the unit are added and read as a light reception value of the light reception unit, and a low resolution frame image is acquired. Then, the acquired low-resolution frame image is stored, and the pixel value of each pixel included in the light receiving unit is estimated based on the plurality of stored low-resolution frame images. Based on the estimated pixel value, a high-resolution frame image having a higher resolution than the low-resolution frame image is output.

- the low-resolution frame image is acquired by reading the light reception value of the light reception unit while sequentially shifting the pixels while superimposing the light reception units. Then, the pixel value of each pixel included in the light reception unit is estimated based on a plurality of light reception values obtained by sequentially shifting the light reception unit.

- the light receiving unit is set every four pixels.

- the received light values a 00 , a 20 ,... Are added and read out in the first frame, and a low-resolution frame image composed of a 00 , a 20 ,.

- the constructed low resolution frame images are sequentially acquired.

- the light reception units for obtaining the light reception values a 00 , a 10 , a 11 , and a 01 are shifted in the horizontal direction or the vertical direction by one pixel, and are shifted while superposing two pixels.

- These low-resolution frame images are acquired by, for example, an imaging device described later with reference to FIG.

- the acquired low-resolution frame image is input to an image processing apparatus to be described later with reference to FIG. 31, for example, and stored in a storage unit such as a memory (not shown).

- a storage unit such as a memory (not shown).

- each pixel value in the estimation processing block is estimated.

- a high resolution image corresponding to the resolution of the image sensor is output from the estimated pixel value.

- the estimation process can be simplified using the above-described estimation of the intermediate pixel value.

- the high-resolution still image can be generated at any timing of the low-resolution moving image, the user can easily obtain the high-resolution still image at the decisive moment.

- a low-resolution video eg 3 megapixels

- a high frame rate eg 60 frames

- a high-resolution still image (12 megapixels) or a high-definition video is displayed as needed. it can.

- the light receiving unit is sequentially set to the first position and the second position next to the first position by pixel shift.

- the light receiving units at the first and second positions overlap.

- the difference value of the light reception value of the light reception unit of the 1st, 2nd position is calculated

- the first intermediate pixel value which is the light receiving value of the first light receiving area obtained by removing the overlapping area from the light receiving unit of the first position, and the second light receiving area obtained by removing the overlapping area from the light receiving unit of the second position.

- a relational expression with the second intermediate pixel value that is the light reception value is expressed using the difference value.

- the first and second intermediate pixel values are estimated using the relational expression, and the pixel value of each pixel of the light receiving unit is obtained using the estimated first intermediate pixel value.

- the in the first frame, the first position to the light receiving unit is configured to obtain the received-light value a 00, in the second frame, second to obtain the received-light value a 10

- the light reception unit is set at the position.

- These light receiving units are overlapped in a region including the estimated pixels v 10 and v 11 .

- the area including the estimated pixels v 00 and v 01 corresponds to the first light receiving area

- the intermediate pixel value b 00 of the area is the first intermediate area. Corresponds to the pixel value.

- a region including the estimated pixels v 20 and v 21 corresponds to the second light receiving region, and an intermediate pixel value b 20 in the region corresponds to the second intermediate pixel value.

- it is estimated unknown b 00, b 20 are estimated using the relational expression.

- estimated pixel values v 00 and v 01 are obtained using b 00 .

- the relationship between the intermediate pixel values of the intermediate pixel value pattern is expressed using the light reception value of the light reception unit. Then, the similarity is evaluated by comparing the intermediate pixel value pattern with the light reception value pattern (light reception value of the light reception unit), and based on the evaluation result, the intermediate pixel of the intermediate pixel value pattern so that the similarity is the highest. The value value is determined.

- successive intermediate pixel values ⁇ b 00 , b 10 , b 20 ⁇ correspond to the intermediate pixel value pattern

- ⁇ b 00 , b 10 , b 20 ⁇ is expressed using received light values a 00 and a 10 .

- the intermediate pixel value pattern ⁇ b 00 , b 10 , b 20 ⁇ is compared with the received light value pattern ⁇ a 00 , a 10 ⁇ , and ⁇ b 00 , so that the similarity represented by the evaluation function Ej is the highest.

- the values of b 10 , b 20 ⁇ are determined.

- the light reception value pattern ⁇ a 00 , a 10 ⁇ is a light reception value that is continuous in the horizontal direction (in a continuous order).

- an intermediate pixel value can be estimated based on a plurality of light reception values acquired by pixel shifting while superimposing light reception units.

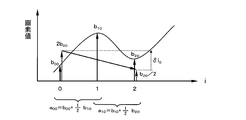

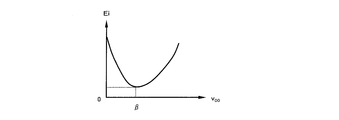

- an evaluation function representing an error between the intermediate pixel value pattern represented by the relational expression between the intermediate pixel values and the light reception value pattern (light reception value of the light reception unit) is obtained. Then, the value of the intermediate pixel value of the intermediate pixel value pattern is determined so that the value of the evaluation function is minimized.

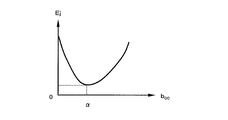

- the intermediate pixel value pattern ⁇ b 00 , b 10 , b 20 ⁇ is expressed as a function of the unknown b 00 as described above in the above equation (4) or the like, and the intermediate pixel value pattern ⁇ b 00 , b 10 , b 20 ⁇ and the light-receiving value pattern ⁇ a 00, the error between a 10 ⁇ is expressed by the evaluation function Ej.

- the unknown b 00 ⁇ (initial value) that minimizes the value of the evaluation function Ej is obtained, and the values b 00 to b 20 are determined based on the obtained b 00 .

- the value of the intermediate pixel value can be estimated by expressing the error by the evaluation function and obtaining the intermediate pixel value corresponding to the minimum value of the evaluation function.

- the initial value of the intermediate pixel estimation can be set with a simple process by obtaining the unknown using the least square method. That is, as compared with the above-described comparative example (Patent Document 2), it is not necessary to search for an image part suitable for initial value setting.

- the intermediate pixel value b 20 is estimated.

- This b 20 corresponds to an unknown (initial variable) in the next estimation processing block set to the intermediate pixel values b 20 and b 30 .

- a second estimation method capable of speeding up the estimation of unknowns will be described with reference to FIGS.

- the estimation of the intermediate pixel value (b 20 etc.) will be described as an example, but the estimation pixel (v 02 etc.) can be similarly estimated.

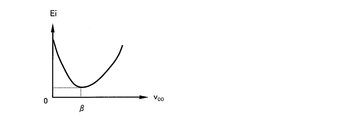

- equation (13) represents the evaluation function Ej of the error as a function of unknown b 00.

- ⁇ i 2 is the difference value of the received light value one shift away, and is expressed by the following equation (16).

- equation (17) represents the evaluation function Ej of the error as a function of unknown b 20.

- the value of b 20 has already been obtained by estimating the intermediate pixel values b 00 to b 20 .

- the first light receiving unit and the second light receiving unit are adjacent light receiving units. Then, the first and second light receiving units are sequentially set to the first position and the second position next to the first position by the pixel shift. The first light receiving units at the first and second positions overlap in the first overlapping region, and the second light receiving units at the first and second positions overlap in the second overlapping region.

- a region obtained by removing the first overlapping region from the first light receiving unit at the first position is the first light receiving region.

- a region obtained by removing the first overlapping region from the first light receiving unit at the second position is a second light receiving region.

- the scope of searching for unknown (b 20) it can be reduced search times.

- the unknown number (b 00 , b 20, etc.) is estimated only once.

- the unknown number is estimated a plurality of times, and the unknown number is estimated based on the plurality of estimated values.

- the value may be determined with high accuracy.

- a third estimation method for determining an unknown value from a plurality of estimated values will be described with reference to FIGS. 16 and 17.

- the intermediate pixel value (b 20 ) will be described as an example, but the estimated pixel value (v 02 and the like) can be similarly estimated.

- a high-definition intermediate pixel value ⁇ 1 ⁇ b 10 , b 20 , b 30 ⁇ is obtained from ⁇ a 10 , a 20 ⁇ by the same method as the above equations (14) to (17).

- a high-definition intermediate pixel value ⁇ 2 ⁇ b 20 , b 30 , b 40 ⁇ is obtained from ⁇ a 20 , a 30 ⁇ by the same method as the above equations (14) to (17).

- the intermediate pixel value b 20 appears in each of the sets ⁇ 0 , ⁇ 1 , ⁇ 2 . Therefore, three estimated values of the intermediate pixel value b 20 are obtained by three estimations.

- the final intermediate pixel value b 20 is determined (determined) from these three estimated values. For example, it can be determined by the following first to fourth determination methods.

- an average value of the three b 20 candidate values is set as the final determination value of b 20 .

- the second determination method two values having the smallest difference among the three b 20 candidate values are specified, and an average value of the two specified values is set as a final determination value of b 20 .

- two estimated values that are close to each other are assumed to be probable estimated values, and the estimation accuracy of unknowns can be improved.

- pixel values of a large number of known high-resolution image samples are added to obtain a light reception value and an intermediate pixel value.

- An intermediate pixel value pattern having a high probability of occurrence with respect to the received light value pattern is specified in advance from the obtained received light value and intermediate pixel value.

- an intermediate pixel value pattern having a high occurrence probability with respect to the received light value pattern acquired by photographing is obtained with reference to the correspondence relationship specified in advance.

- the three intermediate pixel value patterns ⁇ 0 , ⁇ 1 , ⁇ 2 the one closest to the obtained intermediate pixel value pattern is determined, and b 20 that is an element of the determined intermediate pixel value pattern is most probable.

- b Final decision value of 20 According to this method, it is possible to perform pixel value estimation reflecting a known image such as a natural image.

- b 20 to be finally adopted is determined according to the degree of change in the difference values ⁇ i 0 , ⁇ i 1 , ⁇ i 2 of the neighboring observation pixel values a 00 to a 30 related to the derivation of the three b 20.

- An occurrence probability distribution of b 20 for the combination pattern ⁇ is obtained in advance from the obtained element pattern and combination pattern ⁇ .

- the occurrence probability distribution of b 20 with respect to the difference value pattern ⁇ obtained from the captured image is obtained with reference to the occurrence probability distribution obtained in advance.

- the most probable value of b 20 can be determined from According to this method, it is possible to perform pixel value estimation reflecting a known image such as a natural image. Further, it is possible to perform pixel value estimation according to the degree of change in the pixel value regardless of the size of the pixel value.

- the first light receiving unit and the second light receiving unit are adjacent light receiving units. Then, the first and second light receiving units are sequentially set to the first position and the second position next to the first position by the pixel shift. The first light receiving units at the first and second positions overlap in the first overlapping region, and the second light receiving units at the first and second positions overlap in the second overlapping region.

- a region obtained by removing the first overlapping region from the first light receiving unit at the first position is the first light receiving region.

- a region obtained by removing the first overlapping region from the first light receiving unit at the second position is a second light receiving region.

- the overlapping region of the first light receiving unit at the second position and the second light receiving unit at the first position is the fifth light receiving region. Then, successive intermediate pixel values that include the fifth intermediate pixel value (b 20 ) that is the light reception value of the fifth light receiving region and do not include the first and fourth intermediate pixel values (b 00 , b 40 ).

- a third intermediate pixel value pattern ( ⁇ 1 ⁇ b 10 , b 20 , b 30 ⁇ ) is estimated.

- the third and fifth light receiving areas are the same light receiving areas as the second light receiving areas.

- the second, third, and second intermediate pixel values (b 20 ) of the same light receiving region are obtained by estimating the first to third intermediate pixel value patterns ( ⁇ 0 , ⁇ 2 , ⁇ 1 ). Finally, it is determined based on the intermediate pixel value (b 20 ) of 5.

- the final pixel value can be determined based on the three (plural) estimated values obtained by estimating three (plural times). For example, by using a determination method using a known image as described above, it is possible to estimate a pixel value in accordance with a pixel value pattern of an actual image.

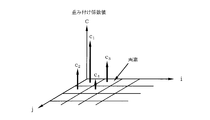

- the pixel value is estimated using the least square method, but in the present embodiment, the pixel value may be estimated using a neural network (nonlinear estimation method).

- the fourth estimation method will be described with reference to FIG. In the following, the estimation of the intermediate pixel value (b 00 etc.) will be described, but the estimated pixel value (v 00 etc.) can be similarly estimated.

- the weighting factor W is calculated in advance by learning calculation of the neural network shown in FIG. Specifically, the weighting factor W is calculated so that the error evaluation value E shown in the following formula (18) becomes zero (including substantially zero, which is a predetermined value in a broad sense).

- a learning method of the neural network a general neural network learning method may be used.

- the similarity is evaluated based on the foreseeing information acquired based on the known high-resolution frame image, so image information (for example, spatial frequency characteristics) included in the known image such as a natural image. Can be estimated.

- the image processing apparatus has a neural network.

- This neural network uses, as look-ahead information, a node weighting factor W obtained by learning based on a known high-resolution frame image.

- the sex evaluation result E is output.

- the similarity between the intermediate pixel value pattern and the light receiving value of the light receiving unit can be evaluated based on the foresight information by the neural network using the node weighting coefficient W obtained by learning.

- the pixel value can be estimated using the occurrence probability distribution of the pixel value as foresight information.

- a pixel value having a high probability of occurrence in a known image such as a natural image can be used as an estimated value.

- noise filter processing (filter processing in a broad sense) corresponding to a pixel position (for example, a pixel position within a light receiving unit) is performed on the estimated pixel value v ij . Good.

- FIG. 19 shows a configuration example of the noise filter.

- the filter coefficients are set so that the noise appearance is the same (substantially the same) regardless of the positions of v ij to v (i + 1) (j + 1) .

- the pixel values v ij to v (i + 1) (j + 1) obtained by estimation are subjected to filter processing with different filter coefficients depending on the pixel position in the light receiving unit.

- the noise can be reduced by performing the noise filter processing according to the pixel position in the light receiving unit.

- the weighting coefficients for addition reading are c 1 , c 2 , c 3 , and c 4 .

- c 1 1

- the weighting coefficient takes the ratio relationship rule shown in the following equation (19) (r is a real number with r> 1).

- the weighted pixel addition values are set to a 00 , a 10 , and a 20 in the shift order.

- a 00 c 1 v 00 + c 2 v 01 + c 3 v 10 + c 4 v 11

- a 10 c 1 v 10 + c 2 v 11 + c 3 v 20 + c 4 v 21 ⁇

- b 00 , b 10 , and b 20 are defined as shown in the following formula (22), and the above formula (20) is substituted.

- b 00 (unknown number)

- b 10 2 (a 00 -b 00 )

- a pattern ⁇ a 00 , a 10 ⁇ based on sampling pixel values detected by weighted superposition shift sampling and a pattern based on intermediate pixel values ⁇ b 00 , b 10 , b 20 ⁇ are compared. Then, an unknown number b 00 that minimizes the error E is derived and set as the intermediate pixel value b 00 .

- the evaluation function Ej shown in the following equation (27) is obtained. Then, the similarity between the pattern ⁇ a 00 , a 10 ⁇ and the intermediate estimated pixel value ⁇ b 00 , b 10 , b 20 ⁇ is evaluated using this evaluation function Ej.

- v 00 (unknown number)

- v 01 2 (b 00 ⁇ v 00 )

- the estimated pixel value pattern ⁇ v 00 , v 01 , v 02 ⁇ of the above equation (30) is compared with the intermediate pixel value pattern ⁇ b 00 , b 01 ⁇ , and an unknown v 00 that minimizes the error Ei is derived. .

- b ij v ij + (1/2) v i (j + 1) (31)

- the patterns are compared in consideration of the weighting shown in the above equation (31). Specifically, the evaluation function Ei shown in the following equation (32) is obtained.

- each pixel value of the light receiving unit is weighted and added to obtain a low-resolution frame image, and the pixel value of the high-resolution frame image can be estimated from the obtained low-resolution frame image.

- the reproducibility of the high-frequency component of the subject can be improved. That is, when the pixel values of the light receiving units are simply added, a rectangular window function is convoluted for imaging.

- a window function containing more high frequency components than the rectangle is convoluted for imaging. Therefore, it is possible to acquire a low-resolution frame image that includes more high-frequency components of the subject, and improve the reproducibility of the high-frequency components in the estimated image.

- the light reception value (a 00 or the like) used for estimating the pixel value the light reception value read out by addition may be used as it is, or the light reception value generated by interpolation may be used. .

- the received light value interpolation method in this embodiment will be described with reference to FIGS.

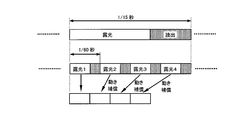

- FIG. 29 is an explanatory diagram of the first interpolation method.

- the frame used in the following description refers to, for example, the timing at which one low-resolution frame image is captured by the image sensor or the timing at which one low-resolution frame image is processed in image processing.

- one low-resolution frame image or high-resolution frame image in image data is also referred to as a frame as appropriate.

- the received light value of the interpolation target frame is interpolated using the received light value acquired in another frame (time axis interpolation).

- received light values a ij , a (i + 1) j , a (i + 1) (j + 1) , and a i (j + 1) are sequentially acquired in frames fx to fx + 3.

- the light reception value a ij is acquired again.

- a low-resolution frame image composed of the received light value a ij is acquired in frames fx, fx + 4, and fx + 8.

- time-axis interpolation filter processing (filter processing) is performed on the time-series data of the light reception values aij .

- the light reception value a ′ ij is generated in all frames (each frame) by this time axis interpolation filter processing.

- each received light value is acquired every four frames, and time axis interpolation filter processing is performed, and the received light values a ′ ij , a ′ (i + 1) j , a ′ (i + 1) (j + 1) , a ′ i (j + 1) is generated.

- FIG. 30 shows an example timing chart of the interpolation process.

- the light receiving unit setting position is shifted by one pixel.

- the fusion frames F1, F2,... Low resolution frame images

- a low-resolution moving image frame is generated, and live view display and recording are performed.

- time axis interpolation of the received light value is performed, pixel value estimation is performed using the received light value after interpolation, and a high-resolution still image frame is generated.

- a high-resolution still image or a high-resolution moving image is output from the ninth frame in which all received light values are interpolated.

- FIG. 31 shows a first detailed configuration example of the imaging device and the image processing device.

- 31 includes an imaging optical system 100 (lens), an optical low-pass filter 110, an imaging element 120 (image sensor), a superposition shift sampling unit 130 (reading control unit), a data recording unit 140 (storage unit), A display processing unit 150 (display control unit) and a monitor display unit 160 (display device) are included.

- the image processing apparatus 20 includes a time axis pixel interpolation unit 200 (interpolation processing unit), a pixel value estimation calculation unit 210 (estimation processing unit), and an image output unit 300.

- FIG. 31 illustrates an example in which the image processing device 20 is provided outside the imaging device 10, but in the present embodiment, the image processing device 20 may be provided inside the imaging device 10.

- the imaging device 10 is, for example, a digital camera or a video camera.

- the imaging optical system 100 forms an image of a subject.

- the optical low-pass filter 110 passes a band corresponding to the resolution of the image sensor 120, for example.

- the image sensor 120 (for example, 12 megapixels) is configured by, for example, a CCD or CMOS sensor that can be added and read in an analog manner.

- the superposition shift sampling unit 130 controls, for example, setting of light reception units and addition reading, and acquires a fusion frame (for example, 3 megapixels).

- the data recording unit 140 is realized by, for example, a memory card or the like, and records a moving image by a fusion frame.

- the monitor display unit 160 displays a live view of a moving image and a reproduced moving image.

- the image processing apparatus 20 is realized by, for example, an image processing engine (IC) or a PC (computer).

- the time axis pixel interpolation unit 200 performs time axis interpolation of the received light value of the fusion frame.

- the pixel value estimation calculation unit 210 estimates a final estimated pixel value.

- the image output unit 300 includes anti-aliasing filters 220 and 250, a low-pass filter 230, and an undersampling unit 240, and outputs a still image or a moving image from the final estimated pixel value.

- the anti-aliasing filter 220 performs anti-aliasing processing on the final estimated pixel value and outputs a high-resolution still image (for example, 12 megapixels).

- the low pass filter 230 limits the final estimated pixel value to the high vision band.

- the undersampling unit 240 undersamples the band-limited final estimated pixel value to the number of high-definition pixels.

- the anti-aliasing filter 220 performs anti-aliasing processing on the undersampled image and outputs a high-definition moving image (for example, 2 megapixels). Note that a high-resolution moving image (for example, 12 megapixels) may be output without undersampling.

- the received light value is interpolated by the time axis filter process.

- the received light value may be interpolated by motion compensation. For example, as shown in FIG. 32, four continuous fusion frames photographed at a high frame rate (1/60 seconds) are used, and motion compensation is performed on each fusion frame to produce one still image (low frame). A high-definition image taken at a rate of 1/15 seconds) may be generated.

- the low-resolution frame images are sequentially acquired by shifting the pixels, four frames are required to acquire all the received light values used for pixel value estimation. Therefore, if the photographed received light value is used for pixel value estimation as it is, the received light value of a different frame is used for estimation, and the image quality may be deteriorated when the subject is moving.

- the pixel shift is performed in each frame fx, fx + 1,...,

- the light reception unit has a plurality of positions (4 positions; P1 to P4 shown in FIG. 29 described above). Are set sequentially. Then, the light receiving unit is set to the same position for each of a plurality of frames (every 4 frames). In this way, the received light values a ij to a (i + 1) (j + 1) corresponding to the respective positions in time series are acquired, and low resolution frame images are acquired in time series using the acquired received light values (continuous low Resolution frame image).

- a process of interpolating the light reception values a ′ ij to a ′ (i + 1) (j + 1) of the light reception units at a plurality of positions P1 to P4 is performed on the acquired continuous low-resolution frame image.

- the light-receiving value (a ′ ij ) of the light-receiving unit at the missing position (eg, P1) in the continuous low-resolution frame image of the frame to be interpolated (eg, fx + 1) is time-axis interpolated.

- the light reception value (a ′ ij ) is the light reception unit in the continuous low-resolution frame image of the frames (fx, fx + 4) before and after the interpolation target frame (fx + 1) at the same position (P1) as the missing position.

- Time axis interpolation is performed using the received light value (a ij ).

- the received light value is acquired by the pixel shift, and the received light value at the missing position is interpolated using the acquired received light value, and the final estimated pixel value can be obtained from the received light value after interpolation.

- the pixel value is estimated from the light reception values in the same frame, and image quality deterioration can be suppressed even when the subject is moving.

- the time axis interpolation is performed by the time axis interpolation filter.

- the received light value (a ij of fx, fx + 4) at each position (for example, P1) is time-axis interpolated to generate the received light value (a ′ ij ) of the missing position (P1 of fx + 1 to fx + 3).

- the image output unit 300 generates a high-resolution frame image in each frame based on the final estimated pixel value in each frame estimated by the pixel value estimation calculation unit 210, and generates The high-resolution frame image is output as a still image or a moving image.

- adaptive received light value interpolation may be performed according to the movement of the subject.

- a second interpolation method for adaptively interpolating received light values will be described with reference to FIGS. 33 and 34.

- the received light values of the frames before and after the neighborhood are applied to a portion where there is no motion or a small amount (light reception value), and the light reception value is superimposed on the adjacent light reception value in the same frame for a portion where the motion is large or large. Interpolate the shifted received light value.

- the motion compensation process may be performed in advance.

- FIG. 34 shows a part of the received light value acquired as the imaging data in the frame fx + 1 for the sake of simplicity.

- the acquired light reception values are indicated by a 10 (x + 1), a ( ⁇ 1) 0 (x + 1), a ( ⁇ 1) 2 (x + 1), and a 12 (x + 1).

- a 00 (x) and a 00 (x + 4) of the neighboring frames fx and fx + 4 acquired at the corresponding position of a 00 (x + 1) are compared.

- the difference is smaller than the predetermined threshold ⁇ , it is determined that the subject (a part of the moving subject) has not passed through the pixel position corresponding to a 00 (x + 1) between the frames fx and fx + 4.

- assign a 00 (x + 1) a as a value of 00 (x) or a 00 (x + 4).

- an interpolated value is obtained using received light values a 10 (x + 1) and a ( ⁇ 1) 0 (x + 1) close to a 00 (x + 1) in the same frame, and a 00 ( x + 1).

- an average value of a 10 (x + 1) and a ( ⁇ 1) 0 (x + 1) is set as a 00 (x + 1).

- interpolation may be performed using a larger number of peripheral light reception values instead of the average of two adjacent light reception values.

- a 11 (x + 1) is interpolated by the following equation (34).

- a 01 (x + 1) is interpolated by the following equation (35).

- a 01 (x + 1) ⁇ a 10 (x + 1) + a ( ⁇ 1) 2 (x + 1) ⁇ / 2 (35)

- the threshold value ⁇ may be set by evaluating the quality of the generated image and setting an allowable level threshold value ⁇ . For example, it may be set to a level at which it is not determined that there is movement due to noise in spite of a still image.

- the difference value (a 00 (x) ⁇ a 00 (x + 4)) of the received light value of the received light unit in the frames (for example, fx, fx + 4) before and after the frame to be interpolated (for example, fx + 1). ) Is required.

- the difference value is smaller than the predetermined threshold ⁇

- the light reception value (a 00 (x + 1)) of the light reception unit at the missing position (position) in the interpolation target frame (fx + 1) is the previous or next frame (fx).

- Fx + 4) is interpolated using the received light value (a 00 (x), a 00 (x + 4)) of the received light unit at the same position as the missing position.

- the light reception value (a 00 (x + 1)) of the light reception unit at the missing position in the interpolation target frame (fx + 1) is the interpolation target frame (fx + 1). Interpolation is performed using the received light reception values (a 10 (x + 1), a ( ⁇ 1) 0 (x + 1)).

- the received light value can be adaptively interpolated according to the movement of the subject.

- the received light value acquired at the same position is used, so that the positional error can be reduced.

- a temporal error can be reduced.

- the subject passes between the frames fx and fx + 4 cannot be known from the received light values a 00 (x) and a 00 (x + 4). Therefore, when interpolating from a 00 (x) and a 00 (x + 4), the influence of the movement of the subject appears even at the timing before the passage timing of the subject.

- interpolation is performed using the light reception value of the same frame, so that the passage timing of the subject can be accurately reflected.

- the second interpolation method it is possible to suppress image quality deterioration due to erroneous detection of motion. For example, if there is a mere change in brightness exceeding a predetermined threshold ⁇ within the four-frame imaging period, there is a possibility that a mere change in brightness is erroneously detected as the movement of the subject. In this regard, according to the second interpolation method, even if erroneous detection is performed, it is only possible to switch to intra-frame interpolation, so that it is possible to prevent the image quality from deteriorating significantly.

- RGB is read without being separated, and the final pixel value of RGB is estimated.

- the received light values a 00 , a 10 , a 01 , a 11 shown in the following formula (36) are sequentially acquired.

- a 00 R 10 + G1 00 + G2 11 + B 01

- a 10 R 10 + G1 20 + G2 11 + B 21

- a 01 R 12 + G1 02 + G2 11 + B 01

- a 11 R 12 + G1 22 + G2 11 + B 21 ⁇ (36)

- the image sensor is a color image sensor (RGB single-plate image sensor), and a plurality of adjacent pixels (for example, G1 00 , R 10 , B 01 , G2 11 ).

- the light receiving unit is set regardless of the pixel color.

- pixel values (G1 00 , R 10 , B 01 , G2 11 ) of each pixel of the light receiving unit are estimated based on the acquired low-resolution frame image, and color high resolution is based on the estimated pixel value.

- a frame image (still image or moving image) is output.

- a low-resolution frame image is captured at a high frame rate, and a pixel value is estimated from the low-resolution frame image to obtain a color high-resolution frame image at an arbitrary timing. it can.

- the received light value is obtained by adding the pixel values of the four adjacent pixels, random noise can be reduced.

- peripheral pixels with higher correlation can be used in intra-frame pixel interpolation in the second interpolation method described above.

- RGB final pixel values may be estimated by separating and adding RGB.

- a second color image estimation method will be described with reference to FIGS.

- the received light value represented by the following equation (37) is acquired by superposition sampling for the G1 pixel.

- the final estimated pixel G1 is estimated from these light reception values.

- a 00 G1 00 + G1 20 + G1 02 + G1 22

- a 10 G1 20 + G1 40 + G1 22 + G1 42

- a 01 G1 02 + G1 22 + G1 04 + G1 24

- a 11 G1 22 + G1 42 + G1 24 + G1 44 (37)

- the light reception value shown in the following equation (38) is acquired for the G2 pixel.

- the final estimated pixel G2 is estimated from these received light values.

- a 00 G2 11 + G2 31 + G2 13 + G2 33

- a 10 G2 31 + G2 51 + G2 33 + G2 53

- a 01 G2 13 + G2 33 + G2 15 + G2 35

- a 11 G2 33 + G2 53 + G2 35 + G2 55 (38)

- the received light value shown in the following equation (39) is acquired for the R pixel.

- the final estimated pixel R is estimated from these received light values.

- a 00 R 10 + R 30 + R 12 + R 32

- a 10 R 30 + R 50 + R 32 + R 52

- a 01 R 12 + R 32 + R 14 + R 34

- a 11 R 32 + R 52 + R 34 + R 54 (39)

- the light reception value shown in the following equation (40) is acquired for the B pixel.

- the final estimated pixel B is estimated from these received light values.

- a 00 B 01 + B 21 + B 03 + B 23

- a 10 B 21 + B 41 + B 23 + B 43

- a 01 B 03 + B 23 + B 05 + B 25

- a 11 B 23 + B 43 + B 25 + B 45 (40)

- a plurality of pixels of the same color for example, G1 00 , G1 20 , G1 02 , G1 22

- pixel values (G1, G2, R, B) of each pixel of the light receiving unit are estimated based on the acquired low resolution frame image, and a color high resolution frame image is output based on the estimated pixel value. Is done.

- a color high-resolution frame image can be obtained by photographing a low-resolution frame image at a high frame rate for each color and estimating a pixel value from the low-resolution frame image.

- the light reception unit is set for every four pixels.

- the number of pixels set for the light reception unit is changed according to the brightness of the captured image. May be. A method for setting the number of added pixels adapted to this brightness will be described with reference to FIGS.

- pixel addition imaging of adjacent 2 ⁇ 2 pixels is basically performed, and pixel addition is performed when the average luminance value L (brightness in a broad sense) of the captured image is lower than a threshold value L2. Pixels are adjacent 3 ⁇ 3 pixels. When the average luminance value L falls below the threshold value L1 (L1 ⁇ L2), the number of pixels to be subjected to pixel addition is increased to 4 ⁇ 4 adjacent pixels. In this way, the number of pixels of the light receiving unit is set, and superposition shift sampling and pixel estimation are performed to obtain the pixel value of the high resolution image.

- FIG. 41 shows a second detailed configuration example of an imaging apparatus and an image processing apparatus that variably set the number of added pixels in accordance with brightness.

- 41 includes an imaging optical system 100, an optical low-pass filter 110, an imaging element 120, a superposition shift sampling unit 130, a data recording unit 140, a display processing unit 150, a monitor display unit 160, a brightness detection unit 170, An addition pixel number setting unit 180 is included.

- the image processing device 20 includes a time axis pixel interpolation unit 200, a pixel value estimation calculation unit 210, and an image output unit 300.