WO2010055915A1 - 植生生育状況解析方法、プログラムを記録した記録媒体および植生生育状況解析装置 - Google Patents

植生生育状況解析方法、プログラムを記録した記録媒体および植生生育状況解析装置 Download PDFInfo

- Publication number

- WO2010055915A1 WO2010055915A1 PCT/JP2009/069370 JP2009069370W WO2010055915A1 WO 2010055915 A1 WO2010055915 A1 WO 2010055915A1 JP 2009069370 W JP2009069370 W JP 2009069370W WO 2010055915 A1 WO2010055915 A1 WO 2010055915A1

- Authority

- WO

- WIPO (PCT)

- Prior art keywords

- radar

- backscattering coefficient

- image

- radar image

- coefficient

- Prior art date

Links

Images

Classifications

-

- A—HUMAN NECESSITIES

- A01—AGRICULTURE; FORESTRY; ANIMAL HUSBANDRY; HUNTING; TRAPPING; FISHING

- A01G—HORTICULTURE; CULTIVATION OF VEGETABLES, FLOWERS, RICE, FRUIT, VINES, HOPS OR SEAWEED; FORESTRY; WATERING

- A01G7/00—Botany in general

-

- G—PHYSICS

- G01—MEASURING; TESTING

- G01S—RADIO DIRECTION-FINDING; RADIO NAVIGATION; DETERMINING DISTANCE OR VELOCITY BY USE OF RADIO WAVES; LOCATING OR PRESENCE-DETECTING BY USE OF THE REFLECTION OR RERADIATION OF RADIO WAVES; ANALOGOUS ARRANGEMENTS USING OTHER WAVES

- G01S13/00—Systems using the reflection or reradiation of radio waves, e.g. radar systems; Analogous systems using reflection or reradiation of waves whose nature or wavelength is irrelevant or unspecified

- G01S13/88—Radar or analogous systems specially adapted for specific applications

- G01S13/89—Radar or analogous systems specially adapted for specific applications for mapping or imaging

- G01S13/90—Radar or analogous systems specially adapted for specific applications for mapping or imaging using synthetic aperture techniques, e.g. synthetic aperture radar [SAR] techniques

- G01S13/9021—SAR image post-processing techniques

- G01S13/9027—Pattern recognition for feature extraction

-

- G—PHYSICS

- G01—MEASURING; TESTING

- G01S—RADIO DIRECTION-FINDING; RADIO NAVIGATION; DETERMINING DISTANCE OR VELOCITY BY USE OF RADIO WAVES; LOCATING OR PRESENCE-DETECTING BY USE OF THE REFLECTION OR RERADIATION OF RADIO WAVES; ANALOGOUS ARRANGEMENTS USING OTHER WAVES

- G01S7/00—Details of systems according to groups G01S13/00, G01S15/00, G01S17/00

- G01S7/02—Details of systems according to groups G01S13/00, G01S15/00, G01S17/00 of systems according to group G01S13/00

- G01S7/024—Details of systems according to groups G01S13/00, G01S15/00, G01S17/00 of systems according to group G01S13/00 using polarisation effects

-

- G—PHYSICS

- G01—MEASURING; TESTING

- G01S—RADIO DIRECTION-FINDING; RADIO NAVIGATION; DETERMINING DISTANCE OR VELOCITY BY USE OF RADIO WAVES; LOCATING OR PRESENCE-DETECTING BY USE OF THE REFLECTION OR RERADIATION OF RADIO WAVES; ANALOGOUS ARRANGEMENTS USING OTHER WAVES

- G01S7/00—Details of systems according to groups G01S13/00, G01S15/00, G01S17/00

- G01S7/02—Details of systems according to groups G01S13/00, G01S15/00, G01S17/00 of systems according to group G01S13/00

- G01S7/41—Details of systems according to groups G01S13/00, G01S15/00, G01S17/00 of systems according to group G01S13/00 using analysis of echo signal for target characterisation; Target signature; Target cross-section

- G01S7/411—Identification of targets based on measurements of radar reflectivity

- G01S7/412—Identification of targets based on measurements of radar reflectivity based on a comparison between measured values and known or stored values

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/0002—Inspection of images, e.g. flaw detection

- G06T7/0012—Biomedical image inspection

- G06T7/0014—Biomedical image inspection using an image reference approach

- G06T7/0016—Biomedical image inspection using an image reference approach involving temporal comparison

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10032—Satellite or aerial image; Remote sensing

- G06T2207/10044—Radar image

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30181—Earth observation

- G06T2207/30188—Vegetation; Agriculture

Definitions

- the present invention is mounted on a flying object such as an artificial satellite, and uses radar image data obtained by a radar device that captures a wide range of the ground surface of an imaging target area and obtains the surface condition, to determine the growth status of vegetation.

- the present invention relates to a vegetation growth situation analysis method suitable for analysis, a recording medium recording a program for executing the processing, and a vegetation growth situation analysis apparatus.

- Synthetic Aperture Radar can capture a wide area, day or night, regardless of the weather, using the characteristics of microwaves.

- the conventional synthetic aperture radar has a problem in resolution (definition) compared to optical remote sensing, but the latest satellite-mounted synthetic aperture radar has a resolution of 1 m or less, and has a high resolution. Images are becoming available.

- Non-Patent Document 1 Japanese Patent Document 1

- Non-Patent Document 2 The applicant of this application has also published research results on the growth of paddy rice using multi-period SAR images (see Non-Patent Document 2). As a result of research described in Non-Patent Document 2, analysis results as shown in FIGS. 1 to 3 were obtained.

- FIG. 1 shows an example of radar images for a plurality of periods, and shows growth and reflection characteristics for each observation day, the state of paddy fields, paddy rice coverage, and radar images.

- a radar image is taken using the C band of RADARSAT. Radar images 1A, 1B, 1C, and 1D for four periods of May 22, June 15, July 9, and August 2 were created, and the overall growth of rice was changed from these radar images. You can see what you are doing.

- Fig. 2 shows the relationship between the paddy rice coverage and the radar backscattering coefficient (the backward component of the scattering intensity of the object with respect to the microwave transmitted from the radar device), and the horizontal axis represents the paddy rice coverage. (%), The vertical axis represents the radar backscatter coefficient (dB).

- a regression line 2 representing the relationship between the paddy rice coverage and the radar backscattering coefficient is obtained. can get.

- Fig. 3 shows the distribution of radar backscattering coefficients for each field in each period.

- Zengyuan Li Guoqing Sun, Mike Wooding, Yong Pang, Y gardeningDong, Erxue Chen and BingxiangTan, “Rice Monitoring Using EnvisatAsar Data in China”, Proc. Of the 2004, Envisatzpos (572, April 2005) Kazuyoshi Takahashi, Hiroaki Abe, Atsushi Rikimaru, Yukio Mukai, “Understanding the distribution of rice growth using time-series RADARSAT data”, Japan Photogrammetric Society, Annual Scientific Lecture, Tokyo International Exhibition Center (Tokyo), June 17, 2004. 18th

- Non-Patent Document 1 describes the research content of paddy rice monitoring using multi-time SAR images, but the relationship between the backscatter coefficient of SAR images and vegetation is not clear.

- Non-Patent Document 2 revealed the correlation between the backscatter coefficient of the satellite SAR data and the growth status.

- the backscattering coefficient is affected by atmospheric conditions and system fluctuations at the time of shooting, calibration of the backscattering coefficient of SAR images taken at different times is necessary. It did not accurately represent the situation.

- the present invention has been made in view of such a situation, and makes it possible to accurately analyze the growth situation of vegetation over many periods using a radar image obtained from a flying object such as an artificial satellite. is there.

- a vegetation growth situation analysis method and a recording medium recording a program acquire a radar image of the ground surface of the same target area, which is taken at a plurality of times by a radar device mounted on a flying object,

- the acquired radar images are stored in a map database.

- the radar image taken at another time is aligned, and then a backscattering coefficient of a specific region of the radar image is extracted.

- the backscattering coefficient of another radar image is calibrated based on the backscattering coefficient of the specific region of the reference image.

- the growth value of the vegetation reflected in the radar image is calculated from the backscattering coefficient of the calibrated radar image. It is characterized by including a function.

- the vegetation growth situation analysis method apparatus includes an acquisition unit that acquires a radar image of a ground surface of the same target area, which is captured at a plurality of times by a radar device mounted on a flying object, and the acquisition unit

- a radar image holding unit that stores a plurality of radar images acquired in the map database, and a positioning process that aligns radar images taken at other times using a radar image taken at a predetermined time as a reference image

- a backscattering coefficient processing unit that extracts a backscattering coefficient of a specific region of the radar image, and a backscattering coefficient of the specific region of the reference image among a plurality of radar images stored in the map database.

- a calibration unit that calibrates the backscatter coefficient of another radar image, and a radar calibrated by the calibration unit based on the correlation between the backscatter coefficient of the radar image and the growth value of the vegetation Characterized in that the backscattering coefficient of the image and a growth value calculation unit for calculating a growth value of vegetation caught on the radar image.

- the backscattering coefficient of the radar image at each time is calibrated based on the backscattering coefficient of the radar image at a predetermined time. And since the radar image of each period is corrected based on the backscattering coefficient after calibration, a growth value indicating an accurate growth state of a plant such as a crop at each period can be calculated.

- A is a radar image after correction

- B is a diagram (August 11) showing a calibration line.

- A is a radar image after correction

- B is a diagram (August 11) showing a calibration line.

- A is a radar image after correction

- B is a diagram (August 11) showing a calibration line.

- A is a radar image after correction

- B is a diagram (August 11) showing a calibration line.

- A is a radar image after correction

- B is a diagram (August 11) showing a calibration line.

- It is a block diagram which shows the example of an internal structure of a personal computer.

- FIG. 4 shows an outline of a system to which the vegetation growth state analyzing apparatus of the present invention is applied.

- a synthetic aperture radar SAR

- the ground surface is photographed (based on an instruction from the data analysis center 12) by the synthetic aperture radar.

- the synthetic aperture radar mounted on the artificial satellite is referred to as “satellite SAR”.

- the satellite SAR 11 mounted on the artificial satellite images the field 13 on the ground surface periodically or according to an instruction from the data analysis center 12 while orbiting a predetermined orbit, and analyzes the image data (radar image data). Transmit to the center 12.

- image data radar image data

- the data analysis center 12 performs an imaging plan along the growth calendar, transmits a radio signal including an imaging instruction based on the imaging plan to the satellite SAR11, and also transmits radar image data captured by the satellite SAR11 via an antenna. Receive.

- a synthetic aperture process and a predetermined correction are performed by a vegetation growth state analyzing apparatus 20 described later, and a corrected multi-time reproduction image and a radar backscatter coefficient (also simply referred to as “backscatter coefficient”). Generate a distribution map etc.

- the present invention calibrates the backscattering coefficient values of time-series images with reference to images acquired at the beginning or at a predetermined time. By calibrating the backscattering coefficient value, it is possible to realize a more practical paddy rice growth prediction system that takes into account the influence of fluctuations depending on the photographing time.

- the following three methods can be considered as the time series image calibration method.

- (1) A method of setting a reference reflector (for example, a corner reflector) in a target area, extracting a backscattering coefficient value of the reflector from a photographed SAR image, and using this as a reference value (2) photographed SAR

- FIG. 5 shows a functional block diagram according to one embodiment of the vegetation growth situation analyzing apparatus of the present invention.

- the vegetation growth state analyzing apparatus calibrates the backscattering coefficient value of the time-series image and generates data for predicting the vegetation growth state.

- this vegetation growth state analysis apparatus is assumed to be installed in the data analysis center 12, it may be mounted on an artificial satellite together with the satellite SAR11, or may be distributed to each.

- each function of the vegetation growth situation analysis apparatus can be realized by either hardware or software. Or you may implement

- the vegetation growth state analyzing apparatus 20 of the present embodiment mainly includes an I / F unit 21, an imaging determination unit 22, a radar image holding unit 24, an alignment processing unit 25, a backscattering coefficient processing unit 27 for a reference reflector, and a rear side.

- a scattering coefficient determination processing unit 28 and a feature backscattering coefficient processing unit 29 are provided.

- the backscattering coefficient holding unit 30, the calibration backscattering coefficient calculating unit 31, the calibration line calculating unit 32, the backscattering coefficient calibration unit 33 using the calibration line, the growth value calculating unit 34, the field aggregation calculating unit 36, and the output unit 38 are provided. Prepare.

- growth calendar DB a growth calendar database

- imaging plan DB an imaging plan database

- map DB a map database

- a database hereinafter referred to as “growth model DB” 35 and a field map database (hereinafter referred to as “field map DB”) 37 are provided.

- the I / F unit 21 is an example of an acquisition unit, and has a function as a so-called interface that captures image data captured by the satellite SAR11.

- the I / F unit 21 also has a function as a communication unit, and can transmit an instruction from the imaging determination unit 22 to the satellite SAR11 to cause the satellite SAR11 to perform imaging.

- the photographing data is data of radar images that are photographed systematically based on the growing calendar of paddy rice registered in the growing calendar DB 23A and the photographing time (cycle) of the satellite registered in the photographing plan DB 23B.

- the growing calendar is a cultivation calendar starting from the rice planting period in May, the dividing period, the highest dividing period, the ear formation period, the heading period, the ripening period, and the maturity period in September.

- artificial satellites equipped with a synthetic aperture radar that are currently launched include those with an observation period of 11 days.

- the imaging determination unit 22 determines the time when the radar image is taken into the I / F unit 21 in consideration of the growth calendar and the imaging cycle of the satellite.

- An example of the determined scheduled shooting date (data acquisition date) is shown below.

- [Observation date] [Calculation date] [Stage] 1) May 7th 0th Rice transplanting period 2) May 31st 24th Divided period 3) June 24th 38th Best divided period 4) July 18th 72nd Young panicle formation period 5) August 11th 96th Heading period 6) September 4th 120th Ripening period

- the photographing determination unit 22 may set the pixel size of the photographed image according to the target area for evaluating the growth of paddy rice. For example, when performing a detailed evaluation, it is preferable to increase the ground resolution (for example, 1 m).

- the radar image holding unit 24 has a function of saving, in the map DB 26, time-series radar images taken at a predetermined time.

- the map DB 26 is constructed in a nonvolatile storage means such as a hard disk or a flash memory.

- the alignment processing unit 25 is a function that performs geometric (position) processing so that the radar image can be superimposed on the map based on the map data stored in the map DB 26.

- the radar image after alignment is supplied to the backscattering coefficient calibration unit 33 using the calibration line, the backscattering coefficient processing unit 27 for the reference reflector, and the backscattering coefficient processing unit 29 for the feature.

- the backscattering coefficient processing unit 27 of the reference reflector has a function of processing (extracting) the backscattering coefficient of the reference reflector shown in the radar image.

- this reference reflector for example, “Yuta Kamikawa, Kazuo Ouchi,“ Calibration / Verification Experiment of Synthetic Aperture Radar PALSAR Mounted on Land Observing Satellite “Daichi” ”, 2006 Graduation Thesis, Faculty of Engineering, Kochi University of Technology”

- Various reflectors such as the corner reflector described in 1) can be applied.

- the reflector When a reflector is used in the observation area, the backscattering coefficient values of the reflectors at two periods are extracted, and a calibration line for performing calibration based on the backscattering coefficient value of the reference image is obtained. Calibrate images taken at other times.

- the reflector has an appropriate area, shape, number, and direction as appropriate depending on the microwave band (wavelength) irradiated on the ground surface and the orbit of the satellite (imaging direction). It is desirable to adjust and install.

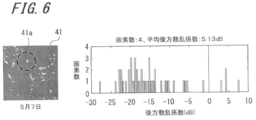

- FIG. 6 shows the measurement result of the radar image and the average backscattering coefficient when a corner reflector is installed as a reflector in an arbitrary observation target area.

- the left side of the figure is a radar image, and the right side is a graph showing a histogram (frequency distribution) of backscattering coefficients.

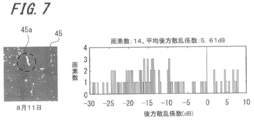

- the corner reflector 45a shown in the radar image 45 on the observation date August 11 shown in FIG. 7 has 14 pixels and an average backscattering coefficient of 5.61 dB.

- the backscattering coefficient discrimination processing unit 28 has a function of determining whether or not the backscattering coefficient processed by the backscattering coefficient processing unit 27 of the reference reflector can be used.

- the backscattering coefficient is saturated, that is, a radar image.

- no use is made. This is because when the backscattering coefficient is saturated, accurate information on the backscattering coefficient cannot be obtained, so that accurate calibration cannot be performed.

- the feature backscattering coefficient processing unit 29 has a function of extracting a backscattering coefficient of a feature (artificial structure, pond, ground, etc.) reflected in the radar image. Based on the processed backscattering coefficient, a low fluctuation region in the radar image is determined. Or the feature which shows the characteristic of a low fluctuation area may be specified beforehand from past data, and this may be used.

- FIG. 8 and FIG. 9 show examples of radar backscattering coefficient [dB] observed at multiple points and multiple times and changes with time. 8 and 9 are obtained by applying a median filter described later as a smoothing process to the observation result.

- FIG. 8 shopping centers, temporary housing, adjustment ponds, grounds, parking lots (parks), ponds (parks), and seven corner reflectors are taken as feature areas, and May 7 and May 31, Data obtained on June 24, July 18, August 11, and September 4 are shown. Each data is an average value of each pixel constituting the feature region.

- FIG. 9 is a graph showing the data shown in FIG. 8 as the time-dependent change of the radar backscatter coefficient in the characteristic region.

- a shopping center or a temporary house with a small change and a large radar backscattering coefficient can be cited as a candidate for a low fluctuation region that is a reference for calibrating the backscattering coefficient of a radar image. It is also possible to list adjustment ponds with little change and a small radar backscattering coefficient as candidates for the low fluctuation region.

- a radar image at the first or predetermined time in which these low fluctuation regions are reflected is used as a reference image at the time of calibration.

- the backscattering coefficient holding unit 30 has a function of storing the backscattering coefficients of the reference reflector and the feature extracted from the radar image.

- the calibration backscattering coefficient calculation unit 31 is a function of performing a smoothing process and / or a local minimum value process on the backscattering coefficient stored in the backscattering coefficient holding unit 30 to obtain a calibration backscattering coefficient, A backscattering coefficient smoothing processing unit 31A and a backscattering coefficient local minimum value calculation unit 31B are provided.

- the backscattering coefficient smoothing processing unit 31A has a function of reducing a noise component such as speckle noise by applying a predetermined smoothing filter, for example, a median filter, to the radar image.

- the median filter is a filter that performs processing in which values in a local region of k ⁇ k are arranged in order and the middle value is used as an output value of a pixel at the center of the region, and the processing can be expressed by Expression (1).

- y [m, n] median ⁇ x [i, j], (i, j) ⁇ (1)

- y [m, n] is the value of the target pixel

- x [i, j] is the value of the neighboring pixel centered on the target pixel

- the backscattering coefficient local minimum value calculation unit 31B has a function of applying a predetermined local minimum value processing filter (hereinafter referred to as “minimum value filter”) to the radar image and extracting a minimum value of a predetermined region.

- the minimum value filter is a filter that performs processing that uses the minimum value in the local area of k ⁇ k as the output value of the pixel at the center of the region, and the processing can be expressed by Expression (2).

- y [m, n] min ⁇ x [i, j], (i, j) ⁇ (2)

- y [m, n] is the value of the target pixel and x [i, j] is the value of the neighboring pixel centered on the target pixel

- the backscattering coefficient smoothing processing unit 31A and the backscattering coefficient local minimum value calculating unit 31B are for reducing the noise component generated in the radar image and extracting the minimum value of the predetermined region, respectively. Without these functional blocks, it is assumed that the image quality of the radar image will deteriorate and the accuracy of calibration will decrease, but this is not always necessary as long as the acquired radar image meets the required specifications, and either It is also possible to use only one or reverse the processing order.

- the calibration line calculation unit 32 is used to calibrate the first image in order to calibrate sequentially captured images (second image, third image,...) With respect to the first captured image (first image). This is a function for calculating a relational expression (calibration line) with the backscattering coefficient for calibration of the second image based on the backscattering coefficient.

- the calibration line calculation unit 32 and the backscattering coefficient calibration unit 33 using the following calibration line constitute the calibration means described in the claims.

- the backscattering coefficient calibration unit 33 based on the calibration line is an example of a backscattering coefficient calibration unit, and an image other than the reference image, for example, the second image and the third image, using the calibration line calculated by the calibration line calculation unit 32. Is a function for processing the backscattering coefficient of all the pixels.

- the growth value calculation unit 34 is obtained by the backscattering coefficient calibration unit 33 using the calibration line based on the information of the growth model (correlation between the backscattering coefficient of the radar image and the paddy rice coverage) stored in the growth model DB 35. This is a function to calculate the rice paddy coverage from the backscattering coefficient.

- the field aggregation calculation unit 36 is a function for calculating the paddy rice coverage in a single stroke unit based on the field map data stored in the field map DB 37, and includes a field representative value calculation unit 36A, a field representative value difference calculation unit 36B, A growth determination unit 36C is provided.

- the field representative value calculation unit 36A is a function for obtaining an average value per stroke or a value having the highest appearance frequency (mode) from the paddy rice coverage of each pixel constituting one radar image.

- the field representative value difference calculation unit 36B is a function that calculates the difference between the field representative value of the reference image (for example, the first image) and the field representative value of the reference image (for example, the second image).

- the growth determination unit 36C has a function of performing growth determination (fast growth and slow growth) from the field representative value and the value of the field representative value difference.

- the output unit 38 is a function for outputting the field representative value of the paddy rice coverage, the value of the field representative value difference, and the result of the growth determination to a list of field units or a ranked map (ranking map). .

- FIG. 10 and 11 are diagrams for explaining the effect of correcting the backscattering coefficient.

- FIG. 10 shows the case of a certain shopping center parking lot on August 11, and

- FIG. 11 shows the case of a certain adjustment pond on August 11.

- the image 51B is an image after the median filter is applied to the original image (image before correction) 51A

- the image 51C is an image obtained by performing the minimum value filter on the image 51B after the median filter is executed.

- the original image 51A has a lot of noise, after the median filtering process and the minimum value filtering process, the noise is removed and the pixel at the center of the area is replaced with the surrounding minimum value.

- the backscattering coefficient for calibration can be stably obtained in a region where the backscattering coefficient itself is large and its fluctuation is small, as in a shopping center parking lot (see arrow).

- FIG. 11 shows an example of the adjustment pond.

- An image 52B is an image after the median filter is applied to the original image (image before correction) 52A

- an image 52C is an image 52B after the median filter is executed. It is the image which implemented the minimum value filter.

- the backscattering coefficient for calibration can be stably increased even in a region such as the adjustment pond where the backscattering coefficient itself is small and its fluctuation is small. (See arrow).

- the alignment processing unit 25 uses the first captured radar image stored in the map DB 26 as a reference image, and the alignment is performed so that the radar images (the same target area) captured at the next or other time overlap. Performed (step S2).

- the ground reference point GCP: Ground ⁇ Control Point

- the alignment process for example, the ground reference point (GCP: Ground ⁇ Control Point) with a clear latitude and longitude, road intersections, buildings, and other points that appear in the image can be used as a reference so that they can be superimposed on the map. Correction is performed.

- backscattering coefficient processing and calibration of the multi-time radar image are performed according to each case (step S3).

- the backscattering coefficient processing unit 27 of the reference reflector extracts the backscattering coefficient values of the corner reflectors that appear in the radar images at a plurality of times, and obtains a calibration line based on the backscattering coefficient values of the reference image. Based on the calibration line, the backscattering coefficient value of the radar image taken at the next time or other time is processed. At this time, the backscattering coefficient determination processing unit 28 determines whether the backscattering coefficient processed by the backscattering coefficient processing unit 27 of the reference reflector can be used, and does not use it when the value of the backscattering coefficient is saturated. .

- the backscattering coefficient value processed by the backscattering coefficient processing unit 27 of the reference reflector is supplied to the backscattering coefficient holding unit 30 in association with the imaging time of the radar image. To do.

- the information on the backscattering coefficient stored in the backscattering coefficient holding unit 30 is filtered by the backscattering coefficient smoothing processing unit 32A and the backscattering coefficient local minimum value calculating unit 32B of the calibration backscattering coefficient calculating unit 31, respectively.

- the noise component is reduced and the backscattering coefficient value in a representative region on the radar image is obtained, and then supplied to the calibration line calculation unit 32.

- the calibration line calculation unit 32 the backscattering coefficient of the low fluctuation region (a plurality of pixels in the reference image) and the specific region (a plurality of pixels in the other radar image corresponding to the low fluctuation region of the reference image).

- a calibration line is calculated from the backscattering coefficient.

- the information on the calibration line is supplied to the calibration unit 33 for the backscattering coefficient calibration unit 33, and the backscattering coefficient of the other radar image is calibrated based on the calibration line.

- Such a calibration process is performed on multi-period radar images.

- the backscattering coefficient of the low fluctuation region in the radar image is used.

- the backscattering coefficient value serving as a calibration reference is extracted from the acquired radar image.

- the feature backscattering coefficient processing unit 29 calculates a backscattering coefficient value of the feature shown in the radar image, and an image region (for example, an artificial structure) having a large backscattering coefficient and a small fluctuation thereof, and the rear An image region (for example, a pond or a soil ground) having a low scattering coefficient and a small fluctuation is extracted.

- These backscattering coefficient values in the image area where the fluctuation of the backscattering coefficient is small are supplied to the backscattering coefficient holding unit 30 in association with the imaging time of the radar image.

- the calibration line calculation unit 32 obtains the backscattering coefficient of the reference reflector reflected in the radar image, and corresponds to the backscattering coefficient of the reference reflector (a plurality of pixels) reflected in the reference image and the reference reflector reflected in the reference image.

- a calibration line is calculated from the backscattering coefficient of the reference reflector (a plurality of pixels thereof) reflected in another radar image.

- the information on the calibration line is supplied to the calibration unit 33 for the backscattering coefficient calibration unit 33, and the backscattering coefficient of the other radar image is calibrated based on the calibration line.

- Such a calibration process is performed on multi-period radar images.

- a reference reflector such as a corner reflector of the first item and a low fluctuation region in the radar image of the second item are used in combination.

- the calibration line calculation unit 32 in accordance with the situation of the image area where the fluctuation of the backscattering coefficient is small in the reference image, the data of the backscattering coefficient of the low fluctuation area on the radar image in the second item and the first item A calibration line is calculated by selectively using data acquired using a reference reflector such as a corner reflector.

- the backscattering coefficient of the region and the backscattering of the reference reflector reflected in another radar image corresponding to the reference reflector reflected in the reference image If the low-fluctuation region is an artificial structure or the like using the coefficient, calibration is performed using the backscattering coefficient of that region and the backscattering coefficient of a specific region of another radar image corresponding to the artificial structure or the like of the reference image. A line is calculated. The information on the calibration line is supplied to the calibration unit 33 for the backscattering coefficient calibration unit 33, and the backscattering coefficient of the other radar image is calibrated based on the calibration line. Such a calibration process is performed on multi-period radar images.

- step S4 The analysis of the growth situation of paddy rice is calculated from the radar image that has been calibrated based on the backscattering coefficient value and the growth information model that are grasped in advance. That is, based on the information on the correlation between the backscattering coefficient of the radar image and the growth value of the vegetation stored in the growth model DB 35, it is reflected in each pixel of the radar image from the backscattering coefficient of the calibrated radar image. The vegetation growth value is calculated.

- the field aggregation calculation unit 36 performs an aggregation process of the analysis results (step S5). For example, when the field representative value calculation unit 36A obtains an average value or mode value in units of one stroke from the paddy rice coverage of each pixel constituting one radar image from the above analysis result, the growth for each field I can understand the situation. Further, when the difference between the field representative value of the reference image (for example, the first image) and the field representative value of the reference image (for example, the second image) is obtained by the field representative value difference calculating unit 36B, between the two periods. Can understand the difference in growth between fields. Furthermore, when the growth determination unit 36C performs the growth determination based on the field representative value and the value of the field representative value difference, it is possible to grasp the difference between the early and late growth between the fields.

- a rice growth situation distribution is created by the output unit 38 (step S6). That is, processing is performed to output the field representative value of the paddy rice coverage, the value of the field representative value difference, and the result of the growth determination to a list of field units or a ranked map (ranking map). These maps showing the rice growth situation distribution are called rice growth situation distribution maps.

- the paddy rice growth situation distribution map is tailored to the actual situation of each user by performing the aggregation process of information for each unit that provides guidance for farming, such as pixel units, field units, and units that subdivide the field. Can provide farming guidance.

- field shape data for example, geographic information data is used.

- the geographic information data of the target area is stored in the map DB 26 or the like.

- FIG. 13 shows the result of calibration (step S3 in FIG. 12) of data acquired on August 11 based on a radar image at a predetermined time (May 7 in this example).

- FIG. 13A is a radar image after calibration of the target time

- FIG. 13B is a diagram showing calibration lines used for calibration of the radar image shown in FIG. 13A.

- the graph is created based on the first imaging time (May 7) at which the backscattering coefficient is minimum, but August 11th is the time when the backscattering coefficient is maximum as described later. It is also possible to standardize on a day basis.

- FIG. 13B is a calibration line based on the May 7 radar image used to calibrate the August 11 data.

- the vertical axis represents the May 7 backscattering coefficient

- the horizontal axis represents the August 11 backscattering coefficient.

- the calibration line (regression line) is expressed by the following equation.

- y backscattering coefficient of the reference image (May 7)

- x backscatter coefficient of the image (August 11) to calibrate

- R 2 is the coefficient of determination.

- the data shown in FIG. 13B is data after applying the minimum value filter.

- y 0.984x-0.137

- R 2 0.972

- the backscattering coefficient of the radar image acquired at each time is calibrated by the calibration line of each time created based on the backscattering coefficient of the radar image at a predetermined time ( May 7 in this example). .

- the backscattering coefficient of the radar image is calibrated, it is possible to calculate a growth value indicating an accurate growth state of paddy rice (plants such as agricultural crops) at each time.

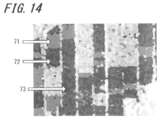

- FIG. 14 shows the distribution of the radar backscattering coefficient for a certain field (paddy rice field), and is an enlarged view of the main part of the radar backscattering coefficient distribution map of the entire target area including a plurality of fields.

- the enlarged radar backscatter coefficient distribution map includes fields 71 to 73. In this way, it is possible to finely confirm the growth status of the crop corresponding to an arbitrary region of the radar image in units of pixels.

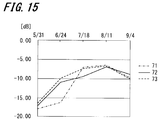

- FIG. 15 is a graph showing the change over time of the average backscattering coefficient corresponding to the radar backscattering coefficient distribution map of the paddy rice field shown in FIG.

- the average backscatter coefficient is obtained by calculating an average value of backscatter coefficients obtained from a plurality of pixels constituting a certain area in the radar image.

- the paddy rice in the fields 71 to 73 has a large backscattering coefficient and a small backscattering coefficient with August 11 as a maximum point. This is presumed to be the result of reduced backscattering by heading and rice drooping. From the graph of FIG. 15, it can be understood that, for example, paddy rice in the field 73 is early-ripened, and paddy rice in the field 71 is late-ripening.

- the objects of observation of the present invention include not only paddy rice but also crops and plants whose backscattering coefficient changes according to the morphological change accompanying the growth stage of corn, barley, etc., and correction of ground surface vegetation using a reference image

- the radar images of a plurality of periods and the radar backscatter coefficient distribution map (vegetation growth situation distribution map) created from the corrected radar image the growth situation of the vegetation can be accurately grasped in real time.

- the calibration line of the radar image at each time is calculated with reference to the backscattering coefficient of the radar image at the predetermined time, and the radar image acquired at each time by the calculated calibration line at each time. Are calibrated. And since the radar image of each period is corrected based on the backscattering coefficient after calibration, it is possible to know the exact growth state of plants such as agricultural crops at each period.

- a series of processes performed by the vegetation growth state analyzing apparatus described above can be executed by hardware or can be executed by software. Needless to say, the function for executing these processes can also be realized by a combination of hardware and software.

- a series of processing is executed by software, it is possible to execute various functions by installing a computer in which a program constituting the software is incorporated in dedicated hardware, or by installing various programs. For example, it is installed from a program recording medium in a general-purpose computer or the like.

- FIG. 16 is a block diagram illustrating a configuration example of a computer that executes the above-described series of processing by a program.

- the computer 101 may be, for example, a personal computer having a certain performance in addition to a dedicated computer with high performance for executing a series of processes.

- a CPU (Central Processing Unit) 111 of the computer 101 executes various processes in addition to the series of processes described above according to a program recorded in a ROM (Read Only Memory) 112 or a recording unit 118.

- a RAM (Random Access Memory) 113 appropriately stores programs executed by the CPU 111 and data.

- the CPU 111, the ROM 112, and the RAM 113 are connected to each other by a bus 114.

- the CPU 111 is also connected with an input / output interface 115 via the bus 114.

- the input / output interface 115 is connected to an input unit 116 including a keyboard, a mouse, and a microphone, and an output unit 117 including a display and a speaker.

- the CPU 111 executes various processes in response to commands input from the input unit 116. Then, the CPU 111 outputs the processing result to the output unit 117.

- the recording unit 118 connected to the input / output interface 115 includes, for example, a hard disk, and records programs executed by the CPU 111 and various data.

- the communication unit 119 communicates with an external device via a network such as the Internet or a local area network.

- a program may be acquired via the communication unit 119 and recorded in the recording unit 118.

- the drive 120 connected to the input / output interface 115 drives a removable medium 131 such as a magnetic disk, an optical disk, a magneto-optical disk, or a semiconductor memory, and drives programs and data recorded there. Get etc. The acquired program and data are transferred to the recording unit 118 and recorded as necessary.

- a program recording medium that stores a program that is installed in a computer and can be executed by the computer is provided as a package medium by a removable medium 131 as shown in FIG.

- a removable medium 131 a magnetic disk (including a flexible disk), an optical disk (including a CD-ROM (compact disc-read-only memory), a DVD (digital versatile disc), a magneto-optical disc), or a semiconductor memory is applied.

- the program recording medium includes a ROM 112 that stores (records) a program temporarily or permanently, a hard disk that forms the recording unit 118, and the like.

- the program is stored in the program recording medium via a communication unit 119 which is an interface such as a router or a modem, as necessary, such as a local area network (LAN), the Internet, or digital satellite broadcasting. This is performed using a wireless communication medium.

- a communication unit 119 is an interface such as a router or a modem, as necessary, such as a local area network (LAN), the Internet, or digital satellite broadcasting. This is performed using a wireless communication medium.

- processing steps describing the program stored in the program recording medium are not limited to the processing performed in time series in the described order, but are not necessarily performed in time series. This includes processing that is executed manually or individually (for example, parallel processing or object processing).

- the program may be processed by a single computer, or may be processed in a distributed manner by a plurality of computers. Furthermore, the program may be transferred to a remote computer and executed.

- SYMBOLS 20 Vegetation growth condition analysis apparatus, 21 ... I / F part, 22 ... Shooting determination part, 23A ... Growth calendar DB, 23B ... Shooting plan DB, 24 ... Radar image holding part, 25 ... Position alignment processing part, 26 ... Map DB, 27... Backscattering coefficient processing unit of reference reflector, 28... Backscattering coefficient discrimination processing unit, 29 .. Backscattering coefficient processing unit of feature, 30... Backscattering coefficient holding unit, 31. Calculation unit, 31A ... backscattering coefficient smoothing processing unit, 31B ... backscattering coefficient local minimum value calculation unit, 32 ... calibration line calculation unit, 33 ...

Landscapes

- Engineering & Computer Science (AREA)

- Remote Sensing (AREA)

- Radar, Positioning & Navigation (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Computer Networks & Wireless Communication (AREA)

- Life Sciences & Earth Sciences (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Artificial Intelligence (AREA)

- Medical Informatics (AREA)

- Forests & Forestry (AREA)

- Environmental Sciences (AREA)

- Botany (AREA)

- Biodiversity & Conservation Biology (AREA)

- Electromagnetism (AREA)

- Health & Medical Sciences (AREA)

- General Health & Medical Sciences (AREA)

- Ecology (AREA)

- Nuclear Medicine, Radiotherapy & Molecular Imaging (AREA)

- Radiology & Medical Imaging (AREA)

- Quality & Reliability (AREA)

- Theoretical Computer Science (AREA)

- Image Processing (AREA)

- Radar Systems Or Details Thereof (AREA)

- Image Analysis (AREA)

Abstract

人工衛星等の飛翔体から得られるレーダ画像を利用して、多時期の植生の生育状況を正確に解析できるようにすることを目的とする。 このため本発明は、飛翔体に搭載されたレーダ装置で複数の時期に撮影された、同一対象エリアの地表面のレーダ画像を取得し、取得された複数のレーダ画像を地図データベースに保存する。次に、所定時期に撮影されたレーダ画像を基準画像として、他の時期に撮影されたレーダ画像の位置合わせを行った後、前記レーダ画像の特定領域の後方散乱係数を抽出する。さらに、前記地図データベースに保存された複数のレーダ画像のうち、前記基準画像の特定領域の後方散乱係数を基に、他のレーダ画像の後方散乱係数を較正する。そして、レーダ画像の後方散乱係数と植生の生育値の相関関係に基づいて、前記較正されたレーダ画像の後方散乱係数から当該レーダ画像に写っている植生の生育値を算出する構成とする。

Description

本発明は、人工衛星等の飛翔体に搭載され、撮影対象地域の地表面を広範囲にわたり撮影して地表の状況を取得するレーダ装置により得られるレーダ画像データを利用して、植生の生育状況を解析するのに好適な植生生育状況解析方法、その処理を実行するためのプログラムを記録した記録媒体および植生生育状況解析装置に係わる。

従来、農作物の生産高の推定・予測(生育状況解析)は、人工衛星や航空機から取得した光学リモートセンシングデータをもとに、アルゴリズムが構築され、実用化に至ってきた。しかし、日本の場合は、四季や雨期があり年間を通して雨や曇りの日が多いため、天候に左右される光学リモートセンシングでは安定した観測が難しい。

また、日本のように南北に続く複雑な地形で多品種・少量の生産をしている場合は、精密な農業管理が必要である。しかし、これまで圃場単位の生育状況が把握できる高精度なデータとして、光学リモートセンシングデータ以外の入手が困難であるという事情があった。

一方、地表面に照射した電波(マイクロ波パルス)の反射波を測定する能動型センサの例として、合成開口レーダ(SAR:Synthetic Aperture Radar)がある。合成開口レーダは、マイクロ波の特性を利用して、昼夜、天候に関係なく、広域を面的に撮影することができる。また、従来の合成開口レーダは光学リモートセンシングと比較すると解像度(精細度)に問題があったが、最新の衛星搭載型合成開口レーダには、解像度が1m以下のものも存在し、高解像度の画像が得られるようになってきている。

農作物に対する合成開口レーダを用いた既往の研究として、下記のようなものがあった。

・光学リモートセンシングデータと多時期のSAR画像を併用した水稲作付け面積の推定

・多重波長、多重偏波のSAR画像からの水稲作付け面積

・多時期のSAR画像を用いた農作物の種別分類の研究

・光学リモートセンシングデータと多時期のSAR画像を併用した水稲作付け面積の推定

・多重波長、多重偏波のSAR画像からの水稲作付け面積

・多時期のSAR画像を用いた農作物の種別分類の研究

これらの研究が海外で行われていたり、多数の論文が公表されたりしているが、水稲など農作物の生育予測に直接結びつくものではなかった。

そこで、多時期のSAR画像を用いた水稲の生育状況について研究が行われている(例えば非特許文献1参照)。

本願の出願人も、多時期のSAR画像を用いた水稲生育状況に関する研究結果を発表している(非特許文献2を参照。)。非特許文献2に記載された研究により、図1~図3に示すような解析結果を得た。

図1は、複数時期のレーダ画像例を示すものであり、各観測日ごとの生育と反射特性、水田の様子、水稲被覆状態、レーダ画像を表している。この例では、RADARSATのCバンドを使用してレーダ画像を撮影している。5月22日、6月15日、7月9日、8月2日の4時期のレーダ画像1A,1B,1C,1Dを作成し、これらのレーダ画像から水稲の生育状況が全体的に変化していることが把握できる。

図2は、水稲被覆率とレーダ後方散乱係数(レーダ装置から送信されたマイクロ波に対する対象物の散乱強度のうち後方への成分)との関係を示したものであり、横軸は水稲被覆率(%)、縦軸はレーダ後方散乱係数(dB)である。図2に示すように水稲被覆率とレーダ後方散乱係数には強い相関があり、これらの観測点に最小2乗法を適用すると、水稲被覆率とレーダ後方散乱係数との関係を表す回帰直線2が得られる。

図3は、各時期における圃場の区画別レーダ後方散乱係数分布を示したものである。このように、レーダ画像を利用して、時期ごとの圃場の区画別レーダ後方散乱係数分布図3A,3B,3C,3Dを作成することにより、水稲の生育状況を区画別に把握することができる。

Zengyuan Li, Guoqing Sun, Mike Wooding, Yong Pang, YanfangDong, Erxue Chen and BingxiangTan, "Rice Monitoring Using EnvisatAsar Data in China", Proc. of the 2004 Envisat & ERS Symposium, Salzburg, Austria6-10 September 2004 (ESA SP-572, April 2005)

高橋一義、阿部博明、力丸厚、向井幸男、「時系列RADARSATデータを用いた水稲生育分布の把握」、日本写真測量学会 年次学術講演会 東京国際展示場(東京)、2004年6月17・18日

ところで、非特許文献1には、多時期のSAR画像を用いた水稲のモニタリングについての研究内容が記載されているが、SAR画像の後方散乱係数と植生との関係は明らかになっていない。

一方、非特許文献2に記載された研究により、衛星SARデータの後方散乱係数と生育状況との相関が明らかになった。しかしながら、後方散乱係数は撮影時期における大気の状況やシステムの変動などの影響を受けるため、異なる時期に撮影したSAR画像の後方散乱係数の較正が必要であり、上記研究結果は多時期の水稲生育状況を正確に表してはいなかった。

本発明は、このような状況に鑑みてなされたものであり、人工衛星等の飛翔体から得られるレーダ画像を利用して、多時期の植生の生育状況を正確に解析できるようにするものである。

本発明の一側面の植生生育状況解析方法およびプログラムを記録した記録媒体は、飛翔体に搭載されたレーダ装置で複数の時期に撮影された、同一対象エリアの地表面のレーダ画像を取得し、取得された複数のレーダ画像を地図データベースに保存する。次に、所定時期に撮影されたレーダ画像を基準画像として、他の時期に撮影されたレーダ画像の位置合わせを行った後、前記レーダ画像の特定領域の後方散乱係数を抽出する。さらに、前記地図データベースに保存された複数のレーダ画像のうち、前記基準画像の特定領域の後方散乱係数を基に、他のレーダ画像の後方散乱係数を較正する。そして、レーダ画像の後方散乱係数と植生の生育値の相関関係に基づいて、前記較正されたレーダ画像の後方散乱係数から当該レーダ画像に写っている植生の生育値を算出する、これらの処理または機能を含むことを特徴とする。

本発明の一側面の植生生育状況解析方法装置は、飛翔体に搭載されたレーダ装置で複数の時期に撮影された、同一対象エリアの地表面のレーダ画像を取得する取得部と、前記取得部で取得された複数のレーダ画像を地図データベースに保存するレーダ画像保持部と、所定時期に撮影されたレーダ画像を基準画像として、他の時期に撮影されたレーダ画像の位置合わせを行う位置合わせ処理部と、前記レーダ画像の特定領域の後方散乱係数を抽出する後方散乱係数処理部と、前記地図データベースに保存された複数のレーダ画像のうち、前記基準画像の特定領域の後方散乱係数を基に、他のレーダ画像の後方散乱係数を較正する較正部と、レーダ画像の後方散乱係数と植生の生育値の相関関係に基づいて、前記較正部により較正されたレーダ画像の後方散乱係数から当該レーダ画像に写る植生の生育値を算出する生育値算出部とを備えることを特徴とする。

本発明の一側面においては、所定時期のレーダ画像の後方散乱係数を基準として各時期のレーダ画像の後方散乱係数が較正される。そして、較正後の後方散乱係数を基に各時期のレーダ画像が補正されるので、各時期における農作物等の植物の正確な生育状況を示す生育値を算出することができる。

以上のように、本発明によれば、飛翔体から得られる多時期のレーダ画像を利用して、多時期の植生の生育状況を正確に解析できる。

以下、本発明を実施するための最良の形態の例について、添付図面を参照しながら説明する。説明は下記項目に従って順に行う。

1.システムの概要

2.植生生育状況解析装置

3.水稲の生育予測処理

4.測定結果等

5.その他

1.システムの概要

2.植生生育状況解析装置

3.水稲の生育予測処理

4.測定結果等

5.その他

<1.システムの概要>

図4は、本発明の植生生育状況解析装置が適用されるシステムの概要を示すものである。

本実施の形態においては、人工衛星にレーダ装置の一例として合成開口レーダ(SAR)を搭載し、その合成開口レーダにより(データ解析センタ12からの指示に基づいて)地表面を撮影する例としてある。以下、人工衛星に搭載した合成開口レーダを「衛星SAR」と称す。

図4は、本発明の植生生育状況解析装置が適用されるシステムの概要を示すものである。

本実施の形態においては、人工衛星にレーダ装置の一例として合成開口レーダ(SAR)を搭載し、その合成開口レーダにより(データ解析センタ12からの指示に基づいて)地表面を撮影する例としてある。以下、人工衛星に搭載した合成開口レーダを「衛星SAR」と称す。

人工衛星に搭載された衛星SAR11は、所定の軌道を周回しながら定期的に、もしくはデータ解析センタ12からの指示に従って随時地表面の圃場13を撮影し、撮影データ(レーダ画像データ)をデータ解析センタ12へ送信する。この例では、農作物として水稲が圃場13に栽培されているとする。

データ解析センタ12は、生育カレンダに沿って撮影計画を行い、その撮影計画に基づいた撮影指示を含む無線信号を衛星SAR11に送信し、また、衛星SAR11が撮影したレーダ画像データを、アンテナを介して受信する。これに対して後述する植生生育状況解析装置20で合成開口処理および所定の補正(較正)を行い、補正された多時期の再生画像やレーダ後方散乱係数(単に「後方散乱係数」ともいう。)の分布図等を生成する。

リアルタイムで水稲の生育評価を行うため、本発明では、最初もしくは所定の時期に取得した画像を基準とした、時系列の画像の後方散乱係数値の較正を行う。この後方散乱係数値の較正を行うことにより、撮影時期による変動の影響を考慮した、より実用的な水稲生育予測システムを実現することができる。

時系列の画像の較正方法は、以下の3つの方法が考えられる。

(1) 対象エリアに基準となる反射板(例えばコーナリフレクタ)を設置して、撮影したSAR画像から反射板の後方散乱係数値を抽出し、これを基準値とする方法

(2) 撮影したSAR画像の中で、低変動領域を抽出し、その領域の後方散乱係数値を用いて較正するための回帰線(較正線)を求め、これに後方散乱係数分布を当てはめる方法

(3) 上記(1),(2)の方法を併用する方法

(1) 対象エリアに基準となる反射板(例えばコーナリフレクタ)を設置して、撮影したSAR画像から反射板の後方散乱係数値を抽出し、これを基準値とする方法

(2) 撮影したSAR画像の中で、低変動領域を抽出し、その領域の後方散乱係数値を用いて較正するための回帰線(較正線)を求め、これに後方散乱係数分布を当てはめる方法

(3) 上記(1),(2)の方法を併用する方法

<2.植生生育状況解析装置>

[植生生育状況解析装置の構成]

図5は、本発明の植生生育状況解析装置の一実施の形態に係る機能ブロック図を示したものである。植生生育状況解析装置は、上記時系列画像の後方散乱係数値の較正を行い、植生の生育状況を予測するためのデータを生成するものである。この植生生育状況解析装置は、データ解析センタ12に設置されることを想定しているが、衛星SAR11とともに人工衛星に搭載してもよいし、それぞれに分散してもよい。また、植生生育状況解析装置の各機能は、ハードウェアまたはソフトウェアのいずれでも実現することができる。あるいはそれらの組み合わせにより実現してもよい。

[植生生育状況解析装置の構成]

図5は、本発明の植生生育状況解析装置の一実施の形態に係る機能ブロック図を示したものである。植生生育状況解析装置は、上記時系列画像の後方散乱係数値の較正を行い、植生の生育状況を予測するためのデータを生成するものである。この植生生育状況解析装置は、データ解析センタ12に設置されることを想定しているが、衛星SAR11とともに人工衛星に搭載してもよいし、それぞれに分散してもよい。また、植生生育状況解析装置の各機能は、ハードウェアまたはソフトウェアのいずれでも実現することができる。あるいはそれらの組み合わせにより実現してもよい。

本実施の形態の植生生育状況解析装置20は主に、I/F部21、撮影決定部22、レーダ画像保持部24、位置合わせ処理部25、基準反射板の後方散乱係数処理部27、後方散乱係数の判別処理部28、地物の後方散乱係数処理部29を備える。また、後方散乱係数保持部30、較正用後方散乱係数算出部31、較正線算出部32、較正線による後方散乱係数較正部33、生育値算出部34、圃場集約算出部36、出力部38を備える。さらに、生育カレンダデータベース(以下、「生育カレンダDB」という。)23A、撮影計画データベース(以下、「撮影計画DB」という。)23B、地図データベース(以下、「地図DB」という。)26、生育モデルデータベース(以下、「生育モデルDB」という。)35、圃場地図データベース(以下、「圃場地図DB」という。)37を備える。

I/F部21は、取得部の一例であり、衛星SAR11で撮影した撮影データを取り込むいわゆるインタフェースとしての機能を備える。I/F部21は、通信部としての機能も備え、撮影決定部22からの指示を衛星SAR11に送信し、衛星SAR11に撮影を実行させることができる。撮影データは、生育カレンダDB23Aに登録された水稲の生育カレンダや、撮影計画DB23Bに登録された衛星の撮影時期(周期)をもとに、計画的に撮影されるレーダ画像のデータである。

生育カレンダは、例えば水稲の場合であれば、5月の田植え期から始まって分けつ期、最高分けつ期、幼穂形成期、出穂期、登熟期、そして9月の成熟期までの栽培暦である。また、現在打ち上げられている合成開口レーダ搭載の人工衛星には、例えば、観測周期が11日のものがある。

撮影決定部22は、これらの生育カレンダと衛星の撮影周期を考慮してレーダ画像をI/F部21に取り込む時期を決定する。決定した撮影予定日(データ取得日)の一例を以下に示す。

[観測日] [起算日] [段階]

1)5月 7日 0日 田植期

2)5月31日 24日 分けつ期

3)6月24日 38日 最高分けつ期

4)7月18日 72日 幼穂形成期

5)8月11日 96日 出穂期

6)9月 4日 120日 登熟期

[観測日] [起算日] [段階]

1)5月 7日 0日 田植期

2)5月31日 24日 分けつ期

3)6月24日 38日 最高分けつ期

4)7月18日 72日 幼穂形成期

5)8月11日 96日 出穂期

6)9月 4日 120日 登熟期

なお、撮影決定部22は、水稲の生育の評価を行う対象面積により、撮影画像の画素サイズを設定するようにしてもよい。例えば、詳細な評価を行う場合は、地上分解能を高く(例えば1m)することが好ましい。

レーダ画像保持部24は、所定の時期に撮影された時系列のレーダ画像を、地図DB26に保存する機能である。地図DB26は、例えばハードディスクやフラッシュメモリ等の不揮発性の記憶手段に構築される。

位置合わせ処理部25は、地図DB26に保存されている地図データをもとに、レーダ画像を地図に重ね合わせることができるように、幾何(位置)的な処理を行う機能である。また、位置合わせ後のレーダ画像を、較正線による後方散乱係数較正部33、基準反射板の後方散乱係数処理部27および地物の後方散乱係数処理部29へ供給する。

基準反射板の後方散乱係数処理部27は、レーダ画像に写っている基準反射板の後方散乱係数を処理(抽出)する機能である。この基準反射板としては、例えば「加美川雄太、大内和夫、“陸域観測技術衛星「だいち」搭載合成開口レーダPALSARの校正・検証実験”、平成18年度卒業論文、高知工科大学工学部」(文献1)に記載されたコーナリフレクタなど、種々の反射板を適用できる。

観測対象エリアに反射板を用いる場合、2時期の反射板の後方散乱係数値をそれぞれ抽出して、基準の画像の後方散乱係数値をもとにした較正を行うための較正線を求め、次の時期や他の時期に撮影した画像を較正する。文献1にも記載されているように、反射板は、地表面に照射するマイクロ波のバンド(波長)や人工衛星の軌道(撮影方向)によって、適宜、適切な面積や形状、個数、方向を調整して設置することが望ましい。

[基準反射板(コーナーリフレクタ)]

図6は、任意の観測対象エリアに、反射板としてコーナリフレクタを設置した場合のレーダ画像と平均後方散乱係数の計測結果を示したものである。図の左側がレーダ画像、右側が後方散乱係数のヒストグラム(頻度分布)を示すグラフである。

図6は、任意の観測対象エリアに、反射板としてコーナリフレクタを設置した場合のレーダ画像と平均後方散乱係数の計測結果を示したものである。図の左側がレーダ画像、右側が後方散乱係数のヒストグラム(頻度分布)を示すグラフである。

図6に示す観測日5月7日のレーダ画像41に写るコーナリフレクタ41aに相当する画素、すなわち後方散乱係数が0dB以上の画素数は4、平均後方散乱係数が5.13dBである。同様に、図7に示す観測日8月11日のレーダ画像45に写るコーナリフレクタ45aは画素数が14、平均後方散乱係数が5.61dBである。

このように、時期によってコーナリフレクタの画素数および平均後方散乱係数が異なるので、この情報を後方散乱係数の較正に反映させる。

後方散乱係数の判別処理部28は、基準反射板の後方散乱係数処理部27で処理した後方散乱係数の利用の可否を判定する機能であり、後方散乱係数が飽和状況の場合、すなわち、レーダ画像の中のコーナリフレクタが設置されている場所以外に、コーナリフレクタにおける後方散乱係数と同じ値の画素が存在する場合は利用しない。後方散乱係数が飽和している場合、正確な後方散乱係数の情報が得られないため精度の良い較正を行うことができないからである。

地物の後方散乱係数処理部29は、レーダ画像に写っている地物(人工構造物、池、グラウンドなど)の後方散乱係数を抽出する機能である。ここで処理された後方散乱係数をもとにレーダ画像中の低変動領域を決定する。あるいは過去のデータから低変動領域の特徴を示す地物を予め特定しておき、これを利用してもよい。

[複数地点・多時期のレーダ後方散乱係数]

図8、図9は、多地点・多時期で観測したレーダ後方散乱係数[dB]及びその経時変化の例を示すものである。なお、図8、図9は、観測結果に平滑処理として後述するメディアンフィルタを適用したものである。

図8、図9は、多地点・多時期で観測したレーダ後方散乱係数[dB]及びその経時変化の例を示すものである。なお、図8、図9は、観測結果に平滑処理として後述するメディアンフィルタを適用したものである。

図8では、特徴領域としてショッピングセンタ、仮設住宅、調整池、グラウンド、駐車場(公園)、池(公園)、並びにコーナリフレクタの7地点、また撮影日として5月7日、5月31日、6月24日、7月18日、8月11日、9月4日において得られたデータを示している。各データは、特徴領域を構成する各画素の平均値をとったものである。

図9は、図8に示したデータを特徴領域のレーダ後方散乱係数の経時変化としてグラフに表したものである。例えば、変化が少なくレーダ後方散乱係数の大きいショッピングセンタや仮設住宅が、レーダ画像の後方散乱係数を較正する際の基準となる低変動領域の候補として挙げられる。また、変化が少なくレーダ後方散乱係数の小さい調整池を低変動領域の候補として挙げることも可能である。これらの低変動領域が写った、最初または所定の時期のレーダ画像が較正時の基準画像として利用される。

図5に示した植生生育状況解析装置の説明に戻る。

後方散乱係数保持部30は、レーダ画像から抽出された基準反射板および地物の後方散乱係数を保存する機能である。

後方散乱係数保持部30は、レーダ画像から抽出された基準反射板および地物の後方散乱係数を保存する機能である。

較正用後方散乱係数算出部31は、後方散乱係数保持部30に保存された後方散乱係数に対して、平滑処理および/または局所最小値処理を行い、較正用後方散乱係数を求める機能であり、後方散乱係数平滑処理部31A、後方散乱係数局所最小値算出部31Bを備える。

後方散乱係数平滑処理部31Aは、レーダ画像に対して所定の平滑処理用フィルタ、例えばメディアンフィルタをかけて、スペックルノイズ等のノイズ成分を低減する機能を備える。メディアンフィルタは、k×kの局所領域における値を順番に並べ、その真ん中の値を領域中央の画素の出力値とする処理を行うフィルタであり、その処理は式(1)で表すことができる。

y[m,n] = median{x[i,j],(i,j)∈ω}・・・・(1)

ここで、y[m,n]は対象画素の値、x[i,j]は対象画素を中心とする近傍画素の値

y[m,n] = median{x[i,j],(i,j)∈ω}・・・・(1)

ここで、y[m,n]は対象画素の値、x[i,j]は対象画素を中心とする近傍画素の値

後方散乱係数局所最小値算出部31Bは、レーダ画像に対して所定の局所最小値処理用フィルタ(以下、「最小値フィルタ」という。)をかけて、所定領域の最小値を抽出する機能を備える。最小値フィルタは、k×kの局所領域における値の最小値を、領域中央の画素の出力値とする処理を行うフィルタであり、その処理は式(2)で表すことができる。

y[m,n] = min{x[i,j],(i,j)∈ω}・・・・(2)

ここで、y[m,n]は対象画素の値、x[i,j]は対象画素を中心とする近傍画素の値

y[m,n] = min{x[i,j],(i,j)∈ω}・・・・(2)

ここで、y[m,n]は対象画素の値、x[i,j]は対象画素を中心とする近傍画素の値

上述のとおり、後方散乱係数平滑処理部31Aおよび後方散乱係数局所最小値算出部31Bは、それぞれレーダ画像に発生するノイズ成分の低減および所定領域の最小値を抽出するものである。これらの機能ブロックがない場合、レーダ画像の画質が劣化し、較正の精度が低下することが想定されるが、取得したレーダ画像が要求仕様を満たしてさえいれば必ずしも必要ではなく、また何れか一方のみを用いたり、あるいは処理順序を逆にしたりすることも可能である。

較正線算出部32は、例えば最初に撮影した画像(第1画像)に対して、順次撮影した画像(第2画像、第3画像・・・)を較正するために、第1画像の較正用後方散乱係数をもとに、第2画像の較正用後方散乱係数との関係式(較正線)を算出する機能である。この較正線算出部32は、下記較正線による後方散乱係数較正部33とともに、特許請求の範囲に記載した較正手段を構成する。

較正線による後方散乱係数較正部33は、後方散乱係数較正手段の一例であり、較正線算出部32で算出された較正線を用いて、基準画像以外の画像、例えば第2画像、第3画像・・・の全画素の後方散乱係数を処理する機能である。

生育値算出部34は、生育モデルDB35に保存された生育モデル(レーダ画像の後方散乱係数と水稲被覆率の相関関係)の情報をもとに、較正線による後方散乱係数較正部33で求められた後方散乱係数から水稲被覆率を算出する機能である。

圃場集約算出部36は、圃場地図DB37に保存された圃場地図データをもとに、一筆単位の水稲被覆率を算出する機能であり、圃場代表値算出部36A、圃場代表値差分算出部36B、生育判定部36Cを備える。

圃場代表値算出部36Aは、1つのレーダ画像を構成する各画素の水稲被覆率から一筆単位の平均値、もしくは、出現頻度が最も高い値(最頻値)を求める機能である。

圃場代表値差分算出部36Bは、基準画像(例えば第1画像)の圃場代表値と参照画像(例えば第2画像)の圃場代表値の差分を計算する機能である。

生育判定部36Cは、圃場代表値および圃場代表値差分の値から生育判定(生育の早い、遅い)を行う機能である。

出力部38は、水稲被覆率の圃場代表値、圃場代表値差分の値、および、生育判定の結果を、圃場単位の一覧表、もしくは、ランキングした地図(ランキングマップ)などに出力する機能である。

[後方散乱係数の補正の効果]

図10、図11は、後方散乱係数の補正の効果を説明するための図である。図10は、8月11日におけるあるショッピングセンタ駐車場の場合を示し、図11は、8月11日におけるある調整池の場合を示している。

画像51Bは、オリジナルの画像(補正前の画像)51Aにメディアンフィルタを実施した後の画像、画像51Cは、メディアンフィルタを実施した後の画像51Bに最小値フィルタを実施した画像である。オリジナルの画像51Aはノイズが多いが、メディアンフィルタ処理および最小値フィルタ処理後は、ノイズが除去されるとともに領域中央の画素が周辺の最小値に置き換えられている。この結果、ショッピングセンタ駐車場のように後方散乱係数自体が大きくその変動が少ない領域において、較正用の後方散乱係数を安定的に求めることができる(矢印参照)。

図10、図11は、後方散乱係数の補正の効果を説明するための図である。図10は、8月11日におけるあるショッピングセンタ駐車場の場合を示し、図11は、8月11日におけるある調整池の場合を示している。

画像51Bは、オリジナルの画像(補正前の画像)51Aにメディアンフィルタを実施した後の画像、画像51Cは、メディアンフィルタを実施した後の画像51Bに最小値フィルタを実施した画像である。オリジナルの画像51Aはノイズが多いが、メディアンフィルタ処理および最小値フィルタ処理後は、ノイズが除去されるとともに領域中央の画素が周辺の最小値に置き換えられている。この結果、ショッピングセンタ駐車場のように後方散乱係数自体が大きくその変動が少ない領域において、較正用の後方散乱係数を安定的に求めることができる(矢印参照)。

図11は調整池の場合の例であり、画像52Bは、オリジナルの画像(補正前の画像)52Aにメディアンフィルタを実施した後の画像、画像52Cは、メディアンフィルタを実施した後の画像52Bに最小値フィルタを実施した画像である。調整池の場合、図10に示したショッピングセンタ駐車場の場合と比較して、さらに後方散乱係数自体が小さくその変動が少ない調整池のような領域においても較正用の後方散乱係数を安定的に求めることができる(矢印参照)。

<3.水稲の生育予測処理>

[植生生育状況解析装置の動作]

次に、図12に示すフローチャートを参照して、植生生育状況解析装置20による水稲の生育状況解析処理を説明する。

図5において、植生生育状況解析装置20の撮影決定部22により、適切な撮影時期、場所および地上分解能等を決定し、これらの情報をI/F部21を介して衛星SAR11へ送信する。I/F部21において、衛星SAR11で撮影されたSAR画像(レーダ画像)が人工衛星から受信される(ステップS1)。受信した各時期のレーダ画像は、レーダ画像保持部24により地図DB26に保存される。

[植生生育状況解析装置の動作]

次に、図12に示すフローチャートを参照して、植生生育状況解析装置20による水稲の生育状況解析処理を説明する。

図5において、植生生育状況解析装置20の撮影決定部22により、適切な撮影時期、場所および地上分解能等を決定し、これらの情報をI/F部21を介して衛星SAR11へ送信する。I/F部21において、衛星SAR11で撮影されたSAR画像(レーダ画像)が人工衛星から受信される(ステップS1)。受信した各時期のレーダ画像は、レーダ画像保持部24により地図DB26に保存される。

続いて、位置合わせ処理部25により、地図DB26に保存されている最初に撮影したレーダ画像を基準画像として、次または他の時期に撮影したレーダ画像(同一対象エリア)が重なるように位置合わせが行われる(ステップS2)。位置合わせ処理では、例えば緯度経度が明確な地上基準点(GCP:Ground Control Point)や道路交差点、建物など画像に表れている点を基準として、地図に重ね合わせることができるように幾何学的な補正が行われる。

位置合わせが終了後、それぞれの場合に応じて、多時期のレーダ画像の後方散乱係数処理および較正が行われる(ステップS3)。

第1に、コーナリフレクタ等の基準反射板を利用する場合を説明する。

基準反射板の後方散乱係数処理部27は、複数時期のレーダ画像中に写るコーナリフレクタの後方散乱係数値をそれぞれ抽出して、基準画像の後方散乱係数値をもとにした較正線を求め、当該較正線に基づいて次の時期や他の時期に撮影したレーダ画像の後方散乱係数値を処理する。このとき、後方散乱係数の判別処理部28は、基準反射板の後方散乱係数処理部27で処理した後方散乱係数の利用の可否を判定し、後方散乱係数の値が飽和状況の場合は利用しない。一方、後方散乱係数の値が飽和状況でない場合は、基準反射板の後方散乱係数処理部27で処理した後方散乱係数値を、レーダ画像の撮影時期と対応づけて後方散乱係数保持部30へ供給する。

基準反射板の後方散乱係数処理部27は、複数時期のレーダ画像中に写るコーナリフレクタの後方散乱係数値をそれぞれ抽出して、基準画像の後方散乱係数値をもとにした較正線を求め、当該較正線に基づいて次の時期や他の時期に撮影したレーダ画像の後方散乱係数値を処理する。このとき、後方散乱係数の判別処理部28は、基準反射板の後方散乱係数処理部27で処理した後方散乱係数の利用の可否を判定し、後方散乱係数の値が飽和状況の場合は利用しない。一方、後方散乱係数の値が飽和状況でない場合は、基準反射板の後方散乱係数処理部27で処理した後方散乱係数値を、レーダ画像の撮影時期と対応づけて後方散乱係数保持部30へ供給する。

そして、後方散乱係数保持部30に保存された後方散乱係数の情報は、較正用後方散乱係数算出部31の後方散乱係数平滑処理部32Aおよび後方散乱係数局所最小値算出部32Bによってそれぞれフィルタ処理されてノイズ成分が低減され、レーダ画像上の代表的な領域内の後方散乱係数値が求められた後、較正線算出部32に供給される。較正線算出部32では、基準画像の低変動領域(内の複数の画素)の後方散乱係数と、その基準画像の低変動領域に対応する他のレーダ画像の特定領域(内の複数の画素)の後方散乱係数から較正線が算出される。この較正線の情報は、較正線による後方散乱係数較正部33に供給され、この較正線に基づいて、他のレーダ画像の後方散乱係数が較正される。このような較正処理が多時期のレーダ画像について行われる。

第2に、レーダ画像中の低変動領域の後方散乱係数を用いる場合を説明する。

この場合、較正の基準となる後方散乱係数値は取得したレーダ画像の中から抽出する。地物の後方散乱係数処理部29は、レーダ画像に写っている地物の後方散乱係数値を計算し、後方散乱係数が大きくその変動が少ない画像領域(例えば、人工構造物)、および、後方散乱係数が低くその変動が少ない画像領域(例えば、池、土のグラウンド)を抽出する。これら後方散乱係数の変動が少ない画像領域、すなわち低変動領域の後方散乱係数値を、レーダ画像の撮影時期と対応付けて後方散乱係数保持部30へ供給する。

この場合、較正の基準となる後方散乱係数値は取得したレーダ画像の中から抽出する。地物の後方散乱係数処理部29は、レーダ画像に写っている地物の後方散乱係数値を計算し、後方散乱係数が大きくその変動が少ない画像領域(例えば、人工構造物)、および、後方散乱係数が低くその変動が少ない画像領域(例えば、池、土のグラウンド)を抽出する。これら後方散乱係数の変動が少ない画像領域、すなわち低変動領域の後方散乱係数値を、レーダ画像の撮影時期と対応付けて後方散乱係数保持部30へ供給する。

そして、後方散乱係数保持部30に保存された後方散乱係数の情報は、第1の場合と同様に後方散乱係数平滑処理部31Aおよび後方散乱係数局所最小値算出部31Bにてフィルタ処理された後、較正線算出部32に供給される。較正線算出部32では、レーダ画像に写る基準反射板の後方散乱係数が求められ、基準画像に写る基準反射板(の複数の画素)の後方散乱係数と、基準画像に写る基準反射板に対応する他のレーダ画像に写る基準反射板(の複数の画素)の後方散乱係数から較正線が算出される。この較正線の情報は、較正線による後方散乱係数較正部33に供給され、この較正線に基づいて、他のレーダ画像の後方散乱係数が較正される。このような較正処理が多時期のレーダ画像について行われる。

第3に、第1項目のコーナリフレクタ等の基準反射板および第2項目のレーダ画像中の低変動領域を併用する場合を説明する。

この場合、較正線算出部32では、基準画像において後方散乱係数の変動が少ない画像領域の状況に応じて、第2項目におけるレーダ画像上の低変動領域の後方散乱係数のデータと、第1項目におけるコーナリフレクタ等の基準反射板を用いて取得したデータとを選択的に用いて較正線が算出される。すなわち、基準画像から低変動領域を抽出し、これが基準反射板である場合にはその領域の後方散乱係数および基準画像に写る基準反射板に対応する他のレーダ画像に写る基準反射板の後方散乱係数を用いて、低変動領域が人工構造物等である場合にはその領域の後方散乱係数および基準画像の人工構造物等に対応する他のレーダ画像の特定領域の後方散乱係数を用いて較正線が算出される。この較正線の情報は、較正線による後方散乱係数較正部33に供給され、この較正線に基づいて、他のレーダ画像の後方散乱係数が較正される。このような較正処理が多時期のレーダ画像について行われる。

この場合、較正線算出部32では、基準画像において後方散乱係数の変動が少ない画像領域の状況に応じて、第2項目におけるレーダ画像上の低変動領域の後方散乱係数のデータと、第1項目におけるコーナリフレクタ等の基準反射板を用いて取得したデータとを選択的に用いて較正線が算出される。すなわち、基準画像から低変動領域を抽出し、これが基準反射板である場合にはその領域の後方散乱係数および基準画像に写る基準反射板に対応する他のレーダ画像に写る基準反射板の後方散乱係数を用いて、低変動領域が人工構造物等である場合にはその領域の後方散乱係数および基準画像の人工構造物等に対応する他のレーダ画像の特定領域の後方散乱係数を用いて較正線が算出される。この較正線の情報は、較正線による後方散乱係数較正部33に供給され、この較正線に基づいて、他のレーダ画像の後方散乱係数が較正される。このような較正処理が多時期のレーダ画像について行われる。

そして、生育値算出部34により生育モデルを基にした水稲の生育解析が行われる(ステップS4)。水稲の生育状況の解析は、予め把握している後方散乱係数値と生育情報のモデルを基に、較正処理済みのレーダ画像から計算する。すなわち、生育モデルDB35に保存された、レーダ画像の後方散乱係数と植生の生育値の相関関係の情報に基づいて、較正されたレーダ画像の後方散乱係数から当該レーダ画像の各画素に写っている植生の生育値が算出される。

水稲の生育解析が終了後、圃場集約算出部36により解析結果の集計処理が行われる(ステップS5)。例えば、圃場代表値算出部36Aにより、上記解析結果から、1つのレーダ画像を構成する各画素の水稲被覆率から一筆単位の平均値、もしくは、最頻値が求められた場合、圃場ごとの生育状況が把握できる。

また、圃場代表値差分算出部36Bにより、基準画像(例えば第1画像)の圃場代表値と参照画像(例えば第2画像)の圃場代表値の差分が求められた場合、2つの時期の間で圃場ごとの生育の違いを把握できる。

さらに、生育判定部36Cにより、圃場代表値および圃場代表値差分の値に基づいて生育判定が行われた場合、圃場間での生育の早いか遅いかの違いを把握できる。

また、圃場代表値差分算出部36Bにより、基準画像(例えば第1画像)の圃場代表値と参照画像(例えば第2画像)の圃場代表値の差分が求められた場合、2つの時期の間で圃場ごとの生育の違いを把握できる。

さらに、生育判定部36Cにより、圃場代表値および圃場代表値差分の値に基づいて生育判定が行われた場合、圃場間での生育の早いか遅いかの違いを把握できる。

そして、出力部38により水稲生育状況分布の作成が行われる(ステップS6)。すなわち、水稲被覆率の圃場代表値、圃場代表値差分の値、および、生育判定の結果を、圃場単位の一覧表、もしくは、ランキングした地図(ランキングマップ)などに出力する処理が行われる。これらの水稲生育状況分布を表した地図は、水稲生育状況分布図と呼ばれる。

水稲生育状況分布図は、ピクセル(画素)単位、圃場単位、圃場の中を細分化した単位など、営農指導を行う単位ごとに情報の集計処理を行うことにより、個々のユーザの実情に合わせた営農指導を行える。

ピクセル(画素)単位から圃場単位に集計するためには、圃場の形状のデータ、例えば、地理情報データを利用する。対象エリアの地理情報データは、地図DB26等に保存しておく。

<4.測定結果等>

図13は、所定の時期(この例では5月7日)のレーダ画像を基に、8月11日に取得したデータを較正(図12のステップS3)した結果を示すものである。図13Aは対象時期の較正後のレーダ画像、図13Bは図13Aに示したレーダ画像の較正に用いた較正線を示す図である。なお、図13Bの例では後方散乱係数が最小となる撮影時期の最初(5月7日)を基準にグラフを作成したが、後述するように後方散乱係数が最大となる時期である8月11日を基準として標準化することも可能である。

図13は、所定の時期(この例では5月7日)のレーダ画像を基に、8月11日に取得したデータを較正(図12のステップS3)した結果を示すものである。図13Aは対象時期の較正後のレーダ画像、図13Bは図13Aに示したレーダ画像の較正に用いた較正線を示す図である。なお、図13Bの例では後方散乱係数が最小となる撮影時期の最初(5月7日)を基準にグラフを作成したが、後述するように後方散乱係数が最大となる時期である8月11日を基準として標準化することも可能である。

図13Bは、8月11日のデータを較正するために用いる、5月7日のレーダ画像を基にした較正線である。縦軸が5月7日の後方散乱係数であり、横軸が8月11日における後方散乱係数である。この例では、較正線(回帰直線)は下記式で表される。ただし、yは基準画像(5月7日)の後方散乱係数、xは較正する画像(8月11日)の後方散乱係数、R2は決定係数である。なお、図13Bに示したデータは、最小値フィルタを適用後のデータである。

y=0.984x-0.137

R2=0.972

y=0.984x-0.137

R2=0.972

同様にして、所定時期(この例では5月7日)のレーダ画像の後方散乱係数を基準として作成した各時期の較正線により、それぞれの時期に取得したレーダ画像の後方散乱係数が較正される。この結果、レーダ画像の後方散乱係数が較正されるので、各時期における水稲(農作物等の植物)の正確な生育状況を示す生育値を算出することができる。

次に、圃場のレーダ後方散乱係数分布図について説明する。

図14は、ある圃場(水稲作付圃場)についてのレーダ後方散乱係数の分布を示したものであり、複数の圃場を含む対象エリア全体のレーダ後方散乱係数分布図の要部の拡大図である。図14において、拡大されたレーダ後方散乱係数分布図には圃場71~73が含まれている。このように、レーダ画像の任意の領域に対応する農作物の生育状況について、画素単位で精細に確認することができる。

図14は、ある圃場(水稲作付圃場)についてのレーダ後方散乱係数の分布を示したものであり、複数の圃場を含む対象エリア全体のレーダ後方散乱係数分布図の要部の拡大図である。図14において、拡大されたレーダ後方散乱係数分布図には圃場71~73が含まれている。このように、レーダ画像の任意の領域に対応する農作物の生育状況について、画素単位で精細に確認することができる。

図15は、図14に示した水稲作付圃場のレーダ後方散乱係数分布図に対応する平均後方散乱係数の経時変化を示すグラフである。平均後方散乱係数とは、レーダ画像内のある領域を構成する複数の画素から得られた後方散乱係数の平均値を算出したものである。圃場71~73の水稲は、田植え後から徐々に成長した結果として、後方散乱係数が大きくなり、8月11日を極大点として後方散乱係数が小さくなっている。これは、出穂および稲の垂下によって後方散乱が減少した結果と推測される。この図15のグラフからは、例えば圃場73の水稲が早熟で、圃場71の水稲は晩熟であることが把握できる。

本発明の観測の対象は、水稲だけでなくトウモロコシや大麦等の生育段階に伴う形態変化に応じて後方散乱係数が変化する農作物、植物が含まれ、地表面の植生について基準画像を用いて補正した複数の時期のレーダ画像や、補正後のレーダ画像から作成したレーダ後方散乱係数分布図(植生の生育状況分布図)を観察することにより、植生の生育状況をリアルタイムかつ正確に把握できる。

上述した実施の形態によれば、所定時期のレーダ画像の後方散乱係数を基準として各時期のレーダ画像の較正線を算出し、算出した各時期の較正線により、それぞれの時期に取得したレーダ画像の後方散乱係数が較正される。そして、較正後の後方散乱係数を基に各時期のレーダ画像が補正されるので、各時期における農作物等の植物の正確な生育状況を知ることができる。

また、人工衛星等の飛翔体からマイクロ波を用いて撮像したレーダ画像は、全天候型であるために、5月(田植え)から8月(出穂)の間の雨期でも農作物等の植物の生育状況を把握することができる。

また、多時期にわたる正確でリアルタイムな生育状況の把握により、農作物等の植物の適時かつ適切な栽培管理、追肥の投入時期の決定等が可能となる。

また、多時期にわたる正確でリアルタイムな生育状況の把握により、病害虫などの発生の予防、生育障害、災害への対処が可能となる。

さらに、官公庁等で実施している現地調査による水稲作況調査が観測手段(リモートセンシング)で可能となる。

<5.その他>

なお、上述した植生生育状況解析装置で行われる一連の処理は、ハードウェアにより実行させることもできるし、ソフトウェアにより実行させることもできる。また、これらの処理を実行する機能はハードウェアとソフトウェアの組み合わせによっても実現できることは言うまでもない。一連の処理をソフトウェアにより実行させる場合には、そのソフトウェアを構成するプログラムが専用のハードウェアに組み込まれているコンピュータ、または、各種のプログラムをインストールすることで各種の機能を実行することが可能な、例えば汎用のコンピュータなどに、プログラム記録媒体からインストールされる。

なお、上述した植生生育状況解析装置で行われる一連の処理は、ハードウェアにより実行させることもできるし、ソフトウェアにより実行させることもできる。また、これらの処理を実行する機能はハードウェアとソフトウェアの組み合わせによっても実現できることは言うまでもない。一連の処理をソフトウェアにより実行させる場合には、そのソフトウェアを構成するプログラムが専用のハードウェアに組み込まれているコンピュータ、または、各種のプログラムをインストールすることで各種の機能を実行することが可能な、例えば汎用のコンピュータなどに、プログラム記録媒体からインストールされる。

図16は、上述した一連の処理をプログラムにより実行するコンピュータの構成例を示すブロック図である。このコンピュータ101は、例えば一連の処理を実行するために高性能化した専用コンピュータの他、一定の性能を備えるパーソナルコンピュータなどでもよい。

コンピュータ101のCPU(Central Processing Unit)111は、ROM(Read Only Memory)112、または記録部118に記録されているプログラムに従って、上記一連の処理の他、各種の処理を実行する。RAM(Random Access Memory)113には、CPU111が実行するプログラムやデータなどが適宜記憶される。これらのCPU111、ROM112、およびRAM113は、バス114により相互に接続されている。

CPU111にはまた、バス114を介して入出力インタフェース115が接続されている。入出力インタフェース115には、キーボード、マウス、マイクロホンなどよりなる入力部116、ディスプレイ、スピーカなどよりなる出力部117が接続されている。CPU111は、入力部116から入力される指令に対応して各種の処理を実行する。そして、CPU111は、処理の結果を出力部117に出力する。

入出力インタフェース115に接続されている記録部118は、例えばハードディスクからなり、CPU111が実行するプログラムや各種のデータを記録する。

通信部119は、インターネットやローカルエリアネットワークなどのネットワークを介して外部の装置と通信する。また通信部119を介してプログラムを取得し、記録部118に記録してもよい。

入出力インタフェース115に接続されているドライブ120は、磁気ディスク、光ディスク、光磁気ディスク、あるいは半導体メモリなどのリムーバブルメディア131が装着されたとき、それらを駆動し、そこに記録されているプログラムやデータなどを取得する。取得されたプログラムやデータは、必要に応じて記録部118に転送され、記録される。

コンピュータにインストールされ、コンピュータによって実行可能な状態とされるプログラムを格納するプログラム記録媒体は、図16に示すように、リムーバブルメディア131によりパッケージメディアとして提供される。リムーバブルメディア131としては、磁気ディスク(フレキシブルディスクを含む)、光ディスク(CD-ROM(Compact Disc - Read Only Memory),DVD(Digital Versatile Disc),光磁気ディスクを含む)、もしくは半導体メモリなどを適用することができる。あるいは、プログラム記録媒体は、プログラムが一時的もしくは永続的に格納(記録)されるROM112や、記録部118を構成するハードディスクなどにより構成される。

このプログラム記録媒体へのプログラムの格納は、必要に応じてルータ、モデムなどのインタフェースである通信部119を介して、ローカルエリアネットワーク(LAN:Local Area Network)、インターネット、デジタル衛星放送といった、有線または無線の通信媒体を利用して行われる。

なお、本明細書において、プログラム記録媒体に格納されるプログラムを記述する処理ステップは、記載された順序に沿って時系列的に行われる処理はもちろん、必ずしも時系列的に処理されなくとも、並列的あるいは個別に実行される処理(例えば、並列処理あるいはオブジェクトによる処理)をも含むものである。

また、プログラムは、一つのコンピュータにより処理されるものであってもよいし、複数のコンピュータによって分散処理されるものであってもよい。さらに、プログラムは、遠方のコンピュータに転送されて実行されるものであってもよい。

以上に述べた実施の形態は、本発明を実施するための好適な形態の具体例であるから、技術的に好ましい種々の限定が付されている。ただし、本発明は、以上の実施の形態の説明において特に本発明を限定する旨の記載がない限り、これらの実施の形態に限られるものではない。したがって、例えば、以上の説明で挙げた処理時間、処理順序および各パラメータの数値的条件等は好適例に過ぎず、また、説明に用いた各図における寸法、形状および配置関係等も実施の形態の一例を示す概略的なものである。したがって、本発明は、上述した実施の形態の例に限定されるものではなく、本発明の要旨を逸脱しない範囲において、種々の変形、変更が可能である。

20…植生生育状況解析装置、21…I/F部、22…撮影決定部、23A…生育カレンダDB、23B…撮影計画DB、24…レーダ画像保持部、25…位置合わせ処理部、26…地図DB、27…基準反射板の後方散乱係数処理部、28…後方散乱係数の判別処理部、29…地物の後方散乱係数処理部、30…後方散乱係数保持部、31…較正用後方散乱係数算出部、31A…後方散乱係数平滑処理部、31B…後方散乱係数局所最小値算出部、32…較正線算出部、33…較正線による後方散乱係数較正部、34…生育値算出部、35…生育モデルDB、36…圃場集約算出部、36A…圃場代表値算出部、36B…圃場代表値差分算出部、36C…生育判定部、37…圃場地図DB、38…出力部

Claims (11)

- 飛翔体に搭載されたレーダ装置で複数の時期に撮影された、同一対象エリアの地表面のレーダ画像を取得する取得ステップと、

前記取得ステップで取得された複数のレーダ画像を地図データベースに保存するレーダ画像保持ステップと、

所定時期に撮影されたレーダ画像を基準画像として、他の時期に撮影されたレーダ画像の位置合わせを行う位置合わせ処理ステップと、

前記レーダ画像の特定領域の後方散乱係数を抽出する後方散乱係数処理ステップと、

前記地図データベースに保存された複数のレーダ画像のうち、前記基準画像の特定領域の後方散乱係数を基に、他のレーダ画像の後方散乱係数を較正する較正ステップと、

レーダ画像の後方散乱係数と植生の生育値の相関関係に基づいて、前記較正ステップにより較正されたレーダ画像の後方散乱係数から当該レーダ画像に写っている植生の生育値を算出する生育値算出ステップと、

を含む植生生育状況解析方法。 - 前記較正ステップは、

前記地図データベースに保存された複数のレーダ画像のうち、前記基準画像の特定領域の後方散乱係数と前記基準画像の特定領域に対応する他のレーダ画像の特定領域の後方散乱係数から、他のレーダ画像の後方散乱係数を較正するための較正線を算出する較正線算出ステップと、

前記較正線算出ステップにより算出された較正線に基づいて、他のレーダ画像の後方散乱係数を較正する後方散乱係数較正ステップと、をさらに含む

請求項1に記載の植生生育状況解析方法。 - 前記後方散乱係数処理ステップでは、時期による後方散乱係数の変動の少ない低変動領域をレーダ画像から抽出し、

前記較正線算出ステップでは、前記基準画像の低変動領域の後方散乱係数と、前記基準画像の低変動領域に対応する他のレーダ画像の特定領域の後方散乱係数から較正線を算出する

請求項2に記載の植生生育状況解析方法。 - 前記対象エリアの地表面の所定位置に基準反射板が設けられ、

前記後方散乱係数処理ステップでは、前記レーダ画像に写る基準反射板の後方散乱係数を求め、

前記較正線算出ステップでは、前記基準画像に写る基準反射板の後方散乱係数と、前記基準画像に写る基準反射板に対応する他のレーダ画像に写る基準反射板の後方散乱係数から較正線を算出する

請求項2に記載の植生生育状況解析方法。 - 前記較正線算出ステップでは、前記基準画像の低変動領域の後方散乱係数および前記基準画像の低変動領域に対応する他のレーダ画像の特定領域の後方散乱係数、並びに、前記基準画像に写る基準反射板の後方散乱係数および前記基準画像に写る基準反射板に対応する前記他のレーダ画像に写る基準反射板の後方散乱係数から較正線を算出する

請求項2に記載の植生生育状況解析方法。 - 前記所定時期は前記複数の時期のうちの最初である

請求項1~5のいずれかに記載の植生生育状況解析方法。 - 前記後方散乱係数処理ステップにより求められた前記レーダ画像に写る基準反射板の後方散乱係数が飽和状況にあるか否かを判定し、前記後方散乱係数が飽和状況にある場合には前記後方散乱係数を前記較正線算出ステップによる較正線の算出に利用しないことを決定する判別処理ステップを、さらに含む

請求項4または5に記載の植生生育状況解析方法。 - 圃場地図を保存する圃場地図データベースと、

前記圃場地図データベースに保存された圃場地図を基に、圃場単位の生育値を算出する圃場集約算出ステップと、をさらに含む

請求項1に記載の植生生育状況解析方法。 - 前記植生の生育値は、水稲の被覆率である

請求項1に記載の植生生育状況解析方法。 - コンピュータを、

飛翔体に搭載されたレーダ装置で複数の時期に撮影された、同一対象エリアの地表面のレーダ画像を取得する取得手段と、

前記取得手段で取得された複数のレーダ画像を地図データベースに保存するレーダ画像保持手段と、

所定時期に撮影されたレーダ画像を基準画像として、他の時期に撮影されたレーダ画像の位置合わせを行う位置合わせ処理手段と、

前記レーダ画像の特定領域の後方散乱係数を抽出する後方散乱係数処理手段と、

前記地図データベースに保存された複数のレーダ画像のうち、前記基準画像の特定領域の後方散乱係数を基に、他のレーダ画像の後方散乱係数を較正する較正手段と、

レーダ画像の後方散乱係数と植生の生育値の相関関係に基づいて、前記較正手段により較正されたレーダ画像の後方散乱係数から当該レーダ画像に写る植生の生育値を算出する生育値算出手段

として機能させるためのプログラムを記録した記録媒体。 - 飛翔体に搭載されたレーダ装置で複数の時期に撮影された、同一対象エリアの地表面のレーダ画像を取得する取得部と、

前記取得部で取得された複数のレーダ画像を地図データベースに保存するレーダ画像保持部と、

所定時期に撮影されたレーダ画像を基準画像として、他の時期に撮影されたレーダ画像の位置合わせを行う位置合わせ処理部と、

前記レーダ画像の特定領域の後方散乱係数を抽出する後方散乱係数処理部と、

前記地図データベースに保存された複数のレーダ画像のうち、前記基準画像の特定領域の後方散乱係数を基に、他のレーダ画像の後方散乱係数を較正する較正部と、

レーダ画像の後方散乱係数と植生の生育値の相関関係に基づいて、前記較正部により較正されたレーダ画像の後方散乱係数から当該レーダ画像に写る植生の生育値を算出する生育値算出部と、

を備える植生生育状況解析装置。

Priority Applications (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| EP09826161.3A EP2351477B1 (en) | 2008-11-14 | 2009-11-13 | Vegetation growth condition analysis method, recording medium on which program is recorded, and vegetation growth condition analyzer |

| US13/129,245 US8478003B2 (en) | 2008-11-14 | 2009-11-13 | Vegetation growth condition analysis method, recording medium on which program is recorded, and vegetation growth condition analyzer |

| CN2009801457435A CN102215666B (zh) | 2008-11-14 | 2009-11-13 | 植被生长状况分析方法、记录有程序的记录介质和植被生长状况分析器 |

Applications Claiming Priority (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2008-292705 | 2008-11-14 | ||

| JP2008292705A JP5369282B2 (ja) | 2008-11-14 | 2008-11-14 | 植生生育状況解析方法、プログラムおよび植生生育状況解析装置 |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| WO2010055915A1 true WO2010055915A1 (ja) | 2010-05-20 |

Family

ID=42170045

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| PCT/JP2009/069370 WO2010055915A1 (ja) | 2008-11-14 | 2009-11-13 | 植生生育状況解析方法、プログラムを記録した記録媒体および植生生育状況解析装置 |

Country Status (5)

| Country | Link |

|---|---|

| US (1) | US8478003B2 (ja) |

| EP (1) | EP2351477B1 (ja) |

| JP (1) | JP5369282B2 (ja) |

| CN (1) | CN102215666B (ja) |

| WO (1) | WO2010055915A1 (ja) |

Cited By (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US20190179009A1 (en) * | 2017-12-08 | 2019-06-13 | International Business Machines Corporation | Crop classification and growth tracking with synthetic aperture radar |

| US10761185B2 (en) | 2015-02-18 | 2020-09-01 | Nec Corporation | Signal processing device, signal processing method, recording medium, target detection device, and target detection method |

| CN111860325A (zh) * | 2020-07-20 | 2020-10-30 | 河南大学 | 土壤水分反演方法、装置、计算机可读介质和电子设备 |

| CN113505635A (zh) * | 2021-05-24 | 2021-10-15 | 中国农业大学 | 基于光学和雷达的冬小麦与大蒜混种区识别方法及装置 |

| CN114332492A (zh) * | 2021-12-15 | 2022-04-12 | 南京林业大学 | 一种基于长时间序列的植被特征提取及选择方法 |

Families Citing this family (23)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| EP2980735A1 (en) * | 2009-07-31 | 2016-02-03 | Global Surface Intelligence Ltd | Greenhouse gas grid and tracking system |

| US8493262B2 (en) * | 2011-02-11 | 2013-07-23 | Mitsubishi Electric Research Laboratories, Inc. | Synthetic aperture radar image formation system and method |

| JP5771430B2 (ja) * | 2011-04-08 | 2015-08-26 | オリンパス株式会社 | 霞除去画像処理装置、霞除去画像処理方法及び霞除去画像処理プログラム |

| JP5795932B2 (ja) * | 2011-10-07 | 2015-10-14 | 株式会社日立製作所 | 土地状態推定方法 |

| EP2871609B1 (en) * | 2012-07-04 | 2021-09-01 | Sony Group Corporation | Device and method for supporting farm works, program, recording medium and system for supporting farm works |

| JP5904044B2 (ja) * | 2012-07-18 | 2016-04-13 | 富士通株式会社 | 農作物の状態変化日特定方法、装置及びプログラム |

| JP5935654B2 (ja) * | 2012-10-22 | 2016-06-15 | 富士通株式会社 | 作物推定方法,作物推定プログラムおよび作物推定装置 |

| JP6292772B2 (ja) * | 2013-06-05 | 2018-03-14 | 三菱電機株式会社 | レーダ画像処理装置及びレーダ画像処理方法 |

| CN103679202B (zh) * | 2013-12-17 | 2017-04-12 | 中国测绘科学研究院 | 一种适用于光学遥感卫星影像植被分类方法及装置 |

| JP6314101B2 (ja) * | 2015-02-26 | 2018-04-18 | 株式会社パスコ | 地上設置型合成開口レーダーを用いた植生域に対応した地盤変位計測方法 |

| FR3035722B1 (fr) * | 2015-04-30 | 2020-05-15 | Ovalie Innovation | Systeme et procede d'estimation du rendement d'une parcelle cultivee |

| US10664750B2 (en) | 2016-08-10 | 2020-05-26 | Google Llc | Deep machine learning to predict and prevent adverse conditions at structural assets |

| CN106331493B (zh) * | 2016-08-30 | 2020-04-10 | 深圳春沐源控股有限公司 | 一种种植相册生成方法及装置 |

| WO2019003400A1 (ja) | 2017-06-29 | 2019-01-03 | 日本電気株式会社 | 係数算出装置、係数算出方法、及び、係数算出プログラムが記録された記録媒体 |

| US11432470B2 (en) | 2017-12-01 | 2022-09-06 | Sony Group Corporation | Information processing apparatus, information processing method, and vegetation management system |

| WO2019130568A1 (ja) * | 2017-12-28 | 2019-07-04 | スカパーJsat株式会社 | 評価情報生成システム、評価情報生成方法、およびプログラム |

| KR102300969B1 (ko) * | 2018-11-19 | 2021-09-10 | 한화시스템 주식회사 | 모의 식생 환경에 대한 산란계수 생성 방법 및 시스템 |

| KR102315392B1 (ko) * | 2018-11-19 | 2021-10-21 | 한화시스템 주식회사 | 모의 식생 환경에 대한 산란계수 생성 시스템 |

| CN109948596B (zh) * | 2019-04-26 | 2022-04-22 | 电子科技大学 | 一种基于植被指数模型进行水稻识别和种植面积提取的方法 |

| CN110378894B (zh) * | 2019-07-25 | 2021-08-13 | 内蒙古工业大学 | 基于相关性的TomoSAR植被病虫害监测方法及装置 |

| US20230169640A1 (en) * | 2020-02-06 | 2023-06-01 | Nileworks Inc. | Growth assessment system, growth assessment server and growth assessment method |

| CN111985433B (zh) * | 2020-08-28 | 2023-01-20 | 中国科学院地理科学与资源研究所 | 一种水稻遥感信息提取方法和系统 |

| KR102671005B1 (ko) * | 2021-11-15 | 2024-06-03 | 주식회사 솔탑 | Sar 레이더의 영상 표출 장치 |

Citations (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2001045867A (ja) * | 1999-08-12 | 2001-02-20 | Satake Eng Co Ltd | 作物の診断方法 |

| JP2002171121A (ja) * | 2000-11-29 | 2002-06-14 | Communication Research Laboratory | 偏波選択性電波反射鏡 |

| JP2005189100A (ja) * | 2003-12-25 | 2005-07-14 | National Institute Of Information & Communication Technology | Sarによる植生被覆分類観測方法 |

| JP2008046107A (ja) * | 2006-07-21 | 2008-02-28 | Pasuko:Kk | レーダ画像処理装置及びレーダ画像処理方法 |

Family Cites Families (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US6683970B1 (en) * | 1999-08-10 | 2004-01-27 | Satake Corporation | Method of diagnosing nutritious condition of crop in plant field |

| US6963662B1 (en) * | 2000-11-15 | 2005-11-08 | Sri International | Method and system for detecting changes in three dimensional shape |

| US7046841B1 (en) * | 2003-08-29 | 2006-05-16 | Aerotec, Llc | Method and system for direct classification from three dimensional digital imaging |

| US7705768B2 (en) * | 2007-05-07 | 2010-04-27 | Pasco Corporation | Radar image processor and method of radar image processing |

-

2008

- 2008-11-14 JP JP2008292705A patent/JP5369282B2/ja active Active

-

2009

- 2009-11-13 WO PCT/JP2009/069370 patent/WO2010055915A1/ja active Application Filing

- 2009-11-13 EP EP09826161.3A patent/EP2351477B1/en not_active Not-in-force

- 2009-11-13 US US13/129,245 patent/US8478003B2/en active Active

- 2009-11-13 CN CN2009801457435A patent/CN102215666B/zh not_active Expired - Fee Related

Patent Citations (4)

| Publication number | Priority date | Publication date | Assignee | Title |