KR20160143654A - 증강 현실 치과 디자인 방법 및 시스템 - Google Patents

증강 현실 치과 디자인 방법 및 시스템 Download PDFInfo

- Publication number

- KR20160143654A KR20160143654A KR1020167025734A KR20167025734A KR20160143654A KR 20160143654 A KR20160143654 A KR 20160143654A KR 1020167025734 A KR1020167025734 A KR 1020167025734A KR 20167025734 A KR20167025734 A KR 20167025734A KR 20160143654 A KR20160143654 A KR 20160143654A

- Authority

- KR

- South Korea

- Prior art keywords

- individual

- model

- dental appliance

- input

- feature

- Prior art date

Links

Images

Classifications

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61C—DENTISTRY; APPARATUS OR METHODS FOR ORAL OR DENTAL HYGIENE

- A61C13/00—Dental prostheses; Making same

- A61C13/0003—Making bridge-work, inlays, implants or the like

- A61C13/0004—Computer-assisted sizing or machining of dental prostheses

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61C—DENTISTRY; APPARATUS OR METHODS FOR ORAL OR DENTAL HYGIENE

- A61C13/00—Dental prostheses; Making same

- A61C13/34—Making or working of models, e.g. preliminary castings, trial dentures; Dowel pins [4]

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61C—DENTISTRY; APPARATUS OR METHODS FOR ORAL OR DENTAL HYGIENE

- A61C19/00—Dental auxiliary appliances

- A61C19/04—Measuring instruments specially adapted for dentistry

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61C—DENTISTRY; APPARATUS OR METHODS FOR ORAL OR DENTAL HYGIENE

- A61C9/00—Impression cups, i.e. impression trays; Impression methods

- A61C9/004—Means or methods for taking digitized impressions

- A61C9/0046—Data acquisition means or methods

- A61C9/0053—Optical means or methods, e.g. scanning the teeth by a laser or light beam

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61C—DENTISTRY; APPARATUS OR METHODS FOR ORAL OR DENTAL HYGIENE

- A61C9/00—Impression cups, i.e. impression trays; Impression methods

- A61C9/004—Means or methods for taking digitized impressions

- A61C9/0046—Data acquisition means or methods

- A61C9/0086—Acoustic means or methods

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/017—Head mounted

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

- G06F3/013—Eye tracking input arrangements

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

- G06F3/015—Input arrangements based on nervous system activity detection, e.g. brain waves [EEG] detection, electromyograms [EMG] detection, electrodermal response detection

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/017—Gesture based interaction, e.g. based on a set of recognized hand gestures

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T19/00—Manipulating 3D models or images for computer graphics

- G06T19/20—Editing of 3D images, e.g. changing shapes or colours, aligning objects or positioning parts

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/10—Human or animal bodies, e.g. vehicle occupants or pedestrians; Body parts, e.g. hands

- G06V40/16—Human faces, e.g. facial parts, sketches or expressions

- G06V40/161—Detection; Localisation; Normalisation

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/10—Human or animal bodies, e.g. vehicle occupants or pedestrians; Body parts, e.g. hands

- G06V40/16—Human faces, e.g. facial parts, sketches or expressions

- G06V40/168—Feature extraction; Face representation

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/10—Human or animal bodies, e.g. vehicle occupants or pedestrians; Body parts, e.g. hands

- G06V40/16—Human faces, e.g. facial parts, sketches or expressions

- G06V40/174—Facial expression recognition

- G06V40/176—Dynamic expression

-

- G—PHYSICS

- G16—INFORMATION AND COMMUNICATION TECHNOLOGY [ICT] SPECIALLY ADAPTED FOR SPECIFIC APPLICATION FIELDS

- G16H—HEALTHCARE INFORMATICS, i.e. INFORMATION AND COMMUNICATION TECHNOLOGY [ICT] SPECIALLY ADAPTED FOR THE HANDLING OR PROCESSING OF MEDICAL OR HEALTHCARE DATA

- G16H50/00—ICT specially adapted for medical diagnosis, medical simulation or medical data mining; ICT specially adapted for detecting, monitoring or modelling epidemics or pandemics

- G16H50/50—ICT specially adapted for medical diagnosis, medical simulation or medical data mining; ICT specially adapted for detecting, monitoring or modelling epidemics or pandemics for simulation or modelling of medical disorders

-

- G—PHYSICS

- G16—INFORMATION AND COMMUNICATION TECHNOLOGY [ICT] SPECIALLY ADAPTED FOR SPECIFIC APPLICATION FIELDS

- G16Z—INFORMATION AND COMMUNICATION TECHNOLOGY [ICT] SPECIALLY ADAPTED FOR SPECIFIC APPLICATION FIELDS, NOT OTHERWISE PROVIDED FOR

- G16Z99/00—Subject matter not provided for in other main groups of this subclass

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/0101—Head-up displays characterised by optical features

- G02B2027/0138—Head-up displays characterised by optical features comprising image capture systems, e.g. camera

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/0101—Head-up displays characterised by optical features

- G02B2027/014—Head-up displays characterised by optical features comprising information/image processing systems

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/0179—Display position adjusting means not related to the information to be displayed

- G02B2027/0187—Display position adjusting means not related to the information to be displayed slaved to motion of at least a part of the body of the user, e.g. head, eye

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/0093—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00 with means for monitoring data relating to the user, e.g. head-tracking, eye-tracking

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F30/00—Computer-aided design [CAD]

Landscapes

- Engineering & Computer Science (AREA)

- Health & Medical Sciences (AREA)

- Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- General Engineering & Computer Science (AREA)

- General Health & Medical Sciences (AREA)

- General Physics & Mathematics (AREA)

- Public Health (AREA)

- Oral & Maxillofacial Surgery (AREA)

- Life Sciences & Earth Sciences (AREA)

- Epidemiology (AREA)

- Human Computer Interaction (AREA)

- Dentistry (AREA)

- Animal Behavior & Ethology (AREA)

- Veterinary Medicine (AREA)

- Biomedical Technology (AREA)

- Optics & Photonics (AREA)

- Medical Informatics (AREA)

- Neurology (AREA)

- Biophysics (AREA)

- Acoustics & Sound (AREA)

- Dermatology (AREA)

- Neurosurgery (AREA)

- Multimedia (AREA)

- Databases & Information Systems (AREA)

- Primary Health Care (AREA)

- Pathology (AREA)

- Data Mining & Analysis (AREA)

- Architecture (AREA)

- Computer Graphics (AREA)

- Computer Hardware Design (AREA)

- Software Systems (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Dental Tools And Instruments Or Auxiliary Dental Instruments (AREA)

- Processing Or Creating Images (AREA)

- Dental Prosthetics (AREA)

- Testing, Inspecting, Measuring Of Stereoscopic Televisions And Televisions (AREA)

Abstract

개인을 위한 치과 기구를 디자인하기 위한 방법 및 시스템. 개인의 3D 특징들은 그들의 얼굴 및 3D 디스플레이 상에 디스플레이되는 궁(arches)의 일부를 포함한다. 3D 모델은 증강 현실 치과 기구를 포함한다. 3D 모델은 증강 현실 치과 기구를 포함한다. 3D 모델은 모션 센서, 뇌-컴퓨터 인터페이스, 둘 모두, 또는 다른 센서들에 의해 감지된 인풋들에 의해 처리될 수 있다. 제스쳐, 신경 활동, 다른 인풋들에 따라, 증강 현실 치과 기구 또는 3D 모델의 다른 실시예가 변형될 수 있다. 3D 모델은 변형된 치과 기구 또는 다른 변화들에 따라 업데이트되고, 업데이트된 3D 모델을 제공하기 위해 리포지셔닝 된다. 업데이트된 3D 모델은 3D 디스플레이 상에 디스플레이된다. 이 시스템 및 방법은 증강 현실 치과 기구의 변형 및 결과 에스테틱 효과들의 관찰을 용이하게 한다.

Description

본원 개시내용은 대부분 치과 기구들 또는 리스토레이션(restorations)과 연관된다.

본원은 2014년 2월 21일 출원된, 참조로 여기에 포함되는 US 가출원(No. 61/942,734) 및 2014년 11월 5일 US 가출원(No. 62/075,665)에 대해 우선권을 주장한다.

현재, 제안된 치과 기구들 또는 리스토레이션들은, 대상 개인의 구강 내에 리스토레이션의 리플리카(replica)에 시도하거나 치과 디자이너 소프트웨어 내에 대상의 2D 이미지들을 포함함으로써 시각화(visualized)된다. 실시예들은 틀니 디자인을 위한 Densply's TruRx 소프트웨어(US 출원 No. 2010/0076581도 참조할 것) 및 개인들의 치아 상에 이용하기 위한 3형태(shape)로부터 2D 이미지 어레인지먼트(US 출원 No. 2013/0218530 또한 참조할 것)을 포함한다.

Densply's TruRx 방법은 대상의 디지털 모델링을 위한 상업적으로-가능한 솔루션이다. 이 방법은, 상기 대상 개인의 상기 얼굴 상에 참조 표시(indicia)를 위치시키는 단계 및 상기 대상의 얼굴의 다음 디지털 포토그래프 내에 공백(voided) 구역을 생성함으로써, 대상 개인의 치아의 적어도 일부의 커버를 커버하기 위해 구강 쉴드(shield)를 포지셔닝하는 단계를 포함한다. 상기 소프트웨어는 상기 대상 개인의 얼굴의 차원(dimensions)을 비교하기 위해 포토그래프 내에 상기 참조 표시를 이용한다. 상기 공백 구역은, 의사 (practitioner) 또는 상기 대상 개인이, 상기 대상 개인이 상기 선택된 컴비네이션처럼 보이는 상기 결과를 볼 수 있도록 상기 소프트웨어 내에서 확인(identified)되고, 상기 틀니를 만들기 위해 선택된 물질들 및 구조들은 상기 디지털 이미지의 상기 공백 구역에 겹쳐진다(superimposed).

첫 번째 실시예에 있어서, 상기 개시내용은 대상 개인을 위한 치과 기구를 디자인하는 방법 및 시스템을 제공한다. 상기 대상 개인의 특징들의 3D 모델은 3D 디스플레이 상에 디스플레이 되는 그들의 얼굴 및 궁(arches)의 일부를 포함한다. 상기 3D 모델은 증강 현실 치과 기구를 포함한다. 상기 3D 모델은 모션 센서, 뇌-컴퓨터 인터페이스, 그 둘 모두, 또는 다른 센서들에 의해 감지되는 인풋들에 의해 처리될 수 있다. 제스쳐들에 따라, 신경 활동, 또는 다른 인풋들, 증강 현실 치과 기구 또는 상기 3D 모델의 다른 실시예들은 변형될 수 있다. 상기 3D 모델은 상기 변형된 치과 기구 또는 다른 변화들에 따라 업데이트되고, 업데이트된 3D 모델을 제공하기 위해 리포지셔닝된다. 상기 업데이트 된 3D 모델은 상기 3D 디스플레이 상에 디스플레이 된다. 이 시스템 및 방법은 상기 증강 현실 치과 기구의 변형 및 에스테틱 효과들의 관찰 (observation)을 용이하게 한다.

다른 실시예에 있어서, 본원 개시내용은 대상 개인을 위한 치과 기구를 디자인하는 단계 - 상기 방법은 3D 디스플레이 상에 상기 대상 개인의 3D 모델을 디스플레이하는 것을 포함함 -; 상기 3D 모델은 상기 대상 개인의 치열 궁을 포함하는 스캔 특징을 포함하며, 상기 대상 개인의 얼굴의 일부 및 상기 궁을 상기 얼굴과 연관시키기 위한 궁; 증강 현실 특징은 상기 대상 개인을 위한 치과 기구를 포함함; 센서로 인풋을 감지하는 단계; 변형된 치과 기구를 제공하기 위한 인풋에 따라 상기 치과 기구를 변형하는 단계; 리포지션 스캔 특징을 제공하기 위해 상기 변형된 치과 기구에 따라 상기 스캔 특징을 리포지셔닝하는 단계; 상기 변형된 치과 기구 및 업데이트된 3D 모델을 제공하기 위한 리포지션 스캔 특징에 따라 상기 3D 모델을 업데이트 하는 단계 및 상기 3D 디스플레이 상에 상기 업데이트된 3D 모델을 디스플레이하는 단계를 포함하는 방법을 제공한다.

일실시예에 있어서, 상기 인풋은 자발적 인풋을 포함한다.

일실시예에 있어서, 상기 자발적 인풋은 제스쳐-기반 인풋을 포함한다.

일실시예에 있어서, 상기 제스쳐-기반 인풋은 상기 3D 디스플레이 상에 상기 3D 모델의 특징을 그리핑(gripping)하는 것과 상기 특징을 처리하는 것을 포함한다.

일실시예에 있어서, 상기 특징을 그리핑하는 것은 상기 특징을 손으로 그리핑하는 것을 포함한다.

일실시예에 있어서, 상기 특징은 상기 치과 기구의 치열을 포함한다.

일실시예에 있어서, 상기 특징을 처리하는 것은 상기 치열의 앵귤레이션을 변화시키는 것을 포함한다.

일실시예에 있어서, 상기 제스쳐-기반 인풋은 상기 대상 개인으로부터 비롯된다.

일실시예에 있어서, 상기 제스쳐-기반 인풋은 비(non)대상 개인으로부터 비롯된다.

일실시예에 있어서, 상기 인풋은 자발적 인풋을 포함한다.

일실시예에 있어서, 상기 자발적 인풋은 제스쳐-기반 인풋을 포함한다.

일실시예에 있어서, 상기 센서는 모니터 센서를 포함한다.

일실시예에 있어서, 상기 비자발적 인풋은 신경 활동 인풋을 포함하고, 상기 센서는 뇌-컴퓨터 인터페이스를 포함한다.

일실시예에 있어서, 상기 신경 활동 인풋은 상기 변형된 치과 기구의 개념화(conceptualization)를 포함한다.

일실시예에 있어서, 상기 신경 활동 인풋은 상기 치과 기구를 변형하는 개념화를 포함한다.

일실시예에 있어서 상기 치과 기구를 변형하는 개념화는 상기 디스플레이 상에 손으로 상기 3D 모델의 특징을 그리핑(gripping)하는 것과 상기 특징을 처리하는 개념화를 포함한다.

일실시예에 있어서, 상기 특징은 상기 치과 기구의 치열을 포함한다.

일실시예에 있어서, 상기 특징을 처리하는 단계는 상기 치열의 앵귤레이션을 변화하는 단계를 포함한다.

일실시예에 있어서, 상기 비자발적 인풋은 제스쳐-기반 인풋을 포함하고, 상기 센서는 모션 센서를 포함한다.

일실시예에 있어서, 상기 비자발적 인풋은 신경 활동 인풋을 포함하고, 상기 센서는 뇌-컴퓨터 인터페이스를 포함한다.

일실시예에 있어서, 상기 신경 활동 인풋은 상기 대상 개인으로부터의 신경 활동 인풋을 포함한다.

일실시예에 있어서, 상기 신경 활동 인풋은 비대상 개인으로부터의 신경 활동 인풋을 포함한다.

일실시예에 있어서, 상기 인풋은 상기 스캔 특징의 적어도 일부를 타겟 포지션에 대해 컨스트레이닝하는 것을 포함하고, 상기 변형된 치과 기구는 상기 타겟 포지션을 용이하게 하는 변형된 특징을 포함한다.

일실시예에 있어서, 상기 타겟 포지션은 선택된 막실로만디불라 관계를 포함한다.

일실시예에 있어서, 상기 선택된 막실로만디불라 관계는 정지 포지션에 있고, 상기 치열은 상기 정지 포지션에서 1 내지 4 미리미터의 자유공간을 제공한다.

일실시예에 있어서, 상기 선택된 막실로만디불라 관계는 선택된 교합 포지션에 있고, 상기 치열은 상기 선택된 막실로만디불라 관계에서 교합을 제공한다.

일실시예에 있어서, 상기 변형된 특징은 상기 치과 기구의 치열을 포함한다.

일실시예에 있어서, 상기 방법은 상기 센서로 비자발적 인풋을 감지하는 단계, 상기 변형된 치과 기구를 제공하기 위해 상기 비자발적 인풋에 따라 상기 치과 기구를 변형하는 단계, 상기 리포지션 스캔 특징을 제공하기 위해 상기 변형된 치과 기구에 따라 상기 스캔 특징을 리포지셔닝하는 단계, 상기 변형된 치과 기구 및 상기 업데이트된 3D 모델을 제공하기 위해 상기 리포지션 스캔 특징에 따라 상기 3D 모델을 업데이트하는 단계 및 상기 3D 디스플레이 상에 상기 업데이트된 3D 모델을 디스플레이하는 단계를 포함한다.

일실시예에 있어서, 상기 비자발적 인풋은 상기 대상 개인으로부터의 비자발적 인풋을 포함한다.

일실시예에 있어서, 상기 비자발적 인풋은 비-대상 개인으로부터의 비자발적 인풋을 포함한다.

일실시예에 있어서, 상기 비자발적 인풋은 신경 활동 인풋을 포함하고, 상기 센서는 뇌-컴퓨터 인터페이스를 포함한다.

일실시예에 있어서, 상기 비자발적 인풋은 얼굴 표정 변화를 포함하고, 상기 센서는 광학 센서를 포함한다.

일실시예에 있어서, 상기 방법은 상기 센서로 비자발적 인풋을 감지하는 단계, 상기 비자발적 인풋을 선호 기준(preference criterion) 및 상기 개인의 선호를 결정하기 위해 상기 변형된 치과 기구와 상호 연관(correlating)시키는 단계, 상기 개인의 상기 선호와 연관된 제안된(suggested) 치과 기구를 제공하기 위해 상기 변형된 치과 기구를 변형하는 단계, 제안된 스캔 특징을 제공하기 위해 상기 제안된 치과 기구에 따라 상기 스캔 특징을 리포지셔닝하는 단계, 상기 제안된 치과 기구 및 제안된 3D 모델을 제공하기 위해 제안된 스캔 특징에 따라 상기 3D 모델을 업데이트하는 단계 및 상기 3D 디스플레이 상에 상기 제안된 3D 모델을 디스플레이하는 단계를 포함한다.

일실시예에 있어서, 상기 선호 기준은 개인의 감정 상태를 포함한다.

일실시예에 있어서, 상기 선호 기준은 개인의 자발적 인풋을 포함한다.

일실시예에 있어서, 상기 비자발적 인풋은 상기 대상 개인으로부터의 비자발적 인풋을 포함한다.

일실시예에 있어서, 비자발적 인풋은 비-대상 개인으로부터의 비자발적 인풋을 포함한다.

일실시예에 있어서, 상기 비자발적 인풋은 신경 활동 인풋을 포함하고 상기 센서는 뇌-컴퓨터 인터페이스를 포함한다.

일실시예에 있어서, 상기 비자발적 인풋은 얼굴 표정을 포함하고 상기 센서는 광학 센서를 포함한다.

일실시예에 있어서, 상기 비자발적 인풋은 상기 업데이트된 3D 모델에 따른 것이다.

일실시예에 있어서, 상기 3D 모델은 저장된 포지션을 포함하고, 상기 저장된 포지션은 상기 얼굴의 선택된 스캔 특징을 포함한다.

일실시예에 있어서, 상기 방법은 상기 스캔 특징을 상기 저장된 포지션에 리포지셔닝하는 단계, 상기 저장된 포지션 및 저장된 포지션 3D 모델을 제공하기 위한 리포지셔닝된 스캔 특징에 따라 상기 3D 모델을 업데이트하는 단계 및 상기 3D 디스플레이 상에 상기 저장된 포지션을 디스플레이하는 단계를 포함한다.

일실시예에 있어서, 상기 스캔 특징은 상기 3D 모델 내의 상기 얼굴 상의 추가적인 디테일에 대한 상기 얼굴의 외부 특징 데이터를 포함한다.

일실시예에 있어서, 상기 대상 개인의 얼굴의 외부 특징 데이터는 상기 3D 모델 내의 대상 개인의 전체 얼굴을 실질적으로 포함한다.

일실시예에 있어서, 상기 방법은 상기 스캔 특징의 데이터를 획득하는 단계를 포함한다.

일실시예에 있어서,상기 스캔 특징의 데이터를 획득하는 단계는 상기 스캔 특징을 광학적으로 스캔하는 단계를 포함한다.

일실시예에 있어서, 상기 스캔 특징의 데이터를 획득하는 단계는, 초음파 검사(ultrasonographically)로 상기 스캔 특징을 스캔하는 단계를 포함한다.

일실시예에 있어서, 상기 스캔 특징의 데이터를 획득하는 단계는, 상기 인풋에 따라 상기 스캔 특징의 추가적인 데이터를 획득하는 단계 및 상기 추가적인 데이터를 포함하기 위해 상기 3D 모델을 업데이트하는 단계를 포함한다.

일실시예에 있어서, 상기 추가적인 데이터를 획득하는 단계 및 상기 추가적인 데이터를 포함하기 위해 상기 3D 모델을 업데이트하는 단계는 각각 연속적이고 실질적으로 실시간으로 수행된다.

일실시예에 있어서, 상기 대상 개인에 의한 얼굴 표정의 채택(adoption)은 상기 추가적인 데이터를 포함하기 위해 상기 3D 모델을 업데이트하도록 하고, 상기 추가적인 데이터는 상기 얼굴 표정을 채택하는 개인의 외부 특징 데이터를 포함한다.

일실시예에 있어서, 상기 인풋은 신경 활동 인풋을 포함하고, 상기 센서는 뇌-컴퓨터 인터페이스를 포함한다.

상기 스캔 특징들의 데이터를 획득하는 단계는, 상기 대상 개인이 정지 포지션에 대응되는 막실로만디불라 관계에 있는지 확인하는 단계 및 상기 막실로만디불라 관계가 상기 정지 포지션인 경우, 상기 얼굴의 데이터를 획득하는 단계를 포함한다.

일실시예에 있어서, 상기 대상 개인이 상기 정지 포지션과 대응되는 막실로만디불라 관계에 있는지 확인하는 단계는, 최소 에너지 이용을 갖는 막실로만디불라 관계를 확인하기 위해 상기 대상 개인의 턱 근육 확동을 측정하는 단계를 포함한다.

일실시예에 있어서, 상기 턱 근육 활동을 측정하는 단계는, 상기 대상 개인에 대해 근전도검사를 적용하는 단계를 포함한다.

일실시예에 있어서, 상기 대상 개인이 상기 정지 포지션과 대응되는 막실로만디불라 관계에 있는 것을 확인하는 단계는 상기 대상 개인의 턱 근육들을 이그조스팅시키는 단계를 포함한다.

일실시예에 있어서, 상기 대상 개인의 턱 근육들을 이그조스팅 시키는 단계는, 상기 턱 근육들에 경피성 전자 신경 자극을 적용하는 단계를 포함한다.

일실시예에 있어서, 상기 막실로만디불라 관계가 상기 정지 포지션에 있는 경우, 상기 3D 모델을 디스플레이하기 위한 상기 데이터는 상기 얼굴의 데이터를 포함한다.

다른 실시예에 있어서, 본원 개시내용은, 3D 모델을 저장하기 위한 컴퓨터로 읽을 수 있는 매체 - 상기 3D 모델은 상기 개인의 치열 궁, 상기 대상 개인의 얼굴의 일부 및 상기 궁을 상기 얼굴과 연관시키기 위한 상기 궁을 포함하는 스캔 특징 및 상기 대상 개인을 위한 치과 기구를 포함하는 증강 현실 특징을 포함함 -, 상기 3D 모델을 디스플레이 하기 위한 3D 디스플레이, 인풋을 감지하는 센서 및 상기 3D 모델을 프로세싱하기 위한 컴퓨터로 읽을 수 있는 매체, 상기 인풋을 수신하기 위한 상기 센서, 및 상기 3D 모델을 디스플레이 하기 위한 상기 3D 디스플레이와 연결되는 프로세서를 포함하는 대상 개인을 위한 치과 기구를 디자인하기 위한 시스템을 제공하고, 상기 프로세서는, 변형된 치과 기구를 제공하기 위해 상기 인풋에 따라 상기 치과 기구를 변형하고, 리포지션 스캔 특징을 제공하기 위해 상기 변형된 치과 기구에 따라 상기 스캔 특징을 리포지셔닝하며, 상기 변형된 치과 기구 및 업데이트 된 3D 모델을 제공하기 위해 상기 리포지션 스캔 특징에 따라 상기 3D 모델을 업데이트하고, 상기 3D 디스플레이 상에 상기 업데이트된 3D 모델을 디스플레이하도록 구성되고 적응된다.

일실시예에 있어서, 상기 센서는 3D 모델 상에 제스쳐-기반 인풋을 감지하기 위한 모션 센서를 포함한다.

일실시예에 있어서, 상기 센서는 상기 3D 모델 상에 신경 활동-기반 인풋을 감지하기 위한 뇌-컴퓨터 인터페이스를 포함한다.

일실시예에 있어서, 상기 센서는 제1 개인으로부터의 인풋을 위한 제1 인풋 포인트 및 제2 개인으로부터의 인풋을 위한 제2 인풋 포인트를 포함한다.

일실시예에 있어서, 상기 센서는 제스쳐-기반 인풋, 얼굴-표정-기반 인풋 또는 안구 확장-기반 인풋 중 하나를 감지하기 위한 광학 센서를 포함한다.

일실시예에 있어서, 상기 시스템은 상기 스캔 특징의 데이터를 획득하기 위한 컴퓨터로 읽을 수 있는 상기 매체와 통신하는 스캐너를 더 포함한다.

상기 스캐너는 치열 궁의 데이터를 획득하기 위한 내부-구강 스캐너를 포함한다.

일실시예에 있어서, 상기 스캐너는 상기 대상 개인의 상기 얼굴의 일부의 데이터를 획득하기 위한 외부 구강 스캐너를 포함한다.

일실시예에 있어서, 상기 스캐너는 광학 스캐너를 포함한다.

일실시예에 있어서, 상기 스캐너는 초음파 스캐너를 포함한다.

일실시예에 있어서, 상기 시스템은 상기 개인의 턱의 근육 활동을 측정하기 위한 근육 활동 센서를 포함한다.

일실시예에 있어서, 상기 근육 활동 센서는 근전도 검사 모듈을 포함한다.

일실시예에 있어서, 상기 프로세서는 상기 스캐너가 상기 스캔 특징을 모델링하기 위한 데이터를 획득하도록 하기 위해 상기 스캐너와 통신하고, 상기 근육활동 센서는, 상기 근육 활동이 선택된 값일 경우, 상기 스캔 특징을 모델링하기 위한 데이터를 획득하기 위해, 상기 스캐너를 다이렉팅(directing)하기 위한 프로세서와 통신한다.

일실시예에 있어서, 상기 선택된 값은 정지 포지션을 의미한다.

다른 실시예에 있어서, 본원 개시내용은 대상 개인을 위한 치과 기구를 디자인하는 방법을 제공하고, 상기 방법은 3D 디스플레이 상에 3D 모델을 디스플레이 - 상기 3D 모델은, 상기 3D 모델/은 상기 대상 개인의 치열 궁, 상기 대상 개인의 얼굴의 일부 및 상기 궁을 상기 얼굴과 연관시키기 위한 상기 궁을 포함하는 스캔 특징 및 상기 대상 개인을 위한 치과 기구를 포함하는 증강 현실 특징을 포함함 - 하는 단계, 모션 센서로 인풋을 감지하는 단계, 변형된 치과 기구를 제공하기 위한 제스쳐-기반 인풋에 따라 치과 기구를 변형하는 단계,

상기 변형된 치과 기구에 따라 상기 스캔 특징을 리포지셔닝하는 단계 및 상기 변형된 치과 기구 및 업데이트된 3D 모델을 제공하기 위해 상기 리포지셔닝된 스캔 특징에 따라 상기 3D 모델을 업데이트하는 단계를 포함한다.

일실시예에 있어서 상기 인풋은 제스쳐-기반 인풋을 포함한다.

다른 실시예에 있어서, 본원 개시내용은 대상 개인을 위한 치과 기구를 디자인하는 방법을 제공하고, 상기 방법은 3D 디스플레이 상에 3D 모델을 디스플레이 - 상기 3D 모델은, 상기 3D 모델/은 상기 대상 개인의 치열 궁, 상기 대상 개인의 얼굴의 일부 및 상기 궁을 상기 얼굴과 연관시키기 위한 상기 궁을 포함하는 스캔 특징 및 상기 대상 개인을 위한 치과 기구를 포함하는 증강 현실 특징을 포함함 - 하는 단계, 모션 센서로 인풋을 감지하는 단계, 변형된 치과 기구를 제공하기 위한 제스쳐-기반 인풋에 따라 치과 기구를 변형하는 단계,

상기 변형된 치과 기구에 따라 상기 스캔 특징을 리포지셔닝하는 단계 및 상기 변형된 치과 기구 및 업데이트된 3D 모델을 제공하기 위해 상기 리포지셔닝된 스캔 특징에 따라 상기 3D 모델을 업데이트하는 단계를 포함한다.

일실시예에 있어서 상기 인풋은 제스쳐-기반 인풋을 포함한다.

일실시예에 있어서, 상기 인풋을 감지하는 단계는 눈 이동들을 추적하는 단계를 포함한다.

일실시예에 있어서, 상기 인풋은 얼굴 표정을 포함한다.

다른 실시예에 있어서, 본원 개시내용은 대상 개인을 위한 치과 기구를 디자인하는 방법을 제공하고, 상기 방법은 3D 디스플레이 상에 3D 모델을 디스플레이, 상기 3D 모델은, 상기 대상 개인의 치열 궁, 상기 대상 개인의 얼굴의 일부 및 상기 궁을 상기 얼굴과 연관시키기 위한 상기 궁을 포함하는 스캔 특징 및 상기 대상 개인을 위한 치과 기구를 포함하는 증강 현실 특징을 포함한 - 하는 단계, 뇌-컴퓨터 인터페이스로 인풋을 감지하는 단계, 변형된 치과 기구를 제공하기 위해 신경 활동-기반 인풋에 따라 치과 기구를 변형하는 단계, 상기 변형된 치과 기구에 따라 상기 스캔 특징을 리포지셔닝하는 단계 및 상기 변형된 치과 기구 및 업데이트된 3D 모델을 제공하기 위해 상기 리포지셔닝된 스캔 특징에 따라 상기 3D 모델을 업데이트하는 단계를 포함한다.

다른 실시예에 있어서, 본원 개시내용은 대상 개인을 위한 치과 기구를 디자인하기 위한 시스템을 제공하고, 상기 시스템은, 3D 모델이 저장된 컴퓨터로 읽을 수 있는 매체 - 상기 3D 모델은 상기 대상 개인의 치열 궁, 상개 대상 개인의 얼굴의 일부 및 상기 얼굴과 연관시키기 위한 상기 궁을 포함하는 스캔 특징 및, 상기 대상 개인을 위한 치과 기구를 포함하는 증강 현실 특징을 포함함 - , 상기 3D 모델을 디스플레이 하기 위한 3D 디스플레이, 상기 3D 모델 상에서 인풋을 감지하기 위한 모션 센서 및 상기 3D 모델을 처리하기 위한 컴퓨터로 읽을 수 있는 상기 매체, 상기 제스쳐-기반 인풋을 수신하기 위한 모션 센서, 및 상기 3D 모델을 디스플레이 하기 위해 3D 디스플레이와 연결되는 프로세서를 포함하고, 상기 프로세서는, 변형된 치과 기구를 제공하기 위해 제스쳐-기반 인풋에 따라 치과 기구를 변형하고, 리포지션 스캔 특징을 제공하기 위해 상기 변형된 치과 기구에 따라 상기 스캔 특징을 리포지셔닝하며, 상기 변형된 치과 기구 및 업데이트된 3D 모델을 제공하도록 상기 리포지션 스캔 특징에 따라 상기 3D 모델을 업데이트하고, 상기 3D 디스플레이 상에 상기 업데이트된 3D 모델을 디스플레이한다.

다른 실시예에 있어서, 본원 개시내용은 대상 개인을 위한 치과 기구를 디자인하는 시스템을 제공하고, 상기 시스템은, 3D 모델이 저장된 컴퓨터로 읽을 수 있는 매체 - 상기 3D 모델은 상기 대상 개인의 치열 궁, 상기 대상 개인의 얼굴의 일부 및 상기 얼굴과 연관시키기 위한 상기 궁을 포함하는 스캔 특징 및, 상기 대상 개인을 위한 치과 기구를 포함하는 증강 현실 특징을 포함함 -, 상기 3D 모델을 디스플레이 하기 위한 3D 디스플레이, 상기 3D 모델 상에 신경 활동-기반 인풋을 감지하기 위한 뇌-컴퓨터 인터페이스 및 상기 3D 모델을 프로세싱 하기 위한 컴퓨터로 읽을 수 있는 상기 매체, 상기 신경 활동-기반 인풋을 수신하기 위한 상기 뇌-컴퓨터 인터페이스, 및 상기 3D 모델을 디스플레이 하기 위한 상기 3D 디스플레이와 연결되는 프로세서를 포함하고, 상기 프로세서는 변형된 치과 기구를 제공하기 위해 제스쳐-기반 인풋에 따라 치과 기구를 변형하고, 리포지션 스캔 특징을 제공하기 위해 상기 변형된 치과 기구에 따라 상기 스캔 특징을 리포지셔닝 하며, 사익 변형된 치과 기구 및 업데이트된 3D 모델을 제공하도록 상기 리포지션 스캔 특징에 따라 상기 3D 모델을 업데이트하고, 상기 3D 디스플레이 상에 상기 업데이트된 3D 모델을 디스플레이한다.

다른 실시예에 있어서, 본원 개시내용은 인스트럭션들이 저장된 컴퓨터로 읽을 수 있는 매체를 포함하고, 상기 인스트럭션들은, 스캔 특징 및 증강 현실 특징을 포함하는 3D 모델, 대상 개인의 치열 궁(dental arch) 및 상기 대상 개인의 얼굴의 일부 및 상기 궁(arch)을 상기 얼굴과 연관시키기 위한 상기 궁을 포함하는 상기 스캔 특징 및 상기 대상 개인을 위한 치과 기구를 포함하는 상기 증강 현실 특징을 렌더링하는 단계, 센서로부터 인풋을 감지하는 단계, 변형된 치과 기구를 제공하기 위해 상기 인풋에 따라 상기 치과 기구를 변형시키는 단계, 리포지션 스캔 특징을 제공하기 위해 상기 변형된 치과 기구에 따라 상기 스캔 특징을 리포지셔닝하는 단계, 상기 변형된 치과 기구 및 업데이트된 3D 모델을 제공하도록 상기 리포지션 스캔 특징에 따라 상기 3D 모델을 업데이트하는 단계 및 3D 디스플레이 상에 상기 업데이트된 3D 모델을 디스플레이하는 단계를 포함한다.

일실시예에 있어서, 상기 인풋은 자발적 인풋을 포함한다.

일실시예에 있어서, 상기 자발적 인풋은 제스쳐-기반 인풋을 포함한다.

일실시예에 있어서, 상기 제스쳐-기반 인풋은 상기 3D 디스플레이 상에 상기 3D 모델의 특징을 그리핑하는 것과 상기 특징을 처리하는 것을 포함한다.

일실시예에 있어서, 상기 특징을 그리핑하는 단계는 손으로 상기 특징을 그리핑하는 단계를 포함한다.

일실시예에 있어서, 상기 특징을 처리하는 단계는 상기 치열의 앵귤레이션을 변화하는 단계를 포함한다.

일실시예에 있어서, 상기 제스쳐-기반 인풋은 제1 개인으로부터 비롯된다.

일실시예에 있어서, 상기 제스쳐-기반 인풋은 제1 개인 및 제2 개인으로부터 비롯된다.

일실시예에 있어서, 상기 센서는 모션 센서를 포함한다.

일실시예에 있어서, 상기 자발적 인풋은 신경 활동 인풋을 포함하고, 상기 센서는 뇌-컴퓨터 인터페이스를 포함한다.

일실시예에 있어서, 상기 신경 활동 인풋은 상기 변형된 치과 기구의 개념화를 포함한다.

일실시예에 있어서, 상기 신경 활동 인풋은 상기 치과 기구를 변형시키는 개념화를 포함한다.

일실시예에 있어서, 상기 치과 기구를 변형시키는 개념화는 상기 디스플레이 상에 손으로 상기 3D 모델의 특징을 그리핑하는 것과 상기 특징을 처리하는 것을 포함한다.

일실시예에 있어서, 상기 특징은 상기 치과 기구의 치열을 포함한다.

일실시예에 있어서, 상기 특징을 처리하는 단계는 상기 치열의 앵귤레이션을 변화시키는 것을 포함한다.

일실시예에 있어서, 상기 자발적 인풋은 제스쳐-기반 인풋을 포함하고, 상기 센서는 모션 센서를 포함한다.

일실시예에 있어서, 상기 신경 활동 인풋은 제1 개인으로부터의 신경 활동 인풋을 포함한다.

일실시예에 있어서, 상기 신경 활동 인풋은 제1 개인 및 제2 개인으로부터의 신경 활동 인풋을 포함한다.

일실시예에 있어서, 상기 인풋은 상기 스캔 특징의 적어도 일부를 타겟 포지션에 대해 컨스트레이닝(constraining) 하는 것을 포함하고, 상기 변형된 치과 기구는 상기 타겟 포지션을 용이하게 하는 변형된 특징을 포함한다.

일실시예에 있어서, 상기 타겟 포지션은 선택된 막실로만디불라 관계를 포함한다.

일실시예에 있어서, 상기 선택된 막실로만디불라 관계는 정지(rest) 포지션에 있고, 상기 치열은 상기 정지 포지션에서 1 내지 4 미리미터(mm)의 자유 공간을 제공한다.

일실시예에 있어서, 상기 선택된 막실로만디불라 관계는 선택된 교합 포지션에 있고, 상기 치열은 상기 선택된 막실로만디불라 관계에서 교합을 제공한다.

일실시예에 있어서, 상기 변형된 특징은 치과 기구의 치열을 포함한다.

일실시예에 있어서, 상기 기록된 인스트럭션들은, 상기 센서로 비자발적 인풋을 감지하는 단계, 상기 변형된 치과 기구를 제공하기 위해 상기 비자발적 인풋에 따라 상기 치과 기구를 변형하는 단계, 상기 리포지션 스캔 특징을 제공하기 위해 상기 변형된 치과 기구에 따라 상기 스캔 특징을 리포지셔닝하는 단계, 상기 변형된 치과 기구 및 상기 업데이트된 3D 모델을 제공하도록 상기 리포지션 스캔 특징에 따라 상기 3D 모델을 업데이트하는 단계 및

상기 3D 디스플레이 상에 상기 업데이트된 3D 모델을 디스플레이하는 단계를 포함한다.

일실시예에 있어서, 상기 비자발적 인풋은 제1 개인으로부터의 비자발적 인풋을 포함한다.

일실시예에 있어서, 상기 비자발적 인풋은 제1 개인 및 제2 개인으로부터의 비자발적 인풋을 포함한다.

일실시예에 있어서, 상기 비자발적 인풋은 신경 활동 인풋을 포함하고, 상기 센서는 뇌-컴퓨터 인터페이스를 포함한다.

일실시예에 있어서, 상기 비자발적 인풋은 얼굴 표정의 변화를 포함하고, 상기 센서는 광학 센서를 포함한다.

일실시예에 있어서, 상기 기록된 인스트럭션들은, 상기 센서로 비자발적 인풋을 감지하는 단계, 상기 비자발적 인풋을 선호 기준(preference criterion) 및 상기 개인의 선호를 결정하기 위해 상기 변형된 치과 기구와 상호 연관(correlating)시키는 단계, 상기 개인의 상기 선호와 연관된 제안된(suggested) 치과 기구를 제공하기 위해 상기 변형된 치과 기구를 변형하는 단계, 제안된 스캔 특징을 제공하기 위해 상기 제안된 치과 기구에 따라 상기 스캔 특징을 리포지셔닝하는 단계, 상기 제안된 치과 기구 및 제안된 3D 모델을 제공하도록 제안된 스캔 특징에 따라 상기 3D 모델을 업데이트하는 단계 및 상기 3D 디스플레이 상에 상기 제안된 3D 모델을 디스플레이하는 단계를 포함한다.

일실시예에 있어서, 상기 선호 기준은 제1 개인의 감정 상태를 포함한다.

일실시예에 있어서, 상기 선호 기준은 개인의 자발적 인풋을 포함한다.

일실시예에 있어서, 상기 비자발적 인풋은 제2 개인으로부터의 비자발적 인풋을 포함하고,

상기 선호 기준은 상기 제2 개인으로부터의 감정 상태를 포함한다.

일실시예에 있어서, 상기 비자발적 인풋은 신경 활동 인풋을 포함하고, 상기 센서는 뇌-컴퓨터 인터페이스를 포함한다.

일실시예에 있어서, 상기 비자발적 인풋은 얼굴 표정 변화를 포함하고, 상기 센서는 광학 센서를 포함한다.

일실시예에 있어서, 상기 비자발적 인풋은 상기 업데이트된 3D 모델에 따른다.

일실시예에 있어서, 상기 3D 모델은 저장된 포지션을 포함하고, 상기 저장된 포지션은 상기 얼굴의 선택된 스캔 특징을 포함한다.

일실시예에 있어서, 상기 스캔 특징을 상기 저장된 포지션에 리포지셔닝하는 단계, 상기 저장된 포지션 및 저장된 포지션 3D 모델을 제공하도록 리포지셔닝된 스캔 특징에 따라 상기 3D 모델을 업데이트하는 단계 및 상기 3D 디스플레이 상에 상기 저장된 포지션을 디스플레이하는 단계를 포함한다.

일실시예에 있어서, 상기 스캔 특징은 상기 3D 모델 내의 상기 얼굴 상의 추가적인 디테일에 대한 상기 얼굴의 외부 특징 데이터를 포함한다.

일실시예에 있어서, 상기 얼굴의 상기 외부 특징 데이터는 실질적으로 상기 3D 모델 내의 전체 얼굴을 포함한다.

일실시예에 있어서, 상기 저장된 인스트럭션들은 스캐너로 상기 스캔 특징의 데이터를 획득하는 단계를 포함한다.

일실시예에 있어서, 상기 스캔 특징의 데이터를 획득하는 단계는, 상기 스캔 특징을 광학적으로 스캔하는 단계를 포함한다.

일실시예에 있어서, 상기 스캔 특징의 데이터를 획득하는 단계는, 초음파 검사로 상기 스캔 특징을 스캔하는 단계를 포함한다.

일실시예에 있어서, 상기 스캔 특징의 데이터를 획득하는 단계는, 상기 인풋에 따라 상기 스캔 특징의 추가적인 데이터를 획득하는 단계 및 상기 추가적인 데이터를 포함하도록 상기 3D 모델을 업데이트하는 단계를 포함한다.

일실시예에 있어서, 상기 추가적인 데이터를 획득하는 단계 및 상기 추가적인 데이터를 포함하기 위해 상기 3D 모델을 업데이트하는 단계는 각각 연속적이고 실질적으로 실시간으로 수행된다.

일실시예에 있어서, 상기 개인에 의한 얼굴 표정의 채택은 상기 추가적인 데이터를 포함하기 위해 상기 3D 모델을 업데이트하도록 하고, 상기 추가적인 데이터는 상기 얼굴 표정을 채택하는 상기 개인의 외부 특징 데이터를 포함한다.

일실시예에 있어서, 상기 인풋은 신경 활동 인풋을 포함하고, 상기 센서는 뇌-컴퓨터 인터페이스를 포함한다.

일실시예에 있어서, 상기 스캔 특징들의 데이터를 획득하는 단계는, 상기 대상 개인이 정지 포지션에 대응되는 막실로만디불라 관계에 있는지 확인하는 단계 및 상기 막실로만디불라 관계가 상기 정지 포지션인 경우, 상기 얼굴의 데이터를 획득하는 단계를 포함한다.

일실시예에 있어서, 상기 대상 개인이 상기 정지 포지션과 대응되는 막실로만디불라 관계에 있는지를 확인하는 단계는, 최소 에너지 이용을 갖는 막실로만디불라 관계를 확인하기 위해 상기 대상 개인의 턱 근육 활동을 측정하는 단계를 포함한다.

일실시예에 있어서, 상기 턱 근육 활동을 측정하는 단계는, 상기 대상 개인에 대해 근전도검사를 적용하는 단계를 포함한다.

일실시예에 있어서, 상기 대상 개인이 상기 정지 포지션과 대응되는 막실로만디불라 관계에 있는지 확인하는 단계는, 상기 대상 개인의 턱 근육들을 이그조스팅 시키는 단계를 포함한다.

일실시예에 있어서, 상기 대상 개인의 턱 근육들을 이그조스팅 시키는 단계는, 상기 턱 근육들에 경피성 전자 신경 자극을 적용하는 단계를 포함한다.

일실시예에 있어서, 상기 막실로만디불라 관계가 정지 포지션인 경우, 상기 3D 모델을 렌더링하기 위한 데이터가 상기 얼굴의 데이터를 포함한다.

본원 개시내용의 다른 실시예들 및 특징들은 아래 첨부된 도면들 및 구체적인 실시예들의 설명으로부터 당업자에 의해 명백할 것이다.

3D 이미징, 치과 디자이너 소프트웨어 및, 임의의 각도 및 관점(perspective)으로부터 가상의(hypothetical) 치과 리스토레이션들 및 옵션들을 실시간으로 디스플레이 하기 위한 3D 디스플레이를 통합한 시스템이 개시된다. 상기 시스템은, 적어도 하나 이상의 이동(movements) 및 제스쳐들, 단순한(simple) 물리 인터페이스의 처리 또는 뇌-컴퓨터 인터페이스("BCI")(예를 들어, 전자 뇌파(electroencephalographic) BCI, 자기 뇌파(magnetoencephalographic) BCI, 등)를 통한 개인의 신경 활동의 측정을 포함하는 인풋들을 이용함으로써, 비전문가(layperson) 개인이 상기 개인의 머리, 입 및 증강 현실("AR") 치과 기구 또는 리스토레이션의 복합(compound) 모델과 상호작용(interact)하도록 하는 인풋들을 센싱한다. 상기 3D 디스플레이 및 직관적인(intuitive) 손 제스쳐들 또는 상기 3D 모델의 BCI 데이터에 대한 상기 반응성(responsiveness)은 비전문가 개인에 의한 이 시스템의 이용을 용이하게 한다. 상기 개인은 치아 형태학(morphology), 어레인지먼트(arrangement) 및 색상(colour) 등과 같은 기구에 대한 다양한 디자인 옵션들을 선택할 수 있다. 상기 복합 모델은 제안된 치과 기구의 외형(appearance)이 확인되고 변형되도록 하는, 상기 디자인 옵션들에 따라 업데이트 된다. 이와 유사하게, 상기 시스템은 다수의 얼굴 표정들, 노광(lighting) 조건들 등 안에서 제안된 치과 리스토레이션들의 뷰(view)를 제공한다.

틀니 또는 다른 치과 기구를 디자인함에 있어 프라이머리(primary) 드라이버(driver)는 생리학적으로(physiologically) 적절한 바이트(bite)를 제공한다. 그러한 바이트는 치아 교체(replacement)의 다양한 조합에 의해 개인에게 제공될 수 있다. 적절한 포지션이 유지되는 동안, 상기 바이트는 다른 형태들 및 크기들의 치아들의 조합으로 구성될 수 있다(특히, 상측 및 하측 치열이 모두 틀니 또는 다른 치과 기구들에 의해 대체된 경우). 상기 특정한 치열의 선택은 에스테틱(aesthetic) 결과 상에 중요한 영향을 가질 수 있다(예를 들어, 미소를 유발하는 등). 그러므로, 개인이, 상기 기구에 포함된 치열의 크기, 형태 및/또는 방향(orientation)에 기초하여 틀니 또는 다른 치과 기구의 심미적인 프리젠테이션(presentation)에 의미 있는 인풋을 가지도록 하는 방법 및 시스템을 제공하는 것이 바람직하다. 틀니를 디자인하기 위한 이전의 접근 방법을 중 적어도 하나를 제거(obviate)하거나 경감(mitigate)하는 것이 본원 개시내용의 목적이다.

본원 개시내용의 실시예들이 첨부된 도면들을 참조하여 설명될 것이고, 이러한 실시예들은 예시적인 것에 불과하며, 특징들(features)은 복수의 도면들에 걸친 대응되는 특징들과 대응하는 참조 번호의 공통적인 마지막 두 자리수의 참조 번호를 공유한다.

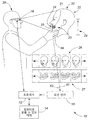

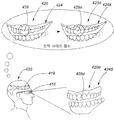

도 1은 이가 없는(edentulous) 개인의 3D 모델을 디스플레이하고 처리하는 시스템의 개념도이다.

도 2는 도 1의 3D 모델을 디스플레이하고 처리하는 방법의 흐름도이다.

도 3은 도 1의 3D 모델을 뷰잉(viewing)하는 도 1의 상기 개인이다.

도 4는 막실로만디불라 관계의 처리 후의 도 1의 3D 모델이다.

도 5는 제안된 치과 기구의 처리 후의 도 1의 3D 모델이다.

도 6은 도 1의 3D 모델을 처리하는 개인을 도시한다.

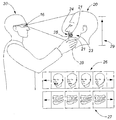

도 7은 3D 모델을 처리하는 개인을 도시한다.

도 8은 3D 모델을 처리하는 개인을 도시한다.

도 9는 3D 모델 상에 줌 인(Zoom in)하는 개인을 도시한다.

도 10은 3D 모델로부터 줌 아웃(Zoom out)하는 개인을 도시한다.

도 11은 3D 모델을 로테이팅(Rotating)하는 개인을 도시한다.

도 12은 3D 모델 내의 하나의 치아의 크기를 증가시키는 개인을 도시한다.

도 13은 3D 모델 내의 하나의 치아의 크기를 감소시키는 개인을 도시한다.

도 14은 3D 모델 내의 하나의 치아의 크기를 증가시키는 개인을 도시한다.

도 15은 3D 모델 내의 하나의 치아의 크기를 감소시키는 개인을 도시한다.

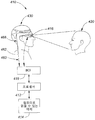

도 16은 이가 없는 개인의 3D 모델을 디스플레이하고 처리하기 위한 시스템의 개념도이다.

도 17은 이가 없는 개인의 3D 모델을 디스플레이하고 처리하기 위한 시스템의 개념도이다.

도 18은 이가 없는 개인의 3D 모델을 디스플레이하고 처리하기 위한 시스템의 개념도이다.

도 19는 이가 없는 개인의 3D 모델을 디스플레이하고 처리하기 위한 시스템의 개념도이다.

도 20은 도 16의 3D 모델을 뷰잉하는 도 16의 개인이다.

도 21은 3D 모델을 처리하는 개인을 도시한다.

도 22은 3D 모델을 처리하는 개인을 도시한다.

도 23은 3D 모델 상에 줌 인하는 개인을 도시한다.

도 24는 3D 모델로부터 줌 아웃하는 개인을 도시한다.

도 25는 3D 모델을 로테이팅하는 개인을 도시한다.

도 26은 3D 모델 상의 하나의 치아의 크기를 증가시키는 개인을 도시한다.

도 27은 3D 모델 상의 하나의 치아의 크기를 감소시키는 개인을 도시한다.

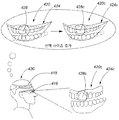

도 28은 이가 없는 개인의 3D 모델을 디스플레이 하고 처리하는 시스템의 개념도이다.

도 29는 도 28의 3D 모델을 디스플레이 하고 처리하는 방법의 흐름도이다.

도 30은 이가 없는 개인의 3D 모델을 디스플레이 하고 처리하는 시스템의 개념도이다.

도 31은 이가 없는 개인의 3D 모델을 디스플레이 하고 처리하는 시스템의 개념도이다.

도 32는 이가 없는 개인의 3D 모델을 디스플레이 하고 처리하는 시스템의 개념도이다.

도 33은 이가 없는 개인의 3D 모델을 준비하기 위한 데이터를 획득하고, 3D 모델을 디스플레이 하고 처리하기 위한 시스템의 개념도이다.

도 34는 도 33의 3D 모델을 디스플레이 하고 처리하기 위한 데이터를 획득하기 위한 방법의 흐름도이다.

도 35는 이가 없는 개인의 3D 모델을 준비하기 위한 데이터를 획득하고, 3D 모델을 디스플레이 하고 처리하고, 3D 모델을 업데이트하기 위한 시스템의 개념도이다.

도 36은 외부 특징들 데이터를 업데이트한 후의 도 35의 시스템이다.

도 37은 도 35의 3D 모델을 디스플레이 하고, 처리하고, 업데이트하기 위한 방법의 흐름도이다.

도 38은 이가 없는 개인의 3D 모델을 준비하기 위한 데이터를 획득하고, 3D 모델을 디스플레이하고 처리하고, 3D 모델을 업데이트하기 위한 시스템의 개념도이다.

도 39는 이가 없는 개인의 3D 모델을 디스플레이하고 처리하기 위한 시스템의 개념도이다.

도 40은 이가 없는 개인의 3D 모델을 준비하기 위한 데이터를 획득하고, 3D 모델을 디스플레이하고 처리하고, 3D 모델을 업데이트하기 위한 시스템의 개념도이다.

도 1은 이가 없는(edentulous) 개인의 3D 모델을 디스플레이하고 처리하는 시스템의 개념도이다.

도 2는 도 1의 3D 모델을 디스플레이하고 처리하는 방법의 흐름도이다.

도 3은 도 1의 3D 모델을 뷰잉(viewing)하는 도 1의 상기 개인이다.

도 4는 막실로만디불라 관계의 처리 후의 도 1의 3D 모델이다.

도 5는 제안된 치과 기구의 처리 후의 도 1의 3D 모델이다.

도 6은 도 1의 3D 모델을 처리하는 개인을 도시한다.

도 7은 3D 모델을 처리하는 개인을 도시한다.

도 8은 3D 모델을 처리하는 개인을 도시한다.

도 9는 3D 모델 상에 줌 인(Zoom in)하는 개인을 도시한다.

도 10은 3D 모델로부터 줌 아웃(Zoom out)하는 개인을 도시한다.

도 11은 3D 모델을 로테이팅(Rotating)하는 개인을 도시한다.

도 12은 3D 모델 내의 하나의 치아의 크기를 증가시키는 개인을 도시한다.

도 13은 3D 모델 내의 하나의 치아의 크기를 감소시키는 개인을 도시한다.

도 14은 3D 모델 내의 하나의 치아의 크기를 증가시키는 개인을 도시한다.

도 15은 3D 모델 내의 하나의 치아의 크기를 감소시키는 개인을 도시한다.

도 16은 이가 없는 개인의 3D 모델을 디스플레이하고 처리하기 위한 시스템의 개념도이다.

도 17은 이가 없는 개인의 3D 모델을 디스플레이하고 처리하기 위한 시스템의 개념도이다.

도 18은 이가 없는 개인의 3D 모델을 디스플레이하고 처리하기 위한 시스템의 개념도이다.

도 19는 이가 없는 개인의 3D 모델을 디스플레이하고 처리하기 위한 시스템의 개념도이다.

도 20은 도 16의 3D 모델을 뷰잉하는 도 16의 개인이다.

도 21은 3D 모델을 처리하는 개인을 도시한다.

도 22은 3D 모델을 처리하는 개인을 도시한다.

도 23은 3D 모델 상에 줌 인하는 개인을 도시한다.

도 24는 3D 모델로부터 줌 아웃하는 개인을 도시한다.

도 25는 3D 모델을 로테이팅하는 개인을 도시한다.

도 26은 3D 모델 상의 하나의 치아의 크기를 증가시키는 개인을 도시한다.

도 27은 3D 모델 상의 하나의 치아의 크기를 감소시키는 개인을 도시한다.

도 28은 이가 없는 개인의 3D 모델을 디스플레이 하고 처리하는 시스템의 개념도이다.

도 29는 도 28의 3D 모델을 디스플레이 하고 처리하는 방법의 흐름도이다.

도 30은 이가 없는 개인의 3D 모델을 디스플레이 하고 처리하는 시스템의 개념도이다.

도 31은 이가 없는 개인의 3D 모델을 디스플레이 하고 처리하는 시스템의 개념도이다.

도 32는 이가 없는 개인의 3D 모델을 디스플레이 하고 처리하는 시스템의 개념도이다.

도 33은 이가 없는 개인의 3D 모델을 준비하기 위한 데이터를 획득하고, 3D 모델을 디스플레이 하고 처리하기 위한 시스템의 개념도이다.

도 34는 도 33의 3D 모델을 디스플레이 하고 처리하기 위한 데이터를 획득하기 위한 방법의 흐름도이다.

도 35는 이가 없는 개인의 3D 모델을 준비하기 위한 데이터를 획득하고, 3D 모델을 디스플레이 하고 처리하고, 3D 모델을 업데이트하기 위한 시스템의 개념도이다.

도 36은 외부 특징들 데이터를 업데이트한 후의 도 35의 시스템이다.

도 37은 도 35의 3D 모델을 디스플레이 하고, 처리하고, 업데이트하기 위한 방법의 흐름도이다.

도 38은 이가 없는 개인의 3D 모델을 준비하기 위한 데이터를 획득하고, 3D 모델을 디스플레이하고 처리하고, 3D 모델을 업데이트하기 위한 시스템의 개념도이다.

도 39는 이가 없는 개인의 3D 모델을 디스플레이하고 처리하기 위한 시스템의 개념도이다.

도 40은 이가 없는 개인의 3D 모델을 준비하기 위한 데이터를 획득하고, 3D 모델을 디스플레이하고 처리하고, 3D 모델을 업데이트하기 위한 시스템의 개념도이다.

일반적으로, 본원 개시내용은 치과 기구의 치열 내의 변화의 에스테틱(aesthetic)(aesthetic) 효과 또는 상기 기구 또는 리스토레이션의 디자인 동안 리스토레이션을 관찰(observing)하기 위한 방법 및 시스템을 제공한다.

현재 치과 분야의 실무는, 개인의 치아(dental) 조건을 평가하고 필요한 경우 트리트먼트(treatment)를 권하는 전문가를 위한 것이다. 에스테틱(aesthetic) 치과의사(dentistry)의 경우, 치과 전문가는 개인에 대한 기구(appliance)를 요하는 트리트먼트들을 제시한다(present). 상기 기구의 디자인은 주로 상기 개인으로부터 최소의 인풋에 의해 상기 치과 전문가 및 치과 연구실(lab)의 책임이 있다. 고비용의 모형(mock ups) 또는 트라이-인즈(try-ins)는 주조 가능한 물질들로부터 시간-소모적인 절차에 의해 만들어질 수 있다. 이러한 이유로, 제시된 트라이-인이나 모형이 바람직하지 않은 경우, 하나(one)가 결정될 때까지 몇 개의 모형들 이상 만드는 것은 드물다. 상기 개인은 대안을 기대할 수 있으나, 그들은 숙련된 치과 연구실 기술자들이 아니기 때문에, 그들은 그들의 바람들을 완벽히 의사소통하지 못할 수 있고, "의사가 가장 잘 안다(doctor knows best)"는 사고방식은 일반적으로, 그들의 초기 바람들을 완전히 달성하지 못하는, 상기 개인과 절충하는 결과를 가져올 수 있다. 치과 리스토레이션을 디자인하기 위한 상기 교육의 필요성이 중요하기 때문에, 그들 자신의 리스토레이션을 디자인하기 위해 상기 개인에게 권한을 부여(empowering)하는 것은 실용적인 대안이 아니다.

현재의 모델링 소프트웨어 상에서 치과 리스토레이션들을 디자인하는 숙련자는 통상적으로 능숙해지기 전 디자인 소프트웨어를 올바르게 이용하고 이해하기 위해 수일 간의 트레이닝이 필요하다. 그러한 치과 디자인 소프트웨어 상에서 치과 기구를 필요로 하는 비전문가 개인을 트레이닝하는 것은 비실용적이다. 그러므로, 제안된 응용에서, 평균적인 개인에게 치과 디자인 소프트웨어와 즉각적으로 상호 작용하고 변화로부터 야기되는 에스테틱 결과를 직관적으로(intuitively) 관찰하는 능력을 부여하는 시스템이 바람직할 것이다.

치과 기구가 디자인되고 있는 개인은 통상적으로 상기 기구에 의해 일어나는 그것들의 외양(appearance)에 대해 가지는 인풋에 관심이 있다. 기구를 준비할 경우, 예비 모델은 종종 시간 소모적이고 비싸고 부정확한 몰딩(moulding) 및 캐스팅(casting)에 의해 준비된다. 상기 개인의 결과적인 웃음(smile)에 대한 특정 변화의 효과(effect)를 예측하고, 상기 예측과 효과적으로 통신하는 것은 쉽지 않다(challenging). 결과적으로, 그것들의 결과로 생긴 외양에 대해 상기 개인에 대한 의미 있는 인풋을 제공하는 것이 쉽지 않다. 상기 개인의 그들의 치열의 외양 상의 특정한 임팩트(impact), 외양 결과에 대한 만족은 긍정적인 트리트먼트 결과에 필수적이다.

상기 개인이 트라이-인즈 또는 최종 보철들(prostheses)의 값비싼 제작에 앞서 제안된 기구를 관찰하고 평가하도록 하는 방법은 현재의 트리트먼트 비주얼라이제이션의 방법들에 비해 장점이 있다. 현재 많은 시스템들은 3D 이미지 상에 2D 이미지들을 중첩(overlay)하는 소프트웨어에 의존한다. 그러한 소프트웨어는 종종 특화(specialized)되어, 대부분의 비전문가에게 있어 사용하고 이해하기에 어렵고, 비전문가 개인이 실시간으로 이용하도록 디렉팅(directed)되지 않는다. 그러한 소프트웨어 내에서의 치열 처리는, 로테이팅, 기울임(tilting) 및 포지션 및 바이트 결과에 영향을 주지 않는 기구의 특징들을 변화시키기 위한 개인의 치아 또는 그룹의 치아의 앵귤레이션을 변화함으로써 수행된다. 또한, 상기 치열은 다른 미리 모델링된(pre-modeled) 치열에 의해 스위치 아웃될 수 있다. 본원 개시내용은 3D 모델링이 통합된 실시간 증강 현실("AR") , 치과 디자인 소프트웨어, 3D 디스플레이 및 센서를 포함하는 방법들 및 시스템들을 제공한다. 상기 센서는 모션 센서 또는 제스쳐(예를 들어, 손 제스쳐들을 추적하거나 눈 이동들을 추적하는 등)들에 기초한 인풋들을 수신하기 위한 모션 캡쳐 디바이스(예를 들어, 광학 모션 센서, SMI Eye Tracking Glasses 2 Wireless system과 같은 눈 추적 센서들, CyberGlove systems 등과 같은 손-기반 모션 캡쳐 디바이스), 다른 광학 센서들, 신경 활동에 기초하여 인풋들을 수신하기 위한 뇌-컴퓨터 인터페이스("BCI"), 펄스, 온도 또는 땀을 측정하기 위한 센서들, 또는 폴리그래프(polygraph)로서 이용되는 복수 테스트들의 조합, 또는 임의의 다른 적절한 센서를 포함할 수 있다. 손-기반 센서들은 유형의(corporeal) 3D 모델의 핸들링을 시뮬레이팅하기 위한 촉각(tactile) 피드백을 제공할 수도 있다.

상기 개인의 머리의 일부의 3D 모델은 여기에 기술된 방법들 및 시스템들에 이용된다. 상기 3D 모델은 상기 개인의 궁(arches)의 실증적인(empirical) 데이터 및 상기 상기 궁(arches)을 상기 머리와 연관시키는(예를 들어, 상기 궁(arches)에 대한 3D 내부-구강 광학 스캐너로부터의 데이터 및, 상기 궁 및 헤드 모두에 대한 3D 외부구강 광학 스캐너로부터의 데이터) 개인의 머리를 포함한다. 상기 3D 모델은 3차원에 디스플레이된다(예를 들어, 오큘러스 리프트 가상 현실 헤드셋, 구글 글래스 디바이스, 홀로그래픽 프로젝션 등을 통한 비주얼라이제이션에 의해). 또한, 상기 실증적인 데이터에 기초한 상기 부분들에(the portions) 있어 3D 모델은 증강 현실 치과 기구를 포함한다. 상기 개인의 머리 및 상기 증강 현실 치과 기구는 상기 개인의 손 또는 다른 제스쳐들, 또는 BCI의 이용을 통해 상기 개인에 의해 처리될 수 있다. 모션 센서는 상기 개인의 손들 또는 인풋을 수신하거나 인풋을 수신하는 상기 BCI를 위한 다른 제스쳐들의 이동을 감지할 수 있다. 상기 3D 모델은 상기 인풋에 기초하여 처리된다. 3D 모델에 쇼잉(showing)되는 상기 기구의 특징들(예를 들어, 치아, 페스툰(festoons) 및 틀니 내의 잇몸(gums)의 다른 특징들)은 그래스핑(grasping) 및 처리될 수 있고, 상기 개인은 BIC의 케이스 내에 그렇게 처리되는 것을 예상(imagine)할 수 있다. 또한, 주지의 손 제스쳐들은 로테이션, 주밍(zooming), 및 다른 공통적인 기능들을 위해 이용되거나 이매진될 수 있다. 눈 추적 및 BCI를 조합하는 것은 공통적인 타임 스탬프를 이용한 두 개의 시스템들로부터의 데이터의 실시간 동기화가 감정적인 상태에 의한 어텐션(attention)의 패턴들을 상호연관시키도록 할 수 있다.

증강 현실 치과 기구로의 변화는 상기 개인 또는 다른 시스템의 유저에 의해 3D 모델 상에 실시간으로 발생할 수 있다. 상기 개인은 임의의 각도로부터 특정 크기들, 외양들, 및 상기 기구 내의 치아의 방향의 에스테틱(aesthetic) 결과를 관찰하기 위한 다양한 줌 각도들에서 상기 모델을 뷰잉할 수 있다. 더 브로드하게(broadly), 증강 현실 치과 기구 및 상기 3D 모델의 처리 및 변형을 통해, 상기 개인은 유의미한 인풋을 상기 기구의 특정한 디자인을 위한 변화들의 에스테틱(aesthetic) 결과에 제공할 수 있다. 이러한 처리들은 직관적인 손 제스쳐 또는 다른 제스쳐들을 통해 달성될 수 있다. 상기 제스쳐들은 실질적인 제스쳐들(케이스, 모션 센서들 또는 BCI 내의) 또는 이매진 제스쳐들(BCI의 케이스 내의)일 수 있다. BCI를 이용하는, 이매진 손 이동은 복호화(deciphered)될 수 있고, 3D 모델을 다루기(manipulate) 위한 특정한 멘탈 커맨드들일 수 있다. AR 특징들 및 상기 모델의 구성요소들은, 상기 개인의 취향에 따라 예를 들어, 푸시, 풀링, 로테이팅, 인라징(enlarged), 쉬렁크(shrunk) 등이 될 수 있다. 또한, 색상 및 셰이드(shade) 같은 구성요소들은 멘탈 커맨드들을 이용하여 변화될 수 있다. 상기 개인의 3D 모델에 대한 자발적인 반응(예를 들어, 감정적인 반응 등)은 카운팅(accounted)될 수 있고, 상기 모델은 상기 개인의 비자발적 반응들에 따라 자동적으로 업데이트된다. 상기 비자발적 인풋들은 광학 변화를 감지하는 센서들, 신경 활동 (a BCI), 펄스, 기온, 땀, 폴리그래프로서 이용되는 복수 테스트들의 조합, 또는 임의의 다른 감정 상태의 적절한 인디케이터에 의해 측정될 수 있다.

상기 특징을 리칭(reaching)하고 이동하는 것을 이매지닝하거나 상기 변화의 결과들을 이매지닝하는 BCI가 이용되는 경우, 상기 제안된 기구 디자인과 인터액팅하는 것은 리칭 아웃(reaching out) 및 치아 또는 상기 개인의 손에 의한 상기 모델의 다른 특징의 이동만큼 간단하다. 결과적으로, 상기 개인에 대한 베이직 인스트럭션만이 요구된다. 상기 디자인 소프트웨어는 지상돌기접착(interdigitation)과 동일한 적절한 바이트를 가진 기구의 결과를 담보하기 위한(to ensure) 치열에 대해 허용 가능한 변화들 상의 미리 정해진 기능적인 제한들을 포함하고, 적절한 생리적(physiological) 정지 포지션을 허용한다. 상기 결과로서의 기구는 기능적일 수 있으나, 상기 에스테틱(aesthetic)은 상기 개인의 관리 하에 있을 것이고(in the hands), 결과(resulting) 치과 기구가 정지 포지션에서의 상측 및 하측 치열 간의 적절한 클리어런스(clearance)를 제공하고, 교합(occlusion) 상태에서, 적절한 막실로만디불라 관계를 제공하는 것을 담보하기 위해 부과된 제약들(constraints)을 조건으로 하고, 그렇지 않으면 기능적으로 최적화된다. 상기 제안된 기구에 대한 변화의 에스테틱 결과들은 실시간으로 확인(verified)될 수 있고, 상기 개인은 그들이 만족하는 디자인을 발견할 수 있다. 대안적으로, 상기 개인은 그들의 이상적인 디자인이 기능적 제한들을 넘고 있다는 점을 인식할 수 있고, 따라서 달성될 수 없다. 상기 개인은 그 다음 에스테틱들 및 기능 간의 적합한 절충(compromise)을 준비하기 위한 3D 모델을 처리할 것이다. 상기 모델 및 상기 디스플레이의 상기 3D 네이쳐(nature)는, 임의의 각도로부터 뷰잉하기 위한 능력 및 다양한 불투명도(opacity)를 포함하는, 제안된 기구에 의한 3차원 룩(look)이 어떻게 보일지에 대한 이해를 개인에게 제공한다.

상기 3D 모델은 다른 얼굴 표정들을 반영하기 위해 업데이트될 수 있다. 기존(preexisting) 치아의 오래된 사진들로부터 도출된(derived) 미소들은 개인의 자연스러운 미소를 리스토어하기 위한 시스템에 대한 인풋이 될 수 있다. 유명 인사(celebrity)의 미소들은 영향 디자인 옵션들에 대한 인풋이 될 수도 있다. 상기 개인은 판단의 두려움 또는 치과 전문가들로부터의 비판 없이 그들이 기대하는 디자인 결과를 표현할 수 있다. 이와 유사하게, 제2 개인은 상기 기구의 변화에 참여하고 제안할 수 있다. 미리 정해진 미소 또는 다른 제약들은 에스테틱 목표들 및 바이트와 연관된 기능적인 제약들을 유지하는 동안 상기 목표들에 도달하거나 근사(approximate)하기 위해 모델링 된 치과 기구로 세팅될 수 있다. 추가적인 데이터는 교합 포지션, 미소, 또는 생리적인 정지 포지션("rest position")에서의 개인의 현재 틀니에 의한 교합 포지션에서의 실증적인 데이터 등과 같은, 특정한 포지션에서 실증적 데이터를 제공하기 위한 상기 3D 모델을 처리하는 동안 획득될 수 있다.

상기 개인의 막실로만디불라 관계가 정지 포지션에 있는 경우, 실증 데이터로부터 준비된 3D 모델은 (다른 포지션에서 데이터를 획득하고 상기 정지 포지션에 대해 추정(extrapolating)하는 것과 대조적으로)상기 정지 포지션에서 상기 개인의 막실로만디불라 관계의 정확한 리프리젠테이션을 제공한다. 상기 개인의 실질적인 정지 포지션은 상기 3D 모델을 결정한다. 상기 3D 모델의 정지 포지션은, 그렇게 함으로써(thereby) 상기 정지 포지션에 영향을 미치는 조인트들, 근육들, 신경들, 잇몸들(gums), 임플란트들(있는 경우), 및 치아(있는 경우)를 포함하는 스토마토그나틱(stomatognathic) 내의 모든 엔티티들의 상호관계(interrelationship)를 어카운팅한다. 정지 포지션에 있는 개인의 아무런 데이터 없이 준비된 3D 모델은 습관적(habitual)이거나 다른 포지션으로부터의 정지 포지션을 믿을 수 있게(reliably) 덜(less) 구별할 것이다.

상기 정지 포지션은 만디불라(mandibular) 클로져(closure)의 등장(isotonic) 경로를 따라 상기 막실라(maxillar)(수직, 안테리어-포스테리어(anterior-posterior), 및 위쪽 업라이트(upright) 자세의 포지션 내의 머리와 연관되는 측면)와 연관되는 공간 내의 만디블(mandible)의 포지션이다. 상기 정지 포지션에 있어서, 턱 근육계(musculature)는, 상기 만디불라를 움직이는 익스텐서(extensor) 및 디프레서(depressor) 근육들, 상기 그것이 최소 전자 활동을 가하는(exerts) 포지션에 포스쳐(posture) 된다. 상기 정지 포지션을 유지하기 위해 요구되는 턱 근육계에 의한 에너지 소모는 만디불라 힌지(hinging)의 경로를 따르는 다른 포지션들과 비교할 때 최소한의 것이다. 상기 정지 포지션에서, 상기 개인의 관절구(condyles)는 중립 상태이고, 제약받지 않은(unrestrained) 포지션이다.

상기 개인의 정지 포지션은 상기 개인에 대한 참조에 의해 결정될 수 있다. 상기 정지 포지션은 치과 아티큘레이터(articulator) 등과 같은 만디불라 움직임들을 자극하는 기계적인 디바이스 상에서 결정될 수 없다. 만디불라 포지션 또는 막실로만디불라 관계는 머리, 목 경부 영역 및 허리(back) 영역의 자세 문제를 포함하는 요소들(factors)에 의해 영향 받을 수 있다. 턱관절 조인트(temporomandibular joint)의 내부 혼란(derangements), 감정 요소들 및 개인의 시스템적인 건강 요소들도 절충된 만디불라 포지션에 기여할 수 있다. 일반적으로 정지 포지션을 설정(establish)하기 전 이러한 요소들을 설명하는 것이 유익하다. 특정 케이스들에 있어서, 이러한 요소들에 대한 어카운팅의 실패(failure)는 정지 포지션의 오류(erroneous)를 야기한다. 예를 들어, 요소(factor)는 바이트 등록을 위한 추론(extrapolate)에 이용될 수 있는 정지 포지션을 설정하기 전 처리(addressed)되거나 제거되어야 할 수 있다. 다른 실시예에 있어서, 요소(factor)는 정지 포지션에 있는 상기 개인의 데이터를 획득하기 위한 장점을 증가시키는, 다른 포지션들로부터의 정지 포지션을 추론하는 것을 더 복잡하게 만들 수 있다.

상기 정지 포지션에서의 실증적인 데이터를 포함하는 3D 모델은 잠재적으로 유용한 다른 막실로만디불라 관계들의 정확한 결정을 용이하게 한다. 예를 들어, 상기 3D 모델은 턱 추적(tracking)에 이용되거나, 바이트를 설정하기에 충분한 치열이 부족한 개인들의 외부구강 바이트 평가에, 예를 들어 이가 없는 개인들, 적용될 수 있다. 상기 개인이 바이트를 설정하기 위해 충분한 치열을 가졌던 경우, 상기 데이터는 중심교합(centric occlusion)("CO", 상기 개인의 치아가 최대 교두감합위(intercuspation)이고, 상기 개인의 턱이 "CO 포지션"인 경우, 발생하는)에서 자연적인 포지션의 결정을 용이하게 할 수 있다. 따라서, 상기 데이터는 광학 신경근(neuromuscular)의 CO 포지션의 근사화(approximation)를 용이하게 할 수 있다. 추정된 CO 포지션은 광학 바이트를 정의하기에 충분한 치아를 가지지 못한 개인들에 대한 틀니를 준비하기 위해 적용될 수 있다.

기구를 준비할 경우 CO 포지션을 설정하는 것은 의치 기공사(denturist) 또는 다른 치과 전문가에게 주지의 사실이다. 상기 개인이 상기 CO 포지션을 설정하기 위해 충분한 치열이 부족한 경우, 추론(extrapolation)은 기구에 발생하는 CO 내의 적절한 막실로만디불라 관계를 결정하기 위해 필수적으로 요구된다. 몇몇 일부 덴테이트(dentate) 개인들도, 예를 들어 앞니(incisors)는 있으나 어금니(molars)는 없는 개인 등, CO를 설정하기 위해 충분한 치열이 부족할 것이다.

기구를 준비할 경우, 상기 정지 포지션에 기초하여 CO 포지션을 설정하는 것은 결과(resulting) 치과 기능, 견고성(stability) 및 조화(harmony), 상기 기구를 포함하는 스토마토그나틱 시스템의 개선 및 최적화를 용이하게 할 수 있다. 상기 정지 포지션에 기초하여 상기 CO 포지션을 설정하는 것도 아래의 적어도 하나 이상을 용이하게 할 수 있다:

-표준(normal) 교합 스킴(scheme)이 상기 개인에게 적절한 기능성을 제공할 경우, 표준 교합 스킴에 대한 상기 개인의 표준 스킴의 최적화, 또는 상기 개인의 CO 포지션이 요구하는 것이 많을 경우, 임의의 턱 관계 분류 또는 부정교합(malocclusion)에 대한 설명;

-치과 에스테틱의 최적화(치아 형태, 윤곽(contour), 안테리어 및 포스테리어 영역들 모두에서의 해부학(anatomy) 및 형태학(morphology));

-광학 생리학 만디불라 포지션이 알려진(found) 경우, 더 조화로운 근육 밸런스로 인한 표정 코스메틱(cosmetics)의 최적화, 또는

-가능한 근골격(musculoskeletal) 교합 사인들 및, 두통, 귀 컨제스쳔(congestion) 느낌, 이명(ringing) 현상, 눈 뒤편의 압력, 치아 민감도, 턱관절 조인트 소음, 저작(masticatory) 근육 유연성, 목 및 어깨 통증 등을 포함하는 증상들의 완화(mitigation).

상기 정지 포지션은 습관적인 포지션과 대조되는 진정한(true) 정지 포지션이다. 상기 습관적인 포지션은 상기 과상돌기(condylar) 번역 경로(pathway)를 따라 앞쪽으로(anteriorly) 포지셔닝 될 수 있는 획득된 막실로만디불라 포지션이다. 특정한 개인에 따라, 상기 정지 포지션 및 상기 습관적 포지션은 동시에 발생하거나(coincide) 매우 근접하게 발생할 수 있다. 그러나, 상기 습관적 포지션을 유지하기 위한 턱 근육계에 의해 획득되는 에너지는 상기 정지 포지션으로서 최소일 필요가 없다. 상기 습관적인 포지션은 때때로 이가 없는 개인들에 있어서 CO 포지션을 결정하는 스타팅 포인트로서 이용된다. 그러나, 습관적 포지션과 함께 시작하는 것은 상기 정지 포지션과 함께 시작하는 것보다 치과 트리트먼트를 계획하는 것에 대한 덜 바람직한 아웃컴을 제공할 수 있다.

상기 3D 모델은 3D 테크닉에 의해 디스플레이 된다(예를 들어, 구글 글래스, 오큘러스 리프트, 마이크로소프트 홀로렌즈, 3D 텔레비전 또는 모니터, 홀로그래픽 프로젝션 등). 상기 3D 모델을 처리하기 위해 이용되는 제스쳐들은 직관적이고 심플할 수 있다(예를 들어, 개인의 손으로 치아를 그리핑하고 상기 치아를 로테이트하는 것 등). 결과적으로, 상기 개인은 특정한 선택된 치열의 에스테틱 임팩트를 관찰하기 위해 제안된 기구의 치열을 쉽게 처리할 수 있다. 2-차원 디스플레이 상에서 유사한 처리를 수행하는 것은 더 큰 숙련도(proficiency)와 추상도(abstraction)를 요구한다. 특히 상기 개인(더 나이가 있고, 틀니 및 다른 치과 기구들을 이용하는 주된 사용자)이 3-차원 비주얼라이제이션 및 2-차원 디스플레이 상에서의 처리에 익숙하지 않은 경우, 상기 3D 디스플레이를 이용하는 것은, 비전문가 개인이 접근 가능한 치아의 포지션 내의 양질의(fine) 특정한 변화를 가져온다. 유사하게, 개인 및 치과 전문가 간의 언어 장벽은 상기 3D 모델을 리뷰잉하고 처리함에 있어 장애(bar)가 되지 않는다. 이것은, 전문가에 의한 여러 차례의 방문이 실용적이지 않거나, 빈곤하거나(impoverished) 접근 불가능한 구역들 내의 개인들을 위한 틀니들을 디자인할 경우의 애플리케이션을 포함할 수 있다.

처리 수단들의 핸즈-프리 네이쳐는, 태블릿 표면, 키보드, 마우스 또는 다른 물리적 인터페이스 디바이스와의 접촉을 통해 덜 감염(infections)되는 경향이 있다.

제2 개인은 상기 3D 모델을 처리할 수 있고, BCI 또는 감정 상태의 지표(indicative) 데이터의 인풋들을 수신하는 다른 센서가 이용되는 경우, 상기 개인의 상기 감정 반응, 상기 제2 개인 또는 둘 모두 상기 개인, 상기 제2 개인 또는 둘 모두의 선호를 예측하기 위해 적용될 수 있다. 이러한 선호는 제1 개인 및 강한 반응을 가진 제2 개인 모두에 대한 기구의 디자인을 용이하게 하기 위해 웨이팅(weighted) 될 수 있다. 제2 개인은 상기 개인과 함께 상기 3D 모델을 처리할 수 있거나, 상기 제2 개인은 상기 참여 또는 상기 개인의 인풋 없이 그렇게 할 수 있다(예를 들어, 상기 개인이 그들 스스로 의사소통 하거나 효과적으로 선택할 수 없는 경우).

몇몇 이전의 방법들의 제한들은 상기 대상 및 치아의 통합된 2개의 2D 이미지들에 기초한 상기 분석으로부터 발생한다. 상기 2개의 이미지들은 공통된 특징을 공유하지 않고, 3D 모델의 생성에 이용될 수 없다. 상기 결과(resulting) 복합 이미지는 어떠한 다른 각도로부터도 가시적이지 않다. 또한, 디지털 포토그래프의 촬영 동안 노광(lighting) 조건들은 불일치할 수 있고, 상기 대상의 얼굴에 대한 리프리젠테이션 내의 치아 셰이딩의 정확한 리프리젠테이션은 완전히 정확하지 않을 수 있다. 제안된 보철(prosthesis)의 리프리젠테이션은 존재하는 틀니 또는 리스토레이션 및 상기 대상 개인의 얼굴 간의 참조 포인트들의 결핍으로부터 고통 받는다(suffer from). 또한, 진정한 3D 모델 없이는, 디자인의 기능적 제한들이 테스트하기 더 어렵고 제약으로 작용한다(apply as constraints). 결과적으로, 비(non)-기능적 디자인들은 잠재적인 문제의 암시(indication) 없이 모델링 될 수 있다. 마지막으로, 그린(green) 스크린을 위해 쉴드를 대상 개인의 입 속에 위치시킴으로써, 변화되는 얼굴 및 입술, 결과 에스테틱이 모델링 되도록 변경(altering)한다.

TruRx 시스템 등과 같은 이전의 그린 스크린 기술은 상기 개인의 치열 궁의 최상단 상에 제안된 디자인의 프로젝션을 중첩하는 것을 포함한다. 대조적으로, 여기 개시된 상기 방법들 및 시스템들에서 이용되는 상기 3D 모델은 궁(arches)을 얼굴 구조들과 연관시킨다. 결국, 상기 궁 및 치아는 특정한 포지션 내의 상기 입술은 완전히 불투명해지고, 상기 3D 모델은 상기 제안된 기구 및 그것의 에스테틱 상의 효과를 정확하게 리프리젠팅 가능하도록 유지한다.

3D 모델을 이용하는 유용성은 입술 라인의 레스팅(resting)과 연관된다. 레스팅 입술 라인에서, 상기 입술은 이완(relaxed)되고, 대부분, 종종 치아들의 전체가 비가시적이다. 내부구강 특징들(예를 들어, 상기 증강 현실에 의해 제안되는 치열)에 더하여 외부 구강 구조들(예를 들어, 얼굴 특징들 등)의 애플리케이션에 의해, 상기 3D 모델은, 상기 궁(arches) 및 기구가 가시적이지 않은 경우에도 상기 외부 특징들 상에 치아의 정확한 묘사할 수 있는 효과를 제공한다.

시스템

도 1은 대상 개인(30)의 3D 모델(20)을 디스플레이 하고 처리하기 위한 시스템(10)이다. 상기 시스템(10)은 프로세서(12) 및 컴퓨터로 읽기 가능한 매체(14)를 포함한다. 상기 3D 모델(20)은 렌더링되고, 처리되고, 업데이트 되고, 프로세서(12)에 의한 인스트럭션들의 실행을 통해 디스플레이된다. 3D 모델(20)은 컴퓨터로 읽기 가능한 매체(14) 상에 유지되는 데이터에 기초한다. 프로세서(12) 및 컴퓨터로 읽기 가능한 매체(14)는 동일한 디바이스 또는 분산(separate) 디바이스 상에 있을 수 있고, 분산 네트워크 로케이션들에 있을 수 있거나, 임의의 다른 적합한 어레인지먼트(arrangement)일 수 있다. 프로세서(12)의 기능들 및 컴퓨터로 읽기 가능한 매체(14)는 복수의 개인 프로세서들 및 컴퓨터로 읽기 가능한 매체 중에서 분할될 수 있다.

시스템(10)은, 개인(30)이 3D 디스플레이(16) 상에 3D 모델(20)을 처리하기 위한 3D 모델(20) 상에 그들의 손을 두도록 하기 위해, 예를 들어 직관적인 제스쳐들을 통해, 3D 모델(20)을 디스플레이 하기 위한 프로세서(12)와 통신하는 3D 디스플레이(16)를 포함한다. 도 1에서, 개인(10)은 손(39)으로 3D 모델(20)을 처리한다. 시스템(10)은 개인이 3D 모델(20)의 포지션 또는 뷰를 변화할 수 있도록 하거나, 3D 모델(20)의 선택된 특징들을 변화할 수 있도록 하거나, 또는 3D 디스플레이(16)에 보여지는 것과 같이 3D 모델(20)에서 다이렉팅되는 제스쳐들을 이용하는 3D 모델(20)을 처리하도록 할 수 있다. 상기 제스쳐들은 손으로 3D 모델(20)의 일부를 그리핑하는 것과 물리적인 모델을 처리할 경우 이용되는 유사한 손 제츠셔들을 적용하는 것을 포함할 수 있다. 그러한 처리들의 실시예들은, 로테이팅, 패닝(panning), 줌 인 또는 줌 아웃, 노광 조건들의 변화, 등과 같이 상기 디스플레이에 보여지는 3D 모델(20)의 뷰의 변화를 포함할 수도 있다.

3D 디스플레이(16)은 아이웨어(eyewear)-스타일 AR 인터페이스(예를 들어, 구글 글래스, 오큘러스 리프트, 마이크로소프트 홀로렌즈, 메타 스페이스글래시스 등)으로서 보여진다. 아이웨어 AR 인터페이스들은 3D 모델(20)이 개인(30)의 시각(perspective)로부터 실질적인 물리적 환경을 넘어(over) 디스플레이하도록 한다. 3D 디스플레이(16)는, 개인(30)이 3차원 내에서 실시간으로 업데이트되는 3D 모델(20)을 볼 수 있도록 복합 환경을 프로젝팅 한다. 아이웨어-스타일 3D 디스플레이(16)는, 그들 눈의 정면에 있고, 그들의 손 또는 다른 커맨드들에 의해 처리될 수 있는 3D 모델(20), 개인(30)에 대한 지각(perception)을 제공하는 임의의 디스플레이 디바이스와 교환 가능하고, 복수의 각도들에서 뷰잉된다.

시스템(10)은 모션 센서(18)을 포함한다. 모션 센서(18)은 개인(30)의 제스쳐들(예를 들어, 손의 이동, 머리, 발 등)을 감지한다. 제스쳐들은, 프로세서(12)에 제공될, 제1 인풋 데이터(60)의 인풋들이 된다. 제1 인풋 데이터(60)는, 모션 센서(18)에 의해 감지되는 개인(30)의 제스쳐들과 대응되는 자발적 액션 데이터(62)를 포함한다. 모션 센서(18)는 모션, 로케이션, 포지션 및 개인(30)의 제스쳐, 개인(30)이 3D 모델(20)을 3D 디스플레이(16) 상에서 처리할 수 있도록 하는, 들의 각도를 모니터링한다. 모션 센서(18)는 임의의 적합한 데이터(예를 들어, 광학, 도플러(Doppler) 레이다, 패시브 IR, 단층 X선 촬영(tomographic), 그것들의 조합들 등)에 기초하여 모션을 감지할 수 있다.

다른 센서들은, 시스템(10) 내에 모션 센서(18) 또는 개인(30)이 3D 모델(20) 및 치과 디자인 소프트웨어와 상호작용하도록 하는 모션 센서(18)의 플레이스(place) 내에 포함될 수 있고,

그 외(otherwise than) 프로세서(12)에 의해 인터프리트 될 수 있는 자발적 액션 데이터(62)를 제공하기 위한 제스쳐(예를 들어, 눈 이동, 목소리 커맨드들, 얼굴 표정들 등)들을 통할 수 있다(도시되지 않음). 그러한 센서들은 광학 데이터의 캡쳐 또는 개인(30)으로부터의 다른 데이터의 폼(forms)에 기초할 수 있다(예를 들어, 도 39의 광학 센서(1296) 등).

3D 모델(20)은 개인(30)(예를 들어, 도 30의 시스템(610) 등) 외에(other than) 개인(person)으로부터의 자발적 액션 데이터에 따라 처리될 수도 있다.

도 2는 3D 모델로 수행되는(working with) 방법(80)을 도시한다. 방법(80)은 3D 모델(82)을 디스플레이 하는 단계, 인풋(84)을 수신하는 단계 및 인풋(84)을 수신함에 대응하여 3D 모델(86)을 업데이트하는 단계를 포함한다. 방법(80)은 시스템(10)을 이용하여 수행될 수 있다. 3D 모델(82)을 디스플레이 하는 단계 및 3D(86)를 업데이트하는 단계는 컴퓨터로 읽을 수 있는 매체(14)에 저장된 데이터를 이용하는 프로세서(12)에 의한 인스트럭션들의 실행에 의해 3D 디스플레이(16) 상에서 완성될 수 있다. 인풋(84)를 수신하는 단계는, 시스템(10)의 모션 센서(18), 다른 자발적 인풋들, 비자발적 인풋들 또는 인풋들의 조합들에 의한 손 제스쳐의 감지를 포함할 수 있다.

3D 모델의 컴포넌트들

도 3은 3D 모델(20)을 뷰잉하는 개인(30)을 도시한다. 3D 모델(20)은 스캔 특징들 데이터(40) 및 증강 현실 데이터(50)에 기초하여 모델링된다. 3D 모델(20)은 대상 특징들(22) 및 제안된 치과 기구(24)를 포함한다. 대상 특징들(22)은 모델링된 궁(arches)(21) 및 모델링된 외부 특징들(23)을 포함한다. 인터페이스 내의 아이웨어-기반의 도 1의 3D 디스플레이(16)와 달리, 도 3의 3D 모델(20)은 아이웨어가 없이(absence) 기능하는 3-차원 프로젝터(예를 들어, 홀로그래픽 프로젝터, 무션 다스 홀로그램 Ltd,의 텔레프레즌스 시스템, 매직 리프의 디지털 라이트필드 시스템 등)로서 도시된다. 이러한 디스플레이들의 타입들 또는 임의의 다른 적합한 디스플레이는 3D 디스플레이(16)로서 이용될 수 있다.

스캔 특징들 데이터(40)는 궁(arches) 데이터(42), 관계 데이터(44) 및 외부 특징들 데이터(46)를 포함한다. 스캔 특징들 데이터(40)는, 예를 들어 내부구강(예를 들어, 도 33의 시스템(910)을 이용함으로써 획득되는), 광학 스캐너에 의해 개인(30)의 궁(arches)(32)을 스캔함으로써 획득되는 실증적인 데이터 및 외부구강 광학 스캐너(예를 들어 도 33의 시스템(910)을 이용하여 획득되는)에 의한 개인(30)의 외부 특징들(34)이다. 반면, 추가 스캔 특징들 데이터(40)는 특정한 포지션에 있어서 3D 모델(20)에 대한 추가적인 정교함을 제공할 수 있고, 3D 모델(20)은 초기-획득된 스캔 특징들 데이터(40)에만 기초하여 많은 포지션들에 대해 처리될 수 있다. 개인(30)의 외양이 3D 모델(20)에 의한 세션들 간에 많이 변화하지 않는 경우, 동일한 스캔 특징들 데이터(40)는 복수의 세션들에 걸쳐 적용될 수 있다. 스캔 특징들 데이터(40)는 광학 스캐너, 초음파 스캐너, 다른 적합한 스캐너 또는 외부 특징들(34)에 적용되는 다른 적합한 데이터 획득 테크닉으로부터 획득될 수 있다.

궁(arches) 데이터(42)는 개인(30)의 막실러리(maxillary) 및 만디불라 치과 궁(arches)의 모델링을 용이하게 하고, 모델링된 궁(arches)(21)을 제공한다.

외부 특징들 데이터(46)는 개인(30)의 외부 특징들(34)의 일부를 모델링하는 것을 용이하게 한다. 외부 특징들 데이터(46)의 양이 더 많을수록, 추가 외부 특징 데이터(예를 들어 도 16의 3D 모델(120)을 보라)가 부족한 3D 모델보다 상기 외부 특징들 얼굴 상의 에스테틱 효과들의 포괄적인(expansive) 관찰에 대응하여, 모델링 된 외부 특징들(23)이 더 많아진다(extensive). 궁(arches) 데이터(42), 관계 데이터(44) 및 외부 특징들 데이터(46)와 유사한 데이터를 획득하고 데이터 타입들에 기초한 모델을 준비하는 것은 본원과 발명자가 공통된 WO 2013/071435에서 더 논의된다. 데이터를 획득하기 위한 특징들은, 도 33, 35, 38 및 40에 각각 도시된 외부구강 스캐너들(992, 1092, 1192 또는 1392) 등이 포함될 수 있다.

관계 데이터(44)는 궁(arches)(32) 및 외부 특징들(34)(예를 들어 얼굴의 비율, 목의 비율 등)의 데이터를 포함한다. 관계 데이터(44)는 궁끼리(arches)(32)의 관계 및 외부 특징들(34) 및 궁(arches)(32) 간의 관계의 설정을 용이하게 한다. 궁(arches)(32)의 상대적인 포지션은 막실로만디불라 관계를 정의한다. 관계 데이터(44)는 외부 특징들(34)이 치열(25)에 기초하여 모델링되는 것에 더하여 궁(arches)(32)의 상대적인 포지션에 기초하여 모델링되도록 한다. 특정한 제안된 치과 기구(24)를 위한 교합에서 막실로만디불라 관계는 모델링된 외부 특징들(23)의 외양에 공헌한다. 교합에서 특정한 막실로만디불라 관계에 대한 특정한 제약, 치열(25)은 제안된 치과 기구(24)에 의한 교합에서 모델링된 외부 특징들(23)의 외양을 드라이빙(drive)할 것이다.

관계 데이터(44)도 3D 모델(20)의 막실로만디불라 관계가 외부 특징들(34)의 포지션에 기초하여 모델링되도록 한다. 제약들(constraints)은 모델링된 외부 특징들(23)이 어떻게 보이는지에 대해 플레이싱될(placed) 수 있다. 제안된 치과 기구(24)는 모델링된 외부 특징들(23)의 선택된 외양을 도출하기(result in) 위해 모델링될 것이다. 제약들도 교합 및 개인(30)에 대한 제안된 치과 기구(24)가 둘 모두 적절하도록 하는(results in) 정지 포지션에서 막실로만디 불라 관계를 담보하기 위해 제안된 치과 기구(24)에 적용될 수도 있다. 결과(resulting) 외양을 위해 선택된 모델링된 외부 특징들(23)은 외부 특징들 데이터(46)에 포함된 포지션으로부터 초래(result from)할 수 있거나 외부 특징들 데이터(46)에 포함된 포지션과 실질적으로 유사할 수 있다. 그러한 포지션의 실증 데이터는 치열(25) 및 개인(30)을 위해 바르게(correctly) 선택된 다른 특징들을 구비한, 제안된 치과 기구(24)를 제공하는 3D 모델(20)의 효과를 증가시킬 수 있다. 상기 정지 포지션은 실증 증거(evidence), 예를 들어 아래에 설명되고 본원과 발명자가 공통된 WO 2013/071435에 개시된, 에 의해 정의될 수 있고, 외부 특징들 데이터(46)는 정지 포지션에서 개인(30)의 실증 데이터를 포함할 수 있다. 시스템(1310)은 정지 포지션에서 실증 외부 특징들 데이터(46)를 획득하는 것을 용이하게 하기 위한 특징들을 포함한다.

관계 데이터(44)는 2개의 모델링된 궁(arches), 및 모델링된 궁(arches)(21) 및 모델링된 외부 특징들(23) 간의 정확한 관계를 유지하는 동안 3D 모델(20) 내의 막실로만디불라 관계의 처리를 용이하게 한다. 상기 관계는 궁(arches)(32)끼리의 관계, 및 궁(arches)(32) 및 외부 특징들(34) 간의 대응되는 관계를 반영하는 관계에 따르는(conform) 3D 모델(20)이라는 점에서 정확하다.

증강 현실 데이터(50)는 제안된 치과 기구(24)의 리프리젠테이션을 포함한다. 도시된, 제안된 치과 기구(24)는 한 쌍의 틀니들이다. 다른 기구들(예를 들어 싱글(single) 틀니, 보철, 리스토레이션 등)도 모델링될 수 있다. 제안된 치과 기구(24)는 증강 현실 데이터(50) 및 모델링된 궁(arches)(21) 상의 중첩(overlaid)에 기초하여 모델링된다. 제안 치과 기구(24)는 제안된 치과 기구(24) 상의 치열(25)에 의해 용이하게 되는 지상돌기접착(interdigitation)에서 모델링된 궁(arches)(21)들 간의 막실로만디불라 관계를 야기한다(result in). 막실로만디불라 관계, 모델링된 궁(arches)(21)의 결과(resulting) 로케이션들 및 모델링된 외부 특징들(23)은 외부 특징들(34) 상의 궁(arches)(32) 간의 막실로만디불라 관계의 3D 모델(20) 효과들 내에 리프리젠트하기 위한 스캔 특징들 데이터에 의해 통지(informed)된다.

제안된 치과 기구(24)는 개인(30)을 위해 적절히 정의된 막실로만디불라 관계(예를 들어, 적절한 교합 및 정지 포지션 등) 및 바이트 포지션으로부터 이동 방향을 정의하는 컨듈라(condular) 각도에 기초한다. 제안된 치과 기구(24)를 AR로 실시간 모델링하는 경우, 확인(verification) 절차는, 3D 모델(20)이 개인(30)의 관찰된 이동에 맞추어 조정하기 위한 제안된 막실로만디불라 관계 포지션을 정확하게 모델링하는 것이 용이하도록 할 수 있다. 치과 기구를 착용하지 않고, 개인은 그들의 턱(예를 들어 일반적인 저작(chewing) 기능 등)을 움직인다. 관찰된 데이터는 3D 모델(20)과 비교될 수 있고, 불일치가 발견되면, 3D 모델(20)의 이동을 개인(30)의 관찰된 이동들과 비교할 경우 유용한 랜드마크(landmarks)로서 막실로만디불라 교합 포지션 또는 컨듈라 각도들에 의해3D 모델(20)이 교정될 수 있다. 확인 절차는 외부 특징 데이터(46)에 기초할 수 있다. 확인 절차는 시스템(910), 예를 들어 시스템(910)(도 33), 시스템(1010)(도 35), 시스템(1110)(도 37), 시스템(1310)(도 40) 등, 을 이용하여 획득된 추가 외부 특징 데이터(46)에 기초할 수도 있다.

3D 모델의 처리

시스템(10)은 비전문가일 수 있는 개인(30)에 의한 3D 모델링(20)의 직관적인 처리를 용이하게 한다. 처리는 3D 모델(20)의 관점(perspective)을 변화시키는 것을 포함할 수 있다. 처리는 대상 특징들(22)의 포지션을 변화시키는 단계, 제안된 치과 기구(24)를 변경시키는 단계, 근본적인(underlying) 외부 특징 데이터(46)를 변화시키는 단계 또는 특히 모델링된 외부 특징들(23)에 관한, 3D 모델(20)의 에스테틱 상의 결과(resulting) 효과들을 관찰하기 용이하도록 하기 위해 근본적인 증강 현실 데이터(50)를 변화시키는 단계를 포함할 수 있다. 제약들은 교합인 막실로만디불라 포지션, 정지 포지션에 있는 치열(25)의 스페이싱(spacing)(25), 모델링된 외부 특징들(23)의 외양, 이러한 특징들의 조합들 또는 제안된 치과 기구(24)를 디자인하는 목표에 따른 다른 적절한 특징들에 적용될 수 있다.

정지 포지션에서 치열(25)의 스페이싱에 제약들을 적용할 경우, 1 내지 4 미리미터의 프리웨이 공간, 예를 들어 2 미리미터, 이 정의될 수 있다. 상기 프리웨이 스페이스는 정지 포지션에서 제안된 치과 기구의 상위 부분 및 하위 부분의 치열(25) 간의 클리어런스(clearance)이다. 과도하거나 불충분한 프리웨이 공간은 각각 표정 외양들을 왜곡(distort)시킨다. 과도한 프리웨이 공간("오버-클로즈드")는 만디블(mandible) 및 입술들이 돌출되고 '충돌' 또는 '찌푸린' 외양을 갖도록 야기한다. 불충분한 프리웨이 공간("오버-오픈드(over-opened)")는 얼굴이 길쭉해지도록(elongate) 하고, 이것은 입술들이 가늘고 늘어난 것처럼 보이게 하고 얼굴이 일반적인 불편한 룩(look)을 갖도록 한다. 이것은 그것들이 적절한 차원(dimension)에 가까운 시도에 관여(engaged)되어 바쁘므로 쉴 수 없는 얼굴 근육들의 압박(strain)에 기인한다. 개인이 오버-오픈드 또는 오버-클로즈드(over-closed) 상태인 경우, 상기 제시된 방법들 및 시스템들은 기대되는 외부 외양 및 적절한 정지 포지션 및 교합 포지션을 달성하기 위해 막실로만디불라 관계를 어떻게 변화하는지 결정하기 위해 이용될 것이다.

도 4는 막실로만디불라 관계와 다른 업데이트된 3D 모델(20a)를 도시한다. 업데이트된 3D(20a)는 대상 특징들(22)의 처리로부터 이루어진다(result from). 다른 막실로만디불라 관계는 모델링된 외부 특징들(23)의 리포지셔닝, 리포지셔닝된 모델링된 외부 특징들(23a)(그리고 유사하게, 대상 특징들(22)은 리포지셔닝된 대상 특징들(22a)로 리포지셔닝됨)을 제공할 수 있다. 3D 모델(20)의 막실로만디불라 관계는, 제스쳐들 또는 3D 디스플레이(16) 상에 디스플레이 되고 모션 센서(18)에 의해 감지되는 것으로서 3D 모델(20)에 있는 다른 디렉티드(directed) 인풋의 결과로서 처리될 수 있다. 관계 데이터(44)의 애플리케이션을 통해, 서로 관계되고 모델링된 외부 특징들(23)과 관계된 모델링된 궁(arches)(21)의 포지션들은 업데이트된 3D 모델(20a)에 대한 막실로만디불라 관계 내의 변화에 따른 3D 모델(20) 내에 업데이트될 수 있다.

도 5는 제안된 치과 기구(24)의 처리로부터 변형되는 치과 기구(24b) 결과(resulting)를 포함하고 증강 현실 데이터(50b)에 기초하여 모델링되는 업데이트된 모델(20b)을 도시한다. 변형된 치과 기구(24b)는 교합에서의 막실로만디불라 관계와 다른 제안된 치과 기구(24)를 발생시킬(result in) 수 있다. 다른 막실로만디불라 관계는 모델링된 외부 특징들(23)을 리포지셔닝하고, 리포지션된 모델링된 외부 특징들(23b)(그리고 유사하게, 대상 특징들(22)이 대상 특징들(22b)에 리포지션된다.)을 제공할 수 있다. 또한, 변형된 치과 기구(24b)는 교합에서 제안된 치과 기구(24)로서 동일한 막실로만디불라 관계를 가질 수 있으나 포지션들 및 리포지션된 모델링된 외부 특징들(23b)을 제공하는 모델링된 외부 특징들(23)의 외양들을 다르게 할 수 있다. 크기, 방향, 형태, 색상, 톤(tone) 및 제안된 치과 기구(24)의 임의의 다른 적절한 특징들 및 그것의 컴포넌트들도 변형된 치과 기구(24b)를 제공하기 위해 업데이트될 수 있다. 치열(25) 또는 제안된 치과 기구(24)의 다른 특징들에 대한 구조적인 변화들은 막실로만디불라 관계가 정지 포지션, 교합 포지션 또는 제안된 치과 기구(24)에 대한 다음의 변화들에 따른 다른 선택된 참조 포인트 변화에 있다는 점에서 대상 특징들(22)에 영향을 줄 수 있다. 다른 특징들은 제안된 치과 기구(24) 및 모델링된 궁(arches)(21) 간의 인터페이스 또는 제안된 치과 기구(24)를 모델링된 궁(arches)(21) 상에 어떻게 시팅(sitting)할 지 결정하는 제안된 치과 기구(24)의 다른 실시예들을 포함할 수 있다. 모델링된 외부 특징들(23)은 모델링된 외부 특징들(23)의 선택된 포지션을 제공하거나 근사(approximate)하는 새로운 막실로만디불라 관계가 생기도록 처리될(result in) 수도 있다. 제안된 치과 기구(24)에 대한 변화들은 개인(30) 또는 제2 개인(예를 들어 도 30의 제2 개인(690) 등)에 의해 정의되는 미리 정해진 제한들에 의해 제약될 수 있다. 그러한 제약들은 전형적으로 생리학적으로 적절한 정지 포지션 또는 교합 포지션을 제공하는 것일 수 있다.

도 6은 3D 모델(20)과 직접 인터액팅하는 개인(30)을 도시한다. 개인(30)은 3D 디스플레이 상에 그려진 3D 모델(20)을 손으로 그리핑하는 것과 같이 제스쳐링한다. 모델링된 궁(arches)(21), 모델링된 외부 특징들(2) 및 제안된 치과 기구(24) 간의 막실로만디불라 관계는 각각 처리될 수 있고, 프로세서(12)에 의해 계산된 3D 모델(20) 상에 영향을 가져올 수 있다. 3D 모델(20)은 대상 특징들(22), 제안된 치과 기구들(24) 또는 그 둘 간의 차이점들을 설명하기 위해 업데이트된다. 개인(30)의 외부 특징들(34)의 대응되는 차이점들은 모델링된 외부 특징들(23) 및 대응되는 3D 모델(20)의 일부들에 의해 변화될 수 있다. 3D 모델(20)의 일부를 그리핑하는 단계 및 직관적인 제스쳐들로 3D 모델(20)을 처리하는 단계는, 모델링된 외부 특징들(23), 치열(25) 또는 3D 모델(20)의 다른 실시예들의 에스테틱들 상의 이러한 변화들의 영향들을 용이하게 비교할 수 있도록, 실시간으로 3D 모델을 업데이트한다.

모델(20)에 대해 저장된 포지션들(26)은 뷰잉을 위해 가용(available)할 수 있다. 저장된 포지션들(26)은 예를 들어, 저장된 얼굴 표정들(예를 들어, 미소들, 찡그림들 등)을 포함할 수 있다. 저장된 포지션들(26)에 있어서, 모델링된 궁(arches)(21)의 막실로만디불라 관계, 모델링된 외부 특징들(23) 또는 그 둘 모두는 저장된 포지션들(26)을 반영하기 위해 업데이트될 수 있다. 제안된 치과 기구(24)의 특징들 및 대응하는 증강 현실 데이터(50)은 저장된 포지션(26)으로부터 업데이트될 수 있고, 3D 모델(20) 내에 반영되는 개인(30)의 외부 특징들 상의 임의의 차이점을 발생시킬(resulting) 수 있다. 저장된 포지션들(26)은 치열(25)의 미리 정해진 크기들 및 포지션에 따라 커스텀(custom) 미소들, 예를 들어 유명 인사의 미소들 또는 개인(30)이 이전에 했던 미소를 반영하기 위해, 을 포함할 수 있다.

저장된 치과 기구들(27)은 3D 모델(20)을 포함하기 위해 가용할 수 있다. 개인(30)은 미리 어레인지된 저장된 치과 기구들(27) 중에서 선택할 수 있고, 저장된 치과 기구들(27)에 대해 커스텀 변경(alterations)을 만들 수 있다. 또한, 치아 셰이드(shade)는 셰이드 셀렉터(29)와 함께 변화할 수 있다. 새로운 저장된 치과 기구(27)는 다른 저장된 포지션들(26)에서 다른 저장된 치과 기구들(27)의 상대적인 에스테틱들을 관찰하기 용이하도록 저장된 포지션(26)의 선택 전 또는 후에 선택될 수 있다.

3D 모델이 처리되는 경우 도 2의 방법(80)이 적용된다. 모션 센서(18)로부터 제1 인풋 데이터(60)를 수신함에 대응하여, 프로세서(12)는 제1 인풋 데이터(60)이 3D 모델(20), 증강 현실 데이터(50) 또는 외부 특징 데이터(46)의 업데이트를 발생시키는지 여부를 평가한다. 궁(arches) 데이터(42) 및 상대 데이터(44)는 상수를 유지할 것이다.

도 6에 도시된 것과 같이 3D 모델을 그리핑하는 것 외에, 다른 손 제스쳐들이 모델 (20)을 처리하기 위해 이용될 수 있다.

도 7 및 도 8은 손(39)으로 모델(20)을 접촉함 없이 개인(30)이 모델(20)을 처리하는 것을 도시한다. 도 8에서, 3D 모델(20)의 제안된 치과 기구(24)의 일부만이 도시된다. 이러한 방식으로, 치열(25) 및 다른 제안된 치과 기구(24)의 다른 실시예들은 대상 특징들(22)에 의한 방해로부터 자유로워지도록(free of obstruction) 업데이트될 수 있다. 치열(25) 또는 제안된 치과 기구(24)의 다른 특징들에 대한 변화들이 완성되면, 대상 특징들(22)은 모델링된 외부 특징들(23) 상에 제안된 치과 기구(24)에 대한 변화들의 효과들의 관찰을 용이하게 하기 위해 3D 디스플레이(16)에 디스플레이 되는 것으로서, 3D 모델(20)로 재도입(reintroduced)될 수 있다. 제안된 치과 기구(24) 및 대상 특징들(22)의 처리를 용이하게 하는 것 이외에도, 상기 시스템은 복수의 각도들, 줌 및 다른 각도에서의 변화들로부터 직관적인 뷰잉이 용이하도록 할 수 있다.

도 9 및 도 10은 각각 두 개의 손(39)를 함께 모아 줌 인하고 두 개의 손(39)을 벌려 줌 아웃하는 이동을 통해 모델(20)을 처리하는 개인(30)을 도시한다.

도 11은 손(39)의 로테이팅에 의한 3D 모델(20)을 로테이팅하는 개인(30)을 도시한다.

도 12 및 도 13은 각각 3D 모델(20) 상에 싱글 치아(28)를 그리핑하고 손(39)이 싱글 치아(28)를 늘리거나 압축하는 것과 같이 이동함으로써 싱글 치아를 인라징(enlarging)하고 쉬링킹(shrinking)하는 개인(30)을 도시한다. 싱글 치아(28)를 인라징하는 것은 인라징된 싱글 치아(28c), 대응되는 변형된 치과 기구(24c) 및 업데이트된 3D 모델(20c)를 발생시킨다. 유사하게, 싱글 치아(28)를 쉬링킹하는 것은 축소된 싱글 치아(28d), 대응하는 변형된 치과 기구(24d) 및 업데이트된 3D 모델(20d)을 발생시킨다.

도 14 및 도 15는 각각 도 12 및 도 13과 유사하지만 3D 모델(20)을 그리핑하는 것을 포함하지는 않는 손 제스쳐들에 의해 싱글 치아(28)을 인라징하고 쉬링킹하는 개인(30)을 도시한다.

개인(30)은 치아 형태, 크기, 셰이드 및 제안된 치과 기구(24)의 포지션을 변화할 수 있고 모델링된 외부 특징들(23) 및 전부 실시간으로서 3D 모델(20) 상에 변화가 발생하는(resulting) 것을 관찰할 수 있다. 3D 모델(20)은 임의의 각도 또는 포지션으로부터 뷰잉될 수 있고, 다양한 각도들로부터 3D 모델(20)에 대한 변화들의 관찰을 용이하게 할 수 있다. 3D 모델(20)은 제1 얼굴 표정, 업데이트된 얼굴 표정을 업데이트하기 위한 얼굴 표정 및 그에 따라 업데이트되는 3D 모델(20)의 외부 특징들(23)과 함께 뷰잉될 수 있다. 업데이트된 얼굴 표정은, 예를 들어 저장된 포지션들(26)으로부터 선택될 수 있고, 3D 모델(20)의 개인 특징들(22)을 처리함으로써 준비되거나 획득되는 추가 외부 특징들 데이터(46)에 기초하여 (예를 들어 도 33, 35, 38 및 40에 각각 도시된 외부 구강 스캐너들(992, 1092, 1192 또는 1392)에 의해)준비될 수 있다. 제안된 치과 기구(24) 상의 치열(25)의 포지션들은 바이트가 기능적 제한들을 벗어나게 어레인지 되지 않도록 하기 위해, 선택된 바이트를 유지하기 위해 선택되는 미리 정해진 파라미터들 내로 제한된다.

3D 모델 내에 포함된 데이터

도 16은 외부 특징 데이터(46)가 부족한 스캔 특징들 데이터(40) 및 모델링된 외부 특징들(23)이 부족한 3D 모델(120)이 있는 시스템을 도시한다. 스캔 특징들 데이터(140)는 궁(arches) 데이터(142) 및 관계 데이터(144)만을 포함한다.

도 17은 상기 3D 모델(220)이 개인의 틀니들(238)을 모델링하기 위한 틀니 데이터(24)을 포함하는 시스템을 도시한다. 틀니 데이터(248)는 개인(230)의 현재 틀니(238)를 반영하고, 예를 들어 도 33의 시스템(910) 내에 포함된 외부구강 광학 스캐너(992)에 의해, 개인(230)의 현재 틀니들(238)을 스캐닝함으로써 획득될 수 있다. 증강 현실 데이터(252)는 치과 데이터(248) 상의 일부에 기초한다. 틀니 데이터(248)는 3D 모델(220) 내의 리뷰 및 변형을 위한 제안된 치과 기구(224)를 프리젠팅함으로써 개인(230)에 대한 틀니들을 재디자인(redesign) 하기 위한 스타팅 포인트로서 증강 현실 데이터(252)를 통지할 수 있다. 상기 개인이 한 쌍 이상의 현재 틀니들을 가지고 있는 경우, 한 세트의 틀니 데이터(248) 이상의 것들이 획득될 수 있고, 대응되는 증강 현실 데이터(252)의 세트들의 수가 제공될 수 있다. 시스템(10)에 의해, 제안된 치과 기구(224)는 근본적인 증강 현실 데이터(252)를 변경하지 않고 3D 모델의 처리를 통해 변형될 수 있다. 제안된 치과 기구(224)의 교합에서 막실로만디불라 관계는 개인의 현재 틀니들(238)과 동일할 수 있거나 개인의 현재 틀니들(238)로부터 변형될 수 있다(예를 들어 정지 포지션에서의 치열(225) 간의 적절한 스페이싱을 제공하기 위해).

도 18은 부분적인 치열(336)을 갖는 개인(330)을 포함하는 시스템(310)을 도시한다. 3D 모델(320)은 부분적으로 덴테이팅한 궁(arches) 데이터(343)에 리프리젠팅되는, 부분적인 치열(336)의 리프리젠테이션을 포함한다. 증강 현실 데이터(350)는 제안된 치과 기구(324)가 부분적으로 덴테이팅한 궁 데이터(343) 내에 도시된 것과 같이 부분적인 치열(336)의 존재를 고려하도록 준비하는데 이용된다.

뇌-컴퓨터 인터페이스

도 19는 3D 모델(420)을 디스플레이하고 처리하기 위한 시스템(410)이다.

도 20은 시스템(410) 및 3D 모델(420)을 준비하는데 이용되는 데이터(440, 450)을 도시한다.

시스템(410)은 프로세서(412), 컴퓨터로 읽기 가능한 매체(414) 및 3D 디스플레이(416)을 포함한다. 개인(430)은 뇌-컴퓨터 인터페이스("BCI")(419)의 이용을 통해 3D 모델(420)과 상호작용한다. BCI(419)는 신경 활동 데이터(466)의 인풋을 수신하기 위한 신경 활동을 나타내는 개인(430)의 뇌의 속성을 모니터링한다. BCI(419)로서 이용될 수 있는 BCI 시스템들의 현재의 실시예들은, 뇌파전위기록(electroencephalography, EEG) 및 뇌의 전자적 활동을 모니터링에 기초한, Emotive에 의해 제조되는 EPOC/EPOC+ systems 및 NeuroSky에 의해 제조되는 MindWave system을 포함할 수 있다. BCI(419)는 개인(430)에 의해 실시간으로 이용되는 것을 지원하는 임의의 적합한 BCI를 포함할 수 있고, EEC를 적용하는 BCI에 제한되지 않는다. 뇌 내의 혈류(blood flow)를 모니터링하는 기능적 자기 공명 이미징 및, 뇌의 전자적 활동으로부터 마그네틱 필드 결과(resulting)를 모니터링하는 마그네토 뇌파전위기록은 신경 활동 데이터(466)의 인풋을 수신하기 위한 BCI(419) 내에 이용될 수도 있다.

BCI(419)는 모션 센서, 오디오 센서 또는, 액션 또는 3D 모델(420)에 대한 변화의 멘탈 개념화의 개인(30) 다운스트림의 액션들에 기초할 필요 없이 3D 모델(420)의 즉각적인 업데이트를 용이하게 한다. 또한, 깜빡임, 윙크 및 미소와 같은 얼굴 표정들은 BCI(419)에 의한 인풋들로서 수신될 수 있고, 모델링된 외부 특징들(423)을 업데이트하기 위해 이용될 수 있는 신경 활동을 발생시킨다. 모델링된 외부 특징들에 대한 그러한 업데이트들은 저장된 포지션(426) 또는 모델링된 외부 특징들(423)의 포지션들에 대한 다른 변형들 또는 외부 특징 데이터(446)의 획득을 통한 것일 수 있다(예를 들어, 도 35의 시스템(1010) 또는 도 37의 시스템(1110)과 같음). 개인(420)에 의해 실질적으로 발생하는(taken) 액션은 개인이 BCI(419)의 이용에 익숙하지 않을 경우 시스템(410)의 이용을 용이하게 하는 액션의 개념화를 포함할 수 있다.

신경 활동 데이터(466)의 인풋들은, 프로세서(412)에 제공되는, 개인(430)으로부터 맨탈 커맨드들과 대응하는 자발적 액션 데이터(462)를 포함할 수 있다. 특정한 BCI(419) 및 프로세서(412)가 필요한 정도로 개인(430)에게 캘리브레이팅 된 경우, 신경 활동 데이터(466)은 생각들(물리적으로 만들어지는 제스쳐들을 포함하는), 개념화된 제스쳐들, 3D 모델(420)에 대한 개념화된 변화들 또는, 3D 모델(420)에 관해 발생할 수 있는 액션들과 연관된 개인(430)의 멘탈 또는 감정 활동과 대응되는 자발적 액션 데이터(462)를 포함한다.

자발적 액션 데이터(462)는 모션, 로케이션, 포지션 및 개인(430)에 의해 정신적으로 개념화되는 개인(430)의 제스쳐들의 각도와 대응될 수 있다(예를 들어, 인풋들은 개인(430)이 로테이트, 팬(pan), 줌 인 및 3D 모델(420) 상에 노광 조건들을 변화시키도록 하는 공통적이고 직관적인 일련의 개념화된 손 제스쳐와 대응될 수 있다). 개인(430)에 의해 개념화될 수 있고 3D 모델(420)에 대한 결과(resulting) 처리들은 제안된 치과 기구(24)를 처리하기 위해 이용되는 손 제스쳐들을 포함할 수 있거나 도 6 내지 도 15에 도시된 모델(20) 상의 관점에서 시스템(10)을 이용하는 경우, 시스템(410)이 있다 하더라도 제스쳐들은 단지 개념화되거나 개인(430)에 의해 상상(imagine)될 수 있다.

시스템은, 시스템(10) 및 모션 센서들 및 BCI(도시되지 않음) 모두에 의해 시스템을 제공하는 시스템(410)의 특징들을 결합하도록 준비될 수 있다. 모션 센서들 및 BCI로부터의 인풋은 가중치가 다르게 부여될 수 있다. 또한, 모션 센서 인풋은 그러한 시스템을 이용하는 개인에 대해 BCI를 캘리브레이팅하기 위해 이용될 수 있다.

도 21 내지 도 27은 변화들의 결과를 개념화함으로써 모델(420)을 처리하고, 실질 제스쳐들 또는 개념화된 제스쳐들이 없는(absence) BCI(419)에 의해 수신되는 자발적 액션 데이터(462)를 발생시키는(resulting in) 개인(430)을 도시한다.

도 21은 저장된 포지션들(426) 중 하나에 대한 변화의 개념화 또는 저장된 포지션들(426) 중 하나에 대한 개념화에 의해 모델(420)을 처리하는 개인(430)을 도시한다.

도 22는 제안된 치과 기구(424) 내의 치아의 색상 및 셰이드 내의 변화들을 개념화함으로써 3D 모델(420)을 처리하는 개인(430)을 도시한다. 도 22에서는, 모델(420)의 제안된 치과 기구(424) 일부가 도시된다. 저장된 치과 기구들(427) 중의 하나에 대한 선택에 동일한 접근법이 적용된다. 3D 디스플레이(416)는 저장된 포지션들(426), 저장된 치과 기구들(427) 및 포커싱 하기 위해 개인(430)에 대한 셰이드 셀렉터(429)를 보여줄 수 있는, 자발적 액션 데이터(462)를 통해 변화할 수 있다. 대안으로서, 이러한 특징들은 3D 디스플레이(416) 상의 디스플레이로부터 누락(omit)될 수 있고, 개인은 저장된 포지션(426), 저장된 치과 기구(427)만을 개념화할 필요가 있고, 또는 개인(430)이 3D 모델(420) 상에 디스플레이되는 것을 보기 원하는 셰이드 내에 변화시킬 수 있다.

도 23 내지 도 25는 각각 줌 인, 줌 아웃 및 3D 모델(420)을 로테이팅하는 개념화를 통해 모델(420)을 처리하는 개인(430)을 도시한다.

도 26 및 도 27은 싱글 치아(428)의 셀렉션 및 싱글 치아(428)의 크기 변화들을 개념화를함으로써 각각 싱글 치아(428)를 확대하고 축소하는 개인(430)을 도시한다.

비자발적 반응 데이터

도 28은 감정들, 리액션들 또는 개인(530)의 비자발적 반응 데이터(564)를 제공하는 개인(530)의 비자발적 반응들과 대응되는 신경 활동 데이터(566)의 인풋들을 수신하는 BCI(519)를 포함하는 시스템(510)을 도시한다. 비자발적 반응 데이터(562)에 대한 참조 및 캘리브레이션에 따라, BCI(519)는 제안된 치과 기구(524)에 관한 개인(530)의 선호들(preferences)을 예측하는 것을 차례로(in turn) 용이하도록 할 수 있는, 감정 상태들 및 개인(530)의 리액션들의 평가를 용이하게 한다.

BCI(519)는 자발적 액션 데이터(562) 또는 비자발적 반응 데이터(564)로서, 개인(530)의 얼굴 표정들과 대응되는 인풋들을 수신하는 것을 용이하게 한다. 개인(530)은 실제로 미소 지을 필요 없고, 그 외 3D 모델(520)로 업데이트하는 것을 트리거링하기 위한 얼굴 표정을 변화시킬 필요가 없다. BCI(519)에 의해 감지되는 개념화된 손 제스쳐 인풋들의 신경 활동 데이터(566)로서, 개념화할 필요만이 있는 얼굴 표정들과 대응되는 신경 활동 데이터(566)는 자발적 얼굴 표정들의 자발적 액션 데이터(562)인지 비자발적 얼굴 표정들의 비자발적 반응 데이터(564)인지만을 판단할 필요가 있다.. 얼굴 표정들은 신경근 접합부(neuromuscular junction)에 대한 모터 뉴런(neurons)을 통해 트래벌링(traveling)하는, 뇌 안의 신경 임펄스들로 비롯된다. 적당한(adequate) 자극에 따라, 모터 뉴런은 포스트시냅틱(postsynaptic) 리셉터들에 대해 블라인드 된 신경전달물질의 홍수를 릴리즈(release)하고 근육 이동을 발생시키는 근섬유 내의 반응을 트리거링 한다. BCI(519)는 감정들 또는 다른 요소들(예를 들어 유명 인사의 미소, 자발적이거나 비자발적인 특정한 얼굴 표정을 채택 또는 개념화 등)에 기초하여 3D 모델(520)의 즉각적이고도 직관적인 변화를 용이하게 한다.

외부 특징 데이터(546)는 프로세서(512)에 의해 BCI(519)로부터의 신경 활동 데이터(566)과 상호 연관되는 실증 광학 이미지 데이터를 포함할 수 있다. 3D 모델(520)는 신경 활동 데이터(566)(예를 들어 미소, 찡그림, 눈 감기 등)에 대한 반응으로 실시간으로 업데이트될 수 있다. 예를 들어, 3D 모델(520)는 미소 짓고 상기 미소로부터 신경 활동 데이터(566)을 생성(자발적 액션 데이터(562)인지 비자발적 반응 데이터(564)인지 여부)하는 개인(530)에 대한 반응으로 미소와 대응되는 저장된 포지션(526)을 추정하도록 업데이트될 수 있다. 외부 특징 데이터(546)가 이미 외부 특징들(534)에 기초하여 획득된 경우, 얼굴 표정 또는 BCI(519)로부터 기초한 다른 업데이트는 특정한 미소 또는 개인(520)이 현재 만드는 것과 반드시(necessarily) 대응될 필요가 없다. 오히려, 3D 모델(520)에 대한 업데이트는 관련된(relevant) 커맨드(예를 들어 미소, 찡그림, 눈 감기 등)와 대응되는 이미 획득된 스캔 특징들 데이터(540)에 기초할 수 있다. 이미 획득된 스캔 특징들 데이터(540)는 저장된 포지션들(526)과 함께 포함될 수 있다. 도 35의 시스템(1010) 및 도 36의 시스템(1110)은 시스템들의 이용 중 외부 특징들 데이터에 대한 추가 데이터의 추가를 위한 외부구강 광학 스캐너들을 포함한다.

프로세서(512)는 제안된 치과 기구(524)(치아 형태 및 크기, 어레인지먼트, 셰이드, 결함 등)의 다른 가상의 치아 디자인 구성요소들과 대응되는 비자발적 반응 데이터(564)를 평가하고 수량(quantify)화하도록 프로그래밍될 수 있다. 증강 현실 데이터(550)는 비자발적 반응 데이터(562)에 기초하여 개인(530)에 대한 특정한 선호들의 계층(hierarchical) 순서 내에 조직될 수 있다. 선호들의 순서는 개인(530)의 감정 상태 또는 개인(530)(또는 다른 개인, 예를 들어 제2 개인(690), 제2 개인(790), 제2 개인(890) 등)으로부터의 자발적인 인풋 등의 선호 기준에 기초할 수 있다. 감정 상태에 기초한 선호 기준은 비자발적 반응 데이터(564)를 개인(530)으로부터 정의된 감정 반응을 이끌어내는(elicits) 것으로서의 3D 모델(520)인지 여부를 결정하기 위한 감정적인 상태와 동일시한다. 상기 반응은 바이너리(binary) 또는 아래 설명된 것과 같은, 비자발적 반응 데이터(564)에 적용될 수 있는 통계적인 모델들과 연관된 뉘앙스(nuanced)일 수 있다. 개인(530)으로부터의 자발적 인풋에 기초한 선호 기준은 가이드라인들 및 시스템(510)의 유저에 의해 자발적으로 선택된 제약들(constraints)에 반하여(against) 비자발적 반응 데이터(564)를 측정한다(예를 들어, 특정한 폭을 초과할 수 없는 치열(525), 앞니의 공간, 오버바이트 필요성, 언더바이트 필요성 등). 상기 가이드라인들은 개인(530) 또는 다른 개인(예를 들어 제2 개인(690), 제2 개인(790), 제2 개인(890) 등)에 의해 적용될 수 있다.

비자발적 반응 데이터(564)는 통계적 모델(예를 들어 오디널(ordinal) 유틸리티 기능이 평가되거나 인터벌 선호 데이터가 통계적으로 개발될 수 있는 컴포넌트 유틸리티 파트-가치 기능들의 평가의 제공에 적용될 수 있다)에 피팅(fit)될 수 있다. 프로세서(512)는 저장된 치과 기구(527)를 선택하거나 제안된 치과 기구(524)를 변형함으로써, 개인(530)에 의해 승인된 더 높은 확률을 가진 제안된 치과 기구(524)를 추천하기 위한 통계적 모델을 이용할 수 있다. 비자발적 반응 데이터(564)는 제안된 치과 기구(524)의 다른 어레인지먼트들에 대한 개인(530)의 리액션들의 평가 및 개인(530)의 선호들의 계량(quantification)을 용이하게 할 수 있다. 통계적 모델은 모델과 같거나/다르게 심플할 수 있고, 주지(예를 들어 효과적인 광고를 준비하기 위한 애플리케이션들 등)의 것으로서, 규모(magnitude)를 다르게 하고 요소들에 가중치를 부여하는 다양한 타입의 반응(예를 들어, 향수(nostalgia), 행복, 자신감, 흥미로움, 무관심, 역겨움 등)들을 포함할 수 있다.

시스템(410)으로서, 시스템은 시스템(10) 및, 모션 센서들 및 비자발적 반응 데이터의 인풋들과 반응하는(도시되지 않음) BCI 모두를 구비한 시스템을 제공하는, 시스템(510)의 특징들을 조합하도록 준비될 수 있다. 모션 센서들 및 BCI들로부터의 인풋은 가중치가 다르게 부여될 수 있다. 또한, 모션 센서 인풋은 BCI를 그러한 시스템을 이용하는 개인에 대해 캘리브레이팅 하는데 이용될 수 있다. 유사하게, 시스템은 시스템(510) 및, BCI 및 광학 또는 비자발적 반응 데이터(도시되지 않음)의 인풋들과 반응하는 다른 센서 모두로부터의 비자발적 반응 데이터의 2 개의 스트림들을 구비한 시스템을 제공하는, 시스템(1210)의 특징들을 조합하는 것이 준비될 수 있다. 그러한 시스템은, 상기 시스템을 이용하는 특정한 개인에 대해 비자발적 반응 데이터의 감지를 캘리브레이팅하기 위한 교차(cross)-체크를 제공할 것이다.

도 29는 자발적 액션 데이터 인풋들 및 비자발적 반응 데이터 인풋들(예를 들어 3D 모델(520), 3D 모델(620), 3D 모델(1220) 등) 모두를 이용하는 3D 모델로 동작(working with)하는 방법(180)을 도시한다. 방법(180)은 3D 모델(182)를 디스플레잉 하는 단계, 자발적 액션 데이터(183)의 인풋을 수신하는 단계 및 자발적 액션 데이터(183)의 인풋 수신에 반응하여 3D 모델(186)을 업데이트하는 단계를 포함한다. 방법(180)은 비자발적 반응 데이터(185)의 인풋을 수신하는 단계 및 비자발적 반응 데이터(187)에 기초하여 디스플레이되는 것으로서의 현재 3D 모델을 랭킹하는 단계를 포함한다. 3D 모델이 비자발적 반응 데이터(187)에 기초하여 디스플레이되는 것과 같이, 3D 모델의 랭킹이 완료되면, 방법(180)은 더 포지티브한 비자발적 반응(188)을 이끌어 낼 수 있는 3D 모델에 대한 변화들인지 여부를 평가하는 알고리즘을 적용한다. 상기 알고리즘이 3D 모델에 대한 변화들이 비자발적 반응 데이터(185)의 인풋을 수신함으로써 발생하는 데이터보다 더 포지티브한 비자발적 반응을 이끌어내지 못한다고 알리는 경우, 방법(180)은 자발적 액션 데이터(183)의 인풋을 수신하거나 비자발적 반응 데이터(185)의 인풋을 수신함으로부터 발생(occur)하는 데이터보다 3D 모델(182)을 디스플레이하는 단계로 되돌아간다.

3D 모델에 대한 변화를 나타내는 상기 알고리즘이 비자발적 반응 데이터(185)의 인풋을 수신함으로써 기인한(resulting from) 데이터에 비해 더 포지티브한 비자발적 반응을 이끌어내는 경우, 상기 방법은 비자발적 반응 데이터(185)의 인풋을 수신함에 따라 3D 모델(186)을 업데이트하는 단계로 진행한다. 이런 경우, 3D 모델(186)을 업데이트 하는 단계는 비자발적 반응 데이터(185)의 인풋을 수신함으로써 발생한(resulting from) 데이터에 비해 더 포지티브한 비자발적 반응을 이끌어 낼 수 있는 변화들을 적용한다. 비자발적 반응 데이터(185)의 인풋을 수신함에 따라 3D 모델(186)을 업데이트하는 단계는, 3D 모델(186)의 유저 승인 업데이트를 조건으로(subject to)할 수 있거나 3D 모델에 대한 변화들이 더 포지티브한 비자발적 반응(188)을 이끌어 내기 위한 변화들인지 여부를 결정함에 있어 자동적으로 발생할 수 있다. 단계(180)는, 시스템(510)의 컴퓨터로 읽을 수 있는 매체(514)에 저장된 데이터를 참조하고, 시스템(610) 및 시스템(1210)과 대응되는 특징들 또는 비자발적 반응 데이터들을 감지하기 위한 센서들을 포함하는 임의의 시스템을 구비한, 프로세서(512)를 이용하여 수행될 수 있다.

비자발적 인풋(185)를 수신하는 단계는 BCI, 광학 스캐너, 동공(pupil) 팽창, 펄스 및 감정 상태를 평가하기 위한 다른 요소들, 그러한 센서들을 조합한 폴리그래프 센서로부터 또는 감정 상태 및 비자발적 인풋을 제공하는 개인의 선호들을 측정하기 위해 적합한 임의의 다른 적합한 접근법으로부터일 수 있다.

방법(180)의 애플리케이션에 있어서, 개인(30)은, 예를 들어, 좌측 보다 그들의 미소의 우측에 더 좋은 리액션을 가질 수 있다. 임의의 구성요소들에 대한 개인(30)의 선호는 우측에 나타나지만, 좌측으로부터의 미싱(missing)이 랭크될 수 있고, 제안된 변경들(alterations)은 포지티브한 감정 리액션의 변화들을 증가를 제공하기 위한 제안된 치과 기구에 추천될 수 있다. 이러한 반응들은 바이너리 반응이거나 다른 옵션들에 비교되어 디스플레이 된 것과 같은 3D 모델과 같이, 개인(30)이 얼마나 3D 모델(20)을 좋아하는지에 대해 더 구체적인 것일 수 있고, 디자인 소프트웨어는 동일한 디자인, 제약들 및 다른 요소들 내에 공존할 수 없는 선호들, 디자인 구성요소들에 기초함을 포함하거나 배제시키는 디자인 구성요소들을 제시할 것이다.

방법(180)은 데이터의 품질에 따른다(예를 들어, BCI, 광학 감정 감지기, 폴리그래프 등). 적용 가능한 알고리즘은 오디널 유틸리티 기능 추정, 인터벌 선호 데이터(통계적으로-개발된 컴포넌트 유틸리티 파트-가치 기능들을 구비한) 등에 기초할 수 있다. BCI들의 발전은 모든 더 정확한 프리퍼런셜(preferential) 정보를 제공하기 위한 그러한 알고리즘들의 정확도를 증가시킬 것이다.

2개인들에

의한 이용

도 30은 BCI(619)에 관여하는(engaged with) 제2 비-대상 개인(690)을 포함하는 시스템(610)을 개시한다. BCI(619)는 제1 개인(630)으로부터 신경 활동 데이터(666)을 수신하고, 제2 개인(690)으로부터 제2 신경 활동 데이터(676)을 수신하거나, 모두 데이터를 수신한다. 신경 활동 데이터(666)는 자발적 액션 데이터(662), 비자발적 반응 데이터(664) 또는 모두를 포함할 수 있다. 제2 신경 활동 데이터(676)는 제2 자발적 액션 데이터(672), 제2 비자발적 반응 데이터(674) 또는 모두를 포함할 수 있다.

제2 자발적 액션 데이터(672) 및 제2 비자발적 반응 데이터(674)는 BCI(619)에 의해 수신될 수 있고, 멘탈 커맨드들, 감정 상태들, 리액션들 또는 제2 개인(690)의 다른 신경 활동으로서 적용될 수 있다. 대조적으로, 시스템(510)은 자발적 액션 데이터(562) 및 비자발적 반응 데이터(564)를 개인(530) 또는 비-대상 개인(도시되지 않음)으로부터만 수신할 수 있다. 그러나, 제2 개인(690)(예를 들어, 배우자, 파트너, 가족 구성원, 친구 등)의 의견(opinion)에 의한 동시(contemporaneous) 제어도 종종 가치가 있다. 프로세서(612)는 신경 활동 데이터(666), 제2 신경 활동 데이터(676) 또는 둘 모두에 대해 다르게 반응하는 다양한 방법들(manners)로 구성될 수 있다. 이러한 방식으로, 방법(180)은 자발적 액션 데이터(183)의 인풋을 수신하는 단계 및 비자발적 반응 데이터(185)의 인풋을 수신하는 단계가 제1 인풋 데이터(660) 및 제2 인풋 데이터(670) 간의 임의의 적절한 가중치를 가진 제1 인풋 데이터(660), 제2 인풋 데이터(670) 또는 둘 모두에 대해 각각 적용될 수 있다.

프로세서(612)는 자발적 액션 데이터(662) 및 제2 자발적 액션 데이터(672) 모두에 반응하도록 구성될 수 있고, 제안된 치과 기구(624)를 준비하는 경우, 비자발적 반응 데이터(664) 및 제2 비자발적 반응 데이터(674) 모두에 가중치를 부여할 수 있다. 이러한 구성은, 리액션들에 반응하여 제안된 치과 기구(624)의 랭킹, 개인(630) 및 제2 개인(690)에 의해 용이하게 될 것이다. 비자발적 반응 데이터(664) 및 제2 비자발적 반응 데이터(674)는 가중치가 다르게 부여될 수 있다.

프로세서(612)는 자발적 액션 데이터(662) 및 제2 자발적 액션 데이터(672) 모두에 대해 반응하도록 구성될 수 있으나, 제안된 치과 기구(624)를 준비하는 경우 비자발적 반응 데이터(664) 또는 제2 비자발적 반응 데이터(674)만이 가중치가 다르게 부여될 수 있다. 이러한 구성은 개인(630) 및 제2 개인(690) 모두에 의한 제어를 용이하게 할 것이지만, 제안들(suggestions)을 제공하고 개인(630) 또는 제2 개인(690) 중 하나만의 비자발적 반응들을 측정한다.

프로세서(612)는 자발적 액션 데이터(662) 또는 제2 자발적 액션 데이터(672) 중 하나에 대해서만 반응하도록 구성될 수 있으나,

비자발적 반응 데이터(664) 및 제2 비자발적 반응 데이터(674) 모두에 대해 가중치를 부여할 수 있다. 이러한 구성은 개인(630) 또는 제2 개인(690) 중 하나에 의해서만 제어되는 것을 용이하게 할 것이지만, 제안된 치과 기구(624)를 준비하는 경우, 개인(630) 및 제2 개인(690) 모두의 비자발적 반응들을 설명할 것이다. 비자발적 반응 데이터(664) 및 제2 비자발적 반응 데이터(674)는 다르게 가중치가 부여될 수 있다.

프로세서(612)는 제2 자발적 액션 데이터에만 반응하도록 구성될 수 있고, 제2 비자발적 반응 데이터(674)에만 가중치를 부여할 수 있다. 이러한 구성은 제2 개인(690)에 의한 제어를 용이하게 하고, 제2 비자발적 반응 데이터(674)만에 대한 참조에 의해 선택된 제안된 치과 기구(624)를 야기할 것이다(result in).

프로세서(612)는 자발적 액션 데이터(662)에 대해서만 반응하도록 구성될 수 있고, 제2 비자발적 반응 데이터(674)에 대해서만 가중치를 부여할 수 있다. 이러한 구성은 개인(630)만에 의한 제어를 용이하게 하고, 제2 비자발적 반응 데이터(674)만에 대한 참조에 의해 선택된 제안된 치과 기구를 발생시킬 것이다.

프로세서(612)는 제2 자발적 액션 데이터(672)에 대해서만 반응하도록 구성될 수 있고, 제2 비자발적 반응 데이터(664)에 대해서만 가중치를 부여할 수 있다. 이러한 구성은 제2 개인(690)만에 의한 제어를 용이하게 할 수 있고, 비자발적 반응 데이터(664)만에 대한 참조에 의해 선택된 제안된 치과 기구를 발생시킬 것이다.

도 31은 BCI(719)에게 각각 인풋을 제공하는 개인(730) 및 제2 개인(790)을 포함하는 시스템을 도시한다. 개인(730)은 3D 디스플레이 상에3D 모델(720)을 뷰잉하고, 제1 인풋 데이터(760)을 인풋함으로써 BCI(719)를 통해 3D 모델(720)을 처리한다. 개인(730)의 제2 3D 모델(791)은 제2 3D 디스플레이(717) 상에 제2 개인(790)에 대해 디스플레이 된다. 제2 개인(790)은 제2 3D 디스플레이(717) 상에 제2 3D 모델(791)을 뷰잉하고, 제2 인풋 데이터(770)를 인풋함으로써 BCI(719)를 통해 제2 3D 모델(791)을 처리한다. 3D 모델(720)에 관한 제1 인풋 데이터(760) 및 제2 3D 모델(791)에 관한 제2 인풋 데이터(770)의 애플리케이션은 본원의 다른 곳에서 설명된 것처럼 제각각일 수 있다. 개인(730)은 3D 모델(720)을 처리하기 위해 자발적 액션 데이터(762), 비자발적 반응 데이터(764) 또는 모두를 제공할 수 있다. 3D 모델(720)을 처리하는 개인과 유사하고 독립적으로, 제2 개인(790)은 제2 3D 모델(791)을 처리하기 위한 자발적 액션 데이터(772), 비자발적 반응 데이터(774) 또는 둘 모두를 제공할 수 있다. 대안적으로, 비자발적 반응 데이터(754)는 제2 3D 모델(791)에 대한 방법(180)과 유사한 방법에 적용될 수 있거나, 제2 비자발적 반응 데이터는 3D 모델(720)에 대해 적용될 수 있다.

도 32는 모션 센서(818)을 통해 3D 모델(820)와 각각 상호작용하는 개인(830) 및 제2 개인(890)을 포함하는 시스템(810)을 도시한다. 프로세서(812)는 개인(830) 및 제2 개인(890)이 3D 모델(820)과 상호작용을 자유롭게 하고, 개인(830) 및 제2 개인(890) 중 하나를 향해 바이어스(bias)하고, 제1 개인(830) 및 제2 개인(890)이 턴(turn) 또는 임의의 적합한 어레인지먼트를 취하도록 한다.

시스템은, 모션 센서들 및 개인 및 제2 개인(도시되지 않음) 중 하나 또는 둘 모두에 대한 BCI 모두를 구비한 시스템을 제공하는, 시스템(810) 및 시스템(610)의 특징들을 조합하도록 준비될 수 있다. 그러한 시스템은 시스템(710)과 유사하게, 분산(separate) 3D 모델들은 개인 및 제2 개인에 의해 디스플레이 되고 처리되도록 준비될 수도 있다.

스캔 특징 데이터의 획득

도 33은 스캔 특징들 데이터(940)를 획득하기 위한 컴퓨터로 읽기 가능한 매체(914)와 통신하는 스캐너들을 포함하는 시스템(910)을 도시한다. 내부구강 광학 스캐너(993)는 막실러리(maxillary) 및 만디불라 치열 궁(arches)(932)로부터 궁(arches) 데이터(942)를 획득하기 위한 것이다. 외부구강 광학 스캐너(992)는 막실러리 및 만디불라 치열 궁으로부터의 관계 데이터(994) 및 외부 특징들(934)를 획득하기 위한 것이다. 외부구강 광학 스캐너(992)는 외부 특징들(934)로부터의 외부 특징들 데이터(946)을 획득하기 위한 것이기도 하다. 시스템(910) 내에 스캐너들을 포함하는 것은, 스캔 특징들 데이터(940)을 획득하고 동일한 로케이션에서 3D 모델(920)을 이용하는 것을 용이하게 한다. 스캔 특징들 데이터(940)은 유선 연결, 무선 연결, 제거 가능한 매체의 전송 등을 이용하는 임의의 방법에 의해 외부구강 광학 스캐너(992) 및 내부구강 광학 스캐너(993)로부터 컴퓨터로 읽기 가능한 메모리(914)로 제공된다.

외부 특징들 데이터(946)는 틀니 또는 개인(930)의 구강 내의 다른 기구에 의하거나 의함 없이 획득될 수 있다. 틀니 또는 제안된 치과 기구(924)를 근사(approximates)하는 개인(930)의 구강 내의 다른 기구의 외부 특징들 데이터(946)를 획득하는 것은, 제안된 치과 기구(924)에 의해 영향 받는 것과 같이, 외부 특징들(934)의 모델링을 개선할 수 있다. 추가 외부 특징들 데이터(946)는 제안된 리스토레이션들의 모델링 정확도를 개선할 수 있다. 존재하는 틀니들 또는 바이트 림(rims)은, 다른 얼굴 표정들에서, 제안된 치과 기구(924) 및 모델링된 외부 특징들(923)의 결과 간의 관계를 개선하기 위해 외부 얼굴 데이터를 캡쳐하는 동안 구강 내에서 플레이싱될 수 있다. 임시 물질(temporary material)(예를 들어, 치과 왁스 등)은 기대되는 제안된 치과 기구(924)에 더 가까운 개선된 틀니로 근사(approximate)하기 위해 존재하는 틀니들에 추가될 수 있다.

도 34는 3D 모델을 디스플레이 하고 처리하기 위한 데이터를 획득하기 위한 방법(280)을 도시한다. 방법(280)은 스캔 특징 데이터(281)을 획득하는 단계, 3D 모델(282)를 디스플레이하는 단계, 인풋(284)을 수신하는 단계 및 인풋(284) 수신에 반응하여 3D 모델(286)을 업데이트하는 단계를 포함한다. 방법(280)은 시스템(910)을 이용하여 수행될 수 있다. 3D 모델(282)을 디스플레이하는 단계 및 3D 모델(286)을 업데이트하는 단계는 컴퓨터로 읽기 가능한 매체(914) 내에 저장된 스캔 특징들 데이터(281)을 획득하는 단계로부터의 데이터를 이용하는 프로세서(912)에 의한 인스트럭션들의 실행에 의해 3D 디스플레이(916) 상에 완성될 수 있다. 인풋(284)을 수신하는 단계는 시스템(910)의 모션 센서(918)에 의한 손 제스쳐, 다른 자발적 인풋들, 비자발적 인풋들 또는 인풋들의 조합들의 감지를 포함할 수 있다.

도 35는 외부 특징들 데이터(1046)을 업데이트하기 위한 외부구강 광학 스캐너(1092)를 포함하는 시스템을 도시한다. 외부구강 광학 스캐너(1092)는 도시된 바와 같이 단독(standalone) 유닛일 수 있거나, 3D 디스플레이(1016) 상의 바깥 방향-얼굴 이미징 센서로서 포함될 수 있다(예를 들어, Leap 또는 키넥트(Kinect) 카메라 시스템 및 프로젝팅 된 홀로그래피/중첩 구성요소 등). 외부구강 광학 스캐너(1092)는, 3D 모델(1020) 내에서 이용하기 위한 3D 모델(1020)이 추가 외부 특징들 데이터(1046)를 획득하기 위해 3D 모델(1020)이 처리되는 동안 이용될 수 있다.

도 36은 개인(30)이 다른 얼굴 표정을 채택(adopt)한다는 점에서 도 35의 외부 특징들(1034)와 외양 상 다른, 업데이트된 외부 특징들(1034e)을 갖는 포즈(pose) 내에 개인(1030)으로부터 업데이트된 외부 특징들 데이터(1046e)를 획득하는 시스템(1010)을 도시한다. 외부구강 광학 스캐너(1092)는 업데이트된 외부 특징들(1034e)을 스캔하고 업데이트된 모델링된 외부 특징들(1023e)을 포함하는, 업데이트된 대상 특징들(1022e)을 갖는 업데이트된 3D 모델(1020e)을 렌더링 하기 위한 프로세서(1012)에 의한 이용을 위한 컴퓨터로 읽기 가능한 매체(1014)에 결과(resulting) 업데이트된 외부 특징들 데이터(1046e)을 제공한다. 3D 모델(1020e)은, 3D 모델(1020)의 이동과 업데이트된 외부 특징들(1034e)에 의해 도시되나 실증 데이터는 없는 얼굴 표정 근사(approximating)를 비교한, 업데이트된 모델링된 외부 특징들(1023e)의 더 정확한 모델링을 용이하게 할 수 있는, 업데이트된 모델링된 외부 특징들(1023e)의 실증 데이터에 기초한다.

시스템(1010)의 이용 중, 개인(1030)은 특정한 얼굴 표정에서 개인(1030)의 외양을 더 정확히 반영하기 위한 실증 데이터로부터 유용할 수 있는 3D 모델(1020) 상에 보여지는 특정한 얼굴 표정을 결정할 수 있다. 상기 개인은 그들의 얼굴 표정을 업데이트된 외부 특징들(1034e)로 변화 시킬 수 있고, 컴퓨터로 읽기 가능한 매체(1014)에 저장된 업데이트된 외부 특징들 데이터(1046e)를 획득하기 위한 외부구강 광학 스캐너(1092)를 활성화시킬 수 있다. 업데이트된 3D 모델(1020e)을 제공하는 프로세서(1012)는, 업데이트된 외부 특징들 데이터(1046e)를 포함하는 3D 모델(1020)을 업데이트한다. 업데이트된 3D 모델(1020e)은 저장된 포지션(1026)으로서 저장될 수 있다. 개인(1030)은 얼굴 표정이 치열(도시되지 않음)로부터 유용한 경우(benefit), 업데이트된 외부 특징들 데이터(1046e)를 획득하기 전에 막실러리 및 만디불라 궁(arches)(1032) 상에 틀니를 포함할 수 있다.

도 37은 함께 동작하고(working with) 3D 모델을 업데이트하는 방법(380)을 도시한다. 방법(380)은 3D 모델(382)를 디스플레이하는 단계, 인풋(384)를 수신하는 단계 및 인풋(384) 수신에 반응하여 3D 모델(386)을 업데이트하는 단계를 포함한다. 또한, 방법(380)은 외부 특징들 데이터(394)를 수신하는 단계 및 추가 외부 특징들 데이터(395)에 따라 3D 모델을 업데이트하는 단계를 포함한다. 방법(380)은 시스템(1010)을 이용하여 수행될 수 있다. 3D 모델(382)을 디스플레이하는 단계, 3D 모델(386)을 이용하는 단계 및 추가 외부 특징들 데이터(395)에 반응하여 3D 모델을 업데이트하는 단계는 업데이트된 외부 특징들 데이터(1046e)를 포함하는 컴퓨터로 읽기 가능한 매체(1014)에 저장된 데이터를 이용하는 프로세서(1012)에 의한 인스트럭션들의 실행에 의해 3D 디스플레이(1016) 상에서 완성될 수 있다. 인풋(384)을 수신하는 단계는 시스템(1010)의 모션 센서(1018)에 의한 손 제스쳐, 다른 자발적 인풋들, 비자발적 인풋들 또는 인풋들의 조합들의 감지를 포함한다.

시스템(1010)은, 개인(1030)의 현재 얼굴 표정을 반영하기 위해 3D 모델(1020)의 실시간 업데이트를 발생시키는(resulting in), 업데이트된 외부 특징들 데이터(1046e)를 계속적으로 획득하기 위해 이용될 수 있다. 시스템(1010)의 애플리케이션은 방법(380)을 실시간으로 수행하고, 개인(1030)이 현재 보유 중인, 제안된 치과 기구(1024)의 존재(presence)에 대해 적응(adjust)된 동일한 얼굴 표정 내에 모델(1020)을 쇼잉(showing)하는 실시간 증강 현실 미러를 효과적으로 뷰잉하고 처리하도록 한다. 실시간 데이터 획득 및 모델링은 계속적이거나 일시적으로 개인(1030)에 의해 선택되는 것으로서 적용될 것이다.

도 38은 외부구강 광학 스캐너(1192) 및 BCI(1119)를 포함하는 시스템(1110)을 도시한다. BCI(1119)는 추가 외부 특징들 데이터(1146)의 획득 예측을 용이하게 할 수 있고, 실시간 또는 특정한 감정 또는 모델링된 외부 특징들(1123) 내에 반영되는 외부 특징들(1134)에 영향을 미치는 다른 상태들에서, 3D 모델(1120)에 의해 얼굴 표정의 더 정확한 모델링을 가능케하는, 특정한 얼굴 표정의 실증 데이터를 발생시키는(resulting in), 추가 외부 특징들 데이터(1146)을 포함하기 위해 3D 모델(1120)을 업데이트하는 것을 용이하게 한다.

BCI(1119)는 추가 외부 특징 데이터(1146)에 의한 신경 활동 데이터의 비교를 용이하게 할 수도 있다. 상기 비교는 신경 활동 데이터(1166)와 추가 외부 특징들 데이터(1146) 내에서 인식될 수 있는 감정 상태들의 정확한 상호연관을 용이하게 할 수 있다. 또한, 시스템(1110)의 실시간 업데이트 애플리케이션들은, 시스템(1010)과 같은 비(non)-BCI 장착된 시스템들과의 비교가 용이해질 수 있다. BCI(1119)는 사색(contemplation)의 정확한 순간들 중, 감정 반응 상의 피드백을 제공할 수 있다.

도 39는 비자발적 반응 데이터(1264)가 BCI의 애플리케이션 없이

수신되는 시스템(1210)을 도시한다. 비자발적 반응 데이터(1264)는, 얼굴 표정들 및 개인(1230)의 감정 상태와 관련된 개인(1230)의 다른 이동들을 감지하는 광학 센서(1296)를 통해 획득될 수 있다. 광학 센서(1296)은 미세한 표정들, 동공 팽창 및 개인(1230)의 감정 상태에 대한 신뢰할 만한 다른 지표들, 각각 또는 그 조합으로 다이렉팅(directed)될 수 있다. 또한, 광학이 아닌 다른 스캐너들은 비자발적 반응 데이터(1264)를 수신할 수 있고(도시되지 않음, 예를 들어 펄스 미터, 온도 게이지 등), 비자발적 반응 데이터(1264)는 복수의 데이터 타입들의 조합에 의해 수신될 수 있다(도시되지 않음, 예를 들어 온도의 폴리그래프, 펄스 및 동공 팽창 등). BCI 이용 없이 획득되는 비자발적 반응 데이터(1264) 외에, 시스템(1210)은 저장된 포지션(1226)을 트리거링 하는 비자발적 반응 데이터(1264)에 관한 것을 포함하는, 시스템(510)과 유사하게 기능한다.

시스템은, 시스템(510) 및 광학 센서(또는 다른 적합한 비-BCI 센서, 예를 들어 온도의 폴리그래프, 펄스 및 동공 팽창 등) 및 BCI(도시되지 않음) 모두를 구비한 시스템을 제공하는, 시스템(1210)의 특징들을 조합하도록 준비될 수도 있다. BCI 및 다른 센서로부터의 인풋은 가중치가 다르게 부여될 수 있다. 또한, 다른 센서로부터의 인풋은 그러한 시스템을 이용하는 개인에게 BCI를 캘리브레이팅 하는데 이용될 수 있다.

동일한 하드웨어는 모션 센서(예를 들어 모션 센서(18), 외부구강 광학 센서(992) 및 광학 센서(1296))의 기능들을 수행할 수 있다. 일반적으로, 스캔 특징들 데이터를 획득하기 위한 스캐너들은 더 가격이 비싸고, 제1 인풋 데이터를 위해 스캐너에 의해 비교되는 추가 엔지니어링 병목(bottlenecks)을 조건으로 한다. 그러나, 상기 방법들 및 여기에서 설명된 시스템들로부터 벗어나지 않는 단일 스캐너(광학 또는 그 외)는 스캔 특징들 데이터, 자발적 액션 데이터 및 비자발적 반응 데이터를 획득하기 위해 적용되는 것이 가능할 수 있다.

도 40은 개인(1330)의 턱 근육계의 활동을 측정하기 위한 개인(1330)에 관여하는(engaged with) 근육 활동 센서(1397)를 포함하는 시스템(1310)을 도시한다. 근육 활동 센서(1397)은 근전도검사(electromyography) 모듈의 실시예일 수 있다. 시스템(1310)은 추가 외부 특징들 데이터(1346)을 획득하기 위한 외부 구강 스캐너(1392)를 포함한다. 근육 활동 센서(1397)은 개인(1330)의 턱 근육계 내의 턱 이용이 최소인 경우를 감지하고, 추가 외부 특징들 데이터(1346)를 획득하기 위한 외부구강 스캐너(1392)를 디렉팅(direct)하기 위해 신호를 프로세서(1312)로 전송한다. 그러한(as with), 외부 특징들 데이터(1346)의 획득은 정지 포지션에서 획득될 수 있다. 또한, 경피성(transcutaneous) 전자 신경 자극 모듈은 턱 근육계를 이그조스팅하고 정지 포지션에 막실로만디불라 관계를 강제(forcing)하기 위해 개인의 턱 근육계에 적용될 수 있다.

3D 모델(1320)은 바이트 정보를 체크하기 위해 이용될 수 있다. 이가 없는 개인(1330)에게 있어, 그들의 입 안에 아무것도 없거나, 상측 테두리만 또는 상측 및 하측 바이트 림들(rims) 또는 틀니들 중에 가능할 수 있다(내부구강 오브젝트들이 기대되는 바이트 로케이션에 대해 서로 컨택(contact)하지 않는 한). 개인(1330)이 그들의 턱을 닫는 동안, 프로세서(1312)는 스캔 특징들 데이터(1340)의 더 많은 정보로서 이용될 수 있는, 적절한 교합 포지션 내에 개인(1330)이 바이팅하고 있는지 여부의 결정을 용이하게 할 수 있다. 본원과 발명자가 공통된 WO 2013/071435의 다양한 포지션들에서 얼굴 근육 활동을 평가하기 위한 근전도검사 또는 정지 포지션을 강제하기 위한 동시 전자 신경 자극 각각은 정지 포지션 내의 데이터 획득을 용이하게 한다. 이러한 정보는 바이트 일관성의 생리학적 실시예가 유지되는 동안 개인(1330)들이 적응들을 만들 수 있는 적절한 제약들을 정의하는 경우로 생각될 수 있다.

몇몇 케이스에서, 이미징은 막실러리 데이터만을 포함한다. 상측 앞쪽 치아를 모델링하기 위해 바이트 정보가 요구되지 않는다. 이것은 앞서 말한 궁(arches) 데이터의 만디불라 일부 및 만디불라 궁과 연관되는 연관 데이터의 일부 외에, 데이터 획득 인풋들을 변화시키지 않는다.

실시예들

앞선 설명에서, 설명의 목적을 위해, 수 많은 디테일들이 실시예들의 철저한 이해를 제공하기 위해 제시된다. 그러나, 당업자에게 이러한 구체적인 디테일들이 요구되지 않는 것은 자명하다. 몇몇 인스턴스들에서, 구체적인 디테일들은 여기에서 소프트웨어 루틴, 하드웨어 회로, 펌웨어 또는 그것들의 조합으로서 구현되는 실시예들인지에 관해 제공되지 않는다.