JP6961007B2 - 複合現実デバイスにおける仮想および実オブジェクトの記録 - Google Patents

複合現実デバイスにおける仮想および実オブジェクトの記録 Download PDFInfo

- Publication number

- JP6961007B2 JP6961007B2 JP2019546368A JP2019546368A JP6961007B2 JP 6961007 B2 JP6961007 B2 JP 6961007B2 JP 2019546368 A JP2019546368 A JP 2019546368A JP 2019546368 A JP2019546368 A JP 2019546368A JP 6961007 B2 JP6961007 B2 JP 6961007B2

- Authority

- JP

- Japan

- Prior art keywords

- audio

- virtual

- generation system

- data

- image generation

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

- 238000012545 processing Methods 0.000 claims description 36

- 230000004044 response Effects 0.000 claims description 28

- 238000009877 rendering Methods 0.000 claims description 17

- 230000006870 function Effects 0.000 claims description 9

- 230000001360 synchronised effect Effects 0.000 claims description 9

- 238000000034 method Methods 0.000 description 100

- 230000003190 augmentative effect Effects 0.000 description 77

- 210000003128 head Anatomy 0.000 description 77

- 230000005236 sound signal Effects 0.000 description 18

- 230000008447 perception Effects 0.000 description 12

- 230000008569 process Effects 0.000 description 10

- 238000010586 diagram Methods 0.000 description 8

- 230000000694 effects Effects 0.000 description 8

- 210000003811 finger Anatomy 0.000 description 7

- 230000000007 visual effect Effects 0.000 description 7

- 230000001755 vocal effect Effects 0.000 description 7

- 238000004891 communication Methods 0.000 description 6

- 210000000613 ear canal Anatomy 0.000 description 4

- 238000005516 engineering process Methods 0.000 description 4

- 230000004913 activation Effects 0.000 description 3

- 230000009471 action Effects 0.000 description 2

- 230000008901 benefit Effects 0.000 description 2

- 230000008859 change Effects 0.000 description 2

- 238000006243 chemical reaction Methods 0.000 description 2

- 239000002131 composite material Substances 0.000 description 2

- 239000004020 conductor Substances 0.000 description 2

- 230000003111 delayed effect Effects 0.000 description 2

- 239000000463 material Substances 0.000 description 2

- 238000012986 modification Methods 0.000 description 2

- 230000004048 modification Effects 0.000 description 2

- 230000003287 optical effect Effects 0.000 description 2

- 230000002747 voluntary effect Effects 0.000 description 2

- 241000256837 Apidae Species 0.000 description 1

- 238000003491 array Methods 0.000 description 1

- 230000006399 behavior Effects 0.000 description 1

- 210000000988 bone and bone Anatomy 0.000 description 1

- 238000004364 calculation method Methods 0.000 description 1

- 230000001427 coherent effect Effects 0.000 description 1

- 238000010411 cooking Methods 0.000 description 1

- 238000012937 correction Methods 0.000 description 1

- 230000008878 coupling Effects 0.000 description 1

- 238000010168 coupling process Methods 0.000 description 1

- 238000005859 coupling reaction Methods 0.000 description 1

- 238000013500 data storage Methods 0.000 description 1

- 238000013461 design Methods 0.000 description 1

- 238000011161 development Methods 0.000 description 1

- 210000005069 ears Anatomy 0.000 description 1

- 230000004424 eye movement Effects 0.000 description 1

- 230000005057 finger movement Effects 0.000 description 1

- 230000004886 head movement Effects 0.000 description 1

- 238000004519 manufacturing process Methods 0.000 description 1

- 238000005259 measurement Methods 0.000 description 1

- 230000006855 networking Effects 0.000 description 1

- 239000013307 optical fiber Substances 0.000 description 1

- 230000002085 persistent effect Effects 0.000 description 1

- 230000005855 radiation Effects 0.000 description 1

- 239000004984 smart glass Substances 0.000 description 1

- 230000001629 suppression Effects 0.000 description 1

- 210000003813 thumb Anatomy 0.000 description 1

- 230000016776 visual perception Effects 0.000 description 1

- 238000012800 visualization Methods 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/16—Sound input; Sound output

- G06F3/165—Management of the audio stream, e.g. setting of volume, audio stream path

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/40—Processing input control signals of video game devices, e.g. signals generated by the player or derived from the environment

- A63F13/42—Processing input control signals of video game devices, e.g. signals generated by the player or derived from the environment by mapping the input signals into game commands, e.g. mapping the displacement of a stylus on a touch screen to the steering angle of a virtual vehicle

- A63F13/424—Processing input control signals of video game devices, e.g. signals generated by the player or derived from the environment by mapping the input signals into game commands, e.g. mapping the displacement of a stylus on a touch screen to the steering angle of a virtual vehicle involving acoustic input signals, e.g. by using the results of pitch or rhythm extraction or voice recognition

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/50—Controlling the output signals based on the game progress

- A63F13/52—Controlling the output signals based on the game progress involving aspects of the displayed game scene

- A63F13/525—Changing parameters of virtual cameras

- A63F13/5255—Changing parameters of virtual cameras according to dedicated instructions from a player, e.g. using a secondary joystick to rotate the camera around a player's character

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/50—Controlling the output signals based on the game progress

- A63F13/53—Controlling the output signals based on the game progress involving additional visual information provided to the game scene, e.g. by overlay to simulate a head-up display [HUD] or displaying a laser sight in a shooting game

- A63F13/537—Controlling the output signals based on the game progress involving additional visual information provided to the game scene, e.g. by overlay to simulate a head-up display [HUD] or displaying a laser sight in a shooting game using indicators, e.g. showing the condition of a game character on screen

- A63F13/5372—Controlling the output signals based on the game progress involving additional visual information provided to the game scene, e.g. by overlay to simulate a head-up display [HUD] or displaying a laser sight in a shooting game using indicators, e.g. showing the condition of a game character on screen for tagging characters, objects or locations in the game scene, e.g. displaying a circle under the character controlled by the player

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/50—Controlling the output signals based on the game progress

- A63F13/54—Controlling the output signals based on the game progress involving acoustic signals, e.g. for simulating revolutions per minute [RPM] dependent engine sounds in a driving game or reverberation against a virtual wall

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/60—Generating or modifying game content before or while executing the game program, e.g. authoring tools specially adapted for game development or game-integrated level editor

- A63F13/65—Generating or modifying game content before or while executing the game program, e.g. authoring tools specially adapted for game development or game-integrated level editor automatically by game devices or servers from real world data, e.g. measurement in live racing competition

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/0093—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00 with means for monitoring data relating to the user, e.g. head-tracking, eye-tracking

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/017—Head mounted

- G02B27/0172—Head mounted characterised by optical features

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

- G06F3/012—Head tracking input arrangements

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

- G06F3/013—Eye tracking input arrangements

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/017—Gesture based interaction, e.g. based on a set of recognized hand gestures

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/033—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor

- G06F3/0346—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor with detection of the device orientation or free movement in a 3D space, e.g. 3D mice, 6-DOF [six degrees of freedom] pointers using gyroscopes, accelerometers or tilt-sensors

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

- G06F3/0481—Interaction techniques based on graphical user interfaces [GUI] based on specific properties of the displayed interaction object or a metaphor-based environment, e.g. interaction with desktop elements like windows or icons, or assisted by a cursor's changing behaviour or appearance

- G06F3/04815—Interaction with a metaphor-based environment or interaction object displayed as three-dimensional, e.g. changing the user viewpoint with respect to the environment or object

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

- G06F3/0484—Interaction techniques based on graphical user interfaces [GUI] for the control of specific functions or operations, e.g. selecting or manipulating an object, an image or a displayed text element, setting a parameter value or selecting a range

- G06F3/04842—Selection of displayed objects or displayed text elements

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/16—Sound input; Sound output

- G06F3/167—Audio in a user interface, e.g. using voice commands for navigating, audio feedback

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T19/00—Manipulating 3D models or images for computer graphics

- G06T19/006—Mixed reality

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04R—LOUDSPEAKERS, MICROPHONES, GRAMOPHONE PICK-UPS OR LIKE ACOUSTIC ELECTROMECHANICAL TRANSDUCERS; DEAF-AID SETS; PUBLIC ADDRESS SYSTEMS

- H04R1/00—Details of transducers, loudspeakers or microphones

- H04R1/10—Earpieces; Attachments therefor ; Earphones; Monophonic headphones

- H04R1/1058—Manufacture or assembly

- H04R1/1075—Mountings of transducers in earphones or headphones

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04R—LOUDSPEAKERS, MICROPHONES, GRAMOPHONE PICK-UPS OR LIKE ACOUSTIC ELECTROMECHANICAL TRANSDUCERS; DEAF-AID SETS; PUBLIC ADDRESS SYSTEMS

- H04R1/00—Details of transducers, loudspeakers or microphones

- H04R1/20—Arrangements for obtaining desired frequency or directional characteristics

- H04R1/32—Arrangements for obtaining desired frequency or directional characteristics for obtaining desired directional characteristic only

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04R—LOUDSPEAKERS, MICROPHONES, GRAMOPHONE PICK-UPS OR LIKE ACOUSTIC ELECTROMECHANICAL TRANSDUCERS; DEAF-AID SETS; PUBLIC ADDRESS SYSTEMS

- H04R1/00—Details of transducers, loudspeakers or microphones

- H04R1/20—Arrangements for obtaining desired frequency or directional characteristics

- H04R1/32—Arrangements for obtaining desired frequency or directional characteristics for obtaining desired directional characteristic only

- H04R1/40—Arrangements for obtaining desired frequency or directional characteristics for obtaining desired directional characteristic only by combining a number of identical transducers

- H04R1/403—Arrangements for obtaining desired frequency or directional characteristics for obtaining desired directional characteristic only by combining a number of identical transducers loud-speakers

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04R—LOUDSPEAKERS, MICROPHONES, GRAMOPHONE PICK-UPS OR LIKE ACOUSTIC ELECTROMECHANICAL TRANSDUCERS; DEAF-AID SETS; PUBLIC ADDRESS SYSTEMS

- H04R3/00—Circuits for transducers, loudspeakers or microphones

- H04R3/005—Circuits for transducers, loudspeakers or microphones for combining the signals of two or more microphones

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04R—LOUDSPEAKERS, MICROPHONES, GRAMOPHONE PICK-UPS OR LIKE ACOUSTIC ELECTROMECHANICAL TRANSDUCERS; DEAF-AID SETS; PUBLIC ADDRESS SYSTEMS

- H04R5/00—Stereophonic arrangements

- H04R5/02—Spatial or constructional arrangements of loudspeakers

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/0101—Head-up displays characterised by optical features

- G02B2027/0138—Head-up displays characterised by optical features comprising image capture systems, e.g. camera

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/0101—Head-up displays characterised by optical features

- G02B2027/014—Head-up displays characterised by optical features comprising information/image processing systems

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2200/00—Indexing scheme for image data processing or generation, in general

- G06T2200/24—Indexing scheme for image data processing or generation, in general involving graphical user interfaces [GUIs]

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04S—STEREOPHONIC SYSTEMS

- H04S2400/00—Details of stereophonic systems covered by H04S but not provided for in its groups

- H04S2400/11—Positioning of individual sound objects, e.g. moving airplane, within a sound field

Description

本発明は、例えば、以下を提供する。

(項目1)

エンドユーザによる使用のための仮想画像生成システムであって、

メモリと、

ディスプレイサブシステムと、

オブジェクト選択デバイスであって、前記オブジェクト選択デバイスは、入力を前記エンドユーザから受信し、エンドユーザ入力に応答して、少なくとも1つのオブジェクトを持続的に選択するために構成される、オブジェクト選択デバイスと、

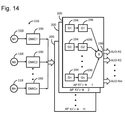

制御サブシステムであって、前記制御サブシステムは、少なくとも1つの選択されたオブジェクトから生じるビデオデータを生成し、複数の画像フレームを前記ビデオデータからの3次元場面内にレンダリングし、前記画像フレームを前記ディスプレイサブシステムに伝達し、前記少なくとも1つの選択されたオブジェクトから生じるオーディオデータを生成することと、前記オーディオデータを前記メモリ内に記憶することとのために構成される、制御サブシステムと

を備える、仮想画像生成システム。

(項目2)

前記制御サブシステムはさらに、前記オーディオデータと同期する前記ビデオデータを前記メモリ内に記憶するために構成される、項目1に記載の仮想画像生成システム。

(項目3)

複数のスピーカをさらに備え、前記制御サブシステムはさらに、前記生成されたオーディオデータを前記スピーカに伝達するために構成される、項目1に記載の仮想画像生成システム。

(項目4)

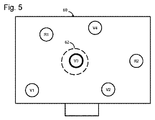

前記ディスプレイサブシステムは、視野を有し、前記オブジェクト選択デバイスは、前記視野内の前記少なくとも1つのオブジェクトを持続的に選択するために構成される、項目1に記載の仮想画像生成システム。

(項目5)

前記オブジェクト選択デバイスは、3次元カーソルを前記ディスプレイサブシステムの視野内で移動させ、前記エンドユーザ入力の受信に応答して、前記少なくとも1つのオブジェクトを選択するために構成される、項目4に記載の仮想画像生成システム。

(項目6)

前記エンドユーザ入力は、1つ以上の音声コマンドを含み、前記オブジェクト選択デバイスは、前記1つ以上の音声コマンドを感知するために構成される1つ以上のマイクロホンを備える、項目1に記載の仮想画像生成システム。

(項目7)

前記エンドユーザ入力は、1つ以上の手のジェスチャを含み、前記オブジェクト選択デバイスは、前記1つ以上の手のジェスチャを感知するために構成される1つ以上のカメラを備える、項目1に記載の仮想画像生成システム。

(項目8)

前記少なくとも1つのオブジェクトは、複数のオブジェクトを含み、前記オブジェクト選択デバイスは、前記エンドユーザ入力に応答して、前記オブジェクトを個々に選択するために構成される、項目1に記載の仮想画像生成システム。

(項目9)

前記少なくとも1つのオブジェクトは、複数のオブジェクトを含み、前記オブジェクト選択デバイスは、前記エンドユーザ入力に応答して、前記オブジェクトを大域的に選択するために構成される、項目1に記載の仮想画像生成システム。

(項目10)

前記オブジェクト選択デバイスは、前記エンドユーザ入力に応答して、前記視野の角度範囲内の全てのオブジェクトを大域的に選択するために構成される、項目9に記載の仮想画像生成システム。

(項目11)

前記角度範囲は、前記視野の角度範囲全体未満である、項目10に記載の仮想画像生成システム。

(項目12)

前記角度範囲は、前記視野の角度範囲全体である、項目10に記載の仮想画像生成システム。

(項目13)

前記オブジェクト選択デバイスはさらに、別の入力を前記エンドユーザから受信し、他のエンドユーザ入力に応答して、少なくとも1つの以前に選択されたオブジェクトを持続的に選択解除するために構成される、項目1に記載の仮想画像生成システム。

(項目14)

前記ディスプレイサブシステムの視野に対する前記少なくとも1つの選択されたオブジェクトの場所を追跡するために構成される少なくとも1つのセンサをさらに備える、項目1に記載の仮想画像生成システム。

(項目15)

前記制御サブシステムは、前記少なくとも1つの選択されたオブジェクトの追跡された場所が前記ディスプレイサブシステムの視野外に移動すると、前記オーディオデータを前記メモリ内に記憶することを中止するために構成される、項目14に記載の仮想画像生成システム。

(項目16)

前記制御サブシステムは、前記少なくとも1つの選択されたオブジェクトの追跡された場所が前記ディスプレイサブシステムの視野外に移動すると、前記オーディオデータを前記メモリ内に記憶することを継続するために構成される、項目14に記載の仮想画像生成システム。

(項目17)

前記少なくとも1つの選択されたオブジェクトは、実オブジェクトを含む、項目1に記載の仮想画像生成システム。

(項目18)

オーディオ出力を生成するために構成されるマイクロホンアセンブリをさらに備え、前記制御サブシステムはさらに、オーディオ出力の方向を修正し、前記選択された実オブジェクトから生じる音を優先的に感知するために構成され、前記オーディオデータは、前記修正されたオーディオ出力から導出される、項目17に記載の仮想画像生成システム。

(項目19)

前記選択された実オブジェクトから生じるビデオデータを捕捉するために構成される1つ以上のカメラをさらに備え、前記制御サブシステムはさらに、前記オーディオデータと同期する前記ビデオデータを前記メモリ内に記憶するために構成される、項目17に記載の仮想画像生成システム。

(項目20)

前記制御サブシステムは、前記捕捉されたビデオデータを前記選択された実オブジェクトのための仮想コンテンツデータに変換し、前記仮想コンテンツを前記メモリ内に記憶するために構成される、項目19に記載の仮想画像生成システム。

(項目21)

前記少なくとも1つの選択されたオブジェクトは、仮想オブジェクトを含む、項目1に記載の仮想画像生成システム。

(項目22)

複数の仮想オブジェクトのための音に対応するコンテンツデータを記憶するために構成されるデータベースをさらに備え、前記制御サブシステムはさらに、前記選択された仮想オブジェクトに対応するコンテンツデータを前記データベースから入手するために構成され、前記メモリ内に記憶されるオーディオデータは、前記入手されたコンテンツデータを含む、項目21に記載の仮想画像生成システム。

(項目23)

前記制御サブシステムはさらに、前記選択された仮想オブジェクトに対応するメタデータを生成するために構成され、前記メモリ内に記憶されるオーディオデータは、前記入手されたコンテンツデータおよび生成されたメタデータを含む、項目22に記載の仮想画像生成システム。

(項目24)

前記メタデータは、前記選択された仮想オブジェクトのための位置、配向、および音量データを含む、項目23に記載の仮想画像生成システム。

(項目25)

前記エンドユーザの頭部姿勢を追跡するために構成される1つ以上のセンサをさらに備え、前記データベースは、前記複数の仮想オブジェクトのための絶対メタデータを記憶するために構成され、前記制御サブシステムはさらに、前記選択された仮想オブジェクトに対応する絶対メタデータを入手し、前記エンドユーザの追跡された頭部姿勢に基づいて、前記絶対メタデータを前記エンドユーザに対して局所化することによって、前記メタデータを生成するために構成される、項目23に記載の仮想画像生成システム。

(項目26)

少なくとも1つのスピーカをさらに備え、前記制御サブシステムはさらに、前記記憶されたオーディオデータを前記メモリから読み出し、オーディオを前記読み出されたオーディオデータから導出し、前記オーディオを前記少なくとも1つのスピーカに伝達するために構成される、項目1に記載の仮想画像生成システム。

(項目27)

前記メモリ内に記憶されるオーディオデータは、コンテンツデータおよびメタデータを含み、前記制御サブシステムはさらに、前記記憶されたコンテンツデータおよびメタデータを前記メモリから読み出し、前記読み出されたコンテンツデータおよびメタデータに基づいて、空間化オーディオをレンダリングし、前記レンダリングされた空間化オーディオを前記少なくとも1つのスピーカに伝達するために構成される、項目26に記載の仮想画像生成システム。

(項目28)

前記ディスプレイサブシステムは、前記エンドユーザの眼の正面に位置付けられるために構成される、項目1に記載の仮想画像生成システム。

(項目29)

前記ディスプレイサブシステムは、投影サブシステムおよび部分的に透明なディスプレイ表面を含み、前記投影サブシステムは、前記画像フレームを前記部分的に透明なディスプレイ表面上に投影させるために構成され、前記部分的に透明なディスプレイ表面は、前記エンドユーザの眼と周囲環境との間の視野内に位置付けられるために構成される、項目28に記載の仮想画像生成システム。

(項目30)

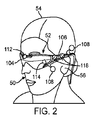

前記エンドユーザによって装着されるために構成されるフレーム構造をさらに備え、前記フレーム構造は、前記ディスプレイサブシステムの少なくとも一部を担持する、項目28に記載の仮想画像生成システム。

(項目31)

エンドユーザによって仮想画像生成システムを動作させる方法であって、

少なくとも1つのオブジェクトを持続的に選択することと、

少なくとも1つの選択されたオブジェクトから生じるビデオデータを生成することと、

複数の画像フレームを前記生成されたビデオデータからの3次元場面内にレンダリングすることと、

前記画像フレームを前記エンドユーザに表示することと、

前記少なくとも1つの選択されたオブジェクトから生じるオーディオデータを生成することと、

前記少なくとも1つの選択されたオブジェクトから生じるオーディオデータをメモリ内に記憶することと

を含む、方法。

(項目32)

前記オーディオデータと同期する前記ビデオデータを前記メモリ内に記憶することをさらに含む、項目31に記載の方法。

(項目33)

前記少なくとも1つの選択されたオブジェクトから生じるオーディオデータを前記エンドユーザによる知覚のための音に変換することをさらに含む、項目31に記載の方法。

(項目34)

前記少なくとも1つのオブジェクトは、前記エンドユーザの視野内で選択される、項目31に記載の方法。

(項目35)

前記少なくとも1つのオブジェクトを選択することは、3次元カーソルを前記エンドユーザの視野内で移動させ、前記3次元カーソルを用いて前記少なくとも1つのオブジェクトを選択することを含む、項目34に記載の方法。

(項目36)

前記少なくとも1つのオブジェクトを選択することは、1つ以上の音声コマンドを発行することを含む、項目31に記載の方法。

(項目37)

前記少なくとも1つのオブジェクトを選択することは、1つ以上の手のジェスチャを行うことを含む、項目31に記載の方法。

(項目38)

前記少なくとも1つのオブジェクトは、複数のオブジェクトを含み、前記複数のオブジェクトを選択することは、前記オブジェクトを個々に選択することを含む、項目31に記載の方法。

(項目39)

前記少なくとも1つのオブジェクトは、複数のオブジェクトを含み、前記複数のオブジェクトを選択することは、前記オブジェクトを大域的に選択することを含む、項目31に記載の方法。

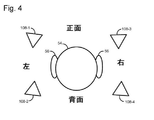

(項目40)

前記オブジェクトを大域的に選択することは、前記エンドユーザの視野の角度範囲を定義し、前記エンドユーザの視野の定義された角度範囲内の前記オブジェクトの全てを選択することを含む、項目39に記載の方法。

(項目41)

前記定義された角度範囲は、前記エンドユーザの視野の角度範囲全体未満である、項目40に記載の方法。

(項目42)

前記定義された角度範囲は、前記エンドユーザの視野の角度範囲全体である、項目40に記載の方法。

(項目43)

少なくとも1つの以前に選択されたオブジェクトを持続的に選択解除することをさらに含む、項目31に記載の方法。

(項目44)

前記エンドユーザの視野に対する前記少なくとも1つの選択されたオブジェクトの場所を追跡することをさらに含む、項目31に記載の方法。

(項目45)

前記少なくとも1つの選択されたオブジェクトの追跡された場所が前記エンドユーザの視野外に移動すると、前記少なくとも1つの選択されたオブジェクトから生じるオーディオデータを前記メモリ内に記憶することを中止することをさらに含む、項目44に記載の方法。

(項目46)

前記少なくとも1つの選択されたオブジェクトの追跡された場所が前記エンドユーザの視野外に移動すると、前記少なくとも1つの選択されたオブジェクトから生じるオーディオデータを前記メモリ内に記憶することを継続することをさらに含む、項目44に記載の方法。

(項目47)

前記少なくとも1つの選択されたオブジェクトは、実オブジェクトを含む、項目31に記載の方法。

(項目48)

他の実オブジェクトから生じる音と比較して、前記選択された実オブジェクトから生じる音を優先的に感知することをさらに含み、前記オーディオデータは、前記優先的に感知される音から導出される、項目47に記載の方法。

(項目49)

前記選択された実オブジェクトから生じるビデオデータを捕捉することと、

前記オーディオデータと同期する前記ビデオデータを前記メモリ内に記憶することと

をさらに含む、項目47に記載の方法。

(項目50)

前記捕捉されたビデオデータを仮想コンテンツデータに変換し、前記仮想コンテンツデータを前記メモリ内に記憶することをさらに含む、項目49に記載の方法。

(項目51)

前記少なくとも1つの選択されたオブジェクトは、仮想オブジェクトを含む、項目31に記載の方法。

(項目52)

複数の仮想オブジェクトのための音に対応するコンテンツデータを記憶することと、

前記選択された仮想オブジェクトに対応するコンテンツデータを入手することであって、前記メモリ内に記憶されるオーディオデータは、前記入手されたコンテンツデータを含む、ことと

をさらに含む、項目51に記載の方法。

(項目53)

前記選択された仮想オブジェクトに対応するメタデータを生成することであって、前記メモリ内に記憶されるオーディオデータは、前記入手されたコンテンツデータおよび前記生成されたメタデータを含む、こと

をさらに含む、項目52に記載の方法。

(項目54)

前記メタデータは、前記選択された仮想オブジェクトのための位置、配向、および音量データを含む、項目53に記載の方法。

(項目55)

前記エンドユーザの頭部姿勢を追跡することと、

前記複数の仮想オブジェクトのための絶対メタデータを記憶することと

をさらに含み、

前記メタデータを生成することは、前記選択された仮想オブジェクトに対応する絶対メタデータを読み出し、前記エンドユーザの追跡された頭部姿勢に基づいて、前記絶対メタデータを前記エンドユーザに対して局所化することを含む、項目53に記載の方法。

(項目56)

前記記憶されたオーディオデータを読み出し、オーディオを前記読み出されたオーディオデータから導出し、前記オーディオを前記エンドユーザによる知覚のための音に変換することをさらに含む、項目31に記載の方法。

(項目57)

前記記憶されたオーディオデータは、コンテンツデータおよびメタデータを含み、前記方法はさらに、

前記記憶されたコンテンツデータおよびメタデータを前記メモリから読み出すことと、

前記読み出されたコンテンツデータおよびメタデータに基づいて、空間化オーディオをレンダリングすることと、

前記空間化オーディオを前記エンドユーザによる知覚のための音に変換することと

を含む、項目31に記載の方法。

(項目58)

再生ユーザによる使用のための仮想画像生成システムであって、

メモリであって、前記メモリは、オリジナル空間環境内の少なくとも1つのオブジェクトから生じるオーディオコンテンツデータおよびビデオコンテンツデータを記憶するために構成される、メモリと、

複数のスピーカと、

ディスプレイサブシステムと、

制御サブシステムであって、前記制御サブシステムは、前記オーディオコンテンツデータおよびビデオコンテンツデータを前記メモリから読み出し、前記読み出されたオーディオコンテンツデータおよびビデオコンテンツデータからそれぞれオーディオおよびビデオを前記オリジナル空間環境と異なる新しい空間環境内にレンダリングし、前記レンダリングされたオーディオを前記スピーカに、前記生成されたビデオデータを前記ディスプレイサブシステムに同期して伝達するために構成される、制御サブシステムと

を備える、仮想画像生成システム。

(項目59)

前記制御サブシステムは、前記オーディオコンテンツデータおよびビデオコンテンツデータを前記メモリ内に記憶するために構成される、項目58に記載の仮想画像生成システム。

(項目60)

前記メモリ内への前記オーディオコンテンツデータおよびビデオコンテンツデータの記憶に先立って、入力をエンドユーザから受信し、エンドユーザ入力に応答して、前記オリジナル空間環境内の前記少なくとも1つのオブジェクトを持続的に選択するために構成されるオブジェクト選択デバイスをさらに備える、項目59に記載の仮想画像生成システム。

(項目61)

前記少なくとも1つのオブジェクトは、実オブジェクトを含む、項目59に記載の仮想画像生成システム。

(項目62)

前記オーディオコンテンツデータを前記オリジナル空間環境内の実オブジェクトから捕捉するために構成されるマイクロホンアセンブリをさらに備える、項目61に記載の仮想画像生成システム。

(項目63)

前記マイクロホンアセンブリは、オーディオ出力を生成するために構成され、前記制御サブシステムはさらに、前記オーディオ出力の方向を修正し、選択された実オブジェクトから生じる音を優先的に感知するために構成され、前記オーディオコンテンツデータは、前記修正されたオーディオ出力から導出される、項目62に記載の仮想画像生成システム。

(項目64)

前記ビデオデータを前記オリジナル空間環境内の選択された実オブジェクトから捕捉するために構成される1つ以上のカメラをさらに備える、項目61に記載の仮想画像生成システム。

(項目65)

前記制御サブシステムは、前記捕捉されたビデオデータを前記選択された実オブジェクトのための仮想コンテンツデータに変換し、前記仮想コンテンツデータを前記ビデオコンテンツデータとして前記メモリ内に記憶するために構成される、項目64に記載の仮想画像生成システム。

(項目66)

前記少なくとも1つのオブジェクトは、仮想オブジェクトを含む、項目58に記載の仮想画像生成システム。

(項目67)

複数の仮想オブジェクトのための音に対応するコンテンツデータを記憶するために構成されるデータベースをさらに備え、前記制御サブシステムはさらに、前記仮想オブジェクトに対応するコンテンツデータを前記データベースから入手するために構成され、前記メモリ内に記憶されるオーディオデータは、前記入手されたコンテンツデータを含む、項目66に記載の仮想画像生成システム。

(項目68)

前記制御サブシステムは、前記新しい空間環境内の前記少なくとも1つのオブジェクトに対応する絶対メタデータを入手し、前記読み出されたオーディオコンテンツデータおよび前記絶対メタデータからのオーディオを前記新しい空間環境内にレンダリングするために構成される、項目58に記載の仮想画像生成システム。

(項目69)

前記再生ユーザの頭部姿勢を追跡するために構成される1つ以上のセンサをさらに備え、前記制御サブシステムはさらに、前記レンダリングされたオーディオが空間化されるように、前記再生ユーザの追跡された頭部姿勢に基づいて、前記絶対メタデータを前記再生ユーザに対して局所化するために構成される、項目68に記載の仮想画像生成システム。

(項目70)

前記新しい空間環境内の少なくとも1つのオブジェクトに対応する絶対メタデータを入手することは、前記少なくとも1つのオブジェクトを前記新しい空間環境内に位置付けることを含む、項目68に記載の仮想画像生成システム。

(項目71)

入力を前記再生ユーザから受信するために構成されるユーザ入力デバイスをさらに備え、前記制御サブシステムは、前記再生ユーザからの入力に応答して、前記少なくとも1つのオブジェクトを前記新しい空間環境内に位置付けるために構成される、項目70に記載の仮想画像生成システム。

(項目72)

前記ディスプレイサブシステムは、前記再生ユーザの眼の正面に位置付けられるために構成される、項目58に記載の仮想画像生成システム。

(項目73)

前記ディスプレイサブシステムは、投影サブシステムおよび部分的に透明なディスプレイ表面を含み、前記投影サブシステムは、前記ビデオデータに応答して、画像フレームを前記部分的に透明なディスプレイ表面上に投影させるために構成され、前記部分的に透明なディスプレイ表面は、前記再生ユーザの眼と前記新しい空間環境との間の視野内に位置付けられるために構成される、項目72に記載の仮想画像生成システム。

(項目74)

前記再生ユーザによって装着されるために構成されるフレーム構造をさらに備え、前記フレーム構造は、前記ディスプレイサブシステムの少なくとも一部を担持する、項目72に記載の仮想画像生成システム。

(項目75)

オリジナル空間環境内にオーディオコンテンツデータおよびビデオコンテンツデータとして以前に記録された少なくとも1つのオブジェクトのオーディオおよびビデオを再生するために、再生ユーザによって仮想画像生成システムを動作させる方法であって、前記方法は、

前記オーディオコンテンツデータおよびビデオコンテンツデータをメモリから読み出すことと、

前記読み出されたオーディオコンテンツデータおよびビデオコンテンツデータからそれぞれオーディオおよびビデオを前記オリジナル空間環境と異なる新しい空間環境内にレンダリングすることと、

前記オーディオおよびビデオをそれぞれ音および画像フレームに変換することと、

前記音および画像フレームを前記再生ユーザに同期して伝達することと

を含む、方法。

(項目76)

前記オーディオコンテンツデータおよびビデオコンテンツデータを前記メモリ内に記憶することをさらに含む、項目75に記載の方法。

(項目77)

前記メモリ内への前記オーディオコンテンツデータおよびビデオコンテンツデータの記憶に先立って、前記オリジナル空間環境内の前記少なくとも1つのオブジェクトを持続的に選択することをさらに含む、項目76に記載の方法。

(項目78)

前記少なくとも1つのオブジェクトは、実オブジェクトを含む、項目76に記載の方法。

(項目79)

前記オーディオコンテンツデータを前記実オブジェクトから捕捉することをさらに含む、項目78に記載の方法。

(項目80)

他の実オブジェクトから生じる音と比較して、選択された実オブジェクトから生じる音を優先的に感知することであって、前記オーディオコンテンツデータは、前記優先的に感知される音から導出される、ことをさらに含む、項目79に記載の方法。

(項目81)

ビデオデータを前記選択された実オブジェクトから捕捉することと、

前記捕捉されたビデオデータを前記仮想コンテンツデータに変換することと

をさらに含む、項目78に記載の方法。

(項目82)

前記少なくとも1つのオブジェクトは、仮想オブジェクトを含む、項目76に記載の方法。

(項目83)

複数の仮想オブジェクトのための音に対応するコンテンツデータを記憶し、前記仮想オブジェクトに対応するコンテンツデータを前記データベースから入手することであって、前記メモリ内に記憶されるオーディオコンテンツデータは、前記入手されたコンテンツデータを含む、こと

をさらに含む、項目82に記載の方法。

(項目84)

前記新しい空間環境内の前記少なくとも1つのオブジェクトに対応する絶対メタデータを入手することであって、前記オーディオは、前記読み出されたオーディオコンテンツデータおよび前記絶対メタデータから前記新しい空間環境内にレンダリングされる、こと

をさらに含む、項目75に記載の方法。

(項目85)

前記再生ユーザの頭部姿勢を追跡することと、

前記再生ユーザの追跡された頭部姿勢に基づいて、前記絶対メタデータを前記再生ユーザに対して局所化することであって、前記オーディオは、前記レンダリングされたオーディオが空間化されるように、前記読み出されたオーディオコンテンツデータおよび前記局所的メタデータから前記新しい空間環境内にレンダリングされる、ことと

をさらに含む、項目84に記載の方法。

(項目86)

前記新しい空間環境内の少なくとも1つのオブジェクトに対応する絶対メタデータを入手することは、前記少なくとも1つのオブジェクトを前記新しい空間環境内に位置付けることを含む、項目84に記載の方法。

(項目87)

入力を前記再生ユーザから受信することであって、前記少なくとも1つのオブジェクトは、前記再生ユーザからの入力に応答して、前記新しい空間環境内に位置付けられる、こと

をさらに含む、項目86に記載の方法。

Claims (30)

- ユーザによる使用のための仮想画像生成システムであって、

メモリと、

ディスプレイサブシステムと、

オブジェクト選択デバイスであって、前記オブジェクト選択デバイスは、入力を前記ユーザから受信し、前記ユーザ入力に応答して、3次元場面内の複数のオブジェクトから少なくとも1つのオブジェクトを選択するために構成され、前記少なくとも1つの選択されたオブジェクトは、実オブジェクトを含む、オブジェクト選択デバイスと、

制御サブシステムであって、前記制御サブシステムは、少なくとも、

オーディオ捕捉デバイスを用いて、前記複数のオブジェクトのうちの少なくとも1つの選択されていないオブジェクトよりも前記少なくとも1つの選択されたオブジェクトから出るオーディオデータを優先的に入手することと、

少なくとも、第2のメタデータに少なくとも部分的に基づいて第1のメタデータを前記ユーザに対して局所化することによって、前記オーディオデータから空間化オーディオをレンダリングすることであって、前記第1のメタデータは、前記ユーザに対して局所化されて第1の局所化メタデータになり、少なくとも1つの選択されたオブジェクトと関連付けられ、前記仮想画像生成システムによってまたは前記オーディオ捕捉デバイスを有する異なる仮想画像生成システムによって前記オーディオデータとともに生成され、前記第2のメタデータは、前記ユーザのための、前記仮想画像生成システムによって検出される位置特性または配向特性に関連する、ことと、

前記第1のメタデータと前記第2のメタデータとに少なくとも部分的に基づいて、レンダリングされた前記空間化オーディオと、前記ユーザに同期する前記少なくとも1つの選択されたオブジェクトを表す少なくとも1つの仮想オブジェクトとを提示することと

のために構成される、制御サブシステムと

を備える、仮想画像生成システム。 - 少なくとも画像捕捉デバイスを用いて、前記少なくとも1つの選択されたオブジェクトのための画像データを入手することと、

少なくとも、前記第2のメタデータに部分的にまたは全体的に基づいて前記ユーザに対して前記第1のメタデータを局所化することによって、前記少なくとも1つの選択されたオブジェクトを3次元場面内の前記仮想オブジェクトとして表す、前記少なくとも1つの選択されたオブジェクトの前記画像データを複数の画像フレームとしてレンダリングすることと

をさらに含み、

前記第1のメタデータは、前記第2のメタデータに部分的にまたは全体的に基づいて局所化されて前記第1の局所化メタデータになり、前記仮想画像生成システムによってまたは前記画像捕捉デバイスを有する異なる仮想画像生成システムによって検出される異なる位置特性または配向特性に関連する、請求項1に記載の仮想画像生成システム。 - 前記空間化オーディオおよび前記画像データは、前記空間化オーディオおよび前記仮想オブジェクトが生成される空間環境と異なる空間環境において、少なくとも、前記異なる空間環境において前記少なくとも1つの選択されたオブジェクトを再位置付けされたオブジェクトとして再位置付けすることによって、再生される、請求項2に記載の仮想画像生成システム。

- 前記空間化オーディオおよび前記画像データは、さらに少なくとも、前記再位置付けされたオブジェクトに対応する絶対メタデータを入手することによって、異なる空間環境において再生される、請求項3に記載の仮想画像生成システム。

- 前記空間化オーディオおよび前記画像データは、さらに少なくとも、前記絶対メタデータを局所化して局所化絶対メタデータになることによって、異なる空間環境において再生され、前記絶対メタデータは、前記少なくとも1つの選択されたオブジェクトに、再生ユーザに対応する、請求項4に記載の仮想画像生成システム。

- 前記空間化オーディオおよび前記画像データは、さらに少なくとも、前記局所化絶対メタデータに少なくとも部分的に基づいて前記空間化オーディオおよび前記画像データをレンダリングすることによって、異なる空間環境において再生される、請求項5に記載の仮想画像生成システム。

- 前記ユーザの頭部姿勢を追跡する1つ以上のセンサをさらに備え、前記ユーザの前記頭部姿勢は、前記第1のメタデータおよび前記オーディオデータに沿って、前記第2のメタデータとしてデータベース内に記憶され、前記少なくとも1つの選択されたオブジェクトに対応する前記第1のメタデータは、前記ユーザの前記頭部姿勢を備える前記第2のメタデータに少なくとも部分的に基づいて前記ユーザに前記空間化オーディオをレンダリングするためにおよび前記画像データをレンダリングするために前記ユーザに対して局所化される、請求項2に記載の仮想画像生成システム。

- ビデオプロセッサをさらに備え、前記ビデオプロセッサは、データベース内に記憶される前記少なくとも1つの選択されたオブジェクトの前記画像データを入手し、前記画像データを処理することなく前記画像データをレコーダに送信し、前記レコーダは、処理された画像を前記メモリ内に記憶し、前記ディスプレイサブシステムは、投影サブシステムおよび部分的に透明なディスプレイ表面を含み、前記投影サブシステムは、前記複数の画像フレームを前記部分的に透明なディスプレイ表面上へ投影し、前記部分的に透明なディスプレイ表面は、エンドユーザの眼と周囲環境との間の視野内に位置付けられるために構成される、請求項2に記載の仮想画像生成システム。

- ビデオプロセッサおよびフレーム構造をさらに備え、前記フレーム構造は、前記ユーザによって装着されるために、および、前記ディスプレイサブシステムの少なくとも一部を担持するために構成され、前記ビデオプロセッサは、前記画像捕捉デバイスによって捕捉されたビデオデータから前記少なくとも1つの選択されたオブジェクトの前記画像データを抽出し、前記ビデオデータから抽出された前記画像データを前記少なくとも1つの仮想オブジェクトとして前記メモリ内に記憶し、前記画像データをレコーダに送信し、前記レコーダは、前記画像データを前記少なくとも1つの仮想オブジェクトとしてデータベース内に記録する、請求項2に記載の仮想画像生成システム。

- 複数のスピーカをさらに備え、前記制御サブシステムは、前記空間化オーディオを前記複数のスピーカにさらに伝達する、請求項1に記載の仮想画像生成システム。

- 前記ディスプレイサブシステムは、視野を有し、前記オブジェクト選択デバイスは、前記ユーザ入力に応答して、前記視野内の前記少なくとも1つのオブジェクトを選択するための第1の命令を受信する、請求項1に記載の仮想画像生成システム。

- 前記オブジェクト選択デバイスは、前記ユーザ入力に応答して、3次元カーソルを前記ディスプレイサブシステムの前記視野内で移動させるための第2の命令を受信する、請求項11に記載の仮想画像生成システム。

- 前記ユーザ入力は、1つ以上の音声コマンドまたは1つ以上の手のジェスチャを含み、前記オブジェクト選択デバイスは、前記1つ以上の音声コマンドまたは前記1つ以上の手のジェスチャを捕捉する1つ以上のデバイスを備える、請求項1に記載の仮想画像生成システム。

- 前記仮想画像生成システムは、前記オーディオデータのタイプに少なくとも部分的に基づいて、前記少なくとも1つの選択されたオブジェクトをプロファイル化し、前記オーディオデータのタイプは、少なくとも、1つ以上の実オブジェクトからそれぞれ出る前記オーディオデータの1つ以上の特性に少なくとも部分的に基づいて前記オーディオデータの特性を分析することによって、決定される、請求項1に記載の仮想画像生成システム。

- 前記少なくとも1つのオブジェクトは、複数のオブジェクトを含み、前記オブジェクト選択デバイスは、前記複数のオブジェクトのうちの1つのオブジェクトを個々に選択する第1の機能を前記ユーザに提供し、前記ユーザ入力に応答する範囲内で前記複数のオブジェクトのうちの複数のオブジェクトを大域的に選択する第2の機能を前記ユーザに提供し、前記ディスプレイサブシステムによって前記ユーザに提供された視野は、前記範囲を備える、請求項1に記載の仮想画像生成システム。

- 前記オブジェクト選択デバイスは、前記ユーザから別の入力を受信し、前記別の入力に応答して、前記少なくとも1つの選択されたオブジェクトを選択解除する、請求項1に記載の仮想画像生成システム。

- 前記ディスプレイサブシステムによって前記ユーザに提供された視野に対する前記少なくとも1つの選択されたオブジェクトの場所を追跡する少なくとも1つのセンサをさらに備える、請求項1に記載の仮想画像生成システム。

- 前記制御サブシステムは、前記少なくとも1つのセンサによって追跡される前記少なくとも1つの選択されたオブジェクトの場所が、前記ディスプレイサブシステムによって前記ユーザに提供される前記視野外に移動すると、前記オーディオデータを前記メモリ内に記憶することを引き起こす、請求項17に記載の仮想画像生成システム。

- 前記制御サブシステムは、前記少なくとも1つのセンサによって追跡される前記少なくとも1つの選択されたオブジェクトの場所が、前記ディスプレイサブシステムによって前記ユーザに提供される前記視野外に移動すると、前記オーディオデータを前記メモリ内に記憶することを継続する、請求項17に記載の仮想画像生成システム。

- オーディオ捕捉デバイスは、指向性オーディオ出力を生成し、前記制御サブシステムは、前記少なくとも1つの選択されていないオブジェクトよりも前記少なくとも1つの選択されたオブジェクトの方向に、前記オーディオ捕捉デバイスによって受信された前記オーディオデータを優先的に表すように、前記指向性オーディオ出力をさらに修正し、前記空間化オーディオは、前記制御サブシステムによって修正された前記指向性オーディオ出力から導出される、請求項1に記載の仮想画像生成システム。

- 前記少なくとも1つの選択されたオブジェクトに関連する画像データを捕捉する1つ以上の画像捕捉デバイスをさらに備え、前記制御サブシステムは、前記オーディオデータと同期する前記画像データを前記メモリ内に記憶し、前記少なくとも1つの選択されたオブジェクトは、カーソルを使用することなく前記ユーザによって選択される、請求項1に記載の仮想画像生成システム。

- 前記制御サブシステムは、前記メモリ内に記憶された前記画像データを前記少なくとも1つの選択されたオブジェクトのための仮想コンテンツデータに変換し、前記仮想コンテンツデータを前記メモリ内にさらに記憶する、請求項21に記載の仮想画像生成システム。

- 前記少なくとも1つの選択されたオブジェクトは、前記仮想画像生成システムによってレンダリングされた仮想オブジェクトを含む、請求項1に記載の仮想画像生成システム。

- 複数の仮想オブジェクトによって生成された前記オーディオデータを記憶するデータベースをさらに備え、前記制御サブシステムは、選択されていない仮想オブジェクトよりも選択された仮想オブジェクトに対応する前記オーディオデータを前記データベースから優先的に入手するための命令を受信し、前記データベースは、前記仮想オブジェクトの説明を記憶し、前記データベースに記憶される前記仮想オブジェクトの前記説明は、前記ユーザによって表される前記仮想オブジェクトの口頭説明に合致される、請求項1に記載の仮想画像生成システム。

- 前記制御サブシステムは、前記少なくとも1つの選択されたオブジェクトに対応する前記第1のメタデータをさらに生成し、前記メモリ内に記憶される前記オーディオデータは、前記オーディオデータ内のコンテンツおよび前記第1のメタデータを含む、請求項1に記載の仮想画像生成システム。

- 前記第1のメタデータは、前記少なくとも1つの選択されたオブジェクトのための絶対位置および絶対配向に関するデータを含む、請求項1に記載の仮想画像生成システム。

- 少なくとも1つのスピーカをさらに備え、前記仮想画像生成システムは、前記空間化オーディオをレンダリングすることによって、前記少なくとも1つの選択されたオブジェクトのみから入手された前記オーディオデータを前記空間化オーディオにさらに変換し、前記オーディオデータを前記空間化オーディオに変換することは、前記メモリ内に記憶された前記オーディオデータを読み出すことと、前記メモリから読み出された前記オーディオデータから空間化オーディオを導出することと、前記空間化オーディオを前記少なくとも1つのスピーカに伝達することと、前記実オブジェクトから生じる音と前記空間化オーディオを混合することとを含む、請求項1に記載の仮想画像生成システム。

- レコーダをさらに備え、前記レコーダは、第1のオーディオデータを入手し、前記第1のオーディオデータは、前記空間化オーディオ、および、前記少なくとも1つの選択されたオブジェクトに対応する前記第1のメタデータまたは前記第2のメタデータを含み、前記レコーダは、第1のビデオデータをさらに入手し、前記第1のビデオデータは、前記第1のビデオデータの画像フレーム、および、少なくとも前記少なくとも1つの選択されたオブジェクトに関連する対応するメタデータを含み、前記レコーダは、異なるコンピューティングデバイス上のプレーヤにおける後続再生のために前記第1のオーディオデータおよび前記第1のビデオデータをさらに記憶する、請求項27に記載の仮想画像生成システム。

- 前記レコーダは、記録し、第1の仮想オブジェクトからの第1のオーディオおよび第1の実オブジェクトからの第2のオーディオを記録しないように構成され、前記空間化オーディオは、少なくとも、前記第1の局所化メタデータおよび大域的メタデータを前記ユーザのために前記オーディオデータに適用することによって、前記オーディオデータからレンダリングされる、請求項28に記載の仮想画像生成システム。

- 少なくとも、前記第2のメタデータに少なくとも部分的に基づいて前記ユーザに対して前記第1のメタデータではなく絶対メタデータを局所化することによって、前記仮想オブジェクトとして前記少なくとも1つの選択されたオブジェクトを表す複数の画像フレームとして、前記少なくとも1つの選択されたオブジェクトのための少なくとも画像捕捉デバイスによって入手された画像データをレンダリングすることをさらに含み、前記少なくとも1つの選択されたオブジェクトは、前記仮想画像生成システムの前記ユーザまたは前記異なる仮想画像生成システムの異なるユーザが注視する方向にかかわらず、持続的に選択されたままである、請求項1に記載の仮想画像生成システム。

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2021167529A JP7275227B2 (ja) | 2017-02-28 | 2021-10-12 | 複合現実デバイスにおける仮想および実オブジェクトの記録 |

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US201762464757P | 2017-02-28 | 2017-02-28 | |

| US62/464,757 | 2017-02-28 | ||

| PCT/US2018/020020 WO2018160593A1 (en) | 2017-02-28 | 2018-02-27 | Virtual and real object recording in mixed reality device |

Related Child Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2021167529A Division JP7275227B2 (ja) | 2017-02-28 | 2021-10-12 | 複合現実デバイスにおける仮想および実オブジェクトの記録 |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2020509492A JP2020509492A (ja) | 2020-03-26 |

| JP2020509492A5 JP2020509492A5 (ja) | 2021-04-08 |

| JP6961007B2 true JP6961007B2 (ja) | 2021-11-05 |

Family

ID=63246339

Family Applications (3)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2019546368A Active JP6961007B2 (ja) | 2017-02-28 | 2018-02-27 | 複合現実デバイスにおける仮想および実オブジェクトの記録 |

| JP2021167529A Active JP7275227B2 (ja) | 2017-02-28 | 2021-10-12 | 複合現実デバイスにおける仮想および実オブジェクトの記録 |

| JP2023076101A Pending JP2023095956A (ja) | 2017-02-28 | 2023-05-02 | 複合現実デバイスにおける仮想および実オブジェクトの記録 |

Family Applications After (2)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2021167529A Active JP7275227B2 (ja) | 2017-02-28 | 2021-10-12 | 複合現実デバイスにおける仮想および実オブジェクトの記録 |

| JP2023076101A Pending JP2023095956A (ja) | 2017-02-28 | 2023-05-02 | 複合現実デバイスにおける仮想および実オブジェクトの記録 |

Country Status (9)

| Country | Link |

|---|---|

| US (4) | US10725729B2 (ja) |

| EP (2) | EP3590097B1 (ja) |

| JP (3) | JP6961007B2 (ja) |

| KR (4) | KR102419065B1 (ja) |

| CN (1) | CN110337318A (ja) |

| AU (2) | AU2018227710B2 (ja) |

| CA (1) | CA3052834A1 (ja) |

| IL (4) | IL311069A (ja) |

| WO (1) | WO2018160593A1 (ja) |

Families Citing this family (33)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US11445305B2 (en) | 2016-02-04 | 2022-09-13 | Magic Leap, Inc. | Technique for directing audio in augmented reality system |

| KR102419065B1 (ko) | 2017-02-28 | 2022-07-07 | 매직 립, 인코포레이티드 | 혼합 현실 디바이스에서의 가상 및 실제 객체 레코딩 |

| US11023109B2 (en) * | 2017-06-30 | 2021-06-01 | Microsoft Techniogy Licensing, LLC | Annotation using a multi-device mixed interactivity system |

| US11019389B2 (en) * | 2017-12-04 | 2021-05-25 | Comcast Cable Communications, Llc | Determination of enhanced viewing experiences based on viewer engagement |

| US10937240B2 (en) * | 2018-01-04 | 2021-03-02 | Intel Corporation | Augmented reality bindings of physical objects and virtual objects |

| US10504274B2 (en) * | 2018-01-05 | 2019-12-10 | Microsoft Technology Licensing, Llc | Fusing, texturing, and rendering views of dynamic three-dimensional models |

| GB2571572A (en) * | 2018-03-02 | 2019-09-04 | Nokia Technologies Oy | Audio processing |

| US10497161B1 (en) * | 2018-06-08 | 2019-12-03 | Curious Company, LLC | Information display by overlay on an object |

| US10818088B2 (en) | 2018-07-10 | 2020-10-27 | Curious Company, LLC | Virtual barrier objects |

| US10902678B2 (en) | 2018-09-06 | 2021-01-26 | Curious Company, LLC | Display of hidden information |

| US11068668B2 (en) * | 2018-10-25 | 2021-07-20 | Facebook Technologies, Llc | Natural language translation in augmented reality(AR) |

| US20220021998A1 (en) * | 2018-11-09 | 2022-01-20 | Whoborn Inc. | Method for generating sound and devices for performing same |

| US11055913B2 (en) | 2018-12-04 | 2021-07-06 | Curious Company, LLC | Directional instructions in an hybrid reality system |

| US10970935B2 (en) | 2018-12-21 | 2021-04-06 | Curious Company, LLC | Body pose message system |

| US20200285056A1 (en) * | 2019-03-05 | 2020-09-10 | Facebook Technologies, Llc | Apparatus, systems, and methods for wearable head-mounted displays |

| US10872584B2 (en) | 2019-03-14 | 2020-12-22 | Curious Company, LLC | Providing positional information using beacon devices |

| US10798292B1 (en) * | 2019-05-31 | 2020-10-06 | Microsoft Technology Licensing, Llc | Techniques to set focus in camera in a mixed-reality environment with hand gesture interaction |

| US11533468B2 (en) | 2019-06-27 | 2022-12-20 | Samsung Electronics Co., Ltd. | System and method for generating a mixed reality experience |

| KR20210014813A (ko) | 2019-07-30 | 2021-02-10 | 삼성디스플레이 주식회사 | 표시장치 |

| US10726631B1 (en) * | 2019-08-03 | 2020-07-28 | VIRNECT inc. | Augmented reality system and method with frame region recording and reproduction technology based on object tracking |

| US11638111B2 (en) * | 2019-11-01 | 2023-04-25 | Meta Platforms Technologies, Llc | Systems and methods for classifying beamformed signals for binaural audio playback |

| CN111273775A (zh) * | 2020-01-16 | 2020-06-12 | Oppo广东移动通信有限公司 | 增强现实眼镜、基于增强现实眼镜的ktv实现方法与介质 |

| CN113452896B (zh) * | 2020-03-26 | 2022-07-22 | 华为技术有限公司 | 一种图像显示方法和电子设备 |

| US11830119B1 (en) * | 2020-05-29 | 2023-11-28 | Apple Inc. | Modifying an environment based on sound |

| KR102508815B1 (ko) * | 2020-11-24 | 2023-03-14 | 네이버 주식회사 | 오디오와 관련하여 사용자 맞춤형 현장감 실현을 위한 컴퓨터 시스템 및 그의 방법 |

| US11930349B2 (en) | 2020-11-24 | 2024-03-12 | Naver Corporation | Computer system for producing audio content for realizing customized being-there and method thereof |

| US11930348B2 (en) | 2020-11-24 | 2024-03-12 | Naver Corporation | Computer system for realizing customized being-there in association with audio and method thereof |

| JP2022162409A (ja) * | 2021-04-12 | 2022-10-24 | キヤノン株式会社 | 電子機器及びその制御方法 |

| US11868526B2 (en) * | 2021-05-03 | 2024-01-09 | Apple Inc. | Method and device for debugging program execution and content playback |

| CN113359986B (zh) * | 2021-06-03 | 2023-06-20 | 北京市商汤科技开发有限公司 | 增强现实数据展示方法、装置、电子设备及存储介质 |

| US20230315383A1 (en) * | 2022-04-04 | 2023-10-05 | Snap Inc. | Wearable device ar object voice-based interaction |

| US11531448B1 (en) * | 2022-06-01 | 2022-12-20 | VR-EDU, Inc. | Hand control interfaces and methods in virtual reality environments |

| WO2024029803A1 (ko) * | 2022-08-04 | 2024-02-08 | 삼성전자 주식회사 | 증강 현실에서 공간에 따라 오브젝트를 배치하는 전자 장치 및 전자 장치의 동작 방법. |

Family Cites Families (101)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US1005519A (en) | 1911-04-24 | 1911-10-10 | Curt O Dietsch | Dispensing apparatus. |

| US1020604A (en) | 1911-12-09 | 1912-03-19 | Pinkie D Hooton | Box-car-door fastener. |

| US8730129B2 (en) | 1990-12-07 | 2014-05-20 | Dennis J Solomon | Advanced immersive visual display system |

| JP3461055B2 (ja) * | 1995-04-26 | 2003-10-27 | 日本電信電話株式会社 | 音声チャンネル選択合成方法およびこの方法を実施する装置 |

| US5901232A (en) | 1996-09-03 | 1999-05-04 | Gibbs; John Ho | Sound system that determines the position of an external sound source and points a directional microphone/speaker towards it |

| DE19854373B4 (de) | 1998-11-25 | 2005-02-24 | Robert Bosch Gmbh | Verfahren zur Steuerung der Empfindlichkeit eines Mikrofons |

| WO2001097558A2 (en) | 2000-06-13 | 2001-12-20 | Gn Resound Corporation | Fixed polar-pattern-based adaptive directionality systems |

| US6975991B2 (en) | 2001-01-31 | 2005-12-13 | International Business Machines Corporation | Wearable display system with indicators of speakers |

| US7269632B2 (en) * | 2001-06-05 | 2007-09-11 | Xdyne, Inc. | Networked computer system for communicating and operating in a virtual reality environment |

| JP2004267433A (ja) * | 2003-03-07 | 2004-09-30 | Namco Ltd | 音声チャット機能を提供する情報処理装置、サーバおよびプログラム並びに記録媒体 |

| US7680300B2 (en) * | 2004-06-01 | 2010-03-16 | Energid Technologies | Visual object recognition and tracking |

| JP2006025281A (ja) * | 2004-07-09 | 2006-01-26 | Hitachi Ltd | 情報源選択システム、および方法 |

| KR100677601B1 (ko) * | 2004-11-11 | 2007-02-02 | 삼성전자주식회사 | 메타 데이터를 포함하는 영상 데이터를 기록한 저장매체,그 재생장치 및 메타 데이터를 이용한 검색방법 |

| JP5286667B2 (ja) | 2006-02-22 | 2013-09-11 | コニカミノルタ株式会社 | 映像表示装置、及び映像表示方法 |

| US20080231926A1 (en) * | 2007-03-19 | 2008-09-25 | Klug Michael A | Systems and Methods for Updating Dynamic Three-Dimensional Displays with User Input |

| FR2915041A1 (fr) | 2007-04-13 | 2008-10-17 | Canon Kk | Procede d'attribution d'une pluralite de canaux audio a une pluralite de haut-parleurs, produit programme d'ordinateur, moyen de stockage et noeud gestionnaire correspondants. |

| US9703369B1 (en) * | 2007-10-11 | 2017-07-11 | Jeffrey David Mullen | Augmented reality video game systems |

| KR20090052169A (ko) | 2007-11-20 | 2009-05-25 | 삼성전자주식회사 | 두부(頭部) 장착 디스플레이 |

| US20090174946A1 (en) | 2008-01-07 | 2009-07-09 | Roni Raviv | Customizable head mounted display |

| US20100074460A1 (en) | 2008-09-25 | 2010-03-25 | Lucent Technologies Inc. | Self-steering directional hearing aid and method of operation thereof |

| JP5499633B2 (ja) | 2009-10-28 | 2014-05-21 | ソニー株式会社 | 再生装置、ヘッドホン及び再生方法 |

| US8819591B2 (en) * | 2009-10-30 | 2014-08-26 | Accuray Incorporated | Treatment planning in a virtual environment |

| US20130278631A1 (en) | 2010-02-28 | 2013-10-24 | Osterhout Group, Inc. | 3d positioning of augmented reality information |

| US9341843B2 (en) | 2010-02-28 | 2016-05-17 | Microsoft Technology Licensing, Llc | See-through near-eye display glasses with a small scale image source |

| AU2011220382A1 (en) | 2010-02-28 | 2012-10-18 | Microsoft Corporation | Local advertising content on an interactive head-mounted eyepiece |

| US9128281B2 (en) | 2010-09-14 | 2015-09-08 | Microsoft Technology Licensing, Llc | Eyepiece with uniformly illuminated reflective display |

| US9285589B2 (en) * | 2010-02-28 | 2016-03-15 | Microsoft Technology Licensing, Llc | AR glasses with event and sensor triggered control of AR eyepiece applications |

| EP2368720B1 (en) * | 2010-03-26 | 2018-10-24 | Provenance Asset Group LLC | Method to transform a virtual object into a real physical object |

| JP5651386B2 (ja) | 2010-06-23 | 2015-01-14 | ソフトバンクモバイル株式会社 | 眼鏡型表示装置 |

| JP2012029209A (ja) | 2010-07-27 | 2012-02-09 | Hitachi Ltd | 音処理システム |

| KR101299910B1 (ko) * | 2010-08-18 | 2013-08-23 | 주식회사 팬택 | 증강 현실 서비스의 공유 방법 및 그를 위한 사용자 단말기와 원격자 단말기 |

| US9122053B2 (en) * | 2010-10-15 | 2015-09-01 | Microsoft Technology Licensing, Llc | Realistic occlusion for a head mounted augmented reality display |

| US9529424B2 (en) * | 2010-11-05 | 2016-12-27 | Microsoft Technology Licensing, Llc | Augmented reality with direct user interaction |

| US8576276B2 (en) * | 2010-11-18 | 2013-11-05 | Microsoft Corporation | Head-mounted display device which provides surround video |

| JP2012133250A (ja) | 2010-12-24 | 2012-07-12 | Sony Corp | 音情報表示装置、音情報表示方法およびプログラム |

| US10585472B2 (en) * | 2011-08-12 | 2020-03-10 | Sony Interactive Entertainment Inc. | Wireless head mounted display with differential rendering and sound localization |

| US20130222371A1 (en) * | 2011-08-26 | 2013-08-29 | Reincloud Corporation | Enhancing a sensory perception in a field of view of a real-time source within a display screen through augmented reality |

| US20140063061A1 (en) * | 2011-08-26 | 2014-03-06 | Reincloud Corporation | Determining a position of an item in a virtual augmented space |

| EP2565664B1 (en) | 2011-09-01 | 2017-02-22 | 9Solutions Oy | Adaptive location tracking system |

| US20130083018A1 (en) * | 2011-09-30 | 2013-04-04 | Kevin A. Geisner | Personal audio/visual system with holographic objects |

| US9255813B2 (en) * | 2011-10-14 | 2016-02-09 | Microsoft Technology Licensing, Llc | User controlled real object disappearance in a mixed reality display |

| BR112014010230A8 (pt) * | 2011-10-28 | 2017-06-20 | Magic Leap Inc | sistema e método para realidade virtual e aumentada |

| JP5969200B2 (ja) | 2011-11-11 | 2016-08-17 | 任天堂株式会社 | 情報処理プログラム、情報処理装置、情報処理システム、および情報処理方法 |

| JP6065370B2 (ja) * | 2012-02-03 | 2017-01-25 | ソニー株式会社 | 情報処理装置、情報処理方法、及びプログラム |

| US8781142B2 (en) | 2012-02-24 | 2014-07-15 | Sverrir Olafsson | Selective acoustic enhancement of ambient sound |

| DK2890159T3 (da) | 2012-05-09 | 2017-01-02 | Oticon As | Anordning til behandling af audiosignaler |

| US9292758B2 (en) * | 2012-05-14 | 2016-03-22 | Sphero, Inc. | Augmentation of elements in data content |

| DE102012214081A1 (de) | 2012-06-06 | 2013-12-12 | Siemens Medical Instruments Pte. Ltd. | Verfahren zum Fokussieren eines Hörinstruments-Beamformers |

| CN104737061B (zh) | 2012-06-11 | 2018-01-16 | 奇跃公司 | 使用波导反射器阵列投射器的多深度平面三维显示器 |

| US9671566B2 (en) | 2012-06-11 | 2017-06-06 | Magic Leap, Inc. | Planar waveguide apparatus with diffraction element(s) and system employing same |

| US20130328925A1 (en) * | 2012-06-12 | 2013-12-12 | Stephen G. Latta | Object focus in a mixed reality environment |

| US9544074B2 (en) * | 2012-09-04 | 2017-01-10 | Broadcom Corporation | Time-shifting distribution of high definition audio data |

| US8750541B1 (en) | 2012-10-31 | 2014-06-10 | Google Inc. | Parametric array for a head-mountable device |

| US20140146394A1 (en) * | 2012-11-28 | 2014-05-29 | Nigel David Tout | Peripheral display for a near-eye display device |

| CA2898750C (en) | 2013-01-25 | 2018-06-26 | Hai HU | Devices and methods for the visualization and localization of sound |

| US10231614B2 (en) | 2014-07-08 | 2019-03-19 | Wesley W. O. Krueger | Systems and methods for using virtual reality, augmented reality, and/or a synthetic 3-dimensional information for the measurement of human ocular performance |

| US20140240351A1 (en) * | 2013-02-27 | 2014-08-28 | Michael Scavezze | Mixed reality augmentation |

| KR102387314B1 (ko) * | 2013-03-11 | 2022-04-14 | 매직 립, 인코포레이티드 | 증강 및 가상 현실을 위한 시스템 및 방법 |

| US10109075B2 (en) * | 2013-03-15 | 2018-10-23 | Elwha Llc | Temporal element restoration in augmented reality systems |

| KR20140114238A (ko) * | 2013-03-18 | 2014-09-26 | 삼성전자주식회사 | 오디오와 결합된 이미지 표시 방법 |

| US10905943B2 (en) * | 2013-06-07 | 2021-02-02 | Sony Interactive Entertainment LLC | Systems and methods for reducing hops associated with a head mounted system |

| US10262462B2 (en) * | 2014-04-18 | 2019-04-16 | Magic Leap, Inc. | Systems and methods for augmented and virtual reality |

| GB2516056B (en) * | 2013-07-09 | 2021-06-30 | Nokia Technologies Oy | Audio processing apparatus |

| US9124990B2 (en) | 2013-07-10 | 2015-09-01 | Starkey Laboratories, Inc. | Method and apparatus for hearing assistance in multiple-talker settings |

| US9619939B2 (en) * | 2013-07-31 | 2017-04-11 | Microsoft Technology Licensing, Llc | Mixed reality graduated information delivery |

| DE102013215131A1 (de) | 2013-08-01 | 2015-02-05 | Siemens Medical Instruments Pte. Ltd. | Verfahren zur Verfolgung einer Schallquelle |

| US9143880B2 (en) | 2013-08-23 | 2015-09-22 | Tobii Ab | Systems and methods for providing audio to a user based on gaze input |

| CN105960193A (zh) | 2013-09-03 | 2016-09-21 | 托比股份公司 | 便携式眼睛追踪设备 |

| US9848260B2 (en) | 2013-09-24 | 2017-12-19 | Nuance Communications, Inc. | Wearable communication enhancement device |

| CN105745602B (zh) * | 2013-11-05 | 2020-07-14 | 索尼公司 | 信息处理装置、信息处理方法和程序 |

| US9271077B2 (en) | 2013-12-17 | 2016-02-23 | Personics Holdings, Llc | Method and system for directional enhancement of sound using small microphone arrays |

| US9716939B2 (en) | 2014-01-06 | 2017-07-25 | Harman International Industries, Inc. | System and method for user controllable auditory environment customization |

| US9552060B2 (en) * | 2014-01-28 | 2017-01-24 | Microsoft Technology Licensing, Llc | Radial selection by vestibulo-ocular reflex fixation |

| US9516412B2 (en) | 2014-03-28 | 2016-12-06 | Panasonic Intellectual Property Management Co., Ltd. | Directivity control apparatus, directivity control method, storage medium and directivity control system |

| JP6125457B2 (ja) | 2014-04-03 | 2017-05-10 | 日本電信電話株式会社 | 収音システム及び放音システム |

| KR20150118855A (ko) * | 2014-04-15 | 2015-10-23 | 삼성전자주식회사 | 전자 장치 및 전자 장치의 레코딩 방법 |

| CA2949929A1 (en) | 2014-05-26 | 2015-12-03 | Vladimir Sherman | Methods circuits devices systems and associated computer executable code for acquiring acoustic signals |

| CN106605415B (zh) * | 2014-06-03 | 2019-10-29 | 杜比实验室特许公司 | 用于向上发射驱动器的有源和无源虚拟高度滤波器系统 |

| US9971492B2 (en) * | 2014-06-04 | 2018-05-15 | Quantum Interface, Llc | Dynamic environment for object and attribute display and interaction |

| US9226090B1 (en) | 2014-06-23 | 2015-12-29 | Glen A. Norris | Sound localization for an electronic call |

| JP6421313B2 (ja) | 2014-07-28 | 2018-11-14 | 株式会社オーディオテクニカ | マイクロホン装置 |

| US9599821B2 (en) * | 2014-08-08 | 2017-03-21 | Greg Van Curen | Virtual reality system allowing immersion in virtual space to consist with actual movement in actual space |

| US20160080874A1 (en) * | 2014-09-16 | 2016-03-17 | Scott Fullam | Gaze-based audio direction |

| US9818225B2 (en) * | 2014-09-30 | 2017-11-14 | Sony Interactive Entertainment Inc. | Synchronizing multiple head-mounted displays to a unified space and correlating movement of objects in the unified space |

| US9654868B2 (en) | 2014-12-05 | 2017-05-16 | Stages Llc | Multi-channel multi-domain source identification and tracking |

| CN107001252B (zh) * | 2014-12-16 | 2019-04-26 | 3M创新有限公司 | 离子型二醇抗静电聚氨酯及其制备方法 |

| US9685005B2 (en) * | 2015-01-02 | 2017-06-20 | Eon Reality, Inc. | Virtual lasers for interacting with augmented reality environments |

| KR20160128119A (ko) * | 2015-04-28 | 2016-11-07 | 엘지전자 주식회사 | 이동 단말기 및 이의 제어방법 |

| US9530426B1 (en) * | 2015-06-24 | 2016-12-27 | Microsoft Technology Licensing, Llc | Filtering sounds for conferencing applications |

| EP3145220A1 (en) * | 2015-09-21 | 2017-03-22 | Dolby Laboratories Licensing Corporation | Rendering virtual audio sources using loudspeaker map deformation |

| US11631421B2 (en) | 2015-10-18 | 2023-04-18 | Solos Technology Limited | Apparatuses and methods for enhanced speech recognition in variable environments |

| US10206042B2 (en) | 2015-10-20 | 2019-02-12 | Bragi GmbH | 3D sound field using bilateral earpieces system and method |

| EP3174005A1 (en) * | 2015-11-30 | 2017-05-31 | Nokia Technologies Oy | Apparatus and method for controlling audio mixing in virtual reality environments |

| US9949056B2 (en) | 2015-12-23 | 2018-04-17 | Ecole Polytechnique Federale De Lausanne (Epfl) | Method and apparatus for presenting to a user of a wearable apparatus additional information related to an audio scene |

| US9905244B2 (en) | 2016-02-02 | 2018-02-27 | Ebay Inc. | Personalized, real-time audio processing |

| IL307306A (en) | 2016-02-04 | 2023-11-01 | Magic Leap Inc | A technique for audio direction in an augmented reality system |

| US10074012B2 (en) * | 2016-06-17 | 2018-09-11 | Dolby Laboratories Licensing Corporation | Sound and video object tracking |

| US20180095542A1 (en) * | 2016-09-30 | 2018-04-05 | Sony Interactive Entertainment Inc. | Object Holder for Virtual Reality Interaction |

| US10754608B2 (en) * | 2016-11-29 | 2020-08-25 | Nokia Technologies Oy | Augmented reality mixing for distributed audio capture |

| KR102419065B1 (ko) | 2017-02-28 | 2022-07-07 | 매직 립, 인코포레이티드 | 혼합 현실 디바이스에서의 가상 및 실제 객체 레코딩 |

| US11498282B1 (en) | 2018-11-30 | 2022-11-15 | National Technology & Engineering Solutions Of Sandia, Llc | Computationally optimized and manufactured acoustic metamaterials |

-

2018

- 2018-02-27 KR KR1020217031142A patent/KR102419065B1/ko active IP Right Grant

- 2018-02-27 KR KR1020197028175A patent/KR102308937B1/ko active IP Right Grant

- 2018-02-27 EP EP18760949.0A patent/EP3590097B1/en active Active

- 2018-02-27 CA CA3052834A patent/CA3052834A1/en active Pending

- 2018-02-27 IL IL311069A patent/IL311069A/en unknown

- 2018-02-27 WO PCT/US2018/020020 patent/WO2018160593A1/en unknown

- 2018-02-27 EP EP23196831.4A patent/EP4270166A3/en active Pending

- 2018-02-27 US US15/907,115 patent/US10725729B2/en active Active

- 2018-02-27 CN CN201880014388.7A patent/CN110337318A/zh active Pending

- 2018-02-27 KR KR1020237043530A patent/KR20240000632A/ko active Application Filing

- 2018-02-27 IL IL288137A patent/IL288137B2/en unknown

- 2018-02-27 IL IL301932A patent/IL301932B1/en unknown

- 2018-02-27 JP JP2019546368A patent/JP6961007B2/ja active Active

- 2018-02-27 AU AU2018227710A patent/AU2018227710B2/en active Active

- 2018-02-27 KR KR1020227023026A patent/KR102616220B1/ko active IP Right Grant

-

2019

- 2019-07-31 IL IL268397A patent/IL268397B/en unknown

-

2020

- 2020-06-16 US US16/902,650 patent/US11194543B2/en active Active

-

2021

- 2021-10-12 JP JP2021167529A patent/JP7275227B2/ja active Active

- 2021-11-02 US US17/517,625 patent/US11669298B2/en active Active

-

2022

- 2022-06-16 AU AU2022204210A patent/AU2022204210B2/en not_active Expired - Fee Related

-

2023

- 2023-04-17 US US18/301,890 patent/US20230251823A1/en active Pending

- 2023-05-02 JP JP2023076101A patent/JP2023095956A/ja active Pending

Also Published As

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6961007B2 (ja) | 複合現実デバイスにおける仮想および実オブジェクトの記録 | |

| US20140328505A1 (en) | Sound field adaptation based upon user tracking | |

| US10798518B2 (en) | Apparatus and associated methods | |

| US20190130644A1 (en) | Provision of Virtual Reality Content | |

| KR20190052086A (ko) | 공간화 오디오를 갖는 가상 현실, 증강 현실 및 혼합 현실 시스템들 | |

| TW201928945A (zh) | 音訊場景處理技術 | |

| EP4252195A1 (en) | Real world beacons indicating virtual locations | |

| KR20210056414A (ko) | 혼합 현실 환경들에서 오디오-가능 접속된 디바이스들을 제어하기 위한 시스템 | |

| JP2016109971A (ja) | 信号処理装置および信号処理装置の制御方法 | |

| CN112256130A (zh) | 生成控制指令的方法和装置 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20210226 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20210226 |

|

| A871 | Explanation of circumstances concerning accelerated examination |

Free format text: JAPANESE INTERMEDIATE CODE: A871 Effective date: 20210226 |

|

| A975 | Report on accelerated examination |

Free format text: JAPANESE INTERMEDIATE CODE: A971005 Effective date: 20210324 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20210329 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20210616 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20210913 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20211012 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6961007 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |