JP6732617B2 - 情報処理装置および画像生成方法 - Google Patents

情報処理装置および画像生成方法 Download PDFInfo

- Publication number

- JP6732617B2 JP6732617B2 JP2016184424A JP2016184424A JP6732617B2 JP 6732617 B2 JP6732617 B2 JP 6732617B2 JP 2016184424 A JP2016184424 A JP 2016184424A JP 2016184424 A JP2016184424 A JP 2016184424A JP 6732617 B2 JP6732617 B2 JP 6732617B2

- Authority

- JP

- Japan

- Prior art keywords

- image

- images

- viewpoint

- line

- eye

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/30—Image reproducers

- H04N13/366—Image reproducers using viewer tracking

- H04N13/383—Image reproducers using viewer tracking for tracking with gaze detection, i.e. detecting the lines of sight of the viewer's eyes

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/10—Processing, recording or transmission of stereoscopic or multi-view image signals

- H04N13/106—Processing image signals

- H04N13/122—Improving the 3D impression of stereoscopic images by modifying image signal contents, e.g. by filtering or adding monoscopic depth cues

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/0093—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00 with means for monitoring data relating to the user, e.g. head-tracking, eye-tracking

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/017—Head mounted

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/14—Digital output to display device ; Cooperation and interconnection of the display device with other functional units

- G06F3/147—Digital output to display device ; Cooperation and interconnection of the display device with other functional units using display panels

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T19/00—Manipulating 3D models or images for computer graphics

-

- G—PHYSICS

- G09—EDUCATION; CRYPTOGRAPHY; DISPLAY; ADVERTISING; SEALS

- G09G—ARRANGEMENTS OR CIRCUITS FOR CONTROL OF INDICATING DEVICES USING STATIC MEANS TO PRESENT VARIABLE INFORMATION

- G09G5/00—Control arrangements or circuits for visual indicators common to cathode-ray tube indicators and other visual indicators

-

- G—PHYSICS

- G09—EDUCATION; CRYPTOGRAPHY; DISPLAY; ADVERTISING; SEALS

- G09G—ARRANGEMENTS OR CIRCUITS FOR CONTROL OF INDICATING DEVICES USING STATIC MEANS TO PRESENT VARIABLE INFORMATION

- G09G5/00—Control arrangements or circuits for visual indicators common to cathode-ray tube indicators and other visual indicators

- G09G5/36—Control arrangements or circuits for visual indicators common to cathode-ray tube indicators and other visual indicators characterised by the display of a graphic pattern, e.g. using an all-points-addressable [APA] memory

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/10—Processing, recording or transmission of stereoscopic or multi-view image signals

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/10—Processing, recording or transmission of stereoscopic or multi-view image signals

- H04N13/106—Processing image signals

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/10—Processing, recording or transmission of stereoscopic or multi-view image signals

- H04N13/106—Processing image signals

- H04N13/111—Transformation of image signals corresponding to virtual viewpoints, e.g. spatial image interpolation

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/10—Processing, recording or transmission of stereoscopic or multi-view image signals

- H04N13/106—Processing image signals

- H04N13/111—Transformation of image signals corresponding to virtual viewpoints, e.g. spatial image interpolation

- H04N13/117—Transformation of image signals corresponding to virtual viewpoints, e.g. spatial image interpolation the virtual viewpoint locations being selected by the viewers or determined by viewer tracking

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/10—Processing, recording or transmission of stereoscopic or multi-view image signals

- H04N13/106—Processing image signals

- H04N13/156—Mixing image signals

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/20—Image signal generators

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/20—Image signal generators

- H04N13/204—Image signal generators using stereoscopic image cameras

- H04N13/243—Image signal generators using stereoscopic image cameras using three or more 2D image sensors

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/20—Image signal generators

- H04N13/282—Image signal generators for generating image signals corresponding to three or more geometrical viewpoints, e.g. multi-view systems

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/30—Image reproducers

- H04N13/332—Displays for viewing with the aid of special glasses or head-mounted displays [HMD]

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/30—Image reproducers

- H04N13/332—Displays for viewing with the aid of special glasses or head-mounted displays [HMD]

- H04N13/344—Displays for viewing with the aid of special glasses or head-mounted displays [HMD] with head-mounted left-right displays

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/30—Image reproducers

- H04N13/366—Image reproducers using viewer tracking

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/0101—Head-up displays characterised by optical features

- G02B2027/0132—Head-up displays characterised by optical features comprising binocular systems

- G02B2027/0134—Head-up displays characterised by optical features comprising binocular systems of stereoscopic type

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/0101—Head-up displays characterised by optical features

- G02B2027/0138—Head-up displays characterised by optical features comprising image capture systems, e.g. camera

-

- G—PHYSICS

- G09—EDUCATION; CRYPTOGRAPHY; DISPLAY; ADVERTISING; SEALS

- G09G—ARRANGEMENTS OR CIRCUITS FOR CONTROL OF INDICATING DEVICES USING STATIC MEANS TO PRESENT VARIABLE INFORMATION

- G09G2354/00—Aspects of interface with display user

Description

図3(b)は、左上のカメラ19cにより撮影される視点画像17cと右下のカメラ19gにより撮影される視点画像17gを示す。

図3(c)は、右上のカメラ19aにより撮影される視点画像17aと左下のカメラ19iにより撮影される視点画像17iを示す。

図3(d)は、中央上のカメラ19bにより撮影される視点画像17bと中央左のカメラ19fにより撮影される視点画像17fを示す。

図3(e)は、中央下のカメラ19hにより撮影される視点画像17hと中央右のカメラ19dにより撮影される視点画像17dを示す。

なお2次元座標面上の視点位置の表現手法は一例であり、視点位置は、2つの視点位置間の距離を算出できるように管理されていればよい。

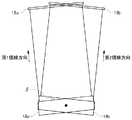

図10(a)は、両眼傾き角度がゼロのHMD100の姿勢を示す。この場合、ユーザは首を横方向に傾けておらず、したがって両眼を結ぶ線Aは水平面と平行となる。

図10(b)は、両眼傾き角度がαとなるHMD100の姿勢を示す。ユーザは首を横方向に傾けることで、両眼を結ぶ線が水平面に対して角度をもつようになる。この例でユーザは、ユーザからみて左側に首を傾けており、両眼を結ぶ線Bは、水平面に対して角度αをもつ。この例で両眼傾き角度αはロール角に相当する。

図11は、ユーザの視線方向と2次元座標面との交点を示す。交点の座標値は、2次元座標面に正対する仮想カメラ8の視点位置、つまりはユーザの視点位置を表現する。以下、2次元座標面とユーザ視線方向との交点座標値を、ユーザの「視線方向位置EP」と呼ぶ。

画像特定部34は視線方向位置EPを特定すると、左目用と右目用の視差画像の生成に用いる2つの画像を、状態決定部32で定めた両眼傾き角度にもとづいて特定する。以下、左目用画像5aの生成に用いる視点画像の座標値を「左目用画像位置LP」、右目用画像5bの生成に用いる視点画像の座標値を「右目用画像位置RP」と呼ぶ。

<パラメータ>

視線方向位置EP:(x0,y0)

視差の設定距離:ipd

両眼傾き角度:α

2次元座標における画像間隔:s

左目用画像位置LPの座標={(x0−(ipd/s)×cos(α)/2),(y0−(ipd/s)×sin(α)/2)}

右目用画像位置RPの座標={(x0+(ipd/s)×cos(α))/2,(y0+(ipd/s)×sin(α)/2)}

の式で導き出せる。

左目用画像位置LPの座標={x0−5×cos(α),y0−5×sin(α)}

右目用画像位置RPの座標={x0+5×cos(α),y0+5×sin(α)}

と表現される。

Claims (11)

- マトリクス状に配列された複数の視点位置から同じ視線方向で取得された複数の視点画像を、2次元座標上の視点位置を表現する座標値に対応付けて記憶する画像記憶装置に接続する情報処理装置であって、

ユーザの頭部に装着されたヘッドマウントディスプレイの姿勢を検出する検出部と、

前記検出部により検出されたヘッドマウントディスプレイの姿勢に応じて、ユーザの視線方向、および両眼を結ぶ線と水平面との角度である両眼傾き角度を定める状態決定部と、

前記画像記憶装置に記憶された複数の視点画像から、左目用と右目用の視差画像の生成に用いる2つの画像を、前記状態決定部で定めたユーザの視線方向および両眼傾き角度にもとづいて特定する画像特定部と、

前記画像特定部が特定した2つの画像から左目用と右目用の視差画像を生成する画像生成部と、

前記画像生成部が生成した視差画像をヘッドマウントディスプレイに提供する画像提供部と、を備え、

前記画像特定部は、2次元座標上のユーザの視線方向位置を特定し、当該視線方向位置から両眼傾き角度に沿う方向に等距離に位置し、且つ2つの画像の視点位置間の距離が設定距離となる2つの画像を特定する、

ことを特徴とする情報処理装置。 - 前記画像生成部は、

両眼傾き角度にもとづいて、2つの画像の角度を調整した視差画像を生成する、

ことを特徴とする請求項1に記載の情報処理装置。 - ユーザから設定距離の指定を受け付ける受付部をさらに備え、

前記画像特定部は、前記受付部で受け付けた指定をもとに、設定距離を変更する、

ことを特徴とする請求項1または2に記載の情報処理装置。 - 前記画像記憶装置には、カメラで取得された複数の実視点画像と、少なくとも2つの実視点画像から補間処理によって生成された複数の補間画像とが、複数の視点画像として記憶されており、

前記画像特定部は、複数の実視点画像と複数の補間画像の中から、視差画像の生成に用いる2つの画像を選択する、

ことを特徴とする請求項1から3のいずれかに記載の情報処理装置。 - マトリクス状に配列された複数の視点位置から同じ視線方向で取得された複数の視点画像を、2次元座標上の視点位置を表現する座標値に対応付けて記憶する画像記憶装置に接続する情報処理装置において、視差画像を生成する方法であって、

ユーザの頭部に装着されたヘッドマウントディスプレイの姿勢を検出するステップと、

検出されたヘッドマウントディスプレイの姿勢に応じて、ユーザの視線方向、および両眼を結ぶ線と水平面との角度である両眼傾き角度を定めるステップと、

前記画像記憶装置に記憶された複数の視点画像から、左目用と右目用の視差画像の生成に用いる2つの画像を、ユーザの視線方向および両眼傾き角度にもとづいて特定するステップと、

特定した2つの画像から左目用と右目用の視差画像を生成するステップと、

生成した視差画像をヘッドマウントディスプレイに提供するステップと、有し、

2つの画像を特定するステップは、2次元座標上のユーザの視線方向位置を特定し、当該視線方向位置から両眼傾き角度に沿う方向に等距離に位置し、且つ2つの画像の視点位置間の距離が設定距離となる2つの画像を特定するステップを含む、

ことを特徴とする画像生成方法。 - マトリクス状に配列された複数の視点位置から同じ視線方向で取得された複数の視点画像を、2次元座標上の視点位置を表現する座標値に対応付けて記憶する画像記憶装置に接続するコンピュータに、

ユーザの頭部に装着されたヘッドマウントディスプレイの姿勢を検出する機能と、

検出されたヘッドマウントディスプレイの姿勢に応じて、ユーザの視線方向、および両眼を結ぶ線と水平面との角度である両眼傾き角度を定める機能と、

前記画像記憶装置に記憶された複数の視点画像から、左目用と右目用の視差画像の生成に用いる2つの画像を、ユーザの視線方向および両眼傾き角度にもとづいて特定する機能と、

特定した2つの画像から左目用と右目用の視差画像を生成する機能と、を実現させるためのプログラムであって、

2つの画像を特定する機能は、2次元座標上のユーザの視線方向位置を特定し、当該視線方向位置から両眼傾き角度に沿う方向に等距離に位置し、且つ2つの画像の視点位置間の距離が設定距離となる2つの画像を特定する機能を含む、プログラム。 - ユーザの頭部に装着されたヘッドマウントディスプレイの姿勢を検出する検出部と、

前記検出部により検出されたヘッドマウントディスプレイの姿勢に応じて、ユーザの視線方向、および両眼を結ぶ線と水平面との角度である両眼傾き角度を定める状態決定部と、

第1視線方向においてマトリクス状に配列された複数の視点位置から取得された複数の視点画像を含む第1画像群および第2視線方向においてマトリクス状に配列された複数の視点位置から取得された複数の視点画像を含む第2画像群から、左目用と右目用の視差画像の生成に用いる少なくとも2つの画像を、前記状態決定部で定めたユーザの視線方向および両眼傾き角度にもとづいて特定する画像特定部と、

前記画像特定部が特定した少なくとも2つの画像から左目用と右目用の視差画像を生成する画像生成部と、

前記画像生成部が生成した視差画像をヘッドマウントディスプレイに提供する画像提供部と、を備え、

前記画像特定部は、1つの視差画像の生成に用いる画像を、第1画像群と第2画像群の双方の中からそれぞれ特定し、

前記画像生成部は、第1画像群の中から特定された1つの画像と、第2画像群の中から特定された1つの画像とを合成して、1つの視差画像を生成する、

ことを特徴とする情報処理装置。 - 前記状態決定部は、第1画像群に含まれる複数の視点画像のそれぞれの視点位置を表現する仮想的な2次元座標面および第2画像群に含まれる複数の視点画像のそれぞれの視点位置を表現する仮想的な2次元座標面を配置した空間において、ユーザの視線方向に対応する仮想カメラの視線方向を設定し、

前記画像特定部は、仮想カメラの視線方向に直交する仮想平面上に、左目用の視差画像の生成に用いる画像の仮想的な座標値である左目用画像位置LPと、右目用の視差画像の生成に用いる画像の仮想的な座標値である右目用画像位置RPとを特定し、

左目用画像位置LPを通る仮想平面に垂直な直線が、第1画像群の仮想的な2次元座標面および第2画像群の仮想的な2次元座標面の双方に交差する場合、それぞれの交差点に対応付けられた2つの画像を、左目用の視差画像の生成に用いる画像として特定し、

右目用画像位置RPを通る仮想平面に垂直な直線が、第1画像群の仮想的な2次元座標面および第2画像群の仮想的な2次元座標面の双方に交差する場合、それぞれの交差点に対応付けられた2つの画像を、右目用の視差画像の生成に用いる画像として特定する、

ことを特徴とする請求項7に記載の情報処理装置。 - ユーザの頭部に装着されたヘッドマウントディスプレイの姿勢を検出するステップと、

検出されたヘッドマウントディスプレイの姿勢に応じて、ユーザの視線方向、および両眼を結ぶ線と水平面との角度である両眼傾き角度を定めるステップと、

第1視線方向においてマトリクス状に配列された複数の視点位置から取得された複数の視点画像を含む第1画像群および第2視線方向においてマトリクス状に配列された複数の視点位置から取得された複数の視点画像を含む第2画像群から、左目用と右目用の視差画像の生成に用いる少なくとも2つの画像を、ユーザの視線方向および両眼傾き角度にもとづいて特定するステップと、

特定した少なくとも2つの画像から左目用と右目用の視差画像を生成するステップと、を有し、

画像を特定するステップは、1つの視差画像の生成に用いる画像を、第1画像群と第2画像群の双方の中からそれぞれ特定するステップを含み、

視差画像を生成するステップは、第1画像群の中から特定された1つの画像と、第2画像群の中から特定された1つの画像とを合成して、1つの視差画像を生成するステップを含む、

画像生成方法。 - コンピュータに、

ユーザの頭部に装着されたヘッドマウントディスプレイの姿勢を検出する機能と、

検出されたヘッドマウントディスプレイの姿勢に応じて、ユーザの視線方向、および両眼を結ぶ線と水平面との角度である両眼傾き角度を定める機能と、

第1視線方向においてマトリクス状に配列された複数の視点位置から取得された複数の視点画像を含む第1画像群および第2視線方向においてマトリクス状に配列された複数の視点位置から取得された複数の視点画像を含む第2画像群から、左目用と右目用の視差画像の生成に用いる少なくとも2つの画像を、ユーザの視線方向および両眼傾き角度にもとづいて特定する機能と、

特定した少なくとも2つの画像から左目用と右目用の視差画像を生成する機能と、を実現させるためのプログラムであって、

画像を特定する機能は、1つの視差画像の生成に用いる画像を、第1画像群と第2画像群の双方の中からそれぞれ特定する機能を含み、

視差画像を生成する機能は、第1画像群の中から特定された1つの画像と、第2画像群の中から特定された1つの画像とを合成して、1つの視差画像を生成する機能を含む、プログラム。 - 請求項6または10に記載のプログラムを記録したコンピュータ読み取り可能な記録媒体。

Priority Applications (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2016184424A JP6732617B2 (ja) | 2016-09-21 | 2016-09-21 | 情報処理装置および画像生成方法 |

| US16/329,918 US11184597B2 (en) | 2016-09-21 | 2017-09-14 | Information processing device, image generation method, and head-mounted display |

| PCT/JP2017/033190 WO2018056155A1 (ja) | 2016-09-21 | 2017-09-14 | 情報処理装置、画像生成方法およびヘッドマウントディスプレイ |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2016184424A JP6732617B2 (ja) | 2016-09-21 | 2016-09-21 | 情報処理装置および画像生成方法 |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2018050179A JP2018050179A (ja) | 2018-03-29 |

| JP2018050179A5 JP2018050179A5 (ja) | 2018-11-15 |

| JP6732617B2 true JP6732617B2 (ja) | 2020-07-29 |

Family

ID=61691028

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2016184424A Active JP6732617B2 (ja) | 2016-09-21 | 2016-09-21 | 情報処理装置および画像生成方法 |

Country Status (3)

| Country | Link |

|---|---|

| US (1) | US11184597B2 (ja) |

| JP (1) | JP6732617B2 (ja) |

| WO (1) | WO2018056155A1 (ja) |

Families Citing this family (11)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN108111874B (zh) * | 2016-11-16 | 2020-01-31 | 腾讯科技(深圳)有限公司 | 一种文件处理方法、终端及服务器 |

| US10488920B2 (en) * | 2017-06-02 | 2019-11-26 | Htc Corporation | Immersive headset system and control method thereof |

| GB2569785B (en) * | 2017-12-20 | 2022-07-13 | Sony Interactive Entertainment Inc | Data processing |

| FR3075985B1 (fr) * | 2017-12-21 | 2019-11-15 | Thales | Procede et systeme d'harmonisation duale d'un systeme d'affichage tete haute porte pour rendre conforme l'affichage d'informations de pilotage d'un aeronef avec le monde reel exterieur |

| US10554883B2 (en) * | 2018-03-30 | 2020-02-04 | Ricoh Company, Ltd. | VR system, communication method, and non-transitory computer-readable medium |

| CN112313949B (zh) * | 2018-06-25 | 2022-10-04 | 京瓷株式会社 | 三维显示系统、光学元件、设置方法、控制方法以及移动体 |

| US10764553B2 (en) * | 2018-11-27 | 2020-09-01 | Number 9, LLC | Immersive display system with adjustable perspective |

| JP7349808B2 (ja) | 2019-03-20 | 2023-09-25 | 任天堂株式会社 | 画像表示システム、画像表示プログラム、画像表示装置、および画像表示方法 |

| US11800231B2 (en) | 2019-09-19 | 2023-10-24 | Apple Inc. | Head-mounted display |

| JP2021089382A (ja) | 2019-12-05 | 2021-06-10 | キヤノン株式会社 | 電子機器、電子機器の制御方法、プログラム、記憶媒体 |

| CN112672138A (zh) * | 2020-12-14 | 2021-04-16 | 聚好看科技股份有限公司 | 一种3d视频图像显示方法及显示设备 |

Family Cites Families (17)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US5841409A (en) | 1995-04-18 | 1998-11-24 | Minolta Co., Ltd. | Image display apparatus |

| JPH08339043A (ja) | 1995-06-12 | 1996-12-24 | Minolta Co Ltd | 映像表示装置 |

| JP3420060B2 (ja) * | 1998-05-26 | 2003-06-23 | 日本電信電話株式会社 | 水平配置立体画像表示システム |

| JP3413489B2 (ja) * | 2000-05-10 | 2003-06-03 | 独立行政法人産業技術総合研究所 | 遠隔操作用画像の伝送方法 |

| IL139995A (en) | 2000-11-29 | 2007-07-24 | Rvc Llc | System and method for spherical stereoscopic photographing |

| WO2002073955A1 (en) * | 2001-03-13 | 2002-09-19 | Canon Kabushiki Kaisha | Image processing apparatus, image processing method, studio apparatus, storage medium, and program |

| JP2002354505A (ja) | 2001-05-29 | 2002-12-06 | Vstone Kk | 立体視システム |

| JP2010258583A (ja) * | 2009-04-22 | 2010-11-11 | Panasonic Corp | 立体画像表示装置、立体画像再生装置および立体画像視認システム |

| US8953242B2 (en) * | 2011-03-31 | 2015-02-10 | Honeywell International Inc. | Varible focus stereoscopic display system and method |

| JP2012244453A (ja) * | 2011-05-20 | 2012-12-10 | Panasonic Corp | 画像表示装置、画像表示システム、及び3次元眼鏡 |

| WO2012172719A1 (ja) * | 2011-06-16 | 2012-12-20 | パナソニック株式会社 | ヘッドマウントディスプレイおよびその位置ずれ調整方法 |

| JP5881732B2 (ja) * | 2011-11-16 | 2016-03-09 | 株式会社東芝 | 画像処理装置、立体画像表示装置、画像処理方法および画像処理プログラム |

| EP2922049A4 (en) | 2012-11-13 | 2016-07-13 | Sony Corp | PICTURE DISPLAY DEVICE AND PICTURE DISPLAY METHOD, MOBILE BODY DEVICE, PICTURE DISPLAY SYSTEM AND COMPUTER PROGRAM |

| JP6353214B2 (ja) | 2013-11-11 | 2018-07-04 | 株式会社ソニー・インタラクティブエンタテインメント | 画像生成装置および画像生成方法 |

| GB2525170A (en) * | 2014-04-07 | 2015-10-21 | Nokia Technologies Oy | Stereo viewing |

| US10742950B2 (en) * | 2016-02-15 | 2020-08-11 | Nvidia Corporation | Collecting and processing stereoscopic digital image data to produce a parallax corrected tilted head view |

| US20180007328A1 (en) * | 2016-07-01 | 2018-01-04 | Intel Corporation | Viewpoint adaptive image projection system |

-

2016

- 2016-09-21 JP JP2016184424A patent/JP6732617B2/ja active Active

-

2017

- 2017-09-14 WO PCT/JP2017/033190 patent/WO2018056155A1/ja active Application Filing

- 2017-09-14 US US16/329,918 patent/US11184597B2/en active Active

Also Published As

| Publication number | Publication date |

|---|---|

| WO2018056155A1 (ja) | 2018-03-29 |

| US20190215505A1 (en) | 2019-07-11 |

| US11184597B2 (en) | 2021-11-23 |

| JP2018050179A (ja) | 2018-03-29 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6732617B2 (ja) | 情報処理装置および画像生成方法 | |

| WO2015068656A1 (ja) | 画像生成装置および画像生成方法 | |

| WO2017077918A1 (ja) | 情報処理装置、情報処理システム、および情報処理方法 | |

| JP5891131B2 (ja) | 画像生成装置および画像生成方法 | |

| WO2017086263A1 (ja) | 情報処理装置および画像生成方法 | |

| CN108156441A (zh) | 视觉视频稳定 | |

| US10681276B2 (en) | Virtual reality video processing to compensate for movement of a camera during capture | |

| JP2013258614A (ja) | 画像生成装置および画像生成方法 | |

| JP6899875B2 (ja) | 情報処理装置、映像表示システム、情報処理装置の制御方法、及びプログラム | |

| JP6518578B2 (ja) | 表示制御装置及び表示制御方法 | |

| JP6216398B2 (ja) | 画像生成装置および画像生成方法 | |

| JP2016015683A (ja) | 画像生成装置および画像生成方法 | |

| WO2019163031A1 (ja) | 画像処理装置および画像処理方法 | |

| JP6859447B2 (ja) | 情報処理システムおよび対象物情報取得方法 | |

| JP2022183177A (ja) | ヘッドマウントディスプレイ装置 | |

| JP6649010B2 (ja) | 情報処理装置 | |

| JP6588196B2 (ja) | 画像生成装置、画像生成方法および較正方法 | |

| JP6518645B2 (ja) | 情報処理装置および画像生成方法 | |

| JP6487512B2 (ja) | ヘッドマウントディスプレイおよび画像生成方法 | |

| JP2018056845A (ja) | 作業支援装置、システム、方法及びプログラム | |

| WO2012169221A1 (ja) | 立体画像表示装置および立体画像表示方法 | |

| JP2020024746A (ja) | 情報処理装置、情報処理装置のプログラム、ヘッドマウントディスプレイ、及び、表示システム | |

| WO2017163649A1 (ja) | 画像処理装置 | |

| JP2019216344A (ja) | 全天周立体映像表示装置及びそのプログラム、全天周立体映像撮影装置、並びに、全天周立体映像システム | |

| JP6705929B2 (ja) | 表示制御装置及び表示制御方法 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20181004 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20181004 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20191224 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20200121 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20200616 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20200708 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6732617 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |