JP6588196B2 - 画像生成装置、画像生成方法および較正方法 - Google Patents

画像生成装置、画像生成方法および較正方法 Download PDFInfo

- Publication number

- JP6588196B2 JP6588196B2 JP2014222569A JP2014222569A JP6588196B2 JP 6588196 B2 JP6588196 B2 JP 6588196B2 JP 2014222569 A JP2014222569 A JP 2014222569A JP 2014222569 A JP2014222569 A JP 2014222569A JP 6588196 B2 JP6588196 B2 JP 6588196B2

- Authority

- JP

- Japan

- Prior art keywords

- marker

- head

- user

- viewpoint position

- dimensional

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/30—Image reproducers

- H04N13/327—Calibration thereof

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/70—Determining position or orientation of objects or cameras

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/10—Processing, recording or transmission of stereoscopic or multi-view image signals

- H04N13/106—Processing image signals

- H04N13/111—Transformation of image signals corresponding to virtual viewpoints, e.g. spatial image interpolation

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/10—Processing, recording or transmission of stereoscopic or multi-view image signals

- H04N13/106—Processing image signals

- H04N13/111—Transformation of image signals corresponding to virtual viewpoints, e.g. spatial image interpolation

- H04N13/117—Transformation of image signals corresponding to virtual viewpoints, e.g. spatial image interpolation the virtual viewpoint locations being selected by the viewers or determined by viewer tracking

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/30—Image reproducers

- H04N13/302—Image reproducers for viewing without the aid of special glasses, i.e. using autostereoscopic displays

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/30—Image reproducers

- H04N13/366—Image reproducers using viewer tracking

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30204—Marker

- G06T2207/30208—Marker matrix

Landscapes

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Signal Processing (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- Testing, Inspecting, Measuring Of Stereoscopic Televisions And Televisions (AREA)

- Processing Or Creating Images (AREA)

Description

(1)カメラ入力座標系

カメラ310による撮影画像の2次元座標系であり、座標系の単位は撮影画像のピクセル単位である。

(2)ワールド座標系

3次元オブジェクト600が存在する3次元空間の座標系である。右目の透視投影の原点と左目の透視投影の原点の中点をワールド座標系の原点とし、ディスプレイ300のスクリーンに向かう方向をZ軸とし、水平方向をX軸、垂直方向をY軸とする。座標系の単位は実空間の長さの単位である。

(3)ディスプレイのスクリーン座標系

ディスプレイ300のピクセル空間で表される2次元のスクリーン座標系であり、座標系の単位はディスプレイ300の表示ピクセル単位である。

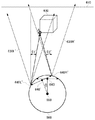

yTran= (hposT−hRef)・hScale

yTran=(hpos0−hRef+hDist・(1−cos(vAngle)))・hScale

yAdj=−yTran/sScale

左目について

xShift= (Ew/2)・cos(vAngle)

yShift=−(Ew/2)・sin(vAngle)

右目について

xShift=−(Ew/2)・cos(vAngle)

yShift= (Ew/2)・sin(vAngle)

xShiftAdj=−xShift/sScale

yShiftAdj=−yShift/sScale

tanθ2’=(−a・sinΦ+(Ew/2)・cosΦ)/(d−a・(1−cosΦ)−(Ew/2)・sinΦ)

tanθ2”=(−a’・sinΦ+Ew/2)/d

tanθ2’=(−a・Φ+Ew/2)/(d−(Ew/2)・Φ)=(−a・Φ+Ew/2+(Ew/2d)・Φ)/d

tanθ2”=(−a’・Φ+Ew/2)/d

Claims (6)

- ユーザの頭部に装着された装身具の頭頂部のマーカーの撮影画像をスキャンして前記頭頂部のマーカーの撮影画像上の2次元座標を検出するマーカー検出部と、

前記頭頂部のマーカーのZ方向の座標を用いることなく、検出された前記頭頂部のマーカーの2次元座標にもとづいて視点位置の並進補正量を求める並進補正量計算部と、

前記並進補正量にもとづいて視点位置を更新する視点位置更新部と、

更新された視点位置から3次元オブジェクトを見た場合の視差画像を生成する立体画像生成部と、

較正用3次元オブジェクトの視差画像を前記立体画像生成部に生成させ、頭部を垂直方向の回転軸周りに回転しても立体視された較正用3次元オブジェクトが静止するように、ユーザの頭部に装着された装身具を前後させてマーカーの位置を調整するようユーザに促す較正部とを含むことを特徴とする画像生成装置。 - ユーザの頭部に装着された装身具の頭頂部のマーカーと左側頭部のマーカーと右側頭部のマーカーの撮影画像をスキャンして前記頭頂部のマーカーと前記左側頭部のマーカーと前記右側頭部のマーカーの撮影画像上の2次元座標を検出するマーカー検出部と、

前記左側頭部のマーカーと前記右側頭部のマーカーのZ方向の座標を用いることなく、検出された前記左側頭部のマーカーの2次元座標および前記右側頭部のマーカーの2次元座標にもとづいて前記左側頭部のマーカーと前記右側頭部のマーカーを結ぶ線が水平方向に対してなす角度である頭部の傾きを求める頭部傾き計算部と、

前記頭部の傾きにもとづいて視点位置のシフト量を求めるシフト量計算部と、

前記頭頂部のマーカーのZ方向の座標を用いることなく、検出された前記頭頂部のマーカーの2次元座標および前記頭部の傾きにもとづいて視点位置の並進補正量を求める並進補正量計算部と、

前記シフト量および前記並進補正量にもとづいて視点位置を更新する視点位置更新部と、

更新された視点位置から3次元オブジェクトを見た場合の視差画像を生成する立体画像生成部とを含むことを特徴とする画像生成装置。 - 較正用3次元オブジェクトの視差画像を前記立体画像生成部に生成させ、頭部を垂直方向の回転軸周りに回転しても立体視された較正用3次元オブジェクトが静止するように、ユーザの頭部に装着された装身具を前後させてマーカーの位置を調整するようユーザに促す較正部をさらに含むことを特徴とする請求項2に記載の画像生成装置。

- ユーザの頭部に装着された装身具の複数のマーカーの撮影画像をスキャンして前記複数のマーカーの撮影画像上の2次元座標を検出するマーカー検出ステップと、

マーカーのZ方向の座標を用いることなく、検出された前記複数のマーカーの2次元座標を用いて、ユーザの視点位置を補正する視点位置補正ステップと、

更新された視点位置から較正用3次元オブジェクトを見た場合の視差画像を生成する立体画像生成ステップと、

頭部を垂直方向の回転軸周りに回転しても立体視された較正用3次元オブジェクトが静止するように、ユーザの頭部に装着された装身具を前後させてマーカーの位置を調整するようユーザに促す較正ステップとを含むことを特徴とする較正方法。 - ユーザの頭部に装着された装身具の頭頂部のマーカーの撮影画像をスキャンして前記頭頂部のマーカーの撮影画像上の2次元座標を検出するマーカー検出ステップと、

前記頭頂部のマーカーのZ方向の座標を用いることなく、検出された前記頭頂部のマーカーの2次元座標にもとづいて視点位置の並進補正量を求める並進補正量計算ステップと、

前記並進補正量にもとづいて視点位置を更新する視点位置更新ステップと、

更新された視点位置から3次元オブジェクトを見た場合の視差画像を生成する立体画像生成ステップと、

較正用3次元オブジェクトの視差画像を前記立体画像生成ステップに生成させ、頭部を垂直方向の回転軸周りに回転しても立体視された較正用3次元オブジェクトが静止するように、ユーザの頭部に装着された装身具を前後させてマーカーの位置を調整するようユーザに促す較正ステップとを含むことを特徴とする画像生成方法。 - ユーザの頭部に装着された装身具の頭頂部のマーカーの撮影画像をスキャンして前記頭頂部のマーカーの撮影画像上の2次元座標を検出するマーカー検出機能と、

前記頭頂部のマーカーのZ方向の座標を用いることなく、検出された前記頭頂部のマーカーの2次元座標にもとづいて視点位置の並進補正量を求める並進補正量計算機能と、

前記並進補正量にもとづいて視点位置を更新する視点位置更新機能と、

更新された視点位置から3次元オブジェクトを見た場合の視差画像を生成する立体画像生成機能と、

較正用3次元オブジェクトの視差画像を前記立体画像生成機能に生成させ、頭部を垂直方向の回転軸周りに回転しても立体視された較正用3次元オブジェクトが静止するように、ユーザの頭部に装着された装身具を前後させてマーカーの位置を調整するようユーザに促す較正機能とをコンピュータに実現させることを特徴とするプログラム。

Priority Applications (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2014222569A JP6588196B2 (ja) | 2014-10-31 | 2014-10-31 | 画像生成装置、画像生成方法および較正方法 |

| US15/519,295 US10362297B2 (en) | 2014-10-31 | 2015-08-26 | Image generation apparatus, image generation method, and calibration method |

| PCT/JP2015/074010 WO2016067729A1 (ja) | 2014-10-31 | 2015-08-26 | 画像生成装置、画像生成方法および較正方法 |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2014222569A JP6588196B2 (ja) | 2014-10-31 | 2014-10-31 | 画像生成装置、画像生成方法および較正方法 |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2016092512A JP2016092512A (ja) | 2016-05-23 |

| JP2016092512A5 JP2016092512A5 (ja) | 2017-09-07 |

| JP6588196B2 true JP6588196B2 (ja) | 2019-10-09 |

Family

ID=55857075

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2014222569A Active JP6588196B2 (ja) | 2014-10-31 | 2014-10-31 | 画像生成装置、画像生成方法および較正方法 |

Country Status (3)

| Country | Link |

|---|---|

| US (1) | US10362297B2 (ja) |

| JP (1) | JP6588196B2 (ja) |

| WO (1) | WO2016067729A1 (ja) |

Families Citing this family (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP6798204B2 (ja) * | 2016-09-08 | 2020-12-09 | 富士ゼロックス株式会社 | 立位姿勢評価装置 |

| WO2019026183A1 (ja) * | 2017-08-01 | 2019-02-07 | 株式会社ソニー・インタラクティブエンタテインメント | 画像生成装置および画像生成方法 |

| JP6920440B2 (ja) * | 2017-08-01 | 2021-08-18 | 株式会社ソニー・インタラクティブエンタテインメント | 画像生成装置および画像生成方法 |

| JP7224559B2 (ja) * | 2020-12-10 | 2023-02-17 | 三菱電機株式会社 | 遠隔制御マニピュレータシステムおよび遠隔制御支援システム |

| SE2350088A1 (en) * | 2023-01-31 | 2024-08-01 | Tobii Ab | Systems and methods for head pose data |

Family Cites Families (15)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH0628452A (ja) * | 1991-08-07 | 1994-02-04 | Nec Home Electron Ltd | 3次元画像処理装置 |

| JP3443272B2 (ja) * | 1996-05-10 | 2003-09-02 | 三洋電機株式会社 | 立体映像表示装置 |

| JP2000315259A (ja) * | 1999-05-06 | 2000-11-14 | Sharp Corp | データベース作成装置及びデータベース作成プログラムを記録した記録媒体 |

| JP3469884B2 (ja) * | 2001-03-29 | 2003-11-25 | 三洋電機株式会社 | 立体映像表示装置 |

| JP2007102343A (ja) * | 2005-09-30 | 2007-04-19 | Fujifilm Corp | 関心度測定装置および方法並びに関心度算出プログラム |

| JP2007232753A (ja) * | 2006-02-27 | 2007-09-13 | Eyemetrics Japan Co Ltd | 眼鏡仕様設定装置及び視野検出装置 |

| JP5066479B2 (ja) * | 2008-04-25 | 2012-11-07 | 横河電子機器株式会社 | 被指揮者識別装置及び指揮支援システム |

| CN102577398B (zh) * | 2009-06-05 | 2015-11-25 | Lg电子株式会社 | 图像显示装置及其操作方法 |

| CN101750747B (zh) * | 2010-02-01 | 2013-04-24 | 刘武强 | 三维立体成像方法、系统和成像设备 |

| US8704879B1 (en) * | 2010-08-31 | 2014-04-22 | Nintendo Co., Ltd. | Eye tracking enabling 3D viewing on conventional 2D display |

| US20120050154A1 (en) * | 2010-08-31 | 2012-03-01 | Adil Jagmag | Method and system for providing 3d user interface in 3d televisions |

| JP2012141502A (ja) * | 2011-01-05 | 2012-07-26 | Nippon Seiki Co Ltd | 視点位置検出装置、視点位置検出方法及び立体表示装置 |

| JP2012223363A (ja) * | 2011-04-20 | 2012-11-15 | Tokyo Institute Of Technology | 手術用撮像システム及び手術用ロボット |

| JP2013120150A (ja) * | 2011-12-08 | 2013-06-17 | Samsung Yokohama Research Institute Co Ltd | 人間位置検出システム及び人間位置検出方法 |

| JP6380881B2 (ja) * | 2012-07-31 | 2018-08-29 | Tianma Japan株式会社 | 立体画像表示装置、画像処理装置及び立体画像処理方法 |

-

2014

- 2014-10-31 JP JP2014222569A patent/JP6588196B2/ja active Active

-

2015

- 2015-08-26 US US15/519,295 patent/US10362297B2/en active Active

- 2015-08-26 WO PCT/JP2015/074010 patent/WO2016067729A1/ja active Application Filing

Also Published As

| Publication number | Publication date |

|---|---|

| US10362297B2 (en) | 2019-07-23 |

| JP2016092512A (ja) | 2016-05-23 |

| WO2016067729A1 (ja) | 2016-05-06 |

| US20170230644A1 (en) | 2017-08-10 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6972105B2 (ja) | 固定距離の仮想現実システムおよび拡張現実システムならびに方法 | |

| US11455032B2 (en) | Immersive displays | |

| JP6732617B2 (ja) | 情報処理装置および画像生成方法 | |

| WO2015068656A1 (ja) | 画像生成装置および画像生成方法 | |

| CN107209950B (zh) | 从现实世界材料自动生成虚拟材料 | |

| JP6588196B2 (ja) | 画像生成装置、画像生成方法および較正方法 | |

| CN114945853A (zh) | 用于头戴式显示系统中的变形的补偿 | |

| KR20160094190A (ko) | 시선 추적 장치 및 방법 | |

| JP7148634B2 (ja) | ヘッドマウントディスプレイ装置 | |

| JP6975309B2 (ja) | 画像処理装置および画像処理方法 | |

| JP2011165068A (ja) | 画像生成装置、画像表示システム、画像生成方法、及びプログラム | |

| JP2005312605A (ja) | 注視点位置表示装置 | |

| KR102113285B1 (ko) | 평행축 방식의 양안 카메라 시스템에서 근거리 물체의 입체영상을 위한 영상처리 방법 및 장치 | |

| JP6446465B2 (ja) | 入出力装置、入出力プログラム、および入出力方法 | |

| KR20200128661A (ko) | 뷰 이미지를 생성하기 위한 장치 및 방법 | |

| JP2012244466A (ja) | 立体画像処理装置 | |

| WO2017191703A1 (ja) | 画像処理装置 | |

| WO2012169221A1 (ja) | 立体画像表示装置および立体画像表示方法 | |

| KR20160116145A (ko) | 투과형 홀로그램을 이용한 hmd | |

| WO2022192306A1 (en) | Image display within a three-dimensional environment | |

| WO2012169220A1 (ja) | 立体画像表示装置および立体画像表示方法 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20170727 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20170727 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20180925 |

|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20181113 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20190305 |

|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20190422 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20190903 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20190912 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6588196 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |