JP6673005B2 - 顔向き推定装置及び顔向き推定方法 - Google Patents

顔向き推定装置及び顔向き推定方法 Download PDFInfo

- Publication number

- JP6673005B2 JP6673005B2 JP2016101244A JP2016101244A JP6673005B2 JP 6673005 B2 JP6673005 B2 JP 6673005B2 JP 2016101244 A JP2016101244 A JP 2016101244A JP 2016101244 A JP2016101244 A JP 2016101244A JP 6673005 B2 JP6673005 B2 JP 6673005B2

- Authority

- JP

- Japan

- Prior art keywords

- driver

- face direction

- visual recognition

- unit

- behavior

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

- 238000000034 method Methods 0.000 title claims description 62

- 230000000007 visual effect Effects 0.000 claims description 92

- 230000008859 change Effects 0.000 claims description 66

- 238000001514 detection method Methods 0.000 claims description 63

- 230000008569 process Effects 0.000 claims description 53

- 230000001133 acceleration Effects 0.000 claims description 19

- 230000009471 action Effects 0.000 claims description 15

- 238000012545 processing Methods 0.000 claims description 15

- 239000011521 glass Substances 0.000 claims description 10

- 238000005259 measurement Methods 0.000 claims description 8

- 230000006399 behavior Effects 0.000 description 64

- 238000004891 communication Methods 0.000 description 29

- 210000003128 head Anatomy 0.000 description 19

- 238000012937 correction Methods 0.000 description 10

- 238000002570 electrooculography Methods 0.000 description 9

- 230000033001 locomotion Effects 0.000 description 8

- 230000002159 abnormal effect Effects 0.000 description 7

- 210000005252 bulbus oculi Anatomy 0.000 description 6

- 238000010586 diagram Methods 0.000 description 4

- 230000004424 eye movement Effects 0.000 description 4

- 230000007704 transition Effects 0.000 description 4

- 230000006870 function Effects 0.000 description 3

- 230000005856 abnormality Effects 0.000 description 2

- 238000009825 accumulation Methods 0.000 description 2

- 238000005516 engineering process Methods 0.000 description 2

- 230000004048 modification Effects 0.000 description 2

- 238000012986 modification Methods 0.000 description 2

- WHXSMMKQMYFTQS-UHFFFAOYSA-N Lithium Chemical compound [Li] WHXSMMKQMYFTQS-UHFFFAOYSA-N 0.000 description 1

- HBBGRARXTFLTSG-UHFFFAOYSA-N Lithium ion Chemical compound [Li+] HBBGRARXTFLTSG-UHFFFAOYSA-N 0.000 description 1

- 206010041349 Somnolence Diseases 0.000 description 1

- 238000005452 bending Methods 0.000 description 1

- 230000005540 biological transmission Effects 0.000 description 1

- 238000012790 confirmation Methods 0.000 description 1

- 238000010191 image analysis Methods 0.000 description 1

- 230000006872 improvement Effects 0.000 description 1

- 229910052744 lithium Inorganic materials 0.000 description 1

- 229910001416 lithium ion Inorganic materials 0.000 description 1

- 239000007769 metal material Substances 0.000 description 1

- 230000009467 reduction Effects 0.000 description 1

- 238000009420 retrofitting Methods 0.000 description 1

- 229910001220 stainless steel Inorganic materials 0.000 description 1

- 239000010935 stainless steel Substances 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

- G08G1/16—Anti-collision systems

Description

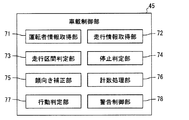

本開示の第一実施形態による顔向き推定システム100は、図1及び図2に示すように、互いに通信可能なウェアラブルデバイス10及び車載デバイス40等によって構成されている。顔向き推定システム100は、移動体である車両110の車室内において主に機能する。顔向き推定システム100は、車両110に搭乗し、車両110を運転する運転者DRの頭部HDの挙動を、ウェアラブルデバイス10によって検出する。顔向き推定システム100は、検出された頭部HDの挙動から運転者DRの顔向きを車載デバイス40によって演算する。

図11に示す本発明の第二実施形態による顔向き推定システム200は、第一実施形態の変形例である。第二実施形態の顔向き推定システム200では、運転者DR(図2参照)の顔向きを推定する各処理が主にウェアラブルデバイス210によって実施される。車載デバイス240は、取得した車速情報及び道路の形状情報を、無線通信によって通信ユニット47からウェアラブルデバイス210に送信する。

以上、本開示による複数の実施形態について説明したが、本開示は、上記実施形態に限定して解釈されるものではなく、本開示の要旨を逸脱しない範囲内において種々の実施形態及び組み合わせに適用することができる。

Claims (12)

- 移動体(110)を運転する運転者(DR)の顔向きを検出した検出結果を取得する顔向き情報取得部(71)と、

前記顔向き情報取得部の取得した前記検出結果に基づき、前記移動体に設置された視認対象物を前記運転者が視認した回数を計数する計数処理部(76)と、

前記顔向き情報取得部の取得した前記検出結果の変化に基づき、前記運転者の視認する前景中での消失点の位置変化に起因して前記視認対象物を視認する前記運転者の視認行動が変化したか否かを判定する行動判定部(77)と、を備え、

前記計数処理部は、前記行動判定部にて前記運転者の視認行動が変化したと判定された場合に、前記消失点の位置変化に合わせて、前記運転者が前記視認対象物を視認した回数を計数する計数処理の内容を変更する顔向き推定装置。 - 前記行動判定部は、前記視認対象物を視認する頻度、前記視認対象物を視認するパターン、及び左右に並ぶ前記視認対象物の視認回数の割合、の少なくとも一つが変化した場合に、前記運転者の視認行動が変化したか否かを判定する請求項1に記載の顔向き推定装置。

- 前記視認対象物には、前記移動体としての車両に設置された左右のサイドミラー(111,112)が含まれ、

前記行動判定部は、左右のうちで前記運転者から遠い側の前記サイドミラーを視認する行動の態様変化に基づき、前記運転者による視認行動が変化したか否かを判定する請求項2に記載の顔向き推定装置。 - 前記移動体が走行を予定している道路の形状情報を取得する走行情報取得部(72)、をさらに備え、

前記行動判定部は、前記形状情報に基づき前記移動体がカーブ区間又は坂道区間を走行している場合に、前記運転者の視認行動が変化していると判定する請求項1〜3のいずれか一項に記載の顔向き推定装置。 - 前記顔向き情報取得部の取得した前記検出結果を蓄積する記憶領域(46a,216a)、をさらに備え、

前記計数処理部は、前記記憶領域に蓄積された前記検出結果に基づいて前記視認対象物の位置を特定する請求項1〜4のいずれか一項に記載の顔向き推定装置。 - 前記移動体が直線区間を走行しているか否かを判定する走行区間判定部(73)、をさらに備え、

前記走行区間判定部にて直線区間でないと判定された期間に取得される顔向きの前記検出結果は、前記記憶領域に蓄積される対象から除外される請求項5に記載の顔向き推定装置。 - 前記計数処理部は、前記行動判定部にて前記運転者の視認行動が変化したと判定された場合に、前記視認対象物の視認回数を計数するための閾値を変更する請求項1〜6のいずれか一項に記載の顔向き推定装置。

- 前記移動体が停止状態にあるか否かを判定する停止判定部(74)、をさらに備え、

前記計数処理部は、前記停止判定部にて前記移動体が停止状態にあると判定された場合に、計数処理を中断する請求項1〜7のいずれか一項に記載の顔向き推定装置。 - 前記顔向き情報取得部は、前記運転者の頭部(HD)に装着されて当該頭部に作用する加速度を計測する加速度センサ(14)の計測データを取得し、

前記停止判定部は、前記加速度センサにて検出された計測データに基づいて、前記移動体が停止状態にあるか否かを判定する請求項8に記載の顔向き推定装置。 - 前記顔向き情報取得部は、前記運転者の頭部に装着されて当該頭部に生じた角速度を計測するジャイロセンサ(13)の計測データを取得する請求項1〜9のいずれか一項に記載の顔向き推定装置。

- 前記顔向き情報取得部は、前記運転者に装着されるメガネ(10a)に搭載された顔向き検出部(11)から前記検出結果を取得する請求項1〜10のいずれか一項に記載の顔向き推定装置。

- 移動体(110)を運転する運転者(DR)の顔向きを推定する顔向き推定方法であって、

少なくとも一つのプロセッサ(45a,215a)は、

前記運転者の顔向きを検出する顔向き検出部(11)の検出結果に基づき、前記移動体に設置された視認対象物を前記運転者が視認した回数を計数し(S107)、

前記顔向き検出部の前記検出結果の変化に基づき、前記運転者の視認する前景中での消失点の位置変化に起因して前記視認対象物を視認する前記運転者の視認行動が変化したか否かを判定し(S105)、

前記運転者の視認行動が変化したと判定された場合に、前記消失点の位置変化に合わせて、前記運転者が前記視認対象物を視認した回数を計数する計数処理の内容を変更する(S106)顔向き推定方法。

Priority Applications (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2016101244A JP6673005B2 (ja) | 2016-05-20 | 2016-05-20 | 顔向き推定装置及び顔向き推定方法 |

| PCT/JP2017/016322 WO2017199709A1 (ja) | 2016-05-20 | 2017-04-25 | 顔向き推定装置及び顔向き推定方法 |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2016101244A JP6673005B2 (ja) | 2016-05-20 | 2016-05-20 | 顔向き推定装置及び顔向き推定方法 |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2017208007A JP2017208007A (ja) | 2017-11-24 |

| JP2017208007A5 JP2017208007A5 (ja) | 2019-06-06 |

| JP6673005B2 true JP6673005B2 (ja) | 2020-03-25 |

Family

ID=60325010

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2016101244A Active JP6673005B2 (ja) | 2016-05-20 | 2016-05-20 | 顔向き推定装置及び顔向き推定方法 |

Country Status (2)

| Country | Link |

|---|---|

| JP (1) | JP6673005B2 (ja) |

| WO (1) | WO2017199709A1 (ja) |

Families Citing this family (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP7127282B2 (ja) * | 2017-12-25 | 2022-08-30 | いすゞ自動車株式会社 | 運転状態判定装置及び運転状態判定方法 |

| JP6977589B2 (ja) | 2018-01-31 | 2021-12-08 | 株式会社デンソー | 車両用警報装置 |

| JP7152651B2 (ja) * | 2018-05-14 | 2022-10-13 | 富士通株式会社 | プログラム、情報処理装置、及び情報処理方法 |

| JP7067353B2 (ja) * | 2018-08-09 | 2022-05-16 | トヨタ自動車株式会社 | 運転者情報判定装置 |

| JP2022018231A (ja) * | 2020-07-15 | 2022-01-27 | 株式会社Jvcケンウッド | 映像処理装置および映像処理方法 |

Family Cites Families (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP3395344B2 (ja) * | 1994-04-20 | 2003-04-14 | 日産自動車株式会社 | 画像処理装置およびそれを用いた居眠り警報装置 |

| EP2755192A4 (en) * | 2011-10-06 | 2015-05-27 | Honda Motor Co Ltd | VISUALALLY DISTANCE DRIVING DETECTION DEVICE |

| JP2014048885A (ja) * | 2012-08-31 | 2014-03-17 | Daimler Ag | 注意力低下検出システム |

| JP2016074410A (ja) * | 2014-10-07 | 2016-05-12 | 株式会社デンソー | ヘッドアップディスプレイ装置、ヘッドアップディスプレイ表示方法 |

-

2016

- 2016-05-20 JP JP2016101244A patent/JP6673005B2/ja active Active

-

2017

- 2017-04-25 WO PCT/JP2017/016322 patent/WO2017199709A1/ja active Application Filing

Also Published As

| Publication number | Publication date |

|---|---|

| JP2017208007A (ja) | 2017-11-24 |

| WO2017199709A1 (ja) | 2017-11-23 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6673005B2 (ja) | 顔向き推定装置及び顔向き推定方法 | |

| US8264531B2 (en) | Driver's state monitoring system using a camera mounted on steering wheel | |

| CN107176165B (zh) | 车辆的控制装置 | |

| JP6369487B2 (ja) | 表示装置 | |

| US9041789B2 (en) | System and method for determining driver alertness | |

| CN103019524B (zh) | 车辆操作输入装置和用于车辆操作输入装置的控制方法 | |

| EP2564766B1 (en) | Visual input of vehicle operator | |

| JP5184596B2 (ja) | 脇見判定装置 | |

| US20180229654A1 (en) | Sensing application use while driving | |

| CN105270287A (zh) | 车辆驾驶辅助装置及具有该车辆驾驶辅助装置的车辆 | |

| US20190138790A1 (en) | Driver monitoring system | |

| JP6187155B2 (ja) | 注視対象物推定装置 | |

| JP6690179B2 (ja) | 挙動推定システム、及び挙動推定方法 | |

| KR101698781B1 (ko) | 차량 운전 보조 장치 및 이를 구비한 차량 | |

| JP6693489B2 (ja) | 情報処理装置、運転者モニタリングシステム、情報処理方法、及び情報処理プログラム | |

| JP4647387B2 (ja) | 車両の運転支援装置 | |

| CN110544368B (zh) | 一种疲劳驾驶增强现实预警装置及预警方法 | |

| JP6683185B2 (ja) | 情報処理装置、運転者モニタリングシステム、情報処理方法、及び情報処理プログラム | |

| JP2006171950A (ja) | ヘッドアップディスプレイの表示制御装置およびプログラム | |

| JP4270010B2 (ja) | 物体危険判定装置 | |

| JP7140154B2 (ja) | 車両制御装置 | |

| JP4345526B2 (ja) | 物体監視装置 | |

| JP2020086907A (ja) | 漫然運転判定装置 | |

| JP2004037220A (ja) | 車両の操縦安定性評価装置、車両の操縦安定性評価方法、及び、車両の操縦安定性評価用プログラム | |

| JP2018094294A (ja) | 状態推定システム |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20190422 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20190422 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20200204 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20200217 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6673005 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |