JP6386331B2 - 動作検出システム、動作検出装置、移動通信端末及びプログラム - Google Patents

動作検出システム、動作検出装置、移動通信端末及びプログラム Download PDFInfo

- Publication number

- JP6386331B2 JP6386331B2 JP2014206748A JP2014206748A JP6386331B2 JP 6386331 B2 JP6386331 B2 JP 6386331B2 JP 2014206748 A JP2014206748 A JP 2014206748A JP 2014206748 A JP2014206748 A JP 2014206748A JP 6386331 B2 JP6386331 B2 JP 6386331B2

- Authority

- JP

- Japan

- Prior art keywords

- data

- unit

- user

- output

- audio

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/017—Gesture based interaction, e.g. based on a set of recognized hand gestures

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63H—TOYS, e.g. TOPS, DOLLS, HOOPS OR BUILDING BLOCKS

- A63H30/00—Remote-control arrangements specially adapted for toys, e.g. for toy vehicles

- A63H30/02—Electrical arrangements

- A63H30/04—Electrical arrangements using wireless transmission

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/033—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor

- G06F3/0346—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor with detection of the device orientation or free movement in a 3D space, e.g. 3D mice, 6-DOF [six degrees of freedom] pointers using gyroscopes, accelerometers or tilt-sensors

Description

ユーザの動作を検出する動作検出装置と、前記動作検出装置と通信可能な移動通信端末とを有する動作検出システムであって、

ユーザの動作を定める第一の動作データに対して、複数の音声又は映像データを関連付けて記憶する記憶部と、

前記ユーザの動作を示す第二の動作データを取得する取得部と、

前記第二の動作データを前記移動通信端末に送信する送信部と、

前記第一の動作データが定める動作と、前記送信部により送信された前記第二の動作データが示す動作とが、同じ動作を示すか判定する判定部と、

前記判定部の結果に応じて、前記第一の動作データと関連付けられた、前記音声又は映像データを選択する選択部と、

前記選択部の選択した前記音声又は映像データを出力する出力部と、を有し、

前記選択部は、前記第一の動作データに関連付けられた複数の音声又は映像データのうち、前記出力部により既に出力された音声又は映像データについての出力履歴に応じて、前記音声又は映像データを選択する。

ユーザの動作を検出する動作検出装置と通信可能な移動通信端末であって、

ユーザの動作を定める第一の動作データに対して、複数の音声又は映像データを関連付けて記憶する記憶部と、

前記ユーザの動作を示す第二の動作データを前記動作検出装置から受信する受信部と、

前記第一の動作データの定める動作と、前記受信部にて受信した前記第二の動作データの示す動作とが、同じ動作を示すか判定する判定部と、

前記判定部の結果に応じて、前記第一の動作データと関連付けられた、前記音声又は映像データを選択する選択部と、

前記選択部の選択した前記音声又は映像データを出力する出力部と、を有し、

前記選択部は、前記第一の動作データに関連付けられた複数の音声又は映像データのうち、前記出力部により既に出力された音声又は映像データについての出力履歴に応じて、前記音声又は映像データを選択する。

ユーザの動作を検出する動作検出装置と通信可能なコンピュータで実行されるプログラムであって、前記コンピュータに、

前記ユーザの動作を示す第一の動作データを前記動作検出装置から受信する受信段階と、

前記受信段階において受信した前記第一の動作データの示す動作と、記憶部に記憶され、複数の音声又は映像データと関連付けられた第二の動作データの定める動作とが、同じ動作を示すか判定する判定段階と、

前記判定段階における判定の結果に応じて、前記音声又は映像データを選択する選択段階と、

前記選択段階において選択された前記音声又は映像データを出力する出力段階と、を実行させ、

前記選択段階は、前記第二の動作データに関連付けられた複数の音声又は映像データのうち、前記出力段階において既に出力された音声又は映像データについての出力履歴に応じて、前記音声又は映像データを選択する。

1. 概要

2. ハードウェア構成

動作検出装置

移動通信端末

3. 機能

動作検出装置

移動通信端末

基本機能

登録機能

出力機能

4. 動作例

登録処理

出力処理

登録処理の具体例

出力処理の具体例

閾値データ/アプリデータを利用する例

所定の動作に応じて有効となるフラグを用いる例

出力データの履歴を用いる例

5. 応用例

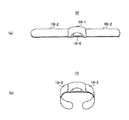

まず、図1を用いて、本発明の第1の実施形態の概要を説明する。図1は、本発明の第1の実施形態に係る動作検出システム1の利用例を示す図である。動作検出システム1は、ユーザが所持する玩具40に、又は、ユーザ自身に装着される動作検出装置10と、動作検出装置10と通信可能な移動通信端末20とを有する。動作検出装置10と移動通信端末20とは、Bluetooth(登録商標)やZigBee(登録商標)のような無線通信方式により、互いに通信を行うことができる。

図3、図4を用いて、本発明の第1の実施形態に係る動作検出装置10及び移動通信端末20のハードウェア構成を説明する。

図3は、本発明の第1の実施形態に係る動作検出装置10のハードウェア構成を示す図である。動作検出装置10は、CPU11と、ROM12と、RAM13と、センサ14と、無線通信装置15と、電池16とを有する。

図4は、本発明の第1の実施形態に係る移動通信端末20のハードウェア構成を示す図である。図4は、移動通信端末20が、スマートフォンである場合のハードウェア構成の一例を示している。移動通信端末20は、CPU(コンピュータ)21と、ROM22と、RAM23と、ディスプレイ24と、スピーカ25と、フラッシュメモリ26と、無線通信装置27と、入力装置28と、マイク29とを有する。

図5、図6を用いて、本発明の第1の実施形態に係る動作検出システム1の機能ブロックについて説明する。

はじめに、図5を用いて、本発明の第1の実施形態に係る動作検出装置10の機能を説明する。動作検出装置10は、検出部101と通信部102とを有する。

次に、図5を用いて、本発明の第1の実施形態に係る移動通信端末20の機能を説明する。なお、以下では、移動通信端末20の機能を、「基本機能」と、「登録機能」と、「出力機能」とに分けて説明する。

図5に示されるように、移動通信端末20は、記憶部201と、通信部202と、入力受付部203と、切替部204とを有する。

移動通信端末20の動作検出アプリケーションは、ユーザの動作に応じて検出される検出データと、予め用意された出力データ又は録音によって得られる新たな出力データとを関連付ける、登録機能を有する。登録機能を実現するため、移動通信端末20は、登録部205と、録音部206とを有する。

移動通信端末20の動作検出アプリケーションは、動作検出装置10で検出された検出データを受信し、その検出データが所定の条件を満たすとき、所定の出力データを出力する、出力機能を有する。出力機能を実現するため、移動通信端末20は、比較部207と、選択部208と、出力部209と、アプリデータ更新部210とを有する。

図11〜図16を用いて、本発明の第1の実施形態に係る動作検出システム1の動作を説明する。図11〜図16に示される例では、ユーザの動作に応じて検出される検出データと、録音によって入力した出力データとの関連付けを行う登録処理と、ユーザの動作を識別し、識別した動作と関連付けられた出力データを出力する出力処理とを説明する。図11〜図16に示される例では、閾値データ233及びアプリデータ235は使用しない。従って、図11〜図16に示される例では、比較部207の閾値データ読込部254及び閾値比較部255、並びに、アプリデータ更新部210は利用しない。

図11を用いて、動作検出システム1が実行する登録処理を説明する。図11に示される登録処理は、動作検出装置10と移動通信端末20とが無線通信により接続され、ユーザが登録処理を実行するよう移動通信端末20に指示した後に実行される。すなわち、上述した移動通信端末20の切替部204によって、移動通信端末20により実現される機能が、登録機能に切り替えられた後に実行される。

図12を用いて、動作検出システム1が実行する出力処理を説明する。図12に示される出力処理は、動作検出装置10と移動通信端末20とが無線通信により接続され、ユーザが出力処理を実行するよう移動通信端末20に指示した後に実行される。すなわち、上述した移動通信端末20の切替部204によって、移動通信端末20により実現される機能が、出力機能に切り替えられた後に実行される。なお、出力処理が実行される時点で、ユーザは、動作検出装置10を装着して、玩具40が操作できる状態にあるものとする。

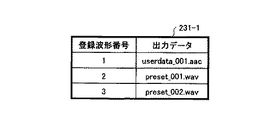

図13を用いて、動作検出システム1が実行する登録処理を、具体的に説明する。なお、以下では、図8に例示されるテーブルに、関連付けデータが何も登録されていないものとして説明を行う。

図14を用いて、動作検出システム1が実行する出力処理を具体的に説明する。図14の出力処理に際して、ユーザは、移動通信端末20上でいずれかの動作検出アプリケーションを起動させているものとする。また、動作検出装置10と移動通信端末20とは通信可能となっており、ユーザは玩具40が操作できる状態になっているものとする。なお、以下の説明では、図8に例示される関連付けデータ231−1を用いるものとする。図15(a)〜(c)は、図8の関連付けデータ231−1に含まれる、登録波形番号「1」〜「3」に対応する登録波形データ232の一例である。

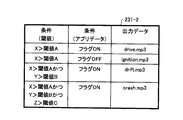

図11〜図16の例では、閾値データ233及びアプリデータ235を使用しない場合について説明した。すなわち、比較部207の閾値データ読込部254及び閾値比較部255、並びに、アプリデータ更新部210を利用しない場合について説明した。一方、以下では、図17〜図19を用いて、閾値データ233及びアプリデータ235を利用し、比較部207の閾値データ読込部254及び閾値比較部255、並びに、アプリデータ更新部210を利用する例について説明する。

≪ 所定の動作に応じて有効となるフラグを用いる例 ≫

図18を用いて、閾値データ233及びアプリデータ235を用いる出力処理の具体例を説明する。ここでは、アプリデータ235として、所定の動作に応じて有効となるフラグを用いるものとする。当初、フラグはOFFに設定されているものとする。図14を用いて説明した例と同様に、ユーザは、移動通信端末20上でいずれかの動作検出アプリケーションを起動させているものとする。また、動作検出装置10と移動通信端末20とは通信可能となっており、ユーザは玩具40が操作できる状態になっているものとする。

図9)を参照し、条件(閾値)「X>AかつY>B」と条件(アプリデータ)「フラグON」に対応する、出力データ「drift.mp3」を、出力すべきデータとして選択する(ステップS628)。次に、選択部208は、選択した出力データを出力するよう、出力部209に指示する(ステップS629)。出力部209は、「drift.mp3」を出力する(ステップS630)。

図19を用いて、閾値データ233及びアプリデータ235を用いる出力処理の異なる具体例を説明する。ここでは、アプリデータ235として、移動通信端末20が出力した出力データの出力履歴を用いるものとする。図14、図18を用いて説明した例と同様に、ユーザは、移動通信端末20上でいずれかの動作検出アプリケーションを起動させているものとする。また、動作検出装置10と移動通信端末20とは通信可能となっており、ユーザは玩具40が操作できる状態になっているものとする。

以上、検出データと予め登録された登録波形データとが一致するとみなせる場合に所定の音を出力する例(図14)と、検出データの最大値やアプリデータが所定の条件を満たす場合に所定の音を出力する例(図18、図19)とについて説明を行った。しかしながら、本発明は、これらの例に限られず、例えば、検出データと予め登録された登録波形データとが一致し、かつ、他の条件(例えば、閾値やアプリデータ)が満たされる場合に、所定の音を出力するようにしてもよい。一方で、本発明は、閾値条件のみを用いて検出データを判定し、所定の音を出力するようにしてもよい。

上記第1の実施形態では、動作検出装置10に内蔵された加速度センサにより検出された検出データを用いることで、ユーザの動作の種類を識別し、出力する音声又は映像データを切り替える構成について説明した。しかしながら、本発明はこれに限定されず、例えば、ユーザの動作が行われている方向(動作方向)を更に加味して、出力する音声又は映像データを切り替える構成としてもよい。以下、第2の実施形態について詳細に説明する。なお、上記第1の実施形態と同様の構成要素については、同じ参照番号を付すこととし、説明を省略する。

はじめに、図20を用いて、第2の実施形態の概要を説明する。図20は、第2の実施形態に係る動作検出システム1の利用例を示す図である。ユーザの動作の種類とユーザの動作が行われている方向とに基づいて、出力する音声又は映像データを切り替える機能として、本実施形態では、疑似ドラムセットの演奏機能を例に説明する。

次に図22、図23を用いて、第2の実施形態に係る動作検出システム1の機能ブロックについて説明する。なお、ここでは、図5、図6に示す機能ブロックとの相違点を中心に説明を行う。

クラッシュシンバル2511=(X1、Y1、Z1)、

ライドシンバル2512=(X2、Y2、Z2)、

フロアタム2513=(X3、Y3、Z3)、

フロアタム2514=(X4、Y4、Z4)、

スネアドラム2515=(X5、Y5、Z5)、

クラッシュシンバル2516=(X6、Y6、Z6)、

ハイアットシンバル2518=(X7、Y7、Z7)、

である。関連付けデータ2221において規定される"相対姿勢データの条件"は、これら7つの打楽器の中心位置の座標を包含するように、動作方向の範囲(つまり、閾値Q0〜Q7)が定義されている。

次に、図26〜図31を用いて、第2の実施形態に係る動作検出システム1において実行される処理を説明する。具体的には、ユーザが疑似ドラムセットの演奏を体験するための準備を行う前処理と、ユーザが疑似ドラムセットの演奏を体験する演奏処理とについて説明する。

図26は、ユーザが疑似ドラムセットの演奏を体験する準備を行うための前処理のフローチャートである。また、図27は、前処理実行時の移動通信端末20の表示画面2700の一例を示す図である。

≪ 5. 応用例 ≫

≪ 演奏処理 ≫

次に、演奏処理について説明する。図30は、ユーザが疑似ドラムセットの演奏を体験する演奏処理のフローチャートである。

上記第1及び第2の実施形態では、加速度データ等を用いてユーザの動作の種類またはユーザの動作が行われた方向を識別する構成としたが、本発明はこれに限定されない。例えば、気圧センサ等を用いて、ユーザの動作が行われた高さを識別する構成としてもよい。

10 動作検出装置

20 移動通信端末

40 玩具

101 検出部

102 通信部

201 記憶部

202 通信部

203 入力受付部

204 切替部

205 登録部

206 録音部

207 比較部

208 選択部

209 出力部

210 アプリデータ更新部

2201 姿勢演算部

2211 比較部

Claims (8)

- ユーザの動作を検出する動作検出装置と、前記動作検出装置と通信可能な移動通信端末とを有する動作検出システムであって、

ユーザの動作を定める第一の動作データに対して、複数の音声又は映像データを関連付けて記憶する記憶部と、

前記ユーザの動作を示す第二の動作データを取得する取得部と、

前記第二の動作データを前記移動通信端末に送信する送信部と、

前記第一の動作データが定める動作と、前記送信部により送信された前記第二の動作データが示す動作とが、同じ動作を示すか判定する判定部と、

前記判定部の結果に応じて、前記第一の動作データと関連付けられた、前記音声又は映像データを選択する選択部と、

前記選択部の選択した前記音声又は映像データを出力する出力部と、を有し、

前記選択部は、前記第一の動作データに関連付けられた複数の音声又は映像データのうち、前記出力部により既に出力された音声又は映像データについての出力履歴に応じて、前記音声又は映像データを選択する動作検出システム。 - 前記ユーザの新たな動作を定める第三の動作データに対応する、新たな音声又は映像データの指定を受け付ける受付部をさらに有し、

前記取得部は、前記第三の動作データを取得し、

前記送信部は、前記第三の動作データを前記移動通信端末に送信し、

前記記憶部は、前記第三の動作データと、前記新たな音声又は映像データとを関連付けて記憶する、

請求項1に記載の動作検出システム。 - 前記動作検出装置は、前記取得部及び前記送信部を有する筐体と、前記筐体の相対する二側面に接続されたベルトを有する、

請求項1又は2に記載の動作検出システム。 - 前記動作検出装置は、前記ベルトにより、前記ユーザの操作する玩具又は前記ユーザの手首に装着される、

請求項3に記載の動作検出システム。 - ユーザの動作を検出する動作検出装置と通信可能な移動通信端末であって、

ユーザの動作を定める第一の動作データに対して、複数の音声又は映像データを関連付けて記憶する記憶部と、

前記ユーザの動作を示す第二の動作データを前記動作検出装置から受信する受信部と、

前記第一の動作データの定める動作と、前記受信部にて受信した前記第二の動作データの示す動作とが、同じ動作を示すか判定する判定部と、

前記判定部の結果に応じて、前記第一の動作データと関連付けられた、前記音声又は映像データを選択する選択部と、

前記選択部の選択した前記音声又は映像データを出力する出力部と、を有し、

前記選択部は、前記第一の動作データに関連付けられた複数の音声又は映像データのうち、前記出力部により既に出力された音声又は映像データについての出力履歴に応じて、前記音声又は映像データを選択する移動通信端末。 - ユーザの動作を検出する動作検出装置と通信可能なコンピュータで実行されるプログラムであって、前記コンピュータに、

前記ユーザの動作を示す第一の動作データを前記動作検出装置から受信する受信段階と、

前記受信段階において受信した前記第一の動作データの示す動作と、記憶部に記憶され、複数の音声又は映像データと関連付けられた第二の動作データの定める動作とが、同じ動作を示すか判定する判定段階と、

前記判定段階における判定の結果に応じて、前記音声又は映像データを選択する選択段階と、

前記選択段階において選択された前記音声又は映像データを出力する出力段階と、を実行させ、

前記選択段階は、前記第二の動作データに関連付けられた複数の音声又は映像データのうち、前記出力段階において既に出力された音声又は映像データについての出力履歴に応じて、前記音声又は映像データを選択するプログラム。 - ユーザの動作を検出する動作検出装置と、前記動作検出装置と通信可能な移動通信端末と、を有する動作検出システムであって、

ユーザにより行われる複数の打楽器それぞれを叩く動作と、該動作が行われる動作方向の範囲とを、該複数の打楽器それぞれを叩いた場合に発生する音声データと関連付けて記憶する記憶部と、

前記複数の打楽器のうち、特定の打楽器を叩く動作を前記ユーザが行った際の動作方向を、基準方向として設定する設定部と、

前記動作検出装置において検出された検出データに基づいて、前記動作検出装置の前記基準方向からの相対角度を算出する算出部と、

前記相対角度により特定される方向が前記動作方向の範囲に含まれ、かつ、前記検出データにより特定される動作が、前記打楽器を叩く動作であった場合に、前記記憶部において前記打楽器を叩く動作及び前記動作方向の範囲と関連付けて記憶された前記音声データを出力する出力部と

を有する、動作検出システム。 - ユーザの動作を検出する動作検出装置と通信可能であり、ユーザにより行われる複数の打楽器それぞれを叩く動作と、該動作が行われる動作方向の範囲とを、該複数の打楽器それぞれを叩いた場合に発生する音声データと関連付けて記憶する移動通信端末のコンピュータで実行されるプログラムであって、前記コンピュータに、

前記複数の打楽器のうち、特定の打楽器を叩く動作を前記ユーザが行った際の動作方向を、基準方向として設定する設定段階と、

前記動作検出装置において検出された検出データに基づいて、前記動作検出装置の前記基準方向からの相対角度を算出する算出段階と、

前記相対角度により特定される方向が前記動作方向の範囲に含まれ、かつ、前記検出データにより特定される動作が、前記打楽器を叩く動作であった場合に、前記打楽器を叩く動作及び前記動作方向の範囲と関連付けて記憶された前記音声データを出力する出力段階と

を実行させる、プログラム。

Priority Applications (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2014206748A JP6386331B2 (ja) | 2013-11-05 | 2014-10-07 | 動作検出システム、動作検出装置、移動通信端末及びプログラム |

| US14/526,737 US9720509B2 (en) | 2013-11-05 | 2014-10-29 | Gesture detection system, gesture detection apparatus, and mobile communication terminal |

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2013229032 | 2013-11-05 | ||

| JP2013229032 | 2013-11-05 | ||

| JP2014206748A JP6386331B2 (ja) | 2013-11-05 | 2014-10-07 | 動作検出システム、動作検出装置、移動通信端末及びプログラム |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2015111404A JP2015111404A (ja) | 2015-06-18 |

| JP2015111404A5 JP2015111404A5 (ja) | 2017-11-24 |

| JP6386331B2 true JP6386331B2 (ja) | 2018-09-05 |

Family

ID=53006676

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2014206748A Active JP6386331B2 (ja) | 2013-11-05 | 2014-10-07 | 動作検出システム、動作検出装置、移動通信端末及びプログラム |

Country Status (2)

| Country | Link |

|---|---|

| US (1) | US9720509B2 (ja) |

| JP (1) | JP6386331B2 (ja) |

Families Citing this family (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN102955603B (zh) * | 2011-08-17 | 2016-05-25 | 宸鸿科技(厦门)有限公司 | 触控面板及其制造方法 |

| KR101685626B1 (ko) * | 2015-10-14 | 2016-12-12 | 이병도 | 블루투스 인형 |

| CN105867208A (zh) * | 2015-12-15 | 2016-08-17 | 乐视致新电子科技(天津)有限公司 | 物理设备的控制方法、装置及物理设备 |

| US10102835B1 (en) * | 2017-04-28 | 2018-10-16 | Intel Corporation | Sensor driven enhanced visualization and audio effects |

| CN107423358B (zh) * | 2017-06-13 | 2020-08-07 | 阿里巴巴集团控股有限公司 | 一种数据存储及调用方法及装置 |

Family Cites Families (19)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2526430B2 (ja) * | 1991-03-01 | 1996-08-21 | ヤマハ株式会社 | 自動伴奏装置 |

| US6150947A (en) * | 1999-09-08 | 2000-11-21 | Shima; James Michael | Programmable motion-sensitive sound effects device |

| JP4694705B2 (ja) * | 2001-02-23 | 2011-06-08 | ヤマハ株式会社 | 楽音制御システム |

| EP1366712A4 (en) * | 2001-03-06 | 2006-05-31 | Microstone Co Ltd | DETECTOR APPLICABLE TO THE MOVEMENT OF A BODY |

| US7301529B2 (en) * | 2004-03-23 | 2007-11-27 | Fujitsu Limited | Context dependent gesture response |

| US7567847B2 (en) * | 2005-08-08 | 2009-07-28 | International Business Machines Corporation | Programmable audio system |

| TWI348639B (en) * | 2005-12-16 | 2011-09-11 | Ind Tech Res Inst | Motion recognition system and method for controlling electronic device |

| JP4989105B2 (ja) | 2006-05-09 | 2012-08-01 | 任天堂株式会社 | ゲームコントローラ |

| US8462109B2 (en) * | 2007-01-05 | 2013-06-11 | Invensense, Inc. | Controlling and accessing content using motion processing on mobile devices |

| JP5082730B2 (ja) * | 2007-10-02 | 2012-11-28 | ヤマハ株式会社 | 音データ生成装置および方向センシング発音楽器 |

| US8858330B2 (en) * | 2008-07-14 | 2014-10-14 | Activision Publishing, Inc. | Music video game with virtual drums |

| US8503932B2 (en) * | 2008-11-14 | 2013-08-06 | Sony Mobile Comminications AB | Portable communication device and remote motion input device |

| US8587519B2 (en) * | 2009-01-07 | 2013-11-19 | Sensor Platforms, Inc. | Rolling gesture detection using a multi-dimensional pointing device |

| JP2011128427A (ja) * | 2009-12-18 | 2011-06-30 | Yamaha Corp | 演奏装置、演奏制御装置及びプログラム |

| US20110199292A1 (en) * | 2010-02-18 | 2011-08-18 | Kilbride Paul E | Wrist-Mounted Gesture Device |

| JP5636888B2 (ja) | 2010-11-09 | 2014-12-10 | ソニー株式会社 | 情報処理装置、プログラムおよびコマンド生成方法 |

| JP2012155616A (ja) | 2011-01-27 | 2012-08-16 | Panasonic Corp | コンテンツ提供システム、コンテンツ提供方法、及びコンテンツ提供プログラム |

| WO2013057048A1 (en) * | 2011-10-18 | 2013-04-25 | Slyde Watch Sa | A method and circuit for switching a wristwatch from a first power mode to a second power mode |

| JP2013182195A (ja) * | 2012-03-02 | 2013-09-12 | Casio Comput Co Ltd | 演奏装置及びプログラム |

-

2014

- 2014-10-07 JP JP2014206748A patent/JP6386331B2/ja active Active

- 2014-10-29 US US14/526,737 patent/US9720509B2/en active Active

Also Published As

| Publication number | Publication date |

|---|---|

| JP2015111404A (ja) | 2015-06-18 |

| US9720509B2 (en) | 2017-08-01 |

| US20150123897A1 (en) | 2015-05-07 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6386331B2 (ja) | 動作検出システム、動作検出装置、移動通信端末及びプログラム | |

| JP6504157B2 (ja) | 体感導入装置、体感導入システム、及び体感導入方法 | |

| JP5022385B2 (ja) | ジェスチャカタログ生成および認識 | |

| JP5465948B2 (ja) | ゲームプログラムの実行を制御するための入力を取得する方法 | |

| TWI409667B (zh) | 用於個人化媒體設備的基於移動介面 | |

| JP6243595B2 (ja) | 情報処理システム、情報処理プログラム、情報処理制御方法、および情報処理装置 | |

| JP6055657B2 (ja) | ゲームシステム、ゲーム処理制御方法、ゲーム装置、および、ゲームプログラム | |

| WO2014147946A1 (ja) | 加速度感覚呈示装置、加速度感覚呈示方法および加速度感覚呈示システム | |

| US11779836B2 (en) | Vibration control apparatus | |

| JP5301429B2 (ja) | ゲームコントローラ本体のユーザ操作を検出、追跡し、その動きを入力およびゲームコマンドに変換するための方式 | |

| US10596459B2 (en) | Systems, methods, and/or computer readable storage medium having program, for localized haptic feedback based on position of virtual object | |

| JP6055651B2 (ja) | 情報処理システム、情報処理プログラム、情報処理制御方法、および情報処理装置 | |

| JP6832712B2 (ja) | 振動制御システム、振動制御装置、振動制御プログラムおよび振動制御方法 | |

| KR20170105071A (ko) | 컴퓨터 엔터테인먼트 시스템용 컨트롤러 | |

| JP2019101050A (ja) | 仮想空間において楽器の演奏を支援するためのプログラム、楽器の選択を支援するためにコンピュータで実行される方法、および情報処理装置 | |

| JP2014097219A (ja) | ゲームプログラム、ゲーム装置、ゲームシステム、およびゲーム処理方法 | |

| US10661163B2 (en) | Video game with haptic signal that is disabled based on losing contact with a surface | |

| JP2009535172A (ja) | 多入力ゲーム制御ミクサ | |

| KR20160147488A (ko) | 스마트 기기와 연동하는 복수의 전자 윷가락들을 포함하는 놀이 기구 및 게임 진행 방법 | |

| JP2019101413A (ja) | 仮想空間において楽器の演奏を支援するためのプログラム、楽器の選択を支援するためにコンピュータで実行される方法、および情報処理装置 | |

| JP2018112820A (ja) | 情報処理プログラム、情報処理装置、情報処理システム、および情報処理方法 | |

| JP2020057987A (ja) | アンビソニックスのためのマイクロホン、a/bフォーマット変換ソフトウェア、レコーダー、再生ソフトウェア | |

| JP2021156600A (ja) | 移動体位置推定装置および移動体位置推定方法 | |

| JP2019126444A (ja) | ゲームプログラムおよびゲーム装置 | |

| KR20090017571A (ko) | 게임 프로그램의 실행을 제어하기 위한 입력을 획득하는 방법 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20171006 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20171006 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20180531 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20180619 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20180727 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20180807 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20180809 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6386331 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |