JP6225538B2 - 情報処理装置、システム、情報提供方法および情報提供プログラム - Google Patents

情報処理装置、システム、情報提供方法および情報提供プログラム Download PDFInfo

- Publication number

- JP6225538B2 JP6225538B2 JP2013153191A JP2013153191A JP6225538B2 JP 6225538 B2 JP6225538 B2 JP 6225538B2 JP 2013153191 A JP2013153191 A JP 2013153191A JP 2013153191 A JP2013153191 A JP 2013153191A JP 6225538 B2 JP6225538 B2 JP 6225538B2

- Authority

- JP

- Japan

- Prior art keywords

- information

- image

- content

- dimensional position

- marker

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/70—Determining position or orientation of objects or cameras

- G06T7/73—Determining position or orientation of objects or cameras using feature-based methods

- G06T7/74—Determining position or orientation of objects or cameras using feature-based methods involving reference images or patches

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T19/00—Manipulating 3D models or images for computer graphics

- G06T19/006—Mixed reality

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30108—Industrial image inspection

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30204—Marker

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30244—Camera pose

Description

まず、第一の実施例に係る詳細な処理および情報処理装置等の構成について説明する。図9は、システム構成図である。図9の例では、情報処理装置の例として、通信端末1−1および通信端末1−2を示す。以下、これらを総称して、情報処理装置1とする。さらに、情報処理装置1は、ネットワークNを介して、管理装置2と通信する。情報処理装置1は、例えば、タブレットPCやスマートフォンなどのコンピュータである。管理装置2は、例えば、サーバコンピュータであって、情報処理装置1を管理する。ネットワークNは、例えば、インターネットである。なお、本実施例に係るシステムは、情報処理装置1および管理装置2を含む。

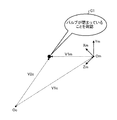

Xs=f・Xc/Zc (式4)

Ys=f・Yc/Zc (式5)

第一の実施例では、情報処理装置が提供する情報の選択を行っていた。第二の実施例では、管理装置が提供する情報の選択を行う。例えば、表示画像に重畳表示されるARコンテンツを、管理装置が選択する。そして、管理装置は、選択したARコンテンツに関するARコンテンツ情報、テンプレート情報を情報処理装置へ送信する。以上のように、第二の実施例においては、事前に、ARコンテンツ情報、テンプレート情報、対応情報を、情報処理装置が記憶する必要がない。

第二の実施例は、以下のように変更することもできる。例えば、情報処理装置3の制御部31は、生成部37のみを有する。そして、管理装置4の制御部41が、情報処理装置3の認識部35および算出部36相当の機能を備えてもよい。この場合、情報処理装置3は、表示画像の生成のみを行えばよいため、処理負荷を軽減することができる。

各実施例に示した情報処理装置および管理装置のハードウェア構成について説明する。まず、第一の実施例に示した情報処理装置1、第二の実施例に示した情報処理装置3のハードウェア構成について説明する。なお、変形例として示した情報処理装置も、図24に示すコンピュータ300で実現することが可能である。

10,30 通信部

11,31 制御部

12,32 撮像部

13,33 記憶部

14,34 表示部

2, 4 管理装置

20,40 通信部

21,41 制御部

22,42 記憶部

Claims (11)

- 入力画像から認識された基準物の像に基づいて、前記基準物に対して相対的な前記入力画像の撮像位置の3次元位置情報を算出する算出部と、

前記3次元位置情報と前記基準物の識別情報とを含む情報提供要求を他の装置へ送信し、前記情報提供要求に対する応答として、前記3次元位置情報に含まれる各成分の値に応じて、前記識別情報と3次元位置の各成分の範囲とに対応付けられた複数の表示情報の中から選択された特定の表示情報を、前記他の装置から受信する通信部と、

前記特定の表示情報に基づき、前記入力画像に他の画像が重畳された表示画像を表示する表示部と、

を有することを特徴とする情報処理装置。 - 入力画像から認識された基準物の像に基づいて、前記基準物に対して相対的な前記入力画像の撮像位置の3次元位置関係を示す位置情報を算出する算出部と、前記3次元位置情報と前記基準物の識別情報とを含む情報提供要求を第二の情報処理装置へ送信し、前記情報提供要求に対する応答として、前記3次元位置情報に含まれる各成分の値に応じて、前記識別情報と3次元位置の各成分の範囲とに対応付けられた複数の表示情報の中から選択された特定の表示情報を、前記第二の情報処理装置から受信する通信部と、前記特定の表示情報に基づき、前記入力画像に他の画像が重畳された合成画像を表示する表示部と、を有する第一の情報処理装置と、

前記第一の情報処理装置から前記情報提供要求を受信し、前記情報提供要求に対する前記応答として、前記特定の表示情報を前記第一の情報処理装置へ送信する通信部と、複数の識別情報と前記3次元位置の各成分の範囲と複数の表示情報との対応情報に基づき、前記情報提供要求が含まれる前記3次元位置情報に含まれる各成分が当てはまる範囲に対応する前記特定の表示情報を取得し、前記通信部へ提供する制御部と、を有する第二の情報処理装置と、

を含むことを特徴とするシステム。 - 前記算出部は、前記像の形状に基づき、前記3次元位置情報を算出する、

ことを特徴とする請求項2に記載のシステム。 - 第一の画像データに対応付いた範囲が第一の範囲で示される領域である場合に、前記制御部は、前記3次元位置情報に含まれる各成分が示す点が前記第一の範囲に合致する場合、前記特定の表示情報として、前記識別情報に対応付けられた複数の画像データのうちの前記第一の画像データを特定する、

ことを特徴とする請求項2に記載のシステム。 - 第二の画像データに対応付いた範囲が前記第一の範囲とは異なる第二の範囲で示される領域である場合に、前記制御部は、前記3次元位置情報に含まれる各成分が示す点が前記第二の範囲に合致する場合、前記特定の表示情報として、前記第一の画像データとは異なる前記第二の画像データを特定する、

ことを特徴とする請求項4に記載のシステム。 - 前記領域は、前記基準物に対して、放射状に設定された領域である、

ことを特徴とする請求項4または5に記載のシステム。 - 前記領域は、前記基準物に対する距離および方向で特定される領域である、

ことを特徴とする請求項4または5に記載のシステム。 - 前記第一の情報処理装置は、前記第二の情報処理装置から受信した前記特定の表示情報および前記入力画像に基づき、前記表示画像を生成する生成部を備える、

ことを特徴とする請求項2乃至請求項7のいずれか一項に記載のシステム。 - 前記算出部は、前記3次元位置情報として、前記基準物を基準とする三次元空間における、前記撮像位置を算出する、

ことを特徴とする請求項2乃至請求項8のいずれか一項に記載のシステム。 - コンピュータに、

入力画像から認識された基準物の像に基づいて、前記基準物に対して相対的な前記入力画像の撮像位置の3次元位置情報を算出し、

前記3次元位置情報と前記基準物の識別情報とを含む情報提供要求を他の装置へ送信し、

前記情報提供要求に対する応答として、前記3次元位置情報に含まれる各成分の値に応じて、前記識別情報と3次元位置の各成分の範囲とに対応付けられた複数の表示情報の中から選択された特定の表示情報を、前記他の装置から受信し、

前記特定の表示情報に基づき、前記入力画像に他の画像が重畳された合成画像を表示する、

処理を実行させることを特徴とする情報提供プログラム。 - コンピュータが、

入力画像から認識された基準物の像に基づいて、前記基準物に対して相対的な前記入力画像の撮像位置の3次元位置情報を算出し、

前記3次元位置情報と前記基準物の識別情報とを含む情報提供要求を他の装置へ送信し、

前記情報提供要求に対する応答として、前記3次元位置情報に含まれる各成分の値に応じて、前記識別情報と3次元位置の各成分の範囲とに対応付けられた複数の表示情報の中から選択された特定の表示情報を、前記他の装置から受信し、

前記特定の表示情報に基づき、前記入力画像に他の画像が重畳された合成画像を表示する、

処理を実行することを特徴とする情報提供方法。

Priority Applications (5)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2013153191A JP6225538B2 (ja) | 2013-07-24 | 2013-07-24 | 情報処理装置、システム、情報提供方法および情報提供プログラム |

| US14/311,656 US20150029219A1 (en) | 2013-07-24 | 2014-06-23 | Information processing apparatus, displaying method and storage medium |

| AU2014203449A AU2014203449B2 (en) | 2013-07-24 | 2014-06-25 | Information processing apparatus, and displaying method |

| EP20140175199 EP2830022A3 (en) | 2013-07-24 | 2014-07-01 | Information processing apparatus, and displaying method |

| CN201410341965.7A CN104346612B (zh) | 2013-07-24 | 2014-07-17 | 信息处理装置和显示方法 |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2013153191A JP6225538B2 (ja) | 2013-07-24 | 2013-07-24 | 情報処理装置、システム、情報提供方法および情報提供プログラム |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2015022737A JP2015022737A (ja) | 2015-02-02 |

| JP6225538B2 true JP6225538B2 (ja) | 2017-11-08 |

Family

ID=51162472

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2013153191A Active JP6225538B2 (ja) | 2013-07-24 | 2013-07-24 | 情報処理装置、システム、情報提供方法および情報提供プログラム |

Country Status (5)

| Country | Link |

|---|---|

| US (1) | US20150029219A1 (ja) |

| EP (1) | EP2830022A3 (ja) |

| JP (1) | JP6225538B2 (ja) |

| CN (1) | CN104346612B (ja) |

| AU (1) | AU2014203449B2 (ja) |

Families Citing this family (14)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN103942049B (zh) * | 2014-04-14 | 2018-09-07 | 百度在线网络技术(北京)有限公司 | 增强现实的实现方法、客户端装置和服务器 |

| JP6524706B2 (ja) * | 2015-02-27 | 2019-06-05 | 富士通株式会社 | 表示制御方法、表示制御プログラム、及び情報処理装置 |

| WO2016189954A1 (ja) | 2015-05-26 | 2016-12-01 | 三菱重工業株式会社 | 運転支援装置および運転支援方法 |

| CN106445088B (zh) * | 2015-08-04 | 2020-05-22 | 上海宜维计算机科技有限公司 | 现实增强的方法及系统 |

| JP2017054185A (ja) * | 2015-09-07 | 2017-03-16 | 株式会社東芝 | 情報処理装置、情報処理方法及び情報処理プログラム |

| US10740614B2 (en) | 2016-04-14 | 2020-08-11 | Nec Corporation | Information processing device, information processing method, and program storing medium |

| CN107481323A (zh) * | 2016-06-08 | 2017-12-15 | 创意点子数位股份有限公司 | 混合实境的互动方法及其系统 |

| JP2018005091A (ja) * | 2016-07-06 | 2018-01-11 | 富士通株式会社 | 表示制御プログラム、表示制御方法および表示制御装置 |

| CN107773981A (zh) * | 2016-08-24 | 2018-03-09 | 丰唐物联技术(深圳)有限公司 | 一种基于增强现实的交互方法及系统 |

| JP6751777B2 (ja) * | 2016-12-28 | 2020-09-09 | 株式会社メガハウス | コンピュータプログラム、表示装置、頭部装着型表示装置 |

| CN109348209B (zh) * | 2018-10-11 | 2021-03-16 | 北京灵犀微光科技有限公司 | 增强现实显示装置和视觉标定方法 |

| CN112651270A (zh) * | 2019-10-12 | 2021-04-13 | 北京七鑫易维信息技术有限公司 | 一种注视信息确定方法、装置、终端设备及展示对象 |

| WO2021130982A1 (ja) * | 2019-12-26 | 2021-07-01 | 日本電気株式会社 | 情報処理装置、制御方法及び記憶媒体 |

| KR20210107409A (ko) | 2020-02-24 | 2021-09-01 | 삼성전자주식회사 | 엣지 컴퓨팅 서비스를 이용한 영상 컨텐츠 전송 방법 및 장치 |

Family Cites Families (13)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| GB2381644A (en) * | 2001-10-31 | 2003-05-07 | Cambridge Display Tech Ltd | Display drivers |

| US8521411B2 (en) * | 2004-06-03 | 2013-08-27 | Making Virtual Solid, L.L.C. | En-route navigation display method and apparatus using head-up display |

| JPWO2005119539A1 (ja) | 2004-06-04 | 2008-04-03 | 三菱電機株式会社 | 動作環境を証明する証明書発行サーバ及び証明システム |

| US7720436B2 (en) * | 2006-01-09 | 2010-05-18 | Nokia Corporation | Displaying network objects in mobile devices based on geolocation |

| US20080310686A1 (en) | 2007-06-15 | 2008-12-18 | Martin Kretz | Digital camera system and method of storing image data |

| US9204050B2 (en) * | 2008-12-25 | 2015-12-01 | Panasonic Intellectual Property Management Co., Ltd. | Information displaying apparatus and information displaying method |

| JP2011244058A (ja) * | 2010-05-14 | 2011-12-01 | Sony Corp | 情報処理装置、情報処理システム、及びプログラム |

| JP5255595B2 (ja) * | 2010-05-17 | 2013-08-07 | 株式会社エヌ・ティ・ティ・ドコモ | 端末位置特定システム、及び端末位置特定方法 |

| US8601380B2 (en) * | 2011-03-16 | 2013-12-03 | Nokia Corporation | Method and apparatus for displaying interactive preview information in a location-based user interface |

| JP2012215989A (ja) | 2011-03-31 | 2012-11-08 | Toppan Printing Co Ltd | 拡張現実表示方法 |

| JP5940785B2 (ja) * | 2011-09-14 | 2016-06-29 | 株式会社バンダイナムコエンターテインメント | プログラムおよびゲーム装置 |

| JP5821526B2 (ja) * | 2011-10-27 | 2015-11-24 | ソニー株式会社 | 画像処理装置、画像処理方法及びプログラム |

| JP6121647B2 (ja) * | 2011-11-11 | 2017-04-26 | ソニー株式会社 | 情報処理装置、情報処理方法およびプログラム |

-

2013

- 2013-07-24 JP JP2013153191A patent/JP6225538B2/ja active Active

-

2014

- 2014-06-23 US US14/311,656 patent/US20150029219A1/en not_active Abandoned

- 2014-06-25 AU AU2014203449A patent/AU2014203449B2/en active Active

- 2014-07-01 EP EP20140175199 patent/EP2830022A3/en not_active Ceased

- 2014-07-17 CN CN201410341965.7A patent/CN104346612B/zh active Active

Also Published As

| Publication number | Publication date |

|---|---|

| JP2015022737A (ja) | 2015-02-02 |

| CN104346612B (zh) | 2018-12-25 |

| EP2830022A2 (en) | 2015-01-28 |

| EP2830022A3 (en) | 2015-02-18 |

| AU2014203449B2 (en) | 2015-07-30 |

| US20150029219A1 (en) | 2015-01-29 |

| CN104346612A (zh) | 2015-02-11 |

| AU2014203449A1 (en) | 2015-02-12 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6225538B2 (ja) | 情報処理装置、システム、情報提供方法および情報提供プログラム | |

| US9710971B2 (en) | Information processing device, position designation method and storage medium | |

| JP6314394B2 (ja) | 情報処理装置、設定方法、設定プログラム、システムおよび管理装置 | |

| US10074217B2 (en) | Position identification method and system | |

| US20230083703A1 (en) | Capturing Environmental Features Using 2D and 3D Scans | |

| JP5991423B2 (ja) | 表示装置、表示方法、表示プログラムおよび位置設定システム | |

| AU2014277858B2 (en) | System and method for controlling a display | |

| JP6264834B2 (ja) | ガイド方法、情報処理装置およびガイドプログラム | |

| JP7079231B2 (ja) | 情報処理装置及び情報処理システム及び制御方法、プログラム | |

| JP6160290B2 (ja) | 情報処理装置、判定方法および判定プログラム | |

| JP6318542B2 (ja) | 表示制御方法、表示制御プログラムおよび情報処理装置 | |

| Valentini | Natural interface in augmented reality interactive simulations: This paper demonstrates that the use of a depth sensing camera that helps generate a three-dimensional scene and track user's motion could enhance the realism of the interactions between virtual and physical objects | |

| JP7045863B2 (ja) | 情報管理システム、情報管理方法、及びプログラム |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| RD01 | Notification of change of attorney |

Free format text: JAPANESE INTERMEDIATE CODE: A7421 Effective date: 20160401 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20160405 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20170126 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20170131 |

|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20170403 |

|

| A02 | Decision of refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A02 Effective date: 20170516 |

|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20170816 |

|

| A911 | Transfer of reconsideration by examiner before appeal (zenchi) |

Free format text: JAPANESE INTERMEDIATE CODE: A911 Effective date: 20170824 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20170912 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20170925 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6225538 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |