JP6119765B2 - 情報処理装置、情報処理システム、情報処理プログラム、及び動画データ送受信方法 - Google Patents

情報処理装置、情報処理システム、情報処理プログラム、及び動画データ送受信方法 Download PDFInfo

- Publication number

- JP6119765B2 JP6119765B2 JP2014546811A JP2014546811A JP6119765B2 JP 6119765 B2 JP6119765 B2 JP 6119765B2 JP 2014546811 A JP2014546811 A JP 2014546811A JP 2014546811 A JP2014546811 A JP 2014546811A JP 6119765 B2 JP6119765 B2 JP 6119765B2

- Authority

- JP

- Japan

- Prior art keywords

- frame

- video

- video data

- deleted

- information

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/234—Processing of video elementary streams, e.g. splicing of video streams or manipulating encoded video stream scene graphs

- H04N21/2343—Processing of video elementary streams, e.g. splicing of video streams or manipulating encoded video stream scene graphs involving reformatting operations of video signals for distribution or compliance with end-user requests or end-user device requirements

- H04N21/234381—Processing of video elementary streams, e.g. splicing of video streams or manipulating encoded video stream scene graphs involving reformatting operations of video signals for distribution or compliance with end-user requests or end-user device requirements by altering the temporal resolution, e.g. decreasing the frame rate by frame skipping

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/233—Processing of audio elementary streams

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/24—Monitoring of processes or resources, e.g. monitoring of server load, available bandwidth, upstream requests

- H04N21/2402—Monitoring of the downstream path of the transmission network, e.g. bandwidth available

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/40—Client devices specifically adapted for the reception of or interaction with content, e.g. set-top-box [STB]; Operations thereof

- H04N21/43—Processing of content or additional data, e.g. demultiplexing additional data from a digital video stream; Elementary client operations, e.g. monitoring of home network or synchronising decoder's clock; Client middleware

- H04N21/44—Processing of video elementary streams, e.g. splicing a video clip retrieved from local storage with an incoming video stream or rendering scenes according to encoded video stream scene graphs

- H04N21/4402—Processing of video elementary streams, e.g. splicing a video clip retrieved from local storage with an incoming video stream or rendering scenes according to encoded video stream scene graphs involving reformatting operations of video signals for household redistribution, storage or real-time display

- H04N21/440281—Processing of video elementary streams, e.g. splicing a video clip retrieved from local storage with an incoming video stream or rendering scenes according to encoded video stream scene graphs involving reformatting operations of video signals for household redistribution, storage or real-time display by altering the temporal resolution, e.g. by frame skipping

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/60—Network structure or processes for video distribution between server and client or between remote clients; Control signalling between clients, server and network components; Transmission of management data between server and client, e.g. sending from server to client commands for recording incoming content stream; Communication details between server and client

- H04N21/65—Transmission of management data between client and server

- H04N21/654—Transmission by server directed to the client

- H04N21/6547—Transmission by server directed to the client comprising parameters, e.g. for client setup

Landscapes

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Signal Processing (AREA)

- Two-Way Televisions, Distribution Of Moving Picture Or The Like (AREA)

Description

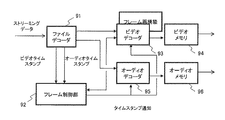

送信部6は、第2の映像データ、音声データ、及びフレーム情報を送信する。

(1)記憶部203に予めインストールされている。

(2)着脱可能記録媒体205により提供される。

(3)ネットワークを介して提供される。

図17は、本実施形態(変形例)における情報処理システムの構成の一例を示す。本変形例と実施形態との違いは受信端末が例えばパソコン33のような端末機器37の形態であることである。同じパソコン33間であってもインターネットの帯域幅によっては画質劣化が確認される場合があるため、このような場合は実施形態に記した構成が適用されることになる。また、変形例は、フレームの削除処理をパソコン33が行う場合の例である。

2 記憶部

3 監視部

4 削除部

5 フレーム情報生成部

6 送信部

7 第2の情報処理装置

8 受信部

9 補完画像生成部

10 映像データ生成部

11 通信ネットワーク

Claims (8)

- 第1の映像データと、該第1の映像データと対応付けた同期情報を含む音声データと、を記憶する記憶部と、

通信ネットワークの状態を監視する監視部と、

前記監視の結果に応じて、前記第1の映像データの単位時間当たりの第1のフレーム数を示す第1のフレームレートから、前記第1の映像データのうち、連続する映像フレーム間で類似度が所定の閾値以上であり、対応する前記音声データの音声レベルが所定の閾値以下である該連続する映像フレームのいずれかを削除して、前記第1のフレームレートより低い第2のフレームレートにした第2の映像データを生成する削除部と、

前記削除されたフレームに関するフレーム情報を生成するフレーム情報生成部と、

前記第2の映像データ及び前記フレーム情報を送信する送信部と、

を備える情報処理装置。 - 前記送信部は、さらに、前記音声データを送信する

請求項1に記載の情報処理装置。 - 第1の映像データの単位時間当たりの第1のフレーム数を示す第1のフレームレートから、前記第1の映像データのうち、連続する映像フレーム間で類似度が所定の閾値以上であり、対応する音声データの音声レベルが所定の閾値以下である該連続する映像フレームのいずれかが削除されて、前記第1のフレームレートより低い第2のフレームレートにされた第2の映像データと、前記削除されたフレームに関するフレーム情報と、前記第1の映像データと対応付けた同期情報を含む音声データと、を受信する受信部と、

前記フレーム情報を用いて前記削除されたフレームの画像を補完する補完画像を生成する補完画像生成部と、

前記補完画像と、前記第2の映像データと、前記同期情報とを用いて、前記第1のフレームレートの映像データであって、前記削除されたフレームに対応する前記補完画像と、前記削除されたフレームに対応する前記音声データとを同期させた該映像データを生成する映像データ生成部と、

を備える情報処理装置。 - 前記映像データ生成部は、前記フレーム情報を用いて、前記補完画像を前記第2の映像データの前記削除されたフレームの位置に挿入し、前記第1のフレームレートの映像データを生成する

請求項3に記載の情報処理装置。 - 前記補完画像生成部は、前記削除されたフレームの直前のフレームを複製することにより前記補完画像を生成する

請求項3または4に記載の情報処理装置。 - 第1の情報処理装置は、

通信ネットワークの状態を監視し、

前記監視の結果に応じて、第1の映像データの単位時間当たりの第1のフレーム数を示す第1のフレームレートから、前記第1の映像データのうち、連続する映像フレーム間で類似度が所定の閾値以上であり、対応する音声データの音声レベルが所定の閾値以下である該連続する映像フレームのいずれかを削除して、前記第1のフレームレートより低い第2のフレームレートにした第2の映像データを生成し、

前記削除されたフレームに関するフレーム情報を生成し、

前記第2の映像データ及び前記フレーム情報と、前記第1の映像データと対応付けた同期情報を含む音声データとを送信する

処理を実行し、

第2の情報処理装置は、

前記送信された、前記第2の映像データ及び前記フレーム情報と、前記同期情報を含む音声データとを受信し、

前記フレーム情報を用いて前記削除されたフレームの画像を補完する補完画像を生成し、

前記補完画像と、前記第2の映像データと、前記同期情報とを用いて、前記第1のフレームレートの映像データであって、前記削除されたフレームに対応する前記補完画像と、前記削除されたフレームに対応する前記音声データとを同期させた該映像データを生成する

処理を実行する映像データ送受信方法。 - 第1の映像データの単位時間当たりの第1のフレーム数を示す第1のフレームレートから、前記第1の映像データのうち、対応する音声データの音声レベルが所定の閾値以下である連続する映像フレームが削除されて、前記第1のフレーム数より小さい第2のフレームレートにされた第2の映像データと、前記削除されたフレームに関するフレーム情報と、を受信する受信部と、

前記フレーム情報を用いて前記削除されたフレームの画像を補完する補完画像を生成する補完画像生成部であって、前記削除されたフレームの前後のフレームを用いて、前記削除されたフレームに含まれる移動量が所定の閾値以上である対象物を判別し、該対象物を表示する領域は、前記削除されたフレームの直後の削除されていないフレームの対象物を示す領域を複製することにより該補完画像を生成する該補完画像生成部と、

前記補完画像と、前記第2の映像データとを用いて、前記第1のフレームレートの映像データを生成する映像データ生成部と、

を備える情報処理装置。 - 第1の情報処理装置は、

通信ネットワークの状態を監視し、

前記監視の結果に応じて、第1の映像データの単位時間当たりの第1のフレーム数を示す第1のフレームレートから、前記第1の映像データのうち、対応する音声データの音声レベルが所定の閾値以下である連続する映像フレームを削除して、前記第1のフレームレートより低い第2のフレームレートにした第2の映像データを生成し、

前記削除されたフレームに関するフレーム情報を生成し、

前記第2の映像データ及び前記フレーム情報を送信する

処理を実行し、

第2の情報処理装置は、

前記送信された、前記第2の映像データ及び前記フレーム情報を受信し、

前記フレーム情報を用いて前記削除されたフレームの画像を補完する補完画像を生成し、

前記補完画像と、前記第2の映像データとを用いて、前記第1のフレームレートの映像データを生成する

処理を実行し、

前記補完画像の生成では、前記削除されたフレームの前後のフレームを用いて、前記削除されたフレームに含まれる移動量が所定の閾値以上である対象物を判別し、該対象物を表示する領域は、前記削除されたフレームの直後の削除されていないフレームの対象物を示す領域を複製することにより前記補完画像を生成する

映像データ送受信方法。

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| PCT/JP2012/079866 WO2014076823A1 (ja) | 2012-11-16 | 2012-11-16 | 情報処理装置、情報処理システム、情報処理プログラム、及び動画データ送受信方法 |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JPWO2014076823A1 JPWO2014076823A1 (ja) | 2017-01-05 |

| JP6119765B2 true JP6119765B2 (ja) | 2017-04-26 |

Family

ID=50730763

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2014546811A Expired - Fee Related JP6119765B2 (ja) | 2012-11-16 | 2012-11-16 | 情報処理装置、情報処理システム、情報処理プログラム、及び動画データ送受信方法 |

Country Status (2)

| Country | Link |

|---|---|

| JP (1) | JP6119765B2 (ja) |

| WO (1) | WO2014076823A1 (ja) |

Families Citing this family (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP6603984B2 (ja) * | 2014-11-07 | 2019-11-13 | セイコーエプソン株式会社 | 画像供給装置、画像供給方法およびプログラム |

| CN107659463A (zh) * | 2017-08-24 | 2018-02-02 | 中国科学院计算机网络信息中心 | 流量回放方法、装置及存储介质 |

| WO2021172578A1 (ja) * | 2020-02-27 | 2021-09-02 | アトモフ株式会社 | 画像表示装置、システム及び方法 |

| JPWO2022085491A1 (ja) * | 2020-10-19 | 2022-04-28 |

Family Cites Families (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH11355380A (ja) * | 1998-06-10 | 1999-12-24 | Matsushita Electric Ind Co Ltd | 無線動画伝送装置 |

| JP2006229618A (ja) * | 2005-02-17 | 2006-08-31 | Ntt Communications Kk | 映像通信システム、映像通信装置、プログラム、及び映像通信方法 |

| JP2010239389A (ja) * | 2009-03-31 | 2010-10-21 | Kddi R & D Laboratories Inc | 映像伝送システム |

-

2012

- 2012-11-16 JP JP2014546811A patent/JP6119765B2/ja not_active Expired - Fee Related

- 2012-11-16 WO PCT/JP2012/079866 patent/WO2014076823A1/ja not_active Ceased

Also Published As

| Publication number | Publication date |

|---|---|

| JPWO2014076823A1 (ja) | 2017-01-05 |

| WO2014076823A1 (ja) | 2014-05-22 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| EP2908547B1 (en) | Information-processing device, information-processing system, information-processing program, and moving image data transmission/reception method adapting the frame rate of moving image data based on frame similarity | |

| US10547850B2 (en) | Audio splitting with codec-enforced frame sizes | |

| JP7471725B2 (ja) | 画像処理方法、装置、電子機器及びコンピュータプログラム | |

| US10277656B2 (en) | Method and system for delivering media data | |

| WO2020242443A1 (en) | Protocol conversion of a video stream | |

| JP6119765B2 (ja) | 情報処理装置、情報処理システム、情報処理プログラム、及び動画データ送受信方法 | |

| JP4444358B1 (ja) | プログレッシブダウンロード再生用プログラム | |

| TW201215100A (en) | Information processing device and information processing method | |

| JP4526294B2 (ja) | ストリームデータ送信装置、受信装置、プログラムを記録した記録媒体、およびシステム | |

| CN108307248A (zh) | 视频播放方法、装置、计算设备及存储介质 | |

| US20190373213A1 (en) | Information processing device and method | |

| JP6193569B2 (ja) | 受信装置、受信方法、及びプログラム、撮像装置、撮像方法、及びプログラム、送信装置、送信方法、及びプログラム | |

| US10002644B1 (en) | Restructuring video streams to support random access playback | |

| JP5940999B2 (ja) | 映像再生装置、映像配信装置、映像再生方法、映像配信方法及びプログラム | |

| JP7365212B2 (ja) | 動画再生装置、動画再生システム、および動画再生方法 | |

| US11409415B1 (en) | Frame interpolation for media streaming | |

| WO2010103963A1 (ja) | 情報処理装置および方法、並びに情報処理システム | |

| US10356159B1 (en) | Enabling playback and request of partial media fragments | |

| JP2020022106A (ja) | 情報処理装置、情報処理方法、及びプログラム | |

| JP2010011287A (ja) | 映像伝送方法および端末装置 | |

| KR101603976B1 (ko) | 동영상 파일 결합 방법 및 그 장치 | |

| JPWO2015020069A1 (ja) | データ処理装置、データ処理方法、プログラム、記録媒体及びデータ処理システム | |

| US20120082435A1 (en) | Moving image display device | |

| CN118573955B (zh) | 一种基于hls协议的加密方法及系统 | |

| JP2004349743A (ja) | 映像ストリーム切替システム、方法、映像ストリーム切替システムを含む映像監視、映像配信システム |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20170228 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20170313 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6119765 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| S111 | Request for change of ownership or part of ownership |

Free format text: JAPANESE INTERMEDIATE CODE: R313113 |

|

| R350 | Written notification of registration of transfer |

Free format text: JAPANESE INTERMEDIATE CODE: R350 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| LAPS | Cancellation because of no payment of annual fees |