JP6119765B2 - Information processing apparatus, information processing system, information processing program, and moving image data transmission / reception method - Google Patents

Information processing apparatus, information processing system, information processing program, and moving image data transmission / reception method Download PDFInfo

- Publication number

- JP6119765B2 JP6119765B2 JP2014546811A JP2014546811A JP6119765B2 JP 6119765 B2 JP6119765 B2 JP 6119765B2 JP 2014546811 A JP2014546811 A JP 2014546811A JP 2014546811 A JP2014546811 A JP 2014546811A JP 6119765 B2 JP6119765 B2 JP 6119765B2

- Authority

- JP

- Japan

- Prior art keywords

- frame

- video

- video data

- deleted

- information

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

- 230000005540 biological transmission Effects 0.000 title claims description 79

- 238000000034 method Methods 0.000 title claims description 55

- 230000010365 information processing Effects 0.000 title claims description 38

- 238000012217 deletion Methods 0.000 claims description 74

- 230000037430 deletion Effects 0.000 claims description 73

- 230000000295 complement effect Effects 0.000 claims description 69

- 238000012544 monitoring process Methods 0.000 claims description 46

- 238000012545 processing Methods 0.000 claims description 30

- 230000008569 process Effects 0.000 claims description 26

- 238000003860 storage Methods 0.000 claims description 26

- 238000004891 communication Methods 0.000 claims description 18

- 230000033001 locomotion Effects 0.000 claims description 18

- 230000001360 synchronised effect Effects 0.000 claims description 7

- 239000000872 buffer Substances 0.000 description 23

- 238000009826 distribution Methods 0.000 description 19

- 230000006870 function Effects 0.000 description 10

- 238000010586 diagram Methods 0.000 description 9

- 230000008859 change Effects 0.000 description 7

- 238000012546 transfer Methods 0.000 description 7

- 230000000694 effects Effects 0.000 description 5

- 238000012986 modification Methods 0.000 description 5

- 230000004048 modification Effects 0.000 description 5

- 230000004044 response Effects 0.000 description 5

- 230000006835 compression Effects 0.000 description 4

- 238000007906 compression Methods 0.000 description 4

- 238000001514 detection method Methods 0.000 description 4

- 230000005236 sound signal Effects 0.000 description 4

- 238000005516 engineering process Methods 0.000 description 3

- 239000004065 semiconductor Substances 0.000 description 3

- 238000004364 calculation method Methods 0.000 description 2

- 238000012508 change request Methods 0.000 description 2

- 238000013500 data storage Methods 0.000 description 2

- 230000003111 delayed effect Effects 0.000 description 2

- 230000006866 deterioration Effects 0.000 description 2

- 238000004519 manufacturing process Methods 0.000 description 2

- 230000000007 visual effect Effects 0.000 description 2

- 230000009471 action Effects 0.000 description 1

- 230000015556 catabolic process Effects 0.000 description 1

- 238000006731 degradation reaction Methods 0.000 description 1

- 239000000284 extract Substances 0.000 description 1

- 230000007774 longterm Effects 0.000 description 1

- 238000012423 maintenance Methods 0.000 description 1

- 238000007726 management method Methods 0.000 description 1

- 230000003287 optical effect Effects 0.000 description 1

- 230000009467 reduction Effects 0.000 description 1

- 238000011946 reduction process Methods 0.000 description 1

- 230000002194 synthesizing effect Effects 0.000 description 1

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/234—Processing of video elementary streams, e.g. splicing of video streams, manipulating MPEG-4 scene graphs

- H04N21/2343—Processing of video elementary streams, e.g. splicing of video streams, manipulating MPEG-4 scene graphs involving reformatting operations of video signals for distribution or compliance with end-user requests or end-user device requirements

- H04N21/234381—Processing of video elementary streams, e.g. splicing of video streams, manipulating MPEG-4 scene graphs involving reformatting operations of video signals for distribution or compliance with end-user requests or end-user device requirements by altering the temporal resolution, e.g. decreasing the frame rate by frame skipping

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/233—Processing of audio elementary streams

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/24—Monitoring of processes or resources, e.g. monitoring of server load, available bandwidth, upstream requests

- H04N21/2402—Monitoring of the downstream path of the transmission network, e.g. bandwidth available

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/40—Client devices specifically adapted for the reception of or interaction with content, e.g. set-top-box [STB]; Operations thereof

- H04N21/43—Processing of content or additional data, e.g. demultiplexing additional data from a digital video stream; Elementary client operations, e.g. monitoring of home network or synchronising decoder's clock; Client middleware

- H04N21/44—Processing of video elementary streams, e.g. splicing a video clip retrieved from local storage with an incoming video stream, rendering scenes according to MPEG-4 scene graphs

- H04N21/4402—Processing of video elementary streams, e.g. splicing a video clip retrieved from local storage with an incoming video stream, rendering scenes according to MPEG-4 scene graphs involving reformatting operations of video signals for household redistribution, storage or real-time display

- H04N21/440281—Processing of video elementary streams, e.g. splicing a video clip retrieved from local storage with an incoming video stream, rendering scenes according to MPEG-4 scene graphs involving reformatting operations of video signals for household redistribution, storage or real-time display by altering the temporal resolution, e.g. by frame skipping

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/60—Network structure or processes for video distribution between server and client or between remote clients; Control signalling between clients, server and network components; Transmission of management data between server and client, e.g. sending from server to client commands for recording incoming content stream; Communication details between server and client

- H04N21/65—Transmission of management data between client and server

- H04N21/654—Transmission by server directed to the client

- H04N21/6547—Transmission by server directed to the client comprising parameters, e.g. for client setup

Description

本発明は、動画データの送受信技術に関する。 The present invention relates to moving image data transmission / reception technology.

現在、外部に持ち出して電池により駆動することができるスマートフォンのような移動端末機器(以下、移動端末と記述)には、例えば内蔵カメラによって動画を撮影し、それを同移動端末で視聴することができるグラフィック性能を持つものがある。このような移動端末は動画再生機能、インターネット接続機能を持ち、インターネット上にある動画サイトのコンテンツを視聴することができる。また、移動端末には、インターネットを介して家庭内のパーソナルコンピュータ(以下、パソコンと記述)の補助記憶装置等に記憶された個人的な写真や動画の視聴ができるものが提供されている。 Currently, mobile terminal devices such as smartphones (hereinafter referred to as mobile terminals) that can be taken out and driven by a battery can shoot videos with a built-in camera and view them on the mobile terminal. Some have graphic performance that can be done. Such a mobile terminal has a video playback function and an Internet connection function, and can view the content of a video site on the Internet. In addition, mobile terminals that can view personal photos and videos stored in an auxiliary storage device of a personal computer (hereinafter referred to as a personal computer) in the home via the Internet are provided.

ところで、動画は送信時に、映像フレームと音声フレームとを個別にエンコードして異なるストリームとして送信される。この場合、動画の視聴時に音声と映像とがずれて再生されることがある。視聴者が画面に表示されている人を見たときに違和感なく話しているように感じられるように映像フレームと音声フレームを調整することをリップシンク調整と呼ぶ。 By the way, at the time of transmission, a moving image is transmitted as a different stream by separately encoding a video frame and an audio frame. In this case, the audio and the video may be reproduced with a shift when the moving image is viewed. The adjustment of the video frame and the audio frame so that the viewer can feel as if he / she is speaking without feeling uncomfortable when he / she sees the person displayed on the screen is called lip sync adjustment.

映像フレームと音声フレームとが個別にエンコードされ、異なるストリームとして送信されて、送信先で再生される技術の一例として、第1〜5の技術がある。第1の技術として、エンコーダ側とデコーダ側のクロック周波数の差を吸収し、オーディオフレーム出力タイミングにビデオフレーム出力タイミングを合わせてリップシンクさせる受信装置がある。この受信装置は、エンコーダ側の基準クロックに基づくビデオタイムスタンプが順次付された複数の符号化ビデオフレームと基準クロックに基づくオーディオタイムスタンプが順次付された複数の符号化オーディオフレームとを受信して復号する復号手段を有する。さらに、受信装置は、復号手段によって符号化ビデオフレーム及び符号化オーディオフレームを復号した結果得られる複数のビデオフレーム及び複数のオーディオフレームを蓄積する記憶手段を有する。また受信装置は、エンコーダ側の基準クロックのクロック周波数とデコーダ側のシステムタイムクロックのクロック周波数とのずれによって生じる時間差を算出する算出手段を有する。さらに受信装置は、時間差に応じ複数のオーディオフレームをフレーム単位で順次出力するときのオーディオフレーム出力タイミングを基準として複数のビデオフレームをフレーム単位で順次出力するときのビデオフレーム出力タイミングを調整する調整手段を有する。 As examples of techniques in which video frames and audio frames are individually encoded, transmitted as different streams, and reproduced at a transmission destination, there are first to fifth techniques. As a first technique, there is a receiving apparatus that absorbs a difference in clock frequency between an encoder side and a decoder side and lip-syncs the audio frame output timing with the video frame output timing. The receiving apparatus receives a plurality of encoded video frames sequentially attached with video time stamps based on a reference clock on an encoder side and a plurality of encoded audio frames sequentially attached with audio time stamps based on a reference clock. Decoding means for decoding is included. Further, the receiving apparatus has storage means for storing a plurality of video frames and a plurality of audio frames obtained as a result of decoding the encoded video frame and the encoded audio frame by the decoding means. The receiving device also has a calculation means for calculating a time difference caused by a difference between the clock frequency of the reference clock on the encoder side and the clock frequency of the system time clock on the decoder side. Further, the receiving apparatus adjusts video frame output timing when sequentially outputting a plurality of video frames in units of frames based on an audio frame output timing when sequentially outputting a plurality of audio frames in units of frames according to a time difference. Have

第2の技術として、リップシンク制御装置は所定のタイミングで入力された音声基準信号を含み且つエンコードされた音声信号を入力する第1の入力手段を備える。さらに、リップシンク制御装置は、音声基準信号と同じタイミングで入力された映像基準信号を含む且つエンコードされた映像信号を入力する第2の入力手段と、第1の入力手段により入力された音声信号をデコードする第1のデコード手段と、を備える。さらに、リップシンク制御装置は、第2の入力手段により入力された映像信号をデコードする第2のデコード手段と、第1のデコード手段でデコードされた音声信号に含まれる音声基準信号と、を備える。さらに、リップシンク制御装置は、第2のデコード手段でデコードされた映像信号に含まれる映像基準信号との間の時間ずれ量を検出する時間ずれ検出手段を備える。さらに、リップシンク制御装置は、時間ずれ検出手段での検出結果に基づいて、音声信号と映像信号とのうち相互の時間関係が早い方の信号を時間ずれ量分遅らせてそれぞれ出力するように制御する制御手段と、を備える。 As a second technique, the lip sync control apparatus includes first input means for inputting an encoded audio signal that includes an audio reference signal input at a predetermined timing. Furthermore, the lip sync control device includes a second input means for inputting an encoded video signal including a video reference signal input at the same timing as the audio reference signal, and an audio signal input by the first input means. First decoding means for decoding. The lip sync control device further includes second decoding means for decoding the video signal input by the second input means, and an audio reference signal included in the audio signal decoded by the first decoding means. . The lip sync control device further includes a time shift detection unit that detects a time shift amount between the video reference signal included in the video signal decoded by the second decoding unit. Further, the lip sync control device controls the audio signal and the video signal, which are earlier in time relative to each other, to be output after being delayed by the amount of time shift based on the detection result of the time shift detection means. And a control means.

第3の技術として、映像及び音声をネットワークを介して通信する画像通信装置であって、映像及び音声の受信側での受信状況に応じて、送信するレートをアプリケーション層から制御する制御手段を有する画像通信装置がある。画像通信装置は、さらに、制御手段により制御された送信レートで映像及び音声を送信する送信手段を有する。 A third technique is an image communication apparatus that communicates video and audio via a network, and includes a control unit that controls a transmission rate from an application layer according to a reception state on the video and audio reception side. There is an image communication device. The image communication apparatus further includes transmission means for transmitting video and audio at a transmission rate controlled by the control means.

第4の技術として、パケット廃棄時に廃棄による品質への影響の小さいパケットを多く廃棄し、廃棄による品質への影響の大きなパケットはなるべく廃棄しない方式がある。 As a fourth technique, there is a method in which many packets that have a small effect on quality due to discard are discarded when a packet is discarded, and packets that have a large effect on quality due to discard are not discarded as much as possible.

第5の技術として、同期のとれたデジタル映像とデジタル音声それぞれに同一の時間情報を電子透かしとして挿入し、同期のずれた電子透かし挿入後のデジタル映像とデジタル音声それぞれから時間情報を抽出する。そして、デジタル映像の時間情報とデジタル音声の時間情報とを比較して両者が一致するようデジタル映像とデジタル音声の少なくともいずれか一方を遅延する。 As a fifth technique, the same time information is inserted as a digital watermark into each of the synchronized digital video and digital audio, and the time information is extracted from each of the digital video and digital audio after the digital watermark is out of synchronization. Then, the time information of the digital video and the time information of the digital audio are compared, and at least one of the digital video and the digital audio is delayed so that they match.

上記第1〜第5の技術はいずれも、映像フレームと音声フレームとを個別にエンコードして異なるストリームとして送信され、送信先で再生する技術である。 Each of the first to fifth techniques is a technique in which video frames and audio frames are individually encoded and transmitted as different streams and reproduced at a transmission destination.

しかしながら、上記第1〜5の技術を用いても、動画の再生レートより伝送レートが低いネットワーク環境では伝送前のデータ本来の画質と比較すると再生時の画像品質が低下する。 However, even when the first to fifth technologies are used, the image quality at the time of reproduction is deteriorated in the network environment where the transmission rate is lower than the reproduction rate of the moving image as compared with the original image quality of the data before transmission.

そこで、1つの側面では、本発明は、帯域幅の狭いネットワークを介して保存先から送信された動画データの再生品質を向上させることを目的とする。 Accordingly, in one aspect, an object of the present invention is to improve the reproduction quality of moving image data transmitted from a storage destination via a network having a narrow bandwidth.

一態様の第1の情報処理装置は、記憶部、監視部、削除部、フレーム情報生成部、及び送信部を含む。記憶部は、第1の映像データと、第1の映像データと対応付けた同期情報を含む音声データと、を記憶する。監視部は、通信ネットワークの状態を監視する。削除部は、監視の結果に応じて、第1の映像データの単位時間当たりの第1のフレーム数を示す第1のフレームレートから、第1の映像データのうち、対応する音声データの音声レベルが所定の閾値以下である連続する映像フレームを削除して、第1のフレームレートより低い第2のフレームレートにした第2の映像データを生成する。フレーム情報生成部は、削除されたフレームに関するフレーム情報を生成する。送信部は、第2の映像データ及びフレーム情報を送信する。 The first information processing apparatus according to one aspect includes a storage unit, a monitoring unit, a deletion unit, a frame information generation unit, and a transmission unit. The storage unit stores first video data and audio data including synchronization information associated with the first video data. The monitoring unit monitors the state of the communication network. The deletion unit determines, from the first frame rate indicating the first number of frames per unit time of the first video data, the audio level of the corresponding audio data in the first video data according to the monitoring result. The second video data having a second frame rate lower than the first frame rate is generated by deleting consecutive video frames having a value equal to or less than a predetermined threshold. The frame information generation unit generates frame information regarding the deleted frame. The transmission unit transmits the second video data and frame information.

第2の情報処理装置は、受信部、補完画像生成部、及び映像データ生成部を含む。受信部は、第1の映像データの単位時間当たりの第1のフレーム数を示す第1のフレームレートから、第1の映像データのうち、対応する音声データの音声レベルが所定の閾値以下である連続する映像フレームが削除されて第1のフレーム数より小さい第2のフレームレートにされた第2の映像データと、削除されたフレームに関するフレーム情報と、を受信する。補完画像生成部は、フレーム情報を用いて削除されたフレームの画像を補完する補完画像を生成する。映像データ生成部は、補完画像と、第2の映像データとを用いて、第1のフレームレートの映像データを生成する。 The second information processing apparatus includes a reception unit, a complementary image generation unit, and a video data generation unit. From the first frame rate indicating the first number of frames per unit time of the first video data, the receiving unit has the audio level of the corresponding audio data of the first video data equal to or less than a predetermined threshold. Second video data in which consecutive video frames are deleted to a second frame rate smaller than the first frame number and frame information related to the deleted frames are received. The complementary image generation unit generates a complementary image that complements the deleted frame image using the frame information. The video data generation unit generates video data of the first frame rate using the complementary image and the second video data.

本実施形態に係る情報処理システムによれば、保存先からネットワークを介して送信された動画データの再生品質を向上させることができる。 According to the information processing system according to the present embodiment, it is possible to improve the reproduction quality of moving image data transmitted from a storage destination via a network.

図1は、本実施形態に係る情報処理システムの機能ブロック図の一例である。第1の情報処理装置1は、記憶部2、監視部3、削除部4、フレーム情報生成部5、送信部6を含む。

FIG. 1 is an example of a functional block diagram of the information processing system according to the present embodiment. The first information processing apparatus 1 includes a

記憶部2は、第1の映像データと、第1の映像データと対応付けた同期情報を含む音声データと、を記憶する。監視部3は、通信ネットワークの状態を監視する。

The

削除部4は、監視の結果に応じて、第1の映像データの単位時間当たりの第1のフレーム数を示す第1のフレームレートから、第1の映像データのうち、対応する音声データの音声レベルが所定の閾値以下である連続する映像フレームを削除して、第1のフレームレートより低い第2のフレームレートにした第2の映像データを生成する。また、削除部4は、連続するフレーム間で、類似度が所定の閾値以上である連続するフレームのいずれかを削除する。 The deletion unit 4 determines the audio of the corresponding audio data from the first frame rate based on the first frame rate indicating the first number of frames per unit time of the first video data according to the monitoring result. Second video data having a second frame rate lower than the first frame rate is generated by deleting consecutive video frames having a level equal to or lower than a predetermined threshold. In addition, the deletion unit 4 deletes any of the consecutive frames whose similarity is equal to or greater than a predetermined threshold between consecutive frames.

フレーム情報生成部5は、削除されたフレームに関するフレーム情報を生成する。

送信部6は、第2の映像データ、音声データ、及びフレーム情報を送信する。The frame

The transmission unit 6 transmits the second video data, audio data, and frame information.

第2の情報処理装置7は、受信部8、補完画像生成部9、及び映像データ生成部10を含む。

The second information processing device 7 includes a reception unit 8, a complementary image generation unit 9, and a video

受信部8は、第1の映像データの単位時間当たりの第1のフレーム数を示す第1のフレームレートから、第1の映像データのうち、対応する音声データの音声レベルが所定の閾値以下である連続する映像フレームが削除されて第1のフレーム数より小さい第2のフレームレートにされた第2の映像データと、削除されたフレームに関するフレーム情報と、を受信する。また、受信部8は、さらに、第1の映像データと対応付けた同期情報を含む音声データを受信する。 From the first frame rate indicating the first number of frames per unit time of the first video data, the receiving unit 8 determines that the audio level of the corresponding audio data of the first video data is equal to or lower than a predetermined threshold. The second video data in which a certain continuous video frame is deleted and the second frame rate is smaller than the first frame number and the frame information related to the deleted frame are received. The receiving unit 8 further receives audio data including synchronization information associated with the first video data.

補完画像生成部9は、フレーム情報を用いて削除されたフレームの画像を補完する補完画像を生成する。また、補完画像生成部9は、削除されたフレームの直前のフレームを複製することにより補完画像を生成する。また、補完画像生成部9は、削除されたフレームの前後のフレームを用いて、削除されたフレームに含まれる移動量が所定の閾値以上である対象物を判別し、対象物を表示する領域は、削除されたフレームの直後の削除されていないフレームの対象物を示す領域を複製することにより補完画像を生成する。 The complementary image generation unit 9 generates a complementary image that complements the deleted frame image using the frame information. Further, the complementary image generation unit 9 generates a complementary image by duplicating the frame immediately before the deleted frame. In addition, the complementary image generation unit 9 uses the frames before and after the deleted frame to determine an object whose movement amount included in the deleted frame is equal to or greater than a predetermined threshold, and an area for displaying the object is The complementary image is generated by duplicating the area indicating the object of the non-deleted frame immediately after the deleted frame.

映像データ生成部10は、補完画像と、第2の映像データとを用いて、第1のフレームレートの映像データを生成する。また、映像データ生成部10は、フレーム情報を用いて、補完画像を第2の映像データの削除されたフレームの位置に挿入し、第1のフレームレートの映像データを生成する。また、映像データ生成部10は、同期情報を用いて、削除されたフレームに対応する補完画像と、削除されたフレームに対応する音声データとを同期させ、第1のフレームレートの映像データを生成する。

The video

このような構成とすることで、ネットワークの帯域幅に応じて動画データの伝送レートまたはフレームレートを変更することができる。よって、ネットワークを流れるストリーミングデータの単位時間当たりのデータ量を削減することができる。また、映像フレームの音声フレームに対する遅延を防ぐことができる。また、映像フレームが音声フレームに比べて伝送量が大きいために、移動端末の映像デコード処理の際に一定時間内に映像フレームが届かずに発生する映像フレームの欠落を防ぐことができる。 With such a configuration, the transmission rate or frame rate of moving image data can be changed according to the bandwidth of the network. Therefore, the data amount per unit time of streaming data flowing through the network can be reduced. Further, it is possible to prevent a delay of the video frame with respect to the audio frame. In addition, since the transmission amount of the video frame is larger than that of the audio frame, it is possible to prevent the loss of the video frame that occurs when the video frame does not reach within a certain time during the video decoding process of the mobile terminal.

さらに、動画の再生レートより伝送レートが低いネットワーク環境を介して動画データを受信し、受信側で十分な動画再生のためのバッファを確保できない場合であっても、送信前の動画データ本来のフレームレートで動画データを再生することが可能となる。 Furthermore, even if video data is received via a network environment where the transmission rate is lower than the video playback rate, and the receiver does not have enough buffer for video playback, the original frame of video data before transmission It becomes possible to reproduce moving image data at a rate.

また、音声レベルに基いて削除する映像フレームを決定するため、削除フレームの前後の削除されていない映像フレームをコピーすることによって削除された映像フレームを復元した場合でも、動画再生時の視聴者の違和感を抑えることができる。また、前後の映像フレームを合成することにより補完フレームを生成することに比べて、補完フレーム生成のための計算量を削減することができ、補完フレームの作成時間に依存する映像と音声のずれを防ぐことができる。 Also, in order to determine the video frame to be deleted based on the audio level, even when the deleted video frame is restored by copying the undeleted video frame before and after the deleted frame, the viewer's A sense of incongruity can be suppressed. Compared to generating complementary frames by synthesizing previous and next video frames, the amount of computation for generating complementary frames can be reduced, and the difference between video and audio depending on the creation time of complementary frames can be reduced. Can be prevented.

また、削除された映像フレームに対応する補完フレームが生成された際に、生成された補完フレームのタイムスタンプが、その映像フレームに対応する音声フレームのタイムスタンプに同期されることにより、映像データと音声データの同期が可能となる。これにより、帯域幅の狭いネットワークを介して保存先から送信された動画データにおける映像再生と音声再生とのずれを最小限に抑えることができる。さらに、リップシンク調整のためのメモリ領域を削減することができ、また、演算負荷を削減することができる。例えば、ビデオメモリやオーディオメモリにおいて、映像データもしくは音声データを遅延させることによりリップシンク調整を行わなくてもよい。従って、リップシンクのためのメモリ領域とその映像処理に耐えうるGPU(Graphics Processing Unit)を削減することができる。 In addition, when a complementary frame corresponding to the deleted video frame is generated, the time stamp of the generated complementary frame is synchronized with the time stamp of the audio frame corresponding to the video frame, so that the video data and Audio data can be synchronized. As a result, it is possible to minimize the difference between video reproduction and audio reproduction in moving image data transmitted from a storage destination via a network with a narrow bandwidth. Furthermore, the memory area for lip sync adjustment can be reduced, and the calculation load can be reduced. For example, in the video memory or the audio memory, the lip sync adjustment may not be performed by delaying the video data or the audio data. Therefore, a memory area for lip sync and a GPU (Graphics Processing Unit) that can withstand the video processing can be reduced.

本実施形態のシステム構成の一例を説明する。図2は、本実施形態に係る情報処理システムの構成の一例を示す。 An example of the system configuration of this embodiment will be described. FIG. 2 shows an example of the configuration of the information processing system according to the present embodiment.

図2に示すように、情報処理システムは、パソコン33、サーバ31、及び移動端末35を含む。パソコン33とサーバ31、サーバ31と移動端末35は通信キャリア34を介してネットワークで接続される。サーバ31は、第1の情報処理装置1の一例である。移動端末35は、第2の情報処理装置7の一例である。

As shown in FIG. 2, the information processing system includes a

情報処理システムは、パソコン33、サーバ31、移動端末35、を含む。パソコン33は、動画データを保存する。サーバ31は、パソコン33から動画データを受信し、受信した動画データのうち複数の映像フレームを削除して転送する。移動端末35は、サーバ31から受信した動画データを再生することができる。

The information processing system includes a

パソコン33は、移動端末35からサーバ31を介してアクセスされる動画データを記憶する。パソコン33は、例えば家庭内に配置され、インターネットを介してサーバ31に接続される。サーバ31からパソコン33へのアクセスは、認証機能によりアクセス制限される。また、パソコン33は、サーバ31毎にそのサーバ31に対して提供可能な動画ファイルの一覧情報を含むファイルを保持する。または、パソコン33は、移動端末35毎にその移動端末35に対して提供可能な動画ファイルの一覧情報を含むファイルを保持してもよい。尚、パソコン33は、サーバ31の機能を有するホストコンピュータでもよいし、動画ファイルを格納しネットワークに接続されたストレージ装置でもよい。

The

サーバ31は、移動端末35からパソコン33に保存された動画ファイルに対する視聴要求を受信する。また、サーバ31は、サーバ31と移動端末35の帯域状況の監視を行う。そして、サーバ31は、視聴要求対象の動画データをパソコン33から取得し、取得した動画データからネットワークの帯域状況に応じて複数の映像フレームを削除して、その動画データを移動端末35に転送する。ネットワークの帯域監視及び映像フレームの削除方法の詳細については後ほど説明する。尚、サーバ31は移動端末35との接続を確立するための認証機能を有する。

The

移動端末35は、ユーザから、再生したい動画の要求を受け付ける。そして、パソコン33に対して、動画の転送を指示する。移動端末35は、サーバ31から動画データをストリーミング形式で受信する。受信した動画データのうち送信時に削除された映像フレームがあれば、移動端末35は、その映像フレームに対応する補完フレームを生成して、動画データに挿入する。それにより、パソコン33は、映像フレームを削除する前の動画データを復元する。そして、移動端末35は復元した動画データを再生する。復元処理を行うことで、移動端末35は動画データをパソコン33に保存されていた動画データと同じフレームレートで再生する。

The

尚、以下の説明では、パソコン33からサーバ31に対してデータを送信することを上り(アップロード)と記し、サーバ31から移動端末35にデータを送信することを下り(ダウンロード)と記すことがある。また、動画データの送信元となるパソコン33またはサーバ31を送信端末、動画データの受信側となるサーバ31または移動端末35を受信端末と記すことがある。さらに、パソコン33において削除される映像フレームを削除フレームと記すことがある。

In the following description, transmitting data from the

ここで映像データのメタ情報の構造を説明する。映像データのメタ情報は映像データとともに送信端末から受信端末へと送付される。送信端末は削除した映像フレームの情報をメタ情報に付加させ、受信端末はこのメタ情報を用いて補完フレームを生成することにより動画データを復元する。図3は、映像データのメタ情報の構造の一例を示す。 Here, the structure of meta information of video data will be described. The meta information of the video data is sent from the transmitting terminal to the receiving terminal together with the video data. The transmitting terminal adds the information of the deleted video frame to the meta information, and the receiving terminal restores the moving image data by generating a complementary frame using the meta information. FIG. 3 shows an example of the structure of meta information of video data.

メタ情報は、動画データに関する情報であり動画データに対応付けられる。メタ情報は、フォーマットサイズ(コンテンツ解像度)43、映像タイトル44、映像時間45、作成日46、内容47、削除フレーム開始番号41、削除フレーム期間(フレーム数)42を含む。

The meta information is information related to the moving image data and is associated with the moving image data. The meta information includes a format size (content resolution) 43, a video title 44, a

フォーマットサイズ(コンテンツ解像度)43、映像タイトル44、映像時間45、作成日46、内容47は、パソコン33に保存された動画データに含まれる。フォーマットサイズ(コンテンツ解像度)43、映像タイトル44、映像時間45、作成日46、内容47は、それぞれ、対応する動画データの、フォーマットサイズ(コンテンツ解像度)、映像タイトル、映像時間、作成日、内容である。

The format size (content resolution) 43, the video title 44, the

削除フレーム開始番号41、削除フレーム期間(フレーム数)42は、送信端末において映像フレームを削除する場合に、メタデータに付加されるデータ項目である。削除フレーム開始番号41は、送信端末により削除される映像フレームのフレーム番号(フレームの識別番号)である。削除フレーム期間(フレーム数)42は、削除される映像フレームが連続する場合の期間を示し、例えば、削除フレームの連続数で表される。

The deletion

削除フレーム開始番号41、削除フレーム期間(フレーム数)42は、所定期間毎(例えば1秒毎)の削除フレームの情報である。よって、所定期間内に削除フレームが複数ある場合には、削除フレーム毎に対応付けた、削除フレーム開始番号41、削除フレーム期間42のデータ項目が、メタ情報に付加される。

The deletion

ここで、削除フレーム開始番号41、削除フレーム期間(フレーム数)42は、再開始フレームのフレーム番号、再開始フレームの期間(フレーム数)でもよい。本実施形態では、削除フレームは連続するものであるため、削除され欠落した映像フレームの次に位置する、映像の再開始フレームの番号とそのフレーム期間の情報があれば、移動端末35での映像再生のときに削除フレームの開始番号とその期間を事前に認識できる。これにより、移動端末35で削除フレームの開始番号とその期間の補完を行ってもよい。

Here, the deletion

次に、送信端末において動画データから映像フレームが削除されて送信され、受信端末において補完フレームが生成されて動画データが復元される動作の説明をする。 Next, a description will be given of an operation in which a video frame is deleted from a moving image data and transmitted at a transmitting terminal, a complementary frame is generated at a receiving terminal, and the moving image data is restored.

送信端末においてどの映像フレームが削除されるかの判定は、各映像フレームに対応する音声フレームの音声レベルに基いて行われる。 The determination of which video frame is deleted at the transmission terminal is made based on the audio level of the audio frame corresponding to each video frame.

動画再生において、リップシンクずれがもっとも顕著に表れるのは、人が話す場面における人の口の動きと音声とのずれである。音量レベルが小さいときは、例え人の顔が映像に表示されていたとしても口は動いていないものと考えられる。よって、音声レベルが小さい連続する映像フレームを削除して、削除フレームの直前の映像フレームをコピーすることによって復元することにより、動画再生時の視聴者の違和感を抑えることができる。 In video playback, the lip sync deviation appears most prominently in the movement of the person's mouth and the voice in the scene where the person speaks. When the volume level is low, it is considered that the mouth is not moving even if a person's face is displayed in the video. Therefore, it is possible to suppress a viewer's uncomfortable feeling when reproducing a moving image by deleting consecutive video frames having a low audio level and restoring by copying a video frame immediately before the deleted frame.

尚、映像フレームの削除処理において、削除されるのは映像データだけであり、音声データは削除されない。それは移動端末側では元の映像と同じフレーム数で再生されるため、音声データを削除する必要はないからである。 In the video frame deletion process, only video data is deleted, and audio data is not deleted. This is because it is not necessary to delete the audio data because the mobile terminal reproduces the same number of frames as the original video.

次に、送信端末において動画データから映像フレームが削除されて送信され、受信端末において補完フレームが生成されて動画データが復元される様子を説明する。図4は、映像フレームの削除及び復元の様子を説明するための図である。尚、図4では映像フレームの削除処理はサーバ31で行われるとするが、パソコン33が行ってもよい。

Next, a description will be given of how a video frame is deleted from video data at the transmitting terminal and transmitted, and a complementary frame is generated at the receiving terminal to restore the video data. FIG. 4 is a diagram for explaining how video frames are deleted and restored. In FIG. 4, the video frame deletion process is performed by the

パソコン33からA〜Kのフレームが移動端末35に送信される場合を考える。まず、パソコン33は、A〜Kのフレームをメタ情報とともにサーバ31に送信する。サーバ31は、A〜Kのフレームをメタ情報とともに受信すると、各映像フレームに対応する音声レベルを認識する。音声レベルは、例えば、音の大きさや、人間の可聴範囲に属するような特定の周波数帯域に属する音の大きさ等を数値化したものであってよいし、これに限定されない。

Consider a case in which frames A to K are transmitted from the

図4の例では、音声レベル50に示すように、フレームAの音声レベルは「60」、フレームBの音声レベルは「70」、フレームCの音声レベルは「90」、以下D〜Kは同様に音声レベル50に示すとおりとする。

In the example of FIG. 4, as indicated by the

サーバ31は、各フレームのうち、音声レベルが所定の閾値以下であるフレームを判別する。そして、音声レベルが所定の閾値以下のフレームのうち、直前のフレームの音声レベルが所定の閾値以下である映像フレームを削除対象フレームとして認識する。

The

図4の場合、所定の閾値の値が20であるとする。すると、音声レベルが20以下であるフレームはD〜Gである。フレームDは、直前のフレームの音声レベルが閾値以上(フレームC、音声レベル90)であるので、映像フレームDは削除対象フレームとは認識されない。一方、フレームE〜Gはいずれも直前のフレームの音声レベルが閾値以下であるので、削除対象フレームとして認識される。尚、映像データと音声データはフレーム毎に対応付けられ、映像フレームの音声レベルは、その映像フレームに対応する音声フレームの情報が用いられて認識される。 In the case of FIG. 4, it is assumed that the predetermined threshold value is 20. Then, the frames whose audio level is 20 or less are D to G. In the frame D, the audio level of the immediately preceding frame is equal to or higher than the threshold (frame C, audio level 90), so the video frame D is not recognized as a deletion target frame. On the other hand, the frames E to G are recognized as frames to be deleted because the audio level of the immediately preceding frame is equal to or less than the threshold value. Note that video data and audio data are associated with each frame, and the audio level of the video frame is recognized using information of the audio frame corresponding to the video frame.

次に、サーバ31は認識した削除対象フレームを動画データから削除する。そして、サーバ31は、削除フレームに関する情報をメタ情報に付加する。図4の例の場合映像フレームE〜Gの情報がメタ情報に付加される。具体的には、サーバ31は、削除フレーム開始番号41に映像フレームEのフレーム番号を格納し、削除フレーム期間(フレーム数)42に整数値「3」を格納する。

Next, the

ここで、削除する映像フレームの数は、サーバ31と移動端末35の間のネットワークの帯域幅よりも送信する動画データの伝送レートが小さくなるように決定される。

Here, the number of video frames to be deleted is determined such that the transmission rate of the moving image data to be transmitted is smaller than the bandwidth of the network between the

動画データの所定の期間内、すなわち所定数の連続するフレームのうち、音声レベルが閾値以下であるフレームが存在しない場合も考えられる。例えば、図4の場合、閾値を3とした場合、フレームA〜Kのうち、音声レベルが閾値以下のフレームが存在しない。この場合、削除対象のフレームが存在しないこととなり、ネットワークの帯域幅を超える伝送レートで動画が配信されてしまう。この場合は、同時に削除対象の判別が行われる動画データの期間を増やすことにより対応するが、この動作の詳細は後ほど説明する。 There may be a case where there is no frame having a sound level equal to or lower than a threshold value within a predetermined period of the moving image data, that is, a predetermined number of consecutive frames. For example, in the case of FIG. 4, when the threshold is set to 3, there is no frame having an audio level equal to or lower than the threshold among the frames A to K. In this case, there is no frame to be deleted, and a moving image is distributed at a transmission rate that exceeds the bandwidth of the network. This case can be dealt with by increasing the period of the moving image data in which the deletion target is simultaneously determined. Details of this operation will be described later.

サーバ31は、削除した映像フレームの情報を追記したメタ情報をフレームに付随させて、移動端末35に送信する。すると、移動端末35は、映像フレームE〜Gが削除された状態の映像データを受信することとなる。移動端末35は、映像データと同時にメタ情報を受信し、削除された映像フレームは映像フレームE〜Gであることを認識する。具体的には、移動端末35はメタ情報の削除フレーム開始番号41、削除フレーム期間(フレーム数)42の情報を認識し、削除フレームを特定する。

The

そして、移動端末35は削除された映像フレームE〜Gの補完フレームを生成し、その補完フレームを動画データの削除された映像フレームの位置に挿入することで、動画データの復元処理を行う。具体的には、移動端末35は、対応するメタ情報の削除フレーム開始番号41、削除フレーム期間(フレーム数)42から特定した削除フレームの位置に補完フレームを挿入する。

Then, the

補完フレーム生成処理は、削除フレームの前後の映像フレームが複製されることにより実行される。 The complementary frame generation process is executed by duplicating the video frames before and after the deletion frame.

図5は、補完フレーム生成処理の一例を示す図である。図5の例は、フレームの音声レベルに基いて映像フレームD〜Fが送信端末で削除された場合の補完の例を示している。映像フレームDに対応するフレームは、直前の削除されていない映像フレームである映像フレームCが複製されることによって生成される。一方、映像フレームE、Fは、直後の削除されていない映像フレームである映像フレームGが複製されることによって生成される。 FIG. 5 is a diagram illustrating an example of a complementary frame generation process. The example of FIG. 5 shows an example of complementation when the video frames D to F are deleted at the transmission terminal based on the audio level of the frame. The frame corresponding to the video frame D is generated by duplicating the video frame C, which is the previous video frame not deleted. On the other hand, the video frames E and F are generated by duplicating the video frame G, which is a video frame that has not been deleted immediately after.

補完フレームの生成では、映像フレームにおける物体の移動量を考慮して複製元の映像フレームを変化させる構成としてもよい。具体的には、移動端末35は、削除フレームの前後の削除されていない映像フレームを比較して、移動量が大きい対象物とそうでない対象物を判別する。そして、移動端末35は、移動量が大きくない対象物に対応する位置の画素値は、直前の削除されていない映像フレームの画素値を複製した値とする。移動量が大きい対象物に対応する位置の画素値は、連続する複数の削除フレームのうち、所定時点以前か以後かで複製元の映像フレームを変更させる。すなわち、所定の時点までの削除フレームの画素値は、直前の削除されていない映像フレームの画素値を複製した値とし、所定の時点より後の削除フレームの画素値は、直後の削除されていない映像フレームの画素値を複製した値とする。尚、移動量の測定は例えばMPEG(Moving Picture Experts Group)の動き補償等で用いられるような、画像の動き量を推定する動きベクトル探索を用いる方法など種々の方法で測定可能である。

The generation of the complementary frame may be configured to change the copy source video frame in consideration of the amount of movement of the object in the video frame. Specifically, the

図6は、移動量が大きい対象物と、そうでない対象物が判別され、補完フレームが生成される方法の一例を示す。図6の例は、フレームの音声レベルに基いて映像フレームD〜Fが送信端末で削除された場合の補完の例を示している。図6に示すように、映像フレームD、Eの移動量の大きい対象物を示す位置の画素値は、直前の削除されていない映像フレームである映像フレームCの対応する位置の画素値とする。また、映像フレームFの移動量の大きい対象物を示す位置の画素値は、直後の削除されていない映像フレームである映像フレームGの対応する位置の画素値とする。一方、映像フレームD、E、Fの移動量の小さい対象物を示す位置の画素値は映像フレームCの対応する位置の画素値とする。 FIG. 6 shows an example of a method in which an object having a large movement amount and an object that is not so are discriminated and a complementary frame is generated. The example of FIG. 6 shows an example of complementation when the video frames D to F are deleted at the transmission terminal based on the audio level of the frame. As shown in FIG. 6, the pixel value at the position indicating the object with the large moving amount of the video frames D and E is the pixel value at the corresponding position of the video frame C that is the previous video frame that has not been deleted. Also, the pixel value at the position indicating the object with the large moving amount of the video frame F is set as the pixel value at the corresponding position of the video frame G which is the video frame not deleted immediately after. On the other hand, a pixel value at a position indicating an object with a small moving amount of the video frames D, E, and F is a pixel value at a corresponding position in the video frame C.

ここで、動画再生時においては、音声出力は元の動画に対して変化しないことから、音飛びは発生しない。また、映像フレーム数は補完され、見た目の映像フレーム数が確保されるという点から、再生映像の見た目の画質劣化を抑えることができる。さらに、音声レベルが大きく変わるところは、映像も大きく変わると考えられ、本実施形態では音声レベルが所定の閾値より低い映像フレームを削除することから、再生映像の見た目の画質劣化を抑えることができる。 Here, at the time of moving image reproduction, since the audio output does not change with respect to the original moving image, no sound skip occurs. In addition, since the number of video frames is complemented and the number of apparent video frames is ensured, it is possible to suppress the degradation of the visual quality of the reproduced video. Furthermore, where the audio level changes significantly, it is considered that the video also changes greatly. In this embodiment, video frames whose audio level is lower than a predetermined threshold are deleted, so that it is possible to suppress the deterioration in the visual image quality of the reproduced video. .

以上、フレームの音声レベルに基いて削除対象フレームを判定する方法を説明したが、削除対象フレームの判定には、音声レベルに加えて、動画データの時系列における前後の映像フレームとの近似性、すなわち類似度をさらに考慮した方法としてもよい。 As described above, the method of determining the deletion target frame based on the audio level of the frame has been described. For the determination of the deletion target frame, in addition to the audio level, the closeness with the video frames before and after the time series of the video data, That is, a method that further considers the similarity may be used.

類似度の計算には、種々の手法が用いられてよいが、例えば、直前の映像フレームとの映像フレーム比較により導かれる相似率を類似度としてもよいし、画素値の差の二乗和(SSD: Sum of Squared Differences)を用いて計算することで、類似度を算出してもよい。 Various methods may be used to calculate the similarity. For example, the similarity calculated by comparing the video frame with the immediately previous video frame may be used as the similarity, or the sum of squares of differences in pixel values (SSD). : Similarity may be calculated by calculating using Sum of Squared Differences).

この場合、送信端末は、映像フレームのうち、類似度が所定の閾値以上である映像フレームを判別し、類似度が所定の閾値以上であると判別した映像フレームのうち音声レベルが所定の閾値以下である連続する映像フレームを削除対象フレームとする。 In this case, the transmitting terminal determines a video frame having a similarity greater than or equal to a predetermined threshold among the video frames, and an audio level of the video frame determined to have a similarity greater than or equal to a predetermined threshold is equal to or lower than the predetermined threshold. Are consecutive video frames as deletion target frames.

次に、サーバ31の動画データの配信品質監視について説明する。配信品質監視とは、動画の転送で使用する帯域幅が、サーバ31と移動端末35間のネットワークの帯域幅以下となるように、送信する動画データの映像フレームレートを調整するための調整量を決定することである。

Next, the distribution quality monitoring of the moving image data of the

サーバ31は、サーバ31と移動端末35間のネットワーク帯域の状況を動的に監視し、監視の結果に応じて動画データから映像フレームを削除することにより伝送レートの調整を行う。ここでサーバ31は動画データの伝送レートがネットワーク帯域を超えないように映像フレームの削除を行う。

The

配信品質監視では、サーバ31は、送信する動画のデータ量と安定的に送受信可能なデータ量とを比較し、安定的に送受信可能なデータ量の範囲内に送信する動画のデータ量が収まるように、動画データの映像フレームレートを決定する。ここで決定された動画データの映像フレームレートを、以下の説明では、送信用フレームレートと記す。

In the distribution quality monitoring, the

先ず、サーバ31は、サーバ31と移動端末35の間の帯域監視の結果からサーバ31と移動端末35間の使用可能な帯域幅を判定する。もしくは、帯域監視の結果と回線の伝送路容量とからサーバ31は使用可能な帯域幅を判定する。そして、サーバ31は、動画データの、解像度、ビット色、圧縮率、アクティビティレベル、及びフレームレートから動画データの伝送ビットレートを算出する。そしてサーバ31は、使用可能な帯域幅に、算出した伝送ビットレートが収まるように、動画データの映像フレームレートの削除量を導出する。

First, the

尚、アクティビティレベルは、ストリームに対するパケットの送信頻度であり、例えば動画データの内容によって変化する。例えば無音の映像データの場合、オーディオストリームを送信する必要はなく、オーディオストリームのアクティビティレベルは0になる。 The activity level is the frequency of packet transmission with respect to the stream, and varies depending on, for example, the content of the moving image data. For example, in the case of silent video data, there is no need to transmit an audio stream, and the activity level of the audio stream is zero.

次に、配信品質監視の動作について、具体例を示して説明する。サーバ31と移動端末35間の通信規格をLTE(Long Term Evolution)と仮定する。この場合の帯域幅を最大75Mbpsと仮定する。尚、以下の例では、動画データはコーデックにおいて固定ビットレートでエンコードされると想定する。

Next, the delivery quality monitoring operation will be described with a specific example. It is assumed that the communication standard between the

動画送信のために使用可能な帯域幅は、ネットワーク内の他のアプリケーション等によるトラフィックにも依存するため、常に100%使用できるというわけではない。そこで、サーバ31は帯域監視を行い、すなわち、一定量のパケットがパソコン33からサーバ31まで到達するまでにかかる時間を算出し、ネットワークのトラフィック状況を把握する。このトラフィック状況に基いて、動画配信のために保証される帯域幅の、回線の最大伝送速度に対する割合をZ%と定義する。ここでは、Z=1と仮定する。

The bandwidth that can be used for video transmission depends on traffic from other applications in the network, and is not always 100% usable. Therefore, the

動画データは、例えば解像度が1280[dot per inch(dpi)]×720[dpi]のフルHD(full high definition)、ビット色が8、映像フレームレートが24fps(frames per second)(とする。この動画データのビットレートは、(1280×720(解像度))×(3(RGB)×256(8ビット色))×24(フレーム)=17Gbpsになる。この値は1フレームが未圧縮状態である場合の値である。 The moving image data has, for example, a resolution of 1280 [dot per inch (dpi)] × 720 [dpi] full HD (full high definition), a bit color of 8, and a video frame rate of 24 fps (frames per second). The bit rate of the video data is (1280 x 720 (resolution)) x (3 (RGB) x 256 (8-bit color)) x 24 (frame) = 17 Gbps This value is one frame uncompressed Is the case value.

ここで例えばMPEG等の圧縮方式は、例えば、フルのIピクチャ(Intra picture)、1/2サイズのPピクチャ(Predictive picture)、1/4サイズのBピクチャ(Bi-directional predictive picture)を含む。そして、Iピクチャ、Pピクチャ、Bピクチャは、1:4:10の割合で構成されている。そのため、動画データの圧縮率は約11/30になる。さらに、例えば、MPEG-AVCは、移動部分だけの差異データであるため、さらにおおよそ1/24に圧縮される。よって動画データは11/30×1/24=11/720に圧縮されると想定する。 Here, for example, a compression method such as MPEG includes a full I picture (Intra picture), a 1/2 size P picture (Predictive picture), and a 1/4 size B picture (Bi-directional predictive picture). The I picture, P picture, and B picture are configured in a ratio of 1: 4: 10. Therefore, the compression rate of moving image data is about 11/30. Furthermore, for example, since MPEG-AVC is difference data of only a moving part, it is further compressed to approximately 1/24. Therefore, it is assumed that the moving image data is compressed to 11/30 × 1/24 = 11/720.

この圧縮を考慮すると動画データの伝送ビットレートは、17Gbps×11/720=259Mbpsとなる。ここで、動画データは、再生が行われる移動端末35の解像度に合わせて圧縮が可能である。例えば、サーバ31が認識した移動端末35の解像度が800×480である場合を考える。この場合、動画データは送信前に、800×480/1280×720=0.42倍に圧縮することができる。

Considering this compression, the transmission bit rate of moving image data is 17 Gbps × 11/720 = 259 Mbps. Here, the moving image data can be compressed in accordance with the resolution of the

ここで、元の動画データは解像度が大きい装置で表示するコンテンツであり、解像度が小さい移動端末35で動画データを再生する場合、動画データの解像度を移動端末35の解像度まで落としても見た目が変化することはない。また、移動端末35の映像再生チップの性能は動画データが含む情報量を全て活用できないことが多く、映像の細かい変化を再現できない。

Here, the original video data is content to be displayed on a device with a high resolution, and when video data is played back on the

よって、サーバ31が認識した移動端末35の解像度に基いた解像度をA、映像フレーム数をBとする。A=800×480、B=24の場合、動画データの伝送ビットレートは、A×(RGB各色フレーム:3×256)×B×11/720=(800×480)×(3×256)×24×11/720≒108Mbpsとなる。

Therefore, the resolution based on the resolution of the

しかしながら、この値はネットワークの帯域幅である75Mbps以下ではない。そこで、送信端末は動画データの伝送ビットレートがネットワークの帯域幅以下となるように映像フレームを削除して送信する。削除前の映像フレームに対する削除後映像フレームの割合をEとすると、108M×E≦77Mが成立すればよいから、E≦0.71となる。24×E、すなわち、24×0.71=17.04であるため、送信する動画データの映像フレームレートは17fpsに変更されればよい。この場合、元の動画の映像フレームレートは24fpsであるから、1秒間の動画データにおいて、削除する映像フレームの数は7となる。 However, this value is not less than the network bandwidth of 75 Mbps. Therefore, the transmission terminal deletes and transmits the video frame so that the transmission bit rate of the moving image data is equal to or less than the network bandwidth. If the ratio of the post-deletion video frame to the pre-deletion video frame is E, 108M × E ≦ 77M may be satisfied, and E ≦ 0.71. Since 24 × E, that is, 24 × 0.71 = 17.04, the video frame rate of the moving image data to be transmitted may be changed to 17 fps. In this case, since the video frame rate of the original moving image is 24 fps, the number of video frames to be deleted is 7 in the moving image data for 1 second.

次に、配信品質監視において決定された動画データの映像フレームレート以下となるように、配信される動画データの映像フレームが削除される動作について説明する。 Next, an operation for deleting the video frame of the moving image data to be distributed so as to be equal to or less than the video frame rate of the moving image data determined in the distribution quality monitoring will be described.

図7は、送信端末における動画データの映像フレームレートの調整を説明するための図である。 FIG. 7 is a diagram for explaining adjustment of the video frame rate of moving image data in the transmission terminal.

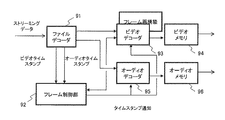

ファイルデコーダ51は、ストリーミングデータを映像データと音声データに分離する。そして、ファイルデコーダ51は分離した映像データをビデオエンコーダ53に出力し、分離した音声データをオーディオエンコーダ55に出力する。さらに、ファイルデコーダ51はストリーミングデータのメタ情報をフレーム制御部52に送信する。

The

ここで、分離された映像データと音声データはフレーム毎に対応付けられる。例えば、映像フレームと音声フレームで同じフレーム番号を有するものがそれぞれ対応付けられる。対応する映像フレームと音声フレームのタイムスタンプは同じ値が設定される。尚、タイムスタンプは、フレーム単位に再生開始からの秒数をつけ定義するものであり、タイムスタンプの時刻に合わせてフレームが再生される。各映像フレームおよび各音声フレームはそれぞれのタイムスタンプ情報を保持する。 Here, the separated video data and audio data are associated with each frame. For example, video frames and audio frames having the same frame number are associated with each other. The same value is set for the time stamp of the corresponding video frame and audio frame. The time stamp is defined by adding the number of seconds from the start of playback to each frame, and the frame is played back at the time of the time stamp. Each video frame and each audio frame holds time stamp information.

フレーム制御部52は、映像データのうち、フレームレートが送信用フレームレート以下となるように、削除する映像フレームを決定する。そして、フレーム制御部52は削除した映像フレームに関する情報をメタ情報に付加する。すなわち、フレーム制御部52は、メタ情報の削除フレーム開始番号41、削除フレーム期間(フレーム数)42に削除した映像フレームの情報を格納する。

The

ファイルデコーダ51より出力された映像データは、ビデオエンコーダ53に入力される。ビデオエンコーダ53は、映像データからフレーム制御部52により決定された削除フレームを削除し、再度映像フレームを構築する。そして、ビデオエンコーダ53は再構築した映像フレームを送信用の形式にエンコードする。エンコードした結果映像データは、例えばRTMP(Real Time Messaging Protocol)形式のパケット等に分割もしくは集約される。ビデオエンコーダ53はエンコードした映像データをビデオメモリ54に出力し、ビデオメモリ54からエンコードされた映像データが受信端末に送信される。

The video data output from the

一方、ファイルデコーダ51により分離された音声データはオーディオエンコーダ55に入力される。オーディオエンコーダ55は受信した音声データを送付用の形式に変換してオーディオメモリ56に出力する。そして、エンコードされた音声データはオーディオメモリ56から受信端末に送信される。ここで、削除された映像フレームに対応する音声フレームが削除されることはなく、音声データのメタ情報も変更されずに送信される。

On the other hand, the audio data separated by the

次に、送信端末における映像フレームの削除処理の動作フローを説明する。図8は、映像フレームの削減処理のフローチャートを示す。ここで、送信端末は、作業バッファに格納される所定期間の映像フレーム毎に削除対象フレームを判定し、そのフレームを削除することによって、作業バッファに格納された動画データの映像フレームレートが送信用フレームレート以下となるように調整される。尚、図8のフローは、作業バッファに格納される所定期間の映像フレーム毎に周期的に実行される。 Next, an operation flow of video frame deletion processing in the transmission terminal will be described. FIG. 8 shows a flowchart of video frame reduction processing. Here, the transmission terminal determines a frame to be deleted for each video frame of a predetermined period stored in the work buffer, and by deleting the frame, the video frame rate of the moving image data stored in the work buffer is set for transmission. It is adjusted so that it is below the frame rate. The flow in FIG. 8 is periodically executed for each video frame of a predetermined period stored in the work buffer.

先ず、送信端末は、所定期間の動画データを作業バッファに読み込む(バッファリングする)(S61)。次に、送信端末は、配信品質監視の結果を確認し、送信用フレームレートを認識する(S62)。そして、送信端末は、現在作業バッファ内に格納されている動画データの映像フレームレートが、S62で認識した送信用フレームレートとなるように、現在作業バッファに格納されている映像フレームのうち削除するフレーム数を確認する(S63)。 First, the transmitting terminal reads (buffers) moving image data for a predetermined period into a work buffer (S61). Next, the transmission terminal confirms the result of the distribution quality monitoring and recognizes the transmission frame rate (S62). Then, the transmitting terminal deletes the video frames currently stored in the work buffer so that the video frame rate of the moving image data currently stored in the work buffer becomes the transmission frame rate recognized in S62. The number of frames is confirmed (S63).

次に、送信端末は、作業バッファに格納された映像フレームのうち、各フレームに対応する音声レベルに基いて削除する削除対象フレームの判別を行う(S64)。そして、送信端末は、S64で判別した削除対象フレームの数が、S63で確認した削除フレーム数以上か否かを判定する(S65)。 Next, the transmission terminal determines a deletion target frame to be deleted based on the audio level corresponding to each frame among the video frames stored in the work buffer (S64). Then, the transmitting terminal determines whether or not the number of deletion target frames determined in S64 is equal to or greater than the number of deleted frames confirmed in S63 (S65).

S64で判別した削除対象フレーム数がS63で確認した削除フレームの数より小さい場合(S65でNo)、送信端末は、作業バッファに格納するフレームの期間を増加して(S66)、再度削除フレームの判別を行う(S64)。S64で判別した削除対象フレームの数がS63で確認した削除フレーム数以上である場合(S65でYes)、送信端末は、S64で判別した削除対象フレームを削除し、その削除フレームの情報をメタ情報に付加する(S66)。そして、送信端末は、映像データを送付用にエンコードして動画データを配信する(S67)。 When the number of frames to be deleted determined in S64 is smaller than the number of deleted frames confirmed in S63 (No in S65), the transmitting terminal increases the period of frames to be stored in the work buffer (S66), and deletes the deleted frames again. A determination is made (S64). When the number of deletion target frames determined in S64 is equal to or greater than the number of deletion frames confirmed in S63 (Yes in S65), the transmitting terminal deletes the deletion target frame determined in S64 and uses the information on the deletion frames as meta information. (S66). Then, the transmission terminal encodes the video data for delivery and distributes the video data (S67).

図9は、作業バッファに格納された動画データのうち、各フレームの音声レベルに基いて送信端末が削除対象レームを判別する動作(S64)のフローの詳細を示す。図9においては、説明のために判別対象映像フレームのフレーム番号をn(以下、フレーム番号がnの映像フレームをnフレームと記す)として説明する。 FIG. 9 shows the details of the flow of the operation (S64) in which the transmitting terminal discriminates the deletion target frame based on the audio level of each frame in the moving image data stored in the work buffer. In FIG. 9, for the sake of explanation, the frame number of the discrimination target video frame is assumed to be n (hereinafter, the video frame having the frame number n is referred to as n frame).

送信端末はフレーム番号がn−1の映像フレーム(n−1フレーム)の音声レベルが所定の閾値以上か否かを判定する(S71)。n−1フレームの音声レベルが所定の閾値未満である場合(S71でNo)、送信端末は、nフレームは削除対象フレームではないと判定する(S74)。そして、送信端末はnの値をインクリメントする(S75)。 The transmitting terminal determines whether or not the audio level of the video frame (n-1 frame) with the frame number n-1 is equal to or greater than a predetermined threshold (S71). When the audio level of the n-1 frame is less than the predetermined threshold (No in S71), the transmitting terminal determines that the n frame is not a deletion target frame (S74). Then, the transmitting terminal increments the value of n (S75).

S71でn−1フレームの音声レベルが所定の閾値以上である場合(S71でYes)、送信端末は、nフレームの音声レベルが所定の閾値以上か否かを判定する(S72)。 When the sound level of the n-1 frame is equal to or higher than the predetermined threshold value in S71 (Yes in S71), the transmitting terminal determines whether or not the sound level of the n frame is equal to or higher than the predetermined threshold value (S72).

nフレームの音声レベルが所定の閾値未満である場合(S72でNo)、送信端末は、nフレームは削除対象のフレームではないと判定する(S74)。そして、送信端末はnの値をインクリメントする(S75)。 When the audio level of n frames is less than the predetermined threshold (No in S72), the transmitting terminal determines that the n frames are not frames to be deleted (S74). Then, the transmitting terminal increments the value of n (S75).

S72でnフレームの音声レベルが所定の閾値以上である場合(S72でYes)、送信端末は、nフレームは削除対象のフレームであると判定する(S73)。そして、送信端末はnの値をインクリメントする(S75)。 If the sound level of the n frame is equal to or greater than the predetermined threshold value in S72 (Yes in S72), the transmitting terminal determines that the n frame is a frame to be deleted (S73). Then, the transmitting terminal increments the value of n (S75).

S75で、nの値をインクリメントした後、送信端末は、すべての作業バッファ内の映像フレームに対して判別処理が行われたか否かを判定する(S76)。作業バッファ内の映像フレームで判別処理が行われていないものがある場合(S76でNo)、処理はS71に戻る。すべての作業バッファ内の映像フレームに対して判別処理が行われた場合(S76でYes)、処理は終了する。 After incrementing the value of n in S75, the transmitting terminal determines whether or not the discrimination process has been performed on the video frames in all the work buffers (S76). If there is a video frame in the work buffer that has not been subjected to the discrimination process (No in S76), the process returns to S71. If discrimination processing has been performed on all the video frames in the work buffer (Yes in S76), the processing ends.

尚、作業バッファは動画データの全ての映像フレームを格納する必要はなく、映像フレームの削除処理を行い、映像フレームレートを配信品質監視で決定された送信用フレームレート以下にすることができる領域があればよい。 Note that the work buffer does not have to store all the video frames of the moving image data, and there is an area in which the video frame can be deleted and the video frame rate can be made equal to or lower than the transmission frame rate determined by the distribution quality monitoring. I just need it.

次に、所定期間の動画データにおいて、削除対象と判定される映像フレームが削除された結果、その所定期間の動画データの映像フレームレートが送信用フレームレートより小さくならない場合の動作について説明する。ここで、送信端末において、送信用フレームレートと一度に比較される動画データの期間を動画データの判別対象期間と記す。 Next, an operation when the video frame determined to be deleted is deleted from the video data for a predetermined period and the video frame rate of the video data for the predetermined period does not become lower than the transmission frame rate will be described. Here, the period of moving image data that is compared with the transmission frame rate at a time in the transmitting terminal is referred to as a moving image data discrimination target period.

上記に述べたように、送信端末は、動画データを所定期間毎に区切って削除対象の判別を行い、この所定期間における動画の映像フレームレートが送信用フレームレートより小さいか否かの判定を行っている。 As described above, the transmission terminal determines the deletion target by dividing the moving image data every predetermined period, and determines whether or not the video frame rate of the moving image in this predetermined period is smaller than the transmission frame rate. ing.

削除対象と判定された映像フレームを削除した結果、その所定期間の動画データの映像フレームレートが送信用フレームレートより小さくならない場合、送信端末は、動画データの判別対象期間を増加させる。本実施形態では、送信端末は、削除対象か否かの判別が同時に行われる映像フレームが格納される作業バッファに格納される動画データの期間を増加させる。送信端末は、作業バッファが格納可能な映像フレームの期間における動画データの映像フレームレートが、配信品質監視によって決定された送信用フレームレート以下となるように映像フレームを削除する。 If the video frame rate of the moving image data in the predetermined period does not become lower than the transmission frame rate as a result of deleting the video frame determined to be deleted, the transmitting terminal increases the determination target period of the moving image data. In the present embodiment, the transmission terminal increases the period of the moving image data stored in the work buffer in which the video frames that are simultaneously determined whether or not to be deleted are stored. The transmission terminal deletes the video frame so that the video frame rate of the moving image data during the period of the video frame that can be stored in the work buffer is equal to or less than the transmission frame rate determined by the distribution quality monitoring.

具体的には、例えば図4の例で、A〜Kの映像フレームのうち、音声レベルが閾値以下の映像フレームが所定の数以上存在しない場合、さらに映像フレームL〜Vを作業バッファにバッファリングし、その中で類似度が閾値以下である映像フレームを削除する。そして、映像フレームA〜Vの期間で映像フレームレートが、配信品質監視で決定された送信用フレームレート以下か否かを確認する。 Specifically, for example, in the example of FIG. 4, when there are no more than a predetermined number of video frames having an audio level equal to or less than a threshold among the video frames A to K, the video frames L to V are further buffered in the work buffer. Among them, the video frame whose similarity is equal to or less than the threshold is deleted. Then, it is confirmed whether or not the video frame rate is equal to or lower than the transmission frame rate determined by the distribution quality monitoring in the period of the video frames A to V.

図10は、受信端末のデコード処理を説明するための図である。デコード処理部は、ファイルデコーダ91、フレーム制御部92、ビデオデコーダ93、ビデオメモリ94、オーディオデコーダ95、オーディオメモリ96を含む。

FIG. 10 is a diagram for explaining the decoding process of the receiving terminal. The decoding processing unit includes a

ファイルデコーダ91は、送信端末より受信したストリーミングデータを映像データと音声データに分離する。そしてファイルデコーダ91は、分離した映像データをビデオデコーダ93に出力し、音声データをオーディオデコーダ95に出力する。また、ファイルデコーダ91は、受信したストリーミングデータよりメタ情報を抽出し、フレーム制御部92に送信する。

The

フレーム制御部92は、ファイルデコーダ91から受信したメタ情報から削除フレームを認識し、削除フレームの情報をビデオデコーダ93に出力する。削除フレームの情報とは、例えば、削除フレーム開始番号41、削除フレーム期間(フレーム数)42を含む。また、フレーム制御部92は、メタ情報を用いて、削除フレームに対応する音声フレームのタイムスタンプを認識し、その音声フレームのタイムスタンプ情報を制御信号としてビデオデコーダ93に出力する。

The

ビデオデコーダ93は、ファイルデコーダ91から映像データを受信し、フレーム制御部92から削除フレーム情報を受信する。ビデオデコーダ93は映像データをデコードする。そして、ビデオデコーダ93は映像データと削除フレーム情報から削除フレームの補完フレームを生成し、映像フレームの再構築を行う。ここで生成した補完フレームのタイムスタンプは、フレーム制御部92から受信した制御信号により、削除フレームと対応する音声フレームのタイムスタンプと同じ値に設定される。これによりリップシンク調整がなされる。そして、ビデオデコーダ93は再構築した映像データをビデオメモリ94に出力する。

The

オーディオデコーダ95は、ファイルデコーダ91から音声データを受信し、デコード処理を行う。そして、音声データをオーディオメモリ96に出力する。

The

ここで、リップシンク調整は、ビデオメモリ94、オーディオメモリ96にデータが格納された時点でなされるのではなく、ビデオデコーダ93において完了する。これにより、受信端末でリップシンク調整のためのメモリ容量を削減することができる。

Here, the lip sync adjustment is not performed when the data is stored in the

次に、受信端末によるフレーム再構築の動作を説明する。図11は、受信端末によるフレーム再構築のフローチャートである。 Next, the operation of frame reconstruction by the receiving terminal will be described. FIG. 11 is a flowchart of frame reconstruction by the receiving terminal.

先ず受信端末のビデオデコーダ93は、削除フレームの補完フレーム生成処理を実行する(S101)。

First, the

ビデオデコーダ93は、メタ情報に含まれる削除フレームに関する情報をフレーム制御部92から受信する。削除フレームに関する情報は、例えば、削除フレーム開始番号41、削除フレームの期間(フレーム数)42を含む。そしてビデオデコーダ93は、削除フレームに関する情報から削除フレーム番号と削除フレームの期間を認識する(S102)。尚、ここで認識するのは削除フレーム番号の代わりに再開始フレーム番号としてもよい。

The

次に、ビデオデコーダ93は、認識した削除フレーム番号または再開始フレーム番号に基いて、生成した補完フレームにフレーム番号を割り当てる(S103)。このフレーム番号の割り当ては、補完フレームを削除されたフレームの位置に挿入する動作といえる。

Next, the

次に、ビデオデコーダ93は、所定の期間のフレームを検出したら(S104)、生成した補完フレームと、S103で割り当てられたフレーム番号に対応する音声フレームのタイムスタンプの値を一致させる(S105)。これにより、リップシンクの調整がなされ、映像と音声の同期がとれる。

Next, when the

そして、ビデオデコーダ93は、リップシンク調整が完了した映像データをビデオメモリ94に出力し、また、音声データをオーディオメモリ96に出力する。そして映像データと音声データがそれぞれビデオメモリ94とオーディオメモリ96に出力されたことが動画の再生アプリケーションに通知される(S106)。このデータを用いて移動端末35は動画を再生する。尚、図11のフローは所定期間のフレーム毎に周期的に実行される。

Then, the

図12は、受信端末における削除フレームに対する補完フレームの生成処理の動作フローチャートである。図12においては、説明のためにメタ情報の削除フレーム開始番号41の値がn+1、削除フレーム期間(フレーム数)42の値がTである場合の例を説明する。また、映像フレームにおいて移動量が大きい対象物が存在する場合、その対象物を示す画素の値を、直前の映像フレームから複製するか直後の映像フレームから複製するかを変更させるために用いられる閾値をxとする。この例では、閾値xはフレームの数を表す整数とするが、これに限定されない。

FIG. 12 is an operation flowchart of a complementary frame generation process for a deleted frame in the receiving terminal. In FIG. 12, an example in which the value of the deletion

受信端末は、メタデータの情報から、送信端末において削除された映像フレームが存在することを確認する(S121)。すなわち、受信端末はメタデータに含まれる削除フレーム開始番号41、削除フレーム期間(フレーム数)42を認識する。

The receiving terminal confirms from the metadata information that there is a video frame deleted at the transmitting terminal (S121). That is, the receiving terminal recognizes the deletion

そして、受信端末は、削除されていないフレームのうち、削除フレーム開始番号41の直前のフレーム番号を有する映像フレーム(nフレーム)をバッファリングする(S122)。

Then, the receiving terminal buffers the video frame (n frame) having the frame number immediately before the deleted

次に、受信端末は、削除されていないフレームのうち、削除フレーム開始番号41の直後のフレーム番号を有するフレーム((n+1+T)フレーム)をバッファリングする(S123)。

Next, the receiving terminal buffers a frame ((n + 1 + T) frame) having a frame number immediately after the deleted

そして、受信端末はnフレームと(n+1+T)フレームを用いて、フレームにおいて移動量の大きい対象物を判別する(S124)。 Then, the receiving terminal uses the n frame and the (n + 1 + T) frame to determine an object having a large movement amount in the frame (S124).

次に、補完処理対象のフレームをn+1フレームに設定する(S125)。そして、受信端末は、補完処理対象フレームのフレーム番号がn+x以上か否かを判定する(S126)。補完処理対象フレームのフレーム番号がn+x未満である場合(S126でNo)、補完処理対象フレームは、nフレームを複製することにより生成される(S127)。 Next, the frame to be complemented is set to n + 1 frame (S125). Then, the receiving terminal determines whether or not the frame number of the complementary processing target frame is n + x or more (S126). When the frame number of the complement processing target frame is less than n + x (No in S126), the complement processing target frame is generated by duplicating n frames (S127).

そして、受信端末は補完処理対象のフレーム番号をインクリメントし(S129)、そのフレーム番号がn+Tより大きいか否かを判定する(S130)。補完処理対象のフレーム番号がn+T以下である場合(S130でNo)、処理はS126に戻る。補完処理対象のフレーム番号がn+Tより大きい場合(S130でYes)、処理は終了する。 The receiving terminal increments the frame number to be complemented (S129), and determines whether the frame number is greater than n + T (S130). When the complement processing target frame number is n + T or less (No in S130), the process returns to S126. If the frame number to be complemented is greater than n + T (Yes in S130), the process ends.

S126において、補完処理対象フレームのフレーム番号がn+x以上である場合(S126でYes)、S124で判定した移動量の大きい対象物を(n+1+T)フレームから複製し、そうでない対象物をnフレームから複製する(S128)。 In S126, when the frame number of the complement processing target frame is n + x or more (Yes in S126), the object with the large amount of movement determined in S124 is duplicated from the (n + 1 + T) frame, and the other object is duplicated from the n frame. (S128).

そして、補完処理対象のフレーム番号をインクリメントし(S129)、そのフレーム番号がn+Tより大きいか否かを判定する(S130)。補完処理対象のフレーム番号がn+T以下である場合(S130でNo)、処理はS126に戻る。補完処理対象のフレーム番号がn+Tより大きい場合(S130でYes)、処理は終了する。 Then, the frame number to be complemented is incremented (S129), and it is determined whether or not the frame number is greater than n + T (S130). When the complement processing target frame number is n + T or less (No in S130), the process returns to S126. If the frame number to be complemented is greater than n + T (Yes in S130), the process ends.

図13A、図13Bは本実施形態にかかる情報処理システムのシーケンス図である。図13は、パソコン33とサーバ31と移動端末35との動作関係を表している。

13A and 13B are sequence diagrams of the information processing system according to the present embodiment. FIG. 13 shows an operational relationship among the

移動端末35はパソコン33に保存された動画データを取得するために、移動端末35とパソコン33とを中継するサーバ31に接続を行う(S401)。接続の確立前に、サーバ31は接続要求のあった移動端末35の正当性を確認するために認証を行う。また、サーバ31は移動端末35の認証と同時に、移動端末35における動画再生時の解像度を認識する(S402)。認証が成功した場合、サーバ31は移動端末35に機器承認応答を行う(S403)。

The

次に、サーバ31は移動端末35から要求のあった動画データが保存されているパソコン33に接続を行う(S404)。パソコン33とサーバ31の接続確立時にも接続の正当性を確認するための認証が行われる。認証が成功した場合、パソコン33は接続応答をサーバ31に送信する(S405)。

Next, the

次に、パソコン33は提供可能な動画の一覧情報を、サーバ31を介して移動端末35に通知する(S406)。提供可能な動画の一覧は、移動端末35毎に、または、サーバ31毎に予め設定して、パソコン33にファイルとして保存されてもよい。また、移動端末35の解像度の情報をサーバ31から受信し、その情報に応じて、パソコン33は、動画データのうち移動端末35が再生することができる動画を判定してもよい。

Next, the

通知された一覧が移動端末35の画面に表示されると、ユーザは、移動端末35を操作して、再生する動画を選択する。移動端末35は、サーバ31に対して、選択された再生動画の配信要求(以下、再生動画要求と記す)を行う(S407)。

When the notified list is displayed on the screen of the

次に、サーバ31は移動端末35とサーバ31間のネットワークの帯域幅を監視するための情報収集作業を行う(S408)。

Next, the

次に、サーバ31は移動端末35から受信した再生動画要求をパソコン33に対して送信する(S409)。パソコン33は再生動画要求を受信すると、再生動画要求で指定のあった動画に関するメタ情報をサーバ31に通知する(S410)。

Next, the

サーバ31はパソコン33からメタ情報を受信すると、サーバ31と移動端末35間の動画送信の配信品質監視を行う(S411)。具体的には、動画の転送で使用する帯域幅が、サーバ31と移動端末35間のネットワークの帯域幅以下となるように、サーバ31は送信する動画データの映像フレームレートを調整するための調整量を決定する。このときサーバ31は、動画データの変更情報を移動端末35が認識できるように、動画データの変更情報を再生情報変更要求として移動端末35に通知する(S412)。

When the

移動端末35はサーバ31から再生情報変更要求を受信すると、配信動画の変更を認識し、再生設定応答をサーバ31に行う(S413)。

When receiving the reproduction information change request from the

次に、サーバ31はストリーミング開始要求をパソコン33に通知する(S414)。パソコン33はサーバ31からストリーミング開始要求を受信すると、サーバ31を介して移動端末35にストリーミング開始応答を行う(S415)。そしてパソコン33はサーバ31に対してストリーミングデータを配信する(S416)。

Next, the

サーバ31はストリーミングデータを受信すると、動画データの音声レベルを認識する(S417)。そして、サーバ31は、認識した音声レベルに基いて、映像フレームレートが配信品質監視により導かれる送信用フレームレートとなるように、削除対象の映像フレームを判別し、選択する。ここで、サーバ31は、動画データの解像度をS402で認識した解像度に変更してもよい。そして、サーバ31は、選択した削除対象フレームを動画データから削除する(S418)。

When receiving the streaming data, the

次に、サーバ31は削除した映像フレームの情報をメタ情報に追記する(S419)。そして、サーバ31は、削除処理を行った動画データを送付用の形式にエンコードして(S420)、エンコードしたデータを移動端末35にストリーミング配信する(S421)。

Next, the

移動端末35はストリーミングデータを受信すると、受信したデータをデコードする(S422)。そして、移動端末35は、S418で削除された映像フレームに対応する補完フレームを生成し動画データに挿入することにより、動画データを復元する(S423)。そして、移動端末35は、復元した動画データを再生する(S424)。

When receiving the streaming data, the

そして、所定のデータ量ごとにS408〜S424の動作が繰り返され、パソコン33による動画データのストリーミング配信と移動端末35による再生が行われる。尚、この所定データ量ごとのS408〜S424の動作は、データ量ごとに平行して行われてもよい。

Then, the operations of S408 to S424 are repeated for each predetermined amount of data, and streaming distribution of moving image data by the

次に、移動端末35とサーバ31、サーバ31とパソコン33の間の接続動作(S401、S404)について詳細に説明する。

Next, the connection operation (S401, S404) between the

移動端末35には、動画を再生するためのアプリケーションプログラム(以下、アプリケーションと称する)がインストールされており、アプリケーションにより目的とするサーバ31に接続する。目的とするサーバ31の指定はユーザが選択できる構成としてもよいし、予めアプリケーションに設定されている構成としてもよい。移動端末35は例えば3G(3rd Generation)回線のように接続するときにその回線を指定してインターネットに接続することができる。また、移動端末35とパソコン33はインターネットを経由してのP2P(Peer to Peer)接続を可能とする。

An application program (hereinafter referred to as an application) for reproducing a moving image is installed in the

サーバ31と移動端末35間、サーバ31とパソコン33間の接続確立時には認証が行われるが、そこで用いられる認証情報は、例えば、各機器の、IPアドレス、MACアドレスなどの固有機器情報などである。認証情報はサーバ31上で管理され、IPアドレスや固有機器情報を、移動端末35と移動端末35が接続可能なパソコン33とを対応付けて、移動端末35毎にグループ化して格納される。尚、1つの移動端末35に対して1つのパソコン33を対応付けてもよいし、複数と対応付けてもよい。

Authentication is performed when a connection is established between the

移動端末35とサーバ31の接続確立時の動作について説明する。サーバ31は、移動端末35から接続要求を受信すると、接続要求のあった移動端末35のIPアドレスまたは固有機器情報と、サーバ31に保存されているIPアドレスまたは固有機器情報と、を照合する。照合の結果が一致すれば、サーバ31は認証が成功したとして接続を確立する。尚、認証には種々の認証技術が用いられてもよく、パスワード認証方式や電子証明書認証方式等を用いてもよい。

An operation when establishing a connection between the

次に、サーバ31とパソコン33の接続確立時の動作について説明する。サーバ31は移動端末35との接続を確立した後、その移動端末35に対応するパソコン33に接続を行う。具体的には、サーバ31に保存されている認証情報において1つの移動端末35に対して1つのパソコン33が対応付けられている場合、サーバ31は認証情報を確認して移動端末35に対応するパソコン33に接続を行う。もしくは、移動端末35がサーバ31との接続を確立する際に、移動端末35が接続先のパソコン33を指定し、サーバ31は指定されたパソコン33に接続する構成にしてもよい。

Next, an operation when establishing a connection between the

サーバ31からの接続要求を受けたパソコン33は、アクセス要求のあったサーバ31が正当なものか否かの認証を行う。認証にはサーバ31が移動端末35に対して行う認証と同様、種々の認証技術が用いられる。または、パソコン33が保有する動画ファイルやパソコン33のディレクトリ(フォルダ)にアクセス権限を付与してアクセス制御を行ってもよい。

The

尚、パソコン33とサーバ31、サーバ31と移動端末35間は、VPN(Virtual Private Network)等の高セキュリティのネットワーク技術を用いて接続されてもよい。さらに、パソコン33とサーバ31、サーバ31と移動端末35間のデータ伝送において、伝送されるデータは種々の暗号化技術により暗号化されてもよい。また、サーバ31とパソコン33は同一イントラネット内に配置されてもよい。

The

次に、サーバ31によるネットワークの帯域幅を監視するための情報収集作業(S408)について詳細に説明する。

Next, the information collection work (S408) for monitoring the network bandwidth by the

サーバ31は、移動端末35とサーバ31間の帯域幅を監視する。サーバ31は移動端末35に接続されるネットワークの帯域幅を検出するために、移動端末35に対して帯域検出用のパケットを送信する。送信パケットにはサーバ31が送信した時刻が記録されている。移動端末35はパケットを受信した際に受信時刻を計測し、これをパケットに記録された送信時刻と比較する。それにより移動端末35は一定量のパケットがサーバ31から移動端末35まで到達するまでにかかる時間を算出することができる。移動端末35はここで得られた帯域監視情報をサーバ31に転送する。尚、サーバ31は、一定量のデータを複数のパケットに分割して、最初のパケットをサーバ31が送信してから最後のパケットを移動端末35が受信するのに要した時間を計測することにより、帯域監視情報を取得してもよい。

The

尚、帯域の監視のためのパケットの送信は、実動画データの再生に問題がない範囲において行う。ここで、帯域の監視は帯域を監視するためのコマンドを送付することにより行ってもよいし、ping等のコマンドを送付し、その応答時間を計測することによって行ってもよい。また、パソコン33がサーバ31を介して移動端末35にパケットを送付することで、一度にパソコン33とサーバ31間とサーバ31と移動端末35間の帯域幅の監視を行ってもよい。尚、帯域幅の監視のみではなく、伝送遅延から回線のトラフィックの監視を行ってもよい。

Note that transmission of packets for bandwidth monitoring is performed within a range where there is no problem in reproduction of actual moving image data. Here, the bandwidth may be monitored by sending a command for monitoring the bandwidth, or by sending a command such as ping and measuring the response time. Alternatively, the bandwidth between the

一方、インターネット接続する回線は種類毎に1秒間にデータの送信(または受信)を安定的に可能とする情報量が規定されている。サーバ31はこの規定の情報量と帯域監視情報とによって、単位時間当たりに安定的に送受信可能なデータ量(使用量)を判定する。

On the other hand, the amount of information that enables stable transmission (or reception) of data per second for each type of line connected to the Internet is defined. The

ここで、サーバ31は、帯域監視動作後(S408後)、監視の結果を移動端末35に送信し、ユーザが移動端末35により帯域監視の結果を確認して再生する動画の解像度を指定してもよい。その場合、指定した解像度情報は配信品質監視において用いられる。

Here, after the bandwidth monitoring operation (after S408), the

図14は、本実施形態におけるサーバ31の構成の一例を示す。サーバ31は、デコード処理部131、演算処理部132、ストレージ133、コンテンツサーバ134、ストリーミングサーバ135を含む。

FIG. 14 shows an example of the configuration of the

デコード処理部131は、パソコン33等の端末機器からアップロードされる動画データをデコードする。ここで、アップロードされる動画データは送付用の形式に分割または統合され、もしくは圧縮されているため、デコード処理を行い、動画データを修復する。

The decode processing unit 131 decodes moving image data uploaded from a terminal device such as the

演算処理部132は、帯域幅の監視及び配信品質管理を行い、その結果に応じて動画データの映像フレームの削除処理及びメタ情報の変更処理を行う。

The

ストレージ133にはオペレーティングシステム、ミドルウェア、アプリケーションが格納されており、演算処理部132によりメモリに読み出され、実行される。

The

コンテンツサーバ134は、ストリーミング再生を行うために準備されているコンテンツが管理されており、移動端末35はここで管理されているコンテンツから再生する動画を選択できる。

The

ストリーミングサーバ135は、動画データを移動端末35に配信する。動画データは演算処理部132から映像フレームが削除された動画データを受信する。また、ストリーミングサーバ135は、配信で使用する、例えばHTTP(HyperText Transfer Protocol)、HTTP/RTMPなどのプロトコルに応じて分けられる。

The streaming

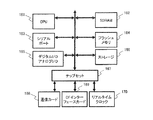

図15は、本実施形態に係るサーバ31またはパソコン33のハードウェア構成の一例を示す。サーバ31またはパソコン33は、CPU(Central Processing Unit)161、SDRAM(Synchronous Dynamic Random Access Memory)162、シリアルポート163、フラッシュメモリ164、デジタルI/O、アナログI/O165を含む。また、サーバ31またはパソコン33はストレージ166、チップセット167、通信カード168、CF(Compact Flash(登録商標))インターフェースカード169、リアルタイムクロック170を含む。

FIG. 15 shows an example of the hardware configuration of the

CPU161は、ストレージ166に保存された上述のフロー図の手順を記述したプログラムを、SDRAM162またはフラッシュメモリ164を利用して実行する。また、CPU161は、チップセット167を介して、通信カード168、CFインターフェースカード169、リアルタイムクロック170とデータのやり取りを行う。サーバ31またはパソコン33は、通信カードを介して、シリアルポート163またはデジタルI/O、アナログI/O165から動画データの入出力を行う。CPU161は、監視部3、削除部4、フレーム情報生成部5、送信部6、受信部8、補完画像生成部9、映像データ生成部10の一部または全部の機能を提供する。また、CPU161は動画データのエンコード、デコード、リップシンク、接続確立のための認証動作、動画データの再生を行う。ストレージ166は、記憶部2の一部または全部の機能を提供する。CPU161は、動画データのフレーム削除処理及び動画データの復元処理を行うための一時データ保存領域(作業バッファ)としてSDRAM162を利用できる。尚、SDRAM162はこれに限定されず種々のRAM(Random Access Memory)とすることができる。

The

フラッシュメモリ164にはカーネル、サーバ31におけるアプリケーション、設定ファイル等が保存される。フラッシュメモリには拡張領域があり、動画データのフレーム削除処理、動画データの復元処理を行うための一時データ保存領域(作業バッファ)としても利用できる。

The flash memory 164 stores a kernel, an application in the

CFインターフェースカード169はサーバ31の保守等に使うための補助機能として使用される。ストレージが内蔵されているため、多くのパソコン33と移動端末35間のデータ処理にはこれが使用される。

The CF interface card 169 is used as an auxiliary function for use in maintenance of the

リアルタイムクロック170は、コンピュータの時計としての機能をもつ専用のチップである。フレームのタイムスタンプはリアルタイムクロック170の時計に従って設定される。

The real-

実施形態の第1の情報処理装置1及び第2の情報処理装置7の一部は、ハードウェアで実現してもよい。或いは、実施形態の第1の情報処理装置1及び第2の情報処理装置7は、ソフトウェアおよびハードウェアの組み合わせで実現してもよい。 A part of the first information processing apparatus 1 and the second information processing apparatus 7 of the embodiment may be realized by hardware. Alternatively, the first information processing device 1 and the second information processing device 7 of the embodiment may be realized by a combination of software and hardware.

図16は、本実施形態に係る移動端末35のハードウェア構成の一例を示す。移動端末35は、図16に示すように、CPU201、メモリ202、記憶部203、読取部204、通信インターフェース206、入出力部207、表示部208を含む。なお、CPU201、メモリ202、記憶部203、読取部204、通信インターフェース206、入出力部207、表示部208は、例えば、バス209を介して互いに接続されている。

FIG. 16 shows an example of the hardware configuration of the

CPU201は、メモリ202を利用して上述のフローチャートの手順を記述したプログラムを実行する。CPU201は、受信部8、補完画像生成部9、映像データ生成部10の一部または全部の機能を提供する。また、CPU201は動画データのデコード、リップシンク、動画データの再生を行う。メモリ202は、例えば半導体メモリであり、RAM領域およびROM領域を含んで構成される。記憶部203は、例えばハードディスクである。なお、記憶部203は、フラッシュメモリ等の半導体メモリであってもよい。動画データを再生するためのアプリケーションは、メモリ202または記憶部203に格納され、CPU201によって実行される。移動端末35は記憶部203を有さない構成とすることも可能である。

The

読取部204は、CPU201の指示に従って着脱可能記録媒体205にアクセスする。着脱可能記録媒体205は、たとえば、半導体デバイス(USBメモリ等)、磁気的作用により情報が入出力される媒体(磁気ディスク等)、光学的作用により情報が入出力される媒体(CD−ROM、DVD等)などにより実現される。

The

通信インターフェース206は、CPU201の指示に従ってネットワークを介してデータを送受信する。また、通信インターフェース206は、動画データを受信する。入出力部207は、例えば、ユーザからの指示を受け付けるデバイスに相当する。ユーザは入出力部207を使用して、再生する動画データの指定や動画データの解像度の指定が可能である。表示部208は、再生した動画データの表示を行う。

The

実施形態を実現するための情報処理プログラムは、例えば、下記の形態で移動端末35に提供される。

(1)記憶部203に予めインストールされている。

(2)着脱可能記録媒体205により提供される。

(3)ネットワークを介して提供される。An information processing program for realizing the embodiment is provided to the

(1) Installed in advance in the

(2) Provided by the removable recording medium 205.

(3) Provided via a network.

(変形例)

図17は、本実施形態(変形例)における情報処理システムの構成の一例を示す。本変形例と実施形態との違いは受信端末が例えばパソコン33のような端末機器37の形態であることである。同じパソコン33間であってもインターネットの帯域幅によっては画質劣化が確認される場合があるため、このような場合は実施形態に記した構成が適用されることになる。また、変形例は、フレームの削除処理をパソコン33が行う場合の例である。(Modification)

FIG. 17 shows an example of the configuration of the information processing system in the present embodiment (modification). The difference between this modification and the embodiment is that the receiving terminal is in the form of a

本実施形態におけるサーバ31で行った、ネットワークの帯域監視、配信品質監視、フレームの削除処理とそれに相当する処理は、パソコン33が行ってもよい。また、ネットワークの帯域監視、配信品質監視は、サーバ31とパソコン33の間においても行われてもよい。また、本実施形態では、動画データはパソコン33に格納される構成としたが、動画データはサーバ31に格納され、サーバ31から移動端末35に提供されてもよい。また、移動端末35は、シンクライアント端末でもよい。また、本実施形態におけるデコードはMPEG2等の規格に則って行われてもよい。

The

また、本実施形態では、サーバ31からストリーミング形式で移動端末35に動画が配信されるとしたが、配信方法はストリーミング形式に限定されない。

In the present embodiment, the moving image is distributed from the

尚、本実施形態は、以上に述べた実施の形態に限定されるものではなく、本実施形態の要旨を逸脱しない範囲内で種々の構成または実施形態を取ることができる。 In addition, this embodiment is not limited to embodiment described above, A various structure or embodiment can be taken in the range which does not deviate from the summary of this embodiment.

1 第1の情報処理装置

2 記憶部

3 監視部

4 削除部

5 フレーム情報生成部

6 送信部

7 第2の情報処理装置

8 受信部

9 補完画像生成部

10 映像データ生成部

11 通信ネットワークDESCRIPTION OF SYMBOLS 1 1st

Claims (8)

通信ネットワークの状態を監視する監視部と、

前記監視の結果に応じて、前記第1の映像データの単位時間当たりの第1のフレーム数を示す第1のフレームレートから、前記第1の映像データのうち、連続する映像フレーム間で類似度が所定の閾値以上であり、対応する前記音声データの音声レベルが所定の閾値以下である該連続する映像フレームのいずれかを削除して、前記第1のフレームレートより低い第2のフレームレートにした第2の映像データを生成する削除部と、

前記削除されたフレームに関するフレーム情報を生成するフレーム情報生成部と、

前記第2の映像データ及び前記フレーム情報を送信する送信部と、

を備える情報処理装置。 A storage unit for storing first video data and audio data including synchronization information associated with the first video data;

A monitoring unit for monitoring the state of the communication network;

In accordance with the result of the monitoring , the similarity between consecutive video frames in the first video data is determined from a first frame rate indicating the first number of frames per unit time of the first video data. Is equal to or higher than a predetermined threshold, and the corresponding audio data has an audio level equal to or lower than a predetermined threshold, and any one of the continuous video frames is deleted to a second frame rate lower than the first frame rate. A deletion unit for generating the second video data,

A frame information generation unit that generates frame information about the deleted frame;

A transmission unit for transmitting the second video data and the frame information;

An information processing apparatus comprising:

請求項1に記載の情報処理装置。 The information processing apparatus according to claim 1, wherein the transmission unit further transmits the audio data.

前記フレーム情報を用いて前記削除されたフレームの画像を補完する補完画像を生成する補完画像生成部と、

前記補完画像と、前記第2の映像データと、前記同期情報とを用いて、前記第1のフレームレートの映像データであって、前記削除されたフレームに対応する前記補完画像と、前記削除されたフレームに対応する前記音声データとを同期させた該映像データを生成する映像データ生成部と、

を備える情報処理装置。 From the first frame rate indicating the first number of frames per unit time of the first video data , the similarity between consecutive video frames of the first video data is greater than or equal to a predetermined threshold, and and second image data one of the video frame that is being removed, the lower than the first frame rate second frame rate for audio level of the audio data is the continuous is below a predetermined threshold for the A receiving unit that receives frame information related to the deleted frame and audio data including synchronization information associated with the first video data ;

A complementary image generation unit that generates a complementary image that complements the image of the deleted frame using the frame information;

Using the complementary image, the second video data, and the synchronization information, the video data of the first frame rate, the complementary image corresponding to the deleted frame, and the deleted image A video data generation unit that generates the video data synchronized with the audio data corresponding to the frame ;

An information processing apparatus comprising:

請求項3に記載の情報処理装置。 The video data generation unit inserts the complementary image at the position of the deleted frame of the second video data using the frame information, and generates video data of the first frame rate. 3. The information processing apparatus according to 3 .

請求項3または4に記載の情報処理装置。 The information processing apparatus according to claim 3, wherein the complementary image generation unit generates the complementary image by duplicating a frame immediately before the deleted frame.

通信ネットワークの状態を監視し、

前記監視の結果に応じて、第1の映像データの単位時間当たりの第1のフレーム数を示す第1のフレームレートから、前記第1の映像データのうち、連続する映像フレーム間で類似度が所定の閾値以上であり、対応する音声データの音声レベルが所定の閾値以下である該連続する映像フレームのいずれかを削除して、前記第1のフレームレートより低い第2のフレームレートにした第2の映像データを生成し、

前記削除されたフレームに関するフレーム情報を生成し、

前記第2の映像データ及び前記フレーム情報と、前記第1の映像データと対応付けた同期情報を含む音声データとを送信する

処理を実行し、

第2の情報処理装置は、

前記送信された、前記第2の映像データ及び前記フレーム情報と、前記同期情報を含む音声データとを受信し、

前記フレーム情報を用いて前記削除されたフレームの画像を補完する補完画像を生成し、

前記補完画像と、前記第2の映像データと、前記同期情報とを用いて、前記第1のフレームレートの映像データであって、前記削除されたフレームに対応する前記補完画像と、前記削除されたフレームに対応する前記音声データとを同期させた該映像データを生成する

処理を実行する映像データ送受信方法。 The first information processing apparatus

Monitor the status of the communication network