JP5424992B2 - 計算機システム、及びシステム制御方法 - Google Patents

計算機システム、及びシステム制御方法 Download PDFInfo

- Publication number

- JP5424992B2 JP5424992B2 JP2010138464A JP2010138464A JP5424992B2 JP 5424992 B2 JP5424992 B2 JP 5424992B2 JP 2010138464 A JP2010138464 A JP 2010138464A JP 2010138464 A JP2010138464 A JP 2010138464A JP 5424992 B2 JP5424992 B2 JP 5424992B2

- Authority

- JP

- Japan

- Prior art keywords

- data

- storage area

- computer

- replication

- replica

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F11/00—Error detection; Error correction; Monitoring

- G06F11/07—Responding to the occurrence of a fault, e.g. fault tolerance

- G06F11/14—Error detection or correction of the data by redundancy in operation

- G06F11/1402—Saving, restoring, recovering or retrying

- G06F11/1446—Point-in-time backing up or restoration of persistent data

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F11/00—Error detection; Error correction; Monitoring

- G06F11/07—Responding to the occurrence of a fault, e.g. fault tolerance

- G06F11/16—Error detection or correction of the data by redundancy in hardware

- G06F11/20—Error detection or correction of the data by redundancy in hardware using active fault-masking, e.g. by switching out faulty elements or by switching in spare elements

- G06F11/2053—Error detection or correction of the data by redundancy in hardware using active fault-masking, e.g. by switching out faulty elements or by switching in spare elements where persistent mass storage functionality or persistent mass storage control functionality is redundant

- G06F11/2056—Error detection or correction of the data by redundancy in hardware using active fault-masking, e.g. by switching out faulty elements or by switching in spare elements where persistent mass storage functionality or persistent mass storage control functionality is redundant by mirroring

Landscapes

- Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- Quality & Reliability (AREA)

- Physics & Mathematics (AREA)

- General Engineering & Computer Science (AREA)

- General Physics & Mathematics (AREA)

- Information Retrieval, Db Structures And Fs Structures Therefor (AREA)

Description

<システムの全体構成>

図1は、本発明の第1実施形態に係る計算機システム1の概略構成を示すブロック図である。図1に示すように本実施形態の計算機システム1は、ストレージシステム10、スイッチ装置20、ホスト計算機(業務サーバ)30、ホスト計算機(待機サーバ)40、及び管理計算機50を有している。

図2は、本発明の実施形態に係るストレージシステム10の内部構成を示す図である。ストレージシステム10は、ストレージシステム10の全体を制御するストレージコントローラ11と、データを格納するストレージ装置12と、を有する。ストレージコントローラ11とストレージ装置12は、ストレージI/F112を介して接続される。

図3は、本発明の実施形態に係るホスト計算機(業務サーバ)30の内部構成を示す図である。ホスト計算機(業務サーバ)30は、キーボードやマウスなどの入力装置300と、CRT(Cathode Ray Tube)やLCD(Liquid Crystal Display)などの表示装置301と、CPU302と、データI/F(A)303と、メモリ304と、記憶領域307と、データI/F(B)308と、管理I/F309と、を有している。

図4は、本発明の実施形態に係るホスト計算機(待機サーバ)40の内部構成を示す図である。ホスト計算機(待機サーバ)40は、ホスト計算機(業務サーバ)30の構成と同様の構成を有しているが、ホストベースレプリケーションエンジン306がホストベースに限定されず、待機サーバ40内にレプリケーションを実行することができる(後述の2次レプリカボリュームを作成できる)レプリケーションエンジン406を有している点が業務サーバ30とは異なっている。

図5は、本発明の実施形態に係る管理計算機50の内部構成を示す図である。管理計算機50は、キーボードやマウスなどの入力装置500と、CRTなどの表示装置501と、CPU502と、管理I/F503と、メモリ504と、を有している。

図6は、本発明の実施形態による構成情報テーブル507の例を示す図である。構成情報テーブル507は、ホスト計算機30及び40とストレージシステム10の構成情報を格納するためのテーブルである。構成情報テーブル507は、管理計算機50で実行されるレプリケーション管理プログラム506によって参照される。

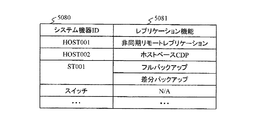

図7は、本発明の実施形態によるレプリケーション情報テーブル508の例を示す図である。レプリケーション情報テーブル508は、計算機システム1の機器上のレプリケーション機能の情報を格納するためのテーブルである。レプリケーション情報テーブル508は、管理計算機50で実行されるレプリケーション管理プログラム506によって参照される。

図8は、本発明の実施形態によるアレイベースレプリケーション管理テーブル509の例を示す図である。アレイベースレプリケーション管理テーブル509は、アレイベースレプリケーションエンジンを用いたバックアップを管理するためのテーブルであり、アレイベースのバックアップ(レプリケーション)動作のスケジュールを管理するものである。アレイベースレプリケーション管理テーブル509は、管理計算機50で実行されるレプリケーション管理プログラム506によって参照される。

図9は、本発明の実施形態によるホストベースレプリケーション管理テーブル510の例を示す図である。ホストベースレプリケーション管理テーブル510は、ホストベースレプリケーションエンジンを用いたレプリケーションを管理するためのテーブルである。ホストベースレプリケーション管理テーブル510は、管理計算機50で実行されるレプリケーション管理プログラム506によって参照される。

図10は、本発明の実施形態によるアレイベースレプリケーションカタログテーブル511の例を示す図である。アレイベースレプリケーションカタログテーブル511は、アレイベースレプリケーション管理テーブル509(図8参照)に従って実行したアレイベースレプリケーション処理の結果を管理するテーブルである。アレイベースレプリケーションカタログテーブル511は、管理計算機50で実行されるレプリケーション管理プログラム506によって参照される。

図11は、2次レプリカカタログテーブル512の例を示す図である。2次レプリカカタログテーブル512は、管理計算機50で実行されるレプリケーション管理プログラム506によって参照される。

図12は、本実施形態による、ホストベースレプリケーションとアレイベースレプリケーションが共有する環境におけるデータ処理の流れを説明するための図である。本実施形態では、ストレージシステム10上のアレイベースレプリケーションエンジンを用いてバックアップを、ホストベースレプリケーションを用いてディザスタリカバリ用にレプリケーションを行う。

まず、計算機システム1を運用するために必要な環境を設定する環境設定処理について説明する。

レプリケーション管理プログラム506は、ホスト計算機30とストレージシステム10から、構成情報(図6参照)と各機器に存在するレプリケーション機能(図7参照)の情報を取得する。ストレージシステム10から取得した構成情報には、ストレージシステム10を識別するストレージIDと、このストレージに格納されているボリュームを識別するボリュームIDの情報が含まれる。ホスト計算機30から取得した構成情報は、ホスト計算機を識別するホストIDと、このホスト計算機上で起動しているアプリケーション305を識別するアプリケーションIDと、このアプリケーション305のデータが格納されているボリュームを識別するボリュームIDと、このボリュームが属するストレージシステム10を識別するストレージIDの情報と、使用状況の情報と、を含んでいる。これらの情報が、構成情報テーブル507(図6)における、ホストIDと、アプリケーションIDと、ストレージIDと、ボリュームIDとに格納される。

レプリケーション管理プログラム506は、レプリケーションの設定情報を取得する。これは、レプリケーション管理プログラム506が、レプリケーション設定画面を表示し、管理者からの指示により処理を開始する。但し、画面は、GUI(Graphical User Interface)などのグラフィックな画面操作であってもよいし、CLI(Command Line Interface)などのコマンドによる入力であってもよい。また、管理者によって作られたプロパティファイルを参照してもよいし、レプリケーション管理プログラム506が自動で生成してもよい。設定方法については限定しない。また、この情報は、ホストベースレプリケーションエンジン306やアレイベースレプリケーションエンジン116が、あらかじめ保持している情報であって、その情報をレプリケーション管理プログラム506が、各エンジンから情報を取得してもよい。

レプリケーション管理プログラム506は、アレイベースレプリケーションと、ホストベースレプリケーションが共有しているボリュームを特定する。具体的には、レプリケーション管理プログラム506は、アレイベースレプリケーション管理テーブル509に登録されているデータVOLID5094と、ホストベースレプリケーション管理テーブル510に登録されているデータVOLID5103とを照合し、同じボリュームが存在するか検索することにより、両レプリケーション処理が実行されているボリュームを特定する。例えば、本実施形態の場合、図8のデータVOLID5094と、図9のデータVOLID5103を検索する。すると、アレイベースレプリケーションとホストベースレプリケーションが共有しているボリュームは、データVOLIDがVOL001のボリュームであることが分かる。

レプリケーション管理プログラム506は、ホストベースレプリケーションのレプリケーション先である待機サーバにおける2次レプリカデータの保存方法を決定する。例えば、図7を参照すると、ホストベースレプリケーションのレプリケーション先であるHOST002に存在するレプリケーション機能はホストベースCDPである。よってホストベースCDPを使用する。

本ステップ終了後、環境設定処理は終了する。

次に、アレイベースレプリケーションによるバックアップと、ホストベースレプリケーションによるデータ転送の方法について説明する。図14は、本実施形態における、アレイベースレプリケーション及びホストベースレプリケーションの運用を説明するためのフローチャートである。

レプリケーション管理プログラム506は、ホストベースレプリケーションエンジン306を用いて、アプリケーション305からのWriteデータをキャプチャして、ホスト計算機(待機サーバ)40側へ転送する。具体的には、ホストベースレプリケーション管理テーブル510を参照して、ホストベースレプリケーションエンジン306が、アプリケーション305からのWriteデータをキャプチャし、ホスト計算機(待機サーバ:ターゲットホスト)40のレプリカVOLID先のボリュームにデータを格納する。

レプリケーション管理プログラム506は、レプリケーションエンジン406を用いて、ホスト計算機(待機サーバ)40内に(或いは、待機サーバ40の外部に設けられた記憶領域内に)、2次レプリカデータとしてデータを複製する。レプリケーション管理プログラム506は、レプリカデータを複製して2次レプリカデータを作成する度に、必要な情報を2次レプリカカタログテーブル512に追加する。

レプリケーション管理プログラム506は、ストレージシステム10におけるバックアップ開始時刻を確認し、バックアップ開始時刻になるまでは、S2001とステップS2002の処理を繰り返す。バックアップ開始時刻になったときに、処理はステップS2004へ進む。

レプリケーション管理プログラム506は、バックアップスケジュールの時刻になったときにはアプリケーションを静止化(フリーズ:アプリケーションを動作させたままでI/O処理を止める)する。具体的には、レプリケーション管理プログラム506は、アレイベースレプリケーション管理テーブル509のバックアップスケジュールを参照し、その時刻になったら、アプリケーションを静止化(フリーズ)する。

レプリケーション管理プログラム506は、アレイベースレプリケーションを用いてバックアップを開始する。まず、レプリケーション管理プログラム506は、管理者がS1002で設定したバックアップの取得方法によってバックアップを取得する。例えば、本実施形態では、図8のアレイベースレプリケーション管理テーブル509におけるレプリケーションIDAPR001を参照すると、VOL001のデータをVOL003へフルバックアップを行うことが分かる。そして、VOL001に格納されているデータをVOL003へ格納する。環境によって、このコピーの方法は異なるため、バックアップ方法はこれに限定されるものではない。バックアップが終了したら、必要な情報がアレイベースレプリケーションカタログテーブル511(図10)に追加される。つまり、レプリケーションIDがARP001なので、カラム5112にはARPC001が追加される。

レプリケーション管理プログラム506は、ホストベースレプリケーションエンジン306を用いて、バックアップフラグをホスト計算機(待機サーバ)40側に転送する。これにより、このフラグが転送されるまでのデータと今バックアップしているデータとの整合性を取ることが可能となる。また、レプリケーション管理プログラム506は、2次レプリカカタログテーブル512(図11参照)のバックアップフラグ5125のカラムにこのバックアップ(ストレージシステムでのバックアップ)の時刻を付与する。バックアップフラグが転送される前までのレプリケーションカタログIDがHRPC001及びHRP002は「2010/04/20 23:00:00」のバックアップデータと同じである。フラグが転送された後は、書き込まれたデータであるHRPC003は次のバックアップで使われた時刻となる。

リストア処理とは、正ボリューム(データボリューム)と副ボリューム(レプリカボリューム)があった場合、正ボリューム内のデータが壊れたときに、副ボリュームを用いて正ボリュームをある時点(副ボリュームにレプリカを生成した時点)のデータに戻す処理をいい、正ボリュームが壊れたときに、違うボリューム(例えば、待機サーバ40のレプリカボリューム)を用いてアプリケーションの運用を再開する業務引継ぎ処理(後述する)とは異なるものである。

レプリケーション管理プログラム506は、アレイベースレプリケーションのリストア指示を受け取る。具体的には、例えば、管理者がリストアしたいアプリケーションを選択して、レプリケーション管理プログラム506に対してリストアの指示を出す。そして、レプリケーション管理プログラム506は、アレイベースレプリケーションカタログテーブル511から、リストア可能な時刻を管理者に提示する。例えば、管理者がアプリケーションID=AP001のデータボリュームのリストアを指示したとすると、レプリケーション管理プログラム506は、アレイベースレプリケーション管理テーブル509のアプリケーションID=AP001に基づいて、対応するレプリケーションIDを検索し、それがARP001であると特定する。そして、レプリケーション管理プログラム506は、アレイベースレプリケーションカタログテーブル511において、レプリケーションID=ARP001に対応するレプリケーションカタログIDがARPC001とARPC003であると認識する。そこで、レプリケーション管理プログラム506は、リストア可能な時刻として「2010/04/20 23:00:00」と「2010/04/21 23:00:00」を管理者に提示する。

続いて、レプリケーション管理プログラム506は、リストアするボリュームを特定する。具体的には、レプリケーション管理プログラム506は、ステップS3001で受け取ったリストアしたいアプリケーションとその時刻の情報から、リストアするボリュームを特定する。例えば、管理者がアプリケーションID=AP001の「2010/04/20 23:00:00」の時点のデータを指定した場合、アレイベースレプリケーションカタログテーブル511のバックアップVOLIDからバックアップデータが格納されているボリュームがVOL003であると特定できる。

そして、レプリケーション管理プログラム506は、該当するアプリケーションを停止する。なお、ステップS3002とS3003の処理はどちらを先に実行してもよい。つまり、S3003を先に処理してもよい。

レプリケーション管理プログラム506は、ホストベースレプリケーションエンジン306を用いて、未転送データをホスト計算機(待機サーバ)40に転送する。この処理は、ホストベースレプリケーションエンジン306が転送せずにホスト計算機(業務サーバ)30内に溜めていたデータを吐き出す処理である。この処理を行うことで、アプリケーション305を停止した時点のデータVOLと、レプリカVOLのデータを一致させることができる。より具体的には、レプリケーション管理プログラム506は、ホストベースレプリケーション管理テーブル510のアプリケーションIDより、管理者が指定したアプリケーションを検索し、ターゲットホストIDとレプリカVOLIDを特定し、特定したボリュームに対してデータを転送する。

レプリケーション管理プログラム506は、アレイベースレプリケーションエンジン116を用いて、リストア処理を実行する。具体的には、S3002で特定したボリューム(例えば、VOL003)をデータボリュームにコピーする。

レプリケーション管理プログラム506は、レプリカボリュームに2次レプリカボリュームのデータを適用して、レプリカボリュームの内容をS3005でリストアされたデータボリュームと同じデータにする。より具体的には、レプリケーション管理プログラム506は、ホスト計算機(待機サーバ)40上のレプリカボリュームが指定時刻に作成されたバックアップデータ(副ボリューム)と同一内容となるように、2次レプリカボリュームのデータをレプリカボリュームに適用する。

レプリケーション管理プログラム506は、ステップS3003で停止したアプリケーションを再開する。これは、S3005とS3006の処理が完了し、データボリュームとレプリカボリュームのデータが一致した状態となっているためである。このように、ストレージシステム10におけるデータボリュームとホスト計算機(待機サーバ)40におけるレプリカボリュームのデータ内容が一致させることができるので、アプリケーションのWriteデータが発生して、ホストベースレプリケーション306によってデータがホスト計算機(待機サーバ)40に転送されてもレプリカボリュームのデータが破壊されることはない。

アプリケーションの再開後、リストア処理は終了する。

次に、本実施形態に係るホストベースレプリケーションにてレプリケーションしたデータを用いた業務引継ぎの処理について説明する。図16は、本実施形態による業務引継ぎ処理を説明するためのフローチャートである。図16において、ステップS4001からステップS4004の処理は、本実施形態による管理計算機50のメモリ504上のレプリケーション管理プログラム506によって実現される処理である。

レプリケーション管理プログラム506は、ホスト計算機(待機サーバ)40における業務引継ぎの指示を受け取る。具体的には、管理者がレプリケーション管理プログラム506に対して、業務を引継ぐホスト計算機とそのアプリケーションを選択して、ホスト計算機(待機サーバ)40に対して業務引継ぎの指示を出す。つまり、管理者は、例えばホスト計算機(業務サーバ)30が壊れたとき、この業務を継続して行うために、業務を引継ぐホスト計算機を選択し、そのホストに属しているアプリケーションを表示し、その中で継続して業務を引継ぐアプリケーションを選択・特定する。

レプリケーション管理プログラム506は、業務を引継ぐボリュームを特定する。具体的には、S4001で受け取った業務を引継ぐホストとアプリケーションから、業務を引継ぐボリュームを特定する。管理者がホストベースレプリケーション管理テーブル510のアプリケーションID5101から、ターゲットホストID5104とレプリカVOLID5105を特定できる。例えば、業務を引継ぎたいHOST001上のAP0011のデータは、HOST002上のVOL011に格納されていることが分かる。

レプリケーション管理プログラム506は、特定したボリュームをマウントする。

レプリケーション管理プログラム506は、S4003でマウントしたボリュームを用いて、ホスト計算機(待機サーバ)40のアプリケーションを再開する。よって、ホスト計算機(業務サーバ)30及び、そのデータが格納されているストレージシステム10が壊れた場合でも、ホスト計算機(待機サーバ)30を使用して業務を再開することができる。また、ホストベースレプリケーションの転送が途中にシステムがダウンした場合でも、ホスト計算機(待機サーバ)40上の2次レプリカボリュームのデータを用いることで、業務の引継ぎが可能なデータを適用することが可能となる。

本発明の第2実施形態は、第1の実施形態における計算機システム1においてホスト計算機30上でアプリケーション305のデータをキャプチャしていたのに対し、スイッチ装置20でアプリケーション305のデータをキャプチャしている点が異なる。本実施形態では、図1の構成との差異を中心に本環境における本発明を適用した場合について説明する。

図17に、本実施形態に係る計算機システム1Bの概略構成を示す図である。図17に示すように、本実施形態の計算機システム1Bは、図1と同様に、ストレージシステム10と、スイッチ装置20と、ホスト計算機(業務サーバ)30と、ホスト計算機(待機サーバ)40、管理計算機50と、を有している。

次に、本実施形態の処理について説明する。具体的処理は、第1の実施形態と同様に、図13、14、15、及び16の処理によって実現される。但し、次のステップの処理が変更される。

第3の実施形態は、第1の実施形態における計算機システム1に含まれるホスト計算機30及び40の代わりにNAS(Network Attached Storage)装置60を設置した点が異なる。NAS装置60は、メモリ603上にファイルシステムプログラム604を格納しており、ファイルサーバとして機能する。本実施形態では、図1の構成との差異を中心にNASの環境における本発明を適用した場合について説明する。

図18は、本実施形態に係る、NAS装置60を含む計算機システム1Cのシステム概略構成を示す図である。図18に示すように、本実施形態の計算機システム1Cは、ストレージシステム10と、スイッチ装置20と、NAS装置60と、管理計算機50と、を有している。ストレージシステム10と、スイッチ装置20と、管理計算機50は、第1の実施形態と同様の内部構成を有している。図1のシステム構成との差異は、ホスト計算機30及び40をNAS装置60で置き換えた点である。

本実施形態による計算機システム1Cの処理動作については、第1の実施形態と同様に、図13、14、15及び16で示される処理を適用することができる。但し、アプリケーション405をファイルシステムプログラム604と、ホストベースレプリケーションエンジン306をNASレプリケーションエンジン605と置き換える。

以上説明したように、本発明の実施形態による計算機システムは、第1の計算機(ホスト計算機30、スイッチ装置20A、NAS装置60A)と、第2の計算機(ホスト計算機40、NAS装置60B)と、ストレージシステムと、管理計算機と、によって構成されている。ストレージシステムでは、所定のタイミング(例えば、管理計算機からレプリケーションスケジュールが指定される)でアレイベースレプリケーションによって第1の記憶領域(主ボリューム)のバックアップデータ(レプリカ)が生成され、第2の記憶領域(副ボリューム)に格納される。一方、第1の計算機ではホストベースレプリケーションが実行され、第2のホスト計算機において、第1の記憶領域のレプリカデータが第3の記憶領域(レプリカボリューム)に格納される。また、第2の計算機では、レプリケーション(ホストベースである必要はない)が実行され、レプリカボリュームのレプリカが第4の記憶領域(2次レプリカボリューム)に2次レプリカデータとして保存される。そして、主ボリュームのデータが欠落した等、何らかの理由で副ボリュームから主ボリュームをリストア処理する際には、第2のホスト計算機のレプリカボリュームのデータ内容がリストア処理後の主ボリュームのデータ内容と同じになるように、2次レプリカデータをレプリカボリュームに適用する。このようにすることにより、主ボリュームをリストアした後でもホストベースレプリケーションによってレプリカボリュームを破壊することはなく、ホストベースレプリケーションとアレイベースレプリケーションの整合性を担保しつつ、両者を併用して運用できる環境を提供することが可能となる。

10 ストレージシステム

11 ストレージコントローラ

12 ストレージ装置

20 スイッチ装置

21 データネットワーク

22 管理ネットワーク

30 ホスト計算機(業務サーバ)

40 ホスト計算機(待機サーバ)

50 管理計算機

110、303、308、403、408 データI/F

111、302、402、502 CPU

112 ストレージI/F

113、309、409、503 管理I/F

114、304、404、504 メモリ

115 ストレージマイクロプログラム

116 アレイベースレプリケーションエンジン

120 物理リソース

121 プール

300、400、500 入力装置

301、401、501 表示装置

305、405 アプリケーション

306 ホストベースレプリケーションエンジン

307、407 記憶領域

406 レプリケーションエンジン

506 レプリケーション管理プログラム

507 構成情報テーブル

508 レプリケーション情報テーブル

509 アレイベースレプリケーション管理テーブル

510 ホストベースレプリケーション管理テーブル

511 アレイベースレプリケーションカタログテーブル

512 2次レプリカカタログテーブル

Claims (12)

- 第1の計算機と、当該第1の計算機に接続され、待機サーバとして機能する第2の計算機と、1つ以上の記憶領域を有し、前記第1の計算機に記憶領域を提供するストレージシステムと、前記第1及び第2の計算機と前記ストレージシステムとに接続され、それらを管理する管理計算機と、を有し、

前記ストレージシステムは、第1の記憶領域と、そのバックアップデータを格納する第2の記憶領域と、を含み、

前記第1の計算機は、前記第1の記憶領域への書き込みデータをキャプチャし、当該キャプチャした書き込みデータを前記第2の計算機に転送し、

前記第2の計算機は、前記第1の計算機から転送された前記書き込みデータを前記第1の記憶領域のレプリカデータとして第3の記憶領域に格納すると共に、当該第3の記憶領域のレプリカデータを第4の記憶領域に格納し、

前記管理計算機は、前記第2記憶領域のデータで前記第1の記録領域に対してリストア処理する際に、前記第3記憶領域のデータが前記リストア処理後の前記第1の記憶領域のデータと同じになるように、前記第1の記憶領域に対するリストア処理に用いたデータと同じバックアップ時刻を有する前記第4の記憶領域のデータを前記第3の記憶領域のデータに適用することを特徴とする計算機システム。 - 請求項1において、

前記管理計算機は、前記第1の記憶領域のバックアップが実行され、当該バックアップが前記第2の記憶領域に格納された時刻を示すバックアップ時刻と、前記書き込みデータの複製が前記第4の記憶領域に追加された時刻を示す2次レプリカ更新時刻と、を管理し、

前記管理計算機は、前記リストア処理に用いた前記第2の記憶領域の前記バックアップ時刻と、前記2次レプリカ時刻とを参照し、前記第4の記憶領域のデータを前記第3の記憶領域のデータに適用することを特徴とする計算機システム。 - 請求項2において、

前記管理計算機は、前記2次レプリカ更新時刻に前記第4の記憶領域に追加された前記書き込みデータが、どのバックアップ時刻に前記第2の記憶領域にバックアップされたかが分かるように、前記バックアップ時刻と前記2次レプリカ更新時刻を対応させて管理し、前記リストア処理に使用した前記第2の記憶領域のデータの前記バックアップ時刻に対応する前記第4の記憶領域のデータを前記第3の記憶領域のデータに適用することを特徴とする計算機システム。 - 請求項1乃至3の何れか1項において、

前記管理計算機は、前記第3の記憶領域のレプリカデータを作成し、前記第4の記憶領域に格納する方法を設定するための設定画面を表示装置に表示することを特徴とする計算機システム。 - 請求項1乃至4の何れか1項において、

前記第1の計算機は業務サーバであり、前記第2の計算機は待機サーバであり、

前記業務サーバは、前記第1の記憶領域を使用するアプリケーションと、ホストベースレプリケーションを実行し、前記アプリケーションによる前記第1の記憶領域に対する書き込みデータをキャプチャし、前記待機サーバに転送する第1のレプリケーションエンジンと、を有し、

前記待機サーバは、前記第3の記憶領域のデータの複製を2次レプリカデータとして前記第4の記憶領域に格納する第2のレプリケーションエンジンを有し、

前記ストレージシステムは、アレイベースレプリケーションを実行し、予め決められたスケジュールに従って、前記第1の記憶領域のデータのバックアップデータを前記第2の記憶領域に格納するアレイベースレプリケーションエンジンを有することを特徴とする計算機システム。 - 請求項1乃至4の何れか1項において、

さらに、前記第1の記憶領域を使用するアプリケーションを有する業務サーバを有し、

前記第1の計算機はスイッチ装置であり、前記第2の計算機は待機サーバであり、

前記スイッチ装置は、レプリケーションを実行し、前記アプリケーションによる前記第1の記憶領域に対する書き込みデータをキャプチャし、前記待機サーバに転送する第1のレプリケーションエンジンと、を有し、

前記第2の計算機は、前記第3の記憶領域のデータの複製を2次レプリカデータとして前記第4の記憶領域に格納する第2のレプリケーションエンジンを有し、

前記ストレージシステムは、アレイベースレプリケーションを実行し、予め決められたスケジュールに従って、前記第1の記憶領域のデータのバックアップデータを前記第2の記憶領域に格納するアレイベースレプリケーションエンジンを有することを特徴とする計算機システム。 - 請求項1乃至4の何れか1項において、

前記第1の計算機は第1のNAS装置であり、前記第2の計算機は第2のNAS装置であり、

前記第1のNAS装置は、ファイルシステムプログラムによって前記第1の記憶領域を使用するファイルシステムを管理するプロセッサと、レプリケーションを実行し、前記ファイルシステムプログラムによる前記第1の記憶領域に対する書き込みデータをキャプチャし、前記第2のNAS装置に転送する第1のレプリケーションエンジンと、を有し、

前記第2のNAS装置は、前記第3の記憶領域のデータの複製を2次レプリカデータとして前記第4の記憶領域に格納する第2のレプリケーションエンジンを有し、

前記ストレージシステムは、アレイベースレプリケーションを実行し、予め決められたスケジュールに従って、前記第1の記憶領域のデータのバックアップデータを前記第2の記憶領域に格納するアレイベースレプリケーションエンジンを有することを特徴とする計算機システム。 - 第1の計算機と、

第1の記憶領域と、そのバックアップデータを格納する第2の記憶領域と、を含み、前記第1の計算機に記憶領域を提供するストレージシステムと、

前記第1の計算機に接続され、前記第1の記憶領域のレプリカデータを格納する第3の記憶領域と、前記第3の記憶領域のレプリカデータを格納する第4の記憶領域と、を含み、待機サーバとして機能する第2の計算機と、

前記第1及び第2の計算機と前記ストレージシステムとに接続され、それらを管理する管理計算機と、を有する計算機システムを制御するシステム制御方法であって、

前記第1の計算機は、前記第1の記憶領域への書き込みデータをキャプチャし、当該キャプチャした書き込みデータを前記第2の計算機に転送し、

前記第2の計算機は、前記第1の計算機から転送された前記書き込みデータを前記第1の記憶領域のレプリカデータとして前記第3の記憶領域に格納すると共に、当該第3の記憶領域のレプリカデータを前記第4の記憶領域に格納し、

前記システム制御方法は、

前記管理計算機が、前記第2記憶領域のデータで前記第1の記録領域に対してリストア処理を実行することと、

前記管理計算機が、前記リストア処理実行の際に、前記第3記憶領域のデータが前記リストア処理後の前記第1の記憶領域のデータと同じになるように、前記第1の記憶領域に対するリストア処理に用いたデータと同じバックアップ時刻を有する前記第4の記憶領域のデータを前記第3の記憶領域のデータに適用することと、

を含むことを特徴とするシステム制御方法。 - 請求項8において、

前記管理計算機が、前記第1の記憶領域のバックアップが実行され、当該バックアップが前記第2の記憶領域に格納された時刻を示すバックアップ時刻と、前記書き込みデータの複製が前記第4の記憶領域に追加された時刻を示す2次レプリカ更新時刻と、を管理し、

前記管理計算機が、前記リストア処理に用いた前記第2の記憶領域の前記バックアップ時刻と、前記2次レプリカ時刻とを参照し、前記第4の記憶領域のデータを前記第3の記憶領域のデータに適用することを特徴とするシステム制御方法。 - 請求項9において、

前記管理計算機が、前記2次レプリカ更新時刻に前記第4の記憶領域に追加された前記書き込みデータが、どのバックアップ時刻に前記第2の記憶領域にバックアップされたかが分かるように、前記バックアップ時刻と前記2次レプリカ更新時刻を対応させて管理し、前記リストア処理に使用した前記第2の記憶領域のデータの前記バックアップ時刻に対応する前記第4の記憶領域のデータを前記第3の記憶領域のデータに適用することを特徴とするシステム制御方法。 - 請求項8乃至10の何れか1項において、さらに、

前記管理計算機が、前記第3の記憶領域のレプリカデータを作成し、前記第4の記憶領域に格納する方法を設定するための設定画面を表示装置に表示することを特徴とするシステム制御方法。 - 請求項8乃至11の何れか1項において、さらに、

前記管理計算機が、前記第1の記憶領域の業務引継ぎ処理の指示に応答し、前記第3の記憶領域のデータをマウントすることを特徴とするシステム制御方法。

Priority Applications (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2010138464A JP5424992B2 (ja) | 2010-06-17 | 2010-06-17 | 計算機システム、及びシステム制御方法 |

| PCT/JP2010/063405 WO2011158386A1 (ja) | 2010-06-17 | 2010-08-06 | 計算機システム、及びシステム制御方法 |

| US12/988,546 US8683154B2 (en) | 2010-06-17 | 2010-08-06 | Computer system and system control method |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2010138464A JP5424992B2 (ja) | 2010-06-17 | 2010-06-17 | 計算機システム、及びシステム制御方法 |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2012003544A JP2012003544A (ja) | 2012-01-05 |

| JP2012003544A5 JP2012003544A5 (ja) | 2012-05-10 |

| JP5424992B2 true JP5424992B2 (ja) | 2014-02-26 |

Family

ID=45347806

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2010138464A Expired - Fee Related JP5424992B2 (ja) | 2010-06-17 | 2010-06-17 | 計算機システム、及びシステム制御方法 |

Country Status (2)

| Country | Link |

|---|---|

| JP (1) | JP5424992B2 (ja) |

| WO (1) | WO2011158386A1 (ja) |

Families Citing this family (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP5838810B2 (ja) * | 2011-12-28 | 2016-01-06 | 富士通株式会社 | バックアップ制御プログラム、バックアップ制御方法およびバックアップ制御装置 |

| WO2016162916A1 (ja) * | 2015-04-06 | 2016-10-13 | 株式会社日立製作所 | 管理計算機およびリソース管理方法 |

Family Cites Families (15)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US6948089B2 (en) * | 2002-01-10 | 2005-09-20 | Hitachi, Ltd. | Apparatus and method for multiple generation remote backup and fast restore |

| JP2005062928A (ja) * | 2003-08-11 | 2005-03-10 | Hitachi Ltd | 複数のサイトにリモートコピーを行うシステム |

| JP4402992B2 (ja) * | 2004-03-18 | 2010-01-20 | 株式会社日立製作所 | バックアップシステム及び方法並びにプログラム |

| JP4843976B2 (ja) * | 2005-03-25 | 2011-12-21 | 日本電気株式会社 | レプリケーションシステムと方法 |

| JP2007047892A (ja) * | 2005-08-08 | 2007-02-22 | Hitachi Ltd | 計算機システム及び計算機システムの状態管理方法 |

| JP2007066192A (ja) * | 2005-09-01 | 2007-03-15 | Hitachi Ltd | ストレージシステム及びその制御方法並びにコンピュータプログラム |

| JP2007310448A (ja) * | 2006-05-16 | 2007-11-29 | Hitachi Ltd | 計算機システム、管理計算機、および、ストレージシステム管理方法 |

| US7627729B2 (en) * | 2006-09-07 | 2009-12-01 | International Business Machines Corporation | Apparatus, system, and method for an improved synchronous mirror swap |

| JP4902403B2 (ja) * | 2006-10-30 | 2012-03-21 | 株式会社日立製作所 | 情報システム及びデータ転送方法 |

| JP2009070143A (ja) * | 2007-09-13 | 2009-04-02 | Hitachi Ltd | Nas装置の差分リモートバックアップにおけるデータ復旧方法及び計算機システム |

| JP4249240B2 (ja) * | 2007-11-19 | 2009-04-02 | 株式会社日立製作所 | 記憶システム |

| JP5026309B2 (ja) * | 2008-03-06 | 2012-09-12 | 株式会社日立製作所 | バックアップデータ管理システム及びバックアップデータ管理方法 |

| JP5224240B2 (ja) * | 2008-03-25 | 2013-07-03 | 株式会社日立製作所 | 計算機システム及び管理計算機 |

| JP2009245004A (ja) * | 2008-03-28 | 2009-10-22 | Nippon Telegraph & Telephone West Corp | 双方向データ配置システム、アクセス解析サーバ、データ移動サーバ、双方向データ配置方法、及び、プログラム |

| JP2010039986A (ja) * | 2008-08-08 | 2010-02-18 | Hitachi Ltd | データのバックアップを管理する計算機システム及び方法 |

-

2010

- 2010-06-17 JP JP2010138464A patent/JP5424992B2/ja not_active Expired - Fee Related

- 2010-08-06 WO PCT/JP2010/063405 patent/WO2011158386A1/ja active Application Filing

Also Published As

| Publication number | Publication date |

|---|---|

| JP2012003544A (ja) | 2012-01-05 |

| WO2011158386A1 (ja) | 2011-12-22 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| US12003581B2 (en) | Enhanced network attached storage (NAS) interoperating with and overflowing to cloud storage resources | |

| US11663099B2 (en) | Snapshot-based disaster recovery orchestration of virtual machine failover and failback operations | |

| US11321195B2 (en) | Hypervisor-independent reference copies of virtual machine payload data based on block-level pseudo-mount | |

| US10715614B2 (en) | Assigning data agent proxies for executing virtual-machine secondary copy operations including streaming backup jobs | |

| US20210334002A1 (en) | Redundant distributed data storage system | |

| JP5227887B2 (ja) | バックアップ管理方法 | |

| JP5227125B2 (ja) | ストレージシステム | |

| US9588849B2 (en) | Synchronizing selected portions of data in a storage management system | |

| JP5172574B2 (ja) | アプリケーションデータのバックアップ構成構築に用いる管理計算機 | |

| US7979649B1 (en) | Method and apparatus for implementing a storage lifecycle policy of a snapshot image | |

| US20100306174A1 (en) | Method and apparatus for block based volume backup | |

| US20090089340A1 (en) | Backup catalog recovery from replicated data | |

| JP2005031716A (ja) | データバックアップの方法及び装置 | |

| US7584339B1 (en) | Remote backup and restore operations for ISB protocol systems | |

| US8386492B2 (en) | Information processing system and data backup method in information processing system | |

| US20180314457A1 (en) | Execution framework for a complex data protection operation | |

| JP2015527620A (ja) | 計算機システム、サーバ、及び、データ管理方法 | |

| US8683154B2 (en) | Computer system and system control method | |

| US8769334B1 (en) | Techniques for providing instant disaster recovery | |

| US7587565B1 (en) | Generating automated and scheduled SAN copy sessions for ISB protocol systems | |

| JP5424992B2 (ja) | 計算機システム、及びシステム制御方法 | |

| JP2013161383A (ja) | 情報処理装置、情報処理方法、プログラム及び情報処理システム | |

| Dufrasne et al. | IBM DS8000 Copy Services: Updated for IBM DS8000 Release 9.1 | |

| US12235744B2 (en) | Snapshot-based disaster recovery orchestration of virtual machine failover and failback operations | |

| Nakajima | Hitachi HiCommand® Protection Manager Software for Microsoft Exchange Server 2003 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20120316 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20120316 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20130521 |

|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20130722 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20131105 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20131126 |

|

| LAPS | Cancellation because of no payment of annual fees |