JP5055214B2 - 画像処理装置、画像処理方法 - Google Patents

画像処理装置、画像処理方法 Download PDFInfo

- Publication number

- JP5055214B2 JP5055214B2 JP2008185295A JP2008185295A JP5055214B2 JP 5055214 B2 JP5055214 B2 JP 5055214B2 JP 2008185295 A JP2008185295 A JP 2008185295A JP 2008185295 A JP2008185295 A JP 2008185295A JP 5055214 B2 JP5055214 B2 JP 5055214B2

- Authority

- JP

- Japan

- Prior art keywords

- image

- virtual

- viewpoint

- screen

- image processing

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Description

VR世界の構築手法 監修者 舘すすむ、編者 廣瀬通孝、発行所 株式会社 培風館、2000年 Interactive Rendering with Coherent Ray-Tracing Ingo Wald, Carsten Benthin, Markus Wagner, and Philipp Slusallek in Computer Graphics Forum / Proceedings of the EUROGRAPHICS 2001, pp 153-164, 20(3), Manchster, United Kingdom, September 3-7, 2001

仮想空間を構成する複数の仮想物体のデータを管理する管理手段と、

前記第1の視点から観察可能な仮想物体を前記複数の仮想物体から探索し、該探索により見つかった仮想物体の画像を含む、当該第1の視点から前記仮想空間を観察した第1画像を描画する第1の描画手段と、

前記第2の視点から観察可能な仮想物体を前記複数の仮想物体から探索し、該探索により見つかった仮想物体の画像を含む、当該第2の視点から前記仮想空間を観察した第2画像を描画する第2の描画手段とを備え、

前記第1の描画手段は、前記仮想物体を所定の順序で探索し、該探索により見つかった仮想物体が先の順序となるように前記所定の順序を更新し、

前記第2の描画手段は、前記第1の描画手段により更新された所定の順序で前記仮想物体を探索することを特徴とする。

本実施形態では、ユーザ(観察者)の右眼、左眼のそれぞれに対して提示する仮想空間画像をレイトレーシング法により生成する場合を想定している。より詳しくは、本実施形態では先ず一方の目に対して提示する仮想空間画像を生成し、係る生成処理の過程で得られる計算結果を記憶する。そして、係る計算結果を、他方の目に対して提示する仮想空間画像の生成処理に利用する。これにより、それぞれの目に対して提示する仮想空間画像の生成処理の効率化と高速化を可能にする。

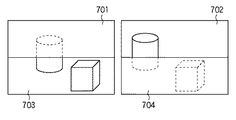

第1の実施形態では、第1画面、第2画面を逐次処理で生成していた。本実施形態では、第1画面、第2画面を分割し、並列でそれぞれの画面を生成する。

ここでは、適応的に画面分割を行う例について説明する。

第1,2の実施形態では、画像の生成を逐次的に1画素ずつおこなっていた。本実施形態では、画像生成処理の前半過程で一部のみ画像生成を行いシーンデータの更新を行い、再度詳細に画像生成処理を行う点が大きく異なる。

第1の実施形態、第2の実施形態、第3の実施形態では、それぞれの画像生成過程で出力されるシーンデータを交換して利用することで効率良く画像を生成するための処理について説明した。本実施形態では、ラスタライゼーションによる画像生成処理において、左右の眼に対する画像生成過程で出力された奥行き値を視点座標変換して流用する点が異なる。

第1〜4の実施形態では、ステレオ画像を生成する際に画像生成過程で得られる情報を交換して利用することで効率良く画像を生成するための処理について説明した。本実施形態では、2眼以上のカメラシステムで画像生成を行う場合を想定しており、画面領域を2つ以上の領域に分割してそれぞれの画像生成処理を適用する点が異なる。

領域分割の際、第1の画面および第2の画面で重なり合う領域が無い場合に最も効率が良くなる。しかし、全く重なり合う領域が無い場合には、境界部分のエッジが目立ってしまうという問題が発生する。そのため、境界エッジの周辺で数ピクセルに渡り重なり合う領域を設け、計算して得られた画像を合成してスムージングすることによりエッジを目立たなくすることが可能となる。領域分割の際に重なり合う領域をどの程度設定するかは、構築するシステムでそれぞれ好適な手段を採用すればよい。

また、本発明の目的は、以下のようにすることによって達成されることはいうまでもない。即ち、前述した実施形態の機能を実現するソフトウェアのプログラムコードを記録した記録媒体(または記憶媒体)を、システムあるいは装置に供給する。係る記憶媒体は言うまでもなく、コンピュータ読み取り可能な記憶媒体である。そして、そのシステムあるいは装置のコンピュータ(またはCPUやMPU)が記録媒体に格納されたプログラムコードを読み出し実行する。この場合、記録媒体から読み出されたプログラムコード自体が前述した実施形態の機能を実現することになり、そのプログラムコードを記録した記録媒体は本発明を構成することになる。

Claims (8)

- 第1の視点および該第1の視点とは異なる第2の視点から共通の物体を描画する画像処理装置であって、

仮想空間を構成する複数の仮想物体のデータを管理する管理手段と、

前記第1の視点から観察可能な仮想物体を前記複数の仮想物体から探索し、該探索により見つかった仮想物体の画像を含む、当該第1の視点から前記仮想空間を観察した第1画像を描画する第1の描画手段と、

前記第2の視点から観察可能な仮想物体を前記複数の仮想物体から探索し、該探索により見つかった仮想物体の画像を含む、当該第2の視点から前記仮想空間を観察した第2画像を描画する第2の描画手段とを備え、

前記第1の描画手段は、前記仮想物体を所定の順序で探索し、該探索により見つかった仮想物体が先の順序となるように前記所定の順序を更新し、

前記第2の描画手段は、前記第1の描画手段により更新された所定の順序で前記仮想物体を探索することを特徴とする画像処理装置。 - 前記第1の描画手段は、

前記探索により見つかった仮想物体が先頭に位置するように、前記所定の順序を更新することを特徴とする請求項1に記載の画像処理装置。 - 前記第1画像及び前記第2画像の画像領域は、第1の領域と第2の領域とを含み、

前記第1の描画手段及び前記第2の描画手段はそれぞれ、前記第1画像の前記第1の領域及び前記第2画像の前記第2の領域を描画し、該描画後、前記第1画像の前記第2の領域及び前記第2画像の前記第1の領域を描画し、

前記第1の描画手段は、前記第1画像の前記第1の領域を描画する際に、前記仮想物体を第1の所定の順序で探索し、該探索により見つかった仮想物体が先の順序となるように前記第1の所定の順序を更新し、

前記第2の描画手段は、前記第2画像の前記第2の領域を描画する際に、前記仮想物体を第2の所定の順序で探索し、該探索により見つかった仮想物体が先の順序となるように前記第2の所定の順序を更新し、

前記第1の描画手段は、前記第1画像の前記第2の領域を描画する際に、前記仮想物体を前記第2の描画手段により更新された前記第2の所定の順序で探索し、

前記第2の描画手段は、前記第2画像の前記第1の領域を描画する際に、前記仮想物体を前記第1の描画手段により更新された前記第1の所定の順序で探索することを特徴とする請求項1又は2に記載の画像処理装置。 - 前記第1の描画手段及び前記第2の描画手段はそれぞれ、描画の過程で得られた奥行き値を他方の視点からの座標系に変換して描画することを特徴とする請求項1乃至3の何れか1項に記載の画像処理装置。

- 前記第1の視点は観察者の一方の目に対応しており、前記第2の視点は当該観察者の他方の目に対応していることを特徴とする請求項1乃至4の何れか1項に記載の画像処理装置。

- 前記第1の描画手段及び前記第2の描画手段はそれぞれ、前記第1の領域と前記第2の領域とが重ならないように前記画像領域の分割を行うことを特徴とする請求項3に記載の画像処理装置。

- 第1の視点および該第1の視点とは異なる第2の視点から共通の物体を描画する画像処理装置が行う画像処理方法であって、

前記画像処理装置の管理手段が、仮想空間を構成する複数の仮想物体のデータを管理する管理工程と、

前記画像処理装置の第1の描画手段が、前記第1の視点から観察可能な仮想物体を前記複数の仮想物体から探索し、該探索により見つかった仮想物体の画像を含む、当該第1の視点から前記仮想空間を観察した第1画像を描画する第1の描画工程と、

前記画像処理装置の第2の描画手段が、前記第2の視点から観察可能な仮想物体を前記複数の仮想物体から探索し、該探索により見つかった仮想物体の画像を含む、当該第2の視点から前記仮想空間を観察した第2画像を描画する第2の描画工程とを有し、

前記第1の描画工程では、前記仮想物体を所定の順序で探索し、該探索により見つかった仮想物体が先の順序となるように前記所定の順序を更新し、

前記第2の描画工程では、前記第1の描画工程で更新された所定の順序で前記仮想物体を探索することを特徴とする画像処理方法。 - コンピュータを、請求項1乃至6の何れか1項に記載の画像処理装置が有する各手段として機能させるためのプログラム。

Priority Applications (4)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2008185295A JP5055214B2 (ja) | 2007-10-19 | 2008-07-16 | 画像処理装置、画像処理方法 |

| EP08015608.6A EP2051533B1 (en) | 2007-10-19 | 2008-09-04 | 3D image rendering apparatus and method |

| US12/237,930 US8884947B2 (en) | 2007-10-19 | 2008-09-25 | Image processing apparatus and image processing method |

| CN200810171559.5A CN101414383B (zh) | 2007-10-19 | 2008-10-17 | 图像处理设备和图像处理方法 |

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2007273088 | 2007-10-19 | ||

| JP2007273088 | 2007-10-19 | ||

| JP2008185295A JP5055214B2 (ja) | 2007-10-19 | 2008-07-16 | 画像処理装置、画像処理方法 |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2009116856A JP2009116856A (ja) | 2009-05-28 |

| JP2009116856A5 JP2009116856A5 (ja) | 2011-07-14 |

| JP5055214B2 true JP5055214B2 (ja) | 2012-10-24 |

Family

ID=40594908

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2008185295A Expired - Fee Related JP5055214B2 (ja) | 2007-10-19 | 2008-07-16 | 画像処理装置、画像処理方法 |

Country Status (2)

| Country | Link |

|---|---|

| JP (1) | JP5055214B2 (ja) |

| CN (1) | CN101414383B (ja) |

Families Citing this family (12)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP5565126B2 (ja) * | 2010-06-17 | 2014-08-06 | 大日本印刷株式会社 | 立体印刷物制作支援装置、プラグインプログラム、立体印刷物制作方法および立体印刷物 |

| EP2461587A1 (en) * | 2010-12-01 | 2012-06-06 | Alcatel Lucent | Method and devices for transmitting 3D video information from a server to a client |

| JP5891426B2 (ja) * | 2011-03-31 | 2016-03-23 | パナソニックIpマネジメント株式会社 | 全周囲立体画像の描画を行う画像描画装置、画像描画方法、画像描画プログラム |

| JP6532393B2 (ja) | 2015-12-02 | 2019-06-19 | 株式会社ソニー・インタラクティブエンタテインメント | 表示制御装置及び表示制御方法 |

| CN105657408B (zh) | 2015-12-31 | 2018-11-30 | 北京小鸟看看科技有限公司 | 虚拟现实场景的实现方法和虚拟现实装置 |

| JP6833348B2 (ja) * | 2016-05-25 | 2021-02-24 | キヤノン株式会社 | 情報処理装置、画像処理システム、情報処理装置の制御方法、仮想視点画像の生成方法、及び、プログラム |

| JP6915237B2 (ja) * | 2016-07-05 | 2021-08-04 | 富士通株式会社 | 情報処理装置、シミュレータ結果表示方法、及びシミュレータ結果表示プログラム |

| US10311630B2 (en) * | 2017-05-31 | 2019-06-04 | Verizon Patent And Licensing Inc. | Methods and systems for rendering frames of a virtual scene from different vantage points based on a virtual entity description frame of the virtual scene |

| CN107576352A (zh) * | 2017-07-18 | 2018-01-12 | 朱跃龙 | 一种检测设备、模型建立方法和计算机处理设备 |

| CN110276260B (zh) * | 2019-05-22 | 2021-06-08 | 杭州电子科技大学 | 一种基于深度摄像头的商品检测方法 |

| WO2022195818A1 (ja) * | 2021-03-18 | 2022-09-22 | 株式会社ソニー・インタラクティブエンタテインメント | 画像生成システムおよび画像生成方法 |

| CN115665541B (zh) * | 2022-10-11 | 2023-06-23 | 深圳市田仓文化传播有限公司 | 基于智能控制的多功能数字影棚系统 |

Family Cites Families (7)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH0528280A (ja) * | 1991-07-22 | 1993-02-05 | Nippon Telegr & Teleph Corp <Ntt> | 光線追跡方法 |

| JPH10232953A (ja) * | 1997-02-20 | 1998-09-02 | Mitsubishi Electric Corp | 立体視画像生成装置 |

| US7528830B2 (en) * | 2003-09-17 | 2009-05-05 | Koninklijke Philips Electronics N.V. | System and method for rendering 3-D images on a 3-D image display screen |

| JP4039676B2 (ja) * | 2004-03-31 | 2008-01-30 | 株式会社コナミデジタルエンタテインメント | 画像処理装置、画像処理方法及びプログラム |

| EP1643758B1 (en) * | 2004-09-30 | 2013-06-19 | Canon Kabushiki Kaisha | Image-capturing device, image-processing device, method for controlling image-capturing device, and associated storage medium |

| JP2006163547A (ja) * | 2004-12-03 | 2006-06-22 | Canon Inc | 立体画像生成プログラム、立体画像生成システム及び立体画像生成装置。 |

| JP2007264966A (ja) * | 2006-03-28 | 2007-10-11 | Seiko Epson Corp | 立体視画像生成装置、立体視画像生成方法、立体視画像生成プログラム、記録媒体、および立体視画像印刷装置 |

-

2008

- 2008-07-16 JP JP2008185295A patent/JP5055214B2/ja not_active Expired - Fee Related

- 2008-10-17 CN CN200810171559.5A patent/CN101414383B/zh not_active Expired - Fee Related

Also Published As

| Publication number | Publication date |

|---|---|

| CN101414383B (zh) | 2014-06-18 |

| JP2009116856A (ja) | 2009-05-28 |

| CN101414383A (zh) | 2009-04-22 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP5055214B2 (ja) | 画像処理装置、画像処理方法 | |

| EP2051533B1 (en) | 3D image rendering apparatus and method | |

| US11263820B2 (en) | Multi-stage block mesh simplification | |

| CN112513712B (zh) | 具有虚拟内容翘曲的混合现实系统和使用该系统生成虚拟内容的方法 | |

| KR101145260B1 (ko) | 3d 객체 모델에 텍스쳐를 매핑하는 방법 및 장치 | |

| JP5005090B2 (ja) | 切削加工シミュレーション表示装置、切削加工シミュレーション表示方法、および切削加工シミュレーション表示プログラム | |

| CN112270756A (zh) | 一种应用于bim模型文件的数据渲染方法 | |

| JP7201869B1 (ja) | 前の目線からのレンダリングされたコンテンツおよびレンダリングされなかったコンテンツを使用した新しいフレームの生成 | |

| US9508191B2 (en) | Optimal point density using camera proximity for point-based global illumination | |

| JPH10255081A (ja) | 画像処理方法及び画像処理装置 | |

| US9401044B1 (en) | Method for conformal visualization | |

| RU2680355C1 (ru) | Способ и система удаления невидимых поверхностей трёхмерной сцены | |

| Petkov et al. | Interactive visibility retargeting in vr using conformal visualization | |

| KR101090660B1 (ko) | 포인트 프리미티브를 이용한 실시간 볼륨 렌더링 방법 | |

| CA3143520C (en) | Method of computing simulated surfaces for animation generation and other purposes | |

| Kuzma | Occlusion in Augmented Reality: Exploring the problem of rendering semi-occluded objects in augmented reality using a model-based approach. | |

| KR20130117074A (ko) | 무안경 3d vr 엔진 개발 방법 | |

| Daş | Stereoscopic ray tracing on graphics processors |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20110527 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20110527 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20120411 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20120416 |

|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20120615 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20120702 |

|

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20120730 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20150803 Year of fee payment: 3 |

|

| LAPS | Cancellation because of no payment of annual fees |