JP4635486B2 - 概念獲得装置及びその方法、並びにロボット装置及びその行動制御方法 - Google Patents

概念獲得装置及びその方法、並びにロボット装置及びその行動制御方法 Download PDFInfo

- Publication number

- JP4635486B2 JP4635486B2 JP2004191935A JP2004191935A JP4635486B2 JP 4635486 B2 JP4635486 B2 JP 4635486B2 JP 2004191935 A JP2004191935 A JP 2004191935A JP 2004191935 A JP2004191935 A JP 2004191935A JP 4635486 B2 JP4635486 B2 JP 4635486B2

- Authority

- JP

- Japan

- Prior art keywords

- concept

- person

- positive

- attribute information

- target

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Landscapes

- Manipulator (AREA)

Description

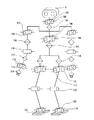

先ず、本実施の形態におけるロボット装置の構成について説明する。図1に示すように、本実施の形態におけるロボット装置1は、体幹部ユニット2の所定の位置に頭部ユニット3が連結されるとともに、左右2つの腕部ユニット4R/Lと、左右2つの脚部ユニット5R/Lが連結されて構成されている(但し、R及びLの各々は、右及び左の各々を示す接尾辞である。以下において同じ。)。

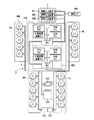

次に、本実施の形態における概念獲得方法について説明する。図4は、本実施の形態における概念獲得装置40を示すブロック図である。概念獲得装置40を搭載したロボット装置1は、外界の情報を取得するセンサに図3に示す画像入力装置251に設けられたCCDカメラ41と音声入力装置252に設けられたマイクロホン43とを用いることができる。なお、ここではILP(Inductive Logic Programming)システムの1つであるProgolを用いて概念を獲得する方法を説明する。

人物ID:p1

髭:true

眼鏡:false

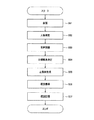

ステップS51にて、マイクロホン43から入力された音声は、音声認識器44にて発話内容が認識され、テキスト文章が出力される(ステップS53)。

ルール:わたしはXがすきです ,like

ルール:わたしはXがすきではありません ,like

ルール:わたしはXがきらいです ,like

そして、例えば「わたしはらーめんがすきです。」とステップS53で認識された場合、目標概念決定器47は、その発話内容に対応する目標概念決定ルールに従ってlikeを目標概念として決定する。

ルール:わたしはTARGETがすきです ,like(person, TARGET)

ルール:わたしはTARGETがすきではありません ,not(like(person, TARGET))

ルール:わたしはTARGETがきらいです ,not(like(person, TARGET))

ここで、TARGETには、テキスト文章に応じて様々な要素が入力される。そして、Fact生成器45は、、ステップS53にて、例えば「わたしはらーめんがすきです。」と認識されたテキスト文章に対応する正負例決定ルールに従って、正例であるlike(person, ramen)を生成する。

like(p1, ramen). not like(p1, udon). not hige(p1). not megane(p1).

not like(p2, ramen). like(p2, udon). hige(p2). not megane(p2).

like(p3, ramen). not like(p3, udon). not hige(p3). megane(p3).

like(p4, ramen). not like(p4, udon). not hige(p4). megane(p4).

not like(p5, ramen). not like(p5, udon). hige(p5). megane(p5).

like(p6, ramen). not like(p6, udon). not hige(p6). megane(p6).

not like(p7, ramen). like(p7, udon). hige(p7). not megane(p7).

not like(p8, ramen). like(p8, udon). hige(p8). not megane(p8).

not like(p9, ramen). not like(p9, udon). not hige(p9). not megane(p9).

ここで、例えば1段目のp1の人について説明すれば、顔には髭も眼鏡もなく、ラーメンが好きで、うどんが嫌いな人であることを示している。

modeh(1, like(+person, #food))

modeb(1, hige (+person))

modeb(1, megane (+person))

modeb(1, not hige(+person)))

modeb(1, not (megane(+person,)))

modeb(*,+any, +any)

ここで、modeh(1, like(+person, #food))の記述は、食べ物#foodに対する目標概念likeについてmodebに記述されている正負例の分類規則を見つけるように規定したものである。また、modeb(*,+any, +any)の記述は、modebに記述されている正負例を組み合わせて分類できるように規定したものである。なお、ラーメン及びうどんについては、背景知識データベース50に食べ物であることが記述されているものとする。

like(A, ramen)←not hige(A)

like(A, udon)←not(megane(A))and hige(A)

ここで、like(A, ramen)←not hige(A)の記述は、「髭を生やしていない人はラーメンが好きである」という概念を表すものである。これは、髭を生やしていない人であるp1、p3、p4、p6及びp9のうち、ラーメンが好きではない人はp9のみであるという事実に基づくものである。また、like(A, udon)←not(megane(A))and hige(A)の記述は、「眼鏡をかけておらず、且つ髭を生やしている人は、うどんが好きである」という概念を表すものである。これは、眼鏡をかけておらず、且つ髭を生やしている人であるp2、p7及びp8は、皆うどんが好きであるという事実に基づくものである。

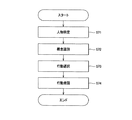

本実施の形態における行動制御方法について説明する。図6は、本実施の形態におけるロボット装置1の行動制御に関わる部分を示すブロック図である。ロボット装置1の行動制御に関わる部分は、外界の情報を取得するセンサとして図3に示す画像入力装置251に設けられたCCDカメラ61を用いることができる。

人物ID:p10

髭:false

眼鏡:false

概念識別器63は、顔認識器62から入力された属性情報に基づいて知識記憶器64に記憶された概念が真か偽かを識別する(ステップS72)。そして、真である概念をロボット装置1の行動に反映させる概念として行動選択器65に出力する。例えば、人物IDp10の属性情報に基づいて、次のような概念が知識記憶器64から取得される。

like(A, udon)←not(megane(A))and hige(A)

ここで、人物IDp10の属性情報を元に概念が真か偽かを識別する。人物IDp10の属性情報よりlike(p10, ramen)が真となることから、この概念をロボット装置1の行動に反映させる概念として行動選択器65に出力する。

like(P, OBJ), speak(Pさん”は”OBJ”がすきなんだね”)

行動選択器65は、行動識別子speakに基づいて発話行動を選択し、speak(“あなた は らーめん がすきなんだね”)を音声合成器67に出力する。ここでは、顔認識器62が新しい顔を検出し、人物名を知らないため、“Pさん”には“あなた”が挿入される。なお、人物名を知っている場合は、“Pさん”に人物IDで識別された人物名が挿入される。

Claims (8)

- 画像から人の顔を認識し、人物IDを出力するとともに、顔の特徴を抽出し、顔の特徴を示す属性情報を出力する顔認識手段と、

音声から発話内容を認識し、テキスト文章を出力する音声認識手段と、

上記属性情報に基づいて顔の特徴の有無を示す正負例を上記人物ID毎に生成するとともに、上記テキスト文章に基づいて発話内容と同じ意味又は反対の意味を示す正負例を上記人物ID毎に生成する正負例生成手段と、

上記属性情報又は上記テキスト文章に基づいて目標概念を決定する目標概念決定手段と、

上記目標概念に対して上記正負例を組み合わせ、最も多くの人物IDに対して事例が成り立つものを概念として獲得する概念獲得手段と

を有する概念獲得装置。 - 上記目標概念決定手段は、目標概念が予め規定されたデータベースを有し、該データベースの目標概念と上記属性情報又は上記テキスト文章とを比較し、合致したものを目標概念として決定する請求項1記載の概念獲得装置。

- 上記概念獲得手段にて獲得した概念を記憶する知識記憶手段を有する請求項1記載の概念獲得装置。

- 顔認識手段により、画像から人の顔を認識し、人物IDを出力するとともに、顔の特徴を抽出し、顔の特徴を示す属性情報を出力する顔認識工程と、

音声認識手段により、音声から発話内容を認識し、テキスト文章を出力する音声認識工程と、

情報処理装置により、上記属性情報又は上記テキスト文章に基づいて目標概念を決定する目標概念決定工程と、

情報処理装置により、上記属性情報に基づいて顔の特徴の有無を示す正負例を上記人物ID毎に生成するとともに、上記テキスト文章に基づいて発話内容と同じ意味又は反対の意味を示す正負例を上記人物ID毎に生成する正負例生成工程と、

情報処理装置により、上記目標概念に対して上記正負例を組み合わせ、最も多くの人物IDに対して事例が成り立つものを概念として獲得する概念獲得工程と

を有する概念獲得方法。 - 自律的な動作が可能なロボット装置において、

画像から人の顔を認識し、人物IDを出力するとともに、顔の特徴を抽出し、顔の特徴を示す属性情報を出力する顔認識手段と、

音声から発話内容を認識し、テキスト文章を出力する音声認識手段と、

上記属性情報に基づいて顔の特徴の有無を示す正負例を上記人物ID毎に生成するとともに、上記テキスト文章に基づいて発話内容と同じ意味又は反対の意味を示す正負例を上記人物ID毎に生成する正負例生成手段と、

上記属性情報又は上記テキスト文章に基づいて目標概念を決定する目標概念決定手段と、

上記目標概念に対して上記正負例を組み合わせ、最も多くの人物IDに対して事例が成り立つものを概念として獲得する概念獲得手段と、

上記概念獲得手段にて獲得した概念を記憶する知識記憶手段と

を有するロボット装置。 - 上記属性情報に基づいて上記知識記憶手段に記憶された概念の真偽を識別する概念識別手段と、

上記概念識別手段にて真であると識別された概念を反映させる行動を選択する行動選択手段とを有する請求項5記載のロボット装置。 - 上記目標概念決定手段は、目標概念が予め規定されたデータベースを有し、該データベースの目標概念と上記属性情報又は上記テキスト文章とを比較し、合致したものを目標概念として決定する請求項5記載のロボット装置。

- 顔認識手段により、画像から人の顔を認識し、人物IDを出力するとともに、顔の特徴を抽出し、顔の特徴を示す属性情報を出力する顔認識工程と、

音声認識手段により、音声から発話内容を認識し、テキスト文章を出力する音声認識工程と、

情報処理装置により、上記属性情報又は上記テキスト文章に基づいて目標概念を決定する目標概念決定工程と、

情報処理装置により、上記属性情報に基づいて顔の特徴の有無を示す正負例を上記人物ID毎に生成するとともに、上記テキスト文章に基づいて発話内容と同じ意味又は反対の意味を示す正負例を上記人物ID毎に生成する正負例生成工程と、

情報処理装置により、上記目標概念に対して上記正負例を組み合わせ、最も多くの人物IDに対して事例が成り立つものを概念として獲得する概念獲得工程と、

情報処理装置により、上記概念獲得工程にて獲得した概念を記憶手段に記憶する知識記憶工程と

を有するロボット装置の行動制御方法。

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2004191935A JP4635486B2 (ja) | 2004-06-29 | 2004-06-29 | 概念獲得装置及びその方法、並びにロボット装置及びその行動制御方法 |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2004191935A JP4635486B2 (ja) | 2004-06-29 | 2004-06-29 | 概念獲得装置及びその方法、並びにロボット装置及びその行動制御方法 |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2006012082A JP2006012082A (ja) | 2006-01-12 |

| JP4635486B2 true JP4635486B2 (ja) | 2011-02-23 |

Family

ID=35779240

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2004191935A Expired - Fee Related JP4635486B2 (ja) | 2004-06-29 | 2004-06-29 | 概念獲得装置及びその方法、並びにロボット装置及びその行動制御方法 |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP4635486B2 (ja) |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN100444985C (zh) * | 2004-11-19 | 2008-12-24 | 财团法人名古屋产业科学研究所 | 多螺距螺纹、多螺距螺纹的制造方法及制造装置 |

Families Citing this family (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR20080075932A (ko) * | 2007-01-11 | 2008-08-20 | (주)에이치씨아이랩 | 음성 및 영상 인식을 이용하여 주인을 알아보고 주인과대화형 인터페이스 및 상호 연동이 가능한 디지털 수족관장치 그 제어방법 |

| WO2019051645A1 (zh) | 2017-09-12 | 2019-03-21 | 深圳前海达闼云端智能科技有限公司 | 一种机器人动态学习方法、系统、机器人以及云端服务器 |

Family Cites Families (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| FR2697101B1 (fr) * | 1992-10-21 | 1994-11-25 | Sextant Avionique | Procédé de détection de la parole. |

| JP2788402B2 (ja) * | 1993-11-17 | 1998-08-20 | 株式会社エイ・ティ・アール音声翻訳通信研究所 | 音声信号処理装置 |

| FR2787902B1 (fr) * | 1998-12-23 | 2004-07-30 | France Telecom | Modele et procede d'implementation d'un agent rationnel dialoguant, serveur et systeme multi-agent pour la mise en oeuvre |

-

2004

- 2004-06-29 JP JP2004191935A patent/JP4635486B2/ja not_active Expired - Fee Related

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN100444985C (zh) * | 2004-11-19 | 2008-12-24 | 财团法人名古屋产业科学研究所 | 多螺距螺纹、多螺距螺纹的制造方法及制造装置 |

Also Published As

| Publication number | Publication date |

|---|---|

| JP2006012082A (ja) | 2006-01-12 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6505748B2 (ja) | 人間型ロボットとユーザーの間におけるマルチモード会話を実行する方法、前記方法を実装するコンピュータプログラム及び人間型ロボット | |

| EP3623118B1 (en) | Emotion recognizer, robot including the same, and server including the same | |

| KR100988708B1 (ko) | 학습 장치, 학습 방법 및 로봇 장치 | |

| JP7205148B2 (ja) | ロボット、制御方法、及び、プログラム | |

| JP4239635B2 (ja) | ロボット装置、その動作制御方法、及びプログラム | |

| US8315454B2 (en) | Robot apparatus and method of controlling the behavior thereof | |

| US7152050B2 (en) | Learning system capable of performing additional learning and robot apparatus | |

| JP4179230B2 (ja) | ロボット装置及びその動作制御方法 | |

| CN113056315B (zh) | 信息处理装置、信息处理方法和程序 | |

| JP7205533B2 (ja) | 情報処理装置及び情報処理方法、並びにロボット装置 | |

| JP2019175432A (ja) | 対話制御装置、対話システム、対話制御方法及びプログラム | |

| JP4600736B2 (ja) | ロボット制御装置および方法、記録媒体、並びにプログラム | |

| JP4635486B2 (ja) | 概念獲得装置及びその方法、並びにロボット装置及びその行動制御方法 | |

| JP4649913B2 (ja) | ロボット装置及びロボット装置の移動制御方法 | |

| JP4433273B2 (ja) | ロボット装置及びロボット装置の制御方法 | |

| JP4281286B2 (ja) | ロボット装置及びその制御方法 | |

| JP2003255990A (ja) | 対話処理装置及び方法並びにロボット装置 | |

| JP2005231012A (ja) | ロボット装置及びその制御方法 | |

| Bennewitz et al. | Enabling a humanoid robot to interact with multiple persons | |

| JP2003260681A (ja) | ロボット装置及びその制御方法 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20070614 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20100601 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20100723 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20100817 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20101008 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20101026 |

|

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20101108 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20131203 Year of fee payment: 3 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20131203 Year of fee payment: 3 |

|

| LAPS | Cancellation because of no payment of annual fees |