JP2015501441A - コンテキスト切り替えのための音声認識 - Google Patents

コンテキスト切り替えのための音声認識 Download PDFInfo

- Publication number

- JP2015501441A JP2015501441A JP2014535793A JP2014535793A JP2015501441A JP 2015501441 A JP2015501441 A JP 2015501441A JP 2014535793 A JP2014535793 A JP 2014535793A JP 2014535793 A JP2014535793 A JP 2014535793A JP 2015501441 A JP2015501441 A JP 2015501441A

- Authority

- JP

- Japan

- Prior art keywords

- context

- game

- application

- user

- contexts

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Ceased

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/16—Sound input; Sound output

- G06F3/167—Audio in a user interface, e.g. using voice commands for navigating, audio feedback

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

-

- A63F13/10—

-

- A63F13/12—

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/30—Interconnection arrangements between game servers and game devices; Interconnection arrangements between game devices; Interconnection arrangements between game servers

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/45—Controlling the progress of the video game

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS OR SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS OR SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

- G10L15/22—Procedures used during a speech recognition process, e.g. man-machine dialogue

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F2300/00—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game

- A63F2300/60—Methods for processing data by generating or executing the game program

- A63F2300/6045—Methods for processing data by generating or executing the game program for mapping control signals received from the input arrangement into game commands

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F2300/00—Features of games using an electronically generated display having two or more dimensions, e.g. on a television screen, showing representations related to the game

- A63F2300/60—Methods for processing data by generating or executing the game program

- A63F2300/6063—Methods for processing data by generating or executing the game program for sound processing

- A63F2300/6072—Methods for processing data by generating or executing the game program for sound processing of an input signal, e.g. pitch and rhythm extraction, voice recognition

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS OR SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

- G10L15/08—Speech classification or search

- G10L2015/088—Word spotting

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS OR SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

- G10L15/22—Procedures used during a speech recognition process, e.g. man-machine dialogue

- G10L2015/223—Execution procedure of a spoken command

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS OR SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

- G10L15/22—Procedures used during a speech recognition process, e.g. man-machine dialogue

- G10L2015/226—Procedures used during a speech recognition process, e.g. man-machine dialogue using non-speech characteristics

- G10L2015/228—Procedures used during a speech recognition process, e.g. man-machine dialogue using non-speech characteristics of application context

Abstract

Description

様々な実施形態が、コンテキスト切り替えのための音声認識を実装する技法を提供する。少なくとも一部の実施形態において、それらの技法は、音声コマンドによって、ユーザがアプリケーションの異なるコンテキスト及び/又はユーザ・インタフェースの間の切り替え行うことを可能にすることができる。例えばゲーム・アプリケーションは、異なるインタラクションのコンテキスト及び機能を提供する多様な異なるユーザ・インタフェースを含む可能性がある。一部のユーザ・インタフェースがゲーム・プレイ機能を提供する可能性がある一方、その他のユーザ・インタフェースはゲーム・カスタマイズ機能を提供する可能性がある。本明細書において検討される技法は、音声コマンドを発することによって様々なユーザ・インタフェースの間のナビゲーションをユーザが行うことを可能にすることができる。

図1は、1つ又は複数の実施形態による動作環境を全体的に100で示す。動作環境100は、様々な手法で構成され得るコンピューティング・デバイス102を含む。例えばコンピューティング・デバイス102を、限定ではなく例として、ゲーム・コンソール、デスクトップコンピュータ、ポータブルコンピュータ、携帯情報端末(PDA)のようなハンドヘルドコンピュータ、セル電話等の任意の好適なコンピューティング・デバイスとして具現化することができる。コンピューティング・デバイス102の1つの例示的な構成は、図7に示され、下記で説明される。

このセクションは、本明細書において検討される技法によって可能にされ得る例示的なコンテキスト切り替えのシナリオについて検討する。少なくとも一部の実施形態において、例示的なコンテキスト切り替えのシナリオは、上で検討された動作環境100及び/又は以下で検討される例示的なシステム600の態様によって実装され得る。したがって、例示的なコンテキスト切り替えのシナリオの特定の態様は、動作環境100及び/又は例示的なシステム600の特徴を参照して検討される。これは、例示のみを目的としており、例示的なコンテキスト切り替えのシナリオの態様を、特許請求される実施形態の趣旨及び範囲から逸脱することなく多様な異なる動作環境及びシステムで実装することができる。

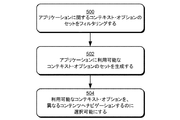

以下で検討されるのは、本明細書において検討される技法を実行するように実施され得るいくつかの方法である。方法の態様は、ハードウェア、ファームウェア又はソフトウェア、あるいはこれらの組合せで実装され得る。方法は、1つ又は複数のデバイスによって実行される動作を指定するブロックのセットとして示されるが、それぞれのブロックによる動作を実行するために示された順序に必ずしも限定されない。さらに、特定の方法に関して示される動作を、1つ又は複数の実装に従って、異なる方法の動作と組み合わされてもよく、及び/又は交換されてもよい。方法の態様を、環境100を参照して上で検討され、システム600を参照して以下で検討される様々なエンティティの間のインタラクションにより実装することができる。

図6は、コンピューティング・デバイス102を、複数のデバイスが中央コンピューティング・デバイスを通じて相互接続される環境で実装されるものとして示す、例示的なシステム600を図示している。中央コンピューティング・デバイスは、複数のデバイスに対してローカルであってよく、また複数のデバイスからリモートに配置されてもよい。一実施形態において、中央コンピューティング・デバイスは、ネットワーク又はインターネット又は他の手段を通じて複数のデバイスに接続される1つ又は複数のサーバ・コンピュータを含む「クラウド」のサーバ・ファームである。

様々な実施形態が、コンテキスト切り替えのための音声認識の技法を提供する。本主題を構造的特徴及び/又は方法的動作に特有の言葉で説明したが、添付の特許請求の範囲で定義される主題は、必ずしも上述の具体的な特徴又は動作に限定されないことを理解されたい。むしろ、上述の具体的な特徴及び動作は、特許請求の範囲を実装する例示的な形態として開示されている。

Claims (10)

- コンピュータにより実施される方法であって、

発話されたトリガ・ワードの認識に応答して、アプリケーションに関する第1のアプリケーション・コンテキストに関連するユーザ・インタフェースにコンテキスト・メニューを提示するステップであって、前記コンテキスト・メニューが、音声コマンドによってナビゲーションされ得る少なくとも1つの他のアプリケーション・コンテキストを含む、ステップと、

前記発話されたトリガ・ワードの前記認識の後の特定の時間間隔以内に、前記少なくとも1つの他のアプリケーション・コンテキストに関連するコンテキスト・ワードの音声入力を認識するステップと、

前記コンテキスト・ワードの前記音声入力の前記認識に応答して、前記第1のアプリケーション・コンテキストに関連する前記ユーザ・インタフェースから前記少なくとも1つの他のアプリケーション・コンテキストに関連するユーザ・インタフェースへナビゲーションするステップと

を含む、方法。 - 前記アプリケーションが、ゲーム・アプリケーションを含み、前記第1のアプリケーション・コンテキストに関連する前記ユーザ・インタフェースが、前記少なくとも1つの他のアプリケーション・コンテキストに関連する前記ユーザ・インタフェースが含むゲーム機能のセットとは異なるゲーム機能のセットを含む、請求項1に記載の方法。

- 前記提示するステップが、1つ又は複数のコンテキスト固有の基準に基づいてアプリケーション・コンテキストのセットをフィルタリングして、前記少なくとも1つの他のアプリケーション・コンテキストを決定するステップを含む、請求項1に記載の方法。

- 前記コンテキスト固有の基準が、前記アプリケーションの属性、前記アプリケーションが実行されているデバイスの属性又は前記デバイスのユーザの属性、のうちの1つ又は複数を含む、請求項3に記載の方法。

- 前記ナビゲーションするステップが、ユーザからの追加の入力とは無関係に、前記コンテキスト・ワードの前記音声入力の前記認識に応答して行われる、請求項1に記載の方法。

- ゲーム・アプリケーションを備えた1つ又は複数のコンピュータ読取可能記憶媒体であって、前記ゲーム・アプリケーションは、コンピューティング・デバイスによって実行されると、該コンピューティング・デバイスに、

前記ゲーム・アプリケーションの第1のゲーム・コンテキストに関連するユーザ・インタフェースが表示されている間に、トリガ・ワードの音声入力の指示を受信させ、

前記ゲーム・アプリケーションに関する1つ又は複数のフィルタリング基準を使用してゲーム・コンテキストのセットをフィルタリングして、1つ又は複数の利用可能なゲーム・コンテキストのセットを生成させ、

前記1つ又は複数の利用可能なゲーム・コンテキストのセットを、前記第1のゲーム・コンテキストに関連する前記ユーザ・インタフェースの一部として表示させ、

追加のユーザ入力とは無関係に、前記利用可能なゲーム・コンテキストの1つ又は複数についての音声での選択の指示に応答して、前記ゲーム・アプリケーションの第2のゲーム・コンテキストに関連するユーザ・インタフェースへナビゲーションさせる、

1つ又は複数のコンピュータ読取可能記憶媒体。 - 前記第1のゲーム・コンテキスト又は前記第2のゲーム・コンテキストのうちの一方が、ゲーム・カスタマイズ機能に関連付けられ、前記第1のゲーム・コンテキスト又は前記第2のゲーム・コンテキストのうちの他方が、ゲーム・プレイ機能に関連付けられる、請求項6に記載の1つ又は複数のコンピュータ読取可能記憶媒体。

- 前記フィルタリング基準が、前記コンピューティング・デバイスの属性又は前記コンピューティング・デバイスのユーザの属性、のうちの1つ又は複数に基づく、請求項6に記載の1つ又は複数のコンピュータ読取可能記憶媒体。

- 前記フィルタリング基準が、前記コンピューティング・デバイスのネットワーク接続性のステータスを含む、請求項6に記載の1つ又は複数のコンピュータ読取可能記憶媒体。

- 前記フィルタリング基準が、ユーザに関連する前記ゲーム・アプリケーションに関するアカウント会員レベル、前記ユーザに関連するアクセス許可又は前記ユーザの年齢のうちの1つ又は複数を含む、請求項6に記載の1つ又は複数のコンピュータ読取可能記憶媒体。

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US13/270,018 US9256396B2 (en) | 2011-10-10 | 2011-10-10 | Speech recognition for context switching |

| US13/270,018 | 2011-10-10 | ||

| PCT/US2012/059410 WO2013055709A1 (en) | 2011-10-10 | 2012-10-10 | Speech recognition for context switching |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2015501441A true JP2015501441A (ja) | 2015-01-15 |

| JP2015501441A5 JP2015501441A5 (ja) | 2015-11-05 |

Family

ID=47968193

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2014535793A Ceased JP2015501441A (ja) | 2011-10-10 | 2012-10-10 | コンテキスト切り替えのための音声認識 |

Country Status (7)

| Country | Link |

|---|---|

| US (1) | US9256396B2 (ja) |

| EP (1) | EP2766791B1 (ja) |

| JP (1) | JP2015501441A (ja) |

| KR (1) | KR102078889B1 (ja) |

| CN (1) | CN103019535B (ja) |

| TW (1) | TWI601128B (ja) |

| WO (1) | WO2013055709A1 (ja) |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2021182168A (ja) * | 2016-01-06 | 2021-11-25 | グーグル エルエルシーGoogle LLC | 音声認識システム |

Families Citing this family (34)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US9737796B2 (en) | 2009-07-08 | 2017-08-22 | Steelseries Aps | Apparatus and method for managing operations of accessories in multi-dimensions |

| US8719714B2 (en) | 2009-07-08 | 2014-05-06 | Steelseries Aps | Apparatus and method for managing operations of accessories |

| US9604147B2 (en) | 2013-03-15 | 2017-03-28 | Steelseries Aps | Method and apparatus for managing use of an accessory |

| US9687730B2 (en) | 2013-03-15 | 2017-06-27 | Steelseries Aps | Gaming device with independent gesture-sensitive areas |

| US9423874B2 (en) | 2013-03-15 | 2016-08-23 | Steelseries Aps | Gaming accessory with sensory feedback device |

| JP6229287B2 (ja) * | 2013-04-03 | 2017-11-15 | ソニー株式会社 | 情報処理装置、情報処理方法及びコンピュータプログラム |

| US9530410B1 (en) | 2013-04-09 | 2016-12-27 | Google Inc. | Multi-mode guard for voice commands |

| US20140329589A1 (en) * | 2013-05-03 | 2014-11-06 | Steelseries Aps | Method and apparatus for configuring a gaming environment |

| CN105122181B (zh) * | 2013-05-16 | 2018-12-18 | 英特尔公司 | 用于基于情景的自然用户接口输入的技术 |

| US9384013B2 (en) * | 2013-06-03 | 2016-07-05 | Microsoft Technology Licensing, Llc | Launch surface control |

| US9747899B2 (en) * | 2013-06-27 | 2017-08-29 | Amazon Technologies, Inc. | Detecting self-generated wake expressions |

| CN103442138A (zh) * | 2013-08-26 | 2013-12-11 | 华为终端有限公司 | 语音控制方法、装置及终端 |

| US9720567B2 (en) | 2014-02-17 | 2017-08-01 | Microsoft Technology Licensing, Llc | Multitasking and full screen menu contexts |

| US9082407B1 (en) * | 2014-04-15 | 2015-07-14 | Google Inc. | Systems and methods for providing prompts for voice commands |

| ES2703338T3 (es) * | 2014-04-17 | 2019-03-08 | Softbank Robotics Europe | Ejecución de aplicaciones de software en un robot |

| CN104225916A (zh) * | 2014-09-25 | 2014-12-24 | 苏州乐聚一堂电子科技有限公司 | 尖锐声音感应游戏系统 |

| JP6229071B2 (ja) | 2014-10-24 | 2017-11-08 | 株式会社ソニー・インタラクティブエンタテインメント | 制御装置、制御方法、プログラム及び情報記憶媒体 |

| CN107077846B (zh) * | 2014-10-24 | 2021-03-16 | 索尼互动娱乐股份有限公司 | 控制装置、控制方法、程序和信息存储介质 |

| US10293260B1 (en) * | 2015-06-05 | 2019-05-21 | Amazon Technologies, Inc. | Player audio analysis in online gaming environments |

| US10019992B2 (en) * | 2015-06-29 | 2018-07-10 | Disney Enterprises, Inc. | Speech-controlled actions based on keywords and context thereof |

| US20170315849A1 (en) * | 2016-04-29 | 2017-11-02 | Microsoft Technology Licensing, Llc | Application target event synthesis |

| US11416212B2 (en) * | 2016-05-17 | 2022-08-16 | Microsoft Technology Licensing, Llc | Context-based user agent |

| CN106205612B (zh) * | 2016-07-08 | 2019-12-24 | 北京光年无限科技有限公司 | 面向智能机器人的信息处理方法及系统 |

| US10845956B2 (en) * | 2017-05-31 | 2020-11-24 | Snap Inc. | Methods and systems for voice driven dynamic menus |

| US10547708B2 (en) | 2017-10-25 | 2020-01-28 | International Business Machines Corporation | Adding conversation context from detected audio to contact records |

| CN111627436B (zh) * | 2018-05-14 | 2023-07-04 | 北京字节跳动网络技术有限公司 | 一种语音控制的方法及装置 |

| US11134308B2 (en) | 2018-08-06 | 2021-09-28 | Sony Corporation | Adapting interactions with a television user |

| KR102563314B1 (ko) * | 2018-08-30 | 2023-08-04 | 삼성전자주식회사 | 전자 장치 및 단축 명령어의 바로가기 생성 방법 |

| CN109788360A (zh) * | 2018-12-12 | 2019-05-21 | 百度在线网络技术(北京)有限公司 | 基于语音的电视控制方法和装置 |

| CN109847348B (zh) * | 2018-12-27 | 2022-09-27 | 努比亚技术有限公司 | 一种操作界面的操控方法及移动终端、存储介质 |

| US11367444B2 (en) | 2020-01-07 | 2022-06-21 | Rovi Guides, Inc. | Systems and methods for using conjunctions in a voice input to cause a search application to wait for additional inputs |

| US11604830B2 (en) * | 2020-01-07 | 2023-03-14 | Rovi Guides, Inc. | Systems and methods for performing a search based on selection of on-screen entities and real-world entities |

| CN112397069A (zh) * | 2021-01-19 | 2021-02-23 | 成都启英泰伦科技有限公司 | 一种语音遥控方法及装置 |

| CN114121013A (zh) * | 2021-12-07 | 2022-03-01 | 杭州逗酷软件科技有限公司 | 语音控制方法、装置、电子设备及存储介质 |

Citations (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2000076085A (ja) * | 1998-08-28 | 2000-03-14 | Nec Software Kobe Ltd | 情報処理装置とリソース不足通知方法および記録媒体 |

| JP2000148177A (ja) * | 1998-11-06 | 2000-05-26 | Harness Syst Tech Res Ltd | 車載用操作入力装置および入力方法 |

| JP2001083991A (ja) * | 1999-09-16 | 2001-03-30 | Denso Corp | ユーザインタフェース装置、ナビゲーションシステム、情報処理装置及び記録媒体 |

| JP2008514111A (ja) * | 2004-09-20 | 2008-05-01 | ソニー エリクソン モバイル コミュニケーションズ, エービー | 正確なケイパビリティ・インディケータを移動電話ユーザに供給する方法 |

| US20090150782A1 (en) * | 2007-12-06 | 2009-06-11 | Dreamer | Method for displaying menu based on service environment analysis in content execution apparatus |

Family Cites Families (41)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US4984177A (en) * | 1988-02-05 | 1991-01-08 | Advanced Products And Technologies, Inc. | Voice language translator |

| GB2310970A (en) * | 1996-03-05 | 1997-09-10 | Ibm | Voice mail on the Internet |

| US6021403A (en) | 1996-07-19 | 2000-02-01 | Microsoft Corporation | Intelligent user assistance facility |

| US7085710B1 (en) * | 1998-01-07 | 2006-08-01 | Microsoft Corporation | Vehicle computer system audio entertainment system |

| TW495710B (en) * | 1998-10-15 | 2002-07-21 | Primax Electronics Ltd | Voice control module for control of game controller |

| JP2000181676A (ja) * | 1998-12-11 | 2000-06-30 | Nintendo Co Ltd | 画像処理装置 |

| US6937984B1 (en) * | 1998-12-17 | 2005-08-30 | International Business Machines Corporation | Speech command input recognition system for interactive computer display with speech controlled display of recognized commands |

| US6862347B1 (en) * | 1999-01-28 | 2005-03-01 | Siemens Communications, Inc. | Method and apparatus for extending a telephone's capabilities |

| US6554707B1 (en) | 1999-09-24 | 2003-04-29 | Nokia Corporation | Interactive voice, wireless game system using predictive command input |

| JP3343099B2 (ja) * | 2000-03-08 | 2002-11-11 | 株式会社コナミコンピュータエンタテインメント大阪 | キャラクタ育成制御プログラムを記録したコンピュータ読み取り可能な記録媒体 |

| US6785653B1 (en) | 2000-05-01 | 2004-08-31 | Nuance Communications | Distributed voice web architecture and associated components and methods |

| US20020023265A1 (en) | 2000-08-08 | 2002-02-21 | Metcalf Darrell J. | Wireless controller with publicly-accessible communications link for controlling the content seen on large-screen systems |

| US7162426B1 (en) * | 2000-10-02 | 2007-01-09 | Xybernaut Corporation | Computer motherboard architecture with integrated DSP for continuous and command and control speech processing |

| GB2372864B (en) | 2001-02-28 | 2005-09-07 | Vox Generation Ltd | Spoken language interface |

| US7085722B2 (en) | 2001-05-14 | 2006-08-01 | Sony Computer Entertainment America Inc. | System and method for menu-driven voice control of characters in a game environment |

| WO2002099597A2 (en) | 2001-06-07 | 2002-12-12 | Unwired Express, Inc. | Method and system for providing context awareness |

| US7369997B2 (en) * | 2001-08-01 | 2008-05-06 | Microsoft Corporation | Controlling speech recognition functionality in a computing device |

| EP1604350A4 (en) | 2002-09-06 | 2007-11-21 | Voice Signal Technologies Inc | METHODS, SYSTEMS AND PROGRAMMING FOR REALIZING VOICE RECOGNITION |

| US7720683B1 (en) * | 2003-06-13 | 2010-05-18 | Sensory, Inc. | Method and apparatus of specifying and performing speech recognition operations |

| JP2005080385A (ja) * | 2003-08-29 | 2005-03-24 | Toshiba Corp | 情報処理装置及び情報処理装置のバッテリ残容量表示方法 |

| US20060041926A1 (en) | 2004-04-30 | 2006-02-23 | Vulcan Inc. | Voice control of multimedia content |

| US8109765B2 (en) * | 2004-09-10 | 2012-02-07 | Scientific Learning Corporation | Intelligent tutoring feedback |

| US8825482B2 (en) * | 2005-09-15 | 2014-09-02 | Sony Computer Entertainment Inc. | Audio, video, simulation, and user interface paradigms |

| EP1857930A3 (en) | 2006-05-17 | 2008-07-23 | Ipreo Holdings LLC | System, method, and apparatus to allow for a design, administration, and presentation of computer software applications |

| US8751672B2 (en) * | 2006-06-21 | 2014-06-10 | Verizon Data Services Llc | Personal video channels |

| WO2008084575A1 (ja) * | 2006-12-28 | 2008-07-17 | Mitsubishi Electric Corporation | 車載用音声認識装置 |

| US7822608B2 (en) | 2007-02-27 | 2010-10-26 | Nuance Communications, Inc. | Disambiguating a speech recognition grammar in a multimodal application |

| US8538757B2 (en) | 2007-05-17 | 2013-09-17 | Redstart Systems, Inc. | System and method of a list commands utility for a speech recognition command system |

| US20090013275A1 (en) | 2007-07-05 | 2009-01-08 | Darrell May | System and method for quick view of application data on a home screen interface triggered by a scroll/focus action |

| US8825468B2 (en) * | 2007-07-31 | 2014-09-02 | Kopin Corporation | Mobile wireless display providing speech to speech translation and avatar simulating human attributes |

| US8140335B2 (en) * | 2007-12-11 | 2012-03-20 | Voicebox Technologies, Inc. | System and method for providing a natural language voice user interface in an integrated voice navigation services environment |

| US8117551B2 (en) | 2007-12-18 | 2012-02-14 | International Business Machines Corporation | Computer system and method of using presence visualizations of avatars as persistable virtual contact objects |

| US8358302B2 (en) | 2008-04-22 | 2013-01-22 | International Business Machines Corporation | Dynamic creation of virtual regions |

| US8224653B2 (en) * | 2008-12-19 | 2012-07-17 | Honeywell International Inc. | Method and system for operating a vehicular electronic system with categorized voice commands |

| US8196174B2 (en) * | 2008-12-23 | 2012-06-05 | At&T Intellectual Property I, L.P. | Navigation method and system to provide a navigation interface |

| US10540976B2 (en) * | 2009-06-05 | 2020-01-21 | Apple Inc. | Contextual voice commands |

| KR101612788B1 (ko) | 2009-11-05 | 2016-04-18 | 엘지전자 주식회사 | 이동 단말기 및 그 제어 방법 |

| US8676581B2 (en) * | 2010-01-22 | 2014-03-18 | Microsoft Corporation | Speech recognition analysis via identification information |

| US8700594B2 (en) * | 2011-05-27 | 2014-04-15 | Microsoft Corporation | Enabling multidimensional search on non-PC devices |

| US8657680B2 (en) * | 2011-05-31 | 2014-02-25 | United Video Properties, Inc. | Systems and methods for transmitting media associated with a measure of quality based on level of game play in an interactive video gaming environment |

| US9037601B2 (en) * | 2011-07-27 | 2015-05-19 | Google Inc. | Conversation system and method for performing both conversation-based queries and message-based queries |

-

2011

- 2011-10-10 US US13/270,018 patent/US9256396B2/en active Active

-

2012

- 2012-09-10 TW TW101133009A patent/TWI601128B/zh not_active IP Right Cessation

- 2012-10-09 CN CN201210380861.8A patent/CN103019535B/zh active Active

- 2012-10-10 KR KR1020147012404A patent/KR102078889B1/ko active IP Right Grant

- 2012-10-10 WO PCT/US2012/059410 patent/WO2013055709A1/en active Application Filing

- 2012-10-10 EP EP12839330.3A patent/EP2766791B1/en active Active

- 2012-10-10 JP JP2014535793A patent/JP2015501441A/ja not_active Ceased

Patent Citations (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2000076085A (ja) * | 1998-08-28 | 2000-03-14 | Nec Software Kobe Ltd | 情報処理装置とリソース不足通知方法および記録媒体 |

| JP2000148177A (ja) * | 1998-11-06 | 2000-05-26 | Harness Syst Tech Res Ltd | 車載用操作入力装置および入力方法 |

| JP2001083991A (ja) * | 1999-09-16 | 2001-03-30 | Denso Corp | ユーザインタフェース装置、ナビゲーションシステム、情報処理装置及び記録媒体 |

| JP2008514111A (ja) * | 2004-09-20 | 2008-05-01 | ソニー エリクソン モバイル コミュニケーションズ, エービー | 正確なケイパビリティ・インディケータを移動電話ユーザに供給する方法 |

| US20090150782A1 (en) * | 2007-12-06 | 2009-06-11 | Dreamer | Method for displaying menu based on service environment analysis in content execution apparatus |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2021182168A (ja) * | 2016-01-06 | 2021-11-25 | グーグル エルエルシーGoogle LLC | 音声認識システム |

Also Published As

| Publication number | Publication date |

|---|---|

| TW201320057A (zh) | 2013-05-16 |

| CN103019535A (zh) | 2013-04-03 |

| US20130090930A1 (en) | 2013-04-11 |

| EP2766791A1 (en) | 2014-08-20 |

| EP2766791B1 (en) | 2017-05-31 |

| WO2013055709A1 (en) | 2013-04-18 |

| CN103019535B (zh) | 2016-12-21 |

| US9256396B2 (en) | 2016-02-09 |

| KR20140082790A (ko) | 2014-07-02 |

| TWI601128B (zh) | 2017-10-01 |

| EP2766791A4 (en) | 2015-03-18 |

| KR102078889B1 (ko) | 2020-04-02 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP2015501441A (ja) | コンテキスト切り替えのための音声認識 | |

| CN109196464B (zh) | 基于上下文的用户代理 | |

| US9542949B2 (en) | Satisfying specified intent(s) based on multimodal request(s) | |

| CN108369456B (zh) | 用于触摸输入设备的触觉反馈 | |

| US8286106B2 (en) | System and method for interacting with status information on a touch screen device | |

| US9432314B2 (en) | Quick navigation of message conversation history | |

| KR101885680B1 (ko) | 이머시브 애플리케이션으로서의 데스크탑 | |

| WO2018040010A1 (zh) | 一种应用界面显示方法以及终端设备 | |

| US20140210710A1 (en) | Method for generating an augmented reality content and terminal using the same | |

| US9720567B2 (en) | Multitasking and full screen menu contexts | |

| KR20180006966A (ko) | 써드 파티 애플리케이션으로의 디지털 어시스턴트 확장성 | |

| JP2014523056A (ja) | オンデマンドタブ回復 | |

| KR101895646B1 (ko) | 이머시브 쉘 및 애플리케이션 쉘의 디스플레이 | |

| JP2017523515A (ja) | アイコンサイズ変更 | |

| US11138956B2 (en) | Method for controlling display of terminal, storage medium, and electronic device | |

| JP2013528304A (ja) | ジャンプ、チェックマーク、および取消し線のジェスチャー | |

| US20150058770A1 (en) | Method and appratus for providing always-on-top user interface for mobile application | |

| CN105389173A (zh) | 一种基于长连接任务的界面切换展示方法及装置 | |

| US10986050B2 (en) | Method and apparatus for providing in-game messenger service | |

| CN105099871A (zh) | 用于即时通信应用的通知方法和装置 | |

| JP2014517974A (ja) | ページ重視の、タッチ又はジェスチャに基づくブラウジング経験を支援するナビゲーションユーザインターフェース | |

| KR20160144445A (ko) | 확장가능한 애플리케이션 표시, 마일스톤, 및 스토리라인 | |

| KR102086181B1 (ko) | 제어 노출 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A711 | Notification of change in applicant |

Free format text: JAPANESE INTERMEDIATE CODE: A711 Effective date: 20150523 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20150914 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20150914 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20160927 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20161004 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20161228 |

|

| A02 | Decision of refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A02 Effective date: 20170321 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20170719 |

|

| A911 | Transfer to examiner for re-examination before appeal (zenchi) |

Free format text: JAPANESE INTERMEDIATE CODE: A911 Effective date: 20170727 |

|

| A912 | Re-examination (zenchi) completed and case transferred to appeal board |

Free format text: JAPANESE INTERMEDIATE CODE: A912 Effective date: 20170825 |

|

| A045 | Written measure of dismissal of application [lapsed due to lack of payment] |

Free format text: JAPANESE INTERMEDIATE CODE: A045 Effective date: 20181218 |