JP2013168146A - 実物体のテクスチャ描写を生成する方法、装置、およびシステム - Google Patents

実物体のテクスチャ描写を生成する方法、装置、およびシステム Download PDFInfo

- Publication number

- JP2013168146A JP2013168146A JP2013024297A JP2013024297A JP2013168146A JP 2013168146 A JP2013168146 A JP 2013168146A JP 2013024297 A JP2013024297 A JP 2013024297A JP 2013024297 A JP2013024297 A JP 2013024297A JP 2013168146 A JP2013168146 A JP 2013168146A

- Authority

- JP

- Japan

- Prior art keywords

- image

- real object

- posture

- support

- texture

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T15/00—3D [Three Dimensional] image rendering

- G06T15/04—Texture mapping

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T15/00—3D [Three Dimensional] image rendering

- G06T15/50—Lighting effects

- G06T15/506—Illumination models

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2200/00—Indexing scheme for image data processing or generation, in general

- G06T2200/08—Indexing scheme for image data processing or generation, in general involving all processing steps from image acquisition to 3D model generation

Abstract

【解決手段】光源を起動させるコマンドがコンピュータによって発行され(300)、画像を取得するためのコマンドが、コンピュータによって画像取得装置に対して発行され(305)、任意の姿勢の前記実物体を描写する第一画像を受信(310)した後、および前記任意の姿勢と同一の姿勢の前記実物体を描写する第二画像を取得(320、325、330、335)した後、前記第二画像は前記任意の姿勢の前記実物体の透明度を表しており、前記テクスチャ描写は前記第一および第二画像を組み合わせることによって生成される。

【選択図】図3

Description

−任意の姿勢の前記実物体を描写する第一画像を受信するステップと、

−前記任意の姿勢と同一の姿勢の前記実物体を描写する第二画像を取得するステップであって、前記第二画像は前記任意の姿勢の前記実物体の透明度を表している、ステップと、

−前記第一および第二画像を組み合わせることによって、前記テクスチャ描写を生成するステップ、とを含む。

−前記画像取得装置に接続され、以下のステップの各々を実行するように構成された、データ処理装置:

・任意の姿勢の前記実物体を描写する第一画像を受信するステップと、

・前記任意の姿勢と同一の姿勢の前記実物体を描写する第二画像を取得するステップであって、前記第二画像は前記任意の姿勢の前記実物体の透明度を表している、ステップと、

・前記第一および第二画像を組み合わせることによって、前記テクスチャ描写を生成するステップ。

そして閾値化は好ましくは、たとえば以下の関係にしたがって実行される(ステップ330);

−中央処理装置(CPU)またはマイクロプロセッサ504と、

−オペレーティングシステムおよび「Prog」などのプログラムを包含することができる読み出し専用メモリ(ROM)506と、

−上述のプログラムの実行中に作成および修正された変数およびパラメータを保存することが可能なレジスタを包含する、ランダム・アクセス・メモリ(RAM)またはキャッシュメモリ508と、である。

−たとえばインターネット等の通信ネットワーク528に接続された通信インターフェース526であって、データを送受信することが可能なインターフェース526と、

−画面516に接続されたグラフィックスカード514と、

−上述のプログラム「Prog」および本発明によって処理済みのまたは処理されるデータを含むことができるハードディスク520と、

−本発明によるプログラムとユーザが対話できるようにする、キーボード522およびマウス524、またはライトペン、タッチ画面、またはリモコンなどその他のポインティングデバイスと、

−本発明によって処理済みのまたは処理されるデータの読み出しまたは書き込みが可能なメモリ・カード・リーダ(図示せず)。

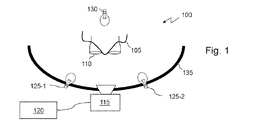

105 支持体

110 眼鏡

115 画像取得装置

120 コンピュータ

125−1、125−2、130 光源

135 サイクロラマ

200 顔

205、210−1、210−2、215、220−1、220−2 静止点

400、405、410、415、420 画像

500 データ処理装置

502 通信バス

504 中央処理装置、マイクロプロセッサ

506 読み出し専用メモリ

508 ランダム・アクセス・メモリ、キャッシュメモリ

514 グラフィックスカード

516 画面

520 ハードディスク

522 キーボード

524 マウス

526 通信インターフェース

528 通信ネットワーク

Claims (14)

- 画像取得装置(115)に結合されたデータ処理装置(120)を含むシステム内で実物体(110)のテクスチャ描写を生成する方法であって、

任意の姿勢の前記実物体を描写する第一画像を受信するステップ(310)と、

前記任意の姿勢と同一の姿勢の前記実物体を描写する第二画像を取得するステップであって、前記第二画像は前記任意の姿勢の前記実物体の透明度を表している、ステップ(315、320、325、330)と、

前記第一および第二画像を組み合わせることによって、前記テクスチャ描写を生成するステップ(335)と、を含むことを特徴とする、方法。 - 前記第一および第二画像の前記組み合わせが、前記第一および第二画像の点同士の組み合わせである、請求項1に記載の方法。

- 前記任意の姿勢と同一の姿勢の前記実物体を表す第三画像を受信するステップをさらに含み、前記第三画像は、結果的に前記第一画像を生じた照明条件とは異なる照明条件の下で生成され、前記第二画像は前記第三画像を処理することによって取得される、請求項1または請求項2に記載の方法。

- 前記処理が、前記第三画像の各点の成分または成分の組み合わせのフィルタリング(320)、反転(325)、および閾値化(330)のステップのうちの少なくとも1つを含む、請求項3に記載の方法。

- 前記第一画像を結果的に生じた前記照明条件が前記実物体の前方照明を可能にし、前記第三画像を結果的に生じた前記照明条件は前記実物体の背面照明を可能にする、請求項3または請求項4に記載の方法。

- 光源の選択的な起動を制御するステップをさらに含む、請求項1から5のいずれか一項に記載の方法。

- 前記画像のうちの少なくとも1つの取得を命令するステップをさらに含む、請求項1から6のいずれか一項に記載の方法。

- コンピュータ上でこのプログラムが実行されるときに、請求項1から7のいずれか一項に記載の方法の各ステップを実行するのに適した命令を含む、コンピュータプログラム。

- 請求項1から7のいずれか一項に記載の方法の各ステップを実行するのに適した手段を含む装置。

- 実物体(110)の画像から前記実物体のテクスチャ描写を生成するシステムであって、

画像取得装置(115)と、

前記画像取得装置に接続され、

任意の姿勢の前記実物体を描写する第一画像を受信するステップ(310)と、

前記任意の姿勢と同一の姿勢の前記実物体を描写する第二画像を取得するステップであって、前記第二画像は前記任意の姿勢の前記実物体の透明度を表しているステップ(315、320、325、330)と、

前記第一および第二画像を組み合わせることによって前記テクスチャ描写を生成するステップ(340)と、

の各々を実行するように構成されたデータ処理装置(120)と、を含むことを特徴とする、システム。 - 前記実物体を受容するのに適した支持体をさらに含み、前記支持体は、使用中のものと類似の姿勢にある前記実物体を提示するように構成されている、請求項10に記載のシステム。

- 少なくとも2つの群に分配された複数の光源をさらに含み、第一群からの少なくとも1つの光源は、第二群からの少なくとも1つの光源とは無関係に起動することが可能である、請求項10または請求項11に記載のシステム。

- 前記データ処理装置が、前記第一群からの少なくとも1つの光源および前記第二群からの少なくとも1つの光源を、順次起動するように構成されている、請求項12に記載のシステム。

- 前記第一画像の前記実物体上の反射を生成するように構成されたサイクロラマ(135)をさらに含む、請求項10から13のいずれか一項に記載のシステム。

Applications Claiming Priority (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| FR1251341 | 2012-02-13 | ||

| FR1251341A FR2986892B1 (fr) | 2012-02-13 | 2012-02-13 | Procede, dispositif et systeme de generation d'une representation texturee d'un objet reel |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2013168146A true JP2013168146A (ja) | 2013-08-29 |

| JP2013168146A5 JP2013168146A5 (ja) | 2016-03-31 |

Family

ID=47594591

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2013024297A Pending JP2013168146A (ja) | 2012-02-13 | 2013-02-12 | 実物体のテクスチャ描写を生成する方法、装置、およびシステム |

Country Status (4)

| Country | Link |

|---|---|

| US (1) | US20140043332A1 (ja) |

| EP (1) | EP2626838A1 (ja) |

| JP (1) | JP2013168146A (ja) |

| FR (1) | FR2986892B1 (ja) |

Families Citing this family (8)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US8689255B1 (en) | 2011-09-07 | 2014-04-01 | Imdb.Com, Inc. | Synchronizing video content with extrinsic data |

| US9113128B1 (en) | 2012-08-31 | 2015-08-18 | Amazon Technologies, Inc. | Timeline interface for video content |

| US8955021B1 (en) | 2012-08-31 | 2015-02-10 | Amazon Technologies, Inc. | Providing extrinsic data for video content |

| US9389745B1 (en) | 2012-12-10 | 2016-07-12 | Amazon Technologies, Inc. | Providing content via multiple display devices |

| US10424009B1 (en) * | 2013-02-27 | 2019-09-24 | Amazon Technologies, Inc. | Shopping experience using multiple computing devices |

| US11019300B1 (en) | 2013-06-26 | 2021-05-25 | Amazon Technologies, Inc. | Providing soundtrack information during playback of video content |

| US9838740B1 (en) | 2014-03-18 | 2017-12-05 | Amazon Technologies, Inc. | Enhancing video content with personalized extrinsic data |

| FR3111451B1 (fr) | 2020-06-12 | 2022-11-11 | Acep Trylive | Dispositif et procédé pour l’acquisition d’images d’une paire de lunettes |

Citations (6)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPS61289786A (ja) * | 1985-06-18 | 1986-12-19 | Asahi Glass Co Ltd | メガネフレ−ムのデ−タ取り込み方法 |

| US4893447A (en) * | 1988-02-01 | 1990-01-16 | Opp Ronald E | Cyclorama construction |

| JP2000099553A (ja) * | 1998-09-21 | 2000-04-07 | Nippon Telegr & Teleph Corp <Ntt> | 眼鏡画像生成方法及び装置ならびにその方法を記録した記録媒体 |

| JP2003230036A (ja) * | 2002-01-31 | 2003-08-15 | Vision Megane:Kk | メガネ画像撮影装置 |

| JP2003295132A (ja) * | 2002-04-02 | 2003-10-15 | Yappa Corp | 3d画像による眼鏡自動選定システム |

| JP2007128096A (ja) * | 1999-12-17 | 2007-05-24 | Takeshi Saigo | 光沢性被写体撮影方法、眼鏡フレームの撮影方法及び眼鏡フレームの電子的カタログ作成方法 |

Family Cites Families (6)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US6903738B2 (en) * | 2002-06-17 | 2005-06-07 | Mitsubishi Electric Research Laboratories, Inc. | Image-based 3D modeling rendering system |

| WO2005124660A2 (en) * | 2004-06-12 | 2005-12-29 | University Of Southern California | Performance relighting and reflectance transformation with time-multiplexed illumination |

| JP4660254B2 (ja) * | 2005-04-08 | 2011-03-30 | 株式会社東芝 | 描画方法及び描画装置 |

| GB2473503B (en) * | 2009-09-15 | 2015-02-11 | Metail Ltd | System and method for image processing |

| FR2955409B1 (fr) * | 2010-01-18 | 2015-07-03 | Fittingbox | Procede d'integration d'un objet virtuel dans des photographies ou video en temps reel |

| US8988422B1 (en) * | 2010-12-17 | 2015-03-24 | Disney Enterprises, Inc. | System and method for augmenting hand animation with three-dimensional secondary motion |

-

2012

- 2012-02-13 FR FR1251341A patent/FR2986892B1/fr not_active Expired - Fee Related

- 2012-11-26 US US13/685,134 patent/US20140043332A1/en not_active Abandoned

-

2013

- 2013-01-29 EP EP13152973.7A patent/EP2626838A1/fr not_active Ceased

- 2013-02-12 JP JP2013024297A patent/JP2013168146A/ja active Pending

Patent Citations (6)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPS61289786A (ja) * | 1985-06-18 | 1986-12-19 | Asahi Glass Co Ltd | メガネフレ−ムのデ−タ取り込み方法 |

| US4893447A (en) * | 1988-02-01 | 1990-01-16 | Opp Ronald E | Cyclorama construction |

| JP2000099553A (ja) * | 1998-09-21 | 2000-04-07 | Nippon Telegr & Teleph Corp <Ntt> | 眼鏡画像生成方法及び装置ならびにその方法を記録した記録媒体 |

| JP2007128096A (ja) * | 1999-12-17 | 2007-05-24 | Takeshi Saigo | 光沢性被写体撮影方法、眼鏡フレームの撮影方法及び眼鏡フレームの電子的カタログ作成方法 |

| JP2003230036A (ja) * | 2002-01-31 | 2003-08-15 | Vision Megane:Kk | メガネ画像撮影装置 |

| JP2003295132A (ja) * | 2002-04-02 | 2003-10-15 | Yappa Corp | 3d画像による眼鏡自動選定システム |

Non-Patent Citations (1)

| Title |

|---|

| 荻原和浩, 外1名: ""ベジェ曲面によるメガネの形状表現とそのメガネオーダメイドシステムへの応用"", 情報処理学会論文誌, vol. 第36巻, 第11号, JPN6016048445, 15 November 1995 (1995-11-15), JP, pages 2642 - 2652, ISSN: 0003460914 * |

Also Published As

| Publication number | Publication date |

|---|---|

| FR2986892A1 (fr) | 2013-08-16 |

| EP2626838A1 (fr) | 2013-08-14 |

| US20140043332A1 (en) | 2014-02-13 |

| FR2986892B1 (fr) | 2014-12-26 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| US11189104B2 (en) | Generating 3D data in a messaging system | |

| US11961189B2 (en) | Providing 3D data for messages in a messaging system | |

| US11694392B2 (en) | Environment synthesis for lighting an object | |

| US10068369B2 (en) | Method and apparatus for selectively integrating sensory content | |

| JP2013168146A (ja) | 実物体のテクスチャ描写を生成する方法、装置、およびシステム | |

| JP6246757B2 (ja) | 現実環境の視野におけるバーチャルオブジェクトを表現方法及びシステム | |

| AU2018214005A1 (en) | Systems and methods for generating a 3-D model of a virtual try-on product | |

| US11462000B2 (en) | Image-based detection of surfaces that provide specular reflections and reflection modification | |

| US11825065B2 (en) | Effects for 3D data in a messaging system | |

| KR20180108709A (ko) | 사용자의 현실적인 신체 모델에 가상으로 옷을 입혀보는 방법 | |

| KR20220051376A (ko) | 메시징 시스템에서의 3d 데이터 생성 | |

| CN111066026B (zh) | 用于向图像数据提供虚拟光调节的技术 | |

| US11727654B2 (en) | Ambient light based mixed reality object rendering | |

| CN110866966A (zh) | 利用与环境相匹配的逼真表面属性渲染虚拟对象 | |

| US20220277512A1 (en) | Generation apparatus, generation method, system, and storage medium | |

| CN109447931B (zh) | 图像处理方法及装置 | |

| JP2013164850A (ja) | 類似および所定の特徴を有する実在モデルから三次元描写を作成するシステム | |

| US10964056B1 (en) | Dense-based object tracking using multiple reference images | |

| GB2593702A (en) | Method and system for eyewear fitting |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20160210 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20160210 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20161205 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20161220 |

|

| A02 | Decision of refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A02 Effective date: 20170711 |