JP2005510985A - デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 - Google Patents

デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 Download PDFInfo

- Publication number

- JP2005510985A JP2005510985A JP2003548553A JP2003548553A JP2005510985A JP 2005510985 A JP2005510985 A JP 2005510985A JP 2003548553 A JP2003548553 A JP 2003548553A JP 2003548553 A JP2003548553 A JP 2003548553A JP 2005510985 A JP2005510985 A JP 2005510985A

- Authority

- JP

- Japan

- Prior art keywords

- block

- mode

- macroblock

- field

- picture

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/10—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding

- H04N19/102—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the element, parameter or selection affected or controlled by the adaptive coding

- H04N19/103—Selection of coding mode or of prediction mode

- H04N19/105—Selection of the reference unit for prediction within a chosen coding or prediction mode, e.g. adaptive choice of position and number of pixels used for prediction

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/10—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding

- H04N19/102—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the element, parameter or selection affected or controlled by the adaptive coding

- H04N19/103—Selection of coding mode or of prediction mode

- H04N19/112—Selection of coding mode or of prediction mode according to a given display mode, e.g. for interlaced or progressive display mode

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/10—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding

- H04N19/134—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the element, parameter or criterion affecting or controlling the adaptive coding

- H04N19/136—Incoming video signal characteristics or properties

- H04N19/137—Motion inside a coding unit, e.g. average field, frame or block difference

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/50—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using predictive coding

- H04N19/503—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using predictive coding involving temporal prediction

- H04N19/51—Motion estimation or motion compensation

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/50—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using predictive coding

- H04N19/503—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using predictive coding involving temporal prediction

- H04N19/51—Motion estimation or motion compensation

- H04N19/573—Motion compensation with multiple frame prediction using two or more reference frames in a given prediction direction

Abstract

Description

if(remaining_mode_selector < most_probable_mode)

intra_pred_mode = remaining_mode_selector ;

else

intra_pred_mode = remaining_mode_selector+1 ;

したがって、ブロックCに割り当てられる予測モードの順序は、まず、最も可能性が高いモードであり、次に残りのモードが昇順(ascending order)に割り当てられる。

Claims (7)

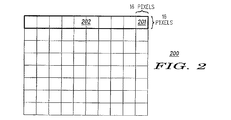

- より小さいブロックに分割されるマクロブロックを含み、イントラピクチャ、予測ピクチャ又は両方向予測ピクチャとすることができるピクチャのストリームからなるデジタルビデオコンテンツを符号化又は復号する符号化又は復号方法において、

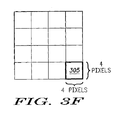

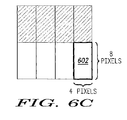

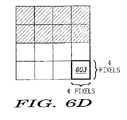

上記ピクチャのストリーム内の上記各ピクチャ内の各ブロックをフレームモード又はフィールドモードで符号化するステップを有する符号化又は復号方法。 - 上記各ブロックは、16×8画素、8×16画素、8×8画素、8×4画素、4×8画素、4×4画素の何れかからなることを特徴とする請求項1記載の符号化又は復号方法。

- 上記各ブロックについて、予測動きベクトルを導出するステップを更に有する請求項2記載の符号化又は復号方法。

- 予測ピクチャにおけるマクロブロックをスキップするステップを更に有し、該スキップされたマクロブロックのデータは伝送されないことを特徴とする請求項1記載の符号化又は復号方法。

- 両方向予測ピクチャにおけるマクロブロックをスキップするステップを更に有し、該スキップされたマクロブロックのデータは伝送されないことを特徴とする請求項1記載の符号化又は復号方法。

- 上記両方向予測ピクチャをダイレクトモードで符号化するステップを更に有する請求項1記載の符号化又は復号方法。

- 符号化において画素値を予測するステップを更に有する請求項1記載の符号化又は復号方法。

Applications Claiming Priority (6)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US33300401P | 2001-11-21 | 2001-11-21 | |

| US33392101P | 2001-11-27 | 2001-11-27 | |

| US39573402P | 2002-07-12 | 2002-07-12 | |

| US39816102P | 2002-07-23 | 2002-07-23 | |

| US10/301,290 US6980596B2 (en) | 2001-11-27 | 2002-11-20 | Macroblock level adaptive frame/field coding for digital video content |

| PCT/US2002/037739 WO2003047272A2 (en) | 2001-11-21 | 2002-11-21 | Macroblock level adaptive frame/field coding for digital video content |

Related Child Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2008234061A Division JP2008295111A (ja) | 2001-11-21 | 2008-09-11 | デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2005510985A true JP2005510985A (ja) | 2005-04-21 |

| JP2005510985A5 JP2005510985A5 (ja) | 2007-11-22 |

Family

ID=27540869

Family Applications (9)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2003548553A Pending JP2005510985A (ja) | 2001-11-21 | 2002-11-21 | デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 |

| JP2008234061A Pending JP2008295111A (ja) | 2001-11-21 | 2008-09-11 | デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 |

| JP2009244955A Expired - Lifetime JP5320254B2 (ja) | 2001-11-21 | 2009-10-23 | デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 |

| JP2012014662A Expired - Lifetime JP5697614B2 (ja) | 2001-11-21 | 2012-01-26 | デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 |

| JP2014240175A Pending JP2015062314A (ja) | 2001-11-21 | 2014-11-27 | デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 |

| JP2016055781A Pending JP2016106504A (ja) | 2001-11-21 | 2016-03-18 | デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 |

| JP2016055783A Expired - Lifetime JP6507114B2 (ja) | 2001-11-21 | 2016-03-18 | デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 |

| JP2016055782A Expired - Lifetime JP6681758B2 (ja) | 2001-11-21 | 2016-03-18 | デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 |

| JP2018110961A Pending JP2018139452A (ja) | 2001-11-21 | 2018-06-11 | デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 |

Family Applications After (8)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2008234061A Pending JP2008295111A (ja) | 2001-11-21 | 2008-09-11 | デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 |

| JP2009244955A Expired - Lifetime JP5320254B2 (ja) | 2001-11-21 | 2009-10-23 | デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 |

| JP2012014662A Expired - Lifetime JP5697614B2 (ja) | 2001-11-21 | 2012-01-26 | デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 |

| JP2014240175A Pending JP2015062314A (ja) | 2001-11-21 | 2014-11-27 | デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 |

| JP2016055781A Pending JP2016106504A (ja) | 2001-11-21 | 2016-03-18 | デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 |

| JP2016055783A Expired - Lifetime JP6507114B2 (ja) | 2001-11-21 | 2016-03-18 | デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 |

| JP2016055782A Expired - Lifetime JP6681758B2 (ja) | 2001-11-21 | 2016-03-18 | デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 |

| JP2018110961A Pending JP2018139452A (ja) | 2001-11-21 | 2018-06-11 | デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 |

Country Status (10)

| Country | Link |

|---|---|

| EP (1) | EP1449385B1 (ja) |

| JP (9) | JP2005510985A (ja) |

| KR (1) | KR101033398B1 (ja) |

| AU (1) | AU2002365338A1 (ja) |

| CA (1) | CA2468087C (ja) |

| DK (1) | DK1449385T3 (ja) |

| ES (5) | ES2545394T3 (ja) |

| MX (1) | MXPA04004724A (ja) |

| PT (5) | PT2271115E (ja) |

| WO (1) | WO2003047272A2 (ja) |

Cited By (12)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2008017209A (ja) * | 2006-07-06 | 2008-01-24 | Canon Inc | 動きベクトル検出装置、動きベクトル検出方法、コンピュータプログラム及び記憶媒体 |

| JP2008048289A (ja) * | 2006-08-18 | 2008-02-28 | Fujitsu Ltd | フレーム間予測処理装置、画像符号化装置、及び画像復号化装置 |

| JP2009049519A (ja) * | 2007-08-14 | 2009-03-05 | Kddi Corp | 動画像符号化装置の予測動きベクトル生成装置 |

| JP2009526456A (ja) * | 2006-02-08 | 2009-07-16 | トムソン ライセンシング | ビデオマクロブロックのペアについてのフレーム/フィールド符号化モードの導出方法 |

| US7570151B2 (en) | 1997-02-27 | 2009-08-04 | Keystone Technology Solutions, Llc | System and method for locating individuals and equipment, airline reservation system, communication system |

| JP2010517405A (ja) * | 2007-01-29 | 2010-05-20 | サムスン エレクトロニクス カンパニー リミテッド | 映像符号化方法及び装置、映像復号化方法及び装置 |

| JP2011101416A (ja) * | 2003-09-07 | 2011-05-19 | Microsoft Corp | インターレース・ビデオの符号化および復号 |

| JP2011139525A (ja) * | 2003-09-07 | 2011-07-14 | Microsoft Corp | インターレース・ビデオの進歩した双方向予測コーディング |

| JP4921971B2 (ja) * | 2003-09-07 | 2012-04-25 | マイクロソフト コーポレーション | インターレース・ビデオおよびプログレッシブ・ビデオのマクロブロックおよび動き情報の符号化および復号における新機軸 |

| JP2013502141A (ja) * | 2009-08-13 | 2013-01-17 | サムスン エレクトロニクス カンパニー リミテッド | 動きベクトルを符号化/復号化する方法及びその装置 |

| JP2013258752A (ja) * | 2010-01-14 | 2013-12-26 | Samsung Electronics Co Ltd | 動きベクトルを符号化/復号化する方法及び装置 |

| JP2016140090A (ja) * | 2010-04-09 | 2016-08-04 | エレクトロニクス アンド テレコミュニケーションズ リサーチ インスチチュートElectronics And Telecommunications Research Institute | 適応的フィルタを用いたイントラ予測実行方法及び装置 |

Families Citing this family (22)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| ES2601356T3 (es) | 2001-11-06 | 2017-02-14 | Panasonic Intellectual Property Corporation Of America | Método de codificación de imágenes en movimiento y método de decodificación de imágenes en movimiento |

| ES2664270T3 (es) | 2001-12-17 | 2018-04-18 | Microsoft Technology Licensing, Llc | Codificación por omisión de macrobloques |

| US7003035B2 (en) | 2002-01-25 | 2006-02-21 | Microsoft Corporation | Video coding methods and apparatuses |

| JP2004088722A (ja) | 2002-03-04 | 2004-03-18 | Matsushita Electric Ind Co Ltd | 動画像符号化方法および動画像復号化方法 |

| PT3525464T (pt) | 2002-04-19 | 2021-04-06 | Panasonic Ip Corp America | Método e sistema de codificação e descodificação de imagem |

| CN101115199B (zh) * | 2002-04-19 | 2010-05-12 | 松下电器产业株式会社 | 图像解码方法及图像解码装置 |

| US20040001546A1 (en) | 2002-06-03 | 2004-01-01 | Alexandros Tourapis | Spatiotemporal prediction for bidirectionally predictive (B) pictures and motion vector prediction for multi-picture reference motion compensation |

| KR100693669B1 (ko) * | 2003-03-03 | 2007-03-09 | 엘지전자 주식회사 | 피일드 매크로 블록의 레퍼런스 픽쳐 결정 방법 |

| MXPA05014211A (es) * | 2003-06-25 | 2006-05-31 | Thomson Licensing | Codificacion de decision en modo rapido para inter-estructuras. |

| US20050013498A1 (en) | 2003-07-18 | 2005-01-20 | Microsoft Corporation | Coding of motion vector information |

| US8179963B2 (en) | 2003-07-24 | 2012-05-15 | Panasonic Corporation | Coding mode determining apparatus, image coding apparatus, coding mode determining method and coding mode determining program |

| MXPA06002210A (es) | 2003-08-26 | 2006-05-19 | Thomson Licensing | Metodo y aparato para la decodificacion de bloques intra-inter codificados hibridos. |

| US8085846B2 (en) | 2004-08-24 | 2011-12-27 | Thomson Licensing | Method and apparatus for decoding hybrid intra-inter coded blocks |

| KR100679031B1 (ko) * | 2004-12-03 | 2007-02-05 | 삼성전자주식회사 | 다 계층 기반의 비디오 인코딩 방법, 디코딩 방법 및 상기방법을 이용한 장치 |

| KR100667806B1 (ko) * | 2005-07-07 | 2007-01-12 | 삼성전자주식회사 | 영상 부호화 및 복호화 방법 및 장치 |

| US9077960B2 (en) | 2005-08-12 | 2015-07-07 | Microsoft Corporation | Non-zero coefficient block pattern coding |

| KR100750128B1 (ko) * | 2005-09-06 | 2007-08-21 | 삼성전자주식회사 | 영상의 인트라 예측 부호화, 복호화 방법 및 장치 |

| KR100727972B1 (ko) * | 2005-09-06 | 2007-06-14 | 삼성전자주식회사 | 영상의 인트라 예측 부호화, 복호화 방법 및 장치 |

| FR2894423A1 (fr) | 2005-12-05 | 2007-06-08 | Thomson Licensing Sas | Procede de prediction de donnees mouvement et de texture |

| JP5341786B2 (ja) * | 2010-01-20 | 2013-11-13 | 株式会社メガチップス | 画像符号化装置及び画像変換装置 |

| US8923395B2 (en) * | 2010-10-01 | 2014-12-30 | Qualcomm Incorporated | Video coding using intra-prediction |

| JP7145822B2 (ja) * | 2019-07-18 | 2022-10-03 | ヤフー株式会社 | 情報提供装置、情報提供方法、および情報提供プログラム |

Family Cites Families (8)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP3125145B2 (ja) * | 1990-08-29 | 2001-01-15 | 日立電子株式会社 | 画像データの高能率符号化方法及びその装置 |

| DE4113505A1 (de) | 1991-04-25 | 1992-10-29 | Thomson Brandt Gmbh | Verfahren zur bildsignalcodierung |

| US6226327B1 (en) * | 1992-06-29 | 2001-05-01 | Sony Corporation | Video coding method and apparatus which select between frame-based and field-based predictive modes |

| PT2334083E (pt) * | 1993-03-24 | 2013-09-30 | Sony Corp | Método para codificar e descodificar vetores de movimento e respetivo dispositivo e método para codificar e descodificar sinais de imagem e respetivo dispositivo |

| US5974184A (en) * | 1997-03-07 | 1999-10-26 | General Instrument Corporation | Intra-macroblock DC and AC coefficient prediction for interlaced digital video |

| JP3559419B2 (ja) * | 1997-03-18 | 2004-09-02 | 松下電器産業株式会社 | 画像圧縮データの伸張方法及び装置 |

| JP2001251627A (ja) * | 2000-03-03 | 2001-09-14 | Matsushita Electric Ind Co Ltd | 符号化装置、符号化方法及びプログラムを記録した記録媒体 |

| FR2806570B1 (fr) * | 2000-03-15 | 2002-05-17 | Thomson Multimedia Sa | Procede et dispositif de codage d'images video |

-

2002

- 2002-11-21 CA CA2468087A patent/CA2468087C/en not_active Expired - Lifetime

- 2002-11-21 AU AU2002365338A patent/AU2002365338A1/en not_active Abandoned

- 2002-11-21 PT PT101826543T patent/PT2271115E/pt unknown

- 2002-11-21 ES ES10182654.3T patent/ES2545394T3/es not_active Expired - Lifetime

- 2002-11-21 JP JP2003548553A patent/JP2005510985A/ja active Pending

- 2002-11-21 ES ES02804054.1T patent/ES2545177T3/es not_active Expired - Lifetime

- 2002-11-21 ES ES10182726.9T patent/ES2545213T3/es not_active Expired - Lifetime

- 2002-11-21 PT PT101827269T patent/PT2268040E/pt unknown

- 2002-11-21 ES ES10182629.5T patent/ES2548385T3/es not_active Expired - Lifetime

- 2002-11-21 EP EP02804054.1A patent/EP1449385B1/en not_active Expired - Lifetime

- 2002-11-21 WO PCT/US2002/037739 patent/WO2003047272A2/en active Application Filing

- 2002-11-21 ES ES10182624.6T patent/ES2548384T3/es not_active Expired - Lifetime

- 2002-11-21 DK DK02804054.1T patent/DK1449385T3/en active

- 2002-11-21 PT PT101826246T patent/PT2268039E/pt unknown

- 2002-11-21 KR KR1020047007762A patent/KR101033398B1/ko active IP Right Grant

- 2002-11-21 PT PT2804054T patent/PT1449385E/pt unknown

- 2002-11-21 PT PT101826295T patent/PT2285121E/pt unknown

-

2004

- 2004-05-19 MX MXPA04004724A patent/MXPA04004724A/es active IP Right Grant

-

2008

- 2008-09-11 JP JP2008234061A patent/JP2008295111A/ja active Pending

-

2009

- 2009-10-23 JP JP2009244955A patent/JP5320254B2/ja not_active Expired - Lifetime

-

2012

- 2012-01-26 JP JP2012014662A patent/JP5697614B2/ja not_active Expired - Lifetime

-

2014

- 2014-11-27 JP JP2014240175A patent/JP2015062314A/ja active Pending

-

2016

- 2016-03-18 JP JP2016055781A patent/JP2016106504A/ja active Pending

- 2016-03-18 JP JP2016055783A patent/JP6507114B2/ja not_active Expired - Lifetime

- 2016-03-18 JP JP2016055782A patent/JP6681758B2/ja not_active Expired - Lifetime

-

2018

- 2018-06-11 JP JP2018110961A patent/JP2018139452A/ja active Pending

Cited By (46)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US7570151B2 (en) | 1997-02-27 | 2009-08-04 | Keystone Technology Solutions, Llc | System and method for locating individuals and equipment, airline reservation system, communication system |

| US8625669B2 (en) | 2003-09-07 | 2014-01-07 | Microsoft Corporation | Predicting motion vectors for fields of forward-predicted interlaced video frames |

| JP2011101416A (ja) * | 2003-09-07 | 2011-05-19 | Microsoft Corp | インターレース・ビデオの符号化および復号 |

| JP2011139525A (ja) * | 2003-09-07 | 2011-07-14 | Microsoft Corp | インターレース・ビデオの進歩した双方向予測コーディング |

| JP4921971B2 (ja) * | 2003-09-07 | 2012-04-25 | マイクロソフト コーポレーション | インターレース・ビデオおよびプログレッシブ・ビデオのマクロブロックおよび動き情報の符号化および復号における新機軸 |

| JP2009526456A (ja) * | 2006-02-08 | 2009-07-16 | トムソン ライセンシング | ビデオマクロブロックのペアについてのフレーム/フィールド符号化モードの導出方法 |

| JP2008017209A (ja) * | 2006-07-06 | 2008-01-24 | Canon Inc | 動きベクトル検出装置、動きベクトル検出方法、コンピュータプログラム及び記憶媒体 |

| JP2008048289A (ja) * | 2006-08-18 | 2008-02-28 | Fujitsu Ltd | フレーム間予測処理装置、画像符号化装置、及び画像復号化装置 |

| US8155197B2 (en) | 2006-08-18 | 2012-04-10 | Fujitsu Semiconductor Limited | Interframe prediction processor with mechanism for providing locations of reference motion vectors used in macroblock adaptive field/frame mode |

| JP2010517405A (ja) * | 2007-01-29 | 2010-05-20 | サムスン エレクトロニクス カンパニー リミテッド | 映像符号化方法及び装置、映像復号化方法及び装置 |

| JP2009049519A (ja) * | 2007-08-14 | 2009-03-05 | Kddi Corp | 動画像符号化装置の予測動きベクトル生成装置 |

| JP2015019420A (ja) * | 2009-08-13 | 2015-01-29 | サムスン エレクトロニクス カンパニー リミテッド | 映像復号化方法 |

| JP2013502141A (ja) * | 2009-08-13 | 2013-01-17 | サムスン エレクトロニクス カンパニー リミテッド | 動きベクトルを符号化/復号化する方法及びその装置 |

| JP2013219824A (ja) * | 2009-08-13 | 2013-10-24 | Samsung Electronics Co Ltd | 動きベクトルを符号化/復号化する方法及びその装置 |

| US10110902B2 (en) | 2009-08-13 | 2018-10-23 | Samsung Electronics Co., Ltd. | Method and apparatus for encoding/decoding motion vector |

| JP2013219826A (ja) * | 2009-08-13 | 2013-10-24 | Samsung Electronics Co Ltd | 動きベクトルを符号化/復号化する方法及びその装置 |

| US8787463B2 (en) | 2009-08-13 | 2014-07-22 | Samsung Electronics Co., Ltd. | Method and apparatus for encoding/decoding motion vector |

| US8792558B2 (en) | 2009-08-13 | 2014-07-29 | Samsung Electronics Co., Ltd. | Method and apparatus for encoding/decoding motion vector |

| US9883186B2 (en) | 2009-08-13 | 2018-01-30 | Samsung Electronics Co., Ltd. | Method and apparatus for encoding/decoding motion vector |

| US9544588B2 (en) | 2009-08-13 | 2017-01-10 | Samsung Electronics Co., Ltd. | Method and apparatus for encoding/decoding motion vector |

| JP2013219825A (ja) * | 2009-08-13 | 2013-10-24 | Samsung Electronics Co Ltd | 動きベクトルを符号化/復号化する方法及びその装置 |

| JP2015029335A (ja) * | 2009-08-13 | 2015-02-12 | サムスン エレクトロニクス カンパニー リミテッド | 映像復号化方法 |

| US8861609B2 (en) | 2010-01-14 | 2014-10-14 | Samsung Electronics Co., Ltd. | Method and apparatus for encoding and decoding motion vector by obtaining motion vector predictor candidate using co-located block |

| US8861608B2 (en) | 2010-01-14 | 2014-10-14 | Samsung Electronics Co., Ltd. | Method and apparatus for encoding and decoding motion vector by obtaining motion vector predictor candidate using co-located block |

| US8995529B2 (en) | 2010-01-14 | 2015-03-31 | Samsung Electronics Co., Ltd. | Method and apparatus for encoding and decoding motion vector by predicting motion vector according to mode |

| US9106924B2 (en) | 2010-01-14 | 2015-08-11 | Samsung Electronics Co., Ltd. | Method and apparatus for encoding and decoding motion vector by predicting motion vector according to mode |

| US9131237B2 (en) | 2010-01-14 | 2015-09-08 | Samsung Electronics Co., Ltd. | Method and apparatus for encoding and decoding motion vector by predicting motion vector according to mode |

| JP2013258752A (ja) * | 2010-01-14 | 2013-12-26 | Samsung Electronics Co Ltd | 動きベクトルを符号化/復号化する方法及び装置 |

| US8861610B2 (en) | 2010-01-14 | 2014-10-14 | Samsung Electronics Co., Ltd. | Method and apparatus for encoding and decoding motion vector by obtaining motion vector predictor candidate using co-located block |

| US8867621B2 (en) | 2010-01-14 | 2014-10-21 | Samsung Electronics Co., Ltd. | Method and apparatus for encoding and decoding motion vector by obtaining motion vector predictor candidate using co-located block |

| US10440392B2 (en) | 2010-04-09 | 2019-10-08 | Electronics And Telecommunications Research Institute | Method and apparatus for performing intra-prediction using adaptive filter |

| US10432968B2 (en) | 2010-04-09 | 2019-10-01 | Electronics And Telecommunications Research Institute | Method and apparatus for performing intra-prediction using adaptive filter |

| US9838711B2 (en) | 2010-04-09 | 2017-12-05 | Electronics And Telecommunications Research Institute | Method and apparatus for performing intra-prediction using adaptive filter |

| US9661345B2 (en) | 2010-04-09 | 2017-05-23 | Electronics And Telecommunications Research Institute | Method and apparatus for performing intra-prediction using adaptive filter |

| JP2017143542A (ja) * | 2010-04-09 | 2017-08-17 | エレクトロニクス アンド テレコミュニケーションズ リサーチ インスチチュートElectronics And Telecommunications Research Institute | ビデオデコーディング装置 |

| JP2016140090A (ja) * | 2010-04-09 | 2016-08-04 | エレクトロニクス アンド テレコミュニケーションズ リサーチ インスチチュートElectronics And Telecommunications Research Institute | 適応的フィルタを用いたイントラ予測実行方法及び装置 |

| US9781448B2 (en) | 2010-04-09 | 2017-10-03 | Electronics And Telecommunications Research Institute | Method and apparatus for performing intra-prediction using adaptive filter |

| US10440393B2 (en) | 2010-04-09 | 2019-10-08 | Electronics And Telecommunications Research Institute | Method and apparatus for performing intra-prediction using adaptive filter |

| US10075734B2 (en) | 2010-04-09 | 2018-09-11 | Electronics And Telecommunications Research Institute | Method and apparatus for performing intra-prediction using adaptive filter |

| US10560722B2 (en) | 2010-04-09 | 2020-02-11 | Electronics And Telecommunications Research Institute | Method and apparatus for performing intra-prediction using adaptive filter |

| US10560721B2 (en) | 2010-04-09 | 2020-02-11 | Electronics And Telecommunications Research Institute | Method and apparatus for performing intra-prediction using adaptive filter |

| US10623771B2 (en) | 2010-04-09 | 2020-04-14 | Electronics And Telecommunications Research Institute | Method and apparatus for performing intra-prediction using adaptive filter |

| US10623769B2 (en) | 2010-04-09 | 2020-04-14 | Electronics And Telecommunications Research Institute | Method and apparatus for performing intra-prediction using adaptive filter |

| US10623770B2 (en) | 2010-04-09 | 2020-04-14 | Electronics And Telecommunications Research Institute | Method and apparatus for performing intra-prediction using adaptive filter |

| US10951917B2 (en) | 2010-04-09 | 2021-03-16 | Electronics And Telecommunications Research Institute | Method and apparatus for performing intra-prediction using adaptive filter |

| US11601673B2 (en) | 2010-04-09 | 2023-03-07 | Electronics And Telecommunications Research Institute | Method and apparatus for performing intra-prediction using adaptive filter |

Also Published As

| Publication number | Publication date |

|---|---|

| JP5320254B2 (ja) | 2013-10-23 |

| AU2002365338A1 (en) | 2003-06-10 |

| JP2016106504A (ja) | 2016-06-16 |

| WO2003047272A3 (en) | 2004-01-08 |

| JP2012105348A (ja) | 2012-05-31 |

| PT2268040E (pt) | 2015-10-15 |

| CA2468087A1 (en) | 2003-06-05 |

| KR101033398B1 (ko) | 2011-05-09 |

| EP1449385B1 (en) | 2015-07-22 |

| ES2548385T3 (es) | 2015-10-16 |

| JP2016136765A (ja) | 2016-07-28 |

| JP2015062314A (ja) | 2015-04-02 |

| PT2268039E (pt) | 2015-10-26 |

| PT1449385E (pt) | 2015-10-15 |

| CA2468087C (en) | 2013-06-25 |

| JP2016123131A (ja) | 2016-07-07 |

| PT2271115E (pt) | 2015-10-15 |

| JP6507114B2 (ja) | 2019-04-24 |

| ES2545177T3 (es) | 2015-09-09 |

| JP6681758B2 (ja) | 2020-04-15 |

| ES2548384T3 (es) | 2015-10-16 |

| JP2018139452A (ja) | 2018-09-06 |

| EP1449385A2 (en) | 2004-08-25 |

| ES2545394T3 (es) | 2015-09-10 |

| ES2545213T3 (es) | 2015-09-09 |

| PT2285121E (pt) | 2015-10-27 |

| MXPA04004724A (es) | 2004-07-30 |

| JP5697614B2 (ja) | 2015-04-08 |

| DK1449385T3 (en) | 2015-10-19 |

| KR20040070176A (ko) | 2004-08-06 |

| WO2003047272A2 (en) | 2003-06-05 |

| JP2010022058A (ja) | 2010-01-28 |

| JP2008295111A (ja) | 2008-12-04 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6681758B2 (ja) | デジタルビデオコンテンツのマクロブロックレベルにおける適応フレーム/フィールド符号化 | |

| US6980596B2 (en) | Macroblock level adaptive frame/field coding for digital video content | |

| JP2005510985A5 (ja) | ||

| KR101076506B1 (ko) | 복수의 픽쳐를 갖는 영상 시퀀스의 엔코딩 및 디코딩 방법 | |

| JP2005510984A5 (ja) |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20050712 |

|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20070921 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20080311 |

|

| A601 | Written request for extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A601 Effective date: 20080611 |

|

| A602 | Written permission of extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A602 Effective date: 20080618 |

|

| A601 | Written request for extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A601 Effective date: 20080711 |

|

| A602 | Written permission of extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A602 Effective date: 20080718 |

|

| A601 | Written request for extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A601 Effective date: 20080811 |

|

| A602 | Written permission of extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A602 Effective date: 20080821 |

|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20080911 |

|

| A02 | Decision of refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A02 Effective date: 20081125 |