CN107430863B - 用于编码的音频编码器及用于解码的音频解码器 - Google Patents

用于编码的音频编码器及用于解码的音频解码器 Download PDFInfo

- Publication number

- CN107430863B CN107430863B CN201680014669.3A CN201680014669A CN107430863B CN 107430863 B CN107430863 B CN 107430863B CN 201680014669 A CN201680014669 A CN 201680014669A CN 107430863 B CN107430863 B CN 107430863B

- Authority

- CN

- China

- Prior art keywords

- channel

- signal

- encoder

- decoder

- domain

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

- 230000005236 sound signal Effects 0.000 claims abstract description 111

- 238000002156 mixing Methods 0.000 claims abstract description 11

- 238000000034 method Methods 0.000 claims description 94

- 230000003595 spectral effect Effects 0.000 claims description 45

- 230000006870 function Effects 0.000 claims description 23

- 230000008569 process Effects 0.000 claims description 20

- 238000005070 sampling Methods 0.000 claims description 20

- 230000015572 biosynthetic process Effects 0.000 claims description 17

- 238000003786 synthesis reaction Methods 0.000 claims description 17

- 238000006243 chemical reaction Methods 0.000 claims description 14

- 238000004590 computer program Methods 0.000 claims description 13

- 238000004422 calculation algorithm Methods 0.000 claims description 10

- 238000011049 filling Methods 0.000 claims description 7

- 239000002131 composite material Substances 0.000 claims description 3

- 238000010586 diagram Methods 0.000 abstract description 43

- 238000004458 analytical method Methods 0.000 description 22

- 238000012545 processing Methods 0.000 description 20

- 238000001228 spectrum Methods 0.000 description 16

- 230000007704 transition Effects 0.000 description 13

- 230000005540 biological transmission Effects 0.000 description 7

- 230000003044 adaptive effect Effects 0.000 description 5

- 238000000354 decomposition reaction Methods 0.000 description 5

- 230000005284 excitation Effects 0.000 description 5

- 238000009432 framing Methods 0.000 description 5

- 238000001914 filtration Methods 0.000 description 4

- 238000013139 quantization Methods 0.000 description 4

- 238000004364 calculation method Methods 0.000 description 3

- 230000002123 temporal effect Effects 0.000 description 3

- 230000001755 vocal effect Effects 0.000 description 3

- 238000013459 approach Methods 0.000 description 2

- 230000008859 change Effects 0.000 description 2

- 238000004891 communication Methods 0.000 description 2

- 239000000203 mixture Substances 0.000 description 2

- 230000008447 perception Effects 0.000 description 2

- 238000012805 post-processing Methods 0.000 description 2

- 208000024875 Infantile dystonia-parkinsonism Diseases 0.000 description 1

- 238000003491 array Methods 0.000 description 1

- 230000008901 benefit Effects 0.000 description 1

- 239000000969 carrier Substances 0.000 description 1

- 238000012937 correction Methods 0.000 description 1

- 230000003111 delayed effect Effects 0.000 description 1

- 230000001419 dependent effect Effects 0.000 description 1

- 238000009499 grossing Methods 0.000 description 1

- 208000001543 infantile parkinsonism-dystonia Diseases 0.000 description 1

- 238000013507 mapping Methods 0.000 description 1

- 238000012986 modification Methods 0.000 description 1

- 230000004048 modification Effects 0.000 description 1

- 238000004321 preservation Methods 0.000 description 1

- 230000009467 reduction Effects 0.000 description 1

- 230000004044 response Effects 0.000 description 1

- 230000011218 segmentation Effects 0.000 description 1

- 238000004088 simulation Methods 0.000 description 1

- 238000000638 solvent extraction Methods 0.000 description 1

- 238000012546 transfer Methods 0.000 description 1

- 230000001131 transforming effect Effects 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS OR SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING; SPEECH OR AUDIO CODING OR DECODING

- G10L19/00—Speech or audio signals analysis-synthesis techniques for redundancy reduction, e.g. in vocoders; Coding or decoding of speech or audio signals, using source filter models or psychoacoustic analysis

- G10L19/008—Multichannel audio signal coding or decoding using interchannel correlation to reduce redundancy, e.g. joint-stereo, intensity-coding or matrixing

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS OR SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING; SPEECH OR AUDIO CODING OR DECODING

- G10L19/00—Speech or audio signals analysis-synthesis techniques for redundancy reduction, e.g. in vocoders; Coding or decoding of speech or audio signals, using source filter models or psychoacoustic analysis

- G10L19/02—Speech or audio signals analysis-synthesis techniques for redundancy reduction, e.g. in vocoders; Coding or decoding of speech or audio signals, using source filter models or psychoacoustic analysis using spectral analysis, e.g. transform vocoders or subband vocoders

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS OR SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING; SPEECH OR AUDIO CODING OR DECODING

- G10L19/00—Speech or audio signals analysis-synthesis techniques for redundancy reduction, e.g. in vocoders; Coding or decoding of speech or audio signals, using source filter models or psychoacoustic analysis

- G10L19/02—Speech or audio signals analysis-synthesis techniques for redundancy reduction, e.g. in vocoders; Coding or decoding of speech or audio signals, using source filter models or psychoacoustic analysis using spectral analysis, e.g. transform vocoders or subband vocoders

- G10L19/032—Quantisation or dequantisation of spectral components

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS OR SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING; SPEECH OR AUDIO CODING OR DECODING

- G10L19/00—Speech or audio signals analysis-synthesis techniques for redundancy reduction, e.g. in vocoders; Coding or decoding of speech or audio signals, using source filter models or psychoacoustic analysis

- G10L19/04—Speech or audio signals analysis-synthesis techniques for redundancy reduction, e.g. in vocoders; Coding or decoding of speech or audio signals, using source filter models or psychoacoustic analysis using predictive techniques

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS OR SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING; SPEECH OR AUDIO CODING OR DECODING

- G10L19/00—Speech or audio signals analysis-synthesis techniques for redundancy reduction, e.g. in vocoders; Coding or decoding of speech or audio signals, using source filter models or psychoacoustic analysis

- G10L19/04—Speech or audio signals analysis-synthesis techniques for redundancy reduction, e.g. in vocoders; Coding or decoding of speech or audio signals, using source filter models or psychoacoustic analysis using predictive techniques

- G10L19/08—Determination or coding of the excitation function; Determination or coding of the long-term prediction parameters

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS OR SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING; SPEECH OR AUDIO CODING OR DECODING

- G10L19/00—Speech or audio signals analysis-synthesis techniques for redundancy reduction, e.g. in vocoders; Coding or decoding of speech or audio signals, using source filter models or psychoacoustic analysis

- G10L19/04—Speech or audio signals analysis-synthesis techniques for redundancy reduction, e.g. in vocoders; Coding or decoding of speech or audio signals, using source filter models or psychoacoustic analysis using predictive techniques

- G10L19/08—Determination or coding of the excitation function; Determination or coding of the long-term prediction parameters

- G10L19/12—Determination or coding of the excitation function; Determination or coding of the long-term prediction parameters the excitation function being a code excitation, e.g. in code excited linear prediction [CELP] vocoders

- G10L19/13—Residual excited linear prediction [RELP]

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS OR SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING; SPEECH OR AUDIO CODING OR DECODING

- G10L19/00—Speech or audio signals analysis-synthesis techniques for redundancy reduction, e.g. in vocoders; Coding or decoding of speech or audio signals, using source filter models or psychoacoustic analysis

- G10L19/04—Speech or audio signals analysis-synthesis techniques for redundancy reduction, e.g. in vocoders; Coding or decoding of speech or audio signals, using source filter models or psychoacoustic analysis using predictive techniques

- G10L19/16—Vocoder architecture

- G10L19/18—Vocoders using multiple modes

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS OR SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING; SPEECH OR AUDIO CODING OR DECODING

- G10L21/00—Processing of the speech or voice signal to produce another audible or non-audible signal, e.g. visual or tactile, in order to modify its quality or its intelligibility

- G10L21/02—Speech enhancement, e.g. noise reduction or echo cancellation

- G10L21/038—Speech enhancement, e.g. noise reduction or echo cancellation using band spreading techniques

Abstract

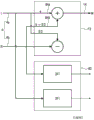

展示用于编码多声道音频信号(4)的音频编码器(2)的示意性框图。音频编码器包括线性预测域编码器(6)、频域编码器(8)以及用于在线性预测域编码器(6)与频域编码器(8)之间切换的控制器(10)。控制器被配置为使得多声道信号的部分由线性预测域编码器的编码帧表示或由频域编码器的编码帧表示。线性预测域编码器包括用于对多声道信号(4)进行降混以获得降混信号(14)的降混频器(12)。线性预测域编码器还包括用于编码降混信号的线性预测域核心编码器(16),此外,线性预测域编码器包括用于从多声道信号(4)生成第一多声道信息(20)的第一联合多声道编码器(18)。

Description

技术领域

本发明涉及一种用于编码多声道音频信号的音频编码器及用于解码经编码的音频信号的音频解码器。实施例涉及包括波形保持及参数化立体声编码的切换式感知音频编解码器。

背景技术

音频信号的感知编码出于用于此等信号的高效存储或传输的数据缩减的目的而被广泛实际应用。特别地,当将达到最高效率时,使用紧密适合于信号输入特性的编解码器。一个示例为MPEG-D USAC核心编解码器,其可用于主要对语音信号使用代数码本激励线性预测(ACELP,Algebraic Code-Excited Linear Prediction)编码、对背景噪声及混合信号使用变换编码激励(TCX,Transform Coded Excitation)以及对音乐内容使用高级音频编码(AAC,Advanced Audio Coding)。所有的三个内部编解码器配置可响应于信号内容以信号自适应方式被立即切换。

此外,使用联合多声道编码技术(中间/侧编码等)或为了最高效率而使用参数化编码技术。参数化编码技术基本上以感知等同音频信号的再造而非给定波形的忠实重建为目标。示例包括噪声填充、带宽扩展以及空间音频编码。

在现有技术水平的编解码器中,当将信号自适应核心编码器与联合多声道编码或参数化编码技术进行组合时,核心编解码器被切换以匹配信号特性,但多声道编码技术(如,M/S立体声、空间音频编码或参数化立体声)的选择保持固定且独立于信号特性。这些技术通常被用于核心编解码器以作为核心编码器的预处理器及核心解码器的后处理器,这两种处理器不知道核心编解码器的实际选择。

另一方面,用于带宽扩展的参数化编码技术的选择有时是信号相依地做出的。举例而言,应用于时域中的技术对于语音信号更有效率,而频域处理对于其他信号更相关。在此情况下,所采用的多声道编码技术必须与两种带宽扩展技术兼容。

现有技术水平中的相关话题包括:

作为MPEG-D USAC核心编解码器的预处理器/后处理器的PS及MPS

MPEG-D USAC标准

MPEG-H 3D音频标准

在MPEG-D USAC中,描述了可切换核心编码器。然而,在USAC中,多声道编码技术被定义为整个核心编码器常见的固定选择,与其编码原理的内部切换为ACELP或TCX(“LPD”)或AAC(“FD”)无关。因此,若期望切换式核心编解码器配置,编解码器被限制为针对整个信号始终使用参数化多声道编码(parametric multichannel coding,PS)。然而,为了编码(例如)音乐信号,使用联合立体声编码将更恰当,其可每频带及每帧地在L/R(左/右)与M/S(中间/侧)方案之间动态地切换。

因此,需要经改良的方法。

发明内容

本发明的目标为提供用于处理音频信号的经改良的概念。通过独立权利要求的主题实现此目标。

本发明基于如下发现:使用多声道编码器的(时域)参数化编码器对参数化多声道音频编码是有利的。多声道编码器可以是多声道残余编码器,其与用于每个声道的单独编码相比可减小用于编码参数的传输的带宽。(例如)结合频域联合多声道音频编码器此可被有利地使用。时域及频域联合多声道编码技术可被组合,以使得(例如)基于帧的决策可将当前帧引导至基于时间或基于频率的编码周期。换言之,实施例展示用于将使用联合多声道编码及参数化空间音频编码的可切换核心编解码器组合成完全可切换感知编解码器的经改良的概念,完全可切换感知编解码器允许依据核心编码器的选择而使用不同的多声道编码技术。此概念是有利的,因为与已经存在的方法相比,实施例展示可与核心编码器一起被立即切换且因此紧密匹配于且适合于核心编码器的选择的多声道编码技术。因此,可避免由于多声道编码技术的固定选择而出现的所描绘的问题。此外,实现给定核心编码器与其相关联且经调适的多声道编码技术的完全可切换组合。举例而言,此种编码器(例如,使用L/R或M/S立体声编码的AAC(高级音频编码))能够使用专用联合立体声或多声道编码(例如,M/S立体声)在频域(FD)核心编码器中对音乐信号进行编码。此决策可单独地应用于每个音频帧中的每个频带。在(例如)语音信号的情况下,核心编码器可立即切换至线性预测性解码(linear predictive decoding,LPD)核心编码器及其相关联的不同技术(例如,参数化立体声编码技术)。

实施例展示对于单声道LPD路径而言是唯一的立体声处理,及将立体声FD路径的输出与来自LPD核心编码器及其专用立体声编码的输出进行组合的基于立体声信号的无缝切换方案。此情况是有利的,因为实现了无伪声(artifact)的无缝编解码器切换。

实施例涉及一种用于编码多声道信号的编码器。编码器包括线性预测域编码器及频域编码器。此外,编码器包括用于在线性预测域编码器与频域编码器之间进行切换的控制器。此外,线性预测域编码器可包括:用于对多声道信号进行降混以获得降混信号的降混频器;用于编码降混信号的线性预测域核心编码器;以及用于从多声道信号生成第一多声道信息的第一多声道编码器。频域编码器包括用于从多声道信号生成第二多声道信息的第二联合多声道编码器,其中第二多声道编码器不同于第一多声道编码器。控制器被配置为使得多声道信号的部分由线性预测域编码器的编码帧表示或由频域编码器的编码帧表示。线性预测域编码器可包括ACELP核心编码器及(例如)作为第一联合多声道编码器的参数化立体声编码算法。频域编码器可包括(例如)作为第二联合多声道编码器的使用(例如)L/R或M/S处理的AAC核心编码器作为第二联合多声道编码器。控制器可关于(例如)帧特性而分析多声道信号(例如,语音或音乐),且用于针对每帧或帧的序列或多声道音频信号的部分,决定是线性预测域编码器还是频域编码器应被用于编码多声道音频信号的此部分。

实施例进一步展示一种用于解码经编码的音频信号的音频解码器。音频解码器包括线性预测域解码器及频域解码器。此外,音频解码器包括:用于使用线性预测域解码器的输出及使用多声道信息生成第一多声道表示的第一联合多声道解码器;以及用于使用频域解码器的输出及第二多声道信息生成第二多声道表示的第二多声道解码器。此外,音频解码器包括用于将第一多声道表示及第二多声道表示进行组合以获得经解码的音频信号的第一组合器。组合器可在作为(例如)经线性预测的多声道音频信号的第一多声道表示与作为(例如)频域经解码的多声道音频信号的第二多声道表示之间执行无缝无伪声切换。

实施例展示可切换音频编码器内的LPD路径中的ACELP/TCX编码与频域路径中的专用立体声编码及独立AAC立体声编码的组合。此外,实施例展示LPD与FD立体声之间的无缝瞬时切换,其中其他实施例涉及用于不同信号内容类型的联合多声道编码的独立选择。举例而言,针对主要使用LPD路径编码的语音,使用参数化立体声,而对于在FD路径中被编码的音乐,使用更加自适应的立体声编码,其可每频带及每帧地在L/R方案与M/S方案之间动态地切换。

根据实施例,针对主要使用LPD路径来编码且通常位于立体声影像的中心的语音,简单的参数化立体声是恰当的,而在FD路径中被编码的音乐通常具有更复杂的空间分布且可利用更加自适应的立体声编码,该更加自适应的立体声编码可每频带及每帧地在L/R方案与M/S方案之间动态地切换。

其他实施例展示音频编码器,该音频编码器包括:用于对多声道信号进行降混以获得降混信号的降混频器(12);用于编码降混信号的线性预测域核心编码器;用于生成多声道信号的频谱表示的滤波器组;以及用于从多声道信号生成多声道信息的联合多声道编码器。降混信号具有低频带和高频带,其中线性预测域核心编码器用于施加带宽扩展处理以用于对高频带进行参数化编码。此外,多声道编码器用于处理包括多声道信号的低频带及高频带的频谱表示。此是有利的,因为每个参数化编码可使用其最佳时间-频率分解以得到其参数。此可(例如)使用代数码本激励线性预测(ACELP)加上时域带宽扩展(TDBWE)以及利用外部滤波器组的参数化多声道编码(例如DFT)的组合来实施,其中ACELP可编码音频信号的低频带且TDBWE可编码音频信号的高频带。此组合特别有效率,因为已知用于语音的最佳带宽扩展应在时域中且多声道处理在频域中。由于ACELP+TDBWE不具有任何时间-频率转换器,因此外部滤波器组或如DFT的变换是有利的。此外,多声道处理器的成帧可与ACELP中所使用的成帧相同。即使多声道处理是在频域中进行,用于计算其参数或进行降混的时间分辨率应理想地接近于或甚至等于ACELP的成帧。

所描述的实施例是有益的,因为可应用用于不同信号内容类型的联合多声道编码的独立选择。

附图说明

随后将参照附图论述本发明的实施例,其中:

图1展示用于编码多声道音频信号的编码器的示意性框图;

图2展示根据实施例的线性预测域编码器的示意性框图;

图3展示根据实施例的频域编码器的示意性框图;

图4展示根据实施例的音频编码器的示意性框图;

图5a展示根据实施例的有源降混频器的示意性框图;

图5b展示根据实施例的无源降混频器的示意性框图;

图6展示用于解码经编码的音频信号的解码器的示意性框图;

图7展示根据实施例的解码器的示意性框图;

图8展示编码多声道信号的方法的示意性框图;

图9展示解码经编码的音频信号的方法的示意性框图;

图10展示根据另一方面的用于编码多声道信号的编码器的示意性框图;

图11展示根据另一方面的用于解码经编码的音频信号的解码器的示意性框图;

图12展示根据另一方面的用于编码多声道信号的音频编码方法的示意性框图;

图13展示根据另一方面的解码经编码的音频信号的方法的示意性框图;

图14展示从频域编码至LPD编码的无缝切换的示意性时序图;

图15展示从频域解码至LPD域解码的无缝切换的示意性时序图;

图16展示从LPD编码至频域编码的无缝切换的示意性时序图;

图17展示从LPD解码至频域解码的无缝切换的示意性时序图;

图18展示根据另一方面的用于编码多声道信号的编码器的示意性框图;

图19展示根据另一方面的用于解码经编码的音频信号的解码器的示意性框图;

图20展示根据另一方面的用于编码多声道信号的音频编码方法的示意性框图;

图21展示根据另一方面的解码经编码的音频信号的方法的示意性框图。

具体实施方式

在下文中,将更详细地描述本发明的实施例。各个附图中所示的具有相同或相似功能的元件将与相同的附图标记相关联。

图1展示用于编码多声道音频信号4的音频编码器2的示意性框图。音频编码器包括线性预测域编码器6、频域编码器8以及用于在线性预测域编码器6与频域编码器8之间切换的控制器10。控制器可分析多声道信号且针对多声道信号的部分决定是线性预测域编码还是频域编码有利。换言之,控制器被配置为使得多声道信号的部分由线性预测域编码器的编码帧表示或由频域编码器的编码帧表示。线性预测域编码器包括用于对多声道信号4进行降混以获得降混信号14的降混频器12。线性预测域编码器还包括用于编码降混信号的线性预测域核心编码器16,此外,线性预测域编码器包括用于从多声道信号4生成第一多声道信息20的第一联合多声道编码器18,第一多声道信息包括(例如)双耳声级差(interaural level difference,ILD)和/或双耳相位差(interaural phase difference,IPD)参数。多声道信号可以是(例如)立体声信号,其中降混频器将立体声信号转换为单声道信号。线性预测域核心编码器可编码单声道信号,其中第一联合多声道编码器可生成经编码的单声道信号的立体声信息以作为第一多声道信息。当与关于图10及图11所描述的另一方面相比时,频域编码器及控制器是可选择的。然而,为了时域编码与频域编码之间的信号自适应切换,使用频域编码器及控制器是有利的。

此外,频域编码器8包括第二联合多声道编码器22,其用于从多声道信号4生成第二多声道信息24,其中第二联合多声道编码器22不同于第一多声道编码器18。然而,对于被第二编码器更好地编码的信号,第二联合多声道处理器22获得允许比由第一多声道编码器获得的第一多声道信息的第一再现质量高的第二再现质量的第二多声道信息。

换言之,根据实施例,第一联合多声道编码器18用于生成允许第一再现质量的第一多声道信息20,其中第二联合多声道编码器22用于生成允许第二再现质量的第二多声道信息24,其中第二再现质量高于第一再现质量。此情况至少与被第二多声道编码器更好地编码的信号(如,语音信号)相关。

因此,第一多声道编码器可以是包括(例如)立体声预测编码器、参数化立体声编码器或基于旋转的参数化立体声编码器的参数化联合多声道编码器。此外,第二联合多声道编码器可以是波形保持的,如(例如)频带选择性切换至中间/侧或左/右立体声编码器。如图1中所描绘,经编码的降混信号26可被传输至音频解码器且选择性地伺服第一联合多声道处理器,在第一联合多声道处理器处,例如,经编码的降混信号可被解码,且可计算来自编码之前及解码经编码的信号之后的多声道信号的残余信号以改良解码器侧的经编码的音频信号的解码质量。此外,在确定用于多声道信号的当前部分的合适编码方案之后,控制器10可分别使用控制信号28a、28b来控制线性预测域编码器及频域编码器。

图2展示根据实施例的线性预测域编码器6的框图。至线性预测域编码器6的输入是由降混频器12降混的降混信号14。此外,线性预测域编码器包括ACELP处理器30及TCX处理器32。ACELP处理器30用于对经降取样的降混信号34进行操作,降混信号可由被降取样器35降取样。此外,时域带宽扩展处理器36可参数化编码降混信号14的部分的频带,其被从输入至ACELP处理器30的经降取样的降混信号34中移除。时域带宽扩展处理器36可输出降混信号14的部分的经参数化编码的频带38。换言之,时域带宽扩展处理器36可计算可包括相比降取样器35的截止频率较高的频率的降混信号14的频带的参数化表示。因此,降取样器35可具有其他属性以将高于降取样器的截止频率的那些频带提供至时域带宽扩展处理器36,或将截止频率提供至时域带宽扩展(TD-BWE)处理器以使TD-BWE处理器36能够计算用于降混信号14的正确部分的参数38。

此外,TCX处理器用于对降混信号进行操作,降混信号(例如)未被降取样或以小于用于ACELP处理器的降取样的程度被降取样。当与输入至ACELP处理器30的经降取样的降混信号35相比时,小于ACELP处理器的降取样的程度的降取样可以是使用较高的截止频率的降取样,其中大量的降混信号的频带被提供至TCX处理器。TCX处理器还可包括第一时间-频率转换器40,如MDCT、DFT或DCT。TCX处理器32还可包括第一参数生成器42及第一量化器编码器44。第一参数生成器42(例如,智能间隙填充(intelligent gap filling,IGF)算法)可计算第一频带集合的第一参数化表示46,其中第一量化器编码器44(例如)使用TCX算法来计算用于第二频带集合的经量化编码的频谱线的第一集合48。换言之,第一量化器编码器可参数化编码入站信号(inbound signal)的相关频带(如,音调频带),其中第一参数生成器将例如IGF算法应用于入站信号的剩余频带以进一步减小经编码的音频信号的带宽。

线性预测域编码器6还可包括线性预测域解码器50,其用于解码降混信号14(例如),由经ACELP处理的经降取样的降混信号52来表示)和/或第一频带集合的第一参数化表示46和/或用于第二频带集合的经量化编码的频谱线的第一集合48来表示的降混信号14。线性预测域解码器50的输出可以是经编码且经解码的降混信号54。此信号54可被输入至多声道残余编码器56,其可使用经编码且经解码的降混信号54来计算并编码多声道残余信号58,其中经编码的多声道残余信号表示使用第一多声道信息的经解码的多声道表示与降混之前的多声道信号之间的误差。因此,多声道残余编码器56可包括联合编码器侧多声道解码器60和差异处理器62。联合编码器侧多声道解码器60可使用第一多声道信息20及经编码且经解码的降混信号54而生成经解码的多声道信号,其中差异处理器可形成经解码的多声道信号64与降混之前的多声道信号4之间的差异以获得多声道残余信号58。换言之,音频编码器内的联合编码器侧多声道解码器可执行解码操作,这是有利的,相同的解码操作在解码器侧上执行。因此,在用于解码经编码的降混信号的联合编码器侧多声道解码器中使用可在传输之后由音频解码器得出的第一联合多声道信息。差异处理器62可计算经解码的联合多声道信号与原始多声道信号4之间的差异。经编码的多声道残余信号58可改进音频解码器的解码质量,因为经解码的信号与原始信号之间的由于(例如)参数化编码所致的差异可通过了解这两个信号之间的差异来减小。此使得第一联合多声道编码器能够以得出用于多声道音频信号的全带宽的多声道信息的方式进行操作。

此外,降混信号14可包括低频带及高频带,其中线性预测域编码器6用于使用(例如)时域带宽扩展处理器36来施加带宽扩展处理以用于参数化编码高频带,其中线性预测域解码器6用于仅获得表示降混信号14的低频带的低频带信号作为经编码且经解码的降混信号54,且其中经编码的多声道残余信号仅具有在降混之前的多声道信号的低频带内的频率。换言之,带宽扩展处理器可计算用于高于截止频率的频带的带宽扩展参数,其中ACELP处理器对低于截止频率的频率进行编码。解码器因此用于基于经编码的低频带信号及带宽参数38来重建较高频率。

根据其他实施例,多声道残余编码器56可计算侧信号,且其中降混信号为M/S多声道音频信号的对应中间信号。因此,多声道残余编码器可计算并编码经计算的侧信号(其可计算自由滤波器组82获得的多声道音频信号的全频带频谱表示)与经编码且经解码的降混信号54的倍数的经预测的侧信号的差异,其中倍数可由成为多声道信息的部分的预测信息来表示。然而,降混信号仅包括低频带信号。因此,残余编码器还可计算用于高频带的残余(或侧)信号。此计算可(例如)通过模拟时域带宽扩展(如在线性预测域核心编码器中所进行的)或通过预测作为经计算的(全频带)侧信号与经计算的(全频带)中间信号之间的差异的侧信号来执行,其中预测因子用于将两个信号之间的差异最小化。

图3展示根据实施例的频域编码器8的示意性框图。频域编码器包括第二时间-频率转换器66、第二参数生成器68以及第二量化器编码器70。第二时间-频率转换器66可将多声道信号的第一声道4a及多声道信号的第二声道4b转换成频谱表示72a、72b。第一声道及第二声道的频谱表示72a、72b可被分析且各自分裂成第一频带集合74及第二频带集合76。因此,第二参数生成器68可生成第二频带集合76的第二参数化表示78,其中第二量化器编码器可生成第一频带集合74的经量化且经编码的表示80。频域编码器或更特别地,第二时间-频率转换器66可针对第一声道4a及第二声道4b执行(例如)MDCT操作,其中第二参数生成器68可执行智能间隙填充算法且第二量化器编码器70可执行(例如)AAC操作。因此,如关于线性预测域编码器已描述的,频域编码器也能够以得出用于多声道音频信号的全带宽的多声道信息的方式来操作。

图4展示根据优选实施例的音频编码器2的示意性框图。LPD路径16由含有“有源或无源DMX”降混计算12的联合立体声或多声道编码组成,降混计算指示LPD降混可为有源(“频率选择性”)或无源(“恒定混合因子”),如图5中所描绘。降混还可由TD-BWE模块或IGF模块支持的可切换单声道ACELP/TCX核心来编码。应注意的是,ACELP对经降取样的输入音频数据34进行操作。可对经降取样的TCX/IGF输出执行由于切换所致的任何ACELP初始化。

由于ACELP不含有任何内部时间-频率分解,LPD立体声编码借助于LP编码之前的分析滤波器组82及LPD解码之后的合成滤波器组来添加额外的复调制滤波器组。在优选的实施例中,使用具有低重叠区域的过取样的DFT。然而,在其他实施例中,可使用具有类似时间分辨率的任何过取样的时间-频率分解。然后,可在频域中计算立体声参数。

参数化立体声编码通过“LPD立体声参数编码”区块18执行,该区块18将LPD立体声参数20输出至比特流。可选择地,后续区块“LPD立体声残余编码”将向量量化的低通降混残余58添加至比特流。

FD路径8被配置为具有其自身的内部联合立体声或多声道编码。对于联合立体声编码,路径再次使用其自身的临界取样及实值的滤波器组66,即(例如)MDCT。

提供至解码器的信号可(例如)多路复用至单一比特流。比特流可包括经编码的降混信号26,经编码的降混信号还可包括以下各者中的至少一个:经参数化编码的经时域带宽扩展的频带38、经ACELP处理的经降取样的降混信号52、第一多声道信息20、经编码的多声道残余信号58、第一频带集合的第一参数化表示46、第二频带集合的经量化编码的频谱线的第一集合48以及包括第一频带集合的经量化且经编码的表示80及第一频带集合的第二参数化表示78的第二多声道信息24。

实施例展示用于将可切换核心编解码器、联合多声道编码以及参数化空间音频编码组合成完全可切换感知编解码器的经改良的方法,完全可切换感知编解码器允许依据核心编码器的选择而使用不同的多声道编码技术。特别地,在可切换音频编码器内,组合本地(native)频域立体声编码与基于ACELP/TCX的线性预测性编码(其具有其自身的专用独立参数化立体声编码)。

图5a及图5b分别展示根据实施例的有源降混频器及无源降混频器。有源降混频器使用(例如)用于将时域信号4变换成频域信号的时间频率转换器82而在频域中操作。在降混之后,频率-时间转换(例如,IDFT)可将来自频域的降混信号转换成时域中的降混信号14。

图5b展示根据实施例的无源降混频器12。无源降混频器12包括加法器,其中第一声道4a及第一声道4b在分别使用权重a 84a及权重b 84b加权之后被组合。此外,第一声道4a及第二声道4b在传输至LPD立体声参数化编码之前可被输入至时间-频率转换器82。

换言之,降混频器用于将多声道信号转换成频谱表示,且其中使用频谱表示或使用时域表示执行降混,且其中第一多声道编码器用于使用频谱表示来生成用于频谱表示的各个频带的单独第一多声道信息。

图6展示根据实施例的用于对经编码的音频信号103进行解码的音频解码器102的示意性框图。音频解码器102包括线性预测域解码器104、频域解码器106、第一联合多声道解码器108、第二多声道解码器110以及第一组合器112。经编码的音频信号103(其可以是先前所描述的编码器部分的经多路复用的比特流,例如音频信号的帧)可被联合多声道解码器108使用第一多声道信息20来解码或被频域解码器106解码,且被第二联合多声道解码器110使用第二多声道信息24进行多声道解码。第一联合多声道解码器可输出第一多声道表示114,且第二联合多声道解码器110的输出可以是第二多声道表示116。

换言之,第一联合多声道解码器108使用线性预测域编码器的输出及使用第一多声道信息20生成第一多声道表示114。第二多声道解码器110使用频域解码器的输出及第二多声道信息24生成第二多声道表示116。此外,第一组合器组合第一多声道表示114及第二多声道表示116(例如,基于帧)以获得经解码的音频信号118。此外,第一联合多声道解码器108可以是使用(例如)复数预测(complex prediction)、参数化立体声操作或旋转操作的参数化联合多声道解码器。第二联合多声道解码器110可以是使用(例如)频带选择性切换至中间/侧或左/右立体声解码算法的波形保持联合多声道解码器。

图7展示根据另一实施例的解码器102的示意性框图。本文中,线性预测域解码器102包括ACELP解码器120、低频带合成器122、升取样器124、时域带宽扩展处理器126或用于组合经升取样的信号和经带宽扩展的信号的第二组合器128。此外,线性预测域解码器可包括TCX解码器132及智能间隙填充处理器132,其在图7中被描绘为一个区块。此外,线性预测域解码器102可包括用于组合第二组合器128及TCX解码器130及IGF处理器132的输出的全频带合成处理器134。如关于编码器已展示的,时域带宽扩展处理器126、ACELP解码器120以及TCX解码器130并行地工作以解码各个经传输的音频信息。

可提供交叉路径136,其用于使用从低频带频谱-时间转换(使用例如频率-时间转换器138)自TCX解码器130及IGF处理器132得出的信息来初始化低频带合成器。参照声道的模型,ACELP数据可模型化声道的形状,其中TCX数据可模型化声道的激励。由低频带频率-时间转换器(如IMDCT解码器)表示的交叉路径136使低频带合成器122能够使用声道的形状及当前激励来重新计算或解码经编码的低频带信号。此外,经合成的低频带被升取样器124升取样,且使用例如第二组合器128而被与经时域带宽扩展的高频带140组合,以(例如)整形经升取样的频率以恢复(例如)每个经升取样的频带的能量。

全频带合成器134可使用第二组合器128的全频带信号及来自TCX处理器130的激励来形成经解码的降混信号142。第一联合多声道解码器108可包括时间-频率转换器144,其用于将线性预测域解码器的输出(例如,经解码的降混信号142)转换成频谱表示145。此外,升混频器(例如,实施于立体声解码器146中)可由第一多声道信息20控制以将频谱表示升混成多声道信号。此外,频率-时间转换器148可将升混结果转换成时间表示114。时间-频率和/或频率-时间转换器可包括复数运算(complex operation)或过取样的操作,诸如DFT或IDFT。

此外,第一联合多声道解码器或更特别地立体声解码器146可使用(例如)由多声道经编码的音频信号103提供的多声道残余信号58来生成第一多声道表示。此外,多声道残余信号可包括比第一多声道表示低的带宽,其中第一联合多声道解码器用于使用第一多声道信息重建中间第一多声道表示且将多声道残余信号添加至中间第一多声道表示。换言之,立体声解码器146可包括使用第一多声道信息20的多声道解码,且在经解码的降混信号的频谱表示已被升混成多声道信号之后,可选择地包括通过将多声道残余信号添加至经重建的多声道信号的经重建的多声道信号的改良。因此,第一多声道信息及残余信号可能已对多声道信号起作用。

第二联合多声道解码器110可使用由频域解码器获得的频谱表示作为输入。频谱表示包括至少针对多个频带的第一声道信号150a及第二声道信号150b。此外,第二联合多声道处理器110可适用于第一声道信号150a及第二声道信号150b的多个频带。联合多声道操作,(如掩码(mask),)为各个频带指示左/右或中间/侧联合多声道编码,且其中联合多声道操作是用于将由掩码指示的频带从中间/侧表示转换为左/右表示的中间/侧或左/右转换操作,其为联合多声道操作的结果至时间表示以获得第二多声道表示的转换。此外,频域解码器可包括频率-时间转换器152,其为(例如)IMDCT操作或特定取样的操作。换言之,掩码可包括指示(例如)L/R或M/S立体声编码的旗标,其中第二联合多声道编码器将对应立体声编码算法应用于各个音频帧。可选择地,智能间隙填充可应用于经编码的音频信号以进一步减小经编码的音频信号的带宽。因此,例如,音调频带可使用前面提及的立体声编码算法以高分辨率被编码,其中其他频带可使用(例如)IGF算法被参数化编码。

换言之,在LPD路径104中,经传输的单声道信号是被(例如)由TD-BWE 126或IGF模块132支持的可切换ACELP/TCX 120/130解码器重建的。将对经降取样的TCX/IGF输出执行因切换所致的任何ACELP初始化。ACELP的输出使用(例如)升取样器124被升取样至全采样率。所有信号,使用(例如)混频器128以高采样率在时域中被混合,且被LPD立体声解码器146进一步处理以提供LPD立体声。

LPD“立体声解码”是由受经传输的立体声参数20的应用操控的经传输的降混的升混组成。可选择地,降混残余58也包含于比特流中。在此情况下,残余被“立体声解码”146解码且被包括于升混计算中。

FD路径106被配置为具有其自身的独立内部联合立体声或多声道解码。对于联合立体声解码,路径再次使用其自身的临界取样及实值的滤波器组152,例如(即)IMDCT。

LPD立体声输出及FD立体声输出使用(例如)第一组合器112而在时域中被混频,以提供全切换式编码器的最终输出118。

尽管关于相关附图中的立体声解码描述了多声道,但相同原理通常也可应用于利用两个或更多个声道的多声道处理。

图8展示用于编码多声道信号的方法800的示意性框图。方法800包括:执行线性预测域编码的步骤805;执行频域编码的步骤810;在线性预测域编码与频域编码之间切换的步骤815,其中线性预测域编码包括降混多声道信号以获得降混信号、对降混信号进行线性预测域核心编码以及从多声道信号生成第一多声道信息的第一联合多声道编码,其中频域编码包括从多声道信号生成第二多声道信息的第二联合多声道编码,其中第二联合多声道编码不同于第一多声道编码,且其中切换被执行以使得多声道信号的部分由线性预测域编码的编码帧或由频域编码的编码帧表示。

图9展示对经编码的音频信号进行解码的方法900的示意性框图。方法900包括:线性预测域解码的步骤905;频域解码的步骤910;使用线性预测域解码的输出及使用第一多声道信息来生成第一多声道表示的第一联合多声道解码的步骤915;使用频域解码的输出及第二多声道信息来生成第二多声道表示的第二多声道解码的步骤920;以及组合第一多声道表示及第二多声道表示以获得经解码的音频信号的步骤925,其中第二多声道信息解码不同于第一多声道解码。

图10展示根据另一方面的用于编码多声道信号的音频编码器的示意性框图。音频编码器2'包括线性预测域编码器6及多声道残余编码器56。线性预测域编码器包括用于对多声道信号4进行降混以获得降混信号14的降混频器12、用于编码降混信号14的线性预测域核心编码器16。线性预测域编码器6还包括用于从多声道信号4生成多声道信息20的联合多声道编码器18。此外,线性预测域编码器包括用于对经编码的降混信号26进行解码以获得经编码且经解码的降混信号54的线性预测域解码器50。多声道残余编码器56可使用经编码且经解码的降混信号54来计算并编码多声道残余信号。多声道残余信号可表示使用多声道信息20的经解码的多声道表示54与降混之前的多声道信号4之间的误差。

根据实施例,降混信号14包括低频带及高频带,其中线性预测域编码器可使用带宽扩展处理器来施加带宽扩展处理以用于参数化编码高频带,其中线性预测域解码器用于仅获得表示降混信号的低频带的低频带信号作为经编码且经解码的降混信号54,且其中经编码的多声道残余信号仅具有对应于降混之前的多声道信号的低频带的频带。此外,关于音频编码器2的相同描述可应用于音频编码器2'。然而,省略编码器2的其他频率编码。此省略简化了编码器配置,且因此在以下情况下是有利的:编码器仅用于仅包括可在时域中被参数化编码而无明显质量损失的信号的音频信号,或经解码的音频信号的质量仍在规范内。然而,专用残余立体声编码对于增加经解码的音频信号的再现质量是有利的。更特别地,编码之前的音频信号与经编码且经解码的音频信号之间的差异被得出且被传输至解码器以增加经解码的音频信号的再现质量,因为经解码的音频信号与经编码的音频信号的差异已被解码器知晓。

图11展示根据另一方面的用于解码经编码的音频信号103的音频解码器102'。音频解码器102'包括线性预测域解码器104,以及用于使用线性预测域解码器104的输出及联合多声道信息20来生成多声道表示114的联合多声道解码器108。此外,经编码的音频信号103可包括多声道残余信号58,其可被多声道解码器用来生成多声道表示114。此外,与音频解码器102相关的相同解释可应用于音频解码器102'。本文中,从原始音频信号至经解码的音频信号的残余信号被使用并被应用至经解码的音频信号以至少几乎达成与原始音频信号相比的相同质量的经解码的音频信号,即使在使用了参数化且因此有损的编码的情况下。然而,在音频解码器102'中省略关于音频解码器102所展示的频率解码部分。

图12展示用于编码多声道信号的音频编码方法1200的示意性框图。方法1200包括:线性预测域编码的步骤1205,其包括对多声道信号进行降混以获得降混多声道信号,以及线性预测域核心编码器从多声道信号生成多声道信息,其中方法还包括对降混信号进行线性预测域解码以获得经编码且经解码的降混信号;以及多声道残余编码的步骤1210,其使用经编码且经解码的降混信号来计算经编码的多声道残余信号,多声道残余信号表示使用第一多声道信息的经解码的多声道表示与降混之前的多声道信号之间的误差。

图13展示对经编码的音频信号进行解码的方法1300的示意性框图。方法1300包括线性预测域解码的步骤1305,以及联合多声道解码的步骤1310,其使用线性预测域解码的输出及联合多声道信息来生成多声道表示,其中经编码的多声道音频信号包括声道残余信号,其中联合多声道解码使用多声道残余信号以生成多声道表示。

所描述的实施例可得以用在所有类型的立体声或多声道音频内容(在给定低比特率下具有恒定感知质量的语音及相似音乐)的广播的分布如关于数字无线电、因特网串流及音频通信应用中。

图14至图17描述如何在LPD编码与频域编码之间及相反情况应用所提出的无缝切换的实施例。通常,之前的窗口化或处理使用细线来指示,粗线指示切换被施加的当前的窗口化或处理,且虚线指示只为过渡或切换进行的当前处理。从LPD编码至频率编码的切换或过渡。

图14展示指示频域编码至时域编码之间的无缝切换的实施例的示意性时序图。若(例如)控制器10指示使用LPD编码而不是用于先前帧的FD编码来更好地编码当前帧,则此图可能相关。在频域编码期间,停止窗口200a及200b可应用于每个立体声信号(其可选择性地扩展至两个以上声道)。停止窗口不同于在第一帧204的开始202处衰落的标准MDCT重叠相加。停止窗口的左边部分可为用于使用(例如)MDCT时间-频率变换来编码先前帧的经典重叠相加。因此,切换之前的帧仍被合适地编码。对于施加切换的当前帧204,计算额外立体声参数,即便用于时域编码的中间信号的第一参数化表示被计算用于随后的帧206。进行这两个额外的立体声分析以用于能够生成用于LPD预看的中间信号208。不过,在两个第一LPD立体声窗口中(另外地)传输立体声参数。正常情况下,立体声参数以两个LPD立体声帧的延迟被发送。为了更新ACELP内存(如为了LPC分析或前向混叠消除(forward aliasingcancellation,FAC)),中间信号也变得可用于过去。因此,在(例如)应用使用DFT的时间-频率转换之前,可在分析滤波器组82中应用用于第一立体声信号的LPD立体声窗口210a至210d及用于第二立体声信号的LPD立体声窗口212a至212d。中间信号在使用TCX编码时可包括典型淡入淡出渐变(crossfade ramp),从而导致例示性LPD分析窗口214。若将ACELP用于编码音频信号(诸如单声道低频带信号),则简单地选择应用LPC分析的多个频带,通过矩形LPD分析窗口216来指示。

此外,由垂直线218指示的时序展示:施加有过渡的当前帧包括来自频域分析窗口200a、200b的信息以及经计算的中间信号208及对应立体声信息。在线202与线218之间的频率分析窗口的水平部分期间,帧204使用频域编码而被完美地编码。从线218至频率分析窗口在线220处的结束,帧204包括来自频域编码及LPD编码二者的信息,且从线220至帧204在垂直线222处的结束,仅LPD编码有助于帧的编码。进一步地注意编码的中间部分,因为第一及最后(第三)部分仅从一个编码技术得出而不具有混叠。然而,对于中间部分,其应在ACELP与TCX单声道信号编码之间进行区分。由于TCX编码使用淡入淡出,如关于频域编码已应用,频率经编码的信号的简单淡出及经TCX编码的中间信号的淡入提供用于编码当前帧204的完整信息。若将ACELP用于单声道信号编码,则可应用更复杂的处理,因为区域224可能不包括用于编码音频信号的完整信息。所提出的方法为前向混叠校正(forwardaliasing correction,FAC),例如,在USAC规范中在章节7.16中所描述。

根据实施例,控制器10用于在多声道音频信号的当前帧204内从使用频域编码器8对先前帧进行编码切换至使用线性预测域编码器对即将到来的帧(upcoming frame)进行解码。第一联合多声道编码器18可从当前帧的多声道音频信号计算合成多声道参数210a、210b、212a、212b,其中第二联合多声道编码器22用于使用停止窗口对第二多声道信号进行加权。

图15展示对应于图14的编码器操作的解码器的示意性时序图。本文中,根据实施例来描述当前帧204的重建。如在图14的编码器时序图中所见,从应用停止窗口200a及200b的先前帧提供频域立体声声道。如在单声道情况下,首先对经解码的中间信号进行从FD至LPD模式的过渡。这通过从以FD模式解码的时域信号116人工建立中间信号226来达成,其中ccfl为核心码帧长度且L_fac表示频率混叠消除窗口或帧或区块或变换的长度。

此信号接着被传输至LPD解码器120以用于更新内存及应用FAC解码,如在单声道情况下针对FD模式至ACELP的过渡所进行的。在USAC规范[ISO/IEC DIS 23003-3,Usac]中在章节7.16中描述了处理。在FD模式至TCX的情况下,执行传统的重叠相加。例如,通过将所传输的立体声参数210及212用于立体声处理,其中过渡已经完成,LPD立体声解码器146接收经解码的(在频域中,在应用时间-频率转换器144的时间-频率转换之后)中间信号作为输入信号。然后,立体声解码器输出与以FD模式解码的先前帧重叠的左声道信号228及右声道信号230。然后,信号(即,用于施加过渡的帧的经FD解码的时域信号及经LPD解码的时域信号)在每个声道上淡入淡出(在组合器112中)以用于平滑左声道及右声道中的过渡:

在图15中,使用M=ccfl/2来示意性地说明过渡。此外,组合器可在仅使用FD或LPD解码来解码而没有这些模式之间的过渡的连续帧处的执行淡入淡出。

换言之,FD解码的重叠相加过程(尤其当将MDCT/IMDCT用于时间-频率/频率-时间转换时)被替换为经FD解码的音频信号及经LPD解码的音频信号的淡入淡出。因此,解码器应计算用于经FD解码的音频信号的淡出部分至经LPD解码的音频信号的淡入部分的LPD信号。根据实施例,音频解码器102用于在多声道音频信号的当前帧204内从使用频域解码器106对先前帧进行解码切换至使用线性预测域解码器104对即将到来的帧进行解码。组合器112可从当前帧的第二多声道表示116来计算合成中间信号226。第一联合多声道解码器108可使用合成中间信号226及第一多声道信息20来生成第一多声道表示114。此外,组合器112用于组合第一多声道表示及第二多声道表示以获得多声道音频信号的经解码的当前帧。

图16展示用于在当前帧232中执行使用LPD编码至使用FD解码的过渡的编码器中的示意性时序图。为了从LPD切换至FD编码,可对FD多声道编码应用开始窗口300a、300b。当与停止窗口200a、200b相比时,开始窗口具有类似功能。在垂直线234与236之间的LPD编码器的经TCX编码的单声道信号的淡出期间,开始窗口300a、300b执行淡入。当使用ACELP替代TCX时,单声道信号不执行平滑淡出。尽管如此,可使用(例如)FAC在解码器中重建正确音频信号。LPD立体声窗口238及240被默认地计算且参考经ACELP或TCX编码的单声道信号(由LPD分析窗口241指示)。

图17展示对应于关于图16所描述的编码器的时序图的解码器中的示意性时序图。

对于从LPD模式至FD模式的过渡,由立体声解码器146解码额外帧。来自LPD模式解码器的中间信号以零进行扩展以用于帧索引i=ccfl/M。

如先前所描述的立体声解码可通过保留上一个立体声参数及通过切断侧信号反量化(即,将code_mode设定为0)来执行。此外,反向DFT之后的右侧窗口化不被应用,此导致额外LPD立体声窗口244a、244b的陡峭边缘242a、242b。可清晰地看到,形状边缘位于平面区段246a、246b处,其中帧的对应部分的整个信息可从经FD编码的音频信号得出。因此,右侧窗口化(无陡峭边缘)可导致LPD信息对FD信息的不想要的干扰且因此不被应用。

然后,通过在TCX至FD模式的情况下使用重叠相加处理或通过在ACELP至FD模式的情况下对每个声道使用FAC将所得的左和右(经LPD解码的)声道250a、250b(使用由LPD分析窗口248指示的经LPD解码的中间信号及立体声参数)组合至下个帧的经FD模式解码的声道。在图17中描绘过渡的示意性说明,其中M=ccfl/2。

根据实施例,音频解码器102可在多声道音频信号的当前帧232内从使用线性预测域解码器104对先前帧进行解码切换至使用频域解码器106对即将到来的帧进行解码。立体声解码器146可使用先前帧的多声道信息从用于当前帧的线性预测域解码器的经解码的单声道信号计算合成多声道音频信号,其中第二联合多声道解码器110可计算用于当前帧的第二多声道表示及使用开始窗口对第二多声道表示加权。组合器112可组合合成多声道音频信号及经加权的第二多声道表示以获得多声道音频信号的经解码的当前帧。

图18展示用于编码多声道信号4的编码器2”的示意性框图。音频编码器2”包括降混频器12、线性预测域核心编码器16、滤波器组82以及联合多声道编码器18。降混频器12用于对多声道信号4进行降混以获得降混信号14。降混信号可以是单声道信号,例如M/S多声道音频信号的中间信号。线性预测域核心编码器16可编码降混信号14,其中降混信号14具有低频带及高频带,其中线性预测域核心编码器16用于施加带宽扩展处理以用于对高频带进行参数化编码。此外,滤波器组82可生成多声道信号4的频谱表示,且联合多声道编码器18可用于处理包括多声道信号的低频带及高频带的频谱表示以生成多声道信息20。多声道信息可包括ILD和/或IPD和/或双耳强度差异(IID,Interaural Intensity Difference)参数,从而使解码器能够从单声道信号重新计算多声道音频信号。根据此方面的实施例的其他方面的更详细的附图可在先前图中、尤其在图4中找到。

根据实施例,线性预测域核心编码器16还可包括用于对经编码的降混信号26进行解码以获得经编码且经解码的降混信号54的线性预测域解码器。本文中,线性预测域核心编码器可形成被编码的M/S音频信号的中间信号用于传输至解码器。此外,音频编码器还包括用于使用经编码且经解码的降混信号54来计算经编码的多声道残余信号58的多声道残余编码器56。多声道残余信号表示使用多声道信息20的经解码的多声道表示与降混之前的多声道信号4之间的误差。换言之,多声道残余信号58可以是M/S音频信号的侧信号,其对应于使用线性预测域核心编码器计算的中间信号。

根据其他实施例,线性预测域核心编码器16用于施加带宽扩展处理以用于对高频带进行参数化编码以及仅获得表示降混信号的低频带的低频带信号以作为经编码且经解码的降混信号,且其中经编码的多声道残余信号58仅具有对应于降混之前的多声道信号的低频带的频带。额外地或可选地,多声道残余编码器可模拟在线性预测域核心编码器中应用于多声道信号的高频带的时域带宽扩展,并计算用于高频带的残余或侧信号以使得能够更准确地解码单声道或中间信号从而得出经解码的多声道音频信号。模拟可包括相同或类似计算,其在解码器中执行以解码经带宽扩展的高频带。作为模拟带宽扩展的替代或补充的方法可以是预测侧信号。因此,多声道残余编码器可从滤波器组82中的时间-频率转换之后的多声道音频信号4的参数化表示83来计算全频带残余信号。可比较此全频带侧信号与从参数化表示83类似地得出的全频带中间信号的频率表示。全频带中间信号可(例如)被计算为参数化表示83的左声道及右声道的总和,且全频带侧信号可被计算为左声道及右声道的差。此外,预测因此可计算全频带中间信号的预测因子,最小化预测因子及全频带中间信号的乘积与全频带侧信号的绝对差。

换言之,线性预测域编码器可用于计算降混信号14以作为M/S多声道音频信号的中间信号的参数化表示,其中多声道残余编码器可用于计算对应于M/S多声道音频信号的中间信号的侧信号,其中残余编码器可使用模拟时域带宽扩展来计算中间信号的高频带,或其中残余编码器可使用发现预测信息来预测中间信号的高频带,预测信息最小化来自先前帧的经计算的侧信号与经计算的全频带中间信号之间的差异。

其他实施例展示包括ACELP处理器30的线性预测域核心编码器16。ACELP处理器可对经降取样的降混信号34进行操作。此外,时域带宽扩展处理器36用于对降混信号的通过第三降取样从ACELP输入信号中移除的部分的频带进行参数化编码。额外地或可选地,线性预测域核心编码器16可包括TCX处理器32。TCX处理器32可对降混信号14进行操作,该降混信号未被降取样或以小于用于ACELP处理器的降取样的程度而被降取样。此外,TCX处理器可包括第一时间-频率转换器40、用于生成第一频带集合的参数化表示46的第一参数生成器42以及用于生成第二频带集合的经量化编码的频谱线的集合48的第一量化器编码器44。ACELP处理器及TCX处理器可分别地执行(例如,使用ACELP编码第一数目的帧,且使用TCX编码第二数目的帧),或以ACELP及TCX均贡献信息以解码一个帧的联合方式执行。

其他实施例展示不同于滤波器组82的时间-频率转换器40。滤波器组82可包括经优化以生成多声道信号4的频谱表示83的滤波器参数,其中时间-频率转换器40可包括经优化以生成第一频带集合的参数化表示46的滤波器参数。在另一步骤中,必须注意,线性预测域编码器在带宽扩展和/或ACELP的情况下使用不同滤波器组或甚至不使用滤波器组。此外,滤波器组82可不依赖于线性预测域编码器的先前参数选择而计算单独的滤波器参数以生成频谱表示83。换言之,LPD模式中的多声道编码可使用用于多声道处理的滤波器组(DFT),其并非是在带宽扩展(时域用于ACELP且MDCT用于TCX)中所使用的滤波器组。此情况的优点为每个参数化编码可使用其最佳时间-频率分解以得到其参数。例如,ACELP+TDBWE与利用外部滤波器组(例如,DFT)的参数化多声道编码的组合是有利的。此组合特别有效率,因为已知用于语音的最佳带宽扩展应在时域中且多声道处理应在频域中。由于ACELP+TDBWE不具有任何时间-频率转换器,因此如DFT的外部滤波器组或变换是优选的或甚至可能是必需的。其他概念始终使用相同滤波器组且因此不使用不同的滤波器组,例如:

-在MDCT中用于AAC的IGF及联合立体声编码

-在QMF中用于HeAACv2的SBR+PS

-在QMF中用于USAC的SBR+MPS212

根据其他实施例,多声道编码器包括第一帧生成器且线性预测域核心编码器包括第二帧生成器,其中第一和第二帧生成器用于从多声道信号4形成帧,其中第一和第二帧生成器用于形成具有类似长度的帧。换言之,多声道处理器的成帧可与ACELP中所使用的成帧相同。即使多声道处理是在频域中进行,用于计算其参数或降混的时间分辨率应理想地接近于或甚至等于ACELP的成帧。此情况下的类似长度可指ACELP的成帧,其可等于或接近于用于计算用于多声道处理或降混的参数的时间分辨率。

根据其他实施例,音频编码器还包括线性预测域编码器6(其包括线性预测域核心编码器16及多声道编码器18)、频域编码器8以及用于在线性预测域编码器6与频域编码器8之间切换的控制器10。频域编码器8可包括用于对于来自多声道信号的第二多声道信息24进行编码的第二联合多声道编码器22,其中第二联合多声道编码器22不同于第一联合多声道编码器18。此外,控制器10被配置为使得多声道信号的部分由线性预测域编码器的编码帧表示或由频域编码器的编码帧表示。

图19展示根据另一方面的用于对经编码的音频信号103进行解码的解码器102”的示意性框图,经编码的音频信号包括经核心编码的信号、带宽扩展参数以及多声道信息。音频解码器包括线性预测域核心解码器104、分析滤波器组144、多声道解码器146以及合成滤波器组处理器148。线性预测域核心解码器104可对经核心编码的信号进行解码以生成单声道信号。此信号可为M/S经编码的音频信号的(全频带)中间信号。分析滤波器组144可将单声道信号转换成频谱表示145,其中多声道解码器146可从单声道信号的频谱表示及多声道信息20生成第一声道频谱及第二声道频谱。因此,多声道解码器可使用多声道信息,多声道信息(例如)包括对应于经解码的中间信号的侧信号。合成滤波器组处理器148用于对第一声道频谱进行合成滤波以获得第一声道信号且用于对第二声道频谱进行合成滤波以获得第二声道信号。因此,优选地,与分析滤波器组144相比的反向操作可应用于第一声道信号及第二声道信号,若分析滤波器组使用DFT,则反向操作可为IDFT。然而,滤波器组处理器可使用(例如)相同的滤波器组并行地或以连续次序来(例如)处理两个声道频谱。关于此另一方面的其他详细附图可在先前图中、尤其关于图7看出。

根据其他实施例,线性预测域核心解码器包括:用于从带宽扩展参数及低频带单声道信号或经核心编码的信号生成高频带部分140以获得音频信号的经解码的高频带140的带宽扩展处理器126;用于解码低频带单声道信号的低频带信号处理器;以及用于使用经解码的低频带单声道信号及音频信号的经解码的高频带来计算全频带单声道信号的组合器128。低频带单声道信号可以是(例如)M/S多声道音频信号的中间信号的基带表示,其中带宽扩展参数可被应用以(在组合器128中)从低频带单声道信号计算全频带单声道信号。

根据其他实施例,线性预测域解码器包括ACELP解码器120、低频带合成器122、升取样器124、时域带宽扩展处理器126或第二组合器128,其中第二组合器128用于组合经升取样的低频带信号及经带宽扩展的高频带信号140以获得全频带经ACELP解码的单声道信号。线性预测域解码器还可包括TCX解码器130及智能间隙填充处理器132以获得全频带经TCX解码的单声道信号。因此,全频带合成处理器134可组合全频带经ACELP解码的单声道信号及全频带经TCX解码的单声道信号。另外,可提供交叉路径136以用于使用通过低频带频谱-时间转换从TCX解码器及IGF处理器得出的信息来初始化低频带合成器。

根据其他实施例,音频解码器包括:频域解码器106;用于使用频域解码器106的输出及第二多声道信息22、24生成第二多声道表示116的第二联合多声道解码器110;以及用于将第一声道信号及第二声道信号与第二多声道表示116进行组合以获得经解码的音频信号118的第一组合器112,其中第二联合多声道解码器不同于第一联合多声道解码器。因此,音频解码器可在使用LPD的参数化多声道解码或频域解码之间切换。已关于先前附图详细地描述了此方法。

根据其他实施例,分析滤波器组144包括DFT以将单声道信号转换成频谱表示145,且其中全频带合成处理器148包括IDFT以将频谱表示145转换成第一声道信号及第二声道信号。此外,分析滤波器组可对经DFT转换的频谱表示145应用窗口,以使得先前帧的频谱表示的右边部分及当前帧的频谱表示的左边部分重叠,其中先前帧和当前帧是连续的。换言之,淡入淡出可从一个DFT区块应用至另一区块以执行连续的DFT区块之间的平滑过渡和/或减少区块伪声。

根据其他实施例,多声道解码器146用于从单声道信号获得第一声道信号及第二声道信号,其中单声道信号为多声道信号的中间信号,且其中多声道解码器146用于获得M/S多声道经解码的音频信号,其中多声道解码器用于从多声道信息计算侧信号。此外,多声道解码器146可用于自M/S多声道经解码的音频信号计算L/R多声道经解码的音频信号,其中多声道解码器146可使用多声道信息及侧信号来计算用于低频带的L/R多声道经解码的音频信号。额外地或可选地,多声道解码器146可从中间信号计算经预测的侧信号,且其中多声道解码器还用于使用经预测的侧信号及多声道信息的ILD值来计算用于高频带的L/R多声道经解码的音频信号。

此外,多声道解码器146还可用于对L/R经解码的多声道音频信号执行复数运算,其中多声道解码器可使用经编码的中间信号的能量及经解码的L/R多声道音频信号的能量来计算复数运算的幅度以获得能量补偿。此外,多声道解码器用于使用多声道信息的IPD值计算复数运算的相位。在解码之后,经解码的多声道信号的能量、水平或相位可不同于经解码的单声道信号。因此,可确定复数运算,以使得多声道信号的能量、水平或相位被调整至经解码的单声道信号的值。此外,可使用(例如)来自在编码器侧所计算的多声道信息的经计算的IPD参数将相位调整至编码之前的多声道信号的相位的值。此外,经解码的多声道信号的人类感知可适于编码之前的原始多声道信号的人类感知。

图20展示用于编码多声道信号的方法2000的流程图的示意性说明。该方法包括:对多声道信号进行降混以获得降混信号的步骤2050;编码降混信号的步骤2100,其中降混信号具有低频带和高频带,其中线性预测域核心编码器用于施加带宽扩展处理以用于对高频带进行参数化编码;生成多声道信号的频谱表示的步骤2150;以及处理包括多声道信号的低频带及高频带的频谱表示以生成多声道信息的步骤2200。

图21展示对经编码的音频信号进行解码的方法2100的流程图的示意性说明,经编码的音频信号包括经核心编码的信号、带宽扩展参数以及多声道信息。该方法包括:对经核心编码的信号进行解码以生成单声道信号的步骤2105;将单声道信号转换成频谱表示的步骤2110;从单声道信号的频谱表示及多声道信息生成第一声道频谱及第二声道频谱的步骤2115;以及对第一声道频谱进行合成滤波以获得第一声道信号并对第二声道频谱进行合成滤波以获得第二声道信号的步骤2120。

其他实施例描述如下。

比特流语法变化

USAC规范[1]在章节5.3.2辅助有效载荷中的表23应修改如下:

表1-UsacCoreCoderData()的语法

应添加下表:

表1-lpd_stereo_stream()的语法

应在章节6.2 USAC有效载荷中添加以下有效载荷描述。

6.2.x lpd_stereo_stream()

详细解码程序在7.x LPD立体声解码章节中描述。

术语及定义

lpd_stereo_stream() 用以关于LPD模式解码立体声数据的数据元素

res_mode 指示参数频带的频率分辨率的旗标。

q_mode 指示参数频带的时间分辨率的旗标。

ipd_mode 定义用于IPD参数的参数频带的最大值的比特字段。

pred_mode 指示是否使用预测的旗标。

cod_mode 定义侧信号被量化的参数频带的最大值的比特字段。

Ild_idx[k][b] 帧k及频带b的ILD参数索引。

Ipd_idx[k][b] 帧k及频带b的IPD参数索引。

pred_gain_idx[k][b] 帧k及频带b的预测增益索引。

cod_gain_idx 经量化的侧信号的全局增益索引。

协助元素

ccfl 核心码帧长度。

M如表7.x.1中所定义的立体声LPD帧长度。

band_config() 传回经编码的参数频带的数目的函数。函数定义于7.x中

band_limits() 传回经编码的参数频带的数目的函数。函数定义于7.x中

max_band() 传回经编码的参数频带的数目的函数。函数定义于7.x中

ipd_max_band() 传回经编码的参数频带的数目的函数。函数

cod_max_band() 传回经编码的参数频带的数目的函数。函数

cod_L 用于经解码的侧信号的DFT线的数目。

解码过程

LPD立体声编码

工具描述

LPD立体声为离散M/S立体声编码,其中由单声道LPD核心编码器对中间声道进行编码且在DFT域中对侧信号进行编码。经解码的中间信号从LPD单声道解码器输出且然后由LPD立体声模块来处理。立体声解码在DFT域中进行,L及R声道在DFT域中被解码。两个经解码的声道变换回到时域且可然后在此域中与来自FD模式的经解码的声道组合。FD编码模式使用其自身立体声工具,即具有或不具有复数预测的离散立体声。

数据元素

res_mode 指示参数频带的频率分辨率的旗标。

q_mode 指示参数频带的时间分辨率的旗标。

ipd_mode 定义用于IPD参数的参数频带的最大值的比特字段。

pred_mode 指示是否使用预测的旗标。

cod_mode 定义侧信号被量化的参数频带的最大值的比特字段。

Ild_idx[k][b] 帧k及频带b的ILD参数索引。

Ipd_idx[k][b] 帧k及频带b的IPD参数索引。

pred_gain_idx[k][b] 帧k及频带b的预测增益索引。

cod_gain_idx 经量化的侧信号的全局增益索引。

协助元素

ccfl 核心码帧长度。

M如表7.x.1中所定义的立体声LPD帧长度。

band_config() 传回经编码的参数频带的数目的函数。函数定义于7.x中

band_limits() 传回经编码的参数频带的数目的函数。函数定义于7.x中

max_band() 传回经编码的参数频带的数目的函数。函数定义于7.x中

ipd_max_band() 传回经编码的参数频带的数目的函数。函数

cod_max_band() 传回经编码的参数频带的数目的函数。函数

cod_L 用于经解码的侧信号的DFT线的数目。

解码过程

在频域中执行立体声解码。立体声解码充当LPD解码器的后处理。其从LPD解码器接收单声道中间信号的合成。然后,在频域中解码或预测侧信号。然后在时域中重新合成之前在频域中重建声道频谱。独立于LPD模式中所使用的编码模式,立体声LPD对等于ACELP帧的大小的固定帧大小起作用。

频率分析

从长度为M的经解码的帧x来计算帧索引i的DFT频谱。

其中N为信号分析的大小,w为分析窗口且x为来自LPD解码器的经延迟DFT的重叠大小L的帧索引i处的经解码的时间信号。M等于FD模式中所使用的采样率下的ACELP帧的大小。N等于立体声LPD帧大小加DFT的重叠大小。大小视所使用LPD版本而定,如表7.x.1中所报告。

表7.x.1-立体声LPD的DFT及帧大小

| LPD版本 | DFT大小N | 帧大小M | 重叠大小L |

| 0 | 336 | 256 | 80 |

| 1 | 672 | 512 | 160 |

窗口w为正弦窗口,其被定义为:

参数频带的配置

DFT频谱被划分为所谓的参数频带的非重叠频带。频谱的分割是不均匀的并模仿听觉频率分解。频谱的两个不同划分可能具有遵照大致两倍或四倍的等效矩形带宽(ERB)的带宽。

频谱分割是通过数据元素res_mod来选择的且由以下伪码定义:

其中nbands为参数频带的总数目且N为DFT分析窗口大小。表band_limits_erb2及band_limits_erb4在表7.x.2中定义。解码器可每两个立体声LPD帧自适应地改变频谱的参数频带的分辨率。

表7.x.2-关于DFT索引k的参数频带极限

用于IPD的参数频带的最大数目在2比特字段ipd_mod数据元素内发送:

ipd_max_band=max_band[res_mod][ipd_mod]

用于侧信号的编码的参数频带的最大数目在2比特字段cod_mod数据元素内发送:

cod_max_band=max_band[res_mod][cod_mod]

表max_band[][]定义于表7.x.3中。

然后,计算期望用于侧信号的经解码的线的数目:

cod_L=2·(band_limits[cod_max_band]-1)

表7.x.3-用于不同码模式的频带的最大数目

| 模式索引 | max_band[0] | max_band[1] |

| 0 | 0 | 0 |

| 1 | 7 | 4 |

| 2 | 9 | 5 |

| 3 | 11 | 6 |

立体声参数的反量化

立体声参数声道间等级差(Interchannel Level Differencies,ILD)、声道间相位差(Interchannel Phase Differencies,IPD)以及预测增益将依据旗标q_mode而每一帧或每两帧地发送。若q_mode等于0,则在每一帧地更新参数。否则,仅针对USAC帧内的立体声LPD帧的奇数索引i更新参数值。USAC帧内的立体声LPD帧的索引i在LPD版本0中可在0与3之间而在LPD版本1中可在0与1之间。

ILD被解码如下:

ILDi[b]=ild_q[ild_idx[i][b]],对于0≤b<nbands

针对前ipd_max_band个频带解码IPD:

预测增益仅在pred_mode旗标设定为一时被解码。经解码的增益因而为:

若pred_mode等于零,则所有增益被设定为零。

不依赖于q_mode的值,若code_mode为非零值,则侧信号的解码每一帧地执行。其首先解码全局增益:

cod_gaini=10cod_gain_idx[i]·20·127/90

侧信号的经解码的形状为USAC规范[1]中在章节中所描述的AVQ的输出。

表7.x.4-反量化表ild_q[]

| 索引 | 输出 | 索引 | 输出 |

| 0 | -50 | 16 | 2 |

| 1 | -45 | 17 | 4 |

| 2 | -40 | 18 | 6 |

| 3 | -35 | 19 | 8 |

| 4 | -30 | 20 | 10 |

| 5 | -25 | 21 | 13 |

| 6 | -22 | 22 | 16 |

| 7 | -19 | 23 | 19 |

| 8 | -16 | 24 | 22 |

| 9 | -13 | 25 | 25 |

| 10 | -10 | 26 | 30 |

| 11 | -8 | 27 | 35 |

| 12 | -6 | 28 | 40 |

| 13 | -4 | 29 | 45 |

| 14 | -2 | 30 | 50 |

| 15 | 0 | 31 | 预留 |

表7.x.5-反量化表res_pres_gain_q[]

| 索引 | 输出 |

| 0 | 0 |

| 1 | 0.1170 |

| 2 | 0.2270 |

| 3 | 0.3407 |

| 4 | 0.4645 |

| 5 | 0.6051 |

| 6 | 0.7763 |

| 7 | 1 |

反声道映射

首先,中间信号X及侧信号S被如下地转换至左声道L及右声道R:

Li[k]=Xi[k]+gXi[k],对于band_limits[b]≤k<band_limits[b+1],

Ri[k]=Xi[k]-gXi[k],对于band_limits[b]≤k<band_limits[b+1],

其中每个参数频带的增益g是从ILD参数得出的:

对于低于cod_max_band的参数频带,用经解码的侧信号来更新两个声道:

Li[k]=Li[k]+cod_gaini·Si[k],对于0≤k<band_limits[cod_max_band],

Ri[k]=Ri[k]-cod_gaini·Si[k],对于0≤k<band_limits[cod_max_band],

对于较高参数频带,对侧信号进行预测且声道更新如下:

Li[k]=Li[k]+cod_predi[b]·Xi-1[k],对于band_limits[b]≤k<band_limits[b+1],

最终,声道以复值倍增,其目标为恢复信号的原始能量及声道间相位:

Li[k]=a·ej2πβ·Li[k]

Ri[k]=a·ej2πβ·Ri[k]

其中

其中c被约束于-12dB及12dB。

且其中

β=atan2(sin(IPDi[b]),cos(IPDi[b])+c)

其中atan2(x,y)为x相对于y的四象限反正切。

时域合成

从两个经解码的频谱L及R,通过反DFT来合成两个时域信号l及r:

最终,重叠相加法操作允许重建M个样本的帧:

后处理

巴斯后处理被分别地应用于两个声道。处理用于两个声道,与[1]的章节7.17中所描述的相同。

应理解,在本说明书中,线上的信号有时以用于线的附图标记来命名或有时以已经属于线的附图标记本身来指示。因此,标记为使得具有某一信号的线指示信号本身。线在固线式实施中可为实体线。然而,在计算机化实施中,实体线并不存在,但由线表示的信号将从一个计算模块传输至另一计算模块。

尽管已在区块表示实际或逻辑硬件组件的框图的上下文中描述本发明,但本发明亦可由计算机实施方法来实施。在后一情况下,区块表示对应方法步骤,其中这些步骤代表由对应逻辑或实体硬件区块执行的功能性。

尽管已在设备的上下文中描述一些方面,但显然,这些方面也表示对应方法的描述,其中区块或装置对应于方法步骤或方法步骤的特征。类似地,方法步骤的上下文中所描述的方面也表示对应区块或项目或对应设备的特征的描述。可由(或使用)硬件设备(类似于(例如)微处理器、可程序化计算机或电子电路)来执行方法步骤中的一些或全部。在一些实施例中,可由此设备来执行最重要方法步骤中的某一个或多个。

本发明的经传输或经编码的信号可被存储于数字存储媒体上或可在如无线传输媒体的传输媒体或如因特网的有线传输媒体上传输。

依据某些实施要求,本发明的实施例可在硬件中或在软件中实施。可使用上面存储有电子可读控制信号、与可程序化计算机系统协作(或能够协作)以使得执行各个方法的数字存储媒体(例如,软盘、DVD、Blu-Ray、CD、ROM、PROM以及EPROM、EEPROM或闪存)来执行实施。因此,数字存储媒体可以是计算机可读的。

根据本发明的一些实施例包括具有电子可读控制信号的数据载体,其能够与可程序化计算机系统协作,从而执行本文中所描述的方法中的一个。

通常,本发明的实施例可实施为具有程序代码的计算机程序产品,当计算机程序产品在计算机上执行时,程序代码操作性地用于执行方法中的一个。程序代码可(例如)存储于机器可读载体上。

其他实施例包括存储于机器可读载体上的用于执行本文中所描述的方法中的一个的计算机程序。

换言之,因此,本发明方法的实施例为计算机程序,其具有用于在计算机程序运行于计算机上时执行本文中所描述的方法中的一个的程序代码。

因此,本发明方法的另一实施例为包括数据载体(或诸如数字存储媒体的非暂时性存储媒体,或计算机可读媒体),其包括记录于其上的用于执行本文中所描述的方法中的一个的计算机程序。数据载体、数字存储媒体或记录媒体通常为有形的和/或非暂时性的。

因此,本发明方法的另一实施例为表示用于执行本文中所描述的方法中的一个的计算机程序的数据串流或信号的序列。数据串流或信号的序列可(例如)用于经由数据通信连接(例如,经由因特网)来传送。

另一实施例包括处理构件,例如,经配置或经调适以执行本文中所描述的方法中的一个的计算机或可规划逻辑设备。

另一实施例包括上面安装有用于执行本文中所描述的方法中的一个的计算机程序的计算机。

根据本发明的另一实施例包括用于将用于执行本文中所描述的方法中的一个的计算机程序进行传送(例如,用电子地或光学地)至接收器的设备或系统。接收器可(例如)为计算机、行动装置、内存装置等。设备或系统可(例如)包括用于将计算机程序传送至接收器的文件服务器。

在一些实施例中,可程序化逻辑设备(例如,现场可程序化门阵列)可用以执行本文中所描述的方法的功能性中的一些或全部。在一些实施例中,现场可规划门阵列可与微处理器合作以便执行本文中所描述的方法中的一个。通常,优选地由任何硬设备来执行方法。

上述实施例仅说明本发明的原理。应理解,本文中所描述的配置及细节的修改及变化对于本领域技术人员是显而易见的。因此,其仅意在由所附专利权利要求的范畴限制,而不是由借助于本文中的实施例的描述及解释所呈现的特定细节限制。

参考文献

[1]ISO/IEC DIS 23003-3,Usac

[2]ISO/IEC DIS 23008-3,3D音频

Claims (21)

1.一种用于编码多声道信号(4)的音频编码器(2),包括:

线性预测域编码器(6);

频域编码器(8);

用于在所述线性预测域编码器(6)与所述频域编码器(8)之间切换的控制器(10),

其中所述线性预测域编码器(6)包括用于对所述多声道信号(4)进行降混以获得降混信号(14)的降混频器(12)、用于编码所述降混信号(14)的线性预测域核心编码器(16)以及用于从所述多声道信号(4)生成第一多声道信息(20)的第一联合多声道编码器(18),

其中所述频域编码器(8)包括用于从所述多声道信号(4)生成第二多声道信息(24)的第二联合多声道编码器(22),其中所述第二联合多声道编码器(22)不同于所述第一联合多声道编码器(18),以及

其中所述控制器(10)被配置为执行切换使得所述多声道信号(4)的部分由所述线性预测域编码器(6)的编码帧表示或由所述频域编码器(8)的编码帧表示;

其中所述线性预测域核心编码器(16)包括ACELP处理器(30)、TCX处理器(32)以及时域带宽扩展处理器(36),其中所述ACELP处理器用于对通过降取样获得的经降取样的降混信号(34)进行操作,且其中所述时域带宽扩展处理器(36)用于对通过降取样从ACELP输入信号中移除的所述降混信号的部分的频带进行参数化编码,以及其中所述TCX处理器(32)用于对未被降取样或以小于由所述ACELP处理器(30)操作的用于生成经降取样的降混信号(34)的降取样的程度被降取样的降混信号(14)进行操作,所述TCX处理器包括第一时间-频率转换器(40)、用于生成第一频带集合的参数化表示(46)的第一参数生成器(42)以及用于生成用于第二频带集合的经量化的编码的频谱线的集合(48)的第一量化器编码器(44);

或

其中所述音频编码器还包括用于对由所述线性预测域核心编码器(16)输出的经编码的降混信号(14)进行解码以获得经编码且经解码的降混信号(54)的线性预测域解码器(50);以及用于使用经编码且经解码的降混信号(54)计算和编码多声道残余信号(58)的多声道残余编码器(56),所述多声道残余信号(58)表示使用第一多声道信息(20)获得的经解码的多声道表示与降混之前的多声道信号(4)之间的误差;

或

其中所述控制器(10)用于在所述多声道信号的当前帧(204)内从使用所述频域编码器(8)对先前帧进行编码切换至使用所述线性预测域编码器(6)对即将到来的帧(206)进行编码;其中第一联合多声道编码器(18)用于从用于所述当前帧的多声道信号计算合成多声道参数(210a,210b,212a,212b)作为所述第一多声道信息(20);以及其中所述第二联合多声道编码器(22)用于使用停止窗口(200a,200b)对所述多声道信号(4)进行加权以获得所述当前帧(204)中的经加权的多声道信号,使得其中执行从所述频域编码器(8)至所述线性预测域编码器(6)的转换的所述当前帧(204)包括所述经加权的多声道信号、关于所述降混信号(14)的信息(208)以及所述合成多声道参数(210a,210b,212a,212b)。

2.根据权利要求1所述的音频编码器(2),其中所述第一联合多声道编码器(18)包括第一时间-频率转换器(82),其中所述第二联合多声道编码器(22)包括第二时间-频率转换器(66),且其中所述第一时间-频率转换器(82)和所述第二时间-频率转换器(66)彼此不同。

3.根据权利要求1所述的音频编码器(2),其中所述第一联合多声道编码器(18)为参数化联合多声道编码器;或

其中所述第二联合多声道编码器(22)为波形保持联合多声道编码器。

4.根据权利要求3所述的音频编码器,

其中所述参数化联合多声道编码器包括立体声产生编码器、参数化立体声编码器或基于旋转的参数化立体声编码器,或

其中所述波形保持联合多声道编码器包括频带选择性切换中间/侧或左/右立体声编码器。

5.根据权利要求1所述的音频编码器(2),其中所述频域编码器(8)包括用于将所述多声道信号(4)的第一声道(4a)及所述多声道信号(4)的第二声道(4b)转换成频谱表示(72a,b)的第二时间-频率转换器(66)、用于生成第二频带集合的参数化表示的第二参数生成器(68)以及用于生成第一频带集合的经量化且经编码的表示(80)的第二量化器编码器(70)。

6.根据权利要求1所述的音频编码器(2),

其中所述TCX处理器包括MDCT操作和智能间隙填充功能,或

其中所述频域编码器(8)包括用于所述多声道信号(4)的第一声道(4a)和第二声道(4b)的MDCT操作和AAC操作以及智能间隙填充功能,或

其中所述第一联合多声道编码器(18)用于以得出用于多声道信号(4)的全带宽的多声道信息的方式进行操作。

7.根据权利要求1所述的音频编码器(2),

其中所述降混信号具有低频带和高频带,其中所述线性预测域编码器(6)用于施加用于对高频带进行参数化编码的带宽扩展处理,其中所述线性预测域解码器用于仅获得表示所述降混信号的低频带的低频带信号以作为经编码且经解码的降混信号(54),且其中经编码的多声道残余信号(58)仅具有在降混之前的多声道信号(4)的低频带内的频率成分。

8.根据权利要求1所述的音频编码器(2),

其中所述多声道残余编码器(56)包括:

用于使用所述第一多声道信息(20)及所述经编码且经解码的降混信号(54)生成经解码的多声道信号(64)的联合多声道解码器(60);以及

用于形成所述经解码的多声道信号(64)与降混之前的多声道信号(4)之间的差异以获得多声道残余信号(58)的差异处理器(62)。

9.根据权利要求1所述的音频编码器(2),

其中所述降混频器(12)用于将所述多声道信号(4)转换成频谱表示,且其中使用频谱表示或使用时域表示来执行降混,且

其中所述第一联合多声道编码器(18)用于使用频谱表示生成用于频谱表示的各个频带的单独第一多声道信息。

10.一种用于对经编码的音频信号(103)进行解码的音频解码器(102),包括:

线性预测域解码器(104);

频域解码器(106);

用于使用所述线性预测域解码器(104)的输出和使用第一多声道信息(20)生成第一多声道表示(114)的第一联合多声道解码器(108);

用于使用所述频域解码器(106)的输出和第二多声道信息(22,24)生成第二多声道表示(116)的第二联合多声道解码器(110);以及

用于组合所述第一多声道表示(114)和所述第二多声道表示(116)以获得经解码的音频信号(118)的第一组合器(112),

其中所述第二联合多声道解码器(110)不同于所述第一联合多声道解码器(108);

其中所述线性预测域解码器(104)包括:ACELP解码器(120)、低频带合成器(122)、用于对由所述低频带合成器(122)生成的信号进行升取样的升取样器(124)、时域带宽扩展处理器(126)以及用于组合由所述升取样器(124)生成的经升取样的信号和由所述时域带宽扩展处理器(126)生成的经带宽扩展的信号的第二组合器(128);

或

其中所述经编码的音频信号(3)包括用于由所述线性预测域解码器(104)输出的经解码的降混信号(142)的多声道残余信号(58),以及其中所述第一联合多声道解码器(108)用于除所述经解码的降混信号(142)和所述第一多声道信息(20)之外还使用所述多声道残余信号(58)来生成所述第一多声道表示(114);

或

其中所述音频解码器(102)用于在多声道音频信号的当前帧(204)内从使用所述频域解码器(106)对先前帧进行解码切换至使用所述线性预测域解码器(104)对即将到来的帧(206)进行解码;其中所述组合器(112)用于从当前帧(204)的第二多声道表示(116)计算合成中间信号(226);其中所述第一联合多声道解码器(108)用于使用所述合成中间信号(226)和所述第一多声道信息(20)生成所述第一多声道表示(114);以及其中所述组合器(112)用于组合所述第一多声道表示(114)和所述第二多声道表示(116)以获得所述经解码的音频信号(118)的当前帧(204);

或

其中所述音频解码器(102)用于在多声道音频信号的当前帧(232)内从使用所述线性预测域解码器(104)对先前帧进行解码切换至使用所述频域解码器(106)对即将到来的帧进行解码;其中所述第一联合多声道解码器(108)包括立体声解码器(146),所述立体声解码器(146)用于使用先前帧的第一多声道信息(20)从用于当前帧的所述线性预测域解码器(104)生成的经解码的单声道信号计算合成多声道音频信号(250a,250b);其中所述第二联合多声道解码器(110)用于计算用于所述当前帧(232)的第二多声道表示(116)并使用开始窗口对所述第二多声道表示(116)进行加权以获得经加权的第二多声道表示;以及其中所述组合器(112)用于组合所述合成多声道音频信号(250a,250b)和所述经加权的第二多声道表示以获得所述经解码的音频信号的当前帧(232)。

11.根据权利要求10所述的音频解码器(102),

其中所述第一联合多声道解码器(108)为参数化联合多声道解码器,且其中所述第二联合多声道解码器(110)为波形保持联合多声道解码器,

其中所述第一联合多声道解码器(108)用于基于复数预测、参数化立体声操作或旋转操作而进行操作,以及

其中所述第二联合多声道解码器(110)用于将频带选择性切换应用于中间/侧或左/右立体声解码算法。

12.根据权利要求10所述的音频解码器(102),其中所述线性预测域解码器(104)包括:

TCX解码器(130)和智能间隙填充IGF处理器(132);

用于组合所述TCX解码器(130)的第二组合器(128)和IGF处理器(132)的输出的全频带合成处理器(134),以及

用以使用通过低频带频谱-时间转换从所述TCX解码器(130)及所述IGF处理器(132)生成的信号得出的信息来初始化所述低频带合成器(122)的交叉路径(136)。

13.根据权利要求10所述的音频解码器(102),

其中所述第一联合多声道解码器(108)包括:用于将所述线性预测域解码器(104)的输出转换成频谱表示(145)的时间-频率转换器(144);

受所述第一多声道信息(20)控制而对所述频谱表示(145)进行操作的升混频器;以及

用于将升混结果转换成与所述第一多声道表示(114)对应的时间表示的频率-时间转换器(148)。

14.根据权利要求10所述的音频解码器(102),

其中所述第二联合多声道解码器(110)用于:

使用由所述频域解码器(106)获得的频谱表示作为输入,所述频谱表示包括至少针对多个频带的第一声道信号和第二声道信号;以及

对所述第一声道信号和所述第二声道信号的多个频带施加联合多声道操作并将所述联合多声道操作的结果转换成时间表示以获得所述第二多声道表示(116)。

15.根据权利要求14所述的音频解码器(102),其中所述第二多声道信息(24)是为各个频带指示左/右或中间/侧联合多声道编码的掩码,且其中联合多声道操作是用于将由所述掩码所指示的频带从中间/侧表示转换为左/右表示的中间/侧至左/右转换操作。

16.根据权利要求13所述的音频解码器(102),其中所述多声道残余信号(58)具有低于所述第一多声道表示(114)的带宽,且其中所述第一联合多声道解码器(108)用于使用第一多声道信息(20)和所述经解码的降混信号(142)重建中间第一多声道表示(114)并将所述多声道残余信号(58)添加至所述中间第一多声道表示。

17.根据权利要求13所述的音频解码器(102),

其中所述时间-频率转换器(144)包括复数运算或过取样的操作,且

其中所述频域解码器(106)包括IMDCT操作(152)或临界取样的操作。

18.根据权利要求13所述的音频解码器(102)或根据权利要求1所述的音频编码器(2),其中所述多声道指的是两个或更多个声道。

19.一种对多声道信号(4)进行编码的方法(800),包括:

执行线性预测域编码;

执行频域编码;

在所述线性预测域编码与所述频域编码之间切换,

其中所述线性预测域编码包括:对所述多声道信号进行降混以获得降混信号、对所述降混信号进行线性预测域核心编码以及从所述多声道信号生成第一多声道信息的第一联合多声道编码,

其中所述频域编码包括从所述多声道信号生成第二多声道信息的第二联合多声道编码,其中所述第二联合多声道编码不同于所述第一多声道编码,且

其中切换被执行以使得所述多声道信号的部分由所述线性预测域编码的编码帧表示或由所述频域编码的编码帧表示;

其中所述线性预测域核心编码包括ACELP处理、TCX处理以及时域带宽扩展处理,其中所述ACELP处理用于对通过降取样获得的经降取样的降混信号(34)进行操作,且其中所述时域带宽扩展处理用于对通过降取样从ACELP输入信号中移除的所述降混信号的部分的频带进行参数化编码,以及其中所述TCX处理用于对未被降取样或以小于由所述ACELP处理操作的用于生成经降取样的降混信号(34)的降取样的程度被降取样的降混信号(14)进行操作,所述TCX处理包括第一时间-频率转换、生成第一频带集合的参数化表示(46)以及生成用于第二频带集合的经量化的编码的频谱线的集合(48);

或

其中所述音频编码的方法还包括线性预测域解码,包括对由所述线性预测域核心编码输出的经编码的降混信号(14)进行解码以获得经编码且经解码的降混信号(54);以及多声道残余编码,包括使用经编码且经解码的降混信号(54)计算和编码多声道残余信号(58),所述多声道残余信号(58)表示使用第一多声道信息(20)获得的经解码的多声道表示与降混之前的多声道信号(4)之间的误差;

或

其中所述切换包括在所述多声道信号的当前帧(204)内从使用所述频域编码(8)对先前帧进行编码切换至使用所述线性预测域编码(6)对即将到来的帧(206)进行编码;其中第一联合多声道编码包括从用于所述当前帧的多声道信号计算合成多声道参数(210a,210b,212a,212b)作为所述第一多声道信息(20);以及其中所述第二联合多声道编码包括使用停止窗口(200a,200b)对所述多声道信号(4)进行加权以获得所述当前帧(204)中的经加权的多声道信号,使得其中执行从所述频域编码(8)至所述线性预测域编码(6)的转换的所述当前帧(204)包括所述经加权的多声道信号、关于所述降混信号(14)的信息(208)以及所述合成多声道参数(210a,210b,212a,212b)。

20.一种对经编码的音频信号进行解码的方法(900),包括:

线性预测域解码;

频域解码;

使用所述线性预测域解码的输出和使用第一多声道信息生成第一多声道表示的第一联合多声道解码;

使用所述频域解码的输出和第二多声道信息生成第二多声道表示的第二多声道解码;以及

组合所述第一多声道表示和所述第二多声道表示以获得经解码的音频信号,

其中所述第二多声道解码不同于所述第一多声道解码;

其中所述线性预测域解码包括:ACELP解码、低频带合成、包括对由所述低频带合成生成的信号进行升取样的升取样、时域带宽扩展处理以及包括组合通过所述升取样生成的经升取样的信号和通过所述时域带宽扩展处理生成的经带宽扩展的信号的第二组合;

或

其中所述经编码的音频信号(103)包括用于通过所述线性预测域解码输出的经解码的降混信号(142)的多声道残余信号,以及其中所述第一联合多声道解码用于除所述经解码的降混信号(142)和所述第一多声道信息(20)之外还使用所述多声道残余信号(58)来生成所述第一多声道表示(114);

或

其中所述解码的方法包括在多声道音频信号的当前帧(204)内从使用所述频域解码对先前帧进行解码切换至使用所述线性预测域解码对即将到来的帧(206)进行解码;其中所述组合包括从当前帧(204)的第二多声道表示(116)计算合成中间信号(226);其中所述第一联合多声道解码包括使用所述合成中间信号(226)和所述第一多声道信息(20)生成所述第一多声道表示(114);以及其中所述组合包括组合所述第一多声道表示(114)和所述第二多声道表示(116)以获得所述经解码的音频信号的当前帧(204);

或

其中所述解码的方法包括在多声道音频信号的当前帧(232)内从使用所述线性预测域解码对先前帧进行解码切换至使用所述频域解码对即将到来的帧进行解码;其中所述第一联合多声道解码包括立体声解码,所述立体声解码包括使用先前帧的第一多声道信息(20)从用于当前帧的所述线性预测域解码生成的经解码的单声道信号计算合成多声道音频信号(250a,250b);其中所述第二联合多声道解码包括计算用于所述当前帧(232)的第二多声道表示(116)并使用开始窗口对所述第二多声道表示(116)进行加权以获得经加权的第二多声道表示;以及其中所述组合包括组合所述合成多声道音频信号(250a,250b)和所述经加权的第二多声道表示以获得所述经解码的音频信号的当前帧(232)。

21.一种存储介质,具有存储于其上的计算机程序,当计算机程序在计算机或处理器上运行时用于执行根据权利要求19或权利要求20所述的方法。

Priority Applications (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| CN202110018176.XA CN112634913B (zh) | 2015-03-09 | 2016-03-07 | 用于编码的音频编码器及用于解码的音频解码器 |

| CN202110019014.8A CN112614496B (zh) | 2015-03-09 | 2016-03-07 | 用于编码的音频编码器及用于解码的音频解码器 |

| CN202110019042.XA CN112614497A (zh) | 2015-03-09 | 2016-03-07 | 用于编码的音频编码器及用于解码的音频解码器 |

Applications Claiming Priority (5)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| EP15158233.5 | 2015-03-09 | ||

| EP15158233 | 2015-03-09 | ||

| EP15172594.2 | 2015-06-17 | ||

| EP15172594.2A EP3067886A1 (en) | 2015-03-09 | 2015-06-17 | Audio encoder for encoding a multichannel signal and audio decoder for decoding an encoded audio signal |

| PCT/EP2016/054776 WO2016142337A1 (en) | 2015-03-09 | 2016-03-07 | Audio encoder for encoding a multichannel signal and audio decoder for decoding an encoded audio signal |

Related Child Applications (3)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| CN202110019014.8A Division CN112614496B (zh) | 2015-03-09 | 2016-03-07 | 用于编码的音频编码器及用于解码的音频解码器 |

| CN202110018176.XA Division CN112634913B (zh) | 2015-03-09 | 2016-03-07 | 用于编码的音频编码器及用于解码的音频解码器 |

| CN202110019042.XA Division CN112614497A (zh) | 2015-03-09 | 2016-03-07 | 用于编码的音频编码器及用于解码的音频解码器 |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| CN107430863A CN107430863A (zh) | 2017-12-01 |

| CN107430863B true CN107430863B (zh) | 2021-01-26 |

Family

ID=52682621

Family Applications (6)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| CN202110018176.XA Active CN112634913B (zh) | 2015-03-09 | 2016-03-07 | 用于编码的音频编码器及用于解码的音频解码器 |

| CN202110178110.7A Pending CN112951248A (zh) | 2015-03-09 | 2016-03-07 | 用于编码的音频编码器及用于解码的音频解码器 |

| CN202110019042.XA Pending CN112614497A (zh) | 2015-03-09 | 2016-03-07 | 用于编码的音频编码器及用于解码的音频解码器 |

| CN201680014669.3A Active CN107430863B (zh) | 2015-03-09 | 2016-03-07 | 用于编码的音频编码器及用于解码的音频解码器 |

| CN202110019014.8A Active CN112614496B (zh) | 2015-03-09 | 2016-03-07 | 用于编码的音频编码器及用于解码的音频解码器 |

| CN201680014670.6A Active CN107408389B (zh) | 2015-03-09 | 2016-03-07 | 用于编码的音频编码器及用于解码的音频解码器 |

Family Applications Before (3)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| CN202110018176.XA Active CN112634913B (zh) | 2015-03-09 | 2016-03-07 | 用于编码的音频编码器及用于解码的音频解码器 |

| CN202110178110.7A Pending CN112951248A (zh) | 2015-03-09 | 2016-03-07 | 用于编码的音频编码器及用于解码的音频解码器 |

| CN202110019042.XA Pending CN112614497A (zh) | 2015-03-09 | 2016-03-07 | 用于编码的音频编码器及用于解码的音频解码器 |

Family Applications After (2)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| CN202110019014.8A Active CN112614496B (zh) | 2015-03-09 | 2016-03-07 | 用于编码的音频编码器及用于解码的音频解码器 |

| CN201680014670.6A Active CN107408389B (zh) | 2015-03-09 | 2016-03-07 | 用于编码的音频编码器及用于解码的音频解码器 |

Country Status (19)

| Country | Link |

|---|---|

| US (7) | US10388287B2 (zh) |

| EP (9) | EP3067886A1 (zh) |

| JP (6) | JP6606190B2 (zh) |

| KR (2) | KR102151719B1 (zh) |

| CN (6) | CN112634913B (zh) |

| AR (6) | AR103881A1 (zh) |

| AU (2) | AU2016231283C1 (zh) |

| BR (4) | BR122022025643B1 (zh) |

| CA (2) | CA2978814C (zh) |

| ES (6) | ES2910658T3 (zh) |

| FI (1) | FI3958257T3 (zh) |

| MX (2) | MX366860B (zh) |

| MY (2) | MY186689A (zh) |

| PL (6) | PL3910628T3 (zh) |

| PT (3) | PT3268957T (zh) |

| RU (2) | RU2679571C1 (zh) |

| SG (2) | SG11201707343UA (zh) |

| TW (2) | TWI609364B (zh) |

| WO (2) | WO2016142337A1 (zh) |

Families Citing this family (39)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| EP3067886A1 (en) | 2015-03-09 | 2016-09-14 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Audio encoder for encoding a multichannel signal and audio decoder for decoding an encoded audio signal |

| KR102083200B1 (ko) | 2016-01-22 | 2020-04-28 | 프라운호퍼 게젤샤프트 쭈르 푀르데룽 데어 안겐반텐 포르슝 에. 베. | 스펙트럼-도메인 리샘플링을 사용하여 멀티-채널 신호를 인코딩 또는 디코딩하기 위한 장치 및 방법 |

| CN107731238B (zh) * | 2016-08-10 | 2021-07-16 | 华为技术有限公司 | 多声道信号的编码方法和编码器 |

| US10573326B2 (en) * | 2017-04-05 | 2020-02-25 | Qualcomm Incorporated | Inter-channel bandwidth extension |

| US10224045B2 (en) | 2017-05-11 | 2019-03-05 | Qualcomm Incorporated | Stereo parameters for stereo decoding |

| JP7009509B2 (ja) | 2017-05-18 | 2022-01-25 | フラウンホーファー-ゲゼルシャフト・ツール・フェルデルング・デル・アンゲヴァンテン・フォルシュング・アインゲトラーゲネル・フェライン | ネットワーク装置の管理 |

| US10431231B2 (en) * | 2017-06-29 | 2019-10-01 | Qualcomm Incorporated | High-band residual prediction with time-domain inter-channel bandwidth extension |

| US10475457B2 (en) | 2017-07-03 | 2019-11-12 | Qualcomm Incorporated | Time-domain inter-channel prediction |

| CN114898761A (zh) | 2017-08-10 | 2022-08-12 | 华为技术有限公司 | 立体声信号编解码方法及装置 |

| US10535357B2 (en) | 2017-10-05 | 2020-01-14 | Qualcomm Incorporated | Encoding or decoding of audio signals |

| US10734001B2 (en) * | 2017-10-05 | 2020-08-04 | Qualcomm Incorporated | Encoding or decoding of audio signals |

| EP3483886A1 (en) | 2017-11-10 | 2019-05-15 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Selecting pitch lag |

| EP3483879A1 (en) | 2017-11-10 | 2019-05-15 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Analysis/synthesis windowing function for modulated lapped transformation |

| WO2019091576A1 (en) | 2017-11-10 | 2019-05-16 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Audio encoders, audio decoders, methods and computer programs adapting an encoding and decoding of least significant bits |

| EP3483878A1 (en) | 2017-11-10 | 2019-05-15 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Audio decoder supporting a set of different loss concealment tools |

| EP3483883A1 (en) | 2017-11-10 | 2019-05-15 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Audio coding and decoding with selective postfiltering |

| EP3483880A1 (en) | 2017-11-10 | 2019-05-15 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Temporal noise shaping |

| EP3483882A1 (en) * | 2017-11-10 | 2019-05-15 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Controlling bandwidth in encoders and/or decoders |

| EP3483884A1 (en) | 2017-11-10 | 2019-05-15 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Signal filtering |

| EP3729427A1 (en) * | 2017-12-19 | 2020-10-28 | Dolby International AB | Methods and apparatus for unified speech and audio decoding qmf based harmonic transposer improvements |

| TWI812658B (zh) * | 2017-12-19 | 2023-08-21 | 瑞典商都比國際公司 | 用於統一語音及音訊之解碼及編碼去關聯濾波器之改良之方法、裝置及系統 |

| TWI760593B (zh) * | 2018-02-01 | 2022-04-11 | 弗勞恩霍夫爾協會 | 使用混成式編碼器/解碼器空間分析之音訊場景編碼器、音訊場景解碼器及相關方法 |

| EP3550561A1 (en) * | 2018-04-06 | 2019-10-09 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Downmixer, audio encoder, method and computer program applying a phase value to a magnitude value |

| EP3588495A1 (en) * | 2018-06-22 | 2020-01-01 | FRAUNHOFER-GESELLSCHAFT zur Förderung der angewandten Forschung e.V. | Multichannel audio coding |

| CN111819627A (zh) * | 2018-07-02 | 2020-10-23 | 杜比实验室特许公司 | 用于对沉浸式音频信号进行编码及/或解码的方法及装置 |

| AU2019298307A1 (en) * | 2018-07-04 | 2021-02-25 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Multisignal audio coding using signal whitening as preprocessing |

| WO2020094263A1 (en) | 2018-11-05 | 2020-05-14 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Apparatus and audio signal processor, for providing a processed audio signal representation, audio decoder, audio encoder, methods and computer programs |

| EP3719799A1 (en) * | 2019-04-04 | 2020-10-07 | FRAUNHOFER-GESELLSCHAFT zur Förderung der angewandten Forschung e.V. | A multi-channel audio encoder, decoder, methods and computer program for switching between a parametric multi-channel operation and an individual channel operation |

| WO2020216459A1 (en) * | 2019-04-23 | 2020-10-29 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Apparatus, method or computer program for generating an output downmix representation |

| CN110267142B (zh) * | 2019-06-25 | 2021-06-22 | 维沃移动通信有限公司 | 一种移动终端及控制方法 |

| FR3101741A1 (fr) * | 2019-10-02 | 2021-04-09 | Orange | Détermination de corrections à appliquer à un signal audio multicanal, codage et décodage associés |

| US11432069B2 (en) * | 2019-10-10 | 2022-08-30 | Boomcloud 360, Inc. | Spectrally orthogonal audio component processing |

| CA3163373A1 (en) * | 2020-02-03 | 2021-08-12 | Vaclav Eksler | Switching between stereo coding modes in a multichannel sound codec |

| CN111654745B (zh) * | 2020-06-08 | 2022-10-14 | 海信视像科技股份有限公司 | 多声道的信号处理方法及显示设备 |

| CN116324980A (zh) * | 2020-09-25 | 2023-06-23 | 苹果公司 | 声道、对象和hoa音频内容的无缝可扩展解码 |

| MX2023003965A (es) * | 2020-10-09 | 2023-05-25 | Fraunhofer Ges Forschung | Aparato, metodo, o programa de computadora para procesar una escena de audio codificada utilizando una extension de ancho de banda. |

| JPWO2022176270A1 (zh) * | 2021-02-16 | 2022-08-25 | ||

| CN115881140A (zh) * | 2021-09-29 | 2023-03-31 | 华为技术有限公司 | 编解码方法、装置、设备、存储介质及计算机程序产品 |

| TW202334938A (zh) * | 2021-12-20 | 2023-09-01 | 瑞典商都比國際公司 | 正交鏡像濾波器域中之沉浸式音訊及視訊服務空間重建濾波器庫 |

Citations (9)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| EP0797324A2 (en) * | 1996-03-22 | 1997-09-24 | Lucent Technologies Inc. | Enhanced joint stereo coding method using temporal envelope shaping |

| CN1437747A (zh) * | 2000-02-29 | 2003-08-20 | 高通股份有限公司 | 闭环多模混合域线性预测(mdlp)语音编解码器 |

| CN101253557A (zh) * | 2005-08-31 | 2008-08-27 | 松下电器产业株式会社 | 立体声编码装置、立体声解码装置、及立体声编码方法 |

| CN101925950A (zh) * | 2008-01-04 | 2010-12-22 | 杜比国际公司 | 音频编码器和解码器 |

| CN102177426A (zh) * | 2008-10-08 | 2011-09-07 | 弗兰霍菲尔运输应用研究公司 | 多分辨率切换音频编码/解码方案 |

| CN102388417A (zh) * | 2009-03-17 | 2012-03-21 | 杜比国际公司 | 基于自适应地可选择的左/右或中央/侧边立体声编码和参数立体声编码的组合的高级立体声编码 |

| CN102741831A (zh) * | 2010-11-12 | 2012-10-17 | 宝利通公司 | 多点环境中的可伸缩音频 |

| CN102859589A (zh) * | 2009-10-20 | 2013-01-02 | 弗兰霍菲尔运输应用研究公司 | 多模式音频编译码器及其适用的码簿激励线性预测编码 |

| WO2013156814A1 (en) * | 2012-04-18 | 2013-10-24 | Nokia Corporation | Stereo audio signal encoder |

Family Cites Families (51)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CA1311059C (en) * | 1986-03-25 | 1992-12-01 | Bruce Allen Dautrich | Speaker-trained speech recognizer having the capability of detecting confusingly similar vocabulary words |

| DE4307688A1 (de) | 1993-03-11 | 1994-09-15 | Daimler Benz Ag | Verfahren zur Geräuschreduktion für gestörte Sprachkanäle |

| US5956674A (en) * | 1995-12-01 | 1999-09-21 | Digital Theater Systems, Inc. | Multi-channel predictive subband audio coder using psychoacoustic adaptive bit allocation in frequency, time and over the multiple channels |

| JP3593201B2 (ja) * | 1996-01-12 | 2004-11-24 | ユナイテッド・モジュール・コーポレーション | オーディオ復号装置 |

| SE519981C2 (sv) | 2000-09-15 | 2003-05-06 | Ericsson Telefon Ab L M | Kodning och avkodning av signaler från flera kanaler |

| KR20060131767A (ko) * | 2003-12-04 | 2006-12-20 | 코닌클리케 필립스 일렉트로닉스 엔.브이. | 오디오 신호 코딩 |

| US7742912B2 (en) * | 2004-06-21 | 2010-06-22 | Koninklijke Philips Electronics N.V. | Method and apparatus to encode and decode multi-channel audio signals |

| US7391870B2 (en) | 2004-07-09 | 2008-06-24 | Fraunhofer-Gesellschaft Zur Foerderung Der Angewandten Forschung E V | Apparatus and method for generating a multi-channel output signal |

| KR20070056081A (ko) * | 2004-08-31 | 2007-05-31 | 마츠시타 덴끼 산교 가부시키가이샤 | 스테레오 신호 생성 장치 및 스테레오 신호 생성 방법 |

| KR20070092240A (ko) * | 2004-12-27 | 2007-09-12 | 마츠시타 덴끼 산교 가부시키가이샤 | 음성 부호화 장치 및 음성 부호화 방법 |

| WO2008035949A1 (en) | 2006-09-22 | 2008-03-27 | Samsung Electronics Co., Ltd. | Method, medium, and system encoding and/or decoding audio signals by using bandwidth extension and stereo coding |

| CN101067931B (zh) * | 2007-05-10 | 2011-04-20 | 芯晟(北京)科技有限公司 | 一种高效可配置的频域参数立体声及多声道编解码方法与系统 |

| WO2009007639A1 (fr) | 2007-07-03 | 2009-01-15 | France Telecom | Quantification apres transformation lineaire combinant les signaux audio d'une scene sonore, codeur associe |

| CN101373594A (zh) * | 2007-08-21 | 2009-02-25 | 华为技术有限公司 | 修正音频信号的方法及装置 |

| KR101505831B1 (ko) * | 2007-10-30 | 2015-03-26 | 삼성전자주식회사 | 멀티 채널 신호의 부호화/복호화 방법 및 장치 |

| AU2008326956B2 (en) * | 2007-11-21 | 2011-02-17 | Lg Electronics Inc. | A method and an apparatus for processing a signal |

| KR20100086000A (ko) * | 2007-12-18 | 2010-07-29 | 엘지전자 주식회사 | 오디오 신호 처리 방법 및 장치 |

| US9659568B2 (en) * | 2007-12-31 | 2017-05-23 | Lg Electronics Inc. | Method and an apparatus for processing an audio signal |

| KR101452722B1 (ko) * | 2008-02-19 | 2014-10-23 | 삼성전자주식회사 | 신호 부호화 및 복호화 방법 및 장치 |

| JP5333446B2 (ja) | 2008-04-25 | 2013-11-06 | 日本電気株式会社 | 無線通信装置 |

| EP3002750B1 (en) | 2008-07-11 | 2017-11-08 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Audio encoder and decoder for encoding and decoding audio samples |

| CN102105930B (zh) * | 2008-07-11 | 2012-10-03 | 弗朗霍夫应用科学研究促进协会 | 用于编码采样音频信号的帧的音频编码器和解码器 |

| CA2871268C (en) * | 2008-07-11 | 2015-11-03 | Nikolaus Rettelbach | Audio encoder, audio decoder, methods for encoding and decoding an audio signal, audio stream and computer program |

| MX2011000375A (es) * | 2008-07-11 | 2011-05-19 | Fraunhofer Ges Forschung | Codificador y decodificador de audio para codificar y decodificar tramas de una señal de audio muestreada. |

| JP5325293B2 (ja) * | 2008-07-11 | 2013-10-23 | フラウンホッファー−ゲゼルシャフト ツァ フェルダールング デァ アンゲヴァンテン フォアシュンク エー.ファオ | 符号化されたオーディオ信号を復号化するための装置および方法 |

| EP2144231A1 (en) | 2008-07-11 | 2010-01-13 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Low bitrate audio encoding/decoding scheme with common preprocessing |

| EP2144230A1 (en) | 2008-07-11 | 2010-01-13 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Low bitrate audio encoding/decoding scheme having cascaded switches |

| JP5203077B2 (ja) | 2008-07-14 | 2013-06-05 | 株式会社エヌ・ティ・ティ・ドコモ | 音声符号化装置及び方法、音声復号化装置及び方法、並びに、音声帯域拡張装置及び方法 |

| EP2146344B1 (en) * | 2008-07-17 | 2016-07-06 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Audio encoding/decoding scheme having a switchable bypass |

| WO2010013450A1 (ja) * | 2008-07-29 | 2010-02-04 | パナソニック株式会社 | 音響符号化装置、音響復号化装置、音響符号化復号化装置および会議システム |

| EP2224433B1 (en) * | 2008-09-25 | 2020-05-27 | Lg Electronics Inc. | An apparatus for processing an audio signal and method thereof |

| EP2345027B1 (en) | 2008-10-10 | 2018-04-18 | Telefonaktiebolaget LM Ericsson (publ) | Energy-conserving multi-channel audio coding and decoding |

| GB2470059A (en) * | 2009-05-08 | 2010-11-10 | Nokia Corp | Multi-channel audio processing using an inter-channel prediction model to form an inter-channel parameter |

| RU2591661C2 (ru) * | 2009-10-08 | 2016-07-20 | Фраунхофер-Гезелльшафт цур Фёрдерунг дер ангевандтен Форшунг Е.Ф. | Многорежимный декодировщик аудио сигнала, многорежимный кодировщик аудио сигналов, способы и компьютерные программы с использованием кодирования с линейным предсказанием на основе ограничения шума |

| KR101414305B1 (ko) * | 2009-10-20 | 2014-07-02 | 프라운호퍼 게젤샤프트 쭈르 푀르데룽 데어 안겐반텐 포르슝 에. 베. | 저 지연 애플리케이션들에서 사용하기 위한 오디오 신호 인코더, 오디오 신호 디코더, 오디오 콘텐츠의 인코딩된 표현을 제공하는 방법, 오디오 콘텐츠의 디코딩된 표현을 제공하는 방법 및 컴퓨터 프로그램 |

| EP4358082A1 (en) * | 2009-10-20 | 2024-04-24 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Audio signal encoder, audio signal decoder, method for encoding or decoding an audio signal using an aliasing-cancellation |

| KR101710113B1 (ko) * | 2009-10-23 | 2017-02-27 | 삼성전자주식회사 | 위상 정보와 잔여 신호를 이용한 부호화/복호화 장치 및 방법 |

| WO2011059254A2 (en) * | 2009-11-12 | 2011-05-19 | Lg Electronics Inc. | An apparatus for processing a signal and method thereof |

| EP2375409A1 (en) * | 2010-04-09 | 2011-10-12 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Audio encoder, audio decoder and related methods for processing multi-channel audio signals using complex prediction |

| US8166830B2 (en) * | 2010-07-02 | 2012-05-01 | Dresser, Inc. | Meter devices and methods |

| JP5499981B2 (ja) * | 2010-08-02 | 2014-05-21 | コニカミノルタ株式会社 | 画像処理装置 |

| CN107516532B (zh) * | 2011-03-18 | 2020-11-06 | 弗劳恩霍夫应用研究促进协会 | 音频内容的编码和解码方法以及介质 |

| US9489962B2 (en) * | 2012-05-11 | 2016-11-08 | Panasonic Corporation | Sound signal hybrid encoder, sound signal hybrid decoder, sound signal encoding method, and sound signal decoding method |

| CN102779518B (zh) * | 2012-07-27 | 2014-08-06 | 深圳广晟信源技术有限公司 | 用于双核编码模式的编码方法和系统 |

| TWI618050B (zh) * | 2013-02-14 | 2018-03-11 | 杜比實驗室特許公司 | 用於音訊處理系統中之訊號去相關的方法及設備 |

| TWI546799B (zh) * | 2013-04-05 | 2016-08-21 | 杜比國際公司 | 音頻編碼器及解碼器 |

| EP2830052A1 (en) | 2013-07-22 | 2015-01-28 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Audio decoder, audio encoder, method for providing at least four audio channel signals on the basis of an encoded representation, method for providing an encoded representation on the basis of at least four audio channel signals and computer program using a bandwidth extension |

| TWI579831B (zh) * | 2013-09-12 | 2017-04-21 | 杜比國際公司 | 用於參數量化的方法、用於量化的參數之解量化方法及其電腦可讀取的媒體、音頻編碼器、音頻解碼器及音頻系統 |

| US20150159036A1 (en) | 2013-12-11 | 2015-06-11 | Momentive Performance Materials Inc. | Stable primer formulations and coatings with nano dispersion of modified metal oxides |

| US9984699B2 (en) * | 2014-06-26 | 2018-05-29 | Qualcomm Incorporated | High-band signal coding using mismatched frequency ranges |

| EP3067886A1 (en) * | 2015-03-09 | 2016-09-14 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Audio encoder for encoding a multichannel signal and audio decoder for decoding an encoded audio signal |

-

2015

- 2015-06-17 EP EP15172594.2A patent/EP3067886A1/en not_active Withdrawn

- 2015-06-17 EP EP15172599.1A patent/EP3067887A1/en not_active Withdrawn

-

2016

- 2016-03-02 TW TW105106305A patent/TWI609364B/zh active

- 2016-03-02 TW TW105106306A patent/TWI613643B/zh active

- 2016-03-07 BR BR122022025643-0A patent/BR122022025643B1/pt active IP Right Grant

- 2016-03-07 EP EP21171835.8A patent/EP3910628B1/en active Active

- 2016-03-07 EP EP21191544.2A patent/EP3958257B1/en active Active

- 2016-03-07 BR BR112017018439-7A patent/BR112017018439B1/pt active IP Right Grant

- 2016-03-07 WO PCT/EP2016/054776 patent/WO2016142337A1/en active Application Filing

- 2016-03-07 MY MYPI2017001288A patent/MY186689A/en unknown

- 2016-03-07 FI FIEP21191544.2T patent/FI3958257T3/fi active

- 2016-03-07 EP EP21171826.7A patent/EP3879527B1/en active Active

- 2016-03-07 SG SG11201707343UA patent/SG11201707343UA/en unknown

- 2016-03-07 ES ES16708171T patent/ES2910658T3/es active Active

- 2016-03-07 PL PL21171835.8T patent/PL3910628T3/pl unknown

- 2016-03-07 PT PT167081710T patent/PT3268957T/pt unknown

- 2016-03-07 JP JP2017548014A patent/JP6606190B2/ja active Active

- 2016-03-07 CN CN202110018176.XA patent/CN112634913B/zh active Active

- 2016-03-07 CA CA2978814A patent/CA2978814C/en active Active

- 2016-03-07 EP EP21171831.7A patent/EP3879528B1/en active Active

- 2016-03-07 ES ES16708172T patent/ES2901109T3/es active Active

- 2016-03-07 MY MYPI2017001286A patent/MY194940A/en unknown

- 2016-03-07 CN CN202110178110.7A patent/CN112951248A/zh active Pending

- 2016-03-07 EP EP23166790.8A patent/EP4224470A1/en active Pending

- 2016-03-07 EP EP16708172.8A patent/EP3268958B1/en active Active

- 2016-03-07 ES ES21191544T patent/ES2951090T3/es active Active

- 2016-03-07 PT PT167081728T patent/PT3268958T/pt unknown

- 2016-03-07 PL PL16708172T patent/PL3268958T3/pl unknown

- 2016-03-07 PT PT211915442T patent/PT3958257T/pt unknown

- 2016-03-07 WO PCT/EP2016/054775 patent/WO2016142336A1/en active Application Filing

- 2016-03-07 KR KR1020177028167A patent/KR102151719B1/ko active IP Right Grant

- 2016-03-07 JP JP2017548000A patent/JP6643352B2/ja active Active

- 2016-03-07 SG SG11201707335SA patent/SG11201707335SA/en unknown

- 2016-03-07 ES ES21171835T patent/ES2958535T3/es active Active

- 2016-03-07 MX MX2017011187A patent/MX366860B/es active IP Right Grant

- 2016-03-07 AU AU2016231283A patent/AU2016231283C1/en active Active

- 2016-03-07 ES ES21171826T patent/ES2959910T3/es active Active

- 2016-03-07 RU RU2017133918A patent/RU2679571C1/ru active

- 2016-03-07 BR BR112017018441-9A patent/BR112017018441B1/pt active IP Right Grant

- 2016-03-07 CN CN202110019042.XA patent/CN112614497A/zh active Pending

- 2016-03-07 CA CA2978812A patent/CA2978812C/en active Active

- 2016-03-07 CN CN201680014669.3A patent/CN107430863B/zh active Active

- 2016-03-07 PL PL21191544.2T patent/PL3958257T3/pl unknown

- 2016-03-07 CN CN202110019014.8A patent/CN112614496B/zh active Active

- 2016-03-07 RU RU2017134385A patent/RU2680195C1/ru active

- 2016-03-07 ES ES21171831T patent/ES2959970T3/es active Active

- 2016-03-07 KR KR1020177028152A patent/KR102075361B1/ko active IP Right Grant

- 2016-03-07 AU AU2016231284A patent/AU2016231284B2/en active Active

- 2016-03-07 PL PL16708171T patent/PL3268957T3/pl unknown

- 2016-03-07 PL PL21171831.7T patent/PL3879528T3/pl unknown

- 2016-03-07 BR BR122022025766-6A patent/BR122022025766B1/pt active IP Right Grant

- 2016-03-07 EP EP16708171.0A patent/EP3268957B1/en active Active

- 2016-03-07 PL PL21171826.7T patent/PL3879527T3/pl unknown

- 2016-03-07 MX MX2017011493A patent/MX364618B/es active IP Right Grant

- 2016-03-07 CN CN201680014670.6A patent/CN107408389B/zh active Active

- 2016-03-08 AR ARP160100609A patent/AR103881A1/es active IP Right Grant

- 2016-03-08 AR ARP160100608A patent/AR103880A1/es active IP Right Grant

-

2017

- 2017-09-05 US US15/695,668 patent/US10388287B2/en active Active

- 2017-09-05 US US15/695,424 patent/US10395661B2/en active Active

-

2019

- 2019-03-22 US US16/362,462 patent/US10777208B2/en active Active

- 2019-07-09 US US16/506,767 patent/US11238874B2/en active Active

- 2019-10-17 JP JP2019189837A patent/JP7077290B2/ja active Active

-

2020

- 2020-01-06 JP JP2020000185A patent/JP7181671B2/ja active Active

- 2020-08-31 US US17/008,428 patent/US11107483B2/en active Active

-

2021

- 2021-08-24 US US17/410,033 patent/US11741973B2/en active Active

- 2021-10-18 AR ARP210102868A patent/AR123836A2/es unknown

- 2021-10-18 AR ARP210102867A patent/AR123835A2/es unknown

- 2021-10-18 AR ARP210102869A patent/AR123837A2/es unknown

- 2021-10-18 AR ARP210102866A patent/AR123834A2/es unknown

-

2022

- 2022-01-13 US US17/575,260 patent/US11881225B2/en active Active

- 2022-03-22 JP JP2022045510A patent/JP7469350B2/ja active Active

- 2022-11-17 JP JP2022183880A patent/JP2023029849A/ja active Pending

Patent Citations (9)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| EP0797324A2 (en) * | 1996-03-22 | 1997-09-24 | Lucent Technologies Inc. | Enhanced joint stereo coding method using temporal envelope shaping |

| CN1437747A (zh) * | 2000-02-29 | 2003-08-20 | 高通股份有限公司 | 闭环多模混合域线性预测(mdlp)语音编解码器 |

| CN101253557A (zh) * | 2005-08-31 | 2008-08-27 | 松下电器产业株式会社 | 立体声编码装置、立体声解码装置、及立体声编码方法 |

| CN101925950A (zh) * | 2008-01-04 | 2010-12-22 | 杜比国际公司 | 音频编码器和解码器 |

| CN102177426A (zh) * | 2008-10-08 | 2011-09-07 | 弗兰霍菲尔运输应用研究公司 | 多分辨率切换音频编码/解码方案 |

| CN102388417A (zh) * | 2009-03-17 | 2012-03-21 | 杜比国际公司 | 基于自适应地可选择的左/右或中央/侧边立体声编码和参数立体声编码的组合的高级立体声编码 |

| CN102859589A (zh) * | 2009-10-20 | 2013-01-02 | 弗兰霍菲尔运输应用研究公司 | 多模式音频编译码器及其适用的码簿激励线性预测编码 |

| CN102741831A (zh) * | 2010-11-12 | 2012-10-17 | 宝利通公司 | 多点环境中的可伸缩音频 |

| WO2013156814A1 (en) * | 2012-04-18 | 2013-10-24 | Nokia Corporation | Stereo audio signal encoder |

Non-Patent Citations (1)

| Title |

|---|

| "3rd Generation Partnership Project";3GPP;《3GPP standard》;20141210;全文 * |

Also Published As

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| CN107430863B (zh) | 用于编码的音频编码器及用于解码的音频解码器 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| PB01 | Publication | ||

| PB01 | Publication | ||

| SE01 | Entry into force of request for substantive examination | ||

| GR01 | Patent grant | ||

| GR01 | Patent grant |