KR20150099570A - 별개의 컴퓨터 비전 기반 포즈 및 관성 센서 기반 포즈의 디스플레이 - Google Patents

별개의 컴퓨터 비전 기반 포즈 및 관성 센서 기반 포즈의 디스플레이 Download PDFInfo

- Publication number

- KR20150099570A KR20150099570A KR1020157019314A KR20157019314A KR20150099570A KR 20150099570 A KR20150099570 A KR 20150099570A KR 1020157019314 A KR1020157019314 A KR 1020157019314A KR 20157019314 A KR20157019314 A KR 20157019314A KR 20150099570 A KR20150099570 A KR 20150099570A

- Authority

- KR

- South Korea

- Prior art keywords

- mobile device

- based pose

- pose

- graphic

- vision

- Prior art date

Links

Images

Classifications

-

- G—PHYSICS

- G01—MEASURING; TESTING

- G01C—MEASURING DISTANCES, LEVELS OR BEARINGS; SURVEYING; NAVIGATION; GYROSCOPIC INSTRUMENTS; PHOTOGRAMMETRY OR VIDEOGRAMMETRY

- G01C21/00—Navigation; Navigational instruments not provided for in groups G01C1/00 - G01C19/00

- G01C21/10—Navigation; Navigational instruments not provided for in groups G01C1/00 - G01C19/00 by using measurements of speed or acceleration

- G01C21/12—Navigation; Navigational instruments not provided for in groups G01C1/00 - G01C19/00 by using measurements of speed or acceleration executed aboard the object being navigated; Dead reckoning

- G01C21/16—Navigation; Navigational instruments not provided for in groups G01C1/00 - G01C19/00 by using measurements of speed or acceleration executed aboard the object being navigated; Dead reckoning by integrating acceleration or speed, i.e. inertial navigation

- G01C21/165—Navigation; Navigational instruments not provided for in groups G01C1/00 - G01C19/00 by using measurements of speed or acceleration executed aboard the object being navigated; Dead reckoning by integrating acceleration or speed, i.e. inertial navigation combined with non-inertial navigation instruments

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/017—Gesture based interaction, e.g. based on a set of recognized hand gestures

-

- G—PHYSICS

- G01—MEASURING; TESTING

- G01C—MEASURING DISTANCES, LEVELS OR BEARINGS; SURVEYING; NAVIGATION; GYROSCOPIC INSTRUMENTS; PHOTOGRAMMETRY OR VIDEOGRAMMETRY

- G01C21/00—Navigation; Navigational instruments not provided for in groups G01C1/00 - G01C19/00

- G01C21/10—Navigation; Navigational instruments not provided for in groups G01C1/00 - G01C19/00 by using measurements of speed or acceleration

- G01C21/12—Navigation; Navigational instruments not provided for in groups G01C1/00 - G01C19/00 by using measurements of speed or acceleration executed aboard the object being navigated; Dead reckoning

- G01C21/16—Navigation; Navigational instruments not provided for in groups G01C1/00 - G01C19/00 by using measurements of speed or acceleration executed aboard the object being navigated; Dead reckoning by integrating acceleration or speed, i.e. inertial navigation

- G01C21/165—Navigation; Navigational instruments not provided for in groups G01C1/00 - G01C19/00 by using measurements of speed or acceleration executed aboard the object being navigated; Dead reckoning by integrating acceleration or speed, i.e. inertial navigation combined with non-inertial navigation instruments

- G01C21/1656—Navigation; Navigational instruments not provided for in groups G01C1/00 - G01C19/00 by using measurements of speed or acceleration executed aboard the object being navigated; Dead reckoning by integrating acceleration or speed, i.e. inertial navigation combined with non-inertial navigation instruments with passive imaging devices, e.g. cameras

-

- G—PHYSICS

- G01—MEASURING; TESTING

- G01C—MEASURING DISTANCES, LEVELS OR BEARINGS; SURVEYING; NAVIGATION; GYROSCOPIC INSTRUMENTS; PHOTOGRAMMETRY OR VIDEOGRAMMETRY

- G01C25/00—Manufacturing, calibrating, cleaning, or repairing instruments or devices referred to in the other groups of this subclass

- G01C25/005—Manufacturing, calibrating, cleaning, or repairing instruments or devices referred to in the other groups of this subclass initial alignment, calibration or starting-up of inertial devices

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/0304—Detection arrangements using opto-electronic means

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/033—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor

- G06F3/0346—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor with detection of the device orientation or free movement in a 3D space, e.g. 3D mice, 6-DOF [six degrees of freedom] pointers using gyroscopes, accelerometers or tilt-sensors

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

- G06F3/0487—Interaction techniques based on graphical user interfaces [GUI] using specific features provided by the input device, e.g. functions controlled by the rotation of a mouse with dual sensing arrangements, or of the nature of the input device, e.g. tap gestures based on pressure sensed by a digitiser

-

- G06T7/0018—

-

- G06T7/0042—

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/70—Determining position or orientation of objects or cameras

- G06T7/73—Determining position or orientation of objects or cameras using feature-based methods

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/80—Analysis of captured images to determine intrinsic or extrinsic camera parameters, i.e. camera calibration

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30204—Marker

- G06T2207/30208—Marker matrix

Landscapes

- Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- General Engineering & Computer Science (AREA)

- Remote Sensing (AREA)

- Radar, Positioning & Navigation (AREA)

- Human Computer Interaction (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Manufacturing & Machinery (AREA)

- Automation & Control Theory (AREA)

- User Interface Of Digital Computer (AREA)

- Processing Or Creating Images (AREA)

- Studio Devices (AREA)

Abstract

모바일 디바이스는 카메라에 의해 캡처된 이미지들을 사용하여 비전 기반 포즈를 결정하고, 가속도계들 및 자이로스코프들과 같은 관성 센서들로부터의 데이터를 사용하여 센서 기반 포즈를 결정한다. 비전 기반 포즈 및 센서 기반 포즈는, 상이한 포즈들에 대한 별개의 그래픽들을 디스플레이하는 시각화 애플리케이션에서 별개로 사용된다. 예를 들면, 시각화 애플리케이션은 관성 센서들을 교정하는데 사용될 수 있고, 여기서 시각화 애플리케이션은 비전 기반 포즈에 기초한 그래픽 및 센서 기반 포즈에 기초한 그래픽을 디스플레이하고, 관성 센서들의 교정의 수렴을 가속화하기 위해 디스플레이된 그래픽들을 통해 특정 방향으로 모바일 디바이스를 이동시키도록 사용자를 유도한다. 대안적으로, 시각화 애플리케이션은, 비전 기반 포즈 및 센서 기반 포즈를 사용하여 별개의 그래픽들을 디스플레이하는 사진 애플리케이션 또는 모션 기반 게임일 수 있다.

Description

[0001] 본 출원은 명칭이 "Display of Separate Computer Vision Based Pose and Inertial Sensor Based Pose"로 2012년 12월 21일자로 출원된 미국 출원 제 13/725,175 호에 대한 이점 및 우선권을 주장하며, 상기 출원은 본원의 양수인에게 양도되었으며, 본원에 인용에 의해 포함된다.

[0002] 본원에 설명된 요지의 실시예들은 일반적으로 시각화 애플리케이션에서 컴퓨터 비전 기반 포즈 및 관성 센서 기반 포즈를 별개로 사용하는 것에 관한 것이며, 더 상세하게는, 모바일 디바이스의 사용자 이동을 유도하기 위해 컴퓨터 비전 기반 포즈 및 관성 센서 기반 포즈에 대한 별개의 그래픽들을 디스플레이하는 것에 관한 것이다.

[0003] 스마트폰들, 태블릿 컴퓨터들, 카메라들 등과 같은 증가하는 수의 모바일 디바이스들은 카메라 이외에 다양한 타입들의 관성 센서들을 포함한다. 가속도계들 및 자이로스코프들과 같은 관성 센서들은, 높은 샘플링 레이트들로 가속도 및 각 속도를 측정하는 자신들의 능력으로 인해 모바일 디바이스의 이동을 추적하기에 유용하다. 증강 현실, 실내 내비게이션 등과 같은 많은 애플리케이션들은 포즈(포지션 및 배향)의 결정 및 모바일 디바이스의 추적을 위해 관성 센서들 및 컴퓨터 비전의 조합을 사용한다.

[0004] 특히 컴퓨터 비전 기술들과 결합될 때, 관성 센서들이 정확한 포지션 결정에 사용되도록 하기 위해, 관성 센서들의 정확한 교정(calibration)이 요구된다. 관성 센서들의 교정은 카메라에 관련한 관성 센서들의 정렬뿐만 아니라 관성 센서들의 스케일 및 비-직교성(non-orthogonality) 파라미터들의 교정을 포함한다. 그러나, 관성 센서의 교정은, 각각의 개별적인 모바일 디바이스에 대해 요구되는 현재 시간 소비형 팩토리 프로세스이다. 관성 센서들의 팩토리 교정 동안에, 모바일 디바이스의 일련의 정밀한 이동들이 수행되고, 관성 센서들의 응답에 상관된다. 사용자 모션을 통한 센서들의 교정을 위한 일부 접근법들이 존재하지만, 그러한 접근법들의 성능은 품질 면에서 팩토리 모션들과 유사한 사용자 모션들을 공급하는 것에 크게 의존한다. 복잡하고 여전히 매우 정확한 모션을 제공하도록 사용자들에게 지시하는 것은 어렵다. 그러나, 이러한 풍부한 모션들이 없다면, 정확한 교정 파라미터들을 신뢰할 수 있게 획득하기 위한 유일한 방법은, 비용 증가가 수반되는 팩토리 교정이다.

[0005] 모바일 디바이스는 카메라에 의해 캡처된 이미지들을 사용하여 비전 기반 포즈를 결정하고, 가속도계들 및 자이로스코프들과 같은 관성 센서들로부터의 데이터를 사용하여 센서 기반 포즈를 결정한다. 비전 기반 포즈 및 센서 기반 포즈는, 상이한 포즈들에 대한 별개의 그래픽들을 디스플레이하는 시각화 애플리케이션에서 별개로 사용된다. 예를 들면, 시각화 애플리케이션은 관성 센서들을 교정하는데 사용될 수 있고, 여기서 시각화 애플리케이션은 비전 기반 포즈에 기초한 그래픽 및 센서 기반 포즈에 기초한 그래픽을 디스플레이하고, 관성 센서들의 교정의 수렴을 가속화하기 위해 디스플레이된 그래픽들을 통해 모바일 디바이스를 특정 방향으로 이동시키도록 사용자를 유도한다. 대안적으로, 시각화 애플리케이션은, 비전 기반 포즈 및 센서 기반 포즈를 사용하여 별개의 그래픽들을 디스플레이하는 사진 애플리케이션 또는 모션 기반 게임일 수 있다.

[0006] 일 구현에서, 방법은 캡처된 이미지들을 사용하여 모바일 디바이스의 비전 기반 포즈를 결정하는 단계, 관성 센서들을 사용하여 모바일 디바이스의 센서 기반 포즈를 결정하는 단계, 및 시각화 애플리케이션에서 비전 기반 포즈 및 센서 기반 포즈를 별개로 사용하는 단계를 포함한다.

[0007] 일 구현에서, 모바일 디바이스는 환경이 이미지들을 캡처하는 카메라, 모바일 디바이스의 이동에 응답하는 데이터를 생성하는 관성 센서들, 디스플레이, 및 디스플레이에 연결되고, 환경의 캡처된 이미지들을 수신하기 위해 카메라에 연결되고, 모바일 디바이스의 이동에 응답하는 데이터를 수신하기 위해 관성 센서들에 연결된 프로세서를 포함하고, 프로세서는 캡처된 이미지들을 사용하여 모바일 디바이스의 비전 기반 포즈를 결정하고, 관성 센서들로부터의 데이터를 사용하여 모바일 디바이스의 센서 기반 포즈를 결정하고, 디스플레이로 하여금 비전 기반 포즈에 기초한 제 1 그래픽을 도시하게 하고 센서 기반 포즈에 기초한 제 2 그래픽을 도시하게 하도록 구성된다.

[0008] 일 구현에서, 모바일 디바이스는 캡처된 이미지들을 사용하여 모바일 디바이스의 비전 기반 포즈를 결정하기 위한 수단, 관성 센서들을 사용하여 모바일 디바이스의 센서 기반 포즈를 결정하기 위한 수단, 및 시각화 애플리케이션에서 비전 기반 포즈 및 센서 기반 포즈를 별개로 사용하기 위한 수단을 포함한다.

[0009] 일 구현에서, 프로그램 코드가 저장되어 있는 저장 매체는, 캡처된 이미지들을 사용하여 모바일 디바이스의 비전 기반 포즈를 결정하기 위한 프로그램 코드, 관성 센서들을 사용하여 모바일 디바이스의 센서 기반 포즈를 결정하기 위한 프로그램 코드, 및 시각화 애플리케이션에서 비전 기반 포즈 및 센서 기반 포즈를 별개로 사용하기 위한 프로그램 코드를 포함한다.

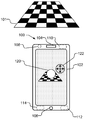

[0010] 도 1은, 캡처된 이미지들로부터 비전 기반 포즈 및 관성 센서들로부터 센서 기반 포즈를 결정하고, 시각화 애플리케이션에서 비전 기반 포즈 및 센서 기반 포즈를 별개로 사용할 수 있는 모바일 디바이스를 예시한다.

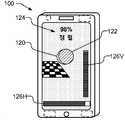

[0011] 도 2는 시각화 애플리케이션에서 모바일 디바이스에 의해 사용될 수 있는 그래픽들의 하나의 가능한 구현을 예시한다.

[0012] 도 3은 시각화 애플리케이션에서 모바일 디바이스에 의해 사용될 수 있는 그래픽들의 다른 가능한 구현을 예시한다.

[0013] 도 4는 시각화 애플리케이션에서 모바일 디바이스에 의해 사용될 수 있는 그래픽들의 다른 가능한 구현을 예시한다.

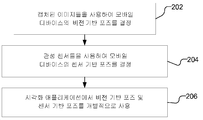

[0014] 도 5는 시각화 애플리케이션에서 비전 기반 그래픽 및 센서 기반 그래픽을 별개로 사용하는 프로세스를 예시한 흐름도이다.

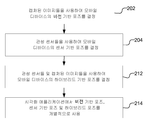

[0015] 도 6은 시각화 애플리케이션에서 비전 기반 그래픽, 센서 기반 그래픽 및 하이브리드 그래픽을 사용하는 프로세스를 예시한 흐름도이다.

[0016] 도 7은 관성 센서들을 교정하기 위한 시각화 애플리케이션의 특정 실시예를 예시한 흐름도이다.

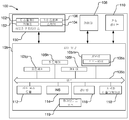

[0017] 도 8은 비전 기반 포즈 및 센서 기반 포즈를 결정하고, 시각화 애플리케이션에서 비전 기반 그래픽 및 센서 기반 그래픽을 별개로 사용할 수 있는 모바일 디바이스의 블록도이다.

[0011] 도 2는 시각화 애플리케이션에서 모바일 디바이스에 의해 사용될 수 있는 그래픽들의 하나의 가능한 구현을 예시한다.

[0012] 도 3은 시각화 애플리케이션에서 모바일 디바이스에 의해 사용될 수 있는 그래픽들의 다른 가능한 구현을 예시한다.

[0013] 도 4는 시각화 애플리케이션에서 모바일 디바이스에 의해 사용될 수 있는 그래픽들의 다른 가능한 구현을 예시한다.

[0014] 도 5는 시각화 애플리케이션에서 비전 기반 그래픽 및 센서 기반 그래픽을 별개로 사용하는 프로세스를 예시한 흐름도이다.

[0015] 도 6은 시각화 애플리케이션에서 비전 기반 그래픽, 센서 기반 그래픽 및 하이브리드 그래픽을 사용하는 프로세스를 예시한 흐름도이다.

[0016] 도 7은 관성 센서들을 교정하기 위한 시각화 애플리케이션의 특정 실시예를 예시한 흐름도이다.

[0017] 도 8은 비전 기반 포즈 및 센서 기반 포즈를 결정하고, 시각화 애플리케이션에서 비전 기반 그래픽 및 센서 기반 그래픽을 별개로 사용할 수 있는 모바일 디바이스의 블록도이다.

[0018] 도 1은, 캡처된 이미지들로부터 비전 기반 포즈 및 관성 센서들로부터 센서 기반 포즈를 결정하고, 시각화 애플리케이션에서 비전 기반 포즈 및 센서 기반 포즈를 별개로 사용할 수 있는 모바일 디바이스(100)를 예시한다. 시각화 애플리케이션은, 본원에서 때때로 비전 기반 그래픽 및 센서 기반 그래픽으로 각각 지칭되는 비전 기반 포즈 및 센서 기반 포즈에 대한 별개의 그래픽들을 디스플레이한다. 시각화 애플리케이션은, 예로서, 관성 센서들, 게임, 사진 등을 교정하는데 사용될 수 있다. 관성 센서들은, 예를 들면, 디스플레이된 그래픽들에 응답하는 모바일 디바이스의 사용자 조작에 기초하여 교정될 수 있다. 모바일 디바이스(100)는, 반드시 그렇지는 않지만, 터치 스크린 디스플레이일 수 있는 디스플레이(102)를 포함하는 것으로 예시된다. 모바일 디바이스(100)는, 디스플레이(102) 상에 도시되는 것으로 예시된, 타겟(101)과 같은 환경을 이미징하기 위한 전방(forward facing) 카메라(108)를 포함한다. 모바일 디바이스(100)는 또한 가속도계들, 자이로스코프들 등과 같은 관성 센서들(110)을 포함한다. 모바일 디바이스(100)는 또한, 예를 들면, 모바일 디바이스(100)가 셀룰러 텔레폰인 경우, 스피커(104) 및 마이크로폰(106)과 같은, 본 발명에 관련되지 않은 다른 특징부들을 포함할 수 있다.

[0019] 본원에 사용된 바와 같이, "모바일 디바이스"는, 비전-기반 포지션 검출 및 캡처된 이미지들 또는 비디오 스트림들로부터의 추적이 가능하고 관성 센서들을 포함하는 임의의 휴대용 전자 디바이스를 지칭하고, 예를 들면, 셀룰러 또는 다른 무선 통신 디바이스, 개인 통신 시스템(PCS) 디바이스, 개인 내비게이션 디바이스(PND), 개인 정보 관리기(PIM), 개인 휴대 정보 단말(PDA), 또는 (카메라들, 무선 통신 디바이스들, 컴퓨터들, 랩탑들, 태블릿 컴퓨터들 등을 포함하는) 다른 적절한 모바일 디바이스를 포함할 수 있다. 모바일 디바이스는, 반드시 그렇지는 않지만, 내비게이션 포지셔닝 신호들과 같은 무선 통신 및/또는 내비게이션 신호들을 수신하는 것이 가능할 수 있다. 용어 "모바일 디바이스"는, 위성 신호 수신, 보조 데이터 수신 및/또는 포지션-관련 프로세싱이 디바이스 또는 PND에서 발생하는지에 관계없이, 예컨대 단거리 무선, 적외선, 유선 접속, 또는 다른 접속에 의해 개인 내비게이션 디바이스(PND)와 통신하는 디바이스들을 포함하도록 또한 의도된다.

[0020] 모바일 디바이스(100)는, 비전 기반 포즈를 생성하기 위해 카메라(108)에 의해 캡처된 이미지들, 예를 들면, 카메라(108)에 의해 생성된 일련의 비디오 프레임들을 사용하는 비전 포즈 모듈(112)을 포함한다. 비전 기반 포즈는, 컴퓨터 비전 기술들을 사용하여 결정되는 모바일 디바이스의 포지션 및 배향이다. 카메라(108)가 이미지들 및/또는 비디오 프레임들을 캡처할 수 있고, 용어들, 이미지 및 프레임이 본원에서 상호 교환 가능하게 사용된다는 것이 이해되어야 한다. 모바일 디바이스(100)는, 센서 기반 포즈를 생성하기 위해 관성 센서들(110)의 출력을 사용하는 관성 센서 시스템(INS)(114)을 더 포함한다. 비전 기반 포즈 및 센서 기반 포즈 중 하나 또는 둘 모두가 다른 것에 기초하여 초기화될 수 있지만, 그렇지 않다면, 본원에 사용된 바와 같이, 비전 기반 포즈가 센서 기반 포즈와 독립적이고 센서 기반 포즈가 비전 기반 포즈와 독립적인 것이 이해되어야 한다. 따라서, 현재 시간 인스턴트에서, 비전 기반 포즈 및 센서 기반 포즈는 현재 세트의 증강들(augmentations)을 렌더링할 때 독립적이지만, 그들은 과거 시간 인스턴트에서 함께 융합되었을 수 있다.

[0021] 모바일 디바이스(100)는, 캡처된 이미지들로부터 생성된 비전 기반 포즈 및 관성 센서 데이터로부터 생성된 센서 기반 포즈에 기초하여 디스플레이(102) 상에 별개의 그래픽들을 디스플레이하는 시각화 애플리케이션을 사용한다. 예를 들면, 도 1에 예시된 바와 같이, 모바일 디바이스(100)는 비전 포즈 모듈(112)에 의해 생성된 비전 기반 포즈에 기초한 제 1 그래픽(120), 및 INS(114)에 의해 생성된 센서 기반 포즈에 기초한 제 2 그래픽(122)을 렌더링할 수 있다. 원한다면, 비전 기반 그래픽(120) 및 센서 기반 그래픽(122)은 동일한 렌더링된 물체들의 상이한 컬러 채널들일 수 있거나, 그들은 상이한 물체들일 수 있다. 도 1은 그래픽들(120 및 122)을 볼들로서 예시하지만, 임의의 타입의 그래픽들이 사용될 수 있다는 것이 이해되어야 한다. 또한, 원한다면, 비전 기반 포즈에 대해 다수의 그래픽들이 사용될 수 있고, 센서 기반 포즈에 대해 다수의 그래픽들이 사용될 수 있다. 예를 들면, 아래에 논의되는 바와 같이, 하나 이상의 수평 바들 및 하나 이상의 수직 바들이 비전 기반 포즈에 기초하여 렌더링될 수 있고, 마찬가지로, 수평 및 수직 바들이 센서 기반 포즈에 기초하여 렌더링될 수 있다. 원한다면, 렌더링된 그래픽들은 더 복잡해지거나 애니메이팅될 수 있고, 예를 들면, 고양이는 비전 기반 포즈에 기초하여 렌더링될 수 있고, 쥐는 센서 기반 포즈에 기초하여 렌더링되고, 여기서 고양이는 사용자 모션에 기초하여 쥐를 잡도록 제어된다.

[0022] 시각화 애플리케이션은, 모바일 디바이스의 사용자 이동을 유도하기 위해 비전 기반 그래픽 및 센서 기반 그래픽을 별개로 디스플레이한다. 예를 들면, 시각화 애플리케이션은 엔터테인먼트, 예를 들면, 게임일 수 있다. 다른 애플리케이션은 사진에 관련될 수 있다. 예를 들면, 단일 카메라를 사용하여 3차원 이미지를 생성하기 위해, 모바일 디바이스는, 이미징된 대상을 디스플레이의 중앙에 유지하면서, 상이한 관점들로 이동된다. 따라서, 비전 기반 그래픽은 대상에 대해 고정된 것으로 디스플레이될 수 있고, 반면에 센서 기반 그래픽의 이동은 비전 기반 그래픽 및 센서 기반 그래픽의 정렬을 유지하기 위해 모바일 디바이스를 상이한 관점들로 이동시키도록 사용자를 유도하다. 다른 예에서, 파노라마를 생성하기 위해, 카메라를 패닝(panning)하면서, 카메라의 포지션을 유지하는 것이 바람직하다. 따라서, 센서 기반 그래픽은 디스플레이에서 고정된 것으로 디스플레이될 수 있고, 반면에 비전 기반 그래픽의 이동은, 비전 기반 그래픽 및 센서 기반 그래픽의 정렬을 유지하기 위해 고정된 위치를 유지하면서, 모바일 디바이스를 회전시키도록 사용자를 유도한다.

[0023] 시각화 애플리케이션의 다른 예는 관성 센서들(110)의 교정을 위한 것이다. 관성 센서들(110) 및 카메라(108)의 정렬뿐만 아니라 스케일 및 비-직교성의 교정은 비전 기반 포즈들을 외부 측정치들로서 사용할 수 있다. 또한, 사용자는, 비전 기반 그래픽 및 센서 기반 그래픽의 디스플레이에 기초한 교정을 위해 원하는 궤적들을 따라 모바일 디바이스(100)를 이동시키도록 유도된다. 따라서, 사용자는, 교정 알고리즘에 제공될 수 있는 양호한 품질의 데이터를 수집하기 위해 원하는 궤적들을 따라 모바일 디바이스를 이동시키도록 장려된다.

[0024] 모바일 디바이스(100)는, 비전 기반 포즈를 생성하는데 사용되는 이미지들을 캡처하는 동안에, 모바일 디바이스(100)의 이동에 응답하여 생성된 데이터를 관성 센서들(110)로부터 수집한다. 비전 기반 포즈 및 센서 데이터는 관성 센서들의 교정을 위해 사용될 수 있다. 비전 기반 그래픽(120) 및 센서 기반 그래픽(122)은 모바일 디바이스를 이동시키도록 사용자를 유도할 뿐만 아니라, 교정 파라미터에서 교정 정확도 및 신뢰도와 같이, 관성 센서들의 교정 상태에 관련하여 사용자에게 피드백하도록 렌더링될 수 있다. 따라서, 모바일 디바이스(100)는, 사용자가 관성 센서 교정 정확도를 시각화하고 교정 파라미터 추정치들의 신뢰성에 기초하여 모바일 디바이스와의 사용자 상호 작용을 적응적으로 변경하도록 허용하기 위해 시각화 애플리케이션을 사용할 수 있다.

[0025] 도 2는, 예로서, 관성 센서들을 교정할 때, 시각화 애플리케이션에서 모바일 디바이스에 의해 사용될 수 있는 그래픽들의 하나의 가능한 구현을 예시한다. 도 1에 도시된 모바일 디바이스(100)의 포즈와 비교하여 볼 수 있듯이, 도 2의 모바일 디바이스(100)는 타겟(101)에 대해 회전된 것으로 예시된다. 모바일 디바이스(100)의 회전으로 인해, 센서 기반 그래픽(122)은 비전 기반 그래픽(120)과의 더 가깝게 정렬하도록 이동되었다. 그래픽들을 정렬시키기 위해 모바일 디바이스(100)를 수동으로 이동시키는 프로세스는 카메라(108)에 관련하여 관성 센서들(110)을 교정하기 위한 피드백을 제공할 수 있다. 또한, 별개의 그래픽들(120 및 122)의 시각 디스플레이는 카메라(108)에 대한 관성 센서들(110)의 교정 상태의 피드백을 사용자에게 제공할 수 있다. 부가적으로, 도 2의 텍스트(124)로 예시된 바와 같이, 정렬 상태를 표시하기 위한 스코어가 사용자에게 제공될 수 있다. 수평 및 수직 축들을 따른 정렬 상태를 각각 나타낼 수 있는 수평 바(126H) 및 수직 바(126V)와 같은 다른 또는 부가적인 피드백이 사용자에게 물론 제공될 수 있다. 또한, 6 개의 차원들(회전에 대한 3 개의 차원 및 병진(translation)에 대한 3 개의 차원)이 존재할 때, 6 개의 별개의 그래픽들, 예를 들면, 바들 또는 그렇지 않다면, 또는 서브세트, 따라서, 예를 들면, 2 개 이상이 디스플레이될 수 있다. 그래픽들(120 및 122)은, 관성 센서들의 교정의 수렴을 가속화하는 특정 방향으로 모바일 디바이스를 이동시키도록 사용자를 장려하는 게임의 부분으로서 렌더링될 수 있다. 다시 말해서, 부담스러운 행정 처리와 대조적으로, 오락을 위해 플레이되는 게임으로서 교정 절차가 사용자에게 제공될 수 있다. 예를 들면, 교정 게임에서, 비전 기반 그래픽(120)의 디스플레이된 포지션은 주기적으로 이동되어, 센서 기반 그래픽(122)과 비전 기반 그래픽(120)을 재정렬하기 위해 모바일 디바이스(100)의 포지션 및 배향을 조작할 것을 사용자에게 요구한다. 따라서, 사용자는 하나 이상의 축들을 따라 모바일 디바이스(100)를 회전 및/또는 이동시키도록 유도될 수 있고, 모바일 디바이스(100)의 결과적인 모션은 교정을 위해 사용될 수 있다. 점점 더 양호한 교정을 통해, 관성 센서들에 의해 추정된 모션은 컴퓨터 비전에 기초하여 해독된 모션에 점점 더 가깝게 매칭할 것이다. 관성 센서들에 의해 추정된 모션과 컴퓨터 비전에 기초하여 해독된 모션 사이의 차이가 임계치 내에서 매칭할 때, 교정이 수용 가능한 것으로 결정될 수 있고, 임계치는 시스템의 잡음 레벨에 기초할 수 있다.

[0026] 정렬 및 비-직교성은 폰의 수명 시간에 걸쳐 매우 느리게 변하는 것으로 예상된다. 따라서, 정렬 및 비-직교성을 교정하는 것은 드물게 수행될 수 있다. 그러나, 스케일은 온도에 의존한다. 스케일이 바이어스에 따라 진행중인 방식으로 추정될 수 있지만, 정렬, 비-직교성, 스케일 및 바이어스를 공동으로 추정하는 것은 전체 교정 파라미터들의 감소된 정확성을 유도할 가능성이 있을 것이다. 따라서, 모바일 디바이스(100)의 사용자 교정은 주기적으로 또는 모바일 디바이스(100) 상의 기계적 스트레스들의 이벤트 시에 수행될 수 있다.

[0027] 도 3은, 관성 센서들을 교정할 때, 시각화 애플리케이션에서 모바일 디바이스에 의해 사용될 수 있는 그래픽들의 다른 가능한 구현을 예시한다. 디스플레이된 그래픽(132)은 컴퓨터 비전 포즈에 기초할 수 있고, 별개의 그래픽(134)은 센서 기반 포즈에 기초할 수 있다. 도 3에 예시된 바와 같이, 비전 기반 그래픽(132)은 미로(maze)일 수 있고, 반면에 센서 기반 그래픽(134)은 모바일 디바이스(100)의 사용자 생성 모션에 의해 미로를 통해 이동될 물체일 수 있다. 따라서, 도 3에서 볼 수 있듯이, 사용자는, 비전 기반 그래픽(132)을 통해 센서 기반 그래픽(134)을 이동시키기 위해 모바일 디바이스(100)를 수평적으로 그리고 수직적으로 회전 또는 이동시키도록 유도될 것이다. 모바일 디바이스(100)의 모션은 관성 센서들(110)을 교정하는데 사용될 수 있다.

[0028] 도 4는, 관성 센서들을 교정할 때, 시각화 애플리케이션에서 모바일 디바이스에 의해 사용될 수 있는 그래픽들의 다른 가능한 구현을 예시한다. 디스플레이된 그래픽(142)은 컴퓨터 비전 포즈에 기초할 수 있고, 별개의 그래픽(144)은 센서 기반 포즈에 기초할 수 있다. 예를 들면, 비전 기반 그래픽(142) 및 센서 기반 그래픽(144)은, 예를 들면, 디스플레이(102)에 수직으로 연장하는 Z 축을 따라 모바일 디바이스(100)를 회전시키도록 사용자를 유도하는데 사용될 수 있다. 부가적으로, 사용자는 모바일 디바이스(100)를 앞뒤로 이동시키도록 유도될 수 있는데, 예를 들면, 디스플레이(102)에 수직으로 연장하는 축을 따라 Z 축을 따라 모바일 디바이스를 병진시켜서, 그래픽들(142, 144)의 크기가 유사할 때까지 그래픽들 중 하나 이상의 크기를 변경한다. 마찬가지로, 사용자는 그래픽들(142, 144)을 정렬시키기 위해 X 및 Y 축들을 따라 모바일 디바이스(100)를 이동(병진)하도록 유도될 수 있고, 그래픽들(142, 144)의 외관(appearance)에 기초하여 X 및 Y 축들을 중심으로 모바일 디바이스(100)를 회전시키도록 유도될 수 있다. 따라서, 사용자가 6 개의 자유도들로 모바일 디바이스를 이동시키도록 유도될 수 있다는 것을 알 수 있다.

[0029] 도 5는 시각화 애플리케이션에서 비전 기반 그래픽 및 센서 기반 그래픽을 별개로 사용하는 프로세스를 예시한 흐름도이다. 모바일 디바이스의 비전 기반 포즈는 캡처된 이미지들을 사용하여 결정된다(202). 모바일 디바이스의 비전 기반 포즈는 통상적인 컴퓨터 비전 기술들을 사용하여 생성될 수 있다. 예를 들면, 새로운 이미지의 각각의 이미지에 대해, 특징들은, FAST(Features from Accelerated Segment Test) 코너 검출기, SIFT(Scale-invariant Feature Transform), SURF(Speeded UP Robust Features), 또는 임의의 다른 원하는 방법을 사용하여 추출될 수 있다. 현재 이미지에 대한 추출된 특징들은, 알려지거나 학습된 타겟의 이전 이미지 또는 모델일 수 있는 기준 이미지로부터의 특징들과 비교될 수 있다. 현재 이미지 내의 추출된 특징들의 포지션들을 기준 이미지에 맵핑하는 호모그래피(homography)는 환경에 관련하여 모바일 디바이스의 포즈에 6 개의 자유도들을 제공할 수 있다.

[0030] 관성 센서들을 사용하여 모바일 디바이스의 센서 기반 포즈가 또한 결정된다(204). 잘 알려진 바와 같이, 센서 기반 포즈는, 통합 시간에 걸쳐 모바일 디바이스의 포즈 변화를 결정하기 위해, 시간에 걸쳐, 예를 들면, 가속도계들 또는 자이로스코프들로부터 관성 센서 데이터를 통합함으로써 결정될 수 있다. 따라서, 카메라를 사용하여 환경의 기준 이미지를 캡처하는 것과 동일한 시간에 관성 센서들의 통합을 개시함으로써, 모바일 디바이스의 센서 기반 포즈가 비전 기반 포즈를 결정하는 것과 동시에 결정될 수 있다. 관성 센서들로부터의 데이터가 포즈의 상대적인 변화를 제공한다는 것이 이해되어야 한다. 포즈의 변화는 센서 기반 포즈로서 사용될 수 있다. 대안적으로, 초기 포즈는, 예를 들면, 컴퓨터 비전 기술 또는 다른 초기화 기술을 사용하여 제공될 수 있고, 여기서 센서 기반 포즈는 초기 포즈로부터의 변화로서 방해받을 수 있다. 예를 들면, 센서 기반 포즈는 규칙적인 간격들로, 예를 들면, 5 번째 프레임마다 비전 기반 포즈를 통해 초기화될 수 있다. 그러한 초기화 프레임들 사이에, 센서들로부터의 포즈의 변화는 센서 기반 포즈로서 사용된다.

[0031] 비전 기반 포즈 및 센서 기반 포즈는 시각화 애플리케이션에서 별개로 사용된다(206). 다시 말해서, 비전 기반 포즈 및 센서 기반 포즈는 동일한 시각화 애플리케이션에 의해 동시에 사용될 수 있지만 결합되지 않아서, 그들이 별개로 사용된다. 예를 들면, 시각화 애플리케이션에서, 비전 기반 포즈에 기초한 제 1 그래픽 및 센서 기반 포즈에 기초한 제 2 그래픽이 디스플레이될 수 있다. 원한다면, 비전 기반 포즈 및 센서 기반 포즈는, 상이한 컬러 채널들을 통해 단일 증강 캐릭터를 렌더링함으로써 시각화 애플리케이션에서 사용될 수 있다. 따라서, 제 1 그래픽은 단일 증강 캐릭터에 대한 제 1 컬러 채널일 수 있고, 제 2 그래픽은 단일 증강 캐릭터에 대한 제 2 컬러 채널일 수 있다.

[0032] 앞서 논의된 바와 같이, 시각화 애플리케이션은 캡처된 이미지들을 사용하여 관성 센서들의 교정을 수행할 수 있고, 제 1 그래픽 및 제 2 그래픽은 관성 센서들의 교정에 기초하여 서로 상호작용하도록 렌더링된다. 예를 들면, 사용자는, 관성 센서들의 교정 상태에 기초하여 제 1 그래픽 및 제 2 그래픽 중 적어도 하나를 이동시킴으로써 모바일 디바이스를 특정 방향으로 이동시키도록 유도될 수 있고, 모바일 디바이스의 특정 방향으로의 이동은 관성 센서들의 교정의 수렴을 가속화한다. 예를 들면, 하나의 교정 파라미터, 예를 들면, X 축의 교정의 완료 후에, Y 축을 따라 모바일 디바이스를 이동시키도록 사용자를 유도하기 위해 제 1 그래픽 및/또는 제 2 그래픽이 이동될 수 있다. 다양한 축들을 중심으로 한 회전들뿐만 아니라 Z 축도 마찬가지로 교정될 수 있다. 부가적으로 또는 대안적으로, 관성 센서들의 교정의 상태는, 예를 들면, 교정 정확성, 교정 파라미터의 신뢰도, 에러 공분산(covariance) 또는 에러 공분산의 편차일 수 있다. 에러 공분산 또는 신뢰도의 예는, 교정 절차에 사용될 수 있는 확장 칼만 필터(Extended Kalman Filter)로부터의 결과이다. 다른 예는 추정치들의 신뢰성을 추정하는 다른 알고리즘으로부터의 결과일 수 있다. 특정 방향으로 모바일 디바이스를 이동시키도록 사용자를 유도하는 것은, 관성 센서들의 교정의 수렴을 가속화하기 위해 시각화 애플리케이션으로의 피드백으로서 관성 센서들의 교정 품질을 사용한다.

[0033] 그러나, 시각화 애플리케이션은 교정 이외의 프로세스들을 위한 것일 수 있다. 예를 들면, 시각화 애플리케이션은, 비전 기반 포즈에 기초한 제 1 그래픽 및 센서 기반 포즈에 기초한 제 2 그래픽을 디스플레이하는 모바일 디바이스용 모션 기반 게임 또는 사진 애플리케이션일 수 있다.

[0034] 원한다면, 모바일 디바이스(100)에서 시각화 애플리케이션에 의해 부가적인 정보가 디스플레이될 수 있다. 예를 들면, 도 6은 도 5에 도시된 흐름도와 유사한 흐름도이지만, 시각화 애플리케이션에 의해 사용되는 부가적인 정보를 포함한다. 따라서, 볼 수 있듯이, 비전 기반 포즈 및 센서 기반 포즈가 결정된다(202, 204). 부가적으로, 모바일 디바이스의 하이브리드 기반 포즈는 캡처된 이미지들 및 관성 센서들을 함께 사용하여 결정된다(212). 예를 들어, 원한다면, 비전 기반 포즈 및 센서 기반 포즈가 결합될 수 있거나, 관성 센서들로부터의 데이터 및 카메라로부터의 데이터가 결합되어 하이브리드 기반 포즈를 형성할 수 있다. 시각화 애플리케이션은, 예를 들면, 각각의 포즈를 나타내는 별개의 그래픽들을 디스플레이함으로써 비전 기반 포즈, 센서 기반 포즈 및 하이브리드 기반 포즈를 별개로 사용한다(214). 비전 기반 포즈 또는 센서 기반 포즈에 기초하여 디스플레이되는 그래픽들 중 하나 또는 둘 모두가 교정 동안에 항상 디스플레이될 필요는 없다는 것이 이해되어야 하며, 예를 들면, 비전 기반 포즈의 추적이 분실된 경우에, 비전 기반 포즈에 대해 디스플레이된 그래픽이 제거될 수 있고, 반면에 센서 기반 포즈에 대해 디스플레이된 그래픽은 여전히 디스플레이된다.

[0035] 도 7은, 관성 센서들에 대한 교정 애플리케이션 형태의 시각화 애플리케이션의 특정 실시예를 예시한 흐름도이다. 볼 수 있듯이, 교정 프로세스가 개시된다(302). 교정 애플리케이션은 팩토리 교정 대신 또는 이외의 것일 수 있고, 모바일 디바이스(100) 상에 미리 설치될 수 있다. 관성 센서들의 사용을 허용하기 전에, 교정 애플리케이션을 자동적으로 개시하는 것이 바람직할 수 있거나, 대안적으로, 사용자가 원할 때 애플리케이션을 개시할 수 있다. 정확한 컴퓨터 비전 포즈 추정들을 생성하기에 적합한 특징 풍부 타겟을 어디서 찾는지에 관한 정보와 같은 명령들이 사용자에게 제공될 수 있다. 모바일 디바이스(100)는 모바일 디바이스의 포즈를 초기화하기 위해 특정 포지션에, 예를 들면, 수준면(level surface) 상에서 앞면이 위로(face up) 배치될 수 있다(304). 모바일 디바이스(100)는, 예를 들면, 톤(tone)을 방출함으로써 초기화가 완료된 때를 사용자에게 표시할 수 있다. 모바일 디바이스(100)는 센서 기반 포즈 및 별개의 비전 기반 포즈를 결정한다(306). 예를 들면, 모바일 디바이스(100)는 기준 타겟의 이미지들 또는 비디오 프레임들을 캡처하여 포즈를 결정하고 컴퓨터 비전을 사용하여 추적을 포착하고, 한편 추적에 또한 사용되는 관성 센서들에 기초하여 포즈를 또한 결정한다. 센서 기반 포즈 및 비전 기반 포즈에 관련된 별개의 그래픽들을 디스플레이함으로써 모바일 디바이스를 이동시키기 위한 명령들이 사용자에게 제공된다(308). 사용자가 교정을 개선하기 위해 모바일 디바이스를 이동시키는 동안에, 센서 기반 포즈 및 비전 기반 포즈가 개별적으로 추적된다(310).

[0036] 모바일 디바이스를 이동시키기 위한 명령들은, 확장 칼만 필터들 또는 다른 알고리즘들로부터의 에러 공분산으로부터 유도될 수 있는 각각의 포즈 추정치의 신뢰도에 기초하여 생성된다. 예를 들면, Z 축을 중심으로 한 회전을 측정하는 자이로스코프에 의해 생성된 포즈에 대한 신뢰도가 낮다면, 신뢰도에 대한 임계값이 도달될 때까지 기준 타겟의 이미지들을 계속해서 캡처하면서, 사용자는 Z 축을 중심으로 모바일 디바이스를 회전시키도록 지시받을 수 있다. 신뢰도 임계치는, 추정치들의 신뢰도를 증가시키기 위한 특정 모션들을 취하도록 사용자를 장려가 위해 디스플레이된 그래픽들의 변화들 또는 스코어에 관련하여 표현될 수 있다. 스코어 및/또는 도전과제들을 사용자에게 제공하는 것은, 게임에서 사용자의 스코어를 증가시키거나 도전과제를 마무리 짓기 위해 플레이하는 게임 플레이어의 일반적인 작동을 레버리지(leverage)한다. 교정 파라미터들 중 하나의 교정이 완료될 때마다, 즉, 신뢰도 레벨이 임계치를 넘어 증가할 때마다, 사용자는 포인트들을 수여받는다. 사용자가 완료하는데 걸리는 시간이 또한 스코어에 포함될 수 있다. 따라서, 사용자들은 교정 프로세스에 대한 입력 데이터를 제공하기 위해 모바일 디바이스를 조작하도록 장려된다. 따라서, 모바일 디바이스와의 사용자 상호 작용이 교정에 사용될 수 있고, 이로써, 관성 센서들의 값비싼 팩토리 교정에 대한 필요성을 제거한다.

[0037] 도 8은, 비전 기반 포즈 및 센서 기반포즈를 결정하고, 시각화 애플리케이션에서 비전 기반 그래픽 및 센서 기반 그래픽을 별개로 사용할 수 있는 모바일 디바이스(100)의 블록도이다. 모바일 디바이스(100)는, 가속도계들, 자이로스코프들 등과 같은 관성 센서들(110)뿐만 아니라 카메라(108)를 포함한다. 모바일 디바이스(100)는, 디스플레이(102)뿐만 아니라 키패드(152) 또는 사용자가 모바일 디바이스(100)에 정보를 입력할 수 있는 다른 입력 디바이스를 포함하는 사용자 인터페이스(150)를 더 포함한다. 원한다면, 키패드(152)는, 터치 센서(또는 제스처 제어부)를 갖는 디스플레이(102)에 가상 키패드를 통합함으로써 제거될 수 있다. 사용자 인터페이스(150)는, 예를 들어, 모바일 디바이스(100)가 셀룰러 텔레폰 등인 경우 스피커(104) 및 마이크로폰(106)을 또한 포함할 수 있다. 물론, 모바일 디바이스(100)는 본 발명에 관련되지 않은 다른 엘리먼트들을 포함할 수 있다.

[0038] 모바일 디바이스(100)는, 디스플레이(102)를 비롯해서, 카메라(108) 및 관성 센서들(110)뿐만 아니라 사용자 인터페이스(150)에 접속되고 그들과 통신하는 제어 유닛(105)을 또한 포함한다. 제어 유닛(105)은, 버스(105b), 프로세서(105p) 및 연관된 메모리(105m), 하드웨어(105h), 펌웨어(105f) 및 소프트웨어(105s)에 의해 제공될 수 있다. 제어 유닛(105)은, 앞서 논의된 바와 같이, 카메라에 의해 캡처된 이미지들뿐만 아니라 관성 센서들(110)로부터 획득된 데이터를 수신 및 프로세싱한다. 제어 유닛(105)은 또한, 컴퓨터 비전 기술들을 사용하여 비전 기반 포즈를 생성하기 위해 카메라(108)에 의해 캡처된 이미지들을 사용하는 비전 포즈 모듈(112)을 포함하는 것으로 예시된다. 모바일 디바이스(100)는, 센서 기반 포즈를 생성하기 위해 관성 센서들(110)의 출력을 사용하는 INS(114)를 더 포함한다. 렌더링 모듈(116)은 비전 기반 그래픽 및 센서 기반 그래픽 및 사용자에게 제공될 임의의 다른 그래픽 데이터를 생성하고, 이는 디스플레이(102) 상에 도시된다. 부가적으로, 시각화 애플리케이션 모듈(118)은 비전 기반 포즈 및 센서 기반 포즈를 사용하고, 렌더링 모듈(116)로부터의 그래픽들이 디스플레이되게 한다. 예를 들면, 시각화 애플리케이션 모듈(118)은, 앞서 논의된 바와 같이, 비전 기반 포즈 및 센서 기반 포즈에 기초하여 관성 센서들(110)을 교정하는 교정 모듈일 수 있거나, 대안적으로 사진 애플리케이션과 같이 모션 기반 게임 또는 다른 적절한 타입의 애플리케이션일 수 있다. 결합된 비전 기반 포즈 및 센서 기반 포즈에 기초하여 모바일 디바이스의 포즈를 결정하거나, 그렇지 않다면 캡처된 이미지들 및 관성 센서 데이터에 기초하여 포즈를 결정하기 위한 하이브리드 포즈 모듈(119)이 포함될 수 있다.

[0039] 비전 포즈 모듈(112), INS(114), 렌더링 모듈(116), 시각화 애플리케이션 모듈(118) 및 하이브리드 포즈 모듈(119)은, 명확화를 위해 프로세서(105p)로부터 별개로 예시되지만, 프로세서(105p)의 일부이거나 프로세서(105p)에서 실행되는 소프트웨어(105s)에서의 명령들에 기초하여 프로세서로 구현될 수 있다. 본원에 사용된 바와 같이, 프로세서(105p)가 하나 이상의 마이크로프로세서들, 임베딩(embed)된 프로세서들, 제어기들, 주문형 집적 회로(ASIC)들, 디지털 신호 프로세서(DSP)들 등을 포함할 수 있지만 반드시 포함할 필요는 없음이 이해될 것이다. 용어 프로세서는, 특정한 하드웨어보다는 시스템에 의해 구현되는 기능들을 설명하도록 의도된다. 또한, 본원에 사용된 바와 같이, 용어 "메모리"는 장기, 단기, 또는 모바일 디바이스와 연관된 다른 메모리를 포함하는 임의의 타입의 컴퓨터 저장 매체를 지칭하며, 임의의 특정한 타입의 메모리 또는 메모리들의 수, 또는 메모리가 저장되는 매체들의 타입에 제한되지 않는다.

[0040] 본원에 설명된 방법들은, 애플리케이션에 의존하여 다양한 수단에 의해 구현될 수 있다. 예를 들어, 이들 방법들은 하드웨어(105h), 펌웨어(105f), 소프트웨어(105s) 또는 이들의 임의의 결합으로 구현될 수 있다. 하드웨어 구현에 대해, 프로세싱 유닛들은, 하나 이상의 주문형 집적 회로(ASIC)들, 디지털 신호 프로세서(DSP)들, 디지털 신호 프로세싱 디바이스(DSPD)들, 프로그래밍가능 로직 디바이스(PLD)들, 필드 프로그래밍가능 게이트 어레이(FPGA)들, 프로세서들, 제어기들, 마이크로-제어기들, 마이크로프로세서들, 전자 디바이스들, 본 명세서에 설명된 기능들을 수행하도록 설계된 다른 전자 유닛들, 또는 이들의 결합 내에 구현될 수 있다.

[0041] 펌웨어 및/또는 소프트웨어 구현에 대해, 방법들은 본원에 설명된 기능들을 수행하는 모듈들(예를 들어, 절차들, 함수들 등)을 이용하여 구현될 수 있다. 명령들을 유형으로 구현하는 임의의 머신-판독가능 매체는, 본원에 설명된 방법들을 구현할 시에 사용될 수 있다. 예를 들어, 소프트웨어 코드들은 메모리(105m)에 저장되고 프로세서(105p)에 의해 실행될 수 있다. 메모리(105m)는 프로세서(105p)의 내부 또는 외부에 구현될 수 있다. 펌웨어 및/또는 소프트웨어로 구현되면, 기능들은 컴퓨터-판독 가능한 저장 매체 상에 하나 이상의 명령들 또는 코드로서 저장될 수 있고, 여기서 저장 매체는 일시적인 전파 신호들을 포함하지 않는다. 예들은, 데이터 구조로 인코딩된 저장 매체들 및 컴퓨터 프로그램으로 인코딩된 저장부를 포함한다. 저장 매체들은 물리적 컴퓨터 저장 매체들을 포함한다. 저장 매체는 컴퓨터에 의해 액세스될 수 있는 임의의 이용가능한 매체일 수 있다. 제한이 아닌 예로서, 그러한 저장 매체들은 RAM, ROM, EEPROM, CD-ROM 또는 다른 광학 디스크 저장부, 자기 디스크 저장 또는 다른 자기 저장 디바이스들, 또는 명령들 또는 데이터 구조들의 형태로 원하는 프로그램 코드를 저장하는데 사용될 수 있고 컴퓨터에 의해 액세스될 수 있는 임의의 다른 매체를 포함할 수 있고, 본원에 사용된 바와 같이, 디스크(disk) 및 디스크(disc)는 컴팩트 디스크(disc)(CD), 레이저 디스크(disc), 광학 디스크(disc), DVD(digital versatile disc), 플로피 디스크(disk) 및 블루-레이 디스크(disc)를 포함하며, 여기서, 디스크(disk)들은 일반적으로 데이터를 자기적으로 재생하지만, 디스크(disc)들은 레이저들을 이용하여 광학적으로 데이터를 재생한다. 상기의 결합들이 또한 저장 매체들의 범위 내에 포함되어야 한다.

[0042] 따라서, 모바일 디바이스(100)는 캡처된 이미지들을 사용하여 모바일 디바이스의 비전 기반 포즈를 결정하기 위한 수단을 포함하고, 모바일 디바이스는, 예를 들면, 카메라(108)뿐만 아니라 비전 포즈 모듈(112)을 포함할 수 있다. 관성 센서들을 사용하여 모바일 디바이스의 센서 기반 포즈를 결정하기 위한 수단은, 예를 들면, 관성 센서들(110) 및 INS(114)를 포함할 수 있다. 시각화 애플리케이션에서 비전 기반 포즈 및 센서 기반 포즈를 별개로 사용하기 위한 수단은, 예를 들면, 교정 모듈, 모션 기반 게임 또는 사진 애플리케이션일 수 있는, 예를 들면, 시각화 애플리케이션 모듈(118)을 포함할 수 있다. 캡처된 이미지들 및 관성 센서들을 사용하여 모바일 디바이스의 하이브리드 기반 포즈를 결정하기 위한 수단은, 비전 기반 포즈 및 센서 기반 포즈를 결합하거나 그렇지 않다면 캡처된 이미지들 및 관성 센서 데이터에 기초하여 포즈를 결정할 수 있는 하이브리드 포즈 모듈(119)일 수 있다.

[0043] 본 발명이 설명의 목적들을 위해 특정한 실시예들과 관련하여 예시되지만, 본 발명은 그들에 제한되지 않는다. 다양한 적응들 및 변형들이 본 발명의 범위를 벗어나지 않으면서 행해질 수 있다. 따라서, 첨부된 청구항들의 사상 및 범위가 이전의 설명으로 제한되어서는 안된다.

Claims (27)

- 방법으로서,

캡처된 이미지들을 사용하여 모바일 디바이스의 비전 기반 포즈를 결정하는 단계,

관성 센서들을 사용하여 상기 모바일 디바이스의 센서 기반 포즈를 결정하는 단계, 및

시각화 애플리케이션에서 상기 비전 기반 포즈 및 상기 센서 기반 포즈를 별개로 사용하는 단계를 포함하는,

방법. - 제 1 항에 있어서,

상기 캡처된 이미지들 및 상기 관성 센서들을 사용하여 상기 모바일 디바이스의 하이브리드 기반 포즈를 결정하는 단계 및 상기 시각화 애플리케이션에서 상기 하이브리드 기반 포즈를 사용하는 단계를 더 포함하는,

방법. - 제 1 항에 있어서,

상기 시각화 애플리케이션에서 상기 비전 기반 포즈 및 상기 센서 기반 포즈를 별개로 사용하는 단계는, 상기 비전 기반 포즈에 기초한 제 1 그래픽 및 상기 센서 기반 포즈에 기초한 제 2 그래픽을 디스플레이하는 단계를 포함하는,

방법. - 제 3 항에 있어서,

상기 시각화 애플리케이션에서 상기 비전 기반 포즈 및 상기 센서 기반 포즈를 별개로 사용하는 단계는 단일 증강 캐릭터(augumentation character)를 렌더링하는 단계를 포함하고,

상기 제 1 그래픽은 상기 단일 증강 캐릭터에 대한 제 1 컬러 채널이고,

상기 제 2 그래픽은 상기 단일 증강 캐릭터에 대한 제 2 컬러 채널인,

방법. - 제 3 항에 있어서,

상기 시각화 애플리케이션에서 상기 비전 기반 포즈 및 상기 센서 기반 포즈를 별개로 사용하는 단계는 상기 캡처된 이미지들을 사용하여 상기 관성 센서들의 교정(calibration)을 수행하는 단계를 포함하고,

상기 제 1 그래픽 및 상기 제 2 그래픽은 상기 관성 센서들의 교정에 기초하여 렌더링되는,

방법. - 제 5 항에 있어서,

상기 제 1 그래픽 및 상기 제 2 그래픽은 상기 관성 센서들의 교정 품질에 기초하여 렌더링되고,

상기 관성 센서들의 교정 품질은, 교정 정확성, 교정 파라미터의 신뢰도, 에러 공분산(covariance) 및 상기 에러 공분산의 편차로 구성된 그룹으로부터 선택되는,

방법. - 제 5 항에 있어서,

상기 시각화 애플리케이션에서 상기 비전 기반 포즈 및 상기 센서 기반 포즈를 별개로 사용하는 단계는,

상기 제 1 그래픽 및 상기 제 2 그래픽을 통해 상기 모바일 디바이스를 특정 방향으로 이동시키도록 사용자를 유도하는 단계를 포함하고,

상기 특정 방향으로의 상기 모바일 디바이스의 이동은 상기 관성 센서들의 교정의 수렴(convergence)을 가속화하는,

방법. - 제 1 항에 있어서,

상기 시각화 애플리케이션은, 상기 모바일 디바이스에 대한 모션 기반 게임 및 상기 비전 기반 포즈 및 상기 센서 기반 포즈에 기초하여 그래픽들을 상기 모바일 디바이스 상에 디스플레이하는 사진 애플리케이션 중 하나인,

방법. - 모바일 디바이스로서,

환경의 이미지들을 캡처하는 카메라,

상기 모바일 디바이스의 이동에 응답하는 데이터를 생성하는 관성 센서들,

디스플레이, 및

상기 디스플레이에 연결되고, 상기 환경의 캡처된 이미지들을 수신하기 위해 상기 카메라에 연결되고, 상기 모바일 디바이스의 이동에 응답하는 상기 데이터를 수신하기 위해 상기 관성 센서들에 연결된 프로세서를 포함하고,

상기 프로세서는 상기 캡처된 이미지들을 사용하여 상기 모바일 디바이스의 비전 기반 포즈를 결정하고, 상기 관성 센서들로부터의 데이터를 사용하여 상기 모바일 디바이스의 센서 기반 포즈를 결정하고, 상기 디스플레이로 하여금 상기 비전 기반 포즈에 기초한 제 1 그래픽을 도시하게 하고 상기 센서 기반 포즈에 기초한 제 2 그래픽을 도시하게 하도록 구성되는,

모바일 디바이스. - 제 9 항에 있어서,

상기 프로세서는, 상기 캡처된 이미지들 및 상기 관성 센서들을 사용하여 상기 모바일 디바이스의 하이브리드 기반 포즈를 결정하고, 상기 디스플레이로 하여금 상기 하이브리드 기반 포즈에 기초한 제 3 그래픽을 도시하게 하도록 추가로 구성되는,

모바일 디바이스. - 제 9 항에 있어서,

상기 프로세서는, 상기 디스플레이로 하여금 단일 증강 캐릭터를 도시하게 함으로써, 상기 디스플레이로 하여금, 상기 비전 기반 포즈에 기초한 제 1 그래픽을 도시하게 하고 상기 센서 기반 포즈에 기초한 제 2 그래픽을 도시하게 하도록 구성되고,

상기 제 1 그래픽은 상기 단일 증강 캐릭터의 제 1 컬러 채널이고,

상기 제 2 그래픽은 상기 단일 증강 캐릭터의 제 2 컬러 채널인,

모바일 디바이스. - 제 9 항에 있어서,

상기 프로세서는 상기 비전 기반 포즈 및 상기 센서 기반 포즈를 사용하여 상기 관성 센서들을 교정하도록 추가로 구성되고,

상기 프로세서는, 상기 디스플레이로 하여금 상기 관성 센서들의 교정에 기초하여 상기 제 1 그래픽 및 상기 제 2 그래픽을 도시하게 하도록 구성되는,

모바일 디바이스. - 제 12 항에 있어서,

상기 프로세서는 상기 관성 센서들의 교정 품질에 기초하여 상기 제 1 그래픽 및 상기 제 2 그래픽을 렌더링하도록 구성되고,

상기 관성 센서들의 교정 품질은, 교정 정확성, 교정 파라미터의 신뢰도, 에러 공분산 및 상기 에러 공분산의 편차로 구성된 그룹으로부터 선택되는,

모바일 디바이스. - 제 12 항에 있어서,

상기 프로세서는 상기 제 1 그래픽 및 상기 제 2 그래픽을 통해 상기 모바일 디바이스를 특정 방향으로 이동시키도록 사용자를 유도하도록 추가로 구성되고,

상기 특정 방향으로의 상기 모바일 디바이스의 이동은 상기 관성 센서들의 교정의 수렴을 가속화하는,

모바일 디바이스. - 제 9 항에 있어서,

상기 프로세서는, 상기 디스플레이로 하여금, 상기 모바일 디바이스에 대한 모션 기반 게임 및 사진 애플리케이션 중 하나에 응답하여 상기 제 1 그래픽 및 상기 제 2 그래픽을 도시하게 하도록 구성되는,

모바일 디바이스. - 모바일 디바이스로서,

캡처된 이미지들을 사용하여 상기 모바일 디바이스의 비전 기반 포즈를 결정하기 위한 수단,

관성 센서들을 사용하여 상기 모바일 디바이스의 센서 기반 포즈를 결정하기 위한 수단, 및

시각화 애플리케이션에서 상기 비전 기반 포즈 및 상기 센서 기반 포즈를 별개로 사용하기 위한 수단을 포함하는,

모바일 디바이스. - 제 16 항에 있어서,

상기 모바일 디바이스는 상기 캡처된 이미지들 및 상기 관성 센서들을 사용하여 상기 모바일 디바이스의 하이브리드 기반 포즈를 결정하기 위한 수단을 더 포함하고,

상기 시각화 애플리케이션에서 상기 비전 기반 포즈 및 상기 센서 기반 포즈를 별개로 사용하기 위한 수단은 상기 하이브리드 기반 포즈를 추가로 사용하는,

모바일 디바이스. - 제 16 항에 있어서,

상기 시각화 애플리케이션에서 상기 비전 기반 포즈 및 상기 센서 기반 포즈를 별개로 사용하기 위한 수단은 상기 비전 기반 포즈에 기초한 제 1 그래픽 및 상기 센서 기반 포즈에 기초한 제 2 그래픽을 디스플레이하는,

모바일 디바이스. - 제 18 항에 있어서,

상기 시각화 애플리케이션에서 상기 비전 기반 포즈 및 상기 센서 기반 포즈를 별개로 사용하기 위한 수단은 단일 증강 캐릭터를 렌더링하고,

상기 제 1 그래픽은 상기 단일 증강 캐릭터에 대한 제 1 컬러 채널이고,

상기 제 2 그래픽은 상기 단일 증강 캐릭터에 대한 제 2 컬러 채널인,

모바일 디바이스. - 제 18 항에 있어서,

상기 시각화 애플리케이션에서 상기 비전 기반 포즈 및 상기 센서 기반 포즈를 별개로 사용하기 위한 수단은 상기 캡처된 이미지들을 사용하여 상기 관성 센서들의 교정을 수행하고,

상기 제 1 그래픽 및 상기 제 2 그래픽은 상기 관성 센서들의 교정에 기초하여 렌더링되는,

모바일 디바이스. - 제 20 항에 있어서,

상기 시각화 애플리케이션에서 상기 비전 기반 포즈 및 상기 센서 기반 포즈를 별개로 사용하기 위한 수단은 상기 제 1 그래픽 및 상기 제 2 그래픽을 통해 상기 모바일 디바이스를 특정 방향으로 이동시키도록 사용자를 유도하고,

상기 특정 방향으로의 상기 모바일 디바이스의 이동은 상기 관성 센서들의 교정의 수렴을 가속화하는,

모바일 디바이스. - 제 16 항에 있어서,

상기 시각화 애플리케이션은 모션 기반 게임 및 사진 애플리케이션 중 하나인,

모바일 디바이스. - 프로그램 코드가 저장되어 있는 저장 매체로서,

캡처된 이미지들을 사용하여 모바일 디바이스의 비전 기반 포즈를 결정하기 위한 프로그램 코드,

관성 센서들을 사용하여 상기 모바일 디바이스의 센서 기반 포즈를 결정하기 위한 프로그램 코드, 및

시각화 애플리케이션에서 상기 비전 기반 포즈 및 상기 센서 기반 포즈를 별개로 사용하기 위한 프로그램 코드를 포함하는,

저장 매체. - 제 23 항에 있어서,

상기 시각화 애플리케이션에서 상기 비전 기반 포즈 및 상기 센서 기반 포즈를 별개로 사용하기 위한 프로그램 코드는, 상기 비전 기반 포즈에 기초한 제 1 그래픽 및 상기 센서 기반 포즈에 기초한 제 2 그래픽을 디스플레이하기 위한 프로그램 코드를 포함하는,

저장 매체. - 제 24 항에 있어서,

상기 시각화 애플리케이션에서 상기 비전 기반 포즈 및 상기 센서 기반 포즈를 별개로 사용하기 위한 프로그램 코드는, 상기 캡처된 이미지들을 사용하여 상기 관성 센서들의 교정을 수행하기 위한 프로그램 코드를 포함하고,

상기 제 1 그래픽 및 상기 제 2 그래픽은 상기 관성 센서들의 교정에 기초하여 렌더링되는,

저장 매체. - 제 25 항에 있어서,

상기 시각화 애플리케이션에서 상기 비전 기반 포즈 및 상기 센서 기반 포즈를 별개로 사용하기 위한 프로그램 코드는,

상기 제 1 그래픽 및 상기 제 2 그래픽을 통해 상기 모바일 디바이스를 특정 방향으로 이동시키도록 사용자를 유도하기 위한 프로그램 코드를 포함하고,

상기 특정 방향으로의 상기 모바일 디바이스의 이동은 상기 관성 센서들의 교정의 수렴을 가속화하는,

저장 매체. - 제 23 항에 있어서,

상기 시각화 애플리케이션은, 상기 모바일 디바이스에 대한 모션 기반 게임, 및 상기 비전 기반 포즈 및 상기 센서 기반 포즈에 기초한 그래픽들을 상기 모바일 디바이스 상에 디스플레이하는 사진 애플리케이션 중 하나인,

저장 매체.

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US13/725,175 US10444845B2 (en) | 2012-12-21 | 2012-12-21 | Display of separate computer vision based pose and inertial sensor based pose |

| US13/725,175 | 2012-12-21 | ||

| PCT/US2013/073511 WO2014099410A1 (en) | 2012-12-21 | 2013-12-06 | Display of separate computer vision based pose and inertial sensor based pose |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| KR20150099570A true KR20150099570A (ko) | 2015-08-31 |

Family

ID=49817312

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020157019314A KR20150099570A (ko) | 2012-12-21 | 2013-12-06 | 별개의 컴퓨터 비전 기반 포즈 및 관성 센서 기반 포즈의 디스플레이 |

Country Status (8)

| Country | Link |

|---|---|

| US (1) | US10444845B2 (ko) |

| EP (1) | EP2936060B1 (ko) |

| JP (1) | JP6285955B2 (ko) |

| KR (1) | KR20150099570A (ko) |

| CN (1) | CN104870941B (ko) |

| BR (1) | BR112015015073A2 (ko) |

| TW (2) | TWI593289B (ko) |

| WO (1) | WO2014099410A1 (ko) |

Families Citing this family (20)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US9292936B2 (en) * | 2013-01-09 | 2016-03-22 | Omiimii Ltd. | Method and apparatus for determining location |

| DE102015203968A1 (de) * | 2014-12-12 | 2016-06-16 | Robert Bosch Gmbh | Vorrichtung zum Abgleich und Selbsttest von Inertialsensoren und Verfahren |

| US9594980B1 (en) * | 2015-01-19 | 2017-03-14 | Ricoh Co., Ltd. | Image acquisition user interface for linear panoramic image stitching |

| JP6565465B2 (ja) | 2015-08-12 | 2019-08-28 | セイコーエプソン株式会社 | 画像表示装置、コンピュータープログラム、および画像表示システム |

| CN107923740B (zh) * | 2015-09-09 | 2020-08-11 | 索尼公司 | 传感器设备、传感器系统以及信息处理设备 |

| US10104282B2 (en) * | 2015-09-30 | 2018-10-16 | Ricoh Co., Ltd. | Yaw user interface |

| US10073531B2 (en) * | 2015-10-07 | 2018-09-11 | Google Llc | Electronic device pose identification based on imagery and non-image sensor data |

| CN105719299A (zh) * | 2016-01-22 | 2016-06-29 | 吉林大学 | 分离的计算机视觉位置及方向与惯性传感器位置及方向的显示 |

| US10078377B2 (en) | 2016-06-09 | 2018-09-18 | Microsoft Technology Licensing, Llc | Six DOF mixed reality input by fusing inertial handheld controller with hand tracking |

| JP2017224984A (ja) * | 2016-06-15 | 2017-12-21 | セイコーエプソン株式会社 | プログラム、装置、キャリブレーション方法 |

| DE102016211244B4 (de) * | 2016-06-23 | 2018-01-18 | Kuka Roboter Gmbh | Roboter-Bedienhandgerätverbund mit einem Grundsteuerungs-Lagesensor |

| JP2018009836A (ja) | 2016-07-12 | 2018-01-18 | セイコーエプソン株式会社 | プログラム、頭部装着型表示装置、キャリブレーション方法 |

| CN112184829A (zh) * | 2016-08-29 | 2021-01-05 | 华为技术有限公司 | 一种调整扫描状态的方法及装置 |

| US11112932B2 (en) * | 2017-04-27 | 2021-09-07 | Magic Leap, Inc. | Light-emitting user input device |

| US10365710B2 (en) * | 2017-06-23 | 2019-07-30 | Seiko Epson Corporation | Head-mounted display device configured to display a visual element at a location derived from sensor data and perform calibration |

| US10970425B2 (en) * | 2017-12-26 | 2021-04-06 | Seiko Epson Corporation | Object detection and tracking |

| GB2573271B (en) * | 2018-03-27 | 2022-04-06 | Displaylink Uk Ltd | Data transmission to mobile devices |

| CN111829552B (zh) * | 2019-04-19 | 2023-01-06 | 北京魔门塔科技有限公司 | 一种视觉惯性系统的误差修正方法和装置 |

| CN111027438B (zh) * | 2019-12-03 | 2023-06-02 | Oppo广东移动通信有限公司 | 一种人体姿态的迁移方法、移动终端以及计算机存储介质 |

| CN112362084A (zh) * | 2020-11-23 | 2021-02-12 | 北京三快在线科技有限公司 | 一种数据标定方法、装置及数据标定系统 |

Family Cites Families (25)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US7554578B2 (en) | 2000-07-11 | 2009-06-30 | Phase One A/S | Digital camera with integrated accelerometers |

| JP4007899B2 (ja) | 2002-11-07 | 2007-11-14 | オリンパス株式会社 | 運動検出装置 |

| DE10318500A1 (de) | 2003-04-24 | 2004-11-25 | Robert Bosch Gmbh | Vorrichtung und Verfahren zur Kalibrierung eines Bildsensors |

| JP4532856B2 (ja) | 2003-07-08 | 2010-08-25 | キヤノン株式会社 | 位置姿勢計測方法及び装置 |

| JP2005050189A (ja) | 2003-07-30 | 2005-02-24 | Canon Inc | 画像処理装置およびその方法並びにプログラムコード、記憶媒体 |

| JP4726194B2 (ja) | 2005-04-01 | 2011-07-20 | キヤノン株式会社 | キャリブレーション方法及び装置 |

| TWI348639B (en) | 2005-12-16 | 2011-09-11 | Ind Tech Res Inst | Motion recognition system and method for controlling electronic device |

| TWI341692B (en) | 2005-12-26 | 2011-05-01 | Ind Tech Res Inst | Online interactive multimedia system and the trasnsmission method thereof |

| TWI333156B (en) | 2007-08-16 | 2010-11-11 | Ind Tech Res Inst | Inertia sensing input controller and receiver and interactive system using thereof |

| US8255161B2 (en) | 2008-10-03 | 2012-08-28 | Honeywell International Inc. | System and method of auto-calibration of inertial sensors |

| KR101556150B1 (ko) * | 2008-12-31 | 2015-09-30 | 엘지전자 주식회사 | 드럼세탁기 |

| KR101557678B1 (ko) | 2009-04-22 | 2015-10-19 | 삼성전자주식회사 | 휴대 단말기의 캘리브레이션 방법 및 장치 |

| US8945720B2 (en) * | 2009-08-06 | 2015-02-03 | National Oilwell Varco, L.P. | Hard composite with deformable constituent and method of applying to earth-engaging tool |

| JP5448073B2 (ja) | 2010-01-12 | 2014-03-19 | 任天堂株式会社 | 情報処理装置、情報処理プログラム、情報処理システム、および、選択対象の選択方法 |

| US8855929B2 (en) | 2010-01-18 | 2014-10-07 | Qualcomm Incorporated | Using object to align and calibrate inertial navigation system |

| JP5564300B2 (ja) | 2010-03-19 | 2014-07-30 | 富士フイルム株式会社 | ヘッドマウント型拡張現実映像提示装置及びその仮想表示物操作方法 |

| US8694051B2 (en) | 2010-05-07 | 2014-04-08 | Qualcomm Incorporated | Orientation sensor calibration |

| US9052202B2 (en) | 2010-06-10 | 2015-06-09 | Qualcomm Incorporated | Use of inertial sensor data to improve mobile station positioning |

| JP5570316B2 (ja) | 2010-06-17 | 2014-08-13 | キヤノン株式会社 | 撮像装置、その制御方法及びプログラム |

| US8705909B2 (en) * | 2010-07-16 | 2014-04-22 | Ibiden Co., Ltd. | Optical interconnect |

| US9341720B2 (en) | 2011-01-11 | 2016-05-17 | Qualcomm Incorporated | Camera-based position location and navigation based on image processing |

| EP2487458A3 (en) * | 2011-02-11 | 2014-11-26 | BlackBerry Limited | System and method for calibrating a magnetometer with visual affordance |

| US8912970B1 (en) * | 2011-03-18 | 2014-12-16 | The Boeing Company | Antenna element with integral faraday cage |

| US8912979B1 (en) * | 2011-07-14 | 2014-12-16 | Google Inc. | Virtual window in head-mounted display |

| US9270885B2 (en) | 2012-10-26 | 2016-02-23 | Google Inc. | Method, system, and computer program product for gamifying the process of obtaining panoramic images |

-

2012

- 2012-12-21 US US13/725,175 patent/US10444845B2/en active Active

-

2013

- 2013-12-06 KR KR1020157019314A patent/KR20150099570A/ko active IP Right Grant

- 2013-12-06 BR BR112015015073A patent/BR112015015073A2/pt not_active Application Discontinuation

- 2013-12-06 CN CN201380066422.2A patent/CN104870941B/zh active Active

- 2013-12-06 WO PCT/US2013/073511 patent/WO2014099410A1/en active Application Filing

- 2013-12-06 EP EP13811098.6A patent/EP2936060B1/en active Active

- 2013-12-06 JP JP2015549442A patent/JP6285955B2/ja active Active

- 2013-12-20 TW TW105112885A patent/TWI593289B/zh not_active IP Right Cessation

- 2013-12-20 TW TW102147644A patent/TWI552596B/zh active

Also Published As

| Publication number | Publication date |

|---|---|

| TW201630405A (zh) | 2016-08-16 |

| US20140176418A1 (en) | 2014-06-26 |

| CN104870941A (zh) | 2015-08-26 |

| CN104870941B (zh) | 2019-07-19 |

| JP2016502210A (ja) | 2016-01-21 |

| BR112015015073A2 (pt) | 2017-07-11 |

| US10444845B2 (en) | 2019-10-15 |

| WO2014099410A1 (en) | 2014-06-26 |

| EP2936060B1 (en) | 2023-10-11 |

| JP6285955B2 (ja) | 2018-02-28 |

| TWI593289B (zh) | 2017-07-21 |

| EP2936060A1 (en) | 2015-10-28 |

| EP2936060C0 (en) | 2023-10-11 |

| TW201434315A (zh) | 2014-09-01 |

| TWI552596B (zh) | 2016-10-01 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| KR20150099570A (ko) | 별개의 컴퓨터 비전 기반 포즈 및 관성 센서 기반 포즈의 디스플레이 | |

| JP6043856B2 (ja) | Rgbdカメラを用いた頭部ポーズ推定 | |

| KR102131477B1 (ko) | 컴퓨터 비전 애플리케이션 초기화를 용이하게 하는 방법들 | |

| JP5660648B2 (ja) | マルチユーザ拡張現実におけるオンライン参照生成および追跡 | |

| JP6258953B2 (ja) | 単眼視覚slamのための高速初期化 | |

| US9674507B2 (en) | Monocular visual SLAM with general and panorama camera movements | |

| KR101554797B1 (ko) | 콘텍스트 인식 증강 상호작용 | |

| JP6456347B2 (ja) | 平面固有の特徴のターゲットのinsitu生成 | |

| US8933986B2 (en) | North centered orientation tracking in uninformed environments | |

| JP5774226B2 (ja) | 方位センサに基づくホモグラフィ分解の曖昧性の解決 | |

| US20120195461A1 (en) | Correlating areas on the physical object to areas on the phone screen | |

| US20230260232A1 (en) | 6-dof tracking using visual cues | |

| KR20130018677A (ko) | 화상 처리 장치, 화상 처리 방법 및 프로그램 | |

| KR102614102B1 (ko) | 실물 객체에 대한 정밀한 추적을 위한 자동화된 캘리브레이션 시스템, 캘리브레이션 방법 및 캘리브레이션 방법을 기초로 이미지 내에서 실물 객체를 추적하고 실물 객체에 가상 모델을 증강하는 방법 | |

| CN105719299A (zh) | 分离的计算机视觉位置及方向与惯性传感器位置及方向的显示 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| E902 | Notification of reason for refusal | ||

| E701 | Decision to grant or registration of patent right |