JP7658366B2 - サーバ装置、端末装置、情報処理システム及び情報処理方法 - Google Patents

サーバ装置、端末装置、情報処理システム及び情報処理方法 Download PDFInfo

- Publication number

- JP7658366B2 JP7658366B2 JP2022517647A JP2022517647A JP7658366B2 JP 7658366 B2 JP7658366 B2 JP 7658366B2 JP 2022517647 A JP2022517647 A JP 2022517647A JP 2022517647 A JP2022517647 A JP 2022517647A JP 7658366 B2 JP7658366 B2 JP 7658366B2

- Authority

- JP

- Japan

- Prior art keywords

- terminal device

- image

- virtual object

- common

- information

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

- G06F3/0481—Interaction techniques based on graphical user interfaces [GUI] based on specific properties of the displayed interaction object or a metaphor-based environment, e.g. interaction with desktop elements like windows or icons, or assisted by a cursor's changing behaviour or appearance

- G06F3/04815—Interaction with a metaphor-based environment or interaction object displayed as three-dimensional, e.g. changing the user viewpoint with respect to the environment or object

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/20—Input arrangements for video game devices

- A63F13/21—Input arrangements for video game devices characterised by their sensors, purposes or types

- A63F13/216—Input arrangements for video game devices characterised by their sensors, purposes or types using geographical information, e.g. location of the game device or player using GPS

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/30—Interconnection arrangements between game servers and game devices; Interconnection arrangements between game devices; Interconnection arrangements between game servers

- A63F13/35—Details of game servers

- A63F13/355—Performing operations on behalf of clients with restricted processing capabilities, e.g. servers transform changing game scene into an encoded video stream for transmitting to a mobile phone or a thin client

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/40—Processing input control signals of video game devices, e.g. signals generated by the player or derived from the environment

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/55—Controlling game characters or game objects based on the game progress

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/60—Generating or modifying game content before or while executing the game program, e.g. authoring tools specially adapted for game development or game-integrated level editor

- A63F13/65—Generating or modifying game content before or while executing the game program, e.g. authoring tools specially adapted for game development or game-integrated level editor automatically by game devices or servers from real world data, e.g. measurement in live racing competition

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F13/00—Interconnection of, or transfer of information or other signals between, memories, input/output devices or central processing units

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/033—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor

- G06F3/0346—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor with detection of the device orientation or free movement in a 3D space, e.g. 3D mice, 6-DOF [six degrees of freedom] pointers using gyroscopes, accelerometers or tilt-sensors

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T19/00—Manipulating 3D models or images for computer graphics

- G06T19/006—Mixed reality

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04W—WIRELESS COMMUNICATION NETWORKS

- H04W4/00—Services specially adapted for wireless communication networks; Facilities therefor

- H04W4/02—Services making use of location information

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2219/00—Indexing scheme for manipulating 3D models or images for computer graphics

- G06T2219/024—Multi-user, collaborative environment

Landscapes

- Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- General Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Human Computer Interaction (AREA)

- Software Systems (AREA)

- Computer Hardware Design (AREA)

- Computer Graphics (AREA)

- Environmental & Geological Engineering (AREA)

- Radar, Positioning & Navigation (AREA)

- Computer Networks & Wireless Communication (AREA)

- Signal Processing (AREA)

- Processing Or Creating Images (AREA)

Description

サーバ装置は、AR表示を実行可能な各端末装置のそれぞれの位置情報に基づいて所定の領域内に存在する端末装置をグループ化し、グループに含まれる前記端末装置に対して共通のAR画像を生成して送信する。

端末装置は、前記共通のAR画像を受信し、前記共通のAR画像に基づいてAR表示を実行する。

<情報処理システム100の概要>

図1は、本技術の第1実施形態に係る情報処理システム100を示す図である。図1に示すように、情報処理システム100は、サーバ装置10と、複数の端末装置20と、遮蔽オブジェクトデータベース30とを含む。

[サーバ装置10]

図2は、サーバ装置10の内部構成を示すブロック図である。図2に示すように、サーバ装置10は、制御部11、記憶部12及び通信部13を含む。

端末装置20は、例えば、ユーザの身体に装着可能なウェアラブルデバイスであってもよいし、ユーザが携帯可能なモバイルデバイスであってもよい。

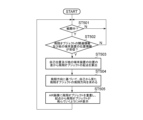

次に、情報処理システム100の処理について説明する。図4は、サーバ装置10の処理を示すフローチャートである。図5及び図6は、端末装置20の処理を示すフローチャートである。

まず、図5を参照して、端末装置20の自己位置推定処理について説明する。各端末装置20の制御部21は、自己位置及び姿勢を推定し(ステップ201)、推定された自己位置情報をサーバ装置10へと出力する(ステップ202)といった処理を所定の周期で繰り返し実行する。

次に、図4を参照して、サーバ装置10の制御部11の処理について説明する。サーバ装置10の制御部11は、まず、ゲーム製作者による入力に応じて、グローバル座標系においてポイント1を設定する(ステップ101)。図7は、グローバル座標系においてポイント1が設定されたときの様子を示す図である。

次に、端末装置20の処理について説明する。図6を参照して、端末装置20の制御部21は、まず、サーバ装置10から自己に対してグループで共通のAR画像が送信され、そのAR画像が受信されたかどうかを判定する(ステップ301)。なお、上述のように、グループ化領域2内に位置する端末装置20に対しては、サーバ装置10から共通のAR画像が送信される(ステップ104参照)。

次に、飛翔オブジェクト(第2の仮想オブジェクト)について説明する。図9は、飛翔オブジェクトを説明するための図である。

次に、情報送信側の端末装置20の処理について説明する。図10は、情報送信側の端末装置20の処理を示すフローチャートである。

次に、情報受信側の端末装置20の処理について説明する。図11は、情報受信側の端末装置20の処理を示すフローチャートである。図12は、情報受信側の端末装置20において、飛翔オブジェクトがどのように見えるかを示す図である。

次に、遮蔽オブジェクト6による敵の仮想オブジェクト5のAR遮蔽について説明する。ここで、遮蔽オブジェクト6は、各端末装置20からの相対的な位置が各端末装置20の位置毎に異なる実空間における実オブジェクトであって、敵の仮想オブジェクト5(第1の仮想オブジェクト)を遮蔽し得るオブジェクトである。この遮蔽オブジェクト6は、例えば、実空間における建物や壁等である。

(1)敵の仮想オブジェクト5のRGB(Red Green Blue)情報

(2)敵の仮想オブジェクト5のデプス情報

(3)遮蔽オブジェクト6のデプス情報(遮蔽オブジェクト6に関する遮蔽オブジェクト情報)

以上説明したように、本実施形態では、サーバ装置10は、各端末装置20のそれぞれの位置情報に基づいてグループ化領域2内に存在する端末装置20をグループ化し、グループに含まれる端末装置20に対して共通のAR画像を生成して送信する。

以上の説明では、本技術がゲームに適用される場合について説明した。一方、本技術は、ゲーム以外の用途にも用いることができる。典型的には、本技術は、複数人がある領域に集まる各種のイベント等であればどのような用途にも用いることができる。

(1)AR表示を実行可能な各端末装置のそれぞれの位置情報に基づいて所定の領域内に存在する端末装置をグループ化し、グループに含まれる前記端末装置に対して共通のAR画像を生成して送信する制御部

を具備するサーバ装置。

(2) 上記(1)に記載のサーバ装置であって、

前記制御部は、所定のポイントから第1の距離の領域内に存在する前記端末装置をグループ化する

サーバ装置。

(3) 上記(2)に記載のサーバ装置であって、

前記共通のAR画像は、前記端末装置におけるAR表示角よりも広角の画像である

サーバ装置。

(4) 上記(3)に記載のサーバ装置であって、

前記共通のAR画像は、前記ポイントを中心とした360度画像である

サーバ装置。

(5) 上記(2)~(4)のうちいずれか1つに記載のサーバ装置であって、

前記共通のAR画像は、前記ポイントから第2の距離以上第3の距離以下の領域内の画像である

サーバ装置。

(6) 上記(5)に記載のサーバ装置であって、

前記第2の距離は、第1の距離以上である

サーバ装置。

(7) 上記(1)~(6)のうちいずれか1つに記載のサーバ装置であって、

前記共通のAR画像は、第1の仮想オブジェクトを含み、

前記各端末装置は、それぞれ、前記各端末装置からの相対的なAR表示位置が各端末装置の位置毎に異なる第2の仮想オブジェクトのAR画像を個別に生成して、前記共通のAR画像に重畳する

サーバ装置。

(8) 上記(7)に記載のサーバ装置であって、

前記端末装置は、他の端末装置の位置情報を取得し、自己の位置情報及び他の端末装置の位置情報に基づいて、前記第2の仮想オブジェクトのAR表示位置を設定する

サーバ装置。

(9) 上記(8)に記載のサーバ装置であって、

前記第2の仮想オブジェクトは、移動可能なオブジェクトであり、

前記端末装置は、前記第2の仮想オブジェクトの移動速度を調整する

サーバ装置。

(10) 上記(1)~(9)のうちいずれか1つに記載のサーバ装置であって、

前記共通のAR画像は、第1の仮想オブジェクトを含み、

前記制御部は、前記各端末装置からの相対的な位置が前記各端末装置の位置毎に異なる実空間における実オブジェクトであって、前記第1の仮想オブジェクトを遮蔽し得る遮蔽オブジェクトに関する遮蔽オブジェクト情報を、前記各端末装置毎に個別にそれぞれ生成して前記各端末装置に送信する

サーバ装置。

(11) 上記(10)に記載のサーバ装置であって、

前記制御部は、前記端末装置の位置情報及び前記遮蔽オブジェクトの位置情報に基づいて前記遮蔽オブジェクト情報を生成する

サーバ装置。

(12) 上記(10)又は(11)に記載のサーバ装置であって、

前記端末装置は、前記遮蔽オブジェクト情報に基づいて、前記第1の仮想オブジェクトにおいて前記遮蔽オブジェクトに遮蔽されない部分について前記AR表示を実行する

サーバ装置。

(13) AR表示を実行可能な各端末装置のそれぞれの位置情報に基づいて所定の領域内に存在する端末装置をグループ化し、グループに含まれる前記端末装置に対して共通のAR画像を生成して送信するサーバ装置から、前記共通のAR画像を受信し、前記共通のAR画像に基づいてAR表示を実行する制御部

を具備する端末装置。

(14) AR表示を実行可能な各端末装置のそれぞれの位置情報に基づいて所定の領域内に存在する端末装置をグループ化し、グループに含まれる前記端末装置に対して共通のAR画像を生成して送信するサーバ装置と、

前記共通のAR画像を受信し、前記共通のAR画像に基づいてAR表示を実行する端末装置と

を具備する情報処理システム。

(15) AR表示を実行可能な各端末装置のそれぞれの位置情報に基づいて所定の領域内に存在する端末装置をグループ化し、グループに含まれる前記端末装置に対して共通のAR画像を生成して送信する

情報処理方法。

2…グループ化領域

5…敵の仮想オブジェクト

6…遮蔽オブジェクト

10…サーバ装置

20…端末装置

30…遮蔽オブジェクトデータベース

Claims (12)

- AR(Augmented Reality)表示を実行可能な各端末装置のそれぞれの位置情報に基づいて所定の領域内に存在する端末装置をグループ化し、グループに含まれる前記端末装置に対して共通のAR画像を生成して送信する制御部

を具備するサーバ装置であって、

前記共通のAR画像は、第1の仮想オブジェクトを含み、

前記各端末装置は、それぞれ、前記各端末装置からの相対的なAR表示位置が各端末装置の位置毎に異なる第2の仮想オブジェクトのAR画像を個別に生成して、前記共通のAR画像に重畳し、

前記端末装置は、他の端末装置の位置情報を取得し、自己の位置情報及び他の端末装置の位置情報に基づいて、前記第2の仮想オブジェクトのAR表示位置を設定し、

前記第2の仮想オブジェクトは、移動可能なオブジェクトであり、

前記端末装置は、前記第2の仮想オブジェクトの移動速度を調整する

サーバ装置。 - 請求項1に記載のサーバ装置であって、

前記制御部は、所定のポイントから第1の距離の領域内に存在する前記端末装置をグループ化する

サーバ装置。 - 請求項2に記載のサーバ装置であって、

前記共通のAR画像は、前記端末装置におけるAR表示角よりも広角の画像である

サーバ装置。 - 請求項3に記載のサーバ装置であって、

前記共通のAR画像は、前記ポイントを中心とした360度画像である

サーバ装置。 - 請求項2に記載のサーバ装置であって、

前記共通のAR画像は、前記ポイントから第2の距離以上第3の距離以下の領域内の画像である

サーバ装置。 - 請求項5に記載のサーバ装置であって、

前記第2の距離は、第1の距離以上である

サーバ装置。 - 請求項1に記載のサーバ装置であって、

前記制御部は、前記各端末装置からの相対的な位置が前記各端末装置の位置毎に異なる実空間における実オブジェクトであって、前記第1の仮想オブジェクトを遮蔽し得る遮蔽オブジェクトに関する遮蔽オブジェクト情報を、前記各端末装置毎に個別にそれぞれ生成して前記各端末装置に送信する

サーバ装置。 - 請求項7に記載のサーバ装置であって、

前記制御部は、前記端末装置の位置情報及び前記遮蔽オブジェクトの位置情報に基づいて前記遮蔽オブジェクト情報を生成する

サーバ装置。 - 請求項7に記載のサーバ装置であって、

前記端末装置は、前記遮蔽オブジェクト情報に基づいて、前記第1の仮想オブジェクトにおいて前記遮蔽オブジェクトに遮蔽されない部分について前記AR表示を実行する

サーバ装置。 - AR表示を実行可能な各端末装置のそれぞれの位置情報に基づいて所定の領域内に存在する端末装置をグループ化し、グループに含まれる前記端末装置に対して共通のAR画像を生成して送信するサーバ装置から、前記共通のAR画像を受信し、前記共通のAR画像に基づいてAR表示を実行する制御部

を具備する端末装置であって、

前記共通のAR画像は、第1の仮想オブジェクトを含み、

前記制御部は、前記各端末装置からの相対的なAR表示位置が各端末装置の位置毎に異なる第2の仮想オブジェクトのAR画像を生成して、前記共通のAR画像に重畳し、

前記制御部は、他の端末装置の位置情報を取得し、自己の位置情報及び他の端末装置の位置情報に基づいて、前記第2の仮想オブジェクトのAR表示位置を設定し、

前記第2の仮想オブジェクトは、移動可能なオブジェクトであり、

前記制御部は、前記第2の仮想オブジェクトの移動速度を調整する

端末装置。 - AR表示を実行可能な各端末装置のそれぞれの位置情報に基づいて所定の領域内に存在する端末装置をグループ化し、グループに含まれる前記端末装置に対して共通のAR画像を生成して送信するサーバ装置と、

前記共通のAR画像を受信し、前記共通のAR画像に基づいてAR表示を実行する端末装置と

を具備する情報処理システムであって、

前記共通のAR画像は、第1の仮想オブジェクトを含み、

前記各端末装置は、それぞれ、前記各端末装置からの相対的なAR表示位置が各端末装置の位置毎に異なる第2の仮想オブジェクトのAR画像を個別に生成して、前記共通のAR画像に重畳し、

前記端末装置は、他の端末装置の位置情報を取得し、自己の位置情報及び他の端末装置の位置情報に基づいて、前記第2の仮想オブジェクトのAR表示位置を設定し、

前記第2の仮想オブジェクトは、移動可能なオブジェクトであり、

前記端末装置は、前記第2の仮想オブジェクトの移動速度を調整する

情報処理システム。 - AR表示を実行可能な各端末装置のそれぞれの位置情報に基づいて所定の領域内に存在する端末装置をグループ化し、グループに含まれる前記端末装置に対して共通のAR画像を生成して送信する

情報処理方法であって、

前記共通のAR画像は、第1の仮想オブジェクトを含み、

前記各端末装置は、それぞれ、前記各端末装置からの相対的なAR表示位置が各端末装置の位置毎に異なる第2の仮想オブジェクトのAR画像を個別に生成して、前記共通のAR画像に重畳し、

前記端末装置は、他の端末装置の位置情報を取得し、自己の位置情報及び他の端末装置の位置情報に基づいて、前記第2の仮想オブジェクトのAR表示位置を設定し、

前記第2の仮想オブジェクトは、移動可能なオブジェクトであり、

前記端末装置は、前記第2の仮想オブジェクトの移動速度を調整する

情報処理方法。

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2020081563 | 2020-05-01 | ||

| JP2020081563 | 2020-05-01 | ||

| PCT/JP2021/015892 WO2021220866A1 (ja) | 2020-05-01 | 2021-04-19 | サーバ装置、端末装置、情報処理システム及び情報処理方法 |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JPWO2021220866A1 JPWO2021220866A1 (ja) | 2021-11-04 |

| JP7658366B2 true JP7658366B2 (ja) | 2025-04-08 |

Family

ID=78374099

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2022517647A Active JP7658366B2 (ja) | 2020-05-01 | 2021-04-19 | サーバ装置、端末装置、情報処理システム及び情報処理方法 |

Country Status (4)

| Country | Link |

|---|---|

| US (1) | US12299250B2 (ja) |

| JP (1) | JP7658366B2 (ja) |

| CN (1) | CN115461788A (ja) |

| WO (1) | WO2021220866A1 (ja) |

Citations (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2019067112A1 (en) | 2017-09-29 | 2019-04-04 | Sony Interactive Entertainment America Llc | SPECTATOR VIEW IN AN INTERACTIVE GAMING WORLD PRESENTED IN A LIVE EVENT LOCATED IN A PLACE OF THE REAL WORLD |

Family Cites Families (7)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP5870958B2 (ja) * | 2012-04-27 | 2016-03-01 | キヤノンマーケティングジャパン株式会社 | 情報処理システム、その制御方法、及びプログラム、並びに情報処理装置、その制御方法、及びプログラム |

| US20130293671A1 (en) * | 2012-05-01 | 2013-11-07 | Tourwrist, Inc. | Systems and methods for stitching and sharing panoramas |

| JP6360711B2 (ja) | 2014-05-07 | 2018-07-18 | 株式会社 ディー・エヌ・エー | ゲームを提供するサーバ及び方法 |

| JP6955861B2 (ja) | 2016-12-16 | 2021-10-27 | 株式会社バンダイナムコエンターテインメント | イベント制御システム及びプログラム |

| US10949669B2 (en) * | 2017-08-22 | 2021-03-16 | Kreatar, Llc | Augmented reality geolocation using image matching |

| JP7173024B2 (ja) * | 2017-09-29 | 2022-11-16 | ソニーグループ株式会社 | 情報処理装置、情報処理方法、およびプログラム |

| US11627118B1 (en) * | 2019-09-26 | 2023-04-11 | Meta Platforms Technologies, Llc | Utilizing inter-device communications and user permissions for capturing digital images at events |

-

2021

- 2021-04-19 WO PCT/JP2021/015892 patent/WO2021220866A1/ja not_active Ceased

- 2021-04-19 CN CN202180030784.0A patent/CN115461788A/zh active Pending

- 2021-04-19 US US17/915,759 patent/US12299250B2/en active Active

- 2021-04-19 JP JP2022517647A patent/JP7658366B2/ja active Active

Patent Citations (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2019067112A1 (en) | 2017-09-29 | 2019-04-04 | Sony Interactive Entertainment America Llc | SPECTATOR VIEW IN AN INTERACTIVE GAMING WORLD PRESENTED IN A LIVE EVENT LOCATED IN A PLACE OF THE REAL WORLD |

Also Published As

| Publication number | Publication date |

|---|---|

| JPWO2021220866A1 (ja) | 2021-11-04 |

| WO2021220866A1 (ja) | 2021-11-04 |

| US20230205389A1 (en) | 2023-06-29 |

| US12299250B2 (en) | 2025-05-13 |

| CN115461788A (zh) | 2022-12-09 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| US11758346B2 (en) | Sound localization for user in motion | |

| US8142277B2 (en) | Program, game system, and movement control method for assisting a user to position a game object | |

| US9892563B2 (en) | System and method for generating a mixed reality environment | |

| US9155967B2 (en) | Method for implementing game, storage medium, game device, and computer | |

| CN109529356B (zh) | 对战结果确定方法、装置及存储介质 | |

| CN110755845B (zh) | 虚拟世界的画面显示方法、装置、设备及介质 | |

| CN111462307A (zh) | 虚拟对象的虚拟形象展示方法、装置、设备及存储介质 | |

| US20220198760A1 (en) | Display system and server | |

| CN111330278B (zh) | 基于虚拟环境的动画播放方法、装置、设备及介质 | |

| US20200294265A1 (en) | Information processing apparatus, method for processing information, and computer program | |

| CN111338534A (zh) | 虚拟对象的对局方法、装置、设备及介质 | |

| JP2022532305A (ja) | 仮想シーンの表示方法、装置、端末及びコンピュータプログラム | |

| WO2015048890A1 (en) | System and method for augmented reality and virtual reality applications | |

| WO2022227915A1 (zh) | 显示位置标记的方法、装置、设备及存储介质 | |

| EP4082638B1 (en) | Image processing system, image processing program, and image processing method | |

| CN111569414B (zh) | 虚拟飞行器的飞行展示方法、装置、电子设备及存储介质 | |

| US10410390B2 (en) | Augmented reality platform using captured footage from multiple angles | |

| JP7658366B2 (ja) | サーバ装置、端末装置、情報処理システム及び情報処理方法 | |

| JP7472912B2 (ja) | 情報処理装置、情報処理方法および記録媒体 | |

| TW201721361A (zh) | 互動式擴增實境系統 | |

| JP2025186425A (ja) | 情報処理システム、情報処理方法、および情報処理プログラム | |

| JP2025136644A (ja) | プログラム及びシステム | |

| HK40023673B (en) | Method and apparatus for playing animation based on virtual environment, device and medium | |

| HK40023673A (en) | Method and apparatus for playing animation based on virtual environment, device and medium |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20240229 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20241203 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20250114 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20250225 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20250310 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 7658366 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |