JP7027552B2 - モバイル機器を用いたジェスチャー認識 - Google Patents

モバイル機器を用いたジェスチャー認識 Download PDFInfo

- Publication number

- JP7027552B2 JP7027552B2 JP2020536953A JP2020536953A JP7027552B2 JP 7027552 B2 JP7027552 B2 JP 7027552B2 JP 2020536953 A JP2020536953 A JP 2020536953A JP 2020536953 A JP2020536953 A JP 2020536953A JP 7027552 B2 JP7027552 B2 JP 7027552B2

- Authority

- JP

- Japan

- Prior art keywords

- mobile device

- depth camera

- sensor

- change

- vehicle information

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/017—Gesture based interaction, e.g. based on a set of recognized hand gestures

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F18/00—Pattern recognition

- G06F18/20—Analysing

- G06F18/285—Selection of pattern recognition techniques, e.g. of classifiers in a multi-classifier system

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/0304—Detection arrangements using opto-electronic means

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/033—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor

- G06F3/0346—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor with detection of the device orientation or free movement in a 3D space, e.g. 3D mice, 6-DOF [six degrees of freedom] pointers using gyroscopes, accelerometers or tilt-sensors

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V10/00—Arrangements for image or video recognition or understanding

- G06V10/70—Arrangements for image or video recognition or understanding using pattern recognition or machine learning

- G06V10/87—Arrangements for image or video recognition or understanding using pattern recognition or machine learning using selection of the recognition techniques, e.g. of a classifier in a multiple classifier system

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/20—Movements or behaviour, e.g. gesture recognition

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/20—Movements or behaviour, e.g. gesture recognition

- G06V40/28—Recognition of hand or arm movements, e.g. recognition of deaf sign language

Landscapes

- Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- General Engineering & Computer Science (AREA)

- Human Computer Interaction (AREA)

- Computer Vision & Pattern Recognition (AREA)

- General Health & Medical Sciences (AREA)

- Multimedia (AREA)

- Health & Medical Sciences (AREA)

- Social Psychology (AREA)

- Psychiatry (AREA)

- Artificial Intelligence (AREA)

- Evolutionary Computation (AREA)

- Computing Systems (AREA)

- Medical Informatics (AREA)

- Software Systems (AREA)

- Databases & Information Systems (AREA)

- Data Mining & Analysis (AREA)

- Life Sciences & Earth Sciences (AREA)

- Bioinformatics & Cheminformatics (AREA)

- Bioinformatics & Computational Biology (AREA)

- Evolutionary Biology (AREA)

- User Interface Of Digital Computer (AREA)

- Image Analysis (AREA)

Description

車両情報および/またはエンターテインメントシステムの1つ以上の操作機能を制御するための、ジェスチャー認識を使用することが提案される。

前段落は、一般的な導入によって提供され、以下の請求の範囲を制限するものではない。本開示において記載された実施形態は、さらなる利益と共に、添付図面と併用された以下の詳細な説明を参照することによって、最もよく理解される。

深度カメラと、

姿勢センサと、

ジェスチャー検出アルゴリズムに従って上記深度カメラによってキャプチャされた画像から1つ以上のジェスチャーを検出するように構成されたプロセッサと

を具備する。

上記プロセッサは、上記姿勢センサによって検出された上記モバイル機器の姿勢に応じて上記ジェスチャー検出アルゴリズムを変更するように構成されている。

深度カメラおよび姿勢センサを有するモバイル機器と、

ジェスチャー検出アルゴリズムに従って上記深度カメラによってキャプチャされた画像から1つ以上のジェスチャーを検出するように構成されたプロセッサと

を具備する。

上記プロセッサは、上記姿勢センサによって検出された上記モバイル機器の姿勢に応じて、上記ジェスチャー検出アルゴリズムを変更するように構成される。

上記モバイル機器の深度カメラを用いて画像を検出するステップと、

上記モバイル機器の姿勢を検出するステップと、

ジェスチャー検出アルゴリズムに従って、上記深度カメラによってキャプチャされた画像から1つ以上のジェスチャーを検出するステップと

を含む。

上記1つ以上のジェスチャーを検出するステップは、上記姿勢センサによって検出された上記モバイル機器の姿勢に応じて、上記ジェスチャー検出アルゴリズムを変更することを含む。

これに関連して、図1は、深度カメラ110に適用可能な座標系の表示112を含み、この座標系112において、図示されるように、x軸およびy軸がモバイル機器100の一面に存在し、z軸がこの一面に対して垂直であり、深度カメラ110の視野方向に延びる。この深度カメラ110によってキャプチャされる奥行き情報は、キャプチャ画像における特定の位置(x、y)におけるピクセルに対する奥行き値すなわちz値を含むことができる。

この制御信号205は、表示画面および/または1つ以上のラウドスピーカなどのユーザーインターフェース230によって、ユーザに提示する情報および/またはエンターテインメントを生み出すいわゆる"インフォテインメント(娯楽情報)"システム220の動作を制御する制御プロセッサ210に通される。

肉体的制御を探らなければならない、すなわち、画面メニューのオプションに触れなければならないことによって車両の運転手が集中力を失うことなく、ジェスチャーベースのシステムが、様々な車両システムを制御可能になるよう、運転手によく適するように熟慮されている。

このうちいくつかのジェスチャーは、300, 305, 310, 320, 330, 335, 340, 345のように、ユーザの手の動きを検出することを含む。他のジェスチャーは、350, 355のように、ユーザの手の静的配置を検出することを含んでもよい。

このようなジェスチャー検出および/または認識技術のさらなる例は、国際公開第2015/104257号パンフレットに開示されており、その内容は、参照によって本明細書に組み込まれる。

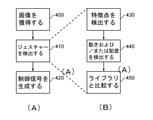

ステップ450において、この検出された動きおよび/または配置が、特徴点の例示的な動きおよび/または配置が特定のジェスチャーを示すライブラリに設定(比較)される。

そうなると、各々の位置において、ユーザが手のジェスチャーを行うことを検出されるときに、ユーザは、モバイル機器100の向きがユーザに向かっていることが必要であることを十分に理解するであろう。

例えば、2つ以上のジェスチャー検出アルゴリズムが提供されてもよい。そのうちの1つは、モバイル機器710の位置および姿勢の範囲730により適しており、そのうちの1つは、モバイル機器710の位置および姿勢の範囲740により適している。

プロセッサ120によって利用可能な複数の候補検出アルゴリズム810が存在する場合、その後のステップ820において、プロセッサ120は、(例えば)モバイル機器の姿勢の部分範囲に各々適したものを、つまり、複数の候補検出器810の中から1つのジェスチャー検出アルゴリズムすなわちジェスチャー検出器を選択する。

図9において、姿勢センサ900は、重力または下方向ベクトル910に対するモバイル機器100の姿勢を検出して、ベクトル910に対するモバイル機器の姿勢の表示を提供する。これは、例えば、重力センサ、加速度センサ、またはジャイロセンサで実行される。

これは、原則として、モバイル機器100の姿勢の変化として図8のプロセスによって誤って検出され、上述したジェスチャー検出アルゴリズムの変更をもたらす。これが生じるのを回避するために、さまざまな対策を講じることができる。

その結果、例えば、検出された姿勢が、(通常の急旋回が車両において実行されるのにかかる時間よりも長いと考えられる数秒または60秒の時定数で)平滑化すなわちローパスフィルタ処理される。そして、平滑化された検出姿勢が、ジェスチャー検出アルゴリズムの変更を制御するために適用される。

その結果が「はい」の場合は、センサによって検出された変化が承諾され、その後のステップ1230で実装される。答えが「いいえ」の場合は、検出された変化は、その後のステップ1240で確認されたときに実装拒否または保留がなされる。

上述したように、深度カメラ1320は、図1のプロセッサ120で実行されるソフトウェア1330と通信する。ソフトウェア1330は、図1のセンサ160に相当するセンサ1340からの信号にも応答する。

上述したようなジェスチャー検出アルゴリズムの変更を行うことができるように、モバイル機器は、モバイル機器の姿勢もキャプチャする必要がある。これに関しては、本開示の実施形態は、車両情報および/またはエンターテインメントシステム用のジェスチャー認識システムを含む。このジェスチャー認識システムはモバイル機器およびプロセッサを含み、モバイル機器は、深度カメラおよび姿勢センサを有し、プロセッサは、ジェスチャー検出アルゴリズムに従って深度カメラによってキャプチャされた画像から1つ以上のジェスチャーを検出するように構成される。

(ステップ1400において)モバイル機器の深度カメラを用いて画像を検出するステップと、

(ステップ1410において)モバイル機器の姿勢を検出するステップと、

(ステップ1420において)ジェスチャー検出アルゴリズムに従って、深度カメラによってキャプチャされた画像から1つ以上のジェスチャーを検出するステップと

を含む。

1つ以上のジェスチャーを検出するステップは、姿勢センサによって検出されたモバイル機器の姿勢に応じて、ジェスチャー検出アルゴリズムを変更すること1430を含む。

同様に、本開示の実施形態は、そのようなコンピュータソフトウェアを保存する非一時的な機械可読記憶媒体によって提供される。

深度カメラと、

姿勢センサと、

ジェスチャー検出アルゴリズムに従って前記深度カメラによってキャプチャされた画像から1つ以上のジェスチャーを検出するように構成されたプロセッサと

を具備し、

前記プロセッサは、前記姿勢センサによって検出された前記モバイル機器の姿勢に応じて前記ジェスチャー検出アルゴリズムを変更するように構成されている

モバイル機器。

(2)上記(1)に記載のモバイル機器であって、

前記プロセッサは、前記姿勢センサによって検出される前記モバイル機器の姿勢に従って、候補となる2つ以上のジェスチャー検出アルゴリズムから選択するように構成される

モバイル機器。

(3)上記(2)に記載のモバイル機器であって、

前記プロセッサは、前記姿勢センサによって検出される前記モバイル機器の姿勢に従って、選択されたジェスチャー検出アルゴリズムの較正パラメータを変化させるように構成される

モバイル機器。

(4)上記(1)に記載のモバイル機器であって、

前記プロセッサは、前記姿勢センサによって検出される前記モバイル機器の姿勢に従って、前記ジェスチャー検出アルゴリズムの較正パラメータを変化させるように構成される

モバイル機器。

(5)上記(1)~(4)のいずれかに記載のモバイル機器であって、

前記深度カメラは、

飛行時間型画像センサと、

ステレオカメラと、

ストラクチャードライトカメラと

で構成されるリストから選択されたセンサを含む

モバイル機器。

(6)上記(1)~(5)のいずれかに記載のモバイル機器であって、

前記姿勢センサは、

ジャイロセンサと、

加速度センサと

重力センサと、

磁気センサと

で構成されるリストから選択された1つ以上のセンサを含む

モバイル機器。

(7)上記(1)~(6)のいずれかに記載のモバイル機器であって、

前記プロセッサは、前記姿勢センサによって検出された姿勢変化が、前記深度カメラによってキャプチャされた画像の、車両内の1つ以上のオブジェクトの位置変化と一致するかどうかを検出するように構成される

モバイル機器。

(8)上記(1)~(5)のいずれかに記載のモバイル機器であって、

前記姿勢センサは、前記深度カメラによってキャプチャされた画像の、車両内のオブジェクトの位置変化を検出する検出器を含む

モバイル機器。

(9)上記(1)~(8)のいずれかに記載のモバイル機器であって、

前記プロセッサは、前記ジェスチャー検出アルゴリズムを、前記深度カメラの画像キャプチャレートよりも低い頻度で変更するように構成される

モバイル機器。

(10)上記(1)~(9)のいずれかに記載のモバイル機器であって、

前記プロセッサは、平滑化を、前記ジェスチャー検出アルゴリズムの変更に適用するように構成される

モバイル機器。

(11)上記(1)~(10)のいずれかに記載のモバイル機器であって、

前記プロセッサは、検出されたジェスチャーによって決まる、前記車両情報および/またはエンターテインメントシステム用の制御信号を生成するように構成される

モバイル機器。

(12)上記(11)に記載のモバイル機器であって、

前記車両情報および/またはエンターテインメントシステムに前記制御信号を伝達する無線インターフェースをさらに含む

モバイル機器。

(13)1つ以上の検出されたジェスチャーによって決まる制御信号を生成するように作動する上記(1)~(11)のいすれかに記載のモバイル機器と、

前記制御信号を受信し、受信した前記制御信号に従って、システム内の作動を変化させるように構成された車両情報および/またはエンターテインメントシステムシステムと

を具備する

車両情報および/またはエンターテインメント機器。

(14)上記(13)に記載の車両情報および/またはエンターテインメント機器であって、

前記モバイル機器および前記車両情報および/またはエンターテインメントシステムシステムの各々は、前記モバイル機器と、前記車両情報および/またはエンターテインメントシステムとの間で前記制御信号を伝達する無線インターフェースを含む

車両情報および/またはエンターテインメント機器。

(15)深度カメラおよび姿勢センサを有するモバイル機器と、

ジェスチャー検出アルゴリズムに従って前記深度カメラによってキャプチャされた画像から1つ以上のジェスチャーを検出するように構成されたプロセッサと

を具備し、

前記プロセッサは、前記姿勢センサによって検出された前記モバイル機器の姿勢に応じて、前記ジェスチャー検出アルゴリズムを変更するように構成される

車両情報および/またはエンターテインメントシステム用のジェスチャー認識システム。

(16)車両情報および/またはエンターテインメントシステム用のジェスチャー認識を行うためのモバイル機器の作動方法であって、

前記モバイル機器の深度カメラを用いて画像を検出するステップと、

前記モバイル機器の姿勢を検出するステップと、

ジェスチャー検出アルゴリズムに従って、前記深度カメラによってキャプチャされた画像から1つ以上のジェスチャーを検出するステップと

を含み、

前記1つ以上のジェスチャーを検出するステップは、前記姿勢センサによって検出された前記モバイル機器の姿勢に応じて、前記ジェスチャー検出アルゴリズムを変更することを含む

方法。

(17)深度カメラを有するモバイル機器のプロセッサによって実行されると、前記モバイル機器に上記(16)に記載の方法を実行させる

コンピュータソフトウェア。

(18)上記(17)に記載のコンピュータソフトウェアを保存する非一時的な機械可読記憶媒体。

Claims (14)

- 車両情報および/またはエンターテインメントシステム用のジェスチャー認識を行うように構成されたモバイル機器であって、

深度カメラと、

姿勢センサと、

ジェスチャー検出アルゴリズムに従って前記深度カメラによってキャプチャされた画像から1つ以上のジェスチャーを検出するように構成されたプロセッサと

を具備し、

前記プロセッサは、前記姿勢センサによって検出された前記モバイル機器の姿勢の変化が、前記深度カメラによってキャプチャされた画像の、車両内の1つ以上のオブジェクトの位置変化と一致するかどうかを検出し、一致する場合、前記姿勢センサによって検出された前記モバイル機器の姿勢に応じて前記ジェスチャー検出アルゴリズムを変更するように構成された

モバイル機器。 - 請求項1に記載のモバイル機器であって、

前記深度カメラは、

飛行時間型画像センサと、

ステレオカメラと、

ストラクチャードライトカメラと

で構成されるリストから選択されたセンサを含む

モバイル機器。 - 請求項1に記載のモバイル機器であって、

前記姿勢センサは、

ジャイロセンサと、

加速度センサと

重力センサと、

磁気センサと

で構成されるリストから選択された1つ以上のセンサを含む

モバイル機器。 - 請求項1に記載のモバイル機器であって、

前記姿勢センサは、前記深度カメラによってキャプチャされた画像の、車両内のオブジェクトの位置変化を検出する検出器を含む

モバイル機器。 - 請求項1に記載のモバイル機器であって、

前記プロセッサは、前記ジェスチャー検出アルゴリズムを、前記深度カメラの画像キャプチャレートよりも低い頻度で変更するように構成される

モバイル機器。 - 請求項5に記載のモバイル機器であって、

前記プロセッサは、平滑化を、前記ジェスチャー検出アルゴリズムの変更に適用するように構成される

モバイル機器。 - 請求項1に記載のモバイル機器であって、

前記プロセッサは、検出されたジェスチャーによって決まる、前記車両情報および/またはエンターテインメントシステム用の制御信号を生成するように構成される

モバイル機器。 - 請求項7に記載のモバイル機器であって、

前記車両情報および/またはエンターテインメントシステムに前記制御信号を伝達する無線インターフェースをさらに含む

モバイル機器。 - 1つ以上の検出されたジェスチャーによって決まる制御信号を生成するように作動する請求項1に記載のモバイル機器と、

前記制御信号を受信し、受信した前記制御信号に従って、システム内の作動を変化させるように構成された車両情報および/またはエンターテインメントシステムと

を具備する

車両情報および/またはエンターテインメント機器。 - 請求項9に記載の車両情報および/またはエンターテインメント機器であって、

前記モバイル機器および前記車両情報および/またはエンターテインメントシステムの各々は、前記モバイル機器と、前記車両情報および/またはエンターテインメントシステムとの間で前記制御信号を伝達する無線インターフェースを含む

車両情報および/またはエンターテインメント機器。 - 深度カメラおよび姿勢センサを有するモバイル機器と、

ジェスチャー検出アルゴリズムに従って前記深度カメラによってキャプチャされた画像から1つ以上のジェスチャーを検出するように構成されたプロセッサと

を具備し、

前記プロセッサは、前記姿勢センサによって検出された前記モバイル機器の姿勢の変化が、前記深度カメラによってキャプチャされた画像の、車両内の1つ以上のオブジェクトの位置変化と一致するかどうかを検出し、一致する場合、前記姿勢センサによって検出された前記モバイル機器の姿勢に応じて、前記ジェスチャー検出アルゴリズムを変更するように構成される

車両情報および/またはエンターテインメントシステム用のジェスチャー認識システム。 - 車両情報および/またはエンターテインメントシステム用のジェスチャー認識を行うためのモバイル機器の作動方法であって、

前記モバイル機器の深度カメラを用いて画像を検出するステップと、

前記モバイル機器の姿勢を姿勢センサを用いて検出するステップと、

ジェスチャー検出アルゴリズムに従って、前記深度カメラによってキャプチャされた画像から1つ以上のジェスチャーを検出するステップと

を含み、

前記1つ以上のジェスチャーを検出するステップは、前記姿勢センサによって検出された前記モバイル機器の姿勢の変化が、前記深度カメラによってキャプチャされた画像の、車両内の1つ以上のオブジェクトの位置変化と一致するかどうかを検出し、一致する場合、前記姿勢センサによって検出された前記モバイル機器の姿勢に応じて、前記ジェスチャー検出アルゴリズムを変更することを含む

方法。 - 深度カメラを有するモバイル機器のプロセッサによって実行されると、前記モバイル機器に請求項12に記載の方法を実行させる

コンピュータソフトウェア。 - 請求項13に記載のコンピュータソフトウェアを保存する非一時的な機械可読記憶媒体。

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| EP18150191.7 | 2018-01-03 | ||

| EP18150191 | 2018-01-03 | ||

| PCT/EP2018/097032 WO2019134888A1 (en) | 2018-01-03 | 2018-12-27 | Gesture recognition using a mobile device |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2021509988A JP2021509988A (ja) | 2021-04-08 |

| JP7027552B2 true JP7027552B2 (ja) | 2022-03-01 |

Family

ID=60935708

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2020536953A Active JP7027552B2 (ja) | 2018-01-03 | 2018-12-27 | モバイル機器を用いたジェスチャー認識 |

Country Status (5)

| Country | Link |

|---|---|

| US (2) | US11662827B2 (ja) |

| EP (1) | EP3735652A1 (ja) |

| JP (1) | JP7027552B2 (ja) |

| CN (1) | CN111417957B (ja) |

| WO (1) | WO2019134888A1 (ja) |

Families Citing this family (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN116848562A (zh) | 2021-01-25 | 2023-10-03 | 索尼半导体解决方案公司 | 电子设备、方法和计算机程序 |

| DE102021111712A1 (de) | 2021-05-05 | 2022-11-10 | Bayerische Motoren Werke Aktiengesellschaft | Verfahren und Vorrichtung zum Kalibrieren eines Tiefensensors in einem Fahrzeuginnenraum |

| US12105884B2 (en) * | 2021-07-30 | 2024-10-01 | Jadelynn Kim Dao | Touchless, gesture-based human interface device |

| US12479366B2 (en) | 2022-12-30 | 2025-11-25 | Gentex Corporation | 3D skeleton detection for in-cabin automotive application |

| US12389109B1 (en) * | 2023-03-31 | 2025-08-12 | Amazon Technologies, Inc. | Acceleration and image based motion detection in vehicles |

Citations (6)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2006143159A (ja) | 2004-11-25 | 2006-06-08 | Alpine Electronics Inc | 車両用動き認識装置 |

| JP2012000165A (ja) | 2010-06-14 | 2012-01-05 | Sega Corp | ビデオゲーム装置 |

| JP2014135668A (ja) | 2013-01-11 | 2014-07-24 | Sharp Corp | 携帯端末装置 |

| US20140306877A1 (en) | 2011-08-11 | 2014-10-16 | Itay Katz | Gesture Based Interface System and Method |

| JP2016081286A (ja) | 2014-10-16 | 2016-05-16 | 株式会社東芝 | 端末操作支援装置および端末操作支援方法 |

| JP2019219904A (ja) | 2018-06-20 | 2019-12-26 | ソニー株式会社 | プログラム、認識装置、及び、認識方法 |

Family Cites Families (23)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR100575906B1 (ko) * | 2002-10-25 | 2006-05-02 | 미츠비시 후소 트럭 앤드 버스 코포레이션 | 핸드 패턴 스위치 장치 |

| US8972902B2 (en) * | 2008-08-22 | 2015-03-03 | Northrop Grumman Systems Corporation | Compound gesture recognition |

| US8952832B2 (en) * | 2008-01-18 | 2015-02-10 | Invensense, Inc. | Interfacing application programs and motion sensors of a device |

| WO2009155465A1 (en) * | 2008-06-18 | 2009-12-23 | Oblong Industries, Inc. | Gesture-based control system for vehicle interfaces |

| US20110221666A1 (en) * | 2009-11-24 | 2011-09-15 | Not Yet Assigned | Methods and Apparatus For Gesture Recognition Mode Control |

| US20110181510A1 (en) * | 2010-01-26 | 2011-07-28 | Nokia Corporation | Gesture Control |

| US8760432B2 (en) * | 2010-09-21 | 2014-06-24 | Visteon Global Technologies, Inc. | Finger pointing, gesture based human-machine interface for vehicles |

| US9785335B2 (en) * | 2010-12-27 | 2017-10-10 | Sling Media Inc. | Systems and methods for adaptive gesture recognition |

| WO2012141352A1 (en) * | 2011-04-13 | 2012-10-18 | Lg Electronics Inc. | Gesture recognition agnostic to device orientation |

| US20130155237A1 (en) * | 2011-12-16 | 2013-06-20 | Microsoft Corporation | Interacting with a mobile device within a vehicle using gestures |

| US9223415B1 (en) * | 2012-01-17 | 2015-12-29 | Amazon Technologies, Inc. | Managing resource usage for task performance |

| US8942881B2 (en) * | 2012-04-02 | 2015-01-27 | Google Inc. | Gesture-based automotive controls |

| DE102012110460A1 (de) * | 2012-10-31 | 2014-04-30 | Audi Ag | Verfahren zum Eingeben eines Steuerbefehls für eine Komponente eines Kraftwagens |

| US20140258942A1 (en) | 2013-03-05 | 2014-09-11 | Intel Corporation | Interaction of multiple perceptual sensing inputs |

| CN104969148B (zh) * | 2013-03-14 | 2018-05-29 | 英特尔公司 | 基于深度的用户界面手势控制 |

| US8886399B2 (en) * | 2013-03-15 | 2014-11-11 | Honda Motor Co., Ltd. | System and method for controlling a vehicle user interface based on gesture angle |

| EP2891950B1 (en) | 2014-01-07 | 2018-08-15 | Sony Depthsensing Solutions | Human-to-computer natural three-dimensional hand gesture based navigation method |

| US10613642B2 (en) * | 2014-03-12 | 2020-04-07 | Microsoft Technology Licensing, Llc | Gesture parameter tuning |

| US10199008B2 (en) * | 2014-03-27 | 2019-02-05 | North Inc. | Systems, devices, and methods for wearable electronic devices as state machines |

| US10481696B2 (en) * | 2015-03-03 | 2019-11-19 | Nvidia Corporation | Radar based user interface |

| US10747327B2 (en) * | 2016-06-28 | 2020-08-18 | Intel Corporation | Technologies for adaptive downsampling for gesture recognition |

| JP6274264B2 (ja) | 2016-06-29 | 2018-02-07 | カシオ計算機株式会社 | 携帯端末装置及びプログラム |

| WO2019091491A1 (en) * | 2017-11-13 | 2019-05-16 | Zyetric Gaming Limited | Gesture recognition based on depth information and computer vision |

-

2018

- 2018-12-27 JP JP2020536953A patent/JP7027552B2/ja active Active

- 2018-12-27 WO PCT/EP2018/097032 patent/WO2019134888A1/en not_active Ceased

- 2018-12-27 US US16/958,024 patent/US11662827B2/en active Active

- 2018-12-27 EP EP18830853.0A patent/EP3735652A1/en active Pending

- 2018-12-27 CN CN201880077267.7A patent/CN111417957B/zh active Active

-

2023

- 2023-05-26 US US18/324,881 patent/US20230305636A1/en not_active Abandoned

Patent Citations (6)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2006143159A (ja) | 2004-11-25 | 2006-06-08 | Alpine Electronics Inc | 車両用動き認識装置 |

| JP2012000165A (ja) | 2010-06-14 | 2012-01-05 | Sega Corp | ビデオゲーム装置 |

| US20140306877A1 (en) | 2011-08-11 | 2014-10-16 | Itay Katz | Gesture Based Interface System and Method |

| JP2014135668A (ja) | 2013-01-11 | 2014-07-24 | Sharp Corp | 携帯端末装置 |

| JP2016081286A (ja) | 2014-10-16 | 2016-05-16 | 株式会社東芝 | 端末操作支援装置および端末操作支援方法 |

| JP2019219904A (ja) | 2018-06-20 | 2019-12-26 | ソニー株式会社 | プログラム、認識装置、及び、認識方法 |

Non-Patent Citations (2)

| Title |

|---|

| Francisco Parada-Loira, Elisardo Gonzalez-Agulla, Jose L. Alba-Castro,Hand Gestures to Control Infotainment Equipement in Cars,2014 IEEE Intelligent Vehicles Symposium Proceedings,米国,IEEE,2014年06月08日,pp. 1-6,https://ieeexplore.ieee.org/document/6856614/ |

| 長谷川 秀太, 赤池 英夫, 角田 博保,姿勢を考慮したハンドジェスチャーを利用する機器操作の提案・評価,情報処理学会研究報告,日本,情報処理学会,2012年04月15日,Vol. 2012-HCI-147, No. 24 (2012/3/22),pp. 1-6 |

Also Published As

| Publication number | Publication date |

|---|---|

| EP3735652A1 (en) | 2020-11-11 |

| CN111417957B (zh) | 2023-10-27 |

| US20210064147A1 (en) | 2021-03-04 |

| JP2021509988A (ja) | 2021-04-08 |

| US11662827B2 (en) | 2023-05-30 |

| CN111417957A (zh) | 2020-07-14 |

| US20230305636A1 (en) | 2023-09-28 |

| WO2019134888A1 (en) | 2019-07-11 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP7027552B2 (ja) | モバイル機器を用いたジェスチャー認識 | |

| JP5261554B2 (ja) | 指先ポインティング、ジェスチャに基づく車両用ヒューマンマシンインタフェース | |

| US9738158B2 (en) | Motor vehicle control interface with gesture recognition | |

| KR101490908B1 (ko) | 차량 내 손모양 궤적 인식을 이용한 사용자 인터페이스 조작 시스템 및 방법 | |

| US20110310001A1 (en) | Display reconfiguration based on face/eye tracking | |

| CN106030460B (zh) | 移动体用手势引导装置、移动体用手势引导系统及移动体用手势引导方法 | |

| JP2018150043A (ja) | 自動車における情報伝送のためのシステム | |

| KR102084032B1 (ko) | 사용자 인터페이스, 운송 수단 및 사용자 구별을 위한 방법 | |

| KR101438615B1 (ko) | 2차원 카메라를 이용한 사용자 인터페이스 조작 시스템 및 방법 | |

| KR101946746B1 (ko) | 차량에서 비-차량 오브젝트의 위치 결정 | |

| WO2014165218A1 (en) | System and method for identifying handwriting gestures in an in-vehicle infromation system | |

| US20200278745A1 (en) | Vehicle and control method thereof | |

| JP2021512392A (ja) | バーチャルコンテンツを表示するためのヘッドマウント式電子ディスプレイ装置の操作方法およびバーチャルコンテンツを表示するためのディスプレイシステム | |

| US20130187845A1 (en) | Adaptive interface system | |

| WO2018061603A1 (ja) | ジェスチャ操作システム、ジェスチャ操作方法およびプログラム | |

| KR20170079045A (ko) | 차량용 사용자 인터페이스 제공 방법 및 장치 | |

| JP5800361B2 (ja) | 表示制御装置及びそれを用いた表示装置 | |

| US9235295B2 (en) | Vehicle graphical user interface arrangement | |

| US20240166153A1 (en) | Camera-Based Vehicle Occupant Sensing | |

| GB2526515A (en) | Image capture system | |

| JP2006327526A (ja) | 車載機器の操作装置 | |

| US11281337B1 (en) | Mirror accessory for camera based touch detection | |

| JP6371589B2 (ja) | 車載システム、視線入力受付方法及びコンピュータプログラム | |

| CN118474312A (zh) | 投影方法、装置、电子设备及存储介质 | |

| JP5901865B2 (ja) | 表示制御装置及び表示制御方法 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20200708 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20210827 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20210907 |

|

| A601 | Written request for extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A601 Effective date: 20211104 |

|

| RD02 | Notification of acceptance of power of attorney |

Free format text: JAPANESE INTERMEDIATE CODE: A7422 Effective date: 20211104 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20220105 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20220118 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20220216 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 7027552 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |